১. লেট নাইট কোড রিভিউ

এখন রাত ২টা।

তুমি ঘণ্টার পর ঘণ্টা ধরে ডিবাগিং করছো। ফাংশনটা ঠিক দেখাচ্ছে, কিন্তু কিছু একটা সমস্যা আছে। তুমি জানো যে, কোডটা কখন কাজ করা উচিত ছিল কিন্তু কাজ করছে না, আর তুমি আর বুঝতে পারছো না কেন, কারণ তুমি অনেকক্ষণ ধরে এটার দিকে তাকিয়ে আছো।

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start # Looks innocent enough...

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

এআই ডেভেলপারদের যাত্রা

যদি আপনি এটি পড়ছেন, তাহলে সম্ভবত আপনি কোডিংয়ে AI যে রূপান্তর এনেছে তা অনুভব করেছেন। জেমিনি কোড অ্যাসিস্ট , ক্লড কোড এবং কার্সারের মতো টুলগুলি আমাদের কোড লেখার পদ্ধতিতে পরিবর্তন এনেছে। বয়লারপ্লেট তৈরি, বাস্তবায়নের পরামর্শ এবং উন্নয়ন ত্বরান্বিত করার জন্য এগুলি অবিশ্বাস্য।

কিন্তু তুমি এখানে এসেছো কারণ তুমি আরও গভীরে যেতে চাও। তুমি বুঝতে চাও কিভাবে এই AI সিস্টেমগুলো তৈরি করতে হয়, শুধু ব্যবহার করা নয়। তুমি এমন কিছু তৈরি করতে চাও যা:

- অনুমানযোগ্য, ট্রেসযোগ্য আচরণ আছে

- আত্মবিশ্বাসের সাথে উৎপাদনে মোতায়েন করা যেতে পারে

- আপনি নির্ভর করতে পারেন এমন ধারাবাহিক ফলাফল প্রদান করে

- এটি কীভাবে সিদ্ধান্ত নেয় তা আপনাকে ঠিক দেখায়

ভোক্তা থেকে স্রষ্টা

আজ, তুমি AI টুল ব্যবহার থেকে শুরু করে সেগুলো তৈরিতে এক ধাপ এগিয়ে যাবে। তুমি একটি মাল্টি-এজেন্ট সিস্টেম তৈরি করবে যা:

- কোড কাঠামো নির্ধারণমূলকভাবে বিশ্লেষণ করে

- আচরণ যাচাই করার জন্য প্রকৃত পরীক্ষা চালায়

- আসল লিন্টারের সাথে স্টাইলের সম্মতি যাচাই করে ।

- ফলাফলগুলিকে কার্যকর প্রতিক্রিয়ায় সংশ্লেষিত করে

- সম্পূর্ণ পর্যবেক্ষণযোগ্যতার সাথে গুগল ক্লাউডে স্থাপন করা হয়

2. আপনার প্রথম এজেন্ট মোতায়েন

ডেভেলপারের প্রশ্ন

"আমি LLM গুলো বুঝি, আমি API গুলো ব্যবহার করেছি, কিন্তু কিভাবে আমি একটি Python স্ক্রিপ্ট থেকে একটি প্রোডাকশন AI এজেন্টে যাব যা স্কেল করে?"

আসুন এর উত্তর দেই আপনার পরিবেশ সঠিকভাবে সেট আপ করে, তারপর উৎপাদনের ধরণে ডুব দেওয়ার আগে মূল বিষয়গুলি বোঝার জন্য একটি সহজ এজেন্ট তৈরি করে।

প্রথমে অপরিহার্য সেটআপ

কোনও এজেন্ট তৈরি করার আগে, আপনার গুগল ক্লাউড পরিবেশ প্রস্তুত কিনা তা নিশ্চিত করুন।

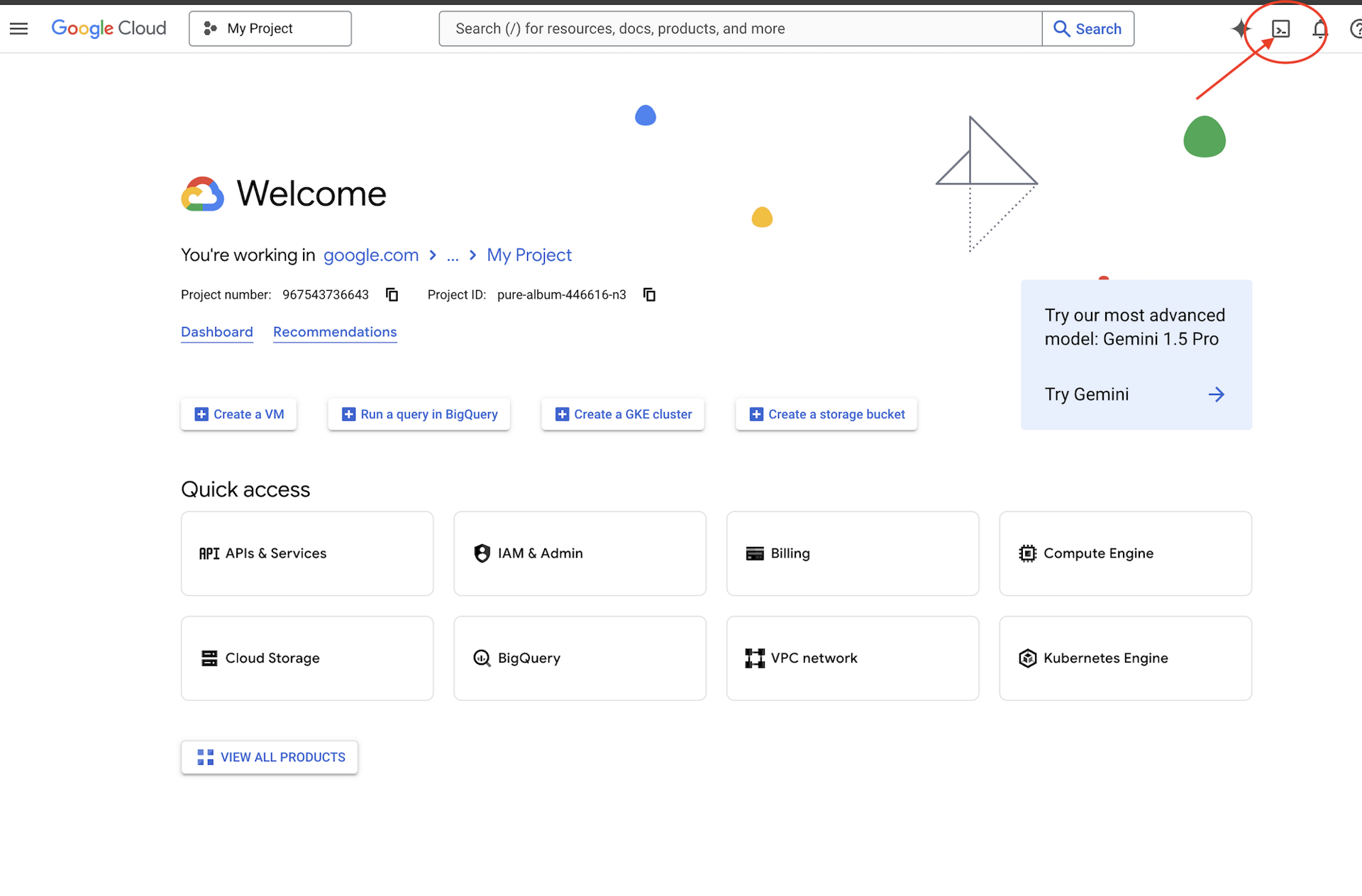

গুগল ক্লাউড ক্রেডিট প্রয়োজন?

গুগল ক্লাউড কনসোলের উপরে অ্যাক্টিভেট ক্লাউড শেল ক্লিক করুন (এটি ক্লাউড শেল প্যানের উপরে টার্মিনাল আকৃতির আইকন),

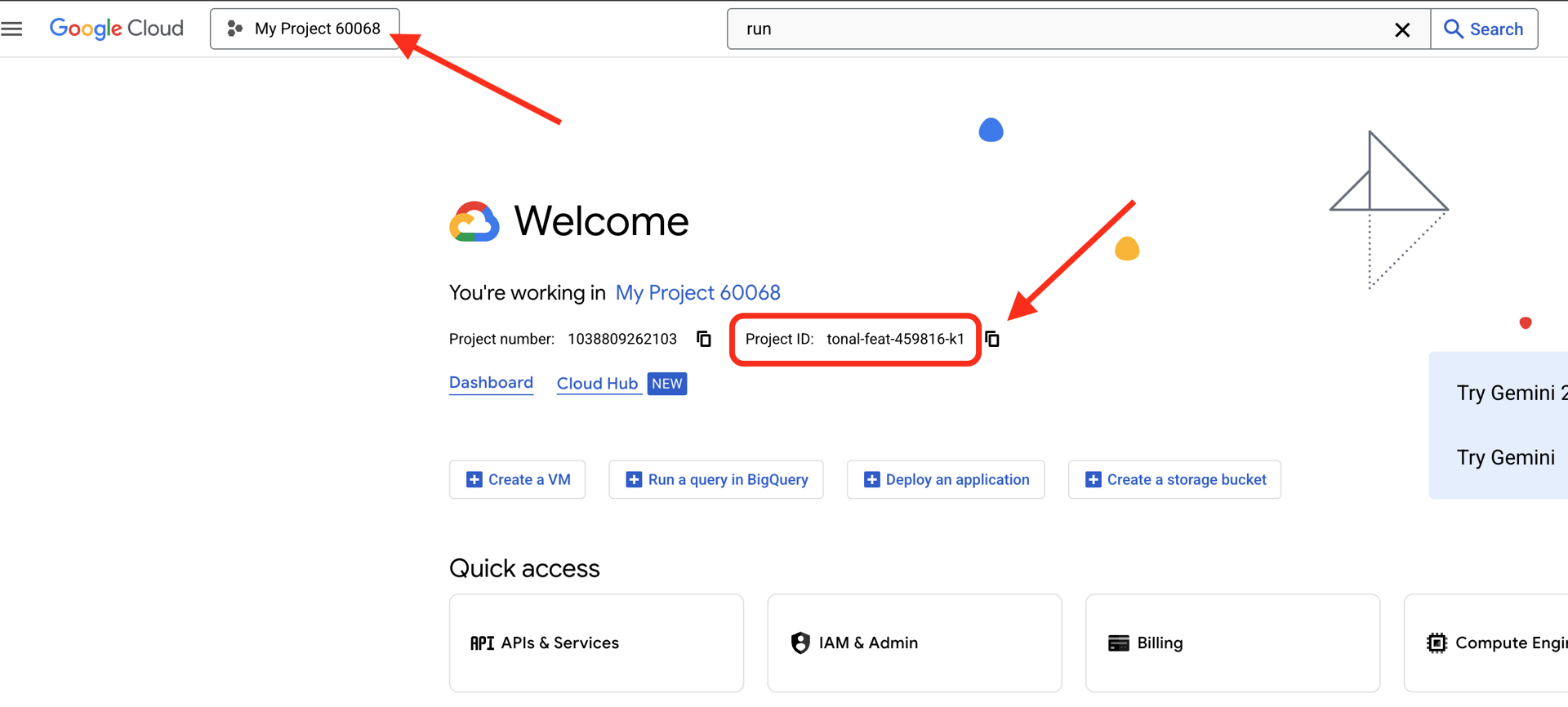

আপনার Google Cloud Project ID খুঁজুন:

- গুগল ক্লাউড কনসোল খুলুন: https://console.cloud.google.com

- পৃষ্ঠার উপরে থাকা প্রকল্পের ড্রপডাউন থেকে এই কর্মশালার জন্য আপনি যে প্রকল্পটি ব্যবহার করতে চান তা নির্বাচন করুন।

- আপনার প্রজেক্ট আইডি ড্যাশবোর্ডের প্রজেক্ট তথ্য কার্ডে প্রদর্শিত হবে।

ধাপ ১: আপনার প্রজেক্ট আইডি সেট করুন

ক্লাউড শেলে, gcloud কমান্ড-লাইন টুলটি ইতিমধ্যেই কনফিগার করা আছে। আপনার সক্রিয় প্রকল্প সেট করতে নিম্নলিখিত কমান্ডটি চালান। এটি $GOOGLE_CLOUD_PROJECT পরিবেশ ভেরিয়েবল ব্যবহার করে, যা আপনার ক্লাউড শেল সেশনে স্বয়ংক্রিয়ভাবে আপনার জন্য সেট হয়ে যায়।

gcloud config set project $GOOGLE_CLOUD_PROJECT

ধাপ ২: আপনার সেটআপ যাচাই করুন

এরপর, আপনার প্রকল্পটি সঠিকভাবে সেট করা হয়েছে এবং আপনি প্রমাণীকরণ করেছেন তা নিশ্চিত করতে নিম্নলিখিত কমান্ডগুলি চালান।

# Confirm project is set

echo "Current project: $(gcloud config get-value project)"

# Check authentication status

gcloud auth list

আপনার প্রোজেক্ট আইডি প্রিন্ট করা এবং আপনার ব্যবহারকারী অ্যাকাউন্টটি (ACTIVE) এর পাশে তালিকাভুক্ত দেখতে পাবেন।

যদি আপনার অ্যাকাউন্টটি সক্রিয় হিসাবে তালিকাভুক্ত না থাকে, অথবা যদি আপনি একটি প্রমাণীকরণ ত্রুটি পান, তাহলে লগ ইন করতে নিম্নলিখিত কমান্ডটি চালান:

gcloud auth application-default login

ধাপ ৩: অপরিহার্য API গুলি সক্ষম করুন

বেসিক এজেন্টের জন্য আমাদের কমপক্ষে এই API গুলি প্রয়োজন:

gcloud services enable \

aiplatform.googleapis.com \

compute.googleapis.com

এতে এক বা দুই মিনিট সময় লাগতে পারে। আপনি দেখতে পাবেন:

Operation "operations/..." finished successfully.

ধাপ ৪: ADK ইনস্টল করুন

# Install the ADK CLI

pip install google-adk --upgrade

# Verify installation

adk --version

আপনার 1.15.0 বা তার বেশি সংস্করণের মতো একটি সংস্করণ নম্বর দেখা উচিত।

এখন আপনার বেসিক এজেন্ট তৈরি করুন

পরিবেশ প্রস্তুত থাকা অবস্থায়, আসুন সেই সহজ এজেন্টটি তৈরি করি।

ধাপ ৫: ADK Create ব্যবহার করুন

adk create my_first_agent

ইন্টারেক্টিভ প্রম্পটগুলি অনুসরণ করুন:

Choose a model for the root agent:

1. gemini-2.5-flash

2. Other models (fill later)

Choose model (1, 2): 1

1. Google AI

2. Vertex AI

Choose a backend (1, 2): 2

Enter Google Cloud project ID [auto-detected-from-gcloud]:

Enter Google Cloud region [us-central1]:

ধাপ ৬: কী তৈরি হয়েছিল তা পরীক্ষা করুন

cd my_first_agent

ls -la

আপনি তিনটি ফাইল পাবেন:

.env # Configuration (auto-populated with your project)

__init__.py # Package marker

agent.py # Your agent definition

ধাপ ৭: দ্রুত কনফিগারেশন পরীক্ষা

# Verify the .env was created correctly

cat .env

# Should show something like:

# GOOGLE_CLOUD_PROJECT=your-project-id

# GOOGLE_CLOUD_LOCATION=us-central1

# GOOGLE_GENAI_USE_VERTEXAI=1

যদি প্রজেক্ট আইডি অনুপস্থিত বা ভুল থাকে, তাহলে .env ফাইলটি সম্পাদনা করুন:

nano .env # or use your preferred editor

ধাপ ৮: এজেন্ট কোডটি দেখুন

cat agent.py

from google.adk.agents.llm_agent import Agent

root_agent = Agent(

model='gemini-2.5-flash',

name='root_agent',

description='A helpful assistant for user questions.',

instruction='Answer user questions to the best of your knowledge',

)

সহজ, পরিষ্কার, ন্যূনতম। এটি আপনার এজেন্টদের "হ্যালো ওয়ার্ল্ড"।

আপনার বেসিক এজেন্ট পরীক্ষা করুন

ধাপ ৯: আপনার এজেন্ট চালান

cd ..

adk run my_first_agent

তোমার এরকম কিছু দেখা উচিত:

Log setup complete: /tmp/agents_log/agent.20250930_162430.log

To access latest log: tail -F /tmp/agents_log/agent.latest.log

[user]:

ধাপ ১০: কিছু প্রশ্ন চেষ্টা করুন

যে টার্মিনালে adk run চলছে, সেখানে আপনি একটি প্রম্পট দেখতে পাবেন। আপনার প্রশ্নগুলি টাইপ করুন:

[user]: Hey, what can you do?

[root_agent]: I can help answer questions, generate text, explain concepts, assist with problem-solving, and provide information on a wide range of topics. What would you like to know or discuss?

[user]: What's the current weather in Mountain View?

[root_agent]: I'm sorry, but I cannot provide real-time weather information as I don't have access to current data or weather services. To get the current weather in Mountain View, I recommend checking a weather website or app like weather.com or using a search engine.

সীমাবদ্ধতাটি লক্ষ্য করুন - এটি বর্তমান ডেটা অ্যাক্সেস করতে পারে না। আরও এগিয়ে যাওয়া যাক:

[user]: Review this Python code: def add(a, b): return a + b

[root_agent]: This is a simple Python function that adds two numbers. Here's my review:

**Strengths:**

- Clean and concise implementation

- Follows Python conventions for simple operations

- Clear function name that describes its purpose

**Suggestions for improvement:**

- Add a docstring to document the function

- Consider adding type hints for better code clarity

- You might want to handle edge cases

Here's an enhanced version:

def add(a: float, b: float) -> float:

"""Add two numbers and return their sum."""

return a + b

এজেন্ট কোড নিয়ে আলোচনা করতে পারে, কিন্তু কি তা করতে পারে:

- কাঠামো বোঝার জন্য আসলে AST বিশ্লেষণ করবেন?

- এটি কাজ করে কিনা তা যাচাই করার জন্য পরীক্ষা চালাবেন?

- স্টাইলের সম্মতি পরীক্ষা করবেন?

- তোমার আগের রিভিউগুলো মনে আছে?

না। এখানেই আমাদের স্থাপত্যের প্রয়োজন।

🏃🚪 এর সাথে প্রস্থান করুন

Ctrl+C

অন্বেষণ শেষ হলে।

৩. আপনার উৎপাদন কর্মক্ষেত্র প্রস্তুত করা

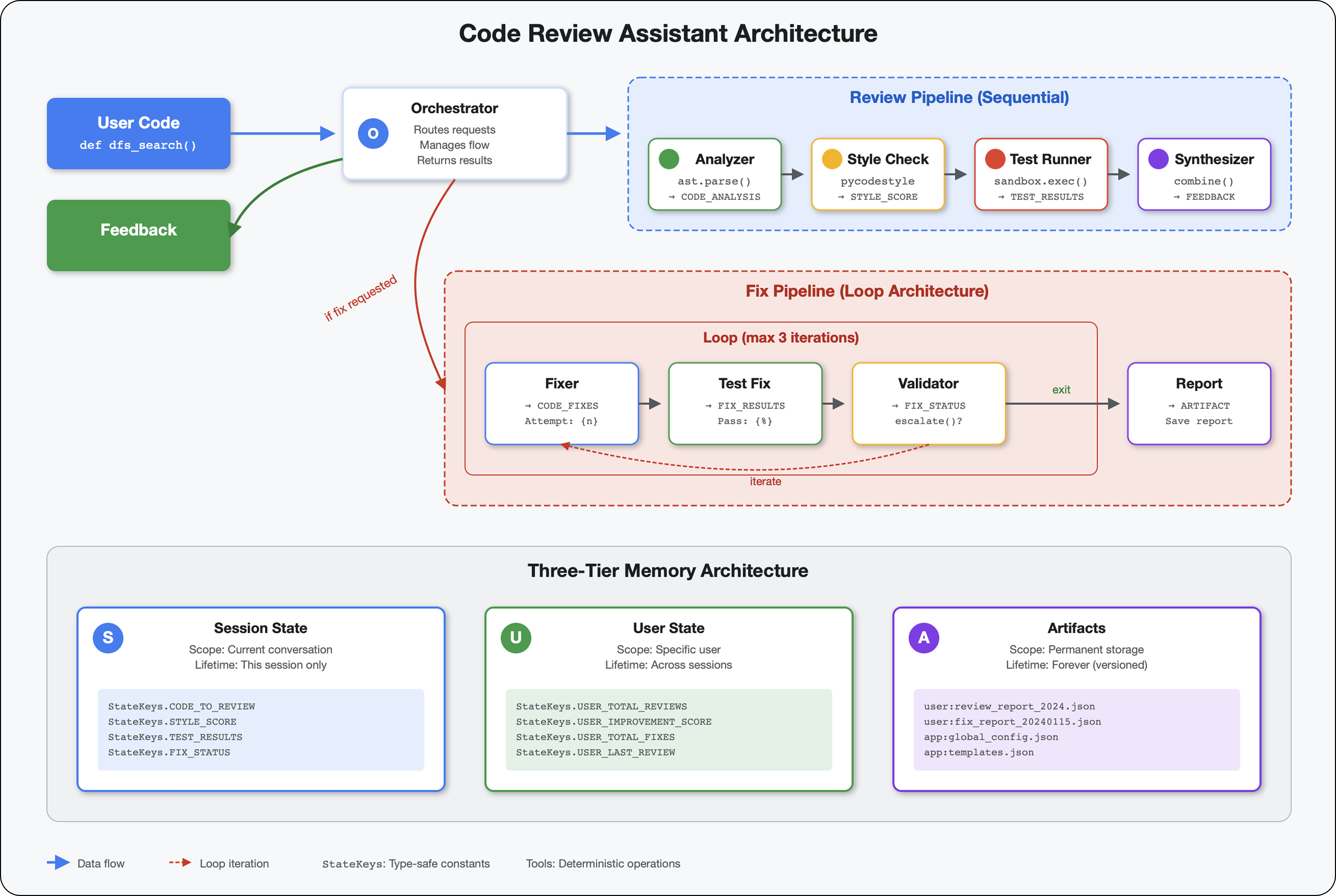

সমাধান: একটি উৎপাদন-প্রস্তুত স্থাপত্য

সেই সহজ এজেন্টটি শুরুর বিন্দুটি দেখিয়েছিল, কিন্তু একটি উৎপাদন ব্যবস্থার জন্য শক্তিশালী কাঠামো প্রয়োজন। আমরা এখন একটি সম্পূর্ণ প্রকল্প স্থাপন করব যা উৎপাদন নীতিগুলিকে মূর্ত করে।

ফাউন্ডেশন স্থাপন করা

আপনি ইতিমধ্যেই আপনার গুগল ক্লাউড প্রজেক্টটিকে বেসিক এজেন্টের জন্য কনফিগার করেছেন। এখন আসুন একটি বাস্তব সিস্টেমের জন্য প্রয়োজনীয় সমস্ত সরঞ্জাম, প্যাটার্ন এবং অবকাঠামো সহ সম্পূর্ণ উৎপাদন কর্মক্ষেত্র প্রস্তুত করি।

ধাপ ১: স্ট্রাকচার্ড প্রজেক্টটি পান

প্রথমে, Ctrl+C ব্যবহার করে যেকোনো চলমান adk run থেকে বেরিয়ে আসুন এবং পরিষ্কার করুন:

# Clean up the basic agent

cd ~ # Make sure you're not inside my_first_agent

rm -rf my_first_agent

# Get the production scaffold

git clone https://github.com/ayoisio/adk-code-review-assistant.git

cd adk-code-review-assistant

git checkout codelab

ধাপ ২: ভার্চুয়াল পরিবেশ তৈরি এবং সক্রিয় করুন

# Create the virtual environment

python -m venv .venv

# Activate it

# On macOS/Linux:

source .venv/bin/activate

# On Windows:

# .venv\Scripts\activate

যাচাইকরণ : আপনার প্রম্পট এখন শুরুতে (.venv) দেখাবে।

ধাপ ৩: নির্ভরতা ইনস্টল করুন

pip install -r code_review_assistant/requirements.txt

# Install the package in editable mode (enables imports)

pip install -e .

এটি ইনস্টল করে:

-

google-adk- ADK ফ্রেমওয়ার্ক -

pycodestyle- PEP 8 চেকিংয়ের জন্য -

vertexai- ক্লাউড স্থাপনার জন্য - অন্যান্য উৎপাদন নির্ভরতা

-e ফ্ল্যাগ আপনাকে যেকোনো জায়গা থেকে code_review_assistant মডিউল আমদানি করতে দেয়।

ধাপ ৪: আপনার পরিবেশ কনফিগার করুন

# Copy the example environment file

cp .env.example .env

# Edit .env and replace the placeholders:

# - GOOGLE_CLOUD_PROJECT=your-project-id → your actual project ID

# - Keep other defaults as-is

যাচাইকরণ : আপনার কনফিগারেশন পরীক্ষা করুন:

cat .env

দেখানো উচিত:

GOOGLE_CLOUD_PROJECT=your-actual-project-id

GOOGLE_CLOUD_LOCATION=us-central1

GOOGLE_GENAI_USE_VERTEXAI=TRUE

ধাপ ৫: প্রমাণীকরণ নিশ্চিত করুন

যেহেতু আপনি ইতিমধ্যেই gcloud auth ব্যবহার করেছেন, আসুন যাচাই করি:

# Check current authentication

gcloud auth list

# Should show your account with (ACTIVE)

# If not, run:

gcloud auth application-default login

ধাপ ৬: অতিরিক্ত উৎপাদন API সক্ষম করুন

আমরা ইতিমধ্যেই মৌলিক API গুলি সক্ষম করেছি। এখন উৎপাদনগুলি যোগ করুন:

gcloud services enable \

sqladmin.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

artifactregistry.googleapis.com \

storage.googleapis.com \

cloudtrace.googleapis.com

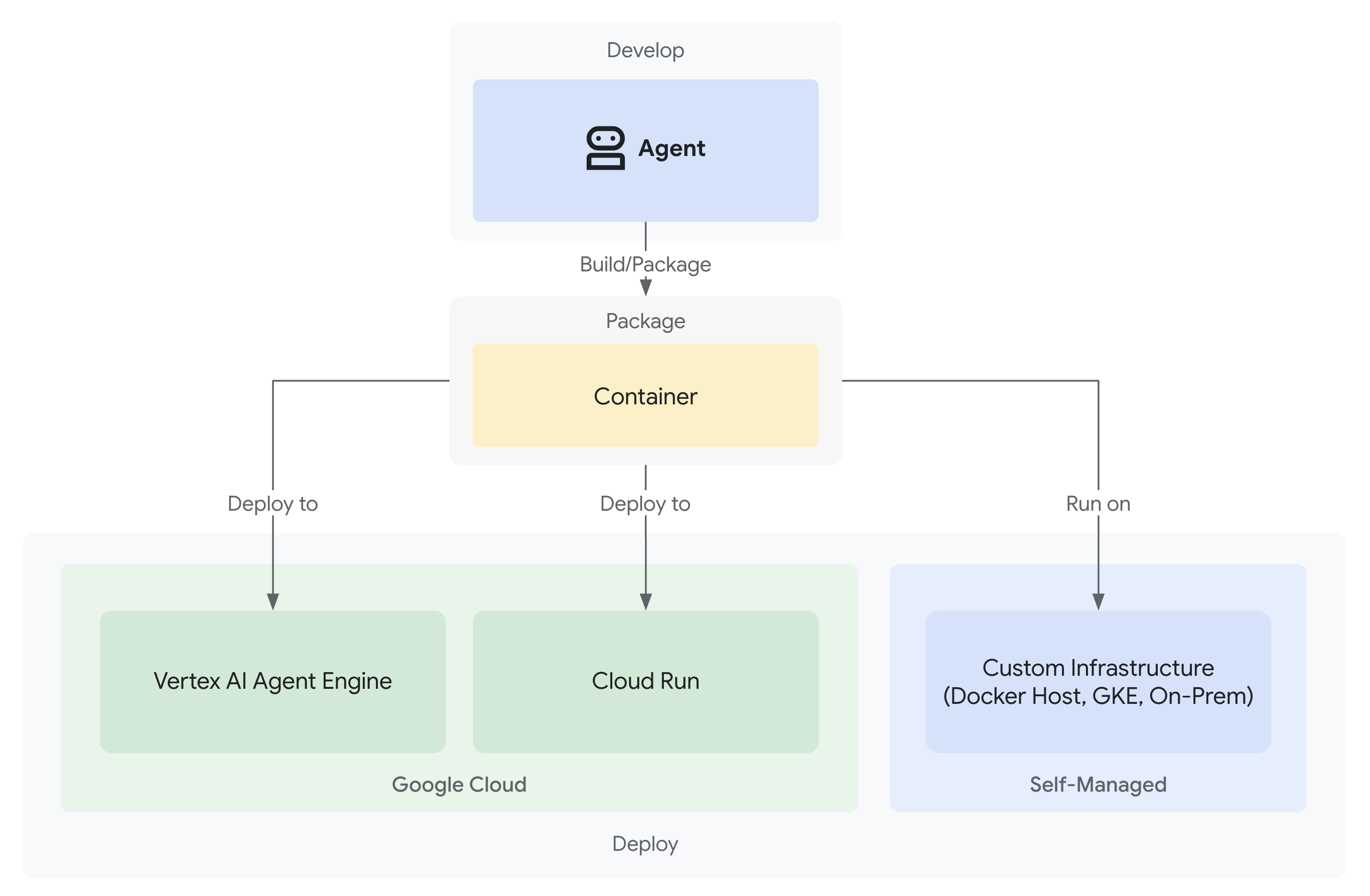

এটি সক্ষম করে:

- SQL অ্যাডমিন : ক্লাউড রান ব্যবহার করলে ক্লাউড SQL এর জন্য

- ক্লাউড রান : সার্ভারলেস স্থাপনার জন্য

- ক্লাউড বিল্ড : স্বয়ংক্রিয় স্থাপনার জন্য

- আর্টিফ্যাক্ট রেজিস্ট্রি : কন্টেইনার ছবির জন্য

- ক্লাউড স্টোরেজ : আর্টিফ্যাক্ট এবং স্টেজিংয়ের জন্য

- ক্লাউড ট্রেস : পর্যবেক্ষণের জন্য

ধাপ ৭: আর্টিফ্যাক্ট রেজিস্ট্রি রিপোজিটরি তৈরি করুন

আমাদের স্থাপনা এমন কন্টেইনার ছবি তৈরি করবে যার জন্য একটি বাড়ির প্রয়োজন:

gcloud artifacts repositories create code-review-assistant-repo \

--repository-format=docker \

--location=us-central1 \

--description="Docker repository for Code Review Assistant"

তোমার দেখা উচিত:

Created repository [code-review-assistant-repo].

যদি এটি ইতিমধ্যেই বিদ্যমান থাকে (সম্ভবত পূর্ববর্তী প্রচেষ্টা থেকে), তাহলে ঠিক আছে - আপনি একটি ত্রুটি বার্তা দেখতে পাবেন যা আপনি উপেক্ষা করতে পারেন।

ধাপ ৮: IAM অনুমতি প্রদান করুন

# Get your project number

PROJECT_NUMBER=$(gcloud projects describe $GOOGLE_CLOUD_PROJECT \

--format="value(projectNumber)")

# Define the service account

SERVICE_ACCOUNT="${PROJECT_NUMBER}@cloudbuild.gserviceaccount.com"

# Grant necessary roles

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/run.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/iam.serviceAccountUser"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/cloudsql.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/storage.admin"

প্রতিটি কমান্ড আউটপুট দেবে:

Updated IAM policy for project [your-project-id].

তুমি যা অর্জন করেছো

আপনার উৎপাদন কর্মক্ষেত্র এখন সম্পূর্ণরূপে প্রস্তুত:

✅ গুগল ক্লাউড প্রকল্প কনফিগার এবং প্রমাণীকরণ করা হয়েছে

✅ সীমাবদ্ধতা বোঝার জন্য মৌলিক এজেন্ট পরীক্ষিত

✅ কৌশলগত স্থানধারক প্রস্তুত সহ প্রকল্প কোড

✅ ভার্চুয়াল পরিবেশে নির্ভরতা বিচ্ছিন্ন

✅ সকল প্রয়োজনীয় API সক্রিয় করা হয়েছে

✅ স্থাপনার জন্য কন্টেইনার রেজিস্ট্রি প্রস্তুত

✅ IAM অনুমতিগুলি সঠিকভাবে কনফিগার করা হয়েছে

✅ পরিবেশের ভেরিয়েবল সঠিকভাবে সেট করা হয়েছে

এখন আপনি নির্ধারক সরঞ্জাম, রাষ্ট্র ব্যবস্থাপনা এবং সঠিক স্থাপত্যের সাহায্যে একটি বাস্তব AI সিস্টেম তৈরি করতে প্রস্তুত।

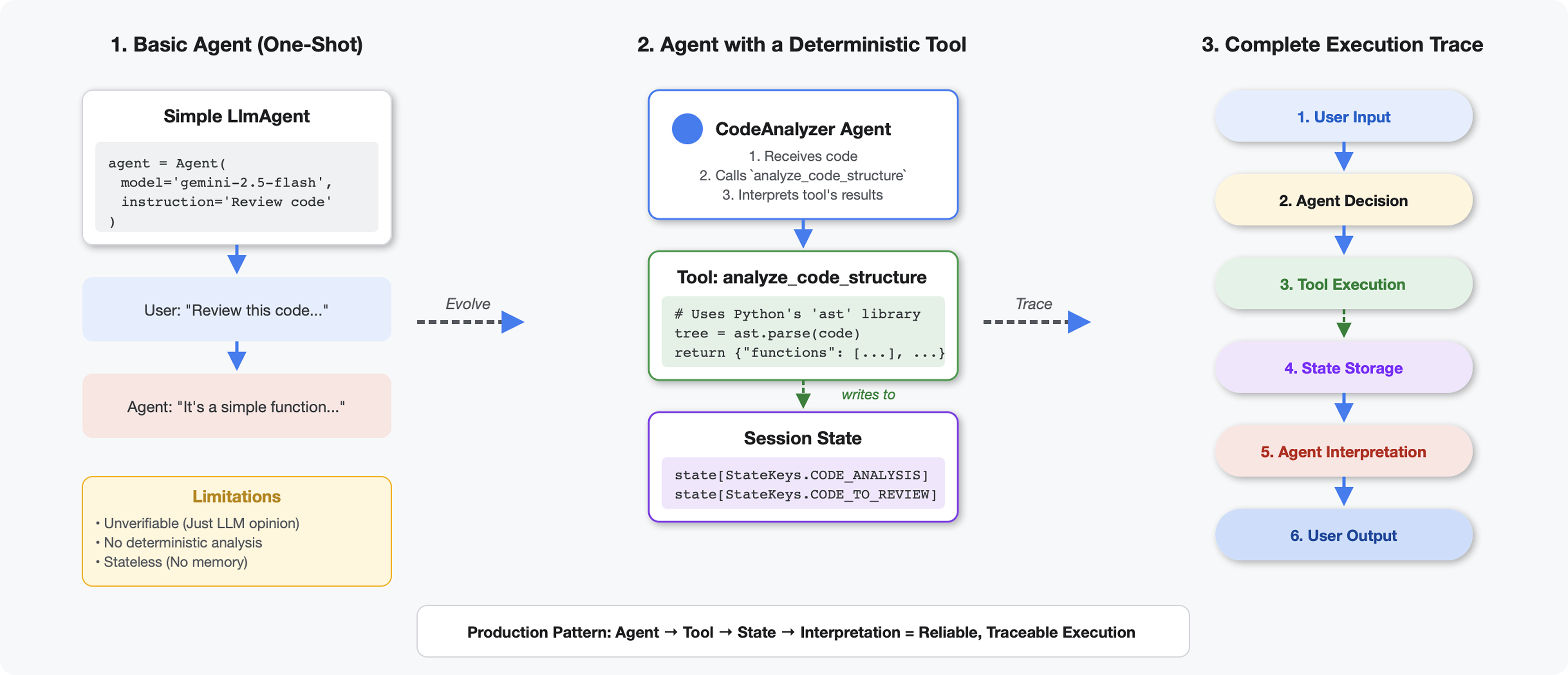

৪. আপনার প্রথম এজেন্ট তৈরি করা

এলএলএম থেকে টুলগুলিকে কী আলাদা করে তোলে

যখন আপনি একটি LLM কে জিজ্ঞাসা করেন "এই কোডে কতগুলি ফাংশন আছে?", এটি প্যাটার্ন ম্যাচিং এবং অনুমান ব্যবহার করে। যখন আপনি একটি টুল ব্যবহার করেন যা Python এর ast.parse() কল করে, তখন এটি প্রকৃত সিনট্যাক্স ট্রি পার্স করে - কোন অনুমান নেই, প্রতিবার একই ফলাফল।

এই বিভাগটি এমন একটি টুল তৈরি করে যা কোড স্ট্রাকচারকে নির্ধারকভাবে বিশ্লেষণ করে, তারপর এটিকে এমন একটি এজেন্টের সাথে সংযুক্ত করে যে জানে কখন এটি ব্যবহার করতে হবে।

ধাপ ১: স্ক্যাফোল্ড বোঝা

তুমি যে কাঠামোটি পূরণ করবে তা পরীক্ষা করে দেখা যাক।

👉 খুলুন

code_review_assistant/tools.py

আপনি analyze_code_structure ফাংশনটি দেখতে পাবেন যেখানে প্লেসহোল্ডার মন্তব্যগুলি চিহ্নিত করবে যেখানে আপনি কোড যুক্ত করবেন। ফাংশনটির ইতিমধ্যেই মৌলিক কাঠামো রয়েছে - আপনি এটি ধাপে ধাপে উন্নত করবেন।

ধাপ ২: স্টেট স্টোরেজ যোগ করুন

স্টেট স্টোরেজ পাইপলাইনে থাকা অন্যান্য এজেন্টদের বিশ্লেষণ পুনরায় না চালিয়েই আপনার টুলের ফলাফল অ্যাক্সেস করার অনুমতি দেয়।

👉 খুঁজুন:

# MODULE_4_STEP_2_ADD_STATE_STORAGE

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

ধাপ ৩: থ্রেড পুলের সাথে অ্যাসিঙ্ক পার্সিং যোগ করুন

আমাদের টুলটিকে অন্যান্য ক্রিয়াকলাপ ব্লক না করে AST পার্স করতে হবে। থ্রেড পুলের সাথে অ্যাসিঙ্ক এক্সিকিউশন যোগ করা যাক।

👉 খুঁজুন:

# MODULE_4_STEP_3_ADD_ASYNC

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

ধাপ ৪: বিস্তৃত তথ্য সংগ্রহ করুন

এবার ক্লাস, আমদানি এবং বিস্তারিত মেট্রিক্স বের করা যাক - একটি সম্পূর্ণ কোড পর্যালোচনার জন্য আমাদের যা যা প্রয়োজন।

👉 খুঁজুন:

# MODULE_4_STEP_4_EXTRACT_DETAILS

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

👉 যাচাই করুন: ফাংশনটি

analyze_code_structure

ভিতরে

tools.py

এর একটি কেন্দ্রীয় অংশ আছে যা দেখতে এরকম:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

👉 এখন নীচে স্ক্রোল করুন

tools.py

এবং খুঁজুন:

# MODULE_4_STEP_4_HELPER_FUNCTION

👉 ঐ একক লাইনটি সম্পূর্ণ সহায়ক ফাংশন দিয়ে প্রতিস্থাপন করুন:

def _extract_code_structure(tree: ast.AST, code: str) -> Dict[str, Any]:

"""

Helper function to extract structural information from AST.

Runs in thread pool for CPU-bound work.

"""

functions = []

classes = []

imports = []

docstrings = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

func_info = {

'name': node.name,

'args': [arg.arg for arg in node.args.args],

'lineno': node.lineno,

'has_docstring': ast.get_docstring(node) is not None,

'is_async': isinstance(node, ast.AsyncFunctionDef),

'decorators': [d.id for d in node.decorator_list

if isinstance(d, ast.Name)]

}

functions.append(func_info)

if func_info['has_docstring']:

docstrings.append(f"{node.name}: {ast.get_docstring(node)[:50]}...")

elif isinstance(node, ast.ClassDef):

methods = []

for item in node.body:

if isinstance(item, ast.FunctionDef):

methods.append(item.name)

class_info = {

'name': node.name,

'lineno': node.lineno,

'methods': methods,

'has_docstring': ast.get_docstring(node) is not None,

'base_classes': [base.id for base in node.bases

if isinstance(base, ast.Name)]

}

classes.append(class_info)

elif isinstance(node, ast.Import):

for alias in node.names:

imports.append({

'module': alias.name,

'alias': alias.asname,

'type': 'import'

})

elif isinstance(node, ast.ImportFrom):

imports.append({

'module': node.module or '',

'names': [alias.name for alias in node.names],

'type': 'from_import',

'level': node.level

})

return {

'functions': functions,

'classes': classes,

'imports': imports,

'docstrings': docstrings,

'metrics': {

'line_count': len(code.splitlines()),

'function_count': len(functions),

'class_count': len(classes),

'import_count': len(imports),

'has_main': any(f['name'] == 'main' for f in functions),

'has_if_main': '__main__' in code,

'avg_function_length': _calculate_avg_function_length(tree)

}

}

def _calculate_avg_function_length(tree: ast.AST) -> float:

"""Calculate average function length in lines."""

function_lengths = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

if hasattr(node, 'end_lineno') and hasattr(node, 'lineno'):

length = node.end_lineno - node.lineno + 1

function_lengths.append(length)

if function_lengths:

return sum(function_lengths) / len(function_lengths)

return 0.0

ধাপ ৫: একজন এজেন্টের সাথে সংযোগ স্থাপন করুন

এখন আমরা টুলটিকে এমন একজন এজেন্টের সাথে সংযুক্ত করি যে জানে কখন এটি ব্যবহার করতে হবে এবং এর ফলাফল কীভাবে ব্যাখ্যা করতে হবে।

👉 খুলুন

code_review_assistant/sub_agents/review_pipeline/code_analyzer.py

👉 খুঁজুন:

# MODULE_4_STEP_5_CREATE_AGENT

👉 ঐ একক লাইনটি সম্পূর্ণ প্রোডাকশন এজেন্ট দিয়ে প্রতিস্থাপন করুন:

code_analyzer_agent = Agent(

name="CodeAnalyzer",

model=config.worker_model,

description="Analyzes Python code structure and identifies components",

instruction="""You are a code analysis specialist responsible for understanding code structure.

Your task:

1. Take the code submitted by the user (it will be provided in the user message)

2. Use the analyze_code_structure tool to parse and analyze it

3. Pass the EXACT code to your tool - do not modify, fix, or "improve" it

4. Identify all functions, classes, imports, and structural patterns

5. Note any syntax errors or structural issues

6. Store the analysis in state for other agents to use

CRITICAL:

- Pass the code EXACTLY as provided to the analyze_code_structure tool

- Do not fix syntax errors, even if obvious

- Do not add missing imports or fix indentation

- The goal is to analyze what IS there, not what SHOULD be there

When calling the tool, pass the code as a string to the 'code' parameter.

If the analysis fails due to syntax errors, clearly report the error location and type.

Provide a clear summary including:

- Number of functions and classes found

- Key structural observations

- Any syntax errors or issues detected

- Overall code organization assessment""",

tools=[FunctionTool(func=analyze_code_structure)],

output_key="structure_analysis_summary"

)

আপনার কোড বিশ্লেষক পরীক্ষা করুন

এখন আপনার বিশ্লেষক সঠিকভাবে কাজ করছে কিনা তা যাচাই করুন।

👉 পরীক্ষার স্ক্রিপ্টটি চালান:

python tests/test_code_analyzer.py

টেস্ট স্ক্রিপ্টটি স্বয়ংক্রিয়ভাবে python-dotenv ব্যবহার করে আপনার .env ফাইল থেকে কনফিগারেশন লোড করে, তাই কোনও ম্যানুয়াল এনভায়রনমেন্ট ভেরিয়েবল সেটআপের প্রয়োজন হয় না।

প্রত্যাশিত আউটপুট:

INFO:code_review_assistant.config:Code Review Assistant Configuration Loaded:

INFO:code_review_assistant.config: - GCP Project: your-project-id

INFO:code_review_assistant.config: - Artifact Bucket: gs://your-project-artifacts

INFO:code_review_assistant.config: - Models: worker=gemini-2.5-flash, critic=gemini-2.5-pro

Testing code analyzer...

INFO:code_review_assistant.tools:Tool: Analysis complete - 2 functions, 1 classes

=== Analyzer Response ===

The analysis of the provided code shows the following:

* **Functions Found:** 2

* `add(a, b)`: A global function at line 2.

* `multiply(self, x, y)`: A method within the `Calculator` class.

* **Classes Found:** 1

* `Calculator`: A class defined at line 5. Contains one method, `multiply`.

* **Imports:** 0

* **Structural Patterns:** The code defines one global function and one class

with a single method. Both are simple, each with a single return statement.

* **Syntax Errors/Issues:** No syntax errors detected.

* **Overall Code Organization:** The code is well-organized for its small size,

clearly defining a function and a class with a method.

এইমাত্র কী ঘটেছে:

- পরীক্ষার স্ক্রিপ্টটি আপনার

.envকনফিগারেশনটি স্বয়ংক্রিয়ভাবে লোড করেছে। - আপনার

analyze_code_structure()টুলটি পাইথনের AST ব্যবহার করে কোডটি পার্স করেছে। -

_extract_code_structure()সাহায্যকারী ফাংশন, ক্লাস এবং মেট্রিক্স বের করে -

StateKeysধ্রুবক ব্যবহার করে ফলাফল সেশন অবস্থায় সংরক্ষণ করা হয়েছিল। - কোড বিশ্লেষক এজেন্ট ফলাফল ব্যাখ্যা করেছেন এবং একটি সারসংক্ষেপ প্রদান করেছেন

সমস্যা সমাধান:

- "'code_review_assistant' নামে কোনও মডিউল নেই" : প্রোজেক্ট রুট থেকে

pip install -e .চালান। - "কী ইনপুট আর্গুমেন্ট মিসিং" : আপনার

.envGOOGLE_CLOUD_PROJECT,GOOGLE_CLOUD_LOCATIONএবংGOOGLE_GENAI_USE_VERTEXAI=trueআছে কিনা তা যাচাই করুন।

তুমি যা তৈরি করেছো

এখন আপনার কাছে একটি প্রোডাকশন-রেডি কোড বিশ্লেষক আছে যা:

✅ প্রকৃত পাইথন AST পার্স করে - নির্ধারক, প্যাটার্ন ম্যাচিং নয়

✅ ফলাফলগুলি রাজ্যে সংরক্ষণ করে - অন্যান্য এজেন্টরা বিশ্লেষণ অ্যাক্সেস করতে পারে

✅ অ্যাসিঙ্ক্রোনাসভাবে চলে - অন্যান্য টুল ব্লক করে না

✅ বিস্তৃত তথ্য বের করে - ফাংশন, ক্লাস, আমদানি, মেট্রিক্স

✅ ত্রুটিগুলি সুন্দরভাবে পরিচালনা করে - লাইন নম্বর সহ বাক্য গঠন ত্রুটিগুলি রিপোর্ট করে

✅ একজন এজেন্টের সাথে সংযোগ স্থাপন করে - এলএলএম জানে কখন এবং কীভাবে এটি ব্যবহার করতে হবে

মূল ধারণাগুলি আয়ত্ত করা হয়েছে

সরঞ্জাম বনাম এজেন্ট:

- সরঞ্জামগুলি নির্ণায়ক কাজ করে (AST বিশ্লেষণ)

- এজেন্টরা কখন সরঞ্জাম ব্যবহার করবেন এবং ফলাফল ব্যাখ্যা করবেন তা নির্ধারণ করেন

রিটার্ন মান বনাম অবস্থা:

- প্রত্যাবর্তন: এলএলএম তাৎক্ষণিকভাবে কী দেখে

- অবস্থা: অন্যান্য এজেন্টদের জন্য কী টিকে থাকে

স্টেট কী ধ্রুবক:

- মাল্টি-এজেন্ট সিস্টেমে টাইপিং ভুল প্রতিরোধ করুন

- এজেন্টদের মধ্যে চুক্তি হিসেবে কাজ করুন

- এজেন্টরা যখন ডেটা শেয়ার করে তখন গুরুত্বপূর্ণ

অ্যাসিঙ্ক + থ্রেড পুল:

-

async defটুলগুলিকে এক্সিকিউশন থামানোর অনুমতি দেয় - থ্রেড পুলগুলি ব্যাকগ্রাউন্ডে CPU-বাউন্ড কাজ চালায়

- একসাথে তারা ইভেন্ট লুপকে প্রতিক্রিয়াশীল রাখে

সাহায্যকারী ফাংশন:

- অ্যাসিঙ্ক টুল থেকে সিঙ্ক হেল্পার আলাদা করুন

- কোডকে পরীক্ষাযোগ্য এবং পুনঃব্যবহারযোগ্য করে তোলে

এজেন্ট নির্দেশাবলী:

- বিস্তারিত নির্দেশাবলী সাধারণ এলএলএম ভুল প্রতিরোধ করে

- কী করা উচিত নয় সে সম্পর্কে স্পষ্ট (কোড ঠিক করবেন না)

- ধারাবাহিকতার জন্য কর্মপ্রবাহের ধাপগুলি পরিষ্কার করুন

এরপর কি?

মডিউল ৫-এ, আপনি যোগ করবেন:

- স্টাইল চেকার যা রাজ্য থেকে কোড পড়ে

- টেস্ট রানার যা আসলে পরীক্ষা চালায়

- সমস্ত বিশ্লেষণকে একত্রিত করে প্রতিক্রিয়া সংশ্লেষক

আপনি দেখতে পাবেন কিভাবে state একটি ক্রমিক পাইপলাইনের মধ্য দিয়ে প্রবাহিত হয় এবং একাধিক এজেন্ট একই ডেটা পড়লে এবং লিখলে ধ্রুবক প্যাটার্ন কেন গুরুত্বপূর্ণ।

৫. একটি পাইপলাইন তৈরি: একাধিক এজেন্ট একসাথে কাজ করছে

ভূমিকা

মডিউল ৪-এ, আপনি একটি একক এজেন্ট তৈরি করেছেন যা কোড কাঠামো বিশ্লেষণ করে। কিন্তু ব্যাপক কোড পর্যালোচনার জন্য কেবল বিশ্লেষণের চেয়েও বেশি কিছু প্রয়োজন - আপনার স্টাইল চেকিং, পরীক্ষা সম্পাদন এবং বুদ্ধিমান প্রতিক্রিয়া সংশ্লেষণ প্রয়োজন।

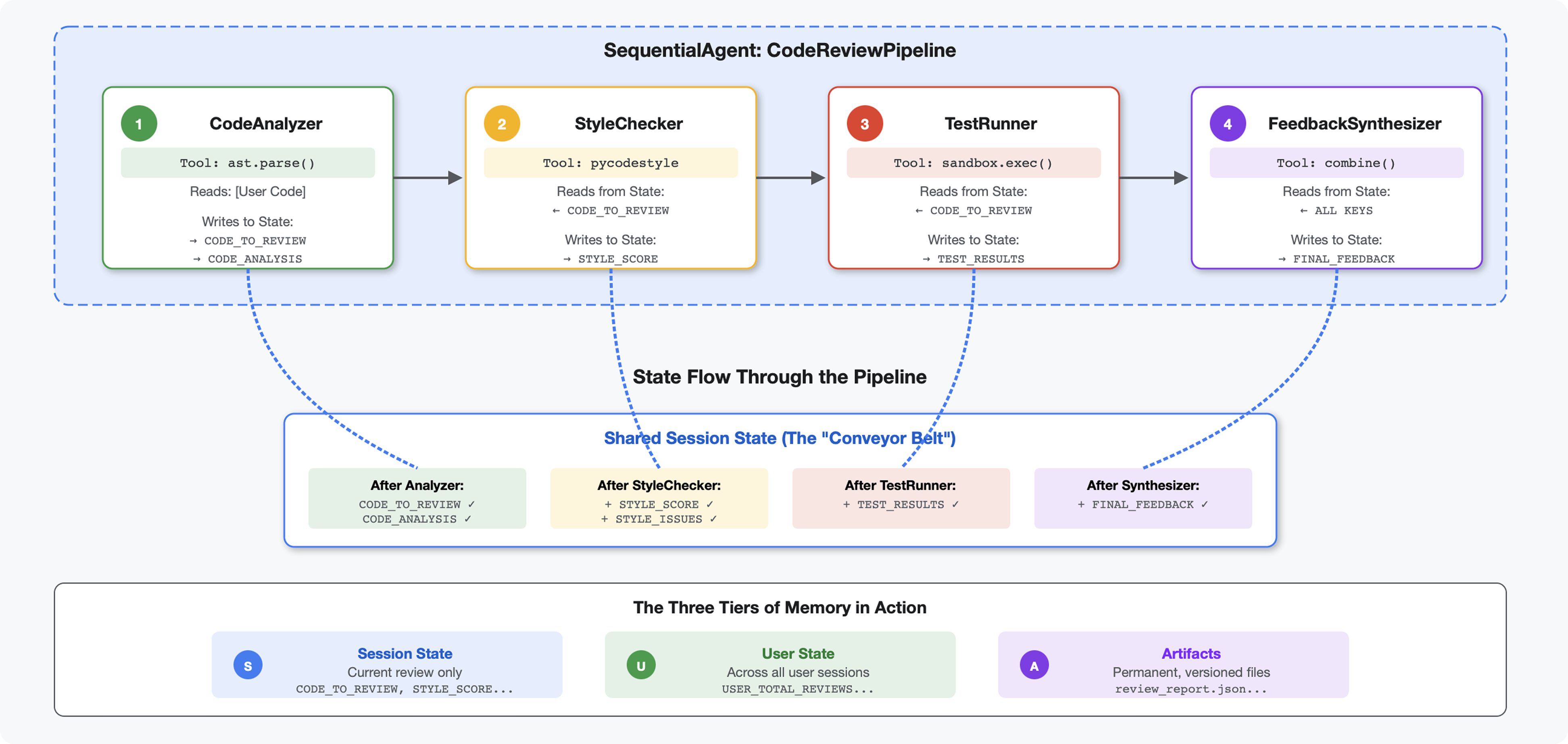

এই মডিউলটি ৪টি এজেন্টের একটি পাইপলাইন তৈরি করে যা ধারাবাহিকভাবে একসাথে কাজ করে, প্রতিটি বিশেষায়িত বিশ্লেষণে অবদান রাখে:

- কোড বিশ্লেষক (মডিউল ৪ থেকে) - কাঠামো বিশ্লেষণ করে

- স্টাইল চেকার - স্টাইল লঙ্ঘন সনাক্ত করে

- টেস্ট রানার - পরীক্ষাগুলি সম্পাদন করে এবং যাচাই করে

- প্রতিক্রিয়া সংশ্লেষক - সবকিছুকে কার্যকর প্রতিক্রিয়ায় একত্রিত করে

মূল ধারণা: যোগাযোগের মাধ্যম হিসেবে রাষ্ট্র। প্রতিটি এজেন্ট পূর্ববর্তী এজেন্টরা যা লিখেছিল তা পড়ে, নিজস্ব বিশ্লেষণ যোগ করে এবং সমৃদ্ধ অবস্থা পরবর্তী এজেন্টের কাছে প্রেরণ করে। একাধিক এজেন্ট যখন ডেটা ভাগ করে তখন মডিউল ৪ এর ধ্রুবক প্যাটার্নটি গুরুত্বপূর্ণ হয়ে ওঠে।

আপনি কী তৈরি করবেন তার পূর্বরূপ: অগোছালো কোড জমা দিন → ৪টি এজেন্টের মাধ্যমে অবস্থা প্রবাহ দেখুন → অতীতের প্যাটার্নের উপর ভিত্তি করে ব্যক্তিগতকৃত প্রতিক্রিয়া সহ ব্যাপক প্রতিবেদন পান।

ধাপ ১: স্টাইল চেকার টুল + এজেন্ট যোগ করুন

স্টাইল চেকার পাইকোডস্টাইল ব্যবহার করে PEP 8 লঙ্ঘন সনাক্ত করে - এটি একটি নির্ধারক লিন্টার, LLM-ভিত্তিক ব্যাখ্যা নয়।

স্টাইল চেকিং টুল যোগ করুন

👉 খুলুন

code_review_assistant/tools.py

👉 খুঁজুন:

# MODULE_5_STEP_1_STYLE_CHECKER_TOOL

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

async def check_code_style(code: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Checks code style compliance using pycodestyle (PEP 8).

Args:

code: Python source code to check (or will retrieve from state)

tool_context: ADK tool context

Returns:

Dictionary containing style score and issues

"""

logger.info("Tool: Checking code style...")

try:

# Retrieve code from state if not provided

if not code:

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

if not code:

return {

"status": "error",

"message": "No code provided or found in state"

}

# Run style check in thread pool

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

result = await loop.run_in_executor(

executor, _perform_style_check, code

)

# Store results in state

tool_context.state[StateKeys.STYLE_SCORE] = result['score']

tool_context.state[StateKeys.STYLE_ISSUES] = result['issues']

tool_context.state[StateKeys.STYLE_ISSUE_COUNT] = result['issue_count']

logger.info(f"Tool: Style check complete - Score: {result['score']}/100, "

f"Issues: {result['issue_count']}")

return result

except Exception as e:

error_msg = f"Style check failed: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Set default values on error

tool_context.state[StateKeys.STYLE_SCORE] = 0

tool_context.state[StateKeys.STYLE_ISSUES] = []

return {

"status": "error",

"message": error_msg,

"score": 0

}

👉 এখন ফাইলের শেষ পর্যন্ত স্ক্রোল করুন এবং খুঁজুন:

# MODULE_5_STEP_1_STYLE_HELPERS

👉 ঐ একক লাইনটি হেল্পার ফাংশন দিয়ে প্রতিস্থাপন করুন:

def _perform_style_check(code: str) -> Dict[str, Any]:

"""Helper to perform style check in thread pool."""

import io

import sys

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as tmp:

tmp.write(code)

tmp_path = tmp.name

try:

# Capture stdout to get pycodestyle output

old_stdout = sys.stdout

sys.stdout = captured_output = io.StringIO()

style_guide = pycodestyle.StyleGuide(

quiet=False, # We want output

max_line_length=100,

ignore=['E501', 'W503']

)

result = style_guide.check_files([tmp_path])

# Restore stdout

sys.stdout = old_stdout

# Parse captured output

output = captured_output.getvalue()

issues = []

for line in output.strip().split('\n'):

if line and ':' in line:

parts = line.split(':', 4)

if len(parts) >= 4:

try:

issues.append({

'line': int(parts[1]),

'column': int(parts[2]),

'code': parts[3].split()[0] if len(parts) > 3 else 'E000',

'message': parts[3].strip() if len(parts) > 3 else 'Unknown error'

})

except (ValueError, IndexError):

pass

# Add naming convention checks

try:

tree = ast.parse(code)

naming_issues = _check_naming_conventions(tree)

issues.extend(naming_issues)

except SyntaxError:

pass # Syntax errors will be caught elsewhere

# Calculate weighted score

score = _calculate_style_score(issues)

return {

"status": "success",

"score": score,

"issue_count": len(issues),

"issues": issues[:10], # First 10 issues

"summary": f"Style score: {score}/100 with {len(issues)} violations"

}

finally:

if os.path.exists(tmp_path):

os.unlink(tmp_path)

def _check_naming_conventions(tree: ast.AST) -> List[Dict[str, Any]]:

"""Check PEP 8 naming conventions."""

naming_issues = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

# Skip private/protected methods and __main__

if not node.name.startswith('_') and node.name != node.name.lower():

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N802',

'message': f"N802 function name '{node.name}' should be lowercase"

})

elif isinstance(node, ast.ClassDef):

# Check if class name follows CapWords convention

if not node.name[0].isupper() or '_' in node.name:

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N801',

'message': f"N801 class name '{node.name}' should use CapWords convention"

})

return naming_issues

def _calculate_style_score(issues: List[Dict[str, Any]]) -> int:

"""Calculate weighted style score based on violation severity."""

if not issues:

return 100

# Define weights by error type

weights = {

'E1': 10, # Indentation errors

'E2': 3, # Whitespace errors

'E3': 5, # Blank line errors

'E4': 8, # Import errors

'E5': 5, # Line length

'E7': 7, # Statement errors

'E9': 10, # Syntax errors

'W2': 2, # Whitespace warnings

'W3': 2, # Blank line warnings

'W5': 3, # Line break warnings

'N8': 7, # Naming conventions

}

total_deduction = 0

for issue in issues:

code_prefix = issue['code'][:2] if len(issue['code']) >= 2 else 'E2'

weight = weights.get(code_prefix, 3)

total_deduction += weight

# Cap at 100 points deduction

return max(0, 100 - min(total_deduction, 100))

স্টাইল চেকার এজেন্ট যোগ করুন

👉 খুলুন

code_review_assistant/sub_agents/review_pipeline/style_checker.py

👉 খুঁজুন:

# MODULE_5_STEP_1_INSTRUCTION_PROVIDER

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

async def style_checker_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are a code style expert focused on PEP 8 compliance.

Your task:

1. Use the check_code_style tool to validate PEP 8 compliance

2. The tool will retrieve the ORIGINAL code from state automatically

3. Report violations exactly as found

4. Present the results clearly and confidently

CRITICAL:

- The tool checks the code EXACTLY as provided by the user

- Do not suggest the code was modified or fixed

- Report actual violations found in the original code

- If there are style issues, they should be reported honestly

Call the check_code_style tool with an empty string for the code parameter,

as the tool will retrieve the code from state automatically.

When presenting results based on what the tool returns:

- State the exact score from the tool results

- If score >= 90: "Excellent style compliance!"

- If score 70-89: "Good style with minor improvements needed"

- If score 50-69: "Style needs attention"

- If score < 50: "Significant style improvements needed"

List the specific violations found (the tool will provide these):

- Show line numbers, error codes, and messages

- Focus on the top 10 most important issues

Previous analysis: {structure_analysis_summary}

Format your response as:

## Style Analysis Results

- Style Score: [exact score]/100

- Total Issues: [count]

- Assessment: [your assessment based on score]

## Top Style Issues

[List issues with line numbers and descriptions]

## Recommendations

[Specific fixes for the most critical issues]"""

return await instructions_utils.inject_session_state(template, context)

👉 খুঁজুন:

# MODULE_5_STEP_1_STYLE_CHECKER_AGENT

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

style_checker_agent = Agent(

name="StyleChecker",

model=config.worker_model,

description="Checks Python code style against PEP 8 guidelines",

instruction=style_checker_instruction_provider,

tools=[FunctionTool(func=check_code_style)],

output_key="style_check_summary"

)

ধাপ ২: টেস্ট রানার এজেন্ট যোগ করুন

টেস্ট রানারটি ব্যাপক পরীক্ষা তৈরি করে এবং বিল্ট-ইন কোড এক্সিকিউটর ব্যবহার করে সেগুলি কার্যকর করে।

👉 খুলুন

code_review_assistant/sub_agents/review_pipeline/test_runner.py

👉 খুঁজুন:

# MODULE_5_STEP_2_INSTRUCTION_PROVIDER

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

async def test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects the code_to_review directly."""

template = """You are a testing specialist who creates and runs tests for Python code.

THE CODE TO TEST IS:

{code_to_review}

YOUR TASK:

1. Understand what the function appears to do based on its name and structure

2. Generate comprehensive tests (15-20 test cases)

3. Execute the tests using your code executor

4. Analyze results to identify bugs vs expected behavior

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Test with the most natural interpretation first

- When something fails, determine if it's a bug or unusual design

- Test edge cases, boundaries, and error scenarios

- Document any surprising behavior

Execute your tests and output ONLY valid JSON with this structure:

- "test_summary": object with "total_tests_run", "tests_passed", "tests_failed", "tests_with_errors", "critical_issues_found"

- "critical_issues": array of objects, each with "type", "description", "example_input", "expected_behavior", "actual_behavior", "severity"

- "test_categories": object with "basic_functionality", "edge_cases", "error_handling" (each containing "passed", "failed", "errors" counts)

- "function_behavior": object with "apparent_purpose", "actual_interface", "unexpected_requirements"

- "verdict": object with "status" (WORKING/BUGGY/BROKEN), "confidence" (high/medium/low), "recommendation"

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 খুঁজুন:

# MODULE_5_STEP_2_TEST_RUNNER_AGENT

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

test_runner_agent = Agent(

name="TestRunner",

model=config.critic_model,

description="Generates and runs tests for Python code using safe code execution",

instruction=test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="test_execution_summary"

)

ধাপ ৩: ক্রস-সেশন লার্নিংয়ের জন্য স্মৃতিশক্তি বোঝা

ফিডব্যাক সিন্থেসাইজার তৈরি করার আগে, আপনাকে অবস্থা এবং মেমোরির মধ্যে পার্থক্য বুঝতে হবে - দুটি ভিন্ন উদ্দেশ্যে দুটি ভিন্ন স্টোরেজ প্রক্রিয়া।

অবস্থা বনাম স্মৃতি: মূল পার্থক্য

কোড পর্যালোচনা থেকে একটি সুনির্দিষ্ট উদাহরণ দিয়ে স্পষ্ট করা যাক:

রাজ্য (শুধুমাত্র বর্তমান অধিবেশন):

# Data from THIS review session

tool_context.state[StateKeys.STYLE_ISSUES] = [

{"line": 5, "code": "E231", "message": "missing whitespace"},

{"line": 12, "code": "E701", "message": "multiple statements"}

]

- পরিধি: শুধুমাত্র এই কথোপকথনটি

- উদ্দেশ্য: বর্তমান পাইপলাইনে এজেন্টদের মধ্যে ডেটা প্রেরণ করা

- এতে থাকে:

Sessionঅবজেক্ট - আজীবন: সেশন শেষ হলে বাতিল করা হবে

স্মৃতি (সমস্ত অতীতের সেশন):

# Learned from 50 previous reviews

"User frequently forgets docstrings on helper functions"

"User tends to write long functions (avg 45 lines)"

"User improved error handling after feedback in session #23"

- ব্যাপ্তি: এই ব্যবহারকারীর জন্য অতীতের সমস্ত সেশন

- উদ্দেশ্য: নিদর্শন শেখা, ব্যক্তিগতকৃত প্রতিক্রিয়া প্রদান করা

- বসবাস করে:

MemoryService - জীবনকাল: সেশন জুড়ে থাকে, অনুসন্ধানযোগ্য

প্রতিক্রিয়ার জন্য উভয়েরই প্রয়োজন কেন:

কল্পনা করুন যে সিন্থেসাইজার প্রতিক্রিয়া তৈরি করছে:

শুধুমাত্র রাজ্য ব্যবহার করা হচ্ছে (বর্তমান পর্যালোচনা):

"Function `calculate_total` has no docstring."

জেনেরিক, যান্ত্রিক প্রতিক্রিয়া।

অবস্থা + মেমোরি (বর্তমান + অতীতের ধরণ) ব্যবহার করে:

"Function `calculate_total` has no docstring. This is the 4th review

where helper functions lacked documentation. Consider adding docstrings

as you write functions, not afterwards - you mentioned in our last

session that you find it easier that way."

সময়ের সাথে সাথে ব্যক্তিগতকৃত, প্রাসঙ্গিক, রেফারেন্সের উন্নতি।

উৎপাদন স্থাপনার জন্য, আপনার কাছে বিকল্প রয়েছে :

বিকল্প ১: VertexAiMemoryBankService (অ্যাডভান্সড)

- এটি কী করে: কথোপকথন থেকে অর্থপূর্ণ তথ্যের LLM-চালিত নিষ্কাশন

- অনুসন্ধান: শব্দার্থিক অনুসন্ধান (শুধু কীওয়ার্ড নয়, অর্থ বোঝে)

- মেমোরি ম্যানেজমেন্ট: সময়ের সাথে সাথে স্বয়ংক্রিয়ভাবে স্মৃতিগুলিকে একীভূত এবং আপডেট করে

- প্রয়োজন: গুগল ক্লাউড প্রজেক্ট + এজেন্ট ইঞ্জিন সেটআপ

- ব্যবহার করুন যখন: আপনি পরিশীলিত, বিকশিত, ব্যক্তিগতকৃত স্মৃতি চান

- উদাহরণ: "ব্যবহারকারী কার্যকরী প্রোগ্রামিং পছন্দ করেন" (কোড স্টাইল সম্পর্কে ১০টি কথোপকথন থেকে নেওয়া)

বিকল্প ২: InMemoryMemoryService + স্থায়ী সেশন দিয়ে চালিয়ে যান

- এটি কী করে: কীওয়ার্ড অনুসন্ধানের জন্য সম্পূর্ণ কথোপকথনের ইতিহাস সংরক্ষণ করে

- অনুসন্ধান: পূর্ববর্তী সেশন জুড়ে মৌলিক কীওয়ার্ড মিল

- মেমোরি ম্যানেজমেন্ট: আপনি কী সংরক্ষণ করা হবে তা নিয়ন্ত্রণ করতে পারেন (

add_session_to_memoryএর মাধ্যমে) - প্রয়োজন: শুধুমাত্র একটি স্থায়ী

SessionService(যেমনVertexAiSessionServiceবাDatabaseSessionService) - যখন ব্যবহার করুন: LLM প্রক্রিয়াকরণ ছাড়াই আপনার অতীতের কথোপকথনগুলিতে সহজ অনুসন্ধানের প্রয়োজন হবে

- উদাহরণ: "docstring" অনুসন্ধান করলে সেই শব্দটি উল্লেখ করে এমন সমস্ত সেশন ফেরত আসে

স্মৃতিশক্তি কীভাবে জনবহুল হয়

প্রতিটি কোড পর্যালোচনা সম্পন্ন হওয়ার পর:

# At the end of a session (typically in your application code)

await memory_service.add_session_to_memory(session)

কি হয়:

- InMemoryMemoryService: কীওয়ার্ড অনুসন্ধানের জন্য সম্পূর্ণ সেশন ইভেন্ট সংরক্ষণ করে।

- ভার্টেক্সএআইমেমোরিব্যাংকসার্ভিস: এলএলএম গুরুত্বপূর্ণ তথ্য বের করে, বিদ্যমান স্মৃতির সাথে একত্রিত করে

ভবিষ্যতের সেশনগুলি তখন জিজ্ঞাসা করতে পারে:

# In a tool, search for relevant past feedback

results = tool_context.search_memory("feedback about docstrings")

ধাপ ৪: ফিডব্যাক সিনথেসাইজার টুলস এবং এজেন্ট যোগ করুন

ফিডব্যাক সিন্থেসাইজার হল পাইপলাইনের সবচেয়ে পরিশীলিত এজেন্ট। এটি তিনটি টুল তৈরি করে, গতিশীল নির্দেশাবলী ব্যবহার করে এবং অবস্থা, স্মৃতি এবং শিল্পকর্মগুলিকে একত্রিত করে।

তিনটি সিনথেসাইজার টুল যোগ করুন

👉 খুলুন

code_review_assistant/tools.py

👉 খুঁজুন:

# MODULE_5_STEP_4_SEARCH_PAST_FEEDBACK

👉 টুল ১ - মেমোরি সার্চ (প্রোডাকশন ভার্সন) দিয়ে প্রতিস্থাপন করুন:

async def search_past_feedback(developer_id: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Search for past feedback in memory service.

Args:

developer_id: ID of the developer (defaults to "default_user")

tool_context: ADK tool context with potential memory service access

Returns:

Dictionary containing feedback search results

"""

logger.info(f"Tool: Searching for past feedback for developer {developer_id}...")

try:

# Default developer ID if not provided

if not developer_id:

developer_id = tool_context.state.get(StateKeys.USER_ID, 'default_user')

# Check if memory service is available

if hasattr(tool_context, 'search_memory'):

try:

# Perform structured searches

queries = [

f"developer:{developer_id} code review feedback",

f"developer:{developer_id} common issues",

f"developer:{developer_id} improvements"

]

all_feedback = []

patterns = {

'common_issues': [],

'improvements': [],

'strengths': []

}

for query in queries:

search_result = await tool_context.search_memory(query)

if search_result and hasattr(search_result, 'memories'):

for memory in search_result.memories[:5]:

memory_text = memory.text if hasattr(memory, 'text') else str(memory)

all_feedback.append(memory_text)

# Extract patterns

if 'style' in memory_text.lower():

patterns['common_issues'].append('style compliance')

if 'improved' in memory_text.lower():

patterns['improvements'].append('showing improvement')

if 'excellent' in memory_text.lower():

patterns['strengths'].append('consistent quality')

# Store in state

tool_context.state[StateKeys.PAST_FEEDBACK] = all_feedback

tool_context.state[StateKeys.FEEDBACK_PATTERNS] = patterns

logger.info(f"Tool: Found {len(all_feedback)} past feedback items")

return {

"status": "success",

"feedback_found": True,

"count": len(all_feedback),

"summary": " | ".join(all_feedback[:3]) if all_feedback else "No feedback",

"patterns": patterns

}

except Exception as e:

logger.warning(f"Tool: Memory search error: {e}")

# Fallback: Check state for cached feedback

cached_feedback = tool_context.state.get(StateKeys.USER_PAST_FEEDBACK_CACHE, [])

if cached_feedback:

tool_context.state[StateKeys.PAST_FEEDBACK] = cached_feedback

return {

"status": "success",

"feedback_found": True,

"count": len(cached_feedback),

"summary": "Using cached feedback",

"patterns": {}

}

# No feedback found

tool_context.state[StateKeys.PAST_FEEDBACK] = []

logger.info("Tool: No past feedback found")

return {

"status": "success",

"feedback_found": False,

"message": "No past feedback available - this appears to be a first submission",

"patterns": {}

}

except Exception as e:

error_msg = f"Feedback search error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

tool_context.state[StateKeys.PAST_FEEDBACK] = []

return {

"status": "error",

"message": error_msg,

"feedback_found": False

}

👉 খুঁজুন:

# MODULE_5_STEP_4_UPDATE_GRADING_PROGRESS

👉 টুল 2 - গ্রেডিং ট্র্যাকার (প্রোডাকশন ভার্সন) দিয়ে প্রতিস্থাপন করুন:

async def update_grading_progress(tool_context: ToolContext) -> Dict[str, Any]:

"""

Updates grading progress counters and metrics in state.

"""

logger.info("Tool: Updating grading progress...")

try:

current_time = datetime.now().isoformat()

# Build all state changes

state_updates = {}

# Temporary (invocation-level) state

state_updates[StateKeys.TEMP_PROCESSING_TIMESTAMP] = current_time

# Session-level state

attempts = tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 0) + 1

state_updates[StateKeys.GRADING_ATTEMPTS] = attempts

state_updates[StateKeys.LAST_GRADING_TIME] = current_time

# User-level persistent state

lifetime_submissions = tool_context.state.get(StateKeys.USER_TOTAL_SUBMISSIONS, 0) + 1

state_updates[StateKeys.USER_TOTAL_SUBMISSIONS] = lifetime_submissions

state_updates[StateKeys.USER_LAST_SUBMISSION_TIME] = current_time

# Calculate improvement metrics

current_style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

last_style_score = tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

score_improvement = current_style_score - last_style_score

state_updates[StateKeys.USER_LAST_STYLE_SCORE] = current_style_score

state_updates[StateKeys.SCORE_IMPROVEMENT] = score_improvement

# Track test results if available

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

if test_results and test_results.get('test_summary', {}).get('total_tests_run', 0) > 0:

summary = test_results['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

pass_rate = (passed / total) * 100

state_updates[StateKeys.USER_LAST_TEST_PASS_RATE] = pass_rate

# Apply all updates atomically

for key, value in state_updates.items():

tool_context.state[key] = value

logger.info(f"Tool: Progress updated - Attempt #{attempts}, "

f"Lifetime: {lifetime_submissions}")

return {

"status": "success",

"session_attempts": attempts,

"lifetime_submissions": lifetime_submissions,

"timestamp": current_time,

"improvement": {

"style_score_change": score_improvement,

"direction": "improved" if score_improvement > 0 else "declined"

},

"summary": f"Attempt #{attempts} recorded, {lifetime_submissions} total submissions"

}

except Exception as e:

error_msg = f"Progress update error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

return {

"status": "error",

"message": error_msg

}

👉 খুঁজুন:

# MODULE_5_STEP_4_SAVE_GRADING_REPORT

👉 টুল ৩ দিয়ে প্রতিস্থাপন করুন - আর্টিফ্যাক্ট সেভার (প্রোডাকশন ভার্সন):

async def save_grading_report(feedback_text: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Saves a detailed grading report as an artifact.

Args:

feedback_text: The feedback text to include in the report

tool_context: ADK tool context for state management

Returns:

Dictionary containing save status and details

"""

logger.info("Tool: Saving grading report...")

try:

# Gather all relevant data from state

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

analysis = tool_context.state.get(StateKeys.CODE_ANALYSIS, {})

style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

style_issues = tool_context.state.get(StateKeys.STYLE_ISSUES, [])

# Get test results

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

timestamp = datetime.now().isoformat()

# Create comprehensive report dictionary

report = {

'timestamp': timestamp,

'grading_attempt': tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 1),

'code': {

'content': code,

'line_count': len(code.splitlines()),

'hash': hashlib.md5(code.encode()).hexdigest()

},

'analysis': analysis,

'style': {

'score': style_score,

'issues': style_issues[:5] # First 5 issues

},

'tests': test_results,

'feedback': feedback_text,

'improvements': {

'score_change': tool_context.state.get(StateKeys.SCORE_IMPROVEMENT, 0),

'from_last_score': tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

}

}

# Convert report to JSON string

report_json = json.dumps(report, indent=2)

report_part = types.Part.from_text(text=report_json)

# Try to save as artifact if the service is available

if hasattr(tool_context, 'save_artifact'):

try:

# Generate filename with timestamp (replace colons for filesystem compatibility)

filename = f"grading_report_{timestamp.replace(':', '-')}.json"

# Save the main report

version = await tool_context.save_artifact(filename, report_part)

# Also save a "latest" version for easy access

await tool_context.save_artifact("latest_grading_report.json", report_part)

logger.info(f"Tool: Report saved as {filename} (version {version})")

# Store report in state as well for redundancy

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

return {

"status": "success",

"artifact_saved": True,

"filename": filename,

"version": str(version),

"size": len(report_json),

"summary": f"Report saved as {filename}"

}

except Exception as artifact_error:

logger.warning(f"Artifact service error: {artifact_error}, falling back to state storage")

# Continue to fallback below

# Fallback: Store in state if artifact service is not available or failed

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

logger.info("Tool: Report saved to state (artifact service not available)")

return {

"status": "success",

"artifact_saved": False,

"message": "Report saved to state only",

"size": len(report_json),

"summary": "Report saved to session state"

}

except Exception as e:

error_msg = f"Report save error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Still try to save minimal data to state

try:

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = {

'error': error_msg,

'feedback': feedback_text,

'timestamp': datetime.now().isoformat()

}

except:

pass

return {

"status": "error",

"message": error_msg,

"artifact_saved": False,

"summary": f"Failed to save report: {error_msg}"

}

সিনথেসাইজার এজেন্ট তৈরি করুন

👉 খুলুন

code_review_assistant/sub_agents/review_pipeline/feedback_synthesizer.py

👉 খুঁজুন:

# MODULE_5_STEP_4_INSTRUCTION_PROVIDER

👉 উৎপাদন নির্দেশ প্রদানকারী দিয়ে প্রতিস্থাপন করুন:

async def feedback_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code reviewer and mentor providing constructive, educational feedback.

CONTEXT FROM PREVIOUS AGENTS:

- Structure analysis summary: {structure_analysis_summary}

- Style check summary: {style_check_summary}

- Test execution summary: {test_execution_summary}

YOUR TASK requires these steps IN ORDER:

1. Call search_past_feedback tool with developer_id="default_user"

2. Call update_grading_progress tool with no parameters

3. Carefully analyze the test results to understand what really happened

4. Generate comprehensive feedback following the structure below

5. Call save_grading_report tool with the feedback_text parameter

6. Return the feedback as your final output

CRITICAL - Understanding Test Results:

The test_execution_summary contains structured JSON. Parse it carefully:

- tests_passed = Code worked correctly

- tests_failed = Code produced wrong output

- tests_with_errors = Code crashed

- critical_issues = Fundamental problems with the code

If critical_issues array contains items, these are serious bugs that need fixing.

Do NOT count discovering bugs as test successes.

FEEDBACK STRUCTURE TO FOLLOW:

## 📊 Summary

Provide an honest assessment. Be encouraging but truthful about problems found.

## ✅ Strengths

List 2-3 things done well, referencing specific code elements.

## 📈 Code Quality Analysis

### Structure & Organization

Comment on code organization, readability, and documentation.

### Style Compliance

Report the actual style score and any specific issues.

### Test Results

Report the actual test results accurately:

- If critical_issues exist, report them as bugs to fix

- Be clear: "X tests passed, Y critical issues were found"

- List each critical issue

- Don't hide or minimize problems

## 💡 Recommendations for Improvement

Based on the analysis, provide specific actionable fixes.

If critical issues exist, fixing them is top priority.

## 🎯 Next Steps

Prioritized action list based on severity of issues.

## 💬 Encouragement

End with encouragement while being honest about what needs fixing.

Remember: Complete ALL steps including calling save_grading_report."""

return await instructions_utils.inject_session_state(template, context)

👉 খুঁজুন:

# MODULE_5_STEP_4_SYNTHESIZER_AGENT

👉 এর পরিবর্তে:

feedback_synthesizer_agent = Agent(

name="FeedbackSynthesizer",

model=config.critic_model,

description="Synthesizes all analysis into constructive, personalized feedback",

instruction=feedback_instruction_provider,

tools=[

FunctionTool(func=search_past_feedback),

FunctionTool(func=update_grading_progress),

FunctionTool(func=save_grading_report)

],

output_key="final_feedback"

)

ধাপ ৫: পাইপলাইনটি তারের সাথে সংযুক্ত করুন

এখন চারটি এজেন্টকে একটি ক্রমিক পাইপলাইনে সংযুক্ত করুন এবং রুট এজেন্ট তৈরি করুন।

👉 খুলুন

code_review_assistant/agent.py

👉 ফাইলের উপরে প্রয়োজনীয় আমদানি যোগ করুন (বিদ্যমান আমদানির পরে):

from google.adk.agents import Agent, SequentialAgent

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

আপনার ফাইলটি এখন এইরকম দেখাবে:

"""

Main agent orchestration for the Code Review Assistant.

"""

from google.adk.agents import Agent, SequentialAgent

from .config import config

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

# MODULE_5_STEP_5_CREATE_PIPELINE

# MODULE_6_STEP_5_CREATE_FIX_LOOP

# MODULE_6_STEP_5_UPDATE_ROOT_AGENT

👉 খুঁজুন:

# MODULE_5_STEP_5_CREATE_PIPELINE

👉 ঐ একক লাইনটি দিয়ে প্রতিস্থাপন করুন:

# Create sequential pipeline

code_review_pipeline = SequentialAgent(

name="CodeReviewPipeline",

description="Complete code review pipeline with analysis, testing, and feedback",

sub_agents=[

code_analyzer_agent,

style_checker_agent,

test_runner_agent,

feedback_synthesizer_agent

]

)

# Root agent - coordinates the review pipeline

root_agent = Agent(

name="CodeReviewAssistant",

model=config.worker_model,

description="An intelligent code review assistant that analyzes Python code and provides educational feedback",

instruction="""You are a specialized Python code review assistant focused on helping developers improve their code quality.

When a user provides Python code for review:

1. Immediately delegate to CodeReviewPipeline and pass the code EXACTLY as it was provided by the user.

2. The pipeline will handle all analysis and feedback

3. Return ONLY the final feedback from the pipeline - do not add any commentary

When a user asks what you can do or asks general questions:

- Explain your capabilities for code review

- Do NOT trigger the pipeline for non-code messages

The pipeline handles everything for code review - just pass through its final output.""",

sub_agents=[code_review_pipeline],

output_key="assistant_response"

)

ধাপ ৬: সম্পূর্ণ পাইপলাইন পরীক্ষা করুন

চারজন এজেন্টকে একসাথে কাজ করার সময় এসেছে।

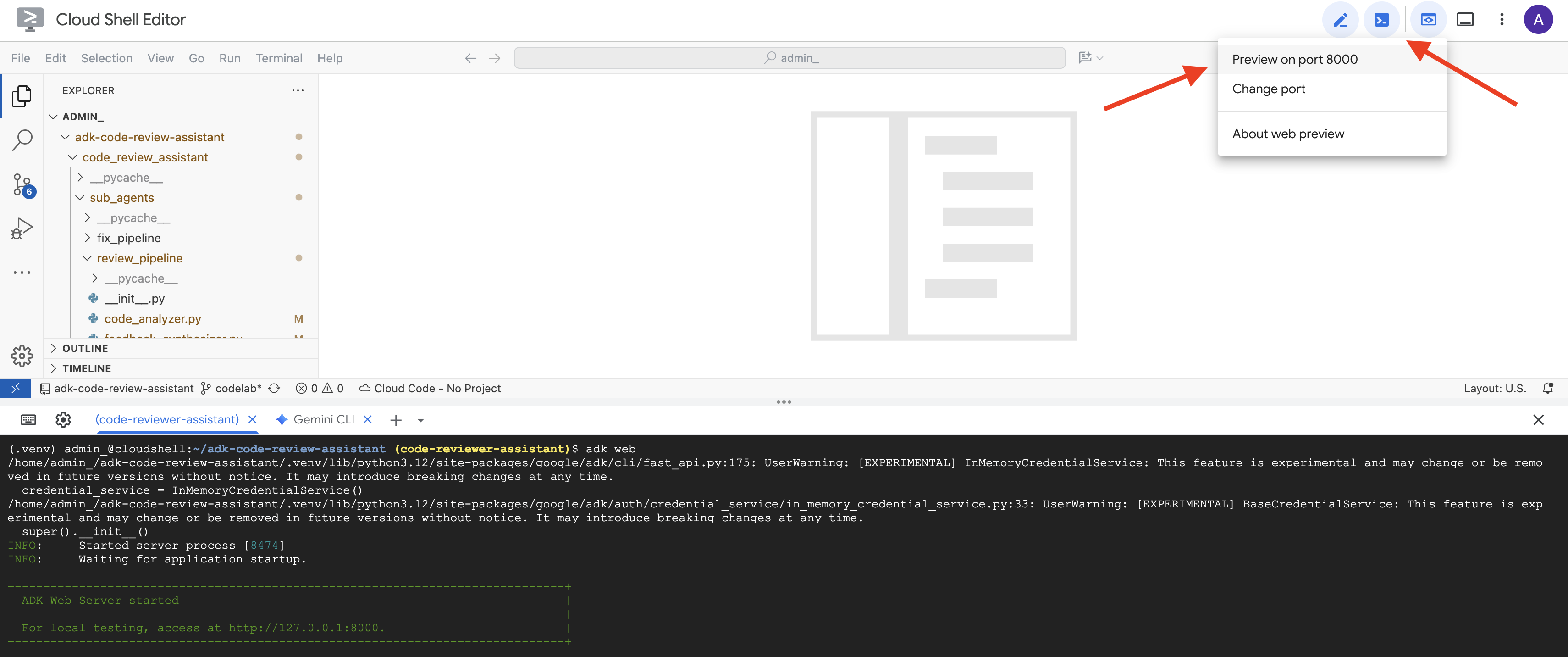

👉 সিস্টেমটি শুরু করুন:

adk web code_review_assistant

adk web কমান্ডটি চালানোর পরে, আপনার টার্মিনালে আউটপুট দেখতে পাবেন যা নির্দেশ করে যে ADK ওয়েব সার্ভার শুরু হয়েছে, যেমন:

+-----------------------------------------------------------------------------+

| ADK Web Server started |

| |

| For local testing, access at http://localhost:8000. |

+-----------------------------------------------------------------------------+

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

👉 এরপর, আপনার ব্রাউজার থেকে ADK Dev UI অ্যাক্সেস করতে:

ক্লাউড শেল টুলবারে (সাধারণত উপরে ডানদিকে) ওয়েব প্রিভিউ আইকন থেকে (প্রায়শই চোখ বা তীরযুক্ত বর্গক্ষেত্রের মতো দেখায়), পরিবর্তন পোর্ট নির্বাচন করুন। পপ-আপ উইন্ডোতে, পোর্টটি 8000 এ সেট করুন এবং "পরিবর্তন এবং পূর্বরূপ" ক্লিক করুন। ক্লাউড শেল এরপর ADK ডেভ UI প্রদর্শন করে একটি নতুন ব্রাউজার ট্যাব বা উইন্ডো খুলবে।

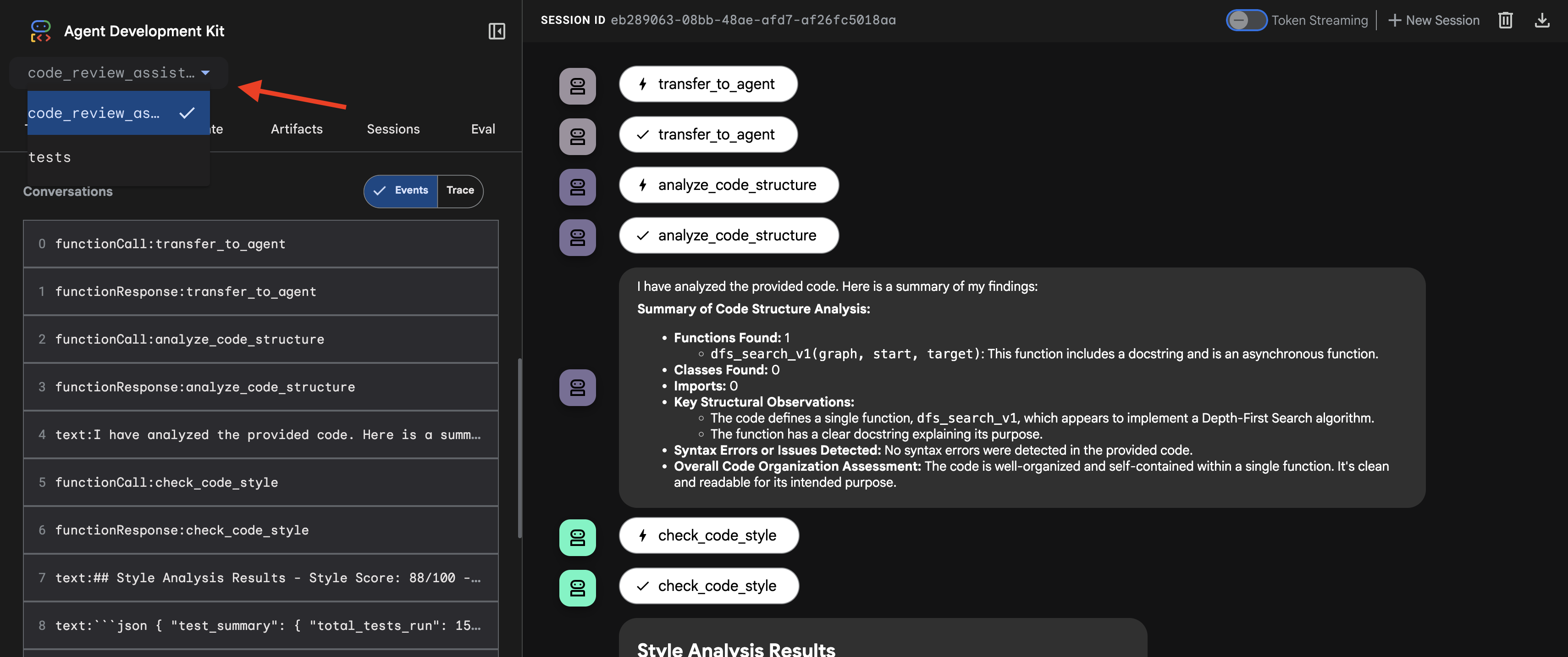

👉 এজেন্টটি এখন চলছে। আপনার ব্রাউজারের ADK ডেভ UI হল এজেন্টের সাথে আপনার সরাসরি সংযোগ।

- আপনার লক্ষ্য নির্বাচন করুন: UI এর উপরের ড্রপডাউন মেনুতে,

code_review_assistantএজেন্টটি নির্বাচন করুন।

👉 পরীক্ষার প্রম্পট:

Please analyze the following:

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

👉 কোড পর্যালোচনা পাইপলাইনটি কার্যকরভাবে দেখুন:

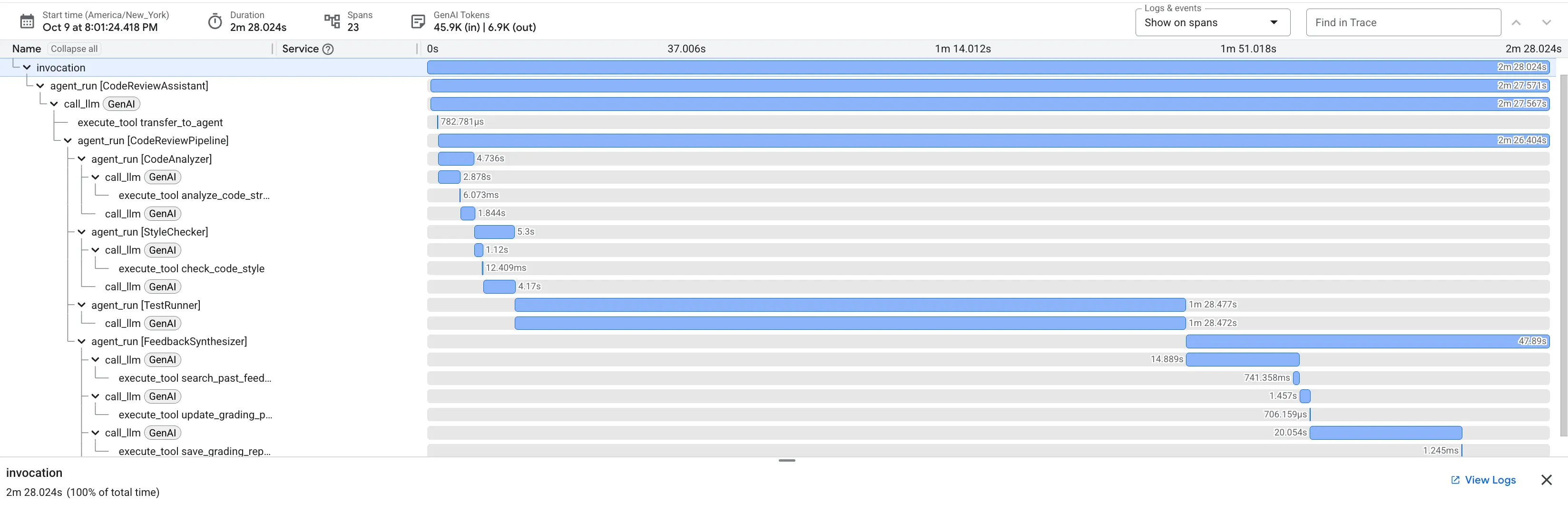

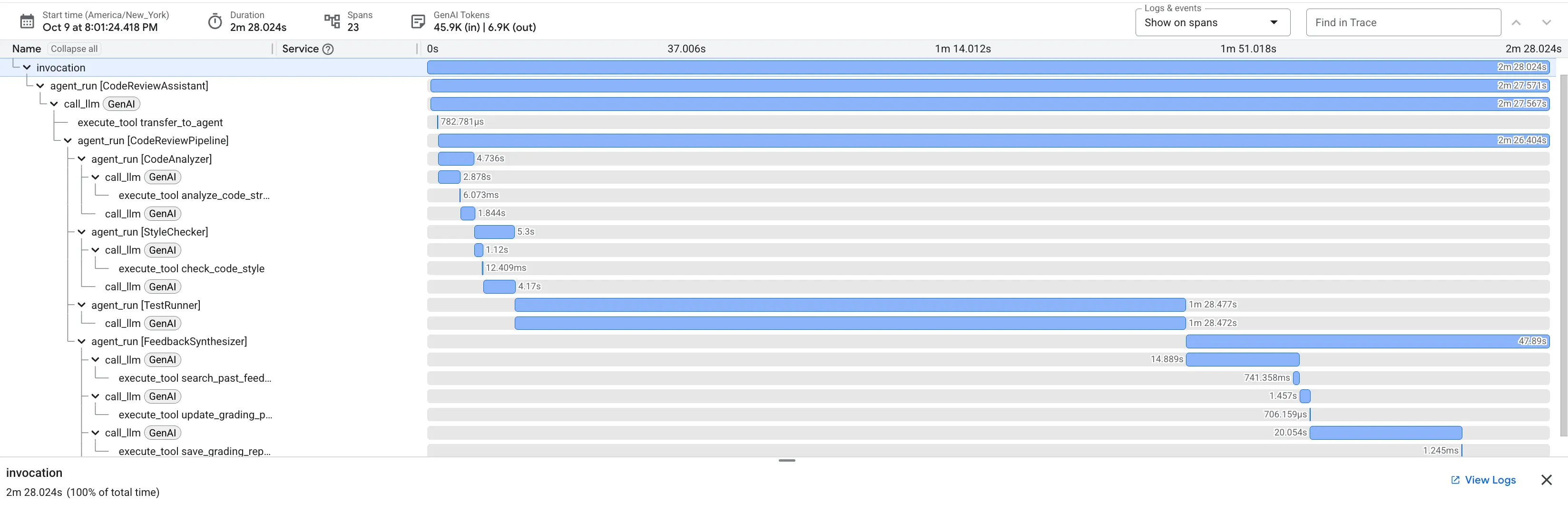

যখন আপনি buggy dfs_search_v1 ফাংশনটি জমা দেন, তখন আপনি কেবল একটি উত্তর পাচ্ছেন না। আপনি আপনার মাল্টি-এজেন্ট পাইপলাইনটি কাজ করছে তা দেখছেন। আপনি যে স্ট্রিমিং আউটপুটটি দেখতে পাচ্ছেন তা হল চারটি বিশেষায়িত এজেন্টের ক্রমানুসারে কার্যকর ফলাফল, প্রতিটি বিল্ডিং শেষের উপর।

প্রতিটি এজেন্ট চূড়ান্ত, ব্যাপক পর্যালোচনায় কী অবদান রাখে, কাঁচা তথ্যকে কার্যকর বুদ্ধিমত্তায় রূপান্তরিত করে তার একটি বিশদ বিবরণ এখানে দেওয়া হল।

১. কোড বিশ্লেষকের কাঠামোগত প্রতিবেদন

প্রথমত, CodeAnalyzer এজেন্ট কাঁচা কোডটি গ্রহণ করে। এটি কোডটি কী করে তা অনুমান করে না; এটি একটি নির্ধারক অ্যাবস্ট্রাক্ট সিনট্যাক্স ট্রি (AST) পার্স সম্পাদন করতে analyze_code_structure টুল ব্যবহার করে।

এর আউটপুট হল কোডের গঠন সম্পর্কে বিশুদ্ধ, বাস্তব তথ্য:

The analysis of the provided code reveals the following:

Summary:

- Functions Found: 1

- Classes Found: 0

Key Structural Observations:

- A single function, dfs_search_v1, is defined.

- It includes a docstring: "Find if target is reachable from start."

- No syntax errors were detected.

Overall Code Organization Assessment:

- The code snippet is a well-defined, self-contained function.

⭐ মান: এই প্রাথমিক পদক্ষেপটি অন্যান্য এজেন্টদের জন্য একটি পরিষ্কার, নির্ভরযোগ্য ভিত্তি প্রদান করে। এটি নিশ্চিত করে যে কোডটি বৈধ পাইথন এবং পর্যালোচনা করা প্রয়োজন এমন সঠিক উপাদানগুলি সনাক্ত করে।

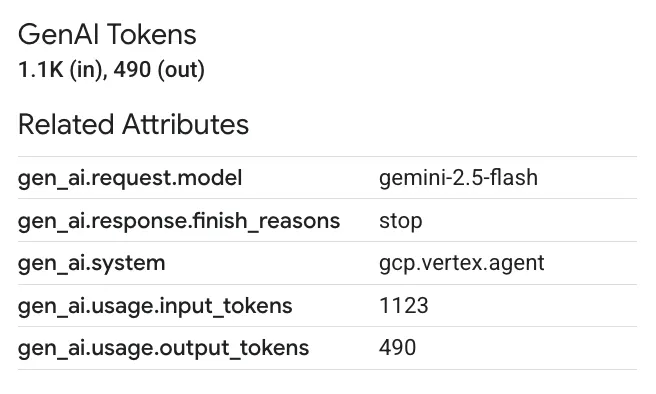

২. স্টাইল চেকারের পিইপি ৮ অডিট

এরপর, StyleChecker এজেন্ট দায়িত্ব নেয়। এটি শেয়ার্ড স্টেট থেকে কোড পড়ে এবং check_code_style টুল ব্যবহার করে, যা pycodestyle লিন্টার ব্যবহার করে।

এর ফলাফল হল একটি পরিমাপযোগ্য মানের স্কোর এবং নির্দিষ্ট লঙ্ঘন:

Style Analysis Results

- Style Score: 88/100

- Total Issues: 6

- Assessment: Good style with minor improvements needed

Top Style Issues

- Line 5, W293: blank line contains whitespace

- Line 19, W292: no newline at end of file

⭐ মূল্য: এই এজেন্ট প্রতিষ্ঠিত সম্প্রদায়ের মান (PEP 8) এর উপর ভিত্তি করে বস্তুনিষ্ঠ, অ-আলোচনাযোগ্য প্রতিক্রিয়া প্রদান করে। ওজনযুক্ত স্কোরিং সিস্টেমটি ব্যবহারকারীকে তাৎক্ষণিকভাবে সমস্যার তীব্রতা বলে দেয়।

৩. টেস্ট রানারের গুরুত্বপূর্ণ বাগ আবিষ্কার

এখানেই সিস্টেমটি পৃষ্ঠ-স্তরের বিশ্লেষণের বাইরে যায়। TestRunner এজেন্ট কোডের আচরণ যাচাই করার জন্য পরীক্ষার একটি বিস্তৃত স্যুট তৈরি করে এবং সম্পাদন করে।

এর আউটপুট হল একটি স্ট্রাকচার্ড JSON অবজেক্ট যাতে একটি জঘন্য রায় রয়েছে:

{

"critical_issues": [

{

"type": "Critical Bug",

"description": "The function's initialization `stack = start` is incorrect... When a common input like a string... is provided... the function crashes with an AttributeError.",

"severity": "Critical"

}

],

"verdict": {

"status": "BROKEN",

"confidence": "high",

"recommendation": "The function is fundamentally broken... the stack initialization line `stack = start` must be changed to `stack = [start]`."

}

}

⭐ মান: এটি সবচেয়ে গুরুত্বপূর্ণ অন্তর্দৃষ্টি। এজেন্ট কেবল অনুমান করেনি; এটি চালানোর মাধ্যমে কোডটি ভেঙে ফেলা হয়েছে তা প্রমাণ করেছে । এটি একটি সূক্ষ্ম কিন্তু গুরুত্বপূর্ণ রানটাইম বাগ আবিষ্কার করেছে যা একজন মানব পর্যালোচক সহজেই মিস করতে পারেন এবং সঠিক কারণ এবং প্রয়োজনীয় সমাধান চিহ্নিত করেছেন।

4. The Feedback Synthesizer's Final Report

Finally, the FeedbackSynthesizer agent acts as the conductor. It takes the structured data from the previous three agents and crafts a single, user-friendly report that is both analytical and encouraging.

Its output is the final, polished review you see:

📊 Summary

Great effort on implementing the Depth-First Search algorithm! ... However, a critical bug in the initialization of the stack prevents the function from working correctly...

✅ Strengths

- Good Algorithm Structure

- Correct Use of `visited` Set

📈 Code Quality Analysis

...

### Style Compliance

The style analysis returned a good score of 88/100.

...

### Test Results

The automated testing revealed a critical issue... The line `stack = start` directly assigns the input... which results in an `AttributeError`.

💡 Recommendations for Improvement

**Fix the Critical Stack Initialization Bug:**

- Incorrect Code: `stack = start`

- Correct Code: `stack = [start]`

💬 Encouragement

You are very close to a perfect implementation! The core logic of your DFS algorithm is sound, which is the hardest part.

⭐ Value: This agent transforms technical data into a helpful, educational experience. It prioritizes the most important issue (the bug), explains it clearly, provides the exact solution, and does so in an encouraging tone. It successfully integrates the findings from all previous stages into a cohesive and valuable whole.

This multi-stage process demonstrates the power of an agentic pipeline. Instead of a single, monolithic response, you get a layered analysis where each agent performs a specialized, verifiable task. This leads to a review that is not only insightful but also deterministic, reliable, and deeply educational.

👉💻 Once you're done testing, return to your Cloud Shell Editor terminal and press Ctrl+C to stop the ADK Dev UI.

What You've Built

You now have a complete code review pipeline that:

✅ Parses code structure - deterministic AST analysis with helper functions

✅ Checks style - weighted scoring with naming conventions

✅ Runs tests - comprehensive test generation with structured JSON output

✅ Synthesizes feedback - integrates state + memory + artifacts

✅ Tracks progress - multi-tier state across invocations/sessions/users

✅ Learns over time - memory service for cross-session patterns

✅ Provides artifacts - downloadable JSON reports with complete audit trail

Key Concepts Mastered

Sequential Pipelines:

- Four agents executing in strict order

- Each enriches state for the next

- Dependencies determine execution sequence

Production Patterns:

- Helper function separation (sync in thread pools)

- Graceful degradation (fallback strategies)

- Multi-tier state management (temp/session/user)

- Dynamic instruction providers (context-aware)

- Dual storage (artifacts + state redundancy)

State as Communication:

- Constants prevent typos across agents

-

output_keywrites agent summaries to state - Later agents read via StateKeys

- State flows linearly through pipeline

Memory vs State:

- State: current session data

- Memory: patterns across sessions

- Different purposes, different lifetimes

Tool Orchestration:

- Single-tool agents (analyzer, style_checker)

- Built-in executors (test_runner)

- Multi-tool coordination (synthesizer)

Model Selection Strategy:

- Worker model: mechanical tasks (parsing, linting, routing)

- Critic model: reasoning tasks (testing, synthesis)

- Cost optimization through appropriate selection

What's Next

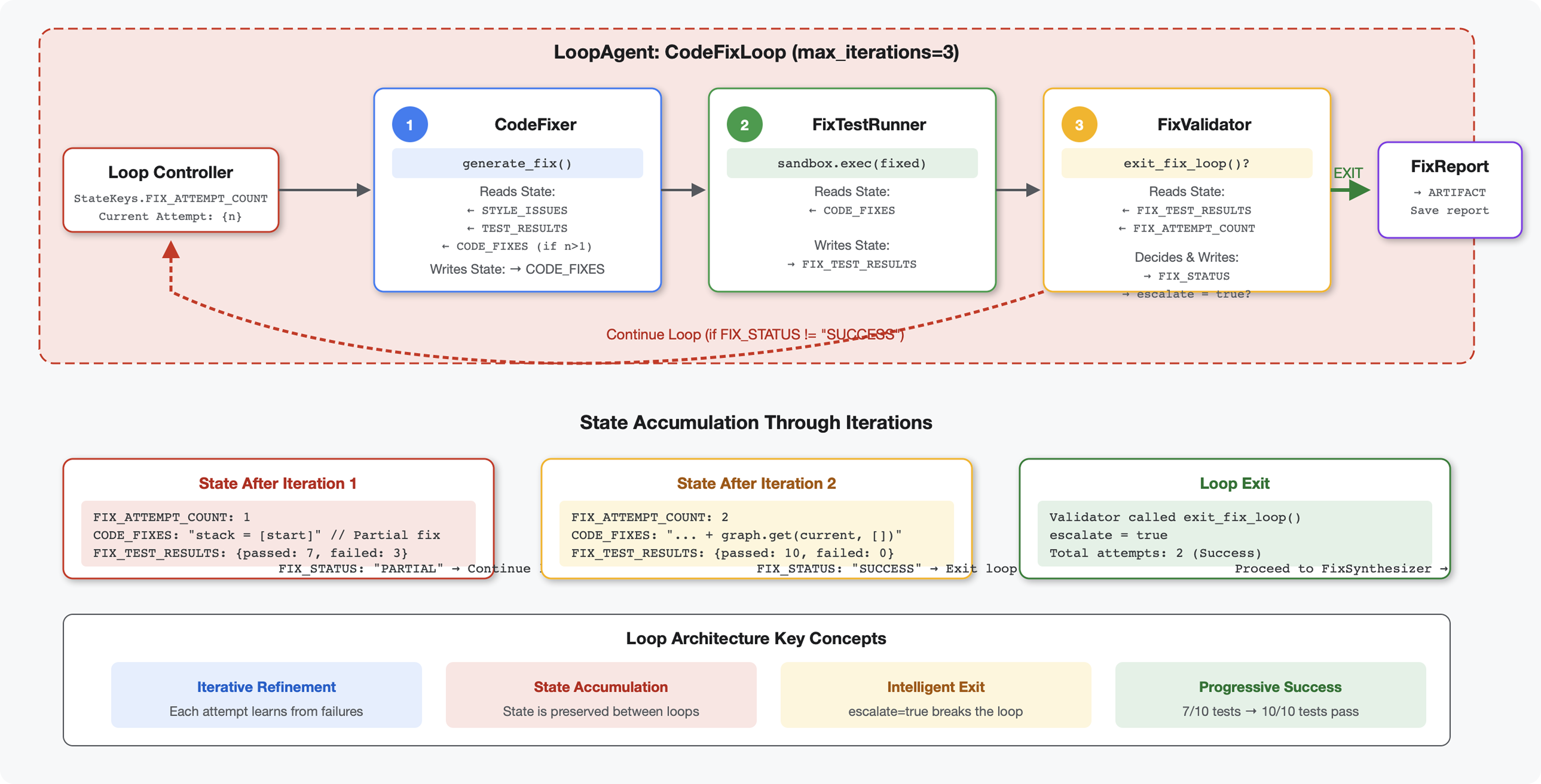

In Module 6, you'll build the fix pipeline :

- LoopAgent architecture for iterative fixing

- Exit conditions via escalation

- State accumulation across iterations

- Validation and retry logic

- Integration with review pipeline to offer fixes

You'll see how the same state patterns scale to complex iterative workflows where agents attempt multiple times until success, and how to coordinate multiple pipelines in a single application.

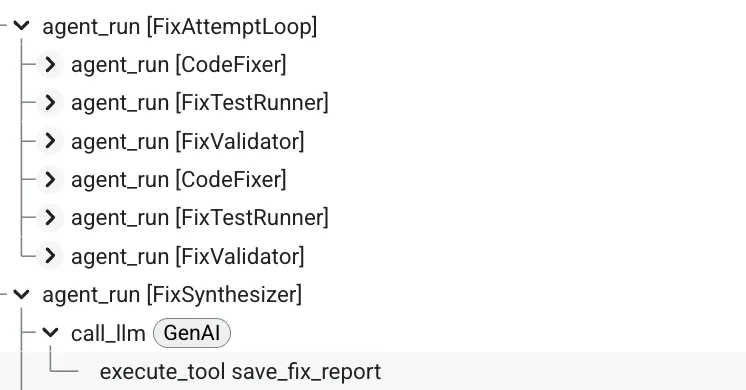

6. Adding the Fix Pipeline: Loop Architecture

ভূমিকা

In Module 5, you built a sequential review pipeline that analyzes code and provides feedback. But identifying problems is only half the solution - developers need help fixing them.

This module builds an automated fix pipeline that:

- Generates fixes based on review results

- Validates fixes by running comprehensive tests

- Retries automatically if fixes don't work (up to 3 attempts)

- Reports results with before/after comparisons

Key concept: LoopAgent for automatic retry. Unlike sequential agents that run once, a LoopAgent repeats its sub-agents until an exit condition is met or max iterations reached. Tools signal success by setting tool_context.actions.escalate = True .

Preview of what you'll build: Submit buggy code → review identifies issues → fix loop generates corrections → tests validate → retries if needed → final comprehensive report.

Core Concepts: LoopAgent vs Sequential

Sequential Pipeline (Module 5):

SequentialAgent(agents=[A, B, C])

# Executes: A → B → C → Done

- One-way flow

- Each agent runs exactly once

- No retry logic

Loop Pipeline (Module 6):

LoopAgent(agents=[A, B, C], max_iterations=3)

# Executes: A → B → C → (check exit) → A → B → C → (check exit) → ...

- Cyclic flow

- Agents can run multiple times

- Exits when:

- A tool sets

tool_context.actions.escalate = True(success) -

max_iterationsreached (safety limit) - Unhandled exception occurs (error)

- A tool sets

Why loops for code fixing:

Code fixes often need multiple attempts:

- First attempt : Fix obvious bugs (wrong variable types)

- Second attempt : Fix secondary issues revealed by tests (edge cases)

- Third attempt : Fine-tune and validate all tests pass

Without a loop, you'd need complex conditional logic in agent instructions. With LoopAgent , retry is automatic.

Architecture comparison:

Sequential (Module 5):

User → Review Pipeline → Feedback → Done

Loop (Module 6):

User → Review Pipeline → Feedback → Fix Pipeline

↓

┌──────────────┴──────────────┐

│ Fix Attempt Loop (1-3x) │

│ ┌─────────────────────┐ │

│ │ 1. Generate Fixes │ │

│ │ 2. Test Fixes │ │

│ │ 3. Validate & Exit? │────┼─→ If escalate=True

│ └─────────────────────┘ │ exit loop

│ ↓ If not │

│ Try Again (max 3) │

└─────────────────────────────┘

↓

4. Synthesize Final Report → Done

Step 1: Add Code Fixer Agent

The code fixer generates corrected Python code based on review results.

👉 Open

code_review_assistant/sub_agents/fix_pipeline/code_fixer.py

👉 Find:

# MODULE_6_STEP_1_CODE_FIXER_INSTRUCTION_PROVIDER

👉 Replace that single line with:

async def code_fixer_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code fixing specialist.

Original Code:

{code_to_review}

Analysis Results:

- Style Score: {style_score}/100

- Style Issues: {style_issues}

- Test Results: {test_execution_summary}

Based on the test results, identify and fix ALL issues including:

- Interface bugs (e.g., if start parameter expects wrong type)

- Logic errors (e.g., KeyError when accessing graph nodes)

- Style violations

- Missing documentation

YOUR TASK:

Generate the complete fixed Python code that addresses all identified issues.

CRITICAL INSTRUCTIONS:

- Output ONLY the corrected Python code

- Do NOT include markdown code blocks (```python)

- Do NOT include any explanations or commentary

- The output should be valid, executable Python code and nothing else

Common fixes to apply based on test results:

- If tests show AttributeError with 'pop', fix: stack = [start] instead of stack = start

- If tests show KeyError accessing graph, fix: use graph.get(current, [])

- Add docstrings if missing

- Fix any style violations identified

Output the complete fixed code now:"""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_6_STEP_1_CODE_FIXER_AGENT

👉 Replace that single line with:

code_fixer_agent = Agent(

name="CodeFixer",

model=config.worker_model,

description="Generates comprehensive fixes for all identified code issues",

instruction=code_fixer_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="code_fixes"

)

Step 2: Add Fix Test Runner Agent

The fix test runner validates corrections by executing comprehensive tests on the fixed code.

👉 Open

code_review_assistant/sub_agents/fix_pipeline/fix_test_runner.py

👉 Find:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_INSTRUCTION_PROVIDER

👉 Replace that single line with:

async def fix_test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that uses the clean code from the previous step."""

template = """You are responsible for validating the fixed code by running tests.

THE FIXED CODE TO TEST:

{code_fixes}

ORIGINAL TEST RESULTS: {test_execution_summary}

YOUR TASK:

1. Understand the fixes that were applied

2. Generate the same comprehensive tests (15-20 test cases)

3. Execute the tests on the FIXED code using your code executor

4. Compare results with original test results

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Run the same tests that revealed issues in the original code

- Verify that previously failing tests now pass

- Ensure no regressions were introduced

- Document the improvement

Execute your tests and output ONLY valid JSON with this structure:

- "passed": number of tests that passed

- "failed": number of tests that failed

- "total": total number of tests

- "pass_rate": percentage as a number

- "comparison": object with "original_pass_rate", "new_pass_rate", "improvement"

- "newly_passing_tests": array of test names that now pass

- "still_failing_tests": array of test names still failing

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_AGENT

👉 Replace that single line with:

fix_test_runner_agent = Agent(

name="FixTestRunner",

model=config.critic_model,

description="Runs comprehensive tests on fixed code to verify all issues are resolved",

instruction=fix_test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="fix_test_execution_summary"

)

Step 3: Add Fix Validator Agent

The validator checks if fixes were successful and decides whether to exit the loop.

Understanding the Tools

First, add the three tools the validator needs.

👉 Open

code_review_assistant/tools.py

👉 Find:

# MODULE_6_STEP_3_VALIDATE_FIXED_STYLE

👉 Replace with Tool 1 - Style Validator:

async def validate_fixed_style(tool_context: ToolContext) -> Dict[str, Any]:

"""

Validates style compliance of the fixed code.

Args:

tool_context: ADK tool context containing fixed code in state

Returns:

Dictionary with style validation results

"""

logger.info("Tool: Validating style of fixed code...")

try:

# Get the fixed code from state

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Try to extract from markdown if present

if '```python' in code_fixes:

start = code_fixes.rfind('```python') + 9

end = code_fixes.rfind('```')

if start < end:

code_fixes = code_fixes[start:end].strip()

if not code_fixes:

return {

"status": "error",

"message": "No fixed code found in state"

}

# Store the extracted fixed code

tool_context.state[StateKeys.CODE_FIXES] = code_fixes

# Run style check on fixed code

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

style_result = await loop.run_in_executor(

executor, _perform_style_check, code_fixes

)

# Compare with original

original_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

improvement = style_result['score'] - original_score

# Store results

tool_context.state[StateKeys.FIXED_STYLE_SCORE] = style_result['score']

tool_context.state[StateKeys.FIXED_STYLE_ISSUES] = style_result['issues']

logger.info(f"Tool: Fixed code style score: {style_result['score']}/100 "

f"(improvement: +{improvement})")

return {

"status": "success",

"fixed_style_score": style_result['score'],

"original_style_score": original_score,

"improvement": improvement,

"remaining_issues": style_result['issues'],

"perfect_style": style_result['score'] == 100

}

except Exception as e:

logger.error(f"Tool: Style validation failed: {e}", exc_info=True)

return {

"status": "error",

"message": str(e)

}

👉 Find:

# MODULE_6_STEP_3_COMPILE_FIX_REPORT

👉 Replace with Tool 2 - Report Compiler:

async def compile_fix_report(tool_context: ToolContext) -> Dict[str, Any]:

"""

Compiles comprehensive report of the fix process.

Args:

tool_context: ADK tool context with all fix pipeline data

Returns:

Comprehensive fix report

"""

logger.info("Tool: Compiling comprehensive fix report...")

try:

# Gather all data

original_code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Test results

original_tests = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

fixed_tests = tool_context.state.get(StateKeys.FIX_TEST_EXECUTION_SUMMARY, {})

# Parse if strings

if isinstance(original_tests, str):

try:

original_tests = json.loads(original_tests)

except:

original_tests = {}

if isinstance(fixed_tests, str):

try:

fixed_tests = json.loads(fixed_tests)

except:

fixed_tests = {}

# Extract pass rates

original_pass_rate = 0

if original_tests:

if 'pass_rate' in original_tests:

original_pass_rate = original_tests['pass_rate']

elif 'test_summary' in original_tests:

# Handle test_runner_agent's JSON structure

summary = original_tests['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

original_pass_rate = (passed / total) * 100

elif 'passed' in original_tests and 'total' in original_tests:

if original_tests['total'] > 0:

original_pass_rate = (original_tests['passed'] / original_tests['total']) * 100

fixed_pass_rate = 0

all_tests_pass = False

if fixed_tests:

if 'pass_rate' in fixed_tests:

fixed_pass_rate = fixed_tests['pass_rate']

all_tests_pass = fixed_tests.get('failed', 1) == 0

elif 'passed' in fixed_tests and 'total' in fixed_tests:

if fixed_tests['total'] > 0: