1. The Late Night Code Review

Es ist 2 Uhr morgens

Du hast stundenlang Fehler behoben. Die Funktion sieht richtig aus, aber es ist ein Fehler aufgetreten. Sie kennen das sicher: Code sollte funktionieren, tut es aber nicht. Sie haben sich den Code schon so lange angesehen, dass Sie nicht mehr erkennen, warum.

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start # Looks innocent enough...

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

Der Weg zum KI-Entwickler

Wenn Sie das hier lesen, haben Sie wahrscheinlich schon selbst erlebt, wie KI das Programmieren verändert. Tools wie Gemini Code Assist, Claude Code und Cursor haben die Art und Weise, wie wir Code schreiben, verändert. Sie sind ideal, um Boilerplate-Code zu generieren, Implementierungen vorzuschlagen und die Entwicklung zu beschleunigen.

Aber Sie sind hier, weil Sie mehr erfahren möchten. Sie möchten wissen, wie Sie diese KI-Systeme erstellen und nicht nur verwenden. Sie möchten etwas erstellen, das

- Vorhersehbares, nachvollziehbares Verhalten

- Kann zuverlässig in der Produktion bereitgestellt werden

- Einheitliche Ergebnisse, auf die Sie sich verlassen können

- Sie sehen genau, wie Entscheidungen getroffen werden.

Vom Konsumenten zum Creator

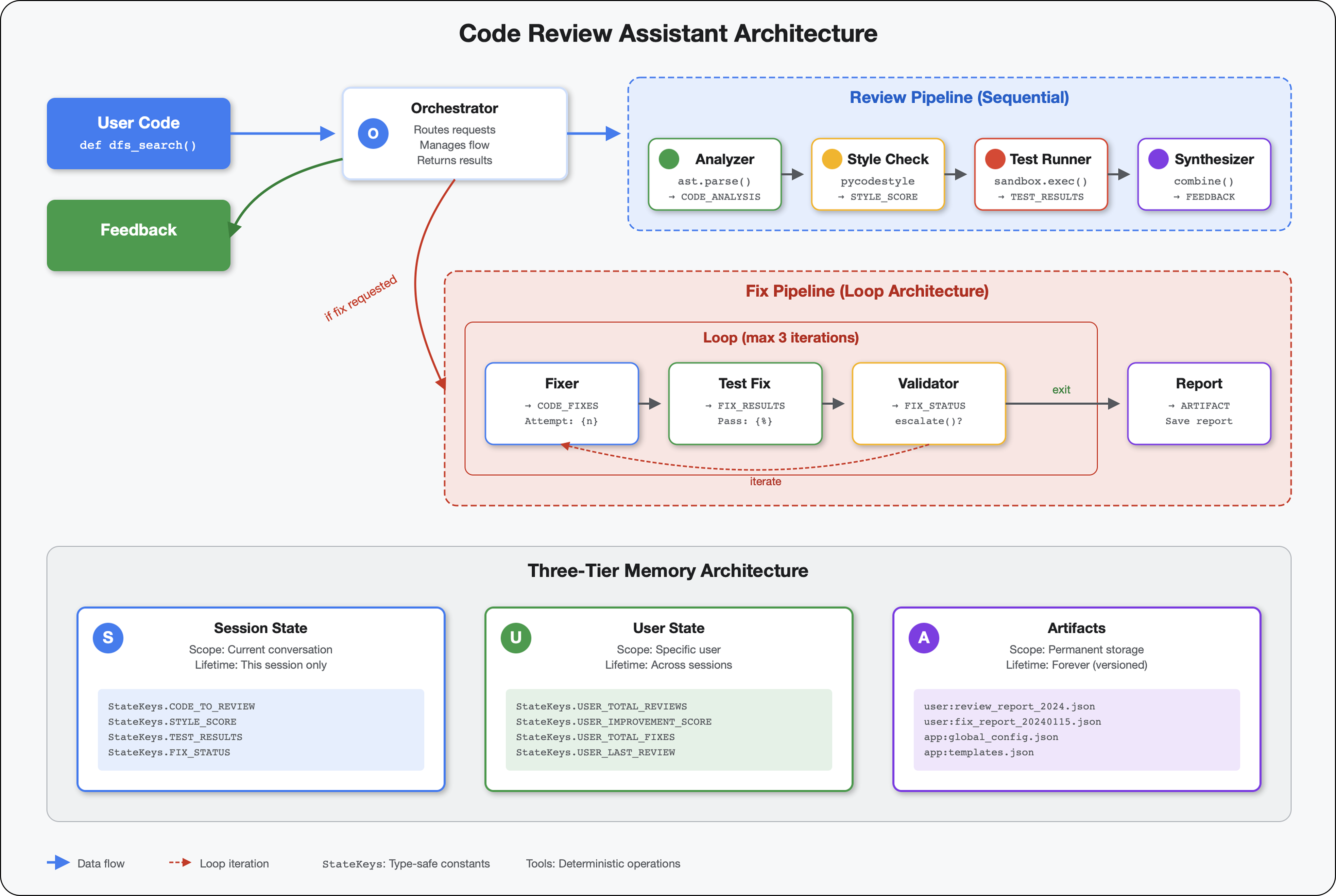

Heute machen Sie den Sprung von der Nutzung von KI‑Tools zur Entwicklung von KI‑Tools. Sie erstellen ein Multi-Agent-System, das:

- Analysiert die Codestruktur deterministisch

- Führt tatsächliche Tests aus, um das Verhalten zu überprüfen

- Validates style compliance with real linters (Stilkonformität mit echten Lintern validieren)

- Fasst Ergebnisse in umsetzbares Feedback zusammen

- Bereitstellungen in Google Cloud mit vollständiger Beobachtbarkeit

2. Erstes Agent-Deployment

Die Frage des Entwicklers

„Ich verstehe LLMs und habe die APIs verwendet, aber wie entwickle ich aus einem Python-Script einen KI-Agenten für die Produktion, der skaliert?“

Wir beantworten diese Frage, indem wir Ihre Umgebung richtig einrichten und dann einen einfachen Agenten erstellen, um die Grundlagen zu verstehen, bevor wir uns mit Produktionsmustern befassen.

Wichtige Einrichtungsschritte zuerst

Bevor wir Agenten erstellen, müssen wir sicherstellen, dass Ihre Google Cloud-Umgebung bereit ist.

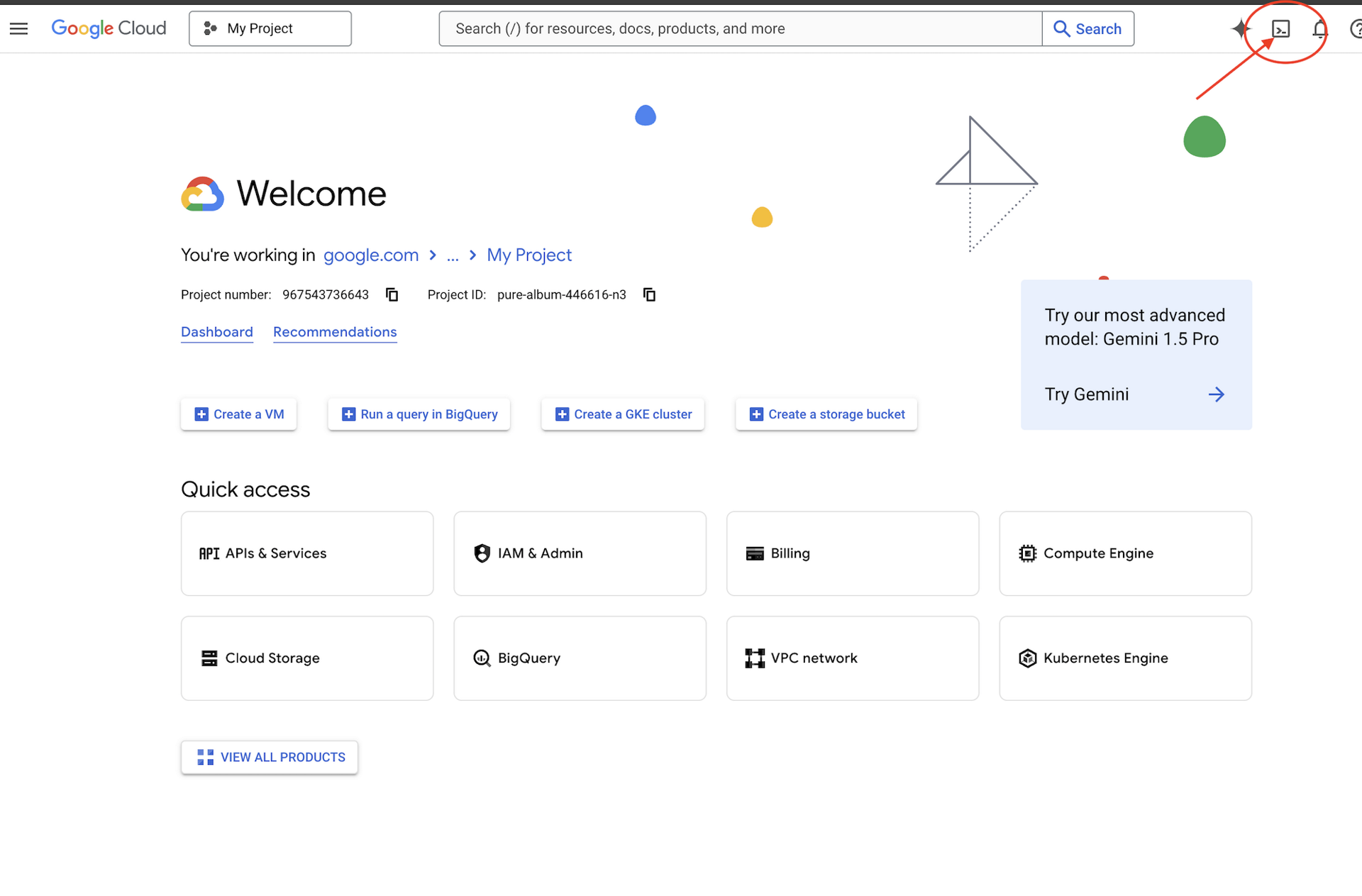

Google Cloud-Guthaben erforderlich?

Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren (das ist das Symbol in Form eines Terminals oben im Cloud Shell-Bereich).

So finden Sie Ihre Google Cloud-Projekt-ID:

- Öffnen Sie die Google Cloud Console: https://console.cloud.google.com.

- Wählen Sie oben auf der Seite im Drop-down-Menü das Projekt aus, das Sie für diesen Workshop verwenden möchten.

- Ihre Projekt-ID wird im Dashboard

auf der Karte „Projektinformationen“ angezeigt.

auf der Karte „Projektinformationen“ angezeigt.

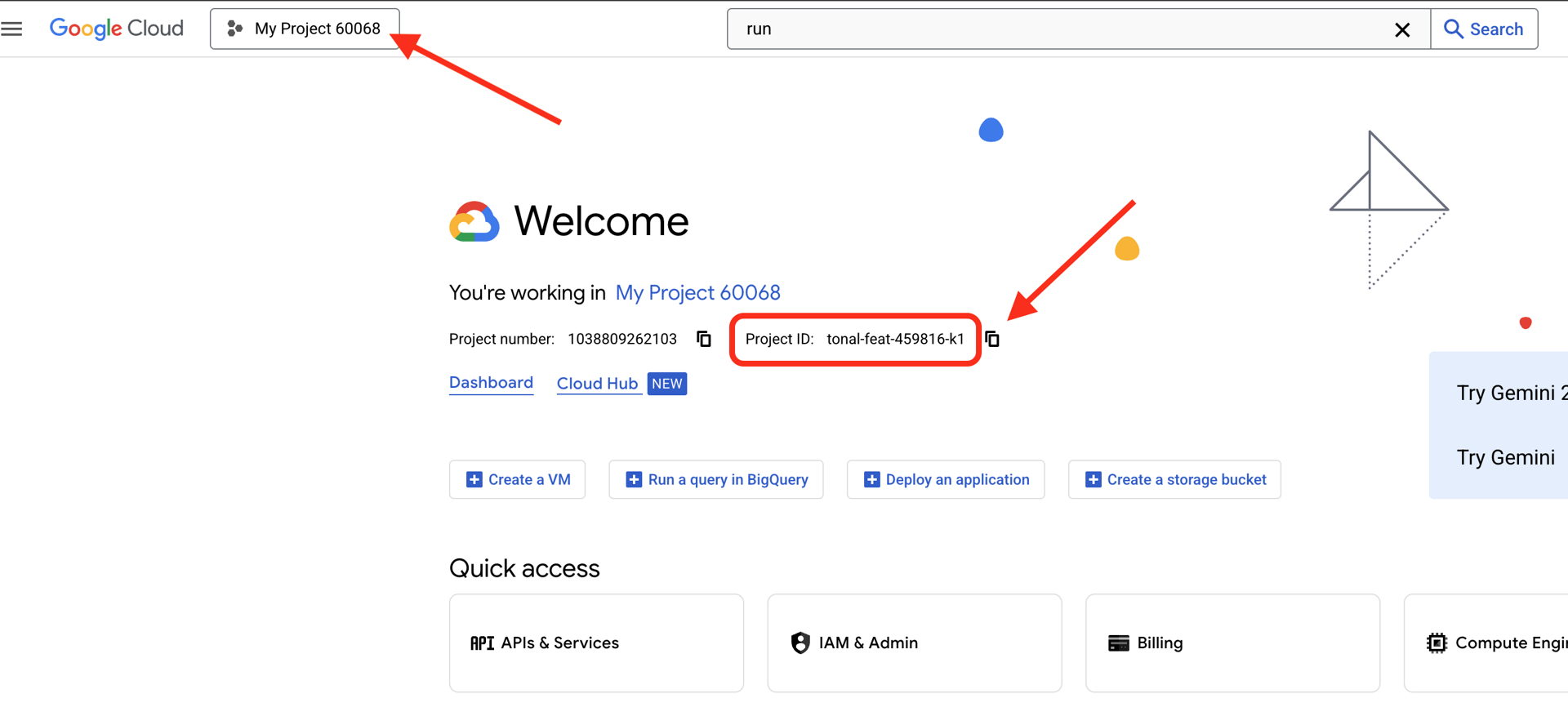

Schritt 1: Projekt-ID festlegen

In Cloud Shell ist das gcloud-Befehlszeilentool bereits konfiguriert. Führen Sie den folgenden Befehl aus, um Ihr aktives Projekt festzulegen. Dabei wird die Umgebungsvariable $GOOGLE_CLOUD_PROJECT verwendet, die automatisch für Sie in Ihrer Cloud Shell-Sitzung festgelegt wird.

gcloud config set project $GOOGLE_CLOUD_PROJECT

Schritt 2: Einrichtung überprüfen

Führen Sie als Nächstes die folgenden Befehle aus, um zu bestätigen, dass Ihr Projekt richtig festgelegt ist und Sie authentifiziert sind.

# Confirm project is set

echo "Current project: $(gcloud config get-value project)"

# Check authentication status

gcloud auth list

Ihre Projekt-ID sollte angezeigt werden und Ihr Nutzerkonto mit (ACTIVE) daneben.

Wenn Ihr Konto nicht als aktiv aufgeführt wird oder Sie einen Authentifizierungsfehler erhalten, führen Sie den folgenden Befehl aus, um sich anzumelden:

gcloud auth application-default login

Schritt 3: Wichtige APIs aktivieren

Für den Basis-Agenten sind mindestens die folgenden APIs erforderlich:

gcloud services enable \

aiplatform.googleapis.com \

compute.googleapis.com

Dies kann ein oder zwei Minuten dauern. Sie sehen hier Folgendes:

Operation "operations/..." finished successfully.

Schritt 4: ADK installieren

# Install the ADK CLI

pip install google-adk --upgrade

# Verify installation

adk --version

Sie sollten eine Versionsnummer wie 1.15.0 oder höher sehen.

Basis-Agent erstellen

Nachdem die Umgebung eingerichtet ist, erstellen wir den einfachen Agent.

Schritt 5: ADK Create verwenden

adk create my_first_agent

Folgen Sie den interaktiven Aufforderungen:

Choose a model for the root agent:

1. gemini-2.5-flash

2. Other models (fill later)

Choose model (1, 2): 1

1. Google AI

2. Vertex AI

Choose a backend (1, 2): 2

Enter Google Cloud project ID [auto-detected-from-gcloud]:

Enter Google Cloud region [us-central1]:

Schritt 6: Erstellte Elemente prüfen

cd my_first_agent

ls -la

Sie finden drei Dateien:

.env # Configuration (auto-populated with your project)

__init__.py # Package marker

agent.py # Your agent definition

Schritt 7: Konfiguration schnell prüfen

# Verify the .env was created correctly

cat .env

# Should show something like:

# GOOGLE_CLOUD_PROJECT=your-project-id

# GOOGLE_CLOUD_LOCATION=us-central1

# GOOGLE_GENAI_USE_VERTEXAI=1

Wenn die Projekt-ID fehlt oder falsch ist, bearbeiten Sie die Datei .env:

nano .env # or use your preferred editor

Schritt 8: Agent-Code ansehen

cat agent.py

from google.adk.agents.llm_agent import Agent

root_agent = Agent(

model='gemini-2.5-flash',

name='root_agent',

description='A helpful assistant for user questions.',

instruction='Answer user questions to the best of your knowledge',

)

Einfach, klar, minimalistisch. Das ist Ihr „Hallo Welt“ für KI-Agenten.

Basis-Agent testen

Schritt 9: Agent ausführen

cd ..

adk run my_first_agent

Sie sollte etwa so aussehen:

Log setup complete: /tmp/agents_log/agent.20250930_162430.log

To access latest log: tail -F /tmp/agents_log/agent.latest.log

[user]:

Schritt 10: Suchanfragen ausprobieren

Im Terminal, in dem adk run ausgeführt wird, wird ein Prompt angezeigt. Geben Sie Ihre Anfragen ein:

[user]: Hey, what can you do?

[root_agent]: I can help answer questions, generate text, explain concepts, assist with problem-solving, and provide information on a wide range of topics. What would you like to know or discuss?

[user]: What's the current weather in Mountain View?

[root_agent]: I'm sorry, but I cannot provide real-time weather information as I don't have access to current data or weather services. To get the current weather in Mountain View, I recommend checking a weather website or app like weather.com or using a search engine.

Beachten Sie die Einschränkung: Das Tool kann nicht auf aktuelle Daten zugreifen. Wir gehen noch einen Schritt weiter:

[user]: Review this Python code: def add(a, b): return a + b

[root_agent]: This is a simple Python function that adds two numbers. Here's my review:

**Strengths:**

- Clean and concise implementation

- Follows Python conventions for simple operations

- Clear function name that describes its purpose

**Suggestions for improvement:**

- Add a docstring to document the function

- Consider adding type hints for better code clarity

- You might want to handle edge cases

Here's an enhanced version:

def add(a: float, b: float) -> float:

"""Add two numbers and return their sum."""

return a + b

Der Agent kann Code diskutieren, aber kann er auch:

- AST tatsächlich parsen, um die Struktur zu verstehen?

- Tests durchführen, um zu prüfen, ob es funktioniert?

- Stilrichtlinien einhalten?

- Erinnern Sie sich an Ihre bisherigen Rezensionen?

Nein. Hier ist Architektur erforderlich.

🏃🚪 Beenden mit

Ctrl+C

wenn Sie mit dem Erkunden fertig sind.

3. Produktionsarbeitsbereich vorbereiten

Die Lösung: Eine produktionsreife Architektur

Dieser einfache Agent hat den Ausgangspunkt gezeigt, aber ein Produktionssystem erfordert eine robuste Struktur. Wir richten jetzt ein vollständiges Projekt ein, das Produktionsprinzipien entspricht.

Grundlage schaffen

Sie haben Ihr Google Cloud-Projekt bereits für den einfachen Agent konfiguriert. Jetzt bereiten wir den vollständigen Produktionsarbeitsbereich mit allen Tools, Mustern und der Infrastruktur vor, die für ein echtes System erforderlich sind.

Schritt 1: Strukturiertes Projekt abrufen

Beenden Sie zuerst alle laufenden adk run mit Ctrl+C und bereinigen Sie:

# Clean up the basic agent

cd ~ # Make sure you're not inside my_first_agent

rm -rf my_first_agent

# Get the production scaffold

git clone https://github.com/ayoisio/adk-code-review-assistant.git

cd adk-code-review-assistant

git checkout codelab

Schritt 2: Virtuelle Umgebung erstellen und aktivieren

# Create the virtual environment

python -m venv .venv

# Activate it

# On macOS/Linux:

source .venv/bin/activate

# On Windows:

# .venv\Scripts\activate

Bestätigung: Ihr Prompt sollte jetzt am Anfang (.venv) enthalten.

Schritt 3: Abhängigkeiten installieren

pip install -r code_review_assistant/requirements.txt

# Install the package in editable mode (enables imports)

pip install -e .

Dadurch wird Folgendes installiert:

google-adk– Das ADK-Frameworkpycodestyle– Für PEP 8-Prüfungvertexai– für die Cloud-Bereitstellung- Andere Produktionsabhängigkeiten

Mit dem Flag -e können Sie code_review_assistant-Module von überall aus importieren.

Schritt 4: Umgebung konfigurieren

# Copy the example environment file

cp .env.example .env

# Edit .env and replace the placeholders:

# - GOOGLE_CLOUD_PROJECT=your-project-id → your actual project ID

# - Keep other defaults as-is

Bestätigung: Konfiguration prüfen:

cat .env

Es sollte Folgendes angezeigt werden:

GOOGLE_CLOUD_PROJECT=your-actual-project-id

GOOGLE_CLOUD_LOCATION=us-central1

GOOGLE_GENAI_USE_VERTEXAI=TRUE

Schritt 5: Authentifizierung sicherstellen

Da Sie gcloud auth bereits ausgeführt haben, überprüfen wir Folgendes:

# Check current authentication

gcloud auth list

# Should show your account with (ACTIVE)

# If not, run:

gcloud auth application-default login

Schritt 6: Zusätzliche Produktions-APIs aktivieren

Wir haben bereits grundlegende APIs aktiviert. Fügen Sie nun die Produktions-IDs hinzu:

gcloud services enable \

sqladmin.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

artifactregistry.googleapis.com \

storage.googleapis.com \

cloudtrace.googleapis.com

Dadurch wird Folgendes ermöglicht:

- SQL-Administrator: Für Cloud SQL bei Verwendung von Cloud Run

- Cloud Run: Für die serverlose Bereitstellung

- Cloud Build: Für automatisierte Bereitstellungen

- Artifact Registry: Für Container-Images

- Cloud Storage: Für Artefakte und Staging

- Cloud Trace: Für die Beobachtbarkeit

Schritt 7: Artifact Registry-Repository erstellen

Bei der Bereitstellung werden Container-Images erstellt, die einen Speicherort benötigen:

gcloud artifacts repositories create code-review-assistant-repo \

--repository-format=docker \

--location=us-central1 \

--description="Docker repository for Code Review Assistant"

Hier sollten Sie dies sehen:

Created repository [code-review-assistant-repo].

Wenn sie bereits vorhanden ist (vielleicht von einem früheren Versuch), ist das in Ordnung. Sie sehen dann eine Fehlermeldung, die Sie ignorieren können.

Schritt 8: IAM-Berechtigungen erteilen

# Get your project number

PROJECT_NUMBER=$(gcloud projects describe $GOOGLE_CLOUD_PROJECT \

--format="value(projectNumber)")

# Define the service account

SERVICE_ACCOUNT="${PROJECT_NUMBER}@cloudbuild.gserviceaccount.com"

# Grant necessary roles

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/run.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/iam.serviceAccountUser"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/cloudsql.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/storage.admin"

Für jeden Befehl wird Folgendes ausgegeben:

Updated IAM policy for project [your-project-id].

Erreichte Ziele

Ihr Produktionsarbeitsbereich ist jetzt vollständig vorbereitet:

✅ Google Cloud-Projekt konfiguriert und authentifiziert

✅ Einfacher Agent getestet, um Einschränkungen zu verstehen

✅ Projektcode mit strategischen Platzhaltern bereit

✅ Abhängigkeiten in virtueller Umgebung isoliert

✅ Alle erforderlichen APIs aktiviert

✅ Container Registry für Bereitstellungen bereit

✅ IAM-Berechtigungen richtig konfiguriert

✅ Umgebungsvariablen richtig festgelegt

Jetzt können Sie ein echtes KI-System mit deterministischen Tools, Statusverwaltung und einer geeigneten Architektur erstellen.

4. Ersten Agenten erstellen

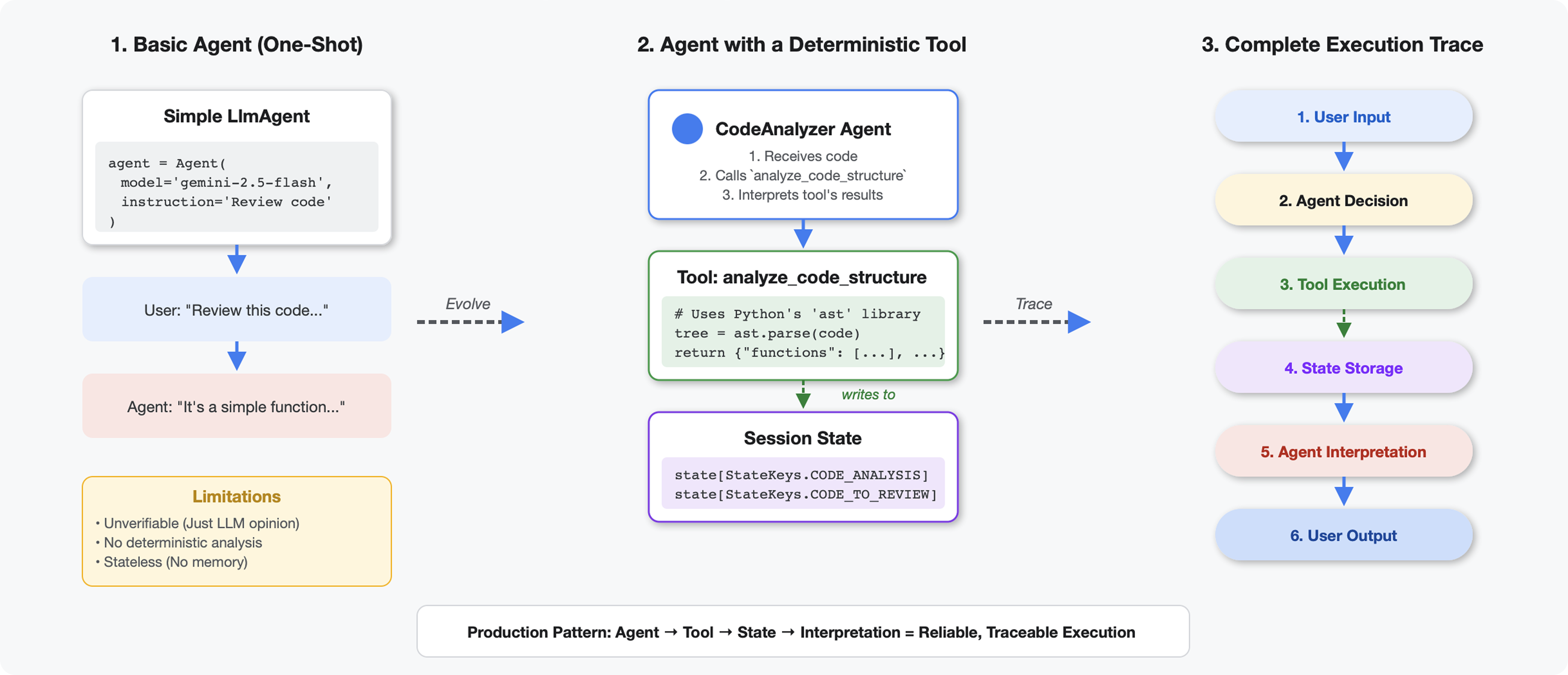

Was unterscheidet Tools von LLMs?

Wenn Sie ein LLM fragen, wie viele Funktionen in diesem Code enthalten sind, verwendet es Mustervergleich und Schätzung. Wenn Sie ein Tool verwenden, das ast.parse() von Python aufruft, wird der tatsächliche Syntaxbaum geparst. Es wird nicht geraten und das Ergebnis ist jedes Mal dasselbe.

In diesem Abschnitt wird ein Tool erstellt, das die Codestruktur deterministisch analysiert und dann mit einem Agent verbunden wird, der weiß, wann es aufgerufen werden muss.

Schritt 1: Das Gerüst verstehen

Sehen wir uns die Struktur an, die Sie ausfüllen müssen.

👉 Öffnen

code_review_assistant/tools.py

Die Funktion analyze_code_structure wird mit Platzhalterkommentaren angezeigt, die angeben, wo Sie Code hinzufügen müssen. Die Funktion hat bereits die grundlegende Struktur. Sie werden sie Schritt für Schritt erweitern.

Schritt 2: Status-Speicher hinzufügen

Durch die Speicherung des Status können andere Agents in der Pipeline auf die Ergebnisse Ihres Tools zugreifen, ohne dass die Analyse noch einmal ausgeführt werden muss.

👉 Finden:

# MODULE_4_STEP_2_ADD_STATE_STORAGE

👉 Ersetzen Sie diese einzelne Zeile durch:

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

Schritt 3: Asynchrone Analyse mit Thread-Pools hinzufügen

Unser Tool muss den AST-Baum parsen, ohne andere Vorgänge zu blockieren. Fügen wir die asynchrone Ausführung mit Thread-Pools hinzu.

👉 Finden:

# MODULE_4_STEP_3_ADD_ASYNC

👉 Ersetzen Sie diese einzelne Zeile durch:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

Schritt 4: Umfassende Informationen extrahieren

Extrahieren wir nun Klassen, Importe und detaillierte Messwerte – alles, was wir für eine vollständige Codeüberprüfung benötigen.

👉 Finden:

# MODULE_4_STEP_4_EXTRACT_DETAILS

👉 Ersetzen Sie diese einzelne Zeile durch:

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

👉 Funktion bestätigen

analyze_code_structure

in

tools.py

hat einen zentralen Textkörper, der so aussieht:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

👉 Scrollen Sie nun ganz nach unten.

tools.py

und finden:

# MODULE_4_STEP_4_HELPER_FUNCTION

👉 Ersetzen Sie diese einzelne Zeile durch die vollständige Hilfsfunktion:

def _extract_code_structure(tree: ast.AST, code: str) -> Dict[str, Any]:

"""

Helper function to extract structural information from AST.

Runs in thread pool for CPU-bound work.

"""

functions = []

classes = []

imports = []

docstrings = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

func_info = {

'name': node.name,

'args': [arg.arg for arg in node.args.args],

'lineno': node.lineno,

'has_docstring': ast.get_docstring(node) is not None,

'is_async': isinstance(node, ast.AsyncFunctionDef),

'decorators': [d.id for d in node.decorator_list

if isinstance(d, ast.Name)]

}

functions.append(func_info)

if func_info['has_docstring']:

docstrings.append(f"{node.name}: {ast.get_docstring(node)[:50]}...")

elif isinstance(node, ast.ClassDef):

methods = []

for item in node.body:

if isinstance(item, ast.FunctionDef):

methods.append(item.name)

class_info = {

'name': node.name,

'lineno': node.lineno,

'methods': methods,

'has_docstring': ast.get_docstring(node) is not None,

'base_classes': [base.id for base in node.bases

if isinstance(base, ast.Name)]

}

classes.append(class_info)

elif isinstance(node, ast.Import):

for alias in node.names:

imports.append({

'module': alias.name,

'alias': alias.asname,

'type': 'import'

})

elif isinstance(node, ast.ImportFrom):

imports.append({

'module': node.module or '',

'names': [alias.name for alias in node.names],

'type': 'from_import',

'level': node.level

})

return {

'functions': functions,

'classes': classes,

'imports': imports,

'docstrings': docstrings,

'metrics': {

'line_count': len(code.splitlines()),

'function_count': len(functions),

'class_count': len(classes),

'import_count': len(imports),

'has_main': any(f['name'] == 'main' for f in functions),

'has_if_main': '__main__' in code,

'avg_function_length': _calculate_avg_function_length(tree)

}

}

def _calculate_avg_function_length(tree: ast.AST) -> float:

"""Calculate average function length in lines."""

function_lengths = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

if hasattr(node, 'end_lineno') and hasattr(node, 'lineno'):

length = node.end_lineno - node.lineno + 1

function_lengths.append(length)

if function_lengths:

return sum(function_lengths) / len(function_lengths)

return 0.0

Schritt 5: Mit einem Kundenservicemitarbeiter verbinden

Jetzt verbinden wir das Tool mit einem Agent, der weiß, wann es verwendet werden muss und wie die Ergebnisse zu interpretieren sind.

👉 Öffnen

code_review_assistant/sub_agents/review_pipeline/code_analyzer.py

👉 Finden:

# MODULE_4_STEP_5_CREATE_AGENT

👉 Ersetzen Sie diese einzelne Zeile durch den vollständigen Produktions-Agenten:

code_analyzer_agent = Agent(

name="CodeAnalyzer",

model=config.worker_model,

description="Analyzes Python code structure and identifies components",

instruction="""You are a code analysis specialist responsible for understanding code structure.

Your task:

1. Take the code submitted by the user (it will be provided in the user message)

2. Use the analyze_code_structure tool to parse and analyze it

3. Pass the EXACT code to your tool - do not modify, fix, or "improve" it

4. Identify all functions, classes, imports, and structural patterns

5. Note any syntax errors or structural issues

6. Store the analysis in state for other agents to use

CRITICAL:

- Pass the code EXACTLY as provided to the analyze_code_structure tool

- Do not fix syntax errors, even if obvious

- Do not add missing imports or fix indentation

- The goal is to analyze what IS there, not what SHOULD be there

When calling the tool, pass the code as a string to the 'code' parameter.

If the analysis fails due to syntax errors, clearly report the error location and type.

Provide a clear summary including:

- Number of functions and classes found

- Key structural observations

- Any syntax errors or issues detected

- Overall code organization assessment""",

tools=[FunctionTool(func=analyze_code_structure)],

output_key="structure_analysis_summary"

)

Code-Analysetool testen

Prüfen Sie nun, ob der Analyzer ordnungsgemäß funktioniert.

👉 Testskript ausführen:

python tests/test_code_analyzer.py

Das Testskript lädt die Konfiguration automatisch aus Ihrer .env-Datei mit python-dotenv. Eine manuelle Einrichtung von Umgebungsvariablen ist also nicht erforderlich.

Erwartete Ausgabe:

INFO:code_review_assistant.config:Code Review Assistant Configuration Loaded:

INFO:code_review_assistant.config: - GCP Project: your-project-id

INFO:code_review_assistant.config: - Artifact Bucket: gs://your-project-artifacts

INFO:code_review_assistant.config: - Models: worker=gemini-2.5-flash, critic=gemini-2.5-pro

Testing code analyzer...

INFO:code_review_assistant.tools:Tool: Analysis complete - 2 functions, 1 classes

=== Analyzer Response ===

The analysis of the provided code shows the following:

* **Functions Found:** 2

* `add(a, b)`: A global function at line 2.

* `multiply(self, x, y)`: A method within the `Calculator` class.

* **Classes Found:** 1

* `Calculator`: A class defined at line 5. Contains one method, `multiply`.

* **Imports:** 0

* **Structural Patterns:** The code defines one global function and one class

with a single method. Both are simple, each with a single return statement.

* **Syntax Errors/Issues:** No syntax errors detected.

* **Overall Code Organization:** The code is well-organized for its small size,

clearly defining a function and a class with a method.

Was ist gerade passiert?

- Das Testskript hat Ihre

.env-Konfiguration automatisch geladen. - Ihr

analyze_code_structure()-Tool hat den Code mit dem AST von Python geparst. - Der

_extract_code_structure()-Helfer hat Funktionen, Klassen und Messwerte extrahiert. - Die Ergebnisse wurden mithilfe von

StateKeys-Konstanten im Sitzungsstatus gespeichert. - Der Code Analyzer-Agent hat die Ergebnisse interpretiert und eine Zusammenfassung erstellt.

Fehlerbehebung:

- „No module named ‘code_review_assistant'“: Führen Sie

pip install -e .über das Projektstammverzeichnis aus. - „Missing key inputs argument“: Prüfen Sie, ob Ihr

.envdie ParameterGOOGLE_CLOUD_PROJECT,GOOGLE_CLOUD_LOCATIONundGOOGLE_GENAI_USE_VERTEXAI=trueenthält.

Was Sie erstellt haben

Sie haben jetzt einen produktionsbereiten Code-Analyzer, der:

✅ Analysiert den tatsächlichen Python-AST – deterministisch, kein Musterabgleich

✅ Speichert Ergebnisse im Status – andere Agents können auf die Analyse zugreifen

✅ Wird asynchron ausgeführt – blockiert keine anderen Tools

✅ Extrahiert umfassende Informationen – Funktionen, Klassen, Importe, Messwerte

✅ Verarbeitet Fehler ordnungsgemäß – meldet Syntaxfehler mit Zeilennummern

✅ Stellt eine Verbindung zu einem Agent her – das LLM weiß, wann und wie es verwendet werden muss

Beherrschte Schlüsselkonzepte

Tools im Vergleich zu Agents:

- Tools führen deterministische Aufgaben aus (AST-Parsing).

- Agents entscheiden, wann Tools verwendet werden, und interpretieren die Ergebnisse.

Rückgabewert im Vergleich zum Status:

- Rückgabe: Was das LLM sofort sieht

- Zustand: Was für andere Agents bestehen bleibt

Konstanten für Status-Schlüssel:

- Tippfehler in Multi-Agent-Systemen vermeiden

- Als Verträge zwischen Agenten fungieren

- Wichtig, wenn Agents Daten teilen

Async + Thread-Pools:

async defermöglicht es Tools, die Ausführung zu pausieren.- Thread-Pools führen CPU-intensive Aufgaben im Hintergrund aus

- Zusammen sorgen sie dafür, dass die Ereignisschleife reaktionsfähig bleibt.

Hilfsfunktionen:

- Synchronisierungshilfen von asynchronen Tools trennen

- Macht Code testbar und wiederverwendbar

Anweisungen für Kundenservicemitarbeiter:

- Detaillierte Anweisungen verhindern häufige LLM-Fehler

- Explizit angeben, was NICHT zu tun ist (keinen Code korrigieren)

- Workflowschritte zur besseren Übersichtlichkeit löschen

Weitere Informationen

In Modul 5 fügen Sie Folgendes hinzu:

- Stilprüfung, die den Code aus dem Status liest

- Test-Runner, der Tests tatsächlich ausführt

- Feedback-Synthesizer, der alle Analysen kombiniert

Sie sehen, wie der Status durch eine sequenzielle Pipeline fließt und warum das Konstantenmuster wichtig ist, wenn mehrere Agents dieselben Daten lesen und schreiben.

5. Pipeline erstellen: Mehrere Agents arbeiten zusammen

Einführung

In Modul 4 haben Sie einen einzelnen Agenten erstellt, der die Codestruktur analysiert. Für eine umfassende Codeüberprüfung ist jedoch mehr als nur das Parsen erforderlich. Sie benötigen Stilprüfungen, die Ausführung von Tests und die intelligente Synthese von Feedback.

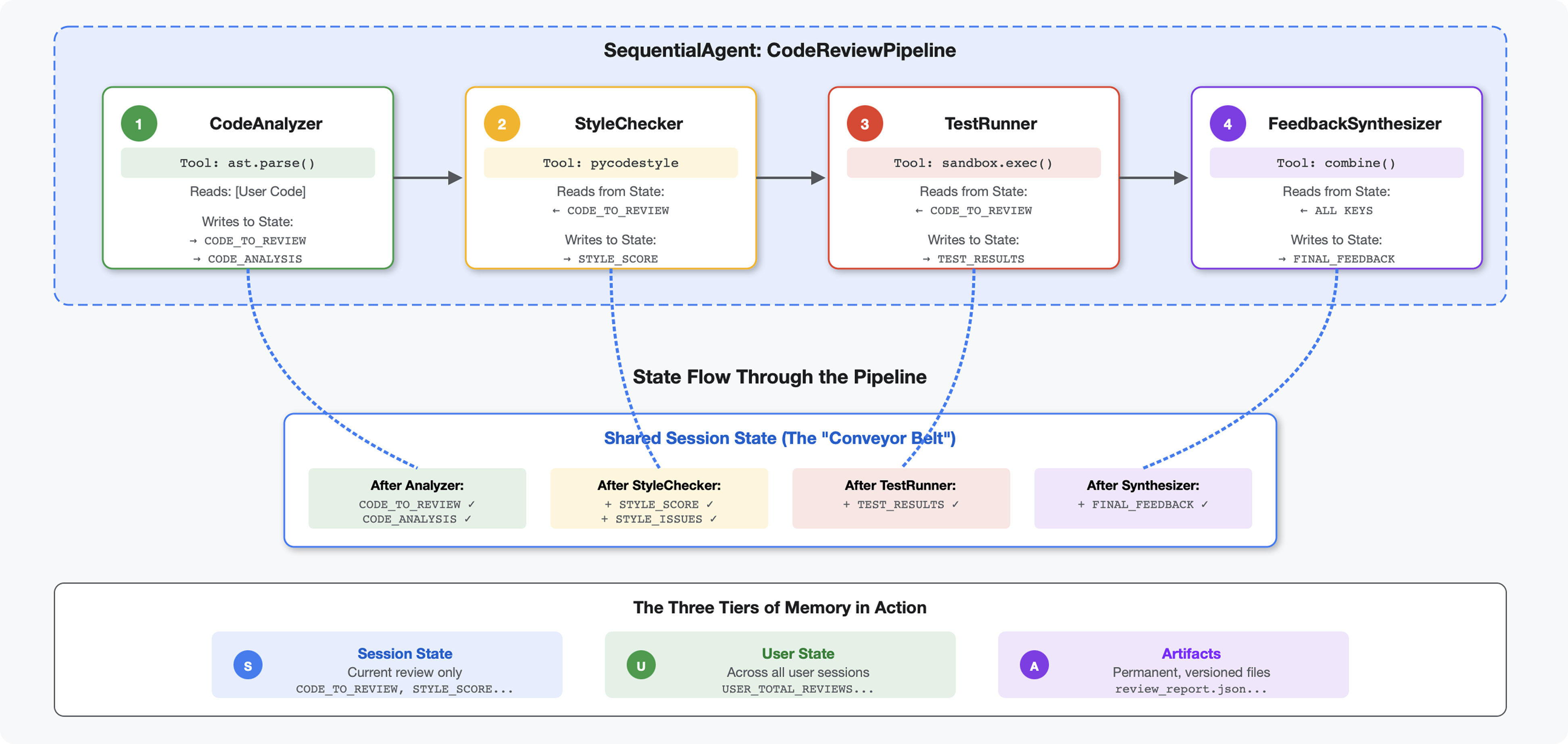

In diesem Modul wird eine Pipeline mit vier Agents erstellt, die sequenziell zusammenarbeiten und jeweils eine spezielle Analyse durchführen:

- Code Analyzer (aus Modul 4): Analysiert die Struktur

- Stilprüfung: Identifiziert Stilverstöße

- Test-Ausführer: Führt Tests aus und validiert sie.

- Feedback-Synthesizer: Hier wird alles in umsetzbares Feedback umgewandelt.

Schlüsselkonzept: Status als Kommunikationskanal Jeder Agent liest, was die vorherigen Agents geschrieben haben, fügt seine eigene Analyse hinzu und übergibt den angereicherten Status an den nächsten Agent. Das Konstantenmuster aus Modul 4 ist entscheidend, wenn mehrere Agents Daten gemeinsam nutzen.

Vorschau auf das, was Sie erstellen:Unsauberen Code einreichen → Status durch 4 Agents fließen lassen → umfassenden Bericht mit personalisiertem Feedback basierend auf früheren Mustern erhalten.

Schritt 1: Style Checker Tool und Agent hinzufügen

Die Stilprüfung erkennt PEP 8-Verstöße mithilfe von pycodestyle – einem deterministischen Linter, der nicht auf LLM-basierter Interpretation beruht.

Tool zur Stilprüfung hinzufügen

👉 Öffnen

code_review_assistant/tools.py

👉 Finden:

# MODULE_5_STEP_1_STYLE_CHECKER_TOOL

👉 Ersetzen Sie diese einzelne Zeile durch:

async def check_code_style(code: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Checks code style compliance using pycodestyle (PEP 8).

Args:

code: Python source code to check (or will retrieve from state)

tool_context: ADK tool context

Returns:

Dictionary containing style score and issues

"""

logger.info("Tool: Checking code style...")

try:

# Retrieve code from state if not provided

if not code:

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

if not code:

return {

"status": "error",

"message": "No code provided or found in state"

}

# Run style check in thread pool

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

result = await loop.run_in_executor(

executor, _perform_style_check, code

)

# Store results in state

tool_context.state[StateKeys.STYLE_SCORE] = result['score']

tool_context.state[StateKeys.STYLE_ISSUES] = result['issues']

tool_context.state[StateKeys.STYLE_ISSUE_COUNT] = result['issue_count']

logger.info(f"Tool: Style check complete - Score: {result['score']}/100, "

f"Issues: {result['issue_count']}")

return result

except Exception as e:

error_msg = f"Style check failed: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Set default values on error

tool_context.state[StateKeys.STYLE_SCORE] = 0

tool_context.state[StateKeys.STYLE_ISSUES] = []

return {

"status": "error",

"message": error_msg,

"score": 0

}

👉 Scrollen Sie nun zum Ende der Datei und suchen Sie nach:

# MODULE_5_STEP_1_STYLE_HELPERS

👉 Ersetzen Sie diese einzelne Zeile durch die Hilfsfunktionen:

def _perform_style_check(code: str) -> Dict[str, Any]:

"""Helper to perform style check in thread pool."""

import io

import sys

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as tmp:

tmp.write(code)

tmp_path = tmp.name

try:

# Capture stdout to get pycodestyle output

old_stdout = sys.stdout

sys.stdout = captured_output = io.StringIO()

style_guide = pycodestyle.StyleGuide(

quiet=False, # We want output

max_line_length=100,

ignore=['E501', 'W503']

)

result = style_guide.check_files([tmp_path])

# Restore stdout

sys.stdout = old_stdout

# Parse captured output

output = captured_output.getvalue()

issues = []

for line in output.strip().split('\n'):

if line and ':' in line:

parts = line.split(':', 4)

if len(parts) >= 4:

try:

issues.append({

'line': int(parts[1]),

'column': int(parts[2]),

'code': parts[3].split()[0] if len(parts) > 3 else 'E000',

'message': parts[3].strip() if len(parts) > 3 else 'Unknown error'

})

except (ValueError, IndexError):

pass

# Add naming convention checks

try:

tree = ast.parse(code)

naming_issues = _check_naming_conventions(tree)

issues.extend(naming_issues)

except SyntaxError:

pass # Syntax errors will be caught elsewhere

# Calculate weighted score

score = _calculate_style_score(issues)

return {

"status": "success",

"score": score,

"issue_count": len(issues),

"issues": issues[:10], # First 10 issues

"summary": f"Style score: {score}/100 with {len(issues)} violations"

}

finally:

if os.path.exists(tmp_path):

os.unlink(tmp_path)

def _check_naming_conventions(tree: ast.AST) -> List[Dict[str, Any]]:

"""Check PEP 8 naming conventions."""

naming_issues = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

# Skip private/protected methods and __main__

if not node.name.startswith('_') and node.name != node.name.lower():

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N802',

'message': f"N802 function name '{node.name}' should be lowercase"

})

elif isinstance(node, ast.ClassDef):

# Check if class name follows CapWords convention

if not node.name[0].isupper() or '_' in node.name:

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N801',

'message': f"N801 class name '{node.name}' should use CapWords convention"

})

return naming_issues

def _calculate_style_score(issues: List[Dict[str, Any]]) -> int:

"""Calculate weighted style score based on violation severity."""

if not issues:

return 100

# Define weights by error type

weights = {

'E1': 10, # Indentation errors

'E2': 3, # Whitespace errors

'E3': 5, # Blank line errors

'E4': 8, # Import errors

'E5': 5, # Line length

'E7': 7, # Statement errors

'E9': 10, # Syntax errors

'W2': 2, # Whitespace warnings

'W3': 2, # Blank line warnings

'W5': 3, # Line break warnings

'N8': 7, # Naming conventions

}

total_deduction = 0

for issue in issues:

code_prefix = issue['code'][:2] if len(issue['code']) >= 2 else 'E2'

weight = weights.get(code_prefix, 3)

total_deduction += weight

# Cap at 100 points deduction

return max(0, 100 - min(total_deduction, 100))

Style Checker-Agent hinzufügen

👉 Öffnen

code_review_assistant/sub_agents/review_pipeline/style_checker.py

👉 Finden:

# MODULE_5_STEP_1_INSTRUCTION_PROVIDER

👉 Ersetzen Sie diese einzelne Zeile durch:

async def style_checker_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are a code style expert focused on PEP 8 compliance.

Your task:

1. Use the check_code_style tool to validate PEP 8 compliance

2. The tool will retrieve the ORIGINAL code from state automatically

3. Report violations exactly as found

4. Present the results clearly and confidently

CRITICAL:

- The tool checks the code EXACTLY as provided by the user

- Do not suggest the code was modified or fixed

- Report actual violations found in the original code

- If there are style issues, they should be reported honestly

Call the check_code_style tool with an empty string for the code parameter,

as the tool will retrieve the code from state automatically.

When presenting results based on what the tool returns:

- State the exact score from the tool results

- If score >= 90: "Excellent style compliance!"

- If score 70-89: "Good style with minor improvements needed"

- If score 50-69: "Style needs attention"

- If score < 50: "Significant style improvements needed"

List the specific violations found (the tool will provide these):

- Show line numbers, error codes, and messages

- Focus on the top 10 most important issues

Previous analysis: {structure_analysis_summary}

Format your response as:

## Style Analysis Results

- Style Score: [exact score]/100

- Total Issues: [count]

- Assessment: [your assessment based on score]

## Top Style Issues

[List issues with line numbers and descriptions]

## Recommendations

[Specific fixes for the most critical issues]"""

return await instructions_utils.inject_session_state(template, context)

👉 Finden:

# MODULE_5_STEP_1_STYLE_CHECKER_AGENT

👉 Ersetzen Sie diese einzelne Zeile durch:

style_checker_agent = Agent(

name="StyleChecker",

model=config.worker_model,

description="Checks Python code style against PEP 8 guidelines",

instruction=style_checker_instruction_provider,

tools=[FunctionTool(func=check_code_style)],

output_key="style_check_summary"

)

Schritt 2: Test Runner Agent hinzufügen

Der Test-Runner generiert umfassende Tests und führt sie mit dem integrierten Code-Executor aus.

👉 Öffnen

code_review_assistant/sub_agents/review_pipeline/test_runner.py

👉 Finden:

# MODULE_5_STEP_2_INSTRUCTION_PROVIDER

👉 Ersetzen Sie diese einzelne Zeile durch:

async def test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects the code_to_review directly."""

template = """You are a testing specialist who creates and runs tests for Python code.

THE CODE TO TEST IS:

{code_to_review}

YOUR TASK:

1. Understand what the function appears to do based on its name and structure

2. Generate comprehensive tests (15-20 test cases)

3. Execute the tests using your code executor

4. Analyze results to identify bugs vs expected behavior

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Test with the most natural interpretation first

- When something fails, determine if it's a bug or unusual design

- Test edge cases, boundaries, and error scenarios

- Document any surprising behavior

Execute your tests and output ONLY valid JSON with this structure:

- "test_summary": object with "total_tests_run", "tests_passed", "tests_failed", "tests_with_errors", "critical_issues_found"

- "critical_issues": array of objects, each with "type", "description", "example_input", "expected_behavior", "actual_behavior", "severity"

- "test_categories": object with "basic_functionality", "edge_cases", "error_handling" (each containing "passed", "failed", "errors" counts)

- "function_behavior": object with "apparent_purpose", "actual_interface", "unexpected_requirements"

- "verdict": object with "status" (WORKING/BUGGY/BROKEN), "confidence" (high/medium/low), "recommendation"

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Finden:

# MODULE_5_STEP_2_TEST_RUNNER_AGENT

👉 Ersetzen Sie diese einzelne Zeile durch:

test_runner_agent = Agent(

name="TestRunner",

model=config.critic_model,

description="Generates and runs tests for Python code using safe code execution",

instruction=test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="test_execution_summary"

)

Schritt 3: Speicher für sitzungsübergreifendes Lernen

Bevor Sie den Feedback-Synthesizer erstellen, müssen Sie den Unterschied zwischen Status und Speicher verstehen. Das sind zwei verschiedene Speichermechanismen für zwei verschiedene Zwecke.

Zustand und Arbeitsspeicher: Der entscheidende Unterschied

Hier ein konkretes Beispiel aus der Code-Überprüfung:

Status (nur aktuelle Sitzung):

# Data from THIS review session

tool_context.state[StateKeys.STYLE_ISSUES] = [

{"line": 5, "code": "E231", "message": "missing whitespace"},

{"line": 12, "code": "E701", "message": "multiple statements"}

]

- Umfang: Nur diese Unterhaltung

- Zweck: Daten zwischen Agents in der aktuellen Pipeline übergeben

- Wohnt in:

Session-Objekt - Lifetime: Wird nach Ende der Sitzung verworfen

Arbeitsspeicher (alle bisherigen Sitzungen):

# Learned from 50 previous reviews

"User frequently forgets docstrings on helper functions"

"User tends to write long functions (avg 45 lines)"

"User improved error handling after feedback in session #23"

- Umfang: Alle bisherigen Sitzungen für diesen Nutzer

- Zweck: Muster erkennen, personalisiertes Feedback geben

- Wohnt in:

MemoryService - Lifetime: Bleibt über Sitzungen hinweg erhalten, durchsuchbar

Warum Feedback beides benötigt:

Stellen Sie sich vor, der Synthesizer gibt Feedback:

Nur „State“ verwenden (aktuelle Überprüfung):

"Function `calculate_total` has no docstring."

Allgemeines, mechanisches Feedback.

State + Memory (aktuelle + vergangene Muster) verwenden:

"Function `calculate_total` has no docstring. This is the 4th review

where helper functions lacked documentation. Consider adding docstrings

as you write functions, not afterwards - you mentioned in our last

session that you find it easier that way."

Personalisierte, kontextbezogene Referenzen, die sich im Laufe der Zeit verbessern.

Für die Bereitstellung in der Produktion haben Sie folgende Optionen:

Option 1: VertexAiMemoryBankService (erweitert)

- Funktionsweise:LLM-gestützte Extraktion relevanter Fakten aus Unterhaltungen

- Suche:Semantische Suche (versteht die Bedeutung, nicht nur Suchbegriffe)

- Arbeitsspeicherverwaltung:Erinnerungen werden im Laufe der Zeit automatisch zusammengeführt und aktualisiert.

- Erforderlich:Google Cloud-Projekt + Einrichtung der Agent Engine

- Verwenden, wenn:Sie anspruchsvolle, sich entwickelnde, personalisierte Erinnerungen wünschen.

- Beispiel: „Nutzer bevorzugt funktionale Programmierung“ (aus 10 Unterhaltungen zum Codestil extrahiert)

Option 2: Mit InMemoryMemoryService + Persistent Sessions fortfahren

- Funktionen:Speichert den vollständigen Unterhaltungsverlauf für die Keyword-Suche.

- Suche:Einfacher Keyword-Abgleich über vergangene Sitzungen hinweg

- Speicherverwaltung:Sie legen fest, was gespeichert wird (über

add_session_to_memory). - Erforderlich:Nur ein dauerhaftes

SessionService(z. B.VertexAiSessionServiceoderDatabaseSessionService) - Verwendung: Sie möchten in früheren Unterhaltungen suchen, ohne dass LLM-Verarbeitung erfolgt.

- Beispiel:Wenn Sie nach „docstring“ suchen, werden alle Sitzungen zurückgegeben, in denen dieses Wort erwähnt wird.

So wird der Arbeitsspeicher gefüllt

Nach Abschluss jeder Codeüberprüfung:

# At the end of a session (typically in your application code)

await memory_service.add_session_to_memory(session)

Was passiert?

- InMemoryMemoryService:Speichert die vollständigen Sitzungsereignisse für die Keyword-Suche.

- VertexAiMemoryBankService:LLM extrahiert wichtige Fakten und konsolidiert sie mit vorhandenen Erinnerungen.

In zukünftigen Sitzungen kann dann Folgendes abgefragt werden:

# In a tool, search for relevant past feedback

results = tool_context.search_memory("feedback about docstrings")

Schritt 4: Feedback-Synthesizer-Tools und ‑Agent hinzufügen

Der Feedback-Synthesizer ist der anspruchsvollste Agent in der Pipeline. Es orchestriert drei Tools, verwendet dynamische Anweisungen und kombiniert Status, Speicher und Artefakte.

Die drei Synthesizer-Tools hinzufügen

👉 Öffnen

code_review_assistant/tools.py

👉 Finden:

# MODULE_5_STEP_4_SEARCH_PAST_FEEDBACK

👉 Durch Tool 1 – Memory Search (Produktionsversion) ersetzen:

async def search_past_feedback(developer_id: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Search for past feedback in memory service.

Args:

developer_id: ID of the developer (defaults to "default_user")

tool_context: ADK tool context with potential memory service access

Returns:

Dictionary containing feedback search results

"""

logger.info(f"Tool: Searching for past feedback for developer {developer_id}...")

try:

# Default developer ID if not provided

if not developer_id:

developer_id = tool_context.state.get(StateKeys.USER_ID, 'default_user')

# Check if memory service is available

if hasattr(tool_context, 'search_memory'):

try:

# Perform structured searches

queries = [

f"developer:{developer_id} code review feedback",

f"developer:{developer_id} common issues",

f"developer:{developer_id} improvements"

]

all_feedback = []

patterns = {

'common_issues': [],

'improvements': [],

'strengths': []

}

for query in queries:

search_result = await tool_context.search_memory(query)

if search_result and hasattr(search_result, 'memories'):

for memory in search_result.memories[:5]:

memory_text = memory.text if hasattr(memory, 'text') else str(memory)

all_feedback.append(memory_text)

# Extract patterns

if 'style' in memory_text.lower():

patterns['common_issues'].append('style compliance')

if 'improved' in memory_text.lower():

patterns['improvements'].append('showing improvement')

if 'excellent' in memory_text.lower():

patterns['strengths'].append('consistent quality')

# Store in state

tool_context.state[StateKeys.PAST_FEEDBACK] = all_feedback

tool_context.state[StateKeys.FEEDBACK_PATTERNS] = patterns

logger.info(f"Tool: Found {len(all_feedback)} past feedback items")

return {

"status": "success",

"feedback_found": True,

"count": len(all_feedback),

"summary": " | ".join(all_feedback[:3]) if all_feedback else "No feedback",

"patterns": patterns

}

except Exception as e:

logger.warning(f"Tool: Memory search error: {e}")

# Fallback: Check state for cached feedback

cached_feedback = tool_context.state.get(StateKeys.USER_PAST_FEEDBACK_CACHE, [])

if cached_feedback:

tool_context.state[StateKeys.PAST_FEEDBACK] = cached_feedback

return {

"status": "success",

"feedback_found": True,

"count": len(cached_feedback),

"summary": "Using cached feedback",

"patterns": {}

}

# No feedback found

tool_context.state[StateKeys.PAST_FEEDBACK] = []

logger.info("Tool: No past feedback found")

return {

"status": "success",

"feedback_found": False,

"message": "No past feedback available - this appears to be a first submission",

"patterns": {}

}

except Exception as e:

error_msg = f"Feedback search error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

tool_context.state[StateKeys.PAST_FEEDBACK] = []

return {

"status": "error",

"message": error_msg,

"feedback_found": False

}

👉 Finden:

# MODULE_5_STEP_4_UPDATE_GRADING_PROGRESS

👉 Durch Tool 2 – Grading Tracker (Produktionsversion) ersetzen:

async def update_grading_progress(tool_context: ToolContext) -> Dict[str, Any]:

"""

Updates grading progress counters and metrics in state.

"""

logger.info("Tool: Updating grading progress...")

try:

current_time = datetime.now().isoformat()

# Build all state changes

state_updates = {}

# Temporary (invocation-level) state

state_updates[StateKeys.TEMP_PROCESSING_TIMESTAMP] = current_time

# Session-level state

attempts = tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 0) + 1

state_updates[StateKeys.GRADING_ATTEMPTS] = attempts

state_updates[StateKeys.LAST_GRADING_TIME] = current_time

# User-level persistent state

lifetime_submissions = tool_context.state.get(StateKeys.USER_TOTAL_SUBMISSIONS, 0) + 1

state_updates[StateKeys.USER_TOTAL_SUBMISSIONS] = lifetime_submissions

state_updates[StateKeys.USER_LAST_SUBMISSION_TIME] = current_time

# Calculate improvement metrics

current_style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

last_style_score = tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

score_improvement = current_style_score - last_style_score

state_updates[StateKeys.USER_LAST_STYLE_SCORE] = current_style_score

state_updates[StateKeys.SCORE_IMPROVEMENT] = score_improvement

# Track test results if available

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

if test_results and test_results.get('test_summary', {}).get('total_tests_run', 0) > 0:

summary = test_results['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

pass_rate = (passed / total) * 100

state_updates[StateKeys.USER_LAST_TEST_PASS_RATE] = pass_rate

# Apply all updates atomically

for key, value in state_updates.items():

tool_context.state[key] = value

logger.info(f"Tool: Progress updated - Attempt #{attempts}, "

f"Lifetime: {lifetime_submissions}")

return {

"status": "success",

"session_attempts": attempts,

"lifetime_submissions": lifetime_submissions,

"timestamp": current_time,

"improvement": {

"style_score_change": score_improvement,

"direction": "improved" if score_improvement > 0 else "declined"

},

"summary": f"Attempt #{attempts} recorded, {lifetime_submissions} total submissions"

}

except Exception as e:

error_msg = f"Progress update error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

return {

"status": "error",

"message": error_msg

}

👉 Finden:

# MODULE_5_STEP_4_SAVE_GRADING_REPORT

👉 Mit Tool 3 – Artifact Saver (Produktionsversion) ersetzen:

async def save_grading_report(feedback_text: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Saves a detailed grading report as an artifact.

Args:

feedback_text: The feedback text to include in the report

tool_context: ADK tool context for state management

Returns:

Dictionary containing save status and details

"""

logger.info("Tool: Saving grading report...")

try:

# Gather all relevant data from state

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

analysis = tool_context.state.get(StateKeys.CODE_ANALYSIS, {})

style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

style_issues = tool_context.state.get(StateKeys.STYLE_ISSUES, [])

# Get test results

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

timestamp = datetime.now().isoformat()

# Create comprehensive report dictionary

report = {

'timestamp': timestamp,

'grading_attempt': tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 1),

'code': {

'content': code,

'line_count': len(code.splitlines()),

'hash': hashlib.md5(code.encode()).hexdigest()

},

'analysis': analysis,

'style': {

'score': style_score,

'issues': style_issues[:5] # First 5 issues

},

'tests': test_results,

'feedback': feedback_text,

'improvements': {

'score_change': tool_context.state.get(StateKeys.SCORE_IMPROVEMENT, 0),

'from_last_score': tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

}

}

# Convert report to JSON string

report_json = json.dumps(report, indent=2)

report_part = types.Part.from_text(text=report_json)

# Try to save as artifact if the service is available

if hasattr(tool_context, 'save_artifact'):

try:

# Generate filename with timestamp (replace colons for filesystem compatibility)

filename = f"grading_report_{timestamp.replace(':', '-')}.json"

# Save the main report

version = await tool_context.save_artifact(filename, report_part)

# Also save a "latest" version for easy access

await tool_context.save_artifact("latest_grading_report.json", report_part)

logger.info(f"Tool: Report saved as {filename} (version {version})")

# Store report in state as well for redundancy

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

return {

"status": "success",

"artifact_saved": True,

"filename": filename,

"version": str(version),

"size": len(report_json),

"summary": f"Report saved as {filename}"

}

except Exception as artifact_error:

logger.warning(f"Artifact service error: {artifact_error}, falling back to state storage")

# Continue to fallback below

# Fallback: Store in state if artifact service is not available or failed

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

logger.info("Tool: Report saved to state (artifact service not available)")

return {

"status": "success",

"artifact_saved": False,

"message": "Report saved to state only",

"size": len(report_json),

"summary": "Report saved to session state"

}

except Exception as e:

error_msg = f"Report save error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Still try to save minimal data to state

try:

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = {

'error': error_msg,

'feedback': feedback_text,

'timestamp': datetime.now().isoformat()

}

except:

pass

return {

"status": "error",

"message": error_msg,

"artifact_saved": False,

"summary": f"Failed to save report: {error_msg}"

}

Synthesizer-Agent erstellen

👉 Öffnen

code_review_assistant/sub_agents/review_pipeline/feedback_synthesizer.py

👉 Finden:

# MODULE_5_STEP_4_INSTRUCTION_PROVIDER

👉 Mit dem Anbieter der Produktionsanleitung ersetzen:

async def feedback_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code reviewer and mentor providing constructive, educational feedback.

CONTEXT FROM PREVIOUS AGENTS:

- Structure analysis summary: {structure_analysis_summary}

- Style check summary: {style_check_summary}

- Test execution summary: {test_execution_summary}

YOUR TASK requires these steps IN ORDER:

1. Call search_past_feedback tool with developer_id="default_user"

2. Call update_grading_progress tool with no parameters

3. Carefully analyze the test results to understand what really happened

4. Generate comprehensive feedback following the structure below

5. Call save_grading_report tool with the feedback_text parameter

6. Return the feedback as your final output

CRITICAL - Understanding Test Results:

The test_execution_summary contains structured JSON. Parse it carefully:

- tests_passed = Code worked correctly

- tests_failed = Code produced wrong output

- tests_with_errors = Code crashed

- critical_issues = Fundamental problems with the code

If critical_issues array contains items, these are serious bugs that need fixing.

Do NOT count discovering bugs as test successes.

FEEDBACK STRUCTURE TO FOLLOW:

## 📊 Summary

Provide an honest assessment. Be encouraging but truthful about problems found.

## ✅ Strengths

List 2-3 things done well, referencing specific code elements.

## 📈 Code Quality Analysis

### Structure & Organization

Comment on code organization, readability, and documentation.

### Style Compliance

Report the actual style score and any specific issues.

### Test Results

Report the actual test results accurately:

- If critical_issues exist, report them as bugs to fix

- Be clear: "X tests passed, Y critical issues were found"

- List each critical issue

- Don't hide or minimize problems

## 💡 Recommendations for Improvement

Based on the analysis, provide specific actionable fixes.

If critical issues exist, fixing them is top priority.

## 🎯 Next Steps

Prioritized action list based on severity of issues.

## 💬 Encouragement

End with encouragement while being honest about what needs fixing.

Remember: Complete ALL steps including calling save_grading_report."""

return await instructions_utils.inject_session_state(template, context)

👉 Finden:

# MODULE_5_STEP_4_SYNTHESIZER_AGENT

👉 Ersetzen durch:

feedback_synthesizer_agent = Agent(

name="FeedbackSynthesizer",

model=config.critic_model,

description="Synthesizes all analysis into constructive, personalized feedback",

instruction=feedback_instruction_provider,

tools=[

FunctionTool(func=search_past_feedback),

FunctionTool(func=update_grading_progress),

FunctionTool(func=save_grading_report)

],

output_key="final_feedback"

)

Schritt 5: Pipeline verbinden

Verbinden Sie nun alle vier Agents in einer sequenziellen Pipeline und erstellen Sie den Root-Agent.

👉 Öffnen

code_review_assistant/agent.py

👉 Fügen Sie oben in der Datei (nach den vorhandenen Importen) die erforderlichen Importe hinzu:

from google.adk.agents import Agent, SequentialAgent

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

Ihre Datei sollte jetzt so aussehen:

"""

Main agent orchestration for the Code Review Assistant.

"""

from google.adk.agents import Agent, SequentialAgent

from .config import config

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

# MODULE_5_STEP_5_CREATE_PIPELINE

# MODULE_6_STEP_5_CREATE_FIX_LOOP

# MODULE_6_STEP_5_UPDATE_ROOT_AGENT

👉 Suchen:

# MODULE_5_STEP_5_CREATE_PIPELINE

👉 Ersetzen Sie diese einzelne Zeile durch:

# Create sequential pipeline

code_review_pipeline = SequentialAgent(

name="CodeReviewPipeline",

description="Complete code review pipeline with analysis, testing, and feedback",

sub_agents=[

code_analyzer_agent,

style_checker_agent,

test_runner_agent,

feedback_synthesizer_agent

]

)

# Root agent - coordinates the review pipeline

root_agent = Agent(

name="CodeReviewAssistant",

model=config.worker_model,

description="An intelligent code review assistant that analyzes Python code and provides educational feedback",

instruction="""You are a specialized Python code review assistant focused on helping developers improve their code quality.

When a user provides Python code for review:

1. Immediately delegate to CodeReviewPipeline and pass the code EXACTLY as it was provided by the user.

2. The pipeline will handle all analysis and feedback

3. Return ONLY the final feedback from the pipeline - do not add any commentary

When a user asks what you can do or asks general questions:

- Explain your capabilities for code review

- Do NOT trigger the pipeline for non-code messages

The pipeline handles everything for code review - just pass through its final output.""",

sub_agents=[code_review_pipeline],

output_key="assistant_response"

)

Schritt 6: Vollständige Pipeline testen

Jetzt sehen wir alle vier Agents in Aktion.

👉 System starten:

adk web code_review_assistant

Nachdem Sie den Befehl adk web ausgeführt haben, sollte in Ihrem Terminal eine Ausgabe angezeigt werden, die darauf hinweist, dass der ADK-Webserver gestartet wurde. Sie sollte in etwa so aussehen:

+-----------------------------------------------------------------------------+

| ADK Web Server started |

| |

| For local testing, access at http://localhost:8000. |

+-----------------------------------------------------------------------------+

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

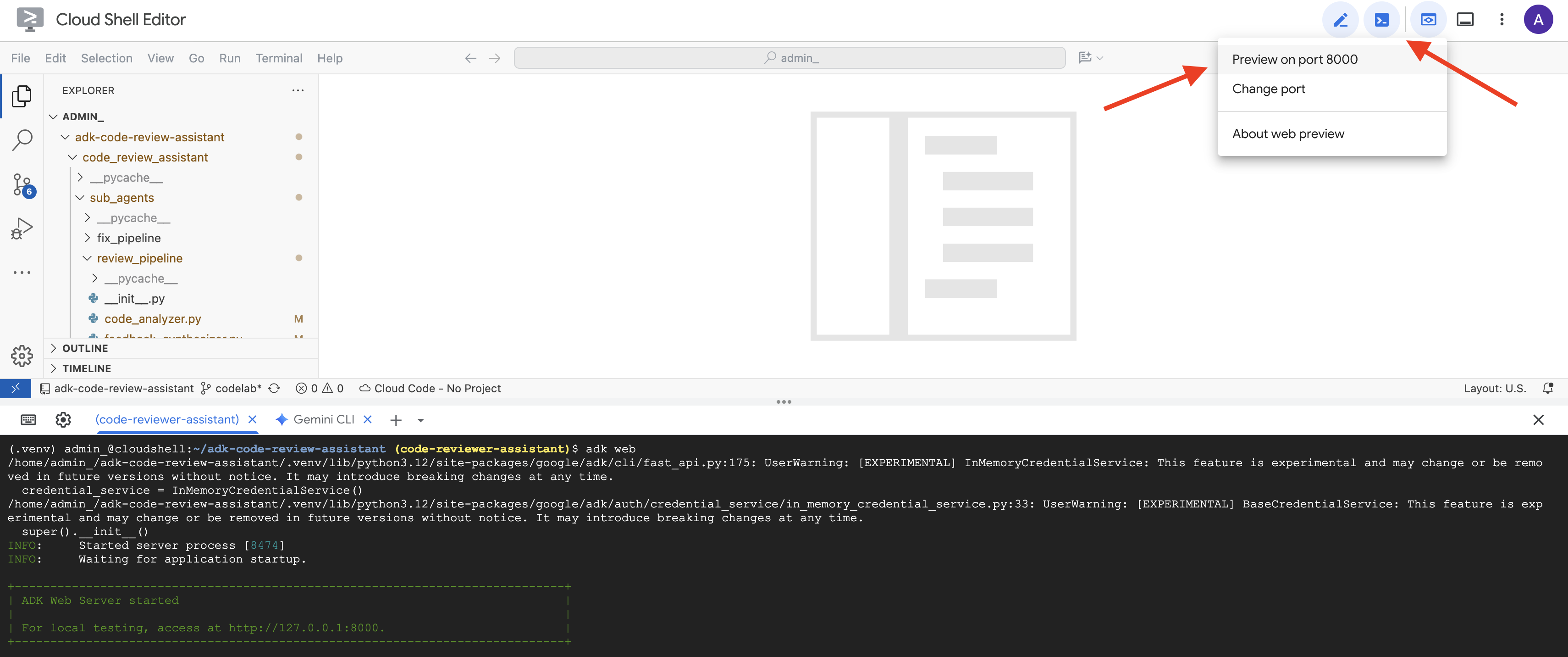

👉 So greifen Sie über Ihren Browser auf die ADK Dev UI zu:

Wählen Sie in der Cloud Shell-Symbolleiste (normalerweise oben rechts) über das Symbol „Webvorschau“ (oft ein Auge oder ein Quadrat mit einem Pfeil) die Option „Port ändern“ aus. Legen Sie im Pop-up-Fenster den Port auf 8000 fest und klicken Sie auf „Ändern und Vorschau“. Cloud Shell öffnet dann einen neuen Browsertab oder ein neues Browserfenster mit der ADK Dev-Benutzeroberfläche.

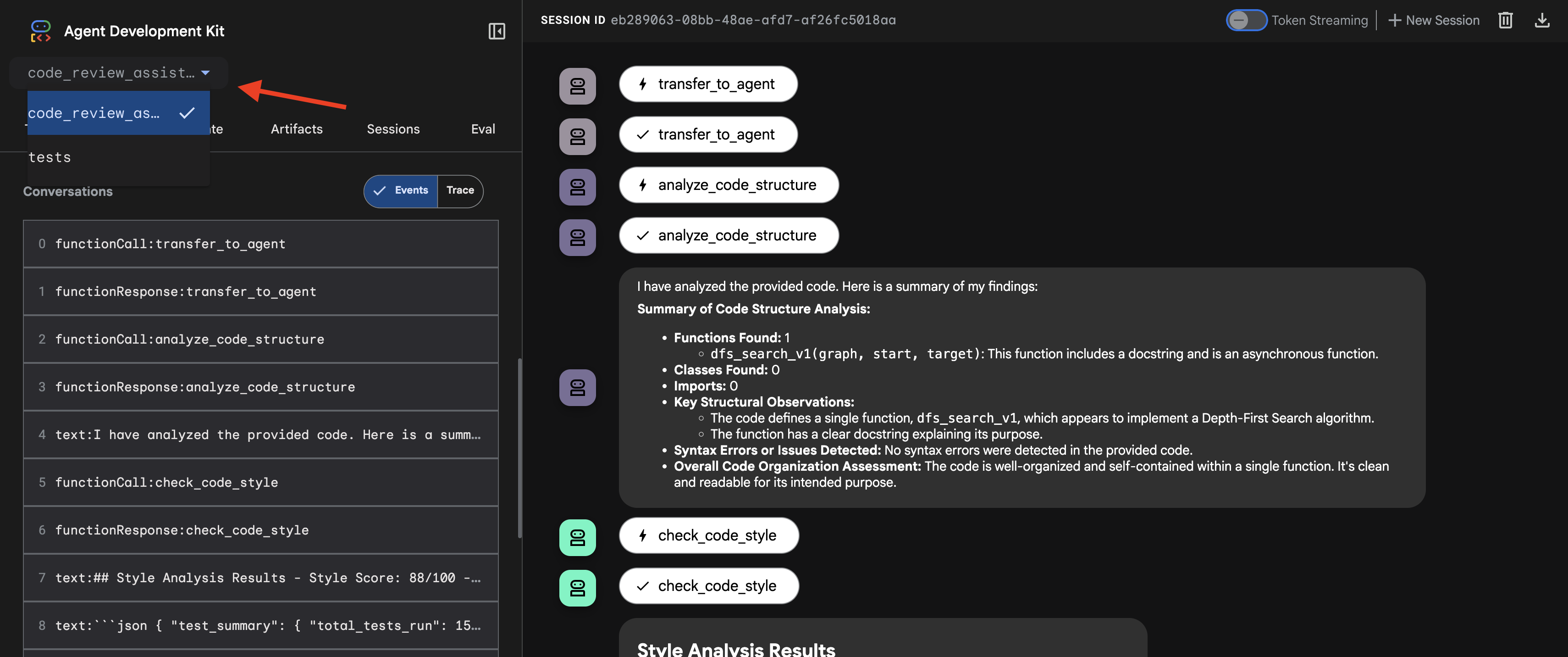

👉 Der Agent wird jetzt ausgeführt. Die ADK Dev UI in Ihrem Browser ist Ihre direkte Verbindung zum Agent.

- Ziel auswählen: Wählen Sie im Drop-down-Menü oben in der Benutzeroberfläche den

code_review_assistant-Agent aus.

👉 Test-Prompt:

Please analyze the following:

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

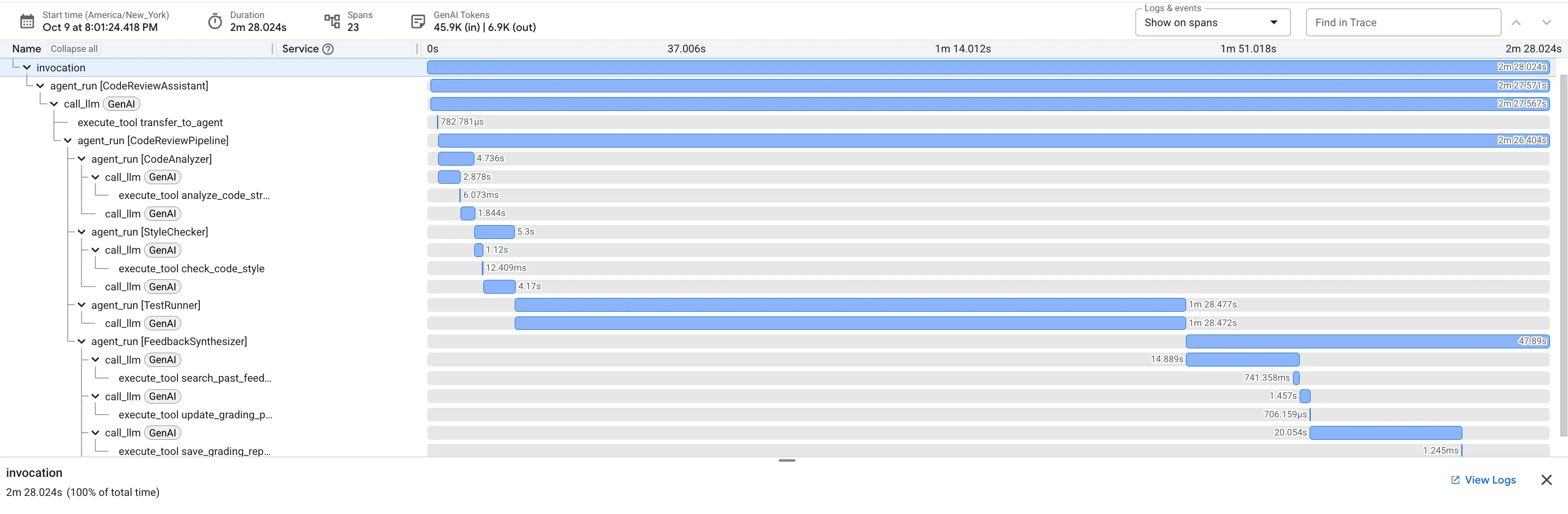

👉 Code-Review-Pipeline in Aktion ansehen:

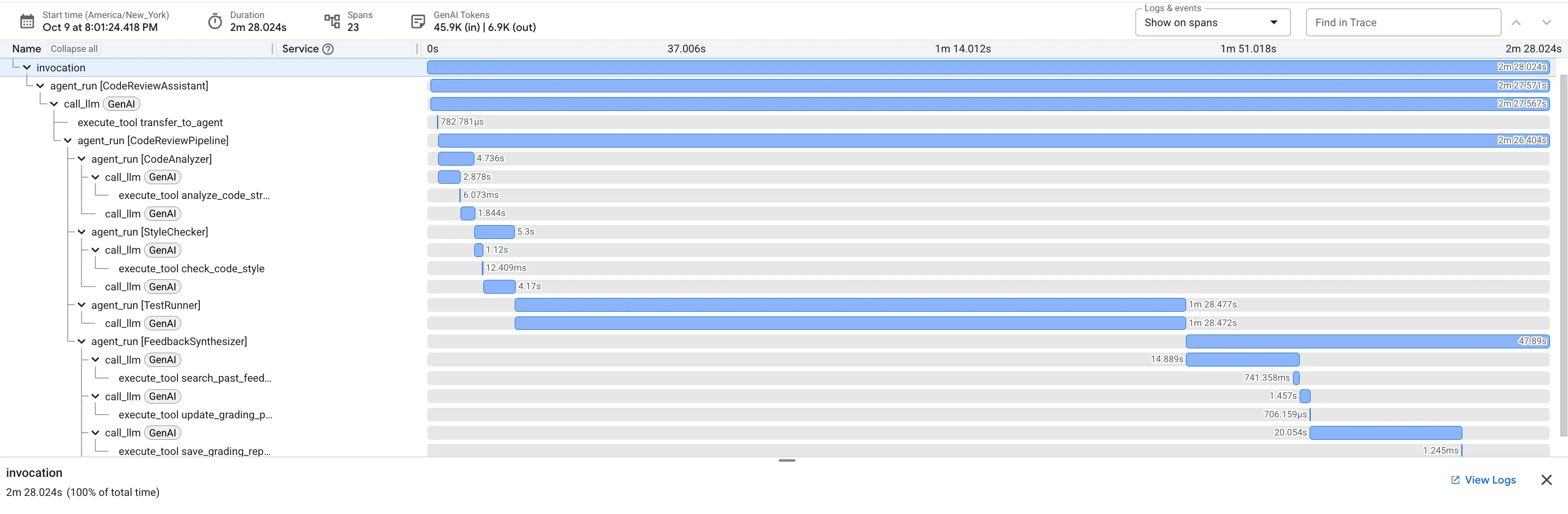

Wenn Sie die fehlerhafte dfs_search_v1-Funktion einreichen, erhalten Sie nicht nur eine Antwort. Sie sehen, wie Ihre Multi-Agent-Pipeline funktioniert. Die Streaming-Ausgabe, die Sie sehen, ist das Ergebnis von vier spezialisierten Agents, die nacheinander ausgeführt werden und jeweils auf dem vorherigen aufbauen.

Hier sehen Sie, wie die einzelnen Agents zur endgültigen, umfassenden Überprüfung beitragen und Rohdaten in verwertbare Informationen umwandeln.

1. Strukturbericht des Code-Analyzers

Zuerst empfängt der CodeAnalyzer-Agent den Rohcode. Es wird nicht geraten, was der Code tut, sondern das analyze_code_structure-Tool wird verwendet, um eine deterministische Analyse des abstrakten Syntaxbaums (Abstract Syntax Tree, AST) durchzuführen.

Die Ausgabe besteht aus reinen, sachlichen Daten zur Struktur des Codes:

The analysis of the provided code reveals the following:

Summary:

- Functions Found: 1

- Classes Found: 0

Key Structural Observations:

- A single function, dfs_search_v1, is defined.

- It includes a docstring: "Find if target is reachable from start."

- No syntax errors were detected.

Overall Code Organization Assessment:

- The code snippet is a well-defined, self-contained function.

⭐ Wert:Dieser erste Schritt bietet eine saubere, zuverlässige Grundlage für die anderen Agents. Es wird bestätigt, dass der Code gültiger Python-Code ist, und die genauen Komponenten werden identifiziert, die überprüft werden müssen.

2. PEP 8-Prüfung durch den Style Checker

Als Nächstes übernimmt der StyleChecker-Agent. Der Code wird aus dem freigegebenen Status gelesen und das check_code_style-Tool verwendet, das den pycodestyle-Linter nutzt.

Die Ausgabe besteht aus einem quantifizierbaren Qualitätsfaktor und spezifischen Verstößen:

Style Analysis Results

- Style Score: 88/100

- Total Issues: 6

- Assessment: Good style with minor improvements needed

Top Style Issues

- Line 5, W293: blank line contains whitespace

- Line 19, W292: no newline at end of file

⭐ Wert:Dieser Agent gibt objektives, nicht verhandelbares Feedback basierend auf etablierten Community-Standards (PEP 8). Das gewichtete Punktesystem zeigt dem Nutzer sofort den Schweregrad der Probleme an.

3. Kritische Fehlererkennung des Test-Ausführers

Hier geht das System über die oberflächliche Analyse hinaus. Der TestRunner-Agent generiert und führt eine umfassende Reihe von Tests aus, um das Verhalten des Codes zu validieren.

Die Ausgabe ist ein strukturiertes JSON-Objekt, das ein vernichtendes Urteil enthält:

{

"critical_issues": [

{

"type": "Critical Bug",

"description": "The function's initialization `stack = start` is incorrect... When a common input like a string... is provided... the function crashes with an AttributeError.",

"severity": "Critical"

}

],

"verdict": {

"status": "BROKEN",

"confidence": "high",

"recommendation": "The function is fundamentally broken... the stack initialization line `stack = start` must be changed to `stack = [start]`."

}

}

⭐ Wert:Das ist die wichtigste Erkenntnis. Der Agent hat nicht nur geraten, sondern bewiesen, dass der Code fehlerhaft ist, indem er ihn ausgeführt hat. Es wurde ein subtiler, aber kritischer Laufzeitfehler aufgedeckt, den ein menschlicher Prüfer leicht übersehen könnte. Außerdem wurde die genaue Ursache und die erforderliche Korrektur ermittelt.

4. Abschlussbericht des Feedback-Synthesizers

Schließlich fungiert der FeedbackSynthesizer-Agent als Dirigent. Er nimmt die strukturierten Daten der drei vorherigen Agents und erstellt daraus einen einzigen, benutzerfreundlichen Bericht, der sowohl analytisch als auch motivierend ist.

Die Ausgabe ist die endgültige, überarbeitete Rezension, die Sie sehen:

📊 Summary

Great effort on implementing the Depth-First Search algorithm! ... However, a critical bug in the initialization of the stack prevents the function from working correctly...

✅ Strengths

- Good Algorithm Structure

- Correct Use of `visited` Set

📈 Code Quality Analysis

...

### Style Compliance

The style analysis returned a good score of 88/100.

...

### Test Results

The automated testing revealed a critical issue... The line `stack = start` directly assigns the input... which results in an `AttributeError`.

💡 Recommendations for Improvement

**Fix the Critical Stack Initialization Bug:**

- Incorrect Code: `stack = start`

- Correct Code: `stack = [start]`

💬 Encouragement

You are very close to a perfect implementation! The core logic of your DFS algorithm is sound, which is the hardest part.

⭐ Wert:Dieser Agent wandelt technische Daten in hilfreiche Informationen um. Es wird das wichtigste Problem (der Fehler) priorisiert, es wird klar erklärt, die genaue Lösung wird angegeben und das Ganze wird in einem ermutigenden Ton formuliert. Hier werden die Ergebnisse aus allen vorherigen Phasen in ein kohäsives und wertvolles Ganzes integriert.

Dieser mehrstufige Prozess zeigt die Leistungsfähigkeit einer Agenten-Pipeline. Statt einer einzelnen, monolithischen Antwort erhalten Sie eine mehrschichtige Analyse, bei der jeder Agent eine spezielle, überprüfbare Aufgabe ausführt. So erhalten Sie eine Überprüfung, die nicht nur aufschlussreich, sondern auch deterministisch, zuverlässig und sehr lehrreich ist.

👉💻 Wenn Sie mit dem Testen fertig sind, kehren Sie zum Cloud Shell Editor-Terminal zurück und drücken Sie Ctrl+C, um die ADK Dev UI zu beenden.

Was Sie erstellt haben

Sie haben jetzt eine vollständige Pipeline für die Codeüberprüfung, die:

✅ Parses code structure (Code-Struktur analysieren) – deterministische AST-Analyse mit Hilfsfunktionen

✅ Checks style (Stil prüfen) – gewichtete Bewertung mit Namenskonventionen

✅ Runs tests (Tests ausführen) – umfassende Testgenerierung mit strukturierter JSON-Ausgabe

✅ Synthesizes feedback (Feedback zusammenfassen) – Integration von Status, Speicher und Artefakten

✅ Tracks progress (Fortschritt verfolgen) – mehrstufiger Status über Aufrufe/Sitzungen/Nutzer hinweg

✅ Learns over time (Im Laufe der Zeit lernen) – Speicherdienst für sitzungsübergreifende Muster

✅ Provides artifacts (Artefakte bereitstellen) – herunterladbare JSON-Berichte mit vollständigem Prüfpfad

Beherrschte Schlüsselkonzepte

Sequenzielle Pipelines:

- Vier Agents, die in strenger Reihenfolge ausgeführt werden

- Jeder Zustand wird für den nächsten angereichert.

- Abhängigkeiten bestimmen die Ausführungsreihenfolge

Produktionsmuster:

- Trennung von Hilfsfunktionen (Synchronisierung in Threadpools)

- Graduelle Fehlertoleranz (Fallback-Strategien)

- Statusverwaltung auf mehreren Ebenen (temporär/Sitzung/Nutzer)

- Anbieter dynamischer Anweisungen (kontextbezogen)

- Dualer Speicher (Artefakte + Statusredundanz)

Status als Mitteilung:

- Konstanten verhindern Tippfehler in allen Agents.

output_keyschreibt Agent-Zusammenfassungen in den Status- Spätere Agenten lesen über StateKeys

- Status fließt linear durch die Pipeline

Arbeitsspeicher und Status:

- Status: Daten der aktuellen Sitzung

- Arbeitsspeicher: Muster über Sitzungen hinweg

- Unterschiedliche Zwecke, unterschiedliche Lebensdauer

Tool-Orchestrierung:

- Agents mit einem Tool (analyzer, style_checker)

- Integrierte Executors (test_runner)

- Koordination mehrerer Tools (Synthesizer)

Strategie zur Modellauswahl:

- Worker-Modell: mechanische Aufgaben (Parsing, Linting, Routing)

- Kritikermodell: Aufgaben zum logischen Denken (Testen, Synthese)

- Kostenoptimierung durch geeignete Auswahl

Weitere Informationen

In Modul 6 erstellen Sie die Fix-Pipeline:

- LoopAgent-Architektur für iterative Korrekturen

- Ausstiegsbedingungen über Eskalierung

- Zustandsakkumulierung über Iterationen hinweg

- Validierungs- und Wiederholungslogik

- Integration in die Überprüfungspipeline, um Korrekturen anzubieten

Sie sehen, wie dieselben Statusmuster auf komplexe iterative Arbeitsabläufe skaliert werden, in denen Agents mehrere Versuche unternehmen, bis sie erfolgreich sind, und wie mehrere Pipelines in einer einzigen Anwendung koordiniert werden.

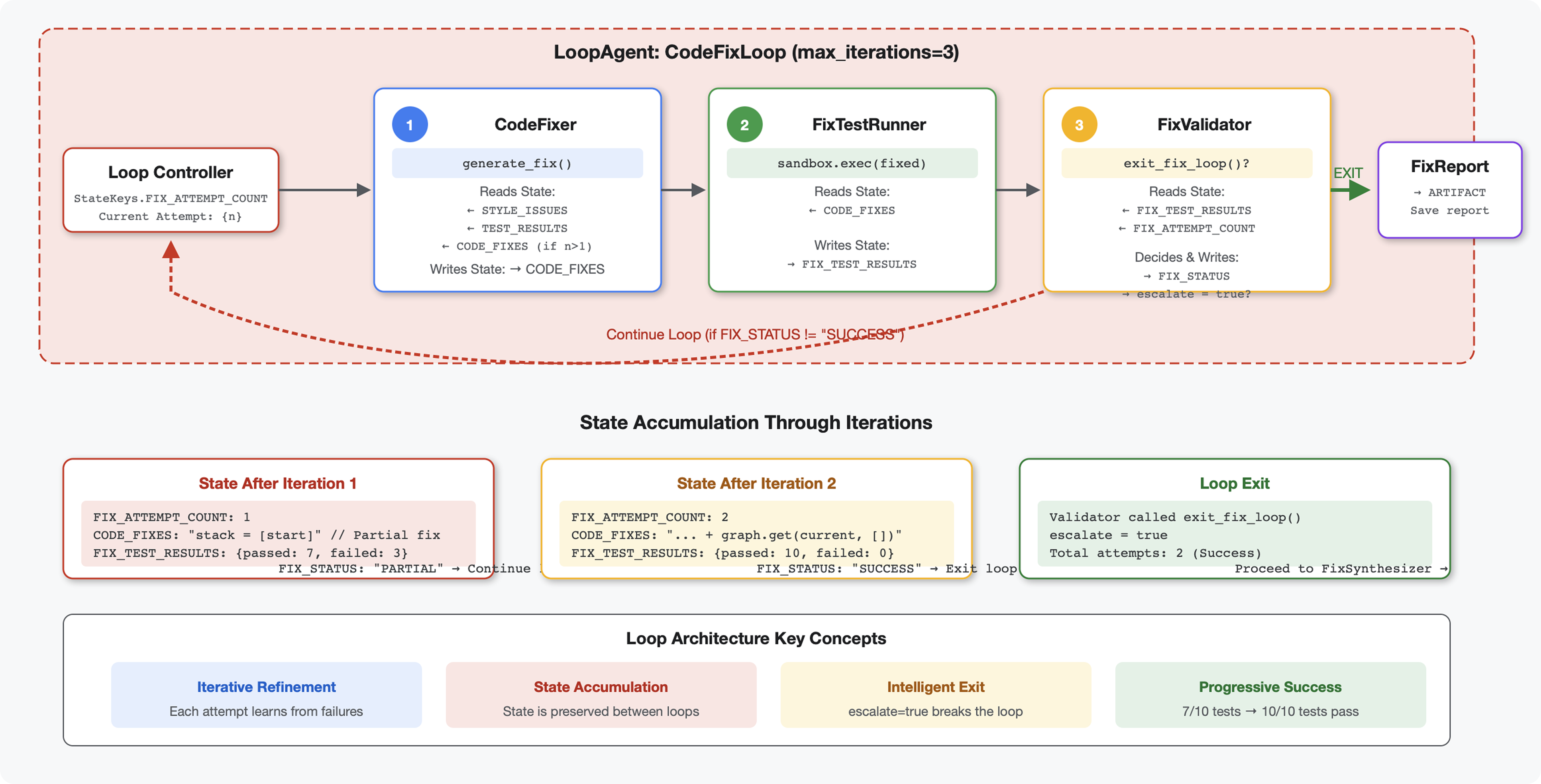

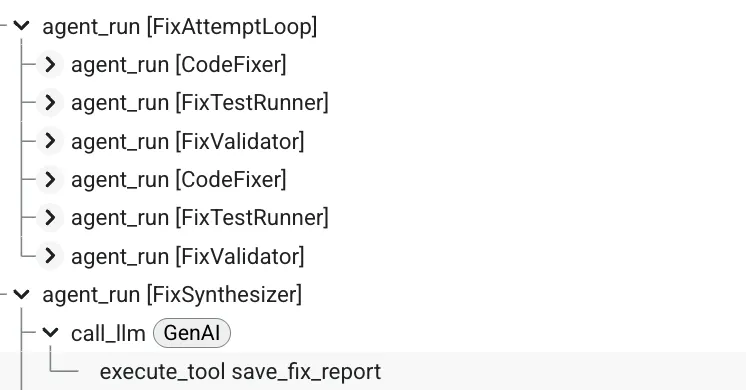

6. Fix-Pipeline hinzufügen: Loop-Architektur

Einführung

In Modul 5 haben Sie eine Pipeline für die sequenzielle Überprüfung erstellt, die Code analysiert und Feedback gibt. Das Identifizieren von Problemen ist jedoch nur die halbe Lösung – Entwickler benötigen Hilfe bei der Behebung.

In diesem Modul wird eine automatisierte Korrekturpipeline erstellt, die:

- Korrekturen werden basierend auf den Überprüfungsergebnissen generiert

- Fehlerbehebungen werden durch umfassende Tests validiert.

- Automatische Wiederholungen, wenn Korrekturen nicht funktionieren (bis zu 3 Versuche)

- Berichtsergebnisse mit Vorher-Nachher-Vergleichen

Schlüsselkonzept: LoopAgent für automatische Wiederholungen Im Gegensatz zu sequenziellen Agents, die einmal ausgeführt werden, wiederholt ein LoopAgent seine untergeordneten Agents, bis eine Beendigungsbedingung erfüllt oder die maximale Anzahl von Iterationen erreicht ist. Tools signalisieren Erfolg, indem sie tool_context.actions.escalate = True festlegen.

Vorschau auf das, was Sie erstellen werden:Fehlerhaften Code einreichen → Überprüfung identifiziert Probleme → Korrekturschleife generiert Korrekturen → Tests validieren → bei Bedarf Wiederholungen → umfassender Abschlussbericht.

Wichtige Konzepte: LoopAgent im Vergleich zu sequenziell

Sequenzielle Pipeline (Modul 5):

SequentialAgent(agents=[A, B, C])

# Executes: A → B → C → Done

- Einseitiger Fluss

- Jeder Agent wird genau einmal ausgeführt.

- Keine Wiederholungslogik

Loop-Pipeline (Modul 6):

LoopAgent(agents=[A, B, C], max_iterations=3)

# Executes: A → B → C → (check exit) → A → B → C → (check exit) → ...

- Zyklischer Fluss

- Agents können mehrmals ausgeführt werden

- Beendet, wenn:

- Ein Tool setzt

tool_context.actions.escalate = True(Erfolg) max_iterationserreicht (Sicherheitsgrenzwert)- Es tritt eine unbehandelte Ausnahme auf (Fehler)

- Ein Tool setzt

Warum Schleifen zum Korrigieren von Code verwendet werden:

Für Codekorrekturen sind oft mehrere Versuche erforderlich:

- Erster Versuch: Offensichtliche Fehler beheben (falsche Variablentypen)

- Zweiter Versuch: Beheben Sie sekundäre Probleme, die durch Tests aufgedeckt wurden (Grenzfälle).

- Dritter Versuch: Alle Tests optimieren und validieren

Ohne Schleife wäre eine komplexe bedingte Logik in den Agent-Anweisungen erforderlich. Bei LoopAgent erfolgt der Wiederholungsversuch automatisch.

Architekturvergleich:

Sequential (Module 5):

User → Review Pipeline → Feedback → Done

Loop (Module 6):

User → Review Pipeline → Feedback → Fix Pipeline

↓

┌──────────────┴──────────────┐

│ Fix Attempt Loop (1-3x) │

│ ┌─────────────────────┐ │

│ │ 1. Generate Fixes │ │

│ │ 2. Test Fixes │ │

│ │ 3. Validate & Exit? │────┼─→ If escalate=True

│ └─────────────────────┘ │ exit loop

│ ↓ If not │

│ Try Again (max 3) │

└─────────────────────────────┘

↓

4. Synthesize Final Report → Done

Schritt 1: Code Fixer-Agent hinzufügen

Der Code-Fixer generiert korrigierten Python-Code basierend auf den Prüfungsergebnissen.

👉 Öffnen

code_review_assistant/sub_agents/fix_pipeline/code_fixer.py

👉 Finden:

# MODULE_6_STEP_1_CODE_FIXER_INSTRUCTION_PROVIDER

👉 Ersetzen Sie diese einzelne Zeile durch:

async def code_fixer_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code fixing specialist.

Original Code:

{code_to_review}

Analysis Results:

- Style Score: {style_score}/100

- Style Issues: {style_issues}

- Test Results: {test_execution_summary}

Based on the test results, identify and fix ALL issues including:

- Interface bugs (e.g., if start parameter expects wrong type)

- Logic errors (e.g., KeyError when accessing graph nodes)

- Style violations

- Missing documentation

YOUR TASK:

Generate the complete fixed Python code that addresses all identified issues.

CRITICAL INSTRUCTIONS:

- Output ONLY the corrected Python code

- Do NOT include markdown code blocks (```python)

- Do NOT include any explanations or commentary

- The output should be valid, executable Python code and nothing else

Common fixes to apply based on test results:

- If tests show AttributeError with 'pop', fix: stack = [start] instead of stack = start

- If tests show KeyError accessing graph, fix: use graph.get(current, [])

- Add docstrings if missing

- Fix any style violations identified

Output the complete fixed code now:"""

return await instructions_utils.inject_session_state(template, context)

👉 Finden:

# MODULE_6_STEP_1_CODE_FIXER_AGENT

👉 Ersetzen Sie diese einzelne Zeile durch:

code_fixer_agent = Agent(

name="CodeFixer",

model=config.worker_model,

description="Generates comprehensive fixes for all identified code issues",

instruction=code_fixer_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="code_fixes"

)

Schritt 2: Fix Test Runner Agent hinzufügen

Der Fix-Test-Runner validiert Korrekturen, indem er umfassende Tests für den korrigierten Code ausführt.

👉 Öffnen

code_review_assistant/sub_agents/fix_pipeline/fix_test_runner.py

👉 Finden:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_INSTRUCTION_PROVIDER

👉 Ersetzen Sie diese einzelne Zeile durch:

async def fix_test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that uses the clean code from the previous step."""

template = """You are responsible for validating the fixed code by running tests.

THE FIXED CODE TO TEST:

{code_fixes}

ORIGINAL TEST RESULTS: {test_execution_summary}

YOUR TASK:

1. Understand the fixes that were applied

2. Generate the same comprehensive tests (15-20 test cases)

3. Execute the tests on the FIXED code using your code executor

4. Compare results with original test results

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Run the same tests that revealed issues in the original code

- Verify that previously failing tests now pass

- Ensure no regressions were introduced

- Document the improvement

Execute your tests and output ONLY valid JSON with this structure:

- "passed": number of tests that passed

- "failed": number of tests that failed

- "total": total number of tests

- "pass_rate": percentage as a number

- "comparison": object with "original_pass_rate", "new_pass_rate", "improvement"

- "newly_passing_tests": array of test names that now pass

- "still_failing_tests": array of test names still failing

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Finden:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_AGENT

👉 Ersetzen Sie diese einzelne Zeile durch:

fix_test_runner_agent = Agent(

name="FixTestRunner",

model=config.critic_model,

description="Runs comprehensive tests on fixed code to verify all issues are resolved",

instruction=fix_test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="fix_test_execution_summary"

)

Schritt 3: Fix Validator Agent hinzufügen

Der Validator prüft, ob die Korrekturen erfolgreich waren, und entscheidet, ob die Schleife beendet werden soll.

Tools

Fügen Sie zuerst die drei Tools hinzu, die für die Validierung erforderlich sind.

👉 Öffnen

code_review_assistant/tools.py

👉 Finden:

# MODULE_6_STEP_3_VALIDATE_FIXED_STYLE

👉 Mit Tool 1 ersetzen – Style Validator:

async def validate_fixed_style(tool_context: ToolContext) -> Dict[str, Any]:

"""

Validates style compliance of the fixed code.

Args:

tool_context: ADK tool context containing fixed code in state

Returns:

Dictionary with style validation results

"""

logger.info("Tool: Validating style of fixed code...")

try:

# Get the fixed code from state