1. La revisión de código nocturna

Son las 2 a.m.

Llevas horas depurando. La función parece correcta, pero algo anda mal. Conoces esa sensación: cuando el código debería funcionar, pero no lo hace, y ya no puedes ver por qué, porque lo has estado mirando durante demasiado tiempo.

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start # Looks innocent enough...

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

El recorrido del desarrollador de IA

Si estás leyendo esto, es probable que ya hayas experimentado la transformación que la IA aporta a la programación. Herramientas como Gemini Code Assist, Claude Code y Cursor cambiaron la forma en que escribimos código. Son increíbles para generar código estándar, sugerir implementaciones y acelerar el desarrollo.

Pero estás aquí porque quieres profundizar más. Quieres comprender cómo crear estos sistemas de IA, no solo usarlos. Quieres crear algo que cumpla con los siguientes requisitos:

- Tiene un comportamiento predecible y rastreable

- Se puede implementar en producción con confianza

- Proporciona resultados coherentes en los que puedes confiar

- Te muestra exactamente cómo toma decisiones

De consumidor a creador

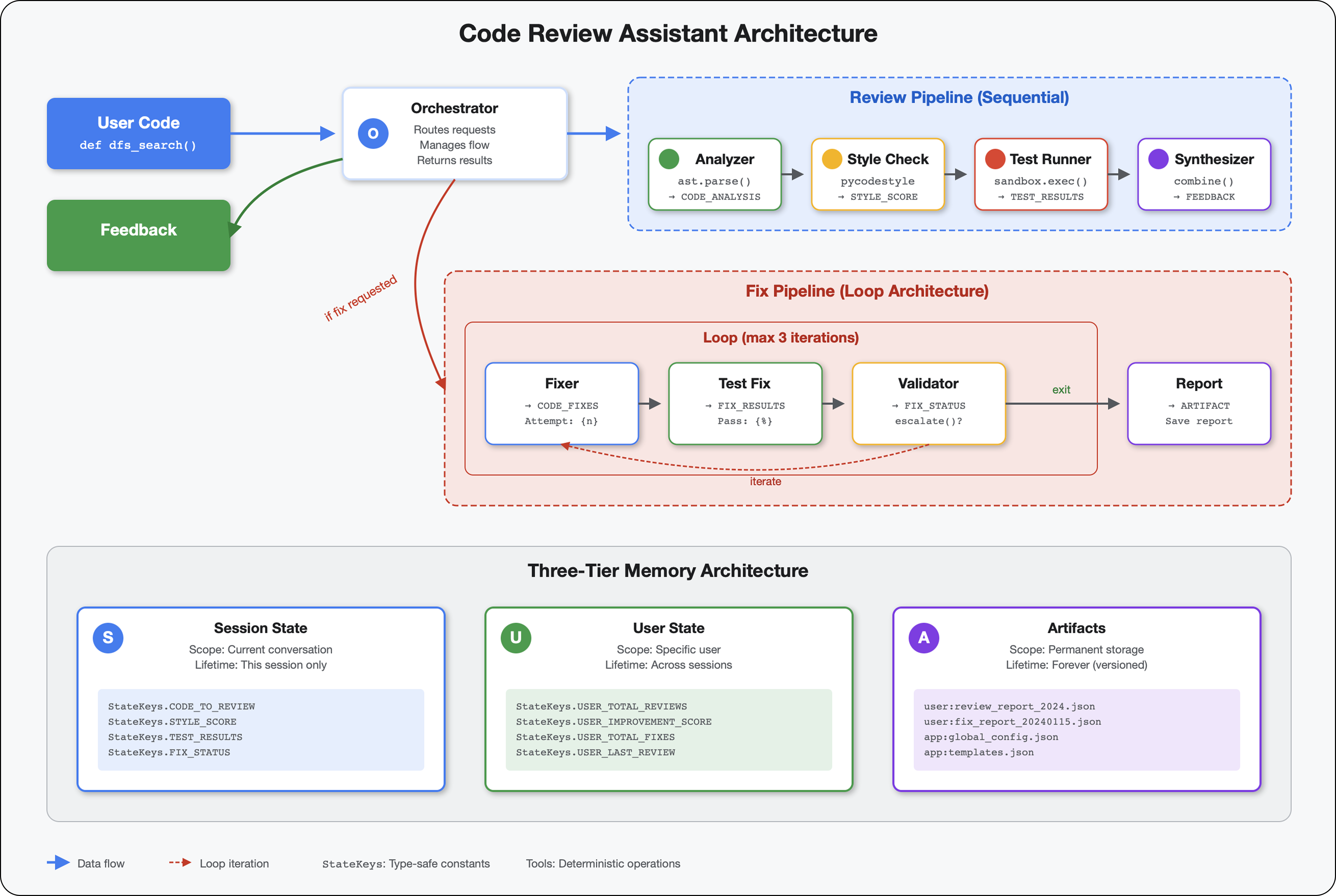

Hoy, pasarás de usar herramientas de IA a crearlas. Crearás un sistema multiagente que haga lo siguiente:

- Analiza la estructura del código de forma determinística.

- Ejecuta pruebas reales para verificar el comportamiento

- Valida el cumplimiento del estilo con verificadores reales

- Sintetiza los hallazgos en comentarios prácticos

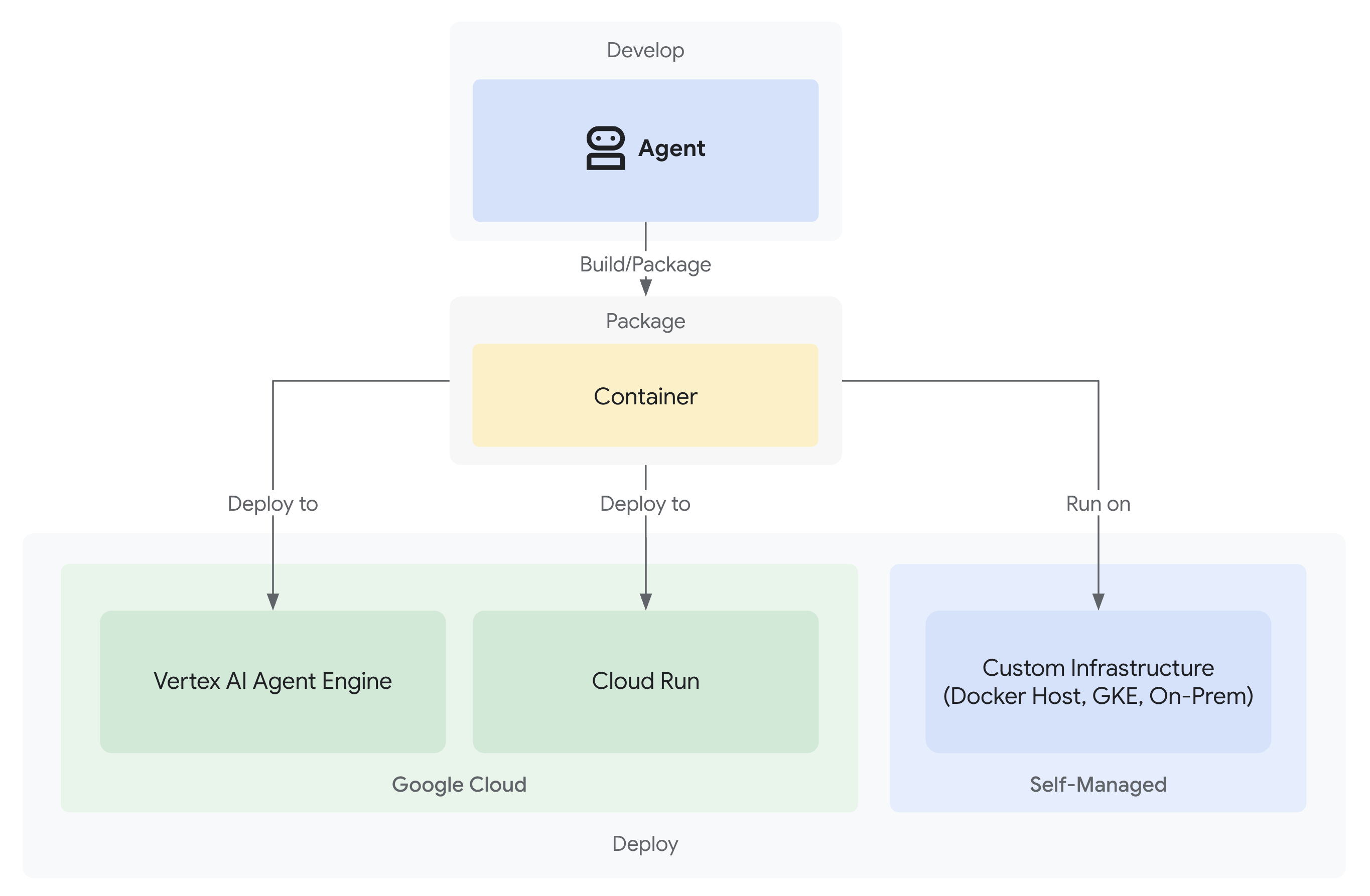

- Implementa en Google Cloud con observabilidad completa

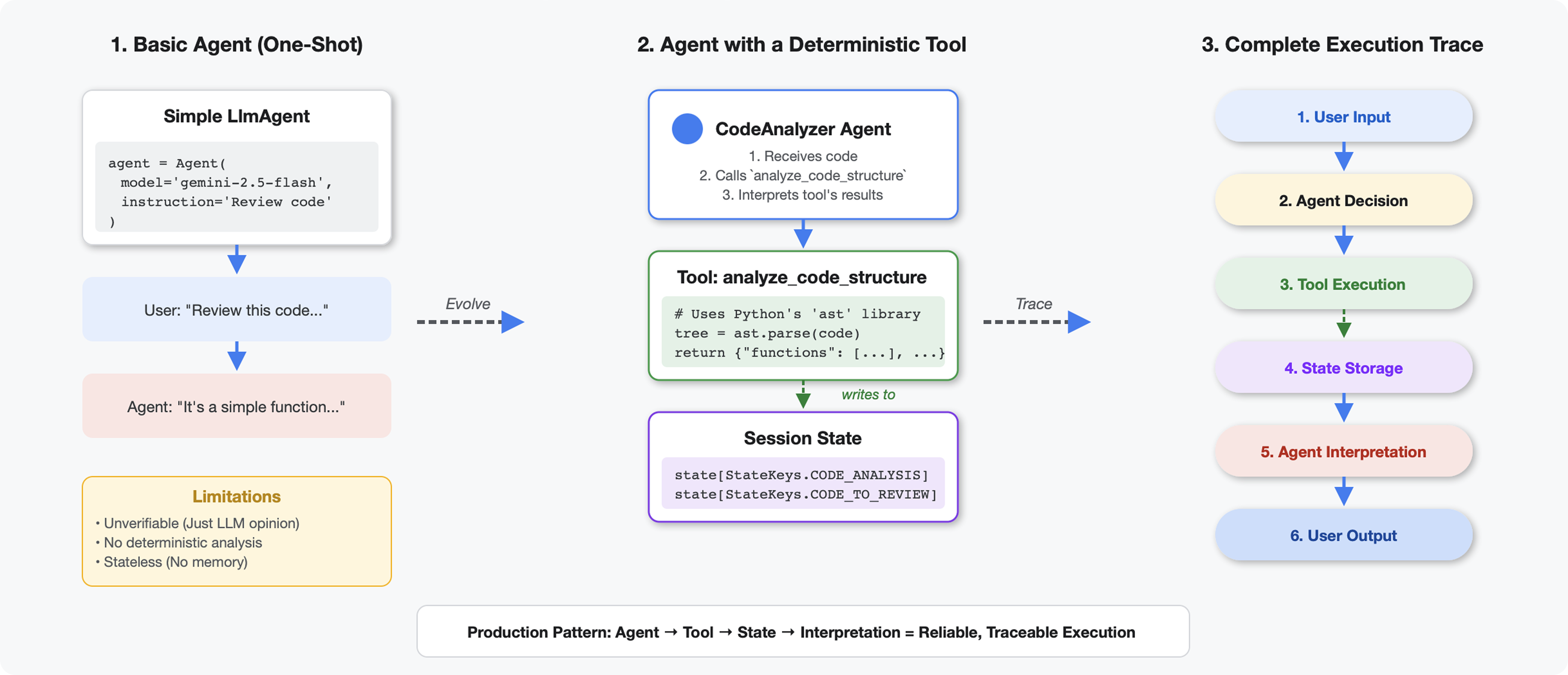

2. Tu primera implementación de un agente

La pregunta del desarrollador

"Entiendo los LLMs y usé las APIs, pero ¿cómo paso de una secuencia de comandos de Python a un agente de IA de producción que se escale?".

Para responder esta pregunta, configuraremos tu entorno de forma adecuada y, luego, compilaremos un agente simple para comprender los conceptos básicos antes de profundizar en los patrones de producción.

Primero, la configuración esencial

Antes de crear cualquier agente, asegúrate de que tu entorno de Google Cloud esté listo.

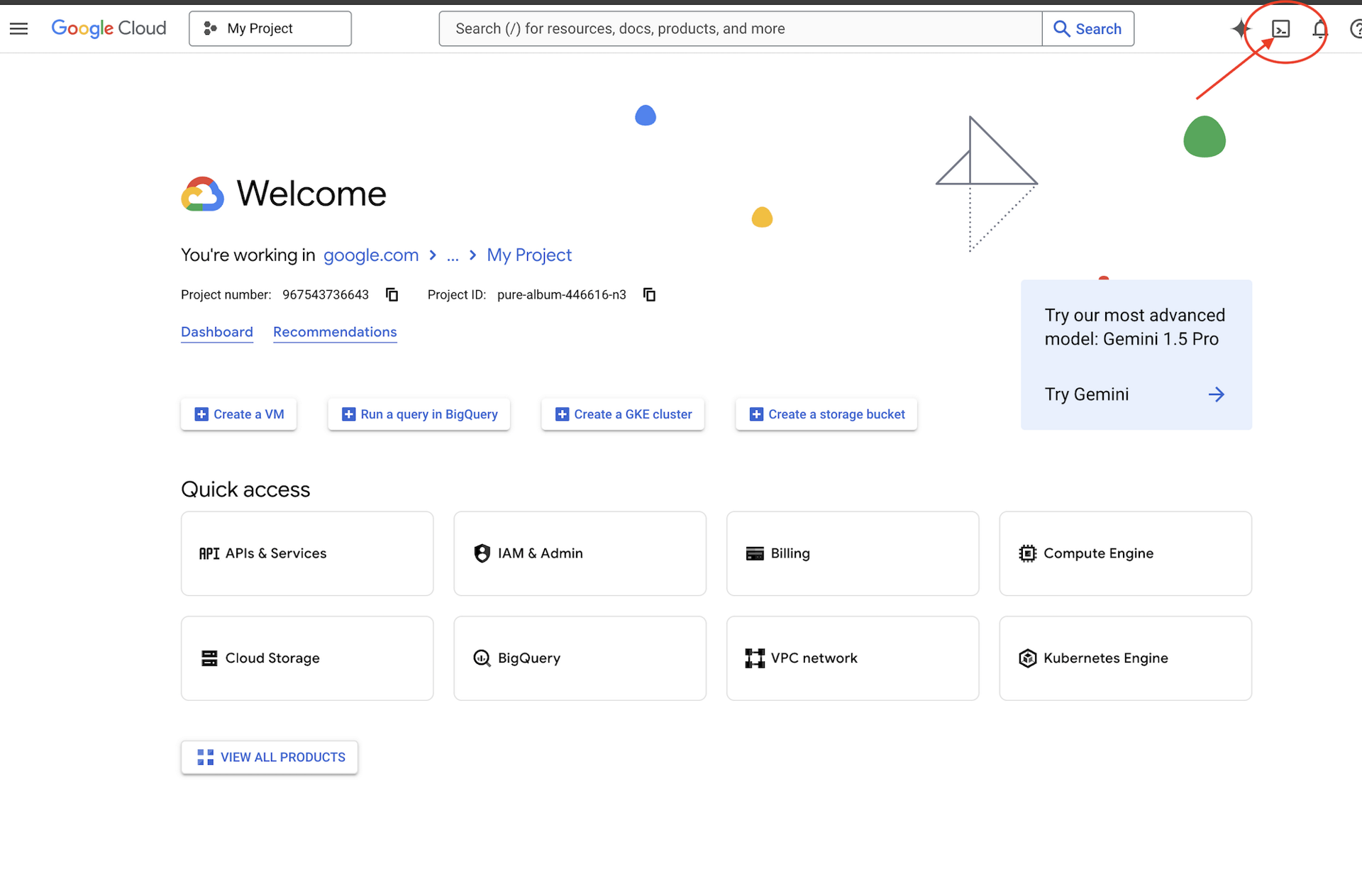

¿Necesitas créditos de Google Cloud?

Haz clic en Activar Cloud Shell en la parte superior de la consola de Google Cloud (es el ícono con forma de terminal en la parte superior del panel de Cloud Shell).

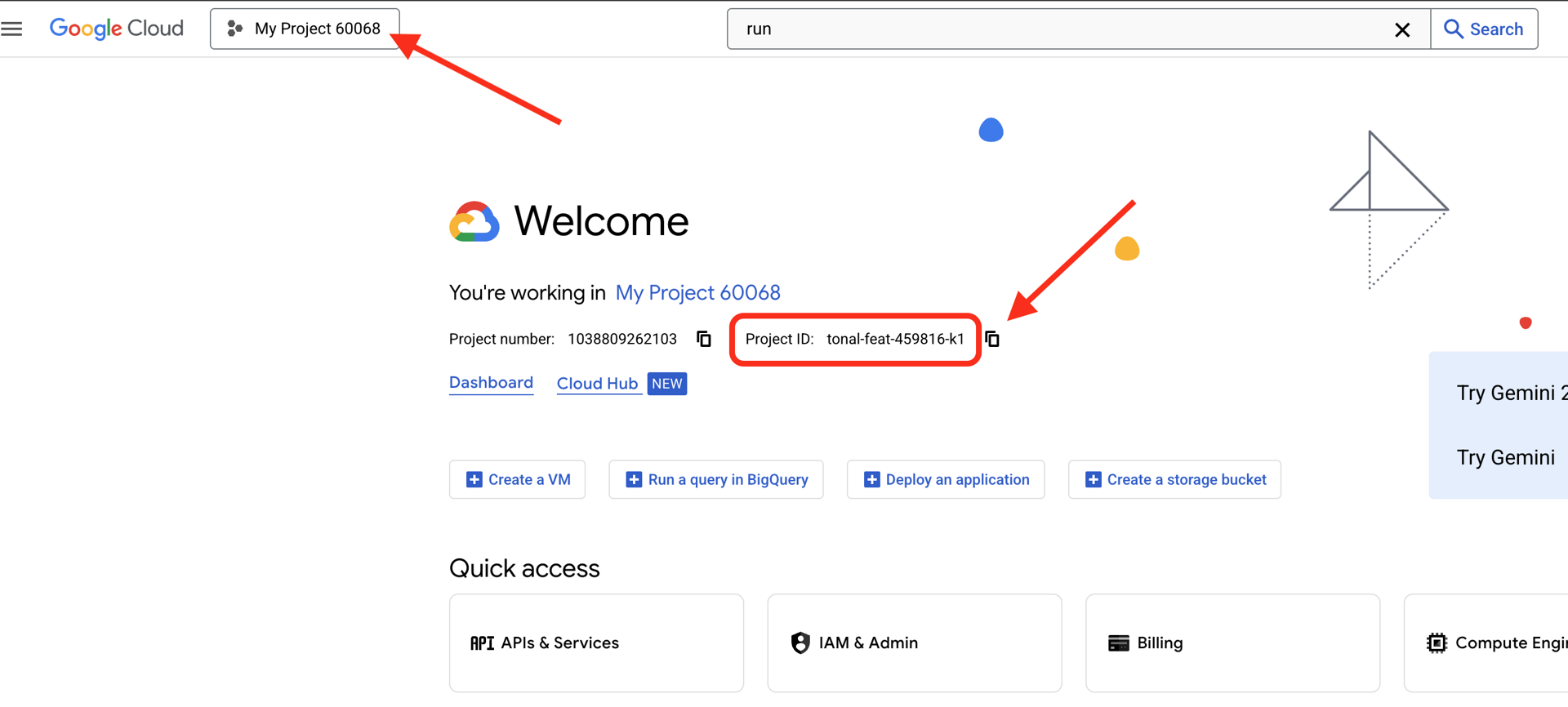

Busca tu ID del proyecto de Google Cloud:

- Abre la consola de Google Cloud: https://console.cloud.google.com

- Selecciona el proyecto que deseas usar para este taller en el menú desplegable de proyectos que se encuentra en la parte superior de la página.

- Tu ID del proyecto se muestra en la tarjeta de información del proyecto en el panel

Paso 1: Configura tu ID del proyecto

En Cloud Shell, la herramienta de línea de comandos de gcloud ya está configurada. Ejecuta el siguiente comando para establecer tu proyecto activo. Esto usa la variable de entorno $GOOGLE_CLOUD_PROJECT, que se configura automáticamente en tu sesión de Cloud Shell.

gcloud config set project $GOOGLE_CLOUD_PROJECT

Paso 2: Verifica tu configuración

A continuación, ejecuta los siguientes comandos para confirmar que tu proyecto esté configurado correctamente y que te autenticaste.

# Confirm project is set

echo "Current project: $(gcloud config get-value project)"

# Check authentication status

gcloud auth list

Deberías ver impreso el ID de tu proyecto y tu cuenta de usuario con (ACTIVE) junto a ella.

Si tu cuenta no aparece como activa o si recibes un error de autenticación, ejecuta el siguiente comando para acceder:

gcloud auth application-default login

Paso 3: Habilita las APIs esenciales

Necesitamos al menos estas APIs para el agente básico:

gcloud services enable \

aiplatform.googleapis.com \

compute.googleapis.com

Esto puede demorar uno o dos minutos. En esta página verá lo siguiente:

Operation "operations/..." finished successfully.

Paso 4: Instala el ADK

# Install the ADK CLI

pip install google-adk --upgrade

# Verify installation

adk --version

Deberías ver un número de versión como 1.15.0 o superior.

Ahora crea tu agente básico

Con el entorno listo, creemos ese agente simple.

Paso 5: Usa ADK Create

adk create my_first_agent

Sigue las indicaciones interactivas:

Choose a model for the root agent:

1. gemini-2.5-flash

2. Other models (fill later)

Choose model (1, 2): 1

1. Google AI

2. Vertex AI

Choose a backend (1, 2): 2

Enter Google Cloud project ID [auto-detected-from-gcloud]:

Enter Google Cloud region [us-central1]:

Paso 6: Examina lo que se creó

cd my_first_agent

ls -la

Encontrarás tres archivos:

.env # Configuration (auto-populated with your project)

__init__.py # Package marker

agent.py # Your agent definition

Paso 7: Verificación rápida de la configuración

# Verify the .env was created correctly

cat .env

# Should show something like:

# GOOGLE_CLOUD_PROJECT=your-project-id

# GOOGLE_CLOUD_LOCATION=us-central1

# GOOGLE_GENAI_USE_VERTEXAI=1

Si el ID del proyecto falta o es incorrecto, edita el archivo .env:

nano .env # or use your preferred editor

Paso 8: Observa el código del agente

cat agent.py

from google.adk.agents.llm_agent import Agent

root_agent = Agent(

model='gemini-2.5-flash',

name='root_agent',

description='A helpful assistant for user questions.',

instruction='Answer user questions to the best of your knowledge',

)

Simple, limpia y minimalista. Este es tu "Hola mundo" de los agentes.

Prueba tu agente básico

Paso 9: Ejecuta tu agente

cd ..

adk run my_first_agent

Deberías ver algo como lo siguiente:

Log setup complete: /tmp/agents_log/agent.20250930_162430.log

To access latest log: tail -F /tmp/agents_log/agent.latest.log

[user]:

Paso 10: Prueba algunas búsquedas

En la terminal en la que se ejecuta adk run, verás un mensaje. Escribe tus preguntas:

[user]: Hey, what can you do?

[root_agent]: I can help answer questions, generate text, explain concepts, assist with problem-solving, and provide information on a wide range of topics. What would you like to know or discuss?

[user]: What's the current weather in Mountain View?

[root_agent]: I'm sorry, but I cannot provide real-time weather information as I don't have access to current data or weather services. To get the current weather in Mountain View, I recommend checking a weather website or app like weather.com or using a search engine.

Observa la limitación: no puede acceder a los datos actuales. Profundicemos un poco más:

[user]: Review this Python code: def add(a, b): return a + b

[root_agent]: This is a simple Python function that adds two numbers. Here's my review:

**Strengths:**

- Clean and concise implementation

- Follows Python conventions for simple operations

- Clear function name that describes its purpose

**Suggestions for improvement:**

- Add a docstring to document the function

- Consider adding type hints for better code clarity

- You might want to handle edge cases

Here's an enhanced version:

def add(a: float, b: float) -> float:

"""Add two numbers and return their sum."""

return a + b

El agente puede hablar sobre código, pero ¿puede hacer lo siguiente?:

- ¿Analizar realmente el AST para comprender la estructura?

- ¿Ejecutar pruebas para verificar que funcione?

- ¿Verificar el cumplimiento de los estándares de estilo?

- ¿Recuerdas tus opiniones anteriores?

No. Aquí es donde necesitamos la arquitectura.

🏃🚪 Salir con

Ctrl+C

cuando termines de explorar.

3. Cómo preparar tu espacio de trabajo de producción

La solución: Una arquitectura lista para producción

Ese agente simple demostró el punto de partida, pero un sistema de producción requiere una estructura sólida. Ahora configuraremos un proyecto completo que incorpore los principios de producción.

Configuración de la base

Ya configuraste tu proyecto de Google Cloud para el agente básico. Ahora, preparemos el espacio de trabajo de producción completo con todas las herramientas, los patrones y la infraestructura necesarios para un sistema real.

Paso 1: Obtén el proyecto estructurado

Primero, sal de cualquier adk run en ejecución con Ctrl+C y limpia:

# Clean up the basic agent

cd ~ # Make sure you're not inside my_first_agent

rm -rf my_first_agent

# Get the production scaffold

git clone https://github.com/ayoisio/adk-code-review-assistant.git

cd adk-code-review-assistant

git checkout codelab

Paso 2: Crea y activa el entorno virtual

# Create the virtual environment

python -m venv .venv

# Activate it

# On macOS/Linux:

source .venv/bin/activate

# On Windows:

# .venv\Scripts\activate

Verificación: Tu instrucción ahora debería mostrar (.venv) al principio.

Paso 3: Instala las dependencias

pip install -r code_review_assistant/requirements.txt

# Install the package in editable mode (enables imports)

pip install -e .

Esto instala lo siguiente:

google-adk: El framework del ADKpycodestyle: Para la verificación de PEP 8vertexai: Para la implementación en la nube- Otras dependencias de producción

La marca -e te permite importar módulos code_review_assistant desde cualquier lugar.

Paso 4: Configura tu entorno

# Copy the example environment file

cp .env.example .env

# Edit .env and replace the placeholders:

# - GOOGLE_CLOUD_PROJECT=your-project-id → your actual project ID

# - Keep other defaults as-is

Verificación: Verifica tu configuración:

cat .env

Debería mostrar lo siguiente:

GOOGLE_CLOUD_PROJECT=your-actual-project-id

GOOGLE_CLOUD_LOCATION=us-central1

GOOGLE_GENAI_USE_VERTEXAI=TRUE

Paso 5: Asegúrate de que la autenticación funcione

Como ya ejecutaste gcloud auth antes, solo verificaremos lo siguiente:

# Check current authentication

gcloud auth list

# Should show your account with (ACTIVE)

# If not, run:

gcloud auth application-default login

Paso 6: Habilita APIs de producción adicionales

Ya habilitamos las APIs básicas. Ahora, agrega los de producción:

gcloud services enable \

sqladmin.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

artifactregistry.googleapis.com \

storage.googleapis.com \

cloudtrace.googleapis.com

Esto permite lo siguiente:

- Administrador de SQL: Para Cloud SQL si se usa Cloud Run

- Cloud Run: Para la implementación sin servidores

- Cloud Build: Para implementaciones automatizadas

- Artifact Registry: Para imágenes de contenedor

- Cloud Storage: Para artefactos y almacenamiento provisional

- Cloud Trace: Para la observabilidad

Paso 7: Crea el repositorio de Artifact Registry

Nuestra implementación compilará imágenes de contenedores que necesitan un lugar:

gcloud artifacts repositories create code-review-assistant-repo \

--repository-format=docker \

--location=us-central1 \

--description="Docker repository for Code Review Assistant"

Deberías ver lo siguiente:

Created repository [code-review-assistant-repo].

Si ya existe (quizás de un intento anterior), no hay problema. Verás un mensaje de error que puedes ignorar.

Paso 8: Otorga permisos de IAM

# Get your project number

PROJECT_NUMBER=$(gcloud projects describe $GOOGLE_CLOUD_PROJECT \

--format="value(projectNumber)")

# Define the service account

SERVICE_ACCOUNT="${PROJECT_NUMBER}@cloudbuild.gserviceaccount.com"

# Grant necessary roles

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/run.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/iam.serviceAccountUser"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/cloudsql.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/storage.admin"

Cada comando generará el siguiente resultado:

Updated IAM policy for project [your-project-id].

Tus logros

Tu espacio de trabajo de producción ya está completamente preparado:

✅ Proyecto de Google Cloud configurado y autenticado

✅ Se probó el agente básico para comprender las limitaciones

✅ Código del proyecto con marcadores de posición estratégicos listos

✅ Dependencias aisladas en el entorno virtual

✅ Todas las APIs necesarias habilitadas

✅ Registro de contenedores listo para las implementaciones

✅ Permisos de IAM configurados correctamente

✅ Variables de entorno configuradas correctamente

Ahora ya puedes crear un sistema de IA real con herramientas determinísticas, administración de estados y una arquitectura adecuada.

4. Cómo compilar tu primer agente

Qué diferencia a las herramientas de los LLM

Cuando le preguntas a un LLM "¿Cuántas funciones hay en este código?", este usa la correlación de patrones y la estimación. Cuando usas una herramienta que llama a ast.parse() de Python, se analiza el árbol de sintaxis real, sin suposiciones y con el mismo resultado cada vez.

En esta sección, se compila una herramienta que analiza la estructura del código de forma determinística y, luego, se conecta a un agente que sabe cuándo invocarla.

Paso 1: Comprende la estructura

Analicemos la estructura que completarás.

👉 Abrir

code_review_assistant/tools.py

Verás la función analyze_code_structure con comentarios de marcador de posición que indican dónde agregarás código. La función ya tiene la estructura básica. La mejorarás paso a paso.

Paso 2: Agrega almacenamiento de estado

El almacenamiento de estado permite que otros agentes de la canalización accedan a los resultados de tu herramienta sin volver a ejecutar el análisis.

👉 Buscar:

# MODULE_4_STEP_2_ADD_STATE_STORAGE

👉 Reemplaza esa sola línea por lo siguiente:

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

Paso 3: Agrega el análisis asíncrono con grupos de subprocesos

Nuestra herramienta debe analizar el AST sin bloquear otras operaciones. Agreguemos la ejecución asíncrona con grupos de subprocesos.

👉 Buscar:

# MODULE_4_STEP_3_ADD_ASYNC

👉 Reemplaza esa sola línea por lo siguiente:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

Paso 4: Extrae información integral

Ahora, extraigamos las clases, las importaciones y las métricas detalladas, todo lo que necesitamos para una revisión de código completa.

👉 Buscar:

# MODULE_4_STEP_4_EXTRACT_DETAILS

👉 Reemplaza esa sola línea por lo siguiente:

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

👉 Verifica la función

analyze_code_structure

en

tools.py

tiene un cuerpo central que se ve así:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

👉 Ahora, desplázate hasta el final de

tools.py

y busca:

# MODULE_4_STEP_4_HELPER_FUNCTION

👉 Reemplaza esa sola línea por la función de ayuda completa:

def _extract_code_structure(tree: ast.AST, code: str) -> Dict[str, Any]:

"""

Helper function to extract structural information from AST.

Runs in thread pool for CPU-bound work.

"""

functions = []

classes = []

imports = []

docstrings = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

func_info = {

'name': node.name,

'args': [arg.arg for arg in node.args.args],

'lineno': node.lineno,

'has_docstring': ast.get_docstring(node) is not None,

'is_async': isinstance(node, ast.AsyncFunctionDef),

'decorators': [d.id for d in node.decorator_list

if isinstance(d, ast.Name)]

}

functions.append(func_info)

if func_info['has_docstring']:

docstrings.append(f"{node.name}: {ast.get_docstring(node)[:50]}...")

elif isinstance(node, ast.ClassDef):

methods = []

for item in node.body:

if isinstance(item, ast.FunctionDef):

methods.append(item.name)

class_info = {

'name': node.name,

'lineno': node.lineno,

'methods': methods,

'has_docstring': ast.get_docstring(node) is not None,

'base_classes': [base.id for base in node.bases

if isinstance(base, ast.Name)]

}

classes.append(class_info)

elif isinstance(node, ast.Import):

for alias in node.names:

imports.append({

'module': alias.name,

'alias': alias.asname,

'type': 'import'

})

elif isinstance(node, ast.ImportFrom):

imports.append({

'module': node.module or '',

'names': [alias.name for alias in node.names],

'type': 'from_import',

'level': node.level

})

return {

'functions': functions,

'classes': classes,

'imports': imports,

'docstrings': docstrings,

'metrics': {

'line_count': len(code.splitlines()),

'function_count': len(functions),

'class_count': len(classes),

'import_count': len(imports),

'has_main': any(f['name'] == 'main' for f in functions),

'has_if_main': '__main__' in code,

'avg_function_length': _calculate_avg_function_length(tree)

}

}

def _calculate_avg_function_length(tree: ast.AST) -> float:

"""Calculate average function length in lines."""

function_lengths = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

if hasattr(node, 'end_lineno') and hasattr(node, 'lineno'):

length = node.end_lineno - node.lineno + 1

function_lengths.append(length)

if function_lengths:

return sum(function_lengths) / len(function_lengths)

return 0.0

Paso 5: Conéctate con un agente

Ahora conectamos la herramienta a un agente que sabe cuándo usarla y cómo interpretar sus resultados.

👉 Abrir

code_review_assistant/sub_agents/review_pipeline/code_analyzer.py

👉 Buscar:

# MODULE_4_STEP_5_CREATE_AGENT

👉 Reemplaza esa sola línea por el agente de producción completo:

code_analyzer_agent = Agent(

name="CodeAnalyzer",

model=config.worker_model,

description="Analyzes Python code structure and identifies components",

instruction="""You are a code analysis specialist responsible for understanding code structure.

Your task:

1. Take the code submitted by the user (it will be provided in the user message)

2. Use the analyze_code_structure tool to parse and analyze it

3. Pass the EXACT code to your tool - do not modify, fix, or "improve" it

4. Identify all functions, classes, imports, and structural patterns

5. Note any syntax errors or structural issues

6. Store the analysis in state for other agents to use

CRITICAL:

- Pass the code EXACTLY as provided to the analyze_code_structure tool

- Do not fix syntax errors, even if obvious

- Do not add missing imports or fix indentation

- The goal is to analyze what IS there, not what SHOULD be there

When calling the tool, pass the code as a string to the 'code' parameter.

If the analysis fails due to syntax errors, clearly report the error location and type.

Provide a clear summary including:

- Number of functions and classes found

- Key structural observations

- Any syntax errors or issues detected

- Overall code organization assessment""",

tools=[FunctionTool(func=analyze_code_structure)],

output_key="structure_analysis_summary"

)

Prueba tu analizador de código

Ahora verifica que el analizador funcione correctamente.

👉 Ejecuta la secuencia de comandos de prueba:

python tests/test_code_analyzer.py

La secuencia de comandos de prueba carga automáticamente la configuración desde tu archivo .env con python-dotenv, por lo que no es necesario configurar manualmente las variables de entorno.

Resultado esperado:

INFO:code_review_assistant.config:Code Review Assistant Configuration Loaded:

INFO:code_review_assistant.config: - GCP Project: your-project-id

INFO:code_review_assistant.config: - Artifact Bucket: gs://your-project-artifacts

INFO:code_review_assistant.config: - Models: worker=gemini-2.5-flash, critic=gemini-2.5-pro

Testing code analyzer...

INFO:code_review_assistant.tools:Tool: Analysis complete - 2 functions, 1 classes

=== Analyzer Response ===

The analysis of the provided code shows the following:

* **Functions Found:** 2

* `add(a, b)`: A global function at line 2.

* `multiply(self, x, y)`: A method within the `Calculator` class.

* **Classes Found:** 1

* `Calculator`: A class defined at line 5. Contains one method, `multiply`.

* **Imports:** 0

* **Structural Patterns:** The code defines one global function and one class

with a single method. Both are simple, each with a single return statement.

* **Syntax Errors/Issues:** No syntax errors detected.

* **Overall Code Organization:** The code is well-organized for its small size,

clearly defining a function and a class with a method.

Qué acaba de suceder:

- La secuencia de comandos de prueba cargó automáticamente tu configuración de

.env. - Tu herramienta

analyze_code_structure()analizó el código con el AST de Python - El asistente

_extract_code_structure()extrajo funciones, clases y métricas - Los resultados se almacenaron en el estado de la sesión con constantes

StateKeys. - El agente de Code Analyzer interpretó los resultados y proporcionó un resumen.

Solución de problemas:

- "No se encontró el módulo ‘code_review_assistant’": Ejecuta

pip install -e .desde la raíz del proyecto - "Falta el argumento de entradas de clave": Verifica que tu

.envtengaGOOGLE_CLOUD_PROJECT,GOOGLE_CLOUD_LOCATIONyGOOGLE_GENAI_USE_VERTEXAI=true.

Qué compilaste

Ahora tienes un analizador de código listo para la producción que hace lo siguiente:

✅ Analiza el AST de Python real: Es determinístico, no se basa en la coincidencia de patrones

✅ Almacena los resultados en el estado: Otros agentes pueden acceder al análisis

✅ Se ejecuta de forma asíncrona: No bloquea otras herramientas

✅ Extrae información integral: Funciones, clases, importaciones, métricas

✅ Controla los errores con elegancia: Informa los errores de sintaxis con números de línea

✅ Se conecta a un agente: El LLM sabe cuándo y cómo usarlo

Conceptos clave dominados

Herramientas vs. agentes:

- Las herramientas realizan un trabajo determinístico (análisis del AST).

- Los agentes deciden cuándo usar herramientas e interpretar resultados

Valor de retorno en comparación con el estado:

- Devuelve lo que el LLM ve de inmediato

- Estado: Lo que persiste para otros agentes

Constantes de claves de estado:

- Cómo evitar errores ortográficos en sistemas multiagente

- Actúan como contratos entre agentes

- Es fundamental cuando los agentes comparten datos

Async + Thread Pools:

async defpermite que las herramientas pausen la ejecución- Los grupos de subprocesos ejecutan el trabajo vinculado a la CPU en segundo plano

- Juntos, mantienen la capacidad de respuesta del bucle de eventos

Funciones auxiliares:

- Separa los asistentes de sincronización de las herramientas asíncronas

- Hace que el código sea reutilizable y fácil de probar

Instrucciones para el agente:

- Las instrucciones detalladas evitan errores comunes del LLM

- Explícita sobre lo que NO se debe hacer (no corregir el código)

- Pasos claros del flujo de trabajo para garantizar la coherencia

Pasos siguientes

En el módulo 5, agregarás lo siguiente:

- Verificador de estilo que lee el código del estado

- Ejecutor de pruebas que ejecuta las pruebas

- Sintetizador de comentarios que combina todo el análisis

Verás cómo el estado fluye a través de una canalización secuencial y por qué el patrón de constantes es importante cuando varios agentes leen y escriben los mismos datos.

5. Cómo crear una canalización: varios agentes trabajando juntos

Introducción

En el módulo 4, creaste un solo agente que analiza la estructura del código. Sin embargo, la revisión integral del código requiere más que solo el análisis: necesitas la verificación de estilo, la ejecución de pruebas y la síntesis inteligente de comentarios.

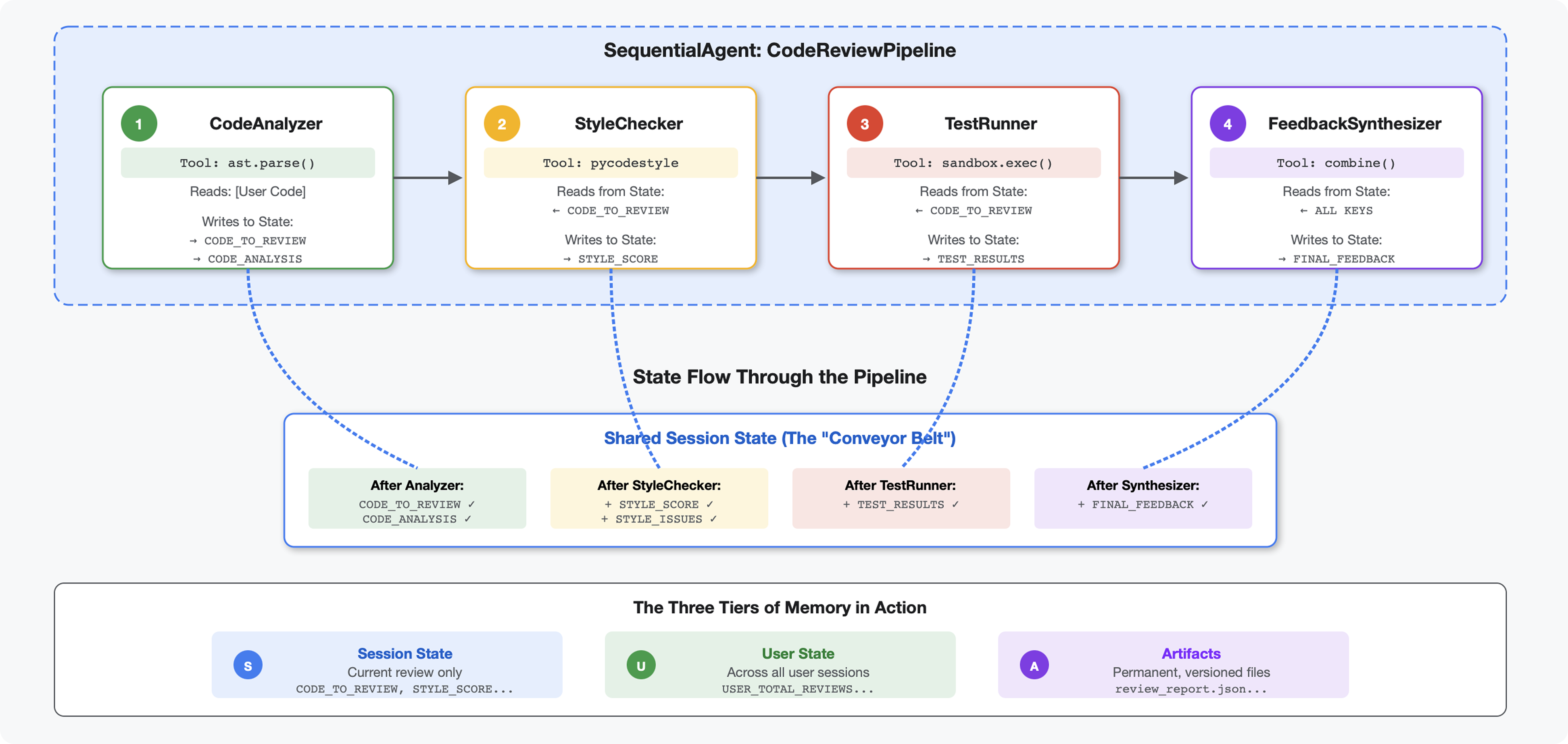

Este módulo crea una canalización de 4 agentes que trabajan juntos de forma secuencial, y cada uno aporta un análisis especializado:

- Analizador de código (del módulo 4): Analiza la estructura

- Style Checker: Identifica incumplimientos de estilo

- Test Runner: Ejecuta y valida pruebas

- Feedback Synthesizer: Combina todo en comentarios prácticos

Concepto clave: El estado como canal de comunicación. Cada agente lee lo que escribieron los agentes anteriores en el estado, agrega su propio análisis y pasa el estado enriquecido al siguiente agente. El patrón de constantes del módulo 4 se vuelve fundamental cuando varios agentes comparten datos.

Vista previa de lo que crearás: Envía código desordenado → observa el flujo de estado a través de 4 agentes → recibe un informe integral con comentarios personalizados basados en patrones anteriores.

Paso 1: Agrega la herramienta y el agente de Style Checker

El verificador de estilo identifica los incumplimientos de la PEP 8 con pycodestyle, un verificador determinista, no una interpretación basada en LLM.

Agrega la herramienta de verificación de estilo

👉 Abrir

code_review_assistant/tools.py

👉 Buscar:

# MODULE_5_STEP_1_STYLE_CHECKER_TOOL

👉 Reemplaza esa sola línea por lo siguiente:

async def check_code_style(code: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Checks code style compliance using pycodestyle (PEP 8).

Args:

code: Python source code to check (or will retrieve from state)

tool_context: ADK tool context

Returns:

Dictionary containing style score and issues

"""

logger.info("Tool: Checking code style...")

try:

# Retrieve code from state if not provided

if not code:

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

if not code:

return {

"status": "error",

"message": "No code provided or found in state"

}

# Run style check in thread pool

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

result = await loop.run_in_executor(

executor, _perform_style_check, code

)

# Store results in state

tool_context.state[StateKeys.STYLE_SCORE] = result['score']

tool_context.state[StateKeys.STYLE_ISSUES] = result['issues']

tool_context.state[StateKeys.STYLE_ISSUE_COUNT] = result['issue_count']

logger.info(f"Tool: Style check complete - Score: {result['score']}/100, "

f"Issues: {result['issue_count']}")

return result

except Exception as e:

error_msg = f"Style check failed: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Set default values on error

tool_context.state[StateKeys.STYLE_SCORE] = 0

tool_context.state[StateKeys.STYLE_ISSUES] = []

return {

"status": "error",

"message": error_msg,

"score": 0

}

👉 Ahora desplázate hasta el final del archivo y busca lo siguiente:

# MODULE_5_STEP_1_STYLE_HELPERS

👉 Reemplaza esa sola línea por las funciones de ayuda:

def _perform_style_check(code: str) -> Dict[str, Any]:

"""Helper to perform style check in thread pool."""

import io

import sys

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as tmp:

tmp.write(code)

tmp_path = tmp.name

try:

# Capture stdout to get pycodestyle output

old_stdout = sys.stdout

sys.stdout = captured_output = io.StringIO()

style_guide = pycodestyle.StyleGuide(

quiet=False, # We want output

max_line_length=100,

ignore=['E501', 'W503']

)

result = style_guide.check_files([tmp_path])

# Restore stdout

sys.stdout = old_stdout

# Parse captured output

output = captured_output.getvalue()

issues = []

for line in output.strip().split('\n'):

if line and ':' in line:

parts = line.split(':', 4)

if len(parts) >= 4:

try:

issues.append({

'line': int(parts[1]),

'column': int(parts[2]),

'code': parts[3].split()[0] if len(parts) > 3 else 'E000',

'message': parts[3].strip() if len(parts) > 3 else 'Unknown error'

})

except (ValueError, IndexError):

pass

# Add naming convention checks

try:

tree = ast.parse(code)

naming_issues = _check_naming_conventions(tree)

issues.extend(naming_issues)

except SyntaxError:

pass # Syntax errors will be caught elsewhere

# Calculate weighted score

score = _calculate_style_score(issues)

return {

"status": "success",

"score": score,

"issue_count": len(issues),

"issues": issues[:10], # First 10 issues

"summary": f"Style score: {score}/100 with {len(issues)} violations"

}

finally:

if os.path.exists(tmp_path):

os.unlink(tmp_path)

def _check_naming_conventions(tree: ast.AST) -> List[Dict[str, Any]]:

"""Check PEP 8 naming conventions."""

naming_issues = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

# Skip private/protected methods and __main__

if not node.name.startswith('_') and node.name != node.name.lower():

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N802',

'message': f"N802 function name '{node.name}' should be lowercase"

})

elif isinstance(node, ast.ClassDef):

# Check if class name follows CapWords convention

if not node.name[0].isupper() or '_' in node.name:

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N801',

'message': f"N801 class name '{node.name}' should use CapWords convention"

})

return naming_issues

def _calculate_style_score(issues: List[Dict[str, Any]]) -> int:

"""Calculate weighted style score based on violation severity."""

if not issues:

return 100

# Define weights by error type

weights = {

'E1': 10, # Indentation errors

'E2': 3, # Whitespace errors

'E3': 5, # Blank line errors

'E4': 8, # Import errors

'E5': 5, # Line length

'E7': 7, # Statement errors

'E9': 10, # Syntax errors

'W2': 2, # Whitespace warnings

'W3': 2, # Blank line warnings

'W5': 3, # Line break warnings

'N8': 7, # Naming conventions

}

total_deduction = 0

for issue in issues:

code_prefix = issue['code'][:2] if len(issue['code']) >= 2 else 'E2'

weight = weights.get(code_prefix, 3)

total_deduction += weight

# Cap at 100 points deduction

return max(0, 100 - min(total_deduction, 100))

Agrega el agente de Style Checker

👉 Abrir

code_review_assistant/sub_agents/review_pipeline/style_checker.py

👉 Buscar:

# MODULE_5_STEP_1_INSTRUCTION_PROVIDER

👉 Reemplaza esa sola línea por lo siguiente:

async def style_checker_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are a code style expert focused on PEP 8 compliance.

Your task:

1. Use the check_code_style tool to validate PEP 8 compliance

2. The tool will retrieve the ORIGINAL code from state automatically

3. Report violations exactly as found

4. Present the results clearly and confidently

CRITICAL:

- The tool checks the code EXACTLY as provided by the user

- Do not suggest the code was modified or fixed

- Report actual violations found in the original code

- If there are style issues, they should be reported honestly

Call the check_code_style tool with an empty string for the code parameter,

as the tool will retrieve the code from state automatically.

When presenting results based on what the tool returns:

- State the exact score from the tool results

- If score >= 90: "Excellent style compliance!"

- If score 70-89: "Good style with minor improvements needed"

- If score 50-69: "Style needs attention"

- If score < 50: "Significant style improvements needed"

List the specific violations found (the tool will provide these):

- Show line numbers, error codes, and messages

- Focus on the top 10 most important issues

Previous analysis: {structure_analysis_summary}

Format your response as:

## Style Analysis Results

- Style Score: [exact score]/100

- Total Issues: [count]

- Assessment: [your assessment based on score]

## Top Style Issues

[List issues with line numbers and descriptions]

## Recommendations

[Specific fixes for the most critical issues]"""

return await instructions_utils.inject_session_state(template, context)

👉 Buscar:

# MODULE_5_STEP_1_STYLE_CHECKER_AGENT

👉 Reemplaza esa sola línea por lo siguiente:

style_checker_agent = Agent(

name="StyleChecker",

model=config.worker_model,

description="Checks Python code style against PEP 8 guidelines",

instruction=style_checker_instruction_provider,

tools=[FunctionTool(func=check_code_style)],

output_key="style_check_summary"

)

Paso 2: Agrega el agente de Test Runner

El ejecutor de pruebas genera pruebas integrales y las ejecuta con el ejecutor de código integrado.

👉 Abrir

code_review_assistant/sub_agents/review_pipeline/test_runner.py

👉 Buscar:

# MODULE_5_STEP_2_INSTRUCTION_PROVIDER

👉 Reemplaza esa sola línea por lo siguiente:

async def test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects the code_to_review directly."""

template = """You are a testing specialist who creates and runs tests for Python code.

THE CODE TO TEST IS:

{code_to_review}

YOUR TASK:

1. Understand what the function appears to do based on its name and structure

2. Generate comprehensive tests (15-20 test cases)

3. Execute the tests using your code executor

4. Analyze results to identify bugs vs expected behavior

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Test with the most natural interpretation first

- When something fails, determine if it's a bug or unusual design

- Test edge cases, boundaries, and error scenarios

- Document any surprising behavior

Execute your tests and output ONLY valid JSON with this structure:

- "test_summary": object with "total_tests_run", "tests_passed", "tests_failed", "tests_with_errors", "critical_issues_found"

- "critical_issues": array of objects, each with "type", "description", "example_input", "expected_behavior", "actual_behavior", "severity"

- "test_categories": object with "basic_functionality", "edge_cases", "error_handling" (each containing "passed", "failed", "errors" counts)

- "function_behavior": object with "apparent_purpose", "actual_interface", "unexpected_requirements"

- "verdict": object with "status" (WORKING/BUGGY/BROKEN), "confidence" (high/medium/low), "recommendation"

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Buscar:

# MODULE_5_STEP_2_TEST_RUNNER_AGENT

👉 Reemplaza esa sola línea por lo siguiente:

test_runner_agent = Agent(

name="TestRunner",

model=config.critic_model,

description="Generates and runs tests for Python code using safe code execution",

instruction=test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="test_execution_summary"

)

Paso 3: Comprende la memoria para el aprendizaje entre sesiones

Antes de crear el sintetizador de comentarios, debes comprender la diferencia entre estado y memoria, dos mecanismos de almacenamiento diferentes para dos propósitos diferentes.

Estado vs. memoria: La distinción clave

Aclararemos esto con un ejemplo concreto de una revisión de código:

Estado (solo en la sesión actual):

# Data from THIS review session

tool_context.state[StateKeys.STYLE_ISSUES] = [

{"line": 5, "code": "E231", "message": "missing whitespace"},

{"line": 12, "code": "E701", "message": "multiple statements"}

]

- Alcance: Solo esta conversación

- Propósito: Pasar datos entre agentes en la canalización actual

- Vive en: objeto

Session - Ciclo de vida: Se descarta cuando finaliza la sesión

Memoria (todas las sesiones anteriores):

# Learned from 50 previous reviews

"User frequently forgets docstrings on helper functions"

"User tends to write long functions (avg 45 lines)"

"User improved error handling after feedback in session #23"

- Alcance: Todas las sesiones anteriores de este usuario

- Objetivo: Aprender patrones y proporcionar comentarios personalizados

- Vive en:

MemoryService - Ciclo de vida: Persiste en todas las sesiones y se puede buscar

Por qué los comentarios necesitan ambas cosas:

Imagina que el sintetizador crea comentarios:

Usar solo el estado (revisión actual):

"Function `calculate_total` has no docstring."

Comentarios mecánicos y genéricos

Uso de State + Memory (patrones actuales y anteriores):

"Function `calculate_total` has no docstring. This is the 4th review

where helper functions lacked documentation. Consider adding docstrings

as you write functions, not afterwards - you mentioned in our last

session that you find it easier that way."

Las referencias contextuales y personalizadas mejoran con el tiempo.

Para las implementaciones de producción, tienes las siguientes opciones:

Opción 1: VertexAiMemoryBankService (avanzada)

- Qué hace: Extracción de hechos significativos de conversaciones con tecnología de LLM

- Búsqueda: Búsqueda semántica (comprende el significado, no solo las palabras clave)

- Administración de la memoria: Consolida y actualiza automáticamente los recuerdos con el tiempo

- Requisitos: Proyecto de Google Cloud y configuración de Agent Engine

- Úsala cuando: Quieras recuerdos sofisticados, evolutivos y personalizados

- Ejemplo: "El usuario prefiere la programación funcional" (extraído de 10 conversaciones sobre el estilo de código)

Opción 2: Continúa con InMemoryMemoryService y sesiones persistentes

- Función: Almacena el historial de conversaciones completo para la búsqueda de palabras clave

- Búsqueda: Concordancia básica de palabras clave en sesiones anteriores

- Administración de la memoria: Tú controlas lo que se almacena (a través de

add_session_to_memory). - Requisitos: Solo un

SessionServicepersistente (comoVertexAiSessionServiceoDatabaseSessionService) - Úsala cuando: Necesitas una búsqueda simple en conversaciones anteriores sin procesamiento de LLM.

- Ejemplo: La búsqueda de "docstring" devuelve todas las sesiones en las que se menciona esa palabra.

Cómo se completa la memoria

Después de que se completa cada revisión de código, haz lo siguiente:

# At the end of a session (typically in your application code)

await memory_service.add_session_to_memory(session)

Qué sucede:

- InMemoryMemoryService: Almacena los eventos de sesión completos para la búsqueda de palabras clave.

- VertexAiMemoryBankService: El LLM extrae hechos clave y los consolida con los recuerdos existentes.

Las sesiones futuras pueden consultar lo siguiente:

# In a tool, search for relevant past feedback

results = tool_context.search_memory("feedback about docstrings")

Paso 4: Agrega las herramientas y el agente de Feedback Synthesizer

El sintetizador de comentarios es el agente más sofisticado de la canalización. Orquesta tres herramientas, usa instrucciones dinámicas y combina el estado, la memoria y los artefactos.

Agrega las tres herramientas de sintetizador

👉 Abrir

code_review_assistant/tools.py

👉 Buscar:

# MODULE_5_STEP_4_SEARCH_PAST_FEEDBACK

👉 Reemplazar con la herramienta 1: Búsqueda en la memoria (versión de producción):

async def search_past_feedback(developer_id: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Search for past feedback in memory service.

Args:

developer_id: ID of the developer (defaults to "default_user")

tool_context: ADK tool context with potential memory service access

Returns:

Dictionary containing feedback search results

"""

logger.info(f"Tool: Searching for past feedback for developer {developer_id}...")

try:

# Default developer ID if not provided

if not developer_id:

developer_id = tool_context.state.get(StateKeys.USER_ID, 'default_user')

# Check if memory service is available

if hasattr(tool_context, 'search_memory'):

try:

# Perform structured searches

queries = [

f"developer:{developer_id} code review feedback",

f"developer:{developer_id} common issues",

f"developer:{developer_id} improvements"

]

all_feedback = []

patterns = {

'common_issues': [],

'improvements': [],

'strengths': []

}

for query in queries:

search_result = await tool_context.search_memory(query)

if search_result and hasattr(search_result, 'memories'):

for memory in search_result.memories[:5]:

memory_text = memory.text if hasattr(memory, 'text') else str(memory)

all_feedback.append(memory_text)

# Extract patterns

if 'style' in memory_text.lower():

patterns['common_issues'].append('style compliance')

if 'improved' in memory_text.lower():

patterns['improvements'].append('showing improvement')

if 'excellent' in memory_text.lower():

patterns['strengths'].append('consistent quality')

# Store in state

tool_context.state[StateKeys.PAST_FEEDBACK] = all_feedback

tool_context.state[StateKeys.FEEDBACK_PATTERNS] = patterns

logger.info(f"Tool: Found {len(all_feedback)} past feedback items")

return {

"status": "success",

"feedback_found": True,

"count": len(all_feedback),

"summary": " | ".join(all_feedback[:3]) if all_feedback else "No feedback",

"patterns": patterns

}

except Exception as e:

logger.warning(f"Tool: Memory search error: {e}")

# Fallback: Check state for cached feedback

cached_feedback = tool_context.state.get(StateKeys.USER_PAST_FEEDBACK_CACHE, [])

if cached_feedback:

tool_context.state[StateKeys.PAST_FEEDBACK] = cached_feedback

return {

"status": "success",

"feedback_found": True,

"count": len(cached_feedback),

"summary": "Using cached feedback",

"patterns": {}

}

# No feedback found

tool_context.state[StateKeys.PAST_FEEDBACK] = []

logger.info("Tool: No past feedback found")

return {

"status": "success",

"feedback_found": False,

"message": "No past feedback available - this appears to be a first submission",

"patterns": {}

}

except Exception as e:

error_msg = f"Feedback search error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

tool_context.state[StateKeys.PAST_FEEDBACK] = []

return {

"status": "error",

"message": error_msg,

"feedback_found": False

}

👉 Buscar:

# MODULE_5_STEP_4_UPDATE_GRADING_PROGRESS

👉 Reemplazar por la herramienta 2: Grading Tracker (versión de producción):

async def update_grading_progress(tool_context: ToolContext) -> Dict[str, Any]:

"""

Updates grading progress counters and metrics in state.

"""

logger.info("Tool: Updating grading progress...")

try:

current_time = datetime.now().isoformat()

# Build all state changes

state_updates = {}

# Temporary (invocation-level) state

state_updates[StateKeys.TEMP_PROCESSING_TIMESTAMP] = current_time

# Session-level state

attempts = tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 0) + 1

state_updates[StateKeys.GRADING_ATTEMPTS] = attempts

state_updates[StateKeys.LAST_GRADING_TIME] = current_time

# User-level persistent state

lifetime_submissions = tool_context.state.get(StateKeys.USER_TOTAL_SUBMISSIONS, 0) + 1

state_updates[StateKeys.USER_TOTAL_SUBMISSIONS] = lifetime_submissions

state_updates[StateKeys.USER_LAST_SUBMISSION_TIME] = current_time

# Calculate improvement metrics

current_style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

last_style_score = tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

score_improvement = current_style_score - last_style_score

state_updates[StateKeys.USER_LAST_STYLE_SCORE] = current_style_score

state_updates[StateKeys.SCORE_IMPROVEMENT] = score_improvement

# Track test results if available

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

if test_results and test_results.get('test_summary', {}).get('total_tests_run', 0) > 0:

summary = test_results['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

pass_rate = (passed / total) * 100

state_updates[StateKeys.USER_LAST_TEST_PASS_RATE] = pass_rate

# Apply all updates atomically

for key, value in state_updates.items():

tool_context.state[key] = value

logger.info(f"Tool: Progress updated - Attempt #{attempts}, "

f"Lifetime: {lifetime_submissions}")

return {

"status": "success",

"session_attempts": attempts,

"lifetime_submissions": lifetime_submissions,

"timestamp": current_time,

"improvement": {

"style_score_change": score_improvement,

"direction": "improved" if score_improvement > 0 else "declined"

},

"summary": f"Attempt #{attempts} recorded, {lifetime_submissions} total submissions"

}

except Exception as e:

error_msg = f"Progress update error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

return {

"status": "error",

"message": error_msg

}

👉 Buscar:

# MODULE_5_STEP_4_SAVE_GRADING_REPORT

👉 Reemplaza con la herramienta 3: Artifact Saver (versión de producción):

async def save_grading_report(feedback_text: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Saves a detailed grading report as an artifact.

Args:

feedback_text: The feedback text to include in the report

tool_context: ADK tool context for state management

Returns:

Dictionary containing save status and details

"""

logger.info("Tool: Saving grading report...")

try:

# Gather all relevant data from state

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

analysis = tool_context.state.get(StateKeys.CODE_ANALYSIS, {})

style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

style_issues = tool_context.state.get(StateKeys.STYLE_ISSUES, [])

# Get test results

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

timestamp = datetime.now().isoformat()

# Create comprehensive report dictionary

report = {

'timestamp': timestamp,

'grading_attempt': tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 1),

'code': {

'content': code,

'line_count': len(code.splitlines()),

'hash': hashlib.md5(code.encode()).hexdigest()

},

'analysis': analysis,

'style': {

'score': style_score,

'issues': style_issues[:5] # First 5 issues

},

'tests': test_results,

'feedback': feedback_text,

'improvements': {

'score_change': tool_context.state.get(StateKeys.SCORE_IMPROVEMENT, 0),

'from_last_score': tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

}

}

# Convert report to JSON string

report_json = json.dumps(report, indent=2)

report_part = types.Part.from_text(text=report_json)

# Try to save as artifact if the service is available

if hasattr(tool_context, 'save_artifact'):

try:

# Generate filename with timestamp (replace colons for filesystem compatibility)

filename = f"grading_report_{timestamp.replace(':', '-')}.json"

# Save the main report

version = await tool_context.save_artifact(filename, report_part)

# Also save a "latest" version for easy access

await tool_context.save_artifact("latest_grading_report.json", report_part)

logger.info(f"Tool: Report saved as {filename} (version {version})")

# Store report in state as well for redundancy

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

return {

"status": "success",

"artifact_saved": True,

"filename": filename,

"version": str(version),

"size": len(report_json),

"summary": f"Report saved as {filename}"

}

except Exception as artifact_error:

logger.warning(f"Artifact service error: {artifact_error}, falling back to state storage")

# Continue to fallback below

# Fallback: Store in state if artifact service is not available or failed

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

logger.info("Tool: Report saved to state (artifact service not available)")

return {

"status": "success",

"artifact_saved": False,

"message": "Report saved to state only",

"size": len(report_json),

"summary": "Report saved to session state"

}

except Exception as e:

error_msg = f"Report save error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Still try to save minimal data to state

try:

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = {

'error': error_msg,

'feedback': feedback_text,

'timestamp': datetime.now().isoformat()

}

except:

pass

return {

"status": "error",

"message": error_msg,

"artifact_saved": False,

"summary": f"Failed to save report: {error_msg}"

}

Crea el agente de sintetizador

👉 Abrir

code_review_assistant/sub_agents/review_pipeline/feedback_synthesizer.py

👉 Buscar:

# MODULE_5_STEP_4_INSTRUCTION_PROVIDER

👉 Reemplaza con el proveedor de instrucciones de producción:

async def feedback_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code reviewer and mentor providing constructive, educational feedback.

CONTEXT FROM PREVIOUS AGENTS:

- Structure analysis summary: {structure_analysis_summary}

- Style check summary: {style_check_summary}

- Test execution summary: {test_execution_summary}

YOUR TASK requires these steps IN ORDER:

1. Call search_past_feedback tool with developer_id="default_user"

2. Call update_grading_progress tool with no parameters

3. Carefully analyze the test results to understand what really happened

4. Generate comprehensive feedback following the structure below

5. Call save_grading_report tool with the feedback_text parameter

6. Return the feedback as your final output

CRITICAL - Understanding Test Results:

The test_execution_summary contains structured JSON. Parse it carefully:

- tests_passed = Code worked correctly

- tests_failed = Code produced wrong output

- tests_with_errors = Code crashed

- critical_issues = Fundamental problems with the code

If critical_issues array contains items, these are serious bugs that need fixing.

Do NOT count discovering bugs as test successes.

FEEDBACK STRUCTURE TO FOLLOW:

## 📊 Summary

Provide an honest assessment. Be encouraging but truthful about problems found.

## ✅ Strengths

List 2-3 things done well, referencing specific code elements.

## 📈 Code Quality Analysis

### Structure & Organization

Comment on code organization, readability, and documentation.

### Style Compliance

Report the actual style score and any specific issues.

### Test Results

Report the actual test results accurately:

- If critical_issues exist, report them as bugs to fix

- Be clear: "X tests passed, Y critical issues were found"

- List each critical issue

- Don't hide or minimize problems

## 💡 Recommendations for Improvement

Based on the analysis, provide specific actionable fixes.

If critical issues exist, fixing them is top priority.

## 🎯 Next Steps

Prioritized action list based on severity of issues.

## 💬 Encouragement

End with encouragement while being honest about what needs fixing.

Remember: Complete ALL steps including calling save_grading_report."""

return await instructions_utils.inject_session_state(template, context)

👉 Buscar:

# MODULE_5_STEP_4_SYNTHESIZER_AGENT

👉 Reemplaza con:

feedback_synthesizer_agent = Agent(

name="FeedbackSynthesizer",

model=config.critic_model,

description="Synthesizes all analysis into constructive, personalized feedback",

instruction=feedback_instruction_provider,

tools=[

FunctionTool(func=search_past_feedback),

FunctionTool(func=update_grading_progress),

FunctionTool(func=save_grading_report)

],

output_key="final_feedback"

)

Paso 5: Conecta la canalización

Ahora conecta los cuatro agentes en una canalización secuencial y crea el agente raíz.

👉 Abrir

code_review_assistant/agent.py

👉 Agrega las importaciones necesarias en la parte superior del archivo (después de las importaciones existentes):

from google.adk.agents import Agent, SequentialAgent

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

Tu archivo ahora debería verse así:

"""

Main agent orchestration for the Code Review Assistant.

"""

from google.adk.agents import Agent, SequentialAgent

from .config import config

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

# MODULE_5_STEP_5_CREATE_PIPELINE

# MODULE_6_STEP_5_CREATE_FIX_LOOP

# MODULE_6_STEP_5_UPDATE_ROOT_AGENT

👉 Buscar:

# MODULE_5_STEP_5_CREATE_PIPELINE

👉 Reemplaza esa sola línea por lo siguiente:

# Create sequential pipeline

code_review_pipeline = SequentialAgent(

name="CodeReviewPipeline",

description="Complete code review pipeline with analysis, testing, and feedback",

sub_agents=[

code_analyzer_agent,

style_checker_agent,

test_runner_agent,

feedback_synthesizer_agent

]

)

# Root agent - coordinates the review pipeline

root_agent = Agent(

name="CodeReviewAssistant",

model=config.worker_model,

description="An intelligent code review assistant that analyzes Python code and provides educational feedback",

instruction="""You are a specialized Python code review assistant focused on helping developers improve their code quality.

When a user provides Python code for review:

1. Immediately delegate to CodeReviewPipeline and pass the code EXACTLY as it was provided by the user.

2. The pipeline will handle all analysis and feedback

3. Return ONLY the final feedback from the pipeline - do not add any commentary

When a user asks what you can do or asks general questions:

- Explain your capabilities for code review

- Do NOT trigger the pipeline for non-code messages

The pipeline handles everything for code review - just pass through its final output.""",

sub_agents=[code_review_pipeline],

output_key="assistant_response"

)

Paso 6: Prueba la canalización completa

Es hora de ver a los cuatro agentes trabajando juntos.

👉 Inicia el sistema:

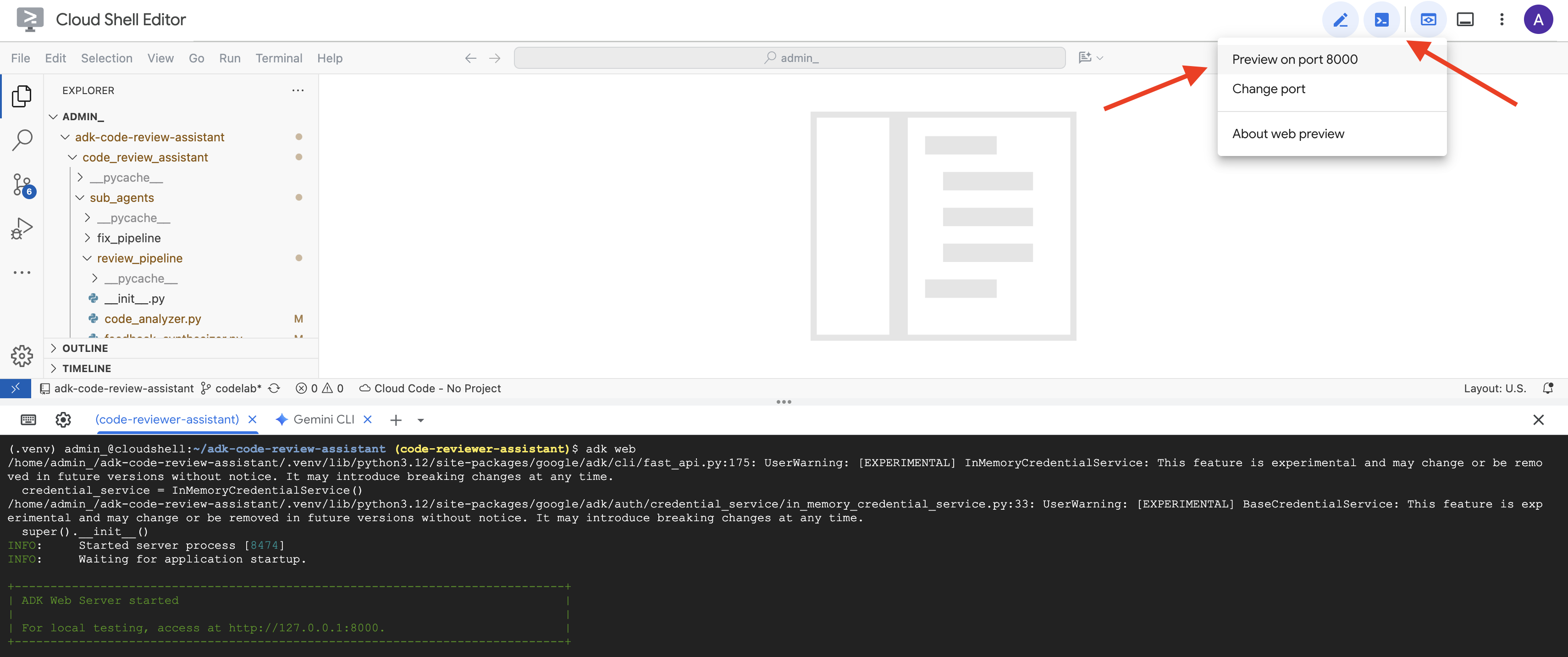

adk web code_review_assistant

Después de ejecutar el comando adk web, deberías ver un resultado en la terminal que indica que se inició el servidor web del ADK, similar a este:

+-----------------------------------------------------------------------------+

| ADK Web Server started |

| |

| For local testing, access at http://localhost:8000. |

+-----------------------------------------------------------------------------+

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

👉 A continuación, para acceder a la IU de desarrollo del ADK desde tu navegador, haz lo siguiente:

En el ícono de Vista previa en la Web (a menudo, parece un ojo o un cuadrado con una flecha) en la barra de herramientas de Cloud Shell (por lo general, en la parte superior derecha), selecciona Cambiar puerto. En la ventana emergente, establece el puerto en 8000 y haz clic en "Cambiar y obtener vista previa". Luego, Cloud Shell abrirá una nueva pestaña o ventana del navegador en la que se mostrará la IU de desarrollo del ADK.

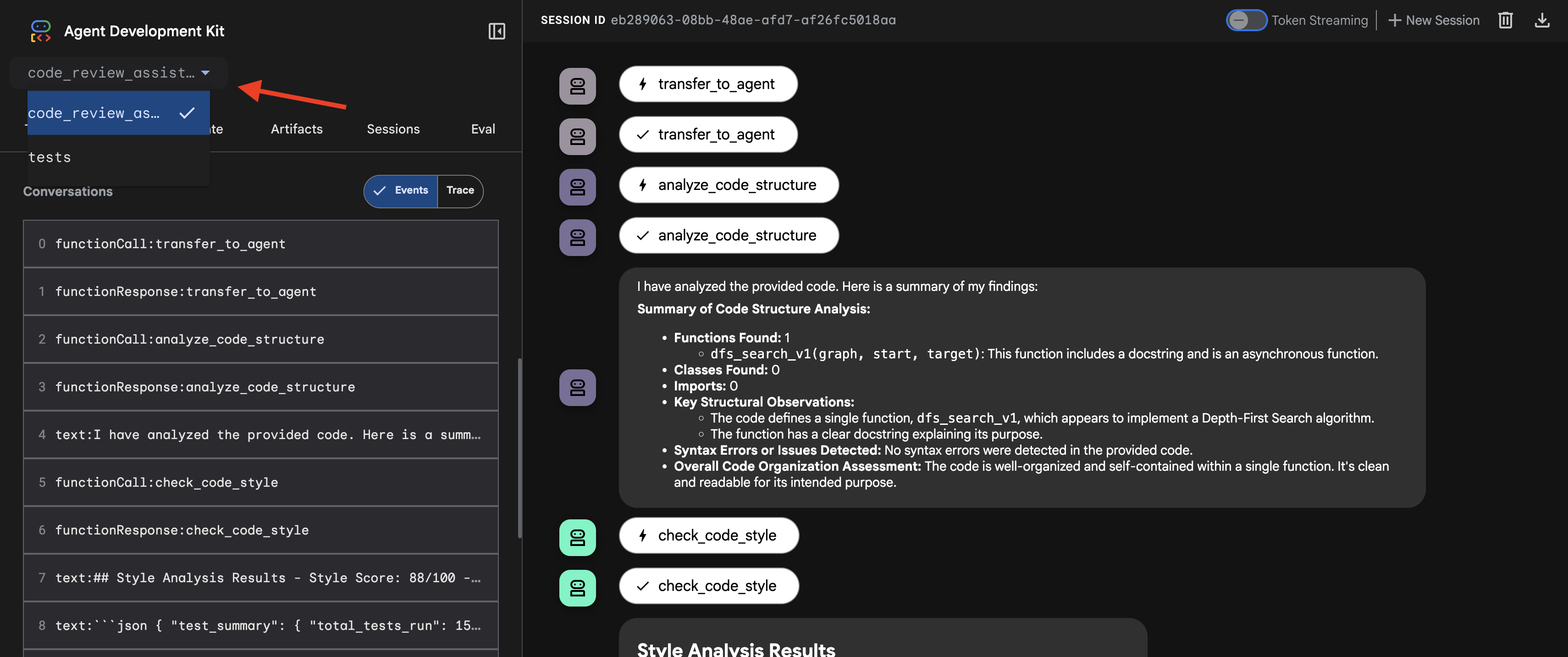

👉 El agente ahora se está ejecutando. La IU de desarrollo del ADK en tu navegador es tu conexión directa con el agente.

- Selecciona tu objetivo: En el menú desplegable de la parte superior de la IU, elige el agente

code_review_assistant.

👉 Instrucción de prueba:

Please analyze the following:

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

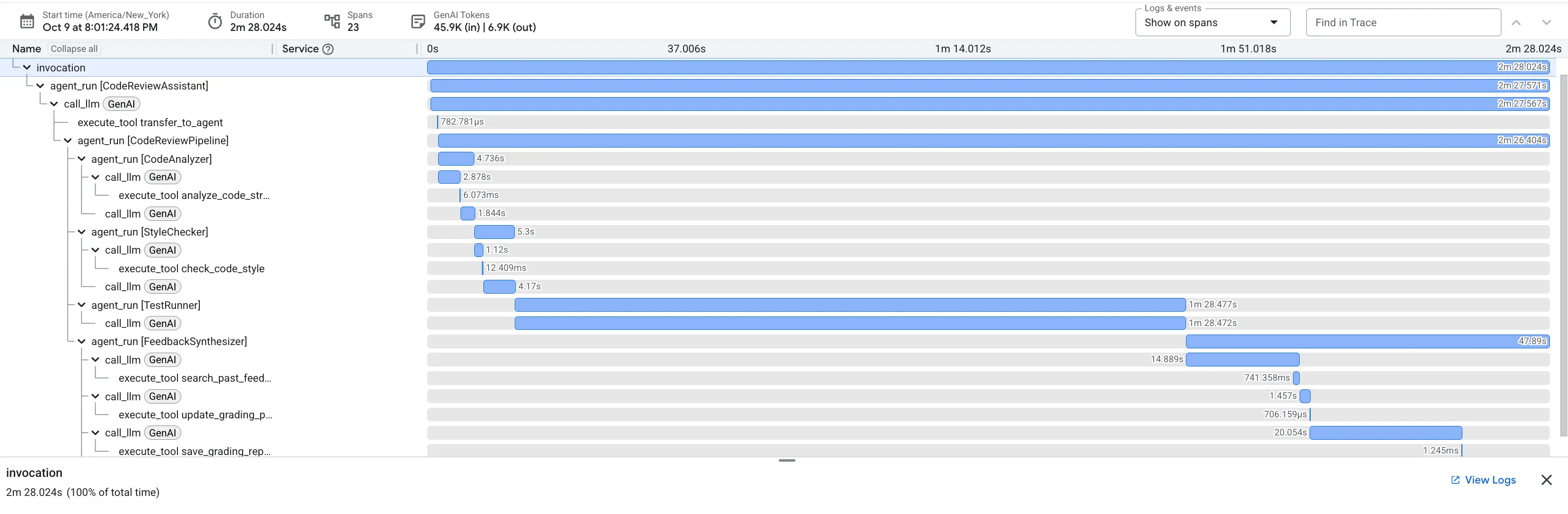

👉 Mira la canalización de revisión de código en acción:

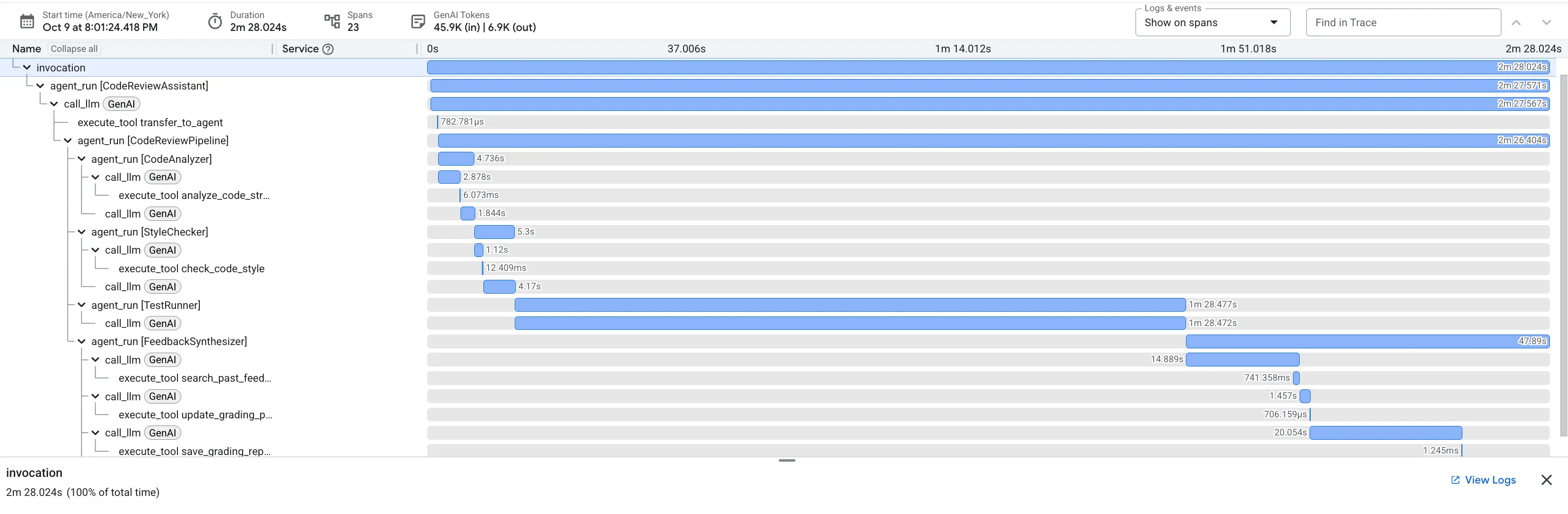

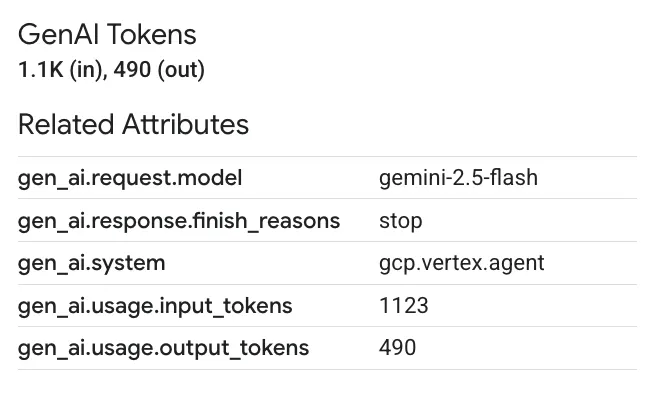

Cuando envías la función dfs_search_v1 con errores, no solo obtienes una respuesta. Estás viendo tu canalización de varios agentes en acción. El resultado de transmisión que ves es el resultado de cuatro agentes especializados que se ejecutan en secuencia, y cada uno se basa en el anterior.

A continuación, se incluye un desglose de lo que cada agente aporta a la revisión final y completa, convirtiendo los datos sin procesar en inteligencia práctica.

1. El informe estructural del Analizador de código

Primero, el agente CodeAnalyzer recibe el código sin procesar. No adivina lo que hace el código, sino que usa la herramienta analyze_code_structure para realizar un análisis determinístico del árbol de sintaxis abstracta (AST).

Su resultado son datos puros y fácticos sobre la estructura del código:

The analysis of the provided code reveals the following:

Summary:

- Functions Found: 1

- Classes Found: 0

Key Structural Observations:

- A single function, dfs_search_v1, is defined.

- It includes a docstring: "Find if target is reachable from start."

- No syntax errors were detected.

Overall Code Organization Assessment:

- The code snippet is a well-defined, self-contained function.

⭐ Valor: Este paso inicial proporciona una base limpia y confiable para los demás agentes. Confirma que el código es un código de Python válido y, luego, identifica los componentes exactos que se deben revisar.

2. Auditoría de PEP 8 del verificador de estilo

A continuación, el agente StyleChecker toma el control. Lee el código del estado compartido y usa la herramienta check_code_style, que aprovecha el verificador de código pycodestyle.

Su resultado es una puntuación de calidad cuantificable y los incumplimientos específicos:

Style Analysis Results

- Style Score: 88/100

- Total Issues: 6

- Assessment: Good style with minor improvements needed

Top Style Issues

- Line 5, W293: blank line contains whitespace

- Line 19, W292: no newline at end of file

⭐ Valor: Este agente proporciona comentarios objetivos y no negociables basados en los estándares de la comunidad establecidos (PEP 8). El sistema de puntuación ponderada le indica de inmediato al usuario la gravedad de los problemas.

3. Descubrimiento de errores críticos del ejecutor de pruebas

Aquí es donde el sistema va más allá del análisis superficial. El agente TestRunner genera y ejecuta un conjunto integral de pruebas para validar el comportamiento del código.

Su resultado es un objeto JSON estructurado que contiene un veredicto condenatorio:

{

"critical_issues": [

{

"type": "Critical Bug",

"description": "The function's initialization `stack = start` is incorrect... When a common input like a string... is provided... the function crashes with an AttributeError.",

"severity": "Critical"

}

],

"verdict": {

"status": "BROKEN",

"confidence": "high",

"recommendation": "The function is fundamentally broken... the stack initialization line `stack = start` must be changed to `stack = [start]`."

}

}

⭐ Valor: Esta es la estadística más importante. El agente no solo adivinó, sino que demostró que el código no funcionaba ejecutándolo. Descubrió un error de tiempo de ejecución sutil, pero crítico, que un revisor humano podría pasar por alto fácilmente, y señaló la causa exacta y la corrección necesaria.

4. Informe final del sintetizador de comentarios

Por último, el agente FeedbackSynthesizer actúa como director. Toma los datos estructurados de los tres agentes anteriores y elabora un solo informe fácil de usar que es tanto analítico como alentador.

El resultado es la opinión final y pulida que ves:

📊 Summary

Great effort on implementing the Depth-First Search algorithm! ... However, a critical bug in the initialization of the stack prevents the function from working correctly...

✅ Strengths

- Good Algorithm Structure

- Correct Use of `visited` Set

📈 Code Quality Analysis

...

### Style Compliance

The style analysis returned a good score of 88/100.

...

### Test Results

The automated testing revealed a critical issue... The line `stack = start` directly assigns the input... which results in an `AttributeError`.

💡 Recommendations for Improvement

**Fix the Critical Stack Initialization Bug:**

- Incorrect Code: `stack = start`

- Correct Code: `stack = [start]`

💬 Encouragement

You are very close to a perfect implementation! The core logic of your DFS algorithm is sound, which is the hardest part.

⭐ Valor: Este agente transforma los datos técnicos en una experiencia educativa y útil. Prioriza el problema más importante (el error), lo explica con claridad, proporciona la solución exacta y lo hace con un tono alentador. Integra con éxito los hallazgos de todas las etapas anteriores en un todo coherente y valioso.

Este proceso de varias etapas demuestra el poder de una canalización basada en agentes. En lugar de una respuesta única y monolítica, obtienes un análisis en capas en el que cada agente realiza una tarea especializada y verificable. Esto genera una revisión que no solo es reveladora, sino también determinística, confiable y profundamente educativa.

👉💻 Cuando termines de probar, vuelve a la terminal del editor de Cloud Shell y presiona Ctrl+C para detener la IU para desarrolladores del ADK.

Qué compilaste

Ahora tienes una canalización completa de revisión de código que hace lo siguiente:

✅ Analiza la estructura del código: Análisis determinístico del AST con funciones de ayuda

✅ Verifica el estilo: Puntuación ponderada con convenciones de nomenclatura

✅ Ejecuta pruebas: Generación integral de pruebas con salida JSON estructurada

✅ Sintetiza comentarios: Integra estado, memoria y artefactos

✅ Realiza un seguimiento del progreso: Estado de varios niveles en invocaciones, sesiones y usuarios

✅ Aprende con el tiempo: Servicio de memoria para patrones entre sesiones

✅ Proporciona artefactos: Informes JSON descargables con un registro de auditoría completo

Conceptos clave dominados

Canalizaciones secuenciales:

- Cuatro agentes que se ejecutan en orden estricto

- Cada uno enriquece el estado para el siguiente.

- Las dependencias determinan la secuencia de ejecución

Patrones de producción:

- Separación de funciones auxiliares (sincronización en grupos de subprocesos)

- Degradación elegante (estrategias de resguardo)

- Administración de estados de varios niveles (temporal, de sesión y de usuario)

- Proveedores de instrucciones dinámicas (adaptados al contexto)

- Almacenamiento doble (redundancia de artefactos y estado)

El estado como comunicación:

- Las constantes evitan errores de escritura en todos los agentes

output_keyescribe resúmenes del agente en el estado- Los agentes posteriores leen a través de StateKeys

- El estado fluye de forma lineal a través de la canalización

Memoria vs. Estado:

- Estado: Datos de la sesión actual

- Memoria: Patrones en las sesiones

- Diferentes propósitos, diferentes vidas útiles

Organización de herramientas:

- Agentes de una sola herramienta (analyzer, style_checker)

- Ejecutores integrados (test_runner)

- Coordinación de múltiples herramientas (sintetizador)

Estrategia de selección del modelo:

- Modelo de trabajador: Tareas mecánicas (análisis, linting, enrutamiento)

- Modelo de crítico: Tareas de razonamiento (pruebas, síntesis)

- Optimización de costos a través de la selección adecuada

Pasos siguientes

En el módulo 6, compilarás la canalización de corrección:

- Arquitectura de LoopAgent para correcciones iterativas

- Condiciones de salida a través de la derivación

- Acumulación de estado en las iteraciones

- Lógica de validación y reintento

- Integración con la canalización de revisión para ofrecer correcciones

Verás cómo los mismos patrones de estado se adaptan a flujos de trabajo iterativos complejos en los que los agentes intentan varias veces hasta tener éxito, y cómo coordinar varias canalizaciones en una sola aplicación.

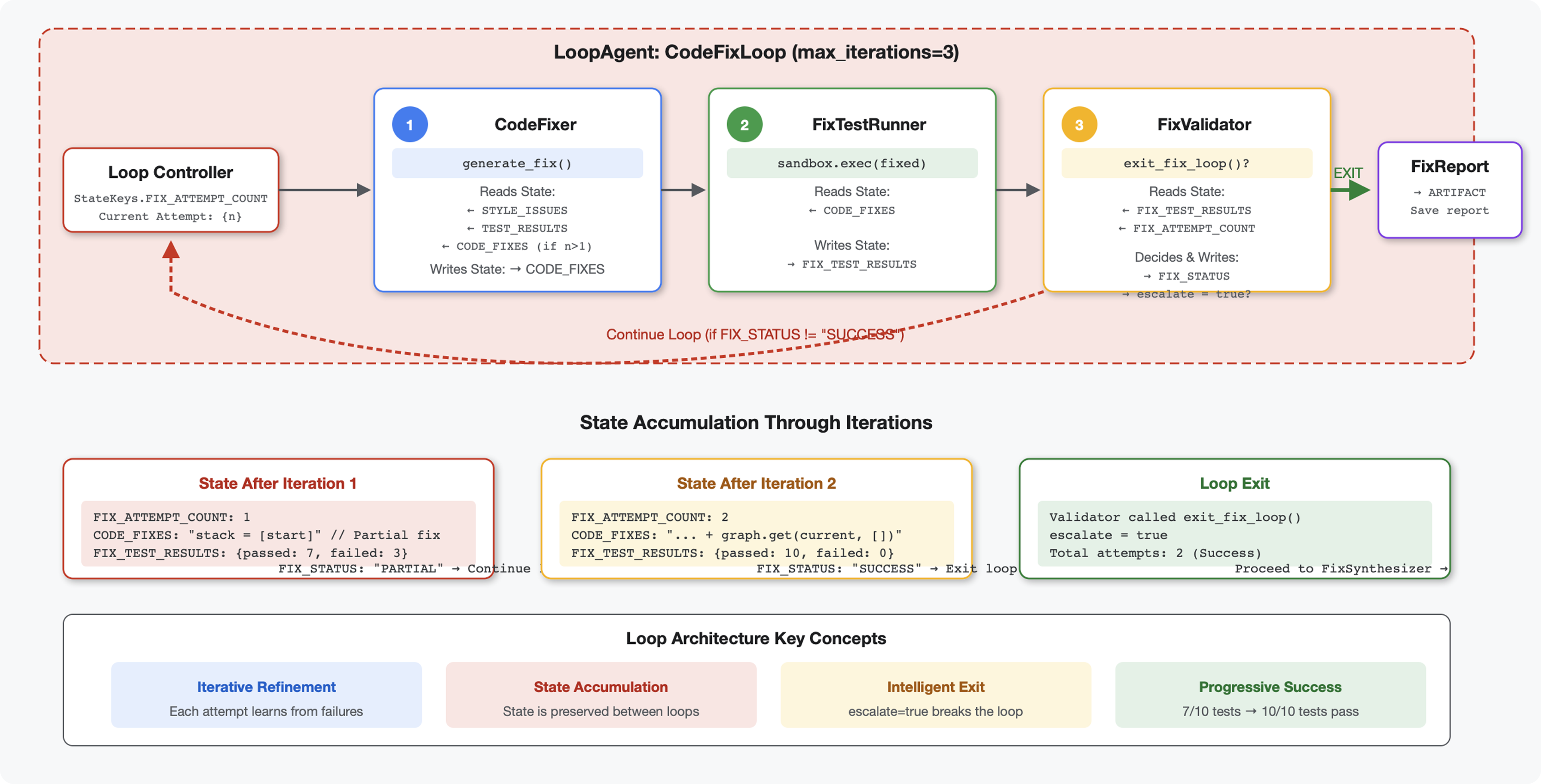

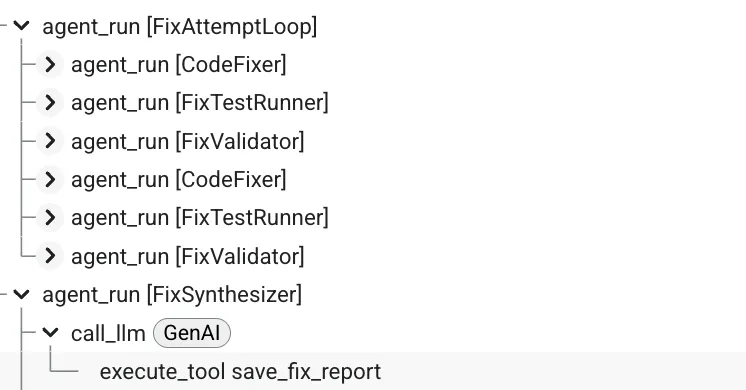

6. Cómo agregar la canalización de corrección: arquitectura de bucle

Introducción

En el módulo 5, creaste una canalización de revisión secuencial que analiza el código y proporciona comentarios. Sin embargo, identificar los problemas es solo la mitad de la solución: los desarrolladores necesitan ayuda para corregirlos.

En este módulo, se compila una canalización de corrección automatizada que hace lo siguiente:

- Genera correcciones basadas en los resultados de la revisión.

- Valida las correcciones ejecutando pruebas integrales.

- Reintenta automáticamente si las correcciones no funcionan (hasta 3 intentos)

- Resultados de los informes con comparaciones de antes y después

Concepto clave: LoopAgent para reintentos automáticos. A diferencia de los agentes secuenciales que se ejecutan una vez, un LoopAgent repite sus subagentes hasta que se cumple una condición de salida o se alcanza la cantidad máxima de iteraciones. Las herramientas indican que la operación se realizó correctamente estableciendo tool_context.actions.escalate = True.

Vista previa de lo que crearás: Envía código con errores → la revisión identifica problemas → el bucle de corrección genera correcciones → las pruebas validan → se reintenta si es necesario → informe final integral.

Conceptos básicos: LoopAgent vs. Sequential

Canalización secuencial (módulo 5):

SequentialAgent(agents=[A, B, C])

# Executes: A → B → C → Done

- Flujo unidireccional

- Cada agente se ejecuta exactamente una vez.

- Sin lógica de reintento

Canalización de bucle (módulo 6):

LoopAgent(agents=[A, B, C], max_iterations=3)

# Executes: A → B → C → (check exit) → A → B → C → (check exit) → ...

- Flujo cíclico

- Los agentes se pueden ejecutar varias veces

- Se cierra cuando:

- Un conjunto de herramientas establece

tool_context.actions.escalate = True(éxito) - Se alcanzó el límite de

max_iterations(límite de seguridad) - Se produce una excepción no controlada (error).

- Un conjunto de herramientas establece

Por qué usar bucles para corregir código:

Las correcciones de código suelen requerir varios intentos:

- Primer intento: Corrige errores evidentes (tipos de variables incorrectos)

- Segundo intento: Corrige los problemas secundarios que revelan las pruebas (casos extremos).

- Tercer intento: Ajusta y valida que todas las pruebas pasen

Sin un bucle, necesitarías una lógica condicional compleja en las instrucciones del agente. Con LoopAgent, el reintento es automático.

Comparación de arquitecturas:

Sequential (Module 5):

User → Review Pipeline → Feedback → Done

Loop (Module 6):

User → Review Pipeline → Feedback → Fix Pipeline

↓

┌──────────────┴──────────────┐

│ Fix Attempt Loop (1-3x) │

│ ┌─────────────────────┐ │

│ │ 1. Generate Fixes │ │

│ │ 2. Test Fixes │ │

│ │ 3. Validate & Exit? │────┼─→ If escalate=True

│ └─────────────────────┘ │ exit loop

│ ↓ If not │

│ Try Again (max 3) │

└─────────────────────────────┘

↓

4. Synthesize Final Report → Done

Paso 1: Agrega el agente de Code Fixer

El corrector de código genera código de Python corregido en función de los resultados de la revisión.

👉 Abrir

code_review_assistant/sub_agents/fix_pipeline/code_fixer.py

👉 Buscar:

# MODULE_6_STEP_1_CODE_FIXER_INSTRUCTION_PROVIDER

👉 Reemplaza esa sola línea por lo siguiente:

async def code_fixer_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code fixing specialist.

Original Code:

{code_to_review}

Analysis Results:

- Style Score: {style_score}/100

- Style Issues: {style_issues}

- Test Results: {test_execution_summary}

Based on the test results, identify and fix ALL issues including:

- Interface bugs (e.g., if start parameter expects wrong type)

- Logic errors (e.g., KeyError when accessing graph nodes)

- Style violations

- Missing documentation

YOUR TASK:

Generate the complete fixed Python code that addresses all identified issues.

CRITICAL INSTRUCTIONS:

- Output ONLY the corrected Python code

- Do NOT include markdown code blocks (```python)

- Do NOT include any explanations or commentary

- The output should be valid, executable Python code and nothing else

Common fixes to apply based on test results:

- If tests show AttributeError with 'pop', fix: stack = [start] instead of stack = start

- If tests show KeyError accessing graph, fix: use graph.get(current, [])

- Add docstrings if missing

- Fix any style violations identified

Output the complete fixed code now:"""

return await instructions_utils.inject_session_state(template, context)

👉 Buscar:

# MODULE_6_STEP_1_CODE_FIXER_AGENT

👉 Reemplaza esa sola línea por lo siguiente:

code_fixer_agent = Agent(

name="CodeFixer",

model=config.worker_model,

description="Generates comprehensive fixes for all identified code issues",

instruction=code_fixer_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="code_fixes"

)

Paso 2: Agrega el agente de Fix Test Runner

El ejecutor de pruebas de corrección valida las correcciones ejecutando pruebas integrales en el código corregido.

👉 Abrir

code_review_assistant/sub_agents/fix_pipeline/fix_test_runner.py

👉 Buscar:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_INSTRUCTION_PROVIDER

👉 Reemplaza esa sola línea por lo siguiente:

async def fix_test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that uses the clean code from the previous step."""

template = """You are responsible for validating the fixed code by running tests.

THE FIXED CODE TO TEST:

{code_fixes}

ORIGINAL TEST RESULTS: {test_execution_summary}

YOUR TASK:

1. Understand the fixes that were applied

2. Generate the same comprehensive tests (15-20 test cases)

3. Execute the tests on the FIXED code using your code executor

4. Compare results with original test results

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Run the same tests that revealed issues in the original code

- Verify that previously failing tests now pass

- Ensure no regressions were introduced

- Document the improvement

Execute your tests and output ONLY valid JSON with this structure:

- "passed": number of tests that passed

- "failed": number of tests that failed

- "total": total number of tests

- "pass_rate": percentage as a number

- "comparison": object with "original_pass_rate", "new_pass_rate", "improvement"

- "newly_passing_tests": array of test names that now pass

- "still_failing_tests": array of test names still failing

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Buscar:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_AGENT

👉 Reemplaza esa sola línea por lo siguiente:

fix_test_runner_agent = Agent(

name="FixTestRunner",

model=config.critic_model,

description="Runs comprehensive tests on fixed code to verify all issues are resolved",

instruction=fix_test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="fix_test_execution_summary"

)

Paso 3: Agrega el agente de Fix Validator

El validador verifica si las correcciones se realizaron correctamente y decide si se debe salir del bucle.

Conceptos básicos sobre las herramientas

Primero, agrega las tres herramientas que necesita el validador.

👉 Abrir

code_review_assistant/tools.py

👉 Buscar:

# MODULE_6_STEP_3_VALIDATE_FIXED_STYLE

👉 Reemplaza con la herramienta 1: Validador de estilo:

async def validate_fixed_style(tool_context: ToolContext) -> Dict[str, Any]:

"""

Validates style compliance of the fixed code.

Args:

tool_context: ADK tool context containing fixed code in state

Returns:

Dictionary with style validation results

"""

logger.info("Tool: Validating style of fixed code...")

try:

# Get the fixed code from state