1. The Late Night Code Review

השעה 2:00

אתם מנסים לאתר באגים כבר שעות. הפונקציה נראית תקינה, אבל משהו לא בסדר. כולנו מכירים את ההרגשה הזו – כשקוד אמור לעבוד אבל לא עובד, ואנחנו לא מצליחים להבין למה כי אנחנו בוהים בו כבר יותר מדי זמן.

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start # Looks innocent enough...

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

המסע של מפתחי AI

אם אתם קוראים את המאמר הזה, כנראה שחוויתם את השינוי ש-AI מביא לתכנות. כלים כמו Gemini Code Assist, Claude Code ו-Cursor שינו את האופן שבו אנחנו כותבים קוד. הם מצוינים ליצירת קוד סטנדרטי, להצעת יישומים ולהאצת הפיתוח.

אבל אתם כאן כי אתם רוצים להעמיק. אתם רוצים להבין איך לבנות את מערכות ה-AI האלה, ולא רק להשתמש בהן. אתם רוצים ליצור משהו ש:

- התנהגות צפויה וניתנת למעקב

- אפשר לפרוס אותו בסביבת הייצור בביטחון

- מספק תוצאות עקביות שאפשר להסתמך עליהן

- הסבר מדויק על אופן קבלת ההחלטות

מצרכן ליוצר

היום תעברו משימוש בכלי AI ליצירת כלים כאלה בעצמכם. תבנו מערכת מרובת סוכנים שתעשה את הפעולות הבאות:

- מנתח את מבנה הקוד באופן דטרמיניסטי

- מריץ בדיקות בפועל כדי לאמת את ההתנהגות

- מאמת את התאימות לסגנון באמצעות כלי לינט אמיתיים

- מסנתז ממצאים למשוב שניתן לפעול לפיו

- פריסה ב-Google Cloud עם ניראות מלאה

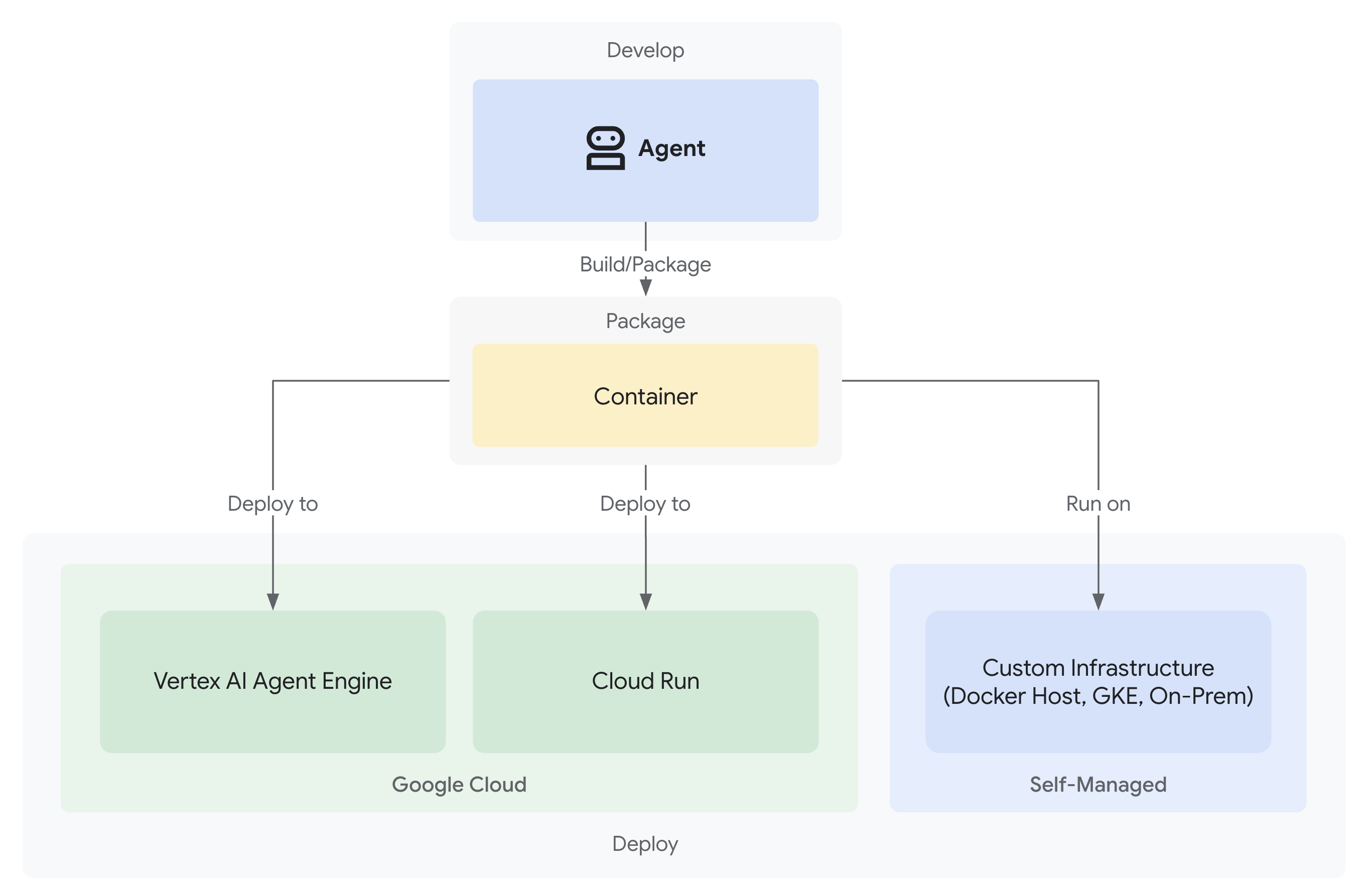

2. הפריסה הראשונה של נציג

השאלה של המפתח

"אני מבין מה זה מודל שפה גדול (LLM), השתמשתי בממשקי ה-API, אבל איך עוברים מסקריפט Python לסוכן AI בסביבת ייצור שאפשר להרחיב?"

כדי לענות על השאלה הזו, נגדיר את הסביבה שלכם בצורה נכונה, ואז ניצור סוכן פשוט כדי להבין את היסודות לפני שנעבור לדפוסי ייצור.

קודם כל מבצעים את ההגדרה הבסיסית

לפני שיוצרים סוכנים, צריך לוודא שהסביבה שלכם ב-Google Cloud מוכנה.

צריכים קרדיטים ב-Google Cloud?

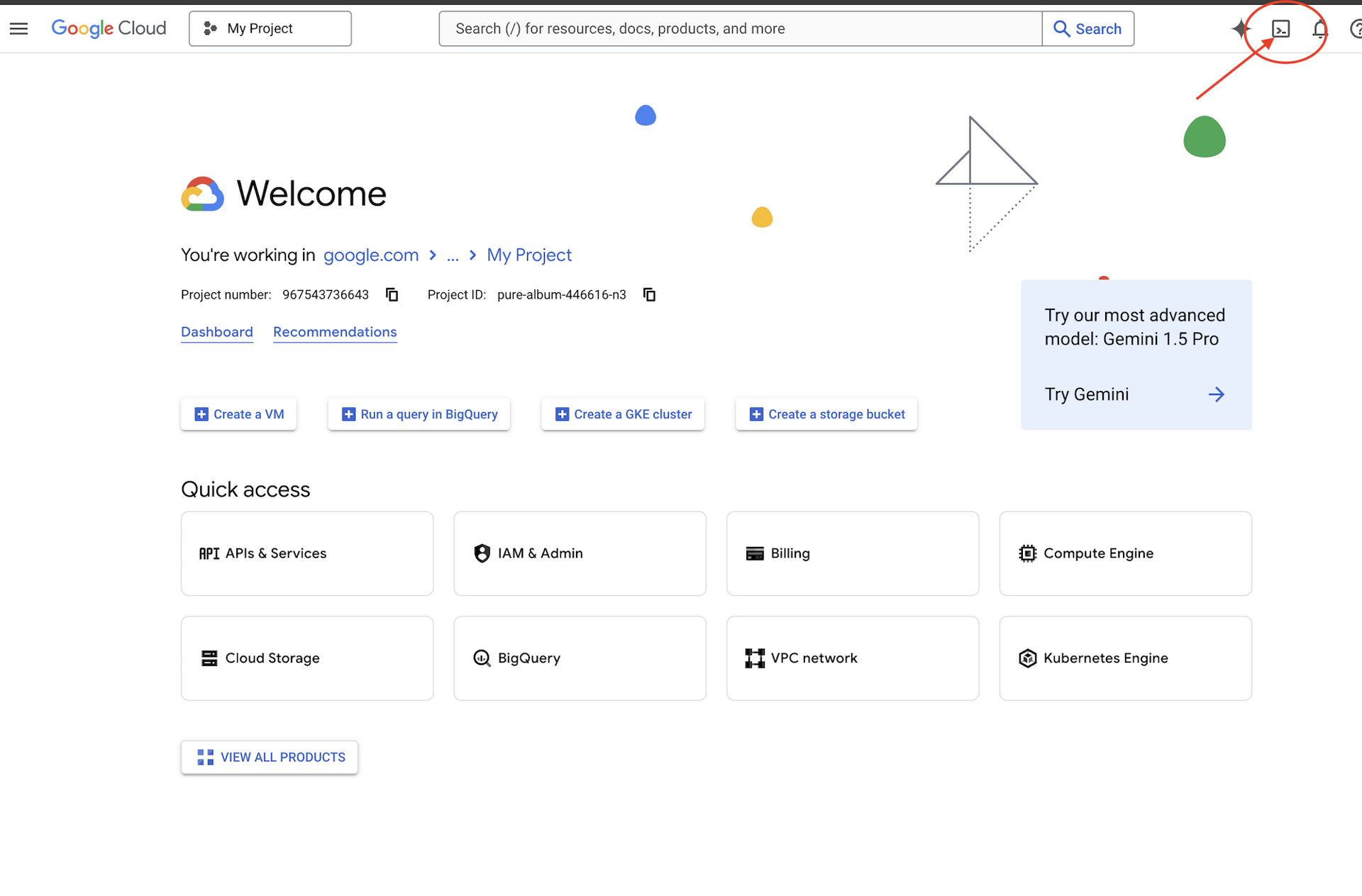

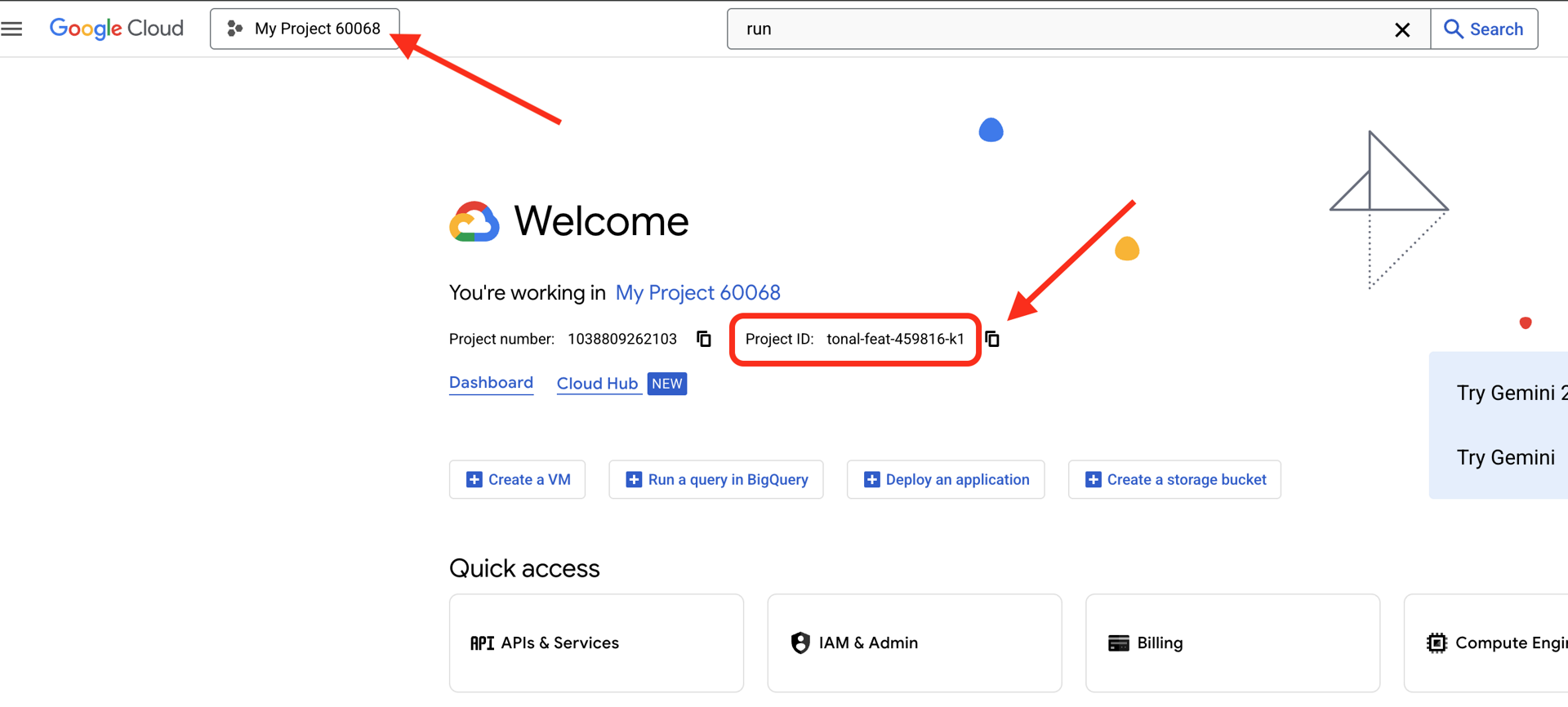

לוחצים על Activate Cloud Shell (הפעלת Cloud Shell) בחלק העליון של מסוף Google Cloud (זהו סמל בצורת מסוף בחלק העליון של חלונית Cloud Shell).

כדי למצוא את מזהה הפרויקט ב-Google Cloud:

- פותחים את Google Cloud Console: https://console.cloud.google.com

- בוחרים את הפרויקט שבו רוצים להשתמש בסדנה הזו מהתפריט הנפתח של הפרויקט בחלק העליון של הדף.

- מזהה הפרויקט מוצג בכרטיס Project info בלוח הבקרה

שלב 1: הגדרת מזהה הפרויקט

ב-Cloud Shell, כלי שורת הפקודה gcloud כבר מוגדר. מריצים את הפקודה הבאה כדי להגדיר את הפרויקט הפעיל. הפקודה הזו משתמשת במשתנה הסביבה $GOOGLE_CLOUD_PROJECT, שמוגדר אוטומטית בסשן Cloud Shell.

gcloud config set project $GOOGLE_CLOUD_PROJECT

שלב 2: אימות ההגדרה

לאחר מכן, מריצים את הפקודות הבאות כדי לוודא שהפרויקט מוגדר בצורה נכונה ושהאימות בוצע.

# Confirm project is set

echo "Current project: $(gcloud config get-value project)"

# Check authentication status

gcloud auth list

מזהה הפרויקט שלכם אמור להופיע, וחשבון המשתמש שלכם יופיע עם (ACTIVE) לידו.

אם החשבון שלכם לא מופיע כפעיל, או אם מופיעה שגיאת אימות, מריצים את הפקודה הבאה כדי להיכנס:

gcloud auth application-default login

שלב 3: הפעלת ממשקי API חיוניים

אנחנו צריכים לפחות את ממשקי ה-API הבאים לסוכן הבסיסי:

gcloud services enable \

aiplatform.googleapis.com \

compute.googleapis.com

פעולה זו עשויה להימשך דקה או שתיים. הפרטים שמוצגים הם:

Operation "operations/..." finished successfully.

שלב 4: התקנת ADK

# Install the ADK CLI

pip install google-adk --upgrade

# Verify installation

adk --version

אמורה להופיע גרסה כמו 1.15.0 ומעלה.

עכשיו יוצרים את הסוכן הבסיסי

אחרי שהסביבה מוכנה, אפשר ליצור את הסוכן הפשוט.

שלב 5: שימוש ב-ADK Create

adk create my_first_agent

פועלים לפי ההנחיות האינטראקטיביות:

Choose a model for the root agent:

1. gemini-2.5-flash

2. Other models (fill later)

Choose model (1, 2): 1

1. Google AI

2. Vertex AI

Choose a backend (1, 2): 2

Enter Google Cloud project ID [auto-detected-from-gcloud]:

Enter Google Cloud region [us-central1]:

שלב 6: בודקים מה נוצר

cd my_first_agent

ls -la

יוצגו שלושה קבצים:

.env # Configuration (auto-populated with your project)

__init__.py # Package marker

agent.py # Your agent definition

שלב 7: בדיקה מהירה של ההגדרות

# Verify the .env was created correctly

cat .env

# Should show something like:

# GOOGLE_CLOUD_PROJECT=your-project-id

# GOOGLE_CLOUD_LOCATION=us-central1

# GOOGLE_GENAI_USE_VERTEXAI=1

אם מזהה הפרויקט חסר או שגוי, צריך לערוך את הקובץ .env:

nano .env # or use your preferred editor

שלב 8: בודקים את קוד הסוכן

cat agent.py

from google.adk.agents.llm_agent import Agent

root_agent = Agent(

model='gemini-2.5-flash',

name='root_agent',

description='A helpful assistant for user questions.',

instruction='Answer user questions to the best of your knowledge',

)

פשוט, נקי, מינימליסטי. זהו ה-Hello World שלכם בנושא נציגים.

בדיקת הנציג הבסיסי

שלב 9: הפעלת הסוכן

cd ..

adk run my_first_agent

אמורה להופיע הודעה שדומה להודעה הבאה:

Log setup complete: /tmp/agents_log/agent.20250930_162430.log

To access latest log: tail -F /tmp/agents_log/agent.latest.log

[user]:

שלב 10: מנסים כמה שאילתות

בטרמינל שבו פועל adk run, תופיע הנחיה. מקלידים את השאילתות:

[user]: Hey, what can you do?

[root_agent]: I can help answer questions, generate text, explain concepts, assist with problem-solving, and provide information on a wide range of topics. What would you like to know or discuss?

[user]: What's the current weather in Mountain View?

[root_agent]: I'm sorry, but I cannot provide real-time weather information as I don't have access to current data or weather services. To get the current weather in Mountain View, I recommend checking a weather website or app like weather.com or using a search engine.

שימו לב למגבלה – אין לו גישה לנתונים עדכניים. בואו נמשיך:

[user]: Review this Python code: def add(a, b): return a + b

[root_agent]: This is a simple Python function that adds two numbers. Here's my review:

**Strengths:**

- Clean and concise implementation

- Follows Python conventions for simple operations

- Clear function name that describes its purpose

**Suggestions for improvement:**

- Add a docstring to document the function

- Consider adding type hints for better code clarity

- You might want to handle edge cases

Here's an enhanced version:

def add(a: float, b: float) -> float:

"""Add two numbers and return their sum."""

return a + b

הסוכן יכול לדון בקוד, אבל האם הוא יכול:

- האם לנתח את ה-AST כדי להבין את המבנה?

- להריץ בדיקות כדי לוודא שהיא פועלת?

- האם לבדוק את התאימות לסגנון?

- זוכר את הביקורות הקודמות שלך?

לא. כאן אנחנו צריכים ארכיטקטורה.

🏃🚪 Exit with

Ctrl+C

כשמסיימים את החיפוש.

3. הכנת סביבת הייצור שלכם ב-Workspace

הפתרון: ארכיטקטורה שמוכנה לייצור

הסוכן הפשוט הזה הדגים את נקודת ההתחלה, אבל מערכת ייצור דורשת מבנה חזק. עכשיו נגדיר פרויקט מלא שמגלם עקרונות של ייצור.

הגדרת הבסיס

כבר הגדרתם את פרויקט Google Cloud לסוכן הבסיסי. עכשיו נכין את סביבת העבודה המלאה לייצור עם כל הכלים, התבניות והתשתית שנדרשים למערכת אמיתית.

שלב 1: מקבלים את הפרויקט המובנה

קודם צריך לצאת מכל אפליקציה שפועלת adk run באמצעות Ctrl+C ולנקות:

# Clean up the basic agent

cd ~ # Make sure you're not inside my_first_agent

rm -rf my_first_agent

# Get the production scaffold

git clone https://github.com/ayoisio/adk-code-review-assistant.git

cd adk-code-review-assistant

git checkout codelab

שלב 2: יצירה והפעלה של סביבה וירטואלית

# Create the virtual environment

python -m venv .venv

# Activate it

# On macOS/Linux:

source .venv/bin/activate

# On Windows:

# .venv\Scripts\activate

אימות: ההנחיה שלכם צריכה להתחיל עכשיו ב-(.venv).

שלב 3: התקנת יחסי תלות

pip install -r code_review_assistant/requirements.txt

# Install the package in editable mode (enables imports)

pip install -e .

הפעולה הזו מתקינה:

-

google-adk– מסגרת ADK -

pycodestyle– לבדיקה של PEP 8 -

vertexai– לפריסה בענן - יחסי תלות אחרים של הפקה

הדגל -e מאפשר לייבא מודולים של code_review_assistant מכל מקום.

שלב 4: הגדרת הסביבה

# Copy the example environment file

cp .env.example .env

# Edit .env and replace the placeholders:

# - GOOGLE_CLOUD_PROJECT=your-project-id → your actual project ID

# - Keep other defaults as-is

אימות: בדיקת ההגדרה:

cat .env

צריך להופיע:

GOOGLE_CLOUD_PROJECT=your-actual-project-id

GOOGLE_CLOUD_LOCATION=us-central1

GOOGLE_GENAI_USE_VERTEXAI=TRUE

שלב 5: מוודאים שהאימות פועל

מכיוון שכבר הפעלת את gcloud auth קודם, נבדוק רק את הדברים הבאים:

# Check current authentication

gcloud auth list

# Should show your account with (ACTIVE)

# If not, run:

gcloud auth application-default login

שלב 6: הפעלת ממשקי API נוספים של סביבת הייצור

כבר הפעלנו ממשקי API בסיסיים. עכשיו מוסיפים את אלה של סביבת הייצור:

gcloud services enable \

sqladmin.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

artifactregistry.googleapis.com \

storage.googleapis.com \

cloudtrace.googleapis.com

השינוי מאפשר:

- SQL Admin: ל-Cloud SQL אם משתמשים ב-Cloud Run

- Cloud Run: לפריסה ללא שרת

- Cloud Build: לפריסות אוטומטיות

- Artifact Registry: לתמונות של קונטיינרים

- Cloud Storage: לארטיפקטים ולשלבי ביניים

- Cloud Trace: לצורך יכולת צפייה

שלב 7: יוצרים Artifact Registry Repository

הפריסה שלנו תיצור קובצי אימג' של קונטיינרים שצריכים בית:

gcloud artifacts repositories create code-review-assistant-repo \

--repository-format=docker \

--location=us-central1 \

--description="Docker repository for Code Review Assistant"

הפרטים שמוצגים הם:

Created repository [code-review-assistant-repo].

אם הוא כבר קיים (אולי מניסיון קודם), זה בסדר – תוצג הודעת שגיאה שאפשר להתעלם ממנה.

שלב 8: הענקת הרשאות IAM

# Get your project number

PROJECT_NUMBER=$(gcloud projects describe $GOOGLE_CLOUD_PROJECT \

--format="value(projectNumber)")

# Define the service account

SERVICE_ACCOUNT="${PROJECT_NUMBER}@cloudbuild.gserviceaccount.com"

# Grant necessary roles

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/run.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/iam.serviceAccountUser"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/cloudsql.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/storage.admin"

כל פקודה תפיק את הפלט הבא:

Updated IAM policy for project [your-project-id].

מה השגתם

סביבת העבודה שלכם בסביבת הייצור מוכנה עכשיו באופן מלא:

✅ פרויקט Google Cloud מוגדר ומאומת

✅ סוכן בסיסי נבדק כדי להבין את המגבלות

✅ קוד הפרויקט עם placeholders אסטרטגיים מוכן

✅ יחסי התלות מבודדים בסביבה וירטואלית

✅ כל ממשקי ה-API הנדרשים מופעלים

✅ מאגר התמונות של הקונטיינרים מוכן לפריסות

✅ הרשאות ה-IAM מוגדרות בצורה נכונה

✅ משתני הסביבה מוגדרים בצורה נכונה

עכשיו אתם מוכנים לבנות מערכת AI אמיתית עם כלים דטרמיניסטיים, ניהול מצב וארכיטקטורה מתאימה.

4. יצירת הסוכן הראשון

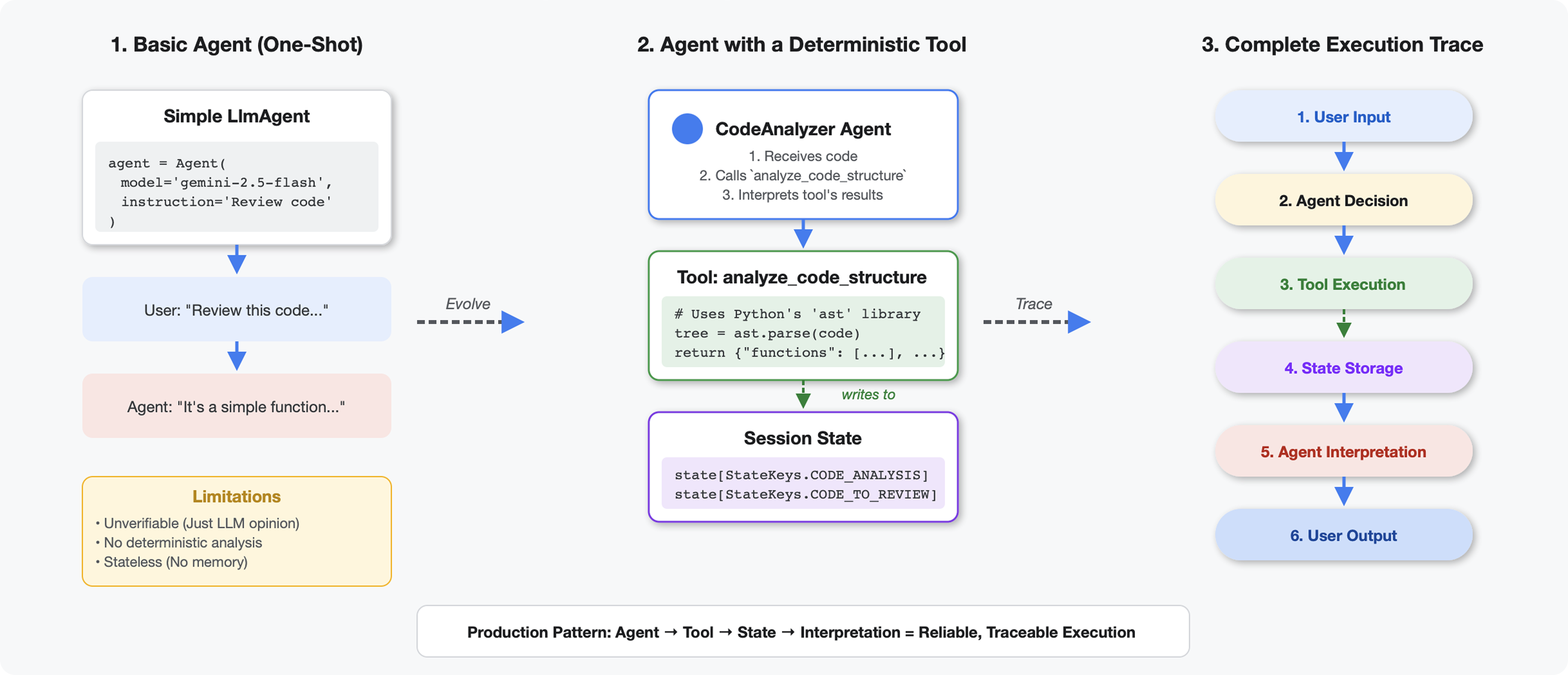

מה ההבדל בין כלים לבין מודלים גדולים של שפה (LLM)

כששואלים מודל LLM 'כמה פונקציות יש בקוד הזה?', הוא משתמש בהתאמת תבניות ובאומדן. כשמשתמשים בכלי שמפעיל את ast.parse() של Python, הכלי מנתח את עץ התחביר בפועל – בלי ניחושים, ותמיד מתקבלת אותה תוצאה.

בקטע הזה נבנה כלי שמנתח את מבנה הקוד באופן דטרמיניסטי, ואז מקשר אותו לסוכן שיודע מתי להפעיל אותו.

שלב 1: הסבר על ה-Scaffold

בואו נבדוק את המבנה שתצטרכו למלא.

👉 פתיחה

code_review_assistant/tools.py

תופיע הפונקציה analyze_code_structure עם הערות placeholder שמציינות איפה צריך להוסיף קוד. לפונקציה כבר יש את המבנה הבסיסי – תשפרו אותה שלב אחרי שלב.

שלב 2: מוסיפים אחסון של מצב

אחסון המצב מאפשר לסוכנים אחרים בצינור הנתונים לגשת לתוצאות של הכלי בלי להריץ מחדש את הניתוח.

👉 Find:

# MODULE_4_STEP_2_ADD_STATE_STORAGE

👈 מחליפים את השורה היחידה הזו ב:

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

שלב 3: הוספת ניתוח אסינכרוני באמצעות מאגרי שרשורים

הכלי שלנו צריך לנתח AST בלי לחסום פעולות אחרות. בואו נוסיף ביצוע אסינכרוני עם מאגרי שרשורים.

👉 Find:

# MODULE_4_STEP_3_ADD_ASYNC

👈 מחליפים את השורה היחידה הזו ב:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

שלב 4: חילוץ מידע מקיף

עכשיו נחלץ מחלקות, ייבוא ומדדים מפורטים – כל מה שצריך כדי לבצע בדיקת קוד מלאה.

👉 Find:

# MODULE_4_STEP_4_EXTRACT_DETAILS

👈 מחליפים את השורה היחידה הזו ב:

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

👉 אימות: הפונקציה

analyze_code_structure

ב

tools.py

יש לו גוף מרכזי שנראה כך:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

👈 עכשיו גוללים לתחתית הדף

tools.py

ולמצוא את:

# MODULE_4_STEP_4_HELPER_FUNCTION

👉 מחליפים את השורה היחידה הזו בפונקציית העזר המלאה:

def _extract_code_structure(tree: ast.AST, code: str) -> Dict[str, Any]:

"""

Helper function to extract structural information from AST.

Runs in thread pool for CPU-bound work.

"""

functions = []

classes = []

imports = []

docstrings = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

func_info = {

'name': node.name,

'args': [arg.arg for arg in node.args.args],

'lineno': node.lineno,

'has_docstring': ast.get_docstring(node) is not None,

'is_async': isinstance(node, ast.AsyncFunctionDef),

'decorators': [d.id for d in node.decorator_list

if isinstance(d, ast.Name)]

}

functions.append(func_info)

if func_info['has_docstring']:

docstrings.append(f"{node.name}: {ast.get_docstring(node)[:50]}...")

elif isinstance(node, ast.ClassDef):

methods = []

for item in node.body:

if isinstance(item, ast.FunctionDef):

methods.append(item.name)

class_info = {

'name': node.name,

'lineno': node.lineno,

'methods': methods,

'has_docstring': ast.get_docstring(node) is not None,

'base_classes': [base.id for base in node.bases

if isinstance(base, ast.Name)]

}

classes.append(class_info)

elif isinstance(node, ast.Import):

for alias in node.names:

imports.append({

'module': alias.name,

'alias': alias.asname,

'type': 'import'

})

elif isinstance(node, ast.ImportFrom):

imports.append({

'module': node.module or '',

'names': [alias.name for alias in node.names],

'type': 'from_import',

'level': node.level

})

return {

'functions': functions,

'classes': classes,

'imports': imports,

'docstrings': docstrings,

'metrics': {

'line_count': len(code.splitlines()),

'function_count': len(functions),

'class_count': len(classes),

'import_count': len(imports),

'has_main': any(f['name'] == 'main' for f in functions),

'has_if_main': '__main__' in code,

'avg_function_length': _calculate_avg_function_length(tree)

}

}

def _calculate_avg_function_length(tree: ast.AST) -> float:

"""Calculate average function length in lines."""

function_lengths = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

if hasattr(node, 'end_lineno') and hasattr(node, 'lineno'):

length = node.end_lineno - node.lineno + 1

function_lengths.append(length)

if function_lengths:

return sum(function_lengths) / len(function_lengths)

return 0.0

שלב 5: התחברות לנציג

עכשיו אנחנו מחברים את הכלי לסוכן שיודע מתי להשתמש בו ואיך לפרש את התוצאות שלו.

👉 פתיחה

code_review_assistant/sub_agents/review_pipeline/code_analyzer.py

👉 Find:

# MODULE_4_STEP_5_CREATE_AGENT

👈 מחליפים את השורה היחידה הזו בסוכן הייצור המלא:

code_analyzer_agent = Agent(

name="CodeAnalyzer",

model=config.worker_model,

description="Analyzes Python code structure and identifies components",

instruction="""You are a code analysis specialist responsible for understanding code structure.

Your task:

1. Take the code submitted by the user (it will be provided in the user message)

2. Use the analyze_code_structure tool to parse and analyze it

3. Pass the EXACT code to your tool - do not modify, fix, or "improve" it

4. Identify all functions, classes, imports, and structural patterns

5. Note any syntax errors or structural issues

6. Store the analysis in state for other agents to use

CRITICAL:

- Pass the code EXACTLY as provided to the analyze_code_structure tool

- Do not fix syntax errors, even if obvious

- Do not add missing imports or fix indentation

- The goal is to analyze what IS there, not what SHOULD be there

When calling the tool, pass the code as a string to the 'code' parameter.

If the analysis fails due to syntax errors, clearly report the error location and type.

Provide a clear summary including:

- Number of functions and classes found

- Key structural observations

- Any syntax errors or issues detected

- Overall code organization assessment""",

tools=[FunctionTool(func=analyze_code_structure)],

output_key="structure_analysis_summary"

)

בדיקת כלי ניתוח הקוד

עכשיו צריך לוודא שהכלי לניתוח פועל בצורה תקינה.

👈 מריצים את סקריפט הבדיקה:

python tests/test_code_analyzer.py

סקריפט הבדיקה טוען אוטומטית את ההגדרה מקובץ .env באמצעות python-dotenv, כך שלא צריך להגדיר משתנה סביבה באופן ידני.

הפלט הצפוי:

INFO:code_review_assistant.config:Code Review Assistant Configuration Loaded:

INFO:code_review_assistant.config: - GCP Project: your-project-id

INFO:code_review_assistant.config: - Artifact Bucket: gs://your-project-artifacts

INFO:code_review_assistant.config: - Models: worker=gemini-2.5-flash, critic=gemini-2.5-pro

Testing code analyzer...

INFO:code_review_assistant.tools:Tool: Analysis complete - 2 functions, 1 classes

=== Analyzer Response ===

The analysis of the provided code shows the following:

* **Functions Found:** 2

* `add(a, b)`: A global function at line 2.

* `multiply(self, x, y)`: A method within the `Calculator` class.

* **Classes Found:** 1

* `Calculator`: A class defined at line 5. Contains one method, `multiply`.

* **Imports:** 0

* **Structural Patterns:** The code defines one global function and one class

with a single method. Both are simple, each with a single return statement.

* **Syntax Errors/Issues:** No syntax errors detected.

* **Overall Code Organization:** The code is well-organized for its small size,

clearly defining a function and a class with a method.

מה קרה עכשיו:

- סקריפט הבדיקה טען את ההגדרה של

.envבאופן אוטומטי - הכלי

analyze_code_structure()ניתח את הקוד באמצעות AST של Python - פונקציות העזר

_extract_code_structure()חילצו פונקציות, מחלקות ומדדים - התוצאות אוחסנו במצב הסשן באמצעות קבועי

StateKeys - הסוכן Code Analyzer פירש את התוצאות וסיפק סיכום

פתרון בעיות:

- 'No module named ‘code_review_assistant'': מריצים את

pip install -e .מספריית השורש של הפרויקט - "Missing key inputs argument": מוודאים שלרכיב

.envיש את הערכיםGOOGLE_CLOUD_PROJECT,GOOGLE_CLOUD_LOCATIONו-GOOGLE_GENAI_USE_VERTEXAI=true

מה יצרתם

עכשיו יש לכם כלי לניתוח קוד שמוכן לייצור, ש:

✅ מנתח את ה-AST של Python בפועל – דטרמיניסטי, לא התאמת תבניות

✅ מאחסן את התוצאות במצב – סוכנים אחרים יכולים לגשת לניתוח

✅ פועל באופן אסינכרוני – לא חוסם כלים אחרים

✅ מחלק מידע מקיף – פונקציות, מחלקות, ייבוא, מדדים

✅ מטפל בשגיאות בצורה חלקה – מדווח על שגיאות תחביר עם מספרי שורות

✅ מתחבר לסוכן – מודל ה-LLM יודע מתי ואיך להשתמש בו

מושגים מרכזיים שנלמדו

כלים לעומת סוכנים:

- הכלים מבצעים עבודה דטרמיניסטית (ניתוח AST)

- הסוכנים מחליטים מתי להשתמש בכלים ומפרשים את התוצאות

ערך ההחזרה לעומת מצב:

- החזרה: מה שמודל ה-LLM רואה באופן מיידי

- מצב: מה נשמר עבור סוכנים אחרים

קבועים של מקשי מצב:

- מניעת שגיאות הקלדה במערכות מרובות סוכנים

- משמשים כחוזים בין סוכנים

- חשוב במיוחד כשסוכנים משתפים נתונים

Async + Thread Pools:

async defמאפשרת לכלים להשהות את הביצוע- מאגרי שרשורים מריצים ברקע עבודות שקשורות למעבד

- ביחד הם שומרים על היענות של לולאת האירועים

פונקציות עזר:

- הפרדה בין כלי עזר לסנכרון לבין כלים אסינכרוניים

- מאפשר לבדוק את הקוד ולעשות בו שימוש חוזר

הוראות לסוכן:

- הוראות מפורטות עוזרות למנוע טעויות נפוצות של מודלים גדולים של שפה (LLM)

- הסבר ברור על מה לא לעשות (לא לתקן קוד)

- ניקוי השלבים בתהליך העבודה כדי לשמור על עקביות

המאמרים הבאים

במודול 5, תוכלו להוסיף:

- בודק סגנון שקורא את הקוד מהמצב

- Test runner שמריץ את הבדיקות בפועל

- כלי לסיכום משוב שמשלב את כל הניתוחים

תראו איך המצב זורם דרך צינור רציף, ולמה דפוס הקבועים חשוב כשכמה סוכנים קוראים וכותבים את אותם נתונים.

5. פיתוח צינור עיבוד נתונים: כמה סוכנים שעובדים יחד

מבוא

במודול 4 יצרתם סוכן יחיד שמנתח את מבנה הקוד. אבל כדי לבצע בדיקת קוד מקיפה, צריך יותר מניתוח – צריך לבדוק את הסגנון, להריץ בדיקות ולסנתז משוב חכם.

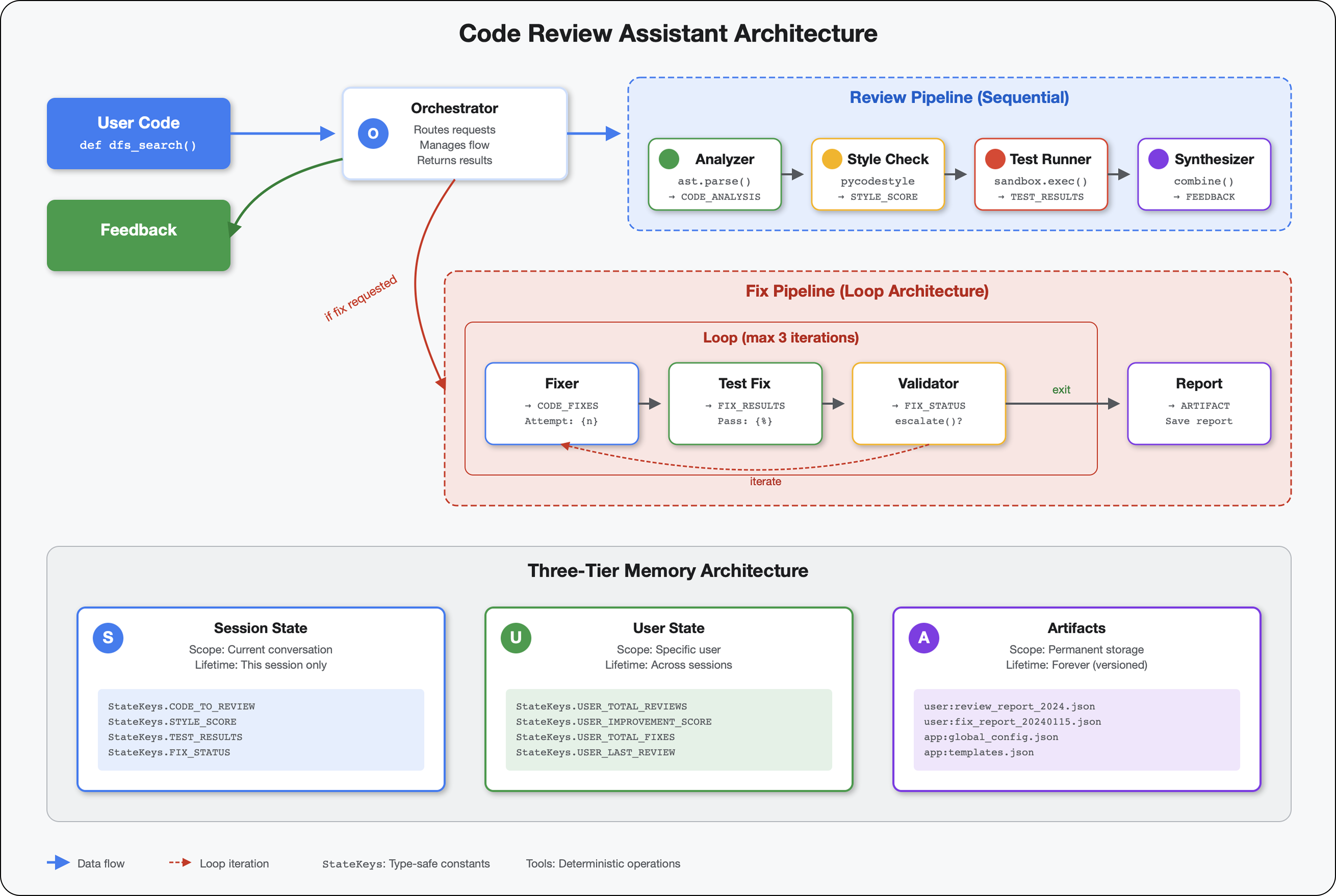

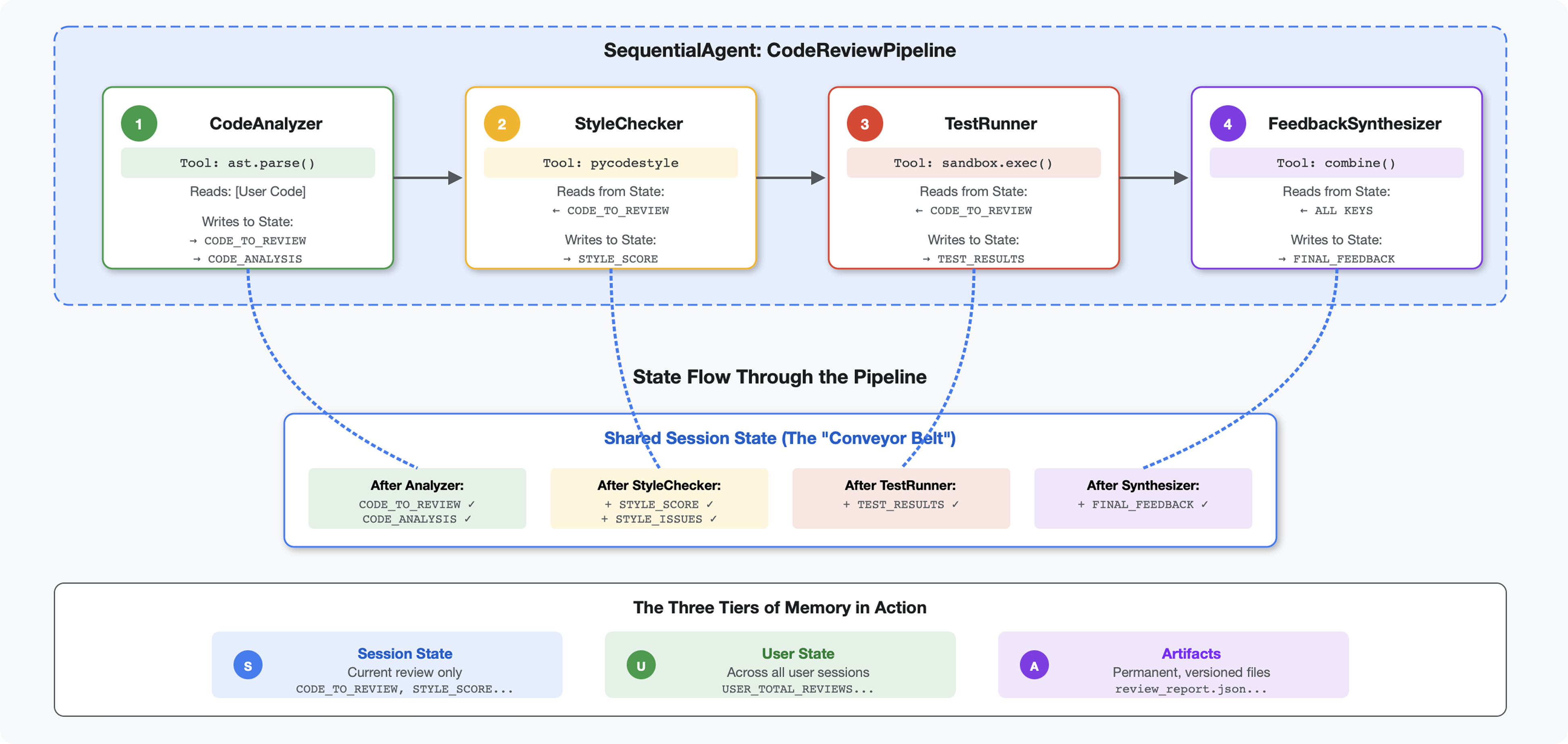

המודול הזה יוצר צינור של 4 סוכנים שפועלים יחד ברצף, וכל אחד מהם תורם ניתוח מיוחד:

- כלי לניתוח קוד (ממודול 4) – מנתח את המבנה

- בודק הסגנון – מזהה הפרות של סגנון

- Test Runner – מריץ ומאמת בדיקות

- Feedback Synthesizer – משלב את כל המידע למשוב שניתן לפעול לפיו

מושג מרכזי: מצב כערוץ תקשורת. כל סוכן קורא את מה שסוכנים קודמים כתבו על המצב, מוסיף ניתוח משלו ומעביר את המצב המועשר לסוכן הבא. הדפוס של הקבועים ממודול 4 הופך לקריטי כשכמה סוכנים משתפים נתונים.

תצוגה מקדימה של מה שתבנו: שליחת קוד מבולגן → צפייה בזרימת המצב דרך 4 סוכנים → קבלת דוח מקיף עם משוב מותאם אישית על סמך דפוסים קודמים.

שלב 1: מוסיפים את הכלי לבדיקת סגנון ואת הסוכן

בודק הסגנון מזהה הפרות של PEP 8 באמצעות pycodestyle – כלי לינטר דטרמיניסטי, לא פרשנות שמבוססת על LLM.

הוספת הכלי לבדיקת סגנון

👉 פתיחה

code_review_assistant/tools.py

👉 Find:

# MODULE_5_STEP_1_STYLE_CHECKER_TOOL

👈 מחליפים את השורה היחידה הזו ב:

async def check_code_style(code: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Checks code style compliance using pycodestyle (PEP 8).

Args:

code: Python source code to check (or will retrieve from state)

tool_context: ADK tool context

Returns:

Dictionary containing style score and issues

"""

logger.info("Tool: Checking code style...")

try:

# Retrieve code from state if not provided

if not code:

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

if not code:

return {

"status": "error",

"message": "No code provided or found in state"

}

# Run style check in thread pool

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

result = await loop.run_in_executor(

executor, _perform_style_check, code

)

# Store results in state

tool_context.state[StateKeys.STYLE_SCORE] = result['score']

tool_context.state[StateKeys.STYLE_ISSUES] = result['issues']

tool_context.state[StateKeys.STYLE_ISSUE_COUNT] = result['issue_count']

logger.info(f"Tool: Style check complete - Score: {result['score']}/100, "

f"Issues: {result['issue_count']}")

return result

except Exception as e:

error_msg = f"Style check failed: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Set default values on error

tool_context.state[StateKeys.STYLE_SCORE] = 0

tool_context.state[StateKeys.STYLE_ISSUES] = []

return {

"status": "error",

"message": error_msg,

"score": 0

}

👉 עכשיו גוללים לסוף הקובץ ומחפשים את השורה:

# MODULE_5_STEP_1_STYLE_HELPERS

👈 מחליפים את השורה היחידה בפונקציות העזר:

def _perform_style_check(code: str) -> Dict[str, Any]:

"""Helper to perform style check in thread pool."""

import io

import sys

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as tmp:

tmp.write(code)

tmp_path = tmp.name

try:

# Capture stdout to get pycodestyle output

old_stdout = sys.stdout

sys.stdout = captured_output = io.StringIO()

style_guide = pycodestyle.StyleGuide(

quiet=False, # We want output

max_line_length=100,

ignore=['E501', 'W503']

)

result = style_guide.check_files([tmp_path])

# Restore stdout

sys.stdout = old_stdout

# Parse captured output

output = captured_output.getvalue()

issues = []

for line in output.strip().split('\n'):

if line and ':' in line:

parts = line.split(':', 4)

if len(parts) >= 4:

try:

issues.append({

'line': int(parts[1]),

'column': int(parts[2]),

'code': parts[3].split()[0] if len(parts) > 3 else 'E000',

'message': parts[3].strip() if len(parts) > 3 else 'Unknown error'

})

except (ValueError, IndexError):

pass

# Add naming convention checks

try:

tree = ast.parse(code)

naming_issues = _check_naming_conventions(tree)

issues.extend(naming_issues)

except SyntaxError:

pass # Syntax errors will be caught elsewhere

# Calculate weighted score

score = _calculate_style_score(issues)

return {

"status": "success",

"score": score,

"issue_count": len(issues),

"issues": issues[:10], # First 10 issues

"summary": f"Style score: {score}/100 with {len(issues)} violations"

}

finally:

if os.path.exists(tmp_path):

os.unlink(tmp_path)

def _check_naming_conventions(tree: ast.AST) -> List[Dict[str, Any]]:

"""Check PEP 8 naming conventions."""

naming_issues = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

# Skip private/protected methods and __main__

if not node.name.startswith('_') and node.name != node.name.lower():

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N802',

'message': f"N802 function name '{node.name}' should be lowercase"

})

elif isinstance(node, ast.ClassDef):

# Check if class name follows CapWords convention

if not node.name[0].isupper() or '_' in node.name:

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N801',

'message': f"N801 class name '{node.name}' should use CapWords convention"

})

return naming_issues

def _calculate_style_score(issues: List[Dict[str, Any]]) -> int:

"""Calculate weighted style score based on violation severity."""

if not issues:

return 100

# Define weights by error type

weights = {

'E1': 10, # Indentation errors

'E2': 3, # Whitespace errors

'E3': 5, # Blank line errors

'E4': 8, # Import errors

'E5': 5, # Line length

'E7': 7, # Statement errors

'E9': 10, # Syntax errors

'W2': 2, # Whitespace warnings

'W3': 2, # Blank line warnings

'W5': 3, # Line break warnings

'N8': 7, # Naming conventions

}

total_deduction = 0

for issue in issues:

code_prefix = issue['code'][:2] if len(issue['code']) >= 2 else 'E2'

weight = weights.get(code_prefix, 3)

total_deduction += weight

# Cap at 100 points deduction

return max(0, 100 - min(total_deduction, 100))

הוספת סוכן לבדיקת סגנון

👉 פתיחה

code_review_assistant/sub_agents/review_pipeline/style_checker.py

👉 Find:

# MODULE_5_STEP_1_INSTRUCTION_PROVIDER

👈 מחליפים את השורה היחידה הזו ב:

async def style_checker_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are a code style expert focused on PEP 8 compliance.

Your task:

1. Use the check_code_style tool to validate PEP 8 compliance

2. The tool will retrieve the ORIGINAL code from state automatically

3. Report violations exactly as found

4. Present the results clearly and confidently

CRITICAL:

- The tool checks the code EXACTLY as provided by the user

- Do not suggest the code was modified or fixed

- Report actual violations found in the original code

- If there are style issues, they should be reported honestly

Call the check_code_style tool with an empty string for the code parameter,

as the tool will retrieve the code from state automatically.

When presenting results based on what the tool returns:

- State the exact score from the tool results

- If score >= 90: "Excellent style compliance!"

- If score 70-89: "Good style with minor improvements needed"

- If score 50-69: "Style needs attention"

- If score < 50: "Significant style improvements needed"

List the specific violations found (the tool will provide these):

- Show line numbers, error codes, and messages

- Focus on the top 10 most important issues

Previous analysis: {structure_analysis_summary}

Format your response as:

## Style Analysis Results

- Style Score: [exact score]/100

- Total Issues: [count]

- Assessment: [your assessment based on score]

## Top Style Issues

[List issues with line numbers and descriptions]

## Recommendations

[Specific fixes for the most critical issues]"""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_5_STEP_1_STYLE_CHECKER_AGENT

👈 מחליפים את השורה היחידה הזו ב:

style_checker_agent = Agent(

name="StyleChecker",

model=config.worker_model,

description="Checks Python code style against PEP 8 guidelines",

instruction=style_checker_instruction_provider,

tools=[FunctionTool(func=check_code_style)],

output_key="style_check_summary"

)

שלב 2: מוסיפים את הסוכן Test Runner

כלי ההרצה של הבדיקות יוצר בדיקות מקיפות ומריץ אותן באמצעות כלי ההרצה המובנה של הקוד.

👉 פתיחה

code_review_assistant/sub_agents/review_pipeline/test_runner.py

👉 Find:

# MODULE_5_STEP_2_INSTRUCTION_PROVIDER

👈 מחליפים את השורה היחידה הזו ב:

async def test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects the code_to_review directly."""

template = """You are a testing specialist who creates and runs tests for Python code.

THE CODE TO TEST IS:

{code_to_review}

YOUR TASK:

1. Understand what the function appears to do based on its name and structure

2. Generate comprehensive tests (15-20 test cases)

3. Execute the tests using your code executor

4. Analyze results to identify bugs vs expected behavior

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Test with the most natural interpretation first

- When something fails, determine if it's a bug or unusual design

- Test edge cases, boundaries, and error scenarios

- Document any surprising behavior

Execute your tests and output ONLY valid JSON with this structure:

- "test_summary": object with "total_tests_run", "tests_passed", "tests_failed", "tests_with_errors", "critical_issues_found"

- "critical_issues": array of objects, each with "type", "description", "example_input", "expected_behavior", "actual_behavior", "severity"

- "test_categories": object with "basic_functionality", "edge_cases", "error_handling" (each containing "passed", "failed", "errors" counts)

- "function_behavior": object with "apparent_purpose", "actual_interface", "unexpected_requirements"

- "verdict": object with "status" (WORKING/BUGGY/BROKEN), "confidence" (high/medium/low), "recommendation"

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_5_STEP_2_TEST_RUNNER_AGENT

👈 מחליפים את השורה היחידה הזו ב:

test_runner_agent = Agent(

name="TestRunner",

model=config.critic_model,

description="Generates and runs tests for Python code using safe code execution",

instruction=test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="test_execution_summary"

)

שלב 3: הסבר על הזיכרון ללמידה בין סשנים

לפני שיוצרים את הכלי לסינתזת משוב, צריך להבין את ההבדל בין מצב לבין זיכרון – שני מנגנוני אחסון שונים למטרות שונות.

מצב לעומת זיכרון: ההבדל העיקרי

כדי להבהיר את העניין, נשתמש בדוגמה קונקרטית מביקורת קוד:

מדינה (במהלך הסשן הנוכחי בלבד):

# Data from THIS review session

tool_context.state[StateKeys.STYLE_ISSUES] = [

{"line": 5, "code": "E231", "message": "missing whitespace"},

{"line": 12, "code": "E701", "message": "multiple statements"}

]

- היקף: השיחה הזו בלבד

- המטרה: העברת נתונים בין סוכנים בצינור הנוכחי

- אובייקט 'מקום מגורים נוכחי':

Session - משך החיים: נמחק בסיום הסשן

זיכרון (כל הסשנים הקודמים):

# Learned from 50 previous reviews

"User frequently forgets docstrings on helper functions"

"User tends to write long functions (avg 45 lines)"

"User improved error handling after feedback in session #23"

- היקף: כל הסשנים הקודמים של המשתמש הזה

- מטרה: ללמוד דפוסים, לספק משוב בהתאמה אישית

- מקום מגורים נוכחי:

MemoryService - במהלך כל משך החיים: נשמר בין סשנים, ניתן לחיפוש

למה המשוב צריך לכלול את שני הדברים:

דמיינו את הסינתיסייזר יוצר משוב:

שימוש רק בסטטוס (בדיקה נוכחית):

"Function `calculate_total` has no docstring."

משוב כללי ומכני.

שימוש במצב + זיכרון (דפוסים נוכחיים + קודמים):

"Function `calculate_total` has no docstring. This is the 4th review

where helper functions lacked documentation. Consider adding docstrings

as you write functions, not afterwards - you mentioned in our last

session that you find it easier that way."

ההפניות בהתאמה אישית ובהקשר משתפרות עם הזמן.

לפריסות בסביבת הייצור, יש אפשרויות:

אפשרות 1: VertexAiMemoryBankService (מתקדם)

- מה זה עושה: חילוץ עובדות משמעותיות משיחות באמצעות LLM

- חיפוש: חיפוש סמנטי (מבין את המשמעות, לא רק מילות מפתח)

- ניהול זיכרון: איחוד ועדכון אוטומטי של הזיכרונות לאורך זמן

- נדרש: פרויקט ב-Google Cloud + הגדרה של Agent Engine

- מתי כדאי להשתמש: כשרוצים זיכרונות מותאמים אישית, מורכבים ומתפתחים

- דוגמה: "המשתמש מעדיף תכנות פונקציונלי" (נלקח מ-10 שיחות על סגנון קוד)

אפשרות 2: המשך השימוש ב-InMemoryMemoryService + Persistent Sessions

- מה היא עושה: שומרת את היסטוריית השיחות המלאה לחיפוש מילות מפתח

- חיפוש: התאמה בסיסית של מילות מפתח בסשנים קודמים

- ניהול הזיכרון: אתם שולטים במה שמאוחסן (באמצעות

add_session_to_memory) - נדרש: רק

SessionServiceקבוע (כמוVertexAiSessionServiceאוDatabaseSessionService) - מתי כדאי להשתמש: כשצריך לבצע חיפוש פשוט בשיחות קודמות בלי עיבוד LLM

- דוגמה: חיפוש של docstring יחזיר את כל הסשנים שבהם המילה הזו מוזכרת.

איך הזיכרון מתמלא

אחרי שכל בדיקת קוד מסתיימת:

# At the end of a session (typically in your application code)

await memory_service.add_session_to_memory(session)

מה קורה:

- InMemoryMemoryService: מאחסן את כל אירועי הסשן לחיפוש מילות מפתח

- VertexAiMemoryBankService: מודל LLM מחלץ עובדות מרכזיות ומאחד אותן עם זיכרונות קיימים

בסשנים עתידיים אפשר יהיה להריץ שאילתות:

# In a tool, search for relevant past feedback

results = tool_context.search_memory("feedback about docstrings")

שלב 4: הוספת כלי סינתזת משוב וסוכן

הסוכן המתוחכם ביותר בצינור העיבוד הוא סינתזת המשוב. הוא מתזמן שלושה כלים, משתמש בהוראות דינמיות ומשלב מצב, זיכרון וארטיפקטים.

הוספה של שלושת הכלים לסינתזה

👉 פתיחה

code_review_assistant/tools.py

👉 Find:

# MODULE_5_STEP_4_SEARCH_PAST_FEEDBACK

👈 Replace with Tool 1 - Memory Search (production version):

async def search_past_feedback(developer_id: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Search for past feedback in memory service.

Args:

developer_id: ID of the developer (defaults to "default_user")

tool_context: ADK tool context with potential memory service access

Returns:

Dictionary containing feedback search results

"""

logger.info(f"Tool: Searching for past feedback for developer {developer_id}...")

try:

# Default developer ID if not provided

if not developer_id:

developer_id = tool_context.state.get(StateKeys.USER_ID, 'default_user')

# Check if memory service is available

if hasattr(tool_context, 'search_memory'):

try:

# Perform structured searches

queries = [

f"developer:{developer_id} code review feedback",

f"developer:{developer_id} common issues",

f"developer:{developer_id} improvements"

]

all_feedback = []

patterns = {

'common_issues': [],

'improvements': [],

'strengths': []

}

for query in queries:

search_result = await tool_context.search_memory(query)

if search_result and hasattr(search_result, 'memories'):

for memory in search_result.memories[:5]:

memory_text = memory.text if hasattr(memory, 'text') else str(memory)

all_feedback.append(memory_text)

# Extract patterns

if 'style' in memory_text.lower():

patterns['common_issues'].append('style compliance')

if 'improved' in memory_text.lower():

patterns['improvements'].append('showing improvement')

if 'excellent' in memory_text.lower():

patterns['strengths'].append('consistent quality')

# Store in state

tool_context.state[StateKeys.PAST_FEEDBACK] = all_feedback

tool_context.state[StateKeys.FEEDBACK_PATTERNS] = patterns

logger.info(f"Tool: Found {len(all_feedback)} past feedback items")

return {

"status": "success",

"feedback_found": True,

"count": len(all_feedback),

"summary": " | ".join(all_feedback[:3]) if all_feedback else "No feedback",

"patterns": patterns

}

except Exception as e:

logger.warning(f"Tool: Memory search error: {e}")

# Fallback: Check state for cached feedback

cached_feedback = tool_context.state.get(StateKeys.USER_PAST_FEEDBACK_CACHE, [])

if cached_feedback:

tool_context.state[StateKeys.PAST_FEEDBACK] = cached_feedback

return {

"status": "success",

"feedback_found": True,

"count": len(cached_feedback),

"summary": "Using cached feedback",

"patterns": {}

}

# No feedback found

tool_context.state[StateKeys.PAST_FEEDBACK] = []

logger.info("Tool: No past feedback found")

return {

"status": "success",

"feedback_found": False,

"message": "No past feedback available - this appears to be a first submission",

"patterns": {}

}

except Exception as e:

error_msg = f"Feedback search error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

tool_context.state[StateKeys.PAST_FEEDBACK] = []

return {

"status": "error",

"message": error_msg,

"feedback_found": False

}

👉 Find:

# MODULE_5_STEP_4_UPDATE_GRADING_PROGRESS

👈 החלפה בכלי 2 – כלי למעקב אחר ציונים (גרסת ייצור):

async def update_grading_progress(tool_context: ToolContext) -> Dict[str, Any]:

"""

Updates grading progress counters and metrics in state.

"""

logger.info("Tool: Updating grading progress...")

try:

current_time = datetime.now().isoformat()

# Build all state changes

state_updates = {}

# Temporary (invocation-level) state

state_updates[StateKeys.TEMP_PROCESSING_TIMESTAMP] = current_time

# Session-level state

attempts = tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 0) + 1

state_updates[StateKeys.GRADING_ATTEMPTS] = attempts

state_updates[StateKeys.LAST_GRADING_TIME] = current_time

# User-level persistent state

lifetime_submissions = tool_context.state.get(StateKeys.USER_TOTAL_SUBMISSIONS, 0) + 1

state_updates[StateKeys.USER_TOTAL_SUBMISSIONS] = lifetime_submissions

state_updates[StateKeys.USER_LAST_SUBMISSION_TIME] = current_time

# Calculate improvement metrics

current_style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

last_style_score = tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

score_improvement = current_style_score - last_style_score

state_updates[StateKeys.USER_LAST_STYLE_SCORE] = current_style_score

state_updates[StateKeys.SCORE_IMPROVEMENT] = score_improvement

# Track test results if available

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

if test_results and test_results.get('test_summary', {}).get('total_tests_run', 0) > 0:

summary = test_results['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

pass_rate = (passed / total) * 100

state_updates[StateKeys.USER_LAST_TEST_PASS_RATE] = pass_rate

# Apply all updates atomically

for key, value in state_updates.items():

tool_context.state[key] = value

logger.info(f"Tool: Progress updated - Attempt #{attempts}, "

f"Lifetime: {lifetime_submissions}")

return {

"status": "success",

"session_attempts": attempts,

"lifetime_submissions": lifetime_submissions,

"timestamp": current_time,

"improvement": {

"style_score_change": score_improvement,

"direction": "improved" if score_improvement > 0 else "declined"

},

"summary": f"Attempt #{attempts} recorded, {lifetime_submissions} total submissions"

}

except Exception as e:

error_msg = f"Progress update error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

return {

"status": "error",

"message": error_msg

}

👉 Find:

# MODULE_5_STEP_4_SAVE_GRADING_REPORT

👉 Replace with Tool 3 - Artifact Saver (production version):

async def save_grading_report(feedback_text: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Saves a detailed grading report as an artifact.

Args:

feedback_text: The feedback text to include in the report

tool_context: ADK tool context for state management

Returns:

Dictionary containing save status and details

"""

logger.info("Tool: Saving grading report...")

try:

# Gather all relevant data from state

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

analysis = tool_context.state.get(StateKeys.CODE_ANALYSIS, {})

style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

style_issues = tool_context.state.get(StateKeys.STYLE_ISSUES, [])

# Get test results

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

timestamp = datetime.now().isoformat()

# Create comprehensive report dictionary

report = {

'timestamp': timestamp,

'grading_attempt': tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 1),

'code': {

'content': code,

'line_count': len(code.splitlines()),

'hash': hashlib.md5(code.encode()).hexdigest()

},

'analysis': analysis,

'style': {

'score': style_score,

'issues': style_issues[:5] # First 5 issues

},

'tests': test_results,

'feedback': feedback_text,

'improvements': {

'score_change': tool_context.state.get(StateKeys.SCORE_IMPROVEMENT, 0),

'from_last_score': tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

}

}

# Convert report to JSON string

report_json = json.dumps(report, indent=2)

report_part = types.Part.from_text(text=report_json)

# Try to save as artifact if the service is available

if hasattr(tool_context, 'save_artifact'):

try:

# Generate filename with timestamp (replace colons for filesystem compatibility)

filename = f"grading_report_{timestamp.replace(':', '-')}.json"

# Save the main report

version = await tool_context.save_artifact(filename, report_part)

# Also save a "latest" version for easy access

await tool_context.save_artifact("latest_grading_report.json", report_part)

logger.info(f"Tool: Report saved as {filename} (version {version})")

# Store report in state as well for redundancy

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

return {

"status": "success",

"artifact_saved": True,

"filename": filename,

"version": str(version),

"size": len(report_json),

"summary": f"Report saved as {filename}"

}

except Exception as artifact_error:

logger.warning(f"Artifact service error: {artifact_error}, falling back to state storage")

# Continue to fallback below

# Fallback: Store in state if artifact service is not available or failed

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

logger.info("Tool: Report saved to state (artifact service not available)")

return {

"status": "success",

"artifact_saved": False,

"message": "Report saved to state only",

"size": len(report_json),

"summary": "Report saved to session state"

}

except Exception as e:

error_msg = f"Report save error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Still try to save minimal data to state

try:

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = {

'error': error_msg,

'feedback': feedback_text,

'timestamp': datetime.now().isoformat()

}

except:

pass

return {

"status": "error",

"message": error_msg,

"artifact_saved": False,

"summary": f"Failed to save report: {error_msg}"

}

יצירת נציג סינתזה

👉 פתיחה

code_review_assistant/sub_agents/review_pipeline/feedback_synthesizer.py

👉 Find:

# MODULE_5_STEP_4_INSTRUCTION_PROVIDER

👉 מחליפים את הטקסט הזה בשם של ספק הוראות הייצור:

async def feedback_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code reviewer and mentor providing constructive, educational feedback.

CONTEXT FROM PREVIOUS AGENTS:

- Structure analysis summary: {structure_analysis_summary}

- Style check summary: {style_check_summary}

- Test execution summary: {test_execution_summary}

YOUR TASK requires these steps IN ORDER:

1. Call search_past_feedback tool with developer_id="default_user"

2. Call update_grading_progress tool with no parameters

3. Carefully analyze the test results to understand what really happened

4. Generate comprehensive feedback following the structure below

5. Call save_grading_report tool with the feedback_text parameter

6. Return the feedback as your final output

CRITICAL - Understanding Test Results:

The test_execution_summary contains structured JSON. Parse it carefully:

- tests_passed = Code worked correctly

- tests_failed = Code produced wrong output

- tests_with_errors = Code crashed

- critical_issues = Fundamental problems with the code

If critical_issues array contains items, these are serious bugs that need fixing.

Do NOT count discovering bugs as test successes.

FEEDBACK STRUCTURE TO FOLLOW:

## 📊 Summary

Provide an honest assessment. Be encouraging but truthful about problems found.

## ✅ Strengths

List 2-3 things done well, referencing specific code elements.

## 📈 Code Quality Analysis

### Structure & Organization

Comment on code organization, readability, and documentation.

### Style Compliance

Report the actual style score and any specific issues.

### Test Results

Report the actual test results accurately:

- If critical_issues exist, report them as bugs to fix

- Be clear: "X tests passed, Y critical issues were found"

- List each critical issue

- Don't hide or minimize problems

## 💡 Recommendations for Improvement

Based on the analysis, provide specific actionable fixes.

If critical issues exist, fixing them is top priority.

## 🎯 Next Steps

Prioritized action list based on severity of issues.

## 💬 Encouragement

End with encouragement while being honest about what needs fixing.

Remember: Complete ALL steps including calling save_grading_report."""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_5_STEP_4_SYNTHESIZER_AGENT

👉 Replace with:

feedback_synthesizer_agent = Agent(

name="FeedbackSynthesizer",

model=config.critic_model,

description="Synthesizes all analysis into constructive, personalized feedback",

instruction=feedback_instruction_provider,

tools=[

FunctionTool(func=search_past_feedback),

FunctionTool(func=update_grading_progress),

FunctionTool(func=save_grading_report)

],

output_key="final_feedback"

)

שלב 5: חיבור הצינור

עכשיו מחברים את כל ארבעת הסוכנים לצינור רציף ויוצרים את סוכן הבסיס.

👈 פתיחת

code_review_assistant/agent.py

👈 מוסיפים את הייבוא הנדרש בחלק העליון של הקובץ (אחרי הייבוא הקיים):

from google.adk.agents import Agent, SequentialAgent

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

הקובץ אמור להיראות כך:

"""

Main agent orchestration for the Code Review Assistant.

"""

from google.adk.agents import Agent, SequentialAgent

from .config import config

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

# MODULE_5_STEP_5_CREATE_PIPELINE

# MODULE_6_STEP_5_CREATE_FIX_LOOP

# MODULE_6_STEP_5_UPDATE_ROOT_AGENT

👉 חיפוש:

# MODULE_5_STEP_5_CREATE_PIPELINE

👈 מחליפים את השורה היחידה הזו בשורה הבאה:

# Create sequential pipeline

code_review_pipeline = SequentialAgent(

name="CodeReviewPipeline",

description="Complete code review pipeline with analysis, testing, and feedback",

sub_agents=[

code_analyzer_agent,

style_checker_agent,

test_runner_agent,

feedback_synthesizer_agent

]

)

# Root agent - coordinates the review pipeline

root_agent = Agent(

name="CodeReviewAssistant",

model=config.worker_model,

description="An intelligent code review assistant that analyzes Python code and provides educational feedback",

instruction="""You are a specialized Python code review assistant focused on helping developers improve their code quality.

When a user provides Python code for review:

1. Immediately delegate to CodeReviewPipeline and pass the code EXACTLY as it was provided by the user.

2. The pipeline will handle all analysis and feedback

3. Return ONLY the final feedback from the pipeline - do not add any commentary

When a user asks what you can do or asks general questions:

- Explain your capabilities for code review

- Do NOT trigger the pipeline for non-code messages

The pipeline handles everything for code review - just pass through its final output.""",

sub_agents=[code_review_pipeline],

output_key="assistant_response"

)

שלב 6: בדיקת צינור העברת הנתונים

הגיע הזמן לראות את ארבעת הסוכנים עובדים יחד.

👈 הפעלת המערכת:

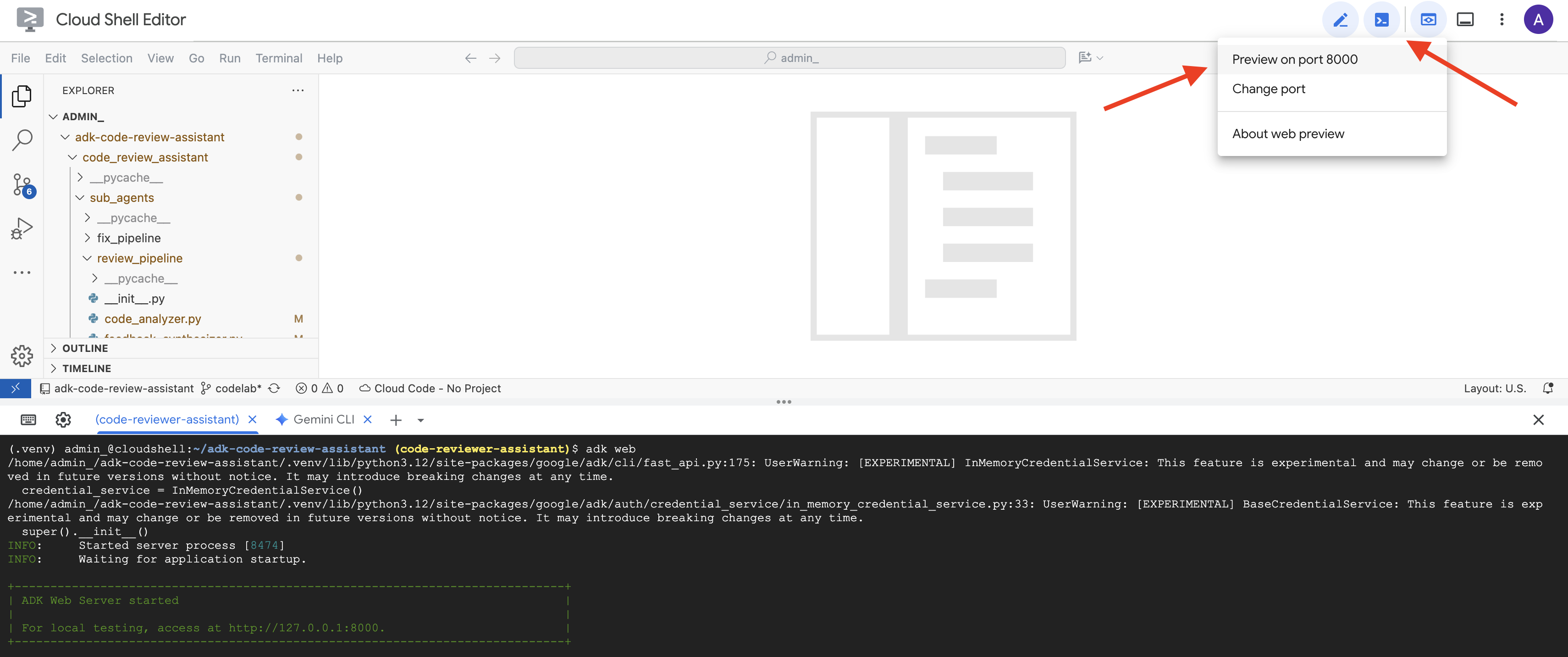

adk web code_review_assistant

אחרי שמריצים את הפקודה adk web, אמור להופיע פלט במסוף שמציין שהשרת של ADK Web התחיל לפעול, בדומה לזה:

+-----------------------------------------------------------------------------+

| ADK Web Server started |

| |

| For local testing, access at http://localhost:8000. |

+-----------------------------------------------------------------------------+

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

👈 כדי לגשת לממשק המשתמש של ADK Dev מהדפדפן:

בסרגל הכלים של Cloud Shell (בדרך כלל בפינה השמאלית העליונה), לוחצים על סמל התצוגה המקדימה בדפדפן (לרוב נראה כמו עין או ריבוע עם חץ) ובוחרים באפשרות 'שינוי יציאה'. בחלון הקופץ, מגדירים את היציאה ל-8000 ולוחצים על 'שינוי ותצוגה מקדימה'. לאחר מכן, ייפתחו ב-Cloud Shell כרטיסייה או חלון חדשים בדפדפן עם ממשק המשתמש של ADK Dev.

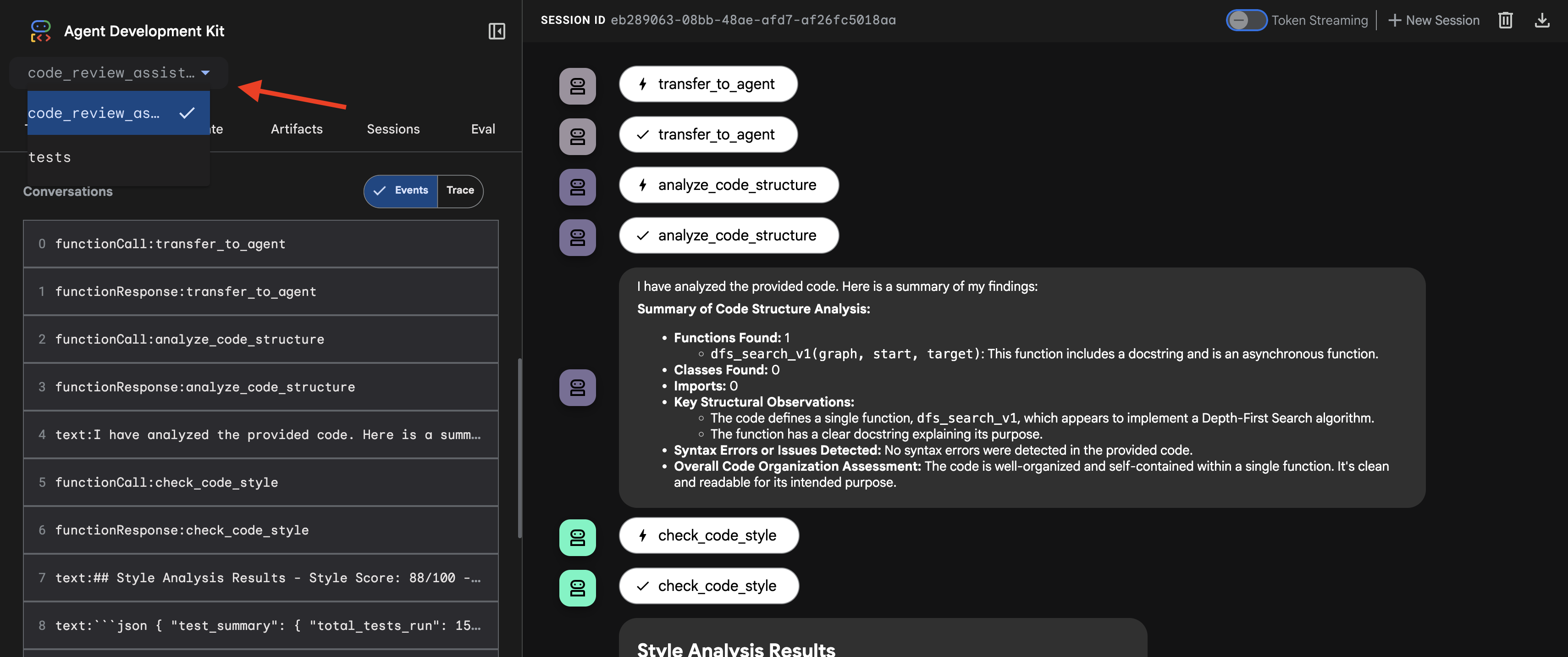

👈 הסוכן פועל עכשיו. ממשק המשתמש של ADK Dev בדפדפן הוא החיבור הישיר שלכם לסוכן.

- בוחרים את היעד: בתפריט הנפתח בחלק העליון של ממשק המשתמש, בוחרים את סוכן

code_review_assistant.

👉 Test Prompt:

Please analyze the following:

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

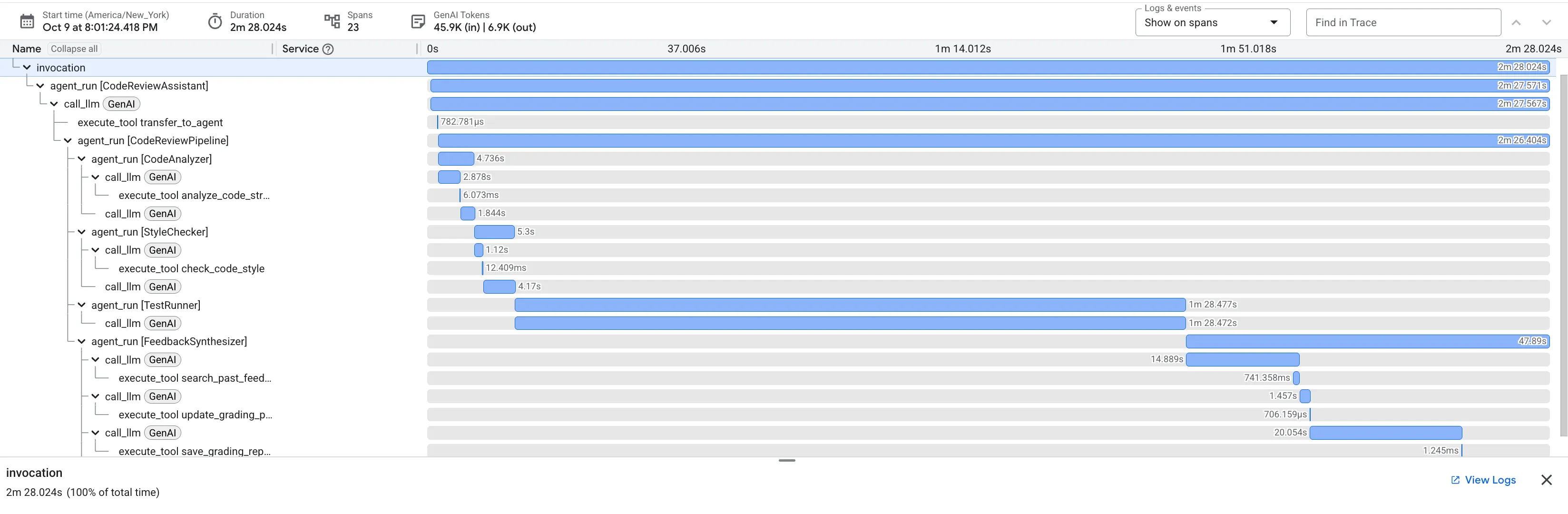

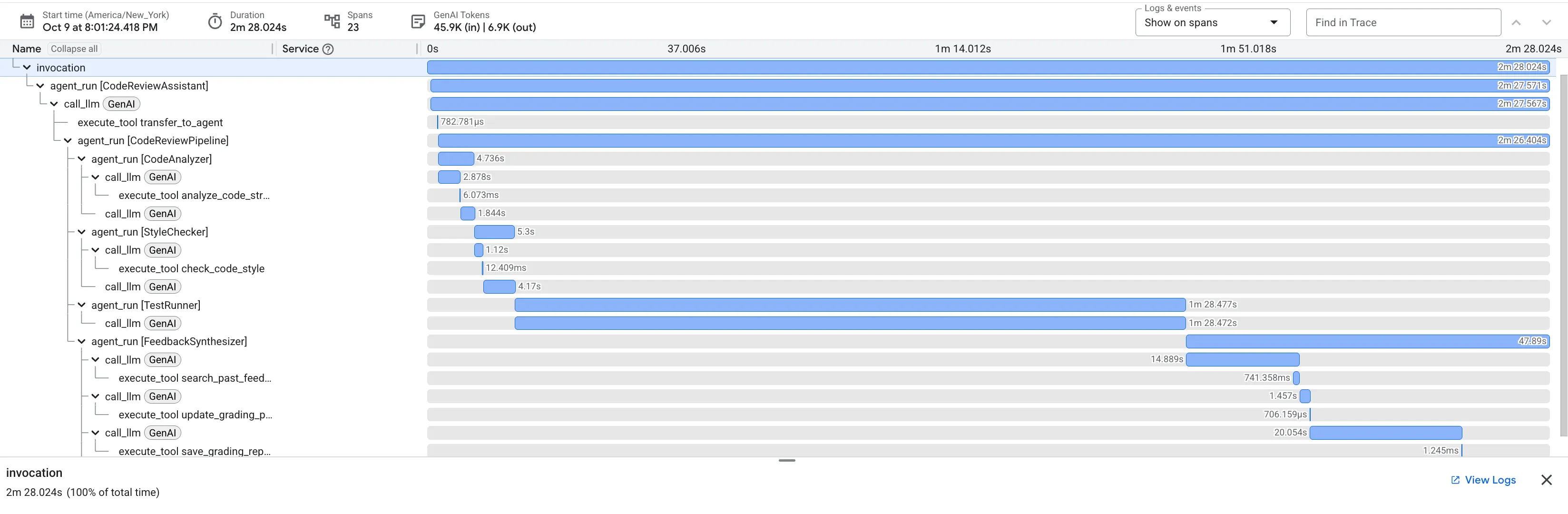

👈 כך נראה צינור לבדיקת קוד בפעולה:

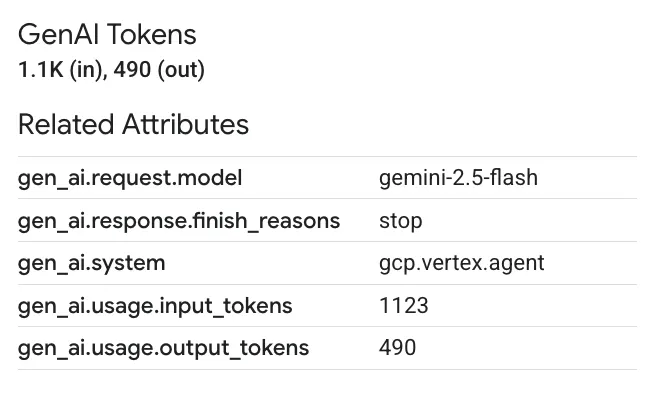

כששולחים את הפונקציה dfs_search_v1 עם הבאג, לא מקבלים רק תשובה אחת. אתם רואים את צינור העיבוד של כמה סוכנים בפעולה. הפלט של הסטרימינג שאתם רואים הוא התוצאה של ארבעה סוכנים מומחים שפועלים ברצף, כשכל אחד מהם מתבסס על הקודם.

הנה פירוט של התרומה של כל סוכן לסקירה המקיפה הסופית, והפיכת נתונים גולמיים למידע שימושי.

1. דוח המבנה של כלי ניתוח הקוד

קודם כל, סוכן CodeAnalyzer מקבל את הקוד הגולמי. הוא לא מנחש מה הקוד עושה, אלא משתמש בכלי analyze_code_structure כדי לבצע ניתוח דטרמיניסטי של עץ תחביר מופשט (AST).

הפלט שלו הוא נתונים טהורים ועובדתיים על מבנה הקוד:

The analysis of the provided code reveals the following:

Summary:

- Functions Found: 1

- Classes Found: 0

Key Structural Observations:

- A single function, dfs_search_v1, is defined.

- It includes a docstring: "Find if target is reachable from start."

- No syntax errors were detected.

Overall Code Organization Assessment:

- The code snippet is a well-defined, self-contained function.

⭐ ערך: השלב הראשוני הזה מספק בסיס נקי ומהימן לסוכנים האחרים. הוא מאשר שהקוד הוא קוד Python תקין ומזהה את הרכיבים המדויקים שצריך לבדוק.

2. ביקורת PEP 8 של בודק הסגנון

לאחר מכן, נציג/ת התמיכה של StyleChecker משתלט/ת על המסך. הוא קורא את הקוד מהמצב המשותף ומשתמש בכלי check_code_style, שמסתמך על pycodestyle linter.

הפלט של הכלי הוא ציון איכות כמותי והפרות ספציפיות:

Style Analysis Results

- Style Score: 88/100

- Total Issues: 6

- Assessment: Good style with minor improvements needed

Top Style Issues

- Line 5, W293: blank line contains whitespace

- Line 19, W292: no newline at end of file

⭐ ערך: הסוכן הזה מספק משוב אובייקטיבי שלא ניתן לשינוי, על סמך סטנדרטים קהילתיים מבוססים (PEP 8). מערכת הניקוד המשוקלל מאפשרת למשתמש לדעת באופן מיידי את חומרת הבעיות.

3. גילוי באגים קריטיים באמצעות הכלי להרצת בדיקות

כאן המערכת מבצעת ניתוח מעמיק יותר. הנציג TestRunner יוצר ומריץ חבילה מקיפה של בדיקות כדי לאמת את ההתנהגות של הקוד.

הפלט הוא אובייקט JSON מובנה שמכיל פסק דין חמור:

{

"critical_issues": [

{

"type": "Critical Bug",

"description": "The function's initialization `stack = start` is incorrect... When a common input like a string... is provided... the function crashes with an AttributeError.",

"severity": "Critical"

}

],

"verdict": {

"status": "BROKEN",

"confidence": "high",

"recommendation": "The function is fundamentally broken... the stack initialization line `stack = start` must be changed to `stack = [start]`."

}

}

⭐ Value: זהו התובנה החשובה ביותר. הסוכן לא ניחש את הקוד, אלא הוכיח שהקוד שבור על ידי הפעלתו. הוא חשף באג קל אבל קריטי בזמן הריצה, שבודק אנושי עלול לפספס בקלות, וזיהה את הסיבה המדויקת ואת התיקון הנדרש.

4. הדוח הסופי של כלי סיכום המשוב

לבסוף, סוכן FeedbackSynthesizer פועל כמנצח. הוא לוקח את הנתונים המובנים משלושת הסוכנים הקודמים ויוצר דוח אחד ידידותי למשתמש, שהוא גם אנליטי וגם מעודד.

הפלט שלו הוא הביקורת הסופית והמלוטשת שאתם רואים:

📊 Summary

Great effort on implementing the Depth-First Search algorithm! ... However, a critical bug in the initialization of the stack prevents the function from working correctly...

✅ Strengths

- Good Algorithm Structure

- Correct Use of `visited` Set

📈 Code Quality Analysis

...

### Style Compliance

The style analysis returned a good score of 88/100.

...

### Test Results

The automated testing revealed a critical issue... The line `stack = start` directly assigns the input... which results in an `AttributeError`.

💡 Recommendations for Improvement

**Fix the Critical Stack Initialization Bug:**

- Incorrect Code: `stack = start`

- Correct Code: `stack = [start]`

💬 Encouragement

You are very close to a perfect implementation! The core logic of your DFS algorithm is sound, which is the hardest part.

⭐ ערך: הסוכן הזה הופך נתונים טכניים לחוויה מועילה וחינוכית. הוא מתעדף את הבעיה הכי חשובה (הבאג), מסביר אותה בצורה ברורה, מספק את הפתרון המדויק ועושה את זה בנימה מעודדת. היא משלבת בהצלחה את הממצאים מכל השלבים הקודמים ליחידה מגובשת ובעלת ערך.

התהליך הרב-שלבי הזה מדגים את היכולות של צינור עיבוד נתונים מבוסס-סוכן. במקום לקבל תשובה אחת מונוליטית, מקבלים ניתוח בשכבות שבו כל סוכן מבצע משימה מיוחדת שניתנת לאימות. כך מתקבלת ביקורת שהיא לא רק מעמיקה, אלא גם דטרמיניסטית, מהימנה ובעלת ערך חינוכי רב.

👈💻 אחרי שמסיימים את הבדיקה, חוזרים לטרמינל של Cloud Shell Editor ומקישים על Ctrl+C כדי להפסיק את ממשק המשתמש של ADK Dev.

מה יצרתם

עכשיו יש לכם צינור לבדיקת קוד מלא שכולל:

✅ ניתוח מבנה הקוד – ניתוח AST דטרמיניסטי עם פונקציות עזר

✅ בדיקת הסגנון – ניקוד משוקלל עם מוסכמות שמות

✅ הרצת בדיקות – יצירת בדיקות מקיפה עם פלט JSON מובנה

✅ סינתוז משוב – שילוב של מצב + זיכרון + ארטיפקטים

✅ מעקב אחר ההתקדמות – מצב רב-שכבתי על פני הפעלות/סשנים/משתמשים

✅ למידה לאורך זמן – שירות זיכרון לדפוסים חוצי-סשנים

✅ אספקת ארטיפקטים – דוחות JSON להורדה עם נתיב ביקורת מלא

מושגים מרכזיים שנלמדו

צינורות עיבוד נתונים רציפים:

- ארבעה סוכנים שפועלים בסדר קפדני

- כל אחד משפר את המצב של הבא

- יחסי התלות קובעים את רצף הביצוע

דפוסי ייצור:

- הפרדה של פונקציות עזר (סנכרון במאגרי שרשורים)

- התדרדרות הדרגתית (אסטרטגיות חלופיות)

- ניהול מצב רב-שכבתי (זמני/סשן/משתמש)

- ספקי הוראות דינמיים (מבוססי-הקשר)

- אחסון כפול (חפצים + יתירות של מצב)

State as Communication:

- קבועים מונעים שגיאות הקלדה בסוכנים

-

output_keyכותב סיכומים של סוכנים למצב - סוכנים מאוחרים יותר קוראים באמצעות StateKeys

- הנתונים עוברים באופן לינארי דרך צינור עיבוד הנתונים

זיכרון לעומת מצב:

- מצב: נתוני הסשן הנוכחי

- זיכרון: דפוסים בסשנים

- מטרות שונות, משך חיים שונה

תיאום בין כלים:

- סוכנים עם כלי אחד (analyzer, style_checker)

- מפעילים מובנים (test_runner)

- תיאום בין כמה כלים (סינתיסייזר)

שיטת בחירת מודל:

- מודל Worker: משימות מכניות (ניתוח, בדיקה, ניתוב)

- מודל ביקורת: משימות של נימוקים (בדיקה, סינתזה)

- אופטימיזציה של עלויות באמצעות בחירה מתאימה

המאמרים הבאים

במודול 6, תיצרו את צינור התיקון:

- ארכיטקטורת LoopAgent לתיקונים איטרטיביים

- תנאי יציאה באמצעות העברה לטיפול ברמה גבוהה יותר

- צבירת מצב בין איטרציות

- אימות ולוגיקה לניסיון חוזר

- שילוב עם צינור הבדיקה כדי להציע תיקונים

תוכלו לראות איך אותם דפוסי מצב ניתנים להרחבה לתהליכי עבודה מורכבים שחוזרים על עצמם, שבהם נציגים מנסים כמה פעמים עד שהם מצליחים, ואיך מתבצעת תיאום בין כמה צינורות באפליקציה אחת.

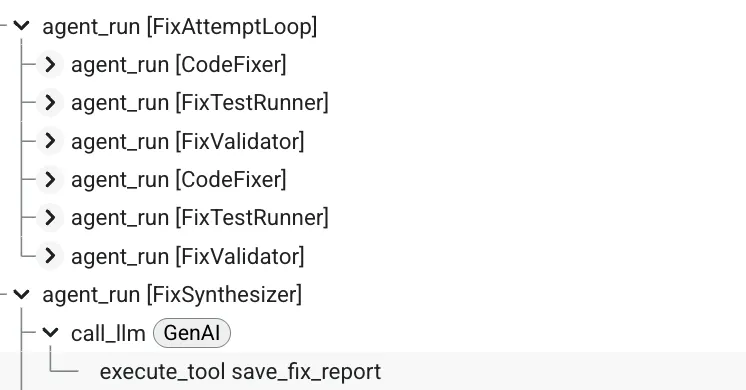

6. הוספת צינור התיקון: ארכיטקטורת לולאה

מבוא

במודול 5 יצרתם צינור עיבוד נתונים לבדיקה רציפה שמנתח קוד ומספק משוב. אבל זיהוי בעיות הוא רק חצי מהפתרון – מפתחים צריכים עזרה בתיקון שלהן.

במודול הזה נבנה צינור אוטומטי לתיקון שכולל את הפעולות הבאות:

- יצירת תיקונים על סמך תוצאות הבדיקה

- אימות התיקונים על ידי הרצת בדיקות מקיפות

- מנסה שוב באופן אוטומטי אם התיקונים לא עובדים (עד 3 ניסיונות)

- תוצאות הדוחות עם השוואות לפני ואחרי

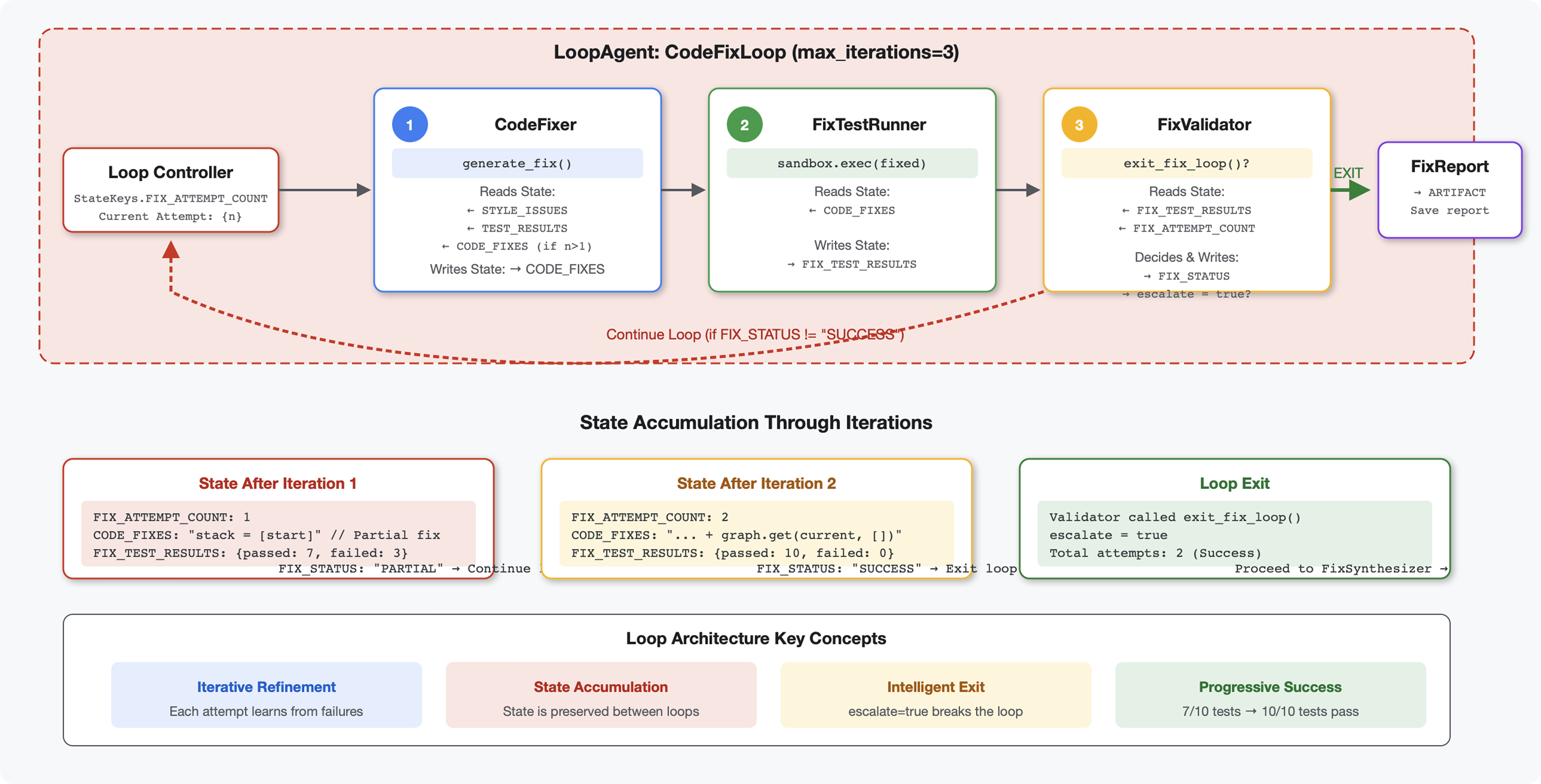

מושג מרכזי: LoopAgent לניסיון חוזר אוטומטי. בניגוד לסוכנים רציפים שפועלים פעם אחת, סוכן LoopAgent חוזר על פעולת הסוכנים המשניים שלו עד שמתקיים תנאי יציאה או עד שמגיעים למספר המקסימלי של איטרציות. הכלי מסמן הצלחה בהגדרת tool_context.actions.escalate = True.

תצוגה מקדימה של מה שתבנו: שליחת קוד עם באגים ← בדיקה מזהה בעיות ← תיקון בלולאה יוצר תיקונים ← בדיקות מאמתות ← ניסיונות חוזרים אם צריך ← דוח מקיף סופי.

מושגי ליבה: LoopAgent לעומת Sequential

Sequential Pipeline (Module 5):

SequentialAgent(agents=[A, B, C])

# Executes: A → B → C → Done

- זרימה חד-כיוונית

- כל סוכן מופעל בדיוק פעם אחת

- ללא לוגיקה לניסיון נוסף

Loop Pipeline (Module 6):

LoopAgent(agents=[A, B, C], max_iterations=3)

# Executes: A → B → C → (check exit) → A → B → C → (check exit) → ...

- זרימה מחזורית

- סוכנים יכולים לפעול כמה פעמים

- יציאה כשהתנאי הבא מתקיים:

- כלי מגדיר את

tool_context.actions.escalate = True(הצלחה) max_iterations(מגבלת בטיחות)- מתרחשת חריגה לא מטופלת (שגיאה)

- כלי מגדיר את

למה כדאי להשתמש בלולאות לתיקון קוד:

לעתים קרובות צריך לנסות כמה פעמים לתקן את הקוד:

- ניסיון ראשון: תיקון באגים ברורים (סוגי משתנים שגויים)

- ניסיון שני: תיקון בעיות משניות שהתגלו בבדיקות (מקרים חריגים)

- ניסיון שלישי: מבצעים התאמות עדינות ומוודאים שכל הבדיקות עוברות

בלי לולאה, תצטרכו להשתמש בלוגיקה מורכבת של תנאים בהוראות לסוכן. ב-LoopAgent, הניסיון החוזר הוא אוטומטי.

השוואה בין ארכיטקטורות:

Sequential (Module 5):

User → Review Pipeline → Feedback → Done

Loop (Module 6):

User → Review Pipeline → Feedback → Fix Pipeline

↓

┌──────────────┴──────────────┐

│ Fix Attempt Loop (1-3x) │

│ ┌─────────────────────┐ │

│ │ 1. Generate Fixes │ │

│ │ 2. Test Fixes │ │

│ │ 3. Validate & Exit? │────┼─→ If escalate=True

│ └─────────────────────┘ │ exit loop

│ ↓ If not │

│ Try Again (max 3) │

└─────────────────────────────┘

↓

4. Synthesize Final Report → Done

שלב 1: מוסיפים את הסוכן Code Fixer

כלי לתיקון קוד יוצר קוד Python מתוקן על סמך תוצאות הבדיקה.

👉 פתיחה

code_review_assistant/sub_agents/fix_pipeline/code_fixer.py

👉 Find:

# MODULE_6_STEP_1_CODE_FIXER_INSTRUCTION_PROVIDER

👈 מחליפים את השורה היחידה הזו ב:

async def code_fixer_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code fixing specialist.

Original Code:

{code_to_review}

Analysis Results:

- Style Score: {style_score}/100

- Style Issues: {style_issues}

- Test Results: {test_execution_summary}

Based on the test results, identify and fix ALL issues including:

- Interface bugs (e.g., if start parameter expects wrong type)

- Logic errors (e.g., KeyError when accessing graph nodes)

- Style violations

- Missing documentation

YOUR TASK:

Generate the complete fixed Python code that addresses all identified issues.

CRITICAL INSTRUCTIONS:

- Output ONLY the corrected Python code

- Do NOT include markdown code blocks (```python)

- Do NOT include any explanations or commentary

- The output should be valid, executable Python code and nothing else

Common fixes to apply based on test results:

- If tests show AttributeError with 'pop', fix: stack = [start] instead of stack = start

- If tests show KeyError accessing graph, fix: use graph.get(current, [])

- Add docstrings if missing

- Fix any style violations identified

Output the complete fixed code now:"""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_6_STEP_1_CODE_FIXER_AGENT

👈 מחליפים את השורה היחידה הזו ב:

code_fixer_agent = Agent(

name="CodeFixer",

model=config.worker_model,

description="Generates comprehensive fixes for all identified code issues",

instruction=code_fixer_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="code_fixes"

)

שלב 2: מוסיפים את Fix Test Runner Agent

כדי לוודא שהתיקונים נכונים, כלי הבדיקה מריץ בדיקות מקיפות על הקוד המתוקן.

👉 פתיחה

code_review_assistant/sub_agents/fix_pipeline/fix_test_runner.py

👉 Find:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_INSTRUCTION_PROVIDER

👈 מחליפים את השורה היחידה הזו ב:

async def fix_test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that uses the clean code from the previous step."""

template = """You are responsible for validating the fixed code by running tests.

THE FIXED CODE TO TEST:

{code_fixes}

ORIGINAL TEST RESULTS: {test_execution_summary}

YOUR TASK:

1. Understand the fixes that were applied

2. Generate the same comprehensive tests (15-20 test cases)

3. Execute the tests on the FIXED code using your code executor

4. Compare results with original test results

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Run the same tests that revealed issues in the original code

- Verify that previously failing tests now pass

- Ensure no regressions were introduced

- Document the improvement

Execute your tests and output ONLY valid JSON with this structure:

- "passed": number of tests that passed

- "failed": number of tests that failed

- "total": total number of tests

- "pass_rate": percentage as a number

- "comparison": object with "original_pass_rate", "new_pass_rate", "improvement"

- "newly_passing_tests": array of test names that now pass

- "still_failing_tests": array of test names still failing

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Find:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_AGENT

👈 מחליפים את השורה היחידה הזו ב:

fix_test_runner_agent = Agent(

name="FixTestRunner",

model=config.critic_model,

description="Runs comprehensive tests on fixed code to verify all issues are resolved",

instruction=fix_test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="fix_test_execution_summary"

)

שלב 3: מוסיפים את Fix Validator Agent

כלי האימות בודק אם התיקונים הצליחו ומחליט אם לצאת מהלולאה.

הסבר על הכלים

קודם מוסיפים את שלושת הכלים שנדרשים למאמת.

👉 פתיחה

code_review_assistant/tools.py

👉 Find:

# MODULE_6_STEP_3_VALIDATE_FIXED_STYLE

👈 Replace with Tool 1 - Style Validator:

async def validate_fixed_style(tool_context: ToolContext) -> Dict[str, Any]:

"""

Validates style compliance of the fixed code.

Args:

tool_context: ADK tool context containing fixed code in state

Returns:

Dictionary with style validation results

"""

logger.info("Tool: Validating style of fixed code...")

try:

# Get the fixed code from state

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Try to extract from markdown if present

if '```python' in code_fixes:

start = code_fixes.rfind('```python') + 9

end = code_fixes.rfind('```')

if start < end:

code_fixes = code_fixes[start:end].strip()

if not code_fixes:

return {

"status": "error",

"message": "No fixed code found in state"

}

# Store the extracted fixed code

tool_context.state[StateKeys.CODE_FIXES] = code_fixes

# Run style check on fixed code

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

style_result = await loop.run_in_executor(

executor, _perform_style_check, code_fixes

)

# Compare with original

original_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

improvement = style_result['score'] - original_score

# Store results

tool_context.state[StateKeys.FIXED_STYLE_SCORE] = style_result['score']

tool_context.state[StateKeys.FIXED_STYLE_ISSUES] = style_result['issues']

logger.info(f"Tool: Fixed code style score: {style_result['score']}/100 "

f"(improvement: +{improvement})")

return {

"status": "success",

"fixed_style_score": style_result['score'],

"original_style_score": original_score,

"improvement": improvement,

"remaining_issues": style_result['issues'],

"perfect_style": style_result['score'] == 100

}

except Exception as e:

logger.error(f"Tool: Style validation failed: {e}", exc_info=True)

return {

"status": "error",

"message": str(e)

}

👉 Find:

# MODULE_6_STEP_3_COMPILE_FIX_REPORT

👈 החלפה בכלי 2 – כלי ליצירת דוחות:

async def compile_fix_report(tool_context: ToolContext) -> Dict[str, Any]:

"""

Compiles comprehensive report of the fix process.

Args:

tool_context: ADK tool context with all fix pipeline data

Returns:

Comprehensive fix report

"""

logger.info("Tool: Compiling comprehensive fix report...")

try:

# Gather all data

original_code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Test results

original_tests = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

fixed_tests = tool_context.state.get(StateKeys.FIX_TEST_EXECUTION_SUMMARY, {})

# Parse if strings

if isinstance(original_tests, str):

try:

original_tests = json.loads(original_tests)

except:

original_tests = {}

if isinstance(fixed_tests, str):

try:

fixed_tests = json.loads(fixed_tests)

except:

fixed_tests = {}

# Extract pass rates

original_pass_rate = 0

if original_tests:

if 'pass_rate' in original_tests:

original_pass_rate = original_tests['pass_rate']

elif 'test_summary' in original_tests:

# Handle test_runner_agent's JSON structure

summary = original_tests['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

original_pass_rate = (passed / total) * 100

elif 'passed' in original_tests and 'total' in original_tests:

if original_tests['total'] > 0:

original_pass_rate = (original_tests['passed'] / original_tests['total']) * 100

fixed_pass_rate = 0

all_tests_pass = False

if fixed_tests:

if 'pass_rate' in fixed_tests:

fixed_pass_rate = fixed_tests['pass_rate']

all_tests_pass = fixed_tests.get('failed', 1) == 0

elif 'passed' in fixed_tests and 'total' in fixed_tests:

if fixed_tests['total'] > 0:

fixed_pass_rate = (fixed_tests['passed'] / fixed_tests['total']) * 100

all_tests_pass = fixed_tests.get('failed', 0) == 0

# Style scores

original_style = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

fixed_style = tool_context.state.get(StateKeys.FIXED_STYLE_SCORE, 0)

# Calculate improvements

test_improvement = {

'original_pass_rate': original_pass_rate,

'fixed_pass_rate': fixed_pass_rate,

'improvement': fixed_pass_rate - original_pass_rate,

'all_tests_pass': all_tests_pass

}

style_improvement = {

'original_score': original_style,

'fixed_score': fixed_style,

'improvement': fixed_style - original_style,

'perfect_style': fixed_style == 100

}

# Determine overall status

if all_tests_pass and style_improvement['perfect_style']:

fix_status = 'SUCCESSFUL'

status_emoji = '✅'

elif test_improvement['improvement'] > 0 or style_improvement['improvement'] > 0:

fix_status = 'PARTIAL'

status_emoji = '⚠️'

else:

fix_status = 'FAILED'

status_emoji = '❌'

# Build comprehensive report

report = {

'status': fix_status,

'status_emoji': status_emoji,

'timestamp': datetime.now().isoformat(),

'original_code': original_code,

'code_fixes': code_fixes,

'improvements': {

'tests': test_improvement,

'style': style_improvement

},

'summary': f"{status_emoji} Fix Status: {fix_status}\n"

f"Tests: {original_pass_rate:.1f}% → {fixed_pass_rate:.1f}%\n"

f"Style: {original_style}/100 → {fixed_style}/100"

}

# Store report in state

tool_context.state[StateKeys.FIX_REPORT] = report

tool_context.state[StateKeys.FIX_STATUS] = fix_status

logger.info(f"Tool: Fix report compiled - Status: {fix_status}")

logger.info(f"Tool: Test improvement: {original_pass_rate:.1f}% → {fixed_pass_rate:.1f}%")

logger.info(f"Tool: Style improvement: {original_style} → {fixed_style}")

return {

"status": "success",

"fix_status": fix_status,

"report": report

}

except Exception as e:

logger.error(f"Tool: Failed to compile fix report: {e}", exc_info=True)

return {

"status": "error",

"message": str(e)

}

👉 Find:

# MODULE_6_STEP_3_EXIT_FIX_LOOP

👈 Replace with Tool 3 - Loop Exit Signal:

def exit_fix_loop(tool_context: ToolContext) -> Dict[str, Any]:

"""

Signal that fixing is complete and should exit the loop.

Args:

tool_context: ADK tool context

Returns:

Confirmation message

"""

logger.info("Tool: Setting escalate flag to exit fix loop")

# This is the critical line that exits the LoopAgent

tool_context.actions.escalate = True

return {

"status": "success",

"message": "Fix complete, exiting loop"

}

יצירת סוכן האימות

👉 פתיחה

code_review_assistant/sub_agents/fix_pipeline/fix_validator.py

👉 Find:

# MODULE_6_STEP_3_FIX_VALIDATOR_INSTRUCTION_PROVIDER

👈 מחליפים את השורה היחידה הזו ב:

async def fix_validator_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are the final validation specialist for code fixes.

You have access to:

- Original issues from initial review

- Applied fixes: {code_fixes}

- Test results after fix: {fix_test_execution_summary}

- All state data from the fix process

Your responsibilities:

1. Use validate_fixed_style tool to check style compliance of fixed code

- Pass no arguments, it will retrieve fixed code from state

2. Use compile_fix_report tool to generate comprehensive report

- Pass no arguments, it will gather all data from state

3. Based on the report, determine overall fix status:

- ✅ SUCCESSFUL: All tests pass, style score 100

- ⚠️ PARTIAL: Improvements made but issues remain

- ❌ FAILED: Fix didn't work or made things worse