1. The Late Night Code Review

Sono le 2 del mattino

Hai eseguito il debug per ore. La funzione sembra corretta, ma qualcosa non va. Conosci quella sensazione: quando il codice dovrebbe funzionare, ma non funziona, e non riesci più a capire perché, perché lo stai guardando da troppo tempo.

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start # Looks innocent enough...

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

Il percorso dello sviluppatore di AI

Se stai leggendo questo articolo, probabilmente hai già sperimentato la trasformazione che l'AI porta alla programmazione. Strumenti come Gemini Code Assist, Claude Code e Cursor hanno cambiato il modo in cui scriviamo il codice. Sono incredibili per generare boilerplate, suggerire implementazioni e accelerare lo sviluppo.

Ma sei qui perché vuoi approfondire. Vuoi capire come creare questi sistemi di AI, non solo come utilizzarli. Vuoi creare qualcosa che:

- Ha un comportamento prevedibile e tracciabile

- Può essere eseguito il deployment in produzione in tutta sicurezza

- Fornisce risultati coerenti su cui puoi fare affidamento

- Ti mostra esattamente come prende le decisioni

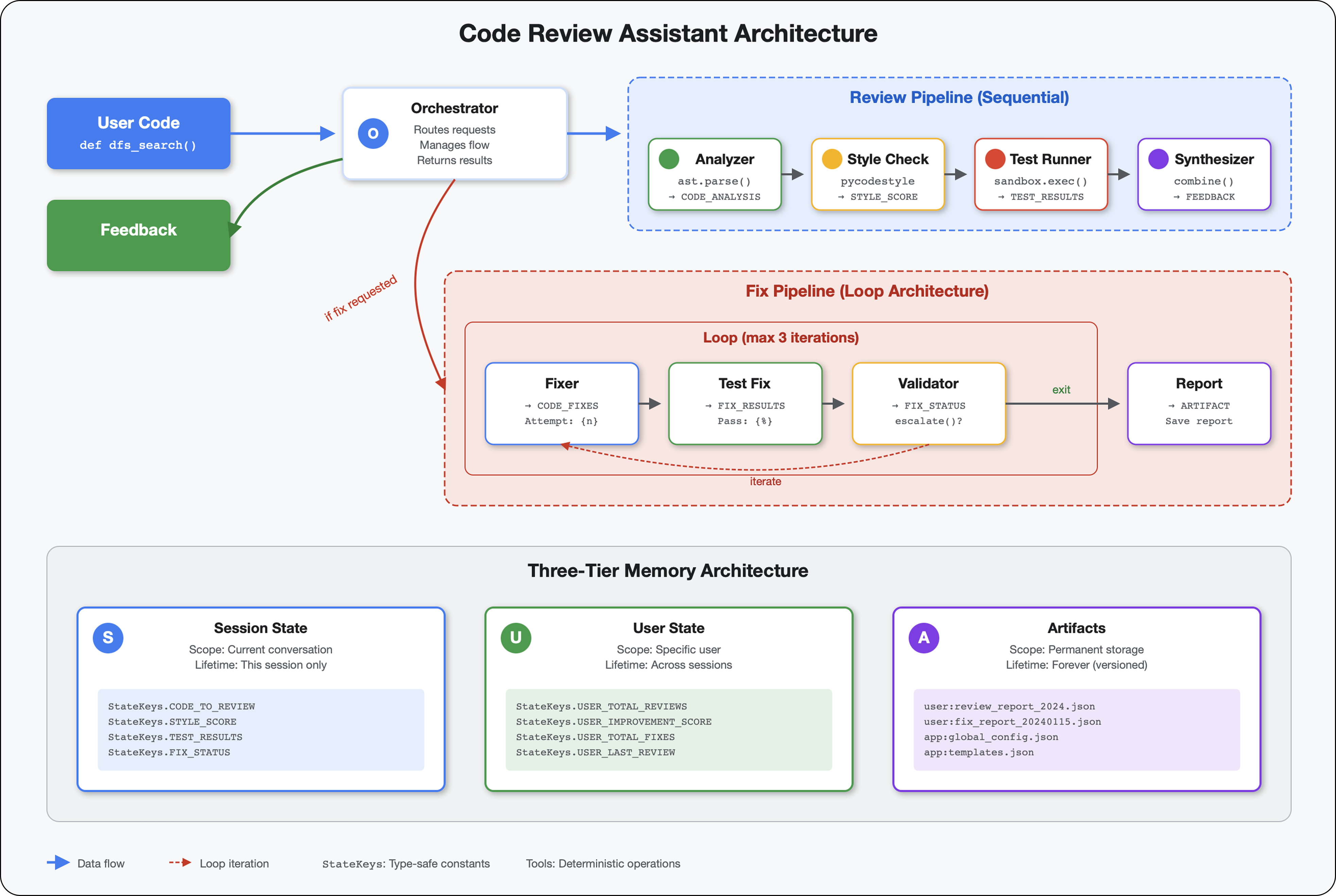

Da consumatore a creator

Oggi, passerai dall'utilizzo degli strumenti AI alla loro creazione. Creerai un sistema multi-agente che:

- Analizza la struttura del codice in modo deterministico

- Esegue test effettivi per verificare il comportamento

- Convalida la conformità dello stile con i linter reali

- Sintetizza i risultati in un feedback pratico

- Deployment su Google Cloud con osservabilità completa

2. Il primo deployment dell'agente

Domanda dello sviluppatore

"Capisco i modelli LLM, ho utilizzato le API, ma come faccio a passare da uno script Python a un agente AI di produzione scalabile?"

Rispondiamo a questa domanda configurando correttamente l'ambiente, quindi creando un semplice agente per comprendere le basi prima di passare ai pattern di produzione.

Eseguire prima la configurazione essenziale

Prima di creare agent, assicuriamoci che il tuo ambiente Google Cloud sia pronto.

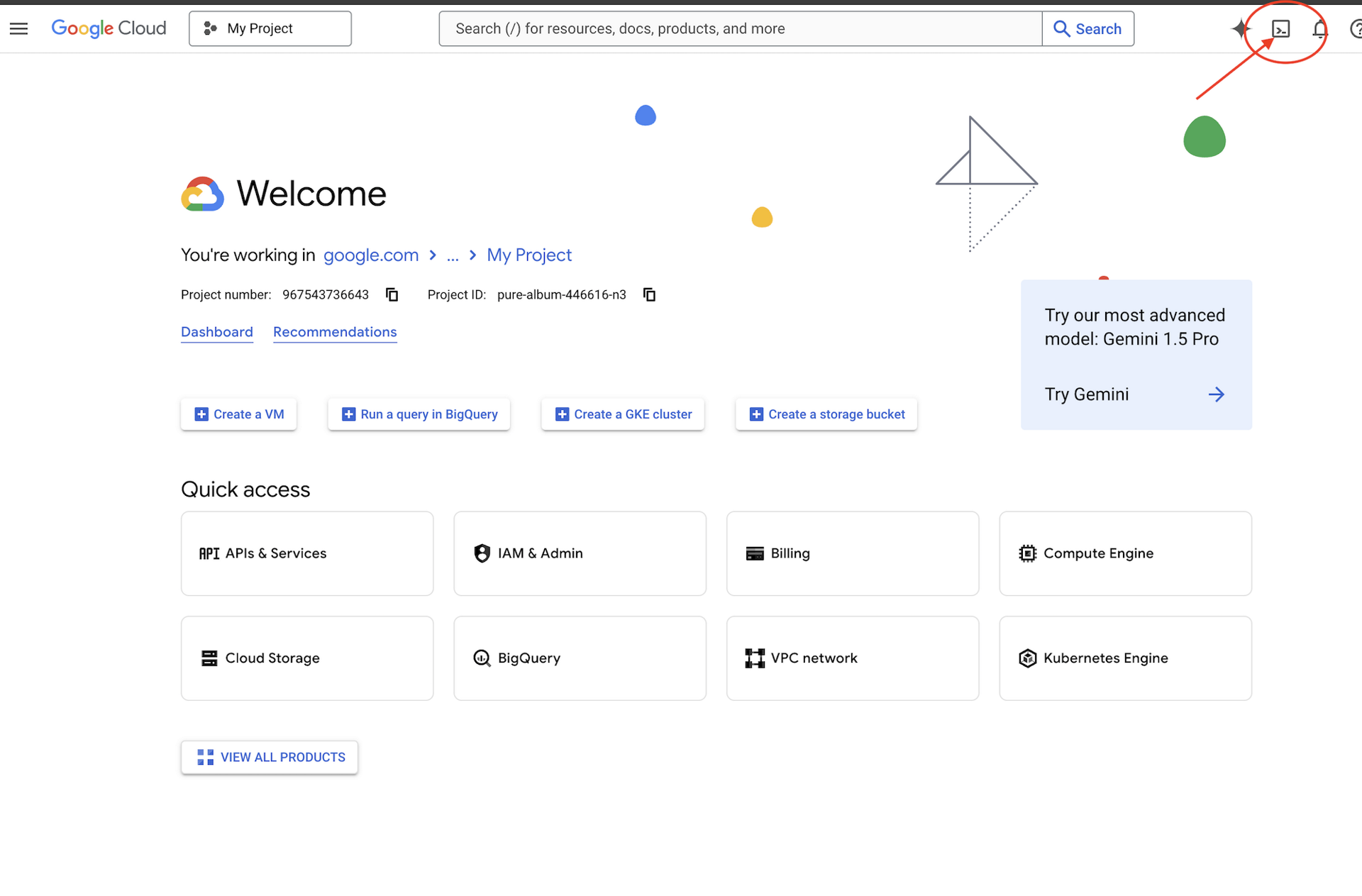

Hai bisogno di crediti Google Cloud?

Fai clic su Attiva Cloud Shell nella parte superiore della console Google Cloud (l'icona a forma di terminale nella parte superiore del riquadro Cloud Shell).

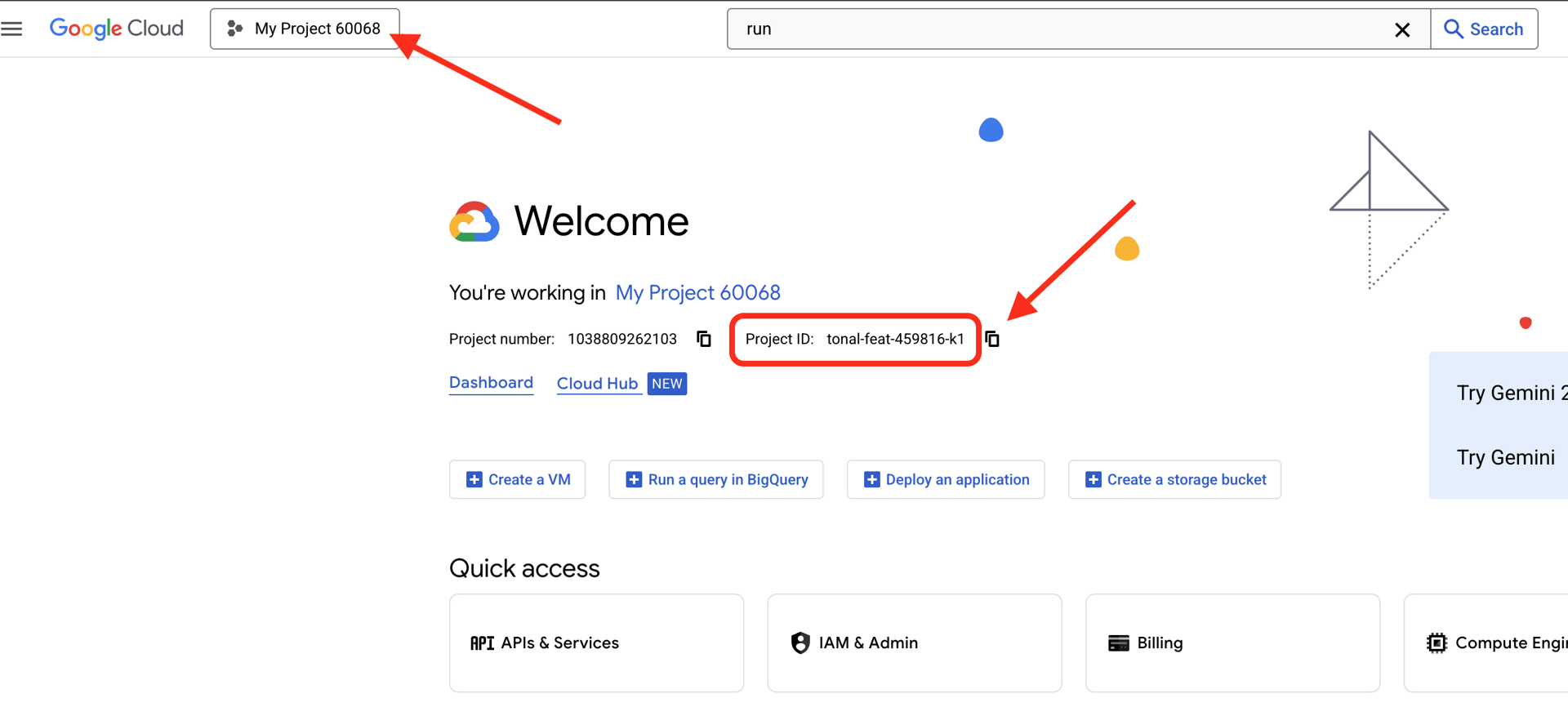

Trova l'ID progetto Google Cloud:

- Apri la console Google Cloud: https://console.cloud.google.com

- Seleziona il progetto che vuoi utilizzare per questo workshop dal menu a discesa dei progetti nella parte superiore della pagina.

- L'ID progetto viene visualizzato nella scheda informativa del progetto nella dashboard

Passaggio 1: imposta l'ID progetto

In Cloud Shell, lo strumento a riga di comando gcloud è già configurato. Esegui questo comando per impostare il progetto attivo. Viene utilizzata la variabile di ambiente $GOOGLE_CLOUD_PROJECT, che viene impostata automaticamente nella sessione Cloud Shell.

gcloud config set project $GOOGLE_CLOUD_PROJECT

Passaggio 2: verifica la configurazione

Successivamente, esegui questi comandi per verificare che il progetto sia impostato correttamente e che l'autenticazione sia stata eseguita.

# Confirm project is set

echo "Current project: $(gcloud config get-value project)"

# Check authentication status

gcloud auth list

Dovresti vedere l'ID progetto stampato e il tuo account utente elencato con (ACTIVE) accanto.

Se il tuo account non è elencato come attivo o se ricevi un errore di autenticazione, esegui questo comando per accedere:

gcloud auth application-default login

Passaggio 3: attiva le API essenziali

Per l'agente di base sono necessarie almeno queste API:

gcloud services enable \

aiplatform.googleapis.com \

compute.googleapis.com

L'operazione può richiedere alcuni minuti. Visualizzerai:

Operation "operations/..." finished successfully.

Passaggio 4: installa ADK

# Install the ADK CLI

pip install google-adk --upgrade

# Verify installation

adk --version

Dovresti visualizzare un numero di versione pari o superiore a 1.15.0.

Ora crea il tuo agente di base

Ora che l'ambiente è pronto, creiamo l'agente semplice.

Passaggio 5: utilizza ADK Create

adk create my_first_agent

Segui le istruzioni interattive:

Choose a model for the root agent:

1. gemini-2.5-flash

2. Other models (fill later)

Choose model (1, 2): 1

1. Google AI

2. Vertex AI

Choose a backend (1, 2): 2

Enter Google Cloud project ID [auto-detected-from-gcloud]:

Enter Google Cloud region [us-central1]:

Passaggio 6: esamina gli elementi creati

cd my_first_agent

ls -la

Troverai tre file:

.env # Configuration (auto-populated with your project)

__init__.py # Package marker

agent.py # Your agent definition

Passaggio 7: controllo rapido della configurazione

# Verify the .env was created correctly

cat .env

# Should show something like:

# GOOGLE_CLOUD_PROJECT=your-project-id

# GOOGLE_CLOUD_LOCATION=us-central1

# GOOGLE_GENAI_USE_VERTEXAI=1

Se l'ID progetto è mancante o errato, modifica il file .env:

nano .env # or use your preferred editor

Passaggio 8: esamina il codice agente

cat agent.py

from google.adk.agents.llm_agent import Agent

root_agent = Agent(

model='gemini-2.5-flash',

name='root_agent',

description='A helpful assistant for user questions.',

instruction='Answer user questions to the best of your knowledge',

)

Semplice, pulito, minimalista. Questo è il tuo "Hello World" degli agenti.

Testare l'agente di base

Passaggio 9: esegui l'agente

cd ..

adk run my_first_agent

Dovresti vedere qualcosa di simile a questo:

Log setup complete: /tmp/agents_log/agent.20250930_162430.log

To access latest log: tail -F /tmp/agents_log/agent.latest.log

[user]:

Passaggio 10: prova alcune query

Nel terminale in cui è in esecuzione adk run, vedrai un prompt. Digita le query:

[user]: Hey, what can you do?

[root_agent]: I can help answer questions, generate text, explain concepts, assist with problem-solving, and provide information on a wide range of topics. What would you like to know or discuss?

[user]: What's the current weather in Mountain View?

[root_agent]: I'm sorry, but I cannot provide real-time weather information as I don't have access to current data or weather services. To get the current weather in Mountain View, I recommend checking a weather website or app like weather.com or using a search engine.

Nota la limitazione: non può accedere ai dati attuali. Andiamo oltre:

[user]: Review this Python code: def add(a, b): return a + b

[root_agent]: This is a simple Python function that adds two numbers. Here's my review:

**Strengths:**

- Clean and concise implementation

- Follows Python conventions for simple operations

- Clear function name that describes its purpose

**Suggestions for improvement:**

- Add a docstring to document the function

- Consider adding type hints for better code clarity

- You might want to handle edge cases

Here's an enhanced version:

def add(a: float, b: float) -> float:

"""Add two numbers and return their sum."""

return a + b

L'agente può discutere del codice, ma può:

- Analizzare effettivamente l'AST per comprendere la struttura?

- Esegui test per verificare che funzioni.

- Controllare la conformità allo stile?

- Ricordi le tue recensioni precedenti?

No. È qui che abbiamo bisogno dell'architettura.

🏃🚪 Esci con

Ctrl+C

quando hai finito di esplorare.

3. Preparazione dello spazio di lavoro di produzione

La soluzione: un'architettura pronta per la produzione

Questo semplice agente ha dimostrato il punto di partenza, ma un sistema di produzione richiede una struttura solida. Ora configureremo un progetto completo che incarna i principi di produzione.

Configurazione delle basi

Hai già configurato il progetto Google Cloud per l'agente di base. Ora prepariamo lo spazio di lavoro di produzione completo con tutti gli strumenti, i pattern e l'infrastruttura necessari per un sistema reale.

Passaggio 1: scarica il progetto strutturato

Innanzitutto, esci da qualsiasi adk run in esecuzione con Ctrl+C e pulisci:

# Clean up the basic agent

cd ~ # Make sure you're not inside my_first_agent

rm -rf my_first_agent

# Get the production scaffold

git clone https://github.com/ayoisio/adk-code-review-assistant.git

cd adk-code-review-assistant

git checkout codelab

Passaggio 2: crea e attiva l'ambiente virtuale

# Create the virtual environment

python -m venv .venv

# Activate it

# On macOS/Linux:

source .venv/bin/activate

# On Windows:

# .venv\Scripts\activate

Verifica: ora il prompt dovrebbe iniziare con (.venv).

Passaggio 3: installa le dipendenze

pip install -r code_review_assistant/requirements.txt

# Install the package in editable mode (enables imports)

pip install -e .

Viene installato:

google-adk- Il framework ADKpycodestyle- For PEP 8 checkingvertexai: per il deployment sul cloud- Altre dipendenze di produzione

Il flag -e ti consente di importare moduli code_review_assistant da qualsiasi posizione.

Passaggio 4: configura l'ambiente

# Copy the example environment file

cp .env.example .env

# Edit .env and replace the placeholders:

# - GOOGLE_CLOUD_PROJECT=your-project-id → your actual project ID

# - Keep other defaults as-is

Verifica: controlla la configurazione:

cat .env

Dovrebbe mostrare:

GOOGLE_CLOUD_PROJECT=your-actual-project-id

GOOGLE_CLOUD_LOCATION=us-central1

GOOGLE_GENAI_USE_VERTEXAI=TRUE

Passaggio 5: assicurati dell'autenticazione

Poiché hai già eseguito gcloud auth in precedenza, verifichiamo solo:

# Check current authentication

gcloud auth list

# Should show your account with (ACTIVE)

# If not, run:

gcloud auth application-default login

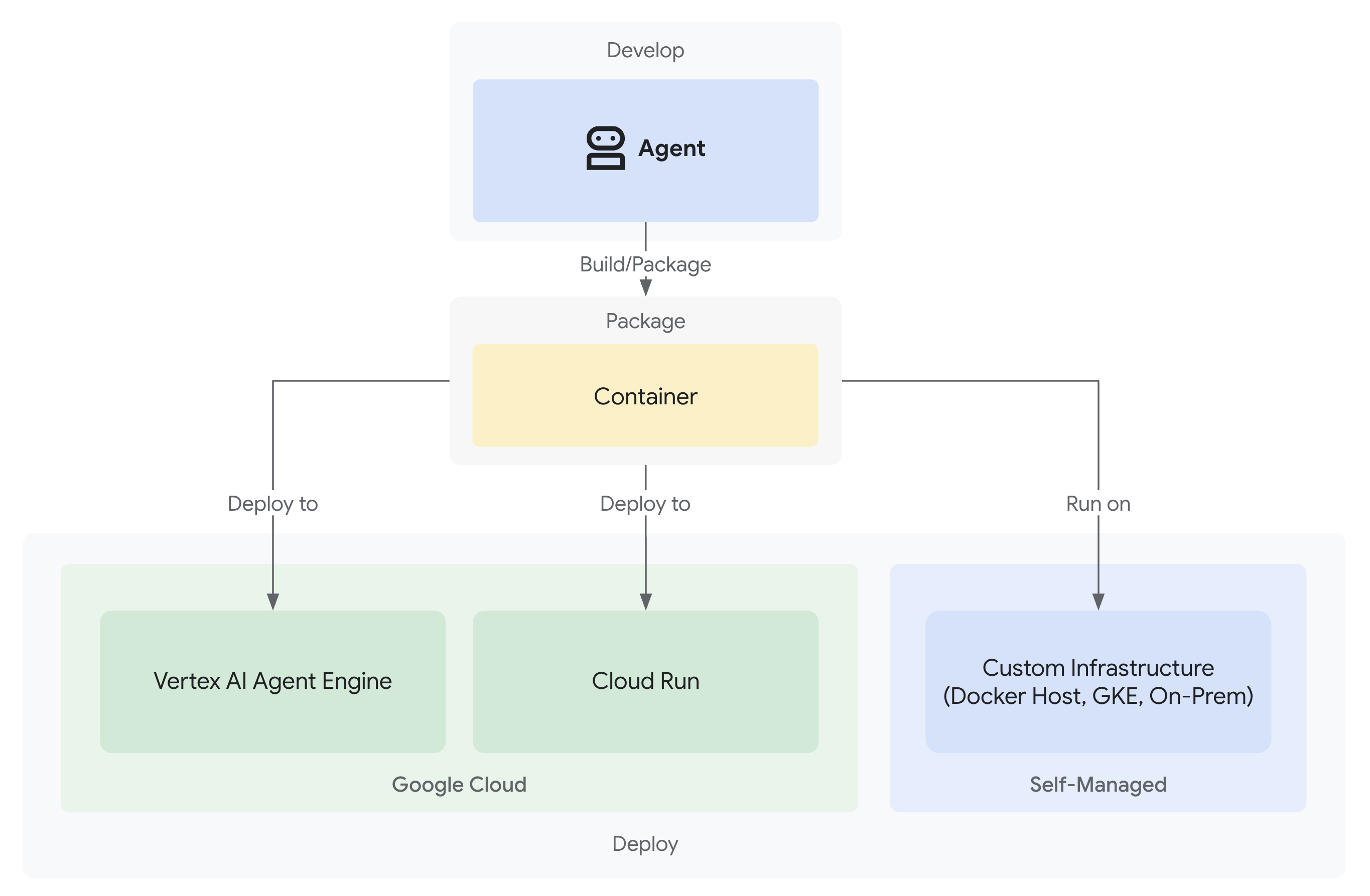

Passaggio 6: attiva le API di produzione aggiuntive

Abbiamo già abilitato le API di base. Ora aggiungi quelli di produzione:

gcloud services enable \

sqladmin.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

artifactregistry.googleapis.com \

storage.googleapis.com \

cloudtrace.googleapis.com

Ciò consente:

- Amministratore SQL: per Cloud SQL se utilizzi Cloud Run

- Cloud Run: per il deployment serverless

- Cloud Build: per i deployment automatizzati

- Artifact Registry: per le immagini container

- Cloud Storage: per artefatti e staging

- Cloud Trace: per l'osservabilità

Passaggio 7: crea il repository Artifact Registry

Il nostro deployment creerà immagini container che hanno bisogno di una casa:

gcloud artifacts repositories create code-review-assistant-repo \

--repository-format=docker \

--location=us-central1 \

--description="Docker repository for Code Review Assistant"

Dovresti vedere:

Created repository [code-review-assistant-repo].

Se esiste già (magari da un tentativo precedente), non preoccuparti, vedrai un messaggio di errore che puoi ignorare.

Passaggio 8: concedi autorizzazioni IAM

# Get your project number

PROJECT_NUMBER=$(gcloud projects describe $GOOGLE_CLOUD_PROJECT \

--format="value(projectNumber)")

# Define the service account

SERVICE_ACCOUNT="${PROJECT_NUMBER}@cloudbuild.gserviceaccount.com"

# Grant necessary roles

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/run.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/iam.serviceAccountUser"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/cloudsql.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/storage.admin"

Ogni comando restituirà:

Updated IAM policy for project [your-project-id].

Cosa hai realizzato

Il tuo workspace di produzione è ora completamente preparato:

✅ Progetto Google Cloud configurato e autenticato

✅ Agente di base testato per comprendere i limiti

✅ Codice del progetto con segnaposto strategici pronto

✅ Dipendenze isolate nell'ambiente virtuale

✅ Tutte le API necessarie abilitate

✅ Registro dei container pronto per le implementazioni

✅ Autorizzazioni IAM configurate correttamente

✅ Variabili di ambiente impostate correttamente

Ora puoi creare un vero sistema di AI con strumenti deterministici, gestione dello stato e architettura adeguata.

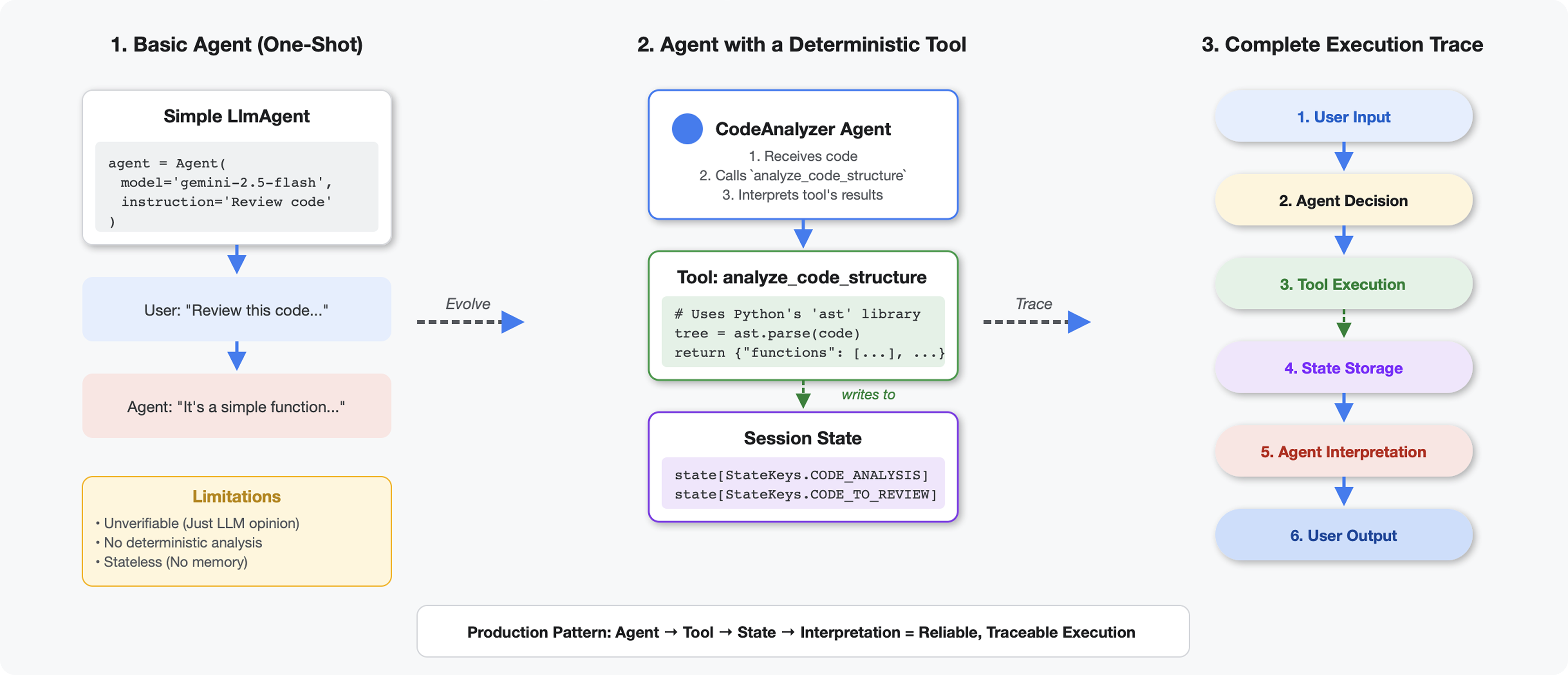

4. Creazione del tuo primo agente

Cosa rende gli strumenti diversi dagli LLM

Quando chiedi a un LLM "quante funzioni ci sono in questo codice?", utilizza la corrispondenza di pattern e la stima. Quando utilizzi uno strumento che chiama ast.parse() di Python, analizza l'albero della sintassi effettivo, senza congetture, e restituisce lo stesso risultato ogni volta.

Questa sezione crea uno strumento che analizza la struttura del codice in modo deterministico, quindi lo collega a un agente che sa quando richiamarlo.

Passaggio 1: comprendi lo scaffold

Esaminiamo la struttura che dovrai compilare.

👉 Apri

code_review_assistant/tools.py

Visualizzerai la funzione analyze_code_structure con commenti segnaposto che indicano dove aggiungere il codice. La funzione ha già la struttura di base, che migliorerai passo dopo passo.

Passaggio 2: aggiungi State Storage

L'archiviazione dello stato consente ad altri agenti nella pipeline di accedere ai risultati dello strumento senza eseguire nuovamente l'analisi.

👉 Trova:

# MODULE_4_STEP_2_ADD_STATE_STORAGE

👉 Sostituisci quella singola riga con:

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

Passaggio 3: aggiungi l'analisi asincrona con i pool di thread

Il nostro strumento deve analizzare l'AST senza bloccare altre operazioni. Aggiungiamo l'esecuzione asincrona con i pool di thread.

👉 Trova:

# MODULE_4_STEP_3_ADD_ASYNC

👉 Sostituisci quella singola riga con:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

Passaggio 4: estrai informazioni complete

Ora estraiamo classi, importazioni e metriche dettagliate, tutto ciò che ci serve per una revisione completa del codice.

👉 Trova:

# MODULE_4_STEP_4_EXTRACT_DETAILS

👉 Sostituisci quella singola riga con:

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

👉 Verifica: la funzione

analyze_code_structure

in

tools.py

ha un corpo centrale che ha questo aspetto:

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

👉 Ora scorri fino in fondo alla pagina

tools.py

e trova:

# MODULE_4_STEP_4_HELPER_FUNCTION

👉 Sostituisci quella singola riga con la funzione helper completa:

def _extract_code_structure(tree: ast.AST, code: str) -> Dict[str, Any]:

"""

Helper function to extract structural information from AST.

Runs in thread pool for CPU-bound work.

"""

functions = []

classes = []

imports = []

docstrings = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

func_info = {

'name': node.name,

'args': [arg.arg for arg in node.args.args],

'lineno': node.lineno,

'has_docstring': ast.get_docstring(node) is not None,

'is_async': isinstance(node, ast.AsyncFunctionDef),

'decorators': [d.id for d in node.decorator_list

if isinstance(d, ast.Name)]

}

functions.append(func_info)

if func_info['has_docstring']:

docstrings.append(f"{node.name}: {ast.get_docstring(node)[:50]}...")

elif isinstance(node, ast.ClassDef):

methods = []

for item in node.body:

if isinstance(item, ast.FunctionDef):

methods.append(item.name)

class_info = {

'name': node.name,

'lineno': node.lineno,

'methods': methods,

'has_docstring': ast.get_docstring(node) is not None,

'base_classes': [base.id for base in node.bases

if isinstance(base, ast.Name)]

}

classes.append(class_info)

elif isinstance(node, ast.Import):

for alias in node.names:

imports.append({

'module': alias.name,

'alias': alias.asname,

'type': 'import'

})

elif isinstance(node, ast.ImportFrom):

imports.append({

'module': node.module or '',

'names': [alias.name for alias in node.names],

'type': 'from_import',

'level': node.level

})

return {

'functions': functions,

'classes': classes,

'imports': imports,

'docstrings': docstrings,

'metrics': {

'line_count': len(code.splitlines()),

'function_count': len(functions),

'class_count': len(classes),

'import_count': len(imports),

'has_main': any(f['name'] == 'main' for f in functions),

'has_if_main': '__main__' in code,

'avg_function_length': _calculate_avg_function_length(tree)

}

}

def _calculate_avg_function_length(tree: ast.AST) -> float:

"""Calculate average function length in lines."""

function_lengths = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

if hasattr(node, 'end_lineno') and hasattr(node, 'lineno'):

length = node.end_lineno - node.lineno + 1

function_lengths.append(length)

if function_lengths:

return sum(function_lengths) / len(function_lengths)

return 0.0

Passaggio 5: contatta un agente

Ora colleghiamo lo strumento a un agente che sa quando utilizzarlo e come interpretarne i risultati.

👉 Apri

code_review_assistant/sub_agents/review_pipeline/code_analyzer.py

👉 Trova:

# MODULE_4_STEP_5_CREATE_AGENT

👉 Sostituisci quella singola riga con l'agente di produzione completo:

code_analyzer_agent = Agent(

name="CodeAnalyzer",

model=config.worker_model,

description="Analyzes Python code structure and identifies components",

instruction="""You are a code analysis specialist responsible for understanding code structure.

Your task:

1. Take the code submitted by the user (it will be provided in the user message)

2. Use the analyze_code_structure tool to parse and analyze it

3. Pass the EXACT code to your tool - do not modify, fix, or "improve" it

4. Identify all functions, classes, imports, and structural patterns

5. Note any syntax errors or structural issues

6. Store the analysis in state for other agents to use

CRITICAL:

- Pass the code EXACTLY as provided to the analyze_code_structure tool

- Do not fix syntax errors, even if obvious

- Do not add missing imports or fix indentation

- The goal is to analyze what IS there, not what SHOULD be there

When calling the tool, pass the code as a string to the 'code' parameter.

If the analysis fails due to syntax errors, clearly report the error location and type.

Provide a clear summary including:

- Number of functions and classes found

- Key structural observations

- Any syntax errors or issues detected

- Overall code organization assessment""",

tools=[FunctionTool(func=analyze_code_structure)],

output_key="structure_analysis_summary"

)

Testare lo strumento di analisi del codice

Ora verifica che l'analizzatore funzioni correttamente.

👉 Esegui lo script di test:

python tests/test_code_analyzer.py

Lo script di test carica automaticamente la configurazione dal file .env utilizzando python-dotenv, quindi non è necessaria alcuna configurazione manuale delle variabili di ambiente.

Output previsto:

INFO:code_review_assistant.config:Code Review Assistant Configuration Loaded:

INFO:code_review_assistant.config: - GCP Project: your-project-id

INFO:code_review_assistant.config: - Artifact Bucket: gs://your-project-artifacts

INFO:code_review_assistant.config: - Models: worker=gemini-2.5-flash, critic=gemini-2.5-pro

Testing code analyzer...

INFO:code_review_assistant.tools:Tool: Analysis complete - 2 functions, 1 classes

=== Analyzer Response ===

The analysis of the provided code shows the following:

* **Functions Found:** 2

* `add(a, b)`: A global function at line 2.

* `multiply(self, x, y)`: A method within the `Calculator` class.

* **Classes Found:** 1

* `Calculator`: A class defined at line 5. Contains one method, `multiply`.

* **Imports:** 0

* **Structural Patterns:** The code defines one global function and one class

with a single method. Both are simple, each with a single return statement.

* **Syntax Errors/Issues:** No syntax errors detected.

* **Overall Code Organization:** The code is well-organized for its small size,

clearly defining a function and a class with a method.

Cosa è appena successo:

- Lo script di test ha caricato automaticamente la configurazione di

.env - Il tuo strumento

analyze_code_structure()ha analizzato il codice utilizzando l'AST di Python - L'helper

_extract_code_structure()ha estratto funzioni, classi e metriche - I risultati sono stati archiviati nello stato della sessione utilizzando le costanti

StateKeys - L'agente Code Analyzer ha interpretato i risultati e fornito un riepilogo

Risoluzione dei problemi:

- "No module named ‘code_review_assistant'": esegui

pip install -e .dalla radice del progetto - "Missing key inputs argument": verifica che

.envabbiaGOOGLE_CLOUD_PROJECT,GOOGLE_CLOUD_LOCATIONeGOOGLE_GENAI_USE_VERTEXAI=true

Cosa hai creato

Ora hai un analizzatore di codice pronto per la produzione che:

✅ Analizza l'AST Python effettivo: deterministico, non basato sulla corrispondenza di pattern

✅ Memorizza i risultati nello stato: altri agenti possono accedere all'analisi

✅ Viene eseguito in modo asincrono: non blocca altri strumenti

✅ Estrae informazioni complete: funzioni, classi, importazioni, metriche

✅ Gestisce gli errori in modo controllato: segnala gli errori di sintassi con i numeri di riga

✅ Si connette a un agente: il LLM sa quando e come utilizzarlo

Concetti fondamentali padroneggiati

Strumenti e agenti:

- Gli strumenti eseguono un lavoro deterministico (analisi AST)

- Gli agenti decidono quando utilizzare gli strumenti e interpretare i risultati

Valore di ritorno e stato:

- Ritorno: ciò che l'LLM vede immediatamente

- Stato: ciò che persiste per gli altri agenti

Costanti delle chiavi di stato:

- Evitare errori di battitura nei sistemi multi-agente

- Fungono da contratti tra gli agenti

- Fondamentale quando gli agenti condividono i dati

Async + Thread Pools:

async defconsente agli strumenti di mettere in pausa l'esecuzione- I pool di thread eseguono in background il lavoro vincolato alla CPU

- Insieme, mantengono reattivo il ciclo degli eventi.

Funzioni helper:

- Separare gli helper di sincronizzazione dagli strumenti asincroni

- Rende il codice testabile e riutilizzabile

Istruzioni per l'agente:

- Istruzioni dettagliate per evitare gli errori comuni degli LLM

- Spiega chiaramente cosa NON fare (non correggere il codice)

- Cancella i passaggi del workflow per coerenza

Passaggi successivi

Nel modulo 5, aggiungerai:

- Controllo dello stile che legge il codice dallo stato

- Test runner che esegue effettivamente i test

- Sintetizzatore di feedback che combina tutte le analisi

Vedrai come lo stato scorre attraverso una pipeline sequenziale e perché il pattern delle costanti è importante quando più agenti leggono e scrivono gli stessi dati.

5. Creazione di una pipeline: più agenti che lavorano insieme

Introduzione

Nel modulo 4, hai creato un singolo agente che analizza la struttura del codice. Tuttavia, la revisione completa del codice richiede più della semplice analisi: è necessario il controllo dello stile, l'esecuzione dei test e la sintesi intelligente del feedback.

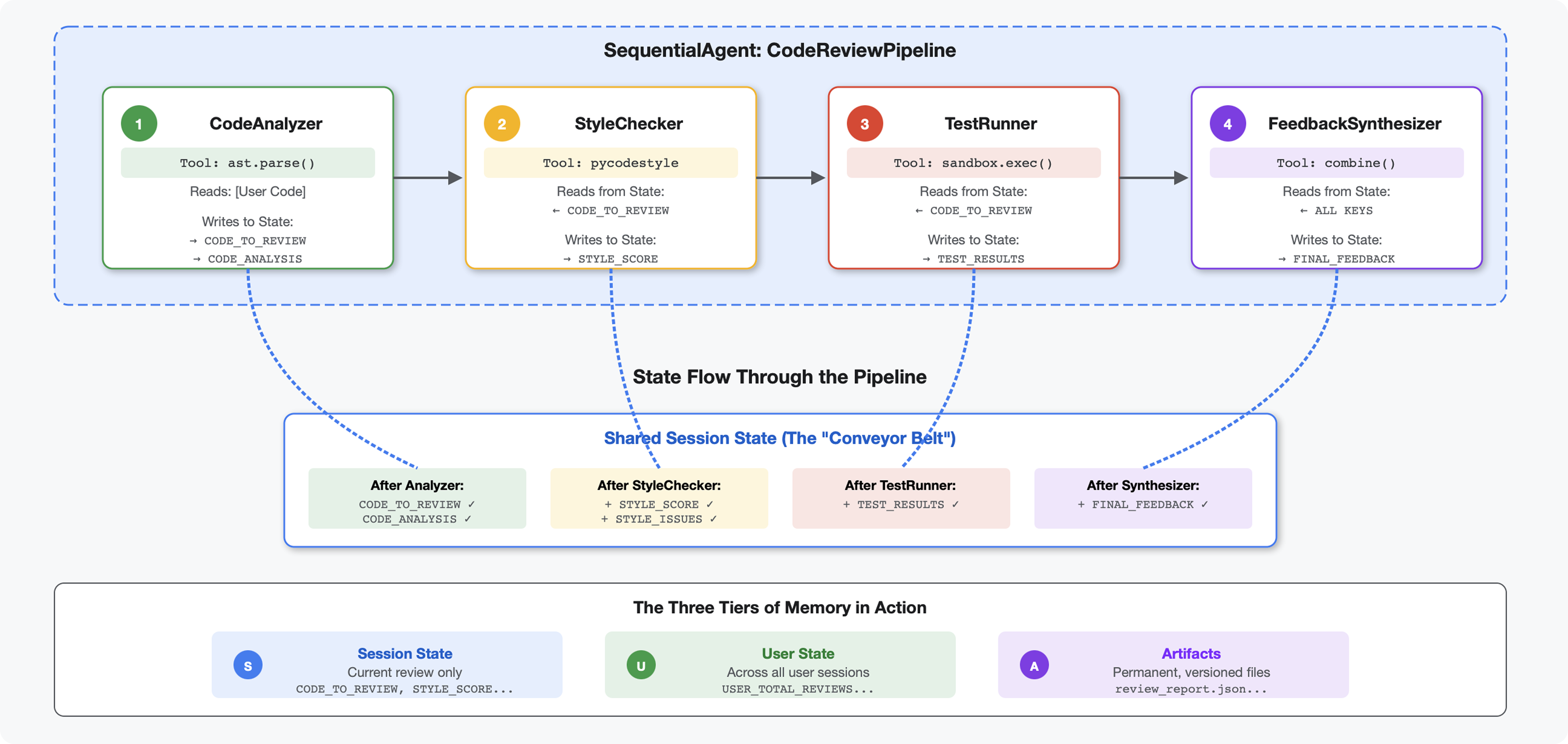

Questo modulo crea una pipeline di 4 agenti che lavorano insieme in sequenza, ognuno dei quali contribuisce con un'analisi specializzata:

- Code Analyzer (dal modulo 4) - Analizza la struttura

- Controllo dello stile: identifica le violazioni dello stile

- Test Runner: esegue e convalida i test

- Feedback Synthesizer: combina tutto in un feedback utile

Concetto chiave: lo stato come canale di comunicazione. Ogni agente legge ciò che hanno scritto gli agenti precedenti per definire lo stato, aggiunge la propria analisi e passa lo stato arricchito all'agente successivo. Il pattern delle costanti del Modulo 4 diventa fondamentale quando più agenti condividono i dati.

Anteprima di ciò che creerai:invia codice disordinato → osserva il flusso di stato attraverso 4 agenti → ricevi un report completo con feedback personalizzato basato su pattern passati.

Passaggio 1: aggiungi lo strumento di controllo dello stile + l'agente

Il controllo dello stile identifica le violazioni di PEP 8 utilizzando pycodestyle, un linter deterministico, non un'interpretazione basata su LLM.

Aggiungere lo strumento di controllo dello stile

👉 Apri

code_review_assistant/tools.py

👉 Trova:

# MODULE_5_STEP_1_STYLE_CHECKER_TOOL

👉 Sostituisci quella singola riga con:

async def check_code_style(code: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Checks code style compliance using pycodestyle (PEP 8).

Args:

code: Python source code to check (or will retrieve from state)

tool_context: ADK tool context

Returns:

Dictionary containing style score and issues

"""

logger.info("Tool: Checking code style...")

try:

# Retrieve code from state if not provided

if not code:

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

if not code:

return {

"status": "error",

"message": "No code provided or found in state"

}

# Run style check in thread pool

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

result = await loop.run_in_executor(

executor, _perform_style_check, code

)

# Store results in state

tool_context.state[StateKeys.STYLE_SCORE] = result['score']

tool_context.state[StateKeys.STYLE_ISSUES] = result['issues']

tool_context.state[StateKeys.STYLE_ISSUE_COUNT] = result['issue_count']

logger.info(f"Tool: Style check complete - Score: {result['score']}/100, "

f"Issues: {result['issue_count']}")

return result

except Exception as e:

error_msg = f"Style check failed: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Set default values on error

tool_context.state[StateKeys.STYLE_SCORE] = 0

tool_context.state[StateKeys.STYLE_ISSUES] = []

return {

"status": "error",

"message": error_msg,

"score": 0

}

👉 Ora scorri fino alla fine del file e trova:

# MODULE_5_STEP_1_STYLE_HELPERS

👉 Sostituisci quella singola riga con le funzioni helper:

def _perform_style_check(code: str) -> Dict[str, Any]:

"""Helper to perform style check in thread pool."""

import io

import sys

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as tmp:

tmp.write(code)

tmp_path = tmp.name

try:

# Capture stdout to get pycodestyle output

old_stdout = sys.stdout

sys.stdout = captured_output = io.StringIO()

style_guide = pycodestyle.StyleGuide(

quiet=False, # We want output

max_line_length=100,

ignore=['E501', 'W503']

)

result = style_guide.check_files([tmp_path])

# Restore stdout

sys.stdout = old_stdout

# Parse captured output

output = captured_output.getvalue()

issues = []

for line in output.strip().split('\n'):

if line and ':' in line:

parts = line.split(':', 4)

if len(parts) >= 4:

try:

issues.append({

'line': int(parts[1]),

'column': int(parts[2]),

'code': parts[3].split()[0] if len(parts) > 3 else 'E000',

'message': parts[3].strip() if len(parts) > 3 else 'Unknown error'

})

except (ValueError, IndexError):

pass

# Add naming convention checks

try:

tree = ast.parse(code)

naming_issues = _check_naming_conventions(tree)

issues.extend(naming_issues)

except SyntaxError:

pass # Syntax errors will be caught elsewhere

# Calculate weighted score

score = _calculate_style_score(issues)

return {

"status": "success",

"score": score,

"issue_count": len(issues),

"issues": issues[:10], # First 10 issues

"summary": f"Style score: {score}/100 with {len(issues)} violations"

}

finally:

if os.path.exists(tmp_path):

os.unlink(tmp_path)

def _check_naming_conventions(tree: ast.AST) -> List[Dict[str, Any]]:

"""Check PEP 8 naming conventions."""

naming_issues = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

# Skip private/protected methods and __main__

if not node.name.startswith('_') and node.name != node.name.lower():

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N802',

'message': f"N802 function name '{node.name}' should be lowercase"

})

elif isinstance(node, ast.ClassDef):

# Check if class name follows CapWords convention

if not node.name[0].isupper() or '_' in node.name:

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N801',

'message': f"N801 class name '{node.name}' should use CapWords convention"

})

return naming_issues

def _calculate_style_score(issues: List[Dict[str, Any]]) -> int:

"""Calculate weighted style score based on violation severity."""

if not issues:

return 100

# Define weights by error type

weights = {

'E1': 10, # Indentation errors

'E2': 3, # Whitespace errors

'E3': 5, # Blank line errors

'E4': 8, # Import errors

'E5': 5, # Line length

'E7': 7, # Statement errors

'E9': 10, # Syntax errors

'W2': 2, # Whitespace warnings

'W3': 2, # Blank line warnings

'W5': 3, # Line break warnings

'N8': 7, # Naming conventions

}

total_deduction = 0

for issue in issues:

code_prefix = issue['code'][:2] if len(issue['code']) >= 2 else 'E2'

weight = weights.get(code_prefix, 3)

total_deduction += weight

# Cap at 100 points deduction

return max(0, 100 - min(total_deduction, 100))

Aggiungere l'agente di controllo dello stile

👉 Apri

code_review_assistant/sub_agents/review_pipeline/style_checker.py

👉 Trova:

# MODULE_5_STEP_1_INSTRUCTION_PROVIDER

👉 Sostituisci quella singola riga con:

async def style_checker_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are a code style expert focused on PEP 8 compliance.

Your task:

1. Use the check_code_style tool to validate PEP 8 compliance

2. The tool will retrieve the ORIGINAL code from state automatically

3. Report violations exactly as found

4. Present the results clearly and confidently

CRITICAL:

- The tool checks the code EXACTLY as provided by the user

- Do not suggest the code was modified or fixed

- Report actual violations found in the original code

- If there are style issues, they should be reported honestly

Call the check_code_style tool with an empty string for the code parameter,

as the tool will retrieve the code from state automatically.

When presenting results based on what the tool returns:

- State the exact score from the tool results

- If score >= 90: "Excellent style compliance!"

- If score 70-89: "Good style with minor improvements needed"

- If score 50-69: "Style needs attention"

- If score < 50: "Significant style improvements needed"

List the specific violations found (the tool will provide these):

- Show line numbers, error codes, and messages

- Focus on the top 10 most important issues

Previous analysis: {structure_analysis_summary}

Format your response as:

## Style Analysis Results

- Style Score: [exact score]/100

- Total Issues: [count]

- Assessment: [your assessment based on score]

## Top Style Issues

[List issues with line numbers and descriptions]

## Recommendations

[Specific fixes for the most critical issues]"""

return await instructions_utils.inject_session_state(template, context)

👉 Trova:

# MODULE_5_STEP_1_STYLE_CHECKER_AGENT

👉 Sostituisci quella singola riga con:

style_checker_agent = Agent(

name="StyleChecker",

model=config.worker_model,

description="Checks Python code style against PEP 8 guidelines",

instruction=style_checker_instruction_provider,

tools=[FunctionTool(func=check_code_style)],

output_key="style_check_summary"

)

Passaggio 2: aggiungi l'agente Test Runner

Il test runner genera test completi e li esegue utilizzando l'executor di codice integrato.

👉 Apri

code_review_assistant/sub_agents/review_pipeline/test_runner.py

👉 Trova:

# MODULE_5_STEP_2_INSTRUCTION_PROVIDER

👉 Sostituisci quella singola riga con:

async def test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects the code_to_review directly."""

template = """You are a testing specialist who creates and runs tests for Python code.

THE CODE TO TEST IS:

{code_to_review}

YOUR TASK:

1. Understand what the function appears to do based on its name and structure

2. Generate comprehensive tests (15-20 test cases)

3. Execute the tests using your code executor

4. Analyze results to identify bugs vs expected behavior

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Test with the most natural interpretation first

- When something fails, determine if it's a bug or unusual design

- Test edge cases, boundaries, and error scenarios

- Document any surprising behavior

Execute your tests and output ONLY valid JSON with this structure:

- "test_summary": object with "total_tests_run", "tests_passed", "tests_failed", "tests_with_errors", "critical_issues_found"

- "critical_issues": array of objects, each with "type", "description", "example_input", "expected_behavior", "actual_behavior", "severity"

- "test_categories": object with "basic_functionality", "edge_cases", "error_handling" (each containing "passed", "failed", "errors" counts)

- "function_behavior": object with "apparent_purpose", "actual_interface", "unexpected_requirements"

- "verdict": object with "status" (WORKING/BUGGY/BROKEN), "confidence" (high/medium/low), "recommendation"

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Trova:

# MODULE_5_STEP_2_TEST_RUNNER_AGENT

👉 Sostituisci quella singola riga con:

test_runner_agent = Agent(

name="TestRunner",

model=config.critic_model,

description="Generates and runs tests for Python code using safe code execution",

instruction=test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="test_execution_summary"

)

Passaggio 3: comprendere la memoria per l'apprendimento cross-sessione

Prima di creare il sintetizzatore di feedback, devi comprendere la differenza tra stato e memoria, due meccanismi di archiviazione diversi per due scopi diversi.

Stato e memoria: la distinzione chiave

Vediamo un esempio concreto di revisione del codice:

Stato (solo sessione corrente):

# Data from THIS review session

tool_context.state[StateKeys.STYLE_ISSUES] = [

{"line": 5, "code": "E231", "message": "missing whitespace"},

{"line": 12, "code": "E701", "message": "multiple statements"}

]

- Ambito: Solo questa conversazione

- Scopo: passare i dati tra gli agenti nella pipeline corrente

- Vive a: oggetto

Session - Lifetime: eliminato al termine della sessione

Memoria (tutte le sessioni passate):

# Learned from 50 previous reviews

"User frequently forgets docstrings on helper functions"

"User tends to write long functions (avg 45 lines)"

"User improved error handling after feedback in session #23"

- Ambito: Tutte le sessioni passate per questo utente

- Scopo: apprendere i pattern, fornire feedback personalizzati

- Vive a:

MemoryService - Lifetime: persiste tra le sessioni, è possibile eseguire ricerche

Perché il feedback deve includere entrambi gli elementi:

Immagina il sintetizzatore che crea un feedback:

Utilizzo solo dello stato (revisione attuale):

"Function `calculate_total` has no docstring."

Feedback generico e meccanico.

Utilizzo di Stato + Memoria (pattern attuali e passati):

"Function `calculate_total` has no docstring. This is the 4th review

where helper functions lacked documentation. Consider adding docstrings

as you write functions, not afterwards - you mentioned in our last

session that you find it easier that way."

Miglioramento personalizzato, contestuale e dei riferimenti nel tempo.

Per i deployment di produzione, hai opzioni:

Opzione 1: VertexAiMemoryBankService (avanzata)

- Come funziona: estrazione basata su LLM di fatti significativi dalle conversazioni

- Ricerca:ricerca semantica (comprende il significato, non solo le parole chiave)

- Gestione dei ricordi:consolida e aggiorna automaticamente i ricordi nel tempo

- Requisiti:progetto Google Cloud + configurazione di Agent Engine

- Utilizzo: vuoi ricordi sofisticati, in evoluzione e personalizzati

- Esempio: "L'utente preferisce la programmazione funzionale" (estratto da 10 conversazioni sullo stile di codice)

Opzione 2: continua con InMemoryMemoryService + sessioni persistenti

- Funzioni: memorizza la cronologia completa delle conversazioni per la ricerca di parole chiave

- Ricerca:corrispondenza di base delle parole chiave nelle sessioni precedenti

- Gestione della memoria:controlli cosa viene memorizzato (tramite

add_session_to_memory) - Requisiti:solo un

SessionServicepersistente (ad esempioVertexAiSessionServiceoDatabaseSessionService) - Utilizzo: hai bisogno di una ricerca semplice nelle conversazioni passate senza l'elaborazione LLM

- Esempio: la ricerca "docstring" restituisce tutte le sessioni in cui viene menzionata questa parola

Come viene compilata la memoria

Al termine di ogni revisione del codice:

# At the end of a session (typically in your application code)

await memory_service.add_session_to_memory(session)

Cosa succede:

- InMemoryMemoryService:memorizza gli eventi di sessione completi per la ricerca di parole chiave

- VertexAiMemoryBankService: l'LLM estrae i fatti chiave e li consolida con i ricordi esistenti

Le sessioni future possono quindi eseguire query:

# In a tool, search for relevant past feedback

results = tool_context.search_memory("feedback about docstrings")

Passaggio 4: aggiungi gli strumenti e l'agente di Feedback Synthesizer

Il sintetizzatore di feedback è l'agente più sofisticato della pipeline. Coordina tre strumenti, utilizza istruzioni dinamiche e combina stato, memoria e artefatti.

Aggiungere i tre strumenti di sintesi

👉 Apri

code_review_assistant/tools.py

👉 Trova:

# MODULE_5_STEP_4_SEARCH_PAST_FEEDBACK

👉 Sostituisci con Strumento 1 - Ricerca nella memoria (versione di produzione):

async def search_past_feedback(developer_id: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Search for past feedback in memory service.

Args:

developer_id: ID of the developer (defaults to "default_user")

tool_context: ADK tool context with potential memory service access

Returns:

Dictionary containing feedback search results

"""

logger.info(f"Tool: Searching for past feedback for developer {developer_id}...")

try:

# Default developer ID if not provided

if not developer_id:

developer_id = tool_context.state.get(StateKeys.USER_ID, 'default_user')

# Check if memory service is available

if hasattr(tool_context, 'search_memory'):

try:

# Perform structured searches

queries = [

f"developer:{developer_id} code review feedback",

f"developer:{developer_id} common issues",

f"developer:{developer_id} improvements"

]

all_feedback = []

patterns = {

'common_issues': [],

'improvements': [],

'strengths': []

}

for query in queries:

search_result = await tool_context.search_memory(query)

if search_result and hasattr(search_result, 'memories'):

for memory in search_result.memories[:5]:

memory_text = memory.text if hasattr(memory, 'text') else str(memory)

all_feedback.append(memory_text)

# Extract patterns

if 'style' in memory_text.lower():

patterns['common_issues'].append('style compliance')

if 'improved' in memory_text.lower():

patterns['improvements'].append('showing improvement')

if 'excellent' in memory_text.lower():

patterns['strengths'].append('consistent quality')

# Store in state

tool_context.state[StateKeys.PAST_FEEDBACK] = all_feedback

tool_context.state[StateKeys.FEEDBACK_PATTERNS] = patterns

logger.info(f"Tool: Found {len(all_feedback)} past feedback items")

return {

"status": "success",

"feedback_found": True,

"count": len(all_feedback),

"summary": " | ".join(all_feedback[:3]) if all_feedback else "No feedback",

"patterns": patterns

}

except Exception as e:

logger.warning(f"Tool: Memory search error: {e}")

# Fallback: Check state for cached feedback

cached_feedback = tool_context.state.get(StateKeys.USER_PAST_FEEDBACK_CACHE, [])

if cached_feedback:

tool_context.state[StateKeys.PAST_FEEDBACK] = cached_feedback

return {

"status": "success",

"feedback_found": True,

"count": len(cached_feedback),

"summary": "Using cached feedback",

"patterns": {}

}

# No feedback found

tool_context.state[StateKeys.PAST_FEEDBACK] = []

logger.info("Tool: No past feedback found")

return {

"status": "success",

"feedback_found": False,

"message": "No past feedback available - this appears to be a first submission",

"patterns": {}

}

except Exception as e:

error_msg = f"Feedback search error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

tool_context.state[StateKeys.PAST_FEEDBACK] = []

return {

"status": "error",

"message": error_msg,

"feedback_found": False

}

👉 Trova:

# MODULE_5_STEP_4_UPDATE_GRADING_PROGRESS

👉 Sostituisci con lo strumento 2 - Monitoraggio dei voti (versione di produzione):

async def update_grading_progress(tool_context: ToolContext) -> Dict[str, Any]:

"""

Updates grading progress counters and metrics in state.

"""

logger.info("Tool: Updating grading progress...")

try:

current_time = datetime.now().isoformat()

# Build all state changes

state_updates = {}

# Temporary (invocation-level) state

state_updates[StateKeys.TEMP_PROCESSING_TIMESTAMP] = current_time

# Session-level state

attempts = tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 0) + 1

state_updates[StateKeys.GRADING_ATTEMPTS] = attempts

state_updates[StateKeys.LAST_GRADING_TIME] = current_time

# User-level persistent state

lifetime_submissions = tool_context.state.get(StateKeys.USER_TOTAL_SUBMISSIONS, 0) + 1

state_updates[StateKeys.USER_TOTAL_SUBMISSIONS] = lifetime_submissions

state_updates[StateKeys.USER_LAST_SUBMISSION_TIME] = current_time

# Calculate improvement metrics

current_style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

last_style_score = tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

score_improvement = current_style_score - last_style_score

state_updates[StateKeys.USER_LAST_STYLE_SCORE] = current_style_score

state_updates[StateKeys.SCORE_IMPROVEMENT] = score_improvement

# Track test results if available

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

if test_results and test_results.get('test_summary', {}).get('total_tests_run', 0) > 0:

summary = test_results['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

pass_rate = (passed / total) * 100

state_updates[StateKeys.USER_LAST_TEST_PASS_RATE] = pass_rate

# Apply all updates atomically

for key, value in state_updates.items():

tool_context.state[key] = value

logger.info(f"Tool: Progress updated - Attempt #{attempts}, "

f"Lifetime: {lifetime_submissions}")

return {

"status": "success",

"session_attempts": attempts,

"lifetime_submissions": lifetime_submissions,

"timestamp": current_time,

"improvement": {

"style_score_change": score_improvement,

"direction": "improved" if score_improvement > 0 else "declined"

},

"summary": f"Attempt #{attempts} recorded, {lifetime_submissions} total submissions"

}

except Exception as e:

error_msg = f"Progress update error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

return {

"status": "error",

"message": error_msg

}

👉 Trova:

# MODULE_5_STEP_4_SAVE_GRADING_REPORT

👉 Sostituisci con lo strumento 3 - Artifact Saver (versione di produzione):

async def save_grading_report(feedback_text: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Saves a detailed grading report as an artifact.

Args:

feedback_text: The feedback text to include in the report

tool_context: ADK tool context for state management

Returns:

Dictionary containing save status and details

"""

logger.info("Tool: Saving grading report...")

try:

# Gather all relevant data from state

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

analysis = tool_context.state.get(StateKeys.CODE_ANALYSIS, {})

style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

style_issues = tool_context.state.get(StateKeys.STYLE_ISSUES, [])

# Get test results

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

timestamp = datetime.now().isoformat()

# Create comprehensive report dictionary

report = {

'timestamp': timestamp,

'grading_attempt': tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 1),

'code': {

'content': code,

'line_count': len(code.splitlines()),

'hash': hashlib.md5(code.encode()).hexdigest()

},

'analysis': analysis,

'style': {

'score': style_score,

'issues': style_issues[:5] # First 5 issues

},

'tests': test_results,

'feedback': feedback_text,

'improvements': {

'score_change': tool_context.state.get(StateKeys.SCORE_IMPROVEMENT, 0),

'from_last_score': tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

}

}

# Convert report to JSON string

report_json = json.dumps(report, indent=2)

report_part = types.Part.from_text(text=report_json)

# Try to save as artifact if the service is available

if hasattr(tool_context, 'save_artifact'):

try:

# Generate filename with timestamp (replace colons for filesystem compatibility)

filename = f"grading_report_{timestamp.replace(':', '-')}.json"

# Save the main report

version = await tool_context.save_artifact(filename, report_part)

# Also save a "latest" version for easy access

await tool_context.save_artifact("latest_grading_report.json", report_part)

logger.info(f"Tool: Report saved as {filename} (version {version})")

# Store report in state as well for redundancy

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

return {

"status": "success",

"artifact_saved": True,

"filename": filename,

"version": str(version),

"size": len(report_json),

"summary": f"Report saved as {filename}"

}

except Exception as artifact_error:

logger.warning(f"Artifact service error: {artifact_error}, falling back to state storage")

# Continue to fallback below

# Fallback: Store in state if artifact service is not available or failed

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

logger.info("Tool: Report saved to state (artifact service not available)")

return {

"status": "success",

"artifact_saved": False,

"message": "Report saved to state only",

"size": len(report_json),

"summary": "Report saved to session state"

}

except Exception as e:

error_msg = f"Report save error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Still try to save minimal data to state

try:

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = {

'error': error_msg,

'feedback': feedback_text,

'timestamp': datetime.now().isoformat()

}

except:

pass

return {

"status": "error",

"message": error_msg,

"artifact_saved": False,

"summary": f"Failed to save report: {error_msg}"

}

Crea l'agente di sintesi

👉 Apri

code_review_assistant/sub_agents/review_pipeline/feedback_synthesizer.py

👉 Trova:

# MODULE_5_STEP_4_INSTRUCTION_PROVIDER

👉 Sostituisci con il fornitore delle istruzioni di produzione:

async def feedback_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code reviewer and mentor providing constructive, educational feedback.

CONTEXT FROM PREVIOUS AGENTS:

- Structure analysis summary: {structure_analysis_summary}

- Style check summary: {style_check_summary}

- Test execution summary: {test_execution_summary}

YOUR TASK requires these steps IN ORDER:

1. Call search_past_feedback tool with developer_id="default_user"

2. Call update_grading_progress tool with no parameters

3. Carefully analyze the test results to understand what really happened

4. Generate comprehensive feedback following the structure below

5. Call save_grading_report tool with the feedback_text parameter

6. Return the feedback as your final output

CRITICAL - Understanding Test Results:

The test_execution_summary contains structured JSON. Parse it carefully:

- tests_passed = Code worked correctly

- tests_failed = Code produced wrong output

- tests_with_errors = Code crashed

- critical_issues = Fundamental problems with the code

If critical_issues array contains items, these are serious bugs that need fixing.

Do NOT count discovering bugs as test successes.

FEEDBACK STRUCTURE TO FOLLOW:

## 📊 Summary

Provide an honest assessment. Be encouraging but truthful about problems found.

## ✅ Strengths

List 2-3 things done well, referencing specific code elements.

## 📈 Code Quality Analysis

### Structure & Organization

Comment on code organization, readability, and documentation.

### Style Compliance

Report the actual style score and any specific issues.

### Test Results

Report the actual test results accurately:

- If critical_issues exist, report them as bugs to fix

- Be clear: "X tests passed, Y critical issues were found"

- List each critical issue

- Don't hide or minimize problems

## 💡 Recommendations for Improvement

Based on the analysis, provide specific actionable fixes.

If critical issues exist, fixing them is top priority.

## 🎯 Next Steps

Prioritized action list based on severity of issues.

## 💬 Encouragement

End with encouragement while being honest about what needs fixing.

Remember: Complete ALL steps including calling save_grading_report."""

return await instructions_utils.inject_session_state(template, context)

👉 Trova:

# MODULE_5_STEP_4_SYNTHESIZER_AGENT

👉 Sostituisci con:

feedback_synthesizer_agent = Agent(

name="FeedbackSynthesizer",

model=config.critic_model,

description="Synthesizes all analysis into constructive, personalized feedback",

instruction=feedback_instruction_provider,

tools=[

FunctionTool(func=search_past_feedback),

FunctionTool(func=update_grading_progress),

FunctionTool(func=save_grading_report)

],

output_key="final_feedback"

)

Passaggio 5: collega la pipeline

Ora collega tutti e quattro gli agenti in una pipeline sequenziale e crea l'agente principale.

👉 Apri

code_review_assistant/agent.py

👉 Aggiungi le importazioni necessarie all'inizio del file (dopo le importazioni esistenti):

from google.adk.agents import Agent, SequentialAgent

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

Il file ora dovrebbe avere il seguente aspetto:

"""

Main agent orchestration for the Code Review Assistant.

"""

from google.adk.agents import Agent, SequentialAgent

from .config import config

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

# MODULE_5_STEP_5_CREATE_PIPELINE

# MODULE_6_STEP_5_CREATE_FIX_LOOP

# MODULE_6_STEP_5_UPDATE_ROOT_AGENT

👉 Trova:

# MODULE_5_STEP_5_CREATE_PIPELINE

👉 Sostituisci quella singola riga con:

# Create sequential pipeline

code_review_pipeline = SequentialAgent(

name="CodeReviewPipeline",

description="Complete code review pipeline with analysis, testing, and feedback",

sub_agents=[

code_analyzer_agent,

style_checker_agent,

test_runner_agent,

feedback_synthesizer_agent

]

)

# Root agent - coordinates the review pipeline

root_agent = Agent(

name="CodeReviewAssistant",

model=config.worker_model,

description="An intelligent code review assistant that analyzes Python code and provides educational feedback",

instruction="""You are a specialized Python code review assistant focused on helping developers improve their code quality.

When a user provides Python code for review:

1. Immediately delegate to CodeReviewPipeline and pass the code EXACTLY as it was provided by the user.

2. The pipeline will handle all analysis and feedback

3. Return ONLY the final feedback from the pipeline - do not add any commentary

When a user asks what you can do or asks general questions:

- Explain your capabilities for code review

- Do NOT trigger the pipeline for non-code messages

The pipeline handles everything for code review - just pass through its final output.""",

sub_agents=[code_review_pipeline],

output_key="assistant_response"

)

Passaggio 6: testa la pipeline completa

È il momento di vedere tutti e quattro gli agenti collaborare.

👉 Avvia il sistema:

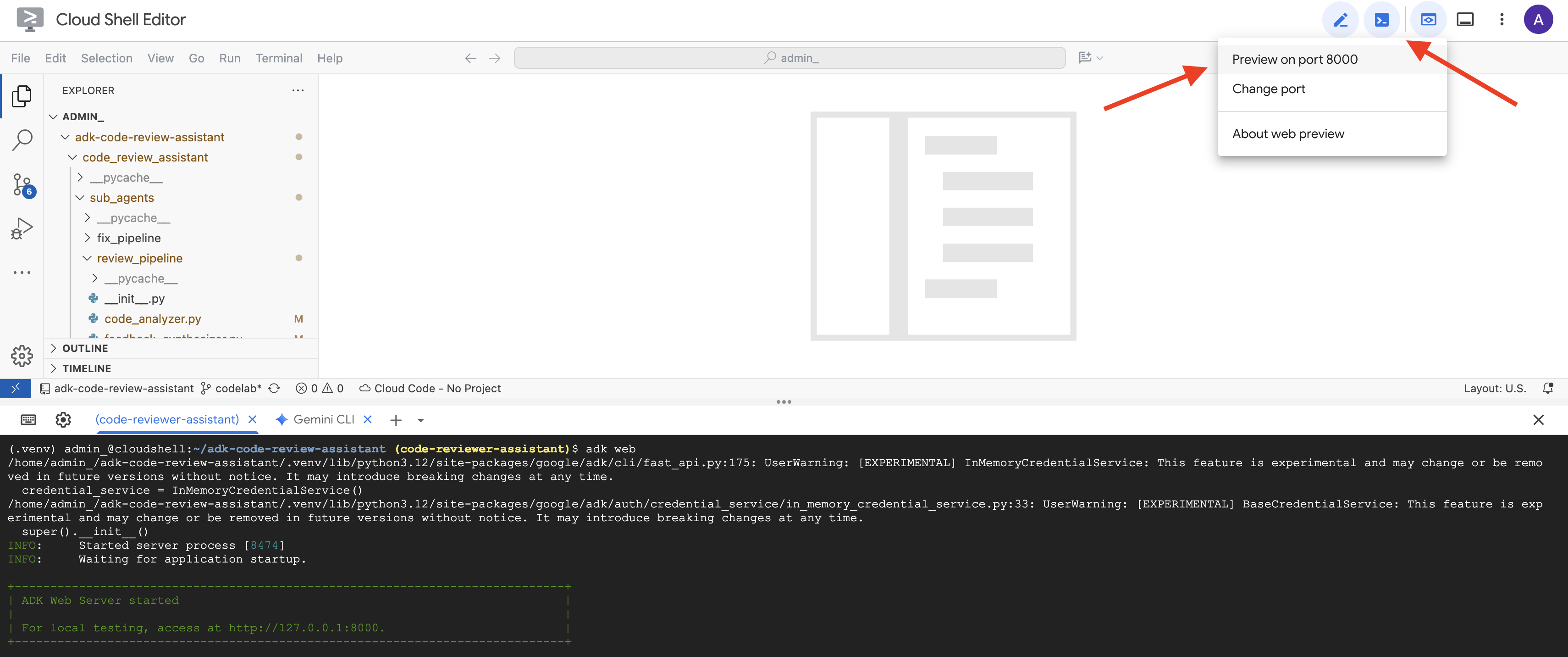

adk web code_review_assistant

Dopo aver eseguito il comando adk web, nel terminale dovresti visualizzare un output che indica che il server web ADK è stato avviato, simile a questo:

+-----------------------------------------------------------------------------+

| ADK Web Server started |

| |

| For local testing, access at http://localhost:8000. |

+-----------------------------------------------------------------------------+

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

👉 Successivamente, per accedere all'interfaccia utente per sviluppatori dell'ADK dal browser:

Dall'icona Anteprima web (spesso a forma di occhio o di quadrato con una freccia) nella barra degli strumenti di Cloud Shell (di solito in alto a destra), seleziona Cambia porta. Nella finestra popup, imposta la porta su 8000 e fai clic su "Cambia e visualizza anteprima". Cloud Shell aprirà quindi una nuova scheda o finestra del browser che mostra l'UI di ADK Dev.

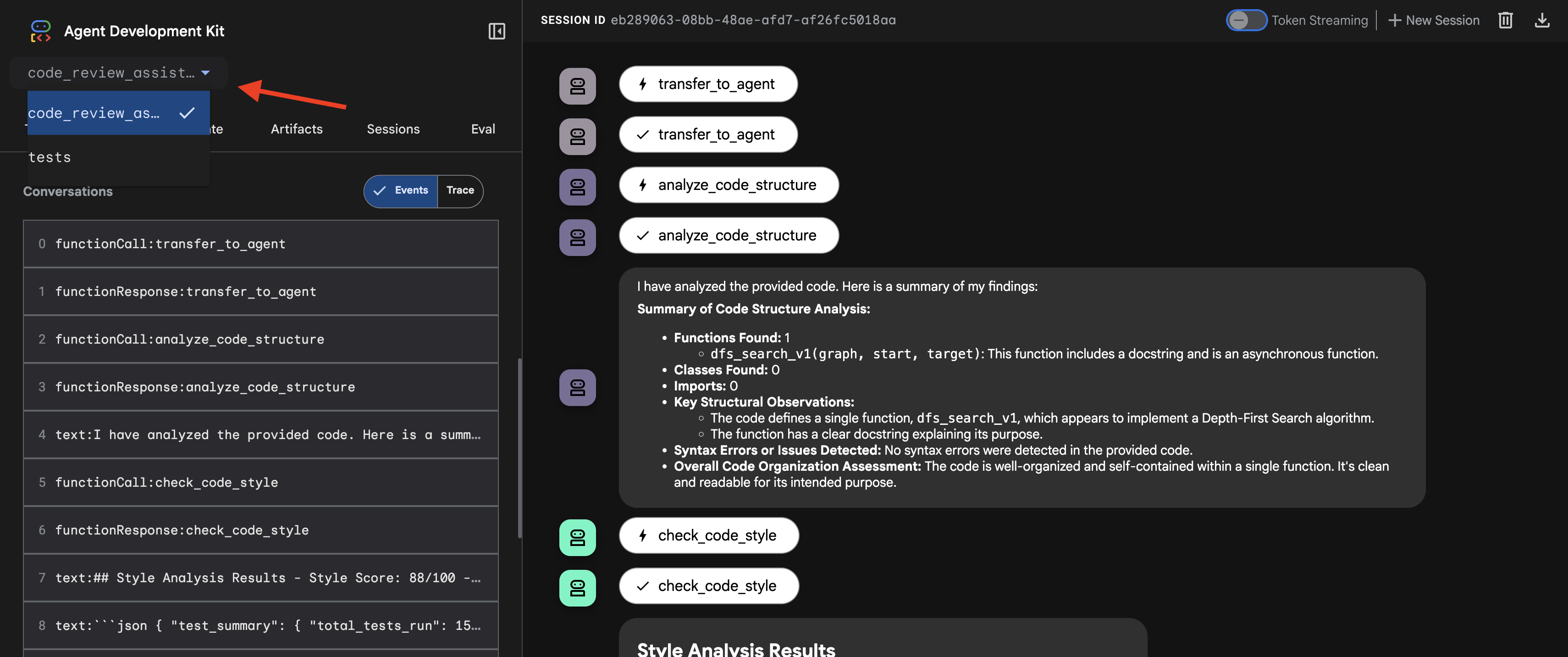

👉 L'agente è ora in esecuzione. La UI di sviluppo dell'ADK nel browser è la tua connessione diretta all'agente.

- Seleziona la destinazione: nel menu a discesa nella parte superiore della UI, scegli l'agente

code_review_assistant.

👉 Test Prompt:

Please analyze the following:

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

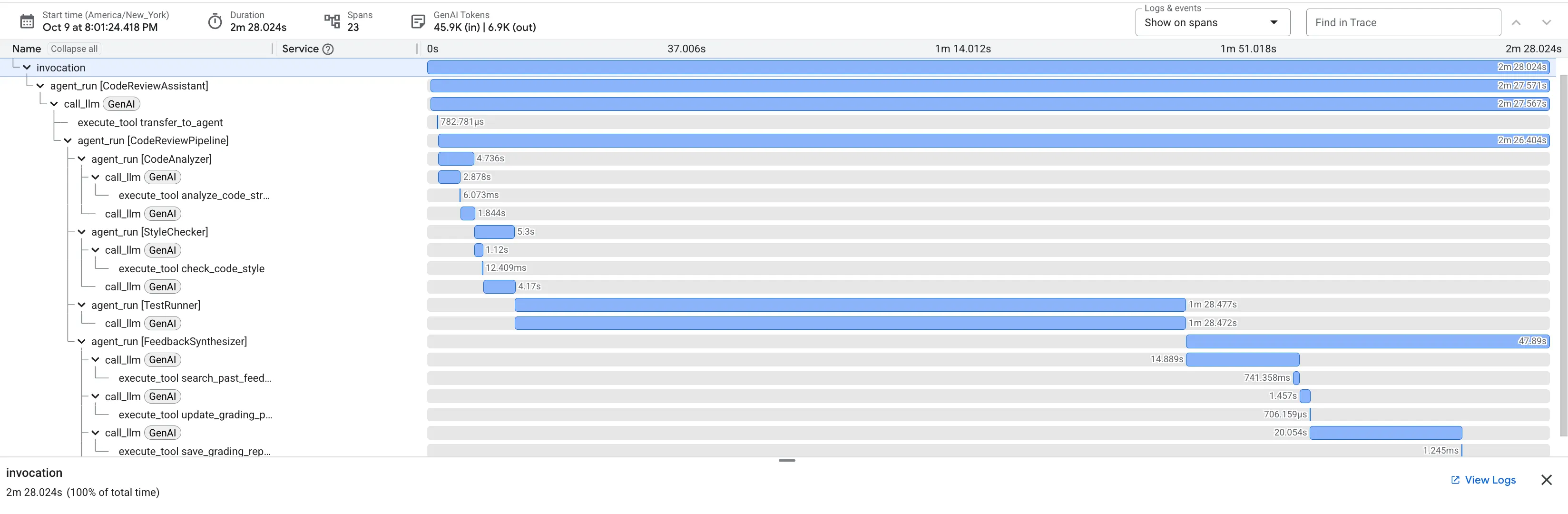

👉 Guarda la pipeline di revisione del codice in azione:

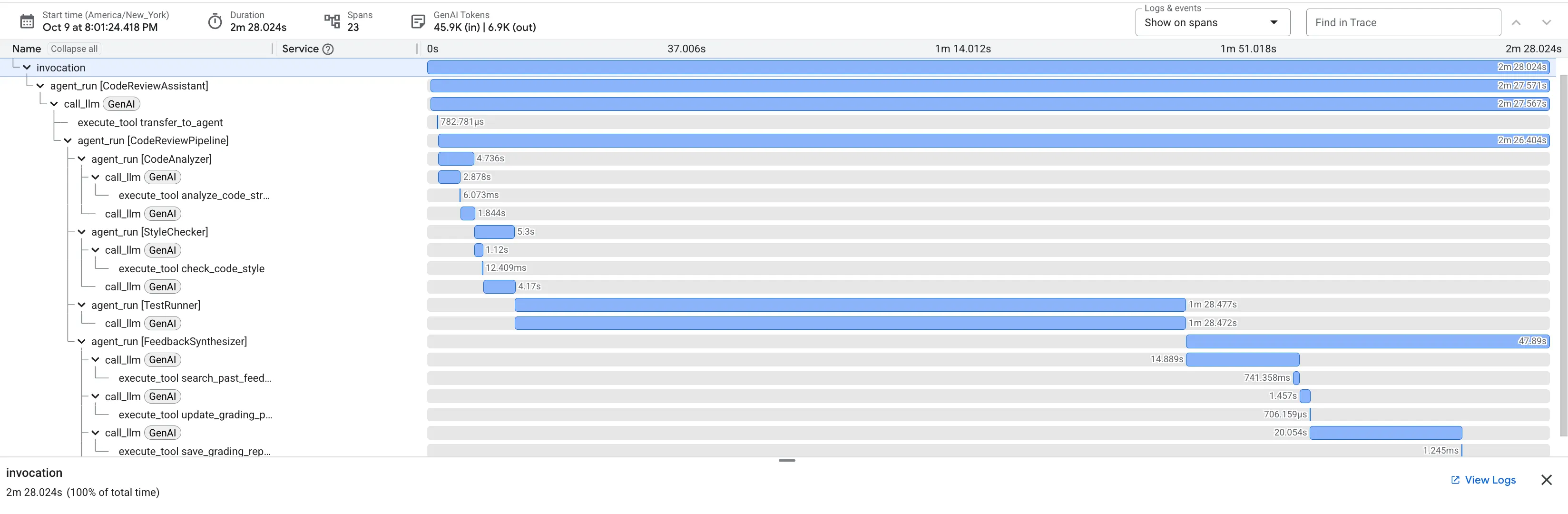

Quando invii la funzione dfs_search_v1 con bug, non ricevi una sola risposta. Stai assistendo al funzionamento della tua pipeline multi-agente. L'output di streaming che vedi è il risultato di quattro agenti specializzati che vengono eseguiti in sequenza, ognuno basato sul precedente.

Ecco una suddivisione del contributo di ciascun agente alla revisione finale e completa, che trasforma i dati non elaborati in informazioni fruibili.

1. Report strutturale di Code Analyzer

Innanzitutto, l'agente CodeAnalyzer riceve il codice non elaborato. Non indovina cosa fa il codice, ma utilizza lo strumento analyze_code_structure per eseguire un'analisi deterministica dell'albero della sintassi astratta (AST).

Il suo output è costituito da dati puri e oggettivi sulla struttura del codice:

The analysis of the provided code reveals the following:

Summary:

- Functions Found: 1

- Classes Found: 0

Key Structural Observations:

- A single function, dfs_search_v1, is defined.

- It includes a docstring: "Find if target is reachable from start."

- No syntax errors were detected.

Overall Code Organization Assessment:

- The code snippet is a well-defined, self-contained function.

⭐ Valore:questo passaggio iniziale fornisce una base pulita e affidabile per gli altri agenti. Conferma che il codice è Python valido e identifica i componenti esatti che devono essere esaminati.

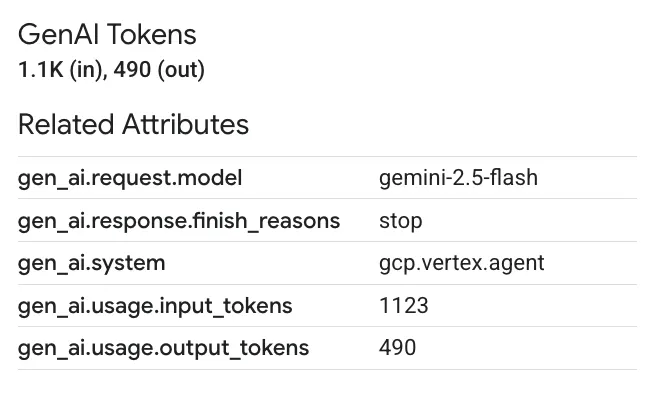

2. Controllo PEP 8 di Style Checker

A questo punto, interviene l'agente StyleChecker. Legge il codice dallo stato condiviso e utilizza lo strumento check_code_style, che sfrutta il linter pycodestyle.

Il suo output è un punteggio di qualità quantificabile e violazioni specifiche:

Style Analysis Results

- Style Score: 88/100

- Total Issues: 6

- Assessment: Good style with minor improvements needed

Top Style Issues

- Line 5, W293: blank line contains whitespace

- Line 19, W292: no newline at end of file

⭐ Valore:questo agente fornisce un feedback oggettivo e non negoziabile basato su standard della community consolidati (PEP 8). Il sistema di punteggio ponderato indica immediatamente all'utente la gravità dei problemi.

3. Rilevamento di bug critici di Test Runner

È qui che il sistema va oltre l'analisi superficiale. L'agente TestRunner genera ed esegue una suite completa di test per convalidare il comportamento del codice.

Il suo output è un oggetto JSON strutturato che contiene un verdetto condannatorio:

{

"critical_issues": [

{

"type": "Critical Bug",

"description": "The function's initialization `stack = start` is incorrect... When a common input like a string... is provided... the function crashes with an AttributeError.",

"severity": "Critical"

}

],

"verdict": {

"status": "BROKEN",

"confidence": "high",

"recommendation": "The function is fundamentally broken... the stack initialization line `stack = start` must be changed to `stack = [start]`."

}

}

⭐ Valore:questo è l'approfondimento più importante. L'agente non ha semplicemente indovinato, ma ha dimostrato che il codice non funzionava eseguendolo. Ha scoperto un bug di runtime sottile ma critico che un revisore umano potrebbe facilmente non notare e ha individuato la causa esatta e la correzione necessaria.

4. Report finale del sintetizzatore di feedback

Infine, l'agente FeedbackSynthesizer funge da direttore d'orchestra. Prende i dati strutturati dei tre agenti precedenti e crea un unico report intuitivo, analitico e incoraggiante.

Il suo output è la recensione finale e perfezionata che vedi:

📊 Summary

Great effort on implementing the Depth-First Search algorithm! ... However, a critical bug in the initialization of the stack prevents the function from working correctly...

✅ Strengths

- Good Algorithm Structure

- Correct Use of `visited` Set

📈 Code Quality Analysis

...

### Style Compliance

The style analysis returned a good score of 88/100.

...

### Test Results

The automated testing revealed a critical issue... The line `stack = start` directly assigns the input... which results in an `AttributeError`.

💡 Recommendations for Improvement

**Fix the Critical Stack Initialization Bug:**

- Incorrect Code: `stack = start`

- Correct Code: `stack = [start]`

💬 Encouragement

You are very close to a perfect implementation! The core logic of your DFS algorithm is sound, which is the hardest part.

⭐ Valore:questo agente trasforma i dati tecnici in un'esperienza utile e didattica. Dà la priorità al problema più importante (il bug), lo spiega chiaramente, fornisce la soluzione esatta e lo fa con un tono incoraggiante. Integra con successo i risultati di tutte le fasi precedenti in un insieme coeso e prezioso.

Questo processo in più fasi dimostra la potenza di una pipeline con agenti. Invece di una singola risposta monolitica, ottieni un'analisi a più livelli in cui ogni agente esegue un'attività specializzata e verificabile. Ciò porta a una revisione non solo approfondita, ma anche deterministica, affidabile e profondamente istruttiva.

👉💻 Al termine del test, torna al terminale dell'editor di Cloud Shell e premi Ctrl+C per interrompere l'interfaccia utente di ADK Dev.

Cosa hai creato

Ora hai una pipeline completa di revisione del codice che:

✅ Analizza la struttura del codice: analisi AST deterministica con funzioni di supporto

✅ Controlla lo stile: punteggio ponderato con convenzioni di denominazione

✅ Esegue test: generazione completa di test con output JSON strutturato

✅ Sintetizza il feedback: integra stato, memoria e artefatti

✅ Monitora l'avanzamento: stato a più livelli in invocazioni, sessioni e utenti

✅ Impara nel tempo: servizio di memoria per pattern tra sessioni

✅ Fornisce artefatti: report JSON scaricabili con audit trail completo

Concetti fondamentali padroneggiati

Pipeline sequenziali:

- Quattro agenti che eseguono in ordine rigoroso

- Ciascuno arricchisce lo stato per il successivo

- Le dipendenze determinano la sequenza di esecuzione

Production Patterns:

- Separazione delle funzioni helper (sincronizzazione nei pool di thread)

- Riduzione controllata (strategie di fallback)

- Gestione dello stato a più livelli (temporaneo/sessione/utente)

- Fornitori di istruzioni dinamiche (sensibili al contesto)

- Doppia archiviazione (ridondanza di artefatti e stato)

Stato come comunicazione:

- Le costanti evitano errori di battitura negli agenti

output_keyscrive riepiloghi dell'agente per lo stato- Gli agenti successivi leggono tramite StateKeys

- Il flusso di stato è lineare nella pipeline

Memoria e stato:

- Stato: dati della sessione corrente

- Memoria: pattern tra le sessioni

- Scopi diversi, durate diverse

Orchestrazione degli strumenti:

- Agenti con un solo strumento (analyzer, style_checker)

- Esecutori integrati (test_runner)

- Coordinamento multi-strumento (sintetizzatore)

Strategia di selezione del modello:

- Modello di worker: attività meccaniche (analisi, linting, routing)

- Modello di critica: attività di ragionamento (test, sintesi)

- Ottimizzazione dei costi tramite una selezione appropriata

Passaggi successivi

Nel modulo 6, creerai la pipeline di correzione:

- Architettura LoopAgent per la correzione iterativa

- Condizioni di uscita tramite escalation

- Accumulo di stato nelle iterazioni

- Logica di convalida e ripetizione

- Integrazione con la pipeline di revisione per offrire correzioni

Vedrai come gli stessi pattern di stato vengono scalati a flussi di lavoro iterativi complessi in cui gli agenti tentano più volte fino a quando non riescono e come coordinare più pipeline in una singola applicazione.

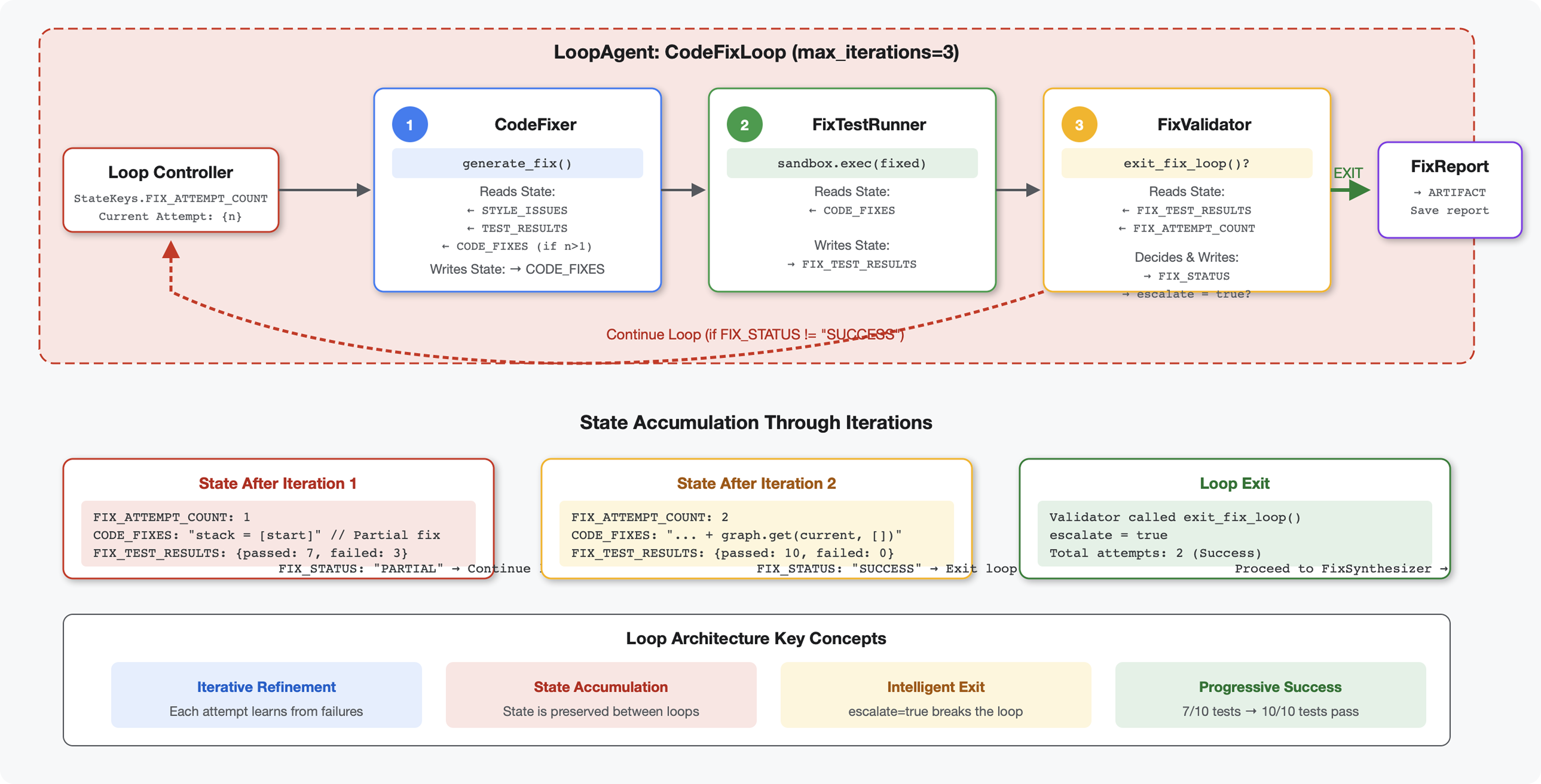

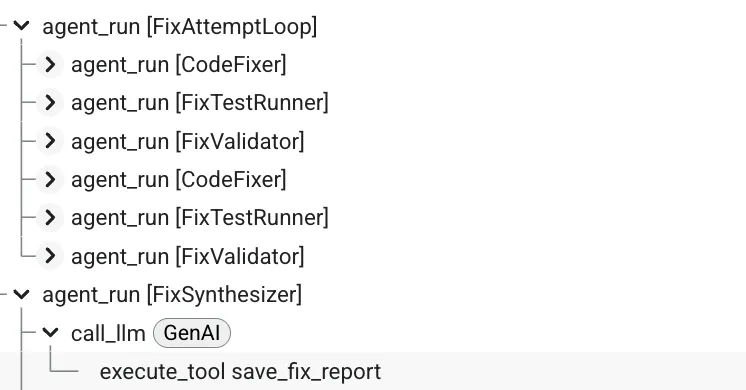

6. Aggiunta della pipeline di correzione: architettura del ciclo

Introduzione

Nel modulo 5, hai creato una pipeline di revisione sequenziale che analizza il codice e fornisce feedback. Tuttavia, identificare i problemi è solo metà della soluzione: gli sviluppatori hanno bisogno di aiuto per risolverli.

Questo modulo crea una pipeline di correzione automatizzata che:

- Genera correzioni in base ai risultati della revisione

- Convalida le correzioni eseguendo test completi

- Riprova automaticamente se le correzioni non funzionano (fino a 3 tentativi)

- Risultati dei report con confronti prima/dopo

Concetto chiave: LoopAgent per il nuovo tentativo automatico. A differenza degli agenti sequenziali che vengono eseguiti una sola volta, un LoopAgent ripete i suoi subagenti finché non viene soddisfatta una condizione di uscita o non viene raggiunto il numero massimo di iterazioni. Gli strumenti segnalano la riuscita impostando tool_context.actions.escalate = True.

Anteprima di ciò che creerai: invia codice con bug → la revisione identifica i problemi → il ciclo di correzione genera correzioni → i test convalidano → riprova se necessario → report finale completo.

Concetti principali: LoopAgent e Sequential

Sequential Pipeline (Module 5):

SequentialAgent(agents=[A, B, C])

# Executes: A → B → C → Done

- Flusso unidirezionale

- Ogni agente viene eseguito esattamente una volta

- Nessuna logica di nuovi tentativi

Loop Pipeline (Modulo 6):

LoopAgent(agents=[A, B, C], max_iterations=3)

# Executes: A → B → C → (check exit) → A → B → C → (check exit) → ...

- Flusso ciclico

- Gli agenti possono essere eseguiti più volte

- Uscite:

- Un set di strumenti imposta

tool_context.actions.escalate = True(successo) max_iterationsraggiunto (limite di sicurezza)- Si verifica un'eccezione non gestita (errore)

- Un set di strumenti imposta

Perché i loop per la correzione del codice:

Le correzioni del codice spesso richiedono più tentativi:

- Primo tentativo: correggere i bug evidenti (tipi di variabili errati)

- Secondo tentativo: risolvi i problemi secondari rivelati dai test (casi limite)

- Terzo tentativo: perfeziona e verifica che tutti i test vengano superati

Senza un ciclo, avresti bisogno di una logica condizionale complessa nelle istruzioni dell'agente. Con LoopAgent, il nuovo tentativo è automatico.

Confronto dell'architettura:

Sequential (Module 5):

User → Review Pipeline → Feedback → Done

Loop (Module 6):

User → Review Pipeline → Feedback → Fix Pipeline

↓

┌──────────────┴──────────────┐

│ Fix Attempt Loop (1-3x) │

│ ┌─────────────────────┐ │

│ │ 1. Generate Fixes │ │

│ │ 2. Test Fixes │ │

│ │ 3. Validate & Exit? │────┼─→ If escalate=True

│ └─────────────────────┘ │ exit loop

│ ↓ If not │

│ Try Again (max 3) │

└─────────────────────────────┘

↓

4. Synthesize Final Report → Done

Passaggio 1: aggiungi l'agente Code Fixer

Il correttore di codice genera codice Python corretto in base ai risultati della revisione.

👉 Apri

code_review_assistant/sub_agents/fix_pipeline/code_fixer.py

👉 Trova:

# MODULE_6_STEP_1_CODE_FIXER_INSTRUCTION_PROVIDER

👉 Sostituisci quella singola riga con:

async def code_fixer_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code fixing specialist.

Original Code:

{code_to_review}

Analysis Results:

- Style Score: {style_score}/100

- Style Issues: {style_issues}

- Test Results: {test_execution_summary}

Based on the test results, identify and fix ALL issues including:

- Interface bugs (e.g., if start parameter expects wrong type)

- Logic errors (e.g., KeyError when accessing graph nodes)

- Style violations

- Missing documentation

YOUR TASK:

Generate the complete fixed Python code that addresses all identified issues.

CRITICAL INSTRUCTIONS:

- Output ONLY the corrected Python code

- Do NOT include markdown code blocks (```python)

- Do NOT include any explanations or commentary

- The output should be valid, executable Python code and nothing else

Common fixes to apply based on test results:

- If tests show AttributeError with 'pop', fix: stack = [start] instead of stack = start

- If tests show KeyError accessing graph, fix: use graph.get(current, [])

- Add docstrings if missing

- Fix any style violations identified

Output the complete fixed code now:"""

return await instructions_utils.inject_session_state(template, context)

👉 Trova:

# MODULE_6_STEP_1_CODE_FIXER_AGENT

👉 Sostituisci quella singola riga con:

code_fixer_agent = Agent(

name="CodeFixer",

model=config.worker_model,

description="Generates comprehensive fixes for all identified code issues",

instruction=code_fixer_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="code_fixes"

)

Passaggio 2: aggiungi Fix Test Runner Agent

Il runner di test di correzione convalida le correzioni eseguendo test completi sul codice corretto.

👉 Apri

code_review_assistant/sub_agents/fix_pipeline/fix_test_runner.py

👉 Trova:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_INSTRUCTION_PROVIDER

👉 Sostituisci quella singola riga con:

async def fix_test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that uses the clean code from the previous step."""

template = """You are responsible for validating the fixed code by running tests.

THE FIXED CODE TO TEST:

{code_fixes}

ORIGINAL TEST RESULTS: {test_execution_summary}

YOUR TASK:

1. Understand the fixes that were applied

2. Generate the same comprehensive tests (15-20 test cases)

3. Execute the tests on the FIXED code using your code executor

4. Compare results with original test results

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Run the same tests that revealed issues in the original code

- Verify that previously failing tests now pass

- Ensure no regressions were introduced

- Document the improvement

Execute your tests and output ONLY valid JSON with this structure:

- "passed": number of tests that passed

- "failed": number of tests that failed

- "total": total number of tests

- "pass_rate": percentage as a number

- "comparison": object with "original_pass_rate", "new_pass_rate", "improvement"

- "newly_passing_tests": array of test names that now pass

- "still_failing_tests": array of test names still failing

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 Trova:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_AGENT

👉 Sostituisci quella singola riga con:

fix_test_runner_agent = Agent(

name="FixTestRunner",

model=config.critic_model,

description="Runs comprehensive tests on fixed code to verify all issues are resolved",

instruction=fix_test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="fix_test_execution_summary"

)

Passaggio 3: aggiungi l'agente di convalida delle correzioni

Il validatore controlla se le correzioni sono andate a buon fine e decide se uscire dal ciclo.

Informazioni sugli strumenti

Innanzitutto, aggiungi i tre strumenti necessari allo strumento di convalida.

👉 Apri

code_review_assistant/tools.py

👉 Trova:

# MODULE_6_STEP_3_VALIDATE_FIXED_STYLE

👉 Sostituisci con lo strumento 1 - Convalida stile:

async def validate_fixed_style(tool_context: ToolContext) -> Dict[str, Any]:

"""

Validates style compliance of the fixed code.

Args:

tool_context: ADK tool context containing fixed code in state

Returns:

Dictionary with style validation results

"""

logger.info("Tool: Validating style of fixed code...")

try:

# Get the fixed code from state

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Try to extract from markdown if present

if '```python' in code_fixes:

start = code_fixes.rfind('```python') + 9

end = code_fixes.rfind('```')

if start < end:

code_fixes = code_fixes[start:end].strip()

if not code_fixes:

return {

"status": "error",

"message": "No fixed code found in state"

}

# Store the extracted fixed code

tool_context.state[StateKeys.CODE_FIXES] = code_fixes

# Run style check on fixed code

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

style_result = await loop.run_in_executor(

executor, _perform_style_check, code_fixes

)

# Compare with original

original_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

improvement = style_result['score'] - original_score

# Store results

tool_context.state[StateKeys.FIXED_STYLE_SCORE] = style_result['score']

tool_context.state[StateKeys.FIXED_STYLE_ISSUES] = style_result['issues']

logger.info(f"Tool: Fixed code style score: {style_result['score']}/100 "

f"(improvement: +{improvement})")

return {

"status": "success",