1. การตรวจสอบโค้ดช่วงดึก

ตอนนี้เป็นเวลา 02:00 น.

คุณดีบักมาหลายชั่วโมงแล้ว ฟังก์ชันดูถูกต้อง แต่มีบางอย่างผิดพลาด คุณคงเคยรู้สึกว่าโค้ดควรทำงานได้ แต่กลับไม่ทำงาน และคุณก็ไม่รู้ว่าทำไมเพราะจ้องโค้ดนานเกินไป

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start # Looks innocent enough...

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

เส้นทางของนักพัฒนา AI

หากคุณกำลังอ่านข้อความนี้ แสดงว่าคุณอาจเคยสัมผัสการเปลี่ยนแปลงที่ AI นำมาสู่การเขียนโค้ดแล้ว เครื่องมืออย่าง Gemini Code Assist, Claude Code และ Cursor ได้เปลี่ยนวิธีที่เราเขียนโค้ด ซึ่งมีประโยชน์อย่างยิ่งในการสร้างข้อความมาตรฐาน แนะนำการติดตั้งใช้งาน และเร่งการพัฒนา

แต่คุณมาที่นี่เพราะต้องการเจาะลึก คุณต้องการทำความเข้าใจวิธีสร้างระบบ AI เหล่านี้ ไม่ใช่แค่ใช้ระบบ คุณต้องการสร้างสิ่งที่

- มีลักษณะการทำงานที่คาดการณ์ได้และติดตามได้

- สามารถนำไปใช้ในเวอร์ชันที่ใช้งานจริงได้อย่างมั่นใจ

- ให้ผลลัพธ์ที่สอดคล้องกันซึ่งคุณวางใจได้

- แสดงให้เห็นว่าโมเดลตัดสินใจอย่างไร

จากผู้บริโภคสู่ครีเอเตอร์

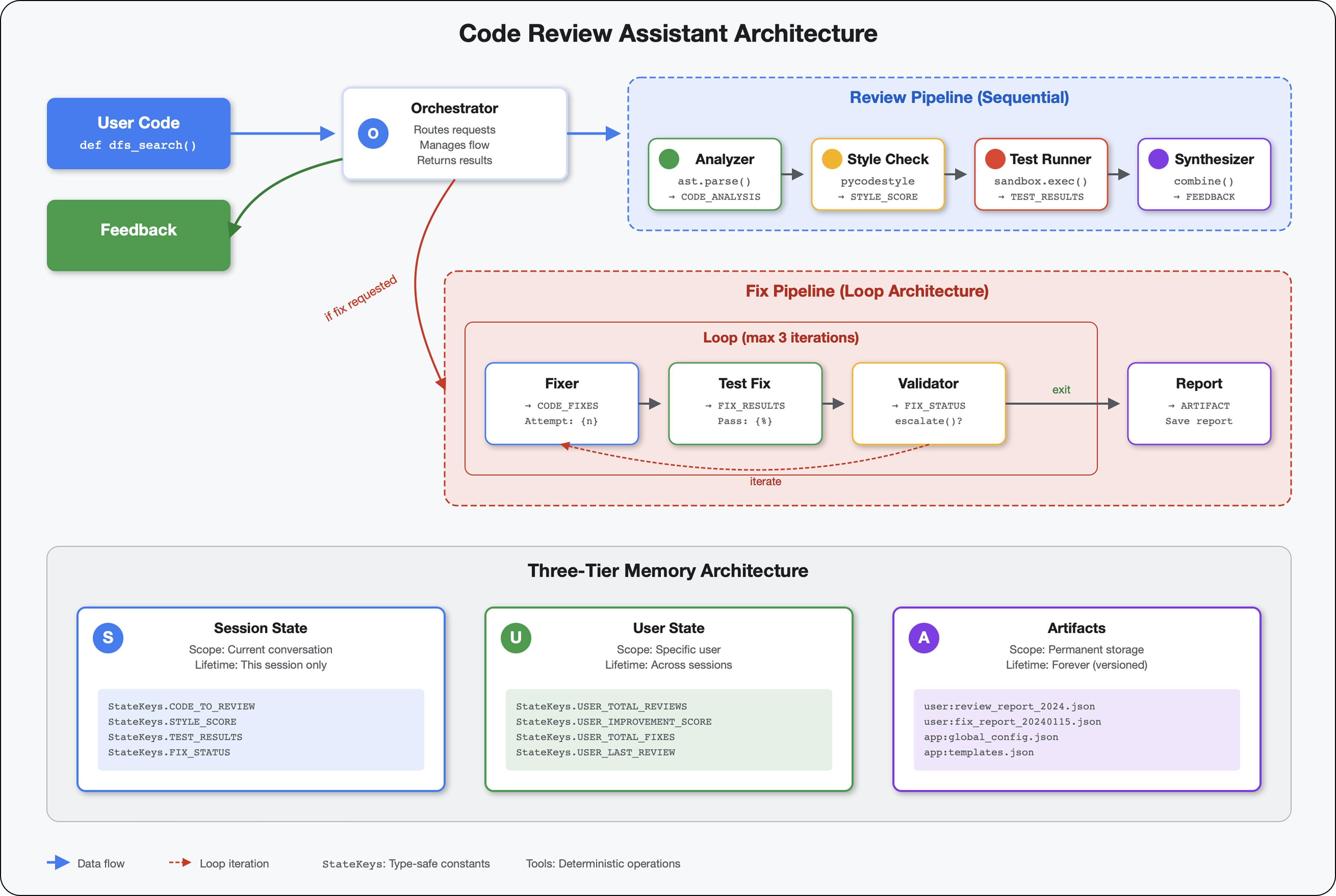

วันนี้คุณจะได้ก้าวกระโดดจากการใช้เครื่องมือ AI ไปสู่การสร้างเครื่องมือเหล่านั้น คุณจะสร้างระบบหลายเอเจนต์ซึ่งมีลักษณะดังนี้

- วิเคราะห์โครงสร้างโค้ดอย่างแน่นอน

- ดำเนินการทดสอบจริงเพื่อยืนยันลักษณะการทำงาน

- ตรวจสอบการปฏิบัติตามรูปแบบด้วย Linter จริง

- สังเคราะห์ผลการค้นหาเป็นความคิดเห็นที่นำไปใช้ได้

- ทำให้ใช้งานได้กับ Google Cloud โดยมีความสามารถในการสังเกตการณ์อย่างเต็มรูปแบบ

2. การติดตั้งใช้งาน Agent ครั้งแรก

คำถามของนักพัฒนาแอป

"ฉันเข้าใจ LLM และเคยใช้ API แต่จะเปลี่ยนจากสคริปต์ Python ไปเป็นเอเจนต์ AI ที่ใช้งานจริงซึ่งปรับขนาดได้ได้อย่างไร"

มาตอบคำถามนี้ด้วยการตั้งค่าสภาพแวดล้อมอย่างเหมาะสม จากนั้นสร้างเอเจนต์อย่างง่ายเพื่อทำความเข้าใจพื้นฐานก่อนที่จะเจาะลึกรูปแบบการใช้งานจริง

ตั้งค่าที่จำเป็นก่อน

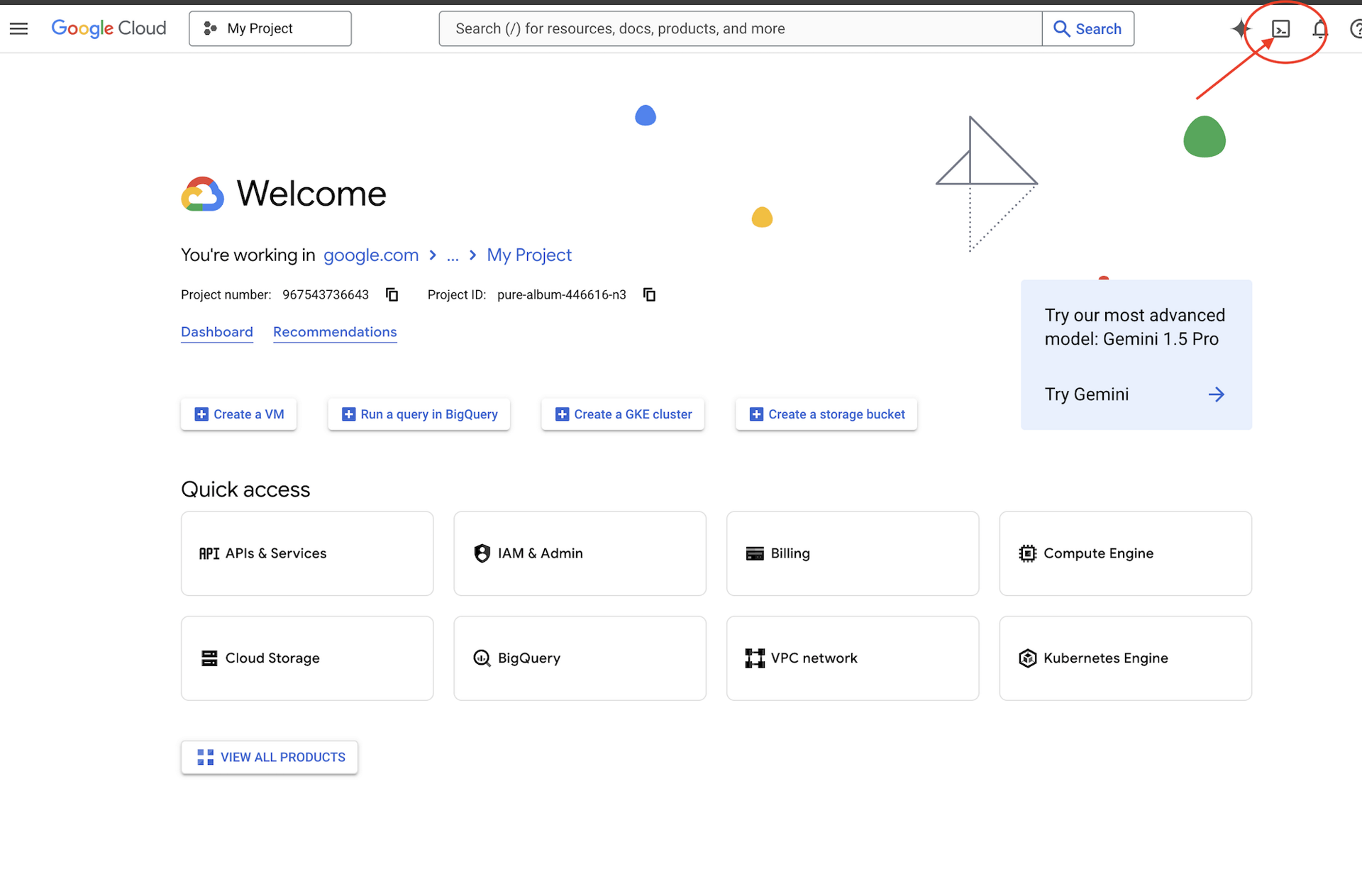

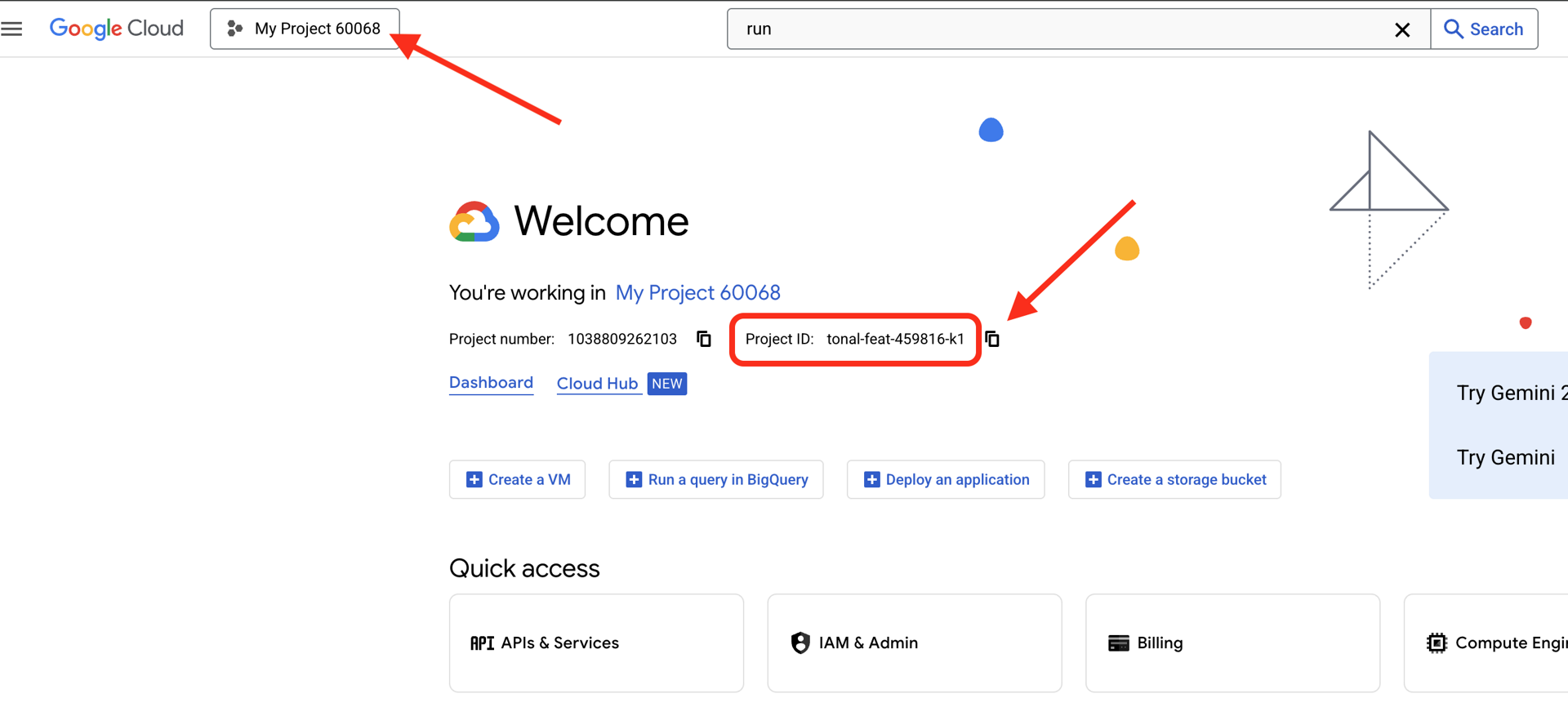

ก่อนที่จะสร้างเอเจนต์ เรามาตรวจสอบกันก่อนว่าสภาพแวดล้อม Google Cloud ของคุณพร้อมใช้งานแล้ว

หากต้องการเครดิต Google Cloud

คลิกเปิดใช้งาน Cloud Shell ที่ด้านบนของคอนโซล Google Cloud (เป็นไอคอนรูปเทอร์มินัลที่ด้านบนของแผง Cloud Shell)

ค้นหารหัสโปรเจ็กต์ Google Cloud

- เปิดคอนโซล Google Cloud: https://console.cloud.google.com

- เลือกโปรเจ็กต์ที่คุณต้องการใช้สำหรับเวิร์กช็อปนี้จากเมนูแบบเลื่อนลงของโปรเจ็กต์ที่ด้านบนของหน้า

- รหัสโปรเจ็กต์จะแสดงในการ์ดข้อมูลโปรเจ็กต์ในแดชบอร์ด

ขั้นตอนที่ 1: ตั้งค่ารหัสโปรเจ็กต์

ใน Cloud Shell ระบบได้กำหนดค่าเครื่องมือบรรทัดคำสั่ง gcloud ไว้แล้ว เรียกใช้คำสั่งต่อไปนี้เพื่อตั้งค่าโปรเจ็กต์ที่ใช้งานอยู่ ซึ่งใช้ตัวแปรสภาพแวดล้อม $GOOGLE_CLOUD_PROJECT ที่ระบบตั้งค่าให้คุณโดยอัตโนมัติในเซสชัน Cloud Shell

gcloud config set project $GOOGLE_CLOUD_PROJECT

ขั้นตอนที่ 2: ยืนยันการตั้งค่า

จากนั้นเรียกใช้คำสั่งต่อไปนี้เพื่อยืนยันว่าโปรเจ็กต์ได้รับการตั้งค่าอย่างถูกต้องและคุณได้รับการตรวจสอบสิทธิ์แล้ว

# Confirm project is set

echo "Current project: $(gcloud config get-value project)"

# Check authentication status

gcloud auth list

คุณจะเห็นรหัสโปรเจ็กต์ที่พิมพ์ออกมา และบัญชีผู้ใช้ของคุณจะแสดงพร้อมกับ (ACTIVE) ข้างบัญชี

หากบัญชีไม่ได้แสดงเป็นบัญชีที่ใช้งานอยู่ หรือหากคุณได้รับข้อผิดพลาดในการตรวจสอบสิทธิ์ ให้เรียกใช้คำสั่งต่อไปนี้เพื่อเข้าสู่ระบบ

gcloud auth application-default login

ขั้นตอนที่ 3: เปิดใช้ API ที่จำเป็น

เราต้องการ API เหล่านี้อย่างน้อยสำหรับตัวแทนพื้นฐาน

gcloud services enable \

aiplatform.googleapis.com \

compute.googleapis.com

อาจใช้เวลา 2-3 นาที คุณจะเห็นข้อมูลดังนี้

Operation "operations/..." finished successfully.

ขั้นตอนที่ 4: ติดตั้ง ADK

# Install the ADK CLI

pip install google-adk --upgrade

# Verify installation

adk --version

คุณควรเห็นหมายเลขเวอร์ชัน เช่น 1.15.0 ขึ้นไป

ตอนนี้สร้างเอเจนต์พื้นฐาน

เมื่อสภาพแวดล้อมพร้อมแล้ว มาสร้าง Agent อย่างง่ายกัน

ขั้นตอนที่ 5: ใช้ ADK Create

adk create my_first_agent

ทำตามข้อความแจ้งแบบอินเทอร์แอกทีฟ

Choose a model for the root agent:

1. gemini-2.5-flash

2. Other models (fill later)

Choose model (1, 2): 1

1. Google AI

2. Vertex AI

Choose a backend (1, 2): 2

Enter Google Cloud project ID [auto-detected-from-gcloud]:

Enter Google Cloud region [us-central1]:

ขั้นตอนที่ 6: ตรวจสอบสิ่งที่สร้างขึ้น

cd my_first_agent

ls -la

คุณจะเห็นไฟล์ 3 ไฟล์ ได้แก่

.env # Configuration (auto-populated with your project)

__init__.py # Package marker

agent.py # Your agent definition

ขั้นตอนที่ 7: ตรวจสอบการกำหนดค่าอย่างรวดเร็ว

# Verify the .env was created correctly

cat .env

# Should show something like:

# GOOGLE_CLOUD_PROJECT=your-project-id

# GOOGLE_CLOUD_LOCATION=us-central1

# GOOGLE_GENAI_USE_VERTEXAI=1

หากไม่มีรหัสโปรเจ็กต์หรือรหัสไม่ถูกต้อง ให้แก้ไขไฟล์ .env ดังนี้

nano .env # or use your preferred editor

ขั้นตอนที่ 8: ดูรหัสตัวแทน

cat agent.py

from google.adk.agents.llm_agent import Agent

root_agent = Agent(

model='gemini-2.5-flash',

name='root_agent',

description='A helpful assistant for user questions.',

instruction='Answer user questions to the best of your knowledge',

)

เรียบง่าย สะอาดตา และมินิมอล นี่คือ "Hello World" ของเอเจนต์

ทดสอบ Agent พื้นฐาน

ขั้นตอนที่ 9: เรียกใช้เอเจนต์

cd ..

adk run my_first_agent

คุณควรเห็นข้อความต่อไปนี้

Log setup complete: /tmp/agents_log/agent.20250930_162430.log

To access latest log: tail -F /tmp/agents_log/agent.latest.log

[user]:

ขั้นตอนที่ 10: ลองใช้คำค้นหา

คุณจะเห็นข้อความแจ้งในเทอร์มินัลที่ adk run กำลังทำงานอยู่ พิมพ์คำค้นหา

[user]: Hey, what can you do?

[root_agent]: I can help answer questions, generate text, explain concepts, assist with problem-solving, and provide information on a wide range of topics. What would you like to know or discuss?

[user]: What's the current weather in Mountain View?

[root_agent]: I'm sorry, but I cannot provide real-time weather information as I don't have access to current data or weather services. To get the current weather in Mountain View, I recommend checking a weather website or app like weather.com or using a search engine.

โปรดทราบข้อจำกัดที่ว่าโมเดลนี้ไม่สามารถเข้าถึงข้อมูลปัจจุบันได้ มาดูรายละเอียดกัน

[user]: Review this Python code: def add(a, b): return a + b

[root_agent]: This is a simple Python function that adds two numbers. Here's my review:

**Strengths:**

- Clean and concise implementation

- Follows Python conventions for simple operations

- Clear function name that describes its purpose

**Suggestions for improvement:**

- Add a docstring to document the function

- Consider adding type hints for better code clarity

- You might want to handle edge cases

Here's an enhanced version:

def add(a: float, b: float) -> float:

"""Add two numbers and return their sum."""

return a + b

ตัวแทนสามารถพูดคุยเรื่องโค้ดได้ แต่จะทำสิ่งต่อไปนี้ได้ไหม

- แยกวิเคราะห์ AST เพื่อทำความเข้าใจโครงสร้างจริงหรือไม่

- ทำการทดสอบเพื่อยืนยันว่าใช้งานได้ไหม

- ตรวจสอบการปฏิบัติตามข้อกำหนดด้านสไตล์ไหม

- คุณจำรีวิวที่เขียนก่อนหน้านี้ได้ไหม

ไม่ได้ เราต้องใช้สถาปัตยกรรม

🏃🚪 ออกด้วย

Ctrl+C

เมื่อสำรวจเสร็จแล้ว

3. การเตรียม Workspace สำหรับเวอร์ชันที่ใช้งานจริง

โซลูชัน: สถาปัตยกรรมที่พร้อมใช้งานจริง

เอเจนต์อย่างง่ายดังกล่าวแสดงให้เห็นจุดเริ่มต้น แต่ระบบการผลิตต้องมีโครงสร้างที่แข็งแกร่ง ตอนนี้เราจะตั้งค่าโปรเจ็กต์ที่สมบูรณ์ซึ่งรวบรวมหลักการผลิต

การวางรากฐาน

คุณได้กำหนดค่าโปรเจ็กต์ Google Cloud สำหรับเอเจนต์พื้นฐานแล้ว ตอนนี้เรามาเตรียมพื้นที่ทำงานสำหรับการผลิตเต็มรูปแบบด้วยเครื่องมือ รูปแบบ และโครงสร้างพื้นฐานทั้งหมดที่จำเป็นสำหรับระบบจริงกัน

ขั้นตอนที่ 1: รับโปรเจ็กต์ที่มีโครงสร้าง

ก่อนอื่น ให้ออกจาก adk run ที่กำลังทำงานด้วย Ctrl+C แล้วล้างข้อมูลโดยทำดังนี้

# Clean up the basic agent

cd ~ # Make sure you're not inside my_first_agent

rm -rf my_first_agent

# Get the production scaffold

git clone https://github.com/ayoisio/adk-code-review-assistant.git

cd adk-code-review-assistant

git checkout codelab

ขั้นตอนที่ 2: สร้างและเปิดใช้งานสภาพแวดล้อมเสมือน

# Create the virtual environment

python -m venv .venv

# Activate it

# On macOS/Linux:

source .venv/bin/activate

# On Windows:

# .venv\Scripts\activate

การยืนยัน: ตอนนี้พรอมต์ของคุณควรแสดง (.venv) ที่จุดเริ่มต้น

ขั้นตอนที่ 3: ติดตั้งการอ้างอิง

pip install -r code_review_assistant/requirements.txt

# Install the package in editable mode (enables imports)

pip install -e .

ซึ่งจะติดตั้งสิ่งต่อไปนี้

google-adk- เฟรมเวิร์ก ADKpycodestyle- สำหรับการตรวจสอบ PEP 8vertexai- สำหรับการติดตั้งใช้งานระบบคลาวด์- ทรัพยากร Dependency อื่นๆ ในการผลิต

โดยแฟล็ก -e จะช่วยให้คุณนำเข้าโมดูล code_review_assistant จากที่ใดก็ได้

ขั้นตอนที่ 4: กำหนดค่าสภาพแวดล้อม

# Copy the example environment file

cp .env.example .env

# Edit .env and replace the placeholders:

# - GOOGLE_CLOUD_PROJECT=your-project-id → your actual project ID

# - Keep other defaults as-is

การยืนยัน: ตรวจสอบการกำหนดค่า

cat .env

ควรแสดงข้อมูลต่อไปนี้

GOOGLE_CLOUD_PROJECT=your-actual-project-id

GOOGLE_CLOUD_LOCATION=us-central1

GOOGLE_GENAI_USE_VERTEXAI=TRUE

ขั้นตอนที่ 5: ตรวจสอบการตรวจสอบสิทธิ์

เนื่องจากคุณเรียกใช้ gcloud auth ไปแล้วก่อนหน้านี้ เรามาตรวจสอบกัน

# Check current authentication

gcloud auth list

# Should show your account with (ACTIVE)

# If not, run:

gcloud auth application-default login

ขั้นตอนที่ 6: เปิดใช้ API เพิ่มเติมในเวอร์ชันที่ใช้งานจริง

เราได้เปิดใช้ API พื้นฐานแล้ว จากนั้นเพิ่มคีย์การผลิตโดยทำดังนี้

gcloud services enable \

sqladmin.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

artifactregistry.googleapis.com \

storage.googleapis.com \

cloudtrace.googleapis.com

ซึ่งจะช่วยให้คุณทำสิ่งต่อไปนี้ได้

- ผู้ดูแลระบบ SQL: สำหรับ Cloud SQL หากใช้ Cloud Run

- Cloud Run: สำหรับการติดตั้งใช้งานแบบไร้เซิร์ฟเวอร์

- Cloud Build: สำหรับการติดตั้งใช้งานอัตโนมัติ

- Artifact Registry: สำหรับอิมเมจคอนเทนเนอร์

- Cloud Storage: สำหรับอาร์ติแฟกต์และการทดสอบ

- Cloud Trace: สำหรับการสังเกตการณ์

ขั้นตอนที่ 7: สร้างที่เก็บ Artifact Registry

การติดตั้งใช้งานของเราจะสร้างอิมเมจคอนเทนเนอร์ที่ต้องมีที่เก็บ

gcloud artifacts repositories create code-review-assistant-repo \

--repository-format=docker \

--location=us-central1 \

--description="Docker repository for Code Review Assistant"

คุณควรเห็นข้อมูลต่อไปนี้

Created repository [code-review-assistant-repo].

หากมีอยู่แล้ว (อาจมาจากการพยายามครั้งก่อน) ก็ไม่เป็นไร คุณจะเห็นข้อความแสดงข้อผิดพลาดที่สามารถละเว้นได้

ขั้นตอนที่ 8: ให้สิทธิ์ IAM

# Get your project number

PROJECT_NUMBER=$(gcloud projects describe $GOOGLE_CLOUD_PROJECT \

--format="value(projectNumber)")

# Define the service account

SERVICE_ACCOUNT="${PROJECT_NUMBER}@cloudbuild.gserviceaccount.com"

# Grant necessary roles

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/run.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/iam.serviceAccountUser"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/cloudsql.admin"

gcloud projects add-iam-policy-binding $GOOGLE_CLOUD_PROJECT \

--member="serviceAccount:${SERVICE_ACCOUNT}" \

--role="roles/storage.admin"

แต่ละคำสั่งจะแสดงผลดังนี้

Updated IAM policy for project [your-project-id].

สิ่งที่คุณทำสำเร็จ

ตอนนี้พื้นที่ทำงานเวอร์ชันที่ใช้งานจริงพร้อมใช้งานแล้ว

✅ กำหนดค่าและตรวจสอบสิทธิ์โปรเจ็กต์ Google Cloud แล้ว

✅ ทดสอบตัวแทนพื้นฐานเพื่อทำความเข้าใจข้อจำกัด

✅ โค้ดโปรเจ็กต์ที่มีตัวยึดตำแหน่งเชิงกลยุทธ์พร้อมแล้ว

✅ แยกการอ้างอิงในสภาพแวดล้อมเสมือน

✅ เปิดใช้ API ที่จำเป็นทั้งหมดแล้ว

✅ Container Registry พร้อมสำหรับการติดตั้งใช้งานแล้ว

✅ กำหนดค่าสิทธิ์ IAM อย่างถูกต้องแล้ว

✅ ตั้งค่าตัวแปรสภาพแวดล้อมอย่างถูกต้องแล้ว

ตอนนี้คุณก็พร้อมที่จะสร้างระบบ AI จริงด้วยเครื่องมือที่กำหนดได้ การจัดการสถานะ และสถาปัตยกรรมที่เหมาะสม

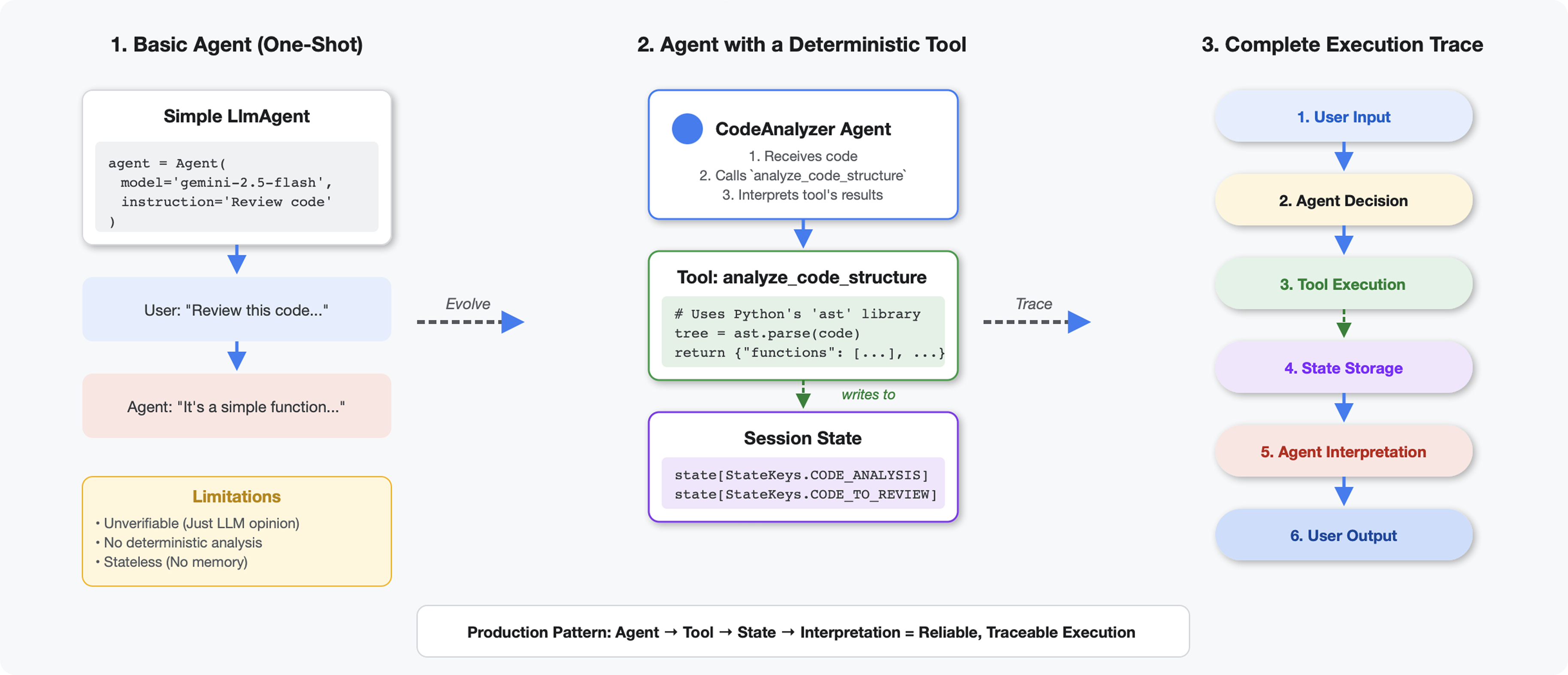

4. สร้างเอเจนต์ตัวแรก

สิ่งที่ทำให้เครื่องมือแตกต่างจาก LLM

เมื่อคุณถาม LLM ว่า "โค้ดนี้มีฟังก์ชันกี่ฟังก์ชัน" LLM จะใช้การจับคู่รูปแบบและการประมาณ เมื่อใช้เครื่องมือที่เรียกใช้ ast.parse() ของ Python เครื่องมือจะแยกวิเคราะห์โครงสร้างไวยากรณ์จริง ไม่ใช่การคาดเดา และให้ผลลัพธ์เดียวกันทุกครั้ง

ส่วนนี้จะสร้างเครื่องมือที่วิเคราะห์โครงสร้างโค้ดอย่างแน่นอน จากนั้นเชื่อมต่อกับเอเจนต์ที่รู้ว่าเมื่อใดควรเรียกใช้

ขั้นตอนที่ 1: ทำความเข้าใจโครงสร้าง

มาดูโครงสร้างที่คุณจะต้องกรอกกัน

👉 เปิด

code_review_assistant/tools.py

คุณจะเห็นฟังก์ชัน analyze_code_structure พร้อมความคิดเห็นตัวยึดตำแหน่งที่ระบุตำแหน่งที่คุณจะเพิ่มโค้ด ฟังก์ชันนี้มีโครงสร้างพื้นฐานอยู่แล้ว คุณจะปรับปรุงฟังก์ชันนี้ทีละขั้นตอน

ขั้นตอนที่ 2: เพิ่มที่เก็บข้อมูลสถานะ

ที่เก็บข้อมูลสถานะช่วยให้ตัวแทนอื่นๆ ในไปป์ไลน์เข้าถึงผลลัพธ์ของเครื่องมือได้โดยไม่ต้องเรียกใช้การวิเคราะห์อีกครั้ง

👉 ค้นหา:

# MODULE_4_STEP_2_ADD_STATE_STORAGE

👉 แทนที่บรรทัดเดียวด้วย

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

ขั้นตอนที่ 3: เพิ่มการแยกวิเคราะห์แบบไม่พร้อมกันด้วย Thread Pool

เครื่องมือของเราต้องแยกวิเคราะห์ AST โดยไม่บล็อกการดำเนินการอื่นๆ มาเพิ่มการดำเนินการแบบไม่พร้อมกันด้วย Thread Pool กัน

👉 ค้นหา:

# MODULE_4_STEP_3_ADD_ASYNC

👉 แทนที่บรรทัดเดียวด้วย

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

ขั้นตอนที่ 4: แยกข้อมูลที่ครอบคลุม

ตอนนี้เรามาแยกคลาส การนำเข้า และเมตริกแบบละเอียด ซึ่งเป็นทุกอย่างที่เราต้องการสำหรับการตรวจสอบโค้ดที่สมบูรณ์

👉 ค้นหา:

# MODULE_4_STEP_4_EXTRACT_DETAILS

👉 แทนที่บรรทัดเดียวด้วย

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

👉 ยืนยัน: ฟังก์ชัน

analyze_code_structure

ใน

tools.py

มีส่วนกลางที่มีลักษณะดังนี้

# Parse in thread pool to avoid blocking the event loop

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

tree = await loop.run_in_executor(executor, ast.parse, code)

# Extract comprehensive structural information

analysis = await loop.run_in_executor(

executor, _extract_code_structure, tree, code

)

# Store code and analysis for other agents to access

tool_context.state[StateKeys.CODE_TO_REVIEW] = code

tool_context.state[StateKeys.CODE_ANALYSIS] = analysis

tool_context.state[StateKeys.CODE_LINE_COUNT] = len(code.splitlines())

👉 ตอนนี้ให้เลื่อนไปที่ด้านล่างของ

tools.py

แล้วค้นหา

# MODULE_4_STEP_4_HELPER_FUNCTION

👉 แทนที่บรรทัดเดียวด้วยฟังก์ชันตัวช่วยที่สมบูรณ์:

def _extract_code_structure(tree: ast.AST, code: str) -> Dict[str, Any]:

"""

Helper function to extract structural information from AST.

Runs in thread pool for CPU-bound work.

"""

functions = []

classes = []

imports = []

docstrings = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

func_info = {

'name': node.name,

'args': [arg.arg for arg in node.args.args],

'lineno': node.lineno,

'has_docstring': ast.get_docstring(node) is not None,

'is_async': isinstance(node, ast.AsyncFunctionDef),

'decorators': [d.id for d in node.decorator_list

if isinstance(d, ast.Name)]

}

functions.append(func_info)

if func_info['has_docstring']:

docstrings.append(f"{node.name}: {ast.get_docstring(node)[:50]}...")

elif isinstance(node, ast.ClassDef):

methods = []

for item in node.body:

if isinstance(item, ast.FunctionDef):

methods.append(item.name)

class_info = {

'name': node.name,

'lineno': node.lineno,

'methods': methods,

'has_docstring': ast.get_docstring(node) is not None,

'base_classes': [base.id for base in node.bases

if isinstance(base, ast.Name)]

}

classes.append(class_info)

elif isinstance(node, ast.Import):

for alias in node.names:

imports.append({

'module': alias.name,

'alias': alias.asname,

'type': 'import'

})

elif isinstance(node, ast.ImportFrom):

imports.append({

'module': node.module or '',

'names': [alias.name for alias in node.names],

'type': 'from_import',

'level': node.level

})

return {

'functions': functions,

'classes': classes,

'imports': imports,

'docstrings': docstrings,

'metrics': {

'line_count': len(code.splitlines()),

'function_count': len(functions),

'class_count': len(classes),

'import_count': len(imports),

'has_main': any(f['name'] == 'main' for f in functions),

'has_if_main': '__main__' in code,

'avg_function_length': _calculate_avg_function_length(tree)

}

}

def _calculate_avg_function_length(tree: ast.AST) -> float:

"""Calculate average function length in lines."""

function_lengths = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

if hasattr(node, 'end_lineno') and hasattr(node, 'lineno'):

length = node.end_lineno - node.lineno + 1

function_lengths.append(length)

if function_lengths:

return sum(function_lengths) / len(function_lengths)

return 0.0

ขั้นตอนที่ 5: ติดต่อตัวแทน

ตอนนี้เราเชื่อมต่อเครื่องมือกับเอเจนต์ที่รู้ว่าเมื่อใดควรใช้เครื่องมือและวิธีตีความผลลัพธ์

👉 เปิด

code_review_assistant/sub_agents/review_pipeline/code_analyzer.py

👉 ค้นหา:

# MODULE_4_STEP_5_CREATE_AGENT

👉 แทนที่บรรทัดเดียวด้วยเอเจนต์เวอร์ชันที่ใช้งานจริงที่สมบูรณ์:

code_analyzer_agent = Agent(

name="CodeAnalyzer",

model=config.worker_model,

description="Analyzes Python code structure and identifies components",

instruction="""You are a code analysis specialist responsible for understanding code structure.

Your task:

1. Take the code submitted by the user (it will be provided in the user message)

2. Use the analyze_code_structure tool to parse and analyze it

3. Pass the EXACT code to your tool - do not modify, fix, or "improve" it

4. Identify all functions, classes, imports, and structural patterns

5. Note any syntax errors or structural issues

6. Store the analysis in state for other agents to use

CRITICAL:

- Pass the code EXACTLY as provided to the analyze_code_structure tool

- Do not fix syntax errors, even if obvious

- Do not add missing imports or fix indentation

- The goal is to analyze what IS there, not what SHOULD be there

When calling the tool, pass the code as a string to the 'code' parameter.

If the analysis fails due to syntax errors, clearly report the error location and type.

Provide a clear summary including:

- Number of functions and classes found

- Key structural observations

- Any syntax errors or issues detected

- Overall code organization assessment""",

tools=[FunctionTool(func=analyze_code_structure)],

output_key="structure_analysis_summary"

)

ทดสอบเครื่องมือวิเคราะห์โค้ด

ตอนนี้ให้ยืนยันว่าเครื่องมือวิเคราะห์ทำงานได้อย่างถูกต้อง

👉 เรียกใช้สคริปต์ทดสอบ:

python tests/test_code_analyzer.py

สคริปต์ทดสอบจะโหลดการกำหนดค่าจากไฟล์ .env โดยอัตโนมัติโดยใช้ python-dotenv จึงไม่จำเป็นต้องตั้งค่าตัวแปรสภาพแวดล้อมด้วยตนเอง

ผลลัพธ์ที่คาดไว้:

INFO:code_review_assistant.config:Code Review Assistant Configuration Loaded:

INFO:code_review_assistant.config: - GCP Project: your-project-id

INFO:code_review_assistant.config: - Artifact Bucket: gs://your-project-artifacts

INFO:code_review_assistant.config: - Models: worker=gemini-2.5-flash, critic=gemini-2.5-pro

Testing code analyzer...

INFO:code_review_assistant.tools:Tool: Analysis complete - 2 functions, 1 classes

=== Analyzer Response ===

The analysis of the provided code shows the following:

* **Functions Found:** 2

* `add(a, b)`: A global function at line 2.

* `multiply(self, x, y)`: A method within the `Calculator` class.

* **Classes Found:** 1

* `Calculator`: A class defined at line 5. Contains one method, `multiply`.

* **Imports:** 0

* **Structural Patterns:** The code defines one global function and one class

with a single method. Both are simple, each with a single return statement.

* **Syntax Errors/Issues:** No syntax errors detected.

* **Overall Code Organization:** The code is well-organized for its small size,

clearly defining a function and a class with a method.

สิ่งที่เพิ่งเกิดขึ้น

- สคริปต์ทดสอบโหลดการกำหนดค่า

.envโดยอัตโนมัติ analyze_code_structure()เครื่องมือของคุณแยกวิเคราะห์โค้ดโดยใช้ AST ของ Python_extract_code_structure()ตัวช่วยดึงฟังก์ชัน คลาส และเมตริก- ระบบจัดเก็บผลลัพธ์ไว้ในสถานะเซสชันโดยใช้ค่าคงที่

StateKeys - เอเจนต์ Code Analyzer ตีความผลลัพธ์และให้ข้อมูลสรุป

การแก้ปัญหา:

- "ไม่มีโมดูลชื่อ "code_review_assistant"": เรียกใช้

pip install -e .จากรูทของโปรเจ็กต์ - "ไม่มีอาร์กิวเมนต์อินพุตคีย์": ตรวจสอบว่า

.envมีGOOGLE_CLOUD_PROJECT,GOOGLE_CLOUD_LOCATIONและGOOGLE_GENAI_USE_VERTEXAI=true

สิ่งที่คุณสร้าง

ตอนนี้คุณมีเครื่องมือวิเคราะห์โค้ดที่พร้อมใช้งานจริงแล้ว ซึ่งมีคุณสมบัติดังนี้

✅ แยกวิเคราะห์ AST ของ Python จริง - กำหนดได้ ไม่ใช่การจับคู่รูปแบบ

✅ จัดเก็บผลลัพธ์ในสถานะ - เอเจนต์อื่นๆ สามารถเข้าถึงการวิเคราะห์ได้

✅ ทำงานแบบไม่พร้อมกัน - ไม่บล็อกเครื่องมืออื่นๆ

✅ ดึงข้อมูลที่ครอบคลุม - ฟังก์ชัน คลาส การนำเข้า เมตริก

✅ จัดการข้อผิดพลาดอย่างราบรื่น - รายงานข้อผิดพลาดทางไวยากรณ์พร้อมหมายเลขบรรทัด

✅ เชื่อมต่อกับเอเจนต์ - LLM รู้ว่าเมื่อใดและจะใช้อย่างไร

แนวคิดหลักที่เชี่ยวชาญ

เครื่องมือเทียบกับเอเจนต์:

- เครื่องมือจะทำงานแบบดีเทอร์มินิสติก (การแยกวิเคราะห์ AST)

- เอเจนต์จะตัดสินใจว่าจะใช้เครื่องมือเมื่อใดและตีความผลลัพธ์

ค่าที่ส่งคืนเทียบกับสถานะ:

- การตอบกลับ: สิ่งที่ LLM เห็นทันที

- สถานะ: สิ่งที่ยังคงอยู่สำหรับเอเจนต์รายอื่นๆ

ค่าคงที่ของคีย์สถานะ:

- ป้องกันการสะกดผิดในระบบหลายเอเจนต์

- ทำหน้าที่เป็นสัญญาในระหว่างเอเจนต์

- สำคัญเมื่อเอเจนต์แชร์ข้อมูล

Async + Thread Pools:

async defช่วยให้เครื่องมือหยุดการดำเนินการชั่วคราวได้- กลุ่มเทรดจะเรียกใช้การทำงานที่ต้องใช้ CPU มากในเบื้องหลัง

- ซึ่งจะช่วยให้ Event Loop ตอบสนองได้

ฟังก์ชันตัวช่วย:

- แยกผู้ช่วยการซิงค์ออกจากเครื่องมือแบบไม่พร้อมกัน

- ทำให้โค้ดทดสอบและนำกลับมาใช้ใหม่ได้

คำสั่งสำหรับตัวแทน

- วิธีการโดยละเอียดช่วยป้องกันข้อผิดพลาดที่พบบ่อยของ LLM

- ระบุอย่างชัดเจนว่าสิ่งใดที่ไม่ควรทำ (อย่าแก้ไขโค้ด)

- ล้างขั้นตอนเวิร์กโฟลว์เพื่อความสอดคล้องกัน

ขั้นตอนถัดไป

ในโมดูลที่ 5 คุณจะได้เพิ่มสิ่งต่อไปนี้

- เครื่องมือตรวจสอบสไตล์ที่อ่านโค้ดจากสถานะ

- โปรแกรมเรียกใช้การทดสอบที่เรียกใช้การทดสอบจริง

- เครื่องมือสังเคราะห์ความคิดเห็นที่รวมการวิเคราะห์ทั้งหมด

คุณจะเห็นว่าสถานะไหลผ่านไปตามไปป์ไลน์แบบลำดับได้อย่างไร และเหตุใดรูปแบบค่าคงที่จึงมีความสำคัญเมื่อเอเจนต์หลายรายอ่านและเขียนข้อมูลเดียวกัน

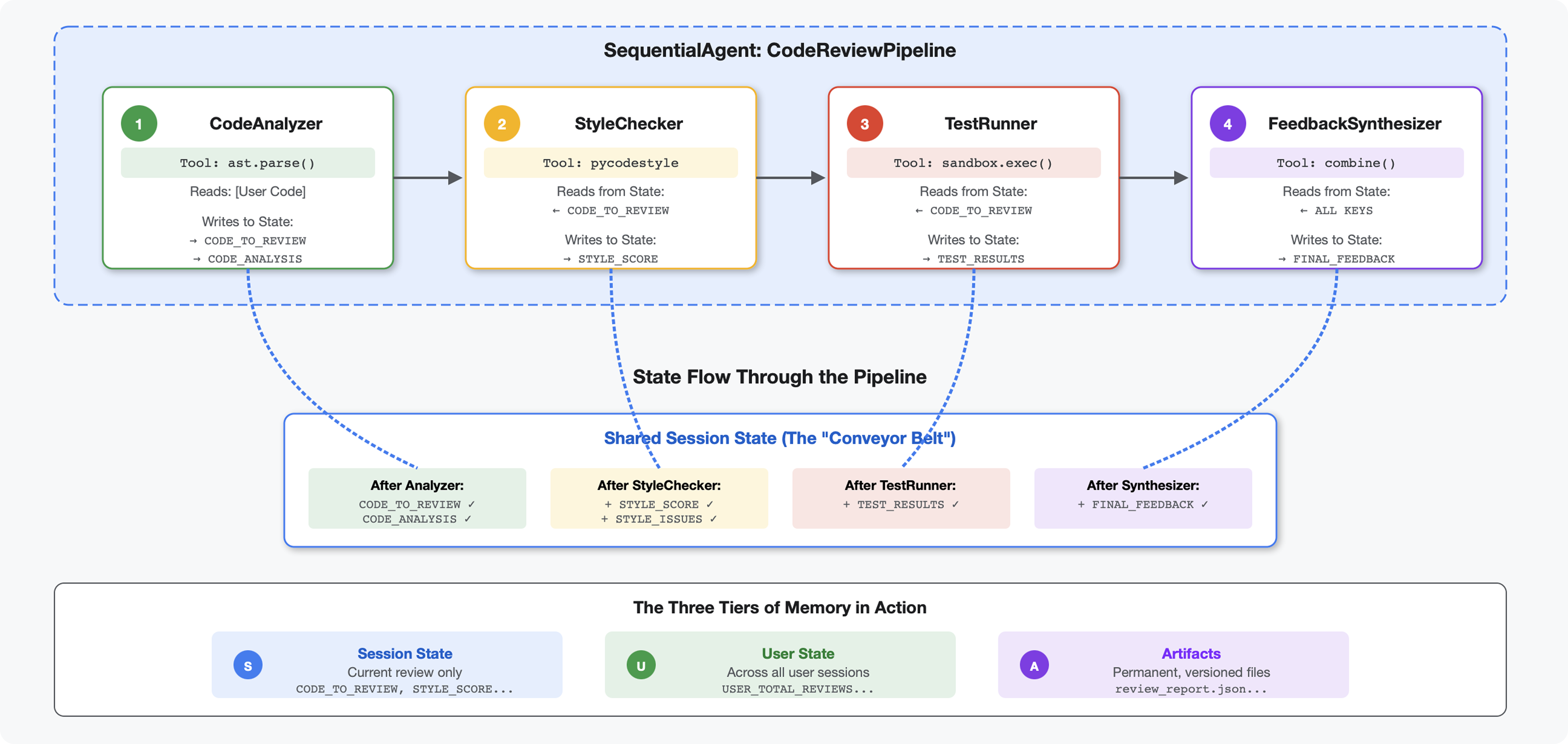

5. การสร้างไปป์ไลน์: ตัวแทนหลายรายทำงานร่วมกัน

บทนำ

ในโมดูลที่ 4 คุณได้สร้าง Agent เดียวที่วิเคราะห์โครงสร้างโค้ด แต่การตรวจสอบโค้ดอย่างละเอียดต้องใช้มากกว่าการแยกวิเคราะห์ คุณต้องตรวจสอบสไตล์ เรียกใช้การทดสอบ และสังเคราะห์ความคิดเห็นอัจฉริยะ

โมดูลนี้สร้างไปป์ไลน์ของ Agent 4 รายที่ทำงานร่วมกันตามลำดับ โดยแต่ละ Agent จะมีส่วนร่วมในการวิเคราะห์เฉพาะทาง ดังนี้

- เครื่องมือวิเคราะห์โค้ด (จากโมดูลที่ 4) - แยกวิเคราะห์โครงสร้าง

- เครื่องมือตรวจสอบสไตล์ - ระบุการละเมิดสไตล์

- Test Runner - ดำเนินการและตรวจสอบการทดสอบ

- เครื่องมือสังเคราะห์ความคิดเห็น - รวมทุกอย่างไว้ในความคิดเห็นที่นำไปใช้ได้

แนวคิดหลัก: สถานะเป็นช่องทางการสื่อสาร โดยเอเจนต์แต่ละตัวจะอ่านสิ่งที่เอเจนต์ก่อนหน้าเขียนเพื่อระบุสถานะ เพิ่มการวิเคราะห์ของตัวเอง และส่งต่อสถานะที่เพิ่มข้อมูลแล้วไปยังเอเจนต์ตัวถัดไป รูปแบบค่าคงที่จากโมดูลที่ 4 จะมีความสำคัญอย่างยิ่งเมื่อเอเจนต์หลายรายแชร์ข้อมูล

ตัวอย่างสิ่งที่คุณจะสร้าง: ส่งโค้ดที่ซับซ้อน → ดูสถานะที่ไหลผ่าน Agent 4 ตัว → รับรายงานที่ครอบคลุมพร้อมความคิดเห็นที่ปรับเปลี่ยนในแบบของคุณตามรูปแบบที่ผ่านมา

ขั้นตอนที่ 1: เพิ่มเครื่องมือตรวจสอบสไตล์ + เอเจนต์

เครื่องมือตรวจสอบรูปแบบจะระบุการละเมิด PEP 8 โดยใช้ pycodestyle ซึ่งเป็นโปรแกรมตรวจสอบโค้ดแบบดีเทอร์มินิสติก ไม่ใช่การตีความที่อิงตาม LLM

เพิ่มเครื่องมือตรวจสอบสไตล์

👉 เปิด

code_review_assistant/tools.py

👉 ค้นหา:

# MODULE_5_STEP_1_STYLE_CHECKER_TOOL

👉 แทนที่บรรทัดเดียวด้วย

async def check_code_style(code: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Checks code style compliance using pycodestyle (PEP 8).

Args:

code: Python source code to check (or will retrieve from state)

tool_context: ADK tool context

Returns:

Dictionary containing style score and issues

"""

logger.info("Tool: Checking code style...")

try:

# Retrieve code from state if not provided

if not code:

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

if not code:

return {

"status": "error",

"message": "No code provided or found in state"

}

# Run style check in thread pool

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

result = await loop.run_in_executor(

executor, _perform_style_check, code

)

# Store results in state

tool_context.state[StateKeys.STYLE_SCORE] = result['score']

tool_context.state[StateKeys.STYLE_ISSUES] = result['issues']

tool_context.state[StateKeys.STYLE_ISSUE_COUNT] = result['issue_count']

logger.info(f"Tool: Style check complete - Score: {result['score']}/100, "

f"Issues: {result['issue_count']}")

return result

except Exception as e:

error_msg = f"Style check failed: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Set default values on error

tool_context.state[StateKeys.STYLE_SCORE] = 0

tool_context.state[StateKeys.STYLE_ISSUES] = []

return {

"status": "error",

"message": error_msg,

"score": 0

}

👉 ตอนนี้ให้เลื่อนไปท้ายไฟล์แล้วค้นหา

# MODULE_5_STEP_1_STYLE_HELPERS

👉 แทนที่บรรทัดเดียวด้วยฟังก์ชันตัวช่วยดังนี้

def _perform_style_check(code: str) -> Dict[str, Any]:

"""Helper to perform style check in thread pool."""

import io

import sys

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as tmp:

tmp.write(code)

tmp_path = tmp.name

try:

# Capture stdout to get pycodestyle output

old_stdout = sys.stdout

sys.stdout = captured_output = io.StringIO()

style_guide = pycodestyle.StyleGuide(

quiet=False, # We want output

max_line_length=100,

ignore=['E501', 'W503']

)

result = style_guide.check_files([tmp_path])

# Restore stdout

sys.stdout = old_stdout

# Parse captured output

output = captured_output.getvalue()

issues = []

for line in output.strip().split('\n'):

if line and ':' in line:

parts = line.split(':', 4)

if len(parts) >= 4:

try:

issues.append({

'line': int(parts[1]),

'column': int(parts[2]),

'code': parts[3].split()[0] if len(parts) > 3 else 'E000',

'message': parts[3].strip() if len(parts) > 3 else 'Unknown error'

})

except (ValueError, IndexError):

pass

# Add naming convention checks

try:

tree = ast.parse(code)

naming_issues = _check_naming_conventions(tree)

issues.extend(naming_issues)

except SyntaxError:

pass # Syntax errors will be caught elsewhere

# Calculate weighted score

score = _calculate_style_score(issues)

return {

"status": "success",

"score": score,

"issue_count": len(issues),

"issues": issues[:10], # First 10 issues

"summary": f"Style score: {score}/100 with {len(issues)} violations"

}

finally:

if os.path.exists(tmp_path):

os.unlink(tmp_path)

def _check_naming_conventions(tree: ast.AST) -> List[Dict[str, Any]]:

"""Check PEP 8 naming conventions."""

naming_issues = []

for node in ast.walk(tree):

if isinstance(node, ast.FunctionDef):

# Skip private/protected methods and __main__

if not node.name.startswith('_') and node.name != node.name.lower():

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N802',

'message': f"N802 function name '{node.name}' should be lowercase"

})

elif isinstance(node, ast.ClassDef):

# Check if class name follows CapWords convention

if not node.name[0].isupper() or '_' in node.name:

naming_issues.append({

'line': node.lineno,

'column': node.col_offset,

'code': 'N801',

'message': f"N801 class name '{node.name}' should use CapWords convention"

})

return naming_issues

def _calculate_style_score(issues: List[Dict[str, Any]]) -> int:

"""Calculate weighted style score based on violation severity."""

if not issues:

return 100

# Define weights by error type

weights = {

'E1': 10, # Indentation errors

'E2': 3, # Whitespace errors

'E3': 5, # Blank line errors

'E4': 8, # Import errors

'E5': 5, # Line length

'E7': 7, # Statement errors

'E9': 10, # Syntax errors

'W2': 2, # Whitespace warnings

'W3': 2, # Blank line warnings

'W5': 3, # Line break warnings

'N8': 7, # Naming conventions

}

total_deduction = 0

for issue in issues:

code_prefix = issue['code'][:2] if len(issue['code']) >= 2 else 'E2'

weight = weights.get(code_prefix, 3)

total_deduction += weight

# Cap at 100 points deduction

return max(0, 100 - min(total_deduction, 100))

เพิ่ม Agent ตรวจสอบสไตล์

👉 เปิด

code_review_assistant/sub_agents/review_pipeline/style_checker.py

👉 ค้นหา:

# MODULE_5_STEP_1_INSTRUCTION_PROVIDER

👉 แทนที่บรรทัดเดียวด้วย

async def style_checker_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are a code style expert focused on PEP 8 compliance.

Your task:

1. Use the check_code_style tool to validate PEP 8 compliance

2. The tool will retrieve the ORIGINAL code from state automatically

3. Report violations exactly as found

4. Present the results clearly and confidently

CRITICAL:

- The tool checks the code EXACTLY as provided by the user

- Do not suggest the code was modified or fixed

- Report actual violations found in the original code

- If there are style issues, they should be reported honestly

Call the check_code_style tool with an empty string for the code parameter,

as the tool will retrieve the code from state automatically.

When presenting results based on what the tool returns:

- State the exact score from the tool results

- If score >= 90: "Excellent style compliance!"

- If score 70-89: "Good style with minor improvements needed"

- If score 50-69: "Style needs attention"

- If score < 50: "Significant style improvements needed"

List the specific violations found (the tool will provide these):

- Show line numbers, error codes, and messages

- Focus on the top 10 most important issues

Previous analysis: {structure_analysis_summary}

Format your response as:

## Style Analysis Results

- Style Score: [exact score]/100

- Total Issues: [count]

- Assessment: [your assessment based on score]

## Top Style Issues

[List issues with line numbers and descriptions]

## Recommendations

[Specific fixes for the most critical issues]"""

return await instructions_utils.inject_session_state(template, context)

👉 ค้นหา:

# MODULE_5_STEP_1_STYLE_CHECKER_AGENT

👉 แทนที่บรรทัดเดียวด้วย

style_checker_agent = Agent(

name="StyleChecker",

model=config.worker_model,

description="Checks Python code style against PEP 8 guidelines",

instruction=style_checker_instruction_provider,

tools=[FunctionTool(func=check_code_style)],

output_key="style_check_summary"

)

ขั้นตอนที่ 2: เพิ่ม Test Runner Agent

Test Runner จะสร้างการทดสอบที่ครอบคลุมและเรียกใช้โดยใช้ตัวดำเนินการโค้ดในตัว

👉 เปิด

code_review_assistant/sub_agents/review_pipeline/test_runner.py

👉 ค้นหา:

# MODULE_5_STEP_2_INSTRUCTION_PROVIDER

👉 แทนที่บรรทัดเดียวด้วย

async def test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects the code_to_review directly."""

template = """You are a testing specialist who creates and runs tests for Python code.

THE CODE TO TEST IS:

{code_to_review}

YOUR TASK:

1. Understand what the function appears to do based on its name and structure

2. Generate comprehensive tests (15-20 test cases)

3. Execute the tests using your code executor

4. Analyze results to identify bugs vs expected behavior

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Test with the most natural interpretation first

- When something fails, determine if it's a bug or unusual design

- Test edge cases, boundaries, and error scenarios

- Document any surprising behavior

Execute your tests and output ONLY valid JSON with this structure:

- "test_summary": object with "total_tests_run", "tests_passed", "tests_failed", "tests_with_errors", "critical_issues_found"

- "critical_issues": array of objects, each with "type", "description", "example_input", "expected_behavior", "actual_behavior", "severity"

- "test_categories": object with "basic_functionality", "edge_cases", "error_handling" (each containing "passed", "failed", "errors" counts)

- "function_behavior": object with "apparent_purpose", "actual_interface", "unexpected_requirements"

- "verdict": object with "status" (WORKING/BUGGY/BROKEN), "confidence" (high/medium/low), "recommendation"

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 ค้นหา:

# MODULE_5_STEP_2_TEST_RUNNER_AGENT

👉 แทนที่บรรทัดเดียวด้วย

test_runner_agent = Agent(

name="TestRunner",

model=config.critic_model,

description="Generates and runs tests for Python code using safe code execution",

instruction=test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="test_execution_summary"

)

ขั้นตอนที่ 3: ทำความเข้าใจหน่วยความจำสำหรับการเรียนรู้ข้ามเซสชัน

ก่อนที่จะสร้างเครื่องมือสังเคราะห์ความคิดเห็น คุณต้องเข้าใจความแตกต่างระหว่างสถานะและหน่วยความจำ ซึ่งเป็นกลไกการจัดเก็บข้อมูล 2 แบบที่มีวัตถุประสงค์แตกต่างกัน

สถานะเทียบกับหน่วยความจำ: ความแตกต่างที่สำคัญ

มาดูตัวอย่างที่ชัดเจนจากการตรวจสอบโค้ดกัน

รัฐ (เซสชันปัจจุบันเท่านั้น):

# Data from THIS review session

tool_context.state[StateKeys.STYLE_ISSUES] = [

{"line": 5, "code": "E231", "message": "missing whitespace"},

{"line": 12, "code": "E701", "message": "multiple statements"}

]

- ขอบเขต: การสนทนานี้เท่านั้น

- จุดประสงค์: ส่งข้อมูลระหว่างเอเจนต์ในไปป์ไลน์ปัจจุบัน

- อาศัยอยู่ใน: ออบเจ็กต์

Session - ตลอดอายุการใช้งาน: ทิ้งเมื่อเซสชันสิ้นสุด

หน่วยความจำ (เซสชันที่ผ่านมาทั้งหมด):

# Learned from 50 previous reviews

"User frequently forgets docstrings on helper functions"

"User tends to write long functions (avg 45 lines)"

"User improved error handling after feedback in session #23"

- ขอบเขต: เซสชันที่ผ่านมาทั้งหมดของผู้ใช้รายนี้

- วัตถุประสงค์: เรียนรู้รูปแบบ ให้ความคิดเห็นเฉพาะบุคคล

- อาศัยอยู่ใน:

MemoryService - ตลอดอายุการใช้งาน: คงอยู่ตลอดเซสชัน ค้นหาได้

เหตุผลที่ต้องมีทั้งความคิดเห็นเชิงบวกและเชิงลบ

ลองนึกภาพว่าซินธิไซเซอร์สร้างฟีดแบ็ก

ใช้เฉพาะรัฐ (การตรวจสอบปัจจุบัน):

"Function `calculate_total` has no docstring."

ความคิดเห็นเชิงกลทั่วไป

การใช้สถานะ + หน่วยความจำ (รูปแบบปัจจุบัน + รูปแบบในอดีต):

"Function `calculate_total` has no docstring. This is the 4th review

where helper functions lacked documentation. Consider adding docstrings

as you write functions, not afterwards - you mentioned in our last

session that you find it easier that way."

การปรับเปลี่ยนในแบบของคุณตามบริบทและการปรับปรุงการอ้างอิงเมื่อเวลาผ่านไป

สำหรับการติดตั้งใช้งานเวอร์ชันที่ใช้งานจริง คุณมีตัวเลือกดังนี้

ตัวเลือกที่ 1: VertexAiMemoryBankService (ขั้นสูง)

- สิ่งที่ทำ: การดึงข้อเท็จจริงที่มีความหมายจากการสนทนาโดยใช้ LLM

- ค้นหา: การค้นหาเชิงความหมาย (เข้าใจความหมาย ไม่ใช่แค่คีย์เวิร์ด)

- การจัดการความทรงจำ: รวมและอัปเดตความทรงจำโดยอัตโนมัติตามกาลเวลา

- ต้องมี: โปรเจ็กต์ Google Cloud + การตั้งค่า Agent Engine

- ใช้เมื่อ คุณต้องการความทรงจำที่ซับซ้อน มีการพัฒนา และปรับเปลี่ยนในแบบของคุณ

- ตัวอย่าง: "ผู้ใช้ชอบการเขียนโปรแกรมเชิงฟังก์ชัน" (ดึงข้อมูลจาก 10 การสนทนาเกี่ยวกับรูปแบบโค้ด)

ตัวเลือกที่ 2: ใช้ InMemoryMemoryService + เซสชันแบบถาวรต่อไป

- การทำงาน: จัดเก็บประวัติการสนทนาทั้งหมดสำหรับการค้นหาคีย์เวิร์ด

- ค้นหา: การทำงานของคีย์เวิร์ดพื้นฐานในเซสชันที่ผ่านมา

- การจัดการหน่วยความจำ: คุณควบคุมได้ว่าจะจัดเก็บอะไร (ผ่าน

add_session_to_memory) - ข้อกำหนด: เฉพาะ

SessionServiceแบบถาวร (เช่นVertexAiSessionServiceหรือDatabaseSessionService) - ใช้เมื่อ: คุณต้องการค้นหาแบบง่ายๆ ในการสนทนาที่ผ่านมาโดยไม่ต้องประมวลผล LLM

- ตัวอย่าง: การค้นหา "docstring" จะแสดงเซสชันทั้งหมดที่พูดถึงคำดังกล่าว

วิธีป้อนข้อมูลความทรงจำ

หลังจากที่การตรวจสอบโค้ดแต่ละครั้งเสร็จสมบูรณ์แล้ว

# At the end of a session (typically in your application code)

await memory_service.add_session_to_memory(session)

สิ่งที่จะเกิดขึ้น

- InMemoryMemoryService: จัดเก็บเหตุการณ์เซสชันทั้งหมดสําหรับการค้นหาคีย์เวิร์ด

- VertexAiMemoryBankService: LLM จะดึงข้อเท็จจริงที่สำคัญและรวมเข้ากับความทรงจำที่มีอยู่

จากนั้นเซสชันในอนาคตจะค้นหาได้ดังนี้

# In a tool, search for relevant past feedback

results = tool_context.search_memory("feedback about docstrings")

ขั้นตอนที่ 4: เพิ่มเครื่องมือและเอเจนต์สรุปความคิดเห็น

เครื่องมือสังเคราะห์ความคิดเห็นเป็นเอเจนต์ที่ซับซ้อนที่สุดในไปป์ไลน์ โดยจะประสานงานเครื่องมือ 3 อย่าง ใช้คำสั่งแบบไดนามิก และรวมสถานะ หน่วยความจำ และอาร์ติแฟกต์

เพิ่มเครื่องมือ Synthesizer ทั้ง 3 รายการ

👉 เปิด

code_review_assistant/tools.py

👉 ค้นหา:

# MODULE_5_STEP_4_SEARCH_PAST_FEEDBACK

👉 แทนที่ด้วยเครื่องมือ 1 - การค้นหาหน่วยความจำ (เวอร์ชันที่ใช้งานจริง):

async def search_past_feedback(developer_id: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Search for past feedback in memory service.

Args:

developer_id: ID of the developer (defaults to "default_user")

tool_context: ADK tool context with potential memory service access

Returns:

Dictionary containing feedback search results

"""

logger.info(f"Tool: Searching for past feedback for developer {developer_id}...")

try:

# Default developer ID if not provided

if not developer_id:

developer_id = tool_context.state.get(StateKeys.USER_ID, 'default_user')

# Check if memory service is available

if hasattr(tool_context, 'search_memory'):

try:

# Perform structured searches

queries = [

f"developer:{developer_id} code review feedback",

f"developer:{developer_id} common issues",

f"developer:{developer_id} improvements"

]

all_feedback = []

patterns = {

'common_issues': [],

'improvements': [],

'strengths': []

}

for query in queries:

search_result = await tool_context.search_memory(query)

if search_result and hasattr(search_result, 'memories'):

for memory in search_result.memories[:5]:

memory_text = memory.text if hasattr(memory, 'text') else str(memory)

all_feedback.append(memory_text)

# Extract patterns

if 'style' in memory_text.lower():

patterns['common_issues'].append('style compliance')

if 'improved' in memory_text.lower():

patterns['improvements'].append('showing improvement')

if 'excellent' in memory_text.lower():

patterns['strengths'].append('consistent quality')

# Store in state

tool_context.state[StateKeys.PAST_FEEDBACK] = all_feedback

tool_context.state[StateKeys.FEEDBACK_PATTERNS] = patterns

logger.info(f"Tool: Found {len(all_feedback)} past feedback items")

return {

"status": "success",

"feedback_found": True,

"count": len(all_feedback),

"summary": " | ".join(all_feedback[:3]) if all_feedback else "No feedback",

"patterns": patterns

}

except Exception as e:

logger.warning(f"Tool: Memory search error: {e}")

# Fallback: Check state for cached feedback

cached_feedback = tool_context.state.get(StateKeys.USER_PAST_FEEDBACK_CACHE, [])

if cached_feedback:

tool_context.state[StateKeys.PAST_FEEDBACK] = cached_feedback

return {

"status": "success",

"feedback_found": True,

"count": len(cached_feedback),

"summary": "Using cached feedback",

"patterns": {}

}

# No feedback found

tool_context.state[StateKeys.PAST_FEEDBACK] = []

logger.info("Tool: No past feedback found")

return {

"status": "success",

"feedback_found": False,

"message": "No past feedback available - this appears to be a first submission",

"patterns": {}

}

except Exception as e:

error_msg = f"Feedback search error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

tool_context.state[StateKeys.PAST_FEEDBACK] = []

return {

"status": "error",

"message": error_msg,

"feedback_found": False

}

👉 ค้นหา:

# MODULE_5_STEP_4_UPDATE_GRADING_PROGRESS

👉 แทนที่ด้วยเครื่องมือ 2 - ตัวติดตามการให้คะแนน (เวอร์ชันที่ใช้งานจริง):

async def update_grading_progress(tool_context: ToolContext) -> Dict[str, Any]:

"""

Updates grading progress counters and metrics in state.

"""

logger.info("Tool: Updating grading progress...")

try:

current_time = datetime.now().isoformat()

# Build all state changes

state_updates = {}

# Temporary (invocation-level) state

state_updates[StateKeys.TEMP_PROCESSING_TIMESTAMP] = current_time

# Session-level state

attempts = tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 0) + 1

state_updates[StateKeys.GRADING_ATTEMPTS] = attempts

state_updates[StateKeys.LAST_GRADING_TIME] = current_time

# User-level persistent state

lifetime_submissions = tool_context.state.get(StateKeys.USER_TOTAL_SUBMISSIONS, 0) + 1

state_updates[StateKeys.USER_TOTAL_SUBMISSIONS] = lifetime_submissions

state_updates[StateKeys.USER_LAST_SUBMISSION_TIME] = current_time

# Calculate improvement metrics

current_style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

last_style_score = tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

score_improvement = current_style_score - last_style_score

state_updates[StateKeys.USER_LAST_STYLE_SCORE] = current_style_score

state_updates[StateKeys.SCORE_IMPROVEMENT] = score_improvement

# Track test results if available

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

if test_results and test_results.get('test_summary', {}).get('total_tests_run', 0) > 0:

summary = test_results['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

pass_rate = (passed / total) * 100

state_updates[StateKeys.USER_LAST_TEST_PASS_RATE] = pass_rate

# Apply all updates atomically

for key, value in state_updates.items():

tool_context.state[key] = value

logger.info(f"Tool: Progress updated - Attempt #{attempts}, "

f"Lifetime: {lifetime_submissions}")

return {

"status": "success",

"session_attempts": attempts,

"lifetime_submissions": lifetime_submissions,

"timestamp": current_time,

"improvement": {

"style_score_change": score_improvement,

"direction": "improved" if score_improvement > 0 else "declined"

},

"summary": f"Attempt #{attempts} recorded, {lifetime_submissions} total submissions"

}

except Exception as e:

error_msg = f"Progress update error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

return {

"status": "error",

"message": error_msg

}

👉 ค้นหา:

# MODULE_5_STEP_4_SAVE_GRADING_REPORT

👉 แทนที่ด้วยเครื่องมือ 3 - โปรแกรมบันทึกอาร์ติแฟกต์ (เวอร์ชันที่ใช้งานจริง):

async def save_grading_report(feedback_text: str, tool_context: ToolContext) -> Dict[str, Any]:

"""

Saves a detailed grading report as an artifact.

Args:

feedback_text: The feedback text to include in the report

tool_context: ADK tool context for state management

Returns:

Dictionary containing save status and details

"""

logger.info("Tool: Saving grading report...")

try:

# Gather all relevant data from state

code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

analysis = tool_context.state.get(StateKeys.CODE_ANALYSIS, {})

style_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

style_issues = tool_context.state.get(StateKeys.STYLE_ISSUES, [])

# Get test results

test_results = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

# Parse if it's a string

if isinstance(test_results, str):

try:

test_results = json.loads(test_results)

except:

test_results = {}

timestamp = datetime.now().isoformat()

# Create comprehensive report dictionary

report = {

'timestamp': timestamp,

'grading_attempt': tool_context.state.get(StateKeys.GRADING_ATTEMPTS, 1),

'code': {

'content': code,

'line_count': len(code.splitlines()),

'hash': hashlib.md5(code.encode()).hexdigest()

},

'analysis': analysis,

'style': {

'score': style_score,

'issues': style_issues[:5] # First 5 issues

},

'tests': test_results,

'feedback': feedback_text,

'improvements': {

'score_change': tool_context.state.get(StateKeys.SCORE_IMPROVEMENT, 0),

'from_last_score': tool_context.state.get(StateKeys.USER_LAST_STYLE_SCORE, 0)

}

}

# Convert report to JSON string

report_json = json.dumps(report, indent=2)

report_part = types.Part.from_text(text=report_json)

# Try to save as artifact if the service is available

if hasattr(tool_context, 'save_artifact'):

try:

# Generate filename with timestamp (replace colons for filesystem compatibility)

filename = f"grading_report_{timestamp.replace(':', '-')}.json"

# Save the main report

version = await tool_context.save_artifact(filename, report_part)

# Also save a "latest" version for easy access

await tool_context.save_artifact("latest_grading_report.json", report_part)

logger.info(f"Tool: Report saved as {filename} (version {version})")

# Store report in state as well for redundancy

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

return {

"status": "success",

"artifact_saved": True,

"filename": filename,

"version": str(version),

"size": len(report_json),

"summary": f"Report saved as {filename}"

}

except Exception as artifact_error:

logger.warning(f"Artifact service error: {artifact_error}, falling back to state storage")

# Continue to fallback below

# Fallback: Store in state if artifact service is not available or failed

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = report

logger.info("Tool: Report saved to state (artifact service not available)")

return {

"status": "success",

"artifact_saved": False,

"message": "Report saved to state only",

"size": len(report_json),

"summary": "Report saved to session state"

}

except Exception as e:

error_msg = f"Report save error: {str(e)}"

logger.error(f"Tool: {error_msg}", exc_info=True)

# Still try to save minimal data to state

try:

tool_context.state[StateKeys.USER_LAST_GRADING_REPORT] = {

'error': error_msg,

'feedback': feedback_text,

'timestamp': datetime.now().isoformat()

}

except:

pass

return {

"status": "error",

"message": error_msg,

"artifact_saved": False,

"summary": f"Failed to save report: {error_msg}"

}

สร้าง Agent สังเคราะห์

👉 เปิด

code_review_assistant/sub_agents/review_pipeline/feedback_synthesizer.py

👉 ค้นหา:

# MODULE_5_STEP_4_INSTRUCTION_PROVIDER

👉 แทนที่ด้วยผู้ให้บริการคำสั่งการผลิต:

async def feedback_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code reviewer and mentor providing constructive, educational feedback.

CONTEXT FROM PREVIOUS AGENTS:

- Structure analysis summary: {structure_analysis_summary}

- Style check summary: {style_check_summary}

- Test execution summary: {test_execution_summary}

YOUR TASK requires these steps IN ORDER:

1. Call search_past_feedback tool with developer_id="default_user"

2. Call update_grading_progress tool with no parameters

3. Carefully analyze the test results to understand what really happened

4. Generate comprehensive feedback following the structure below

5. Call save_grading_report tool with the feedback_text parameter

6. Return the feedback as your final output

CRITICAL - Understanding Test Results:

The test_execution_summary contains structured JSON. Parse it carefully:

- tests_passed = Code worked correctly

- tests_failed = Code produced wrong output

- tests_with_errors = Code crashed

- critical_issues = Fundamental problems with the code

If critical_issues array contains items, these are serious bugs that need fixing.

Do NOT count discovering bugs as test successes.

FEEDBACK STRUCTURE TO FOLLOW:

## 📊 Summary

Provide an honest assessment. Be encouraging but truthful about problems found.

## ✅ Strengths

List 2-3 things done well, referencing specific code elements.

## 📈 Code Quality Analysis

### Structure & Organization

Comment on code organization, readability, and documentation.

### Style Compliance

Report the actual style score and any specific issues.

### Test Results

Report the actual test results accurately:

- If critical_issues exist, report them as bugs to fix

- Be clear: "X tests passed, Y critical issues were found"

- List each critical issue

- Don't hide or minimize problems

## 💡 Recommendations for Improvement

Based on the analysis, provide specific actionable fixes.

If critical issues exist, fixing them is top priority.

## 🎯 Next Steps

Prioritized action list based on severity of issues.

## 💬 Encouragement

End with encouragement while being honest about what needs fixing.

Remember: Complete ALL steps including calling save_grading_report."""

return await instructions_utils.inject_session_state(template, context)

👉 ค้นหา:

# MODULE_5_STEP_4_SYNTHESIZER_AGENT

👉 แทนที่ด้วย:

feedback_synthesizer_agent = Agent(

name="FeedbackSynthesizer",

model=config.critic_model,

description="Synthesizes all analysis into constructive, personalized feedback",

instruction=feedback_instruction_provider,

tools=[

FunctionTool(func=search_past_feedback),

FunctionTool(func=update_grading_progress),

FunctionTool(func=save_grading_report)

],

output_key="final_feedback"

)

ขั้นตอนที่ 5: ต่อสายไปป์ไลน์

ตอนนี้ให้เชื่อมต่อเอเจนต์ทั้ง 4 รายเข้ากับไปป์ไลน์ตามลำดับและสร้างเอเจนต์รูท

👉 เปิด

code_review_assistant/agent.py

👉 เพิ่มการนำเข้าที่จำเป็นที่ด้านบนของไฟล์ (หลังจากการนำเข้าที่มีอยู่)

from google.adk.agents import Agent, SequentialAgent

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

ตอนนี้ไฟล์ควรมีลักษณะดังนี้

"""

Main agent orchestration for the Code Review Assistant.

"""

from google.adk.agents import Agent, SequentialAgent

from .config import config

from code_review_assistant.sub_agents.review_pipeline.code_analyzer import code_analyzer_agent

from code_review_assistant.sub_agents.review_pipeline.style_checker import style_checker_agent

from code_review_assistant.sub_agents.review_pipeline.test_runner import test_runner_agent

from code_review_assistant.sub_agents.review_pipeline.feedback_synthesizer import feedback_synthesizer_agent

# MODULE_5_STEP_5_CREATE_PIPELINE

# MODULE_6_STEP_5_CREATE_FIX_LOOP

# MODULE_6_STEP_5_UPDATE_ROOT_AGENT

👉 ค้นหา:

# MODULE_5_STEP_5_CREATE_PIPELINE

👉 แทนที่บรรทัดเดียวด้วยข้อความต่อไปนี้

# Create sequential pipeline

code_review_pipeline = SequentialAgent(

name="CodeReviewPipeline",

description="Complete code review pipeline with analysis, testing, and feedback",

sub_agents=[

code_analyzer_agent,

style_checker_agent,

test_runner_agent,

feedback_synthesizer_agent

]

)

# Root agent - coordinates the review pipeline

root_agent = Agent(

name="CodeReviewAssistant",

model=config.worker_model,

description="An intelligent code review assistant that analyzes Python code and provides educational feedback",

instruction="""You are a specialized Python code review assistant focused on helping developers improve their code quality.

When a user provides Python code for review:

1. Immediately delegate to CodeReviewPipeline and pass the code EXACTLY as it was provided by the user.

2. The pipeline will handle all analysis and feedback

3. Return ONLY the final feedback from the pipeline - do not add any commentary

When a user asks what you can do or asks general questions:

- Explain your capabilities for code review

- Do NOT trigger the pipeline for non-code messages

The pipeline handles everything for code review - just pass through its final output.""",

sub_agents=[code_review_pipeline],

output_key="assistant_response"

)

ขั้นตอนที่ 6: ทดสอบไปป์ไลน์ที่สมบูรณ์

ถึงเวลาดูตัวแทนทั้ง 4 คนทำงานร่วมกันแล้ว

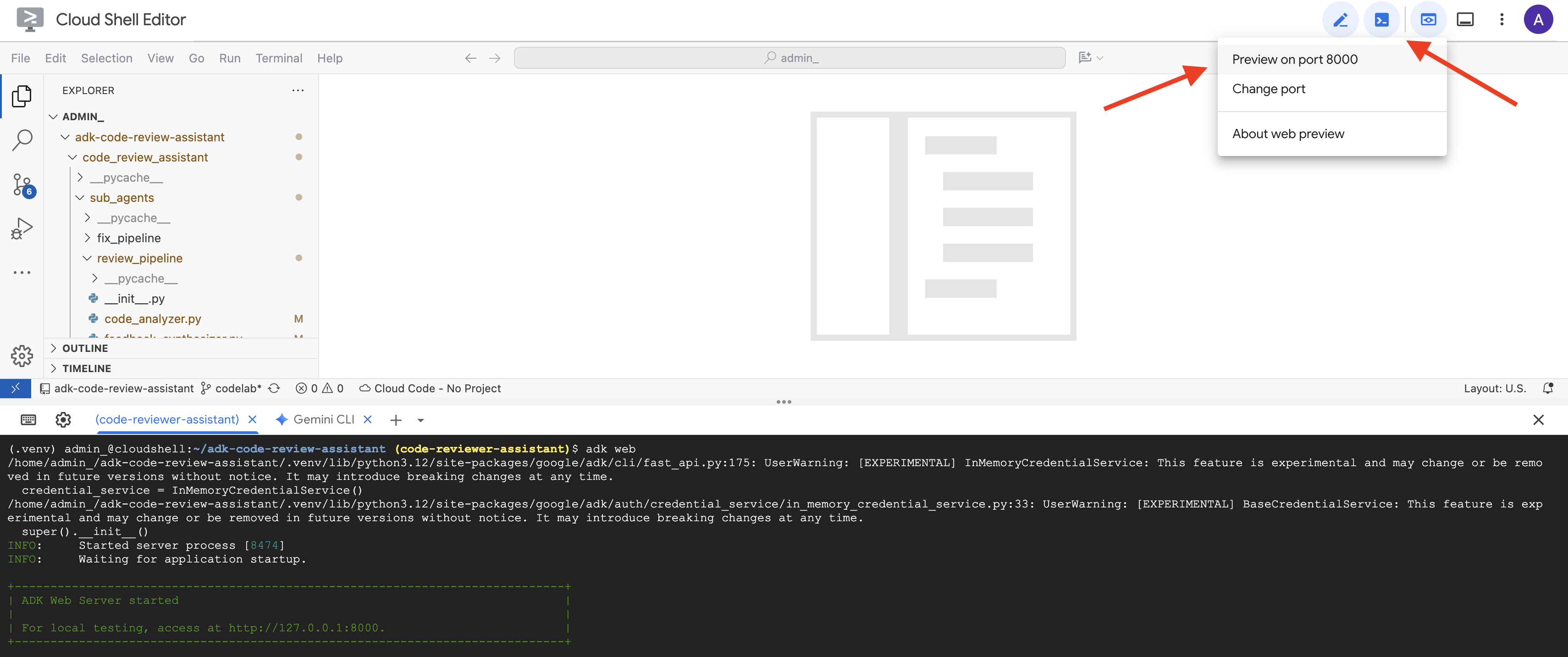

👉 เริ่มระบบ:

adk web code_review_assistant

หลังจากเรียกใช้คำสั่ง adk web แล้ว คุณควรเห็นเอาต์พุตในเทอร์มินัลที่ระบุว่าเว็บเซิร์ฟเวอร์ ADK เริ่มทำงานแล้ว ซึ่งมีลักษณะคล้ายกับเอาต์พุตนี้

+-----------------------------------------------------------------------------+

| ADK Web Server started |

| |

| For local testing, access at http://localhost:8000. |

+-----------------------------------------------------------------------------+

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

👉 จากนั้น หากต้องการเข้าถึง UI สำหรับนักพัฒนาแอป ADK จากเบราว์เซอร์ ให้ทำดังนี้

จากไอคอนตัวอย่างเว็บ (มักจะมีลักษณะเป็นรูปดวงตาหรือสี่เหลี่ยมที่มีลูกศร) ในแถบเครื่องมือ Cloud Shell (มักจะอยู่ด้านขวาบน) ให้เลือกเปลี่ยนพอร์ต ในหน้าต่างป๊อปอัป ให้ตั้งค่าพอร์ตเป็น 8000 แล้วคลิก "เปลี่ยนและแสดงตัวอย่าง" จากนั้น Cloud Shell จะเปิดแท็บหรือหน้าต่างเบราว์เซอร์ใหม่ที่แสดง UI ของ ADK Dev

👉 ตอนนี้ Agent กำลังทำงานอยู่ UI สำหรับนักพัฒนาซอฟต์แวร์ ADK ในเบราว์เซอร์คือการเชื่อมต่อโดยตรงกับเอเจนต์

- เลือกเป้าหมาย: ในเมนูแบบเลื่อนลงที่ด้านบนของ UI ให้เลือกเอเจนต์

code_review_assistant

👉 พรอมต์ทดสอบ:

Please analyze the following:

def dfs_search_v1(graph, start, target):

"""Find if target is reachable from start."""

visited = set()

stack = start

while stack:

current = stack.pop()

if current == target:

return True

if current not in visited:

visited.add(current)

for neighbor in graph[current]:

if neighbor not in visited:

stack.append(neighbor)

return False

👉 ดูไปป์ไลน์การตรวจสอบโค้ดที่ใช้งานจริง:

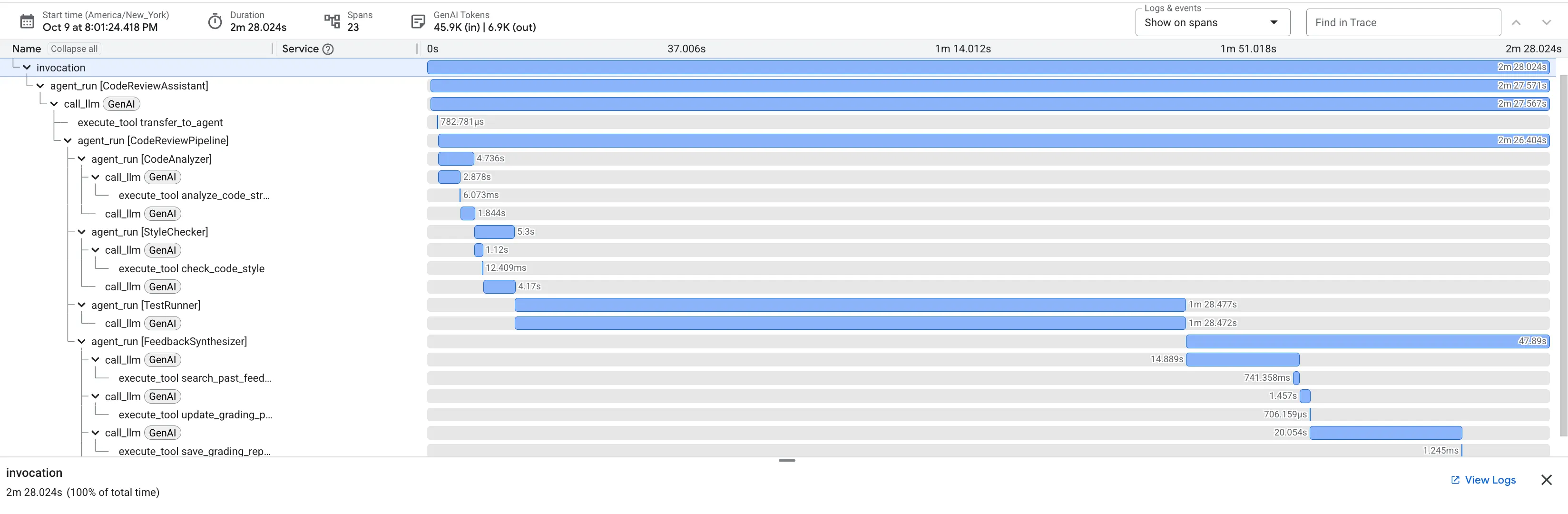

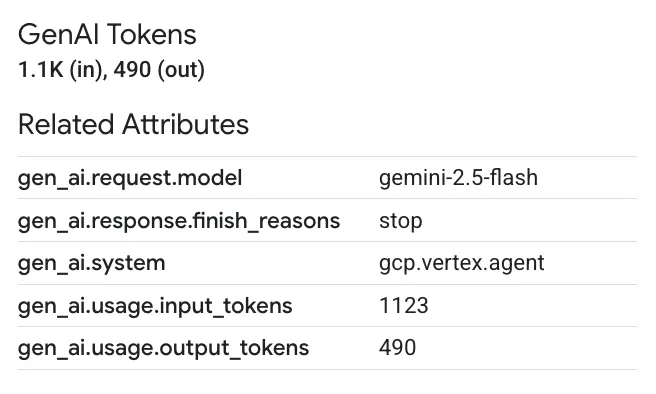

เมื่อส่งฟังก์ชัน dfs_search_v1 ที่มีข้อบกพร่อง คุณจะไม่ได้รับคำตอบเพียงคำตอบเดียว คุณกำลังเห็นไปป์ไลน์แบบหลายเอเจนต์ทำงาน เอาต์พุตการสตรีมที่คุณเห็นเป็นผลลัพธ์ของเอเจนต์เฉพาะทาง 4 รายที่ทำงานตามลำดับ โดยแต่ละรายจะสร้างขึ้นจากเอเจนต์ก่อนหน้า

ต่อไปนี้คือรายละเอียดของสิ่งที่เอเจนต์แต่ละรายมีส่วนร่วมในการตรวจสอบที่ครอบคลุมขั้นสุดท้าย ซึ่งจะเปลี่ยนข้อมูลดิบให้เป็นข้อมูลเชิงลึกที่นำไปใช้ได้จริง

1. รายงานโครงสร้างของเครื่องมือวิเคราะห์โค้ด

ก่อนอื่น CodeAnalyzerเอเจนต์จะได้รับโค้ดดิบ โดยจะไม่คาดเดาว่าโค้ดทำอะไร แต่จะใช้เครื่องมือ analyze_code_structure เพื่อแยกวิเคราะห์ Abstract Syntax Tree (AST) แบบดีเทอร์มินิสติก

เอาต์พุตของเครื่องมือนี้คือข้อมูลข้อเท็จจริงล้วนๆ เกี่ยวกับโครงสร้างของโค้ด

The analysis of the provided code reveals the following:

Summary:

- Functions Found: 1

- Classes Found: 0

Key Structural Observations:

- A single function, dfs_search_v1, is defined.

- It includes a docstring: "Find if target is reachable from start."

- No syntax errors were detected.

Overall Code Organization Assessment:

- The code snippet is a well-defined, self-contained function.

⭐ คุณค่า: ขั้นตอนเริ่มต้นนี้จะช่วยสร้างรากฐานที่สะอาดและเชื่อถือได้สำหรับเอเจนต์อื่นๆ ซึ่งจะยืนยันว่าโค้ดเป็น Python ที่ถูกต้องและระบุคอมโพเนนต์ที่ต้องตรวจสอบอย่างชัดเจน

2. การตรวจสอบ PEP 8 ของตัวตรวจสอบสไตล์

จากนั้นเอเจนต์ StyleChecker จะเข้ามาดูแล โดยจะอ่านโค้ดจากสถานะที่แชร์และใช้เครื่องมือ check_code_style ซึ่งใช้ประโยชน์จาก Linter pycodestyle

ผลลัพธ์คือคะแนนคุณภาพที่วัดได้และการละเมิดที่เฉพาะเจาะจง

Style Analysis Results

- Style Score: 88/100

- Total Issues: 6

- Assessment: Good style with minor improvements needed

Top Style Issues

- Line 5, W293: blank line contains whitespace

- Line 19, W292: no newline at end of file

⭐ คุณค่า: เอเจนต์นี้ให้ความคิดเห็นที่เป็นกลางและไม่สามารถต่อรองได้ตามมาตรฐานชุมชนที่กำหนดไว้ (PEP 8) ระบบการให้คะแนนแบบถ่วงน้ำหนักจะบอกความรุนแรงของปัญหาแก่ผู้ใช้ทันที

3. การค้นพบข้อบกพร่องที่สำคัญของ Test Runner

ซึ่งเป็นจุดที่ระบบจะทำการวิเคราะห์ที่ลึกซึ้งกว่าการวิเคราะห์ระดับพื้นผิว TestRunner Agent จะสร้างและเรียกใช้ชุดการทดสอบที่ครอบคลุมเพื่อตรวจสอบลักษณะการทำงานของโค้ด

เอาต์พุตของโมเดลคือออบเจ็กต์ JSON ที่มีโครงสร้างซึ่งมีคำตัดสินที่รุนแรง

{

"critical_issues": [

{

"type": "Critical Bug",

"description": "The function's initialization `stack = start` is incorrect... When a common input like a string... is provided... the function crashes with an AttributeError.",

"severity": "Critical"

}

],

"verdict": {

"status": "BROKEN",

"confidence": "high",

"recommendation": "The function is fundamentally broken... the stack initialization line `stack = start` must be changed to `stack = [start]`."

}

}

⭐ คุณค่า: ข้อมูลเชิงลึกนี้มีความสําคัญมากที่สุด เอเจนต์ไม่ได้เดาเท่านั้น แต่ยังพิสูจน์ว่าโค้ดใช้ไม่ได้ด้วยการเรียกใช้โค้ด โดยพบข้อบกพร่องรันไทม์ที่เล็กน้อยแต่สำคัญ ซึ่งผู้ตรวจสอบที่เป็นมนุษย์อาจพลาดได้ง่าย และระบุสาเหตุที่แน่ชัดพร้อมการแก้ไขที่จำเป็น

4. รายงานสุดท้ายของเครื่องมือสังเคราะห์ความคิดเห็น

สุดท้าย FeedbackSynthesizerเอเจนต์จะทำหน้าที่เป็นตัวนำ โดยจะนำข้อมูลที่มีโครงสร้างจากตัวแทน 3 คนก่อนหน้ามาสร้างเป็นรายงานเดียวที่ใช้งานง่าย ซึ่งทั้งวิเคราะห์และให้กำลังใจได้

เอาต์พุตคือรีวิวสุดท้ายที่ขัดเกลาแล้วซึ่งคุณเห็น

📊 Summary

Great effort on implementing the Depth-First Search algorithm! ... However, a critical bug in the initialization of the stack prevents the function from working correctly...

✅ Strengths

- Good Algorithm Structure

- Correct Use of `visited` Set

📈 Code Quality Analysis

...

### Style Compliance

The style analysis returned a good score of 88/100.

...

### Test Results

The automated testing revealed a critical issue... The line `stack = start` directly assigns the input... which results in an `AttributeError`.

💡 Recommendations for Improvement

**Fix the Critical Stack Initialization Bug:**

- Incorrect Code: `stack = start`

- Correct Code: `stack = [start]`

💬 Encouragement

You are very close to a perfect implementation! The core logic of your DFS algorithm is sound, which is the hardest part.

⭐ คุณค่า: เอเจนต์นี้เปลี่ยนข้อมูลทางเทคนิคให้เป็นประสบการณ์การเรียนรู้ที่เป็นประโยชน์ โดยจะให้ความสำคัญกับปัญหาที่สำคัญที่สุด (ข้อบกพร่อง) อธิบายอย่างชัดเจน ให้วิธีแก้ปัญหาที่แน่นอน และใช้โทนที่ให้กำลังใจ โดยจะรวมผลลัพธ์จากทุกขั้นตอนก่อนหน้าเข้าด้วยกันจนกลายเป็นข้อมูลที่สอดคล้องและมีคุณค่า

กระบวนการแบบหลายขั้นตอนนี้แสดงให้เห็นถึงพลังของไปป์ไลน์แบบเอเจนต์ คุณจะได้รับการวิเคราะห์แบบเลเยอร์แทนที่จะเป็นการตอบกลับแบบก้อนเดียว โดยที่เอเจนต์แต่ละรายจะทำงานเฉพาะทางที่ตรวจสอบได้ ซึ่งจะนำไปสู่การตรวจสอบที่ไม่เพียงแต่ให้ข้อมูลเชิงลึกเท่านั้น แต่ยังเป็นแบบดีเทอร์มินิสติก เชื่อถือได้ และให้ความรู้เชิงลึกอีกด้วย

👉💻 เมื่อทดสอบเสร็จแล้ว ให้กลับไปที่เทอร์มินัลของเครื่องมือแก้ไข Cloud Shell แล้วกด Ctrl+C เพื่อหยุด UI สำหรับนักพัฒนา ADK

สิ่งที่คุณสร้าง

ตอนนี้คุณมีไปป์ไลน์การตรวจสอบโค้ดที่สมบูรณ์แล้ว ซึ่งมีลักษณะดังนี้

✅ แยกวิเคราะห์โครงสร้างโค้ด - การวิเคราะห์ AST ที่กำหนดได้ด้วยฟังก์ชันตัวช่วย

✅ ตรวจสอบสไตล์ - การให้คะแนนแบบถ่วงน้ำหนักตามแบบแผนการตั้งชื่อ

✅ เรียกใช้การทดสอบ - การสร้างการทดสอบที่ครอบคลุมพร้อมเอาต์พุต JSON ที่มีโครงสร้าง

✅ สังเคราะห์ความคิดเห็น - ผสานรวมสถานะ + หน่วยความจำ + อาร์ติแฟกต์

✅ ติดตามความคืบหน้า - สถานะหลายระดับในการเรียกใช้/เซสชัน/ผู้ใช้

✅ เรียนรู้เมื่อเวลาผ่านไป - บริการหน่วยความจำสำหรับรูปแบบข้ามเซสชัน

✅ จัดเตรียมอาร์ติแฟกต์ - รายงาน JSON ที่ดาวน์โหลดได้พร้อมบันทึกการตรวจสอบที่สมบูรณ์

แนวคิดหลักที่เชี่ยวชาญ

ไปป์ไลน์แบบลำดับ:

- เอเจนต์ 4 รายที่ดำเนินการตามลำดับอย่างเคร่งครัด

- แต่ละรายการจะเพิ่มคุณค่าให้กับสถานะสำหรับรายการถัดไป

- ทรัพยากร Dependency จะกำหนดลำดับการดำเนินการ

รูปแบบการผลิต:

- การแยกฟังก์ชันตัวช่วย (ซิงค์ในพูลเธรด)

- การลดระดับอย่างค่อยเป็นค่อยไป (กลยุทธ์สำรอง)

- การจัดการสถานะแบบหลายระดับ (ชั่วคราว/เซสชัน/ผู้ใช้)

- ผู้ให้บริการคำสั่งแบบไดนามิก (รับรู้บริบท)

- พื้นที่เก็บข้อมูลคู่ (อาร์ติแฟกต์ + ความซ้ำซ้อนของสถานะ)

รัฐในฐานะการสื่อสาร:

- ค่าคงที่จะช่วยป้องกันการสะกดผิดในเอเจนต์

output_keyเขียนข้อมูลสรุปของตัวแทนเพื่อระบุสถานะ- Agent จะอ่านในภายหลังผ่าน StateKeys

- สถานะจะไหลผ่านไปตามไปป์ไลน์ในเชิงเส้น

หน่วยความจำเทียบกับสถานะ:

- สถานะ: ข้อมูลเซสชันปัจจุบัน

- หน่วยความจำ: รูปแบบในเซสชัน

- วัตถุประสงค์ที่ต่างกัน อายุการใช้งานที่ต่างกัน

การประสานงานเครื่องมือ:

- เอเจนต์แบบเครื่องมือเดียว (analyzer, style_checker)

- ตัวดำเนินการในตัว (test_runner)

- การประสานงานแบบหลายเครื่องมือ (เครื่องสังเคราะห์เสียง)

กลยุทธ์การเลือกโมเดล:

- โมเดลผู้ปฏิบัติงาน: งานเชิงกล (การแยกวิเคราะห์ การตรวจสอบ การกำหนดเส้นทาง)

- โมเดลนักวิจารณ์: งานการให้เหตุผล (การทดสอบ การสังเคราะห์)

- การเพิ่มประสิทธิภาพต้นทุนผ่านการเลือกที่เหมาะสม

ขั้นตอนถัดไป

ในโมดูลที่ 6 คุณจะสร้างไปป์ไลน์การแก้ไขโดยทำดังนี้

- สถาปัตยกรรม LoopAgent สำหรับการแก้ไขแบบวนซ้ำ

- เงื่อนไขการออกผ่านการยกระดับ

- การสะสมสถานะในแต่ละการทำซ้ำ

- ตรรกะการตรวจสอบและการลองอีกครั้ง

- การผสานรวมกับไปป์ไลน์การตรวจสอบเพื่อเสนอการแก้ไข

คุณจะเห็นว่ารูปแบบสถานะเดียวกันนี้ขยายขนาดไปเป็นเวิร์กโฟลว์แบบวนซ้ำที่ซับซ้อนได้อย่างไร ซึ่งเอเจนต์จะพยายามหลายครั้งจนกว่าจะสำเร็จ และวิธีประสานงานไปป์ไลน์หลายรายการในแอปพลิเคชันเดียว

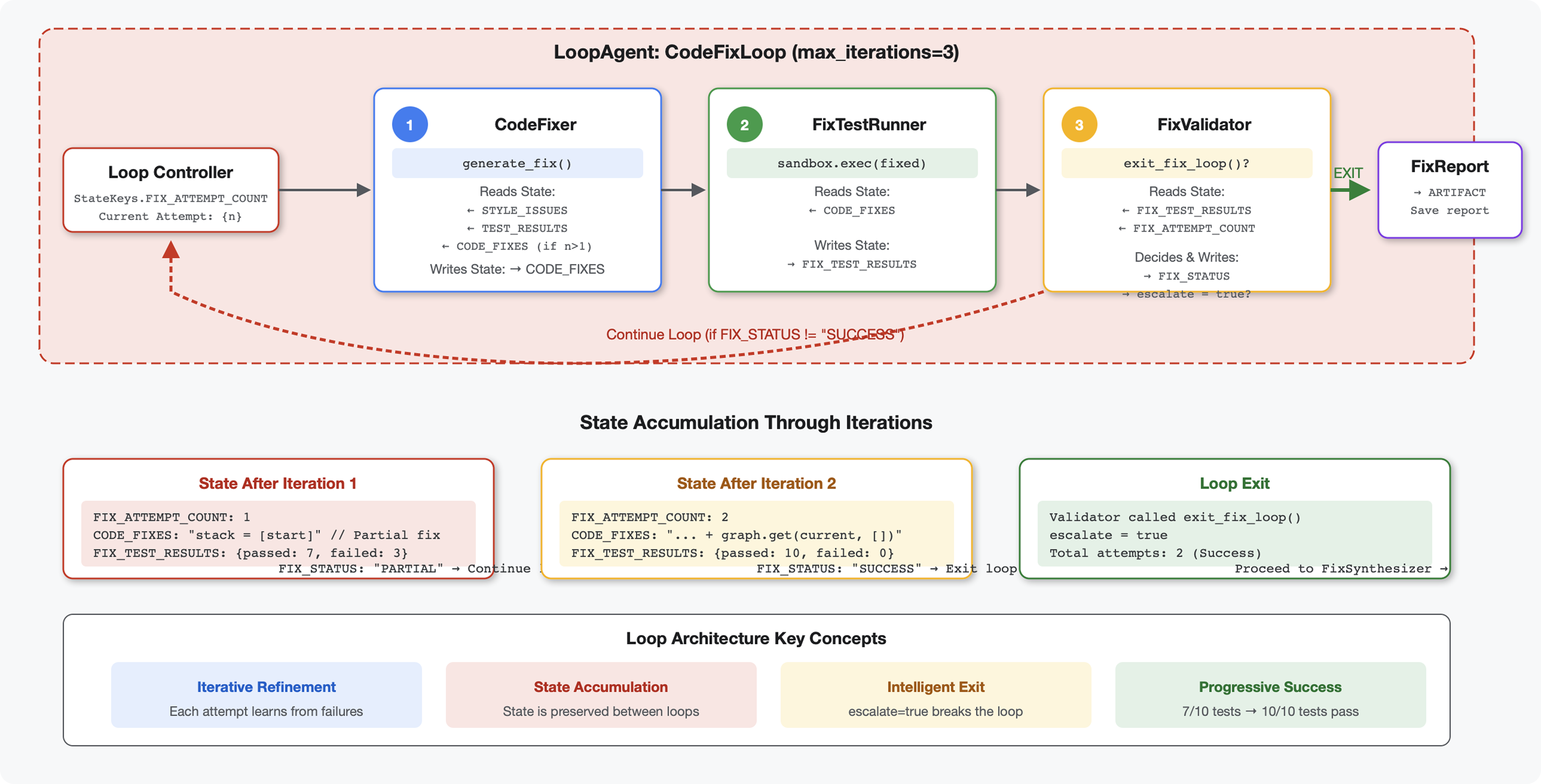

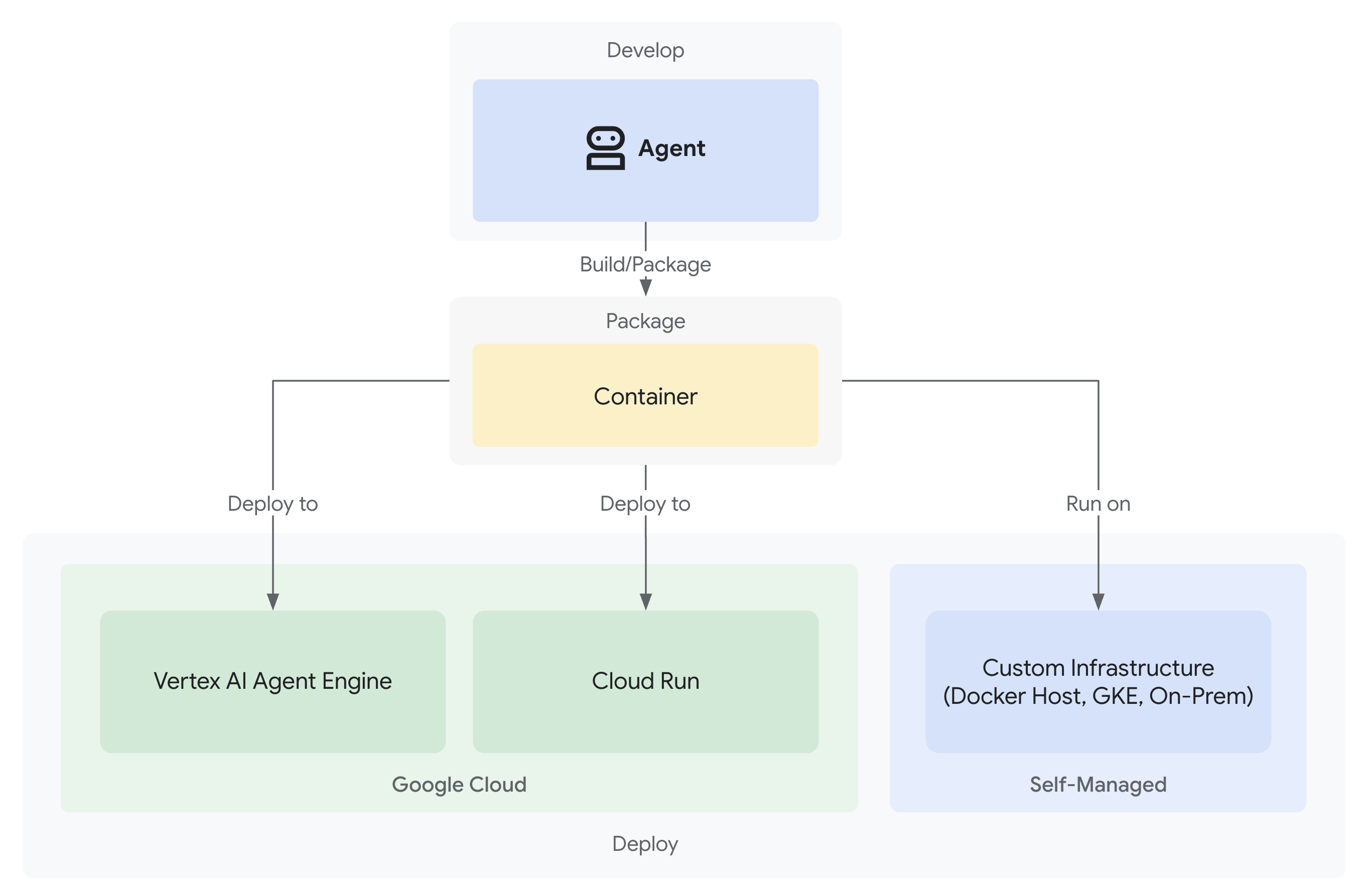

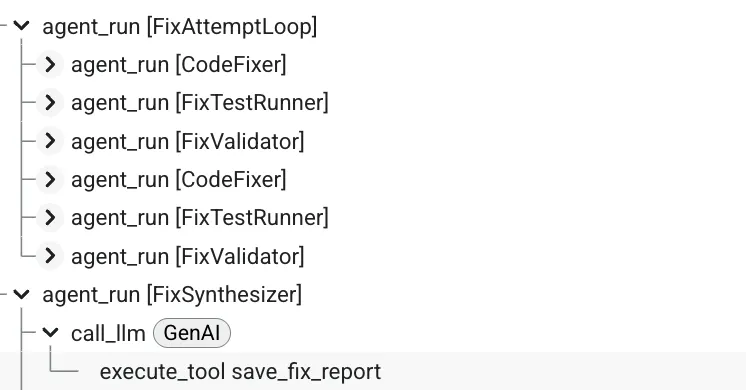

6. การเพิ่มไปป์ไลน์การแก้ไข: สถาปัตยกรรมลูป

บทนำ

ในโมดูลที่ 5 คุณได้สร้างไปป์ไลน์การตรวจสอบตามลำดับที่วิเคราะห์โค้ดและให้ความคิดเห็น แต่การระบุปัญหาเป็นเพียงครึ่งหนึ่งของวิธีแก้ปัญหาเท่านั้น นักพัฒนาแอปยังต้องการความช่วยเหลือในการแก้ไขปัญหาด้วย

โมดูลนี้สร้างไปป์ไลน์การแก้ไขอัตโนมัติซึ่งมีลักษณะดังนี้

- สร้างการแก้ไขตามผลการตรวจสอบ

- ตรวจสอบการแก้ไขโดยการเรียกใช้การทดสอบที่ครอบคลุม

- ลองอีกครั้งโดยอัตโนมัติหากการแก้ไขไม่ได้ผล (สูงสุด 3 ครั้ง)

- ผลลัพธ์ของรายงานที่มีการเปรียบเทียบก่อน/หลัง

แนวคิดหลัก: LoopAgent สำหรับการลองใหม่โดยอัตโนมัติ LoopAgentจะเรียกใช้ตัวแทนย่อยซ้ำจนกว่าจะตรงตามเงื่อนไขการออกหรือถึงการวนซ้ำสูงสุด ซึ่งแตกต่างจากเอเจนต์ตามลำดับที่ทำงานครั้งเดียว เครื่องมือจะส่งสัญญาณความสำเร็จโดยการตั้งค่า tool_context.actions.escalate = True

ตัวอย่างสิ่งที่คุณจะสร้าง: ส่งโค้ดที่มีข้อบกพร่อง → ตรวจสอบพบปัญหา → ลูปการแก้ไขสร้างการแก้ไข → การทดสอบตรวจสอบ → ลองอีกครั้งหากจำเป็น → รายงานที่ครอบคลุมขั้นสุดท้าย

แนวคิดหลัก: LoopAgent เทียบกับ Sequential

ไปป์ไลน์แบบลำดับ (โมดูล 5):

SequentialAgent(agents=[A, B, C])

# Executes: A → B → C → Done

- การไหลทางเดียว

- Agent แต่ละตัวจะทำงานเพียงครั้งเดียว

- ไม่มีตรรกะการลองใหม่

ไปป์ไลน์ของ Loop (โมดูล 6):

LoopAgent(agents=[A, B, C], max_iterations=3)

# Executes: A → B → C → (check exit) → A → B → C → (check exit) → ...

- การไหลเวียนแบบวนซ้ำ

- เรียกใช้เอเจนต์ได้หลายครั้ง

- ออกจากโปรแกรมเมื่อ:

- เครื่องมือตั้งค่า

tool_context.actions.escalate = True(สำเร็จ) max_iterationsถึงขีดจำกัดแล้ว (ขีดจำกัดความปลอดภัย)- เกิดข้อยกเว้นที่ไม่มีการจัดการ (ข้อผิดพลาด)

- เครื่องมือตั้งค่า

เหตุใดจึงใช้ลูปในการแก้ไขโค้ด

การแก้ไขโค้ดมักต้องลองหลายครั้ง

- ความพยายามครั้งแรก: แก้ไขข้อบกพร่องที่เห็นได้ชัด (ประเภทตัวแปรไม่ถูกต้อง)

- ความพยายามครั้งที่ 2: แก้ไขปัญหาที่ 2 ที่พบจากการทดสอบ (กรณีที่พบได้ยาก)

- ความพยายามครั้งที่ 3: ปรับแต่งและตรวจสอบว่าการทดสอบทั้งหมดผ่าน

หากไม่มีลูป คุณจะต้องใช้ตรรกะแบบมีเงื่อนไขที่ซับซ้อนในคำสั่งของเอเจนต์ เมื่อใช้ LoopAgent ระบบจะลองอีกครั้งโดยอัตโนมัติ

การเปรียบเทียบสถาปัตยกรรม:

Sequential (Module 5):

User → Review Pipeline → Feedback → Done

Loop (Module 6):

User → Review Pipeline → Feedback → Fix Pipeline

↓

┌──────────────┴──────────────┐

│ Fix Attempt Loop (1-3x) │

│ ┌─────────────────────┐ │

│ │ 1. Generate Fixes │ │

│ │ 2. Test Fixes │ │

│ │ 3. Validate & Exit? │────┼─→ If escalate=True

│ └─────────────────────┘ │ exit loop

│ ↓ If not │

│ Try Again (max 3) │

└─────────────────────────────┘

↓

4. Synthesize Final Report → Done

ขั้นตอนที่ 1: เพิ่มตัวแทนแก้ไขโค้ด

ตัวแก้ไขโค้ดจะสร้างโค้ด Python ที่แก้ไขแล้วตามผลการตรวจสอบ

👉 เปิด

code_review_assistant/sub_agents/fix_pipeline/code_fixer.py

👉 ค้นหา:

# MODULE_6_STEP_1_CODE_FIXER_INSTRUCTION_PROVIDER

👉 แทนที่บรรทัดเดียวด้วย

async def code_fixer_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that injects state variables."""

template = """You are an expert code fixing specialist.

Original Code:

{code_to_review}

Analysis Results:

- Style Score: {style_score}/100

- Style Issues: {style_issues}

- Test Results: {test_execution_summary}

Based on the test results, identify and fix ALL issues including:

- Interface bugs (e.g., if start parameter expects wrong type)

- Logic errors (e.g., KeyError when accessing graph nodes)

- Style violations

- Missing documentation

YOUR TASK:

Generate the complete fixed Python code that addresses all identified issues.

CRITICAL INSTRUCTIONS:

- Output ONLY the corrected Python code

- Do NOT include markdown code blocks (```python)

- Do NOT include any explanations or commentary

- The output should be valid, executable Python code and nothing else

Common fixes to apply based on test results:

- If tests show AttributeError with 'pop', fix: stack = [start] instead of stack = start

- If tests show KeyError accessing graph, fix: use graph.get(current, [])

- Add docstrings if missing

- Fix any style violations identified

Output the complete fixed code now:"""

return await instructions_utils.inject_session_state(template, context)

👉 ค้นหา:

# MODULE_6_STEP_1_CODE_FIXER_AGENT

👉 แทนที่บรรทัดเดียวด้วย

code_fixer_agent = Agent(

name="CodeFixer",

model=config.worker_model,

description="Generates comprehensive fixes for all identified code issues",

instruction=code_fixer_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="code_fixes"

)

ขั้นตอนที่ 2: เพิ่ม Fix Test Runner Agent

โปรแกรมเรียกใช้การทดสอบการแก้ไขจะตรวจสอบการแก้ไขโดยการเรียกใช้การทดสอบที่ครอบคลุมในโค้ดที่แก้ไขแล้ว

👉 เปิด

code_review_assistant/sub_agents/fix_pipeline/fix_test_runner.py

👉 ค้นหา:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_INSTRUCTION_PROVIDER

👉 แทนที่บรรทัดเดียวด้วย

async def fix_test_runner_instruction_provider(context: ReadonlyContext) -> str:

"""Dynamic instruction provider that uses the clean code from the previous step."""

template = """You are responsible for validating the fixed code by running tests.

THE FIXED CODE TO TEST:

{code_fixes}

ORIGINAL TEST RESULTS: {test_execution_summary}

YOUR TASK:

1. Understand the fixes that were applied

2. Generate the same comprehensive tests (15-20 test cases)

3. Execute the tests on the FIXED code using your code executor

4. Compare results with original test results

5. Output a detailed JSON analysis

TESTING METHODOLOGY:

- Run the same tests that revealed issues in the original code

- Verify that previously failing tests now pass

- Ensure no regressions were introduced

- Document the improvement

Execute your tests and output ONLY valid JSON with this structure:

- "passed": number of tests that passed

- "failed": number of tests that failed

- "total": total number of tests

- "pass_rate": percentage as a number

- "comparison": object with "original_pass_rate", "new_pass_rate", "improvement"

- "newly_passing_tests": array of test names that now pass

- "still_failing_tests": array of test names still failing

Do NOT output the test code itself, only the JSON analysis."""

return await instructions_utils.inject_session_state(template, context)

👉 ค้นหา:

# MODULE_6_STEP_2_FIX_TEST_RUNNER_AGENT

👉 แทนที่บรรทัดเดียวด้วย

fix_test_runner_agent = Agent(

name="FixTestRunner",

model=config.critic_model,

description="Runs comprehensive tests on fixed code to verify all issues are resolved",

instruction=fix_test_runner_instruction_provider,

code_executor=BuiltInCodeExecutor(),

output_key="fix_test_execution_summary"

)

ขั้นตอนที่ 3: เพิ่ม Fix Validator Agent

เครื่องมือตรวจสอบจะตรวจสอบว่าการแก้ไขสำเร็จหรือไม่ และตัดสินใจว่าจะออกจากลูปหรือไม่

ทำความเข้าใจเครื่องมือ

ก่อนอื่น ให้เพิ่มเครื่องมือ 3 อย่างที่เครื่องมือตรวจสอบต้องการ

👉 เปิด

code_review_assistant/tools.py

👉 ค้นหา:

# MODULE_6_STEP_3_VALIDATE_FIXED_STYLE

👉 แทนที่ด้วยเครื่องมือ 1 - เครื่องมือตรวจสอบสไตล์:

async def validate_fixed_style(tool_context: ToolContext) -> Dict[str, Any]:

"""

Validates style compliance of the fixed code.

Args:

tool_context: ADK tool context containing fixed code in state

Returns:

Dictionary with style validation results

"""

logger.info("Tool: Validating style of fixed code...")

try:

# Get the fixed code from state

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Try to extract from markdown if present

if '```python' in code_fixes:

start = code_fixes.rfind('```python') + 9

end = code_fixes.rfind('```')

if start < end:

code_fixes = code_fixes[start:end].strip()

if not code_fixes:

return {

"status": "error",

"message": "No fixed code found in state"

}

# Store the extracted fixed code

tool_context.state[StateKeys.CODE_FIXES] = code_fixes

# Run style check on fixed code

loop = asyncio.get_event_loop()

with ThreadPoolExecutor() as executor:

style_result = await loop.run_in_executor(

executor, _perform_style_check, code_fixes

)

# Compare with original

original_score = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

improvement = style_result['score'] - original_score

# Store results

tool_context.state[StateKeys.FIXED_STYLE_SCORE] = style_result['score']

tool_context.state[StateKeys.FIXED_STYLE_ISSUES] = style_result['issues']

logger.info(f"Tool: Fixed code style score: {style_result['score']}/100 "

f"(improvement: +{improvement})")

return {

"status": "success",

"fixed_style_score": style_result['score'],

"original_style_score": original_score,

"improvement": improvement,

"remaining_issues": style_result['issues'],

"perfect_style": style_result['score'] == 100

}

except Exception as e:

logger.error(f"Tool: Style validation failed: {e}", exc_info=True)

return {

"status": "error",

"message": str(e)

}

👉 ค้นหา:

# MODULE_6_STEP_3_COMPILE_FIX_REPORT

👉 แทนที่ด้วยเครื่องมือ 2 - ตัวรวบรวมรายงาน:

async def compile_fix_report(tool_context: ToolContext) -> Dict[str, Any]:

"""

Compiles comprehensive report of the fix process.

Args:

tool_context: ADK tool context with all fix pipeline data

Returns:

Comprehensive fix report

"""

logger.info("Tool: Compiling comprehensive fix report...")

try:

# Gather all data

original_code = tool_context.state.get(StateKeys.CODE_TO_REVIEW, '')

code_fixes = tool_context.state.get(StateKeys.CODE_FIXES, '')

# Test results

original_tests = tool_context.state.get(StateKeys.TEST_EXECUTION_SUMMARY, {})

fixed_tests = tool_context.state.get(StateKeys.FIX_TEST_EXECUTION_SUMMARY, {})

# Parse if strings

if isinstance(original_tests, str):

try:

original_tests = json.loads(original_tests)

except:

original_tests = {}

if isinstance(fixed_tests, str):

try:

fixed_tests = json.loads(fixed_tests)

except:

fixed_tests = {}

# Extract pass rates

original_pass_rate = 0

if original_tests:

if 'pass_rate' in original_tests:

original_pass_rate = original_tests['pass_rate']

elif 'test_summary' in original_tests:

# Handle test_runner_agent's JSON structure

summary = original_tests['test_summary']

total = summary.get('total_tests_run', 0)

passed = summary.get('tests_passed', 0)

if total > 0:

original_pass_rate = (passed / total) * 100

elif 'passed' in original_tests and 'total' in original_tests:

if original_tests['total'] > 0:

original_pass_rate = (original_tests['passed'] / original_tests['total']) * 100

fixed_pass_rate = 0

all_tests_pass = False

if fixed_tests:

if 'pass_rate' in fixed_tests:

fixed_pass_rate = fixed_tests['pass_rate']

all_tests_pass = fixed_tests.get('failed', 1) == 0

elif 'passed' in fixed_tests and 'total' in fixed_tests:

if fixed_tests['total'] > 0:

fixed_pass_rate = (fixed_tests['passed'] / fixed_tests['total']) * 100

all_tests_pass = fixed_tests.get('failed', 0) == 0

# Style scores

original_style = tool_context.state.get(StateKeys.STYLE_SCORE, 0)

fixed_style = tool_context.state.get(StateKeys.FIXED_STYLE_SCORE, 0)

# Calculate improvements

test_improvement = {

'original_pass_rate': original_pass_rate,

'fixed_pass_rate': fixed_pass_rate,

'improvement': fixed_pass_rate - original_pass_rate,

'all_tests_pass': all_tests_pass

}

style_improvement = {

'original_score': original_style,

'fixed_score': fixed_style,

'improvement': fixed_style - original_style,

'perfect_style': fixed_style == 100

}

# Determine overall status

if all_tests_pass and style_improvement['perfect_style']:

fix_status = 'SUCCESSFUL'

status_emoji = '✅'

elif test_improvement['improvement'] > 0 or style_improvement['improvement'] > 0:

fix_status = 'PARTIAL'

status_emoji = '⚠️'

else: