1. Wprowadzenie

Cześć! Podoba Ci się pomysł agentów – małych pomocników, którzy mogą wykonywać za Ciebie różne zadania bez kiwnięcia palcem, prawda? Świetnie! Ale bądźmy szczerzy, jeden agent nie zawsze wystarczy, zwłaszcza gdy pracujesz nad większymi i bardziej złożonymi projektami. Prawdopodobnie będziesz potrzebować całego zespołu takich osób. Właśnie dlatego powstały systemy wieloagentowe.

Agenty oparte na LLM-ach zapewniają niesamowitą elastyczność w porównaniu z tradycyjnym kodowaniem. Ale, jak to zwykle bywa, wiążą się one z pewnymi trudnościami. Właśnie tym zajmiemy się na tym szkoleniu.

Oto czego możesz się nauczyć – potraktuj to jako sposób na podniesienie swoich umiejętności:

Tworzenie pierwszego agenta za pomocą LangGraph: stworzymy własnego agenta za pomocą popularnej platformy LangGraph. Dowiesz się, jak tworzyć narzędzia, które łączą się z bazami danych, korzystają z najnowszego interfejsu Gemini 2 API do wyszukiwania w internecie oraz optymalizują prompty i odpowiedzi, aby Twój agent mógł wchodzić w interakcje nie tylko z modelami LLM, ale też z istniejącymi usługami. Pokażemy Ci też, jak działa wywoływanie funkcji.

Orkiestracja agentów na Twój sposób: omówimy różne sposoby orkiestracji agentów, od prostych ścieżek bezpośrednich po bardziej złożone scenariusze wielościeżkowe. Możesz to traktować jako kierowanie pracą zespołu agentów.

Systemy wieloagentowe: dowiesz się, jak skonfigurować system, w którym agenci mogą współpracować i wykonywać zadania wspólnie – wszystko dzięki architekturze opartej na zdarzeniach.

LLM Freedom: używaj najlepszego narzędzia do danego zadania. Nie jesteśmy przywiązani tylko do jednego LLM. Dowiesz się, jak używać wielu dużych modeli językowych, przypisując im różne role, aby zwiększyć możliwości rozwiązywania problemów za pomocą ciekawych „modeli myślenia”.

Treści dynamiczne? Żaden problem! Wyobraź sobie, że Twój agent tworzy dynamiczne treści dostosowane do każdego użytkownika w czasie rzeczywistym. Pokażemy Ci, jak to zrobić.

Przenoszenie do chmury za pomocą Google Cloud: zapomnij o zabawie w notatniku. Pokażemy Ci, jak zaprojektować i wdrożyć system wieloagentowy w Google Cloud, aby był gotowy do działania w rzeczywistym świecie.

Ten projekt będzie dobrym przykładem wykorzystania wszystkich omówionych technik.

2. Architektura

Praca nauczyciela lub w edukacji może być bardzo satysfakcjonująca, ale nie oszukujmy się – obciążenie pracą, zwłaszcza przygotowawczą, może być trudne. Poza tym często brakuje personelu, a korepetycje mogą być drogie. Dlatego proponujemy asystenta nauczyciela opartego na AI. To narzędzie może odciążyć nauczycieli i pomóc w przezwyciężeniu problemów wynikających z niedoboru personelu i braku niedrogich korepetycji.

Nasz asystent nauczania AI może przygotowywać szczegółowe plany lekcji, ciekawe quizy, łatwe do zrozumienia podsumowania audio i spersonalizowane zadania. Dzięki temu nauczyciele mogą skupić się na tym, co robią najlepiej: nawiązywaniu kontaktu z uczniami i pomaganiu im w polubieniu nauki.

System składa się z 2 witryn: jednej dla nauczycieli, w której mogą tworzyć plany lekcji na najbliższe tygodnie,

i jedna dla uczniów, w której mogą oni uzyskać dostęp do quizów, podsumowań audio i projektów.

Przyjrzyjmy się architekturze, która zasila naszego asystenta dydaktycznego Aidemy. Jak widzisz, podzieliliśmy go na kilka kluczowych komponentów, które współpracują ze sobą, aby to osiągnąć.

Kluczowe elementy architektury i technologie:

Google Cloud Platform (GCP): kluczowa dla całego systemu:

- Vertex AI: dostęp do modeli LLM Gemini od Google.

- Cloud Run: bezserwerowa platforma do wdrażania skonteneryzowanych agentów i funkcji.

- Cloud SQL: baza danych PostgreSQL na potrzeby danych o programie nauczania.

- Pub/Sub i Eventarc: podstawa architektury opartej na zdarzeniach, umożliwiająca asynchroniczną komunikację między komponentami.

- Cloud Storage: przechowuje podsumowania audio i pliki projektów.

- Secret Manager: bezpiecznie zarządza danymi logowania do bazy danych.

- Artifact Registry: przechowuje obrazy Dockera dla agentów.

- Compute Engine: do wdrażania samodzielnie hostowanego modelu LLM zamiast korzystania z rozwiązań dostawców.

LLM: „mózg” systemu:

- Modele Gemini od Google: (Gemini x Pro, Gemini x Flash, Gemini x Flash Thinking) używane do planowania lekcji, generowania treści, tworzenia dynamicznego kodu HTML, wyjaśniania quizów i łączenia zadań.

- DeepSeek: wykorzystywany do specjalistycznego zadania generowania zadań do samodzielnej nauki.

LangChain i LangGraph: platformy do tworzenia aplikacji LLM

- Ułatwia tworzenie złożonych przepływów pracy z wieloma agentami.

- Umożliwia inteligentne zarządzanie narzędziami (wywołaniami interfejsu API, zapytaniami do bazy danych, wyszukiwaniami w internecie).

- Wdraża architekturę opartą na zdarzeniach, aby zapewnić skalowalność i elastyczność systemu.

Nasza architektura łączy moc dużych modeli językowych z danymi strukturalnymi i komunikacją opartą na zdarzeniach, a wszystko to działa w Google Cloud. Dzięki temu możemy stworzyć skalowalnego, niezawodnego i skutecznego asystenta nauczyciela.

3. Zanim zaczniesz

W konsoli Google Cloud na stronie selektora projektów wybierz lub utwórz projekt Google Cloud. Sprawdź, czy w projekcie Cloud włączone są płatności. Dowiedz się, jak sprawdzić, czy w projekcie są włączone płatności

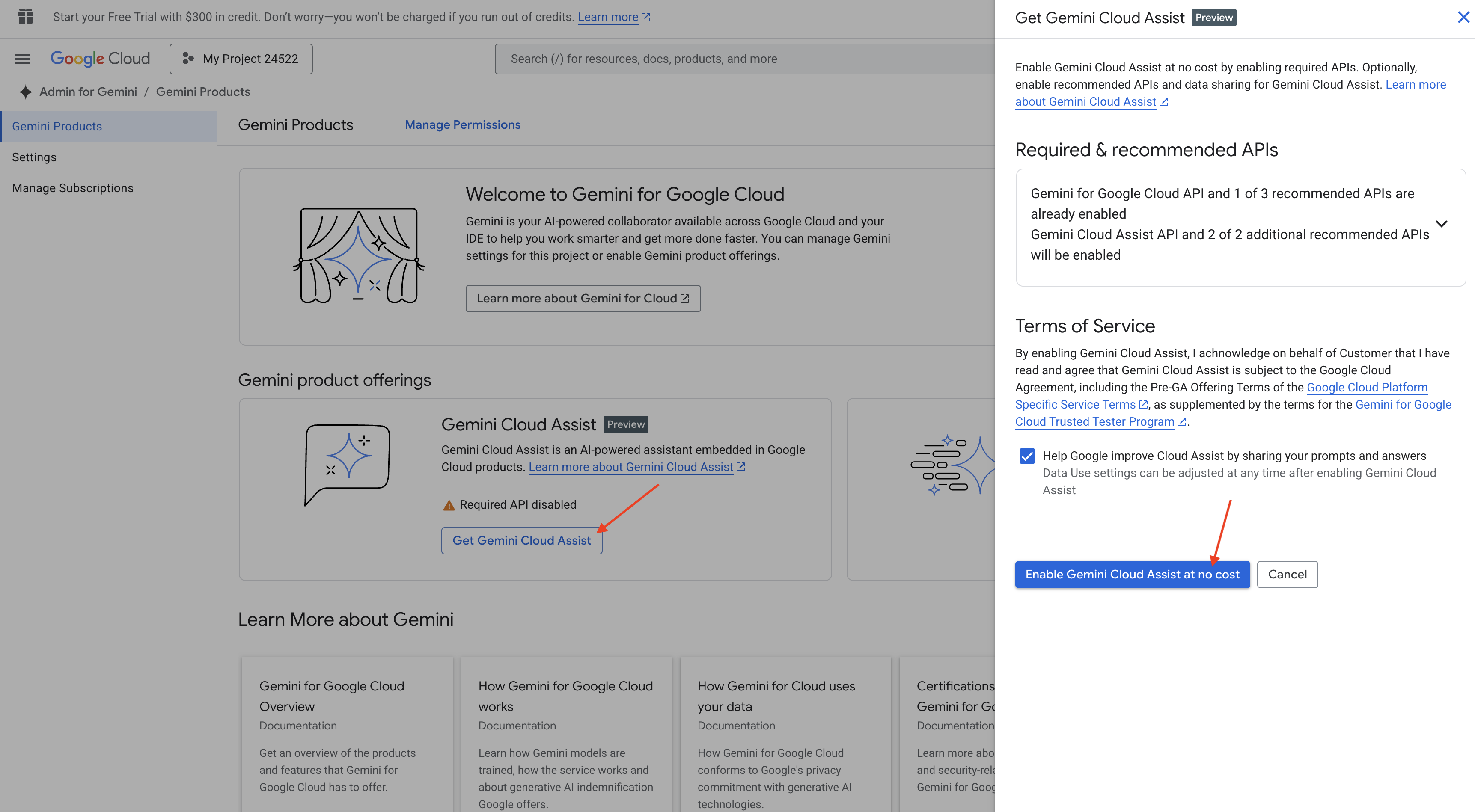

Włączanie Gemini Code Assist w środowisku IDE Cloud Shell

👉 W konsoli Google Cloud otwórz Narzędzia Gemini Code Assist i włącz Gemini Code Assist bezpłatnie, akceptując warunki.

Zignoruj konfigurację uprawnień i opuść tę stronę.

Praca w edytorze Cloud Shell

👉 U góry konsoli Google Cloud kliknij Aktywuj Cloud Shell (ikona terminala u góry panelu Cloud Shell), a następnie kliknij przycisk „Otwórz edytor” (ikona otwartego folderu z ołówkiem). W oknie otworzy się edytor kodu Cloud Shell. Po lewej stronie zobaczysz eksplorator plików.

👉 Na pasku stanu u dołu kliknij przycisk Zaloguj się w Cloud Code, jak pokazano na ilustracji. Autoryzuj wtyczkę zgodnie z instrukcjami. Jeśli na pasku stanu widzisz Cloud Code – brak projektu, wybierz tę opcję, a następnie w menu „Wybierz projekt Google Cloud” wybierz konkretny projekt Google Cloud z listy utworzonych projektów.

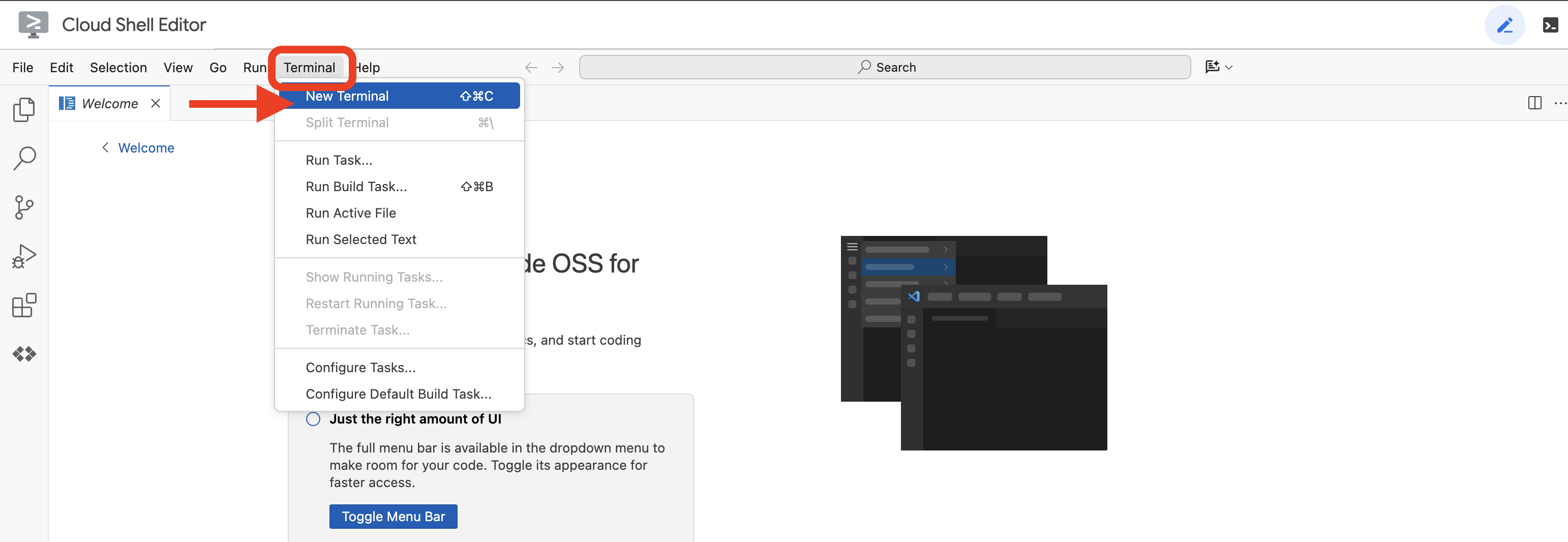

👉Otwórz terminal w chmurowym IDE  lub

lub  .

.

👉 W terminalu sprawdź, czy masz już uwierzytelnienie i czy projekt jest ustawiony na Twój identyfikator projektu. Użyj tego polecenia:

gcloud auth list

👉 Zastąp <YOUR_PROJECT_ID> identyfikatorem projektu:

echo <YOUR_PROJECT_ID> > ~/project_id.txt

gcloud config set project $(cat ~/project_id.txt)

👉Aby włączyć niezbędne interfejsy Google Cloud API, uruchom to polecenie:

gcloud services enable compute.googleapis.com \

storage.googleapis.com \

run.googleapis.com \

artifactregistry.googleapis.com \

aiplatform.googleapis.com \

eventarc.googleapis.com \

sqladmin.googleapis.com \

secretmanager.googleapis.com \

cloudbuild.googleapis.com \

cloudresourcemanager.googleapis.com \

cloudfunctions.googleapis.com \

cloudaicompanion.googleapis.com

Może to potrwać kilka minut.

Konfigurowanie uprawnień

👉Skonfiguruj uprawnienia konta usługi. W terminalu uruchom :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export SERVICE_ACCOUNT_NAME=$(gcloud compute project-info describe --format="value(defaultServiceAccount)")

echo "Here's your SERVICE_ACCOUNT_NAME $SERVICE_ACCOUNT_NAME"

👉 Przyznaj uprawnienia. W terminalu uruchom :

#Cloud Storage (Read/Write):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/storage.objectAdmin"

#Pub/Sub (Publish/Receive):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/pubsub.publisher"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/pubsub.subscriber"

#Cloud SQL (Read/Write):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/cloudsql.editor"

#Eventarc (Receive Events):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/iam.serviceAccountTokenCreator"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/eventarc.eventReceiver"

#Vertex AI (User):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/aiplatform.user"

#Secret Manager (Read):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/secretmanager.secretAccessor"

👉Sprawdź wynik w konsoli IAM

👉 Aby utworzyć instancję Cloud SQL o nazwie aidemy, uruchom w terminalu te polecenia: Będziemy tego potrzebować później, ale ponieważ ten proces może zająć trochę czasu, zrobimy to teraz.

gcloud sql instances create aidemy \

--database-version=POSTGRES_14 \

--cpu=2 \

--memory=4GB \

--region=us-central1 \

--root-password=1234qwer \

--storage-size=10GB \

--storage-auto-increase

4. Tworzenie pierwszego agenta

Zanim przejdziemy do złożonych systemów wieloagentowych, musimy stworzyć podstawowy element składowy: pojedynczego, funkcjonalnego agenta. W tej sekcji wykonamy pierwsze kroki, tworząc prostego agenta „dostawcy książek”. Agent dostawcy książek przyjmuje kategorię jako dane wejściowe i używa modelu LLM Gemini do wygenerowania reprezentacji książki w formacie JSON w tej kategorii. Następnie udostępnia te rekomendacje książek jako punkt końcowy interfejsu API REST .

👉 Na innej karcie przeglądarki otwórz konsolę Google Cloud. W menu nawigacyjnym (☰) kliknij „Cloud Run”. Kliknij przycisk „+ ... NAPISZ FUNKCJĘ”.

👉Następnie skonfigurujemy podstawowe ustawienia funkcji Cloud Run:

- Nazwa usługi:

book-provider - Region:

us-central1 - Środowisko wykonawcze:

Python 3.12 - Uwierzytelnianie: ustaw przełącznik

Allow unauthenticated invocationsna Włączone.

👉 Pozostaw inne ustawienia domyślne i kliknij Utwórz. Spowoduje to przejście do edytora kodu źródłowego.

Zobaczysz wstępnie wypełnione pliki main.py i requirements.txt.

main.py będzie zawierać logikę biznesową funkcji, a requirements.txt – potrzebne pakiety.

👉 Teraz możemy napisać kod. Zanim jednak zaczniemy, sprawdźmy, czy Gemini Code Assist może nam pomóc. Wróć do edytora Cloud Shell i kliknij ikonę Gemini Code Assist u góry. Powinien otworzyć się czat Gemini Code Assist.

👉 Wklej do pola prompta to żądanie:

Use the functions_framework library to be deployable as an HTTP function.

Accept a request with category and number_of_book parameters (either in JSON body or query string).

Use langchain and gemini to generate the data for book with fields bookname, author, publisher, publishing_date.

Use pydantic to define a Book model with the fields: bookname (string, description: "Name of the book"), author (string, description: "Name of the author"), publisher (string, description: "Name of the publisher"), and publishing_date (string, description: "Date of publishing").

Use langchain and gemini model to generate book data. the output should follow the format defined in Book model.

The logic should use JsonOutputParser from langchain to enforce output format defined in Book Model.

Have a function get_recommended_books(category) that internally uses langchain and gemini to return a single book object.

The main function, exposed as the Cloud Function, should call get_recommended_books() multiple times (based on number_of_book) and return a JSON list of the generated book objects.

Handle the case where category or number_of_book are missing by returning an error JSON response with a 400 status code.

return a JSON string representing the recommended books. use os library to retrieve GOOGLE_CLOUD_PROJECT env var. Use ChatVertexAI from langchain for the LLM call

Asystent kodu wygeneruje potencjalne rozwiązanie, udostępniając kod źródłowy i plik zależności requirements.txt. (NIE UŻYWAJ TEGO KODU)

Zachęcamy do porównania wygenerowanego przez Asystenta kodu z przetestowanym, prawidłowym rozwiązaniem podanym poniżej. Dzięki temu możesz ocenić skuteczność narzędzia i wykryć ewentualne rozbieżności. Chociaż LLM nigdy nie należy ufać bezkrytycznie, Code Assist może być świetnym narzędziem do szybkiego tworzenia prototypów i generowania początkowych struktur kodu. Warto go używać, aby zyskać przewagę na starcie.

Ponieważ są to warsztaty, użyjemy zweryfikowanego kodu podanego poniżej. Możesz jednak w wolnej chwili eksperymentować z kodem wygenerowanym przez Asystenta kodu, aby lepiej poznać jego możliwości i ograniczenia.

👉Wróć do edytora kodu źródłowego funkcji Cloud Run (na innej karcie przeglądarki). Ostrożnie zastąp dotychczasową zawartość pliku main.py kodem podanym poniżej:

import functions_framework

import json

from flask import Flask, jsonify, request

from langchain_google_vertexai import ChatVertexAI

from langchain_core.output_parsers import JsonOutputParser

from langchain_core.prompts import PromptTemplate

from pydantic import BaseModel, Field

import os

class Book(BaseModel):

bookname: str = Field(description="Name of the book")

author: str = Field(description="Name of the author")

publisher: str = Field(description="Name of the publisher")

publishing_date: str = Field(description="Date of publishing")

project_id = os.environ.get("GOOGLE_CLOUD_PROJECT")

llm = ChatVertexAI(model_name="gemini-2.0-flash-lite-001")

def get_recommended_books(category):

"""

A simple book recommendation function.

Args:

category (str): category

Returns:

str: A JSON string representing the recommended books.

"""

parser = JsonOutputParser(pydantic_object=Book)

question = f"Generate a random made up book on {category} with bookname, author and publisher and publishing_date"

prompt = PromptTemplate(

template="Answer the user query.\n{format_instructions}\n{query}\n",

input_variables=["query"],

partial_variables={"format_instructions": parser.get_format_instructions()},

)

chain = prompt | llm | parser

response = chain.invoke({"query": question})

return json.dumps(response)

@functions_framework.http

def recommended(request):

request_json = request.get_json(silent=True) # Get JSON data

if request_json and 'category' in request_json and 'number_of_book' in request_json:

category = request_json['category']

number_of_book = int(request_json['number_of_book'])

elif request.args and 'category' in request.args and 'number_of_book' in request.args:

category = request.args.get('category')

number_of_book = int(request.args.get('number_of_book'))

else:

return jsonify({'error': 'Missing category or number_of_book parameters'}), 400

recommendations_list = []

for i in range(number_of_book):

book_dict = json.loads(get_recommended_books(category))

print(f"book_dict=======>{book_dict}")

recommendations_list.append(book_dict)

return jsonify(recommendations_list)

👉Zastąp zawartość pliku requirements.txt tymi elementami:

functions-framework==3.*

google-genai==1.0.0

flask==3.1.0

jsonify==0.5

langchain_google_vertexai==2.0.13

langchain_core==0.3.34

pydantic==2.10.5

👉ustawimy Punkt wejścia funkcji: recommended

👉 Aby wdrożyć funkcję, kliknij ZAPISZ I WDROŻ (lub ZAPISZ I WDROŻ PONOWNIE). Poczekaj na zakończenie procesu wdrażania. W konsoli Cloud pojawi się stan. Może to potrwać kilka minut.

👉Po wdrożeniu wróć do edytora Cloud Shell i uruchom w terminalu to polecenie:

👉Po wdrożeniu wróć do edytora Cloud Shell i uruchom w terminalu to polecenie:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

curl -X POST -H "Content-Type: application/json" -d '{"category": "Science Fiction", "number_of_book": 2}' $BOOK_PROVIDER_URL

Powinny się w nim wyświetlić dane książki w formacie JSON.

[

{"author":"Anya Sharma","bookname":"Echoes of the Singularity","publisher":"NovaLight Publishing","publishing_date":"2077-03-15"},

{"author":"Anya Sharma","bookname":"Echoes of the Quantum Dawn","publisher":"Nova Genesis Publishing","publishing_date":"2077-03-15"}

]

Gratulacje! Udało Ci się wdrożyć funkcję Cloud Run. Jest to jedna z usług, które zintegrujemy podczas tworzenia naszego agenta Aidemy.

5. Narzędzia do tworzenia: łączenie agentów z usługą RESTFUL i danymi

Pobierz projekt szkieletowy Bootstrap. Upewnij się, że jesteś w edytorze Cloud Shell. W terminalu uruchom:

git clone https://github.com/weimeilin79/aidemy-bootstrap.git

Po uruchomieniu tego polecenia w środowisku Cloud Shell zostanie utworzony nowy folder o nazwie aidemy-bootstrap.

W panelu Eksplorator w edytorze Cloud Shell (zwykle po lewej stronie) powinien być widoczny folder utworzony podczas klonowania repozytorium Git aidemy-bootstrap. Otwórz folder główny projektu w Eksploratorze. Znajdziesz w nim podfolder planner, który też otwórz.

Zacznijmy tworzyć narzędzia, które pomogą naszym agentom stać się naprawdę przydatnymi. Jak wiesz, duże modele językowe doskonale sprawdzają się w rozumowaniu i generowaniu tekstu, ale do wykonywania zadań w rzeczywistym świecie i podawania dokładnych, aktualnych informacji potrzebują dostępu do zewnętrznych zasobów. Potraktuj te narzędzia jako „szwajcarski scyzoryk” agenta, który umożliwia mu interakcję ze światem.

Podczas tworzenia agenta łatwo jest zakodować na stałe mnóstwo szczegółów. W ten sposób powstaje agent, który nie jest elastyczny. Zamiast tego, tworząc i używając narzędzi, agent ma dostęp do zewnętrznej logiki lub systemów, co daje mu korzyści zarówno z modelu LLM, jak i z tradycyjnego programowania.

W tej sekcji stworzymy podstawy agenta planującego, którego nauczyciele będą używać do generowania konspektów lekcji. Zanim agent zacznie generować plan, chcemy wyznaczyć granice, podając więcej szczegółów na temat przedmiotu i tematu. Stworzymy 3 narzędzia:

- Wywołanie interfejsu API RESTful: interakcja z istniejącym interfejsem API w celu pobrania danych.

- Zapytanie do bazy danych: pobieranie danych strukturalnych z bazy danych Cloud SQL.

- Wyszukiwarka Google: dostęp do informacji z internetu w czasie rzeczywistym.

Pobieranie rekomendacji książek z interfejsu API

Najpierw utwórzmy narzędzie, które pobiera rekomendacje książek z interfejsu API book-provider wdrożonego w poprzedniej sekcji. Pokazuje to, jak agent może korzystać z dotychczasowych usług.

W edytorze Cloud Shell otwórz projekt aidemy-bootstrap, który został sklonowany w poprzedniej sekcji.

👉Edytuj plik book.py w folderze planner i wklej ten kod na końcu pliku:

def recommend_book(query: str):

"""

Get a list of recommended book from an API endpoint

Args:

query: User's request string

"""

region = get_next_region();

llm = VertexAI(model_name="gemini-1.5-pro", location=region)

query = f"""The user is trying to plan a education course, you are the teaching assistant. Help define the category of what the user requested to teach, respond the categroy with no more than two word.

user request: {query}

"""

print(f"-------->{query}")

response = llm.invoke(query)

print(f"CATEGORY RESPONSE------------>: {response}")

# call this using python and parse the json back to dict

category = response.strip()

headers = {"Content-Type": "application/json"}

data = {"category": category, "number_of_book": 2}

books = requests.post(BOOK_PROVIDER_URL, headers=headers, json=data)

return books.text

if __name__ == "__main__":

print(recommend_book("I'm doing a course for my 5th grade student on Math Geometry, I'll need to recommend few books come up with a teach plan, few quizes and also a homework assignment."))

Objaśnienie:

- recommend_book(query: str): ta funkcja przyjmuje zapytanie użytkownika jako dane wejściowe.

- Interakcja z LLM: używa LLM do wyodrębniania kategorii z zapytania. Pokazuje to, jak można używać modelu LLM do tworzenia parametrów narzędzi.

- Wywołanie interfejsu API: wysyła żądanie POST do interfejsu API dostawcy książek, przekazując kategorię i żądaną liczbę książek.

👉 Aby przetestować tę nową funkcję, ustaw zmienną środowiskową i uruchom :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

cd ~/aidemy-bootstrap/planner/

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

👉Zainstaluj zależności i uruchom kod, aby sprawdzić, czy działa:

cd ~/aidemy-bootstrap/planner/

python -m venv env

source env/bin/activate

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

pip install -r requirements.txt

python book.py

Powinien pojawić się ciąg znaków JSON zawierający rekomendacje książek pobrane z interfejsu API dostawcy książek. Wyniki są generowane losowo. Książki mogą się różnić, ale powinny być to 2 rekomendacje w formacie JSON.

[{"author":"Anya Sharma","bookname":"Echoes of the Singularity","publisher":"NovaLight Publishing","publishing_date":"2077-03-15"},{"author":"Anya Sharma","bookname":"Echoes of the Quantum Dawn","publisher":"Nova Genesis Publishing","publishing_date":"2077-03-15"}]

Jeśli widzisz ten komunikat, pierwsze narzędzie działa prawidłowo.

Zamiast tworzyć wywołanie interfejsu API REST z określonymi parametrami, używamy języka naturalnego („I'm doing a course...”). Następnie agent inteligentnie wyodrębnia niezbędne parametry (np. kategorię) za pomocą NLP, co pokazuje, jak wykorzystuje on rozumienie języka naturalnego do interakcji z API.

👉Usuń z pliku book.py ten kod testowy:

if __name__ == "__main__":

print(recommend_book("I'm doing a course for my 5th grade student on Math Geometry, I'll need to recommend few books come up with a teach plan, few quizes and also a homework assignment."))

Pobieranie danych o programie nauczania z bazy danych

Następnie utworzymy narzędzie, które pobiera ustrukturyzowane dane z programu nauczania z bazy danych Cloud SQL PostgreSQL. Dzięki temu agent ma dostęp do wiarygodnego źródła informacji do planowania lekcji.

Pamiętasz instancję Cloud SQL aidemy utworzoną w poprzednim kroku? Oto gdzie będzie używany.

👉 W terminalu uruchom to polecenie, aby utworzyć w nowej instancji bazę danych o nazwie aidemy-db.

gcloud sql databases create aidemy-db \

--instance=aidemy

Sprawdźmy instancję w Cloud SQL w Google Cloud Console. Powinna być tam widoczna instancja Cloud SQL o nazwie aidemy.

👉 Kliknij nazwę instancji, aby wyświetlić jej szczegóły. 👉 Na stronie szczegółów instancji Cloud SQL w menu nawigacyjnym po lewej stronie kliknij Cloud SQL Studio. Otworzy się nowa karta.

Wybierz bazę danych aidemy-db, wpisz postgres jako użytkownika i 1234qwer jako hasło.

Kliknij Uwierzytelnij.

👉W edytorze zapytań SQL Studio otwórz kartę Edytor 1 i wklej ten kod SQL:

CREATE TABLE curriculums (

id SERIAL PRIMARY KEY,

year INT,

subject VARCHAR(255),

description TEXT

);

-- Inserting detailed curriculum data for different school years and subjects

INSERT INTO curriculums (year, subject, description) VALUES

-- Year 5

(5, 'Mathematics', 'Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.'),

(5, 'English', 'Developing reading comprehension, creative writing, and basic grammar, with a focus on storytelling and poetry.'),

(5, 'Science', 'Exploring basic physics, chemistry, and biology concepts, including forces, materials, and ecosystems.'),

(5, 'Computer Science', 'Basic coding concepts using block-based programming and an introduction to digital literacy.'),

-- Year 6

(6, 'Mathematics', 'Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.'),

(6, 'English', 'Introduction to persuasive writing, character analysis, and deeper comprehension of literary texts.'),

(6, 'Science', 'Forces and motion, the human body, and introductory chemical reactions with hands-on experiments.'),

(6, 'Computer Science', 'Introduction to algorithms, logical reasoning, and basic text-based programming (Python, Scratch).'),

-- Year 7

(7, 'Mathematics', 'Algebraic expressions, geometry, and introduction to statistics and probability.'),

(7, 'English', 'Analytical reading of classic and modern literature, essay writing, and advanced grammar skills.'),

(7, 'Science', 'Introduction to cells and organisms, chemical reactions, and energy transfer in physics.'),

(7, 'Computer Science', 'Building on programming skills with Python, introduction to web development, and cyber safety.');

Ten kod SQL tworzy tabelę o nazwie curriculums i wstawia do niej przykładowe dane.

👉 Aby uruchomić kod SQL, kliknij Uruchom. Powinien pojawić się komunikat z potwierdzeniem, że instrukcje zostały wykonane.

👉 Rozwiń eksplorator, znajdź nowo utworzoną tabelę curriculums i kliknij zapytanie. Powinna otworzyć się nowa karta edytora z wygenerowanym dla Ciebie kodem SQL.

SELECT * FROM

"public"."curriculums" LIMIT 1000;

👉 Kliknij Uruchom.

W tabeli wyników powinny być widoczne wiersze danych wstawione w poprzednim kroku. Potwierdza to, że tabela i dane zostały utworzone prawidłowo.

Po utworzeniu bazy danych z przykładowymi danymi dotyczącymi programu nauczania zbudujemy narzędzie do ich pobierania.

👉 W edytorze kodu Cloud zmodyfikuj plik curriculums.py w folderze aidemy-bootstrap i wklej na końcu pliku ten kod:

def connect_with_connector() -> sqlalchemy.engine.base.Engine:

db_user = os.environ["DB_USER"]

db_pass = os.environ["DB_PASS"]

db_name = os.environ["DB_NAME"]

print(f"--------------------------->db_user: {db_user!r}")

print(f"--------------------------->db_pass: {db_pass!r}")

print(f"--------------------------->db_name: {db_name!r}")

connector = Connector()

pool = sqlalchemy.create_engine(

"postgresql+pg8000://",

creator=lambda: connector.connect(

instance_connection_name,

"pg8000",

user=db_user,

password=db_pass,

db=db_name,

),

pool_size=2,

max_overflow=2,

pool_timeout=30, # 30 seconds

pool_recycle=1800, # 30 minutes

)

return pool

def get_curriculum(year: int, subject: str):

"""

Get school curriculum

Args:

subject: User's request subject string

year: User's request year int

"""

try:

stmt = sqlalchemy.text(

"SELECT description FROM curriculums WHERE year = :year AND subject = :subject"

)

with db.connect() as conn:

result = conn.execute(stmt, parameters={"year": year, "subject": subject})

row = result.fetchone()

if row:

return row[0]

else:

return None

except Exception as e:

print(e)

return None

db = connect_with_connector()

Objaśnienie:

- Zmienne środowiskowe: kod pobiera dane logowania do bazy danych i informacje o połączeniu ze zmiennych środowiskowych (więcej informacji poniżej).

- connect_with_connector(): ta funkcja używa Cloud SQL Connector do nawiązania bezpiecznego połączenia z bazą danych.

- get_curriculum(year: int, subject: str): ta funkcja przyjmuje rok i przedmiot jako dane wejściowe, wysyła zapytanie do tabeli programów nauczania i zwraca odpowiedni opis programu.

👉Zanim uruchomimy kod, musimy ustawić kilka zmiennych środowiskowych. W terminalu uruchom:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉Aby przetestować, dodaj ten kod na końcu pliku curriculums.py:

if __name__ == "__main__":

print(get_curriculum(6, "Mathematics"))

👉 Uruchom kod:

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python curriculums.py

W konsoli powinien pojawić się opis programu nauczania matematyki dla klasy 6.

Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.

Jeśli widzisz opis programu nauczania, narzędzie bazy danych działa prawidłowo. Jeśli skrypt nadal działa, zatrzymaj go, naciskając Ctrl+C.

👉Usuń z pliku curriculums.py ten kod testowy:

if __name__ == "__main__":

print(get_curriculum(6, "Mathematics"))

👉 Aby zamknąć środowisko wirtualne, w terminalu uruchom polecenie:

deactivate

6. Narzędzia do tworzenia: dostęp do informacji z internetu w czasie rzeczywistym

Na koniec stworzymy narzędzie, które wykorzystuje integrację Gemini 2 i wyszukiwarki Google, aby uzyskiwać dostęp do informacji z internetu w czasie rzeczywistym. Dzięki temu agent może być na bieżąco i wyświetlać trafne wyniki.

Integracja Gemini 2 z interfejsem Google Search API zwiększa możliwości agenta, ponieważ zapewnia dokładniejsze i bardziej dopasowane do kontekstu wyniki wyszukiwania. Dzięki temu agenty mają dostęp do aktualnych informacji i mogą opierać swoje odpowiedzi na danych z rzeczywistego świata, co minimalizuje halucynacje. Ulepszona integracja interfejsu API ułatwia też tworzenie zapytań w języku naturalnym, dzięki czemu agenci mogą formułować złożone i zniuansowane żądania wyszukiwania.

Ta funkcja przyjmuje jako dane wejściowe zapytanie, program nauczania, przedmiot i rok, a następnie używa interfejsu Gemini API i narzędzia wyszukiwarki Google do pobierania z internetu odpowiednich informacji. Jeśli przyjrzysz się bliżej, zobaczysz, że do wywoływania funkcji używa pakietu Google Generative AI SDK bez korzystania z innych platform.

👉Edytuj plik search.py w folderze aidemy-bootstrap i wklej ten kod na końcu pliku:

model_id = "gemini-2.0-flash-001"

google_search_tool = Tool(

google_search = GoogleSearch()

)

def search_latest_resource(search_text: str, curriculum: str, subject: str, year: int):

"""

Get latest information from the internet

Args:

search_text: User's request category string

subject: "User's request subject" string

year: "User's request year" integer

"""

search_text = "%s in the context of year %d and subject %s with following curriculum detail %s " % (search_text, year, subject, curriculum)

region = get_next_region()

client = genai.Client(vertexai=True, project=PROJECT_ID, location=region)

print(f"search_latest_resource text-----> {search_text}")

response = client.models.generate_content(

model=model_id,

contents=search_text,

config=GenerateContentConfig(

tools=[google_search_tool],

response_modalities=["TEXT"],

)

)

print(f"search_latest_resource response-----> {response}")

return response

if __name__ == "__main__":

response = search_latest_resource("What are the syllabus for Year 6 Mathematics?", "Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.", "Mathematics", 6)

for each in response.candidates[0].content.parts:

print(each.text)

Objaśnienie:

- Narzędzie do definiowania – google_search_tool: opakowanie obiektu GoogleSearch w narzędzie.

- search_latest_resource(search_text: str, subject: str, year: int): ta funkcja przyjmuje jako dane wejściowe zapytanie, temat i rok, a następnie używa interfejsu Gemini API do przeprowadzenia wyszukiwania w Google.

- GenerateContentConfig: określ, że ma dostęp do narzędzia GoogleSearch.

Model Gemini wewnętrznie analizuje tekst wyszukiwania i określa, czy może bezpośrednio odpowiedzieć na pytanie, czy też musi użyć narzędzia GoogleSearch. Jest to kluczowy krok, który następuje w procesie rozumowania LLM. Model został wytrenowany pod kątem rozpoznawania sytuacji, w których konieczne jest użycie narzędzi zewnętrznych. Jeśli model zdecyduje się użyć narzędzia GoogleSearch, wywołanie jest obsługiwane przez pakiet Google Generative AI SDK. Pakiet SDK pobiera decyzję modelu i wygenerowane przez niego parametry i wysyła je do interfejsu Google Search API. Ta część jest ukryta przed użytkownikiem w kodzie.

Model Gemini integruje następnie wyniki wyszukiwania w swojej odpowiedzi. Może wykorzystać te informacje, aby odpowiedzieć na pytanie użytkownika, wygenerować podsumowanie lub wykonać inne zadanie.

👉 Aby przetestować kod, uruchom go:

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

source env/bin/activate

python search.py

Powinna się wyświetlić odpowiedź interfejsu Gemini Search API zawierająca wyniki wyszukiwania związane z „Syllabus for Year 5 Mathematics”. Dokładny wynik zależy od wyników wyszukiwania, ale będzie to obiekt JSON z informacjami o wyszukiwaniu.

Jeśli widzisz wyniki wyszukiwania, narzędzie wyszukiwarki Google działa prawidłowo. Jeśli skrypt nadal działa, zatrzymaj go, naciskając Ctrl+C.

👉 Usuń ostatnią część kodu.

if __name__ == "__main__":

response = search_latest_resource("What are the syllabus for Year 6 Mathematics?", "Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.", "Mathematics", 6)

for each in response.candidates[0].content.parts:

print(each.text)

👉Aby zamknąć środowisko wirtualne, w terminalu uruchom polecenie:

deactivate

Gratulacje! Masz teraz 3 zaawansowane narzędzia dla agenta planującego: łącznik API, łącznik bazy danych i narzędzie wyszukiwarki Google. Dzięki tym narzędziom agent będzie mieć dostęp do informacji i funkcji potrzebnych do tworzenia skutecznych planów nauczania.

7. Administrowanie za pomocą LangGraph

Po utworzeniu poszczególnych narzędzi czas je skoordynować za pomocą LangGraph. Dzięki temu będziemy mogli stworzyć bardziej zaawansowanego agenta „planującego”, który na podstawie prośby użytkownika będzie inteligentnie decydować, których narzędzi użyć i kiedy.

LangGraph to biblioteka Pythona, która ułatwia tworzenie aplikacji stanowych z wieloma aktorami przy użyciu dużych modeli językowych (LLM). To platforma do zarządzania złożonymi rozmowami i przepływami pracy z udziałem LLM, narzędzi i innych agentów.

Kluczowe pojęcia:

- Struktura grafu: LangGraph przedstawia logikę aplikacji w postaci grafu skierowanego. Każdy węzeł na wykresie reprezentuje krok w procesie (np. wywołanie LLM, wywołanie narzędzia, sprawdzenie warunku). Krawędzie określają przepływ wykonywania między węzłami.

- Stan: LangGraph zarządza stanem aplikacji w miarę jej przechodzenia przez wykres. Ten stan może obejmować zmienne takie jak dane wejściowe użytkownika, wyniki wywołań narzędzi, dane wyjściowe pośrednie z LLM i wszelkie inne informacje, które muszą być zachowane między krokami.

- Węzły: każdy węzeł reprezentuje obliczenie lub interakcję. Mogą to być:

- Węzły narzędzi: używaj narzędzia (np.wyszukiwarki internetowej lub bazy danych).

- Węzły funkcji: wykonują funkcję Pythona.

- Krawędzie: łączą węzły i określają przepływ wykonania. Mogą to być:

- Bezpośrednie krawędzie: prosty, bezwarunkowy przepływ z jednego węzła do drugiego.

- Krawędzie warunkowe: przepływ zależy od wyniku węzła warunkowego.

Do wdrożenia orkiestracji użyjemy LangGraph. Edytujmy plik aidemy.py w folderze aidemy-bootstrap, aby zdefiniować logikę LangGraph.

👉 Dodaj ten kod na końcu

aidemy.py:

tools = [get_curriculum, search_latest_resource, recommend_book]

def determine_tool(state: MessagesState):

llm = ChatVertexAI(model_name="gemini-2.0-flash-001", location=get_next_region())

sys_msg = SystemMessage(

content=(

f"""You are a helpful teaching assistant that helps gather all needed information.

Your ultimate goal is to create a detailed 3-week teaching plan.

You have access to tools that help you gather information.

Based on the user request, decide which tool(s) are needed.

"""

)

)

llm_with_tools = llm.bind_tools(tools)

return {"messages": llm_with_tools.invoke([sys_msg] + state["messages"])}

Ta funkcja odpowiada za pobieranie bieżącego stanu rozmowy, przekazywanie modelu LLM wiadomości systemowej, a następnie proszenie go o wygenerowanie odpowiedzi. Model LLM może bezpośrednio odpowiedzieć użytkownikowi lub użyć jednego z dostępnych narzędzi.

tools : ta lista zawiera zestaw narzędzi dostępnych dla agenta. Zawiera 3 funkcje narzędziowe zdefiniowane w poprzednich krokach: get_curriculum, search_latest_resource i recommend_book. llm.bind_tools(tools): „wiąże” listę narzędzi z obiektem llm. Powiązanie narzędzi informuje model LLM, że są one dostępne, i dostarcza mu informacji o sposobie ich używania (np. nazwy narzędzi, parametry, które akceptują, i działania, które wykonują).

Do wdrożenia orkiestracji użyjemy LangGraph.

👉 Dodaj ten kod na końcu

aidemy.py:

def prep_class(prep_needs):

builder = StateGraph(MessagesState)

builder.add_node("determine_tool", determine_tool)

builder.add_node("tools", ToolNode(tools))

builder.add_edge(START, "determine_tool")

builder.add_conditional_edges("determine_tool",tools_condition)

builder.add_edge("tools", "determine_tool")

memory = MemorySaver()

graph = builder.compile(checkpointer=memory)

config = {"configurable": {"thread_id": "1"}}

messages = graph.invoke({"messages": prep_needs},config)

print(messages)

for m in messages['messages']:

m.pretty_print()

teaching_plan_result = messages["messages"][-1].content

return teaching_plan_result

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, , get school curriculum, and come up with few books recommendation plus search latest resources on the internet base on the curriculum outcome. And come up with a 3 week teaching plan")

Objaśnienie:

StateGraph(MessagesState): tworzy obiektStateGraph.StateGraphto podstawowe pojęcie w LangGraph. Przedstawia przepływ pracy agenta w postaci wykresu, w którym każdy węzeł reprezentuje krok w procesie. To jakby określenie planu działania agenta.- Krawędź warunkowa: wychodząca z węzła

"determine_tool", argumenttools_conditionjest prawdopodobnie funkcją, która określa, którą krawędzią należy podążać na podstawie wyniku funkcjidetermine_tool. Krawędzie warunkowe umożliwiają rozgałęzienie grafu na podstawie decyzji LLM o tym, którego narzędzia użyć (lub czy odpowiedzieć użytkownikowi bezpośrednio). W tym momencie wkracza do akcji „inteligencja” agenta – może on dynamicznie dostosowywać swoje zachowanie do sytuacji. - Pętla: dodaje do wykresu krawędź, która łączy węzeł

"tools"z węzłem"determine_tool". W ten sposób powstaje pętla w grafie, która umożliwia agentowi wielokrotne używanie narzędzi, dopóki nie zgromadzi wystarczającej ilości informacji, aby wykonać zadanie i udzielić satysfakcjonującej odpowiedzi. Ta pętla ma kluczowe znaczenie w przypadku złożonych zadań, które wymagają wieloetapowego rozumowania i gromadzenia informacji.

Teraz przetestujmy agenta planującego, aby sprawdzić, jak koordynuje różne narzędzia.

Ten kod uruchomi funkcję prep_class z określonymi danymi wejściowymi użytkownika, symulując żądanie utworzenia planu lekcji z matematyki dla klasy 5 z geometrii z wykorzystaniem programu nauczania, rekomendacji książek i najnowszych zasobów internetowych.

👉 Jeśli terminal został zamknięty lub zmienne środowiskowe nie są już ustawione, uruchom ponownie te polecenia:

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Uruchom kod:

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

pip install -r requirements.txt

python aidemy.py

Obserwuj dziennik w terminalu. Zanim podasz ostateczny plan nauczania, sprawdź, czy agent korzysta ze wszystkich 3 narzędzi (pobiera program nauczania, rekomendacje książek i najnowsze zasoby). Pokazuje to, że orkiestracja LangGraph działa prawidłowo, a agent inteligentnie korzysta ze wszystkich dostępnych narzędzi, aby spełnić prośbę użytkownika.

================================ Human Message =================================

I'm doing a course for year 5 on subject Mathematics in Geometry, , get school curriculum, and come up with few books recommendation plus search latest resources on the internet base on the curriculum outcome. And come up with a 3 week teaching plan

================================== Ai Message ==================================

Tool Calls:

get_curriculum (xxx)

Call ID: xxx

Args:

year: 5.0

subject: Mathematics

================================= Tool Message =================================

Name: get_curriculum

Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.

================================== Ai Message ==================================

Tool Calls:

search_latest_resource (xxxx)

Call ID: xxxx

Args:

year: 5.0

search_text: Geometry

curriculum: {"content": "Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques."}

subject: Mathematics

================================= Tool Message =================================

Name: search_latest_resource

candidates=[Candidate(content=Content(parts=[Part(.....) automatic_function_calling_history=[] parsed=None

================================== Ai Message ==================================

Tool Calls:

recommend_book (93b48189-4d69-4c09-a3bd-4e60cdc5f1c6)

Call ID: 93b48189-4d69-4c09-a3bd-4e60cdc5f1c6

Args:

query: Mathematics Geometry Year 5

================================= Tool Message =================================

Name: recommend_book

[{.....}]

================================== Ai Message ==================================

Based on the curriculum outcome, here is a 3-week teaching plan for year 5 Mathematics Geometry:

**Week 1: Introduction to Shapes and Properties**

.........

Jeśli skrypt nadal działa, zatrzymaj go, naciskając Ctrl+C.

👉 (TEN KROK JEST OPCJONALNY) zastąp kod testowy innym promptem, który wymaga wywołania innych narzędzi.

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan")

👉 Jeśli terminal został zamknięty lub zmienne środowiskowe nie są już ustawione, ponownie uruchom te polecenia:

gcloud config set project $(cat ~/project_id.txt)

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 (TEN KROK JEST OPCJONALNY. WYKONAJ GO TYLKO WTEDY, GDY ZREALIZOWANO POPRZEDNI KROK) Uruchom kod ponownie:

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python aidemy.py

Co tym razem zauważasz? Które narzędzia zostały wywołane przez agenta? Powinno być widać, że tym razem agent wywołuje tylko narzędzie search_latest_resource. Dzieje się tak, ponieważ prompt nie określa, że potrzebuje pozostałych 2 narzędzi, a nasz LLM jest wystarczająco inteligentny, aby ich nie wywoływać.

================================ Human Message =================================

I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan

================================== Ai Message ==================================

Tool Calls:

get_curriculum (xxx)

Call ID: xxx

Args:

year: 5.0

subject: Mathematics

================================= Tool Message =================================

Name: get_curriculum

Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.

================================== Ai Message ==================================

Tool Calls:

search_latest_resource (xxx)

Call ID: xxxx

Args:

year: 5.0

subject: Mathematics

curriculum: {"content": "Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques."}

search_text: Geometry

================================= Tool Message =================================

Name: search_latest_resource

candidates=[Candidate(content=Content(parts=[Part(.......token_count=40, total_token_count=772) automatic_function_calling_history=[] parsed=None

================================== Ai Message ==================================

Based on the information provided, a 3-week teaching plan for Year 5 Mathematics focusing on Geometry could look like this:

**Week 1: Introducing 2D Shapes**

........

* Use visuals, manipulatives, and real-world examples to make the learning experience engaging and relevant.

Zatrzymaj skrypt, naciskając Ctrl+C.

👉 (NIE POMIJAJ TEGO KROKU!) Usuń kod testowy, aby zachować przejrzystość pliku aidemy.py :

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan")

Zdefiniowaliśmy już logikę agenta, więc uruchommy aplikację internetową Flask. Dzięki temu nauczyciele będą mogli korzystać z agenta za pomocą znanego interfejsu opartego na formularzach. Interakcje z chatbotem są powszechne w przypadku modeli LLM, ale my wybraliśmy tradycyjny interfejs przesyłania formularzy, ponieważ może być bardziej intuicyjny dla wielu nauczycieli.

👉 Jeśli terminal został zamknięty lub zmienne środowiskowe nie są już ustawione, ponownie uruchom te polecenia:

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Teraz uruchom interfejs internetowy.

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python app.py

Poszukaj komunikatów startowych w danych wyjściowych terminala Cloud Shell. Flask zwykle wyświetla komunikaty informujące o tym, że działa i na jakim porcie.

Running on http://127.0.0.1:8080

Running on http://127.0.0.1:8080

The application needs to keep running to serve requests.

👉 W menu „Podgląd w przeglądarce” w prawym górnym rogu wybierz Podejrzyj na porcie 8080. Cloud Shell otworzy nową kartę lub okno przeglądarki z podglądem internetowym aplikacji.

W interfejsie aplikacji wybierz 5 dla roku, wybierz temat Mathematics i wpisz Geometry w prośbie o dodatek.

👉 Jeśli opuścisz interfejs aplikacji, wróć do niego. Powinien wyświetlać wygenerowane dane wyjściowe.

👉 W terminalu zatrzymaj skrypt, naciskając Ctrl+C.

👉 W terminalu zamknij środowisko wirtualne:

deactivate

8. Wdrażanie agenta planującego w chmurze

Tworzenie i przesyłanie obrazu do rejestru

Czas wdrożyć to w chmurze.

👉 W terminalu utwórz repozytorium artefaktów, w którym zapiszesz obraz Dockera, który zamierzamy utworzyć.

gcloud artifacts repositories create agent-repository \

--repository-format=docker \

--location=us-central1 \

--description="My agent repository"

Powinien wyświetlić się komunikat Utworzono repozytorium [agent-repository].

👉 Aby utworzyć obraz Dockera, uruchom to polecenie.

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-planner .

👉 Musimy ponownie otagować obraz, aby był hostowany w Artifact Registry zamiast w GCR, i przesłać otagowany obraz do Artifact Registry:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-planner us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

docker push us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

Po zakończeniu przesyłania możesz sprawdzić, czy obraz został zapisany w Artifact Registry.

👉 W konsoli Google Cloud otwórz Artifact Registry. Obraz aidemy-planner powinien znajdować się w repozytorium agent-repository.

Zabezpieczanie danych logowania do bazy danych za pomocą usługi Secret Manager

Do bezpiecznego zarządzania danymi logowania do bazy danych i uzyskiwania do nich dostępu użyjemy usługi Google Cloud Secret Manager. Zapobiega to zakodowaniu na stałe informacji poufnych w kodzie aplikacji i zwiększa bezpieczeństwo.

Utworzymy osobne wpisy tajne dla nazwy użytkownika bazy danych, hasła i nazwy bazy danych. Dzięki temu możemy zarządzać każdym rodzajem danych logowania osobno.

👉 W terminalu uruchom to polecenie:

gcloud secrets create db-user

printf "postgres" | gcloud secrets versions add db-user --data-file=-

gcloud secrets create db-pass

printf "1234qwer" | gcloud secrets versions add db-pass --data-file=-

gcloud secrets create db-name

printf "aidemy-db" | gcloud secrets versions add db-name --data-file=-

Korzystanie z Menedżera obiektów tajnych to ważny krok w zabezpieczaniu aplikacji i zapobieganiu przypadkowemu ujawnieniu poufnych danych logowania. Jest zgodny ze sprawdzonymi metodami dotyczącymi bezpieczeństwa wdrożeń w chmurze.

Wdrożenie w Cloud Run

Cloud Run to w pełni zarządzana platforma bezserwerowa, która umożliwia szybkie i łatwe wdrażanie aplikacji w kontenerach. Usługa nie wymaga zarządzania infrastrukturą, dzięki czemu możesz skupić się na pisaniu i wdrażaniu kodu. Nasz planer wdrożymy jako usługę Cloud Run.

👉 W konsoli Google Cloud otwórz „Cloud Run”. Kliknij WDRÓŻ KONTENER i wybierz SERVICE. Skonfiguruj usługę Cloud Run:

- Obraz kontenera: w polu URL kliknij „Wybierz”. Znajdź adres URL obrazu przesłanego do Artifact Registry (np. us-central1-docker.pkg.dev/YOUR_PROJECT_ID/agent-repository/aidemy-planner/YOUR_IMG).

- Nazwa usługi:

aidemy-planner - Region: wybierz region

us-central1. - Uwierzytelnianie: na potrzeby tych warsztatów możesz zezwolić na „Zezwalaj na nieuwierzytelnione wywołania”. W przypadku wersji produkcyjnej prawdopodobnie zechcesz ograniczyć dostęp.

- Rozwiń sekcję Kontenery, woluminy, sieć, zabezpieczenia i na karcie Kontenery ustaw te wartości:

- Karta Ustawienia:

- Zasoby

- pamięć : 2 GiB

- Zasoby

- Karta Zmienne i obiekty tajne:

- Zmienne środowiskowe: dodaj te zmienne, klikając przycisk + Dodaj zmienną:

- Dodaj nazwę:

GOOGLE_CLOUD_PROJECTi wartość: <YOUR_PROJECT_ID> - Dodaj nazwę:

BOOK_PROVIDER_URLi ustaw wartość na adres URL funkcji dostawcy książek, który możesz określić za pomocą tego polecenia w terminalu:gcloud config set project $(cat ~/project_id.txt) gcloud run services describe book-provider \ --region=us-central1 \ --project=$PROJECT_ID \ --format="value(status.url)"

- Dodaj nazwę:

- W sekcji Obiekty tajne ujawnione jako zmienne środowiskowe dodaj te obiekty tajne, klikając przycisk + Odwołaj się do obiektu tajnego:

- Dodaj nazwę:

DB_USER, obiekt tajny: wybierzdb-useri wersję:latest - Dodaj nazwę:

DB_PASS, obiekt tajny: wybierzdb-passi wersję:latest - Dodaj nazwę:

DB_NAME, obiekt tajny: wybierzdb-namei wersję:latest

- Dodaj nazwę:

- Zmienne środowiskowe: dodaj te zmienne, klikając przycisk + Dodaj zmienną:

- Karta Ustawienia:

W pozostałych polach pozostaw wartości domyślne.

👉 Kliknij UTWÓRZ.

Cloud Run wdroży Twoją usługę.

Po wdrożeniu, jeśli nie jesteś jeszcze na stronie szczegółów, kliknij nazwę usługi, aby przejść na stronę szczegółów. Wdrożony adres URL znajdziesz u góry.

👉 W interfejsie aplikacji wybierz 7 dla roku, Mathematics jako temat i wpisz Algebra w polu Prośba o dodatek.

👉 Kliknij Wygeneruj plan. Dzięki temu agent będzie miał niezbędny kontekst do wygenerowania dostosowanego planu lekcji.

Gratulacje! Udało Ci się utworzyć plan nauczania za pomocą naszego zaawansowanego agenta AI. Pokazuje to potencjał agentów w zakresie znacznego zmniejszenia obciążenia pracą i usprawnienia zadań, co w efekcie zwiększa wydajność i ułatwia życie nauczycielom.

9. Systemy wieloagentowe

Narzędzie do tworzenia planów nauczania zostało już wdrożone. Teraz skupimy się na budowaniu portalu dla uczniów. Ten portal zapewni uczniom dostęp do testów, podsumowań audio i projektów związanych z ich zajęciami. Ze względu na zakres tej funkcji wykorzystamy możliwości systemów wieloagentowych, aby stworzyć modułowe i skalowalne rozwiązanie.

Jak wspomnieliśmy wcześniej, zamiast polegać na jednym agencie, który zajmuje się wszystkim, system wielu agentów pozwala nam podzielić zadania na mniejsze, wyspecjalizowane części, z których każda jest obsługiwana przez dedykowanego agenta. Takie podejście ma kilka kluczowych zalet:

Modułowość i łatwość konserwacji: zamiast tworzyć jednego agenta, który robi wszystko, buduj mniejsze, wyspecjalizowane agenty o dobrze zdefiniowanych obowiązkach. Dzięki modułowości system jest łatwiejszy do zrozumienia, utrzymania i debugowania. Gdy pojawi się problem, możesz go przypisać do konkretnego agenta, zamiast przeszukiwać ogromną bazę kodu.

Skalowalność: skalowanie pojedynczego, złożonego agenta może być wąskim gardłem. Dzięki systemowi wielu agentów możesz skalować poszczególnych agentów w zależności od ich konkretnych potrzeb. Jeśli na przykład jeden agent obsługuje dużą liczbę żądań, możesz łatwo uruchomić więcej jego instancji bez wpływu na resztę systemu.

Specjalizacja zespołu: pomyśl o tym w ten sposób: nie poprosisz jednego inżyniera o zbudowanie całej aplikacji od zera. Zamiast tego zbierasz zespół specjalistów, z których każdy ma wiedzę w określonej dziedzinie. Podobnie system wielu agentów pozwala wykorzystać zalety różnych dużych modeli językowych i narzędzi, przypisując je do agentów, którzy najlepiej nadają się do konkretnych zadań.

Równoległe tworzenie: różne zespoły mogą pracować nad różnymi agentami jednocześnie, co przyspiesza proces tworzenia. Agenci są niezależni, więc zmiany w przypadku jednego z nich rzadziej wpływają na innych.

Architektura oparta na zdarzeniach

Aby umożliwić skuteczną komunikację i koordynację między tymi agentami, zastosujemy architekturę opartą na zdarzeniach. Oznacza to, że agenci będą reagować na „zdarzenia” zachodzące w systemie.

Agenci subskrybują określone typy zdarzeń (np. „wygenerowano plan nauczania”, „utworzono zadanie”). Gdy wystąpi zdarzenie, odpowiedni agenci otrzymają powiadomienie i będą mogli odpowiednio zareagować. Takie rozdzielenie zwiększa elastyczność, skalowalność i szybkość reakcji w czasie rzeczywistym.

Aby zacząć, musimy mieć możliwość transmitowania tych wydarzeń. W tym celu skonfigurujemy temat Pub/Sub. Zacznijmy od utworzenia tematu o nazwie plan.

👉 Otwórz konsolę Google Cloud Pub/Sub.

👉 Kliknij przycisk Utwórz temat.

👉 Skonfiguruj temat o identyfikatorze lub nazwie plan i odznaczAdd a default subscription. Pozostałe ustawienia pozostaw domyślne i kliknij Utwórz.

Strona Pub/Sub zostanie odświeżona i w tabeli powinien być widoczny nowo utworzony temat.

Teraz zintegrujmy funkcję publikowania zdarzeń Pub/Sub z naszym agentem planującym. Dodamy nowe narzędzie, które będzie wysyłać zdarzenie „plan” do utworzonego właśnie tematu Pub/Sub. To zdarzenie poinformuje inne komponenty systemu (np. te w portalu dla uczniów), że dostępny jest nowy plan nauczania.

👉 Wróć do edytora Cloud Code i otwórz plik app.py znajdujący się w folderze planner. Dodamy funkcję publikowania wydarzenia. Zastąp:

##ADD SEND PLAN EVENT FUNCTION HERE

z tym kodem

def send_plan_event(teaching_plan:str):

"""

Send the teaching event to the topic called plan

Args:

teaching_plan: teaching plan

"""

publisher = pubsub_v1.PublisherClient()

print(f"-------------> Sending event to topic plan: {teaching_plan}")

topic_path = publisher.topic_path(PROJECT_ID, "plan")

message_data = {"teaching_plan": teaching_plan}

data = json.dumps(message_data).encode("utf-8")

future = publisher.publish(topic_path, data)

return f"Published message ID: {future.result()}"

- send_plan_event: ta funkcja przyjmuje wygenerowany plan nauczania jako dane wejściowe, tworzy klienta publikującego Pub/Sub, konstruuje ścieżkę tematu, przekształca plan nauczania w ciąg znaków JSON i publikuje wiadomość w temacie.

W tym samym pliku app.py

👉Zaktualizuj prompt, aby po wygenerowaniu planu nauczania agent wysyłał zdarzenie planu nauczania do tematu Pub/Sub. *Zastąp

### ADD send_plan_event CALL

z tymi informacjami:

send_plan_event(teaching_plan)

Dodając narzędzie send_plan_event i modyfikując prompt, umożliwiliśmy naszemu agentowi planującemu publikowanie zdarzeń w Pub/Sub, dzięki czemu inne komponenty naszego systemu mogą reagować na tworzenie nowych planów nauczania. W kolejnych sekcjach będziemy mieć funkcjonalny system wieloagentowy.

10. Umożliwianie uczniom rozwiązywania testów na żądanie

Wyobraź sobie środowisko do nauki, w którym uczniowie mają dostęp do nieograniczonej liczby quizów dostosowanych do ich indywidualnych planów nauki. Quizy te zapewniają natychmiastową informację zwrotną, w tym odpowiedzi i wyjaśnienia, co sprzyja głębszemu zrozumieniu materiału. To potencjał, który chcemy wykorzystać dzięki naszemu portalowi z quizami opartemu na AI.

Aby zrealizować tę wizję, utworzymy komponent do generowania quizów, który będzie tworzyć pytania wielokrotnego wyboru na podstawie treści planu nauczania.

👉 W panelu Eksplorator edytora Cloud Code otwórz folder portal. Otwórz kopię pliku quiz.py i wklej ten kod na końcu pliku.

def generate_quiz_question(file_name: str, difficulty: str, region:str ):

"""Generates a single multiple-choice quiz question using the LLM.

```json

{

"question": "The question itself",

"options": ["Option A", "Option B", "Option C", "Option D"],

"answer": "The correct answer letter (A, B, C, or D)"

}

```

"""

print(f"region: {region}")

# Connect to resourse needed from Google Cloud

llm = VertexAI(model_name="gemini-2.5-flash-preview-04-17", location=region)

plan=None

#load the file using file_name and read content into string call plan

with open(file_name, 'r') as f:

plan = f.read()

parser = JsonOutputParser(pydantic_object=QuizQuestion)

instruction = f"You'll provide one question with difficulty level of {difficulty}, 4 options as multiple choices and provide the anwsers, the quiz needs to be related to the teaching plan {plan}"

prompt = PromptTemplate(

template="Generates a single multiple-choice quiz question\n {format_instructions}\n {instruction}\n",

input_variables=["instruction"],

partial_variables={"format_instructions": parser.get_format_instructions()},

)

chain = prompt | llm | parser

response = chain.invoke({"instruction": instruction})

print(f"{response}")

return response

W agencie tworzy parser danych wyjściowych JSON, który jest specjalnie zaprojektowany do rozumienia i strukturyzowania danych wyjściowych LLM. Korzysta z modelu QuizQuestion, który został zdefiniowany wcześniej, aby mieć pewność, że przeanalizowane dane wyjściowe są zgodne z prawidłowym formatem (pytanie, opcje i odpowiedź).

👉 W terminalu wykonaj te polecenia, aby skonfigurować środowisko wirtualne, zainstalować zależności i uruchomić agenta:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

python -m venv env

source env/bin/activate

pip install -r requirements.txt

python app.py

👉 W menu „Podgląd w przeglądarce” w prawym górnym rogu wybierz Podejrzyj na porcie 8080. Cloud Shell otworzy nową kartę lub okno przeglądarki z podglądem internetowym aplikacji.

👉 W aplikacji internetowej kliknij link „Quizy” na górnym pasku nawigacyjnym lub na karcie na stronie indeksu. Uczeń powinien zobaczyć 3 losowo wygenerowane quizy. Te quizy są oparte na planie nauczania i pokazują możliwości naszego systemu generowania quizów opartego na AI.

👉 Aby zatrzymać proces uruchomiony lokalnie, naciśnij Ctrl+C w terminalu.

Myślenie modelu Gemini 2 w przypadku wyjaśnień

OK, mamy quizy, co jest świetnym początkiem. Ale co się stanie, jeśli uczniowie się pomylą? To właśnie wtedy się uczymy, prawda? Jeśli wyjaśnimy, dlaczego odpowiedź była nieprawidłowa i jak uzyskać prawidłową, użytkownik z większym prawdopodobieństwem ją zapamięta. Pomaga to też rozwiać wszelkie wątpliwości i zwiększyć pewność siebie.

Dlatego sięgniemy po potężne narzędzie: model „myślenia” Gemini 2. To tak, jakby dać AI trochę więcej czasu na przemyślenie sprawy przed wyjaśnieniem. Dzięki temu może przekazywać bardziej szczegółowe i lepsze opinie.

Chcemy sprawdzić, czy może pomóc uczniom, udzielając odpowiedzi i szczegółowych wyjaśnień. Aby to sprawdzić, zaczniemy od notorycznie trudnego przedmiotu, czyli rachunku różniczkowego i całkowego.

👉Najpierw otwórz edytor Cloud Code w pliku answer.py w folderze portal. Zastąp ten kod funkcji

def answer_thinking(question, options, user_response, answer, region):

return ""

z tym fragmentem kodu:

def answer_thinking(question, options, user_response, answer, region):

try:

llm = VertexAI(model_name="gemini-2.0-flash-001",location=region)

input_msg = HumanMessage(content=[f"Here the question{question}, here are the available options {options}, this student's answer {user_response}, whereas the correct answer is {answer}"])

prompt_template = ChatPromptTemplate.from_messages(

[

SystemMessage(

content=(

"You are a helpful teacher trying to teach the student on question, you were given the question and a set of multiple choices "

"what's the correct answer. use friendly tone"

)

),

input_msg,

]

)

prompt = prompt_template.format()

response = llm.invoke(prompt)

print(f"response: {response}")

return response

except Exception as e:

print(f"Error sending message to chatbot: {e}") # Log this error too!

return f"Unable to process your request at this time. Due to the following reason: {str(e)}"

if __name__ == "__main__":

question = "Evaluate the limit: lim (x→0) [(sin(5x) - 5x) / x^3]"

options = ["A) -125/6", "B) -5/3 ", "C) -25/3", "D) -5/6"]

user_response = "B"

answer = "A"

region = "us-central1"

result = answer_thinking(question, options, user_response, answer, region)

Jest to bardzo prosta aplikacja Langchain, która inicjuje model Gemini 2 Flash. Instruujemy ją, aby działała jako pomocny nauczyciel i wyjaśniała różne kwestie.

👉 W terminalu wykonaj to polecenie:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python answer.py

Dane wyjściowe powinny być podobne do przykładu podanego w oryginalnych instrukcjach. Obecny model może nie zapewniać tak dokładnego wyjaśnienia.

Okay, I see the question and the choices. The question is to evaluate the limit:

lim (x→0) [(sin(5x) - 5x) / x^3]

You chose option B, which is -5/3, but the correct answer is A, which is -125/6.

It looks like you might have missed a step or made a small error in your calculations. This type of limit often involves using L'Hôpital's Rule or Taylor series expansion. Since we have the form 0/0, L'Hôpital's Rule is a good way to go! You need to apply it multiple times. Alternatively, you can use the Taylor series expansion of sin(x) which is:

sin(x) = x - x^3/3! + x^5/5! - ...

So, sin(5x) = 5x - (5x)^3/3! + (5x)^5/5! - ...

Then, (sin(5x) - 5x) = - (5x)^3/3! + (5x)^5/5! - ...

Finally, (sin(5x) - 5x) / x^3 = - 5^3/3! + (5^5 * x^2)/5! - ...

Taking the limit as x approaches 0, we get -125/6.

Keep practicing, you'll get there!

👉 W pliku answer.py zastąp

model_name od gemini-2.0-flash-001 do gemini-2.0-flash-thinking-exp-01-21 w funkcji answer_thinking.

Spowoduje to zmianę modelu LLM na inny, który lepiej radzi sobie z rozumowaniem. Pomoże to modelowi generować lepsze wyjaśnienia.

👉 Ponownie uruchom skrypt answer.py, aby przetestować nowy model myślenia:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python answer.py

Oto przykład odpowiedzi modelu myślącego, która jest znacznie bardziej szczegółowa i zawiera wyjaśnienie krok po kroku, jak rozwiązać zadanie z rachunku różniczkowego. Podkreśla to możliwości modeli „myślących” w generowaniu wysokiej jakości wyjaśnień. Dane wyjściowe powinny być podobne do tych:

Hey there! Let's take a look at this limit problem together. You were asked to evaluate:

lim (x→0) [(sin(5x) - 5x) / x^3]

and you picked option B, -5/3, but the correct answer is actually A, -125/6. Let's figure out why!

It's a tricky one because if we directly substitute x=0, we get (sin(0) - 0) / 0^3 = (0 - 0) / 0 = 0/0, which is an indeterminate form. This tells us we need to use a more advanced technique like L'Hopital's Rule or Taylor series expansion.

Let's use the Taylor series expansion for sin(y) around y=0. Do you remember it? It looks like this:

sin(y) = y - y^3/3! + y^5/5! - ...

where 3! (3 factorial) is 3 × 2 × 1 = 6, 5! is 5 × 4 × 3 × 2 × 1 = 120, and so on.

In our problem, we have sin(5x), so we can substitute y = 5x into the Taylor series:

sin(5x) = (5x) - (5x)^3/3! + (5x)^5/5! - ...

sin(5x) = 5x - (125x^3)/6 + (3125x^5)/120 - ...

Now let's plug this back into our limit expression:

[(sin(5x) - 5x) / x^3] = [ (5x - (125x^3)/6 + (3125x^5)/120 - ...) - 5x ] / x^3

Notice that the '5x' and '-5x' cancel out! So we are left with:

= [ - (125x^3)/6 + (3125x^5)/120 - ... ] / x^3

Now, we can divide every term in the numerator by x^3:

= -125/6 + (3125x^2)/120 - ...

Finally, let's take the limit as x approaches 0. As x gets closer and closer to zero, terms with x^2 and higher powers will become very, very small and approach zero. So, we are left with:

lim (x→0) [ -125/6 + (3125x^2)/120 - ... ] = -125/6

Therefore, the correct answer is indeed **A) -125/6**.

It seems like your answer B, -5/3, might have come from perhaps missing a factor somewhere during calculation or maybe using an incorrect simplification. Double-check your steps when you were trying to solve it!

Don't worry, these limit problems can be a bit tricky sometimes! Keep practicing and you'll get the hang of it. Let me know if you want to go through another similar example or if you have any more questions! 😊

Now that we have confirmed it works, let's use the portal.

👉USUŃ z pliku answer.py ten kod testowy:

if __name__ == "__main__":

question = "Evaluate the limit: lim (x→0) [(sin(5x) - 5x) / x^3]"

options = ["A) -125/6", "B) -5/3 ", "C) -25/3", "D) -5/6"]

user_response = "B"

answer = "A"

region = "us-central1"

result = answer_thinking(question, options, user_response, answer, region)

👉Aby skonfigurować środowisko wirtualne, zainstalować zależności i uruchomić agenta, wykonaj w terminalu te polecenia:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python app.py

👉 W menu „Podgląd w przeglądarce” w prawym górnym rogu wybierz Podejrzyj na porcie 8080. Cloud Shell otworzy nową kartę lub okno przeglądarki z podglądem internetowym aplikacji.

👉 W aplikacji internetowej kliknij link „Quizy” na górnym pasku nawigacyjnym lub na karcie na stronie indeksu.

👉 Odpowiedz na wszystkie quizy i upewnij się, że przynajmniej jedna odpowiedź jest błędna, a następnie kliknij Prześlij.

Zamiast czekać na odpowiedź, przełącz się na terminal edytora Cloud. Postęp i wszelkie dane wyjściowe lub komunikaty o błędach generowane przez funkcję możesz obserwować w terminalu emulatora. 😁

👉 W terminalu zatrzymaj lokalnie działający proces, naciskając Ctrl+C.

11. OPCJONALNIE: koordynowanie agentów za pomocą Eventarc

Do tej pory portal dla uczniów generował quizy na podstawie domyślnego zestawu planów nauczania. Jest to przydatne, ale oznacza, że nasz agent planujący i agent quizów w portalu nie komunikują się ze sobą. Pamiętasz, jak dodaliśmy funkcję, dzięki której agent planujący publikuje nowo wygenerowane plany nauczania w temacie Pub/Sub? Teraz połączmy go z agentem portalu.

Chcemy, aby portal automatycznie aktualizował treści quizu za każdym razem, gdy zostanie wygenerowany nowy plan nauczania. W tym celu utworzymy w portalu punkt końcowy, który będzie mógł odbierać te nowe plany.

👉 W panelu Eksplorator edytora Cloud Code otwórz folder portal.

👉 Otwórz plik app.py do edycji. Zastąp wiersz REPLACE ## REPLACE ME! NEW TEACHING PLAN tym kodem:

@app.route('/new_teaching_plan', methods=['POST'])

def new_teaching_plan():

try:

# Get data from Pub/Sub message delivered via Eventarc

envelope = request.get_json()

if not envelope:

return jsonify({'error': 'No Pub/Sub message received'}), 400

if not isinstance(envelope, dict) or 'message' not in envelope:

return jsonify({'error': 'Invalid Pub/Sub message format'}), 400

pubsub_message = envelope['message']

print(f"data: {pubsub_message['data']}")

data = pubsub_message['data']

data_str = base64.b64decode(data).decode('utf-8')

data = json.loads(data_str)

teaching_plan = data['teaching_plan']

print(f"File content: {teaching_plan}")

with open("teaching_plan.txt", "w") as f:

f.write(teaching_plan)

print(f"Teaching plan saved to local file: teaching_plan.txt")

return jsonify({'message': 'File processed successfully'})

except Exception as e:

print(f"Error processing file: {e}")

return jsonify({'error': 'Error processing file'}), 500

Ponowne kompilowanie i wdrażanie w Cloud Run

Musisz zaktualizować i ponownie wdrożyć w Cloud Run zarówno agenta planującego, jak i agenta portalu. Dzięki temu będą one miały najnowszy kod i będą skonfigurowane do komunikacji za pomocą zdarzeń.

👉Najpierw ponownie skompilujemy i prześlemy obraz agenta planner. W terminalu uruchom:

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-planner .

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-planner us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

docker push us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

👉 Zrobimy to samo, czyli utworzymy i prześlemy obraz agenta portal:

cd ~/aidemy-bootstrap/portal/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-portal .

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-portal us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-portal

docker push us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-portal

👉 Przejdź do Artifact Registry. W sekcji agent-repository powinny być widoczne obrazy kontenerów aidemy-planner i aidemy-portal.

👉Wróć do terminala i uruchom to polecenie, aby zaktualizować obraz Cloud Run dla agenta planującego:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

gcloud run services update aidemy-planner \

--region=us-central1 \

--image=us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner:latest

Dane wyjściowe powinny być podobne do tych:

OK Deploying... Done.

OK Creating Revision...

OK Routing traffic...

Done.

Service [aidemy-planner] revision [aidemy-planner-xxxxx] has been deployed and is serving 100 percent of traffic.

Service URL: https://aidemy-planner-xxx.us-central1.run.app

Zanotuj adres URL usługi. Jest to link do wdrożonego agenta planowania. Jeśli później będziesz potrzebować adresu URL usługi agenta planującego, użyj tego polecenia:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

gcloud run services describe aidemy-planner \

--region=us-central1 \

--format 'value(status.url)'

👉 Uruchom to polecenie, aby utworzyć instancję Cloud Run dla agenta portalu.

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

gcloud run deploy aidemy-portal \

--image=us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-portal:latest \

--region=us-central1 \

--platform=managed \

--allow-unauthenticated \

--memory=2Gi \

--cpu=2 \

--set-env-vars=GOOGLE_CLOUD_PROJECT=${PROJECT_ID}

Dane wyjściowe powinny być podobne do tych:

Deploying container to Cloud Run service [aidemy-portal] in project [xxxx] region [us-central1]

OK Deploying new service... Done.

OK Creating Revision...

OK Routing traffic...

OK Setting IAM Policy...

Done.

Service [aidemy-portal] revision [aidemy-portal-xxxx] has been deployed and is serving 100 percent of traffic.

Service URL: https://aidemy-portal-xxxx.us-central1.run.app

Zanotuj adres URL usługi. Jest to link do wdrożonego portalu dla uczniów. Jeśli później będziesz potrzebować adresu URL usługi portalu dla uczniów, użyj tego polecenia:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

gcloud run services describe aidemy-portal \

--region=us-central1 \

--format 'value(status.url)'

Tworzenie aktywatora Eventarc

Pojawia się jednak ważne pytanie: jak ten punkt końcowy otrzymuje powiadomienie, gdy w temacie Pub/Sub czeka nowy plan? W takich sytuacjach Eventarc przychodzi z pomocą.

Eventarc działa jak pomost, nasłuchując określonych zdarzeń (np. nadejścia nowej wiadomości w temacie Pub/Sub) i automatycznie wywołując działania w odpowiedzi na nie. W naszym przypadku wykryje on opublikowanie nowego planu nauczania, a następnie wyśle sygnał do punktu końcowego portalu, informując go, że nadszedł czas na aktualizację.

Dzięki Eventarc, który obsługuje komunikację opartą na zdarzeniach, możemy bezproblemowo połączyć agenta planującego i agenta portalu, tworząc prawdziwie dynamiczny i elastyczny system uczenia się. To jak inteligentny posłaniec, który automatycznie dostarcza najnowsze plany lekcji we właściwe miejsce.

👉 W konsoli otwórz Eventarc.

👉 Kliknij przycisk „+ UTWÓRZ WYWOŁYWACZ”.

Skonfiguruj regułę (podstawowe ustawienia):

- Nazwa aktywatora:

plan-topic-trigger - Typ aktywatora: źródła Google

- Dostawca zdarzeń: Cloud Pub/Sub

- Typ zdarzenia:

google.cloud.pubsub.topic.v1.messagePublished - Temat Cloud Pub/Sub: wybierz

projects/PROJECT_ID/topics/plan. - Region:

us-central1. - Konto usługi:

- PRZYPISZ do konta usługi rolę

roles/iam.serviceAccountTokenCreator - Użyj wartości domyślnej: domyślne konto usługi Compute.

- PRZYPISZ do konta usługi rolę

- Miejsce docelowe zdarzenia: Cloud Run

- Usługa Cloud Run:

aidemy-portal - Zignoruj komunikat o błędzie: Odmowa uprawnień w odniesieniu do „locations/me-central2” (lub może on nie istnieć).

- Ścieżka URL usługi:

/new_teaching_plan

👉 Kliknij „Utwórz”.

Strona Aktywatory Eventarc zostanie odświeżona i w tabeli powinien być widoczny nowo utworzony aktywator.

Teraz uzyskaj dostęp do agenta planowania za pomocą jego adresu URL usługi, aby poprosić o nowy plan nauczania.

👉 Aby określić adres URL usługi agenta planującego, uruchom to polecenie w terminalu:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

gcloud run services list --platform=managed --region=us-central1 --format='value(URL)' | grep planner

👉 Otwórz wygenerowany adres URL i tym razem wypróbuj rok 5, temat Science i prośbę o dodatek atoms.