1. Introducción

Última actualización: 08/02/2022

¿Por qué es necesario el Multi-Cloud Streaming?

Las empresas buscan activamente distribuir sus cargas de trabajo en varias plataformas de nube, ya que adoptar varios proveedores de servicios en la nube en el flujo de trabajo operativo de una empresa tiene varias ventajas, como las siguientes:

- Compromiso con un solo proveedor

- Mitiga el riesgo de continuidad empresarial

- Dependencias y confianza en una sola pila de tecnología

Qué compilarás

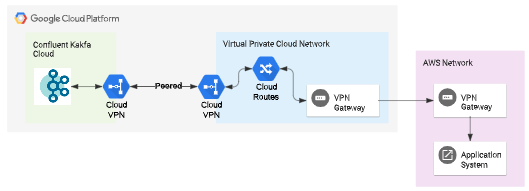

En este codelab, configurarás una transmisión de datos de múltiples nubes entre AWS y GCP con Confluent Cloud. Harás lo siguiente:

- Configura un clúster de Kafka dedicado en Confluent Cloud en GCP.

- Configura un intercambio de tráfico entre VPC entre Confluent Cloud y tu proyecto de GCP para que se pueda acceder a él en una red privada.

- Configura un túnel de VPN entre tu proyecto de AWS y tu proyecto de GCP para que los recursos de ambos hiperescaladores puedan conectarse.

- Accede a Confluent Kafka desde AWS y configura una canalización de transmisión desde AWS a GCP aprovechando Confluent Kafka Cloud.

Qué aprenderás

- Cómo configurar el intercambio de tráfico entre redes de VPC entre Confluent Cloud Kafka y tu proyecto de GCP

- Cómo configurar un túnel de VPN entre proyectos de AWS y GCP

- Cómo acceder a Confluent Cloud alojado en GCP desde tu proyecto de AWS

Este codelab se enfoca en la creación de transmisión de datos en múltiples nubes. Los conceptos y los bloques de código no relacionados con esos temas se abordan superficialmente y se proporcionan para que simplemente los copies y pegues.

Requisitos

- Acceso al proyecto de AWS

- Acceso al proyecto de GCP

- Experiencia en GCP y AWS Cloud

- Suscripción a Confluent Kafka desde GCP Marketplace

2. Cómo prepararte

Configura la conexión VPN entre AWS y GCP

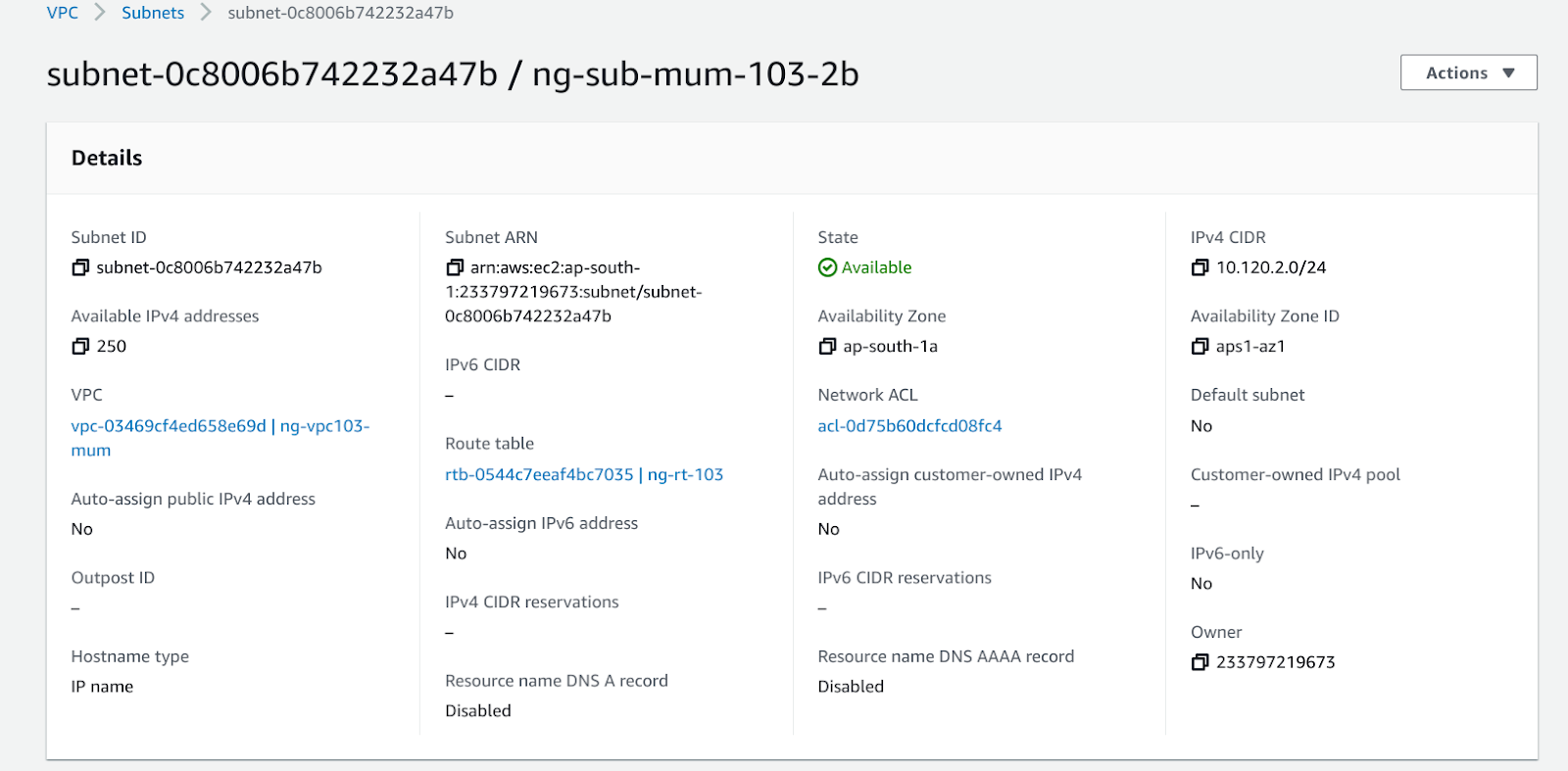

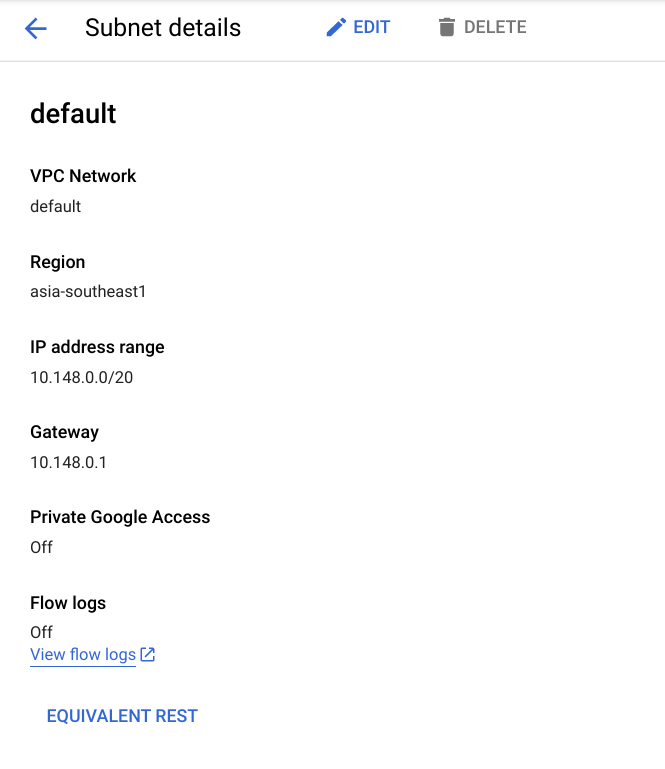

- En esta demostración, se usa la VPC predeterminada (asia-southeast1) en GCP y ng-vpc-103-mum (ap-south1) en AWS.

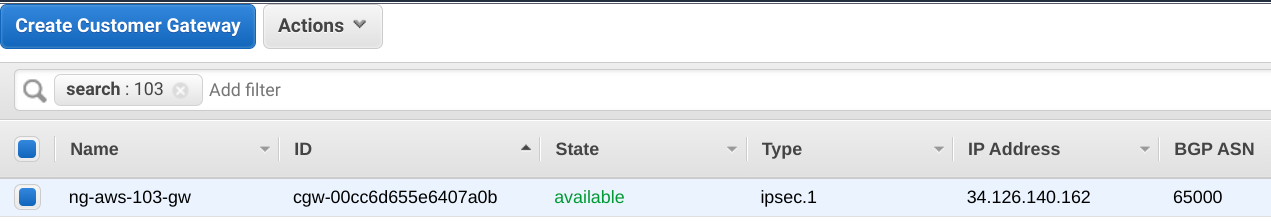

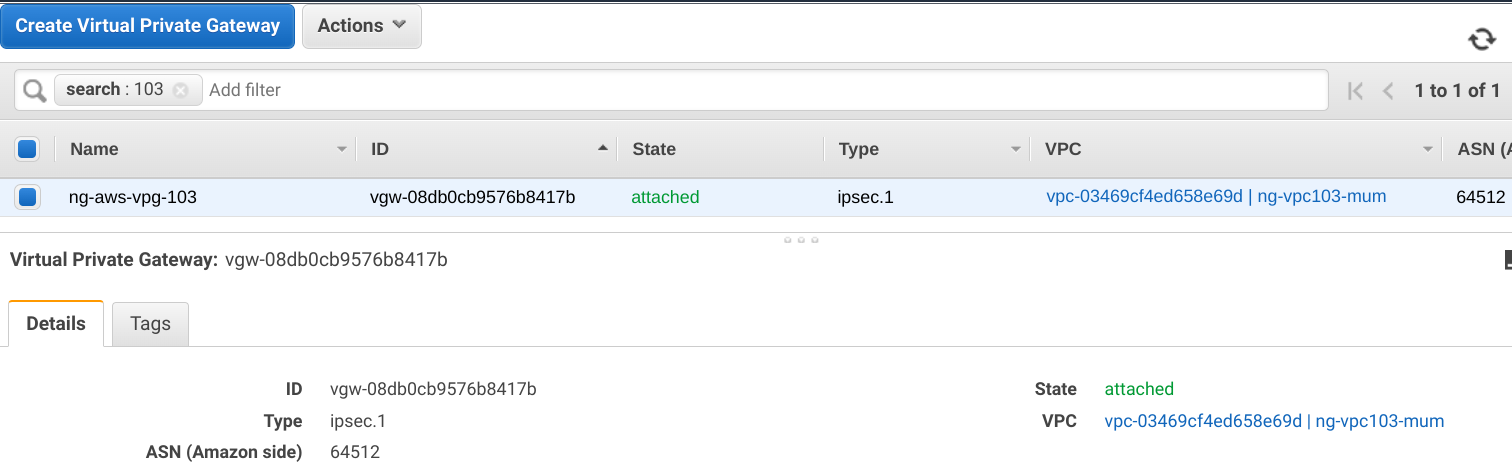

- En AWS, crea la puerta de enlace del cliente y la puerta de enlace privada virtual (VPG). Adjunta la VPG a la VPC de AWS.

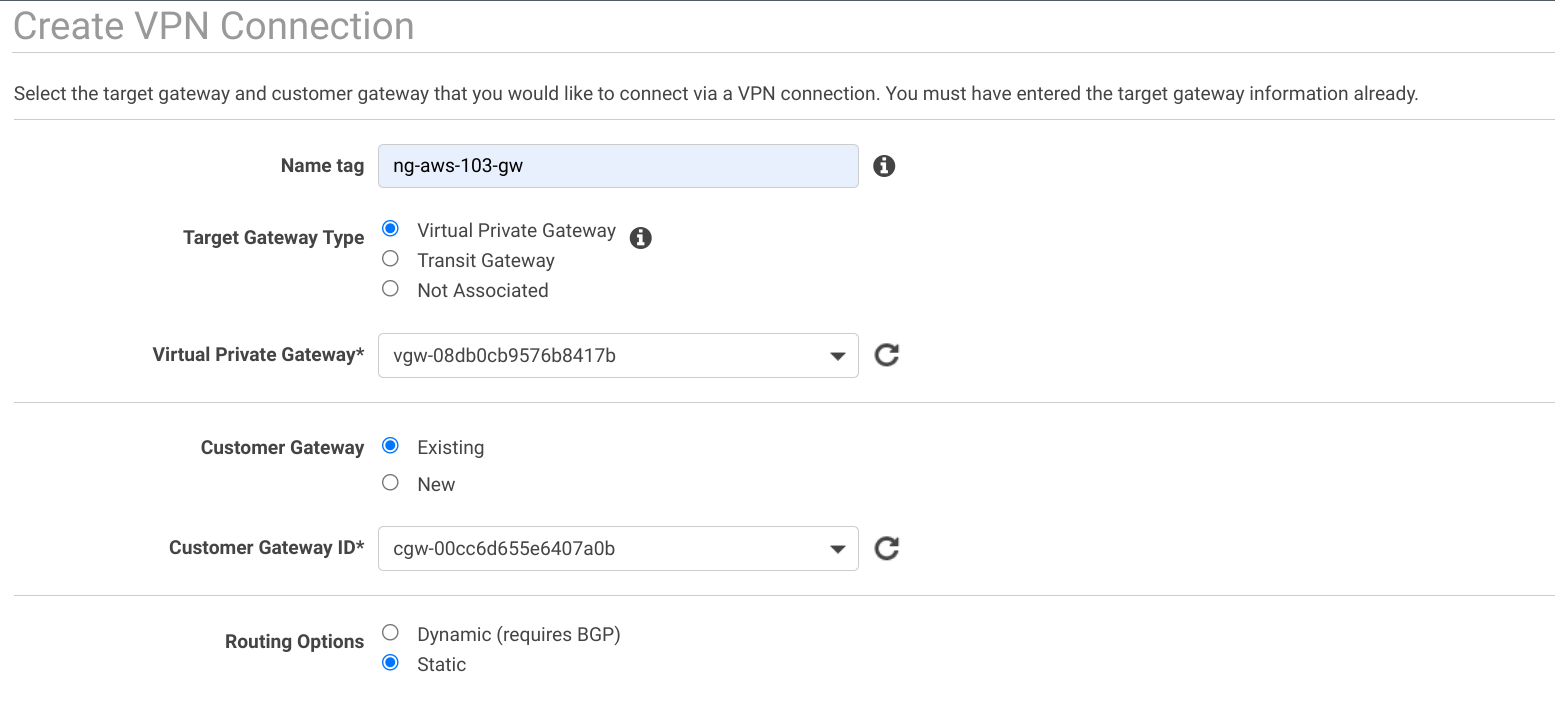

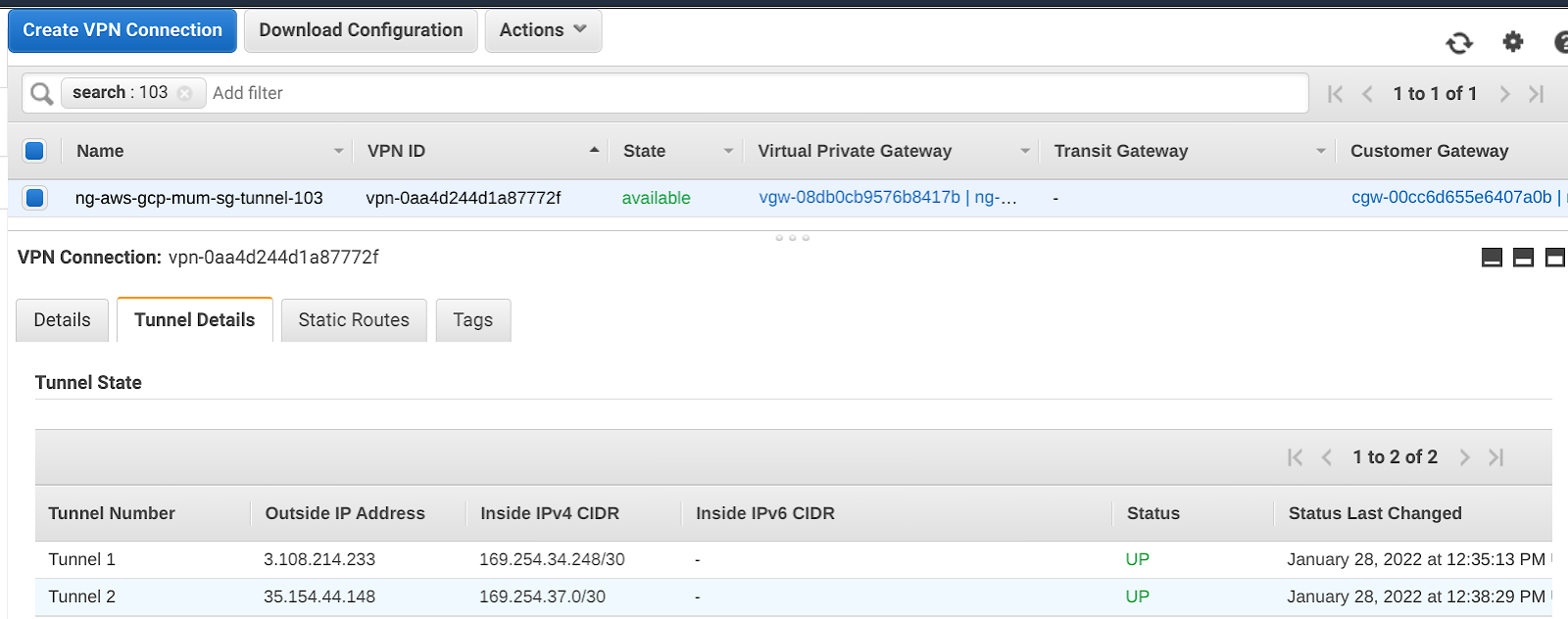

- Crea la conexión de VPN de sitio a sitio en AWS.

- Descarga el archivo de configuración del túnel creado en AWS. Seleccionar

- Proveedor : Genérico

- Plataforma : Genérica

- Software : Independiente del proveedor

- Versión de IKE : Ikev2

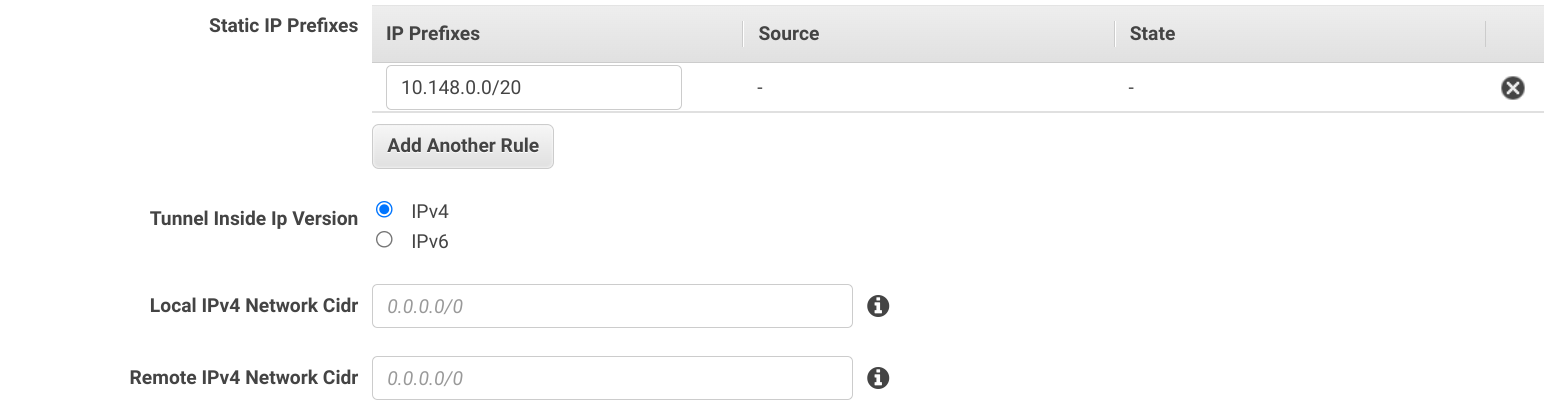

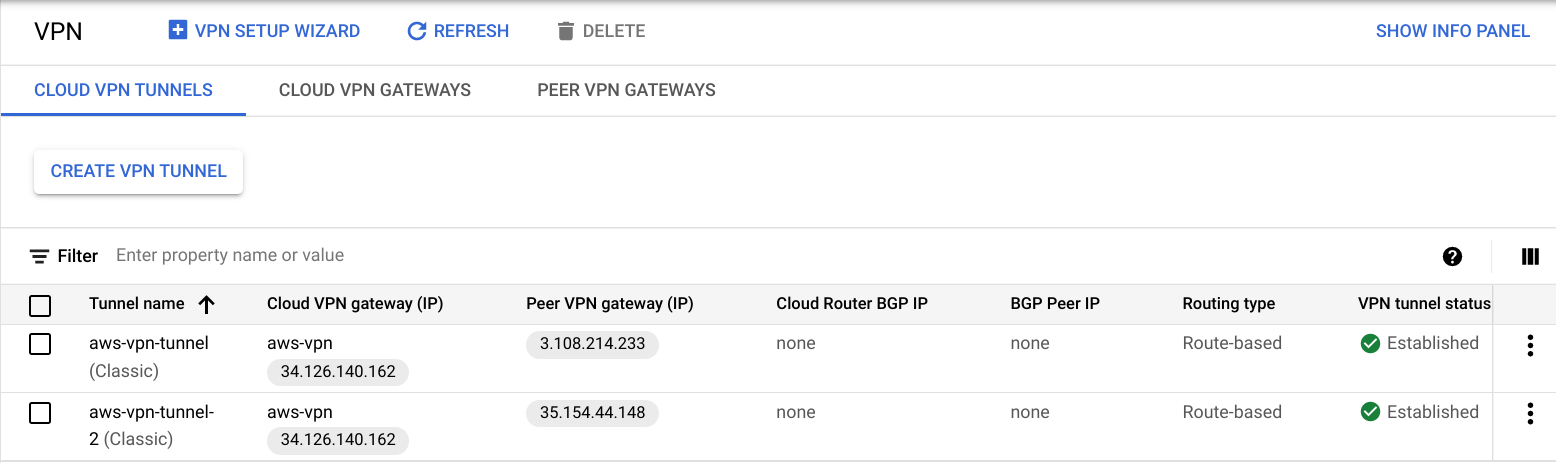

- Crea la puerta de enlace de VPN y el túnel de VPN en GCP.

Proporciona la dirección IP y la clave de Ikev2 del archivo de configuración de AWS descargado para ambos túneles.

- Una vez que se complete, el túnel debería estar EN FUNCIONAMIENTO en AWS y GCP.

Se completó la configuración del túnel.

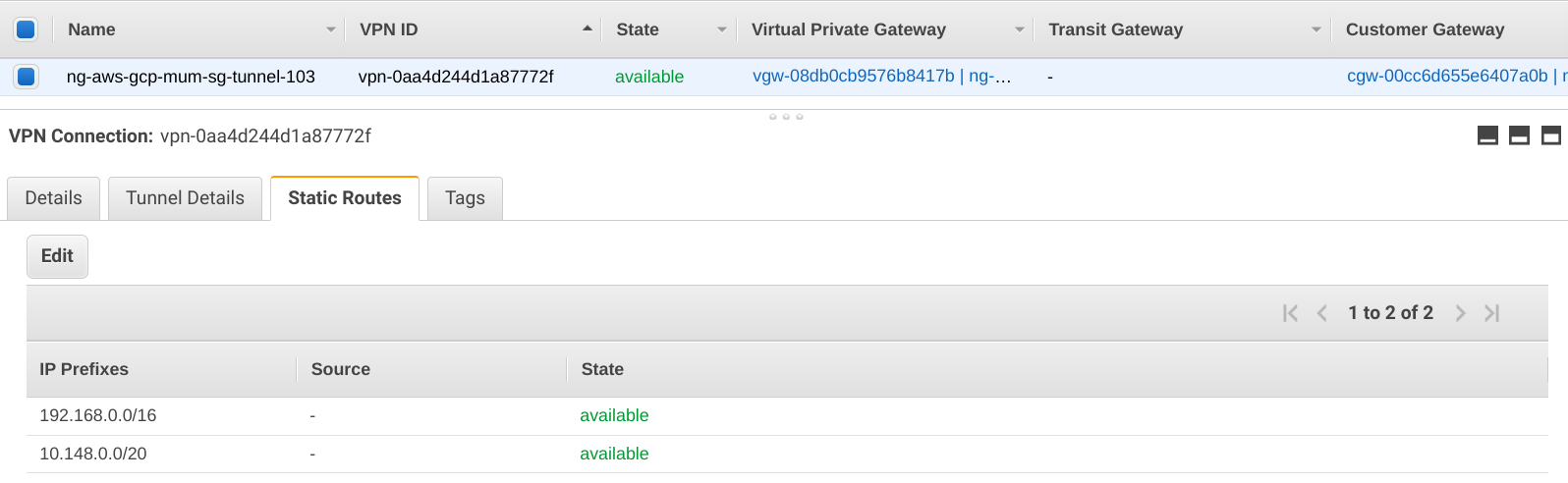

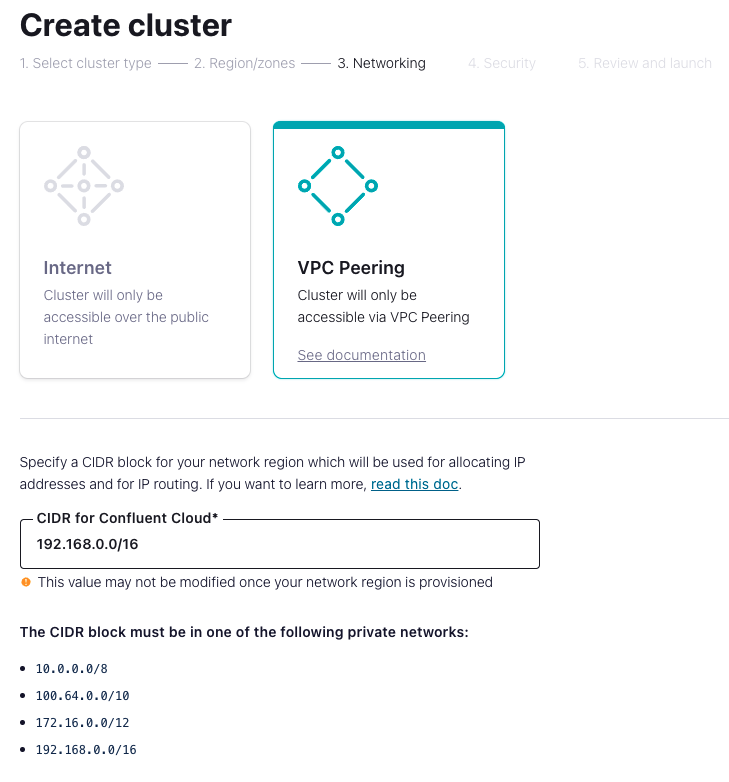

- Selecciona un bloque CIDR que se usará para configurar Confluent Cloud. Agrega esto al túnel VPN como una ruta estática en AWS.

Confluent Kafka en GCP Marketplace

- Suscríbete a Confluent Kafka desde GCP Marketplace.

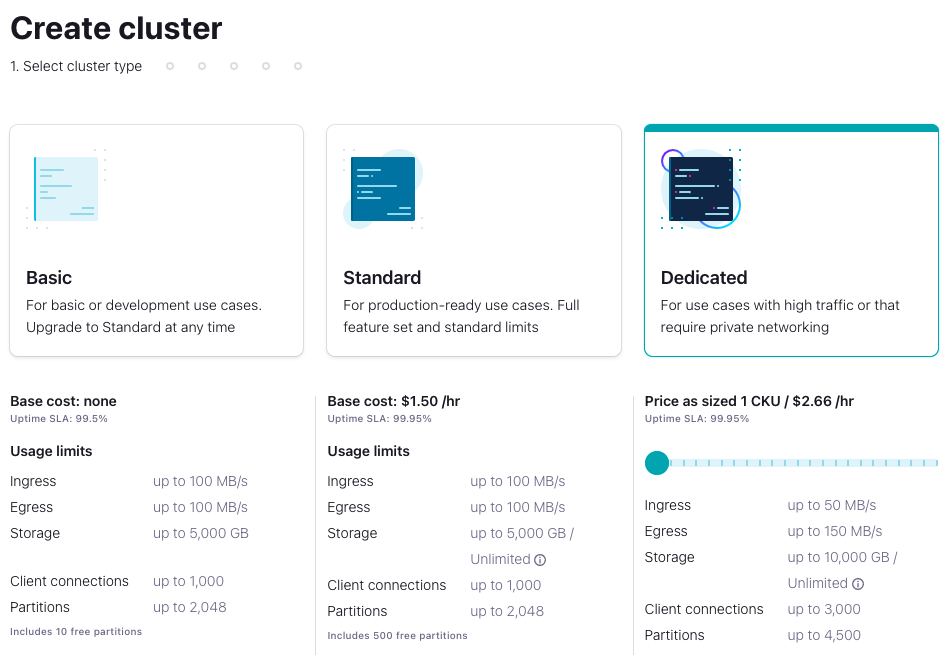

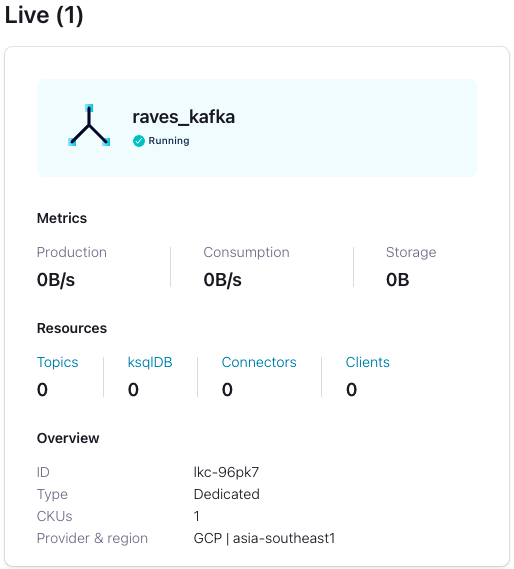

- Accede a Confluent Cloud y crea un clúster dedicado

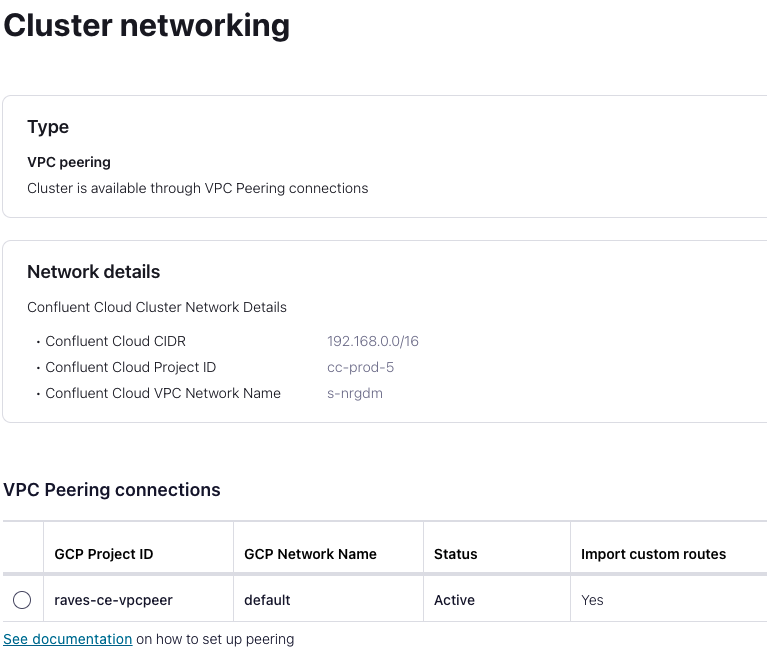

- Proporciona el ID del proyecto de GCP junto con los detalles de la red de VPC para el intercambio de tráfico.

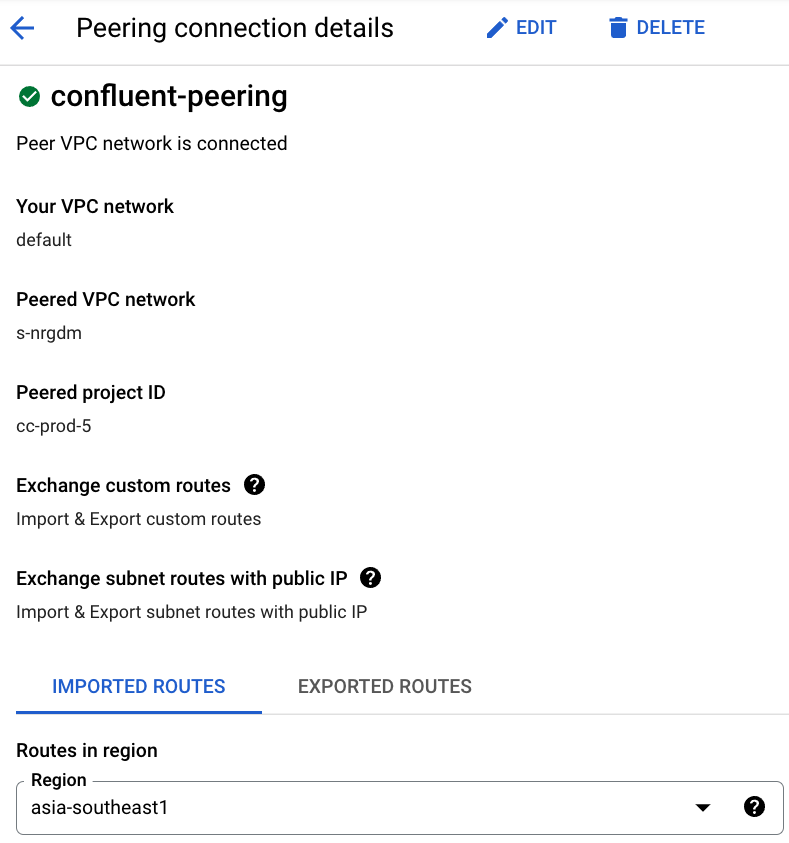

- Completa el intercambio de tráfico entre VPC en el extremo de GCP con los detalles de la red del clúster de Confluent Cloud proporcionados.

- El clúster de Confluent Cloud ahora está activo y tiene intercambio de tráfico con GCP.

- Prueba la conectividad al clúster de Confluent desde GCP.

- Aprovisiona una instancia de GCE y, luego, instala Python 3.

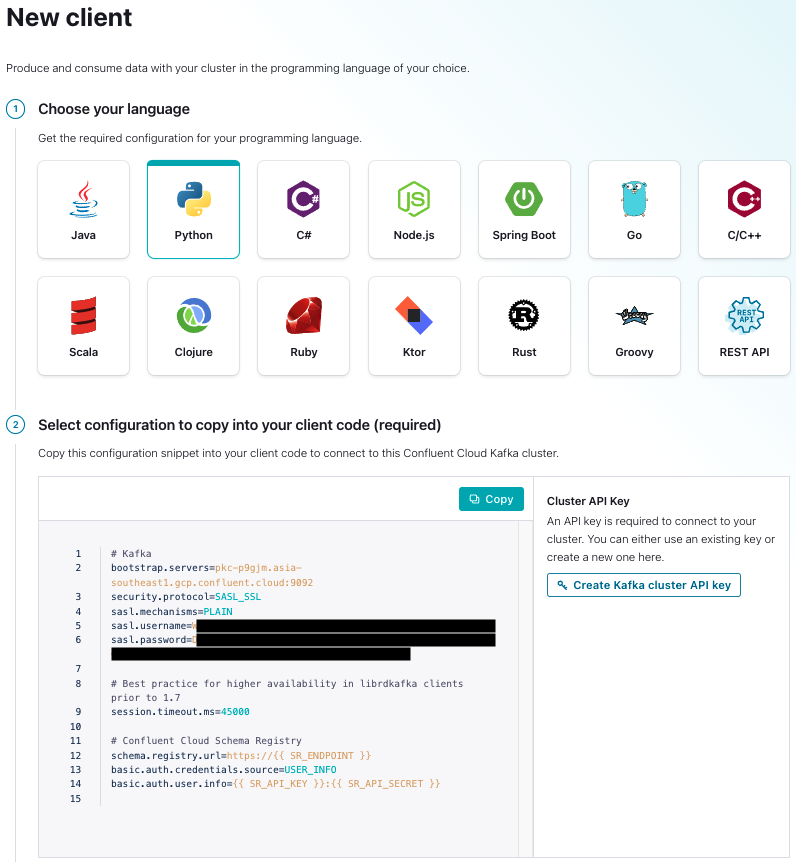

- Genera la clave de cliente de Python en Confluent Cloud

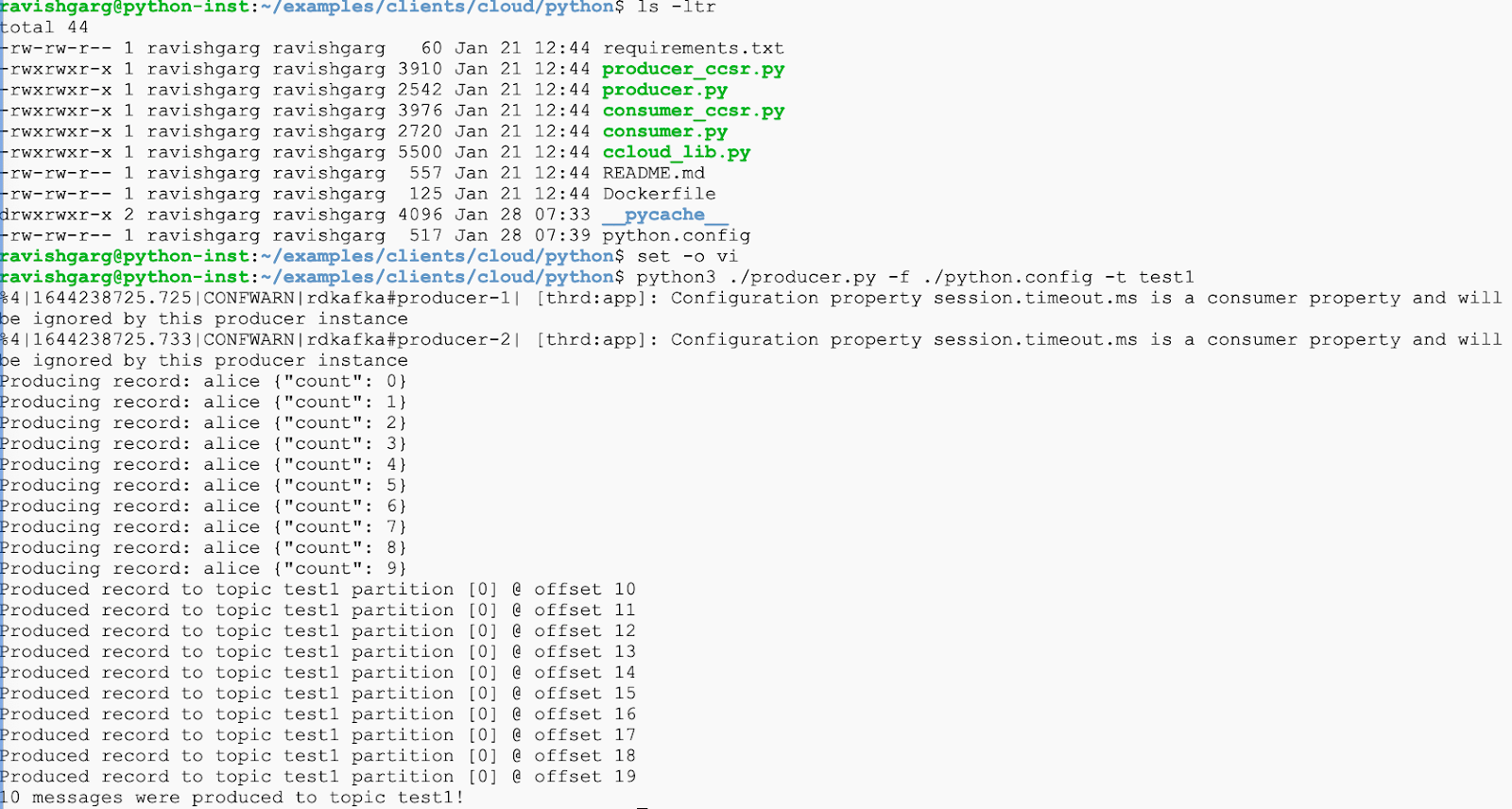

- Ejecuta la secuencia de comandos de prueba "producer.py" desde la instancia de GCP:

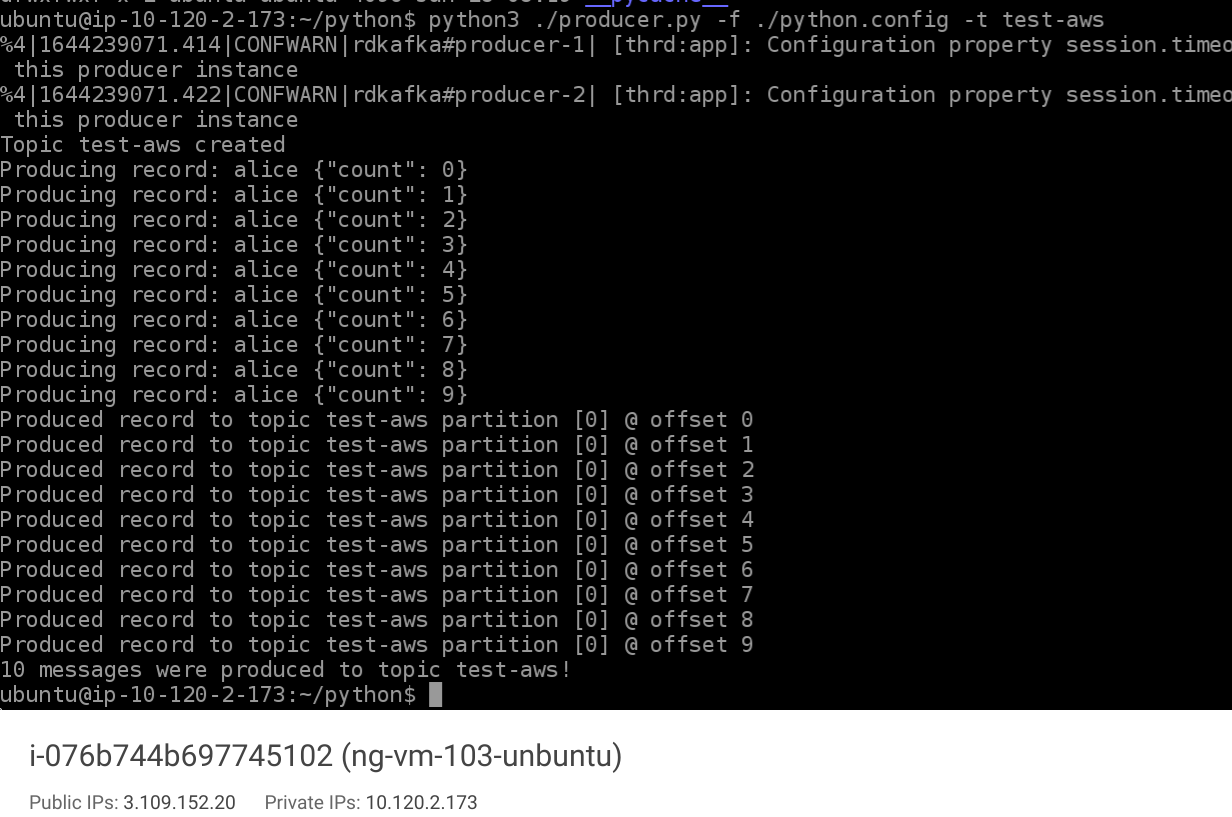

- Ahora, descarga el ejemplo de código base en la instancia de AWS y ejecuta la secuencia de comandos "producer.py" para probar la conectividad híbrida a Confluent Cloud desde GCP.

3. Felicitaciones

Felicitaciones, creaste correctamente tu plataforma de transmisión de Confluent Kafka multicloud y entre regiones entre AWS y GCP.

¿Codelabs útiles?

Consulta algunos codelabs sobre los siguientes temas: