Развертывание ИИ в мобильных, веб- и встроенных приложениях

На устройстве

Уменьшите задержку. Работайте в автономном режиме. Сохраняйте свои данные локально и конфиденциально.

Кроссплатформенный

Запускайте одну и ту же модель на Android, iOS, в веб-приложениях и на встроенных устройствах.

Мультифреймворк

Совместимость с моделями JAX, Keras, PyTorch и TensorFlow.

Полный стек ИИ-технологий

Гибкие фреймворки, готовые решения, аппаратные ускорители

Готовые решения и гибкие фреймворки

API с низким уровнем кода для типичных задач ИИ

Кроссплатформенные API для решения распространенных задач генеративного ИИ, зрения, текста и звука.

Начните работу с задачами MediaPipeРазвертывание пользовательских моделей на кросс-платформенных платформах

Эффективно запускайте модели JAX, Keras, PyTorch и TensorFlow на Android, iOS, веб-устройствах и встраиваемых устройствах, оптимизированные для традиционного машинного обучения и генеративного искусственного интеллекта.

Начните работу с LiteRT

Сократите циклы разработки с помощью визуализации

Визуализируйте трансформацию вашей модели посредством преобразования и квантования. Отладьте горячие точки, наложив результаты тестов.

Начните работу с Model Explorer

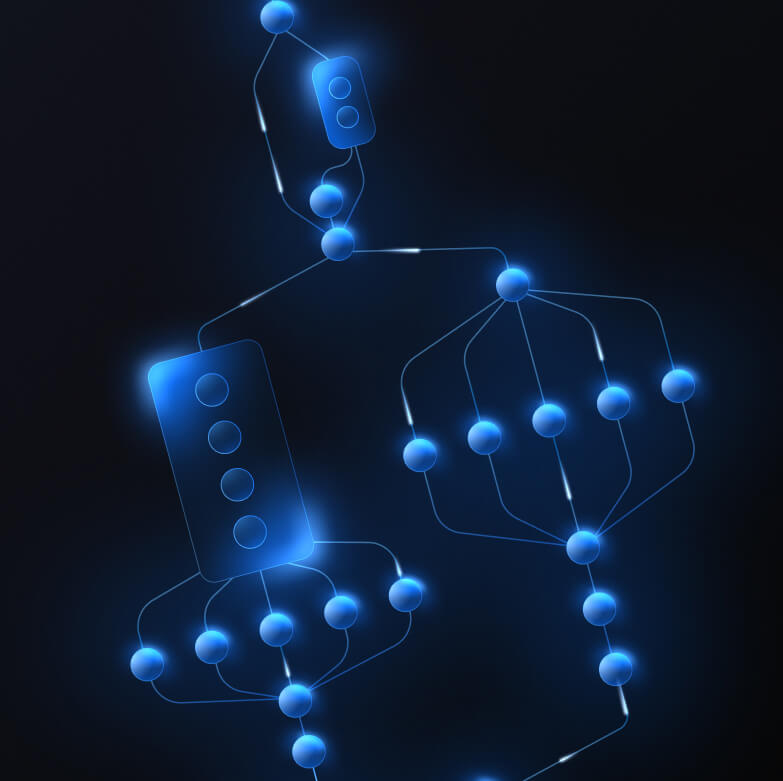

Создавайте собственные конвейеры для сложных функций машинного обучения

Создайте свою собственную задачу, эффективно объединяя несколько моделей машинного обучения вместе с логикой предварительной и последующей обработки. Запускайте ускоренные конвейеры (GPU и NPU) без блокировки на CPU.

Начните работу с фреймворком MediaPipe

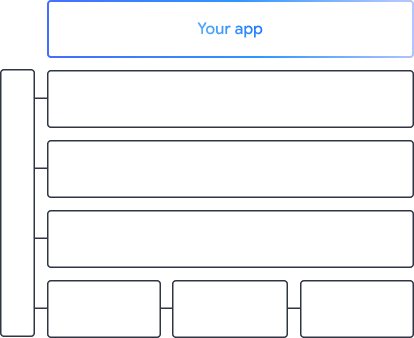

Инструменты и фреймворки, на которых работают приложения Google

Изучите полный спектр решений для искусственного интеллекта с продуктами на каждом уровне — от API с минимальным кодированием до библиотек аппаратного ускорения.

Задачи MediaPipe

Задачи MediaPipe

Быстро встраивайте функции ИИ в мобильные и веб-приложения, используя API с минимальным кодированием для выполнения распространенных задач, охватывающих генеративный ИИ, компьютерное зрение, текст и аудио.

Генеративный ИИ

Интегрируйте генеративный язык и модели изображений непосредственно в свои приложения с помощью готовых к использованию API.

Зрение

Изучите широкий спектр задач зрения, охватывающих сегментацию, классификацию, обнаружение, распознавание и ориентиры тела.

Текст и аудио

Классифицируйте текст и аудио по многим категориям, включая язык, тональность и ваши собственные категории.

Начать

Документация по задачам

Найдите все наши готовые задачи MediaPipe с низким кодом, включая документацию и примеры кода.

Генеративные задачи ИИ

Запускайте LLM и модели диффузии на периферии с помощью наших генеративных задач ИИ MediaPipe.

Попробуйте демо-версии

Изучите нашу библиотеку задач MediaPipe и попробуйте выполнить их самостоятельно.

Документация производителя модели

Настройте модели в наших задачах MediaPipe, используя собственные данные.