Wdrażanie AI w aplikacjach mobilnych, internetowych i osadzonych

-

Na urządzeniu

zmniejszyć opóźnienia; Praca offline. Zadbaj o prywatność i lokalny charakter danych.

-

Na wielu platformach

Używanie tego samego modelu na Androidzie, iOS, w internecie i w ramach aplikacji.

-

Wiele platform

Zgodność z modelami JAX, Keras, PyTorch i TensorFlow.

-

Pełny zestaw AI do stosowania na urządzeniach peryferyjnych

Elastyczne platformy, gotowe rozwiązania, akceleratory sprzętowe

Gotowe rozwiązania i elastyczne ramy

Interfejsy API do tworzenia aplikacji bez kodowania do typowych zadań związanych z AI

Interfejsy API na wiele platform do wykonywania typowych zadań związanych z generatywną AI, obrazowaniem, tekstem i dźwiękiem.

Zaczynaj korzystać z zadań MediaPipeWdrażanie modeli niestandardowych na różnych platformach

wydajnie uruchamiać modele JAX, Keras, PyTorch i TensorFlow na urządzeniach z Androidem, iOS, w przeglądarce i wbudowanych, zoptymalizowanych pod kątem tradycyjnych systemów uczących się i generatywnej AI;

Pierwsze kroki z LiteRT

Skrócenie cykli programowania dzięki wizualizacji

Wizualizacja przekształcenia modelu przez konwersję i kwantyzację. Debugowanie obszarów problemowych przez nakładanie wyników testów porównawczych.

Pierwsze kroki z Eksploratorem modeli

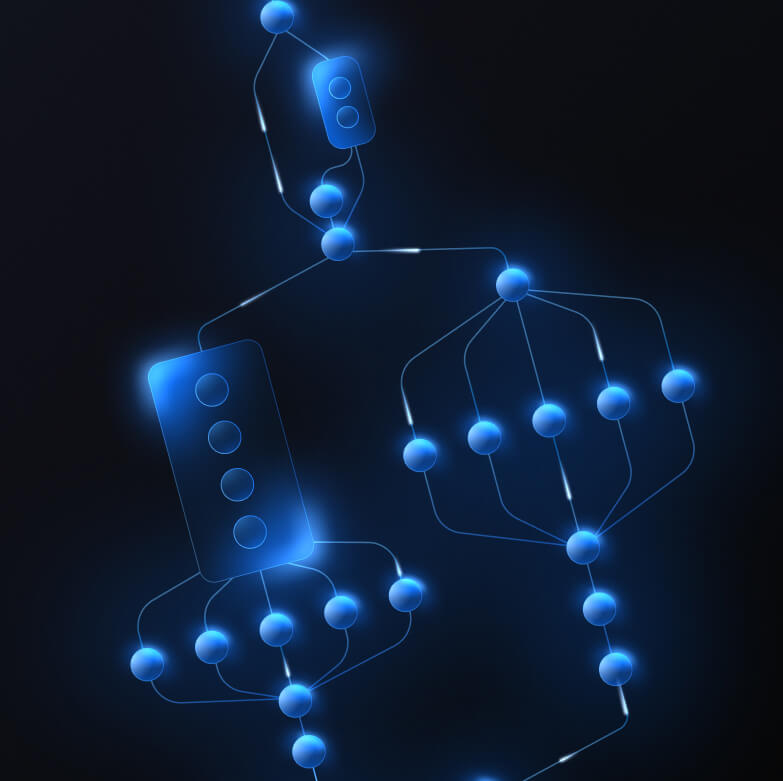

tworzyć niestandardowe potoki na potrzeby złożonych funkcji ML.

Utwórz własne zadanie, łącząc wydajnie wiele modeli ML z logiką wstępną i końcową. Uruchamianie przyspieszonych ścieżek (GPU i NPU) bez blokowania procesora CPU.

Pierwsze kroki z platformą MediaPipe Framework

narzędzia i platformy, które obsługują aplikacje Google;

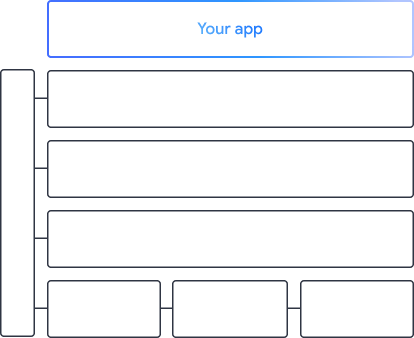

Poznaj pełną platformę AI Edge z produktami na każdym poziomie – od interfejsów API typu low-code po biblioteki przyspieszające działanie na konkretnym sprzęcie.

MediaPipe Tasks

MediaPipe Tasks

Szybko twórz funkcje AI w aplikacjach mobilnych i internetowych za pomocą interfejsów API, które nie wymagają pisania dużych ilości kodu. Wykorzystaj je do wykonywania typowych zadań związanych z generatywną AI, rozpoznawaniem obrazów, tekstem i dźwiękiem.

Generatywna AI

Zintegruj modele generowania języka i obrazów bezpośrednio ze swoimi aplikacjami, korzystając z gotowych interfejsów API.

Vision

Poznaj szeroki zakres zadań związanych z wizualizacją, obejmujący podział na segmenty, klasyfikację, wykrywanie, rozpoznawanie i lokalizowanie punktów orientacyjnych ciała.

Tekst i dźwięk

Klasyfikuj tekst i dźwięk w różnych kategoriach, w tym języka, nastroju i własnych kategorii.

Rozpocznij

MediaPipe Framework

MediaPipe Framework

Platforma niskiego poziomu używana do tworzenia wydajnych przyspieszonych ścieżek ML, często obejmująca wiele modeli ML połączonych z przetwarzaniem wstępnym i pochodnym.

LiteRT

LiteRT

Wdrażaj modele AI utworzone w dowolnym frameworku na urządzeniach mobilnych, w internecie i na mikrokontrolerach z optymalizacją przyspieszenia sprzętowego.

Wiele platform

Konwertuj modele z JAX, Keras, PyTorch i TensorFlow, aby można było je uruchamiać na urządzeniach brzegowych.

Na wielu platformach

Uruchom ten sam model na Androidzie, iOS, w internecie i na mikrokontrolerach z użyciem natywnych pakietów SDK.

Lekka i szybka

Środowisko wykonawcze LiteRT zajmuje tylko kilka megabajtów i umożliwia przyspieszenie modelu na procesorach CPU, GPU i NPU.

Rozpocznij

Eksplorator modeli

Eksplorator modeli

Wizualnie przeglądaj, debuguj i porównuj modele. Nakładaj testy porównawcze wydajności i dane liczbowe, aby wskazywać problematyczne obszary.

Gemini Nano na Androidzie i w Chrome

Twórz rozwiązania oparte na generatywnej AI przy użyciu najskuteczniejszego modelu na urządzeniu od Google