Implantar a IA em aplicativos para dispositivos móveis, Web e incorporados

-

No dispositivo

reduzir a latência. Trabalhar off-line Mantenha seus dados locais e privados.

-

Multiplataforma

Execute o mesmo modelo no Android, iOS, Web e incorporado.

-

Vários frameworks

Compatível com modelos JAX, Keras, PyTorch e TensorFlow.

-

Pilha completa de IA

Frameworks flexíveis, soluções chave na mão e aceleradores de hardware

Soluções prontas e frameworks flexíveis

APIs de pouco código para tarefas comuns de IA

APIs multiplataforma para lidar com tarefas comuns de IA generativa, visão, texto e áudio.

Comece a usar as tarefas do MediaPipeImplantar modelos personalizados em várias plataformas

Execute modelos JAX, Keras, PyTorch e TensorFlow com eficiência em dispositivos Android, iOS, Web e incorporados, otimizados para ML tradicional e IA generativa.

Comece a usar o LiteRT

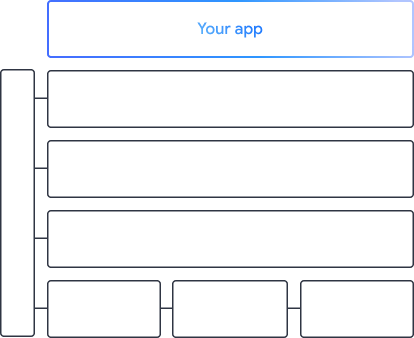

Encurtar os ciclos de desenvolvimento com a visualização

Visualize a transformação do seu modelo por conversão e quantização. Depurar pontos de acesso sobrepondo os resultados de comparativos.

Comece a usar o Model Explorer

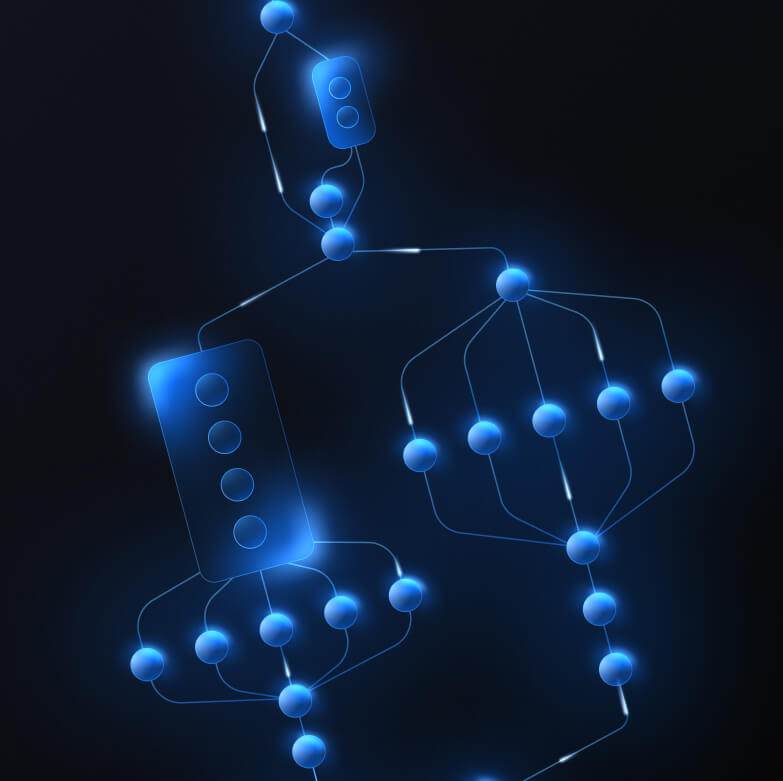

Criar pipelines personalizados para recursos complexos de ML

Crie sua própria tarefa encadeando vários modelos de ML com a lógica de pré e pós-processamento. Executar pipelines acelerados (GPU e NPU) sem bloquear a CPU.

Comece a usar o MediaPipe Framework

Ferramentas e frameworks que alimentam os apps do Google

Conheça toda a pilha de IA de ponta, com produtos em todos os níveis, de APIs de pouco código a bibliotecas de aceleração específicas de hardware.

Tarefas do MediaPipe

Tarefas do MediaPipe

Crie recursos de IA rapidamente em apps para dispositivos móveis e Web usando APIs de pouco código para tarefas comuns que abrangem IA generativa, visão computacional, texto e áudio.

IA generativa

Integre modelos de imagem e linguagem generativa diretamente aos seus apps com APIs prontas para uso.

Vision

Conheça uma grande variedade de tarefas de visão que abrangem segmentação, classificação, detecção, reconhecimento e pontos de referência do corpo.

Texto e áudio

Classifique texto e áudio em várias categorias, incluindo idioma, sentimento e suas próprias categorias personalizadas.

Primeiros passos

Framework MediaPipe

Framework MediaPipe

Um framework de baixo nível usado para criar pipelines de ML acelerados de alto desempenho, muitas vezes incluindo vários modelos de ML combinados com pré e pós-processamento.

LiteRT

LiteRT

Implante modelos de IA criados em qualquer framework em dispositivos móveis, na Web e em microcontroladores com aceleração otimizada específica para hardware.

Vários frameworks

Converta modelos do JAX, Keras, PyTorch e TensorFlow para execução na borda.

Multiplataforma

Execute o mesmo modelo em Android, iOS, Web e microcontroladores com SDKs nativos.

Leve e rápido

O ambiente de execução eficiente do LiteRT ocupa apenas alguns megabytes e permite a aceleração do modelo em CPUs, GPUs e NPUs.

Primeiros passos

Model Explorer

Model Explorer

Analise visualmente, depure e compare seus modelos. Sobreponha comparativos de mercado e números de desempenho para identificar pontos problemáticos.

Gemini Nano no Android e no Chrome

Crie experiências de IA generativa usando o modelo mais eficiente do Google no dispositivo