1. מבוא

סקירה כללית

בשיעור ה-Lab הזה תכירו כמה מהתכונות של Network Connectivity Center.

Network Connectivity Center (NCC) הוא מודל מישור בקרה רכזת ודיבור לניהול קישוריות הרשת ב-Google Cloud. משאב המרכז מספק מודל מרכזי לניהול קישוריות לחיבור חישורים. נכון לעכשיו, מערכת NCC תומכת במשאבי הרשת הבאים בדיבורים:

- קבצים מצורפים ל-VLAN

- נתבים מכשירי חשמל

- HA VPN

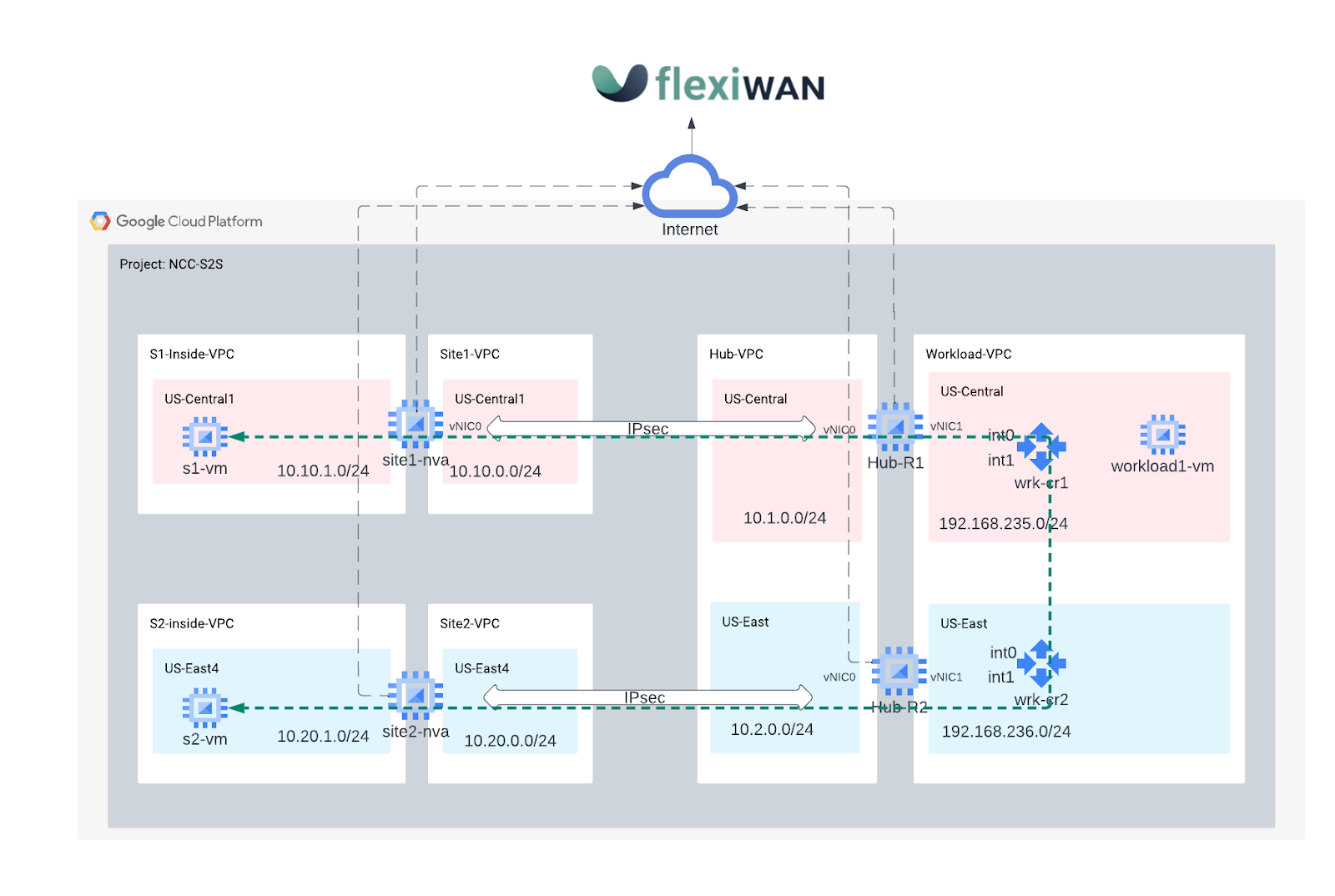

ב-Codelabs צריך להשתמש בפתרון SD-WAN גמיש (פתרון SD-WAN) כדי לפשט את הפריסה והניהול של WAN. FlexibleWAN הוא פתרון SD-WAN ו-SASE בקוד פתוח.

מה תפַתחו

ב-Codelab הזה תבנה רכזת ותווי טופולוגיה של SD-WAN כדי לדמות אתרים הסתעפויות מרוחקות, שיעברו את רשת השדרה של Google לתקשורת מאתר לענן ומהאתר לאתר.

- תתבצע פריסה של זוג התקני vm של GCE שהוגדרו ל-'flexiWAN' סוכן SD-WAN ב-VPC המרכזי שמייצג את הקצה הקדמי לתנועה נכנסת ויוצאת ל-GCP.

- פריסת שני נתבים גמישים מרחוק מסוג SD-WAN מרחוק כדי לייצג VPC של אתר הסתעפות שונה

- כדי לבדוק נתיב נתונים, צריך להגדיר שלוש מכונות וירטואליות ב-GCE שידמה לקוחות נייחים ושרתים שמתארחים ב-GCP

מה תלמדו

- שימוש ב-NCC כדי לחבר בין משרדים בסניפים מרוחקים באמצעות פתרון WAN בהגדרת תוכנה בקוד פתוח.

- ניסיון מעשי עם פתרון WAN מוגדר של תוכנת קוד פתוח

מה צריך להכין

- ידע על רשת GCP VPC

- ידע בניתוב Cloud Router ו-BGP

- Codelab מחייב 6 רשתות VPC. אם צריך, בודקים את Quota:Networks ואת הרשתות הנוספות של בקשות נוספות, צילום מסך למטה:

2. מטרות

- הגדרת סביבת GCP

- פריסת מכונות FlexibleiWAN Edge ב-GCP

- יוצרים NCC Hub ו-FlexibleiWAN Edge NVA כדי לדבר

- הגדרה וניהול של מכונות FlexibleiWAN באמצעות FlexibleiManage

- הגדרה של החלפת מסלול BGP בין vpc-app-svcs לבין FlexibleiWAN NVA

- יצירת אתר מרוחק שמדמה סניף מרוחק של לקוח או מרכז נתונים

- יצירת מנהרת IPSEC בין האתר המרוחק ל-NVA

- אימות של מכשירי החשמל שנפרסו

- אימות העברת נתונים מאתר לענן

- אימות העברת נתונים מאתר לאתר

- מחיקת המשאבים שנוצלו

במדריך הזה צריך ליצור חשבון FlexiManage (חשבון גמיש) בחינם לצורך אימות, הצטרפות וניהול של מכונות FlexiEdge.

לפני שמתחילים

שימוש במסוף Google Cloud וב-Cloud Shell

כדי לקיים אינטראקציה עם GCP, נשתמש גם ב-Google Cloud Console וגם ב-Cloud Shell בשיעור ה-Lab הזה.

מסוף Google Cloud

אפשר להגיע אל Cloud Console בכתובת https://console.cloud.google.com.

כדי שיהיה קל יותר להגדיר את Network Connectivity Center, צריך להגדיר את הפריטים הבאים ב-Google Cloud:

במסוף Google Cloud, בדף בחירת הפרויקט, בוחרים או יוצרים פרויקט חדש ב-Google Cloud.

מפעילים את Cloud Shell. ב-Codelab הזה נעשה שימוש ב-$variables כדי לעזור בהטמעת ההגדרות של gcloud ב-Cloud Shell.

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectname=[YOUR-PROJECT-NAME]

echo $projectname

תפקידי IAM

ל-NCC נדרשים תפקידי IAM כדי לגשת לממשקי API ספציפיים. חשוב להגדיר למשתמשים את תפקידי ה-NCC ב-IAM לפי הצורך.

שם התפקיד | תיאור | הרשאות |

networkconnectivity.networkAdmin | מאפשרת למנהלי רשתות לנהל את הרכזת והדיבור. | Networkconnectivity.hubs.networkconnectivity.spokes. |

networkconnectivity.networkSpokeManager | מאפשרת הוספה וניהול של חישורים ברכזת. לשימוש ב-VPC משותף שבו המרכז המארח הוא הבעלים של הפרויקט, אבל אדמינים אחרים בפרויקטים אחרים יכולים להוסיף חישורים לקבצים המצורפים שלהם למרכז. | networkconnectivity.spokes.** |

networkconnectivity.networkUsernetworkconnectivity.networkViewer | מאפשרת למשתמשי הרשת להציג מאפיינים שונים של רכזת וחשורים. | networkconnectivity.hubs.getnetworkconnectivity.hubs.listnetworkconnectivity.spokes.getnetworkconnectivity.spokes.listnetworkconnectivity.spokes.aggregatedList |

3. הגדרה של סביבת מעבדת הרשת

סקירה כללית

בקטע הזה נפרוס את רשתות ה-VPC וכללי חומת האש.

הדמיה של רשתות אתרים סניפים מקומיים

רשת ה-VPC הזו מכילה רשתות משנה למכונות וירטואליות מקומיות.

יוצרים את הרשתות ואת רשתות המשנה בארגון:

gcloud compute networks create site1-vpc \

--subnet-mode custom

gcloud compute networks create site2-vpc \

--subnet-mode custom

gcloud compute networks create s1-inside-vpc \

--subnet-mode custom

gcloud compute networks create s2-inside-vpc \

--subnet-mode custom

gcloud compute networks subnets create site1-subnet \

--network site1-vpc \

--range 10.10.0.0/24 \

--region us-central1

gcloud compute networks subnets create site2-subnet \

--network site2-vpc \

--range 10.20.0.0/24 \

--region us-east4

gcloud compute networks subnets create s1-inside-subnet \

--network s1-inside-vpc \

--range 10.10.1.0/24 \

--region us-central1

gcloud compute networks subnets create s2-inside-subnet \

--network s2-inside-vpc \

--range 10.20.1.0/24 \

--region us-east4

יוצרים כללי חומת אש מסוג site1-vpc כדי לאפשר:

- SSH, פנימי, IAP

- ESP, UDP/500, UDP/4500

- טווח של 10.0.0.0/8

- טווח 192.168.0.0/16

gcloud compute firewall-rules create site1-ssh \--network site1-vpc \

--allow tcp:22

gcloud compute firewall-rules create site1-internal \

--network site1-vpc \

--allow all \

--source-ranges 10.0.0.0/8

gcloud compute firewall-rules create site1-cloud \

--network site1-vpc \

--allow all \

--source-ranges 192.168.0.0/16

gcloud compute firewall-rules create site1-vpn \

--network site1-vpc \

--allow esp,udp:500,udp:4500 \

--target-tags router

gcloud compute firewall-rules create site1-iap \

--network site1-vpc --allow tcp:22 --source-ranges=35.235.240.0/20

יוצרים כללי חומת אש מסוג site2-vpc כדי לאפשר:

- SSH, פנימי, IAP

- טווח של 10.0.0.0/8

- טווח 192.168.0.0/16

gcloud compute firewall-rules create site2-ssh \

--network site2-vpc \

--allow tcp:22

gcloud compute firewall-rules create site2-internal \

--network site2-vpc \

--allow all \

--source-ranges 10.0.0.0/8

gcloud compute firewall-rules create site2-cloud \

--network site1-vpc \

--allow all \

--source-ranges 192.168.0.0/16

gcloud compute firewall-rules create site2-vpn \

--network site1-vpc \

--allow esp,udp:500,udp:4500 \

--target-tags router

gcloud compute firewall-rules create site2-iap \

--network site2-vpc --allow tcp:22 --source-ranges=35.235.240.0/20

יוצרים כללי חומת אש מסוג s1-inside-vpc כדי לאפשר:

- SSH, פנימי, IAP

- טווח של 10.0.0.0/8

- טווח 192.168.0.0/16

gcloud compute firewall-rules create s1-inside-ssh \

--network s1-inside-vpc \

--allow tcp:22

gcloud compute firewall-rules create s1-inside-internal \

--network s1-inside-vpc \

--allow all \

--source-ranges 10.0.0.0/8

gcloud compute firewall-rules create s1-inside-cloud \

--network s1-inside-vpc \

--allow all \

--source-ranges 192.168.0.0/16

gcloud compute firewall-rules create s1-inside-iap \

--network site2-vpc --allow tcp:22 --source-ranges=35.235.240.0/20

יוצרים כללי חומת אש מסוג s2-inside-vpc כדי לאפשר:

- SSH, פנימי, IAP

- טווח של 10.0.0.0/8

- טווח 192.168.0.0/16

gcloud compute firewall-rules create s2-inside-ssh \

--network s2-inside-vpc \

--allow tcp:22

gcloud compute firewall-rules create s2-inside-internal \

--network s2-inside-vpc \

--allow all \

--source-ranges 10.0.0.0/8

gcloud compute firewall-rules create s2-inside-cloud \

--network s2-inside-vpc \

--allow all \

--source-ranges 192.168.0.0/16

gcloud compute firewall-rules create s2-inside-iap \

--network site2-vpc --allow tcp:22 --source-ranges=35.235.240.0/20

למטרות בדיקה, יוצרים את המופעים s1-inside-vm ו-s2-inside-vm

gcloud compute instances create s1-vm \

--zone=us-central1-a \

--machine-type=e2-micro \

--network-interface subnet=s1-inside-subnet,private-network-ip=10.10.1.3,no-address

gcloud compute instances create s2-vm \

--zone=us-east4-b \

--machine-type=e2-micro \

--network-interface subnet=s2-inside-subnet,private-network-ip=10.20.1.3,no-address

סימולציה של סביבת הרשת של GCP ל-GCP

כדי להפעיל תנועה חוצת-אזור מאתר לאתר דרך רשת hub-vpc והדיבורים, צריך להפעיל ניתוב גלובלי ברשת hub-vpc. מידע נוסף זמין במאמר בנושא החלפת מסלולים ב-NCC.

- יצירת רשת ורשתות משנה של

hub-vpc:

gcloud compute networks create hub-vpc \

--subnet-mode custom \

--bgp-routing-mode=global

gcloud compute networks subnets create hub-subnet1 \

--network hub-vpc \

--range 10.1.0.0/24 \

--region us-central1

gcloud compute networks subnets create hub-subnet2 \

--network hub-vpc \

--range 10.2.0.0/24 \

--region us-east4

- יצירת רשת ורשתות משנה של

workload-vpc:

gcloud compute networks create workload-vpc \

--subnet-mode custom \

--bgp-routing-mode=global

gcloud compute networks subnets create workload-subnet1 \

--network workload-vpc \

--range 192.168.235.0/24 \

--region us-central1

gcloud compute networks subnets create workload-subnet2 \

--network workload-vpc \

--range 192.168.236.0/24 \

--region us-east4

- יוצרים כללי חומת אש של Hub-VPC כדי לאפשר:

- SSH

- ESP, UDP/500, UDP/4500

- טווח פנימי 10.0.0.0/8 (שמכסה את יציאת ה-TCP 179 שנדרשת לסשן BGP מהנתב בענן אל הנתב)

gcloud compute firewall-rules create hub-ssh \

--network hub-vpc \

--allow tcp:22

gcloud compute firewall-rules create hub-vpn \

--network hub-vpc \

--allow esp,udp:500,udp:4500 \

--target-tags router

gcloud compute firewall-rules create hub-internal \

--network hub-vpc \

--allow all \

--source-ranges 192.168.0.0/16

gcloud compute firewall-rules create hub-iap \

--network hub-vpc --allow tcp:22 --source-ranges=35.235.240.0/20

- ליצור כללי חומת אש של Workload-VPC כדי לאפשר:

- SSH

- טווח פנימי 192.168.0.0/16 (שמכסה את יציאת ה-TCP 179 שנדרשת לסשן BGP מנתב בענן אל הנתב)

gcloud compute firewall-rules create workload-ssh \

--network workload-vpc \

--allow tcp:22

gcloud compute firewall-rules create workload-internal \

--network workload-vpc \

--allow all \

--source-ranges 192.168.0.0/16

gcloud compute --project=$projectname firewall-rules create allow-from-site-1-2 --direction=INGRESS --priority=1000 --network=workload-vpc --action=ALLOW --rules=all --source-ranges=10.10.1.0/24,10.20.1.0/24

gcloud compute firewall-rules create workload-onprem \

--network hub-vpc \

--allow all \

--source-ranges 10.0.0.0/8

gcloud compute firewall-rules create workload-iap \

--network workload-vpc --allow tcp:22 --source-ranges=35.235.240.0/20

- הפעלת Cloud NAT בעומס העבודה-VPC כדי לאפשר ל-workload1-vm להוריד חבילות על ידי יצירת Cloud Router ו-NAT Gateway

gcloud compute routers create cloud-router-usc-central-1-nat \

--network workload-vpc \

--region us-central1

gcloud compute routers nats create cloudnat-us-central1 \

--router=cloud-router-usc-central-1-nat \

--auto-allocate-nat-external-ips \

--nat-all-subnet-ip-ranges \

--region us-central1

- יוצרים את

workload1-vmin "us-central1-a" inworkload-VPC, והמארח הזה ישמש לאימות הקישוריות לענן של האתר

gcloud compute instances create workload1-vm \

--project=$projectname \

--machine-type=e2-micro \

--image-family debian-10 \

--image-project debian-cloud \

--zone us-central1-a \

--private-network-ip 192.168.235.3 \

--no-address \

--subnet=workload-subnet1 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install apache2 -y

sudo service apache2 restart

echo 'Welcome to Workload VM1 !!' | tee /var/www/html/index.html

EOF"

4. הגדרה במכשירי חשמל נטענים עבור SD-WAN

יצירת מכונה וירטואלית מקומית (VM) עבור SDWAN (Appliances)

בחלק הבא ניצור מכשירי חשמל מסוג site1-nva ו-site2-nva לנתבים מקומיים.

יצירת מכונות

יוצרים את הכלי site1-router בשם site1-nva

gcloud compute instances create site1-nva \

--zone=us-central1-a \

--machine-type=e2-medium \

--network-interface subnet=site1-subnet \

--network-interface subnet=s1-inside-subnet,no-address \

--create-disk=auto-delete=yes,boot=yes,device-name=flex-gcp-nva-1,image=projects/ubuntu-os-cloud/global/images/ubuntu-1804-bionic-v20220901,mode=rw,size=20,type=projects/$projectname/zones/us-central1-a/diskTypes/pd-balanced \

--no-shielded-secure-boot \

--shielded-vtpm \

--shielded-integrity-monitoring \

--reservation-affinity=any \

--can-ip-forward

יוצרים את מכשיר ה-site2-router בשם site2-nva

gcloud compute instances create site2-nva \

--zone=us-east4-b \

--machine-type=e2-medium \

--network-interface subnet=site2-subnet \

--network-interface subnet=s2-inside-subnet,no-address \

--create-disk=auto-delete=yes,boot=yes,device-name=flex-gcp-nva-1,image=projects/ubuntu-os-cloud/global/images/ubuntu-1804-bionic-v20220901,mode=rw,size=20,type=projects/$projectname/zones/us-east4-a/diskTypes/pd-balanced \

--no-shielded-secure-boot \

--shielded-vtpm \

--shielded-integrity-monitoring \

--reservation-affinity=any \

--can-ip-forward

5. התקנה של FlexibleiWAN ב-site1-nva

פתיחת חיבור SSH לאתר site1-nva, אם הזמן הקצוב לתפוגה יהיה ניסיון חוזר

gcloud compute ssh site1-nva --zone=us-central1-a

התקנה של FlexibleiWAN ב-site1-nva

sudo su

sudo curl -sL https://deb.flexiwan.com/setup | sudo bash -

apt install flexiwan-router -y

מכינים את המכונה הווירטואלית (VM) לרישום רמת הבקרה הגמישה של WAN.

לאחר השלמת ההתקנה של FlexibleiWAN, מריצים את הפקודה fwsystem_checker כדי לבדוק את הגדרת המערכת. הפקודה הזו בודקת את דרישות המערכת ועוזרת לתקן שגיאות בהגדרה במערכת.

- בוחרים באפשרות

2להגדרה מהירה ושקטה - יציאה לאחר מכן עם 0.

- אסור לסגור את חלון ה-Cloud Shell.

root@site-1-nva-1:/home/user# fwsystem_checker

<output snipped>

[0] - quit and use fixed parameters

1 - check system configuration

2 - configure system silently

3 - configure system interactively

4 - restore system checker settings to default

------------------------------------------------

Choose: 2

<output snipped>

[0] - quit and use fixed parameters

1 - check system configuration

2 - configure system silently

3 - configure system interactively

4 - restore system checker settings to default

------------------------------------------------

Choose: 0

Please wait..

Done.

=== system checker ended ====

צריך להשאיר את הסשן פתוח כדי לבצע את השלבים הבאים

6. רישום site1-nva בבקר SD-WAN

השלבים האלה נדרשים כדי להשלים את ההקצאה של FlexibleiWAN NVA מנוהל מ-FlexibleiManage Console. לפני שממשיכים, צריך לוודא שהארגון ה-גמיש מוגדר.

אימות של FlexibleiWAN NVA שנפרס באמצעות FlexibleiManage באמצעות אסימון אבטחה, על ידי התחברות לחשבון ה-FlexibleiManage. ניתן לעשות שימוש חוזר באותו אסימון בכל מכשירי הנתב.

בוחרים באפשרות מלאי ← אסימונים, יוצרים אסימון בחירת עותק

חוזרים ל-Cloud Shell (site1-nva) ומדביקים את האסימון בספרייה /etc/flexiwan/agent/token.txt לפי השלבים הבאים

nano /etc/flexiwan/agent/token.txt

#Paste the generated token obtain from flexiManage

#Exit session with CTRL+X and Select Y to save then enter

הפעלת נתבי האתרים במסוף ה-גמיש

מתחברים למסוף ה-FlexibleiManage Console כדי להפעיל את site1-nva בבקר

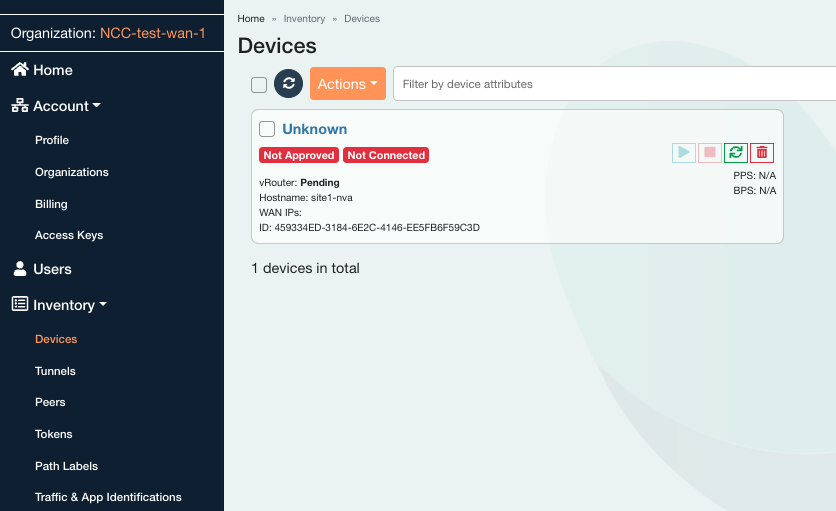

בחלונית הימנית, בוחרים מלאי ← מכשירים, לוחצים על המכשיר לא ידוע.

מזינים את שם המארח של ה-site1-nva ומאשרים את המכשיר על ידי החלקת החוגה ימינה.

בוחרים בכרטיסייה ממשקים.

מאתרים את הרשימה 'הוקצו' עמודה ולוחצים על לא ומשנים את ההגדרה לכן.

בוחרים בכרטיסייה 'חומת אש' ולוחצים על הסימן '+' כדי להוסיף כלל חומת אש נכנסת.

צריך לבחור את ממשק ה-WAN כדי להחיל את כלל ה-SSH כפי שמתואר בהמשך

לוחצים על עדכון המכשיר.

מפעילים את site1-nva מבקר ה-FlexibleiWAN. חוזרים אל מלאי ← מכשירים ← site1-nva ובוחרים באפשרות הפעלת המכשיר

סטטוס – בסנכרון

סטטוס – מסונכרן

אפשר לראות את אינדיקטור האזהרה בקטע פתרון בעיות ← התראות. לאחר הצפייה, יש לבחור את כל הפריטים ולסמן כנקרא

7. התקנה של FlexibleiWAN ב-site2-nva

פתיחת כרטיסייה חדשה, יצירת סשן של Cloud Shell ועדכון ה-$variables כדי לעזור בהטמעת ההגדרות של gcloud

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectname=[YOUR-PROJECT-NAME]

echo $projectname

פתיחת חיבור SSH לאתר site2-nva, אם הזמן הקצוב לתפוגה יהיה ניסיון חוזר

gcloud compute ssh site2-nva --zone=us-east4-b

התקנה של FlexibleiWAN ב-site2-nva

sudo su

sudo curl -sL https://deb.flexiwan.com/setup | sudo bash -

apt install flexiwan-router -y

מכינים את המכונה הווירטואלית (VM) לרישום רמת הבקרה הגמישה של WAN.

לאחר השלמת ההתקנה של FlexibleiWAN, מריצים את הפקודה fwsystem_checker כדי לבדוק את הגדרת המערכת. הפקודה הזו בודקת את דרישות המערכת ועוזרת לתקן שגיאות בהגדרה במערכת.

- בוחרים באפשרות

2להגדרה מהירה ושקטה - יציאה לאחר מכן עם 0.

- אסור לסגור את חלון ה-Cloud Shell.

root@site2-nva:/home/user# fwsystem_checker

<output snipped>

[0] - quit and use fixed parameters

1 - check system configuration

2 - configure system silently

3 - configure system interactively

4 - restore system checker settings to default

------------------------------------------------

Choose: 2

<output snipped>

[0] - quit and use fixed parameters

1 - check system configuration

2 - configure system silently

3 - configure system interactively

4 - restore system checker settings to default

------------------------------------------------

Choose: 0

Please wait..

Done.

=== system checker ended ====

8. רישום site2-nva עם בקר SD-WAN

השלבים האלה נדרשים כדי להשלים את ההקצאה של FlexibleiWAN NVA מנוהל מ-FlexibleiManage Console. לפני שממשיכים, צריך לוודא שהארגון ה-גמיש מוגדר.

אימות של FlexibleiWAN NVA שנפרס באמצעות FlexibleiManage באמצעות אסימון אבטחה, על ידי התחברות לחשבון ה-FlexibleiManage. ניתן לעשות שימוש חוזר באותו אסימון בכל מכשירי הנתב.

בוחרים 'מלאי' ← אסימונים, יוצרים אסימון בוחרים באפשרות העתקה

חוזרים ל-Cloud Shell (site2-nva) ומדביקים את האסימון בספרייה /etc/flexiwan/agent/token.txt לפי השלבים הבאים

nano /etc/flexiwan/agent/token.txt

#Paste the generated token obtain from flexiManage

#Exit session with CTRL+X and Select Y to save then enter

הפעלת נתבי האתר ממסוף FlexibleiManage

מתחברים למסוף ה-FlexibleiManage Console כדי להפעיל את site2-nva בבקר

בחלונית הימנית, בוחרים מלאי ← מכשירים, לוחצים על המכשיר לא ידוע.

מזינים את שם המארח של ה-site2-nva ומאשרים את המכשיר על ידי החלקת החוגה ימינה.

בוחרים בכרטיסייה ממשקים.

מאתרים את הרשימה 'הוקצו' עמודה ולוחצים על לא ומשנים את ההגדרה לכן.

בוחרים באפשרות הכרטיסייה 'חומת אש' ולוחצים על הסימן '+' כדי להוסיף כלל לחומת אש נכנסת. צריך לבחור את ממשק ה-WAN כדי להחיל את כלל ה-SSH כפי שמתואר בהמשך

לוחצים על עדכון המכשיר.

מפעילים את ה-site2-nva בבקר ה-FlexibleiWAN. חוזרים אל מלאי ← מכשירים ← site2-nva ובוחרים באפשרות הפעלת המכשיר

Satus – בסנכרון

סטטוס – מסונכרן

אפשר לראות את אינדיקטור האזהרה בקטע פתרון בעיות ← התראות. לאחר הצפייה, יש לבחור את כל הפריטים ולסמן כנקרא

9. הגדרת מכשירי רשת SDWAN של Hub

בקטע הבא תיצרו ותרשמו את הנתבים Hub (hub-r1 ו-Hub-r2) עם ה-FlexibleiWAN Controller, כפי שביצעתם בעבר עם מסלולי האתר.

פתיחת כרטיסייה חדשה, יצירת סשן של Cloud Shell ועדכון ה-$variables כדי לעזור בהטמעת ההגדרות של gcloud

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectname=[YOUR-PROJECT-NAME]

echo $projectname

יצירת מכונות Hub NVA

יוצרים את המכשיר hub-r1:

gcloud compute instances create hub-r1 \

--zone=us-central1-a \

--machine-type=e2-medium \

--network-interface subnet=hub-subnet1 \

--network-interface subnet=workload-subnet1,no-address \

--can-ip-forward \

--create-disk=auto-delete=yes,boot=yes,device-name=flex-gcp-nva-1,image=projects/ubuntu-os-cloud/global/images/ubuntu-1804-bionic-v20220901,mode=rw,size=20,type=projects/$projectname/zones/us-central1-a/diskTypes/pd-balanced \

--no-shielded-secure-boot \

--shielded-vtpm \

--shielded-integrity-monitoring \

--reservation-affinity=any

יוצרים את המכשיר hub-r2:

gcloud compute instances create hub-r2 \

--zone=us-east4-b \

--machine-type=e2-medium \

--network-interface subnet=hub-subnet2 \

--network-interface subnet=workload-subnet2,no-address \

--can-ip-forward \

--create-disk=auto-delete=yes,boot=yes,device-name=flex-gcp-nva-1,image=projects/ubuntu-os-cloud/global/images/ubuntu-1804-bionic-v20220901,mode=rw,size=20,type=projects/$projectname/zones/us-east4-a/diskTypes/pd-balanced \

--no-shielded-secure-boot \

--shielded-vtpm \

--shielded-integrity-monitoring \

--reservation-affinity=any

10. התקנת FlexibleiWAN ב-Hub Instances עבור Hub-r1

פתיחת חיבור SSH ל-Hub-r1

gcloud compute ssh hub-r1 --zone=us-central1-a

התקנת סוכן FlexibleiWAN בשני ה-Hub-r1

sudo su

sudo curl -sL https://deb.flexiwan.com/setup | sudo bash -

apt install flexiwan-router -y

הכנת מכונות וירטואליות של Hub-r1 לרישום גמיש ל-FlexibleiWAN.

לאחר השלמת ההתקנה של FlexibleiWAN, מריצים את הפקודה fwsystem_checker כדי לבדוק את הגדרת המערכת. הפקודה הזו בודקת את דרישות המערכת ועוזרת לתקן שגיאות בהגדרה במערכת.

root@hub-r1:/home/user# fwsystem_checker

- בוחרים באפשרות

2להגדרה מהירה ושקטה - יציאה לאחר מכן עם 0.

- אסור לסגור את חלון ה-Cloud Shell.

11. רישום מכונות וירטואליות של Hub-r1 בבקר של FlexibleiManage

אימות של FlexibleiWAN NVA שנפרס באמצעות FlexibleiManage באמצעות אסימון אבטחה, על ידי התחברות לחשבון ה-FlexibleiManage.

- בוחרים באפשרות מלאי ← אסימונים ומעתיקים את האסימון

חוזרים אל Cloud Shell (hub-r1) ומדביקים את האסימון בספרייה /etc/flexiwan/agent/token.txt לפי השלבים הבאים

nano /etc/flexiwan/agent/token.txt

#Paste the generated token obtain from flexiManage

#Exit session with CTRL+X and Select Y to save then enter

12. התקנת FlexibleiWAN ב-Hub Instances עבור Hub-r2

פתיחת חיבור SSH ל-Hub-r2

gcloud compute ssh hub-r2 --zone=us-east4-b

התקנת סוכן FlexibleiWAN בשני ה-Hub-r2

sudo su

sudo curl -sL https://deb.flexiwan.com/setup | sudo bash -

apt install flexiwan-router -y

הכנת מכונות וירטואליות של Hub-r2 לרישום גמיש ל-FlexibleiWAN.

לאחר השלמת ההתקנה של FlexibleiWAN, מריצים את הפקודה fwsystem_checker כדי לבדוק את הגדרת המערכת. הפקודה הזו בודקת את דרישות המערכת ועוזרת לתקן שגיאות בהגדרה במערכת.

root@hub-r2:/home/user# fwsystem_checker

- בוחרים באפשרות

2להגדרה מהירה ושקטה - יציאה לאחר מכן עם 0.

- אסור לסגור את חלון ה-Cloud Shell.

13. רישום מכונות וירטואליות של Hub-r2 בבקר של FlexibleiManage

אימות של FlexibleiWAN NVA שנפרס באמצעות FlexibleiManage באמצעות אסימון אבטחה, על ידי התחברות לחשבון ה-FlexibleiManage.

- בוחרים באפשרות מלאי ← אסימונים ומעתיקים את האסימון

חוזרים אל Cloud Shell (hub-r2) ומדביקים את האסימון בספרייה /etc/flexiwan/agent/token.txt לפי השלבים הבאים

nano /etc/flexiwan/agent/token.txt

#Paste the generated token obtain from flexiManage

#Exit session with CTRL+X and Select Y to save then enter

הפעלת נתבים Hub-r1 בקונסולה ה-FlexiManage

התחברות למסוף FlexiManage

- עוברים אל מלאי ← מכשירים.

- מאתרים ומציינים את שם המארח של hub-r1 ו-hub-r2 הם "לא ידוע".

בוחרים את המכשיר הלא ידוע עם שם המארח hub-r1

- צריך להזין את שם המארח של hub-r1

- אישור המכשיר, מסיטים את החוגה שמאלה.

בוחרים בכרטיסייה ממשקים.

- מאתרים את העמודה "הוקצו".

- ליד שורת הממשק, לוחצים על לא כדי לשנות את ההגדרה ל'כן'.

בוחרים בכרטיסייה חומת אש.

- לוחצים על +. להוספה של כלל חומת אש נכנס

- צריך לבחור את ממשק ה-WAN כדי לרשת את הכלל

- אישור ליציאת SSH 22 עם פרוטוקול TCP

- לוחצים על עדכון המכשיר.

יש להפעיל את המכשיר hub-r1 ל-SD-WAN מהבקר של FlexibleiWAN

- חוזרים אל מלאי ← מכשירים ← Hub-r1

בוחרים באפשרות הפעלת המכשיר

- ממתינים עד שהסנכרון יסתיים ורושמים את הסטטוס פועל סטטוס

הפעלת נתבים של Hub-r2 בקונסולה ה-FlexiManage

בוחרים את המכשיר הלא ידוע עם שם המארח hub-r2

- צריך להזין את שם המארח של hub-r2

- מאשרים את המכשיר, מסיטים את החוגה ימינה.

בוחרים בכרטיסייה 'ממשקים'

- מאתרים את העמודה "הוקצו".

- ליד שורת הממשק, לוחצים על לא כדי לשנות את ההגדרה ל'כן'.

בוחרים בכרטיסייה 'חומת אש'.

- לוחצים על +. להוספה של כלל חומת אש נכנס

- צריך לבחור את ממשק ה-WAN כדי לרשת את הכלל

- אישור של יציאת SSH 22 עם פרוטוקול TCP

- לוחצים על הוספת כלל.

- לוחצים על עדכון המכשיר.

יש להפעיל את המכשיר hub-r2 ל-SD-WAN מהבקר של FlexibleiWAN

- חוזרים אל מלאי ← מכשירים ← hub-r2 ובוחרים באפשרות הפעלת המכשיר

- ממתינים עד שהסנכרון יסתיים ורושמים את הסטטוס פועל סטטוס

14. מרכז הקישוריות של הרשת ב-GCP Hub

הפעלת שירותי API

מפעילים את ממשק ה-API של קישוריות הרשת אם הוא עדיין לא מופעל:

gcloud services enable networkconnectivity.googleapis.com

יצירת מרכז NCC

gcloud network-connectivity hubs create ncc-hub

Create request issued for: [ncc-hub]

Waiting for operation [projects/user-3p-dev/locations/global/operations/operation-1668793629598-5edc24b7ee3ce-dd4c765b-5ca79556] to complete...done.

Created hub [ncc-hub]

הגדרת שני המכשירים של הנתב כדיבור NCC

מאתרים את ה-URI ואת כתובת ה-IP של Hub-r1 וגם של Hub-r2 ושימו לב לפלט. תצטרכו את המידע הזה בשלב הבא.

חשוב לזכור את כתובת ה-IP (192.168.x.x) של המכונה Hub-r1 ו-Hub-r2.

gcloud compute instances describe hub-r1 \

--zone=us-central1-a \

--format="value(selfLink.scope(projects))"

gcloud compute instances describe hub-r1 --zone=us-central1-a | grep "networkIP"

gcloud compute instances describe hub-r2 \

--zone=us-east4-b \

--format="value(selfLink.scope(projects))"

gcloud compute instances describe hub-r2 --zone=us-east4-b | grep "networkIP"

מוסיפים את Hub-r1 של Hub-r1 networkIP (192.168.x.x) כדי לדבר ומאפשרים העברת נתונים מהאתר לאתר

gcloud network-connectivity spokes linked-router-appliances create s2s-wrk-cr1 \

--hub=ncc-hub \

--router-appliance=instance="https://www.googleapis.com/compute/projects/$projectname/zones/us-central1-a/instances/hub-r1",ip=192.168.235.4 \

--region=us-central1 \

--site-to-site-data-transfer

מוסיפים את Hub-r2 של Hub-r2 networkIP (192.168.x.x) למצב דיבור ומפעילים את העברת הנתונים מהאתר לאתר

gcloud network-connectivity spokes linked-router-appliances create s2s-wrk-cr2 \

--hub=ncc-hub \

--router-appliance=instance=/projects/$projectname/zones/us-east4-b/instances/hub-r2,ip=192.168.236.101 \

--region=us-east4 \

--site-to-site-data-transfer

הגדרת Cloud Router ליצירת BGP עם Hub-R1

בשלב הבא, יוצרים את Cloud Router ומכריזים על רשת המשנה של VPC של עומס העבודה 192.168.235.0/24.

יצירת ה-Cloud Rout ב-us-central1 שיתקשר עם BGP עם Hub-r1

gcloud compute routers create wrk-cr1 \

--region=us-central1 \

--network=workload-vpc \

--asn=65002 \

--set-advertisement-groups=all_subnets \

--advertisement-mode=custom

על ידי הגדרת מכשירי הנתב כ-NCC Spoke, הנתב בענן יכול לנהל משא ומתן על BGP בממשקים וירטואליים.

יצירת שני ממשקים בנתב בענן שיחליפו הודעות BGP עם Hub-r1.

כתובות ה-IP נבחרות מרשת המשנה של עומס העבודה, ו- & ניתן לשנות לפי הצורך.

gcloud compute routers add-interface wrk-cr1 \

--region=us-central1 \

--subnetwork=workload-subnet1 \

--interface-name=int0 \

--ip-address=192.168.235.101

gcloud compute routers add-interface wrk-cr1 \

--region=us-central1 \

--subnetwork=workload-subnet1 \

--interface-name=int1 \

--ip-address=192.168.235.102 \

--redundant-interface=int0

מגדירים את הממשק של Cloud Router ליצירת BGP עם vNIC-1 של Hub-r1, ומעדכנים את כתובת ה-IP-IP של כתובת ה-IP של Hub-r1 networkIP . הערה: אותה כתובת IP משמשת עבור int0 & int1.

gcloud compute routers add-bgp-peer wrk-cr1 \

--peer-name=hub-cr1-bgp-peer-0 \

--interface=int0 \

--peer-ip-address=192.168.235.4 \

--peer-asn=64111 \

--instance=hub-r1 \

--instance-zone=us-central1-a \

--region=us-central1

gcloud compute routers add-bgp-peer wrk-cr1 \

--peer-name=hub-cr1-bgp-peer-1 \

--interface=int1 \

--peer-ip-address=192.168.235.4 \

--peer-asn=64111 \

--instance=hub-r1 \

--instance-zone=us-central1-a \

--region=us-central1

יש לאמת את מצב BGP, בשלב הזה ב-Code Lab, BGP הוא 'מצב חיבור' כי נתב הרשת לא הוגדר עבור BGP.

gcloud compute routers get-status wrk-cr1 --region=us-central1

הגדרת Workload-cr2 ליצירת BGP עם Hub-R2

בשלב הבא, יוצרים את Cloud Router ומכריזים על רשת המשנה של VPC של עומס העבודה 192.168.236.0/24

יצירת ה-Cloud Rout ב-us-east4 שיתקשר עם BGP עם Hub-r2

gcloud compute routers create wrk-cr2 \

--region=us-east4 \

--network=workload-vpc \

--asn=65002 \

--set-advertisement-groups=all_subnets \

--advertisement-mode=custom

יוצרים שני ממשקים בנתב בענן שיחליפו הודעות BGP עם Hub-r2, כתובות IP נבחרות מרשת המשנה של עומס העבודה ניתן לשנות לפי הצורך.

gcloud compute routers add-interface wrk-cr2 \

--region=us-east4 \

--subnetwork=workload-subnet2 \

--interface-name=int0 \

--ip-address=192.168.236.5

gcloud compute routers add-interface wrk-cr2 \

--region=us-east4 \

--subnetwork=workload-subnet2 \

--interface-name=int1 \

--ip-address=192.168.236.6 \

--redundant-interface=int0

מגדירים את הממשק של Cloud Router ליצירת BGP עם vNIC-1 של Hub-r2, מעדכנים את כתובת ה-IP של העמיתים עם כתובת ה-IP של Hub-r1 networkIP . הערה: אותה כתובת IP משמשת עבור int0 & int1.

gcloud compute routers add-bgp-peer wrk-cr2 \

--peer-name=hub-cr2-bgp-peer-0 \

--interface=int0 \

--peer-ip-address=192.168.236.101 \

--peer-asn=64112 \

--instance=hub-r2 \

--instance-zone=us-east4-b \

--region=us-east4

gcloud compute routers add-bgp-peer wrk-cr2 \

--peer-name=hub-cr2-bgp-peer-1 \

--interface=int1 \

--peer-ip-address=192.168.236.101 \

--peer-asn=64112 \

--instance=hub-r2 \

--instance-zone=us-east4-b \

--region=us-east4

יש לאמת את מצב BGP, בשלב הזה ב-Code Lab, BGP הוא 'מצב חיבור' כי נתב הרשת לא הוגדר עבור BGP.

gcloud compute routers get-status wrk-cr2 --region=us-east4

15. הגדרת מכשירים לנתב של Hub עבור BGP

הגדרת Hub-r1 ל-BGP

חשוב להתחבר למסוף ה-FlexibleiManage

עוברים אל מלאי ← מכשירים ← hub-r1 ובוחרים את המכשיר עם HostName:hub-r1

- לוחצים על הכרטיסייה ניתוב.

- לוחצים על 'BGP Configuration'

- השבתת "הפצה מחדש של מסלולי OSPF"

- מגדירים את hub-r1 ל-BGP עם הפרמטרים האלה ולוחצים על "שמירה"

בוחרים באפשרות Interfaces (ממשקים). הכרטיסייה, אתר את ממשק ה-LAN, אתר את העמודה 'ניתוב'

- לוחצים על ללא. כדי לפתוח את התפריט לבחור BGP כפרוטוקול הניתוב

- בחלק העליון של הדף, לוחצים על 'עדכון המכשיר'

הגדרת Hub-r2 ל-BGP

חשוב להתחבר למסוף ה-FlexibleiManage

עוברים אל מלאי ← מכשירים ← hub-r2,בוחרים את המכשיר עם HostName:hub-r2

- לוחצים על הכרטיסייה ניתוב.

- לוחצים על 'BGP Configuration'

- השבתת "הפצה מחדש של מסלולי OSPF"

- מגדירים את hub-r2 ל-BGP עם הפרמטרים האלה ולוחצים על "שמירה"

בוחרים באפשרות Interfaces (ממשקים). Tab, איתור ממשק ה-LAN, חיפוש העמודה 'ניתוב'

- לוחצים על 'ללא'. כדי לפתוח תפריט נפתח ולבחור ב-BGP כפרוטוקול הניתוב

- בחלק העליון של הדף, לוחצים על עדכון המכשיר.

בוחרים באפשרות ניתוב. טאב

- מוודאים ש-Hub-r2 למד מסלול BGP מ-wrk-cr2

16. החלפת נתיב BGP בין מכשירי חשמל לנתב

יצירת ASN מקומי לאתרים מרוחקים

מגדירים BGP ASN מקומי ל-site1-nva ו-site2-nva. לאחר ההגדרה ניצור מנהרת IPSEC בין האתרים המרוחקים לנתבים של Hub.

בוחרים במכשיר עם ה-HostName:site1-nva

- לוחצים על הכרטיסייה ניתוב.

- לוחצים על 'BGP Configuration'

- השבתת "הפצה מחדש של מסלולי OSPF"

- BGP מופעל

- ASN מקומי 7269 ← שמירה

- עדכון המכשיר

- הכרטיסייה 'ממשקים' ← LAN ← ניתוב ← BGP

- עדכון המכשיר

בוחרים את המכשיר עם ה-HostName:site2-nva

- לוחצים על הכרטיסייה ניתוב.

- לוחצים על 'BGP Configuration'

- השבתת "הפצה מחדש של מסלולי OSPF"

- BGP מופעל

- ASN מקומי 7270 ← שמירה

- עדכון המכשיר

- הכרטיסייה 'ממשקים' ← LAN ← ניתוב ← BGP

- עדכון המכשיר

הגדרת מנהרות VPN בין מכשירי חשמל מסוג אתרים ו-Hub

חשוב להתחבר למסוף ה-FlexibleiManage

- עוברים אל מלאי ← מכשירים.

- בוחרים את התיבה שלצד שם המארח של site1-nva ו-hub-r1 כדי ליצור מנהרת VPN בין שתי רשתות ה-NVA האלה.

- לוחצים על פעולות ← יצירת מנהרות ומגדירים את ההגדרות הבאות

- בוחרים באפשרות יצירת מנהרות.

- מסירים את סימני הווי מ-site1-nva ומ-ub-r1

חוזרים על השלבים ליצירת מנהרה בין site2-nva ו-Hub-r2 על ידי בחירת הפרמטרים המתאימים.

ודאו שיש שתי מנהרות בין כל צמד של NVA.

- בחלונית שבצד ימין, בוחרים באפשרות מלאי ולוחצים על מנהרות. ולאתר את עמודת הסטטוס

יש לאמת ש-'site1-nva' שנלמדו לרשת המשנה 192.168.235.0/24 ו-192.168.236.0/24

- בוחרים באפשרות מלאי ← מכשירים ← site1-nva ולוחצים על הכרטיסייה ניתוב.

בפלט לדוגמה שבהמשך, FlexibleiWAN יצר את המנהרה באופן אוטומטי באמצעות כתובת ה-IP של המארח 10.100.0.6

17. אימות הקישוריות של נתיב הנתונים

אימות הקישוריות בין אתר לענן מ-Prem

מעיינים בתרשים, מוודאים שנתיב הנתונים בין s1-vm לבין workload1-vm.

הגדרת נתיבים סטטיים של VPC מאתר לענן

הרשתות Site1-VPC ו-Site2-VPC בארגון מדמות רשת של מרכזי נתונים בארגון.

גם הנתבים מסוג Site-1-nva וגם ה-site-2-nva משתמשים בקישוריות VPN כדי להגיע לרשת המרכז.

עבור התרחיש לדוגמה של האתר לענן**,** יש ליצור מסלולים סטטיים ליעד 192.168.0.0/16 באמצעות הנתב כצעד הבא כדי להגיע לרשתות ברשת הענן של GCP.

ב-s1-inside-vpc, יוצרים נתיב סטטי ליעד בענן (192.168.0.0/16):

gcloud compute routes create site1-subnet-route \

--network=s1-inside-vpc \

--destination-range=192.168.0.0/16 \

--next-hop-instance=site1-nva \

--next-hop-instance-zone=us-central1-a

ב-s2-inside-vpc, יוצרים נתיב סטטי ליעד בענן (192.168.0.0/16):

gcloud compute routes create site2-subnet-route \

--network=s2-inside-vpc \

--destination-range=192.168.0.0/16 \

--next-hop-instance=site2-nva \

--next-hop-instance-zone=us-east4-b

מחפשים את כתובת ה-IP של workload1-vm ב-cloudshell. תצטרכו את הקישור הזה כדי לבדוק את הקישוריות מ-'s1-vm'.

gcloud compute instances describe workload1-vm --zone=us-central1-a | grep "networkIP"

פותחים חיבור SSH ל-s1-vm, אם הזמן הקצוב לתפוגה הוא לנסות שוב.

gcloud compute ssh s1-vm --zone=us-central1-a

SSH אל s1-vm ומשתמשים בפקודה curl כדי ליצור סשן TCP לכתובת IP של workload1-VM.

s1-vm:~$ curl 192.168.235.3 -vv * Trying 192.168.235.3:80... * Connected to 192.168.235.3 (192.168.235.3) port 80 (#0) > GET / HTTP/1.1 > Host: 192.168.235.3 > User-Agent: curl/7.74.0 > Accept: */* > * Mark bundle as not supporting multiuse < HTTP/1.1 200 OK < Date: Wed, 07 Dec 2022 15:12:08 GMT < Server: Apache/2.4.54 (Debian) < Last-Modified: Tue, 06 Dec 2022 00:57:46 GMT < ETag: "1f-5ef1e4acfa1d9" < Accept-Ranges: bytes < Content-Length: 31 < Content-Type: text/html < Page served from: workload1-vm * Connection #0 to host 192.168.235.3 left intact

אימות הקישוריות בין אתר לאתר

מעיינים בתרשים, מוודאים שנתיב הנתונים בין s1-vm לבין s2-vm

הגדרת נתיבים סטטיים של VPC לאתר לאתר

כדי לנתב תנועה מאתר לאתר בין אתר 1 לאתר 2 באמצעות הרשת הגלובלית של GCP, צריך ליצור נתיבים סטטיים ליעדי תת-רשת של אתרים מרוחקים באמצעות ה-Google Drive מראש של הנתב, כצעד הבא.

בשלב מאוחר יותר, ה-VPC של עומס העבודה יוגדר עם NCC כדי לתמוך בהעברת נתונים מאתר לאתר.

ב-s1-inside-vpc, יוצרים נתיב סטטי כדי להגיע אל site2-subnet (10.20.1.0/24):

gcloud compute routes create site1-sn1-route \

--network=s1-inside-vpc \

--destination-range=10.20.1.0/24 \

--next-hop-instance=site1-nva \

--next-hop-instance-zone=us-central1-a

ב-s2-inside-vpc, יוצרים נתיב סטטי כדי להגיע אל site1-subnet (10.10.1.0/24):

gcloud compute routes create site2-sn1-route \

--network=s2-inside-vpc \

--destination-range=10.10.1.0/24 \

--next-hop-instance=site2-nva \

--next-hop-instance-zone=us-east4-b

מחפשים את כתובת ה-IP של 's2-vm' ב-cloudshell. צריך את הקישור הזה כדי לבדוק את הקישוריות מ-S1-vm.

gcloud compute instances describe s2-vm --zone=us-east4-b | grep networkIP

פותחים חיבור SSH ל-s1-vm, אם הזמן הקצוב לתפוגה צריך לנסות שוב.

gcloud compute ssh s1-vm --zone=us-central1-a

SSH אל s1-vm ו-ping את כתובת ה-IP של "s2-vm".

s1-vm:~$ ping 10.20.1.3

PING 10.20.1.3 (10.20.1.3) 56(84) bytes of data.

64 bytes from 10.20.1.3: icmp_seq=1 ttl=60 time=99.1 ms

64 bytes from 10.20.1.3: icmp_seq=2 ttl=60 time=94.3 ms

64 bytes from 10.20.1.3: icmp_seq=3 ttl=60 time=92.4 ms

64 bytes from 10.20.1.3: icmp_seq=4 ttl=60 time=90.9 ms

64 bytes from 10.20.1.3: icmp_seq=5 ttl=60 time=89.7 ms

18. הסרת המשאבים

התחברות ל-Cloud Shell ומחיקה של מכונות וירטואליות ברשתות של האתר המרכזי והסתעפות

#on prem instances

gcloud compute instances delete s1-vm --zone=us-central1-a --quiet

gcloud compute instances delete s2-vm --zone=us-east4-b --quiet

#delete on prem firewall rules

gcloud compute firewall-rules delete site1-ssh --quiet

gcloud compute firewall-rules delete site1-internal --quiet

gcloud compute firewall-rules delete site1-cloud --quiet

gcloud compute firewall-rules delete site1-vpn --quiet

gcloud compute firewall-rules delete site1-iap --quiet

gcloud compute firewall-rules delete site2-ssh --quiet

gcloud compute firewall-rules delete site2-internal --quiet

gcloud compute firewall-rules delete site2-cloud --quiet

gcloud compute firewall-rules delete site2-vpn --quiet

gcloud compute firewall-rules delete site2-iap --quiet

gcloud compute firewall-rules delete allow-from-site-1-2 --quiet

gcloud compute firewall-rules delete s2-inside-cloud s2-inside-internal s2-inside-ssh --quiet

gcloud compute firewall-rules delete s1-inside-cloud s1-inside-iap s1-inside-internal s1-inside-ssh s2-inside-cloud s2-inside-iap s2-inside-internal s2-inside-ssh --quiet

#delete ncc spokes

gcloud network-connectivity spokes delete s2s-wrk-cr1 --region us-central1 --quiet

gcloud network-connectivity spokes delete s2s-wrk-cr2 --region us-east4 --quiet

#delete ncc hub

gcloud network-connectivity hubs delete ncc-hub --quiet

#delete the cloud router

gcloud compute routers delete wrk-cr1 --region=us-central1 --quiet

gcloud compute routers delete wrk-cr2 --region=us-east4 --quiet

#delete the instances

gcloud compute instances delete hub-r1 --zone=us-central1-a --quiet

gcloud compute instances delete hub-r2 --zone=us-east4-b --quiet

gcloud compute instances delete workload1-vm --zone=us-central1-a --quiet

gcloud compute instances delete site1-nva --zone=us-central1-a --quiet

gcloud compute instances delete site2-nva --zone=us-east4-b --quiet

#delete on prem subnets

gcloud compute networks subnets delete hub-subnet1 s1-inside-subnet site1-subnet workload-subnet1 --region=us-central1 --quiet

gcloud compute networks subnets delete hub-subnet2 s2-inside-subnet site2-subnet workload-subnet2 --region=us-east4 --quiet

#delete hub firewall rule

gcloud compute firewall-rules delete hub-ssh --quiet

gcloud compute firewall-rules delete hub-vpn --quiet

gcloud compute firewall-rules delete hub-internal --quiet

gcloud compute firewall-rules delete hub-iap --quiet

gcloud compute firewall-rules delete workload-ssh --quiet

gcloud compute firewall-rules delete workload-internal --quiet

gcloud compute firewall-rules delete workload-onprem --quiet

gcloud compute firewall-rules delete workload-iap --quiet

#delete on vpcs

gcloud compute networks delete hub-vpc s1-inside-vpc s2-inside-vpc site2-vpc workload-vpc --quiet

19. מעולה!

השלמת את ה-Network Connectivity Center Lab!

מה נכלל בקורס

- שילוב WAN בהגדרת תוכנה שהוגדר בשביל אתר NCC לענן

- שילוב WAN בהגדרת תוכנה שהוגדר בשביל אתר NCC לאתר

השלבים הבאים

- סקירה כללית של Network Connectivity Center

- מסמכי התיעוד של Network Connectivity Center

- משאבי WAN גמישים

- מאגר גמיש של GitLab

©Google, LLC או השותפים העצמאיים שלה. כל הזכויות שמורות. אסור להפיץ.