1. Introduzione

Un'interfaccia Private Service Connect è una risorsa che consente a una rete Virtual Private Cloud (VPC) del producer di avviare connessioni a varie destinazioni in una rete VPC consumer. Le reti di produttori e consumatori possono trovarsi in organizzazioni e progetti diversi.

Se un collegamento di rete accetta una connessione da un'interfaccia Private Service Connect, Google Cloud alloca all'interfaccia un indirizzo IP da una subnet consumer specificata dal collegamento di rete. Le reti di consumatori e produttori sono connesse e possono comunicare tramite indirizzi IP interni.

Una connessione tra un collegamento di rete e un'interfaccia Private Service Connect è simile a quella tra un endpoint Private Service Connect e un collegamento a un servizio, ma presenta due differenze fondamentali:

- Un collegamento di rete consente a una rete del producer di avviare connessioni a una rete consumer (in uscita dai servizi gestiti), mentre un endpoint consente a una rete consumer di avviare connessioni a una rete producer (servizio in entrata gestito).

- Una connessione all'interfaccia di Private Service Connect è transitiva. Ciò significa che una rete del produttore può comunicare con altre reti connesse alla rete del consumatore.

Cosa creerai

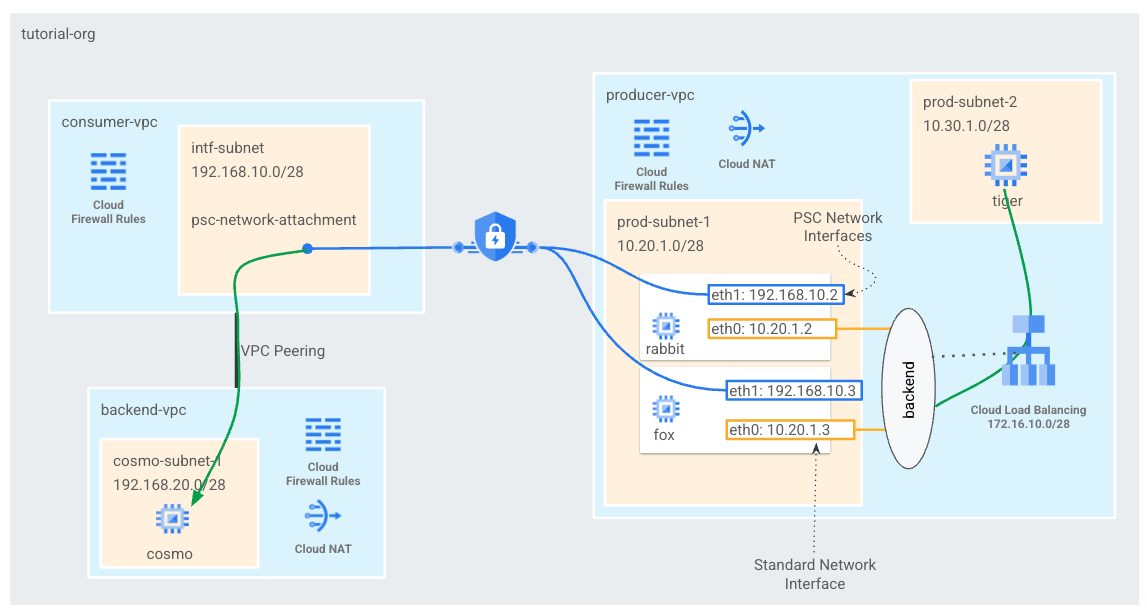

Creerai un singolo psc-network-attachment nel VPC consumer, in modo da creare due interfacce PSC come backend per il bilanciatore del carico interno L4. Il tiger VPC del producer invierà un comando curl a cosmo nel backend-vpc. Nel VPC del producer, creerai una route statica verso il traffico di destinazione 192.168.20.0/28 come bilanciatore del carico interno che sfrutterà le interfacce PSC e backend successive per instradare il traffico a cosmo. Per una panoramica, vedi la Figura 1.

Lo stesso approccio può essere utilizzato con i servizi gestiti di Google che sono in peering VPC con il VPC del cliente quando si utilizza l'accesso privato ai servizi.

Figura 1

Cosa imparerai a fare

- Come creare un collegamento di rete

- In che modo un producer può utilizzare un collegamento di rete per creare un'interfaccia PSC come backend

- Come stabilire una comunicazione dal produttore al consumatore utilizzando ILB come hop successivo

- Come consentire l'accesso dalla VM producer (tiger) alla VM consumer (cosmo) tramite peering VPC

Che cosa ti serve

- Progetto Google Cloud

- Autorizzazioni IAM

- Amministratore rete Compute (roles/compute.networkAdmin)

- Amministratore istanze Compute (roles/compute.instanceAdmin)

- Amministratore sicurezza Compute (roles/compute.securityAdmin)

2. Prima di iniziare

Aggiorna il progetto per supportare il tutorial

Questo tutorial utilizza $variables per facilitare l'implementazione della configurazione di gcloud in Cloud Shell.

All'interno di Cloud Shell, esegui queste operazioni:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

3. Configurazione consumer

Crea il VPC consumer

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks create consumer-vpc --project=$projectid --subnet-mode=custom

Crea la subnet del collegamento di rete Private Service Connect

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks subnets create intf-subnet --project=$projectid --range=192.168.10.0/28 --network=consumer-vpc --region=us-central1

Crea il VPC di backend

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks create backend-vpc --project=$projectid --subnet-mode=custom

Crea le subnet VPC di backend

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks subnets create cosmo-subnet-1 --project=$projectid --range=192.168.20.0/28 --network=backend-vpc --region=us-central1

Crea le regole firewall backend-vpc

In Cloud Shell, crea una regola in entrata per il traffico dalla subnet psc-network-attachment a cosmo

gcloud compute firewall-rules create allow-ingress-to-cosmo \

--network=backend-vpc \

--action=ALLOW \

--rules=ALL \

--direction=INGRESS \

--priority=1000 \

--source-ranges="192.168.10.0/28" \

--destination-ranges="192.168.20.0/28" \

--enable-logging

Router Cloud e configurazione NAT

Nel tutorial viene utilizzato Cloud NAT per l'installazione dei pacchetti software perché l'istanza VM non ha un indirizzo IP pubblico. Cloud NAT consente alle VM con indirizzi IP privati di accedere a internet.

All'interno di Cloud Shell, crea il router Cloud.

gcloud compute routers create cloud-router-for-nat --network backend-vpc --region us-central1

In Cloud Shell, crea il gateway NAT.

gcloud compute routers nats create cloud-nat-us-central1 --router=cloud-router-for-nat --auto-allocate-nat-external-ips --nat-all-subnet-ip-ranges --region us-central1

4. Abilita IAP

Per consentire a IAP di connettersi alle tue istanze VM, crea una regola firewall che:

- Si applica a tutte le istanze VM a cui vuoi rendere accessibile tramite IAP.

- Consente il traffico in entrata dall'intervallo IP 35.235.240.0/20. Questo intervallo contiene tutti gli indirizzi IP utilizzati da IAP per l'inoltro TCP.

In Cloud Shell, crea la regola firewall IAP.

gcloud compute firewall-rules create ssh-iap-consumer \

--network backend-vpc \

--allow tcp:22 \

--source-ranges=35.235.240.0/20

5. Creazione di istanze VM consumer

In Cloud Shell, crea l'istanza VM consumer, cosmo

gcloud compute instances create cosmo \

--project=$projectid \

--machine-type=e2-micro \

--image-family debian-11 \

--no-address \

--image-project debian-cloud \

--zone us-central1-a \

--subnet=cosmo-subnet-1 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart

echo 'Welcome to cosmo's backend server !!' | tee /var/www/html/index.html

EOF"

Ottieni e archivia gli indirizzi IP delle istanze:

All'interno di Cloud Shell, esegui una descrizione sulle istanze VM cosmo.

gcloud compute instances describe cosmo --zone=us-central1-a | grep networkIP:

6. Collegamento di rete Private Service Connect

I collegamenti di rete sono risorse di regione che rappresentano il lato consumer di un'interfaccia di Private Service Connect. Associa una singola subnet a un collegamento di rete e il producer assegna gli IP all'interfaccia Private Service Connect da quella subnet. La subnet deve trovarsi nella stessa regione del collegamento di rete. Un collegamento di rete deve trovarsi nella stessa regione del servizio producer.

Crea il collegamento di rete

In Cloud Shell, crea il collegamento di rete.

gcloud compute network-attachments create psc-network-attachment \

--region=us-central1 \

--connection-preference=ACCEPT_MANUAL \

--producer-accept-list=$projectid \

--subnets=intf-subnet

Elenca i collegamenti di rete

All'interno di Cloud Shell, elenca il collegamento di rete.

gcloud compute network-attachments list

Descrivi i collegamenti di rete

All'interno di Cloud Shell, descrivi il collegamento di rete.

gcloud compute network-attachments describe psc-network-attachment --region=us-central1

Prendi nota dell'URI psc-network-attachment che verrà utilizzato dal producer durante la creazione delle interfacce Private Service Connect. Ad esempio:

user$ gcloud compute network-attachments describe psc-network-attachment --region=us-central1

connectionPreference: ACCEPT_MANUAL

creationTimestamp: '2023-06-07T11:27:33.116-07:00'

fingerprint: 8SDsvG6TfYQ=

id: '5014253525248340730'

kind: compute#networkAttachment

name: psc-network-attachment

network: https://www.googleapis.com/compute/v1/projects/$projectid/global/networks/consumer-vpc

producerAcceptLists:

- $projectid

region: https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1

selfLink: https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment

subnetworks:

- https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/subnetworks/intf-subnet

7. Stabilisci il peering VPC tra il VPC consumer e il VPC backend

Creerai una connessione in peering VPC tra il VPC consumer e il VPC backend. Questo replica il modo in cui Google stabilisce la connettività ai VPC dei clienti per i servizi gestiti, oltre al peering tra organizzazioni per la connettività di rete. Il peering VPC deve essere configurato da ogni VPC.

Peering VPC consumer al peering VPC backend

Crea una connessione in peering VPC dal consumer al VPC di backend

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks peerings create consumer-to-backend-vpc \

--network=consumer-vpc \

--peer-project=$projectid \

--peer-network=backend-vpc \

--stack-type=IPV4_ONLY

Crea una connessione in peering VPC dal backend al VPC consumer

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks peerings create backend-to-consumer-vpc \

--network=backend-vpc \

--peer-project=$projectid \

--peer-network=consumer-vpc \

--stack-type=IPV4_ONLY

Convalida i dettagli dello stato del peering VPC

All'interno di Cloud Shell, verifica che il peering VPC sia nello stato "Attivo" e "Connesso" stato.

gcloud compute networks peerings list

Esempio:

user@cloudshell$ gcloud compute networks peerings list

NAME: backend-to-consumer-vpc

NETWORK: backend-vpc

PEER_PROJECT: $projectid

PEER_NETWORK: consumer-vpc

STACK_TYPE: IPV4_ONLY

PEER_MTU:

IMPORT_CUSTOM_ROUTES: False

EXPORT_CUSTOM_ROUTES: False

STATE: ACTIVE

STATE_DETAILS: [2023-06-07T11:42:27.634-07:00]: Connected.

NAME: consumer-to-backend-vpc

NETWORK: consumer-vpc

PEER_PROJECT: $projectid

PEER_NETWORK: backend-vpc

STACK_TYPE: IPV4_ONLY

PEER_MTU:

IMPORT_CUSTOM_ROUTES: False

EXPORT_CUSTOM_ROUTES: False

STATE: ACTIVE

STATE_DETAILS: [2023-06-07T11:42:27.634-07:00]: Connected.

8. Configurazione del producer

Crea il VPC del producer

All'interno di Cloud Shell, esegui queste operazioni:

gcloud compute networks create producer-vpc --project=$projectid --subnet-mode=custom

Crea le subnet del producer

In Cloud Shell, crea la subnet utilizzata per la vNIC0 delle interfacce psc

gcloud compute networks subnets create prod-subnet --project=$projectid --range=10.20.1.0/28 --network=producer-vpc --region=us-central1

In Cloud Shell, crea la subnet utilizzata per la tiger dell'istanza.

gcloud compute networks subnets create prod-subnet-2 --project=$projectid --range=10.30.1.0/28 --network=producer-vpc --region=us-central1

In Cloud Shell, crea la subnet utilizzata per il bilanciatore del carico interno.

gcloud compute networks subnets create prod-subnet-3 --project=$projectid --range=172.16.10.0/28 --network=producer-vpc --region=us-central1

Router Cloud e configurazione NAT

Nel tutorial viene utilizzato Cloud NAT per l'installazione dei pacchetti software perché l'istanza VM non ha un indirizzo IP pubblico. Cloud NAT consente alle VM con indirizzi IP privati di accedere a internet.

All'interno di Cloud Shell, crea il router Cloud.

gcloud compute routers create cloud-router-for-nat-producer --network producer-vpc --region us-central1

In Cloud Shell, crea il gateway NAT.

gcloud compute routers nats create cloud-nat-us-central1-producer --router=cloud-router-for-nat-producer --auto-allocate-nat-external-ips --nat-all-subnet-ip-ranges --region us-central1

Abilita IAP

Per consentire a IAP di connettersi alle tue istanze VM, crea una regola firewall che:

- Si applica a tutte le istanze VM a cui vuoi rendere accessibile tramite IAP.

- Consente il traffico in entrata dall'intervallo IP 35.235.240.0/20. Questo intervallo contiene tutti gli indirizzi IP utilizzati da IAP per l'inoltro TCP.

In Cloud Shell, crea la regola firewall IAP.

gcloud compute firewall-rules create ssh-iap-producer \

--network producer-vpc \

--allow tcp:22 \

--source-ranges=35.235.240.0/20

Crea istanze VM producer

In Cloud Shell, crea l'istanza VM consumer, tiger

gcloud compute instances create tiger \

--project=$projectid \

--machine-type=e2-micro \

--image-family debian-11 \

--no-address \

--image-project debian-cloud \

--zone us-central1-a \

--subnet=prod-subnet-2 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump"

9. Crea regole firewall del producer

Nel VPC del producer, crea una regola firewall in entrata che consenta la comunicazione da prod-subnet-2 a tutte le istanze del producer-vpc.

In Cloud Shell, crea la regola firewall del producer.

gcloud compute --project=$projectid firewall-rules create allow-tiger-ingress --direction=INGRESS --priority=1000 --network=producer-vpc --action=ALLOW --rules=all --source-ranges=10.30.1.0/28 --enable-logging

10. Crea l'interfaccia di Private Service Connect

Un'interfaccia Private Service Connect è una risorsa che consente a una rete Virtual Private Cloud (VPC) del producer di avviare connessioni a varie destinazioni in una rete VPC consumer. Le reti di produttori e consumatori possono trovarsi in organizzazioni e progetti diversi.

Se un collegamento di rete accetta una connessione da un'interfaccia Private Service Connect, Google Cloud alloca all'interfaccia un indirizzo IP da una subnet consumer specificata dal collegamento di rete. Le reti di consumatori e produttori sono connesse e possono comunicare tramite indirizzi IP interni.

Nel tutorial creerai due istanze con il collegamento di rete Private Service Connect che costituirà il backend del bilanciatore del carico interno.

All'interno di Cloud Shell, crea l'interfaccia Private Service Connect (rabbit) e inserisci il valore psc-network-attachment URI identificato in precedenza dall'output della descrizione del collegamento di rete.

gcloud compute instances create rabbit --zone us-central1-a --machine-type=f1-micro --can-ip-forward --network-interface subnet=prod-subnet,network=producer-vpc,no-address --network-interface network-attachment=https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment --metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart"

All'interno di Cloud Shell, crea l'interfaccia Private Service Connect (fox) e inserisci il valore psc-network-attachment URI identificato in precedenza dall'output della descrizione del collegamento di rete.

gcloud compute instances create fox --zone us-central1-a --machine-type=f1-micro --can-ip-forward --network-interface subnet=prod-subnet,network=producer-vpc,no-address --network-interface network-attachment=https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment --metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart"

Convalida di più NIC

Verifica che l'interfaccia PSC sia configurata con l'indirizzo IP appropriato. vNIC0 utilizzerà la subnet prod-produttore 10.20.1.0/28 e vNIC1 utilizzerà la subnet intf consumer (192.168.10.0/28).

gcloud compute instances describe rabbit --zone=us-central1-a | grep networkIP:

gcloud compute instances describe fox --zone=us-central1-a | grep networkIP:

Esempio:

user$ gcloud compute instances describe rabbit --zone=us-central1-a | grep networkIP:

networkIP: 10.20.1.2

networkIP: 192.168.10.2

user$ gcloud compute instances describe fox --zone=us-central1-a | grep networkIP:

networkIP: 10.20.1.3

networkIP: 192.168.10.3

11. Crea e aggiungi Rabbit e fox in un gruppo di istanze non gestite

Nella sezione seguente creerai un gruppo di istanze non gestite composto dalle istanze dell'interfaccia PSC rabbit e fox.

In Cloud Shell, crea il gruppo di istanze non gestite.

gcloud compute instance-groups unmanaged create psc-interface-instances-ig --project=$projectid --zone=us-central1-a

All'interno di Cloud Shell, aggiungi le istanze fox e rabbit al gruppo di istanze.

gcloud compute instance-groups unmanaged add-instances psc-interface-instances-ig --project=$projectid --zone=us-central1-a --instances=fox,rabbit

12. Creare controllo di integrità TCP, servizi di backend, regola di forwarding e firewall

All'interno di Cloud Shell, crea il controllo di integrità del backend.

gcloud compute health-checks create http hc-http-80 --port=80

In Cloud Shell crea il servizio di backend

gcloud compute backend-services create psc-interface-backend --load-balancing-scheme=internal --protocol=tcp --region=us-central1 --health-checks=hc-http-80

gcloud compute backend-services add-backend psc-interface-backend --region=us-central1 --instance-group=psc-interface-instances-ig --instance-group-zone=us-central1-a

In Cloud Shell crea la regola di forwarding

gcloud compute forwarding-rules create psc-ilb --region=us-central1 --load-balancing-scheme=internal --network=producer-vpc --subnet=prod-subnet-3 --address=172.16.10.10 --ip-protocol=TCP --ports=all --backend-service=psc-interface-backend --backend-service-region=us-central1

Da Cloud Shell, crea una regola firewall per abilitare i controlli di integrità del backend.

gcloud compute firewall-rules create ilb-health-checks --allow tcp:80,tcp:443 --network producer-vpc --source-ranges 130.211.0.0/22,35.191.0.0/16

13. Creazione di tabelle IP Linux per le interfacce PSC - rabbit

Dall'istanza dell'interfaccia PSC, configura le tabelle IP di Linux per consentire la comunicazione del producer con le subnet consumer.

Trovare il nome del sistema operativo guest dell'interfaccia di Private Service Connect

Per configurare il routing, devi conoscere il nome del sistema operativo guest dell'interfaccia di Private Service Connect, che è diverso dal nome dell'interfaccia in Google Cloud.

Accedi alla VM psc-interface vm, rabbit, utilizzando IAP in Cloud Shell.

gcloud compute ssh rabbit --project=$projectid --zone=us-central1-a --tunnel-through-iap

In Cloud Shell ottieni l'indirizzo IP dell'istanza psc-interface

ip a

Esempio:

user@rabbit:~$ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:0a:14:01:02 brd ff:ff:ff:ff:ff:ff

altname enp0s4

inet 10.20.1.2/32 brd 10.20.1.2 scope global dynamic ens4

valid_lft 59396sec preferred_lft 59396sec

inet6 fe80::4001:aff:fe14:102/64 scope link

valid_lft forever preferred_lft forever

3: ens5: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:c0:a8:0a:02 brd ff:ff:ff:ff:ff:ff

altname enp0s5

inet 192.168.10.2/32 brd 192.168.10.2 scope global dynamic ens5

valid_lft 66782sec preferred_lft 66782sec

inet6 fe80::4001:c0ff:fea8:a02/64 scope link

valid_lft forever preferred_lft forever

Trova l'IP gateway dell'interfaccia PSC

Nell'elenco delle interfacce di rete, trova e archivia il nome dell'interfaccia associato all'indirizzo IP dell'interfaccia Private Service Connect, ad esempio ens5 (vNIC1)

Per configurare il routing, devi conoscere l'indirizzo IP del gateway predefinito dell'interfaccia di Private Service Connect

In Cloud Shell utilizzeremo 1 poiché l'interfaccia PSC è associata a vNIC1.

curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

L'esempio restituisce il valore predefinito gw 192.168.10.1

user@rabbit:~$ curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

192.168.10.1

Aggiungi route per le subnet consumer

Devi aggiungere una route al gateway predefinito dell'interfaccia Private Service Connect per ogni subnet consumer che si connette all'interfaccia Private Service Connect. In questo modo si garantisce il traffico associato per il traffico di rete consumer in uscita dall'interfaccia Private Service Connect.

Convalida tabella di route

In Cloud Shell convalida le route attuali.

ip route show

Esempio.

user@rabbit:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

In Cloud Shell aggiungi la route a cosmo-subnet-1

sudo ip route add 192.168.20.0/28 via 192.168.10.1 dev ens5

Convalida tabella di route

In Cloud Shell convalida le route aggiunte aggiornate.

ip route show

Esempio.

user@rabbit:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

192.168.20.0/28 via 192.168.10.1 dev ens5

Crea regole per le tabelle IP

In Cloud Shell convalida le tabelle IP attuali.

sudo iptables -t nat -L -n -v

Esempio:

user@rabbit:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

In Cloud Shell aggiorna le tabelle IP

sudo iptables -t nat -A POSTROUTING -o ens5 -j MASQUERADE

sudo sysctl net.ipv4.ip_forward=1

In Cloud Shell convalida le tabelle IP aggiornate.

sudo iptables -t nat -L -n -v

Esempio:

user@rabbit:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * ens5 0.0.0.0/0 0.0.0.0/0

14. Creazione di tabelle IP Linux per le interfacce PSC - fox

Dall'istanza dell'interfaccia PSC, configura le tabelle IP di Linux per consentire la comunicazione del producer con le subnet consumer.

Trovare il nome del sistema operativo guest dell'interfaccia di Private Service Connect

Per configurare il routing, devi conoscere il nome del sistema operativo guest dell'interfaccia di Private Service Connect, che è diverso dal nome dell'interfaccia in Google Cloud.

Apri una nuova scheda di Cloud Shell e aggiorna le impostazioni del progetto.

All'interno di Cloud Shell, esegui queste operazioni:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Accedi alla VM psc-interface fox utilizzando IAP in Cloud Shell.

gcloud compute ssh fox --project=$projectid --zone=us-central1-a --tunnel-through-iap

In Cloud Shell ottieni l'indirizzo IP dell'istanza psc-interface

ip a

Esempio:

user@fox:~$ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:0a:14:01:03 brd ff:ff:ff:ff:ff:ff

altname enp0s4

inet 10.20.1.3/32 brd 10.20.1.3 scope global dynamic ens4

valid_lft 65601sec preferred_lft 65601sec

inet6 fe80::4001:aff:fe14:103/64 scope link

valid_lft forever preferred_lft forever

3: ens5: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:c0:a8:0a:03 brd ff:ff:ff:ff:ff:ff

altname enp0s5

inet 192.168.10.3/32 brd 192.168.10.3 scope global dynamic ens5

valid_lft 63910sec preferred_lft 63910sec

inet6 fe80::4001:c0ff:fea8:a03/64 scope link

valid_lft forever preferred_lft forever

Trova l'IP gateway dell'interfaccia PSC

Nell'elenco delle interfacce di rete, trova e archivia il nome dell'interfaccia associato all'indirizzo IP dell'interfaccia Private Service Connect, ad esempio ens5 (vNIC1)

Per configurare il routing, devi conoscere l'indirizzo IP del gateway predefinito dell'interfaccia di Private Service Connect

In Cloud Shell utilizzeremo 1 poiché l'interfaccia PSC è associata a vNIC1.

curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

L'esempio restituisce il valore predefinito gw 192.168.10.1

user@fox:~$ curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

192.168.10.1

Aggiungi route per le subnet consumer

Devi aggiungere una route al gateway predefinito dell'interfaccia Private Service Connect per ogni subnet consumer che si connette all'interfaccia Private Service Connect. In questo modo si garantisce il traffico associato per il traffico di rete consumer in uscita dall'interfaccia Private Service Connect.

Convalida tabella di route

In Cloud Shell convalida le route attuali.

ip route show

Esempio.

user@fox:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

In Cloud Shell aggiungi la route a cosmo-subnet-1

sudo ip route add 192.168.20.0/28 via 192.168.10.1 dev ens5

Convalida tabella di route

In Cloud Shell convalida le route aggiunte aggiornate.

ip route show

Esempio.

user@fox:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

192.168.20.0/28 via 192.168.10.1 dev ens5

Crea regole per le tabelle IP

In Cloud Shell convalida le tabelle IP attuali.

sudo iptables -t nat -L -n -v

Esempio:

user@fox:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

In Cloud Shell aggiorna le tabelle IP.

sudo iptables -t nat -A POSTROUTING -o ens5 -j MASQUERADE

sudo sysctl net.ipv4.ip_forward=1

In Cloud Shell convalida le tabelle IP aggiornate.

sudo iptables -t nat -L -n -v

Esempio:

user@fox:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * ens5 0.0.0.0/0 0.0.0.0/0

15. Aggiorna tabella di route

In producer-vpc, crea una route statica verso la subnet consumer 192.168.20.0/28, hop successivo come bilanciatore del carico interno. Una volta creato, qualsiasi pacchetto (all'interno di producer-vpc) nella destinazione 192.168.20.0/28 verrà indirizzato al bilanciatore del carico interno.

Apri una nuova scheda di Cloud Shell e aggiorna le impostazioni del progetto.

All'interno di Cloud Shell, esegui queste operazioni:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

In Cloud Shell aggiorna la tabella delle route producer-vpc con una route statica.

gcloud beta compute routes create producer-to-cosmo-subnet-1 --project=$projectid --network=producer-vpc --priority=1000 --destination-range=192.168.20.0/28 --next-hop-ilb=psc-ilb --next-hop-ilb-region=us-central1

16. Convalida la connettività riuscita da tigre a cosmo

Convalida dei Curl

Confermiamo che l'istanza della VM producer, tiger, può comunicare con l'istanza consumer, cosmo, eseguendo un comando curl.

Apri una nuova scheda di Cloud Shell e aggiorna le impostazioni del progetto.

All'interno di Cloud Shell, esegui queste operazioni:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Accedi all'istanza tiger utilizzando IAP in Cloud Shell.

gcloud compute ssh tiger --project=$projectid --zone=us-central1-a --tunnel-through-iap

Esegui un comando curl dall'istanza tiger sull'indirizzo IP di cosmo identificato in precedenza nel tutorial.

curl -v <cosmo's IP Address>

Esempio:

user@tiger:~$ curl -v 192.168.20.2

* Trying 192.168.20.2:80...

* Connected to 192.168.20.2 (192.168.20.2) port 80 (#0)

> GET / HTTP/1.1

> Host: 192.168.20.2

> User-Agent: curl/7.74.0

> Accept: */*

>

* Mark bundle as not supporting multiuse

< HTTP/1.1 200 OK

< Date: Fri, 09 Jun 2023 03:49:42 GMT

< Server: Apache/2.4.56 (Debian)

< Last-Modified: Fri, 09 Jun 2023 03:28:37 GMT

< ETag: "27-5fda9f6ea060e"

< Accept-Ranges: bytes

< Content-Length: 39

< Content-Type: text/html

<

Welcome to cosmo's backend server !!

Congratulazioni! La connettività da producer-vpc a backend-vpc è stata convalidata eseguendo un comando curl.

17. Esegui la pulizia

Da Cloud Shell, elimina i componenti del tutorial.

gcloud compute instances delete cosmo --zone=us-central1-a --quiet

gcloud compute instances delete rabbit --zone=us-central1-a --quiet

gcloud compute instances delete fox --zone=us-central1-a --quiet

gcloud compute instances delete tiger --zone=us-central1-a --quiet

gcloud compute network-attachments delete psc-network-attachment --region=us-central1 --quiet

gcloud compute firewall-rules delete allow-ingress-to-cosmo allow-tiger-ingress ilb-health-checks ssh-iap-consumer ssh-iap-producer --quiet

gcloud beta compute routes delete producer-to-cosmo-subnet-1 --quiet

gcloud compute forwarding-rules delete psc-ilb --region=us-central1 --quiet

gcloud compute backend-services delete psc-interface-backend --region=us-central1 --quiet

gcloud compute instance-groups unmanaged delete psc-interface-instances-ig --zone=us-central1-a --quiet

gcloud compute health-checks delete hc-http-80 --quiet

gcloud compute networks subnets delete cosmo-subnet-1 prod-subnet prod-subnet-2 prod-subnet-3 intf-subnet --region=us-central1 --quiet

gcloud compute routers delete cloud-router-for-nat --region=us-central1 --quiet

gcloud compute routers delete cloud-router-for-nat-producer --region=us-central1 --quiet

gcloud compute networks delete consumer-vpc --quiet

gcloud compute networks delete producer-vpc --quiet

gcloud compute networks delete backend-vpc --quiet

18. Complimenti

Congratulazioni, hai configurato e convalidato un'interfaccia Private Service Connect e convalidato la connettività consumer e producer tramite peering VPC.

Hai creato l'infrastruttura consumer e hai aggiunto un collegamento di rete che consente al producer di creare una VM con più NIC per collegare le comunicazioni tra consumatore e producer. Hai imparato come utilizzare l'interfaccia PSC per comunicare con servizi proprietari/di terze parti tramite il peering VPC utilizzando un bilanciatore del carico interno e una route statica nel VPC del producer.

Cosmopup pensa che i tutorial siano straordinari.

Passaggi successivi

Guarda alcuni di questi tutorial...

- Utilizzo di Private Service Connect per pubblicare e utilizzare servizi con GKE

- Utilizzo di Private Service Connect per pubblicare e utilizzare servizi

- Connettiti ai servizi on-prem su una rete ibrida utilizzando Private Service Connect e un bilanciatore del carico proxy TCP interno

Per approfondire Video

- Panoramica di Private Service Connect

- Che cos'è Private Service Connect?

- Tipi di bilanciatori del carico supportati