1. परिचय

Private Service Connect इंटरफ़ेस एक ऐसा संसाधन है जिसकी मदद से, प्रोड्यूसर वर्चुअल प्राइवेट क्लाउड (VPC) नेटवर्क, उपभोक्ता VPC नेटवर्क में अलग-अलग डेस्टिनेशन से कनेक्शन शुरू कर सकता है. निर्माता और उपभोक्ता नेटवर्क अलग-अलग प्रोजेक्ट और संगठनों में हो सकते हैं.

अगर कोई नेटवर्क अटैचमेंट, Private Service Connect इंटरफ़ेस से मिले कनेक्शन को स्वीकार करता है, तो Google Cloud, इंटरफ़ेस को एक आईपी पता देता है. यह आईपी पता, नेटवर्क अटैचमेंट के ज़रिए उपभोक्ता के सबनेट से मिलता है. उपभोक्ता और उत्पादक नेटवर्क जुड़े हुए हैं और वे आंतरिक आईपी पतों का इस्तेमाल करके बातचीत कर सकते हैं.

नेटवर्क अटैचमेंट और Private Service Connect इंटरफ़ेस के बीच का कनेक्शन, Private Service Connect के एंडपॉइंट और सेवा अटैचमेंट के बीच के कनेक्शन की तरह ही होता है. हालांकि, इनमें दो मुख्य अंतर हैं:

- नेटवर्क अटैचमेंट की मदद से, निर्माता नेटवर्क किसी उपभोक्ता नेटवर्क (मैनेज की जा रही सेवा के ज़रिए इग्रेस डेटा ट्रैफ़िक) से कनेक्शन शुरू कर सकता है. वहीं, एंडपॉइंट की मदद से, उपभोक्ता नेटवर्क किसी प्रोड्यूसर नेटवर्क (मैनेज की जा रही सेवा के ज़रिए अपने लेन-देन पर खर्च होने वाली गतिविधि) से कनेक्शन शुरू कर सकता है.

- Private Service Connect के इंटरफ़ेस का कनेक्शन, ट्रांज़िटिव होता है. इसका मतलब है कि निर्माता नेटवर्क, उपभोक्ता नेटवर्क से जुड़े दूसरे नेटवर्क से संपर्क कर सकता है.

आपको क्या बनाना होगा

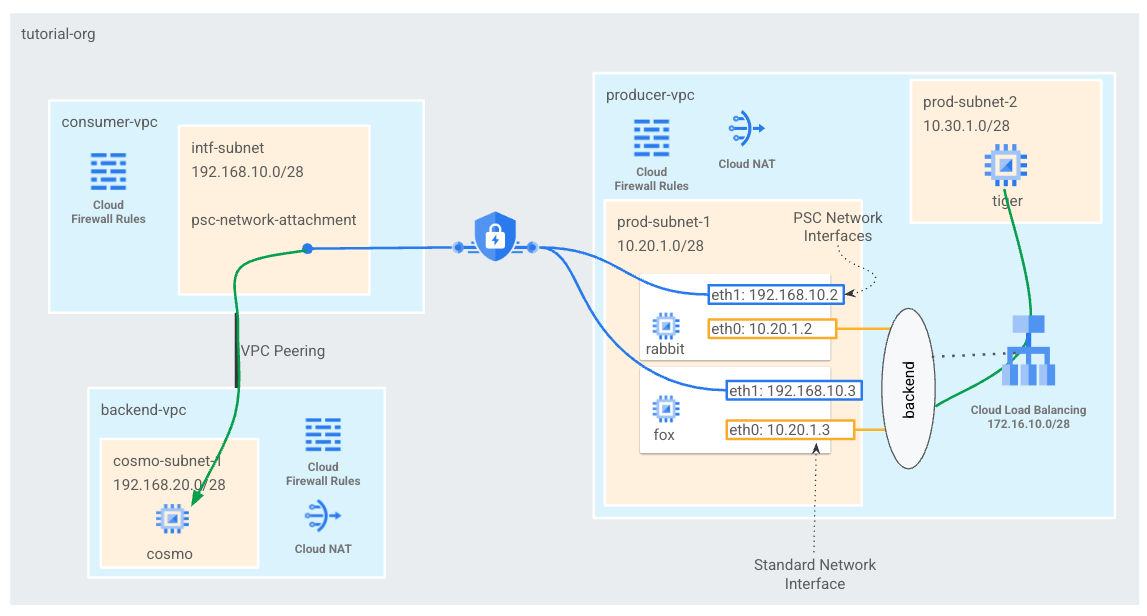

आपको उपभोक्ता VPC में, एक psc-नेटवर्क अटैचमेंट बनाना होगा. इससे, L4 इंटरनल लोड बैलेंसर के बैकएंड के तौर पर दो PSC इंटरफ़ेस बन जाएंगे. निर्माता VPC टाइगर से, बैकएंड-vpc में कॉस्मो पर एक कर्ल भेजेंगे. प्रोड्यूसर के VPC में, इंटरनल लोड बैलेंसर के तौर पर अगली बार डेस्टिनेशन ट्रैफ़िक के लिए एक स्टैटिक रूट बनाया जाएगा. यह ट्रैफ़िक को कॉस्मो पर रूट करने के लिए, बैकएंड और उसके बाद के PSC इंटरफ़ेस(इंटरफ़ेस) का इस्तेमाल करेगा. खास जानकारी के लिए पहली इमेज देखें.

यह तरीका, Google की मैनेज की जा रही उन सेवाओं के साथ भी इस्तेमाल किया जा सकता है जो प्राइवेट सेवा ऐक्सेस का इस्तेमाल करते समय, ग्राहक के VPC के साथ पीयर होती हैं.

इमेज 1

आपको इनके बारे में जानकारी मिलेगी

- नेटवर्क अटैचमेंट बनाने का तरीका

- कोई निर्माता, बैकएंड के तौर पर PSC इंटरफ़ेस बनाने के लिए नेटवर्क अटैचमेंट का इस्तेमाल कैसे कर सकता है

- अगले हॉप के तौर पर आईएलबी का इस्तेमाल करके, प्रोड्यूसर से उपभोक्ता तक बातचीत कैसे करें

- VPC पीयरिंग की मदद से, प्रोड्यूसर वीएम (टायगर) से उपभोक्ता वीएम (cosmo) को ऐक्सेस करने की अनुमति देने का तरीका

आपको इन चीज़ों की ज़रूरत होगी

- Google Cloud प्रोजेक्ट

- IAM अनुमतियां

- Compute Network एडमिन (roles/compute.networkAdmin)

- Compute इंस्टेंस एडमिन (roles/compute.instanceAdmin)

- Compute सिक्योरिटी एडमिन (roles/compute.securityAdmin)

2. शुरू करने से पहले

ट्यूटोरियल की मदद करने के लिए प्रोजेक्ट अपडेट करें

यह ट्यूटोरियल, Cloud Shell में gcloud कॉन्फ़िगरेशन लागू करने में मदद करने के लिए $variables का इस्तेमाल करता है.

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

3. उपभोक्ता सेटअप

उपभोक्ता के लिए VPC बनाना

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks create consumer-vpc --project=$projectid --subnet-mode=custom

Private Service Connect नेटवर्क का अटैचमेंट सबनेट बनाएं

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks subnets create intf-subnet --project=$projectid --range=192.168.10.0/28 --network=consumer-vpc --region=us-central1

बैकएंड VPC बनाना

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks create backend-vpc --project=$projectid --subnet-mode=custom

बैकएंड VPC सबनेट बनाना

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks subnets create cosmo-subnet-1 --project=$projectid --range=192.168.20.0/28 --network=backend-vpc --region=us-central1

बैकएंड-vpc फ़ायरवॉल के नियम बनाएं

Cloud Shell में, psc-network-अटैचमेंट सबनेट से cosmo पर ट्रैफ़िक के लिए, इन्ग्रेस डेटा ट्रैफ़िक का नियम बनाएं

gcloud compute firewall-rules create allow-ingress-to-cosmo \

--network=backend-vpc \

--action=ALLOW \

--rules=ALL \

--direction=INGRESS \

--priority=1000 \

--source-ranges="192.168.10.0/28" \

--destination-ranges="192.168.20.0/28" \

--enable-logging

Cloud राऊटर और NAT का कॉन्फ़िगरेशन

Cloud NAT का इस्तेमाल सॉफ़्टवेयर पैकेज इंस्टॉल करने के लिए ट्यूटोरियल में किया जाता है, क्योंकि वीएम इंस्टेंस का कोई सार्वजनिक आईपी पता नहीं होता है. Cloud NAT, निजी आईपी पते वाली वीएम को इंटरनेट ऐक्सेस करने की सुविधा देता है.

Cloud Shell के अंदर, क्लाउड राऊटर बनाएं.

gcloud compute routers create cloud-router-for-nat --network backend-vpc --region us-central1

Cloud Shell के अंदर, NAT गेटवे बनाएं.

gcloud compute routers nats create cloud-nat-us-central1 --router=cloud-router-for-nat --auto-allocate-nat-external-ips --nat-all-subnet-ip-ranges --region us-central1

4. आईएपी चालू करें

आईएपी को अपने वीएम इंस्टेंस से कनेक्ट करने की अनुमति देने के लिए, फ़ायरवॉल का नियम बनाएं:

- यह उन सभी वीएम इंस्टेंस पर लागू होता है जिन्हें आपको आईएपी का इस्तेमाल करके ऐक्सेस करना है.

- आईपी रेंज 35.235.240.0/20 से, इन्ग्रेस डेटा ट्रैफ़िक की अनुमति देता है. इस रेंज में वे सभी आईपी पते शामिल होते हैं जिनका इस्तेमाल आईएपी, टीसीपी फ़ॉरवर्ड करने के लिए करता है.

Cloud Shell के अंदर, IAP फ़ायरवॉल का नियम बनाएं.

gcloud compute firewall-rules create ssh-iap-consumer \

--network backend-vpc \

--allow tcp:22 \

--source-ranges=35.235.240.0/20

5. उपभोक्ता के लिए वीएम इंस्टेंस बनाना

Cloud Shell के अंदर, उपभोक्ता वीएम इंस्टेंस, cosmo बनाएं

gcloud compute instances create cosmo \

--project=$projectid \

--machine-type=e2-micro \

--image-family debian-11 \

--no-address \

--image-project debian-cloud \

--zone us-central1-a \

--subnet=cosmo-subnet-1 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart

echo 'Welcome to cosmo's backend server !!' | tee /var/www/html/index.html

EOF"

इंस्टेंस के आईपी पतों को हासिल और सेव करें:

Cloud Shell के अंदर, cosmo वीएम इंस्टेंस के हिसाब से ब्यौरा लिखें.

gcloud compute instances describe cosmo --zone=us-central1-a | grep networkIP:

6. Private Service Connect का नेटवर्क अटैचमेंट

नेटवर्क अटैचमेंट, क्षेत्रीय संसाधन होते हैं. ये Private Service Connect इंटरफ़ेस के उपभोक्ता की तरफ़ से दिखाए जाते हैं. एक सबनेट को नेटवर्क अटैचमेंट के साथ जोड़ा जाता है और निर्माता उस सबनेट से Private Service Connect इंटरफ़ेस को आईपी असाइन करता है. सबनेट उसी क्षेत्र में होना चाहिए जिसमें नेटवर्क अटैचमेंट है. नेटवर्क अटैचमेंट उसी क्षेत्र में होना चाहिए जिसमें प्रोड्यूसर सेवा दे रही है.

नेटवर्क अटैचमेंट बनाएं

Cloud Shell में, नेटवर्क अटैचमेंट बनाएं.

gcloud compute network-attachments create psc-network-attachment \

--region=us-central1 \

--connection-preference=ACCEPT_MANUAL \

--producer-accept-list=$projectid \

--subnets=intf-subnet

नेटवर्क अटैचमेंट की सूची बनाएं

Cloud Shell में, नेटवर्क अटैचमेंट की सूची बनाएं.

gcloud compute network-attachments list

नेटवर्क अटैचमेंट के बारे में बताएं

Cloud Shell में, नेटवर्क अटैचमेंट के बारे में बताएं.

gcloud compute network-attachments describe psc-network-attachment --region=us-central1

psc-network-attachment यूआरआई को ध्यान में रखें. निर्माता इसका इस्तेमाल Private Service Connect इंटरफ़ेस बनाते समय करेगा. उदाहरण के लिए:

user$ gcloud compute network-attachments describe psc-network-attachment --region=us-central1

connectionPreference: ACCEPT_MANUAL

creationTimestamp: '2023-06-07T11:27:33.116-07:00'

fingerprint: 8SDsvG6TfYQ=

id: '5014253525248340730'

kind: compute#networkAttachment

name: psc-network-attachment

network: https://www.googleapis.com/compute/v1/projects/$projectid/global/networks/consumer-vpc

producerAcceptLists:

- $projectid

region: https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1

selfLink: https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment

subnetworks:

- https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/subnetworks/intf-subnet

7. उपभोक्ता और बैकएंड वीपीसी के बीच VPC पीयरिंग तय करना

आपको उपभोक्ता और बैकएंड VPC के बीच VPC पीयरिंग कनेक्शन बनाना होगा. यह Google, नेटवर्क कनेक्टिविटी के लिए क्रॉस ऑर्गेनाइज़ेशन पीयरिंग के साथ-साथ मैनेज की जा रही सेवाओं के लिए, ग्राहक VPC से कनेक्ट करने के तरीके की नकल करता है. VPC पीयरिंग को, हर VPC से कॉन्फ़िगर करना ज़रूरी है.

उपभोक्ता VPC से बैकएंड VPC पीयरिंग

उपभोक्ता से बैकएंड वीपीसी पर VPC पीयरिंग कनेक्शन बनाएं

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks peerings create consumer-to-backend-vpc \

--network=consumer-vpc \

--peer-project=$projectid \

--peer-network=backend-vpc \

--stack-type=IPV4_ONLY

बैकएंड से उपभोक्ता वीपीसी पर VPC पीयरिंग कनेक्शन बनाएं

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks peerings create backend-to-consumer-vpc \

--network=backend-vpc \

--peer-project=$projectid \

--peer-network=consumer-vpc \

--stack-type=IPV4_ONLY

VPC पीयरिंग की स्थिति की जानकारी की पुष्टि करना

Cloud Shell के अंदर, पुष्टि करें कि VPC पीयरिंग "चालू है" में है और "कनेक्ट हो गई" राज्य.

gcloud compute networks peerings list

उदाहरण:

user@cloudshell$ gcloud compute networks peerings list

NAME: backend-to-consumer-vpc

NETWORK: backend-vpc

PEER_PROJECT: $projectid

PEER_NETWORK: consumer-vpc

STACK_TYPE: IPV4_ONLY

PEER_MTU:

IMPORT_CUSTOM_ROUTES: False

EXPORT_CUSTOM_ROUTES: False

STATE: ACTIVE

STATE_DETAILS: [2023-06-07T11:42:27.634-07:00]: Connected.

NAME: consumer-to-backend-vpc

NETWORK: consumer-vpc

PEER_PROJECT: $projectid

PEER_NETWORK: backend-vpc

STACK_TYPE: IPV4_ONLY

PEER_MTU:

IMPORT_CUSTOM_ROUTES: False

EXPORT_CUSTOM_ROUTES: False

STATE: ACTIVE

STATE_DETAILS: [2023-06-07T11:42:27.634-07:00]: Connected.

8. प्रोड्यूसर सेटअप

प्रोड्यूसर VPC बनाएं

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud compute networks create producer-vpc --project=$projectid --subnet-mode=custom

प्रोड्यूसर सबनेट बनाएं

Cloud Shell के अंदर, psc इंटरफ़ेस के vNIC0 के लिए इस्तेमाल किया जाने वाला सबनेट बनाएं

gcloud compute networks subnets create prod-subnet --project=$projectid --range=10.20.1.0/28 --network=producer-vpc --region=us-central1

Cloud Shell के अंदर, बाघ के लिए इस्तेमाल किया जाने वाला सबनेट बनाएं.

gcloud compute networks subnets create prod-subnet-2 --project=$projectid --range=10.30.1.0/28 --network=producer-vpc --region=us-central1

Cloud Shell में, इंटरनल लोड बैलेंसर के लिए इस्तेमाल किया जाने वाला सबनेट बनाएं.

gcloud compute networks subnets create prod-subnet-3 --project=$projectid --range=172.16.10.0/28 --network=producer-vpc --region=us-central1

Cloud राऊटर और NAT का कॉन्फ़िगरेशन

Cloud NAT का इस्तेमाल सॉफ़्टवेयर पैकेज इंस्टॉल करने के लिए ट्यूटोरियल में किया जाता है, क्योंकि वीएम इंस्टेंस का कोई सार्वजनिक आईपी पता नहीं होता है. Cloud NAT, निजी आईपी पते वाली वीएम को इंटरनेट ऐक्सेस करने की सुविधा देता है.

Cloud Shell के अंदर, क्लाउड राऊटर बनाएं.

gcloud compute routers create cloud-router-for-nat-producer --network producer-vpc --region us-central1

Cloud Shell के अंदर, NAT गेटवे बनाएं.

gcloud compute routers nats create cloud-nat-us-central1-producer --router=cloud-router-for-nat-producer --auto-allocate-nat-external-ips --nat-all-subnet-ip-ranges --region us-central1

आईएपी चालू करें

आईएपी को अपने वीएम इंस्टेंस से कनेक्ट करने की अनुमति देने के लिए, फ़ायरवॉल का नियम बनाएं:

- यह उन सभी वीएम इंस्टेंस पर लागू होता है जिन्हें आपको आईएपी का इस्तेमाल करके ऐक्सेस करना है.

- आईपी रेंज 35.235.240.0/20 से, इन्ग्रेस डेटा ट्रैफ़िक की अनुमति देता है. इस रेंज में वे सभी आईपी पते शामिल होते हैं जिनका इस्तेमाल आईएपी, टीसीपी फ़ॉरवर्ड करने के लिए करता है.

Cloud Shell के अंदर, IAP फ़ायरवॉल का नियम बनाएं.

gcloud compute firewall-rules create ssh-iap-producer \

--network producer-vpc \

--allow tcp:22 \

--source-ranges=35.235.240.0/20

प्रोड्यूसर वीएम इंस्टेंस बनाएं

Cloud Shell के अंदर, उपभोक्ता वीएम इंस्टेंस बनाएं, टाइगर

gcloud compute instances create tiger \

--project=$projectid \

--machine-type=e2-micro \

--image-family debian-11 \

--no-address \

--image-project debian-cloud \

--zone us-central1-a \

--subnet=prod-subnet-2 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump"

9. प्रोड्यूसर फ़ायरवॉल के नियम बनाएं

प्रोड्यूसर में VPC एक इन्ग्रेस फ़ायरवॉल नियम बनाएं, जो prod-subnet-2 से प्रोड्यूसर-vpc में सभी इंस्टेंस पर कम्यूनिकेशन की अनुमति देता है.

Cloud Shell के अंदर, प्रोड्यूसर फ़ायरवॉल नियम बनाएं.

gcloud compute --project=$projectid firewall-rules create allow-tiger-ingress --direction=INGRESS --priority=1000 --network=producer-vpc --action=ALLOW --rules=all --source-ranges=10.30.1.0/28 --enable-logging

10. Private Service Connect इंटरफ़ेस बनाना

Private Service Connect इंटरफ़ेस एक ऐसा संसाधन है जिसकी मदद से, प्रोड्यूसर वर्चुअल प्राइवेट क्लाउड (VPC) नेटवर्क, उपभोक्ता VPC नेटवर्क में अलग-अलग डेस्टिनेशन से कनेक्शन शुरू कर सकता है. निर्माता और उपभोक्ता नेटवर्क अलग-अलग प्रोजेक्ट और संगठनों में हो सकते हैं.

अगर कोई नेटवर्क अटैचमेंट, Private Service Connect इंटरफ़ेस से मिले कनेक्शन को स्वीकार करता है, तो Google Cloud, इंटरफ़ेस को एक आईपी पता देता है. यह आईपी पता, नेटवर्क अटैचमेंट के ज़रिए उपभोक्ता के सबनेट से मिलता है. उपभोक्ता और उत्पादक नेटवर्क जुड़े हुए हैं और वे आंतरिक आईपी पतों का इस्तेमाल करके बातचीत कर सकते हैं.

इस ट्यूटोरियल में, प्राइवेट सर्विस कनेक्ट नेटवर्क अटैचमेंट की मदद से दो इंस्टेंस बनाए जाएंगे. ये अटैचमेंट, इंटरनल लोड बैलेंसर के बैकएंड के तौर पर होंगे.

Cloud Shell के अंदर, Private Service Connect इंटरफ़ेस (रैबिट) बनाएं. इसके बाद, नेटवर्क अटैचमेंट में दिए गए आउटपुट के बारे में पहले से पहचाने गए psc-network-attachment URI को डालें.

gcloud compute instances create rabbit --zone us-central1-a --machine-type=f1-micro --can-ip-forward --network-interface subnet=prod-subnet,network=producer-vpc,no-address --network-interface network-attachment=https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment --metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart"

Cloud Shell के अंदर, Private Service Connect इंटरफ़ेस (फ़ॉक्स) बनाएं. इसके बाद, नेटवर्क अटैचमेंट में दिए गए आउटपुट के बारे में पहले से पहचाने गए psc-network-attachment URI को डालें.

gcloud compute instances create fox --zone us-central1-a --machine-type=f1-micro --can-ip-forward --network-interface subnet=prod-subnet,network=producer-vpc,no-address --network-interface network-attachment=https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment --metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart"

मल्टी-निक वैलिडेशन

पुष्टि करें कि PSC इंटरफ़ेस सही आईपी पते के साथ कॉन्फ़िगर किया गया है. vNIC0, प्रोड्यूसर प्रोडक्शन-सबनेट (10.20.1.0/28) का इस्तेमाल करेगा और vNIC1, उपभोक्ता के intf-सबनेट (192.168.10.0/28) का इस्तेमाल करेगा.

gcloud compute instances describe rabbit --zone=us-central1-a | grep networkIP:

gcloud compute instances describe fox --zone=us-central1-a | grep networkIP:

उदाहरण:

user$ gcloud compute instances describe rabbit --zone=us-central1-a | grep networkIP:

networkIP: 10.20.1.2

networkIP: 192.168.10.2

user$ gcloud compute instances describe fox --zone=us-central1-a | grep networkIP:

networkIP: 10.20.1.3

networkIP: 192.168.10.3

11. मैनेज नहीं किए जा रहे इंस्टेंस ग्रुप में खरगोश और लोमड़ी बनाएं और जोड़ें

नीचे दिए गए सेक्शन में, मैनेज नहीं किया जा रहा इंस्टेंस ग्रुप बनाया जाएगा. इसमें PSC इंटरफ़ेस के इंस्टेंस, खरगोश और लोमड़ी वाले इंस्टेंस शामिल होंगे.

Cloud Shell में, मैनेज नहीं किया जा रहा इंस्टेंस ग्रुप बनाएं.

gcloud compute instance-groups unmanaged create psc-interface-instances-ig --project=$projectid --zone=us-central1-a

Cloud Shell के अंदर, इंस्टेंस ग्रुप में इंस्टेंस फ़ॉक्स और रैबिट जोड़ें.

gcloud compute instance-groups unmanaged add-instances psc-interface-instances-ig --project=$projectid --zone=us-central1-a --instances=fox,rabbit

12. टीसीपी की परफ़ॉर्मेंस की जांच, बैकएंड सेवाएं, कॉल फ़ॉरवर्ड करने से जुड़े नियम, और फ़ायरवॉल

Cloud Shell के अंदर, बैकएंड की परफ़ॉर्मेंस की जांच करें.

gcloud compute health-checks create http hc-http-80 --port=80

Cloud Shell के अंदर बैकएंड सेवा बनाएं

gcloud compute backend-services create psc-interface-backend --load-balancing-scheme=internal --protocol=tcp --region=us-central1 --health-checks=hc-http-80

gcloud compute backend-services add-backend psc-interface-backend --region=us-central1 --instance-group=psc-interface-instances-ig --instance-group-zone=us-central1-a

Cloud Shell में, फ़ॉरवर्ड करने का नियम बनाएं

gcloud compute forwarding-rules create psc-ilb --region=us-central1 --load-balancing-scheme=internal --network=producer-vpc --subnet=prod-subnet-3 --address=172.16.10.10 --ip-protocol=TCP --ports=all --backend-service=psc-interface-backend --backend-service-region=us-central1

बैकएंड की परफ़ॉर्मेंस की जांच चालू करने के लिए, Cloud Shell से फ़ायरवॉल का नियम बनाएं

gcloud compute firewall-rules create ilb-health-checks --allow tcp:80,tcp:443 --network producer-vpc --source-ranges 130.211.0.0/22,35.191.0.0/16

13. PSC इंटरफ़ेस के लिए Linux आईपी टेबल बनाएं - रैबिट

PSC इंटरफ़ेस इंस्टेंस से, Linux आईपी टेबल कॉन्फ़िगर करें, ताकि उपभोक्ता सबनेट को प्रोड्यूसर से कम्यूनिकेशन के लिए अनुमति दी जा सके.

अपने Private Service Connect इंटरफ़ेस के मेहमान ओएस का नाम ढूंढना

रूटिंग कॉन्फ़िगर करने के लिए, आपको अपने Private Service Connect इंटरफ़ेस के मेहमान ओएस का नाम जानना होगा. यह नाम, Google Cloud में इंटरफ़ेस के नाम से अलग होता है.

Cloud Shell में IAP का इस्तेमाल करके psc-इंटरफ़ेस vm, rabit में लॉग इन करें.

gcloud compute ssh rabbit --project=$projectid --zone=us-central1-a --tunnel-through-iap

क्लाउड शेल में psc-इंटरफ़ेस इंस्टेंस का आईपी पता पाएं

ip a

उदाहरण:

user@rabbit:~$ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:0a:14:01:02 brd ff:ff:ff:ff:ff:ff

altname enp0s4

inet 10.20.1.2/32 brd 10.20.1.2 scope global dynamic ens4

valid_lft 59396sec preferred_lft 59396sec

inet6 fe80::4001:aff:fe14:102/64 scope link

valid_lft forever preferred_lft forever

3: ens5: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:c0:a8:0a:02 brd ff:ff:ff:ff:ff:ff

altname enp0s5

inet 192.168.10.2/32 brd 192.168.10.2 scope global dynamic ens5

valid_lft 66782sec preferred_lft 66782sec

inet6 fe80::4001:c0ff:fea8:a02/64 scope link

valid_lft forever preferred_lft forever

अपने PSC इंटरफ़ेस का गेटवे आईपी ढूंढें

नेटवर्क इंटरफ़ेस की सूची में, अपने Private Service Connect इंटरफ़ेस के आईपी पते से जुड़े इंटरफ़ेस का नाम ढूंढें और सेव करें. उदाहरण के लिए, ens5 (vNIC1)

रूटिंग को कॉन्फ़िगर करने के लिए, आपके पास अपने Private Service Connect इंटरफ़ेस के डिफ़ॉल्ट गेटवे का आईपी पता होना चाहिए

क्लाउड शेल में हम 1 का इस्तेमाल करेंगे, क्योंकि PSC इंटरफ़ेस vNIC1 से जुड़ा होता है.

curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

उदाहरण में डिफ़ॉल्ट रूप से gov 192.168.10.1 कोड जनरेट होता है

user@rabbit:~$ curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

192.168.10.1

उपभोक्ता सबनेट के लिए रूट जोड़ें

आपको अपने Private Service Connect इंटरफ़ेस के डिफ़ॉल्ट गेटवे में, हर उस उपभोक्ता सबनेट के लिए एक रूट जोड़ना होगा जो आपके Private Service Connect इंटरफ़ेस से कनेक्ट होता है. इससे यह पक्का होता है कि Private Service Connect इंटरफ़ेस से, उपभोक्ता नेटवर्क से आने वाले ट्रैफ़िक का पता चलता है.

रूट टेबल की पुष्टि करें

Cloud Shell में मौजूदा रास्तों की पुष्टि की जा रही है.

ip route show

उदाहरण.

user@rabbit:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

Cloud Shell में cosmo-subnet-1 पर रूट जोड़ें

sudo ip route add 192.168.20.0/28 via 192.168.10.1 dev ens5

रूट टेबल की पुष्टि करें

Cloud Shell में, अपडेट किए गए रूट की पुष्टि की जा सकती है.

ip route show

उदाहरण.

user@rabbit:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

192.168.20.0/28 via 192.168.10.1 dev ens5

आईपी टेबल के नियम बनाएं

Cloud Shell में, मौजूदा आईपी टेबल की पुष्टि की जा रही है.

sudo iptables -t nat -L -n -v

उदाहरण:

user@rabbit:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Cloud Shell में आईपी टेबल अपडेट करें

sudo iptables -t nat -A POSTROUTING -o ens5 -j MASQUERADE

sudo sysctl net.ipv4.ip_forward=1

Cloud Shell में, अपडेट की गई आईपी टेबल की पुष्टि की जा रही है.

sudo iptables -t nat -L -n -v

उदाहरण:

user@rabbit:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * ens5 0.0.0.0/0 0.0.0.0/0

14. PSC इंटरफ़ेस के लिए Linux IP टेबल बनाएं - fox

PSC इंटरफ़ेस इंस्टेंस से, Linux आईपी टेबल कॉन्फ़िगर करें, ताकि उपभोक्ता सबनेट को प्रोड्यूसर से कम्यूनिकेशन के लिए अनुमति दी जा सके.

अपने Private Service Connect इंटरफ़ेस के मेहमान ओएस का नाम ढूंढना

रूटिंग कॉन्फ़िगर करने के लिए, आपको अपने Private Service Connect इंटरफ़ेस के मेहमान ओएस का नाम जानना होगा. यह नाम, Google Cloud में इंटरफ़ेस के नाम से अलग होता है.

नया Cloud Shell टैब खोलें और अपने प्रोजेक्ट की सेटिंग अपडेट करें.

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Cloud Shell में IAP का इस्तेमाल करके psc-इंटरफ़ेस vm, फ़ॉक्स में लॉग इन करें.

gcloud compute ssh fox --project=$projectid --zone=us-central1-a --tunnel-through-iap

क्लाउड शेल में psc-इंटरफ़ेस इंस्टेंस का आईपी पता पाएं

ip a

उदाहरण:

user@fox:~$ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:0a:14:01:03 brd ff:ff:ff:ff:ff:ff

altname enp0s4

inet 10.20.1.3/32 brd 10.20.1.3 scope global dynamic ens4

valid_lft 65601sec preferred_lft 65601sec

inet6 fe80::4001:aff:fe14:103/64 scope link

valid_lft forever preferred_lft forever

3: ens5: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:c0:a8:0a:03 brd ff:ff:ff:ff:ff:ff

altname enp0s5

inet 192.168.10.3/32 brd 192.168.10.3 scope global dynamic ens5

valid_lft 63910sec preferred_lft 63910sec

inet6 fe80::4001:c0ff:fea8:a03/64 scope link

valid_lft forever preferred_lft forever

अपने PSC इंटरफ़ेस का गेटवे आईपी ढूंढें

नेटवर्क इंटरफ़ेस की सूची में, अपने Private Service Connect इंटरफ़ेस के आईपी पते से जुड़े इंटरफ़ेस का नाम ढूंढें और सेव करें. उदाहरण के लिए, ens5 (vNIC1)

रूटिंग को कॉन्फ़िगर करने के लिए, आपके पास अपने Private Service Connect इंटरफ़ेस के डिफ़ॉल्ट गेटवे का आईपी पता होना चाहिए

क्लाउड शेल में हम 1 का इस्तेमाल करेंगे, क्योंकि PSC इंटरफ़ेस vNIC1 से जुड़ा होता है.

curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

उदाहरण में डिफ़ॉल्ट रूप से gov 192.168.10.1 कोड जनरेट होता है

user@fox:~$ curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

192.168.10.1

उपभोक्ता सबनेट के लिए रूट जोड़ें

आपको अपने Private Service Connect इंटरफ़ेस के डिफ़ॉल्ट गेटवे में, हर उस उपभोक्ता सबनेट के लिए एक रूट जोड़ना होगा जो आपके Private Service Connect इंटरफ़ेस से कनेक्ट होता है. इससे यह पक्का होता है कि Private Service Connect इंटरफ़ेस से, उपभोक्ता नेटवर्क से आने वाले ट्रैफ़िक का पता चलता है.

रूट टेबल की पुष्टि करें

Cloud Shell में मौजूदा रास्तों की पुष्टि की जा रही है.

ip route show

उदाहरण.

user@fox:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

Cloud Shell में cosmo-subnet-1 पर रूट जोड़ें

sudo ip route add 192.168.20.0/28 via 192.168.10.1 dev ens5

रूट टेबल की पुष्टि करें

Cloud Shell में, अपडेट किए गए रूट की पुष्टि की जा सकती है.

ip route show

उदाहरण.

user@fox:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

192.168.20.0/28 via 192.168.10.1 dev ens5

आईपी टेबल के नियम बनाएं

Cloud Shell में, मौजूदा आईपी टेबल की पुष्टि की जा रही है.

sudo iptables -t nat -L -n -v

उदाहरण:

user@fox:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Cloud Shell अपडेट आईपी टेबल में.

sudo iptables -t nat -A POSTROUTING -o ens5 -j MASQUERADE

sudo sysctl net.ipv4.ip_forward=1

Cloud Shell में, अपडेट की गई आईपी टेबल की पुष्टि की जा रही है.

sudo iptables -t nat -L -n -v

उदाहरण:

user@fox:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * ens5 0.0.0.0/0 0.0.0.0/0

15. रास्ते की टेबल अपडेट करें

प्रोड्यूसर-vpc में उपभोक्ता सबनेट 192.168.20.0/28 के लिए एक स्टैटिक रूट बनाएं, फिर अगली बार इंटरनल लोड बैलेंसर के तौर पर काम करें. बनने के बाद, पैकेट (प्रोड्यूसर-vpc में) 192.168.20.0/28 पर ले जाने वाले पैकेट को इंटरनल लोड बैलेंसर पर भेज दिया जाएगा.

नया Cloud Shell टैब खोलें और अपने प्रोजेक्ट की सेटिंग अपडेट करें.

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Cloud Shell में, प्रोड्यूसर-vpc के रूट की टेबल को स्टैटिक रास्ते के साथ अपडेट करें.

gcloud beta compute routes create producer-to-cosmo-subnet-1 --project=$projectid --network=producer-vpc --priority=1000 --destination-range=192.168.20.0/28 --next-hop-ilb=psc-ilb --next-hop-ilb-region=us-central1

16. बाघ से कॉस्मो तक कनेक्ट होने की पुष्टि करें

कर्ल की पुष्टि

इस बात की पुष्टि करें कि प्रोड्यूसर वीएम इंस्टेंस, टाइगर, कर्ल परफ़ॉर्म करके उपभोक्ता के इंस्टेंस, कॉस्मो से संपर्क कर सकता है.

नया Cloud Shell टैब खोलें और अपने प्रोजेक्ट की सेटिंग अपडेट करें.

Cloud Shell के अंदर, यह तरीका अपनाएं:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Cloud Shell में IAP का इस्तेमाल करके टाइगर इंस्टेंस में लॉग इन करें.

gcloud compute ssh tiger --project=$projectid --zone=us-central1-a --tunnel-through-iap

टाइगर इंस्टेंस से ट्यूटोरियल में पहले पहचाने गए कॉस्मो के आईपी पते के मुताबिक कर्ल करें.

curl -v <cosmo's IP Address>

उदाहरण:

user@tiger:~$ curl -v 192.168.20.2

* Trying 192.168.20.2:80...

* Connected to 192.168.20.2 (192.168.20.2) port 80 (#0)

> GET / HTTP/1.1

> Host: 192.168.20.2

> User-Agent: curl/7.74.0

> Accept: */*

>

* Mark bundle as not supporting multiuse

< HTTP/1.1 200 OK

< Date: Fri, 09 Jun 2023 03:49:42 GMT

< Server: Apache/2.4.56 (Debian)

< Last-Modified: Fri, 09 Jun 2023 03:28:37 GMT

< ETag: "27-5fda9f6ea060e"

< Accept-Ranges: bytes

< Content-Length: 39

< Content-Type: text/html

<

Welcome to cosmo's backend server !!

बधाई!! आपने कर्ल निर्देश लागू करके, प्रोड्यूसर-vpc से बैकएंड-vpc में कनेक्टिविटी की पुष्टि कर दी है.

17. व्यवस्थित करें

Cloud Shell से, ट्यूटोरियल कॉम्पोनेंट मिटाएं.

gcloud compute instances delete cosmo --zone=us-central1-a --quiet

gcloud compute instances delete rabbit --zone=us-central1-a --quiet

gcloud compute instances delete fox --zone=us-central1-a --quiet

gcloud compute instances delete tiger --zone=us-central1-a --quiet

gcloud compute network-attachments delete psc-network-attachment --region=us-central1 --quiet

gcloud compute firewall-rules delete allow-ingress-to-cosmo allow-tiger-ingress ilb-health-checks ssh-iap-consumer ssh-iap-producer --quiet

gcloud beta compute routes delete producer-to-cosmo-subnet-1 --quiet

gcloud compute forwarding-rules delete psc-ilb --region=us-central1 --quiet

gcloud compute backend-services delete psc-interface-backend --region=us-central1 --quiet

gcloud compute instance-groups unmanaged delete psc-interface-instances-ig --zone=us-central1-a --quiet

gcloud compute health-checks delete hc-http-80 --quiet

gcloud compute networks subnets delete cosmo-subnet-1 prod-subnet prod-subnet-2 prod-subnet-3 intf-subnet --region=us-central1 --quiet

gcloud compute routers delete cloud-router-for-nat --region=us-central1 --quiet

gcloud compute routers delete cloud-router-for-nat-producer --region=us-central1 --quiet

gcloud compute networks delete consumer-vpc --quiet

gcloud compute networks delete producer-vpc --quiet

gcloud compute networks delete backend-vpc --quiet

18. बधाई हो

बधाई हो, आपने Private Service Connect इंटरफ़ेस को कॉन्फ़िगर करके उसकी पुष्टि कर ली है. साथ ही, आपने VPC पीयरिंग की मदद से, उपभोक्ता और प्रोड्यूसर की कनेक्टिविटी की पुष्टि कर ली है.

आपने उपभोक्ता इंफ़्रास्ट्रक्चर बनाया है और आपने ऐसा नेटवर्क अटैचमेंट जोड़ा है जिसकी मदद से, प्रोड्यूसर उपभोक्ता और प्रोड्यूसर के बीच कम्यूनिकेशन को आपस में जोड़ने के लिए, मल्टी-निक वीएम बना सकते हैं. आपने जाना कि इंटरनल लोड बैलेंसर और प्रोड्यूसर के स्टैटिक रूट का इस्तेमाल करके, VPC पीयरिंग की मदद से 1P/3P सेवाओं के साथ कैसे संपर्क किया जा सकता है.

Cosmopup को लगता है कि ट्यूटोरियल शानदार हैं!!

आगे क्या होगा?

इनमें से कुछ ट्यूटोरियल देखें...

- GKE की मदद से सेवाएं पब्लिश करने और उनका इस्तेमाल करने के लिए, Private Service Connect का इस्तेमाल करना

- सेवाएं पब्लिश करने और उनका इस्तेमाल करने के लिए, Private Service Connect का इस्तेमाल करना

- प्राइवेट सर्विस कनेक्ट और इंटरनल टीसीपी प्रॉक्सी लोड बैलेंसर का इस्तेमाल करके, हाइब्रिड नेटवर्किंग की मदद से कंपनी की ऑन-प्रेम सेवाओं से कनेक्ट करें

आगे पढ़ें और वीडियो

- Private Service Connect के बारे में खास जानकारी

- प्राइवेट सर्विस कनेक्ट क्या है?

- इस्तेमाल किए जा सकने वाले लोड बैलेंसर के टाइप