1. Giriş

Private Service Connect arayüzü, üretici Sanal Özel Bulut (VPC) ağının tüketici VPC ağındaki çeşitli hedeflere bağlantı başlatmasını sağlayan bir kaynaktır. Yapımcı ve tüketici ağları farklı proje ve kuruluşlarda olabilir.

Bir ağ eki Private Service Connect arayüzünden bir bağlantıyı kabul ederse Google Cloud arayüze, ağ ekinde belirtilen bir tüketici alt ağına ait bir IP adresi ayırır. Tüketici ve üretici ağları birbirine bağlıdır ve dahili IP adreslerini kullanarak iletişim kurabilir.

Ağ eki ile Private Service Connect arayüzü arasındaki bağlantı, Private Service Connect uç noktası ile hizmet eki arasındaki bağlantıya benzer ancak iki önemli fark vardır:

- Ağ eki, üretici ağın tüketici ağına bağlantı başlatmasına (yönetilen hizmet çıkışı) izin verirken uç nokta ise tüketici ağının üretici ağına bağlantı başlatmasına (yönetilen hizmet girişi) olanak tanır.

- Private Service Connect arayüz bağlantısı geçişlidir. Bu, bir üretici ağının tüketici ağına bağlı diğer ağlarla iletişim kurabileceği anlamına gelir.

Neler oluşturacaksınız?

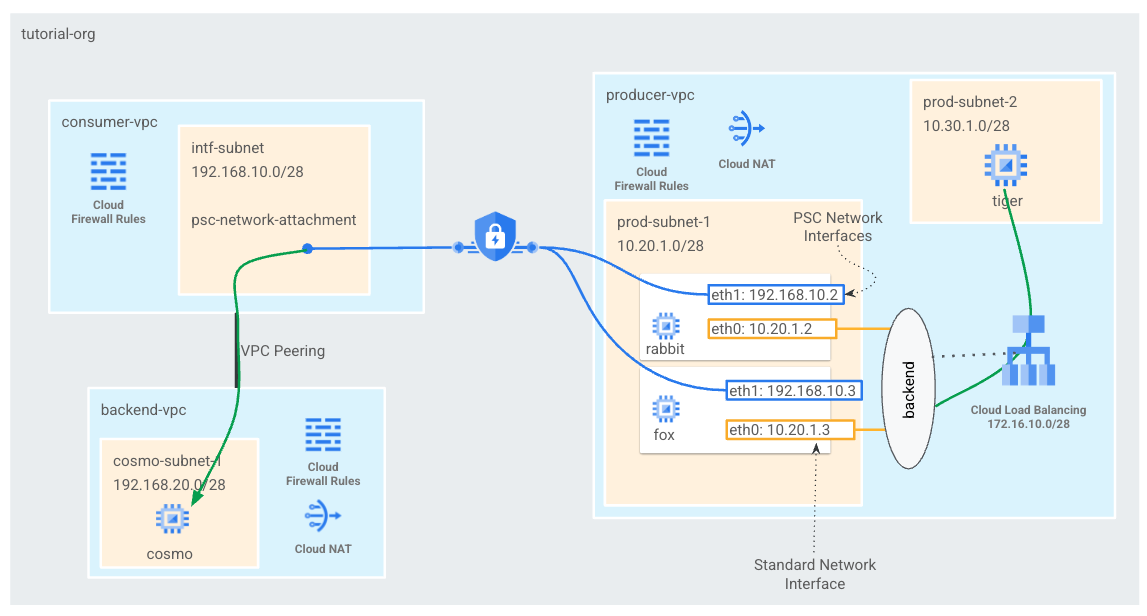

Tüketici VPC'sinde tek bir psc ağ eki oluşturursunuz. Böylece L4 dahili yük dengeleyiciye arka uç olarak iki PSC arayüzü oluşturulur. Üretici VPC kaplanı, arka uç-vpc'de cosmo'ya bir curl gönderir. Üreticinin VPC'sinde, trafiği cosmo'ya yönlendirmek için arka uç ve sonraki PSC arayüzlerinden yararlanacak dahili yük dengeleyici olarak 192.168.20.0/28 sonraki durak adlı hedef trafiğe giden statik bir yol oluşturacaksınız. Genel bakış için bkz. Şekil 1.

Aynı yaklaşım, Özel Hizmet Erişimi kullanılırken müşteri VPC'siyle eşlenen VPC'ler olan Google tarafından yönetilen hizmetlerde de kullanılabilir.

1. Şekil

Neler öğreneceksiniz?

- Ağ eki oluşturma

- Üreticiler arka uç olarak PSC arayüzü oluşturmak için ağ ekini nasıl kullanabilir?

- Sonraki durak olarak ILB'yi kullanarak yapımcıdan tüketiciye iletişim nasıl kurulur?

- VPC eşleme üzerinden üretici sanal makinesinden (tiger) tüketici sanal makinesine (cosmo) erişime izin verme

Gerekenler

- Google Cloud Projesi

- IAM İzinleri

- İşlem Ağ Yöneticisi (roles/compute.networkAdmin)

- Compute Örnek Yöneticisi (roles/compute.instanceAdmin)

- Compute Güvenlik Yöneticisi (roles/compute.securityAdmin)

2. Başlamadan önce

Projeyi eğiticiyi destekleyecek şekilde güncelleme

Bu eğiticide, Cloud Shell'de gcloud yapılandırması uygulamasına yardımcı olmak için $variables kullanımı açıklanmaktadır.

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

3. Tüketici Kurulumu

Tüketici VPC'si oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks create consumer-vpc --project=$projectid --subnet-mode=custom

Private Service Connect Ağ Eki alt ağını oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks subnets create intf-subnet --project=$projectid --range=192.168.10.0/28 --network=consumer-vpc --region=us-central1

Arka uç VPC'sini oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks create backend-vpc --project=$projectid --subnet-mode=custom

Arka uç VPC alt ağlarını oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks subnets create cosmo-subnet-1 --project=$projectid --range=192.168.20.0/28 --network=backend-vpc --region=us-central1

Arka uç-vpc güvenlik duvarı kurallarını oluşturma

Cloud Shell'de psc-network-attachment alt ağından cosmo'ya giden trafik için bir giriş kuralı oluşturun

gcloud compute firewall-rules create allow-ingress-to-cosmo \

--network=backend-vpc \

--action=ALLOW \

--rules=ALL \

--direction=INGRESS \

--priority=1000 \

--source-ranges="192.168.10.0/28" \

--destination-ranges="192.168.20.0/28" \

--enable-logging

Cloud Router ve NAT yapılandırması

Sanal makine örneğinin herkese açık IP adresi olmadığından yazılım paketi kurulumu için Cloud NAT kullanılır. Cloud NAT, özel IP adreslerine sahip sanal makinelerin internete erişmesine olanak tanır.

Cloud Shell'in içinde bulut yönlendiricisini oluşturun.

gcloud compute routers create cloud-router-for-nat --network backend-vpc --region us-central1

Cloud Shell'in içinde NAT ağ geçidini oluşturun.

gcloud compute routers nats create cloud-nat-us-central1 --router=cloud-router-for-nat --auto-allocate-nat-external-ips --nat-all-subnet-ip-ranges --region us-central1

4. IAP'yi etkinleştirme

IAP'nin sanal makine örneklerinize bağlanmasına izin vermek için aşağıdaki şartları yerine getiren bir güvenlik duvarı kuralı oluşturun:

- IAP kullanarak erişilmesini istediğiniz tüm sanal makine örnekleri için geçerlidir.

- 35.235.240.0/20 IP aralığından giriş trafiğine izin verir. Bu aralık, IAP'nin TCP yönlendirme için kullandığı tüm IP adreslerini içerir.

Cloud Shell'in içinde IAP güvenlik duvarı kuralını oluşturun.

gcloud compute firewall-rules create ssh-iap-consumer \

--network backend-vpc \

--allow tcp:22 \

--source-ranges=35.235.240.0/20

5. Tüketici sanal makine örnekleri oluşturma

Cloud Shell'in içinde cosmo tüketici sanal makine örneğini oluşturma

gcloud compute instances create cosmo \

--project=$projectid \

--machine-type=e2-micro \

--image-family debian-11 \

--no-address \

--image-project debian-cloud \

--zone us-central1-a \

--subnet=cosmo-subnet-1 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart

echo 'Welcome to cosmo's backend server !!' | tee /var/www/html/index.html

EOF"

Örneklerin IP Adreslerini alın ve depolayın:

Cloud Shell'in içinde cosmo sanal makine örneklerine yönelik bir açıklama yapın.

gcloud compute instances describe cosmo --zone=us-central1-a | grep networkIP:

6. Private Service Connect ağ eki

Ağ ekleri, Private Service Connect arayüzünün tüketici tarafını temsil eden bölgesel kaynaklardır. Tek bir alt ağı bir ağ ekiyle ilişkilendirirsiniz ve üretici, IP'leri Private Service Connect arayüzüne bu alt ağdan atar. Alt ağ, ağ ekiyle aynı bölgede olmalıdır. Ağ eki, üretici hizmetiyle aynı bölgede olmalıdır.

Ağ ekini oluşturma

Cloud Shell'in içinde ağ ekini oluşturun.

gcloud compute network-attachments create psc-network-attachment \

--region=us-central1 \

--connection-preference=ACCEPT_MANUAL \

--producer-accept-list=$projectid \

--subnets=intf-subnet

Ağ eklerini listeleyin

Cloud Shell'in içinde ağ ekini listeleyin.

gcloud compute network-attachments list

Ağ eklerini açıklayın

Cloud Shell'in içinde ağ ekini açıklayın.

gcloud compute network-attachments describe psc-network-attachment --region=us-central1

Private Service Connect Arayüzleri'ni oluştururken üretici tarafından kullanılacak psc-network-attachment URI'sini not edin. Aşağıda bir örnek gösterilmiştir:

user$ gcloud compute network-attachments describe psc-network-attachment --region=us-central1

connectionPreference: ACCEPT_MANUAL

creationTimestamp: '2023-06-07T11:27:33.116-07:00'

fingerprint: 8SDsvG6TfYQ=

id: '5014253525248340730'

kind: compute#networkAttachment

name: psc-network-attachment

network: https://www.googleapis.com/compute/v1/projects/$projectid/global/networks/consumer-vpc

producerAcceptLists:

- $projectid

region: https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1

selfLink: https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment

subnetworks:

- https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/subnetworks/intf-subnet

7. Tüketici ve arka uç VPC'si arasında VPC eşleme oluşturun

Tüketici ile arka uç VPC arasında bir VPC eşleme bağlantısı oluşturacaksınız. Bu, Google'ın ağ bağlantısı için kuruluşlar arası eşlemeye ek olarak yönetilen hizmetler için müşteri VPC'lerine bağlantı kurma şeklini kopyalar. VPC eşleme her VPC'den yapılandırılmalıdır.

Tüketici VPC'sinden arka uç VPC eşlemeye

Tüketiciden arka uç VPC'sine VPC eşleme bağlantısı oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks peerings create consumer-to-backend-vpc \

--network=consumer-vpc \

--peer-project=$projectid \

--peer-network=backend-vpc \

--stack-type=IPV4_ONLY

Arka uçtan tüketici VPC'sine VPC eşleme bağlantısı oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks peerings create backend-to-consumer-vpc \

--network=backend-vpc \

--peer-project=$projectid \

--peer-network=consumer-vpc \

--stack-type=IPV4_ONLY

VPC eşleme durumu ayrıntılarını doğrulama

Cloud Shell içinde VPC eşlemenin "Etkin" durumda olduğunu doğrulayın ve "Bağlı" durumu.

gcloud compute networks peerings list

Örnek:

user@cloudshell$ gcloud compute networks peerings list

NAME: backend-to-consumer-vpc

NETWORK: backend-vpc

PEER_PROJECT: $projectid

PEER_NETWORK: consumer-vpc

STACK_TYPE: IPV4_ONLY

PEER_MTU:

IMPORT_CUSTOM_ROUTES: False

EXPORT_CUSTOM_ROUTES: False

STATE: ACTIVE

STATE_DETAILS: [2023-06-07T11:42:27.634-07:00]: Connected.

NAME: consumer-to-backend-vpc

NETWORK: consumer-vpc

PEER_PROJECT: $projectid

PEER_NETWORK: backend-vpc

STACK_TYPE: IPV4_ONLY

PEER_MTU:

IMPORT_CUSTOM_ROUTES: False

EXPORT_CUSTOM_ROUTES: False

STATE: ACTIVE

STATE_DETAILS: [2023-06-07T11:42:27.634-07:00]: Connected.

8. Yapımcı Kurulumu

Üretici VPC'sini oluşturma

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud compute networks create producer-vpc --project=$projectid --subnet-mode=custom

Üretici alt ağlarını oluşturma

Cloud Shell'in içinde psc arayüzlerinin vNIC0 için kullanılan alt ağı oluşturun

gcloud compute networks subnets create prod-subnet --project=$projectid --range=10.20.1.0/28 --network=producer-vpc --region=us-central1

Cloud Shell'in içinde, kaplanı örneği için kullanılan alt ağı oluşturun.

gcloud compute networks subnets create prod-subnet-2 --project=$projectid --range=10.30.1.0/28 --network=producer-vpc --region=us-central1

Cloud Shell'in içinde, dahili yük dengeleyici için kullanılan alt ağı oluşturun.

gcloud compute networks subnets create prod-subnet-3 --project=$projectid --range=172.16.10.0/28 --network=producer-vpc --region=us-central1

Cloud Router ve NAT yapılandırması

Sanal makine örneğinin herkese açık IP adresi olmadığından yazılım paketi kurulumu için Cloud NAT kullanılır. Cloud NAT, özel IP adreslerine sahip sanal makinelerin internete erişmesine olanak tanır.

Cloud Shell'in içinde bulut yönlendiricisini oluşturun.

gcloud compute routers create cloud-router-for-nat-producer --network producer-vpc --region us-central1

Cloud Shell'in içinde NAT ağ geçidini oluşturun.

gcloud compute routers nats create cloud-nat-us-central1-producer --router=cloud-router-for-nat-producer --auto-allocate-nat-external-ips --nat-all-subnet-ip-ranges --region us-central1

IAP'yi etkinleştirme

IAP'nin sanal makine örneklerinize bağlanmasına izin vermek için aşağıdaki şartları yerine getiren bir güvenlik duvarı kuralı oluşturun:

- IAP kullanarak erişilmesini istediğiniz tüm sanal makine örnekleri için geçerlidir.

- 35.235.240.0/20 IP aralığından giriş trafiğine izin verir. Bu aralık, IAP'nin TCP yönlendirme için kullandığı tüm IP adreslerini içerir.

Cloud Shell'in içinde IAP güvenlik duvarı kuralını oluşturun.

gcloud compute firewall-rules create ssh-iap-producer \

--network producer-vpc \

--allow tcp:22 \

--source-ranges=35.235.240.0/20

Üretici sanal makine örnekleri oluşturma

Cloud Shell'de tüketici sanal makine örneğini (tiger) oluşturma

gcloud compute instances create tiger \

--project=$projectid \

--machine-type=e2-micro \

--image-family debian-11 \

--no-address \

--image-project debian-cloud \

--zone us-central1-a \

--subnet=prod-subnet-2 \

--metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump"

9. Üretici güvenlik duvarı kuralları oluşturma

Üretici VPC'sinde, prod-subnet-2'den üretici-vpc'deki tüm örneklere iletişime izin veren bir giriş güvenlik duvarı kuralı oluşturun.

Cloud Shell'in içinde üretici güvenlik duvarı kuralını oluşturun.

gcloud compute --project=$projectid firewall-rules create allow-tiger-ingress --direction=INGRESS --priority=1000 --network=producer-vpc --action=ALLOW --rules=all --source-ranges=10.30.1.0/28 --enable-logging

10. Private Service Connect Arayüzünü Oluşturma

Private Service Connect arayüzü, üretici Sanal Özel Bulut (VPC) ağının tüketici VPC ağındaki çeşitli hedeflere bağlantı başlatmasını sağlayan bir kaynaktır. Yapımcı ve tüketici ağları farklı proje ve kuruluşlarda olabilir.

Bir ağ eki Private Service Connect arayüzünden bir bağlantıyı kabul ederse Google Cloud arayüze, ağ ekinde belirtilen bir tüketici alt ağına ait bir IP adresi ayırır. Tüketici ve üretici ağları birbirine bağlıdır ve dahili IP adreslerini kullanarak iletişim kurabilir.

Eğiticide, dahili yük dengeleyicinin arka ucu olacak özel hizmet bağlantısı ağı ekini içeren iki örnek oluşturacaksınız.

Cloud Shell'in içinde Private Service Connect arayüzünü (tavşan) oluşturun ve çıkışı açıklamak için ağ ekinde önceden tanımlanan psc-network-attachment URI'yi ekleyin.

gcloud compute instances create rabbit --zone us-central1-a --machine-type=f1-micro --can-ip-forward --network-interface subnet=prod-subnet,network=producer-vpc,no-address --network-interface network-attachment=https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment --metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart"

Cloud Shell'de Private Service Connect arayüzünü (fox) oluşturun ve çıkışı açıklamak için ağ ekinde önceden tanımlanan psc-network-attachment URI'yi ekleyin.

gcloud compute instances create fox --zone us-central1-a --machine-type=f1-micro --can-ip-forward --network-interface subnet=prod-subnet,network=producer-vpc,no-address --network-interface network-attachment=https://www.googleapis.com/compute/v1/projects/$projectid/regions/us-central1/networkAttachments/psc-network-attachment --metadata startup-script="#! /bin/bash

sudo apt-get update

sudo apt-get install tcpdump

sudo apt-get install apache2 -y

sudo service apache2 restart"

Çoklu nic doğrulaması

PSC arayüzünün uygun IP adresiyle yapılandırıldığını doğrulayın. vNIC0, üretici üretim alt ağını (10.20.1.0/28) ve vNIC1, tüketici intf-alt ağını (192.168.10.0/28) kullanır.

gcloud compute instances describe rabbit --zone=us-central1-a | grep networkIP:

gcloud compute instances describe fox --zone=us-central1-a | grep networkIP:

Örnek:

user$ gcloud compute instances describe rabbit --zone=us-central1-a | grep networkIP:

networkIP: 10.20.1.2

networkIP: 192.168.10.2

user$ gcloud compute instances describe fox --zone=us-central1-a | grep networkIP:

networkIP: 10.20.1.3

networkIP: 192.168.10.3

11. Tavşan ve tilki oluşturup yönetilmeyen bir örnek grubuna ekleyin

Aşağıdaki bölümde PSC arayüzü örneklerinden oluşan (tabbit ve fox) yönetilmeyen bir örnek grubu oluşturacaksınız.

Cloud Shell'in içinde yönetilmeyen örnek grubunu oluşturun.

gcloud compute instance-groups unmanaged create psc-interface-instances-ig --project=$projectid --zone=us-central1-a

Cloud Shell'in içinde fox ve tabbit örneklerini örnek grubuna ekleyin.

gcloud compute instance-groups unmanaged add-instances psc-interface-instances-ig --project=$projectid --zone=us-central1-a --instances=fox,rabbit

12. TCP durum denetimi, arka uç hizmetleri, iletim kuralı ve güvenlik duvarı

Cloud Shell'in içinde arka uç durum denetimini oluşturun.

gcloud compute health-checks create http hc-http-80 --port=80

Cloud Shell'in içinde arka uç hizmetini oluşturma

gcloud compute backend-services create psc-interface-backend --load-balancing-scheme=internal --protocol=tcp --region=us-central1 --health-checks=hc-http-80

gcloud compute backend-services add-backend psc-interface-backend --region=us-central1 --instance-group=psc-interface-instances-ig --instance-group-zone=us-central1-a

Cloud Shell'in içinde iletim kuralını oluşturma

gcloud compute forwarding-rules create psc-ilb --region=us-central1 --load-balancing-scheme=internal --network=producer-vpc --subnet=prod-subnet-3 --address=172.16.10.10 --ip-protocol=TCP --ports=all --backend-service=psc-interface-backend --backend-service-region=us-central1

Arka uç durum denetimlerini etkinleştirmek için Cloud Shell'den güvenlik duvarı kuralı oluşturun

gcloud compute firewall-rules create ilb-health-checks --allow tcp:80,tcp:443 --network producer-vpc --source-ranges 130.211.0.0/22,35.191.0.0/16

13. PSC arayüzleri için linux IP tabloları oluşturma - tabbit

PSC arayüzü örneğinden, tüketici alt ağlarına üretici iletişimine izin vermek için Linux IP tablolarını yapılandırın.

Private Service Connect arayüzünüzün konuk işletim sistemi adını bulma

Yönlendirmeyi yapılandırmak için Private Service Connect arayüzünüzün misafir işletim sistemi adını bilmeniz gerekir. Bu ad, Google Cloud'daki arayüzün adından farklıdır.

Cloud Shell'de IAP kullanarak psc-interface sanal makinesi olan tabbit'e giriş yapın.

gcloud compute ssh rabbit --project=$projectid --zone=us-central1-a --tunnel-through-iap

Cloud Shell'de psc-interface örneğinin IP adresini alın

ip a

Örnek:

user@rabbit:~$ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:0a:14:01:02 brd ff:ff:ff:ff:ff:ff

altname enp0s4

inet 10.20.1.2/32 brd 10.20.1.2 scope global dynamic ens4

valid_lft 59396sec preferred_lft 59396sec

inet6 fe80::4001:aff:fe14:102/64 scope link

valid_lft forever preferred_lft forever

3: ens5: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:c0:a8:0a:02 brd ff:ff:ff:ff:ff:ff

altname enp0s5

inet 192.168.10.2/32 brd 192.168.10.2 scope global dynamic ens5

valid_lft 66782sec preferred_lft 66782sec

inet6 fe80::4001:c0ff:fea8:a02/64 scope link

valid_lft forever preferred_lft forever

PSC arayüzünüzün ağ geçidi IP'sini bulma

Ağ arayüzleri listesinde Private Service Connect arayüzünüzün IP adresiyle ilişkili arayüz adını bulun ve saklayın; örneğin, ens5 (vNIC1)

Yönlendirmeyi yapılandırmak için Private Service Connect arayüzünüzün varsayılan ağ geçidinin IP adresini bilmeniz gerekir

PSC arayüzü vNIC1 ile ilişkilendirildiğinden Cloud Shell'de 1'i kullanacağız.

curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

Örnek, varsayılan gw 192.168.10.1'i üretir

user@rabbit:~$ curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

192.168.10.1

Tüketici alt ağları için rota ekleyin

Private Service Connect arayüzünüze bağlanan her tüketici alt ağı için Private Service Connect arayüzünüzün varsayılan ağ geçidine bir rota eklemeniz gerekir. Bu, Private Service Connect arayüzünden tüketici ağı çıkışlarına bağlanan trafiğin bağlı olmasını sağlar.

Rota tablosunu doğrula

Cloud Shell'de mevcut rotaları doğrulayın.

ip route show

Örnek.

user@rabbit:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

Cloud Shell'de rotayı cosmo-subnet-1'e ekleyin

sudo ip route add 192.168.20.0/28 via 192.168.10.1 dev ens5

Rota tablosunu doğrula

Eklenen rotaları Cloud Shell'de doğrulayın.

ip route show

Örnek.

user@rabbit:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

192.168.20.0/28 via 192.168.10.1 dev ens5

IP tablosu kuralları oluşturma

Cloud Shell'de geçerli IP Tablolarını doğrulayın.

sudo iptables -t nat -L -n -v

Örnek:

user@rabbit:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Cloud Shell'de IP Tablolarını güncelleme

sudo iptables -t nat -A POSTROUTING -o ens5 -j MASQUERADE

sudo sysctl net.ipv4.ip_forward=1

Cloud Shell'de, güncellenen IP Tablolarını doğrulayın.

sudo iptables -t nat -L -n -v

Örnek:

user@rabbit:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * ens5 0.0.0.0/0 0.0.0.0/0

14. PSC arayüzleri için Linux IP tabloları oluşturma - fox

PSC arayüzü örneğinden, tüketici alt ağlarına üretici iletişimine izin vermek için Linux IP tablolarını yapılandırın.

Private Service Connect arayüzünüzün konuk işletim sistemi adını bulma

Yönlendirmeyi yapılandırmak için Private Service Connect arayüzünüzün misafir işletim sistemi adını bilmeniz gerekir. Bu ad, Google Cloud'daki arayüzün adından farklıdır.

Yeni bir Cloud Shell sekmesi açın ve proje ayarlarınızı güncelleyin.

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Cloud Shell'de IAP kullanarak psc-interface sanal makinesi, fox'a giriş yapın.

gcloud compute ssh fox --project=$projectid --zone=us-central1-a --tunnel-through-iap

Cloud Shell'de psc-interface örneğinin IP adresini alın

ip a

Örnek:

user@fox:~$ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:0a:14:01:03 brd ff:ff:ff:ff:ff:ff

altname enp0s4

inet 10.20.1.3/32 brd 10.20.1.3 scope global dynamic ens4

valid_lft 65601sec preferred_lft 65601sec

inet6 fe80::4001:aff:fe14:103/64 scope link

valid_lft forever preferred_lft forever

3: ens5: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1460 qdisc pfifo_fast state UP group default qlen 1000

link/ether 42:01:c0:a8:0a:03 brd ff:ff:ff:ff:ff:ff

altname enp0s5

inet 192.168.10.3/32 brd 192.168.10.3 scope global dynamic ens5

valid_lft 63910sec preferred_lft 63910sec

inet6 fe80::4001:c0ff:fea8:a03/64 scope link

valid_lft forever preferred_lft forever

PSC arayüzünüzün ağ geçidi IP'sini bulma

Ağ arayüzleri listesinde Private Service Connect arayüzünüzün IP adresiyle ilişkili arayüz adını bulun ve saklayın; örneğin, ens5 (vNIC1)

Yönlendirmeyi yapılandırmak için Private Service Connect arayüzünüzün varsayılan ağ geçidinin IP adresini bilmeniz gerekir

PSC arayüzü vNIC1 ile ilişkilendirildiğinden Cloud Shell'de 1'i kullanacağız.

curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

Örnek, varsayılan gw 192.168.10.1'i üretir

user@fox:~$ curl http://metadata.google.internal/computeMetadata/v1/instance/network-interfaces/1/gateway -H "Metadata-Flavor: Google" && echo

192.168.10.1

Tüketici alt ağları için rota ekleyin

Private Service Connect arayüzünüze bağlanan her tüketici alt ağı için Private Service Connect arayüzünüzün varsayılan ağ geçidine bir rota eklemeniz gerekir. Bu, Private Service Connect arayüzünden tüketici ağı çıkışlarına bağlanan trafiğin bağlı olmasını sağlar.

Rota tablosunu doğrula

Cloud Shell'de mevcut rotaları doğrulayın.

ip route show

Örnek.

user@fox:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

Cloud Shell'de rotayı cosmo-subnet-1'e ekleyin

sudo ip route add 192.168.20.0/28 via 192.168.10.1 dev ens5

Rota tablosunu doğrula

Eklenen rotaları Cloud Shell'de doğrulayın.

ip route show

Örnek.

user@fox:~$ ip route show

default via 10.20.1.1 dev ens4

10.20.1.0/28 via 10.20.1.1 dev ens4

10.20.1.1 dev ens4 scope link

192.168.10.0/28 via 192.168.10.1 dev ens5

192.168.10.1 dev ens5 scope link

192.168.20.0/28 via 192.168.10.1 dev ens5

IP tablosu kuralları oluşturma

Cloud Shell'de geçerli IP Tablolarını doğrulayın.

sudo iptables -t nat -L -n -v

Örnek:

user@fox:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Cloud Shell'de IP Tablolarını güncelleyin.

sudo iptables -t nat -A POSTROUTING -o ens5 -j MASQUERADE

sudo sysctl net.ipv4.ip_forward=1

Cloud Shell'de, güncellenen IP Tablolarını doğrulayın.

sudo iptables -t nat -L -n -v

Örnek:

user@fox:~$ sudo iptables -t nat -L -n -v

Chain PREROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain INPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain OUTPUT (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

Chain POSTROUTING (policy ACCEPT 0 packets, 0 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * ens5 0.0.0.0/0 0.0.0.0/0

15. Rota tablosunu güncelle

Üretici-vpc'de tüketici alt ağına (192.168.20.0/28) giden statik bir rota, dahili yük dengeleyici olarak sonraki durak'ı oluşturun. Oluşturulduktan sonra, 192.168.20.0/28 hedefine giden tüm paketler (Üretici-vpc içinde) dahili yük dengeleyiciye yönlendirilir.

Yeni bir Cloud Shell sekmesi açın ve proje ayarlarınızı güncelleyin.

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Cloud Shell'de generative-vpc rota tablosunu statik bir rotayla güncelleyin.

gcloud beta compute routes create producer-to-cosmo-subnet-1 --project=$projectid --network=producer-vpc --priority=1000 --destination-range=192.168.20.0/28 --next-hop-ilb=psc-ilb --next-hop-ilb-region=us-central1

16. Kaplandan kozmoya başarılı bağlantı sağlandığını doğrulayın

Curl doğrulaması

Üretici sanal makine örneğinin (kaplan) bir curl işlemi gerçekleştirerek tüketici örneği olan cosmo ile iletişim kurabildiğini onaylayalım.

Yeni bir Cloud Shell sekmesi açın ve proje ayarlarınızı güncelleyin.

Cloud Shell'in içinde aşağıdaki işlemleri gerçekleştirin:

gcloud config list project

gcloud config set project [YOUR-PROJECT-NAME]

projectid=YOUR-PROJECT-NAME

echo $projectid

Cloud Shell'de IAP kullanarak tiger örneğine giriş yapın.

gcloud compute ssh tiger --project=$projectid --zone=us-central1-a --tunnel-through-iap

Eğiticide daha önce kaplan örneğinde tanımlanan cosmo IP adresine göre curl işlemini gerçekleştirin.

curl -v <cosmo's IP Address>

Örnek:

user@tiger:~$ curl -v 192.168.20.2

* Trying 192.168.20.2:80...

* Connected to 192.168.20.2 (192.168.20.2) port 80 (#0)

> GET / HTTP/1.1

> Host: 192.168.20.2

> User-Agent: curl/7.74.0

> Accept: */*

>

* Mark bundle as not supporting multiuse

< HTTP/1.1 200 OK

< Date: Fri, 09 Jun 2023 03:49:42 GMT

< Server: Apache/2.4.56 (Debian)

< Last-Modified: Fri, 09 Jun 2023 03:28:37 GMT

< ETag: "27-5fda9f6ea060e"

< Accept-Ranges: bytes

< Content-Length: 39

< Content-Type: text/html

<

Welcome to cosmo's backend server !!

Tebrikler! Bir curl komutu gerçekleştirerek generative-vpc ile arka uç-vpc arasındaki bağlantıyı başarıyla doğruladınız.

17. Temizleme

Cloud Shell'den eğitim bileşenlerini silin.

gcloud compute instances delete cosmo --zone=us-central1-a --quiet

gcloud compute instances delete rabbit --zone=us-central1-a --quiet

gcloud compute instances delete fox --zone=us-central1-a --quiet

gcloud compute instances delete tiger --zone=us-central1-a --quiet

gcloud compute network-attachments delete psc-network-attachment --region=us-central1 --quiet

gcloud compute firewall-rules delete allow-ingress-to-cosmo allow-tiger-ingress ilb-health-checks ssh-iap-consumer ssh-iap-producer --quiet

gcloud beta compute routes delete producer-to-cosmo-subnet-1 --quiet

gcloud compute forwarding-rules delete psc-ilb --region=us-central1 --quiet

gcloud compute backend-services delete psc-interface-backend --region=us-central1 --quiet

gcloud compute instance-groups unmanaged delete psc-interface-instances-ig --zone=us-central1-a --quiet

gcloud compute health-checks delete hc-http-80 --quiet

gcloud compute networks subnets delete cosmo-subnet-1 prod-subnet prod-subnet-2 prod-subnet-3 intf-subnet --region=us-central1 --quiet

gcloud compute routers delete cloud-router-for-nat --region=us-central1 --quiet

gcloud compute routers delete cloud-router-for-nat-producer --region=us-central1 --quiet

gcloud compute networks delete consumer-vpc --quiet

gcloud compute networks delete producer-vpc --quiet

gcloud compute networks delete backend-vpc --quiet

18. Tebrikler

Tebrikler, Private Service Connect Arayüzünü başarıyla yapılandırıp doğruladınız, VPC eşleme üzerinden tüketici ve üretici bağlantısını doğruladınız.

Tüketici altyapısını oluşturdunuz ve üreticinin tüketici ile üretici iletişimi arasında köprü kurmak için çoklu nic sanal makinesi oluşturmasına olanak tanıyan bir ağ eki eklediniz. PSC arayüzünün, üreticinin VPC'sinde dahili bir yük dengeleyici ve statik bir rota kullanarak birinci taraf ve üçüncü taraf hizmetleriyle iletişim kurmak için VPC eşleme üzerinden nasıl kullanılabileceğini öğrendiniz.

Cosmopup, eğitici videoların çok iyi olduğunu düşünüyor.

Sırada ne var?

Bu eğitimlerden bazılarına göz atın...

- GKE ile hizmetleri yayınlamak ve kullanmak için Private Service Connect'i kullanma

- Hizmetleri yayınlamak ve kullanmak için Private Service Connect'i kullanma

- Private Service Connect ve dahili TCP Proxy yük dengeleyici kullanarak Karma Ağ İletişimi üzerinden şirket içi hizmetlere bağlanma

Daha fazla bilgi ve Videolar

- Private Service Connect'e genel bakış

- Private Service Connect nedir?

- Desteklenen Yük Dengeleyici Türleri