1. نظرة عامة

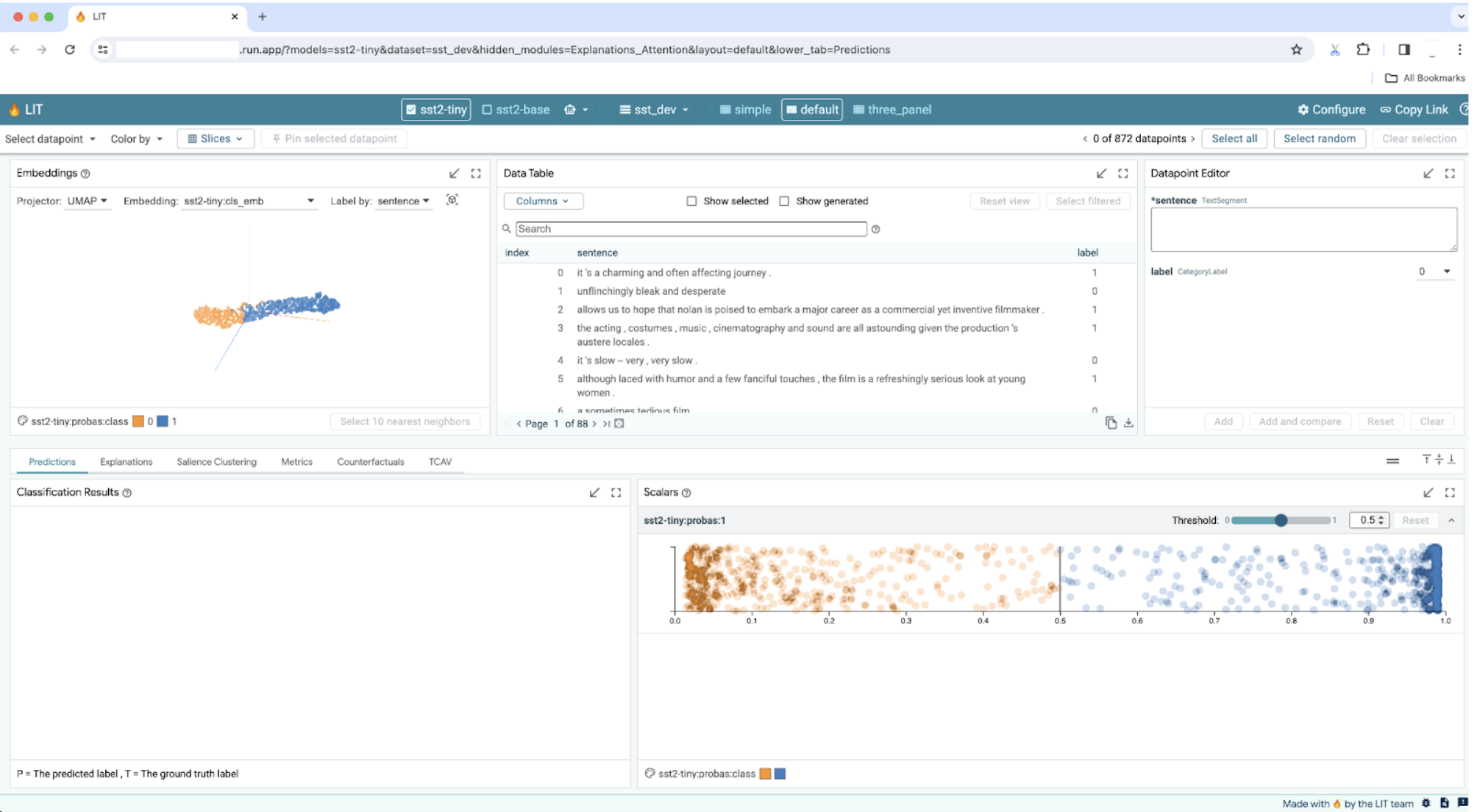

يوفّر هذا المختبر شرحًا مفصّلاً حول نشر خادم تطبيقات LIT على Google Cloud Platform (GCP) للتفاعل مع نماذج Vertex AI Gemini الأساسية والنماذج اللغوية الكبيرة (LLM) المستضافة ذاتيًا التابعة لجهات خارجية. كما تتضمّن إرشادات حول كيفية استخدام واجهة مستخدم LIT لتصحيح الأخطاء بسرعة وتفسير النموذج.

من خلال اتباع هذا التمرين، سيتعلم المستخدمون كيفية:

- اضبط خادم LIT على GCP.

- ربط خادم LIT بنماذج Vertex AI Gemini أو نماذج أخرى من النماذج اللغوية الكبيرة المستضافة ذاتيًا

- استخدِم واجهة مستخدم LIT لتحليل الطلبات وتصحيح الأخطاء وتفسيرها من أجل تحسين أداء النماذج والإحصاءات.

ما هو LIT؟

LIT هي أداة مرئية تفاعلية لفهم النماذج تتيح استخدام البيانات النصية والصور والجداول. ويمكن تشغيله كخادم مستقل أو داخل بيئات تطبيقات "دفتر ملاحظات"، مثل Google Colab وJupyter وGoogle Cloud Vertex AI. يتوفّر LIT من خلال PyPI وGitHub.

تم إنشاء هذه الميزة في الأصل لفهم نماذج التصنيف والانحدار، وقد أضافت التحديثات الأخيرة أدوات لتصحيح أخطاء طلبات النماذج اللغوية الكبيرة، ما يتيح لك استكشاف كيفية تأثير محتوى المستخدم والنموذج والنظام في سلوك الإنشاء.

ما هو Vertex AI وModel Garden؟

Vertex AI هي منصّة تعلُّم آلة تتيح لك تدريب نماذج تعلُّم الآلة وتطبيقات الذكاء الاصطناعي ونشرها، وتخصيص النماذج اللغوية الكبيرة لاستخدامها في تطبيقاتك المستندة إلى الذكاء الاصطناعي. تجمع Vertex AI بين سير عمل هندسة البيانات وعلم البيانات وهندسة تعلُّم الآلة، ما يتيح لفِرقك التعاون باستخدام مجموعة أدوات مشتركة وتوسيع نطاق تطبيقاتك باستخدام مزايا Google Cloud.

Vertex Model Garden هي مكتبة لنماذج تعلُّم الآلة تساعدك في اكتشاف نماذج ومواد عرض تابعة لجهات خارجية واختبارها وتخصيصها ونشرها.

الإجراءات التي ستنفّذها

ستستخدم Cloud Shell وCloud Run من Google لنشر حاوية Docker من صورة LIT المُنشأة مسبقًا.

Cloud Run هو نظام أساسي مُدار للحوسبة يتيح لك تشغيل الحاويات مباشرةً فوق بنية Google الأساسية القابلة للتطور، بما في ذلك وحدات معالجة الرسومات.

مجموعة البيانات

يستخدم الإصدار التجريبي نموذج مجموعة البيانات لتحديد أخطاء طلبات LIT وتصحيحها تلقائيًا، أو يمكنك تحميل مجموعة البيانات الخاصة بك من خلال واجهة المستخدم.

قبل البدء

لاستخدام هذا الدليل المرجعي، تحتاج إلى مشروع على Google Cloud. يمكنك إنشاء مشروع جديد أو اختيار مشروع سبق أن أنشأته.

2. افتح Google Cloud Console وCloud Shell.

ستطلق Google Cloud Console وستستخدم Google Cloud Shell في هذه الخطوة.

2(أ): تشغيل Google Cloud Console

افتح متصفّحًا وانتقِل إلى Google Cloud Console.

Google Cloud Console هي واجهة مشرف ويب فعّالة وآمنة تتيح لك إدارة موارد Google Cloud بسرعة. وهي أداة DevOps أثناء التنقل.

2-ب: تشغيل Google Cloud Shell

Cloud Shell هي بيئة تطوير وعمليات على الإنترنت يمكن الوصول إليها من أي مكان باستخدام المتصفّح. يمكنك إدارة مواردك باستخدام الوحدة الطرفية الخاصة بها على الإنترنت والتي تم تحميلها مسبقًا بأدوات مساعدة، مثل أداة سطر الأوامر gcloud وkubectl وغير ذلك. يمكنك أيضًا تطوير تطبيقات مستندة إلى السحابة الإلكترونية وإنشائها وتصحيح أخطائها ونشرها باستخدام "محرِّر Cloud Shell" على الإنترنت. توفّر Cloud Shell بيئة إلكترونية جاهزة للمطوّرين مع مجموعة من الأدوات المفضَّلة المثبَّتة مسبقًا ومساحة التخزين الدائمة التي تبلغ 5 غيغابايت. ستستخدم موجّه الأوامر في الخطوات التالية.

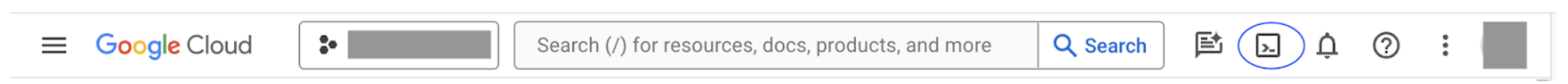

افتح Google Cloud Shell باستخدام الرمز في أعلى يسار شريط القوائم، والذي تم وضع دائرة حوله باللون الأزرق في لقطة الشاشة التالية.

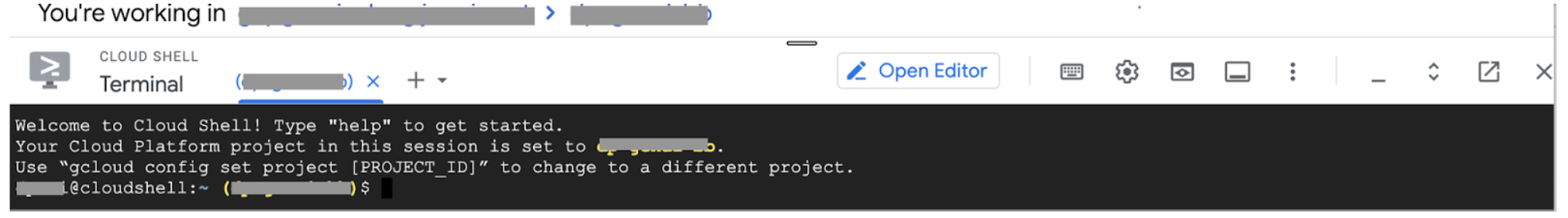

من المفترض أن تظهر لك نافذة طرفية بهيكل باش في أسفل الصفحة.

2-ج: ضبط مشروع Google Cloud

يجب ضبط معرّف المشروع ومنطقة المشروع باستخدام الأمر gcloud.

# Set your GCP Project ID.

gcloud config set project your-project-id

# Set your GCP Project Region.

gcloud config set run/region your-project-region

3- نشر صورة Docker الخاصة بخادم تطبيق LIT باستخدام Cloud Run

3-أ: نشر تطبيق LIT على التشغيل في السحابة الإلكترونية

عليك أولاً ضبط أحدث إصدار من LIT-App على أنّه الإصدار المطلوب نشره.

# Set latest version as your LIT_SERVICE_TAG.

export LIT_SERVICE_TAG=latest

# List all the public LIT GCP App server docker images.

gcloud container images list-tags us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-lit-app

بعد إعداد علامة الإصدار، عليك تسمية الخدمة.

# Set your lit service name. While 'lit-app-service' is provided as a placeholder, you can customize the service name based on your preferences.

export LIT_SERVICE_NAME=lit-app-service

بعد ذلك، يمكنك تنفيذ الأمر التالي لنشر الحاوية على Cloud Run.

# Use below cmd to deploy the LIT App to Cloud Run.

gcloud run deploy $LIT_SERVICE_NAME \

--image us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-lit-app:$LIT_SERVICE_TAG \

--port 5432 \

--cpu 8 \

--memory 32Gi \

--no-cpu-throttling \

--no-allow-unauthenticated

تتيح لك أداة LIT أيضًا إضافة مجموعة البيانات عند بدء تشغيل الخادم. لإجراء ذلك، اضبط المتغيّر DATASETS لتضمين البيانات التي تريد تحميلها، باستخدام التنسيق name:path، على سبيل المثال، data_foo:/bar/data_2024.jsonl. يجب أن يكون تنسيق مجموعة البيانات .jsonl، حيث يحتوي كل سجلّ على حقل prompt وحقول target وsource اختيارية. لتحميل مجموعات بيانات متعددة، افصل بينها باستخدام فاصلة. في حال عدم ضبط القيمة، سيتم تحميل مجموعة بيانات نموذجية لتصحيح أخطاء طلبات LIT.

# Set the dataset.

export DATASETS=[DATASETS]

بتعيين MAX_EXAMPLES، يمكنك تعيين أقصى عدد من الأمثلة لتحميلها من كل مجموعة تقييم.

# Set the max examples.

export MAX_EXAMPLES=[MAX_EXAMPLES]

بعد ذلك، يمكنك إضافة

--set-env-vars "DATASETS=$DATASETS" \

--set-env-vars "MAX_EXAMPLES=$MAX_EXAMPLES" \

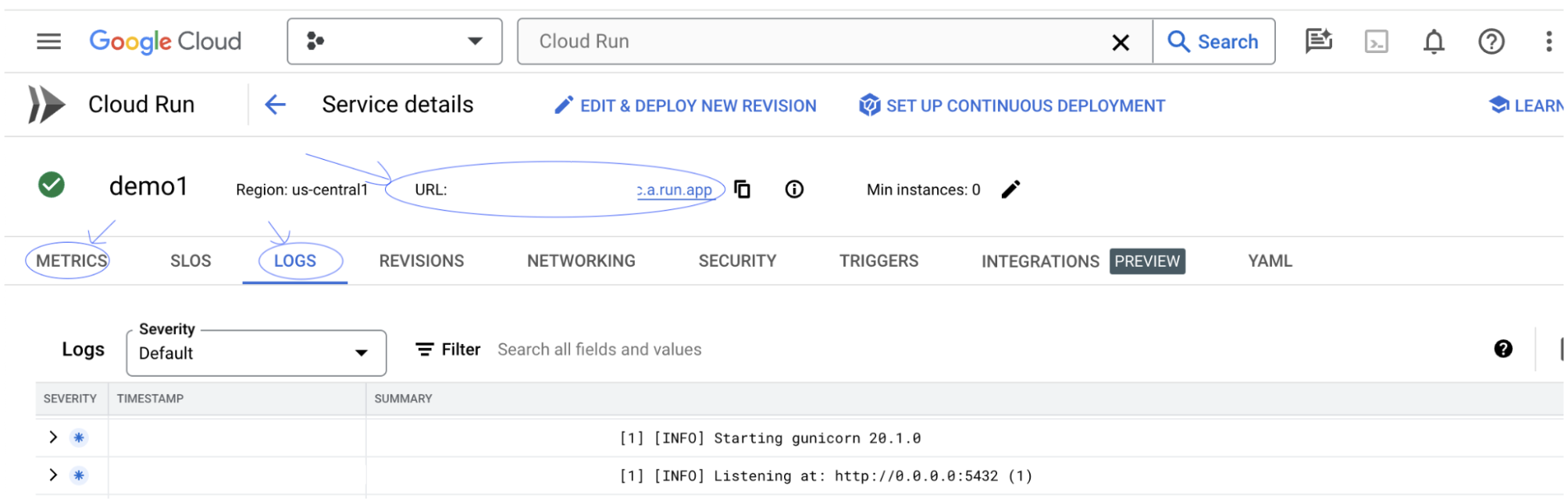

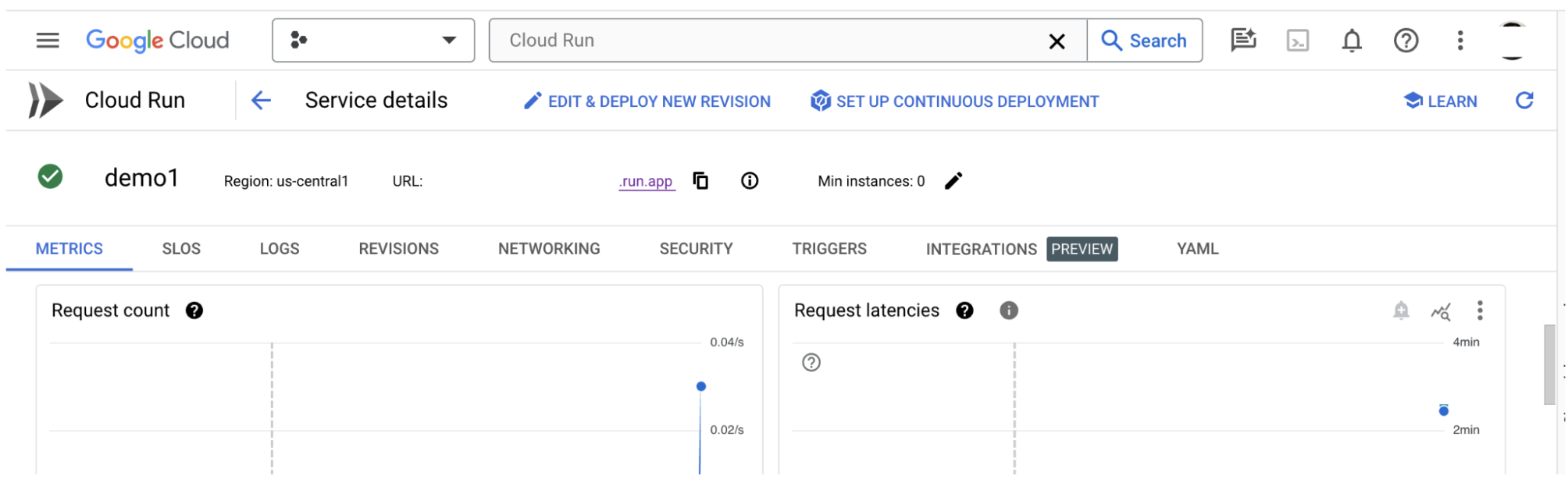

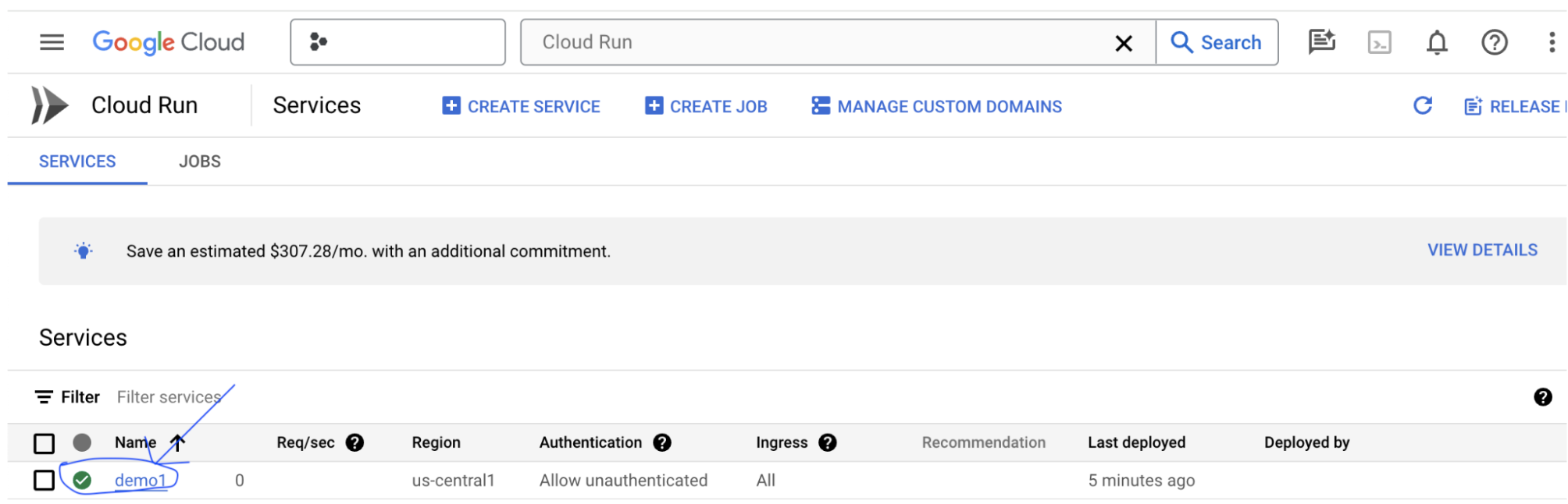

3-ب: عرض خدمة LIT App Service

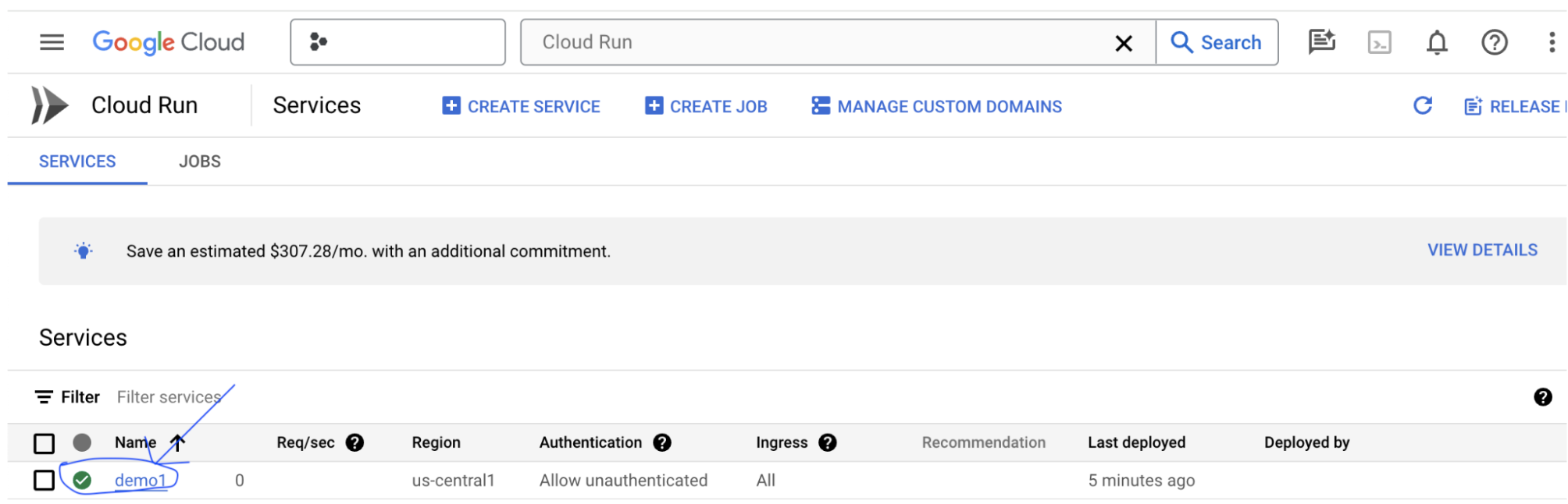

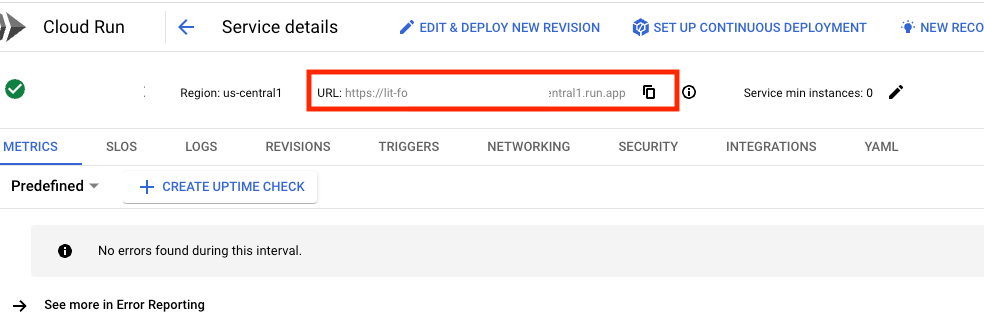

بعد إنشاء خادم تطبيق LIT، يمكنك العثور على الخدمة في قسم Cloud Run في Cloud Console.

اختَر خدمة LIT App التي أنشأتها للتو. تأكَّد من أنّ اسم الخدمة هو نفسه LIT_SERVICE_NAME.

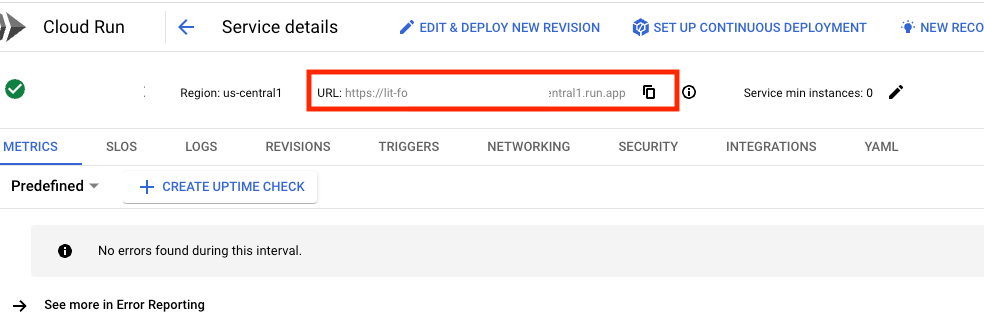

يمكنك العثور على عنوان URL للخدمة بالنقر على الخدمة التي نشرتها للتو.

بعد ذلك، يُفترض أن تتمكن من عرض واجهة مستخدم LIT. إذا ظهرت لك رسالة خطأ، يُرجى الاطّلاع على قسم "تحديد المشاكل وحلّها".

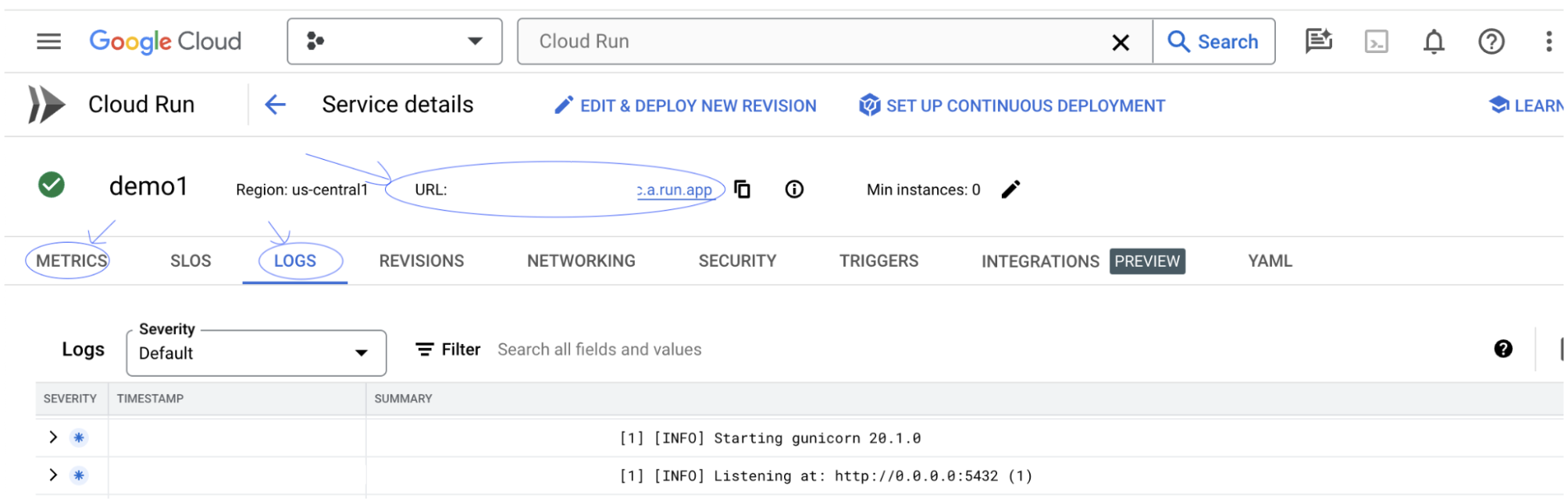

يمكنك الاطّلاع على قسم "السجلّات" لمراقبة النشاط وعرض رسائل الخطأ وتتبُّع مستوى تقدّم عملية النشر.

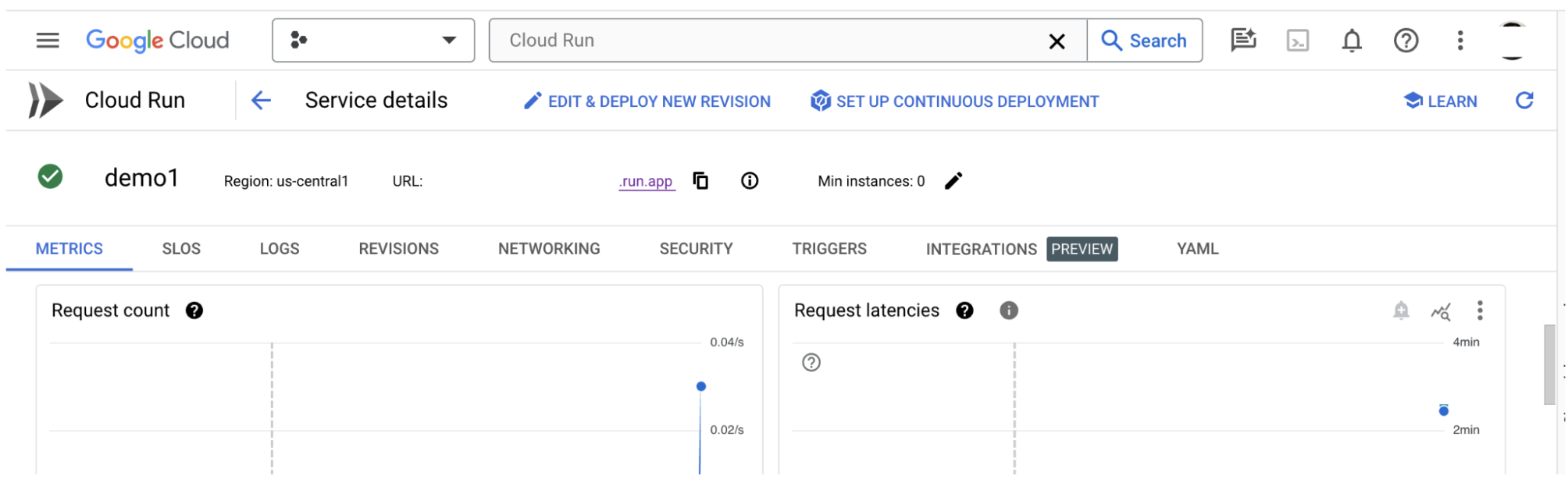

يمكنك الانتقال إلى قسم "المقاييس" للاطّلاع على مقاييس الخدمة.

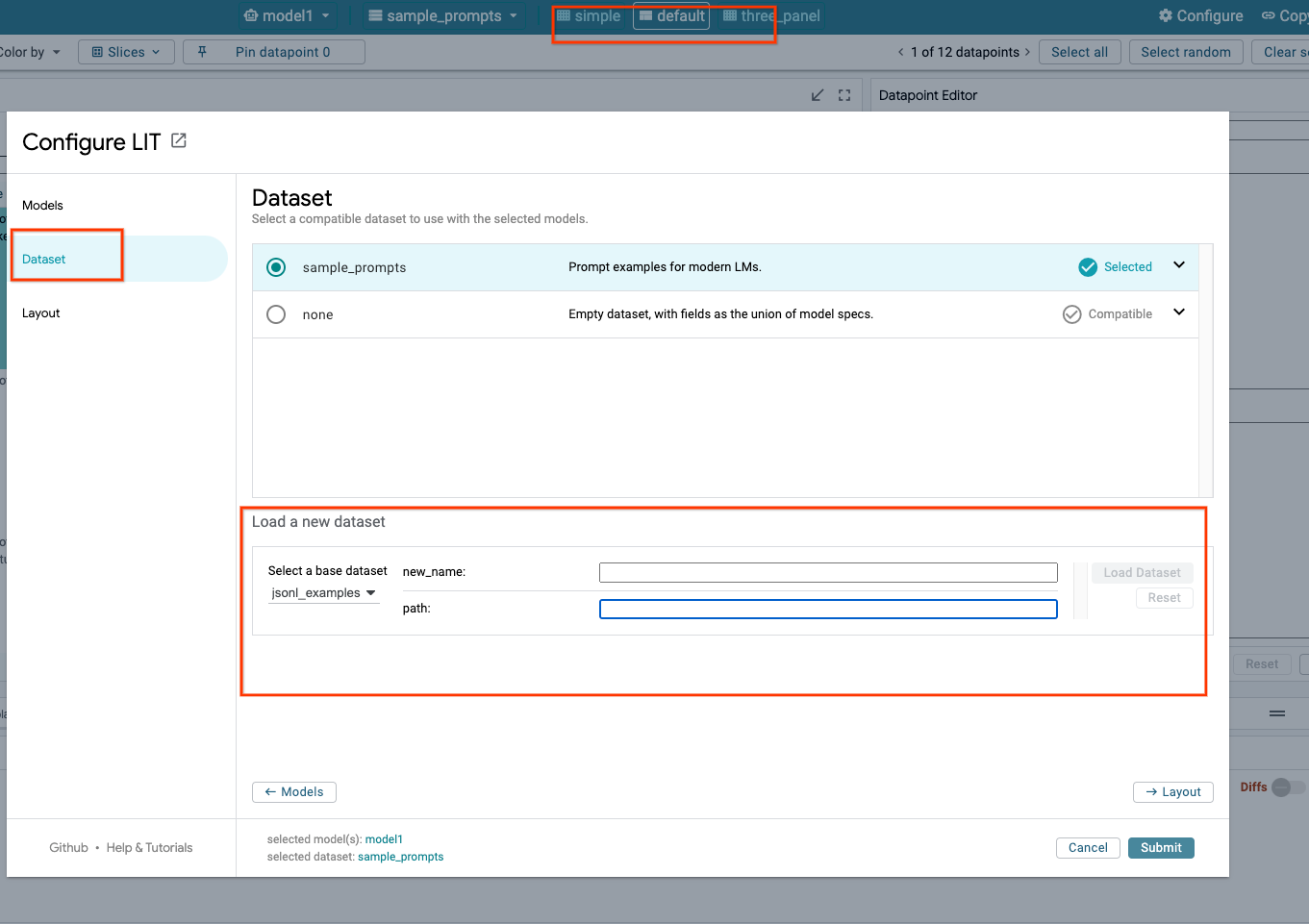

3-ج: تحميل مجموعات البيانات

انقر على الخيار Configure في واجهة مستخدم LIT، ثم انقر على Dataset. حمِّل مجموعة البيانات من خلال تحديد اسم وتقديم عنوان URL الخاص بها. يجب أن يكون تنسيق مجموعة البيانات .jsonl، حيث يحتوي كل سجلّ على حقل prompt وحقول target وsource اختيارية.

4. إعداد نماذج Gemini في Model Garden في Vertex AI

تتوفّر نماذج Gemini الأساسية من Google من خلال واجهة برمجة التطبيقات Vertex AI API. توفّر LIT حزمة VertexAIModelGarden لتغليف النماذج لاستخدام هذه النماذج في عملية الإنشاء. ما عليك سوى تحديد الإصدار المطلوب (مثلاً، "gemini-1.5-pro-001") من خلال مَعلمة اسم النموذج. ومن المزايا الرئيسية لاستخدام هذه النماذج أنّها لا تتطلّب أي جهد إضافي للنشر. يمكنك الوصول فورًا إلى نماذج مثل Gemini 1.0 Pro وGemini 1.5 Pro على Google Cloud Platform، ما يغنيك عن اتّباع خطوات ضبط إضافية.

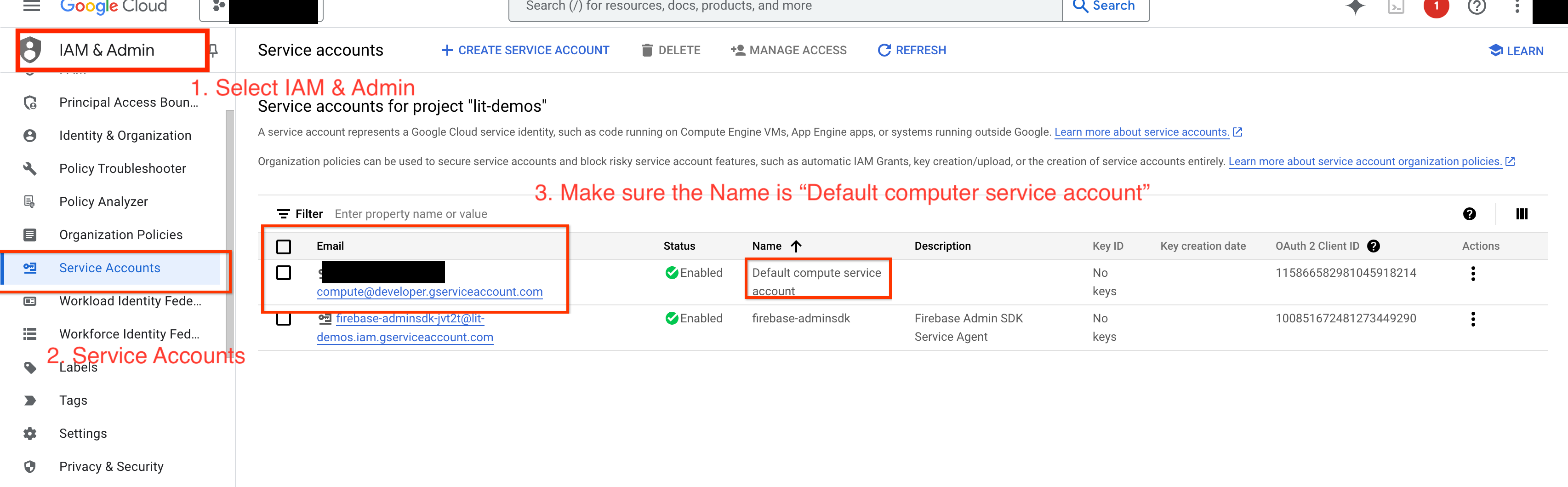

4(أ): منح أذونات Vertex AI

لطلب بحث Gemini في Google Cloud Platform، يجب منح Vertex AI أذونات الوصول إلى حساب الخدمة. تأكَّد من أنّ اسم حساب الخدمة هو Default compute service account. انسخ عنوان البريد الإلكتروني لحساب الخدمة.

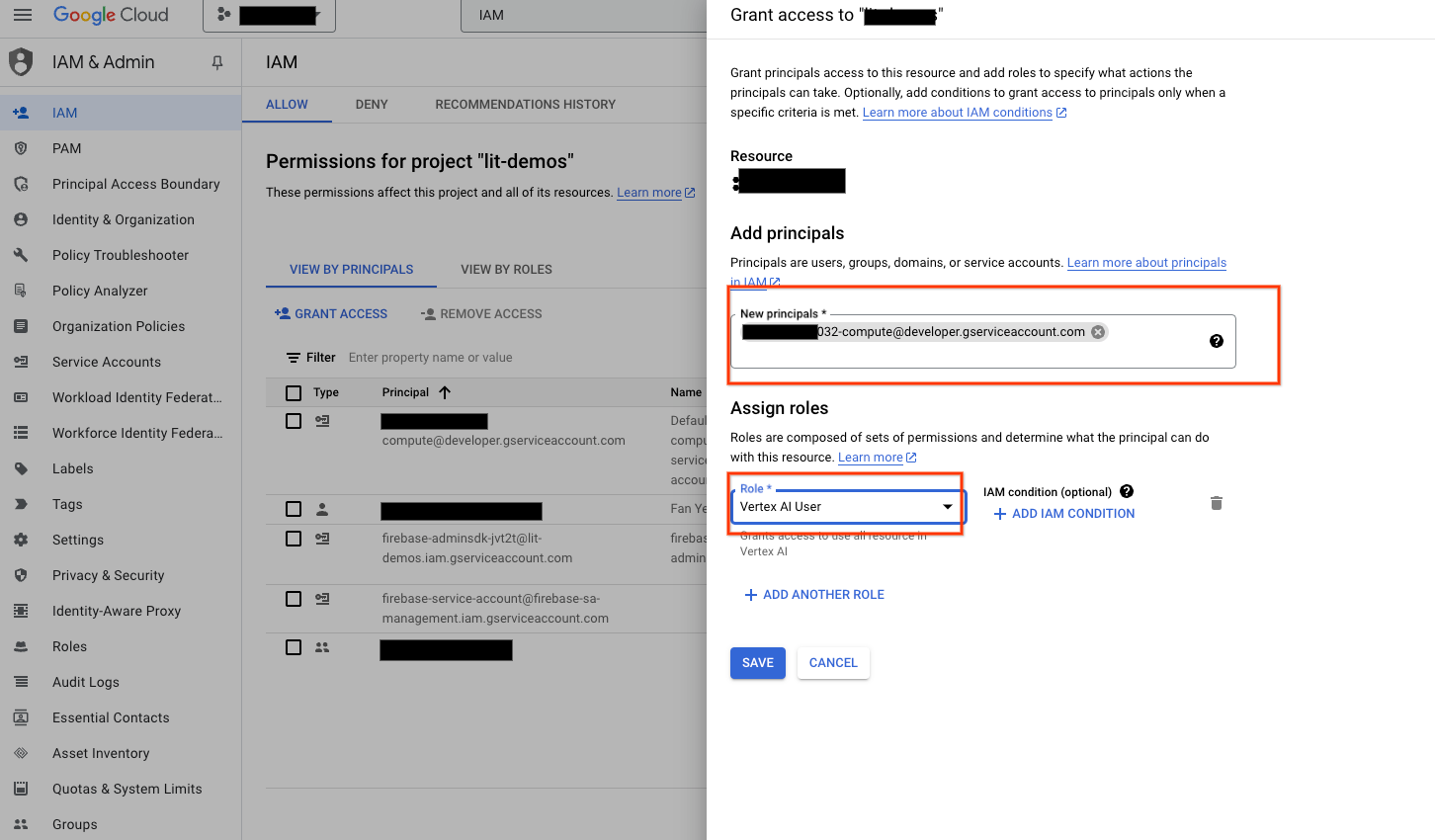

أضِف عنوان البريد الإلكتروني لحساب الخدمة كمستخدم أساسي لديه الدور Vertex AI User في قائمة السماح في إدارة الهوية وإمكانية الوصول.

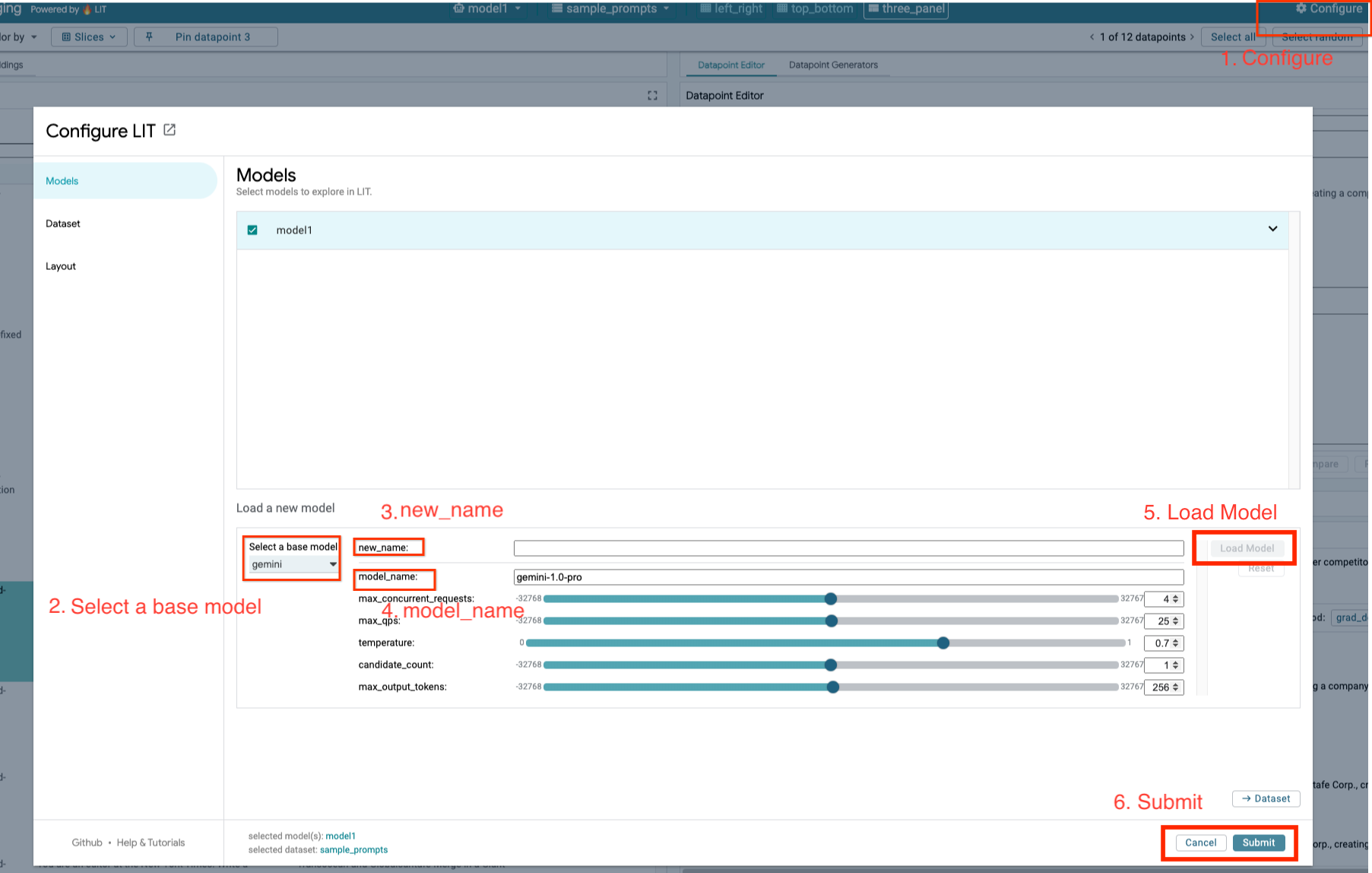

4-ب: تحميل نماذج Gemini

ستحمّل نماذج Gemini وتُعدّل مَعلماتها باتّباع الخطوات أدناه.

- انقر على الخيار

Configureفي واجهة مستخدم LIT.

- انقر على الخيار

- حدِّد الخيار

geminiضمن الخيارSelect a base model.

- حدِّد الخيار

- عليك تسمية النموذج في

new_name.

- عليك تسمية النموذج في

- أدخِل نماذج Gemini التي اخترتها على أنّها

model_name.

- أدخِل نماذج Gemini التي اخترتها على أنّها

- انقر على

Load Model.

- انقر على

- انقر على

Submit.

- انقر على

5- نشر خادم نماذج LLMs المستضافة ذاتيًا على Google Cloud Platform

يتيح لك استضافة النماذج اللغوية الكبيرة ذاتيًا باستخدام صورة Docker لخادم النماذج في LIT استخدام وظائف تمييز المحتوى وتحليله إلى وحدات في LIT للحصول على إحصاءات أكثر تفصيلاً حول سلوك النموذج. تعمل صورة خادم النماذج مع نماذج KerasNLP أو Hugging Face Transformers، بما في ذلك الأوزان المقدَّمة من المكتبة والذاتية الاستضافة، مثل Google Cloud Storage.

5-أ: ضبط النماذج

تحمِّل كل حاوية نموذجًا واحدًا يتم ضبطه باستخدام متغيّرات البيئة.

يجب تحديد نماذج لتحميلها عن طريق تعيين MODEL_CONFIG. يجب أن يكون التنسيق name:path، على سبيل المثال model_foo:model_foo_path. يمكن أن يكون المسار عنوان URL أو مسار ملف محلي أو اسم إعداد مُسبَق لإطار عمل التعلّم العميق الذي تم ضبطه (اطّلِع على الجدول التالي لمعرفة المزيد). تم اختبار هذا الخادم باستخدام Gemma وGPT2 وLlama وMistral على جميع قيم DL_FRAMEWORK المتوافقة. ومن المفترض أن تعمل نماذج أخرى، ولكن قد تكون هناك حاجة إلى إجراء تعديلات.

# Set models you want to load. While 'gemma2b is given as a placeholder, you can load your preferred model by following the instructions above.

export MODEL_CONFIG=gemma2b:gemma_2b_en

بالإضافة إلى ذلك، يسمح خادم نموذج LIT بضبط متغيّرات البيئة المختلفة باستخدام الأمر أدناه. يُرجى الاطّلاع على الجدول للحصول على التفاصيل. يُرجى العلم أنّه يجب ضبط كل متغيّر على حدة.

# Customize the variable value as needed.

export [VARIABLE]=[VALUE]

متغير | القيم | الوصف |

DL_FRAMEWORK |

| مكتبة وضع النماذج المستخدَمة لتحميل أوزان النماذج على وقت التشغيل المحدّد الإعداد التلقائي هو |

DL_RUNTIME |

| إطار عمل الخلفية للتعرّف العميق الذي يعمل عليه النموذج ستستخدم جميع النماذج التي يحمّلها هذا الخادم الخلفية نفسها، وستؤدي عدم التوافق إلى حدوث أخطاء. الإعداد التلقائي هو |

الدقة |

| دقة النقطة العائمة لنماذج النصوص اللغوية الكبيرة وتكون القيمة التلقائية هي |

BATCH_SIZE | الأعداد الصحيحة الموجبة | عدد الأمثلة المطلوب معالجتها لكل دفعة الإعداد التلقائي هو |

SEQUENCE_LENGTH | الأعداد الصحيحة الموجبة | الحد الأقصى لطول التسلسل في طلب الإدخال بالإضافة إلى النص الذي تم إنشاؤه وتكون القيمة التلقائية هي |

5-ب: نشر "خادم النماذج" على Cloud Run

عليك أولاً ضبط أحدث إصدار من Model Server على أنّه الإصدار المطلوب نشره.

# Set latest as MODEL_VERSION_TAG.

export MODEL_VERSION_TAG=latest

# List all the public LIT GCP model server docker images.

gcloud container images list-tags us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-model-server

بعد ضبط علامة الإصدار، عليك تسمية خادم النماذج.

# Set your Service name.

export MODEL_SERVICE_NAME='gemma2b-model-server'

بعد ذلك، يمكنك تنفيذ الأمر التالي لنشر الحاوية على Cloud Run. في حال عدم ضبط متغيّرات البيئة، سيتم تطبيق القيم التلقائية. ننصح باستخدام وحدة معالجة الرسومات لأنّ معظم النماذج اللغوية الكبيرة تتطلب موارد حوسبة باهظة الثمن. إذا كنت تفضّل التشغيل على وحدة المعالجة المركزية فقط (وهو ما يعمل بشكل جيد مع النماذج الصغيرة مثل GPT2)، يمكنك إزالة الوسيطات ذات الصلة --gpu 1 --gpu-type nvidia-l4 --max-instances 7.

# Deploy the model service container.

gcloud beta run deploy $MODEL_SERVICE_NAME \

--image us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-model-server:$MODEL_VERSION_TAG \

--port 5432 \

--cpu 8 \

--memory 32Gi \

--no-cpu-throttling \

--gpu 1 \

--gpu-type nvidia-l4 \

--max-instances 7 \

--set-env-vars "MODEL_CONFIG=$MODEL_CONFIG" \

--no-allow-unauthenticated

بالإضافة إلى ذلك، يمكنك تخصيص متغيرات البيئة عن طريق إضافة الأوامر التالية. لا تُدرِج سوى متغيّرات البيئة الضرورية لاحتياجاتك المحدّدة.

--set-env-vars "DL_FRAMEWORK=$DL_FRAMEWORK" \

--set-env-vars "DL_RUNTIME=$DL_RUNTIME" \

--set-env-vars "PRECISION=$PRECISION" \

--set-env-vars "BATCH_SIZE=$BATCH_SIZE" \

--set-env-vars "SEQUENCE_LENGTH=$SEQUENCE_LENGTH" \

قد تكون متغيّرات البيئة الإضافية ضرورية للوصول إلى نماذج معيّنة. اطّلِع على التعليمات من Kaggle Hub (المستخدَمة لنماذج KerasNLP) وHugging Face Hub حسب الاقتضاء.

5-ج: الوصول إلى خادم النماذج

بعد إنشاء خادم النماذج، يمكن العثور على الخدمة التي تم تشغيلها في قسم Cloud Run ضمن مشروعك على Google Cloud Platform.

اختَر خادم النماذج الذي أنشأته للتو. تأكَّد من أنّ اسم الخدمة هو نفسه MODEL_SERVICE_NAME.

يمكنك العثور على عنوان URL للخدمة بالنقر على نموذج الخدمة الذي نشرته للتو.

يمكنك الاطّلاع على قسم "السجلّات" لمراقبة النشاط وعرض رسائل الخطأ وتتبُّع مستوى تقدّم عملية النشر.

يمكنك الانتقال إلى قسم "المقاييس" للاطّلاع على مقاييس الخدمة.

5-د: تحميل النماذج المستضافة ذاتيًا

إذا كنت تستخدم خادم LIT كوكيل في الخطوة 3 (راجِع قسم تحديد المشاكل وحلّها)، عليك الحصول على رمز تعريف Google Cloud Platform من خلال تنفيذ الأمر التالي.

# Find your GCP identity token.

gcloud auth print-identity-token

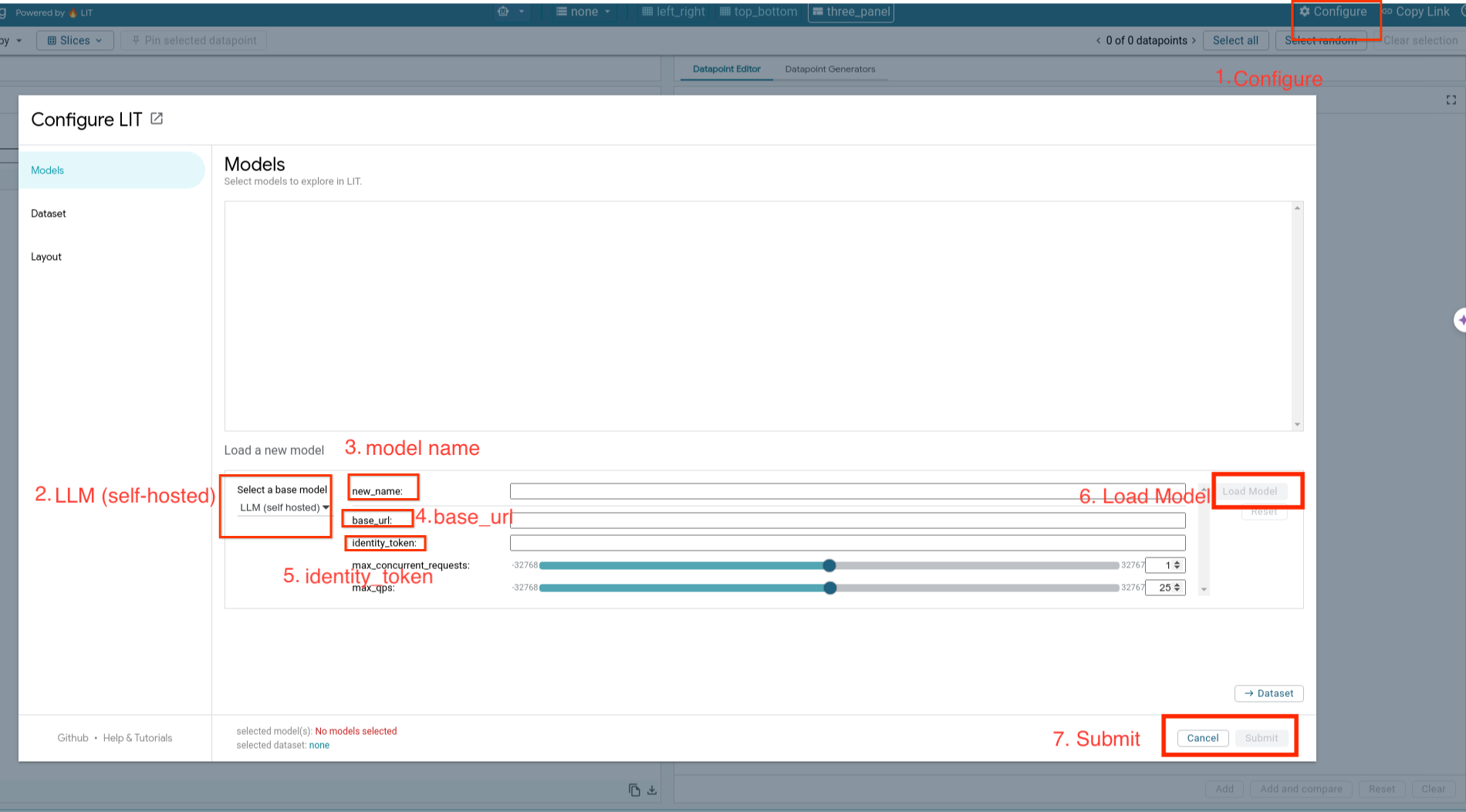

سيتم تحميل نماذج مستضافة ذاتيًا وتعديل مَعلماتها باتّباع الخطوات أدناه.

- انقر على الخيار

Configureفي واجهة مستخدم LIT. - حدِّد الخيار

LLM (self hosted)ضمن الخيارSelect a base model. - عليك تسمية النموذج في

new_name. - أدخِل عنوان URL لخادم النماذج على أنّه

base_url. - أدخِل الرمز المميّز للهوية الذي تم الحصول عليه في

identity_tokenإذا كنت تستخدم خادمًا وكيلاً لتطبيق LIT (راجِع الخطوة 3 والخطوة 7). وبخلاف ذلك، اترك هذا الحقل فارغًا. - انقر على

Load Model. - انقر على

Submit.

6- التفاعل مع LIT على Google Cloud Platform

يوفّر LIT مجموعة غنية من الميزات لمساعدتك في تصحيح أخطاء سلوكيات النماذج وفهمها. يمكنك إجراء عملية بسيطة مثل طلب المعلومات من النموذج، وذلك من خلال كتابة نص في مربّع والاطّلاع على توقّعات النموذج، أو فحص النماذج بالتفصيل باستخدام مجموعة ميزات LIT القوية، بما في ذلك:

6-أ: طلب بيانات النموذج من خلال واجهة برمجة التطبيقات LIT

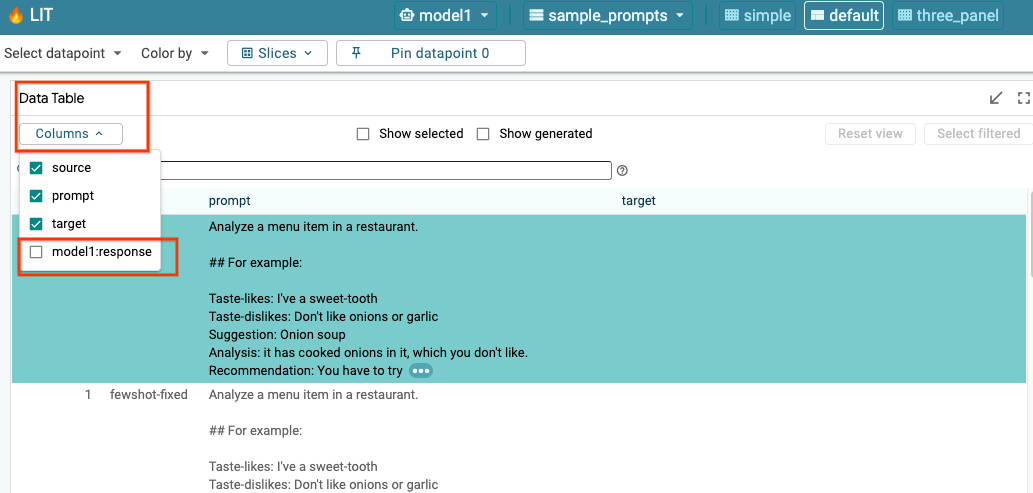

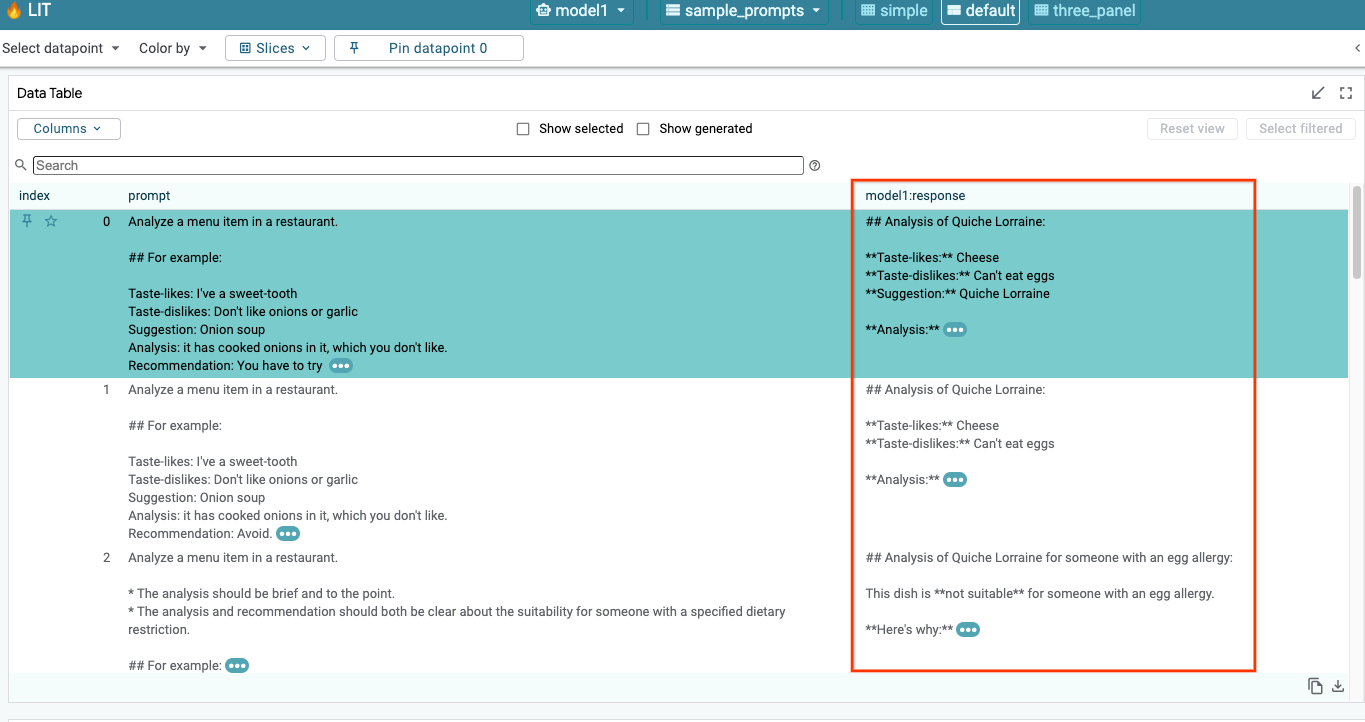

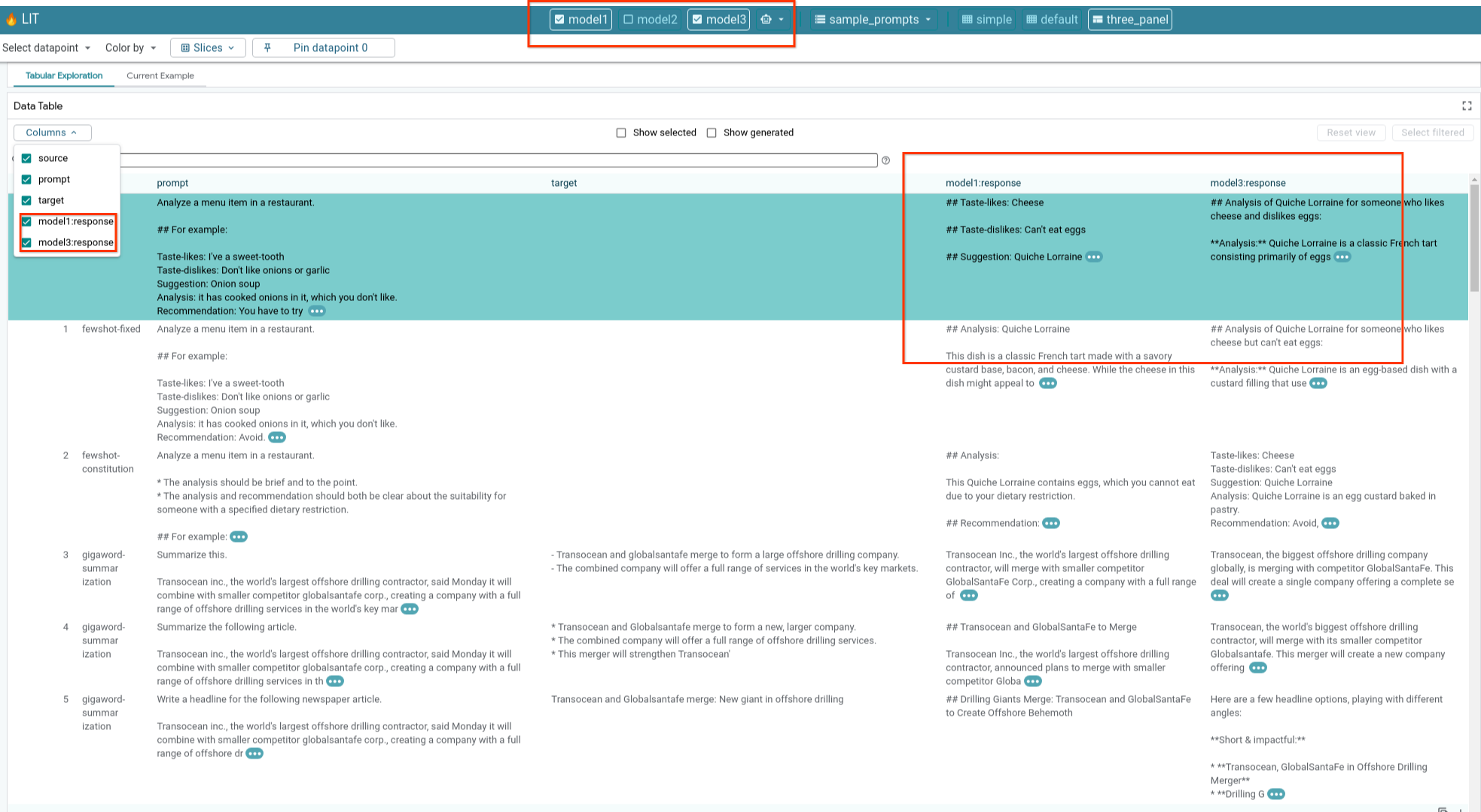

تستعلم LIT تلقائيًا من مجموعة البيانات بعد تحميل النموذج ومجموعة البيانات. يمكنك الاطّلاع على ردّ كل نموذج من خلال اختيار الردّ في الأعمدة.

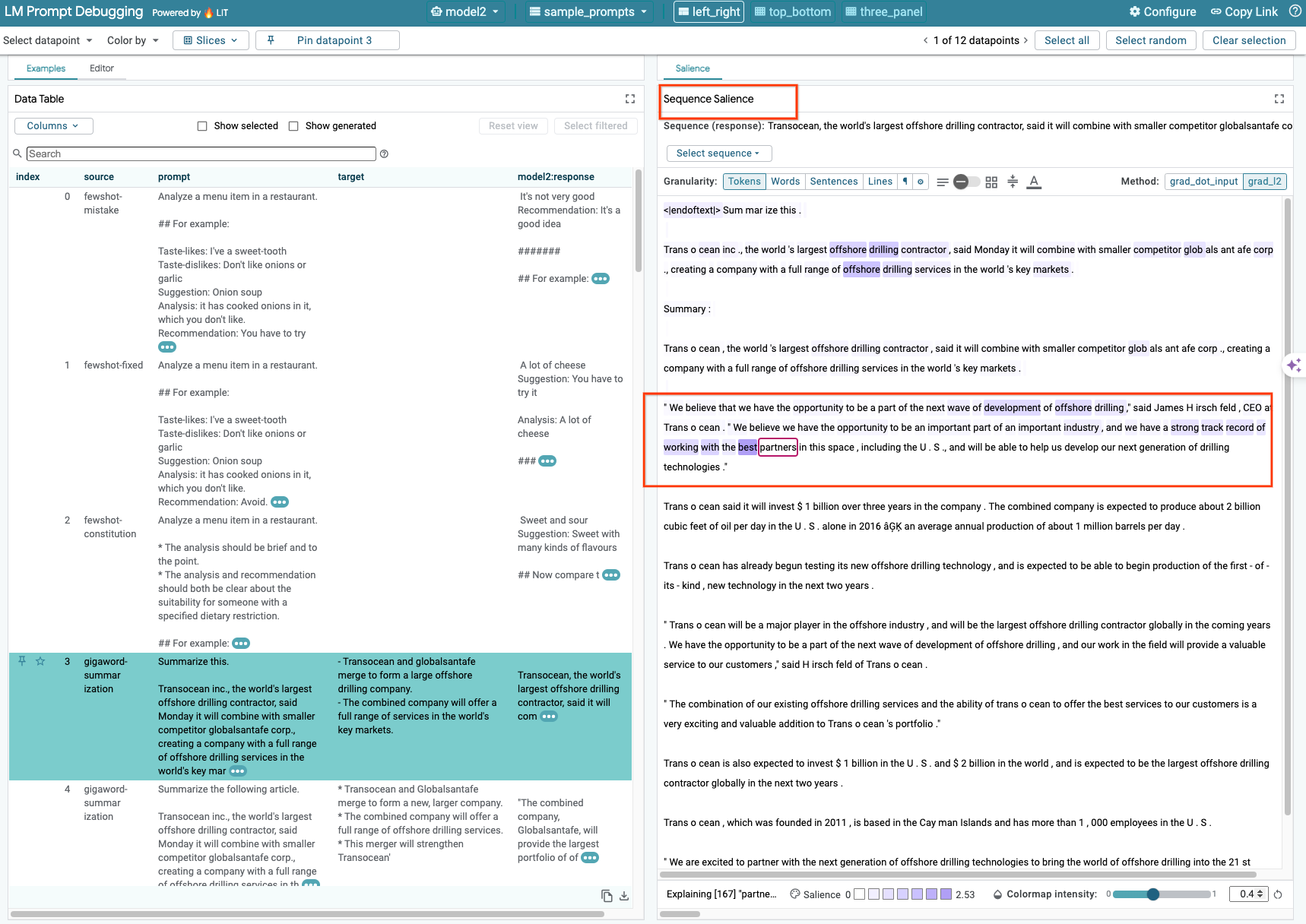

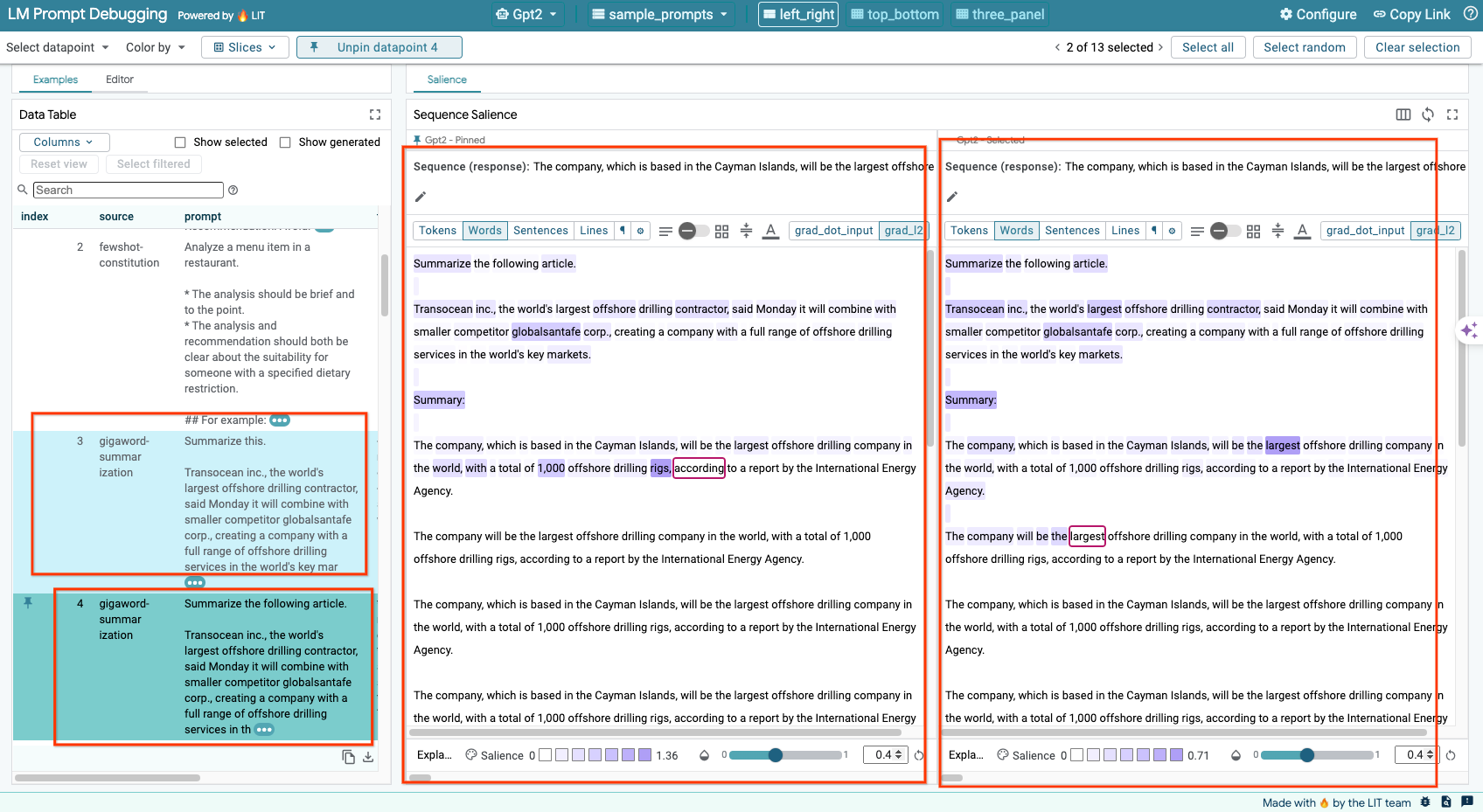

6-ب: استخدام أسلوب "تمييز التسلسل"

لا تتيح تقنية "تمييز التسلسل" في LIT حاليًا استخدام النماذج المستضافة ذاتيًا إلا.

"تمييز التسلسل" هي أداة مرئية تساعد في تصحيح أخطاء طلبات الذكاء الاصطناعي اللغوي الكبير (LLM) من خلال إبراز الأجزاء الأكثر أهمية من الطلب للحصول على نتيجة معيّنة. لمزيد من المعلومات عن ميزة "تمييز التسلسل"، يمكنك الاطّلاع على الدليل التعليمي الكامل لمعرفة المزيد عن كيفية استخدام هذه الميزة.

للوصول إلى نتائج العناصر البارزة، انقر على أي إدخال أو إخراج في الطلب أو الاستجابة، وسيتم عرض نتائج العناصر البارزة.

6-c: طلب تعديل Manullay والهدف

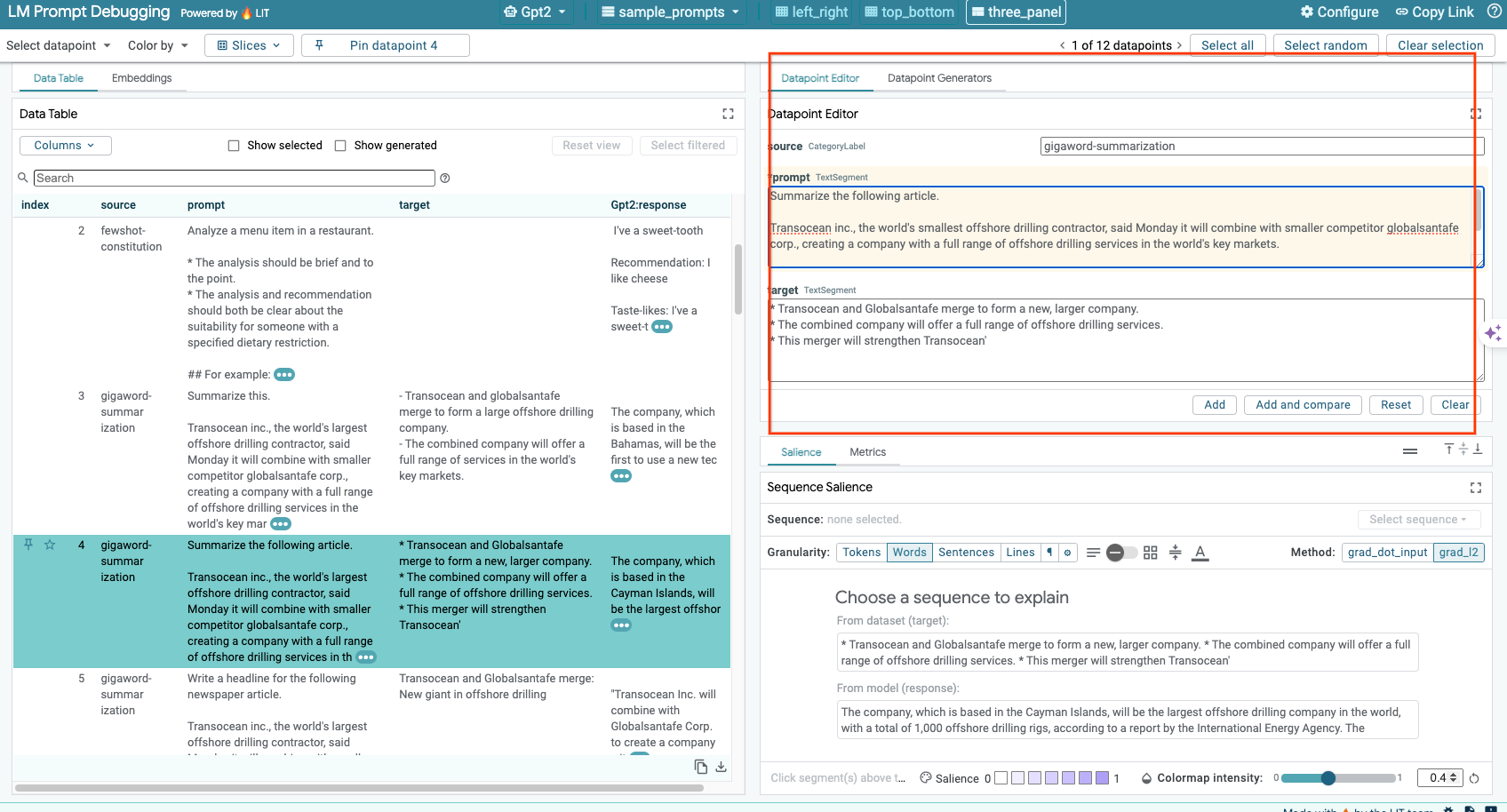

تتيح لك LIT تعديل أي prompt وtarget يدويًا لنقطة البيانات الحالية. عند النقر على Add، ستتم إضافة الإدخال الجديد إلى مجموعة البيانات.

6-د: مقارنة الطلبَين جنبًا إلى جنب

يتيح لك LIT مقارنة الطلب جنبًا إلى جنب مع الأمثلة الأصلية المعدَّلة. يمكنك تعديل مثال يدويًا وعرض نتيجة التوقّع وتحليل "مدى بروز التسلسل" لكل من الإصدار الأصلي والإصدار المعدَّل في الوقت نفسه. يمكنك تعديل الطلب لكل نقطة بيانات، وستنشئ LIT الرد المقابل عن طريق الاستعلام عن النموذج.

6-هـ: مقارنة نماذج متعددة جنبًا إلى جنب

تتيح لك أداة LIT مقارنة النماذج جنبًا إلى جنب استنادًا إلى أمثلة فردية لإنشاء النصوص وتقييمها، بالإضافة إلى أمثلة مجمّعة لمقاييس محدّدة. من خلال طلب نماذج مختلفة تم تحميلها، يمكنك بسهولة مقارنة الاختلافات في ردود هذه النماذج.

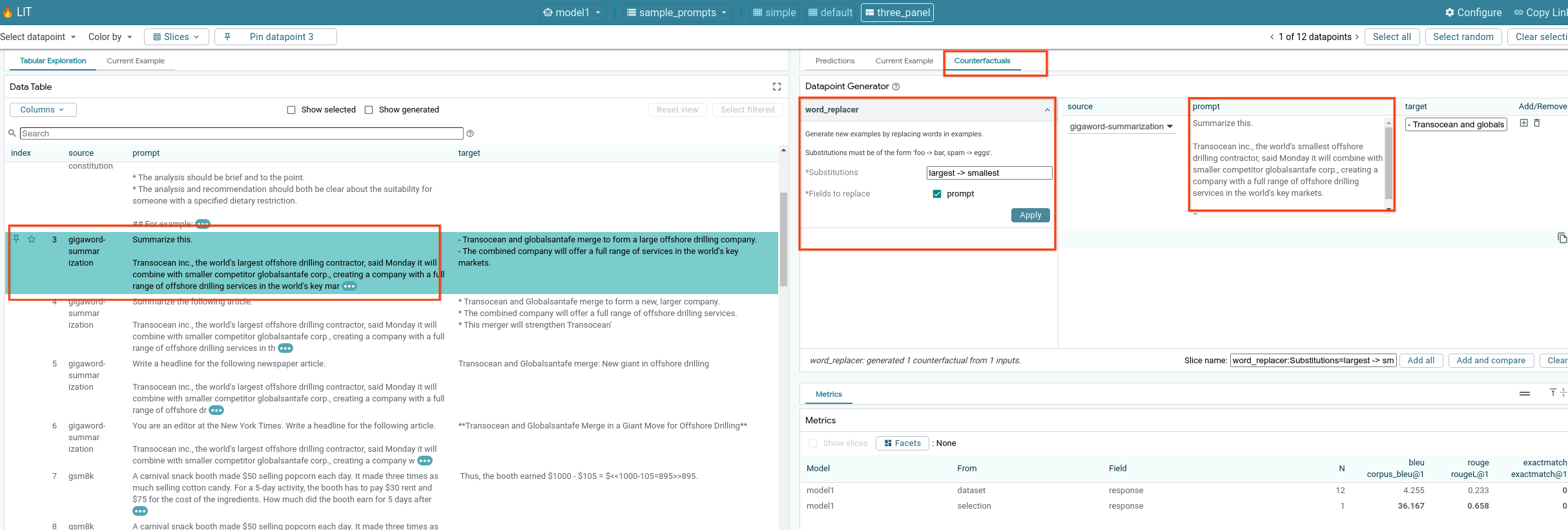

6-و: أدوات إنشاء السيناريوهات البديلة التلقائية

يمكنك استخدام أدوات إنشاء عكسية تلقائية لإنشاء مدخلات بديلة ومعرفة سلوك نموذجك عليها في الحال.

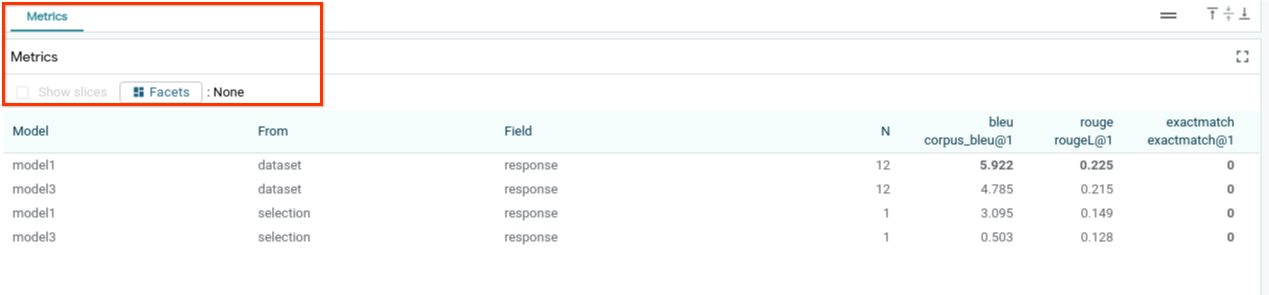

6-(ز): تقييم أداء النموذج

يمكنك تقييم أداء النموذج باستخدام المقاييس (تتيح حاليًا نتائج BLEU وROUGE لإنشاء النصوص) على مستوى مجموعة البيانات بالكامل أو أي مجموعات فرعية من الأمثلة التي تمّت فلترتها أو اختيارها.

7- تحديد المشاكل وحلّها

7-أ: المشاكل المحتملة في الوصول إلى البيانات والحلول

بما أنّه يتم تطبيق --no-allow-unauthenticated عند النشر على Cloud Run، قد تواجه أخطاء محظورة كما هو موضّح أدناه.

هناك طريقتان للوصول إلى خدمة LIT App.

1. خادم وكيل للخدمة المحلّية

يمكنك إنشاء وكيل للخدمة مع مضيف محلي باستخدام الأمر أدناه.

# Proxy the service to local host.

gcloud run services proxy $LIT_SERVICE_NAME

بعد ذلك، من المفترض أن تتمكّن من الوصول إلى خادم LIT من خلال النقر على رابط الخدمة الوكيل.

2. مصادقة المستخدمين مباشرةً

يمكنك اتّباع هذا الرابط لمصادقة المستخدمين، ما يتيح الوصول المباشر إلى خدمة LIT App. ويمكن أن تتيح هذه الطريقة أيضًا لمجموعة من المستخدمين الوصول إلى الخدمة. بالنسبة إلى التطوير الذي ينطوي على تعاون مع عدة أشخاص، يُعدّ هذا الخيار أكثر فعالية.

7-ب: عمليات التحقّق للتأكّد من إطلاق "خادم النماذج" بنجاح

للتأكّد من تشغيل خادم النماذج بنجاح، يمكنك الاستعلام عن خادم النماذج مباشرةً من خلال إرسال طلب. يقدّم خادم النماذج ثلاث نقاط نهاية، وهي predict وtokenize وsalience. احرص على تقديم الحقلين prompt وtarget في طلبك.

# Query the model server predict endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/predict -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

# Query the model server tokenize endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/tokenize -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

# Query the model server salience endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/salience -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

إذا واجهت مشكلة في الوصول إلى الحساب، اطّلِع على القسم 7(أ) أعلاه.

8. تهانينا

أحسنت في إكمال الدرس التطبيقي حول الترميز. حان وقت الاسترخاء.

تَنظيم

لتنظيف المختبر، احذف جميع خدمات Google Cloud التي تم إنشاؤها للمختبر. استخدِم Google Cloud Shell لتشغيل الأوامر التالية.

إذا انقطع الاتصال بخدمة Google Cloud بسبب عدم النشاط، عليك إعادة ضبط المتغيّرات باتّباع الخطوات السابقة.

# Delete the LIT App Service.

gcloud run services delete $LIT_SERVICE_NAME

إذا كنت قد بدأت خادم النماذج، عليك أيضًا حذفه.

# Delete the Model Service.

gcloud run services delete $MODEL_SERVICE_NAME

مراجع إضافية

يمكنك الاطّلاع على المزيد من المعلومات عن ميزات أداة LIT من خلال المراجع التالية:

- جميلة: رابط

- قاعدة الرموز البرمجية المفتوحة المصدر في LIT: مستودع Git

- ورقة LIT: ArXiv

- مقالة تصحيح أخطاء طلبات البحث في "مساعد Google": ArXiv

- عرض توضيحي لفيديو LIT: YouTube

- عرض توضيحي لتصحيح أخطاء طلبات LIT: YouTube

- مجموعة أدوات الذكاء الاصطناعي التوليدي المسؤول: الرابط

التواصل

إذا كانت لديك أي أسئلة أو مشاكل بشأن هذا الدليل التعليمي حول الرموز البرمجية، يُرجى التواصل معنا على GitHub.

الترخيص

يخضع هذا العمل رخصة المشاع الإبداعي العامة 4.0 مع نسب العمل إلى مؤلفه.