1. Übersicht

In diesem Lab wird eine detaillierte Anleitung zur Bereitstellung eines LIT-Anwendungsservers auf der Google Cloud Platform (GCP) zur Interaktion mit Vertex AI Gemini-Foundation-Modellen und selbst gehosteten Large Language Models (LLMs) von Drittanbietern beschrieben. Außerdem finden Sie hier eine Anleitung dazu, wie Sie die LIT-Benutzeroberfläche für die schnelle Fehlerbehebung und Modellinterpretation verwenden.

In diesem Lab lernen Nutzer Folgendes:

- Konfigurieren Sie einen LIT-Server in der GCP.

- Verbinden Sie den LIT-Server mit Vertex AI Gemini-Modellen oder anderen selbst gehosteten LLMs.

- Mit der LIT-Benutzeroberfläche können Sie Prompts analysieren, beheben und interpretieren, um die Modellleistung und die Statistiken zu verbessern.

Was ist LIT?

LIT ist ein visuelles, interaktives Tool zum Verstehen von Modellen, das Text-, Bild- und Tabellendaten unterstützt. Er kann als eigenständiger Server oder in Notebook-Umgebungen wie Google Colab, Jupyter und Google Cloud Vertex AI ausgeführt werden. LIT ist bei PyPI und GitHub verfügbar.

Ursprünglich wurde es entwickelt, um Klassifizierungs- und Regressionsmodelle zu verstehen. Durch die jüngsten Updates wurden Tools zum Debuggen von LLM-Prompts hinzugefügt, mit denen Sie untersuchen können, wie Nutzer-, Modell- und Systeminhalte das Generierungsverhalten beeinflussen.

Was sind Vertex AI und Model Garden?

Vertex AI ist eine ML-Plattform, mit der Sie ML-Modelle und KI-Anwendungen trainieren und bereitstellen sowie LLMs für die Verwendung in Ihren KI-gestützten Anwendungen anpassen können. Vertex AI kombiniert Data Engineering-, Data Science- und ML-Engineering-Workflows, sodass Ihre Teams mit einem gemeinsamen Toolset zusammenarbeiten und Ihre Anwendungen mithilfe der Vorteile von Google Cloud skalieren können.

Vertex Model Garden ist eine ML-Modellbibliothek, mit der Sie Google-eigene Modelle sowie ausgewählte Modelle und Assets von Drittanbietern entdecken, testen, anpassen und bereitstellen können.

Ihre Aufgaben

Sie verwenden die Cloud Shell und Cloud Run von Google, um einen Docker-Container aus dem vorkonfigurierten LIT-Image bereitzustellen.

Cloud Run ist eine verwaltete Computing-Plattform, mit der Sie Container direkt auf der skalierbaren Infrastruktur von Google ausführen können, auch auf GPUs.

Dataset

In der Demo wird standardmäßig das Beispiel-Dataset zum Debuggen von LIT-Prompts verwendet. Sie können aber auch Ihr eigenes Dataset über die Benutzeroberfläche laden.

Hinweis

Für diese Referenzanleitung benötigen Sie ein Google Cloud-Projekt. Sie können ein neues Projekt erstellen oder ein vorhandenes Projekt auswählen.

2. Google Cloud Console und Cloud Shell starten

In diesem Schritt starten Sie die Google Cloud Console und verwenden die Google Cloud Shell.

2-a: Google Cloud Console starten

Öffnen Sie einen Browser und rufen Sie die Google Cloud Console auf.

Die Google Cloud Console ist eine leistungsstarke, sichere Web-Benutzeroberfläche, mit der Sie Ihre Google Cloud-Ressourcen schnell verwalten können. Es ist ein DevOps-Tool für unterwegs.

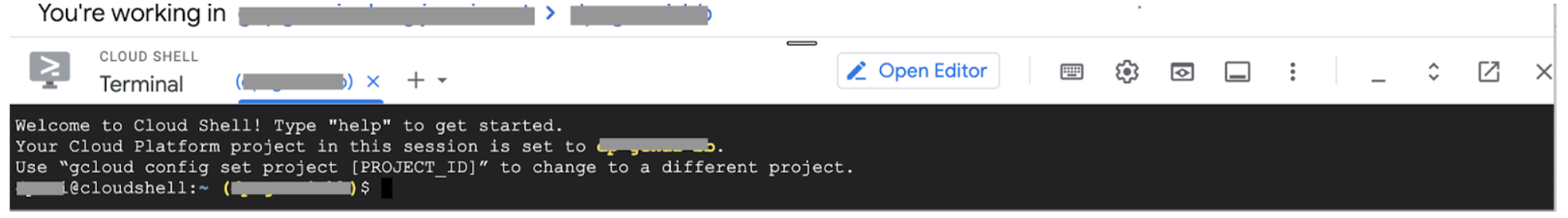

2-b: Google Cloud Shell starten

Cloud Shell ist eine Online-Entwicklungs- und Betriebsumgebung, auf die Sie mit Ihrem Browser von jedem Standort aus zugreifen können. Sie können Ihre Ressourcen über das Online-Terminal verwalten, auf dem Dienstprogramme wie das gcloud-Befehlszeilentool und kubectl vorinstalliert sind. Mit dem Cloud Shell Editor können Sie außerdem cloudbasierte Apps entwickeln, erstellen, debuggen und bereitstellen. Cloud Shell bietet eine entwicklerfähige Onlineumgebung mit vorinstallierten bevorzugten Tools und 5 GB nichtflüchtigen Speicher. Sie verwenden die Eingabeaufforderung in den nächsten Schritten.

Starten Sie Google Cloud Shell über das Symbol oben rechts in der Menüleiste, das im folgenden Screenshot blau umkreist ist.

Unten auf der Seite sollte ein Terminal mit einer Bash-Shell angezeigt werden.

2-c: Google Cloud-Projekt festlegen

Sie müssen die Projekt-ID und die Projektregion mit dem Befehl gcloud festlegen.

# Set your GCP Project ID.

gcloud config set project your-project-id

# Set your GCP Project Region.

gcloud config set run/region your-project-region

3. Docker-Image des LIT App-Servers mit Cloud Run bereitstellen

3-a: LIT-App in Cloud Run bereitstellen

Sie müssen zuerst die neueste Version der LIT-App als Version festlegen, die bereitgestellt werden soll.

# Set latest version as your LIT_SERVICE_TAG.

export LIT_SERVICE_TAG=latest

# List all the public LIT GCP App server docker images.

gcloud container images list-tags us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-lit-app

Nachdem Sie das Versions-Tag festgelegt haben, müssen Sie den Dienst benennen.

# Set your lit service name. While 'lit-app-service' is provided as a placeholder, you can customize the service name based on your preferences.

export LIT_SERVICE_NAME=lit-app-service

Anschließend können Sie den folgenden Befehl ausführen, um den Container in Cloud Run bereitzustellen.

# Use below cmd to deploy the LIT App to Cloud Run.

gcloud run deploy $LIT_SERVICE_NAME \

--image us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-lit-app:$LIT_SERVICE_TAG \

--port 5432 \

--cpu 8 \

--memory 32Gi \

--no-cpu-throttling \

--no-allow-unauthenticated

Mit LIT können Sie den Datensatz auch beim Starten des Servers hinzufügen. Legen Sie dazu die Variable DATASETS so fest, dass sie die Daten enthält, die Sie laden möchten, und verwenden Sie dabei das Format name:path, z. B. data_foo:/bar/data_2024.jsonl. Das Dataset-Format sollte .jsonl sein. Jeder Datensatz muss das Feld prompt und optional die Felder target und source enthalten. Wenn Sie mehrere Datensätze laden möchten, trennen Sie sie durch ein Komma. Wenn nicht festgelegt, wird der Beispieldatensatz für die LIT-Prompt-Fehlerbehebung geladen.

# Set the dataset.

export DATASETS=[DATASETS]

Mit MAX_EXAMPLES können Sie die maximale Anzahl von Beispielen festlegen, die aus jedem Bewertungssatz geladen werden sollen.

# Set the max examples.

export MAX_EXAMPLES=[MAX_EXAMPLES]

Anschließend können Sie

--set-env-vars "DATASETS=$DATASETS" \

--set-env-vars "MAX_EXAMPLES=$MAX_EXAMPLES" \

3-b: LIT App Service aufrufen

Nachdem Sie den LIT App-Server erstellt haben, finden Sie den Dienst in der Cloud Console im Bereich Cloud Run.

Wählen Sie den LIT App-Dienst aus, den Sie gerade erstellt haben. Achten Sie darauf, dass der Dienstname mit LIT_SERVICE_NAME übereinstimmt.

Sie finden die Dienst-URL, indem Sie auf den gerade bereitgestellten Dienst klicken.

Anschließend sollte die LIT-Benutzeroberfläche angezeigt werden. Wenn ein Fehler auftritt, lesen Sie den Abschnitt zur Fehlerbehebung.

Im Bereich „LOGS“ können Sie Aktivitäten überwachen, Fehlermeldungen ansehen und den Fortschritt der Bereitstellung verfolgen.

Im Bereich „MESSWERTE“ finden Sie die Messwerte des Dienstes.

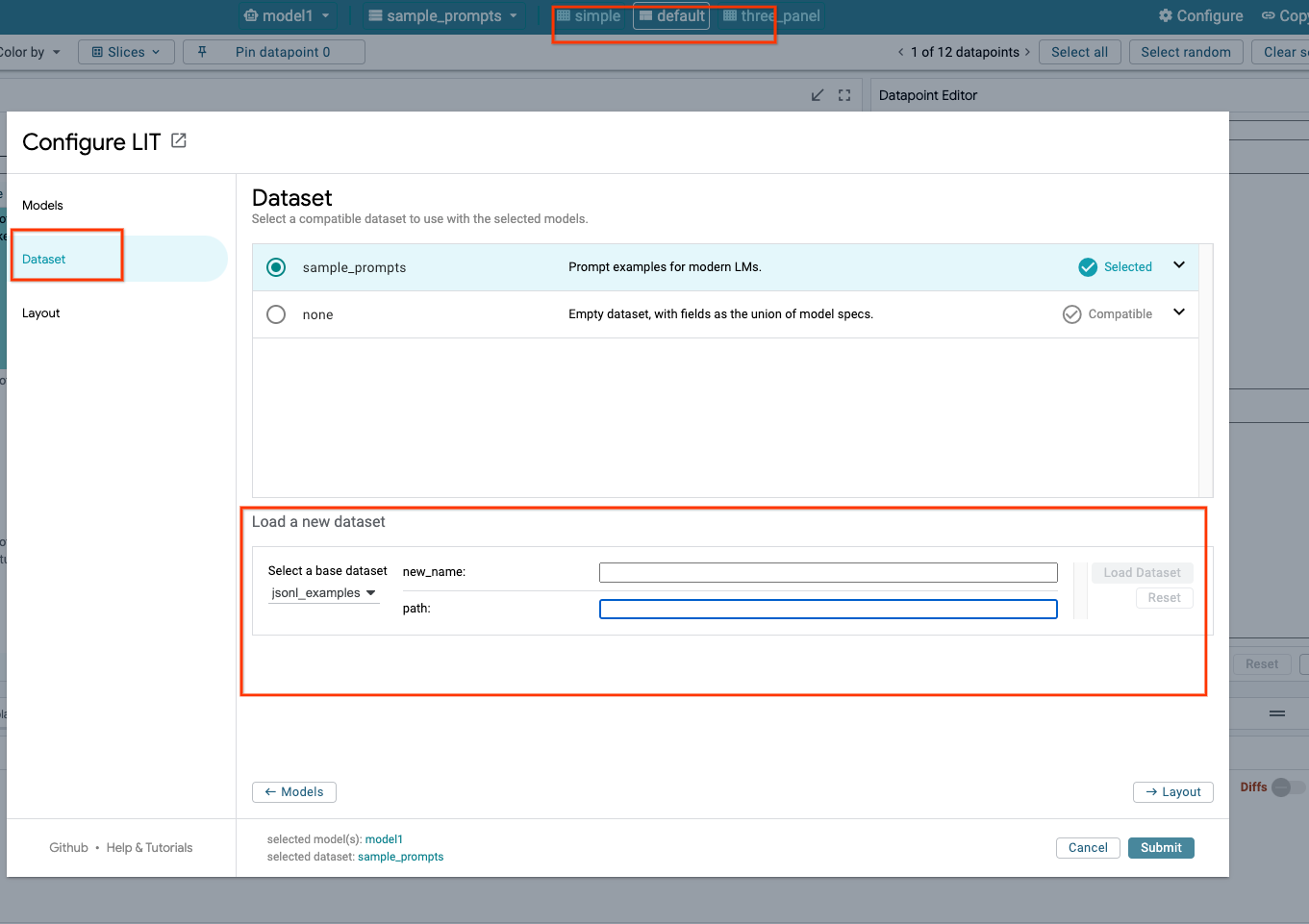

3-c: Datasets laden

Klicken Sie in der LIT-Benutzeroberfläche auf die Option Configure und wählen Sie Dataset aus. Laden Sie den Datensatz, indem Sie einen Namen und die Datensatz-URL angeben. Das Dataset-Format sollte „.jsonl“ sein. Jeder Datensatz muss das Feld prompt und optional die Felder target und source enthalten.

4. Gemini-Modelle in Vertex AI Model Garden vorbereiten

Die Gemini-Foundation Models von Google sind über die Vertex AI API verfügbar. LIT bietet den VertexAIModelGarden-Modell-Wrapper, um diese Modelle für die Generierung zu verwenden. Geben Sie einfach die gewünschte Version an, z.B. „gemini-1.5-pro-001“) über den Parameter „model_name“. Ein wichtiger Vorteil dieser Modelle besteht darin, dass sie bei der Bereitstellung keinen zusätzlichen Aufwand erfordern. Standardmäßig haben Sie sofort Zugriff auf Modelle wie Gemini 1.0 Pro und Gemini 1.5 Pro in der GCP. Es sind keine zusätzlichen Konfigurationsschritte erforderlich.

4-a: Vertex AI-Berechtigungen erteilen

Wenn Sie Gemini in der GCP abfragen möchten, müssen Sie dem Dienstkonto Vertex AI-Berechtigungen erteilen. Der Name des Dienstkontos muss Default compute service account sein. Kopieren Sie die E-Mail-Adresse des Dienstkontos.

Fügen Sie die E-Mail-Adresse des Dienstkontos als Hauptkonto mit der Rolle Vertex AI User zur IAM-Zulassungsliste hinzu.

4-b: Gemini-Modelle laden

Führen Sie die folgenden Schritte aus, um Gemini-Modelle zu laden und ihre Parameter anzupassen.

- Klicken Sie in der LIT-Benutzeroberfläche auf die Option

Configure.

- Klicken Sie in der LIT-Benutzeroberfläche auf die Option

- Wählen Sie unter

Select a base modeldie Optiongeminiaus.

- Wählen Sie unter

- Sie müssen das Modell in

new_namebenennen.

- Sie müssen das Modell in

- Geben Sie die ausgewählten Gemini-Modelle als

model_nameein.

- Geben Sie die ausgewählten Gemini-Modelle als

- Klicken Sie auf

Load Model.

- Klicken Sie auf

- Klicken Sie auf

Submit.

- Klicken Sie auf

5. Eigenhosteten LLMs-Modellserver in der GCP bereitstellen

Wenn Sie LLMs mit dem Modellserver-Docker-Image von LIT selbst hosten, können Sie die Auffälligkeits- und Tokenisierungsfunktionen von LIT verwenden, um tiefere Einblicke in das Modellverhalten zu erhalten. Das Modellserver-Image funktioniert mit KerasNLP- oder Hugging Face Transformers-Modellen, einschließlich von der Bibliothek bereitgestellter und selbst gehosteter Gewichte, z.B. in Google Cloud Storage.

5-a: Modelle konfigurieren

In jedem Container wird ein Modell geladen, das mithilfe von Umgebungsvariablen konfiguriert wird.

Sie sollten die zu ladenden Modelle angeben, indem Sie die MODEL_CONFIG festlegen. Das Format sollte name:path sein, z. B. model_foo:model_foo_path. Der Pfad kann eine URL, ein lokaler Dateipfad oder der Name einer Voreinstellung für das konfigurierte Deep Learning-Framework sein. Weitere Informationen finden Sie in der folgenden Tabelle. Dieser Server wird mit Gemma, GPT2, Llama und Mistral für alle unterstützten DL_FRAMEWORK-Werte getestet. Andere Modelle sollten funktionieren, aber es sind möglicherweise Anpassungen erforderlich.

# Set models you want to load. While 'gemma2b is given as a placeholder, you can load your preferred model by following the instructions above.

export MODEL_CONFIG=gemma2b:gemma_2b_en

Außerdem können Sie mit dem folgenden Befehl verschiedene Umgebungsvariablen auf dem LIT-Modellserver konfigurieren. Weitere Informationen findest du in der Tabelle. Hinweis: Jede Variable muss einzeln festgelegt werden.

# Customize the variable value as needed.

export [VARIABLE]=[VALUE]

Variable | Werte | Beschreibung |

DL_FRAMEWORK |

| Die Modellierungsbibliothek, die zum Laden der Modellgewichtungen in die angegebene Laufzeit verwendet wird. Die Standardeinstellung ist |

DL_RUNTIME |

| Das Deep-Learning-Backend-Framework, auf dem das Modell ausgeführt wird. Alle von diesem Server geladenen Modelle verwenden dasselbe Backend. Inkompatibilitäten führen zu Fehlern. Die Standardeinstellung ist |

PRECISION |

| Gleitkommagenauigkeit für die LLM-Modelle. Die Standardeinstellung ist |

BATCH_SIZE | Positive Ganzzahlen | Die Anzahl der Beispiele, die pro Batch verarbeitet werden sollen. Die Standardeinstellung ist |

SEQUENCE_LENGTH | Positive Ganzzahlen | Die maximale Sequenzlänge des Eingabeprompts plus generierter Text. Die Standardeinstellung ist |

5-b: Modellserver in Cloud Run bereitstellen

Sie müssen zuerst die neueste Version des Modellservers als Version festlegen, die bereitgestellt werden soll.

# Set latest as MODEL_VERSION_TAG.

export MODEL_VERSION_TAG=latest

# List all the public LIT GCP model server docker images.

gcloud container images list-tags us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-model-server

Nachdem Sie das Versions-Tag festgelegt haben, müssen Sie Ihrem Modellserver einen Namen geben.

# Set your Service name.

export MODEL_SERVICE_NAME='gemma2b-model-server'

Danach können Sie den folgenden Befehl ausführen, um den Container in Cloud Run bereitzustellen. Wenn Sie die Umgebungsvariablen nicht festlegen, werden Standardwerte angewendet. Da die meisten LLMs teure Rechenressourcen erfordern, wird die Verwendung einer GPU dringend empfohlen. Wenn Sie die Ausführung nur auf der CPU bevorzugen (was für kleine Modelle wie GPT2 gut funktioniert), können Sie die zugehörigen Argumente entfernen --gpu 1 --gpu-type nvidia-l4 --max-instances 7.

# Deploy the model service container.

gcloud beta run deploy $MODEL_SERVICE_NAME \

--image us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-model-server:$MODEL_VERSION_TAG \

--port 5432 \

--cpu 8 \

--memory 32Gi \

--no-cpu-throttling \

--gpu 1 \

--gpu-type nvidia-l4 \

--max-instances 7 \

--set-env-vars "MODEL_CONFIG=$MODEL_CONFIG" \

--no-allow-unauthenticated

Außerdem können Sie Umgebungsvariablen anpassen, indem Sie die folgenden Befehle hinzufügen. Geben Sie nur die Umgebungsvariablen an, die für Ihre spezifischen Anforderungen erforderlich sind.

--set-env-vars "DL_FRAMEWORK=$DL_FRAMEWORK" \

--set-env-vars "DL_RUNTIME=$DL_RUNTIME" \

--set-env-vars "PRECISION=$PRECISION" \

--set-env-vars "BATCH_SIZE=$BATCH_SIZE" \

--set-env-vars "SEQUENCE_LENGTH=$SEQUENCE_LENGTH" \

Für den Zugriff auf bestimmte Modelle können zusätzliche Umgebungsvariablen erforderlich sein. Entsprechende Anleitungen finden Sie unter Kaggle Hub (für KerasNLP-Modelle verwendet) und Hugging Face Hub.

5-c: Auf Modellserver zugreifen

Nachdem Sie den Modellserver erstellt haben, finden Sie den gestarteten Dienst im Bereich Cloud Run Ihres GCP-Projekts.

Wählen Sie den gerade erstellten Modellserver aus. Der Dienstname muss mit MODEL_SERVICE_NAME übereinstimmen.

Sie finden die Dienst-URL, indem Sie auf den gerade bereitgestellten Modelldienst klicken.

Im Bereich „LOGS“ können Sie Aktivitäten überwachen, Fehlermeldungen ansehen und den Fortschritt der Bereitstellung verfolgen.

Im Bereich „MESSWERTE“ finden Sie die Messwerte des Dienstes.

5-d: Eigenhostete Modelle laden

Wenn Sie in Schritt 3 einen Proxy für Ihren LIT-Server verwenden (siehe Abschnitt „Fehlerbehebung“), müssen Sie Ihr GCP-Identitätstoken abrufen. Führen Sie dazu den folgenden Befehl aus.

# Find your GCP identity token.

gcloud auth print-identity-token

Mit den folgenden Schritten laden Sie selbst gehostete Modelle und passen ihre Parameter an.

- Klicken Sie in der LIT-Benutzeroberfläche auf die Option

Configure. - Wählen Sie unter

Select a base modeldie OptionLLM (self hosted)aus. - Sie müssen das Modell in

new_namebenennen. - Geben Sie die URL Ihres Modellservers als

base_urlein. - Gib das erhaltene Identitätstoken in das

identity_tokenein, wenn du den LIT App-Server per Proxy verwendest (siehe Schritte 3 und 7). Andernfalls lassen Sie das Feld leer. - Klicken Sie auf

Load Model. - Klicken Sie auf

Submit.

6. Mit LIT auf der GCP interagieren

LIT bietet eine Vielzahl von Funktionen, mit denen Sie das Modellverhalten analysieren und nachvollziehen können. Sie können das Modell ganz einfach abfragen, indem Sie Text in ein Feld eingeben und sich die Modellvorhersagen ansehen. Mit den leistungsstarken Funktionen von LIT können Sie die Modelle auch eingehend untersuchen, darunter:

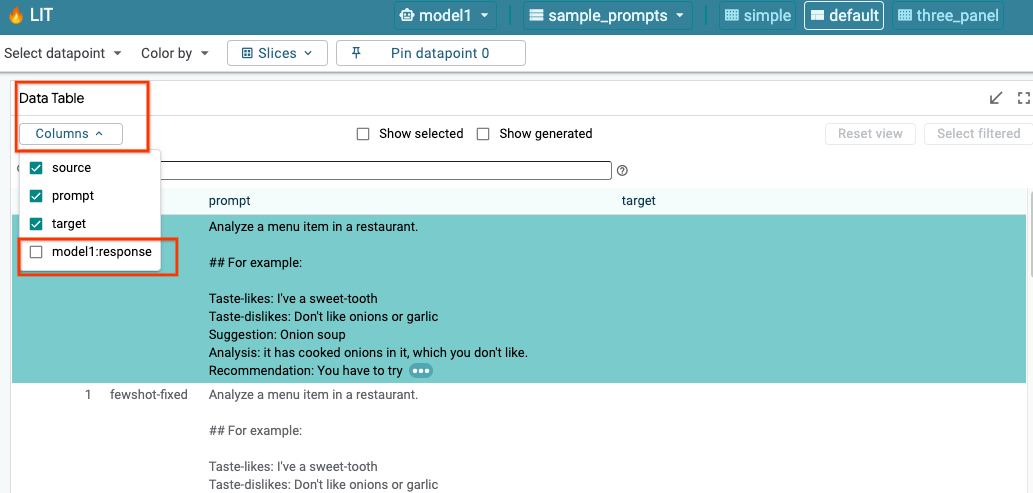

6-a: Modell über LIT abfragen

Nach dem Laden des Modells und des Datasets wird das Dataset automatisch von LIT abgefragt. Sie können die Antwort jedes Modells ansehen, indem Sie die Antwort in den Spalten auswählen.

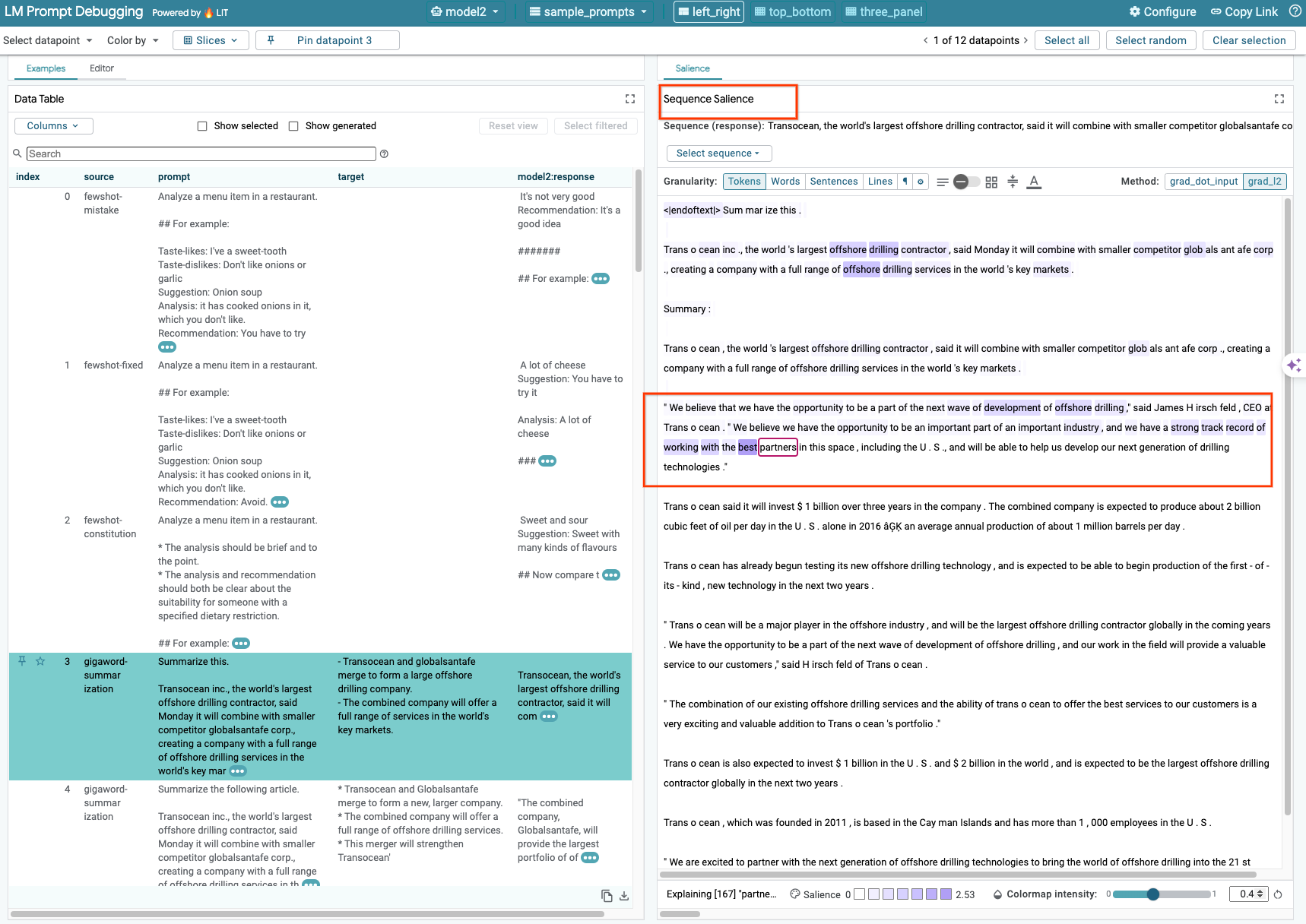

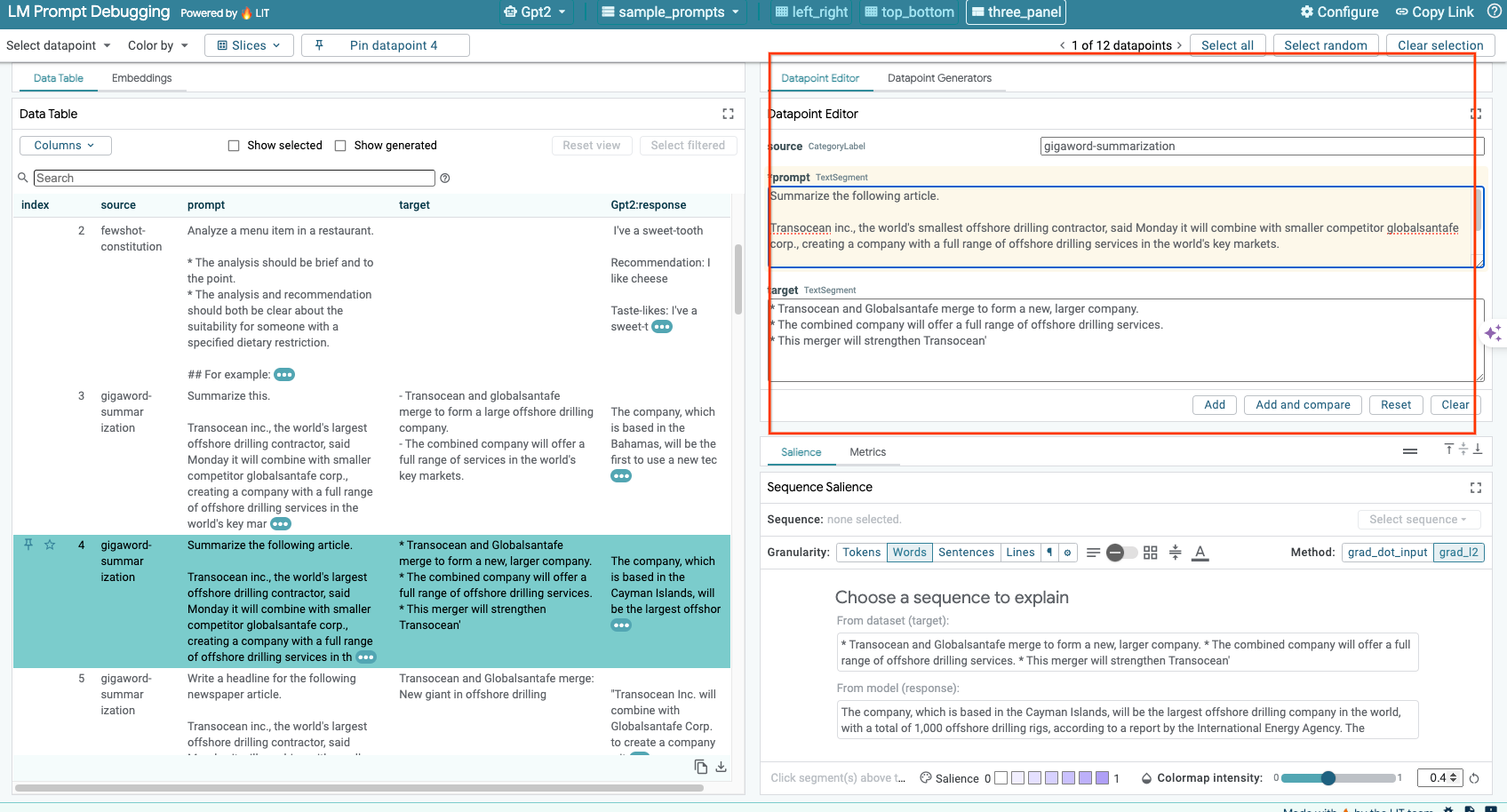

6-b: Die Sequenz-Auffälligkeitstechnik verwenden

Derzeit wird die Sequenzsalenz-Methode bei der leistungsorientierten Anzeigenbereitstellung nur für selbst gehostete Modelle unterstützt.

Sequence Salience ist ein visuelles Tool, mit dem Sie LLM-Prompts beheben können, indem Sie hervorheben, welche Teile eines Prompts für eine bestimmte Ausgabe am wichtigsten sind. Weitere Informationen zur Sequenz Salience finden Sie in der vollständigen Anleitung, in der Sie mehr über die Verwendung dieser Funktion erfahren.

Klicken Sie auf eine Ein- oder Ausgabe im Prompt oder in der Antwort, um auf die Auffälligkeitsergebnisse zuzugreifen.

6-c: Aufforderung und Ziel bearbeiten

Mit LIT können Sie prompt und target für vorhandene Datenpunkte manuell bearbeiten. Wenn Sie auf Add klicken, wird die neue Eingabe dem Dataset hinzugefügt.

6-d: Aufforderung nebeneinander vergleichen

Mit der Funktion „LIT“ können Sie Prompts mit ursprünglichen und bearbeiteten Beispielen direkt vergleichen. Sie können ein Beispiel manuell bearbeiten und sich das Vorhersageergebnis und die Analyse der Sequenzverteilung sowohl für die Originalversion als auch für die bearbeitete Version gleichzeitig ansehen. Sie können die Aufforderung für jeden Datenpunkt ändern. LIT generiert die entsprechende Antwort durch Abfragen des Modells.

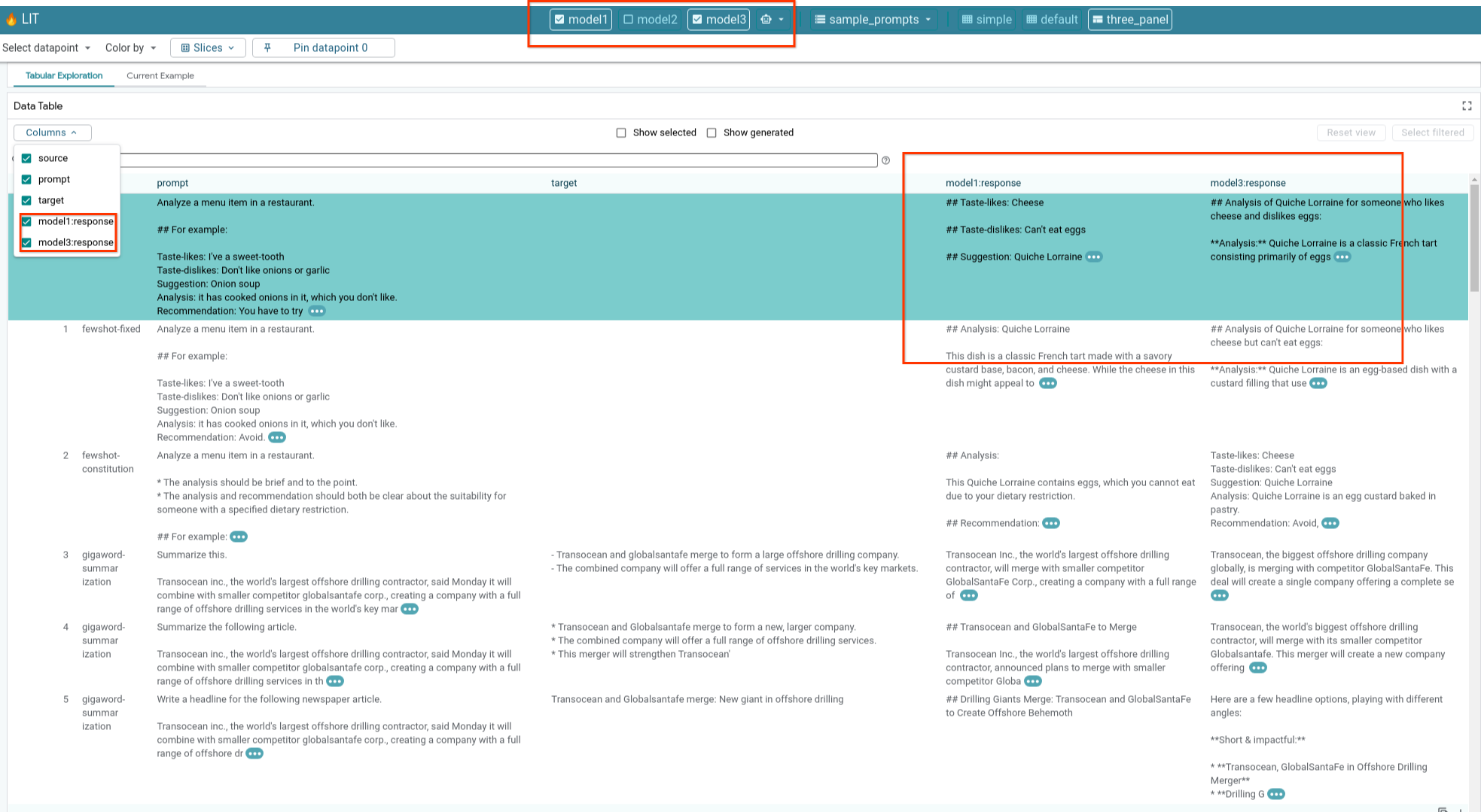

6-e: Mehrere Modelle vergleichen

LIT ermöglicht den direkten Vergleich von Modellen zu individuellen Textgenerierungs- und Bewertungsbeispielen sowie aggregierten Beispielen für bestimmte Messwerte. Durch Abfragen verschiedener geladener Modelle können Sie die Unterschiede in den Antworten leicht vergleichen.

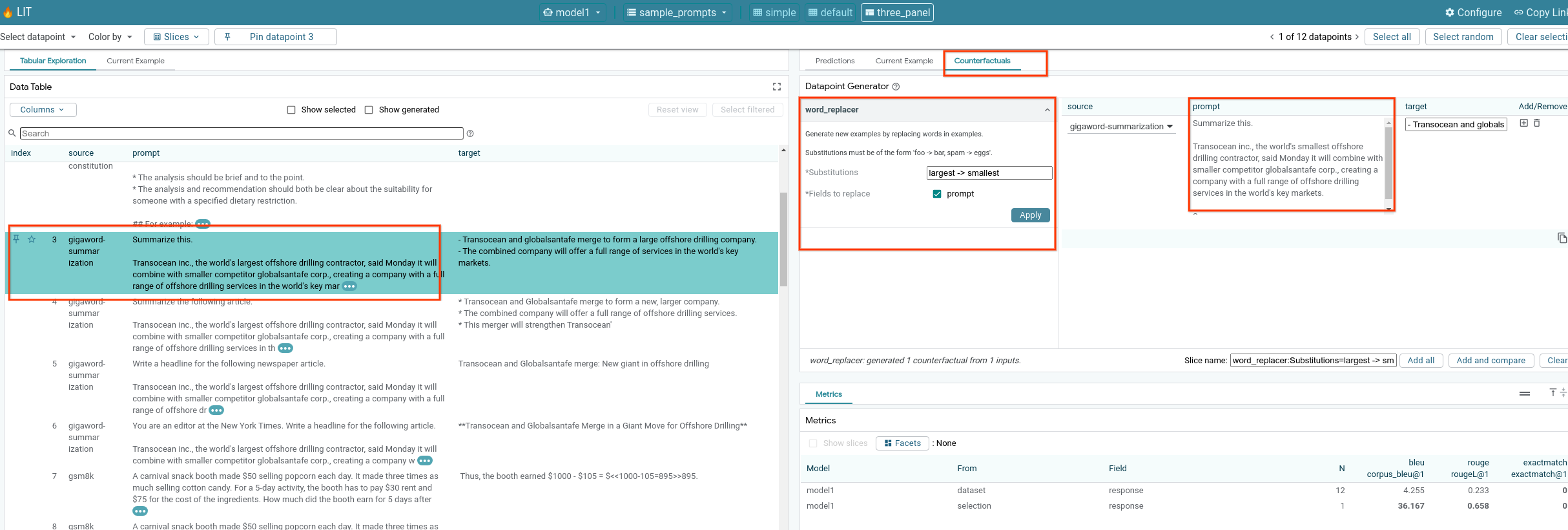

6-f: Automatische Gegenfaktengeneratoren

Mit automatischen Gegenfaktengeneratoren können Sie alternative Eingaben erstellen und sofort sehen, wie sich Ihr Modell bei diesen Eingaben verhält.

6-g: Modellleistung bewerten

Sie können die Modellleistung mithilfe von Messwerten (unterstützen derzeit BLEU- und ROUGE-Werte für die Textgenerierung) für das gesamte Dataset oder beliebige Teilmengen gefilterter oder ausgewählter Beispiele bewerten.

7. Fehlerbehebung

7-a: Mögliche Zugriffsprobleme und Lösungen

Da --no-allow-unauthenticated bei der Bereitstellung in Cloud Run angewendet wird, können verbotene Fehler wie unten gezeigt auftreten.

Es gibt zwei Möglichkeiten, auf den LIT App-Dienst zuzugreifen.

1. Proxy an lokalen Dienst

Mit dem folgenden Befehl können Sie einen Proxy für den Dienst an den lokalen Host senden.

# Proxy the service to local host.

gcloud run services proxy $LIT_SERVICE_NAME

Sie sollten dann auf den LIT-Server zugreifen können, indem Sie auf den Link zum Proxydienst klicken.

2. Nutzer direkt authentifizieren

Über diesen Link können Sie Nutzer authentifizieren und ihnen so direkten Zugriff auf den LIT App-Dienst gewähren. Mit diesem Ansatz kann auch einer Gruppe von Nutzern der Zugriff auf den Dienst gewährt werden. Bei der Entwicklung, die die Zusammenarbeit mehrerer Personen erfordert, ist dies eine effektivere Option.

7-b: Prüfen, ob der Modellserver erfolgreich gestartet wurde

Um sicherzustellen, dass der Modellserver erfolgreich gestartet wurde, können Sie den Modellserver direkt abfragen, indem Sie eine Anfrage senden. Der Modellserver bietet drei Endpunkte: predict, tokenize und salience. Achten Sie darauf, dass Sie in Ihrer Anfrage sowohl das Feld prompt als auch das Feld target angeben.

# Query the model server predict endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/predict -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

# Query the model server tokenize endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/tokenize -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

# Query the model server salience endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/salience -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

Falls Probleme beim Zugriff auftreten, lesen Sie den Abschnitt 7-a oben.

8. Glückwunsch

Gut gemacht, Sie haben das Codelab abgeschlossen. Zeit zum Chillen!

Bereinigen

Wenn Sie das Lab bereinigen möchten, löschen Sie alle für das Lab erstellten Google Cloud-Dienste. Führen Sie die folgenden Befehle in der Google Cloud Shell aus.

Wenn die Google Cloud-Verbindung aufgrund von Inaktivität unterbrochen wird, setzen Sie die Variablen gemäß den vorherigen Schritten zurück.

# Delete the LIT App Service.

gcloud run services delete $LIT_SERVICE_NAME

Wenn Sie den Modellserver gestartet haben, müssen Sie ihn auch löschen.

# Delete the Model Service.

gcloud run services delete $MODEL_SERVICE_NAME

Weitere Informationen

Mit den folgenden Materialien können Sie mehr über die Funktionen des LIT-Tools erfahren:

- Gemma: Link

- LIT-Open-Source-Codebasis: Git-Repository

- LIT-Artikel: ArXiv

- Artikel zum Beheben von Fehlern bei LIT-Prompts: ArXiv

- Demo zu LIT-Funktion: YouTube

- Demo zum Debuggen mit LIT-Prompts: YouTube

- Toolkit für Responsible GenAI: Link

Kontakt

Bei Fragen oder Problemen mit diesem Codelab können Sie uns auf GitHub kontaktieren.

Lizenz

Dieses Werk unterliegt der Creative-Commons-Lizenz „Namensnennung 4.0“.