1. Einführung 👋

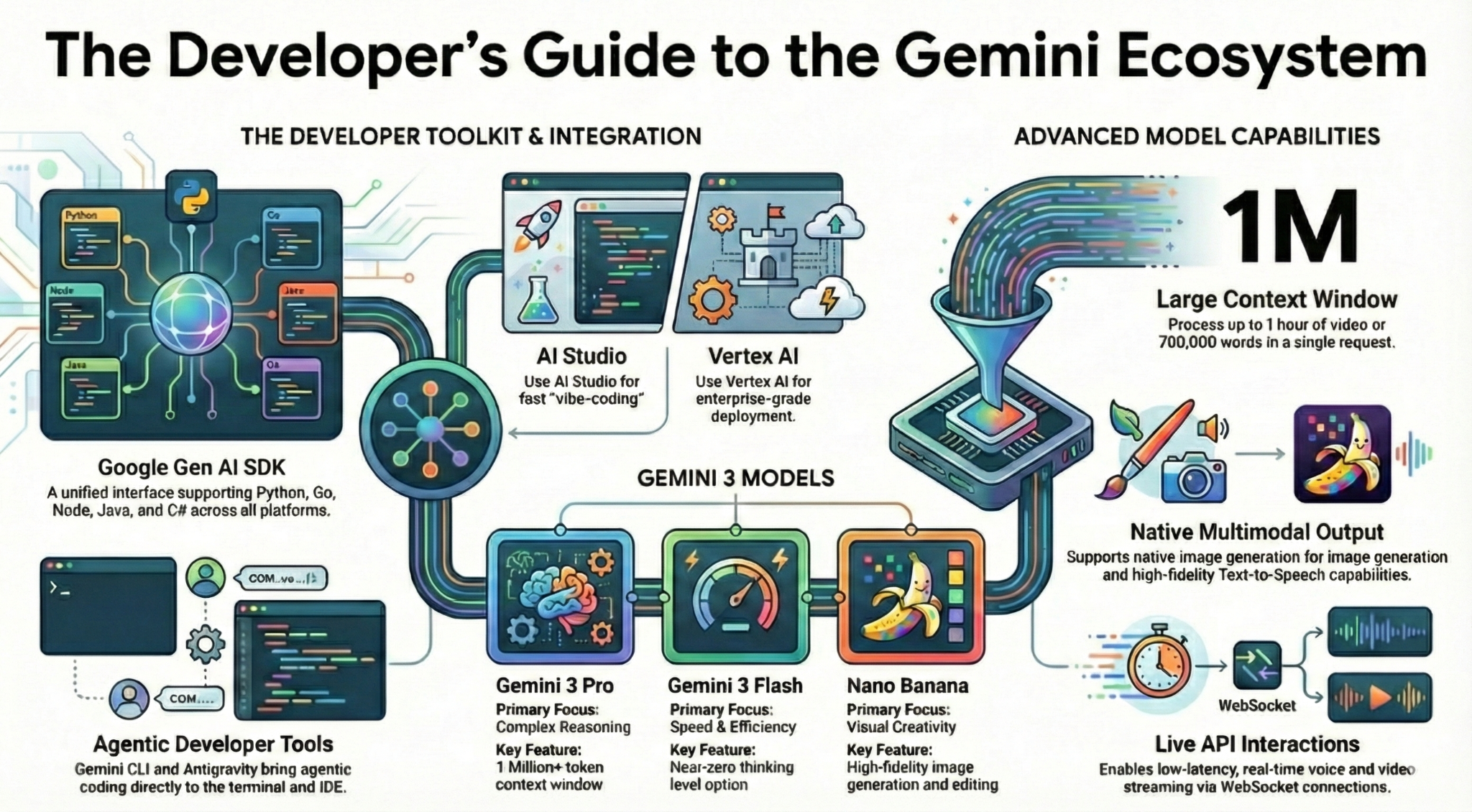

In diesem Codelab erfahren Sie alles, was Sie als Entwickler über das Gemini-Ökosystem wissen müssen. Sie lernen verschiedene Gemini-Modelle, verschiedene Tools, die auf Gemini basieren, und das Google Gen AI SDK kennen, mit dem Sie Gemini einbinden können. Außerdem werden verschiedene Funktionen von Gemini vorgestellt, z. B. langer Kontext, Denkmodus, räumliches Verständnis, Live API, native Bild- und Audioausgabe.

Am Ende dieses Codelabs sollten Sie ein solides Verständnis des Gemini-Ökosystems haben.

💡 Lerninhalte

- Verschiedene Gemini-Modelle

- Tools, die auf Gemini-Modellen basieren.

- Gemini mit dem Google Gen AI SDK einbinden

- Großes Kontextfenster von Gemini.

- Der Thinking-Modus von Gemini.

- Verschiedene integrierte Tools wie die Google Suche und Google Maps.

- So interagieren Sie mit der Interactions API mit Research Agents.

- Bild- und Text-zu-Sprache-Generierung.

- Räumliches Verständnis von Gemini

- Live-API für Sprach- und Videointeraktionen in Echtzeit.

⚠️ Voraussetzungen

- Ein API-Schlüssel für Google AI Studio-Beispiele.

- Ein Google Cloud-Projekt mit aktivierter Abrechnung für Vertex AI-Beispiele.

- Ihre lokale Entwicklungsumgebung oder Cloud Shell Editor in Google Cloud.

2. Die Gemini-Familie 🫂

Gemini ist das KI-Modell von Google, mit dem Sie jede Idee zum Leben erwecken können. Es ist ein hervorragendes Modell für multimodales Verstehen und agentisches und Vibe-Coding – alles auf Grundlage modernster Schlussfolgerungsfunktionen. In diesem Video erhalten Sie einen kurzen Überblick über das Gemini-Modell:

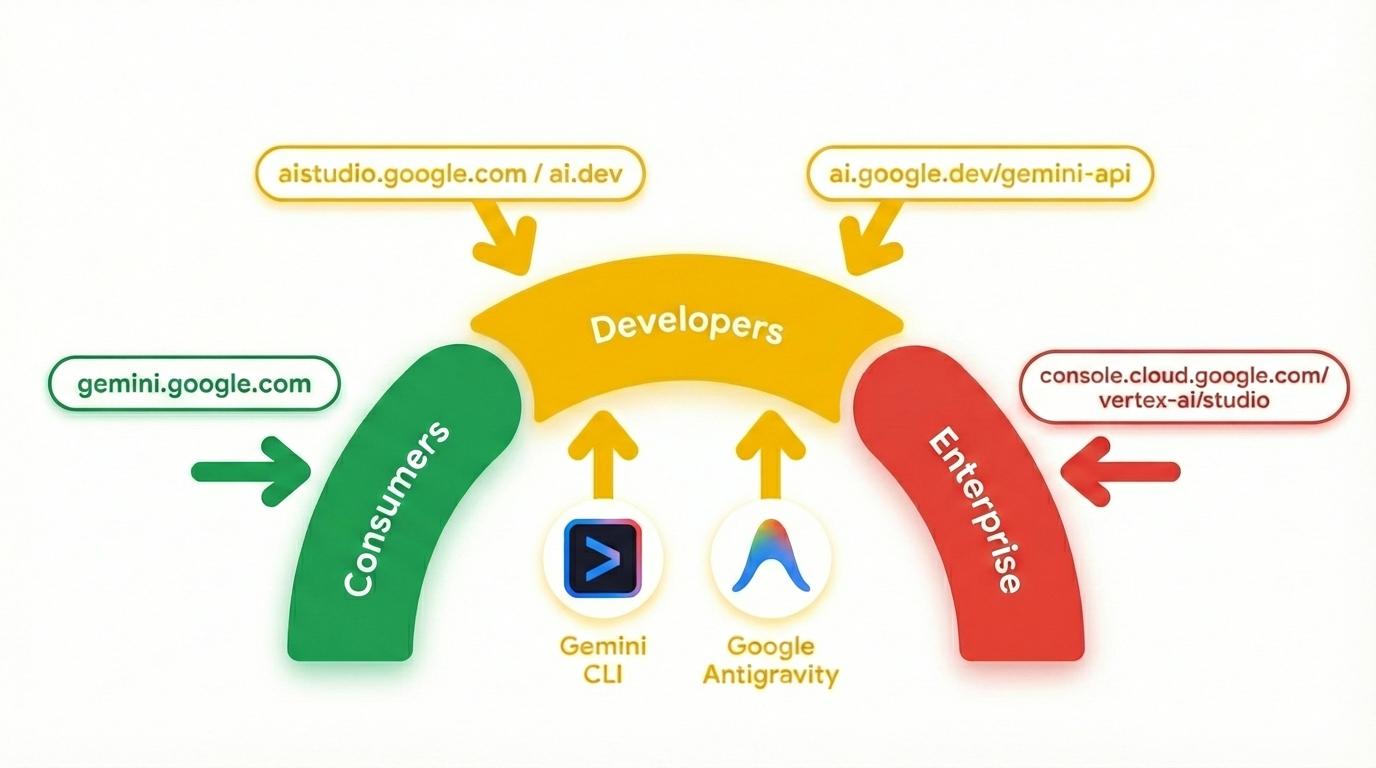

Gemini ist nicht nur ein Modell. Sie ist auch eine Dachmarke, die in Google-Produkten verwendet wird.

die das Gemini-Modell nutzen. Es gibt eine Reihe von Gemini-Produkten, die von der Gemini App und NotebookLM für Privatnutzer über AI Studio für Entwickler bis hin zu Vertex AI von Google Cloud für Unternehmen reichen. Es gibt auch Entwicklertools wie die Gemini CLI und Google Antigravity, die auf Gemini basieren.

3. Gemini-basierte Tools 🧰

Sehen wir uns kurz die Tools an, die auf Gemini basieren.

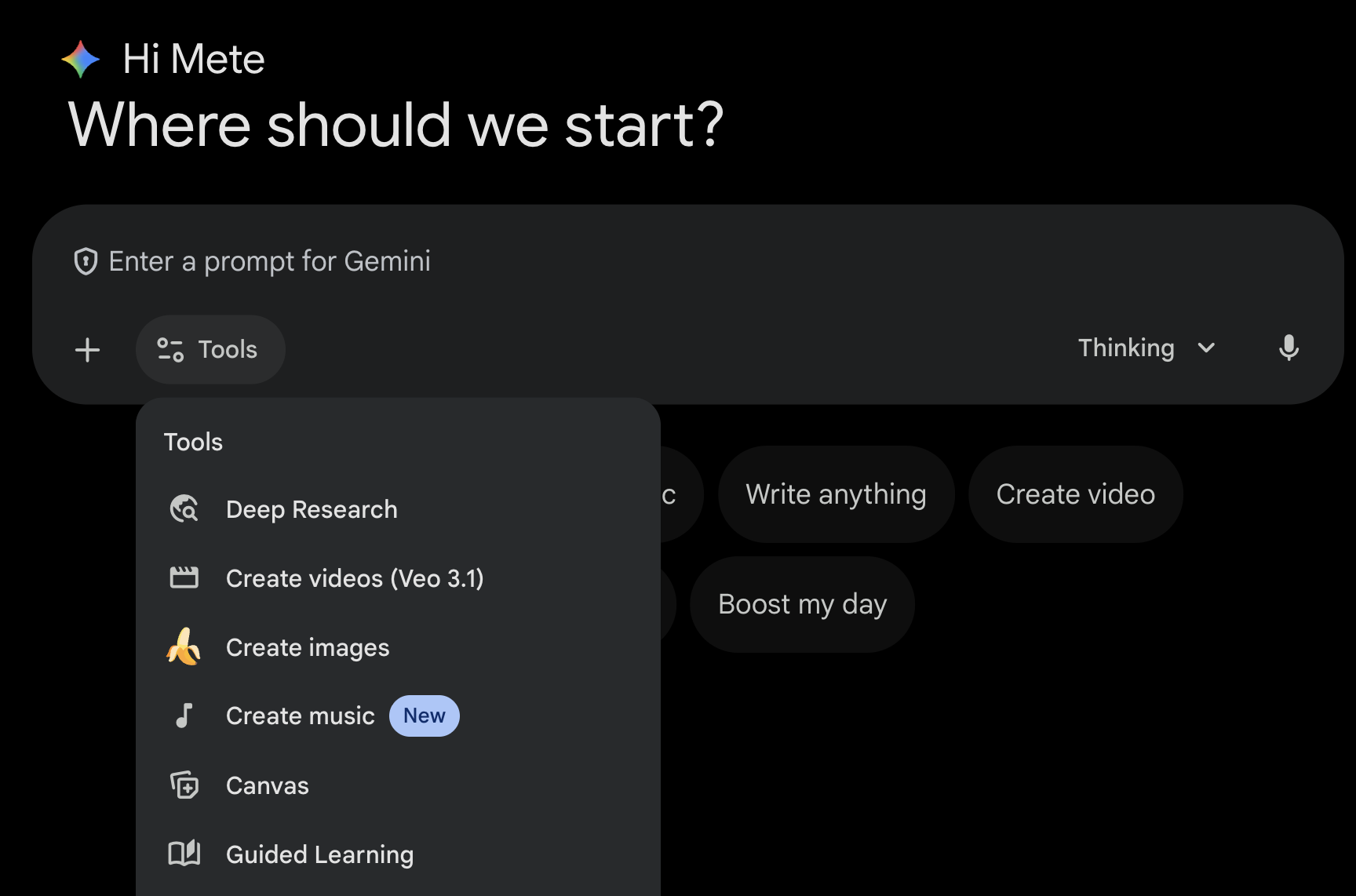

Gemini App 💬

Die Gemini App ( gemini.google.com) ist eine chatbasierte Verbraucheranwendung. Das ist die einfachste Möglichkeit, mit Gemini zu interagieren. Es bietet Tools für Deep Research, Bild-, Video- und Musikgenerierung und vieles mehr. Außerdem gibt es verschiedene Varianten des neuesten Gemini-Modells (Schnell, Denken, Pro). Die Gemini App eignet sich perfekt für den täglichen Gebrauch.

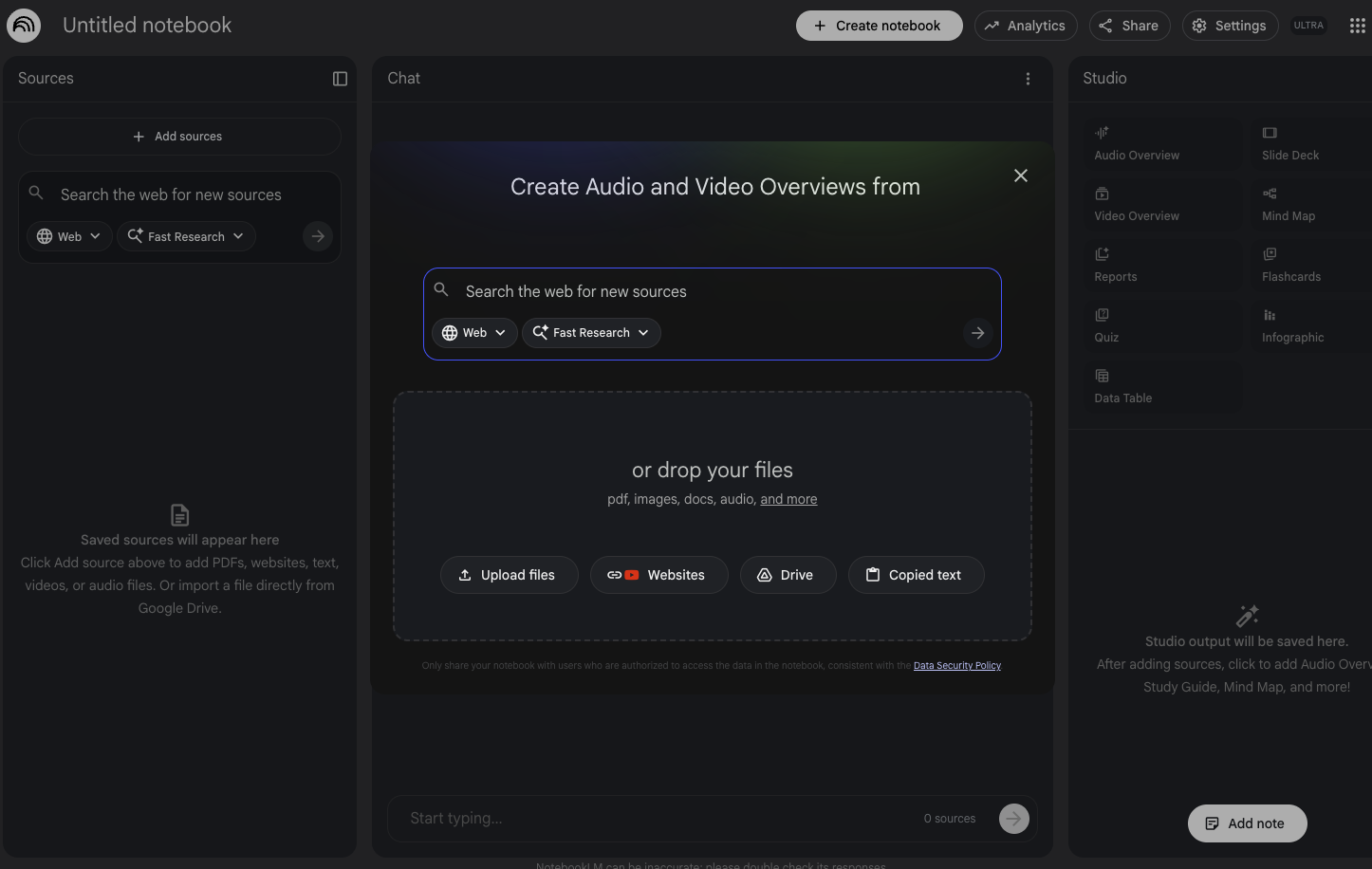

NotebookLM 📓

NotebookLM ( notebooklm.google.com) ist ein KI‑basierter Recherchepartner. Sie können PDFs, Websites, YouTube-Videos, Audiodateien, Google-Dokumente, Google-Präsentationen und mehr hochladen. NotebookLM fasst die Inhalte zusammen und stellt interessante Zusammenhänge zwischen Themen her. Dies wird durch die multimodalen Analysefunktionen der aktuellen Version von Gemini ermöglicht. Außerdem werden aus den von Ihnen hochgeladenen Quellen interessante und ansprechende Audio-Zusammenfassungen, Video-Zusammenfassungen, Infografiken und mehr erstellt.

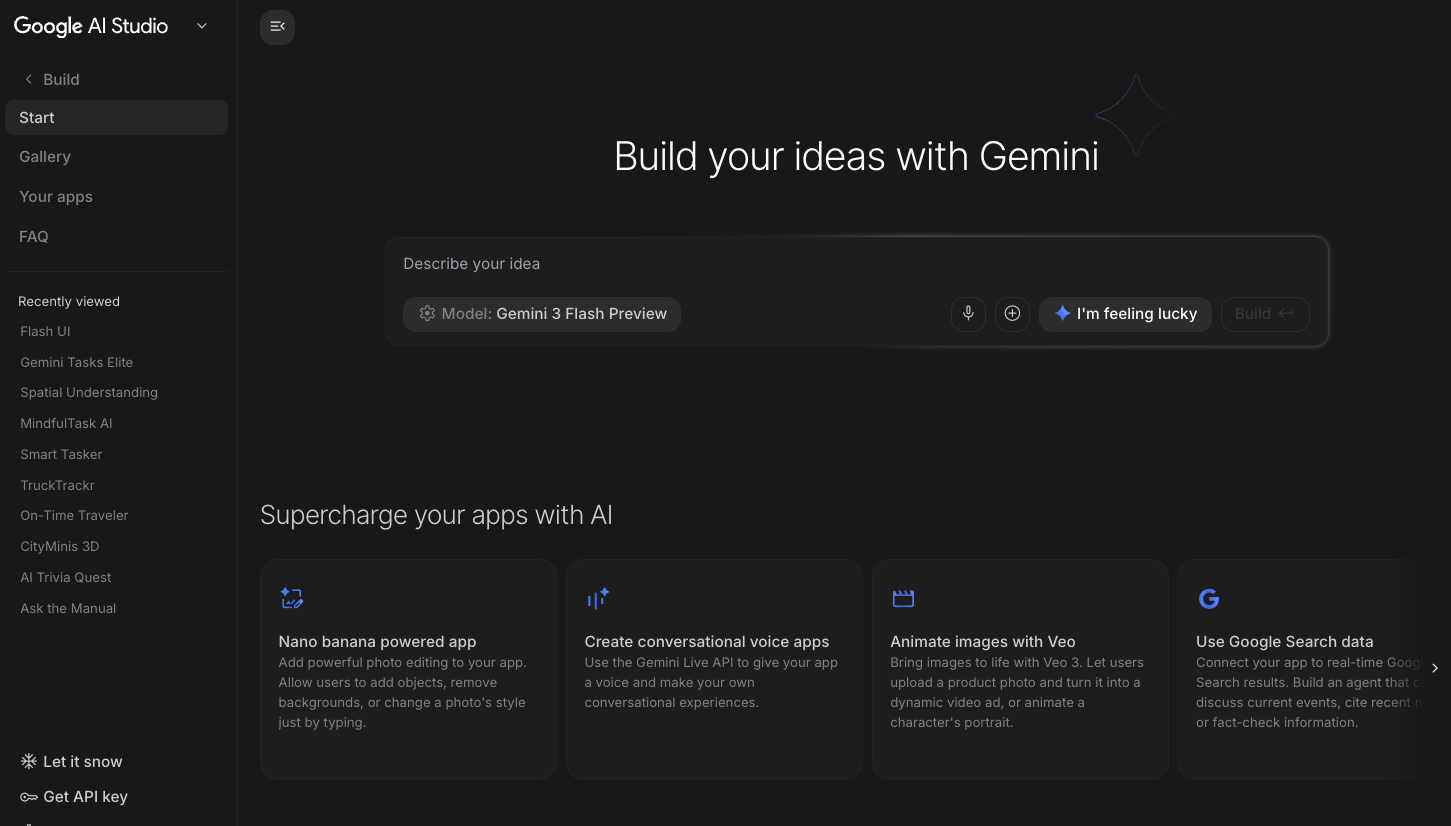

Google AI Studio 🎨

Google AI Studio ( ai.dev) ist die schnellste Möglichkeit, mit Gemini zu entwickeln. Im Bereich Playground in Google AI Studio können Sie mit verschiedenen Modellen experimentieren, um Text, Bilder und Videos zu generieren. Außerdem können Sie die Gemini Live API für Sprach- und Video-Chats in Echtzeit ausprobieren. Im Bereich Build in Google AI Studio können Sie Webanwendungen mit Vibe-Code erstellen, in Cloud Run in Google Cloud bereitstellen und den Code an GitHub übertragen.

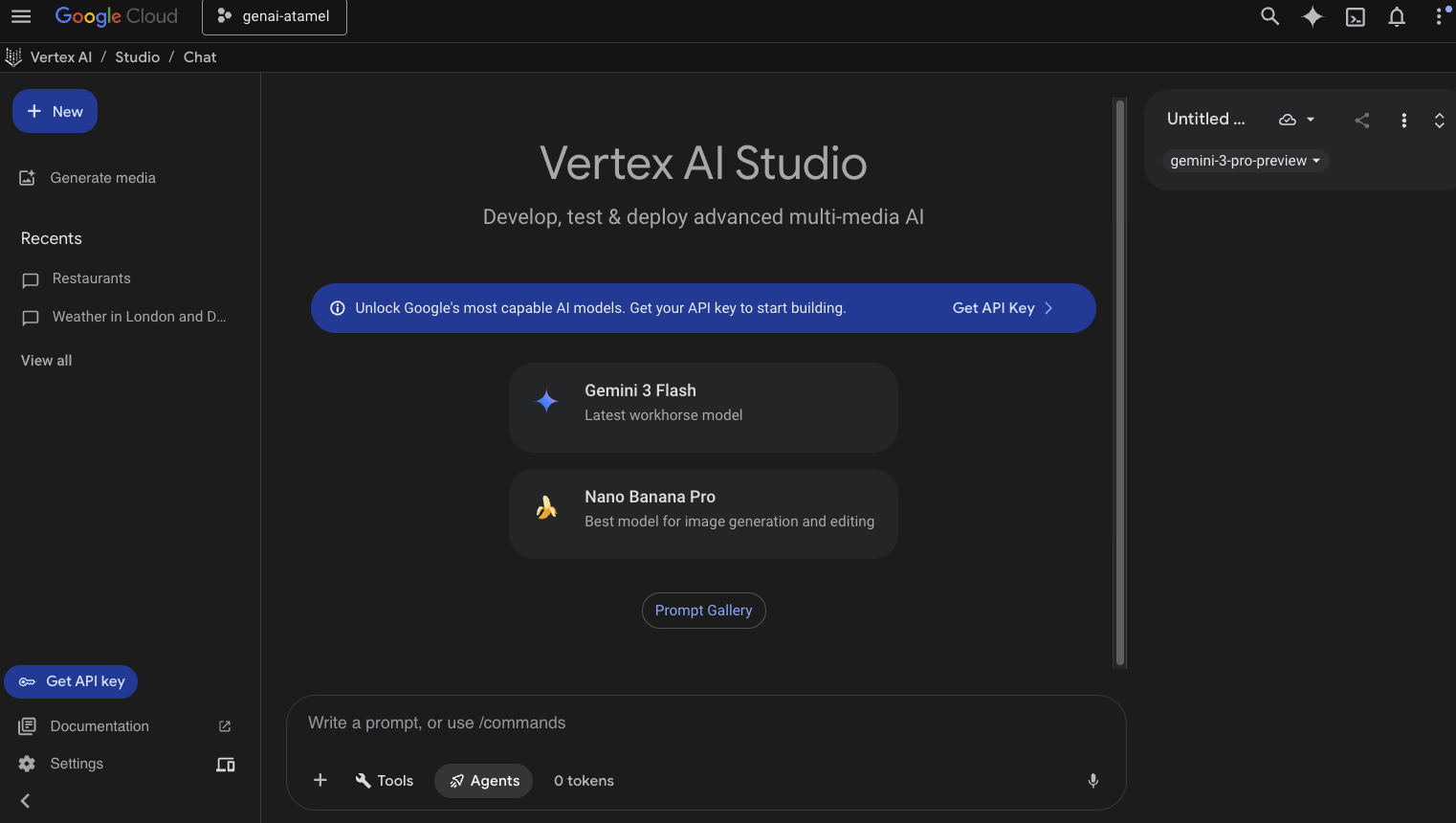

Vertex AI Studio ☁️

Vertex AI ist eine vollständig verwaltete, einheitliche KI-Entwicklungsplattform zum Erstellen und Verwenden von generativer KI in Google Cloud. Mit Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) können Sie generative KI-Anwendungen für Unternehmen testen, optimieren und bereitstellen.

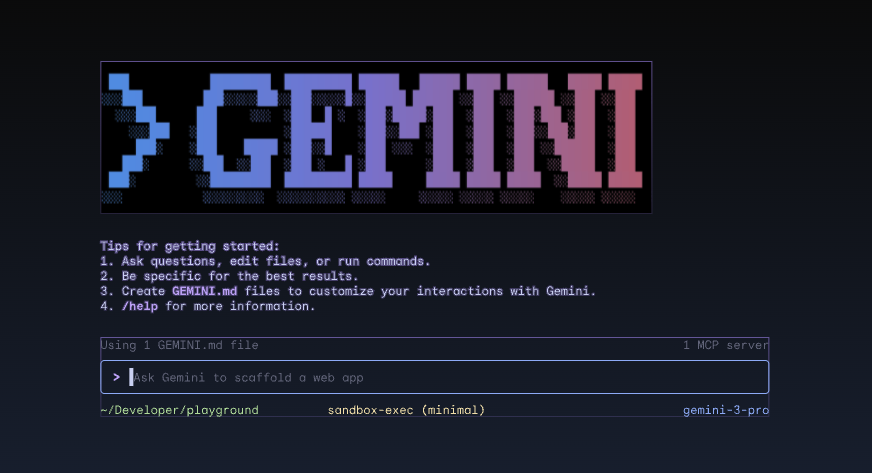

Gemini CLI ⚙️

Gemini CLI ( geminicli.com) ist ein Open-Source-KI-Agent, der die Leistungsfähigkeit von Gemini direkt in Ihr Terminal bringt. Es ist als terminalbasiertes, erweiterbares und leistungsstarkes Tool für Entwickler, Ingenieure, SREs und andere gedacht. Die Gemini CLI ist in Ihre lokale Umgebung eingebunden. Sie kann Dateien lesen und bearbeiten, Shell-Befehle ausführen und im Web suchen, wobei der Projektkontext beibehalten wird.

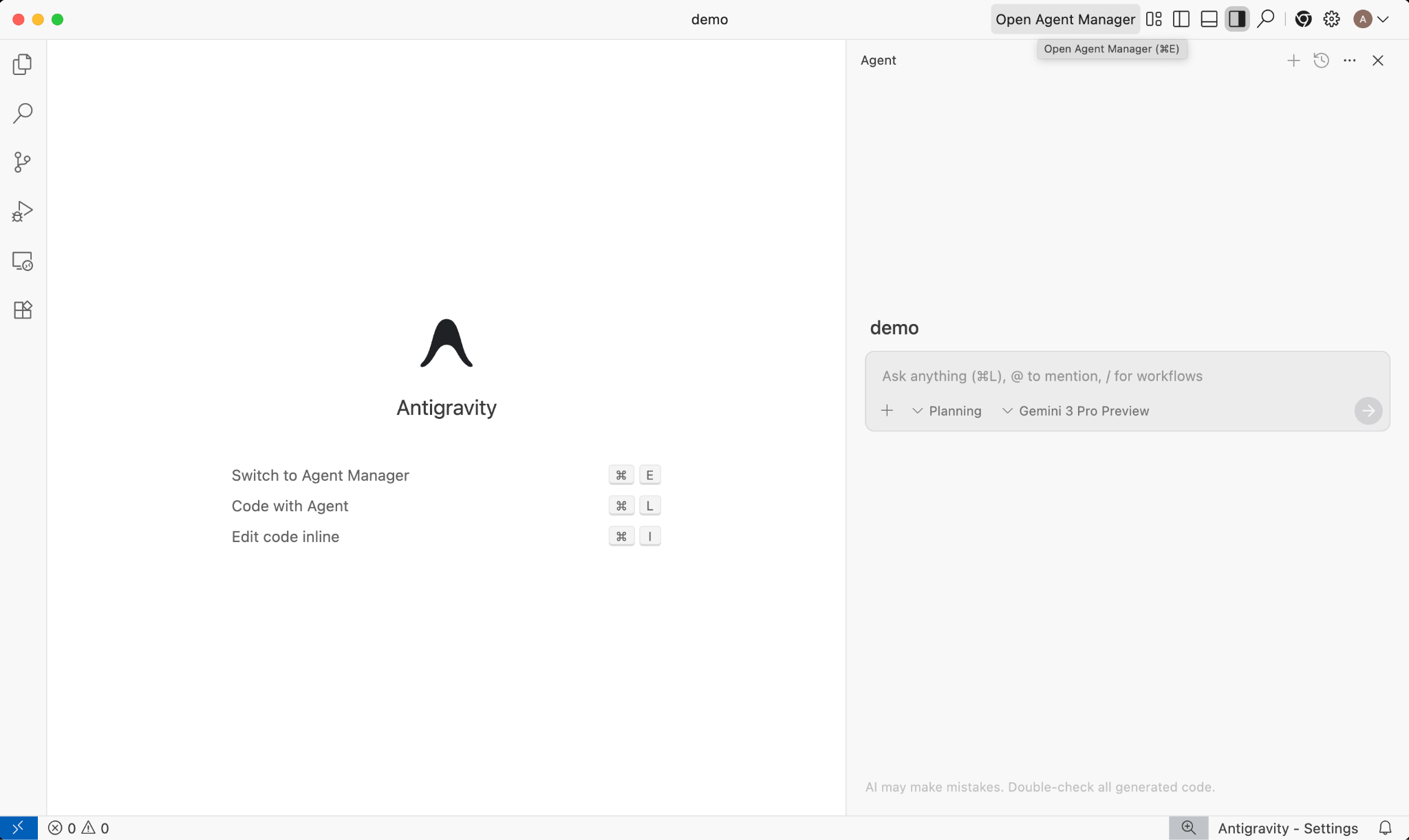

Google Antigravity 🚀

Google Antigravity ( antigravity.google) ist eine agentische Entwicklungsplattform, die die IDE in das Zeitalter der KI‑Agenten führt. Mit Antigravity können Entwickler auf einer höheren, aufgabenorientierten Ebene arbeiten und Agents in verschiedenen Arbeitsbereichen verwalten. Dabei bleibt die vertraute KI-IDE im Kern erhalten.

Antigravity extrahiert Agents in eine eigene Oberfläche und stellt ihnen die Tools zur Verfügung, die sie benötigen, um autonom im Editor, Terminal und Browser zu arbeiten. Dabei wird die Überprüfung und Kommunikation auf höherer Ebene über Aufgaben und Artefakte betont. Mit dieser Funktion können Agents komplexere End-to-End-Softwareaufgaben planen und ausführen. So lassen sich alle Aspekte der Entwicklung optimieren – von der Erstellung von Funktionen, der Benutzeroberflächen-Iteration und der Fehlerbehebung bis hin zu Recherche und Berichterstellung.

Sie können diese Tools gerne herunterladen und ausprobieren. Im Folgenden finden Sie einige allgemeine Hinweise dazu, wann Sie welches Tool verwenden sollten:

- Wenn Sie gerade erst anfangen, verwenden Sie wahrscheinlich die Gemini App, um Fragen zu stellen oder einfachen Code zu generieren.

- Wenn Sie eine Webanwendung mit Vibe-Code erstellen, ist Google AI Studio wahrscheinlich das Tool Ihrer Wahl.

- Wenn Sie eine komplexe Anwendung mit dem Kontext aus Ihrer lokalen Entwicklungsumgebung erstellen möchten, sollten Sie die Gemini CLI oder Google Antigravity verwenden.

- Wenn Sie Google Cloud bereitstellen oder bereits verwenden und Support und Funktionen auf Unternehmensniveau benötigen, ist Vertex AI mit seinem Studio die richtige Wahl.

Sie können diese Tools natürlich auch kombinieren. Sie können beispielsweise mit Vibe Coding in AI Studio beginnen, den Code in GitHub speichern und dann mit Antigravity weiter codieren und in Google Cloud bereitstellen.

4. Gemini-Modelle 🧠

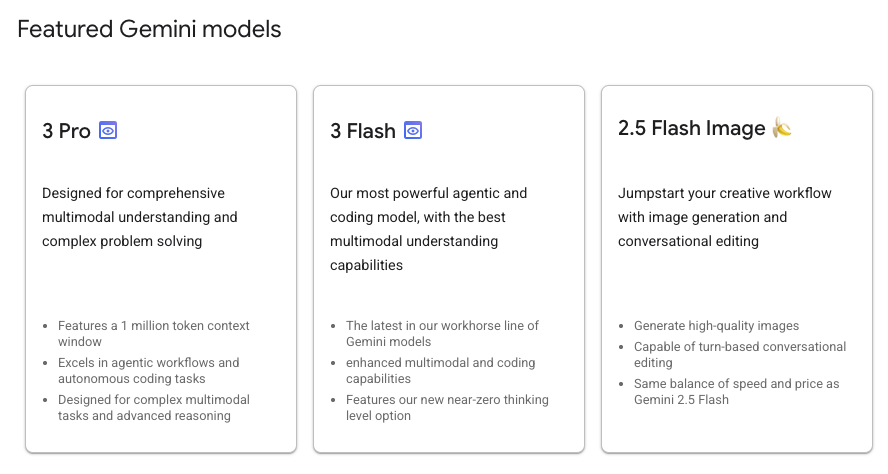

Gemini-Modelle werden ständig verbessert und alle paar Monate werden neue Versionen veröffentlicht. Aktuell (Februar 2026) sind dies die vorgestellten Modelle in Vertex AI in Google Cloud:

Es gibt viele andere allgemein verfügbare Gemini-Modelle, Gemini-Vorschaumodelle, die offenen Gemma-Modelle, Embedding-Modelle, Imagegen-Modelle, Veo-Modelle und mehr.

Auf der Dokumentationsseite Google-Modelle finden Sie Informationen zu den wichtigsten Modellen, die in Vertex AI für verschiedene Anwendungsfälle verfügbar sind.

5. Google Gen AI SDK 📦

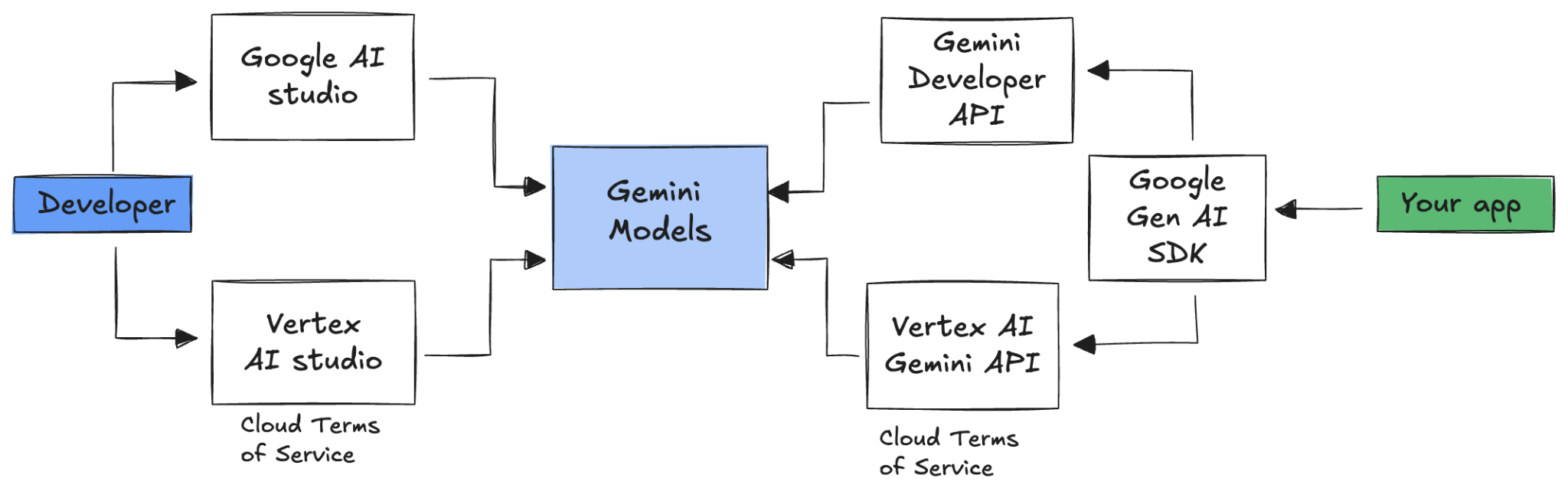

Wenn Sie Gemini in Ihre Anwendung einbinden möchten, können Sie das Google Gen AI SDK verwenden.

Wie bereits erwähnt, können Sie über Google AI Studio oder Vertex AI Studio auf Gemini-Modelle zugreifen. Das Google Gen AI SDK bietet eine einheitliche Schnittstelle zu Gemini-Modellen über die Google AI API und die Google Cloud API. Mit wenigen Ausnahmen kann Code, der auf einer Plattform ausgeführt wird, auf beiden ausgeführt werden.

Das Google Gen AI SDK unterstützt derzeit Python, Go, Node, Java und C#.

So würden Sie beispielsweise mit Gemini in Google AI in Python interagieren:

client = genai.Client(

api_key=your-gemini-api-key)

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Wenn Sie dasselbe für Gemini in Vertex AI ausführen möchten, müssen Sie nur die Clientinitialisierung ändern. Der Rest ist identisch:

client = genai.Client(

vertexai=True,

project=your-google-cloud-project,

location="us-central1")

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Wenn Sie diese Beispiele selbst ausführen möchten, können Sie main.py in github.com/meteatamel/genai-samples/tree/main/vertexai/gemini2/hello-world ausführen.

6. Interactions API 🔄

Die Interactions API (Beta) ist eine neue einheitliche Schnittstelle für die Interaktion mit Gemini-Modellen und ‑Agents. Als verbesserte Alternative zur generateContent API vereinfacht sie die Zustandsverwaltung, die Tool-Orchestrierung und lang andauernde Aufgaben.

So würde eine grundlegende Interaktion mit der neuen API aussehen:

interaction = client.interactions.create(

model="gemini-3-flash-preview",

input="Tell me a short joke."

)

print(interaction.outputs[-1].text)

Sie können eine zustandsorientierte Unterhaltung führen, indem Sie die Interaktions-ID aus der vorherigen Interaktion übergeben:

interaction1 = client.interactions.create(

model="gemini-3-flash-preview",

input="Hi, my name is Phil."

)

print(f"Model: {interaction1.outputs[-1].text}")

interaction2 = client.interactions.create(

model="gemini-3-flash-preview",

input="What is my name?",

previous_interaction_id=interaction1.id

)

print(f"Model: {interaction2.outputs[-1].text}")

Die Interactions API wurde für die Entwicklung von und Interaktion mit Agents entwickelt und bietet Unterstützung für Funktionsaufrufe, integrierte Tools, strukturierte Ausgaben und das Model Context Protocol (MCP). Informationen dazu, wie sie mit dem Deep Research-Agent verwendet werden kann, finden Sie unten im Schritt „Agents 🤖“.

Wenn Sie diese Beispiele selbst ausführen möchten, können Sie main.py unter github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api ausführen.

7. Großes Kontextfenster 🪟

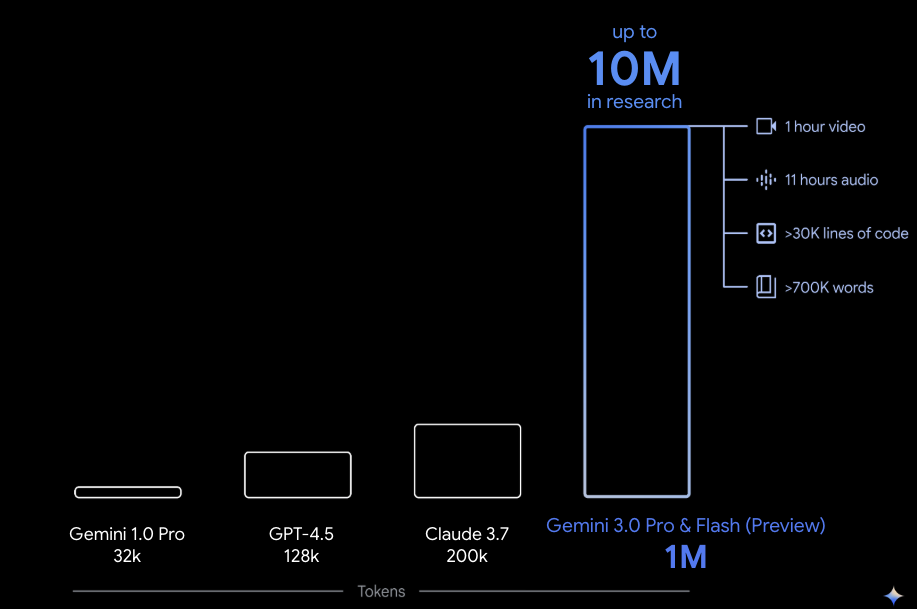

Viele Gemini-Modelle haben große Kontextfenster mit 1 Million oder mehr Tokens. Bisher waren Large Language Models (LLMs) durch die Menge an Text (oder Tokens) stark eingeschränkt, die dem Modell gleichzeitig übergeben werden konnten. Das große Kontextfenster von Gemini eröffnet viele neue Anwendungsfälle und Entwicklerparadigmen.

Wenn Sie das lange Kontextfenster in Aktion sehen möchten, rufen Sie die Vertex AI Studio Prompt Gallery auf und wählen Sie den Prompt Extract Video Chapters aus. In diesem Prompt wird der Videoinhalt in Kapitel unterteilt und für jedes Kapitel eine Zusammenfassung erstellt.

Wenn Sie das Skript mit dem bereitgestellten Video ausführen, sollte die Ausgabe in etwa so aussehen:

[

{

"timecode": "00:00",

"chapterSummary": "The video opens with scenic views of Rio de Janeiro, introducing the \"Marvelous City\" and its famous beaches like Ipanema and Copacabana, before pivoting to the existence of the favelas."

},

{

"timecode": "00:20",

"chapterSummary": "The narrator describes the favelas, home to one in five Rio residents, highlighting that while often associated with crime and poverty, this is only a small part of their story."

},

{

"timecode": "00:36",

"chapterSummary": "Google introduces its project to map the favelas, emphasizing that providing addresses to these uncharted areas is a crucial step in giving residents an identity."

},

{

"timecode": "00:43",

"chapterSummary": "The video concludes by focusing on the people of the favelas, inviting viewers to go beyond the map and explore their world through a 360-degree experience."

}

]

Das ist nur dank des langen Kontextfensters von Gemini möglich.

8. Thinking-Modus 🧠

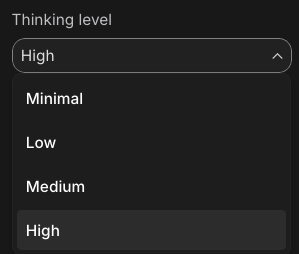

Die Gemini-Modelle verwenden einen internen Denkprozess, der ihre Fähigkeit, komplexe Aufgaben zu lösen, deutlich verbessert. Mit Denkebenen (Gemini 3) und Budgets (Gemini 2.5) wird das Denkverhalten gesteuert. Sie können auch das Flag include_thoughts aktivieren, um die Rohgedanken des Modells zu sehen.

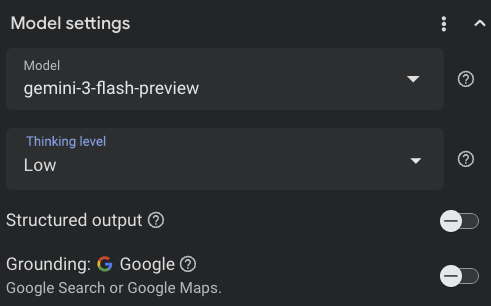

Um den Denkmodus in Aktion zu sehen, öffnen wir Google AI Studio ( ai.dev) und starten einen neuen Chat. In der rechten Seitenleiste können Sie die Denkebene festlegen:

Wenn Sie oben rechts auf die Schaltfläche Get code klicken, sehen Sie auch, wie Sie die Denkebene im Code festlegen können, etwa so:

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(

thinking_level="low",

include_thoughts=True

)

),

)

Experimentieren Sie mit verschiedenen Prompts und unterschiedlichen Denkebenen, um das Verhalten des Modells zu beobachten.

9. Tools 🧰

Gemini bietet eine Reihe integrierter Tools wie die Google Suche, Google Maps, Codeausführung, Computernutzung und Dateisuche. Mit Funktionsaufrufen können Sie auch benutzerdefinierte Tools definieren. Sehen wir uns kurz an, wie sie verwendet werden.

Google Suche 🔎

Sie können Modellantworten mit Google-Suchergebnissen fundieren, um genauere, aktuellere und relevantere Antworten zu erhalten.

In Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) oder Google AI Studio ( ai.dev) können Sie einen neuen Chat starten und darauf achten, dass die Google Suche-Fundierung deaktiviert ist:

Anschließend können Sie eine Frage zum heutigen Wetter an Ihrem Standort stellen. Beispiel:

How's the weather in London today?

Normalerweise erhalten Sie eine Antwort für einen Tag in der Vergangenheit, da das Modell keinen Zugriff auf die neuesten Informationen hat. Beispiel:

In London today (Friday, May 24, 2025), the weather is a bit of a mixed bag, typical for late May.

Aktivieren Sie jetzt die Fundierung der Google Suche und stellen Sie dieselbe Frage. Sie sollten aktuelle Wetterinformationen mit Links zu den zugrunde liegenden Quellen erhalten:

In London today (Wednesday, February 11, 2026), the weather is cool and mostly cloudy with a chance of light rain.

So würden Sie Google Suche in Ihren Code einbinden. Sie können auch in Vertex AI Studio auf die Schaltfläche „Code“ klicken, um ein Fundierungsbeispiel zu erhalten:

google_search_tool = Tool(google_search=GoogleSearch())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="How's the weather like today in London?",

config=GenerateContentConfig(tools=[google_search_tool])

)

Google Maps 🗺️

Sie können Modellantworten auch auf Google Maps stützen, das Zugriff auf Informationen zu über 250 Millionen Orten hat.

Wenn Sie das in Aktion sehen möchten, können Sie in den Modelleinstellungen in Vertex AI Studio im Bereich „Grounding“ Google Maps anstelle der Google Suche auswählen und eine Frage stellen, für die Maps-Daten erforderlich sind, z. B.:

Can you show me some Greek restaurants and their map coordinates near me?

Der Code dafür sieht in etwa so aus:

google_maps_tool = Tool(google_maps=GoogleMaps())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=""What are the best restaurants near here?",

config=GenerateContentConfig(tools=[google_maps_tool]),

# Optional: Provide location context (this is in Los Angeles)

tool_config=ToolConfig(

retrieval_config=types.RetrievalConfig(

lat_lng=types.LatLng(

latitude=34.050481, longitude=-118.248526))),

)

Codeausführung 🧑💻

Gemini kann Python-Code mit einer Liste unterstützter Bibliotheken (pandas, numpy, PyPDF2 usw.) generieren und ausführen. Dies ist nützlich für Anwendungen, die von codebasierten Schlussfolgerungen profitieren (z. B. zum Lösen von Gleichungen).

Wenn Sie diese Funktion ausprobieren möchten,wechseln Sie zu Google AI Studio, starten Sie einen neuen Chat und achten Sie darauf, dass die Ein/Aus-Schaltfläche Code execution aktiviert ist. Stellen Sie dann eine Frage, bei der das Tool zur Codeausführung nützlich sein könnte. Beispiel:

What is the sum of the first 50 prime numbers?

Gemini sollte Python-Code generieren und ausführen. Die richtige Antwort ist 5117.

Sie können das Codeausführungstool so aus dem Code heraus ausführen:

code_execution_tool = Tool(code_execution=ToolCodeExecution())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="What is the sum of the first 50 prime numbers?",

config=GenerateContentConfig(

tools=[code_execution_tool],

temperature=0))

Computernutzung 🖥️

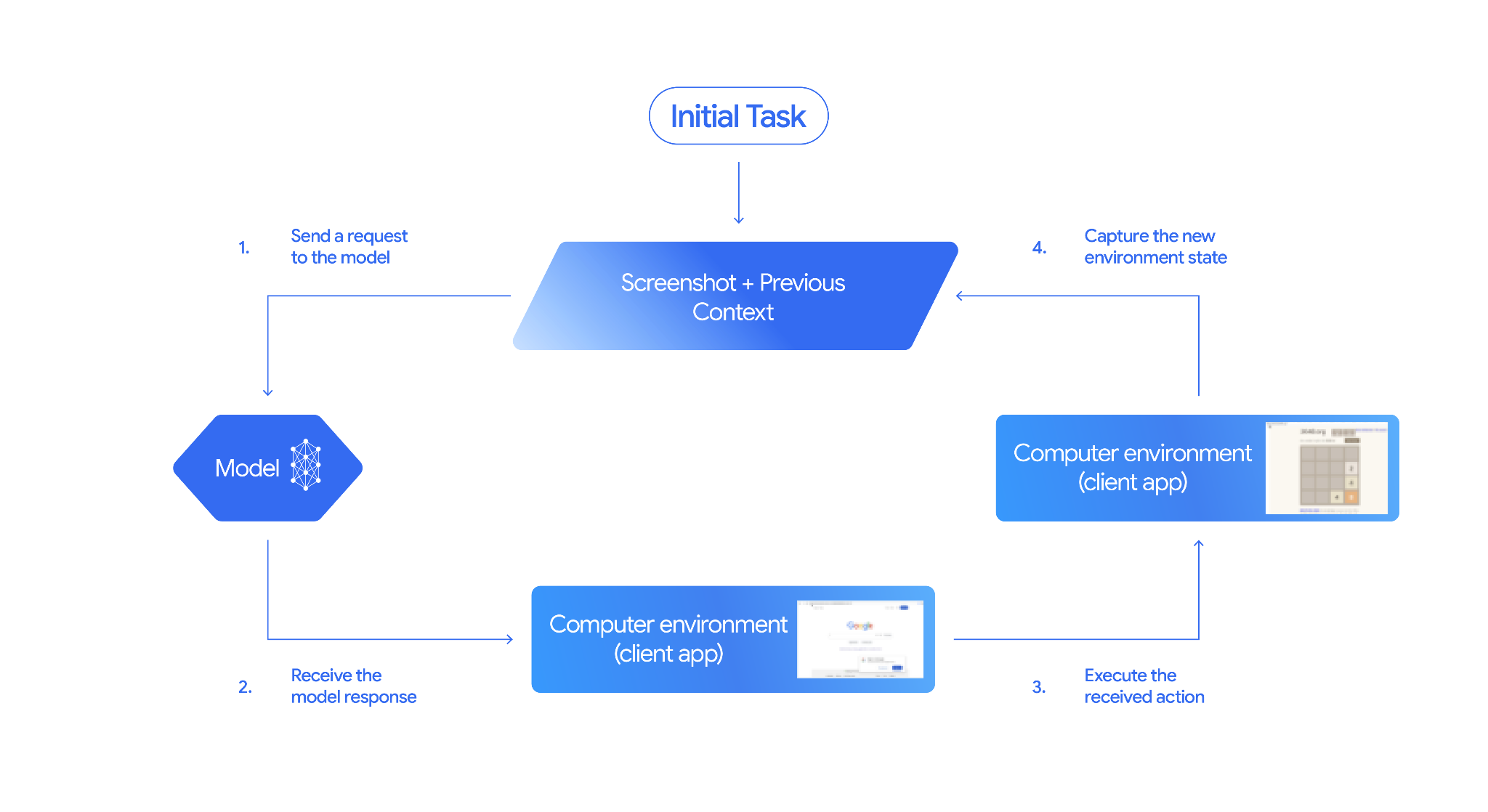

Mit dem Gemini-Modell für die Computernutzung (Vorabversion) können Sie Agents zur Browsersteuerung erstellen, um Aufgaben zu automatisieren. Das funktioniert so:

Wenn Sie sich das in Aktion ansehen möchten, können Sie main.py unter github.com/google-gemini/computer-use-preview ausführen.

Sie können beispielsweise Ihren API-Schlüssel aus Google AI Studio abrufen und Gemini bitten, nach Flügen für Sie zu suchen:

export GEMINI_API_KEY=your-api-key

python main.py --query "Find me top 5 fights sorted by price with the following constraints:

Flight site to use: www.google.com/travel/flights

From: London

To: Larnaca

One-way or roundtrip: One way

Date to leave: Sometime next week

Date to return: N/A

Travel preferences:

-Direct flights

-No flights before 10am

-Carry-on luggage"

Gemini sollte nun einen Inkognitobrowser öffnen und mit der Suche nach Flügen beginnen.

Dateisuche 📁

Mit dem Tool zur Dateisuche lässt sich Retrieval Augmented Generation (RAG) ganz einfach nutzen. Laden Sie einfach Ihre Dateien hoch. Die RAG-Details wie Chunking, Einbetten und Abrufen werden automatisch erledigt.

Um das in Aktion zu sehen, können Sie main.py unter github.com/meteatamel/genai-beyond-basics/blob/main/samples/grounding/file-search-tool ausführen.

Rufen Sie Ihren API-Schlüssel aus Google AI Studio ab und erstellen Sie einen Dateisuchspeicher:

export GEMINI_API_KEY=your-gemini-api-key

python main.py create_store my-file-search-store

So laden Sie ein PDF in den Store hoch:

python main.py upload_to_store fileSearchStores/myfilesearchstore-5a9x71ifjge9 cymbal-starlight-2024.pdf

Stellen Sie eine Frage zum PDF, die auf das Geschäft verweist:

python main.py generate_content "What's the cargo capacity of Cymbal Starlight?" fileSearchStores/myfilesearchstore-5a9x71ifjge9

Sie sollten eine Antwort erhalten, die auf der PDF-Datei basiert:

Generating content with file search store: fileSearchStores/myfilesearchstore-5a9x71ifjge9

Response: The Cymbal Starlight 2024 has a cargo capacity of 13.5 cubic feet, which is located in the trunk of the vehicle. It is important to distribute the weight evenly and not overload the trunk, as this could impact the vehicle's handling and stability. The vehicle can also accommodate up to two suitcases in the trunk, and it is recommended to use soft-sided luggage to maximize space and cargo straps to secure it while driving.

Grounding sources: cymbal-starlight-2024.pdf

Funktionsaufrufe 📲

Wenn die integrierten Tools nicht ausreichen, können Sie auch eigene Tools (Funktionen) in Gemini definieren. Sie senden einfach eine Python-Funktion als Tool (anstatt einer detaillierten OpenAPI-Spezifikation der Funktion). Es wird automatisch vom Modell und vom SDK als Tool verwendet.

Sie können beispielsweise eine Funktion haben, die den Breiten- und Längengrad eines Standorts zurückgibt:

def location_to_lat_long(location: str):

"""Given a location, returns the latitude and longitude

Args:

location: The location for which to get the weather.

Returns:

The latitude and longitude information in JSON.

"""

logger.info(f"Calling location_to_lat_long({location})")

url = f"https://geocoding-api.open-meteo.com/v1/search?name={location}&count=1"

return api_request(url)

Sie können auch eine Funktion verwenden, um die Wetterinformationen anhand von Breiten- und Längengrad zurückzugeben:

def lat_long_to_weather(latitude: str, longitude: str):

"""Given a latitude and longitude, returns the weather information

Args:

latitude: The latitude of a location

longitude: The longitude of a location

Returns:

The weather information for the location in JSON.

"""

logger.info(f"Calling lat_long_to_weather({latitude}, {longitude})")

url = (f"https://api.open-meteo.com/v1/forecast?latitude={latitude}&longitude={longitude}¤t=temperature_2m,"

f"relative_humidity_2m,surface_pressure,wind_speed_10m,wind_direction_10m&forecast_days=1")

return api_request(url)

Sie können diese beiden Funktionen jetzt als Tools an Gemini übergeben und damit die Wetterinformationen für einen Ort abrufen:

def generate_content_with_function_calls():

client = genai.Client(

vertexai=True,

project=PROJECT_ID,

location=LOCATION)

response = client.models.generate_content(

model=MODEL_ID,

contents=PROMPT,

config=GenerateContentConfig(

system_instruction=[

"You are a helpful weather assistant.",

"Your mission is to provide weather information for different cities."

"Make sure your responses are in plain text format (no markdown) and include all the cities asked.",

],

tools=[location_to_lat_long, lat_long_to_weather],

temperature=0),

)

print(response.text)

#print(response.automatic_function_calling_history)

Um die Funktion in Aktion zu sehen, können Sie main_genaisdk.py unter github.com/meteatamel/genai-beyond-basics/blob/main/samples/function-calling/weather ausführen.

10. KI-Agenten 🤖

Die Interactions API von Gemini wurde für die Entwicklung von und die Interaktion mit Agents entwickelt. Sie können spezielle Agents wie den Gemini Deep Research-Agent verwenden. Der Gemini Deep Research Agent plant, führt aus und fasst mehrstufige Rechercheaufgaben selbstständig zusammen. Es navigiert durch komplexe Informationslandschaften und verwendet die Websuche und Ihre eigenen Daten, um detaillierte Berichte mit Quellenangaben zu erstellen.

So verwenden Sie den Deep Research-Agent mit der Interaction API:

interaction = client.interactions.create(

input="Research the history of the Google TPUs.",

agent="deep-research-pro-preview-12-2025",

background=True

)

while True:

if interaction.status == "completed":

print("\nFinal Report:\n",

interaction.outputs[-1].text)

break

Wenn Sie dieses Beispiel selbst ausführen möchten, können Sie main.py unter github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api ausführen.

export GOOGLE_API_KEY=your-api-key

python main.py agent

Nach einer Weile sollten Sie die Rechercheergebnisse sehen:

User: Research the history of the Google TPUs with a focus on 2025 and 2026

Status: in_progress

Status: in_progress

Status: in_progress

...

Model Final Report:

# Architectural Convergence and Commercial Expansion: The History of Google TPUs (2015–2026)

## Key Findings

* **Strategic Pivot (2025):** Google transitioned the Tensor Processing Unit (TPU) from a primarily internal differentiator to a commercial merchant-silicon competitor, epitomized by the massive "Ironwood" (TPU v7) deployment and external sales strategy.

* **Technological Leap:** The introduction of TPU v7 "Ironwood" in 2025 marked a paradigm shift, utilizing 3nm process technology to deliver 42.5 exaFLOPS per pod, directly challenging NVIDIA's Blackwell architecture in the high-performance computing (HPC) sector.

...

11. Bildgenerierung 📷

Nano Banana 🍌 ist der Name für die nativen Funktionen von Gemini zur Bildgenerierung. Gemini kann Bilder in Unterhaltungen mit Text, Bildern oder einer Kombination aus beidem generieren und verarbeiten. So können Sie Visuals mit beispielloser Kontrolle erstellen, bearbeiten und optimieren.

Nano Banana bezieht sich auf zwei verschiedene Modelle, die in der Gemini API verfügbar sind:

- Nano Banana: Das Gemini 2.5 Flash Image-Modell (

gemini-2.5-flash-image). Dieses Modell ist auf Geschwindigkeit und Effizienz ausgelegt und für Aufgaben mit hohem Volumen und geringer Latenz optimiert. - Nano Banana Pro: Das Gemini 3 Pro Image-Vorschaumodell (

gemini-3-pro-image-preview). Dieses Modell wurde für die professionelle Asset-Produktion entwickelt. Es nutzt fortschrittliche Schlussfolgerungen, um komplexe Anweisungen zu befolgen und Text in hoher Qualität zu rendern.

Hier ist ein Code-Snippet, in dem Sie ein vorhandenes Bild übergeben und Nano Banana bitten können, das Bild zu bearbeiten:

from google import genai

from google.genai import types

from PIL import Image

client = genai.Client()

prompt = (

"Create a picture of my cat eating a nano-banana in a "

"fancy restaurant under the Gemini constellation",

)

image = Image.open("/path/to/cat_image.png")

response = client.models.generate_content(

model="gemini-2.5-flash-image",

contents=[prompt, image],

)

for part in response.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = part.as_image()

image.save("generated_image.png")

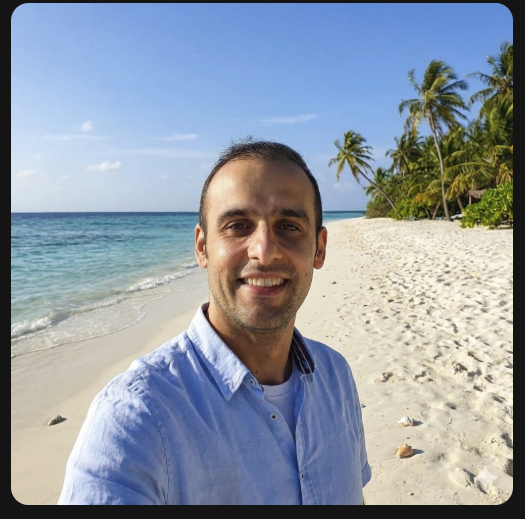

Nano Banana ist in der Gemini App, AI Studio oder Vertex AI Studio verfügbar. Am einfachsten können Sie die Funktion in der Gemini App ( gemini.google.com) ausprobieren. Wählen Sie dort unter Tools die Option 🍌 Create images aus. Laden Sie dann ein Bild hoch und probieren Sie etwas aus. Sagen Sie zum Beispiel:

Can you transform this picture of mine to a nice beach on a tropical island?

12. Text-to-Speech-Generierung 🎶

Mit den Gemini-TTS-Funktionen (Text-to-Speech) kann Gemini Texteingaben in Audio mit einem oder mehreren Sprechern umwandeln. Die TTS-Generierung ist steuerbar. Sie können also natürliche Sprache verwenden, um Interaktionen zu strukturieren und Stil, Akzent, Tempo und Ton des Audios zu bestimmen.

Es gibt zwei Modelle, die TTS unterstützen:

Die TTS-Funktion unterscheidet sich von der Sprachgenerierung über die Live API, die für interaktive, unstrukturierte Audioinhalte sowie multimodale Ein- und Ausgaben konzipiert ist. Die Live API eignet sich hervorragend für dynamische Konversationskontexte, während TTS über die Gemini API für Szenarien entwickelt wurde, in denen eine genaue Textwiedergabe mit detaillierter Steuerung von Stil und Klang erforderlich ist, z. B. bei der Generierung von Podcasts oder Hörbüchern.

Hier sehen Sie ein Code-Snippet für die TTS-Synthese mit einem einzelnen Sprecher:

from google import genai

from google.genai import types

import wave

# Set up the wave file to save the output:

def wave_file(filename, pcm, channels=1, rate=24000, sample_width=2):

with wave.open(filename, "wb") as wf:

wf.setnchannels(channels)

wf.setsampwidth(sample_width)

wf.setframerate(rate)

wf.writeframes(pcm)

client = genai.Client()

response = client.models.generate_content(

model="gemini-2.5-flash-preview-tts",

contents="Say cheerfully: Have a wonderful day!",

config=types.GenerateContentConfig(

response_modalities=["AUDIO"],

speech_config=types.SpeechConfig(

voice_config=types.VoiceConfig(

prebuilt_voice_config=types.PrebuiltVoiceConfig(

voice_name='Kore',

)

)

),

)

)

data = response.candidates[0].content.parts[0].inline_data.data

file_name='out.wav'

wave_file(file_name, data) # Saves the file to current directory

Weitere Beispiele finden Sie in der Dokumentation zur Sprachausgabe.

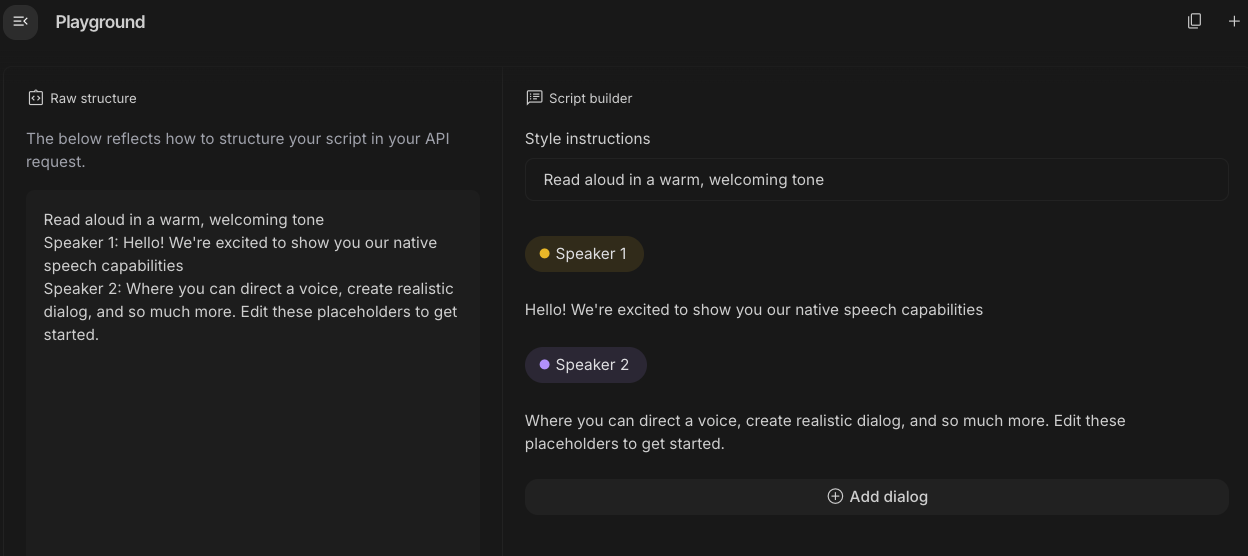

Sie können auch versuchen, Sprache im Google AI Studio-Playground zu generieren. Probieren Sie verschiedene Prompts in der App generate-speech aus:

13. Räumliches Verständnis 🌐

Gemini bietet eine fortschrittliche Objekterkennung und ein räumliches Verständnis.

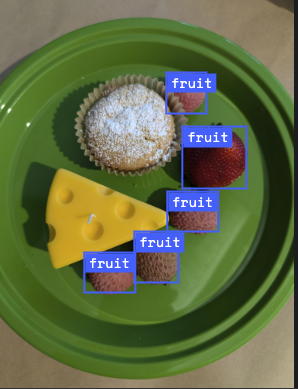

Am einfachsten ist es, sich das in der Praxis anzusehen. Rufen Sie die Spatial Understanding Starter App in AI Studio auf. Wählen Sie einige Bilder aus und versuchen Sie, mit Gemini einige Elemente im Bild zu erkennen.

Sie können beispielsweise „Schatten“ oder „Früchte“ in verschiedenen Bildern erkennen:

Probieren Sie verschiedene Bilder aus und sehen Sie, wie gut Gemini verschiedene Objekte erkennt und kennzeichnet.

14. Live API 🎤

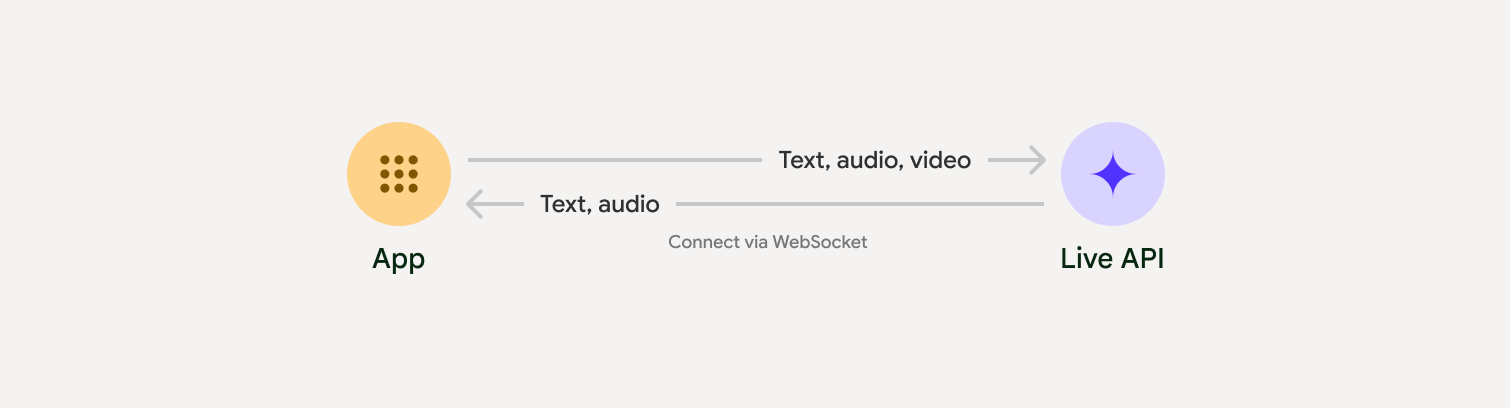

Die Live API ermöglicht latenzarme Sprach- und Videointeraktionen mit Gemini in Echtzeit. Es verarbeitet kontinuierliche Audio-, Video- oder Textstreams, um sofortige, menschenähnliche gesprochene Antworten zu liefern, und schafft so eine natürliche Konversationsumgebung für Ihre Nutzer.

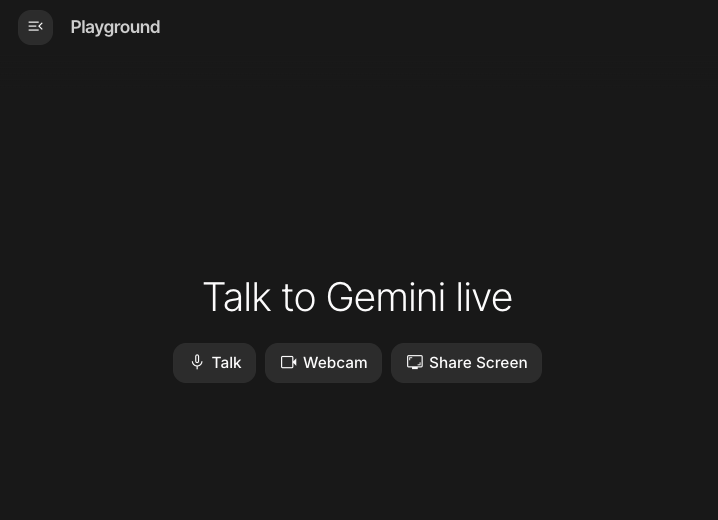

Probieren Sie die Live API in Google AI Studio oder die Live API in Vertex AI Studio aus. In beiden Apps können Sie Ihre Stimme, Ihr Video und Ihren Bildschirm teilen und eine Live-Unterhaltung mit Gemini führen.

Sie können jetzt Ihr Video oder Ihren Bildschirm teilen und Gemini per Spracheingabe allgemeine Fragen stellen. Beispiel:

Can you describe what you see on the screen?

Sie werden staunen, wie natürlich die Antworten von Gemini klingen.

15. Fazit

In diesem Codelab haben wir uns mit dem Gemini-Ökosystem befasst. Wir haben mit der Gemini-Produktfamilie begonnen und gelernt, wie wir die Modelle mit dem einheitlichen Google Gen AI SDK in unsere Anwendungen einbinden. Wir haben uns die innovativen Funktionen von Gemini angesehen, darunter das lange Kontextfenster, den Denkmodus, integrierte Grounding-Tools, die Live API und Spatial Understanding. Wir empfehlen Ihnen, sich die Referenzdokumente genauer anzusehen und weiter mit dem vollen Potenzial von Gemini zu experimentieren.