1. Introduction 👋

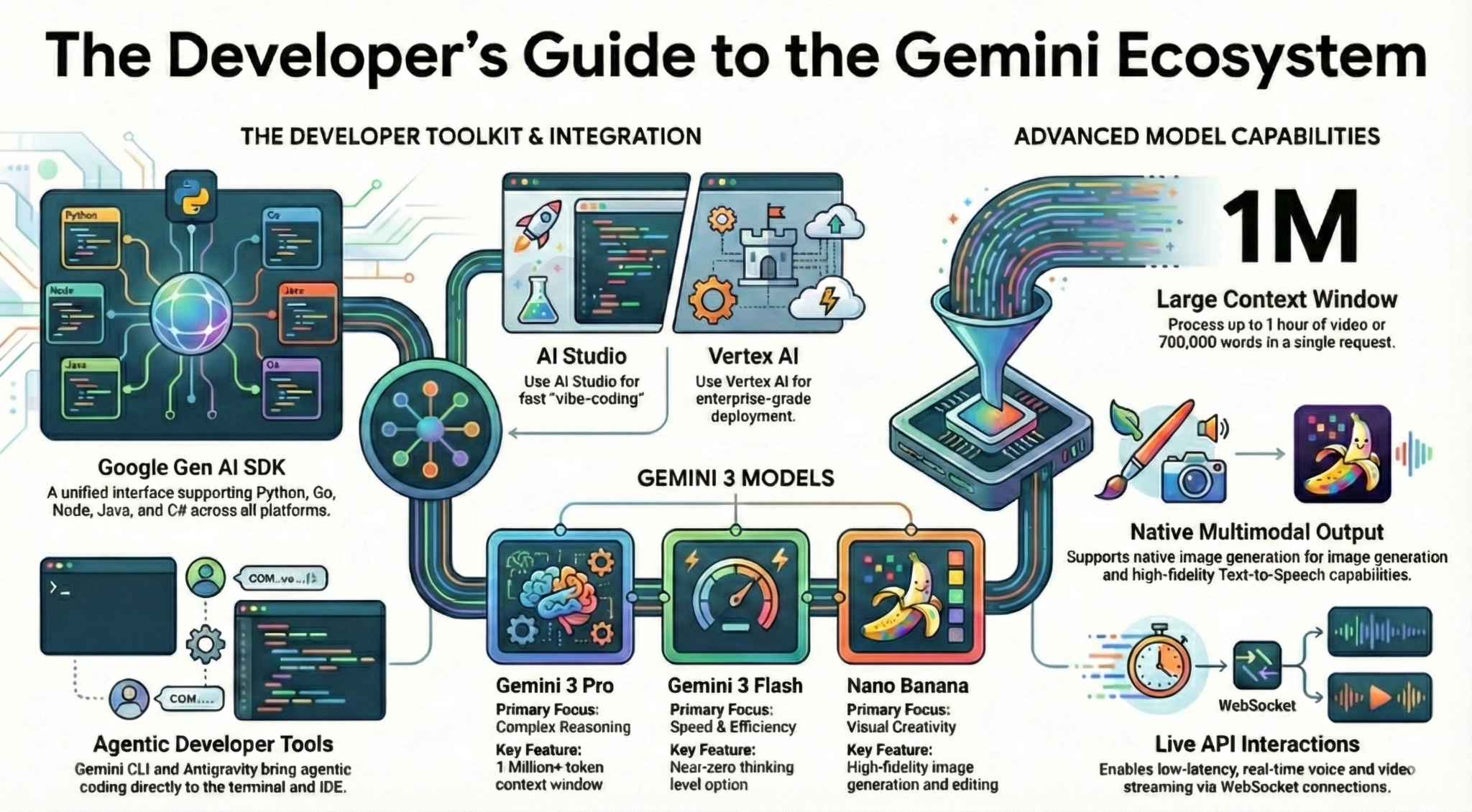

Dans cet atelier de programmation, vous apprendrez tout ce que vous devez savoir, en tant que développeur, sur l'écosystème Gemini. Plus précisément, vous découvrirez différents modèles Gemini, différents outils optimisés par Gemini et le SDK Google Gen AI pour l'intégration à Gemini. Vous explorerez également diverses fonctionnalités de Gemini, telles que son contexte long, son mode de réflexion, sa compréhension spatiale, l'API Live, la sortie audio et d'image native, et plus encore.

À la fin de cet atelier de programmation, vous devriez avoir une bonne compréhension de l'écosystème Gemini.

💡 Points abordés

- Différents modèles Gemini.

- Outils optimisés par les modèles Gemini.

- Découvrez comment intégrer Gemini à l'aide du SDK Google Gen AI.

- Grande fenêtre de contexte de Gemini.

- Mode de réflexion de Gemini.

- Différents outils intégrés tels que la recherche Google et Google Maps.

- Découvrez comment interagir avec les agents de recherche à l'aide de l'API Interactions.

- Génération d'images et de synthèse vocale.

- Compréhension spatiale de Gemini.

- API Live pour les interactions vocales et vidéo en temps réel.

⚠️ Ce dont vous aurez besoin

- Clé API pour les exemples Google AI Studio.

- Un projet Google Cloud avec la facturation activée pour les exemples Vertex AI.

- Votre environnement de développement local ou l'éditeur Cloud Shell dans Google Cloud.

2. La famille Gemini 🫂

Gemini est le modèle d'IA de Google qui donne vie à toutes vos idées. Il s'agit d'un excellent modèle pour la compréhension multimodale, le codage agentif et le vibe coding. Il repose sur une technologie de raisonnement à la pointe du secteur. Pour obtenir un aperçu rapide du modèle Gemini, regardez cette vidéo :

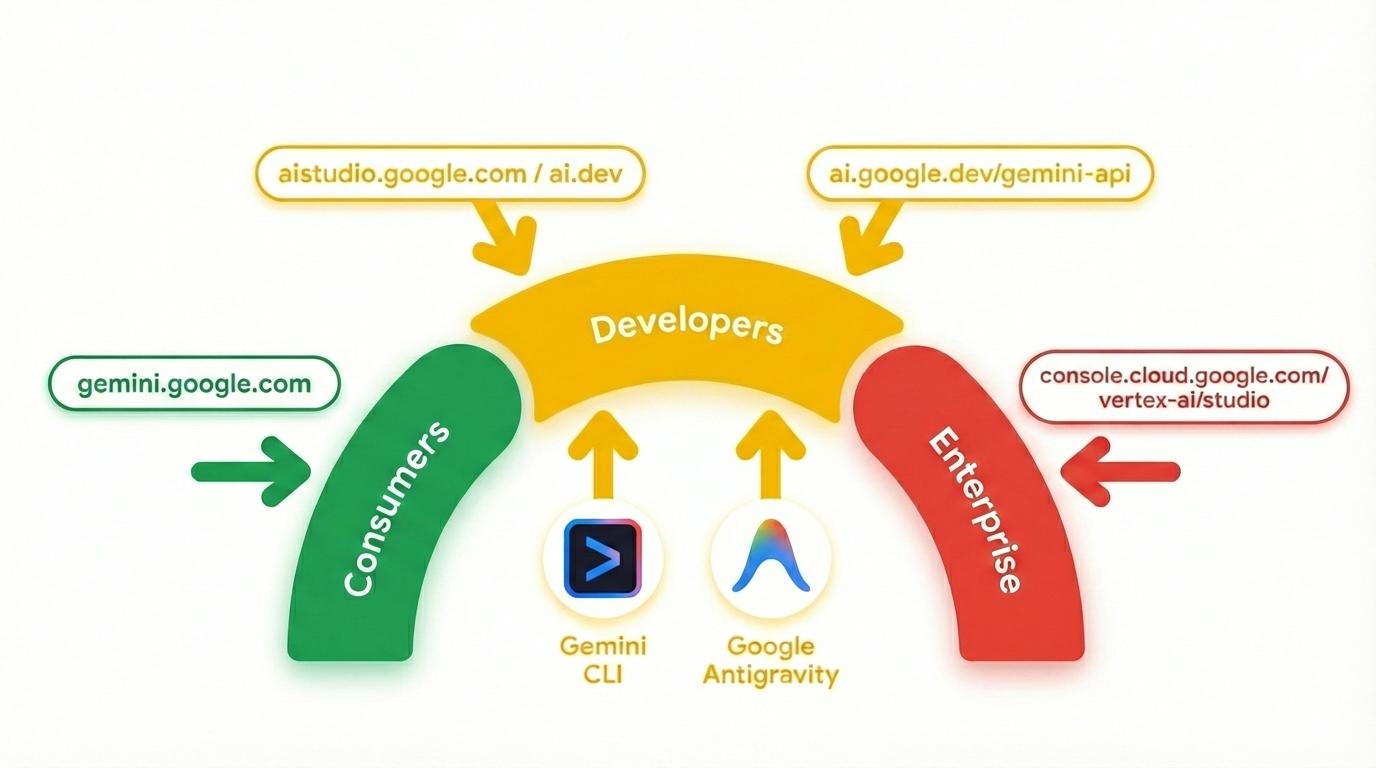

Gemini n'est pas qu'un modèle. Il s'agit également d'une marque ombrelle utilisée dans les produits Google.

qui utilisent le modèle Gemini. Il existe une gamme de produits Gemini, allant de l'application Gemini et de NotebookLM axés sur les consommateurs à AI Studio axé sur les développeurs et Vertex AI de Google Cloud axé sur les entreprises. Il existe également des outils pour les développeurs tels que Gemini CLI et Google Antigravity, optimisés par Gemini.

3. Outils optimisés par Gemini 🧰

Examinons brièvement les outils optimisés par Gemini.

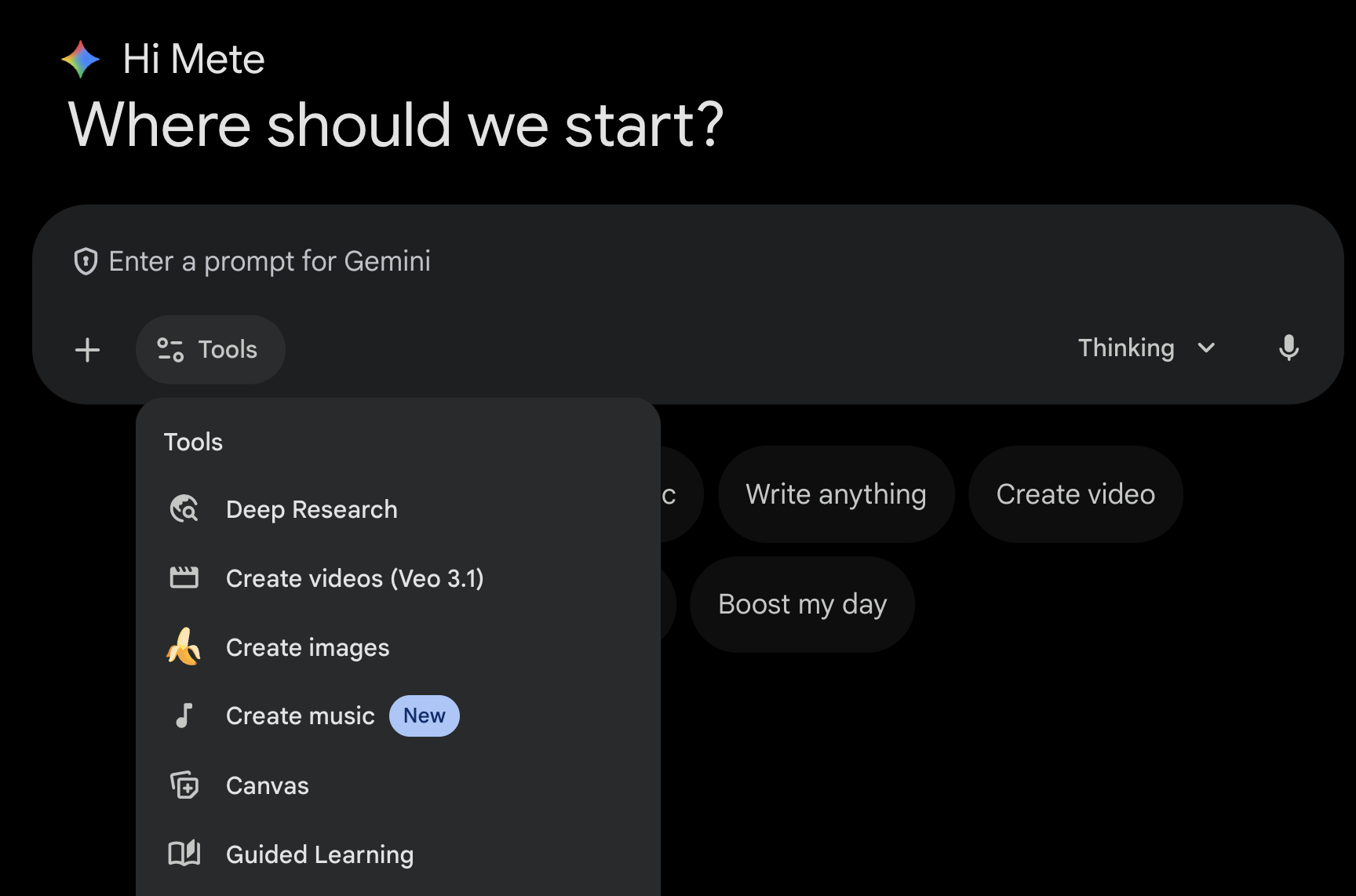

Application Gemini 💬

L'application Gemini ( gemini.google.com) est une application grand public basée sur le chat. C'est le moyen le plus simple d'interagir avec Gemini. Il propose des outils pour Deep Research, la génération d'images, de vidéos, de musique et plus encore. Il propose également différentes versions du dernier modèle Gemini (Rapide, Réfléchi, Pro). L'application Gemini est idéale pour une utilisation quotidienne.

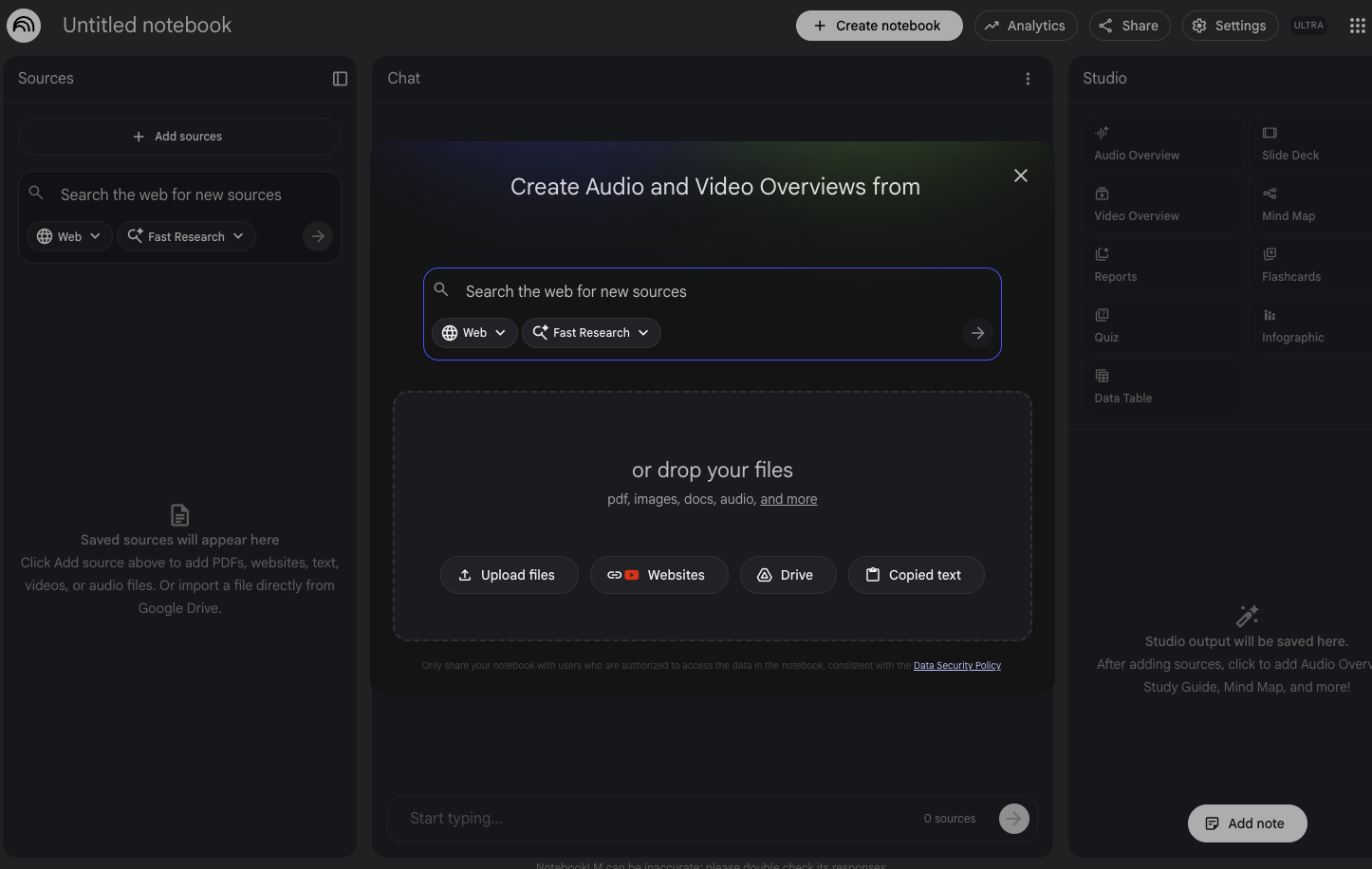

NotebookLM 📓

NotebookLM ( notebooklm.google.com) est un partenaire de recherche optimisé par l'IA. Importez des PDF, des sites Web, des vidéos YouTube, des fichiers audio, des documents Google Docs, des présentations Google Slides et plus encore. NotebookLM les résumera et établira des liens intéressants entre les thèmes grâce aux capacités de compréhension multimodale de la dernière version de Gemini. Il génère également des résumés audio et vidéo, des infographies et plus encore intéressants et attrayants à partir des sources que vous avez importées.

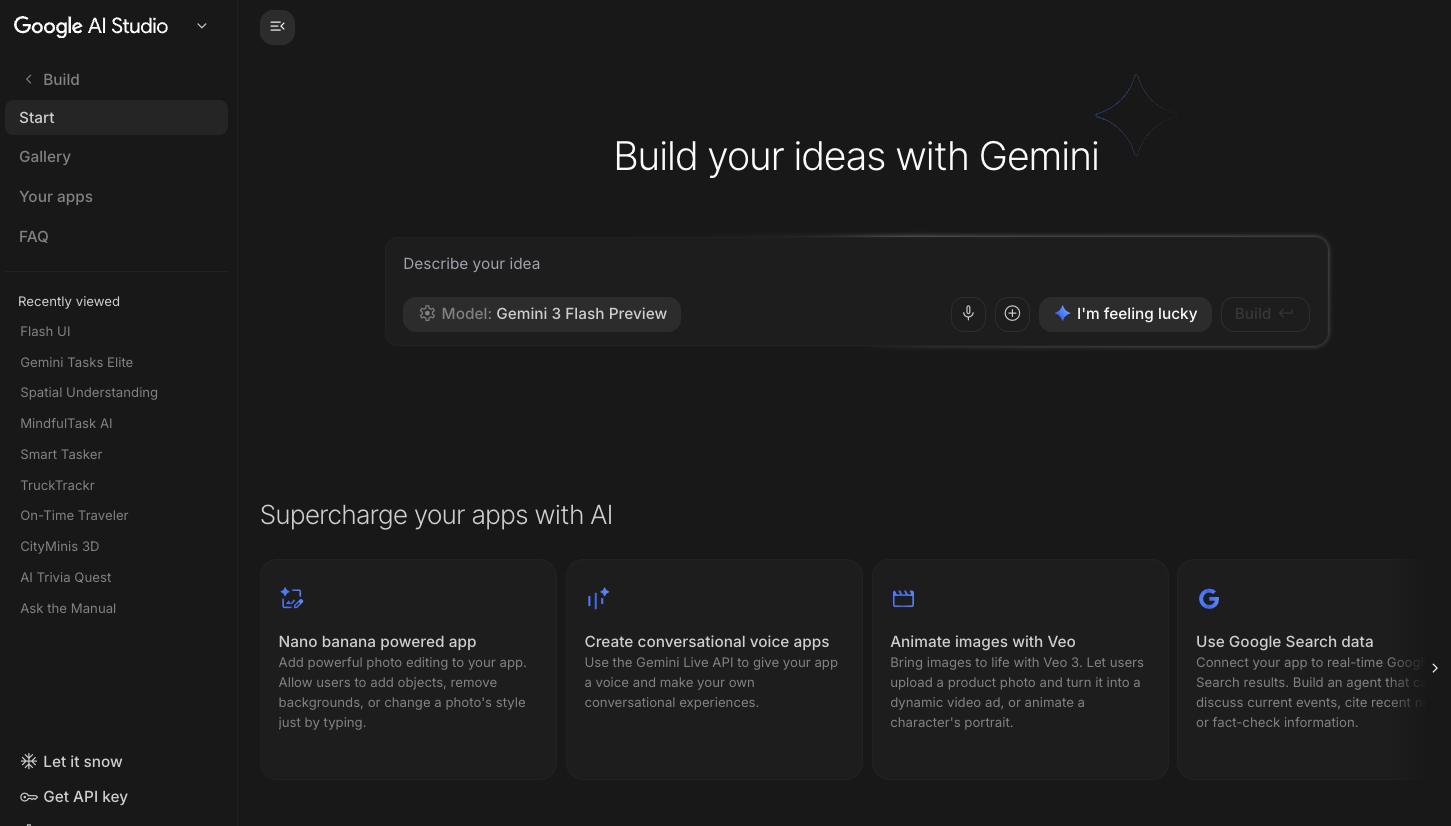

Google AI Studio 🎨

Google AI Studio ( ai.dev) est le moyen le plus rapide de commencer à créer avec Gemini. Le panneau Playground de Google AI Studio vous permet de tester différents modèles pour générer du texte, des images et des vidéos, mais aussi d'essayer la voix et la vidéo en temps réel avec l'API Gemini Live. Le panneau Build (Créer) de Google AI Studio vous permet de coder des applications Web et de les déployer sur Cloud Run sur Google Cloud, ainsi que d'envoyer le code vers GitHub.

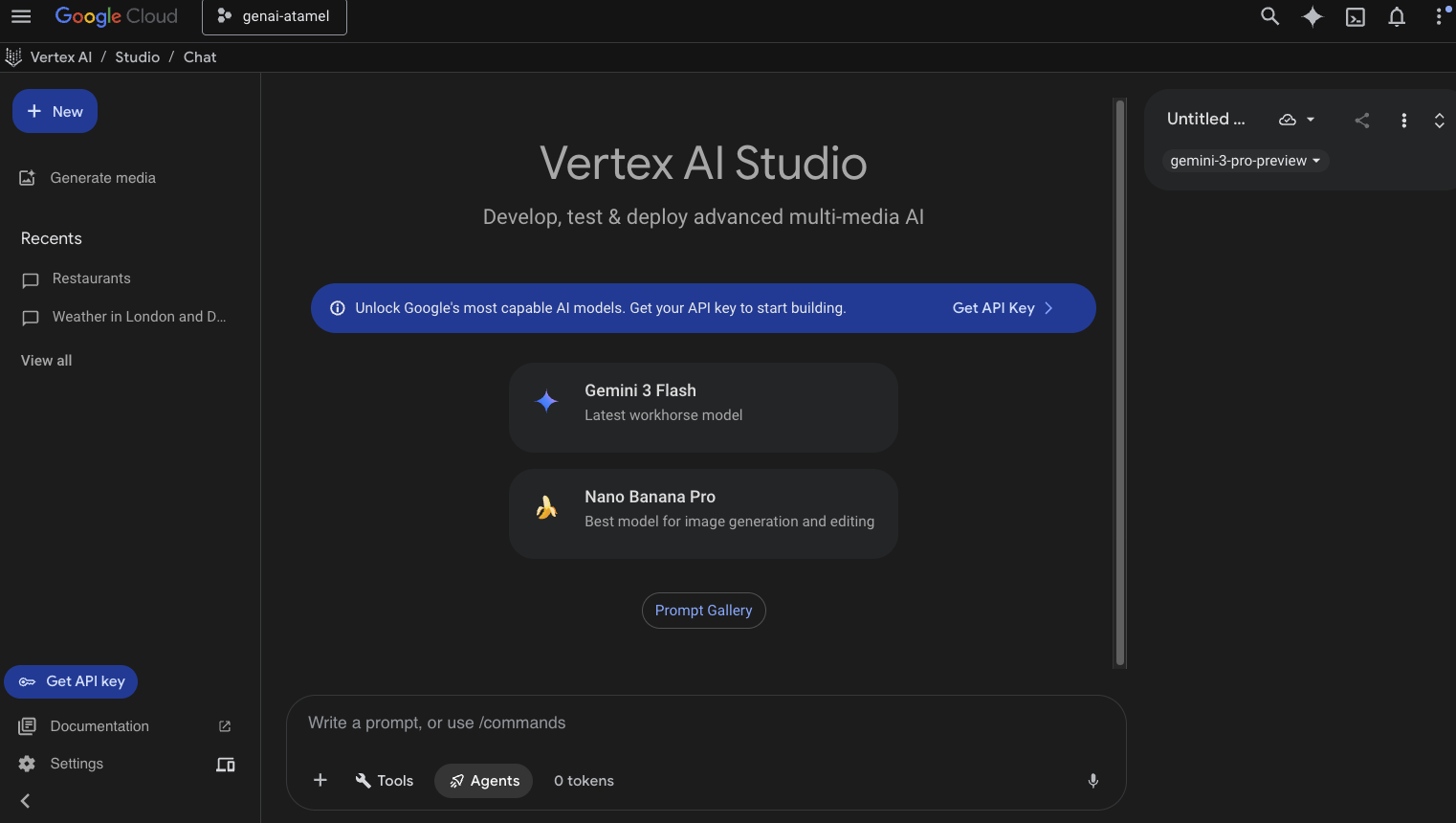

Vertex AI Studio ☁️

Vertex AI est une plate-forme de développement d'IA unifiée et entièrement gérée qui permet de créer et d'utiliser l'IA générative dans Google Cloud. Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) vous aide à tester, régler et déployer des applications d'IA générative adaptées aux entreprises.

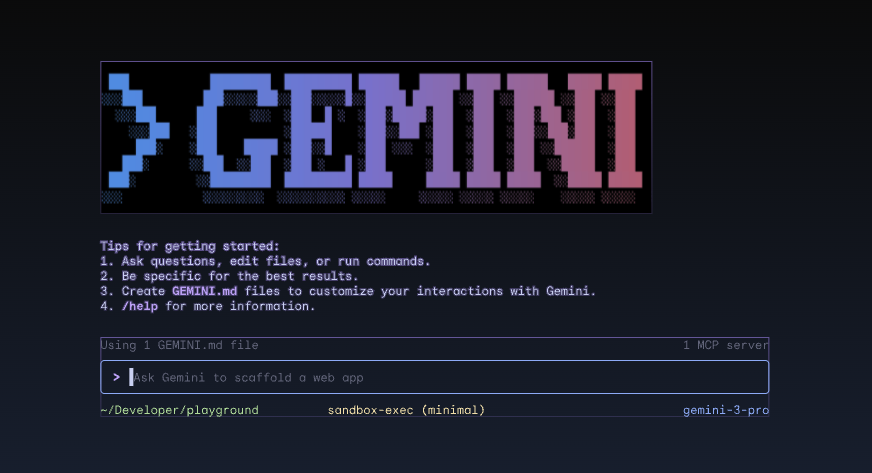

Gemini CLI ⚙️

Gemini CLI ( geminicli.com) est un agent d'IA Open Source qui vous permet d'exploiter la puissance de Gemini directement dans votre terminal. Il s'agit d'un outil puissant, extensible et axé sur le terminal, destiné aux développeurs, aux ingénieurs, aux SRE et à d'autres professionnels. Gemini CLI s'intègre à votre environnement local. Il peut lire et modifier des fichiers, exécuter des commandes shell et effectuer des recherches sur le Web, tout en conservant le contexte de votre projet.

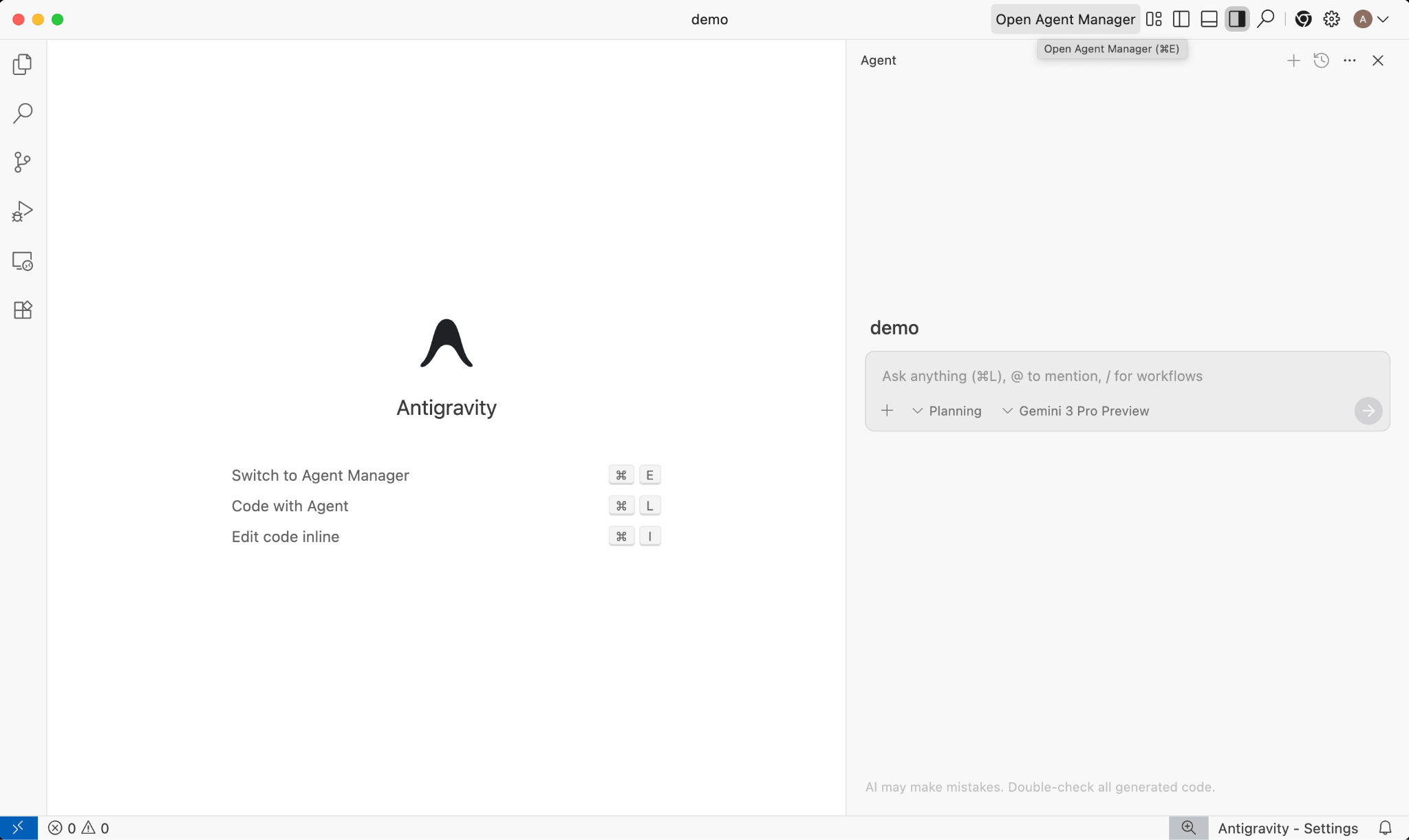

Google Antigravity 🚀

Google Antigravity ( antigravity.google) est une plate-forme de développement agentive qui fait évoluer l'IDE vers l'ère agentive. Antigravity permet aux développeurs de superviser leurs tâches à un niveau stratégique en gérant les agents dans les espaces de travail, tout en conservant une expérience d'IDE d'IA familière.

Antigravity extrait les agents dans leur propre surface et leur fournit les outils nécessaires pour fonctionner de manière autonome dans l'éditeur, le terminal et le navigateur, en mettant l'accent sur la vérification et la communication de niveau supérieur via des tâches et des artefacts. Cette fonctionnalité permet aux agents de planifier et d'exécuter des tâches logicielles de bout en bout plus complexes, ce qui améliore tous les aspects du développement, de la création de fonctionnalités à la correction de bugs, en passant par l'itération de l'UI, la recherche et la génération de rapports.

N'hésitez pas à télécharger ces outils et à les tester. Voici quelques conseils généraux pour vous aider à choisir l'outil approprié :

- Si vous débutez, vous utiliserez probablement l'application Gemini pour poser des questions ou générer du code de base.

- Si vous codez une application Web, Google AI Studio est probablement l'outil que vous choisirez.

- Si vous souhaitez créer une application complexe avec le contexte de votre environnement de développement local, choisissez Gemini CLI ou Google Antigravity.

- Si vous souhaitez déployer ou utilisez déjà Google Cloud et que vous souhaitez bénéficier d'une assistance et de fonctionnalités de niveau Enterprise, Vertex AI et son studio sont les outils qu'il vous faut.

Bien sûr, vous pouvez combiner ces outils. Par exemple, commencez par le vibe coding dans AI Studio pour transférer le code vers GitHub, puis utilisez Antigravity pour continuer à coder et à déployer sur Google Cloud.

4. Modèles Gemini 🧠

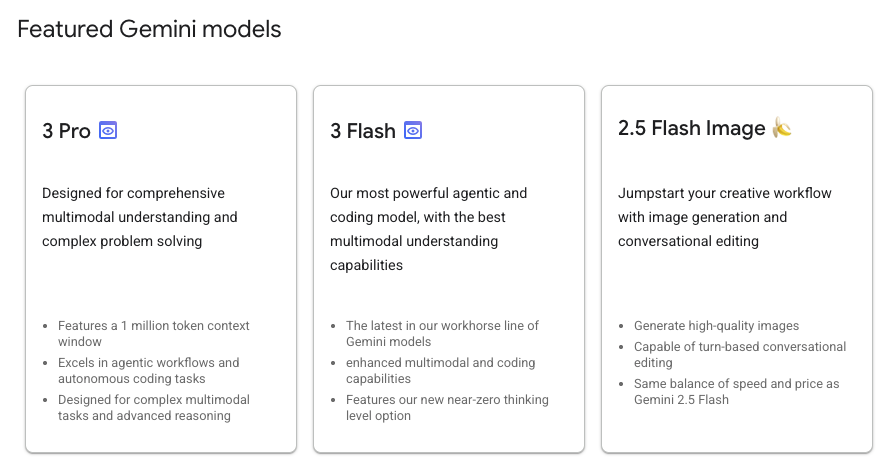

Les modèles Gemini s'améliorent constamment grâce à de nouvelles versions publiées tous les quelques mois. Voici les modèles mis en avant sur Vertex AI sur Google Cloud (en février 2026) :

De nombreux autres modèles Gemini disponibles en disponibilité générale, modèles Gemini en version Preview, modèles Gemma ouverts, modèles d'embedding, modèles Imagegen, modèles Veo et plus encore sont disponibles.

Consultez la page de documentation Modèles Google pour découvrir les principaux modèles disponibles sur Vertex AI pour différents cas d'utilisation.

5. SDK Google Gen AI 📦

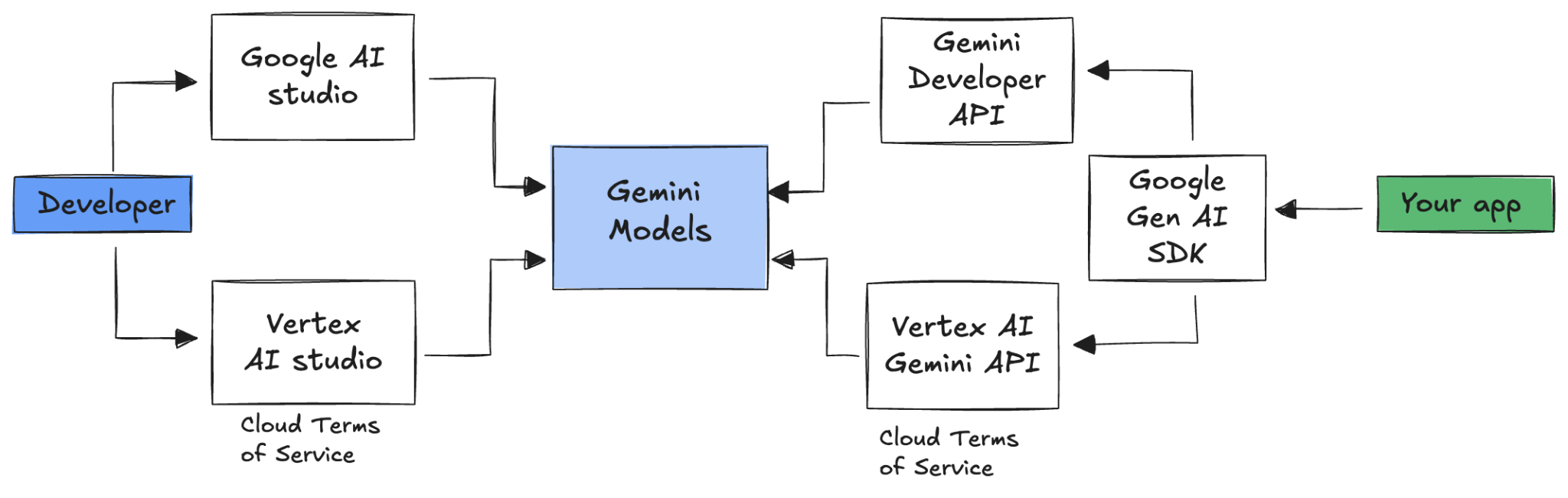

Pour intégrer Gemini à votre application, vous pouvez utiliser le SDK Google Gen AI.

Comme nous l'avons vu précédemment, vous pouvez accéder aux modèles Gemini via Google AI Studio ou Vertex AI Studio. Le SDK Google Gen AI fournit une interface unifiée pour les modèles Gemini à l'aide de l'API Google AI et de l'API Google Cloud. À quelques exceptions près, le code qui s'exécute sur une plate-forme fonctionnera sur les deux.

Le SDK Google Gen AI est actuellement compatible avec Python, Go, Node, Java et C#.

Par exemple, voici comment vous pouvez parler à Gemini dans Google AI en Python :

client = genai.Client(

api_key=your-gemini-api-key)

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Pour faire de même avec Gemini dans Vertex AI, il vous suffit de modifier l'initialisation du client. Le reste est identique :

client = genai.Client(

vertexai=True,

project=your-google-cloud-project,

location="us-central1")

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Pour exécuter ces exemples vous-même, vous pouvez exécuter main.py dans github.com/meteatamel/genai-samples/tree/main/vertexai/gemini2/hello-world.

6. API Interactions 🔄

L'API Interactions (bêta) est une nouvelle interface unifiée permettant d'interagir avec les modèles et les agents Gemini. Cette API, qui constitue une alternative améliorée à l'API generateContent, simplifie la gestion de l'état, l'orchestration des outils et les tâches de longue durée.

Voici comment interagir de base avec la nouvelle API :

interaction = client.interactions.create(

model="gemini-3-flash-preview",

input="Tell me a short joke."

)

print(interaction.outputs[-1].text)

Vous pouvez avoir une conversation avec état en transmettant l'ID d'interaction de l'interaction précédente :

interaction1 = client.interactions.create(

model="gemini-3-flash-preview",

input="Hi, my name is Phil."

)

print(f"Model: {interaction1.outputs[-1].text}")

interaction2 = client.interactions.create(

model="gemini-3-flash-preview",

input="What is my name?",

previous_interaction_id=interaction1.id

)

print(f"Model: {interaction2.outputs[-1].text}")

L'API Interactions est conçue pour créer des agents et interagir avec eux. Elle est compatible avec l'appel de fonctions, les outils intégrés, les sorties structurées et le protocole MCP (Model Context Protocol). Pour découvrir comment l'utiliser avec l'agent Deep Research, consultez l'étape "Agents 🤖" ci-dessous.

Pour exécuter ces exemples vous-même, vous pouvez exécuter main.py dans github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api.

7. Fenêtre de contexte longue 🪟

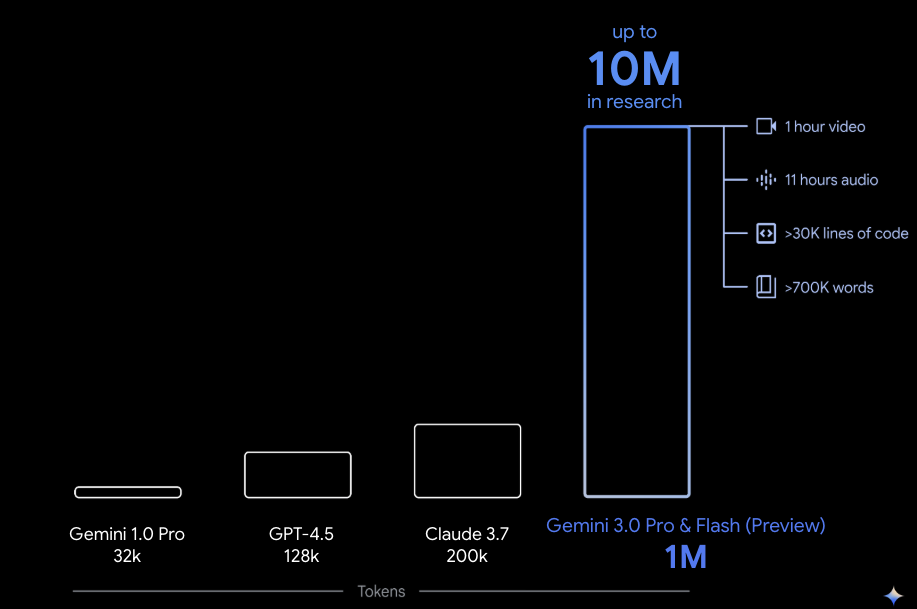

De nombreux modèles Gemini sont fournis avec de grandes fenêtres de contexte d'un million de jetons ou plus. Auparavant, les grands modèles de langage (LLM) étaient considérablement limités par la quantité de texte (ou de jetons) pouvant être transmise au modèle en même temps. La grande fenêtre de contexte de Gemini déverrouille de nombreux nouveaux cas d'utilisation et paradigmes pour les développeurs.

Pour voir la fenêtre de contexte étendu en action, vous pouvez accéder à la galerie de prompts Vertex AI Studio et choisir le prompt Extract Video Chapters. Cette requête regroupe le contenu vidéo en chapitres et fournit un résumé pour chacun d'eux.

Une fois que vous l'aurez exécuté avec la vidéo fournie, vous devriez obtenir un résultat semblable à ce qui suit :

[

{

"timecode": "00:00",

"chapterSummary": "The video opens with scenic views of Rio de Janeiro, introducing the \"Marvelous City\" and its famous beaches like Ipanema and Copacabana, before pivoting to the existence of the favelas."

},

{

"timecode": "00:20",

"chapterSummary": "The narrator describes the favelas, home to one in five Rio residents, highlighting that while often associated with crime and poverty, this is only a small part of their story."

},

{

"timecode": "00:36",

"chapterSummary": "Google introduces its project to map the favelas, emphasizing that providing addresses to these uncharted areas is a crucial step in giving residents an identity."

},

{

"timecode": "00:43",

"chapterSummary": "The video concludes by focusing on the people of the favelas, inviting viewers to go beyond the map and explore their world through a 360-degree experience."

}

]

C'est possible grâce à la grande fenêtre de contexte de Gemini.

8. Mode Réflexion 🧠

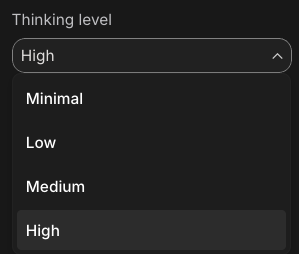

Les modèles Gemini utilisent un processus de réflexion interne qui améliore considérablement leur raisonnement pour les tâches complexes. Les niveaux de réflexion (Gemini 3) et les budgets (Gemini 2.5) contrôlent le comportement de réflexion. Vous pouvez également activer l'indicateur include_thoughts pour afficher les réflexions brutes du modèle.

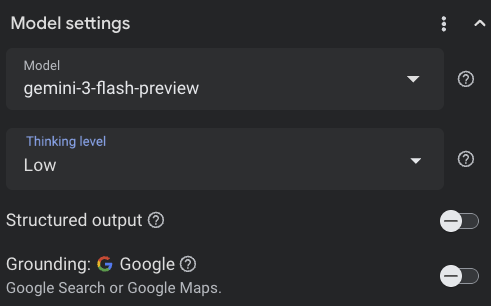

Pour voir le mode réflexion en action, ouvrez Google AI Studio ( ai.dev) et lancez une nouvelle discussion. Dans le panneau de droite, vous pouvez définir le niveau de réflexion :

Si vous cliquez sur le bouton Get code en haut à droite, vous pouvez également voir comment définir le niveau de réflexion dans le code, comme ceci :

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(

thinking_level="low",

include_thoughts=True

)

),

)

Testez différentes requêtes et différents niveaux de réflexion pour observer le comportement du modèle.

9. Outils 🧰

Gemini est fourni avec un certain nombre d'outils intégrés, tels que la recherche Google, Google Maps, l'exécution de code, l'utilisation de l'ordinateur, la recherche de fichiers et plus encore. Vous pouvez également définir vos outils personnalisés avec l'appel de fonction. Voyons brièvement comment les utiliser.

Recherche Google 🔎

Vous pouvez ancrer les réponses du modèle dans les résultats de recherche Google pour obtenir des réponses plus précises, plus à jour et plus pertinentes.

Dans Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) ou Google AI Studio ( ai.dev), vous pouvez démarrer une nouvelle discussion et vous assurer que l'ancrage à la recherche Google est désactivé :

Vous pouvez ensuite poser une question sur la météo du jour dans votre région. Exemple :

How's the weather in London today?

Vous recevez généralement une réponse pour un jour passé, car le modèle n'a pas accès aux dernières informations. Exemple :

In London today (Friday, May 24, 2025), the weather is a bit of a mixed bag, typical for late May.

Maintenant, activez l'ancrage avec la recherche Google et posez la même question. Vous devriez obtenir des informations météorologiques à jour avec des liens vers les sources de référence :

In London today (Wednesday, February 11, 2026), the weather is cool and mostly cloudy with a chance of light rain.

Voici comment ancrer la recherche Google dans votre code. Vous pouvez également cliquer sur le bouton "Code" dans Vertex AI Studio pour obtenir un exemple d'ancrage :

google_search_tool = Tool(google_search=GoogleSearch())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="How's the weather like today in London?",

config=GenerateContentConfig(tools=[google_search_tool])

)

Google Maps 🗺️

Vous pouvez également ancrer les réponses du modèle dans Google Maps, qui a accès à des informations sur plus de 250 millions de lieux.

Pour le voir en action, vous pouvez choisir Google Maps au lieu de la recherche Google dans la section "Ancrage" des paramètres du modèle dans Vertex AI Studio, puis poser une question nécessitant des données Maps, par exemple :

Can you show me some Greek restaurants and their map coordinates near me?

Le code se présente comme suit :

google_maps_tool = Tool(google_maps=GoogleMaps())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=""What are the best restaurants near here?",

config=GenerateContentConfig(tools=[google_maps_tool]),

# Optional: Provide location context (this is in Los Angeles)

tool_config=ToolConfig(

retrieval_config=types.RetrievalConfig(

lat_lng=types.LatLng(

latitude=34.050481, longitude=-118.248526))),

)

Exécution de code 🧑💻

Gemini peut générer et exécuter du code Python avec une liste de bibliothèques compatibles (pandas, numpy, PyPDF2, etc.). Cette fonctionnalité est utile pour les applications qui bénéficient d'un raisonnement basé sur du code (par exemple, la résolution d'équations).

Pour essayer cette fonctionnalité, passez à Google AI Studio, lancez une nouvelle discussion et assurez-vous que le bouton Code execution est activé. Posez ensuite une question pour laquelle l'outil d'exécution de code pourrait être utile. Exemple :

What is the sum of the first 50 prime numbers?

Gemini devrait générer du code Python et l'exécuter. La bonne réponse est 5 117.

Vous pouvez exécuter l'outil d'exécution de code à partir du code comme suit :

code_execution_tool = Tool(code_execution=ToolCodeExecution())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="What is the sum of the first 50 prime numbers?",

config=GenerateContentConfig(

tools=[code_execution_tool],

temperature=0))

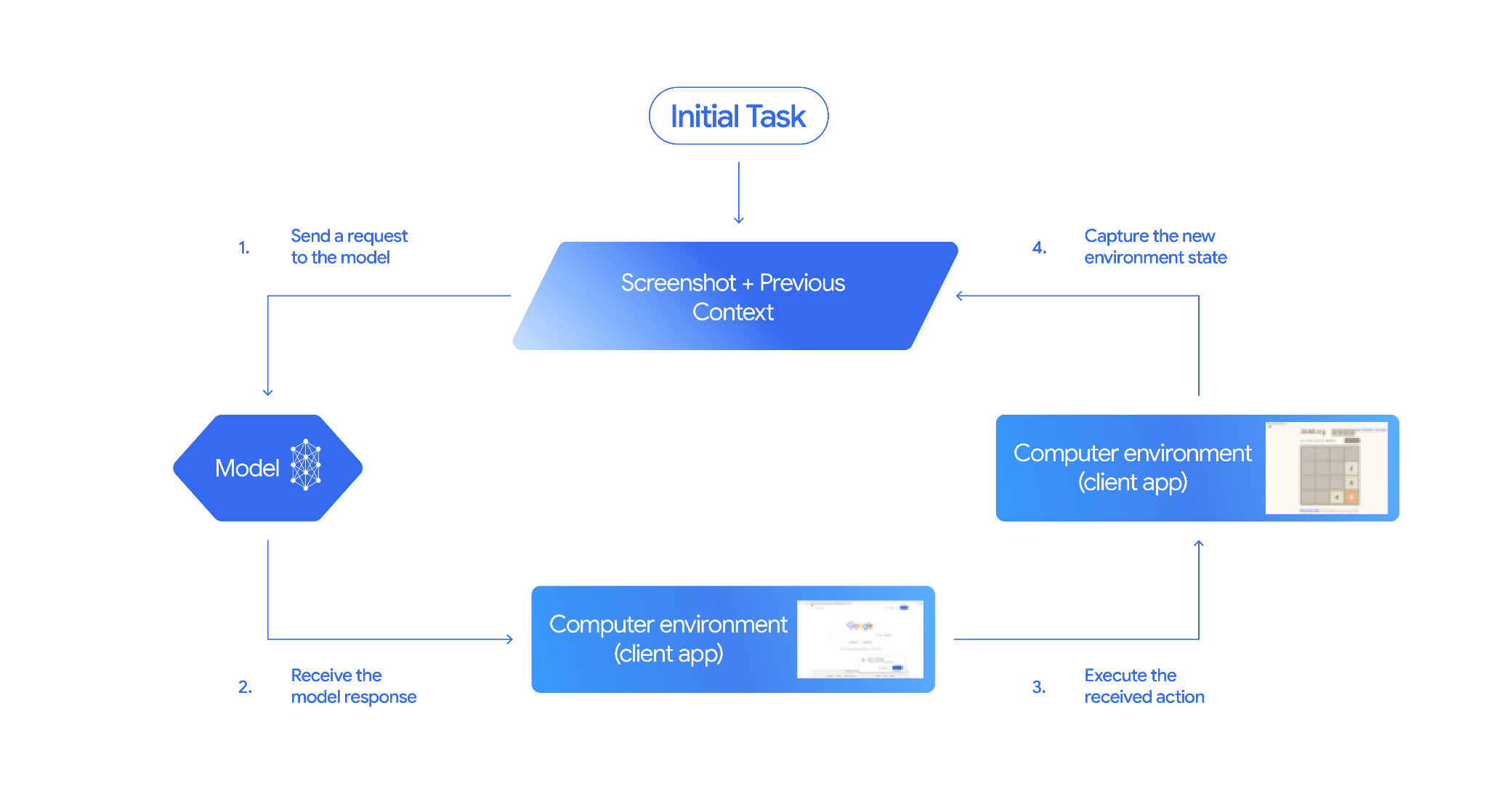

Utilisation d'un ordinateur 🖥️

Le modèle Gemini Computer Use (preview) vous permet de créer des agents de contrôle du navigateur pour automatiser des tâches. Voici comment cela fonctionne :

Pour le voir en action, vous pouvez exécuter main.py dans github.com/google-gemini/computer-use-preview.

Par exemple, vous pouvez obtenir votre clé API depuis Google AI Studio et demander à Gemini de rechercher des vols pour vous :

export GEMINI_API_KEY=your-api-key

python main.py --query "Find me top 5 fights sorted by price with the following constraints:

Flight site to use: www.google.com/travel/flights

From: London

To: Larnaca

One-way or roundtrip: One way

Date to leave: Sometime next week

Date to return: N/A

Travel preferences:

-Direct flights

-No flights before 10am

-Carry-on luggage"

Gemini devrait ouvrir un navigateur en mode navigation privée et commencer à rechercher des vols pour vous.

Recherche de fichiers 📁

L'outil de recherche de fichiers permet une génération augmentée par récupération (RAG) sans effort. Il vous suffit d'importer vos fichiers. L'outil s'occupe de tous les détails de la RAG (segmentation, intégration et récupération).

Pour le voir en action, vous pouvez exécuter main.py dans github.com/meteatamel/genai-beyond-basics/blob/main/samples/grounding/file-search-tool.

Obtenez votre clé API depuis Google AI Studio et créez un magasin de recherche de fichiers :

export GEMINI_API_KEY=your-gemini-api-key

python main.py create_store my-file-search-store

Importez un PDF dans la boutique :

python main.py upload_to_store fileSearchStores/myfilesearchstore-5a9x71ifjge9 cymbal-starlight-2024.pdf

Posez une question sur le PDF qui pointe vers le magasin :

python main.py generate_content "What's the cargo capacity of Cymbal Starlight?" fileSearchStores/myfilesearchstore-5a9x71ifjge9

Vous devriez obtenir une réponse basée sur le PDF :

Generating content with file search store: fileSearchStores/myfilesearchstore-5a9x71ifjge9

Response: The Cymbal Starlight 2024 has a cargo capacity of 13.5 cubic feet, which is located in the trunk of the vehicle. It is important to distribute the weight evenly and not overload the trunk, as this could impact the vehicle's handling and stability. The vehicle can also accommodate up to two suitcases in the trunk, and it is recommended to use soft-sided luggage to maximize space and cargo straps to secure it while driving.

Grounding sources: cymbal-starlight-2024.pdf

Appel de fonction 📲

Si les outils intégrés ne suffisent pas, vous pouvez également définir vos propres outils (fonctions) dans Gemini. Il vous suffit d'envoyer une fonction Python en tant qu'outil (au lieu d'envoyer une spécification OpenAPI détaillée de la fonction). Il est automatiquement utilisé comme outil par le modèle et le SDK.

Par exemple, vous pouvez créer une fonction pour renvoyer la latitude et la longitude d'un lieu :

def location_to_lat_long(location: str):

"""Given a location, returns the latitude and longitude

Args:

location: The location for which to get the weather.

Returns:

The latitude and longitude information in JSON.

"""

logger.info(f"Calling location_to_lat_long({location})")

url = f"https://geocoding-api.open-meteo.com/v1/search?name={location}&count=1"

return api_request(url)

Vous pouvez également créer une fonction pour renvoyer les informations météorologiques à partir d'une latitude et d'une longitude :

def lat_long_to_weather(latitude: str, longitude: str):

"""Given a latitude and longitude, returns the weather information

Args:

latitude: The latitude of a location

longitude: The longitude of a location

Returns:

The weather information for the location in JSON.

"""

logger.info(f"Calling lat_long_to_weather({latitude}, {longitude})")

url = (f"https://api.open-meteo.com/v1/forecast?latitude={latitude}&longitude={longitude}¤t=temperature_2m,"

f"relative_humidity_2m,surface_pressure,wind_speed_10m,wind_direction_10m&forecast_days=1")

return api_request(url)

Vous pouvez désormais transmettre ces deux fonctions en tant qu'outils à Gemini et le laisser les utiliser pour récupérer les informations météorologiques d'un lieu :

def generate_content_with_function_calls():

client = genai.Client(

vertexai=True,

project=PROJECT_ID,

location=LOCATION)

response = client.models.generate_content(

model=MODEL_ID,

contents=PROMPT,

config=GenerateContentConfig(

system_instruction=[

"You are a helpful weather assistant.",

"Your mission is to provide weather information for different cities."

"Make sure your responses are in plain text format (no markdown) and include all the cities asked.",

],

tools=[location_to_lat_long, lat_long_to_weather],

temperature=0),

)

print(response.text)

#print(response.automatic_function_calling_history)

Pour voir une démonstration, vous pouvez exécuter main_genaisdk.py dans github.com/meteatamel/genai-beyond-basics/blob/main/samples/function-calling/weather.

10. Agents 🤖

L'API Interactions de Gemini est conçue pour créer des agents et interagir avec eux. Vous pouvez utiliser des agents spécialisés comme l'agent Gemini Deep Research. L'agent Gemini Deep Research planifie, exécute et synthétise de manière autonome les tâches de recherche en plusieurs étapes. Il explore des ensembles d'informations complexes à l'aide de la recherche sur le Web et de vos propres données pour produire des rapports détaillés et cités.

Voici comment utiliser l'agent Deep Research avec l'API Interaction :

interaction = client.interactions.create(

input="Research the history of the Google TPUs.",

agent="deep-research-pro-preview-12-2025",

background=True

)

while True:

if interaction.status == "completed":

print("\nFinal Report:\n",

interaction.outputs[-1].text)

break

Pour exécuter cet exemple vous-même, vous pouvez exécuter main.py dans github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api.

export GOOGLE_API_KEY=your-api-key

python main.py agent

Au bout d'un moment, vous devriez voir les recherches effectuées :

User: Research the history of the Google TPUs with a focus on 2025 and 2026

Status: in_progress

Status: in_progress

Status: in_progress

...

Model Final Report:

# Architectural Convergence and Commercial Expansion: The History of Google TPUs (2015–2026)

## Key Findings

* **Strategic Pivot (2025):** Google transitioned the Tensor Processing Unit (TPU) from a primarily internal differentiator to a commercial merchant-silicon competitor, epitomized by the massive "Ironwood" (TPU v7) deployment and external sales strategy.

* **Technological Leap:** The introduction of TPU v7 "Ironwood" in 2025 marked a paradigm shift, utilizing 3nm process technology to deliver 42.5 exaFLOPS per pod, directly challenging NVIDIA's Blackwell architecture in the high-performance computing (HPC) sector.

...

11. Génération d'images 📷

Nano Banana 🍌 est le nom des fonctionnalités de génération d'images natives de Gemini. Gemini peut générer et traiter des images de manière conversationnelle avec du texte, des images ou une combinaison des deux. Vous pouvez ainsi créer, modifier et améliorer des éléments visuels avec un contrôle sans précédent.

Nano Banana fait référence à deux modèles distincts disponibles dans l'API Gemini :

- Nano Banana : modèle Gemini 2.5 Flash Image (

gemini-2.5-flash-image). Ce modèle est conçu pour la rapidité et l'efficacité, et optimisé pour les tâches à volume élevé et à faible latence. - Nano Banana Pro : modèle Gemini 3 Pro Image Preview (

gemini-3-pro-image-preview). Ce modèle est conçu pour la production d'assets professionnels. Il utilise un raisonnement avancé pour suivre des instructions complexes et générer du texte haute fidélité.

Voici un extrait de code dans lequel vous pouvez transmettre une image existante et demander à Nano Banana de la retoucher :

from google import genai

from google.genai import types

from PIL import Image

client = genai.Client()

prompt = (

"Create a picture of my cat eating a nano-banana in a "

"fancy restaurant under the Gemini constellation",

)

image = Image.open("/path/to/cat_image.png")

response = client.models.generate_content(

model="gemini-2.5-flash-image",

contents=[prompt, image],

)

for part in response.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = part.as_image()

image.save("generated_image.png")

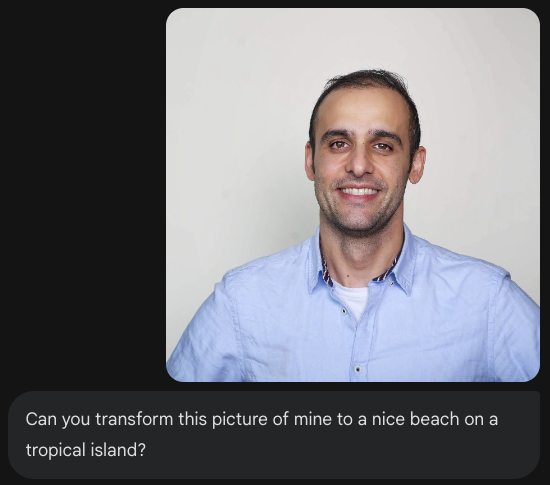

Nano Banana est disponible dans l'application Gemini, AI Studio ou Vertex AI Studio. Le moyen le plus simple de l'essayer est dans l'application Gemini. Dans l'application Gemini ( gemini.google.com), sélectionnez 🍌 Create images sous Tools. Importez ensuite une image et amusez-vous. Par exemple, vous pouvez énoncer les commandes suivantes :

Can you transform this picture of mine to a nice beach on a tropical island?

12. Génération de texte en parole 🎶

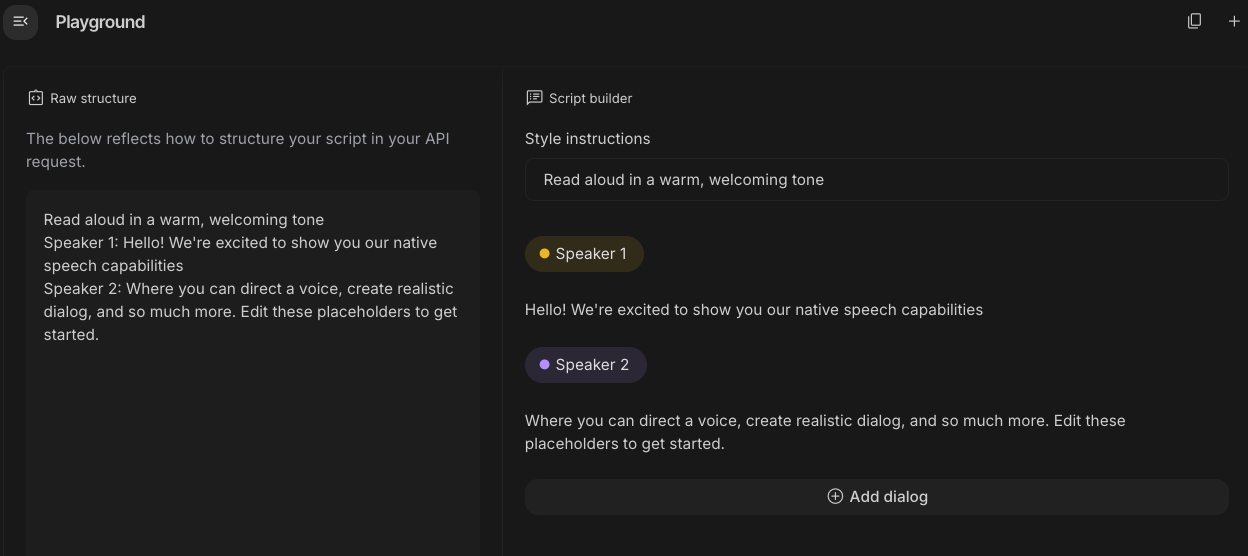

Gemini peut transformer une entrée de texte en audio à une ou plusieurs voix à l'aide de ses fonctionnalités de synthèse vocale (TTS). La génération de TTS est contrôlable, ce qui signifie que vous pouvez utiliser le langage naturel pour structurer les interactions et guider le style, l'accent, le rythme et le ton de l'audio.

Deux modèles sont compatibles avec la synthèse vocale :

La fonctionnalité TTS diffère de la génération vocale fournie par l'API Live, qui est conçue pour les entrées et sorties audio, multimodales et interactives non structurées. Alors que l'API Live excelle dans les contextes conversationnels dynamiques, la synthèse vocale via l'API Gemini est conçue pour les scénarios qui nécessitent une récitation exacte du texte avec un contrôle précis du style et du son, comme la génération de podcasts ou de livres audio.

Voici un extrait de code pour la synthèse vocale à une seule voix :

from google import genai

from google.genai import types

import wave

# Set up the wave file to save the output:

def wave_file(filename, pcm, channels=1, rate=24000, sample_width=2):

with wave.open(filename, "wb") as wf:

wf.setnchannels(channels)

wf.setsampwidth(sample_width)

wf.setframerate(rate)

wf.writeframes(pcm)

client = genai.Client()

response = client.models.generate_content(

model="gemini-2.5-flash-preview-tts",

contents="Say cheerfully: Have a wonderful day!",

config=types.GenerateContentConfig(

response_modalities=["AUDIO"],

speech_config=types.SpeechConfig(

voice_config=types.VoiceConfig(

prebuilt_voice_config=types.PrebuiltVoiceConfig(

voice_name='Kore',

)

)

),

)

)

data = response.candidates[0].content.parts[0].inline_data.data

file_name='out.wav'

wave_file(file_name, data) # Saves the file to current directory

Vous trouverez d'autres exemples dans la documentation sur la génération de synthèse vocale.

Vous pouvez également essayer de générer de la parole dans l'atelier Google AI Studio. Testez différentes requêtes dans l'application generate-speech :

13. Compréhension spatiale 🌐

Gemini dispose d'une détection d'objets et d'une compréhension spatiale avancées.

Le meilleur moyen de comprendre ce concept est de le voir en action. Accédez à l'application de démarrage de compréhension spatiale dans AI Studio. Choisissez des images et essayez de détecter des éléments dans l'image avec Gemini.

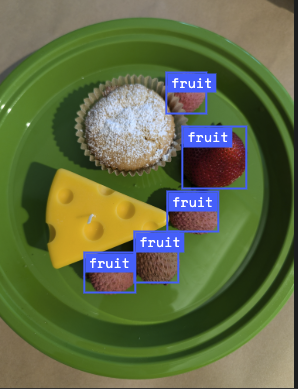

Par exemple, vous pouvez détecter des "ombres" ou des "fruits" dans différentes images :

Testez différentes images et voyez dans quelle mesure Gemini détecte et identifie différents objets.

14. API Live 🎤

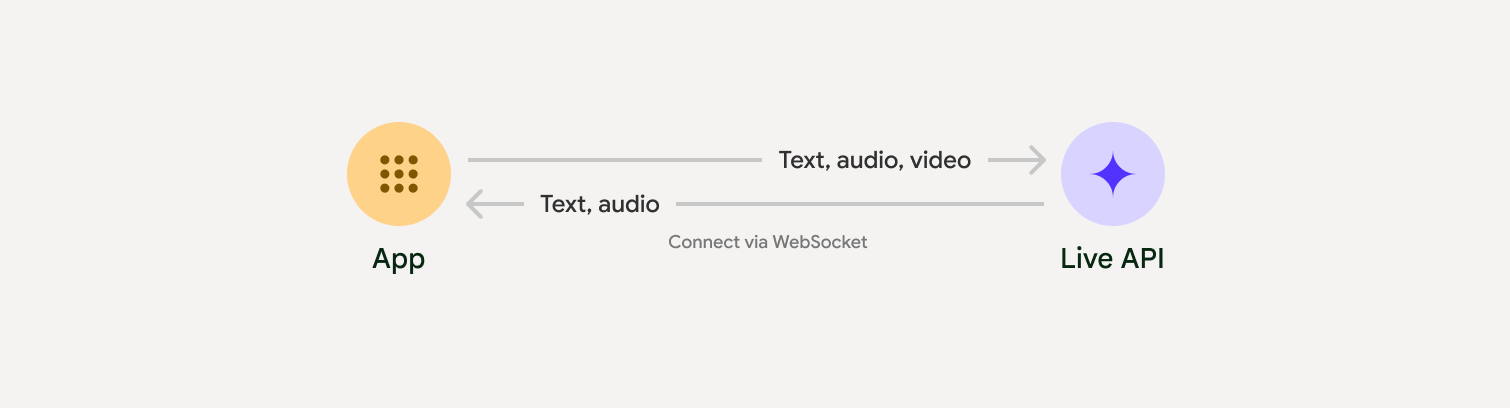

L'API Live permet des interactions vocales et vidéo en temps réel et à faible latence avec Gemini. Il traite les flux continus d'audio, de vidéo ou de texte pour fournir des réponses vocales immédiates et semblables à celles d'un humain, créant ainsi une expérience conversationnelle naturelle pour vos utilisateurs.

Essayez l'API Live dans Google AI Studio ou l'API Live dans Vertex AI Studio. Dans les deux applications, vous pouvez partager votre voix, votre vidéo et votre écran, et discuter en direct avec Gemini.

Commencez à partager votre vidéo ou votre écran, puis posez des questions générales à Gemini par commande vocale. Exemple :

Can you describe what you see on the screen?

Vous serez surpris par le naturel des réponses de Gemini.

15. Conclusion

Dans cet atelier de programmation, nous avons abordé l'écosystème Gemini, en commençant par la famille de produits Gemini et en apprenant à intégrer les modèles dans nos applications à l'aide du SDK Google Gen AI unifié. Nous avons exploré les fonctionnalités de pointe de Gemini, y compris la fenêtre de contexte longue, le mode Réflexion, les outils d'ancrage intégrés, l'API Live et la compréhension spatiale. Nous vous encourageons à consulter la documentation de référence pour en savoir plus et à continuer à expérimenter tout le potentiel de Gemini.