1. Wprowadzenie 👋

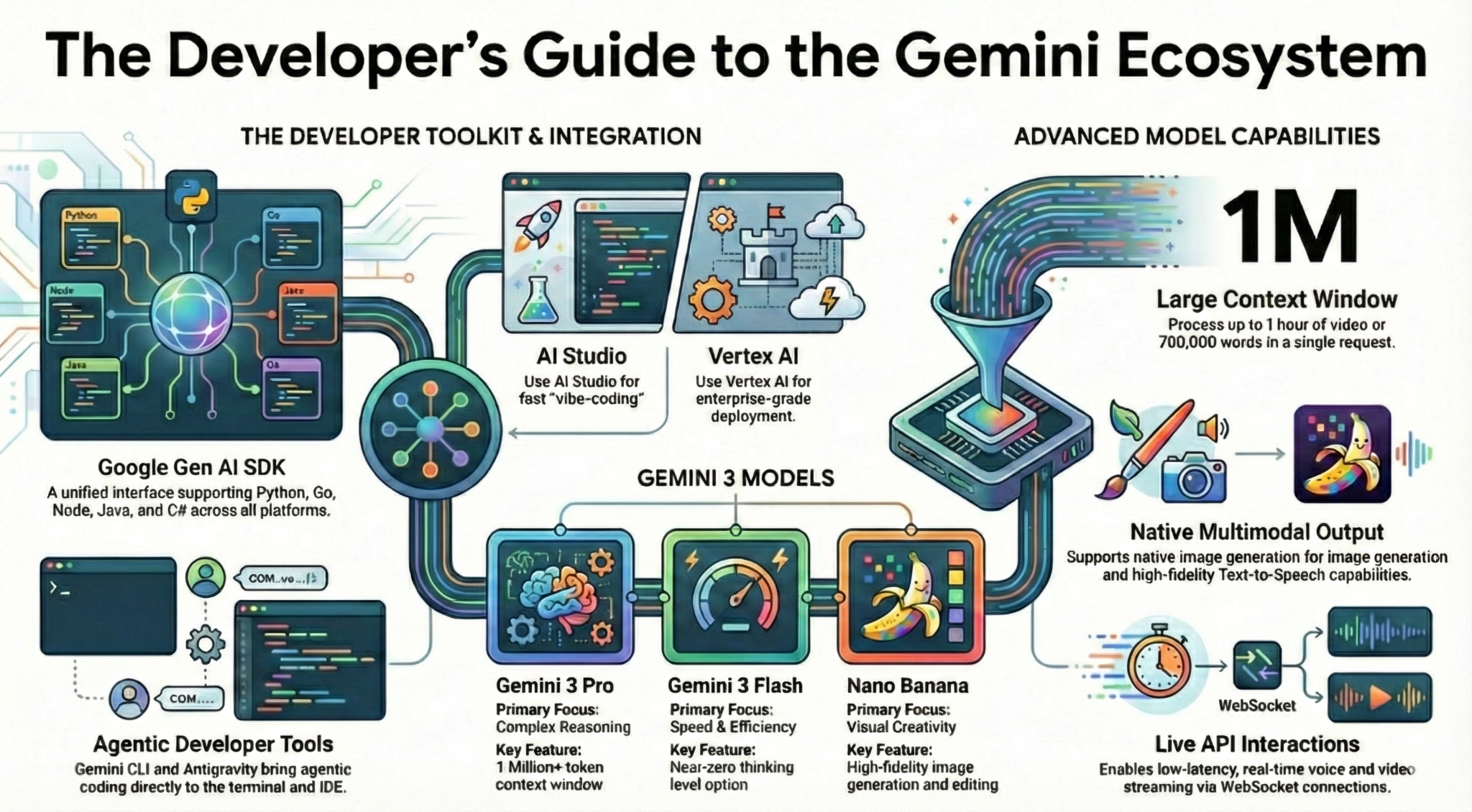

W tym laboratorium dowiesz się wszystkiego, co jako programista musisz wiedzieć o ekosystemie Gemini. Dowiesz się więcej o różnych modelach Gemini, narzędziach opartych na Gemini i pakiecie Google Gen AI SDK do integracji z Gemini. Poznasz też różne funkcje Gemini, takie jak długi kontekst, tryb myślenia, rozumienie przestrzenne, interfejs Live API, natywne dane wyjściowe obrazu i dźwięku i inne.

Po ukończeniu tego ćwiczenia będziesz mieć solidną wiedzę o ekosystemie Gemini.

💡Czego się nauczysz

- różnych modeli Gemini,

- Narzędzia oparte na modelach Gemini.

- Jak zintegrować Gemini za pomocą pakietu Google Gen AI SDK.

- Długie okno kontekstu Gemini.

- tryb myślenia Gemini,

- Różne wbudowane narzędzia, takie jak wyszukiwarka Google czy Mapy Google.

- Jak wchodzić w interakcje z agentami badawczymi za pomocą interfejsu Interactions API.

- generowanie obrazów i zamiana tekstu na mowę;

- Przestrzenne rozumienie Gemini.

- Interfejs Live API do interakcji głosowych i wideo w czasie rzeczywistym.

⚠️ Co będzie potrzebne

- Klucz interfejsu API do próbek Google AI Studio.

- Projekt Google Cloud z włączonymi płatnościami na potrzeby przykładów Vertex AI.

- lokalne środowisko programistyczne lub edytor Cloud Shell w Google Cloud;

2. Rodzina Gemini 🫂

Gemini to model AI od Google, który pomaga realizować każdy pomysł. Jest to świetny model do rozumienia multimodalnego oraz kodowania agentowego i vibe codingu – zbudowany na fundamencie najnowocześniejszego rozumowania. Krótkie omówienie modelu Gemini znajdziesz w tym filmie:

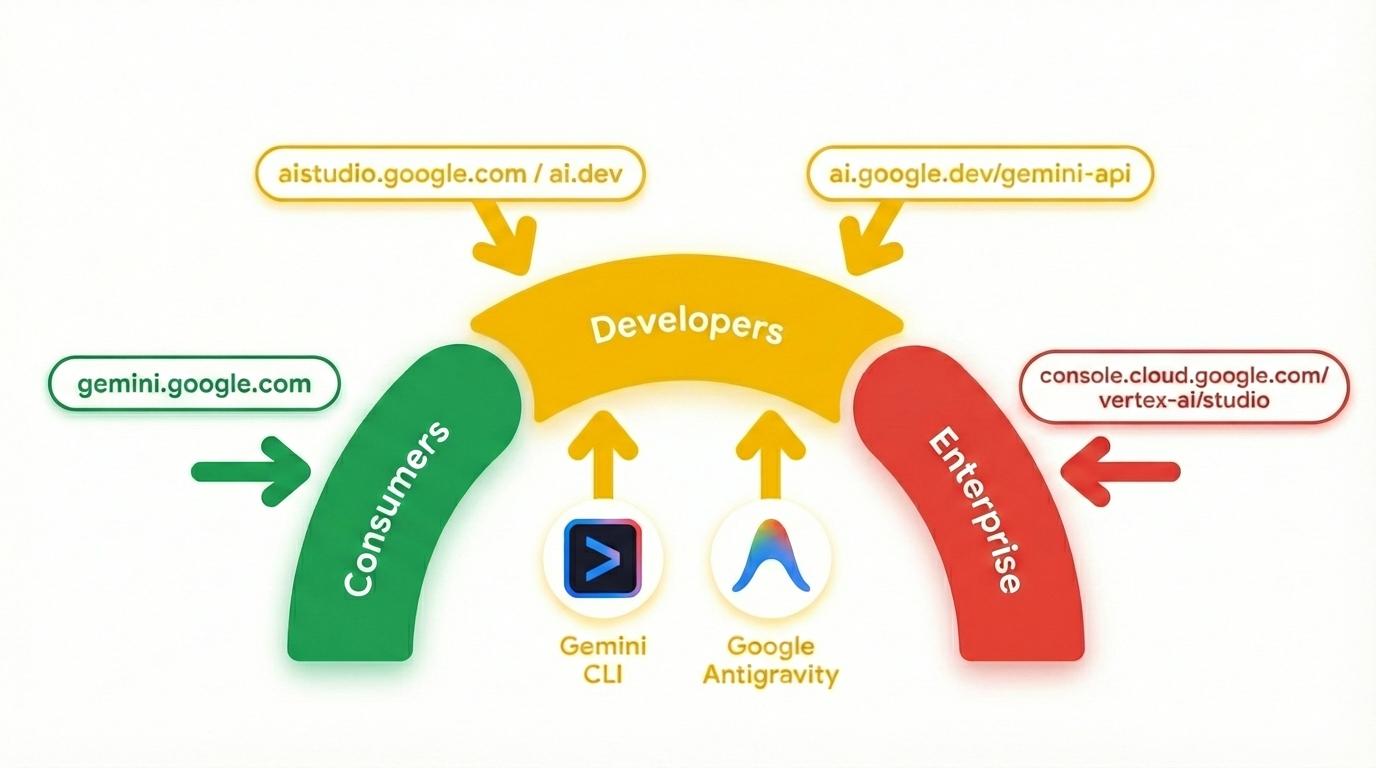

Gemini to nie tylko model. Jest to też marka parasolowa używana w usługach Google.

które korzystają z modelu Gemini. Oferujemy szeroką gamę usług Gemini, od aplikacji Gemini i NotebookLM dla konsumentów po AI Studio dla deweloperów i Vertex AI w Google Cloud dla przedsiębiorstw. Dostępne są też narzędzia dla programistów, takie jak interfejs wiersza poleceń Gemini i Google Antigravity, które wykorzystują Gemini.

3. Narzędzia oparte na Gemini 🧰

Przyjrzyjmy się pokrótce narzędziom opartym na Gemini.

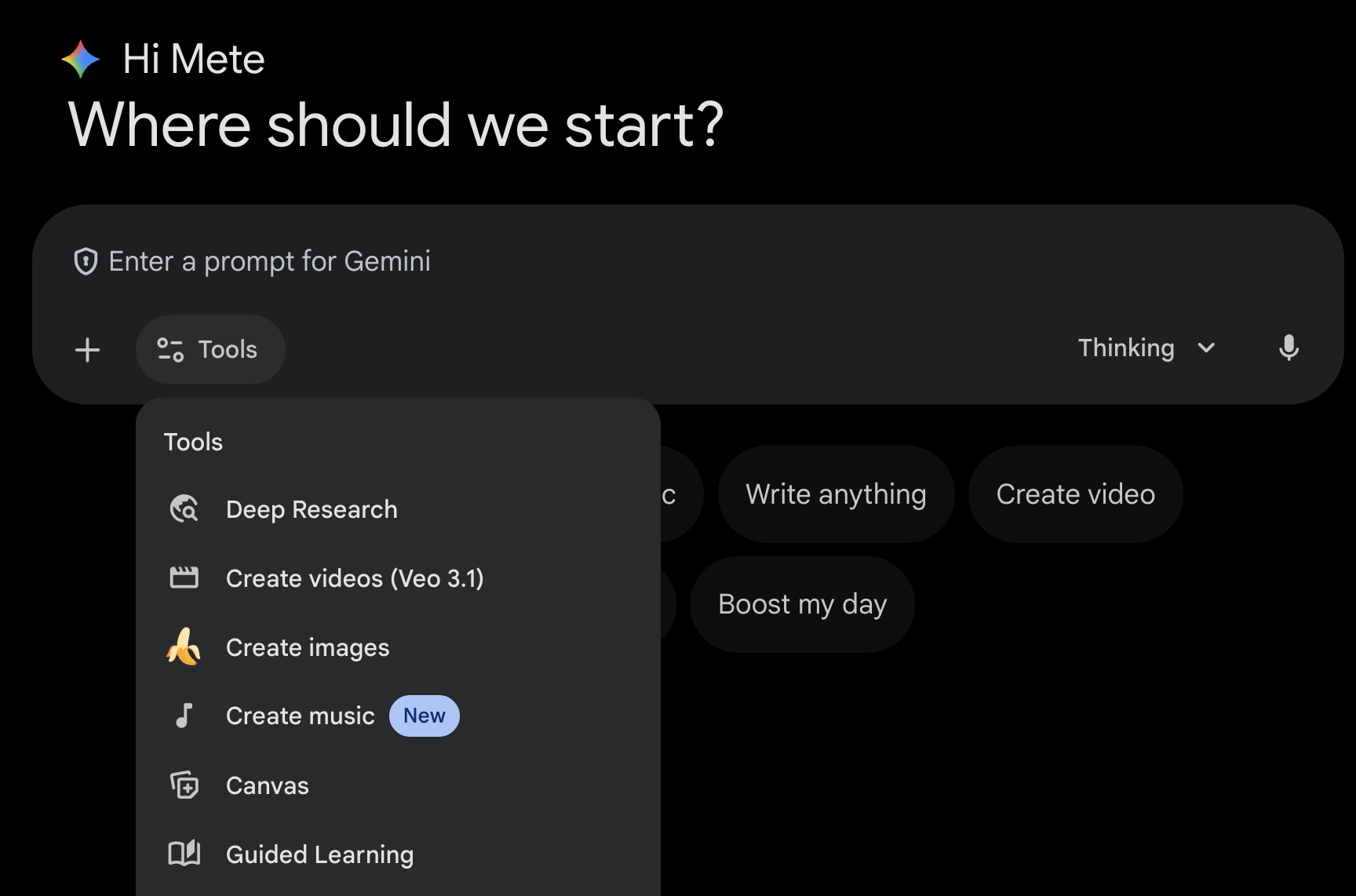

Aplikacja Gemini 💬

Aplikacja Gemini ( gemini.google.com) to aplikacja konsumencka oparta na czacie. To najprostszy sposób interakcji z Gemini. Zawiera narzędzia do Deep Research, generowania obrazów, filmów, muzyki i nie tylko. Dostępne są też różne wersje najnowszego modelu Gemini (Fast, Thinking, Pro). Aplikacja Gemini doskonale sprawdza się w codziennym użytkowaniu.

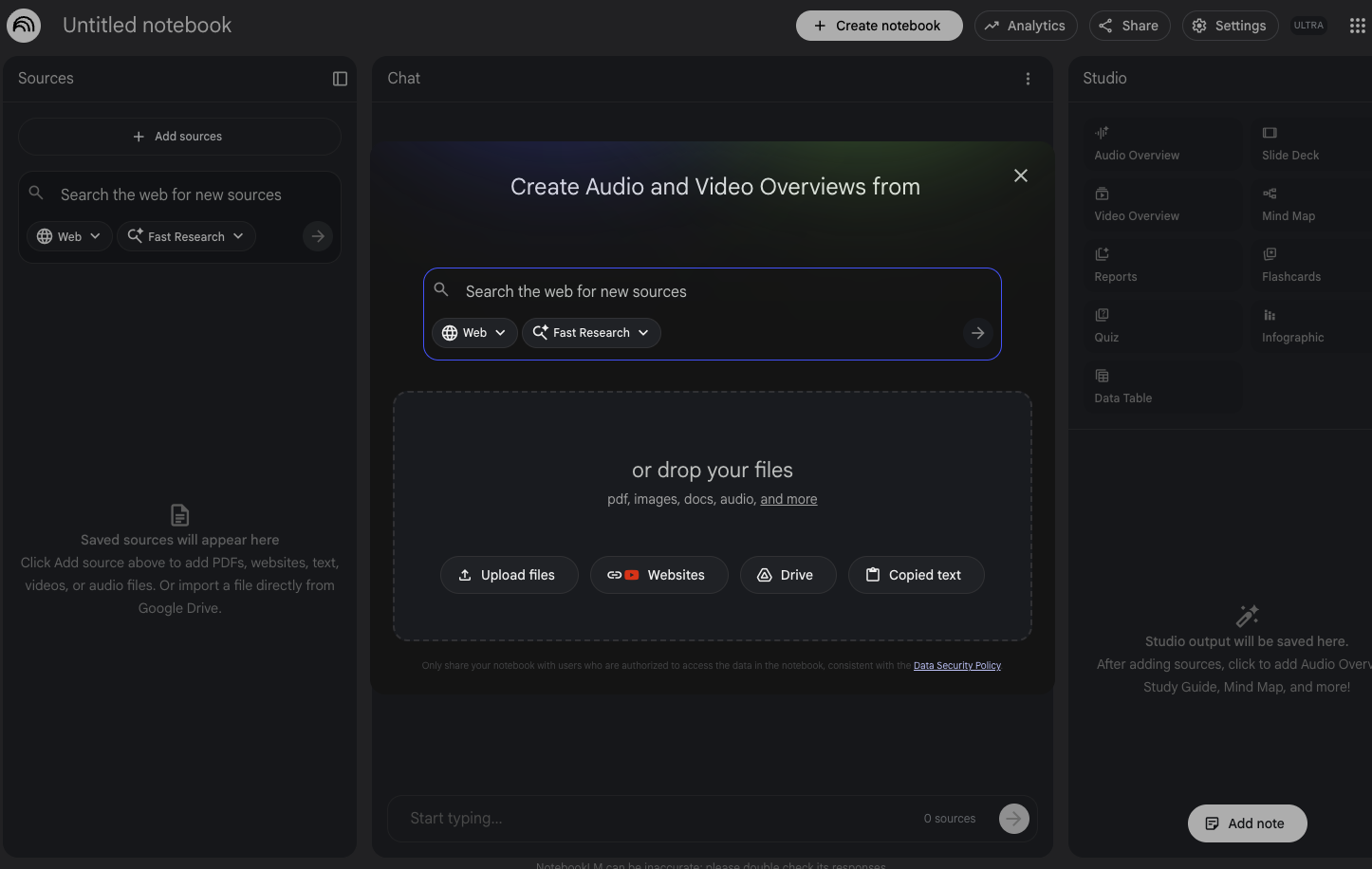

NotebookLM 📓

NotebookLM ( notebooklm.google.com) to oparty na AI partner do pozyskiwania informacji. Prześlij pliki PDF, strony internetowe, filmy na YouTube, pliki audio, dokumenty Google, prezentacje Google i inne materiały – NotebookLM przygotuje ich podsumowanie i wskaże interesujące powiązania między tematami. Wszystko to dzięki multimodalnym funkcjom rozumienia treści zapewnianym przez najnowszą wersję Gemini. Generuje też ciekawe i angażujące podsumowania audio, podsumowania wideo, infografiki i inne materiały na podstawie przesłanych źródeł.

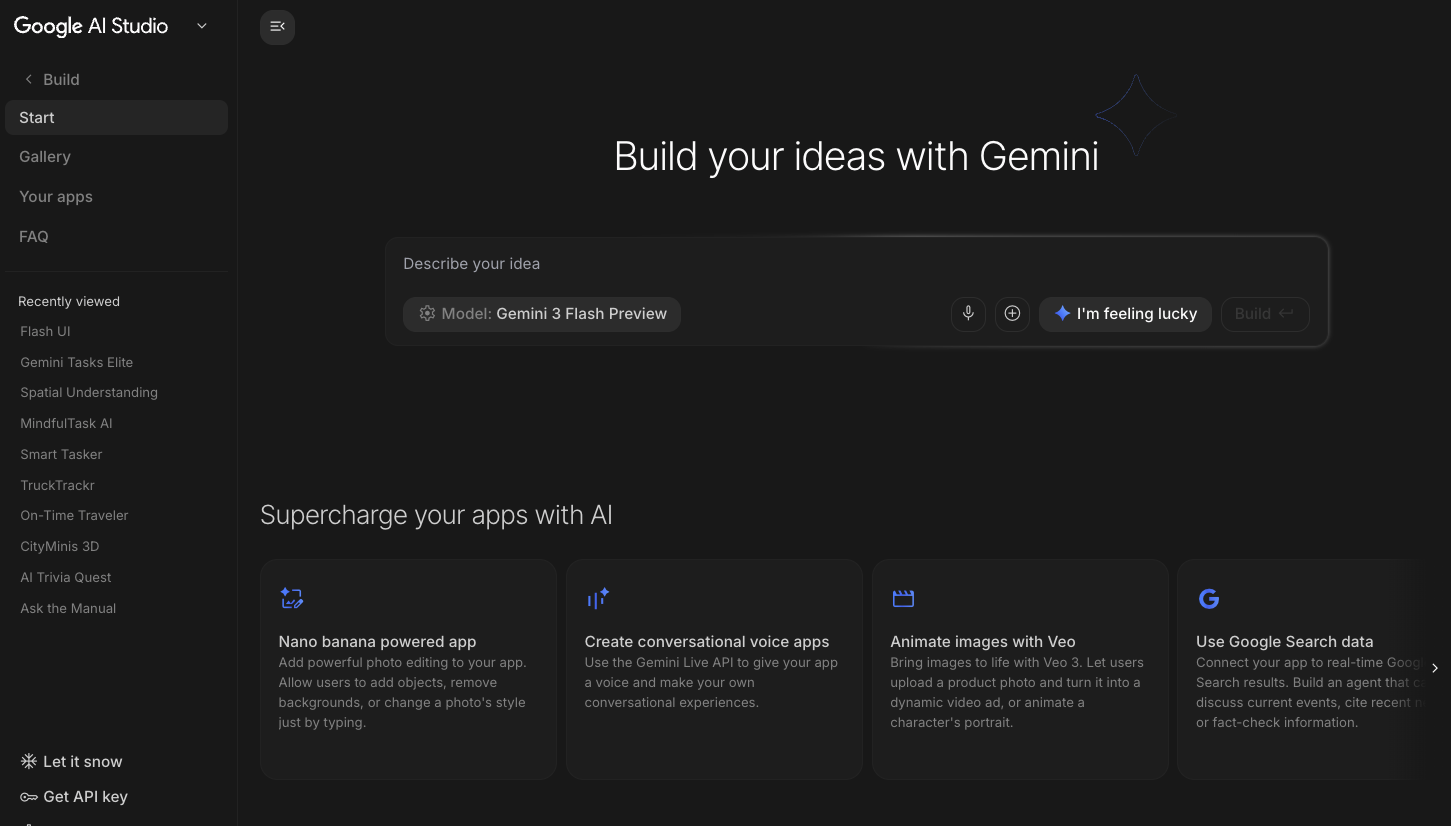

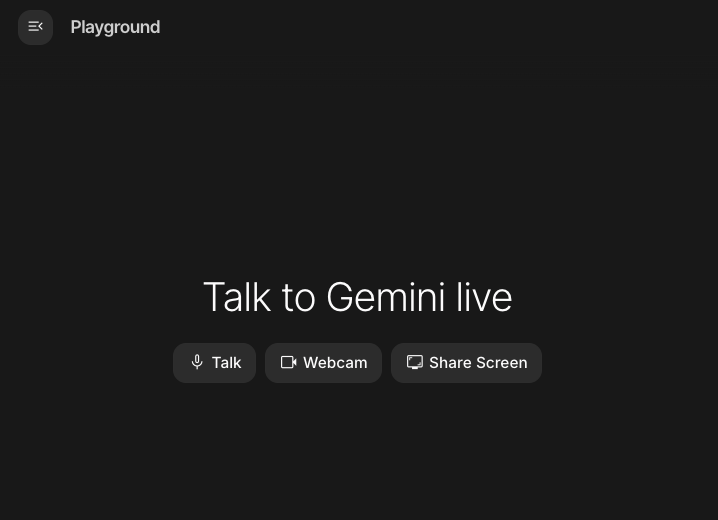

Google AI Studio 🎨

Google AI Studio ( ai.dev) to najszybszy sposób na rozpoczęcie tworzenia rozwiązań z wykorzystaniem Gemini. Panel Playground w Google AI Studio umożliwia eksperymentowanie z różnymi modelami w celu generowania tekstu, obrazów i filmów, a także wypróbowywanie rozmów głosowych i wideo w czasie rzeczywistym za pomocą Gemini Live API. Panel Build w Google AI Studio umożliwia tworzenie aplikacji internetowych i wdrażanie ich w Cloud Run w Google Cloud oraz przesyłanie kodu do GitHub.

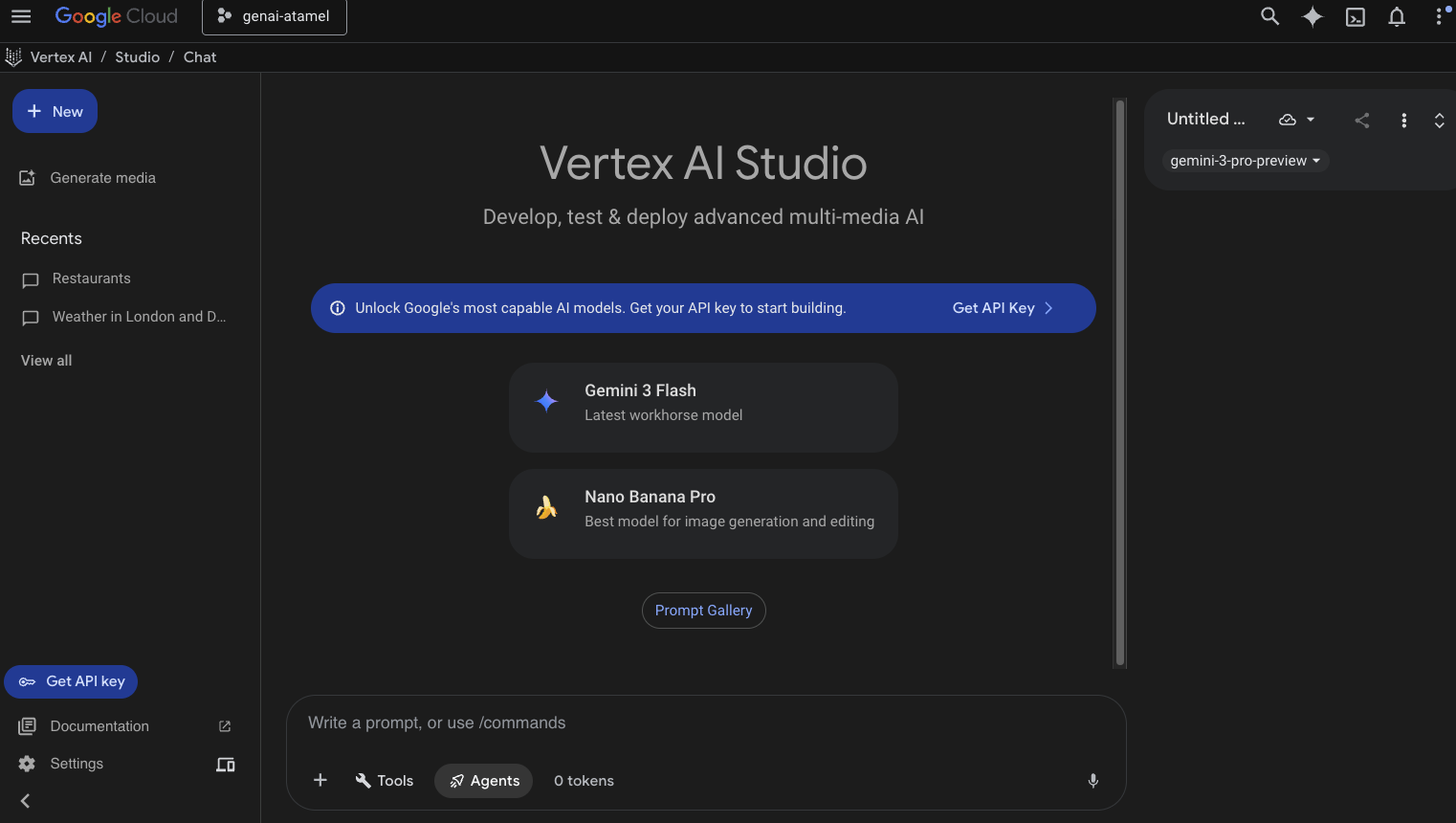

Vertex AI Studio ☁️

Vertex AI to w pełni zarządzana, ujednolicona platforma do tworzenia i używania generatywnej AI w Google Cloud. Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) pomaga testować, dostrajać i wdrażać aplikacje generatywnej AI gotowe do użycia w firmie.

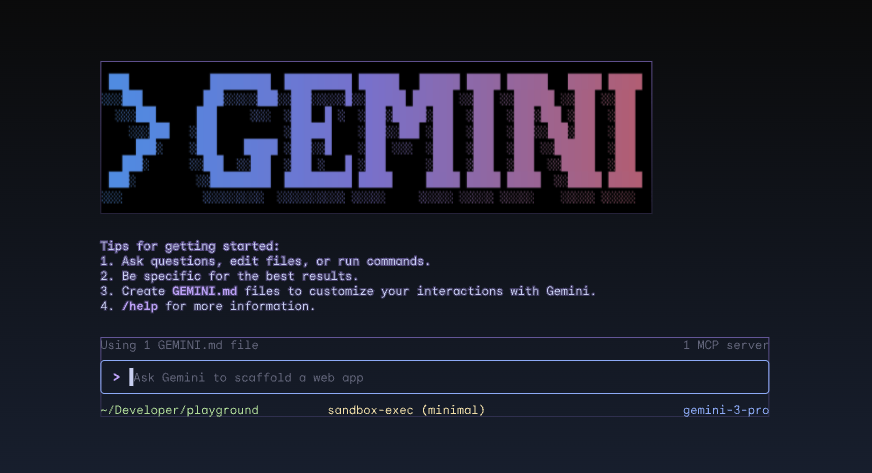

Interfejs wiersza poleceń Gemini ⚙️

Interfejs wiersza poleceń Gemini ( geminicli.com) to agent AI o otwartym kodzie źródłowym, który udostępnia możliwości Gemini bezpośrednio w terminalu. To narzędzie zostało zaprojektowane z myślą o deweloperach, inżynierach, specjalistach ds. niezawodności systemów i innych osobach. Jest ono rozszerzalne, wydajne i przeznaczone do obsługi w terminalu. Interfejs wiersza poleceń Gemini integruje się z Twoim środowiskiem lokalnym. Może czytać i edytować pliki, wykonywać polecenia powłoki i przeszukiwać internet, a przy tym zachowywać kontekst projektu.

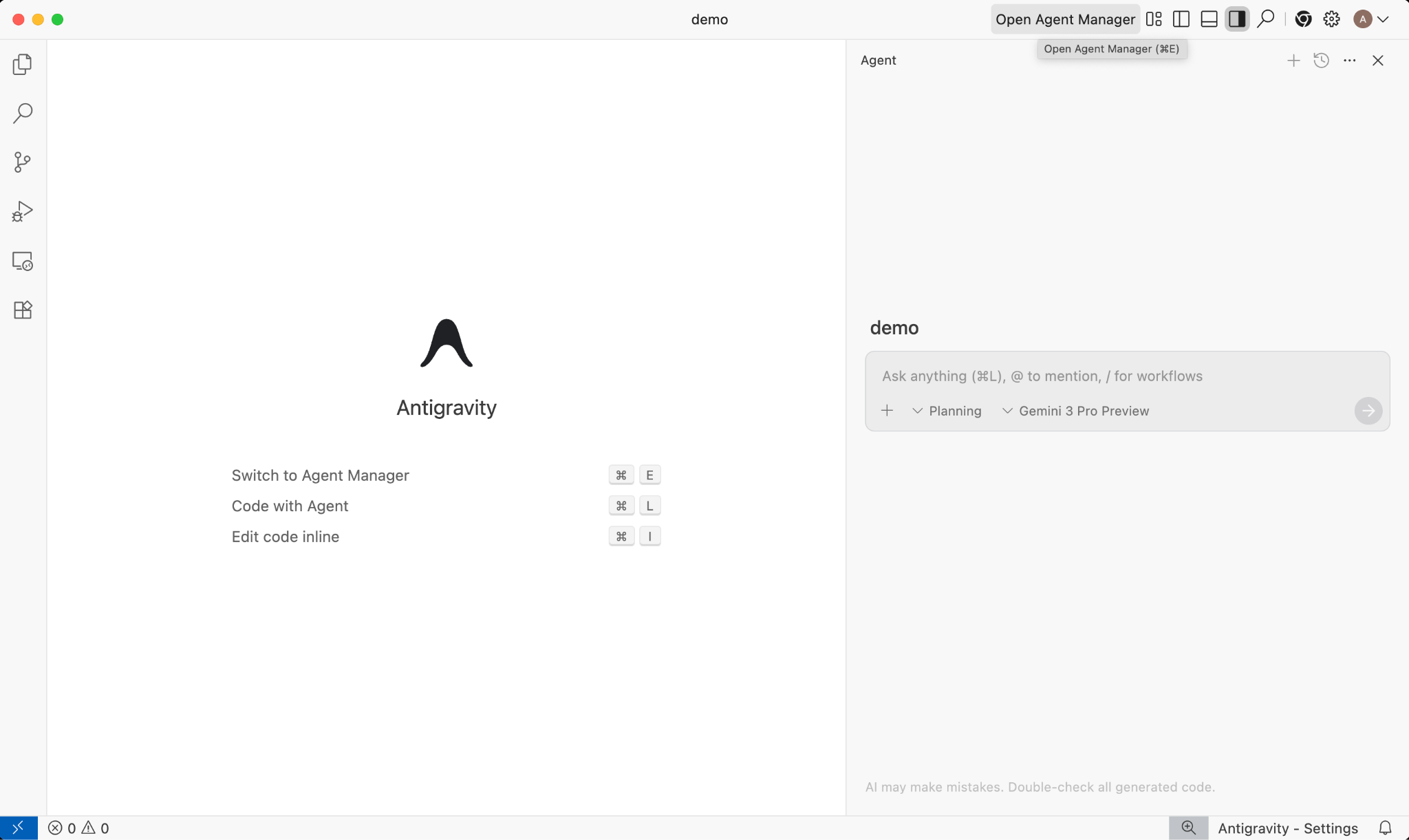

Google Antigravity 🚀

Google Antigravity ( antigravity.google) to oparta na agentach platforma dla programistów, która wprowadza środowisko IDE w erę agentów. Antigravity umożliwia programistom pracę na wyższym poziomie, zorientowanym na zadania, poprzez zarządzanie agentami w różnych obszarach roboczych, przy zachowaniu znajomego środowiska IDE wspomaganego przez AI.

Antigravity wyodrębnia agentów do osobnego interfejsu i zapewnia im narzędzia potrzebne do autonomicznego działania w edytorze, terminalu i przeglądarce, z naciskiem na weryfikację i komunikację na wyższym poziomie za pomocą zadań i artefaktów. Ta funkcja umożliwia agentom planowanie i wykonywanie bardziej złożonych zadań związanych z oprogramowaniem, co usprawnia wszystkie aspekty procesu tworzenia oprogramowania – od budowania funkcji, iteracji interfejsu i usuwania błędów po prowadzenie badań i generowanie raportów.

Możesz pobrać te narzędzia i z nich korzystać. Oto ogólne wskazówki dotyczące tego, kiedy używać poszczególnych narzędzi:

- Jeśli dopiero zaczynasz, prawdopodobnie będziesz używać aplikacji Gemini do zadawania pytań lub generowania podstawowego kodu.

- Jeśli tworzysz aplikację internetową metodą vibe-coding, prawdopodobnie wybierzesz Google AI Studio.

- Jeśli chcesz utworzyć złożoną aplikację z kontekstem z lokalnego środowiska programistycznego, wybierz interfejs Gemini CLI lub Google Antigravity.

- Jeśli chcesz wdrożyć lub już korzystasz z Google Cloud i potrzebujesz pomocy i funkcji na poziomie przedsiębiorstwa, wybierz Vertex AI i jego studio.

Oczywiście możesz łączyć te narzędzia. Możesz na przykład zacząć od kodowania w AI Studio, aby przesłać kod do GitHuba, a potem użyć Antigravity do dalszego kodowania i wdrażania w Google Cloud.

4. Modele Gemini 🧠

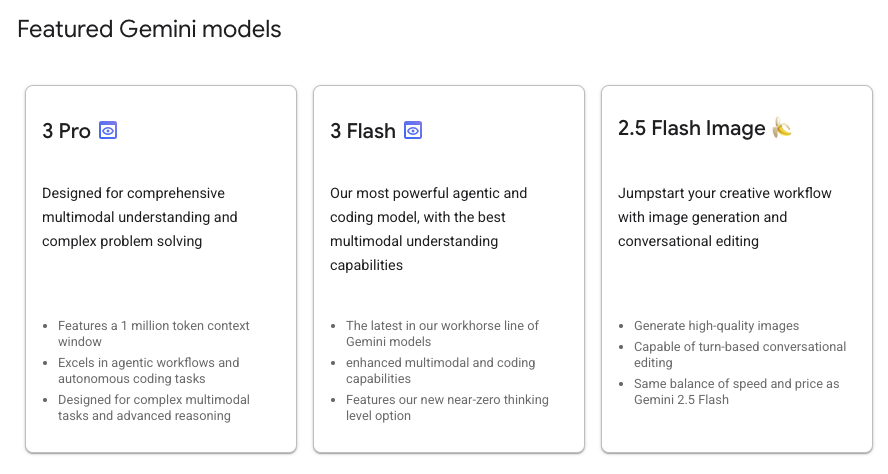

Modele Gemini są stale ulepszane, a nowe wersje pojawiają się co kilka miesięcy. Obecnie (luty 2026 r.) w Vertex AI w Google Cloud dostępne są te modele:

Dostępnych jest wiele innych ogólnodostępnych modeli Gemini, wersji testowych modeli Gemini, otwartych modeli Gemma, modeli do tworzenia osadzeń, modeli do generowania obrazów, modeli Veo i innych.

Zapoznaj się ze stroną dokumentacji Modeli Google, aby poznać główne modele dostępne w Vertex AI w różnych przypadkach użycia.

5. Google Gen AI SDK 📦

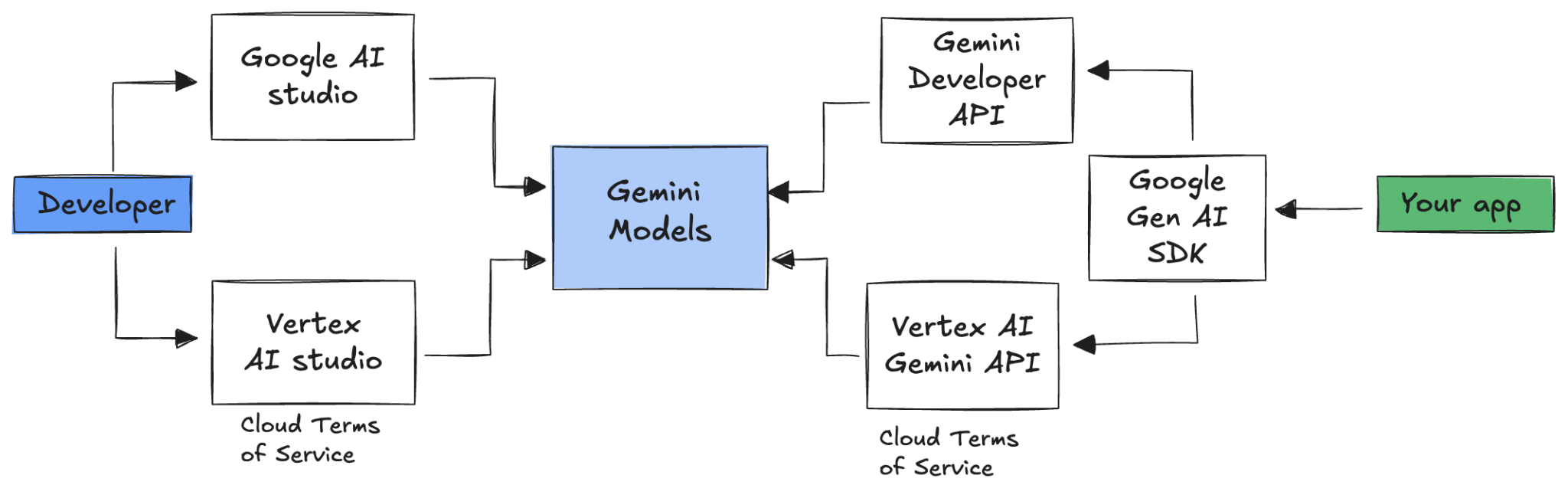

Aby zintegrować Gemini z aplikacją, możesz użyć pakietu Google Gen AI SDK.

Jak wspomnieliśmy wcześniej, do modeli Gemini możesz uzyskać dostęp za pomocą Google AI Studio lub Vertex AI Studio. Pakiet SDK Google Gen AI udostępnia ujednolicony interfejs do modeli Gemini za pomocą interfejsu Google AI API i Google Cloud API. Z kilkoma wyjątkami kod działający na jednej platformie będzie działać na obu.

Google Gen AI SDK obsługuje obecnie języki Python, Go, Node, Java i C#.

Oto przykład rozmowy z Gemini w Google AI w Pythonie:

client = genai.Client(

api_key=your-gemini-api-key)

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Aby zrobić to samo w przypadku Gemini w Vertex AI, wystarczy zmienić inicjowanie klienta, a reszta pozostanie bez zmian:

client = genai.Client(

vertexai=True,

project=your-google-cloud-project,

location="us-central1")

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Aby samodzielnie uruchomić te przykłady, możesz użyć polecenia main.py w github.com/meteatamel/genai-samples/tree/main/vertexai/gemini2/hello-world.

6. Interfejs Interactions API 🔄

Interfejs Interactions API (beta) to nowy ujednolicony interfejs do korzystania z modeli i agentów Gemini. Jest to ulepszona alternatywa dla interfejsu generateContent API, która upraszcza zarządzanie stanem, koordynację narzędzi i długotrwałe zadania.

Oto podstawowa interakcja z nowym interfejsem API:

interaction = client.interactions.create(

model="gemini-3-flash-preview",

input="Tell me a short joke."

)

print(interaction.outputs[-1].text)

Możesz prowadzić rozmowę z zachowaniem stanu, przekazując identyfikator interakcji z poprzedniej interakcji:

interaction1 = client.interactions.create(

model="gemini-3-flash-preview",

input="Hi, my name is Phil."

)

print(f"Model: {interaction1.outputs[-1].text}")

interaction2 = client.interactions.create(

model="gemini-3-flash-preview",

input="What is my name?",

previous_interaction_id=interaction1.id

)

print(f"Model: {interaction2.outputs[-1].text}")

Interfejs Interactions API jest przeznaczony do tworzenia agentów i interakcji z nimi. Obsługuje wywoływanie funkcji, wbudowane narzędzia, dane wyjściowe o ustrukturyzowanej formie oraz protokół Model Context Protocol (MCP). Aby dowiedzieć się, jak można go używać z agentem do dogłębnych badań, zapoznaj się z krokiem Agenci 🤖 poniżej.

Aby samodzielnie uruchomić te przykłady, możesz użyć polecenia main.py w github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api.

7. Długie okno kontekstu 🪟

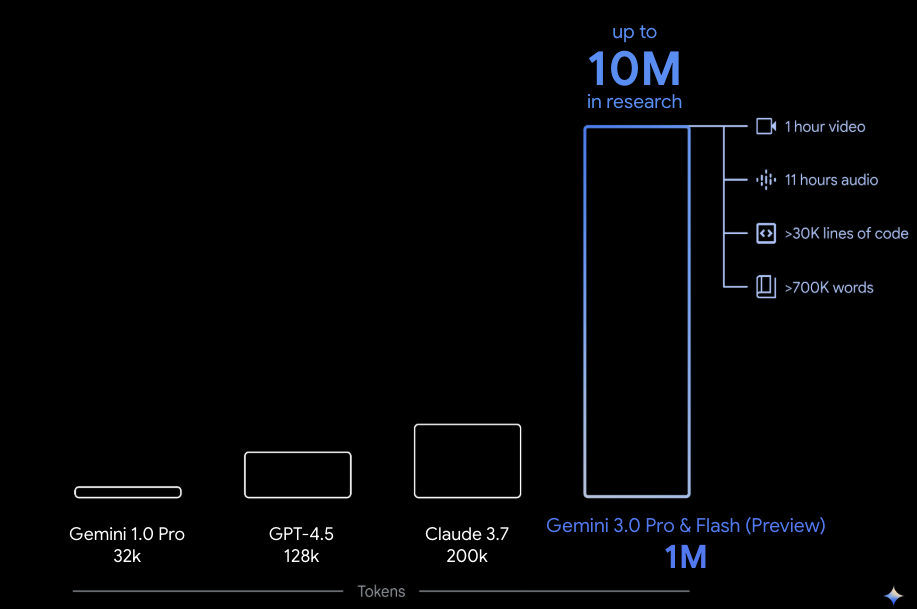

Wiele modeli Gemini ma duże okna kontekstu obejmujące milion lub więcej tokenów. W przeszłości duże modele językowe (LLM) były znacznie ograniczone przez ilość tekstu (lub tokenów), które można było przekazać do modelu w jednym momencie. Długie okno kontekstu Gemini otwiera wiele nowych przypadków użycia i paradygmatów deweloperskich.

Aby zobaczyć, jak działa długie okno kontekstu, otwórz Galerię promptów w Vertex AI Studio i wybierz prompt Extract Video Chapters. Ten prompt dzieli treści wideo na rozdziały i podaje podsumowanie każdego z nich.

Po uruchomieniu go z dostarczonym filmem powinny pojawić się dane wyjściowe podobne do tych:

[

{

"timecode": "00:00",

"chapterSummary": "The video opens with scenic views of Rio de Janeiro, introducing the \"Marvelous City\" and its famous beaches like Ipanema and Copacabana, before pivoting to the existence of the favelas."

},

{

"timecode": "00:20",

"chapterSummary": "The narrator describes the favelas, home to one in five Rio residents, highlighting that while often associated with crime and poverty, this is only a small part of their story."

},

{

"timecode": "00:36",

"chapterSummary": "Google introduces its project to map the favelas, emphasizing that providing addresses to these uncharted areas is a crucial step in giving residents an identity."

},

{

"timecode": "00:43",

"chapterSummary": "The video concludes by focusing on the people of the favelas, inviting viewers to go beyond the map and explore their world through a 360-degree experience."

}

]

Jest to możliwe tylko dzięki długiemu oknu kontekstu Gemini.

8. Tryb myślenia 🧠

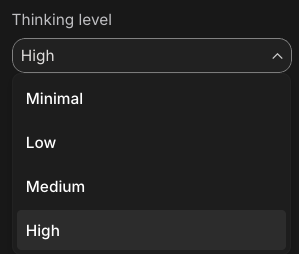

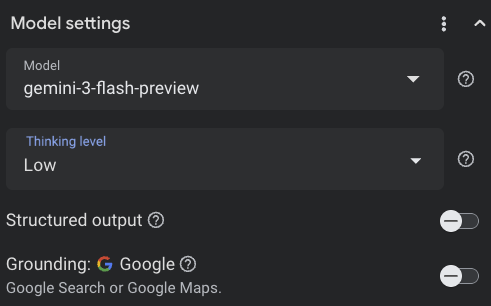

Modele Gemini wykorzystują wewnętrzny proces myślowy, który znacznie poprawia ich zdolność do rozumowania w przypadku złożonych zadań. Poziomy myślenia (Gemini 3) i budżety (Gemini 2.5) kontrolują sposób myślenia. Możesz też włączyć include_thoughts, aby zobaczyć surowe przemyślenia modelu.

Aby zobaczyć tryb myślenia w działaniu, otwórz Google AI Studio ( ai.dev) i rozpocznij nowy czat. W panelu po prawej stronie możesz ustawić poziom myślenia:

Jeśli w prawym górnym rogu klikniesz przycisk Get code, zobaczysz też, jak ustawić poziom myślenia w kodzie, np. w ten sposób:

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(

thinking_level="low",

include_thoughts=True

)

),

)

Wypróbuj różne prompty i poziomy myślenia, aby zobaczyć, jak działa model.

9. Narzędzia 🧰

Gemini ma wiele wbudowanych narzędzi, takich jak wyszukiwarka Google, Mapy Google, wykonywanie kodu, korzystanie z komputera, wyszukiwanie plików i inne. Możesz też definiować własne narzędzia za pomocą wywoływania funkcji. Przyjrzyjmy się pokrótce, jak z nich korzystać.

Wyszukiwarka Google 🔎

Możesz opierać odpowiedzi modelu na wynikach wyszukiwania w Google, aby były dokładniejsze, aktualniejsze i trafniejsze.

W Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) lub Google AI Studio ( ai.dev) możesz rozpocząć nowy czat i upewnić się, że funkcja Google Search grounding jest wyłączona:

Następnie możesz zadać pytanie o dzisiejszą pogodę w Twojej lokalizacji. Na przykład:

How's the weather in London today?

Zwykle otrzymujesz odpowiedź dotyczącą dnia z przeszłości, ponieważ model nie ma dostępu do najnowszych informacji. Na przykład:

In London today (Friday, May 24, 2025), the weather is a bit of a mixed bag, typical for late May.

Teraz włącz grounding z użyciem wyszukiwarki Google i zadaj to samo pytanie. Powinny się wyświetlić aktualne informacje o pogodzie wraz z linkami do źródeł podstawowych:

In London today (Wednesday, February 11, 2026), the weather is cool and mostly cloudy with a chance of light rain.

W ten sposób możesz uwzględnić w kodzie wyszukiwarkę Google. Możesz też kliknąć przycisk Kod w Vertex AI Studio, aby uzyskać przykładowe ugruntowanie:

google_search_tool = Tool(google_search=GoogleSearch())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="How's the weather like today in London?",

config=GenerateContentConfig(tools=[google_search_tool])

)

Mapy Google 🗺️

Możesz też ugruntować odpowiedzi modelu za pomocą Map Google, które mają dostęp do informacji o ponad 250 milionach miejsc.

Aby zobaczyć, jak to działa, w sekcji „Grounding” w ustawieniach modelu w Vertex AI Studio wybierz Mapy Google zamiast wyszukiwarki Google i zadaj pytanie, które wymaga danych z Map, np.:

Can you show me some Greek restaurants and their map coordinates near me?

Kod wygląda mniej więcej tak:

google_maps_tool = Tool(google_maps=GoogleMaps())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=""What are the best restaurants near here?",

config=GenerateContentConfig(tools=[google_maps_tool]),

# Optional: Provide location context (this is in Los Angeles)

tool_config=ToolConfig(

retrieval_config=types.RetrievalConfig(

lat_lng=types.LatLng(

latitude=34.050481, longitude=-118.248526))),

)

Wykonywanie kodu 🧑💻

Gemini może generować i uruchamiać kod w Pythonie z listą obsługiwanych bibliotek (pandas, numpy, PyPDF2 itp.). Jest to przydatne w przypadku aplikacji, które korzystają z rozumowania opartego na kodzie (np.rozwiązywanie równań).

Aby to sprawdzić,przełącz się na Google AI Studio, rozpocznij nowy czat i upewnij się, że przełącznik Code execution jest włączony. Następnie zadaj pytanie, w przypadku którego narzędzie do wykonywania kodu może być przydatne. Na przykład:

What is the sum of the first 50 prime numbers?

Gemini powinien wygenerować i uruchomić kod Pythona. Prawidłowa odpowiedź to 5117.

Narzędzie do wykonywania kodu możesz uruchomić z poziomu kodu w ten sposób:

code_execution_tool = Tool(code_execution=ToolCodeExecution())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="What is the sum of the first 50 prime numbers?",

config=GenerateContentConfig(

tools=[code_execution_tool],

temperature=0))

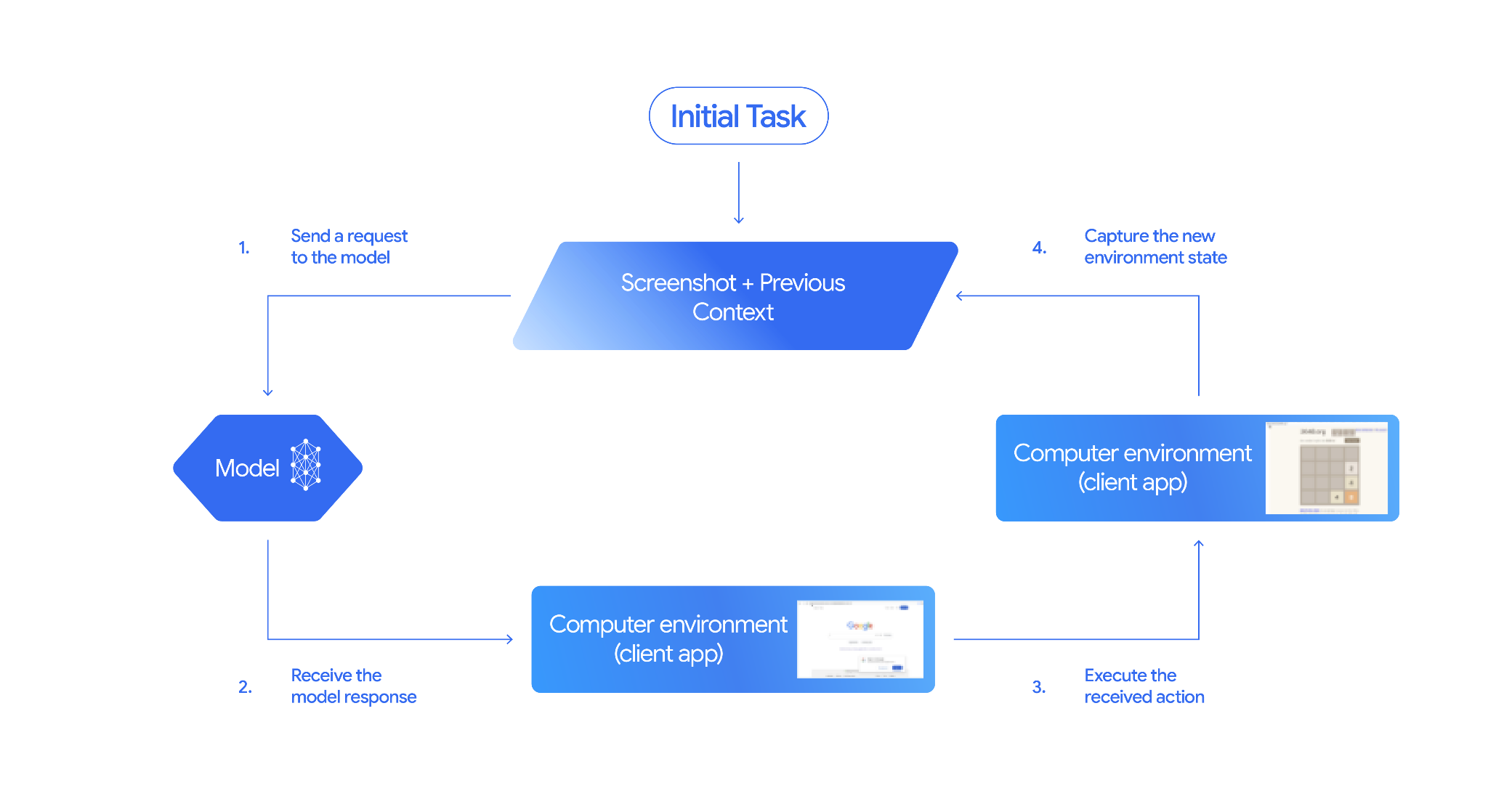

Korzystanie z komputera 🖥️

Model Gemini Computer Use (wersja testowa) umożliwia tworzenie agentów sterujących przeglądarką, którzy automatyzują zadania. Działa to w ten sposób:

Aby zobaczyć, jak to działa, możesz uruchomić main.py na stronie github.com/google-gemini/computer-use-preview.

Możesz na przykład pobrać klucz interfejsu API z Google AI Studio i poprosić Gemini o wyszukanie lotów:

export GEMINI_API_KEY=your-api-key

python main.py --query "Find me top 5 fights sorted by price with the following constraints:

Flight site to use: www.google.com/travel/flights

From: London

To: Larnaca

One-way or roundtrip: One way

Date to leave: Sometime next week

Date to return: N/A

Travel preferences:

-Direct flights

-No flights before 10am

-Carry-on luggage"

Gemini otworzy przeglądarkę w trybie incognito i rozpocznie wyszukiwanie lotów.

Wyszukiwanie plików 📁

Narzędzie do wyszukiwania plików umożliwia łatwe generowanie rozszerzone przez wyszukiwanie w zapisanych informacjach (RAG). Wystarczy przesłać pliki, a usługa zajmie się wszystkimi szczegółami RAG, takimi jak dzielenie na fragmenty, osadzanie i pobieranie.

Aby zobaczyć, jak to działa, uruchom main.py na stronie github.com/meteatamel/genai-beyond-basics/blob/main/samples/grounding/file-search-tool.

Uzyskaj klucz interfejsu API z Google AI Studio i utwórz sklep wyszukiwania plików:

export GEMINI_API_KEY=your-gemini-api-key

python main.py create_store my-file-search-store

Prześlij plik PDF do sklepu:

python main.py upload_to_store fileSearchStores/myfilesearchstore-5a9x71ifjge9 cymbal-starlight-2024.pdf

Zadaj pytanie dotyczące pliku PDF, wskazując sklep:

python main.py generate_content "What's the cargo capacity of Cymbal Starlight?" fileSearchStores/myfilesearchstore-5a9x71ifjge9

Powinna pojawić się odpowiedź oparta na pliku PDF:

Generating content with file search store: fileSearchStores/myfilesearchstore-5a9x71ifjge9

Response: The Cymbal Starlight 2024 has a cargo capacity of 13.5 cubic feet, which is located in the trunk of the vehicle. It is important to distribute the weight evenly and not overload the trunk, as this could impact the vehicle's handling and stability. The vehicle can also accommodate up to two suitcases in the trunk, and it is recommended to use soft-sided luggage to maximize space and cargo straps to secure it while driving.

Grounding sources: cymbal-starlight-2024.pdf

Wywoływanie funkcji 📲

Jeśli wbudowane narzędzia nie wystarczą, możesz też zdefiniować własne narzędzia (funkcje) w Gemini. Wystarczy przesłać funkcję w Pythonie jako narzędzie (zamiast przesyłać szczegółową specyfikację OpenAPI funkcji). Jest on automatycznie używany jako narzędzie przez model i pakiet SDK.

Możesz na przykład utworzyć funkcję zwracającą szerokość i długość geograficzną lokalizacji:

def location_to_lat_long(location: str):

"""Given a location, returns the latitude and longitude

Args:

location: The location for which to get the weather.

Returns:

The latitude and longitude information in JSON.

"""

logger.info(f"Calling location_to_lat_long({location})")

url = f"https://geocoding-api.open-meteo.com/v1/search?name={location}&count=1"

return api_request(url)

Możesz też mieć funkcję zwracającą informacje o pogodzie na podstawie szerokości i długości geograficznej:

def lat_long_to_weather(latitude: str, longitude: str):

"""Given a latitude and longitude, returns the weather information

Args:

latitude: The latitude of a location

longitude: The longitude of a location

Returns:

The weather information for the location in JSON.

"""

logger.info(f"Calling lat_long_to_weather({latitude}, {longitude})")

url = (f"https://api.open-meteo.com/v1/forecast?latitude={latitude}&longitude={longitude}¤t=temperature_2m,"

f"relative_humidity_2m,surface_pressure,wind_speed_10m,wind_direction_10m&forecast_days=1")

return api_request(url)

Teraz możesz przekazać te 2 funkcje jako narzędzia do Gemini i pozwolić mu na pobieranie informacji o pogodzie w danej lokalizacji:

def generate_content_with_function_calls():

client = genai.Client(

vertexai=True,

project=PROJECT_ID,

location=LOCATION)

response = client.models.generate_content(

model=MODEL_ID,

contents=PROMPT,

config=GenerateContentConfig(

system_instruction=[

"You are a helpful weather assistant.",

"Your mission is to provide weather information for different cities."

"Make sure your responses are in plain text format (no markdown) and include all the cities asked.",

],

tools=[location_to_lat_long, lat_long_to_weather],

temperature=0),

)

print(response.text)

#print(response.automatic_function_calling_history)

Aby zobaczyć, jak to działa, możesz uruchomić main_genaisdk.py na stronie github.com/meteatamel/genai-beyond-basics/blob/main/samples/function-calling/weather.

10. Agenci 🤖

Interactions API w Gemini służy do tworzenia agentów i interakcji z nimi. Możesz używać specjalistycznych agentów, takich jak agent Gemini Deep Research. Agent Gemini Deep Research autonomicznie planuje, wykonuje i syntetyzuje wieloetapowe zadania badawcze. Porusza się po złożonych zasobach informacji, korzystając z wyszukiwarki internetowej i Twoich danych, aby tworzyć szczegółowe raporty z cytatami.

Oto jak używać agenta Deep Research z API interakcji:

interaction = client.interactions.create(

input="Research the history of the Google TPUs.",

agent="deep-research-pro-preview-12-2025",

background=True

)

while True:

if interaction.status == "completed":

print("\nFinal Report:\n",

interaction.outputs[-1].text)

break

Aby samodzielnie uruchomić ten przykład, możesz wykonać polecenie main.py w github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api.

export GOOGLE_API_KEY=your-api-key

python main.py agent

Po pewnym czasie powinny pojawić się wyniki wyszukiwania:

User: Research the history of the Google TPUs with a focus on 2025 and 2026

Status: in_progress

Status: in_progress

Status: in_progress

...

Model Final Report:

# Architectural Convergence and Commercial Expansion: The History of Google TPUs (2015–2026)

## Key Findings

* **Strategic Pivot (2025):** Google transitioned the Tensor Processing Unit (TPU) from a primarily internal differentiator to a commercial merchant-silicon competitor, epitomized by the massive "Ironwood" (TPU v7) deployment and external sales strategy.

* **Technological Leap:** The introduction of TPU v7 "Ironwood" in 2025 marked a paradigm shift, utilizing 3nm process technology to deliver 42.5 exaFLOPS per pod, directly challenging NVIDIA's Blackwell architecture in the high-performance computing (HPC) sector.

...

11. Generowanie obrazów 📷

Nano Banana 🍌 to nazwa natywnych funkcji Gemini do generowania obrazów. Gemini może generować i przetwarzać obrazy w formie rozmowy, używając tekstu, obrazów lub obu tych elementów. Dzięki temu możesz tworzyć, edytować i ulepszać elementy wizualne z niespotykaną dotąd kontrolą.

Nano Banana to 2 różne modele dostępne w Gemini API:

- Nano Banana: model Gemini 2.5 Flash Image (

gemini-2.5-flash-image). Ten model został zaprojektowany z myślą o szybkości i wydajności oraz zoptymalizowany pod kątem zadań o dużej objętości i niskim opóźnieniu. - Nano Banana Pro: model Gemini 3 Pro do podglądu obrazów (

gemini-3-pro-image-preview). Ten model został zaprojektowany do profesjonalnego tworzenia zasobów. Wykorzystuje zaawansowane rozumowanie, aby wykonywać złożone instrukcje i renderować tekst o wysokiej wierności.

Oto fragment kodu, w którym możesz przekazać istniejący obraz i poprosić Nano Banana o jego edycję:

from google import genai

from google.genai import types

from PIL import Image

client = genai.Client()

prompt = (

"Create a picture of my cat eating a nano-banana in a "

"fancy restaurant under the Gemini constellation",

)

image = Image.open("/path/to/cat_image.png")

response = client.models.generate_content(

model="gemini-2.5-flash-image",

contents=[prompt, image],

)

for part in response.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = part.as_image()

image.save("generated_image.png")

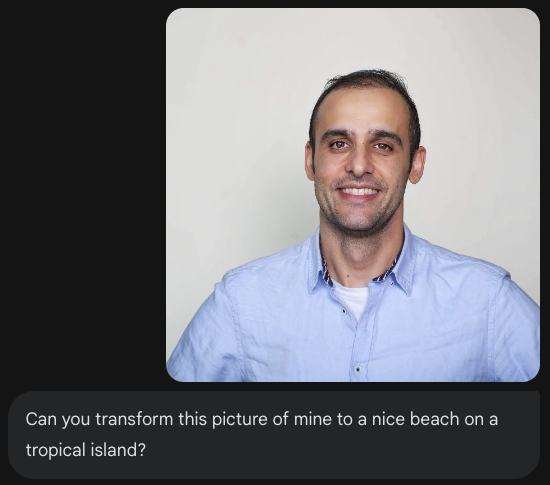

Nano Banana jest dostępny w aplikacji Gemini, AI Studio i Vertex AI Studio. Najprostszym sposobem na wypróbowanie tej funkcji jest użycie aplikacji Gemini. W aplikacji Gemini ( gemini.google.com) wybierz 🍌 Create images w sekcji Tools. Następnie prześlij obraz i spróbuj czegoś ciekawego. Na przykład możesz powiedzieć:

Can you transform this picture of mine to a nice beach on a tropical island?

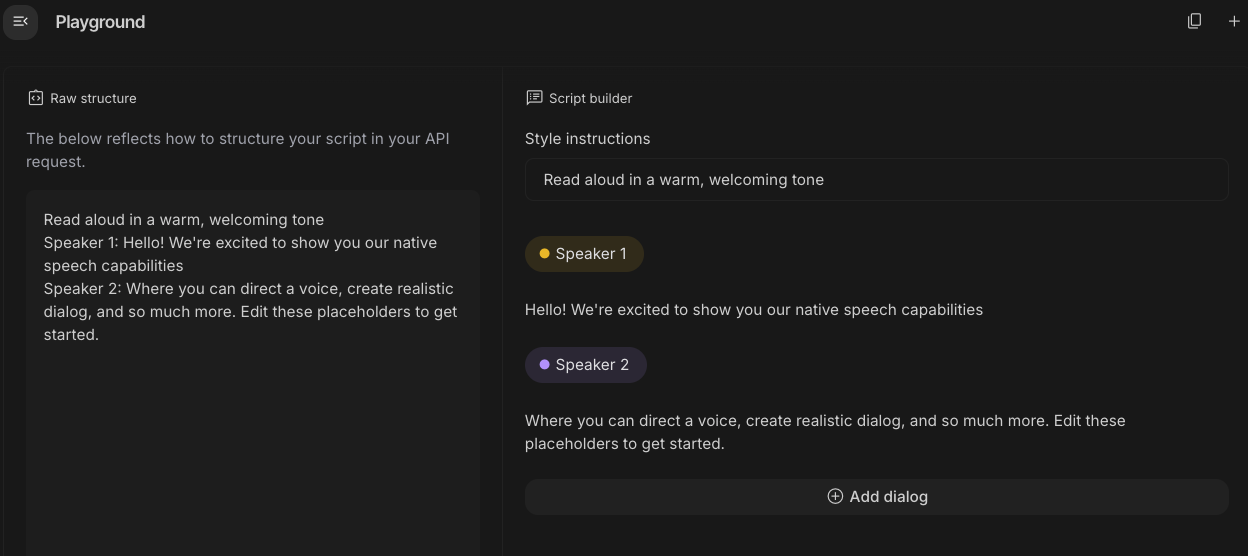

12. Generowanie tekstu na mowę 🎶

Gemini może przekształcać tekst w dźwięk z jednym lub wieloma mówcami, korzystając z funkcji zamiany tekstu na mowę (TTS). Generowanie TTS jest kontrolowane, co oznacza, że możesz używać języka naturalnego do strukturyzowania interakcji i określania stylu, akcentu, tempa i tonu dźwięku.

Tekst na mowę obsługują 2 modele:

Funkcja TTS różni się od generowania mowy za pomocą interfejsu Live API, który jest przeznaczony do interaktywnego, nieustrukturyzowanego dźwięku oraz wejść i wyjść multimodalnych. Interfejs Live API sprawdza się w dynamicznych kontekstach konwersacyjnych, a TTS za pomocą interfejsu Gemini API jest dostosowany do scenariuszy, które wymagają dokładnego odczytania tekstu z precyzyjną kontrolą stylu i dźwięku, takich jak generowanie podcastów lub audiobooków.

Oto fragment kodu dla TTS z jednym głosem:

from google import genai

from google.genai import types

import wave

# Set up the wave file to save the output:

def wave_file(filename, pcm, channels=1, rate=24000, sample_width=2):

with wave.open(filename, "wb") as wf:

wf.setnchannels(channels)

wf.setsampwidth(sample_width)

wf.setframerate(rate)

wf.writeframes(pcm)

client = genai.Client()

response = client.models.generate_content(

model="gemini-2.5-flash-preview-tts",

contents="Say cheerfully: Have a wonderful day!",

config=types.GenerateContentConfig(

response_modalities=["AUDIO"],

speech_config=types.SpeechConfig(

voice_config=types.VoiceConfig(

prebuilt_voice_config=types.PrebuiltVoiceConfig(

voice_name='Kore',

)

)

),

)

)

data = response.candidates[0].content.parts[0].inline_data.data

file_name='out.wav'

wave_file(file_name, data) # Saves the file to current directory

Więcej przykładów znajdziesz w dokumentacji dotyczącej generowania tekstu na mowę.

Możesz też wypróbować generowanie mowy na platformie Google AI Studio. Wypróbuj różne prompty w aplikacji generate-speech:

13. Rozumienie przestrzeni 🌐

Gemini ma zaawansowane funkcje wykrywania obiektów i rozumienia przestrzeni.

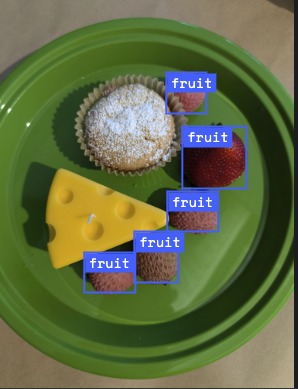

Najłatwiej to zrozumieć, widząc to w praktyce. Otwórz aplikację startową Spatial Understanding w AI Studio. Wybierz kilka obrazów i spróbuj wykryć na nich elementy za pomocą Gemini.

Możesz na przykład wykryć „cienie” lub „owoce” na różnych obrazach:

Wypróbuj różne obrazy i sprawdź, jak dobrze Gemini wykrywa i oznacza różne obiekty.

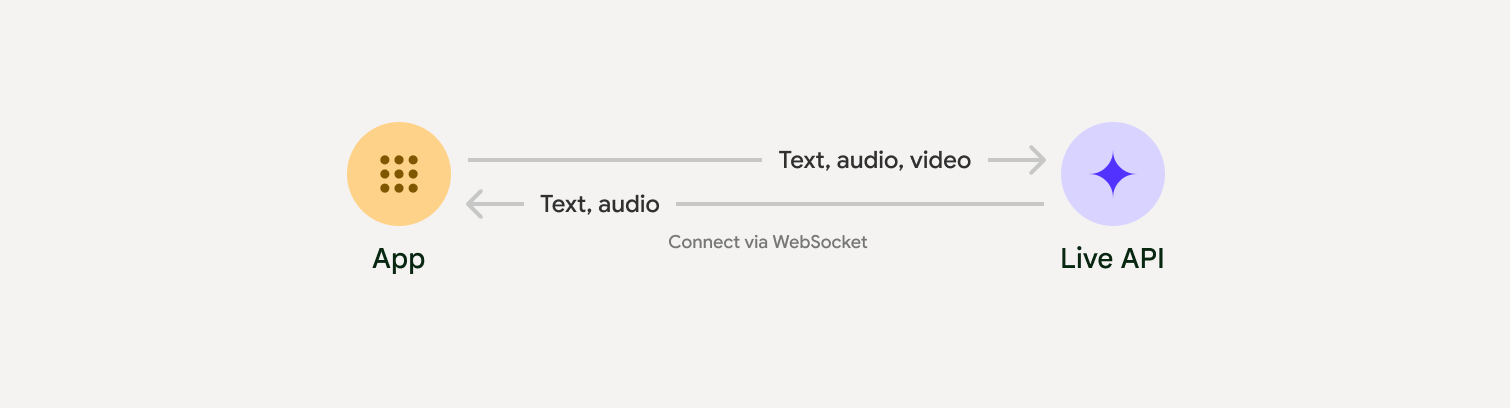

14. Interfejs Live API 🎤

Interfejs Live API umożliwia interakcje z Gemini z użyciem głosu i wideo w czasie rzeczywistym z niewielkimi opóźnieniami. Przetwarza ciągłe strumienie audio, wideo lub tekstu, aby dostarczać natychmiastowe odpowiedzi głosowe, które brzmią jak ludzkie, tworząc naturalne doświadczenie konwersacyjne dla użytkowników.

Wypróbuj interfejs API na żywo w Google AI Studio lub interfejs API na żywo w Vertex AI Studio. W obu aplikacjach możesz udostępniać głos, wideo i ekran oraz prowadzić rozmowę na żywo z Gemini.

Rozpocznij udostępnianie filmu lub ekranu i zadawaj Gemini ogólne pytania głosowo. Na przykład:

Can you describe what you see on the screen?

Zaskoczy Cię, jak naturalnie brzmią odpowiedzi Gemini.

15. Podsumowanie

W tym laboratorium kodowym omówiliśmy ekosystem Gemini, zaczynając od rodziny usług Gemini i ucząc się, jak integrować modele z aplikacjami za pomocą ujednoliconego pakietu Google Gen AI SDK. Omówiliśmy najnowocześniejsze funkcje Gemini, w tym długie okno kontekstowe, tryb myślenia, wbudowane narzędzia do ugruntowania, interfejs Live API i rozumienie przestrzenne. Zachęcamy do zapoznania się z dokumentacją i dalszego eksperymentowania z pełnym potencjałem Gemini.

References

- Aplikacja Gemini

- NotebookLM

- Google AI Studio

- Vertex AI Studio

- Interfejs wiersza poleceń Gemini

- Google Antigravity

- Modele Gemini

- Google Gen AI SDK

- Python SDK

- Go SDK

- Pakiet SDK Node

- Java SDK

- Pakiet SDK w języku C#

- Interactions API

- Agent Deep Research w Gemini

- Generowanie obrazów za pomocą Nano Banana

- Generowanie tekstu na mowę (TTS)

- Live API