1. Introdução 👋

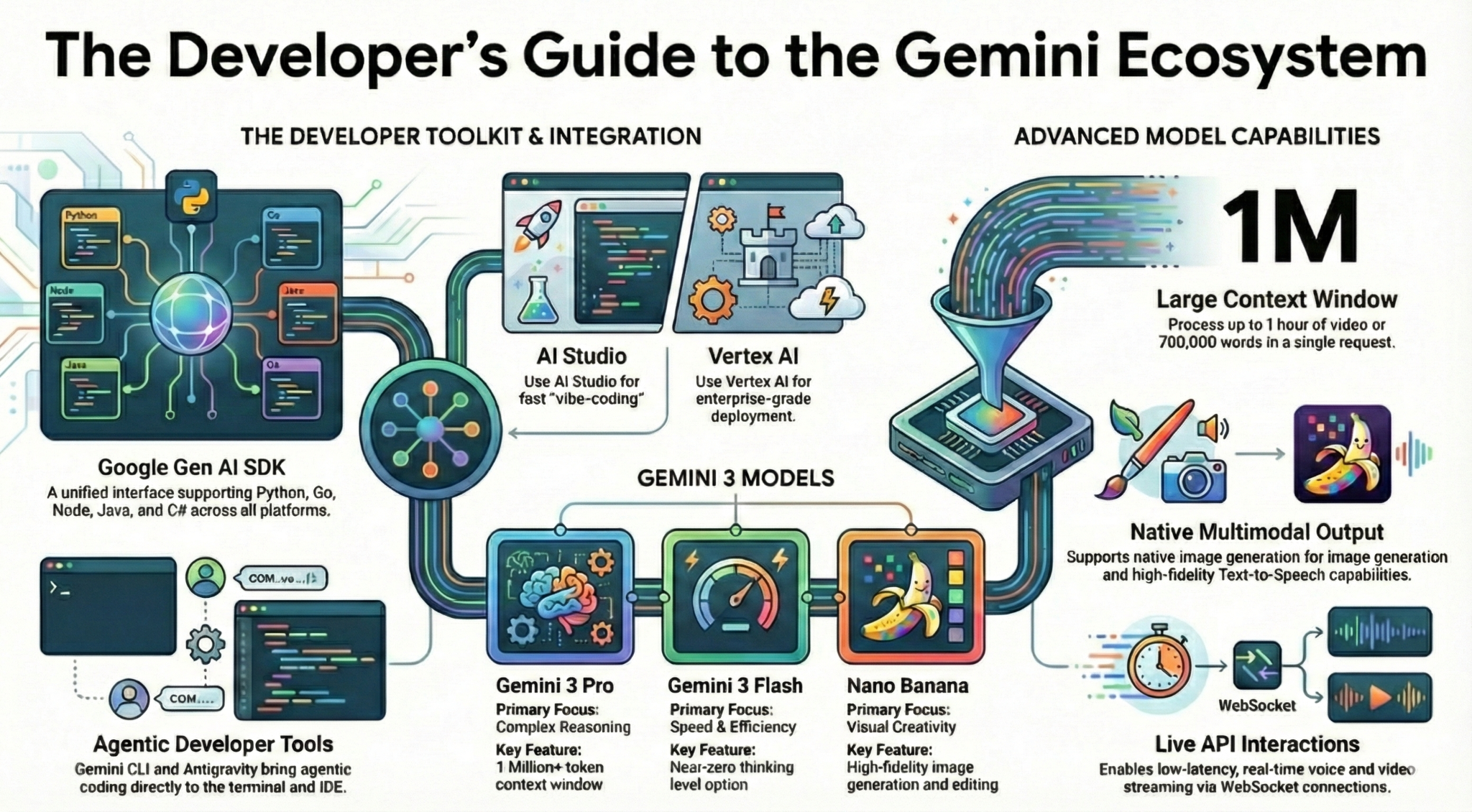

Neste codelab, você vai aprender tudo o que precisa saber, como desenvolvedor, sobre o ecossistema do Gemini. Mais especificamente, você vai conhecer diferentes modelos do Gemini, ferramentas com tecnologia do Gemini e o SDK da IA generativa do Google para integração com o Gemini. Você também vai conhecer vários recursos do Gemini, como contexto longo, modo de pensar, compreensão espacial, API Live, saída nativa de imagem e áudio e muito mais.

Ao final deste codelab, você terá um conhecimento sólido do ecossistema do Gemini.

💡O que você vai aprender

- Diferentes modelos do Gemini.

- Ferramentas com tecnologia dos modelos do Gemini.

- Como fazer a integração com o Gemini usando o SDK da IA generativa do Google.

- Janela de contexto longa do Gemini.

- Modo de raciocínio do Gemini.

- Diferentes ferramentas integradas, como a Pesquisa Google e o Google Maps.

- Como interagir com agentes de pesquisa usando a API Interactions.

- Geração de imagens e conversão de texto em voz.

- Compreensão espacial do Gemini.

- API Live para interações de voz e vídeo em tempo real.

⚠️ O que é necessário

- Uma chave de API para amostras do Google AI Studio.

- Um projeto do Google Cloud com o faturamento ativado para exemplos da Vertex AI.

- Seu ambiente de desenvolvimento local ou o editor do Cloud Shell no Google Cloud.

2. A família Gemini 🫂

O Gemini é o modelo de IA do Google que tira qualquer ideia do papel. Ele é um ótimo modelo para compreensão multimodal e programação vibe coding e agêntica, tudo com base em um raciocínio de última geração. Assista este vídeo para uma visão geral rápida do modelo do Gemini:

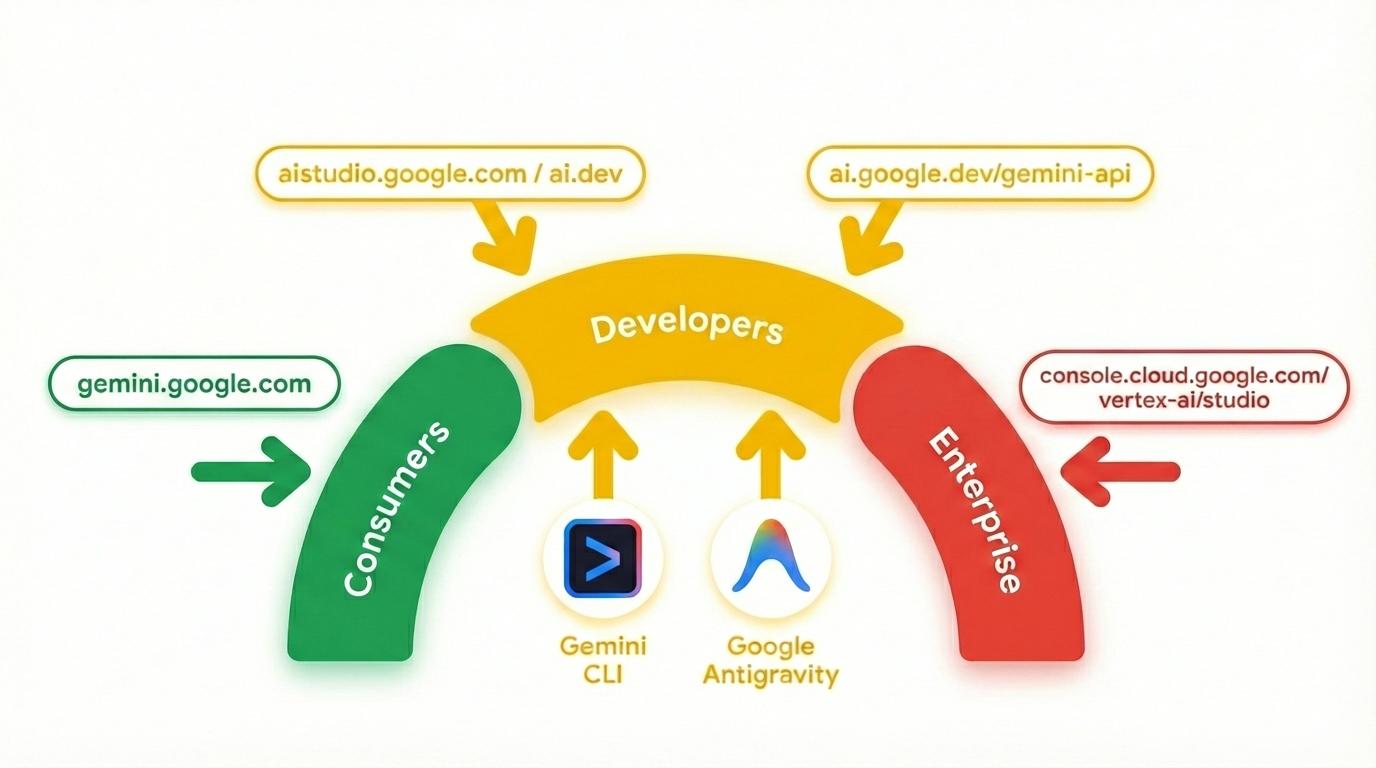

O Gemini não é apenas um modelo. Ela também é uma marca geral usada em produtos do Google

que usam o modelo do Gemini. Há um espectro de produtos do Gemini, desde o app Gemini e o NotebookLM, focados no consumidor, até o AI Studio, focado em desenvolvedores, e a Vertex AI, do Google Cloud, focada em empresas. Há também ferramentas para desenvolvedores, como a CLI do Gemini e o Google Antigravity, com tecnologia do Gemini.

3. Ferramentas com tecnologia do Gemini 🧰

Vamos dar uma olhada rápida nas ferramentas com tecnologia do Gemini.

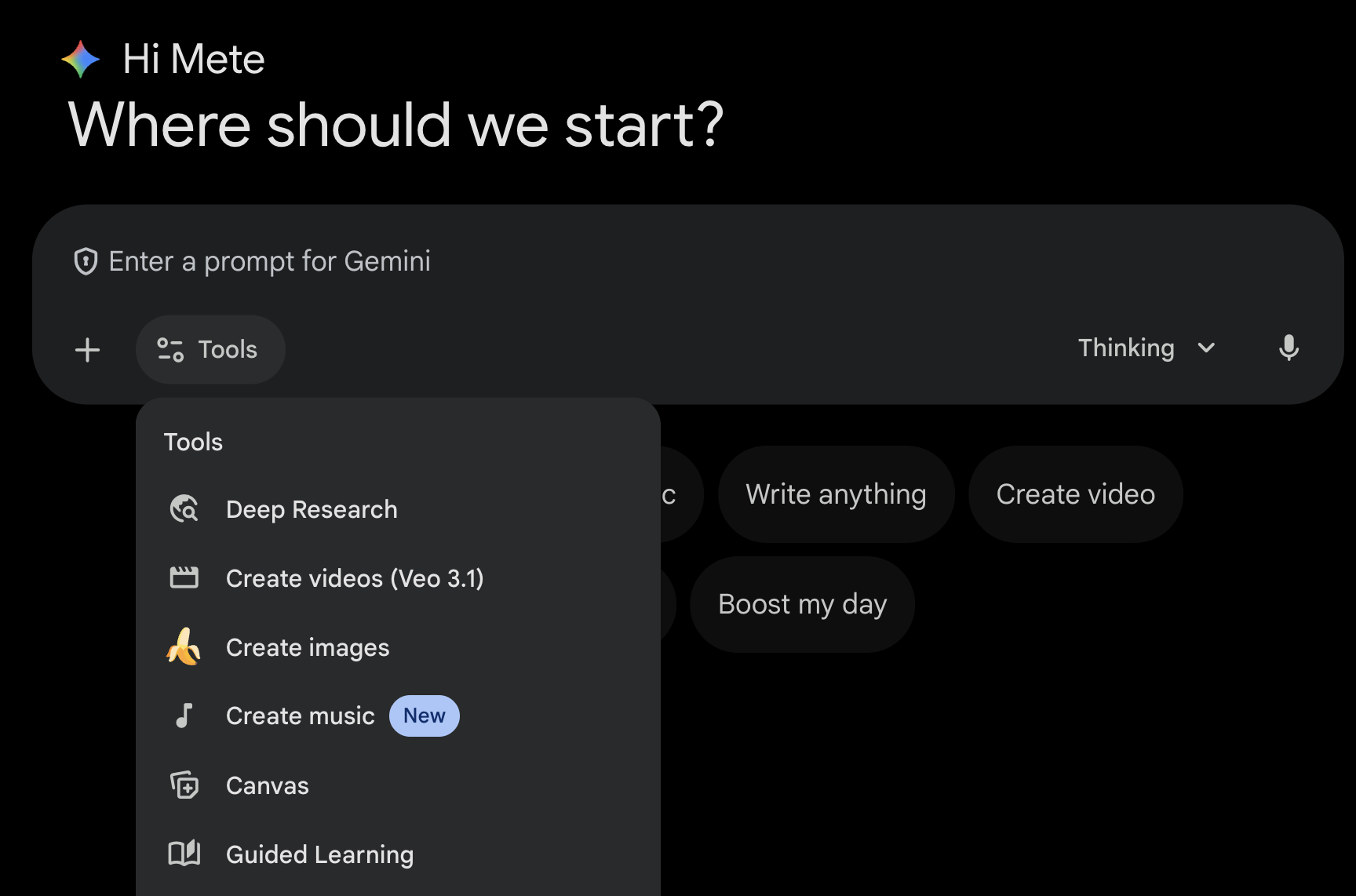

App Gemini 💬

O app Gemini ( gemini.google.com) é um aplicativo para consumidores baseado em chat. É a maneira mais fácil de interagir com o Gemini. Ele tem ferramentas para pesquisa avançada, geração de imagens, vídeos, músicas e muito mais. Ele também tem diferentes versões do modelo mais recente do Gemini (Fast, Thinking, Pro). O app Gemini é perfeito para uso diário.

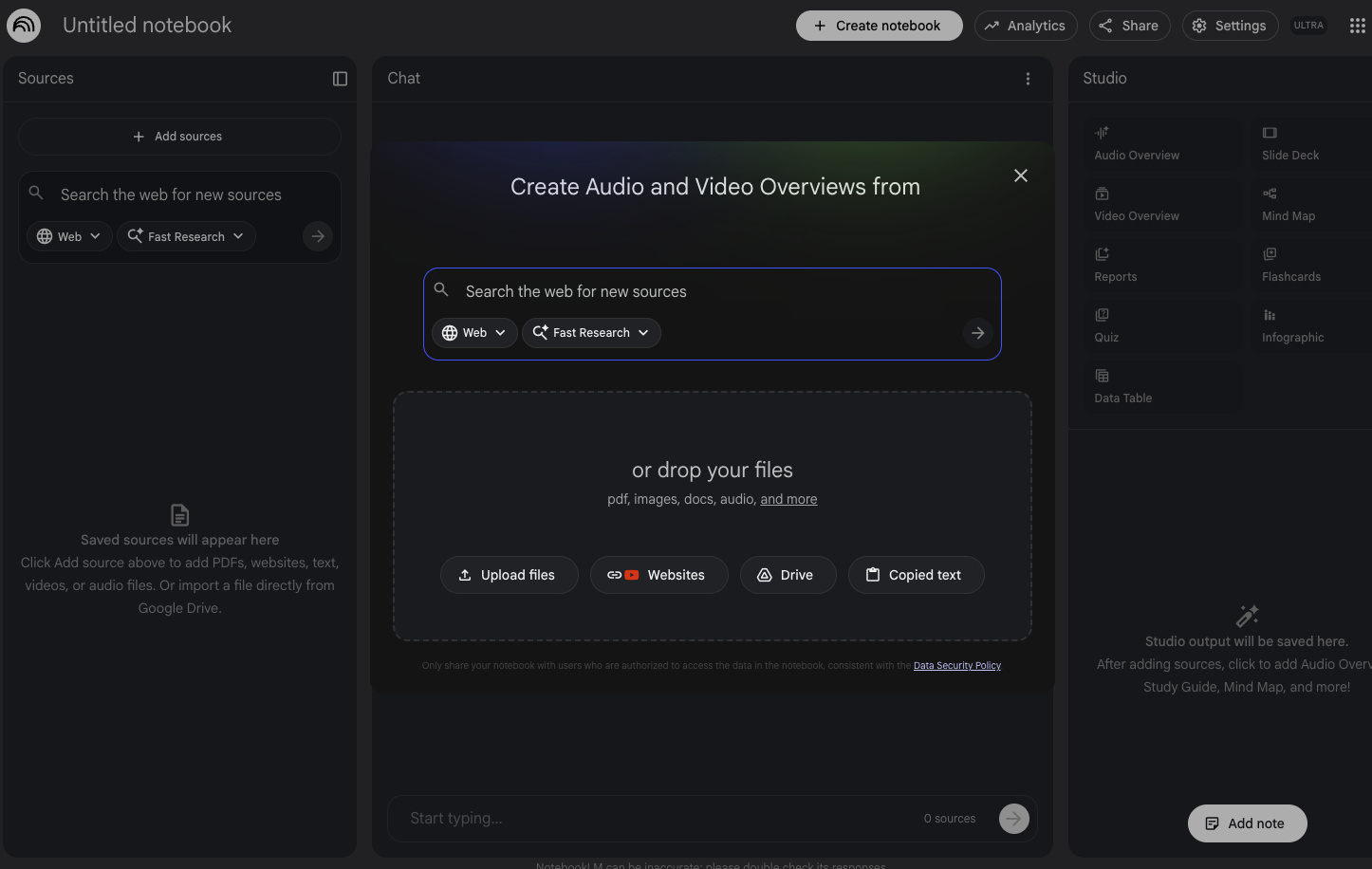

NotebookLM 📓

O NotebookLM ( notebooklm.google.com) é um parceiro de pesquisa com tecnologia de IA. Envie PDFs, sites, vídeos do YouTube, arquivos de áudio, Google Docs, Slides e muito mais para o NotebookLM resumir tudo e fazer conexões interessantes entre assuntos. Tudo isso com a versão mais recente da tecnologia de compreensão multimodal do Gemini. Ele também gera resumos em áudio e vídeo, infográficos e muito mais com base nas fontes que você enviou.

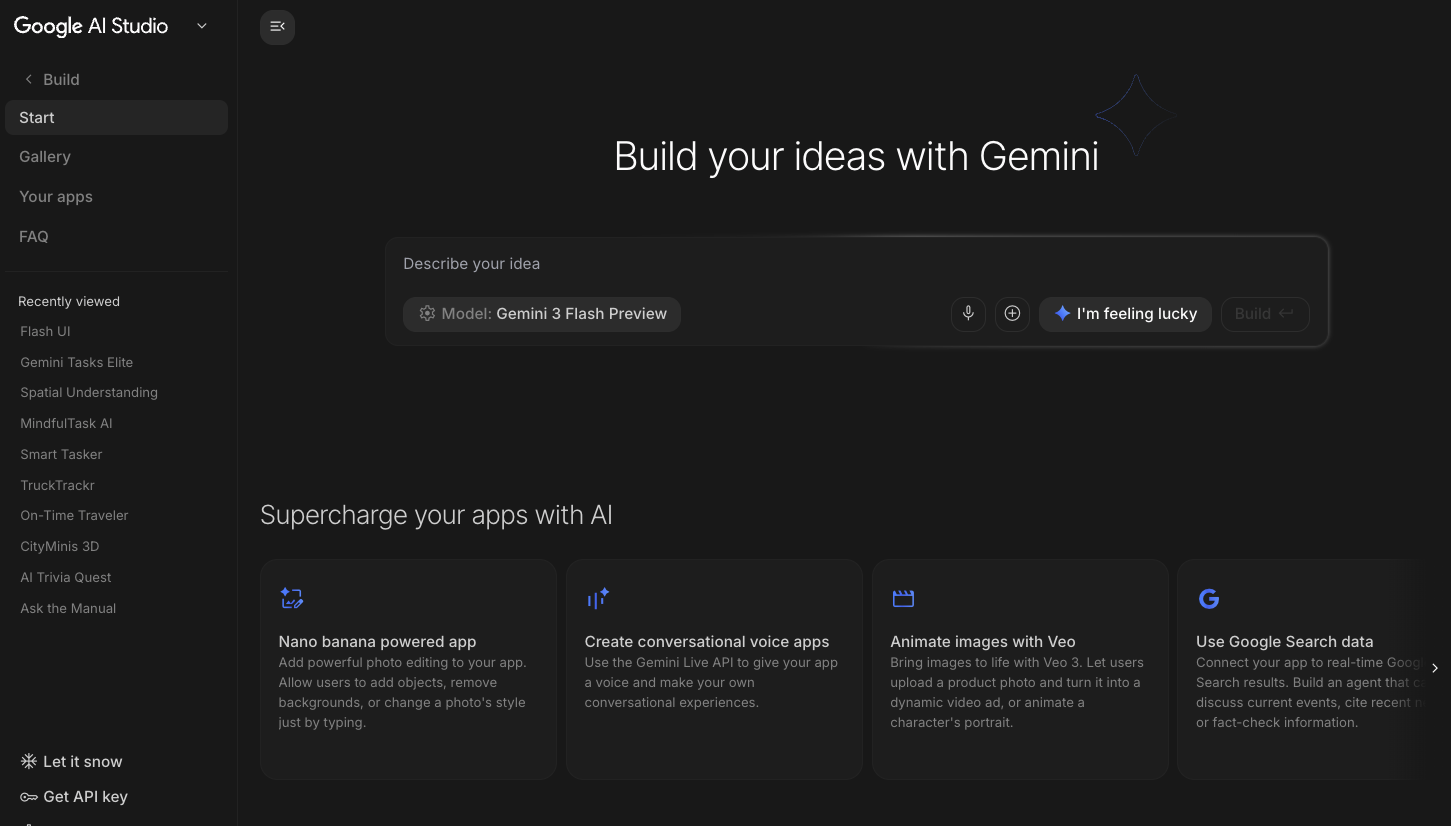

Google AI Studio 🎨

O Google AI Studio ( ai.dev) é a maneira mais rápida de começar a criar com o Gemini. O painel Playground no Google AI Studio permite testar diferentes modelos para gerar texto, imagem e vídeo, além de usar voz e vídeo em tempo real com a API Gemini Live. O painel Build no Google AI Studio permite criar aplicativos da Web com vibe-code, implantá-los no Cloud Run no Google Cloud e enviar o código para o GitHub.

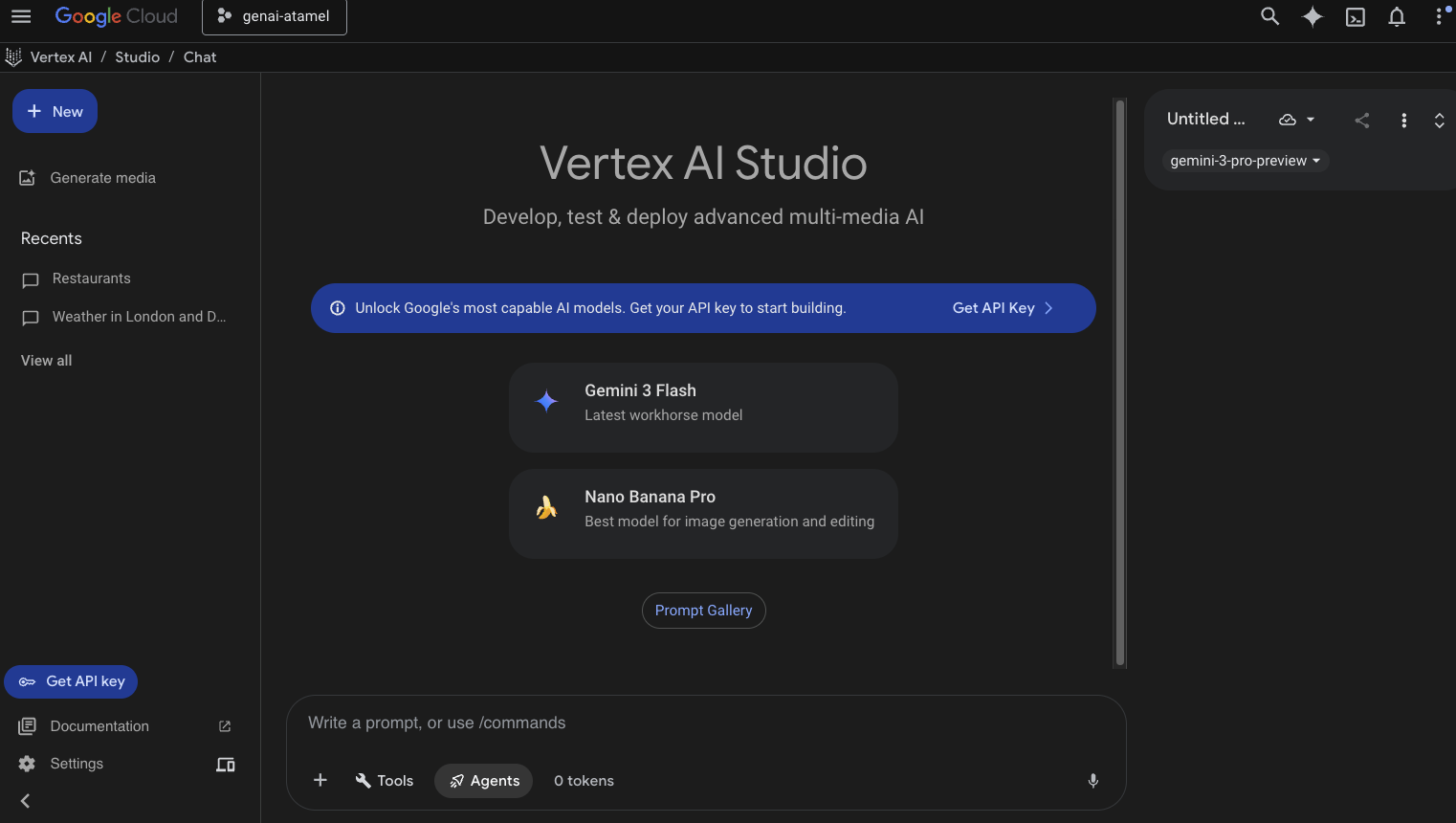

Vertex AI Studio ☁️

A Vertex AI é uma plataforma de desenvolvimento de IA unificada e totalmente gerenciada para criar e usar a IA generativa no Google Cloud. O Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) ajuda você a testar, ajustar e implantar aplicativos de IA generativa prontos para empresas.

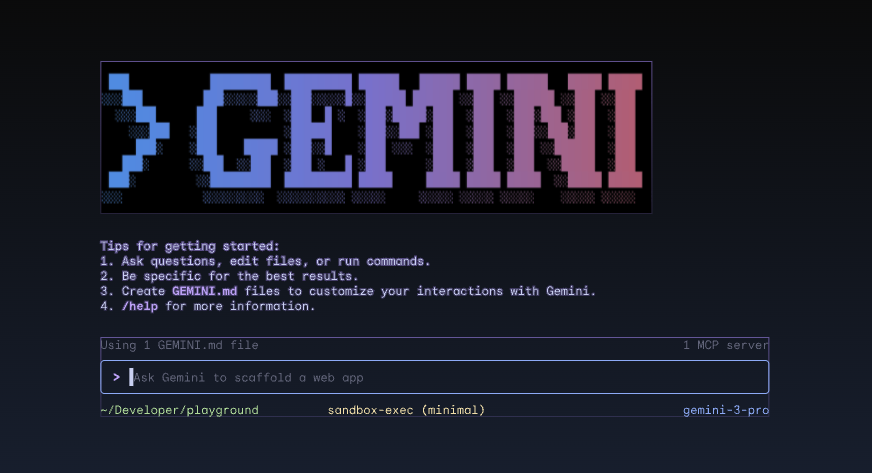

CLI do Gemini ⚙️

A CLI do Gemini ( geminicli.com) é um agente de IA de código aberto que traz o poder do Gemini diretamente para o seu terminal. Ele foi projetado para ser uma ferramenta extensível e poderosa, com foco no terminal, para desenvolvedores, engenheiros, SREs e muito mais. A CLI do Gemini se integra ao seu ambiente local. Ele pode ler e editar arquivos, executar comandos do shell e pesquisar na Web, tudo isso mantendo o contexto do projeto.

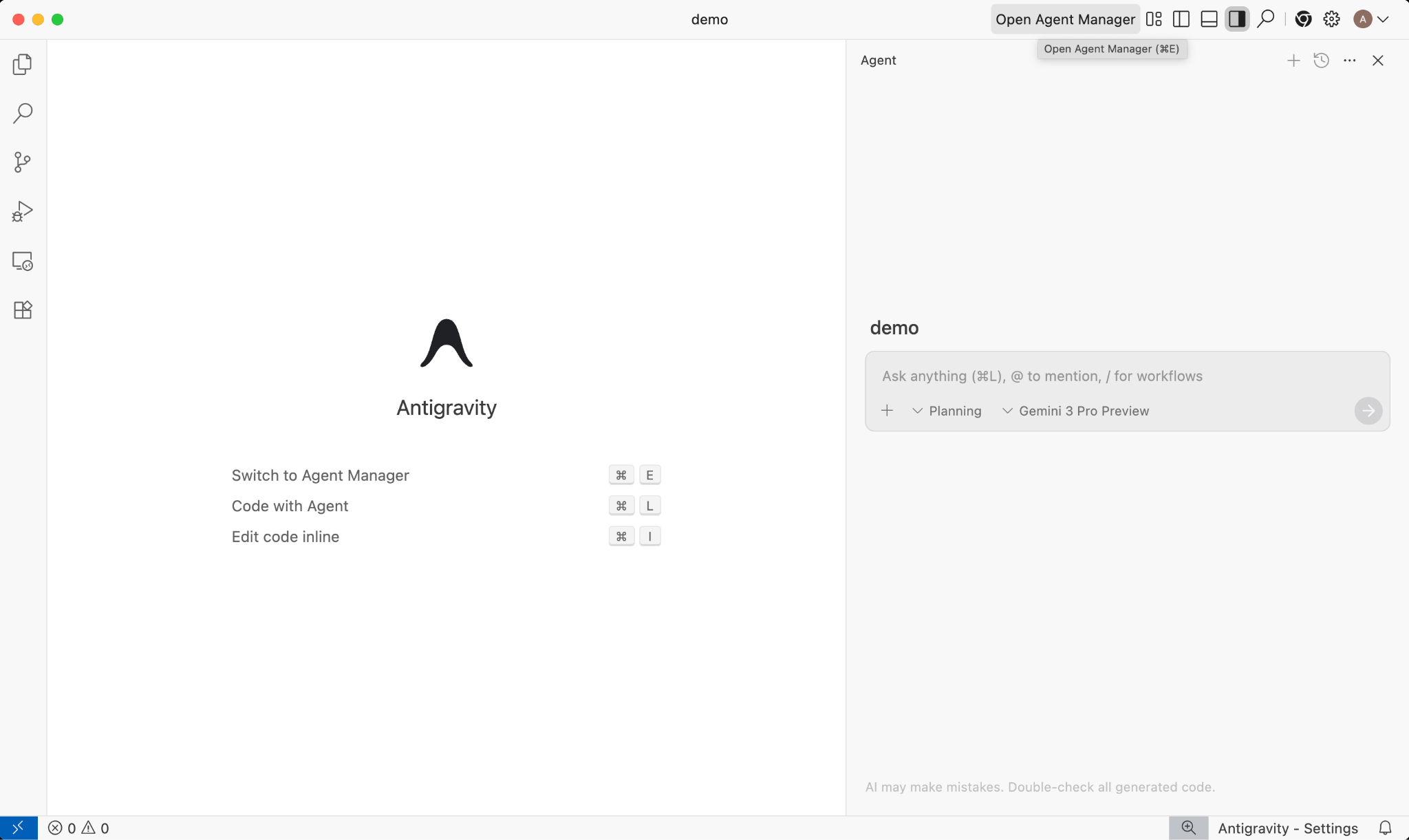

Google Antigravity 🚀

O Google Antigravity ( antigravity.google) é uma plataforma de desenvolvimento agêntica que evolui o IDE para a era focada em agentes. O Antigravity permite que os desenvolvedores operem em um nível mais alto e orientado a tarefas, gerenciando agentes em vários espaços de trabalho, mantendo uma experiência familiar de IDE de IA no núcleo.

O Antigravity extrai os agentes para a própria superfície e oferece as ferramentas necessárias para operar de forma autônoma no editor, no terminal e no navegador, enfatizando a verificação e a comunicação de nível superior por meio de tarefas e artefatos. Com esse recurso, os agentes podem planejar e executar tarefas de software mais complexas e completas, melhorando todos os aspectos do desenvolvimento, desde a criação de recursos, iteração de UI e correção de bugs até a pesquisa e geração de relatórios.

Baixe e use essas ferramentas. Confira algumas orientações gerais sobre qual ferramenta usar em cada situação:

- Se você estiver começando, provavelmente vai usar o app Gemini para fazer perguntas ou gerar um código básico.

- Se você estiver criando um aplicativo da Web, provavelmente vai escolher o Google AI Studio.

- Se você quiser criar um aplicativo complexo com o contexto do seu ambiente de desenvolvimento local, escolha a CLI Gemini ou o Google Antigravity.

- Se você quiser implantar ou já estiver usando o Google Cloud e quiser suporte e recursos de nível empresarial, a Vertex AI e o Studio são as opções ideais.

É claro que você pode combinar essas ferramentas. Por exemplo, comece com a programação de vibe no AI Studio para enviar ao GitHub e use o Antigravity para continuar programando e implantando no Google Cloud.

4. Modelos do Gemini 🧠

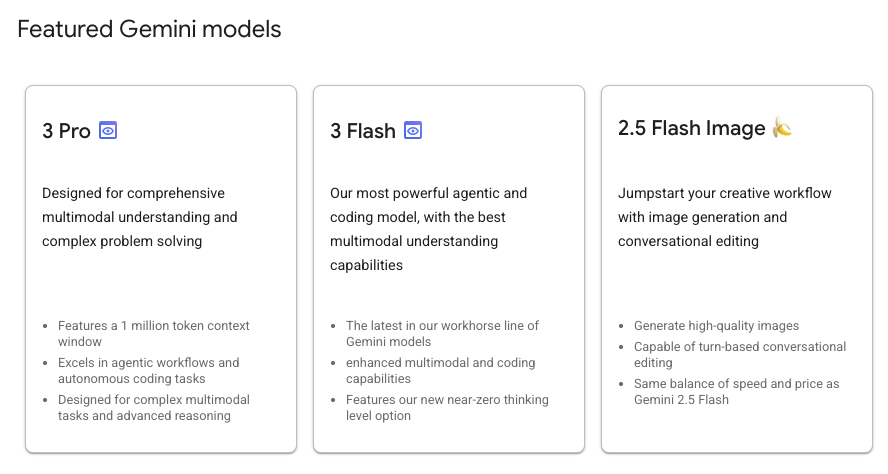

Os modelos do Gemini estão sempre sendo melhorados com novas versões a cada poucos meses. Atualmente (fevereiro de 2026), estes são os modelos em destaque na Vertex AI no Google Cloud:

Há muitos outros modelos do Gemini em disponibilidade geral, modelos do Gemini em pré-lançamento, modelos abertos do Gemma, modelos de incorporação, modelos do Imagegen, modelos do Veo e muito mais.

Acesse a página de documentação dos Modelos do Google para conhecer os principais modelos disponíveis na Vertex AI para diferentes casos de uso.

5. SDK de IA generativa do Google 📦

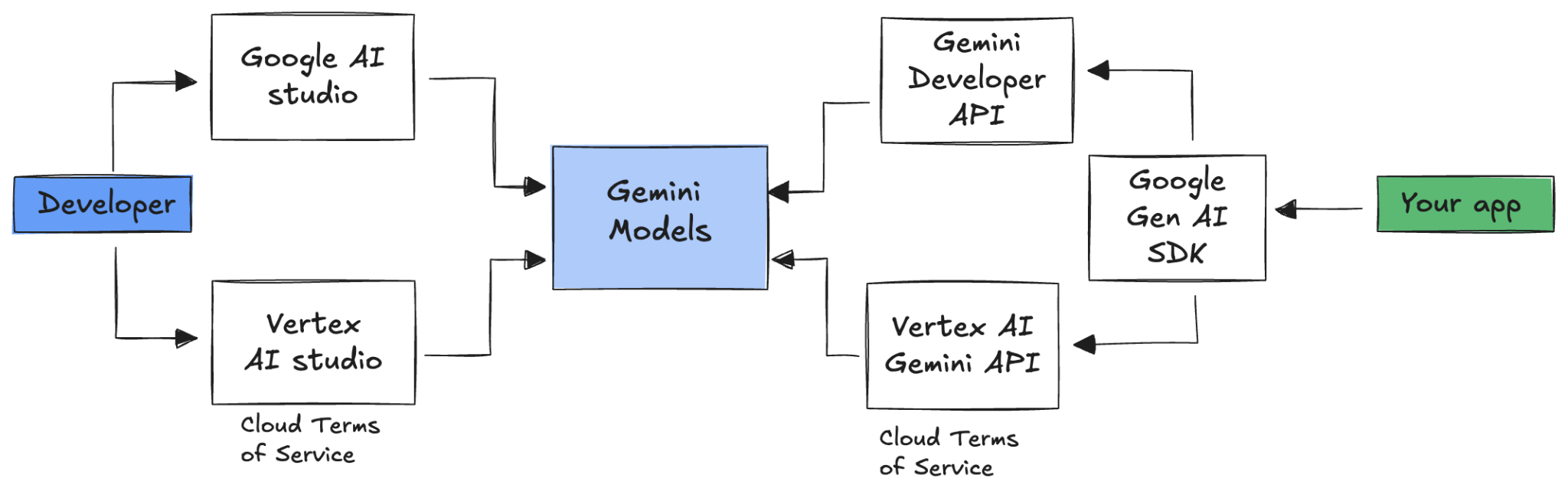

Para integrar o Gemini ao seu aplicativo, use o SDK da IA generativa do Google.

Como já discutimos, é possível acessar os modelos do Gemini pelo Google AI Studio ou pelo Vertex AI Studio. O SDK da IA generativa do Google oferece uma interface unificada para os modelos do Gemini pela API Google AI e pela API Google Cloud. Com algumas exceções, o código executado em uma plataforma será executado nas duas.

No momento, o SDK de IA generativa do Google é compatível com Python, Go, Node, Java e C#.

Por exemplo, é assim que você conversaria com o Gemini na IA do Google em Python:

client = genai.Client(

api_key=your-gemini-api-key)

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Para fazer o mesmo com o Gemini na Vertex AI, basta mudar a inicialização do cliente. O restante é igual:

client = genai.Client(

vertexai=True,

project=your-google-cloud-project,

location="us-central1")

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="Why is the sky blue?")

Para executar essas amostras, execute main.py em github.com/meteatamel/genai-samples/tree/main/vertexai/gemini2/hello-world.

6. API Interactions 🔄

A API Interactions (Beta) é uma nova interface unificada para interagir com modelos e agentes do Gemini. Como uma alternativa aprimorada à API generateContent, ela simplifica o gerenciamento de estado, a orquestração de ferramentas e as tarefas de longa duração.

Esta é uma interação básica com a nova API:

interaction = client.interactions.create(

model="gemini-3-flash-preview",

input="Tell me a short joke."

)

print(interaction.outputs[-1].text)

Para ter uma conversa com estado, transmita o ID da interação anterior:

interaction1 = client.interactions.create(

model="gemini-3-flash-preview",

input="Hi, my name is Phil."

)

print(f"Model: {interaction1.outputs[-1].text}")

interaction2 = client.interactions.create(

model="gemini-3-flash-preview",

input="What is my name?",

previous_interaction_id=interaction1.id

)

print(f"Model: {interaction2.outputs[-1].text}")

A API Interactions foi projetada para criar e interagir com agentes e inclui suporte para chamadas de função, ferramentas integradas, saídas estruturadas e o Protocolo de Contexto de Modelo (MCP). Para saber como ele pode ser usado com o agente Deep Research, consulte a etapa Agentes 🤖 abaixo.

Para executar essas amostras, use main.py em github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api.

7. Janela de contexto longa 🪟

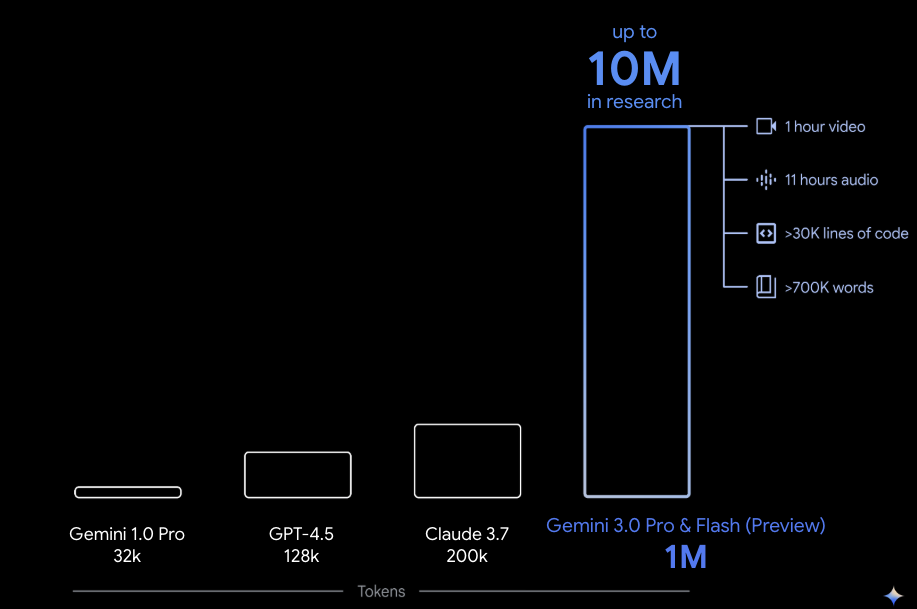

Muitos modelos do Gemini vêm com grandes janelas de contexto de 1 milhão ou mais de tokens. Historicamente, os modelos de linguagem grandes (LLMs) eram significativamente limitados pela quantidade de texto (ou tokens) que podiam ser transmitidos ao modelo de uma só vez. A janela de contexto longo do Gemini libera muitos novos casos de uso e paradigmas de desenvolvedor.

Para ver a janela de contexto longo em ação, acesse a Galeria de comandos do Vertex AI Studio e escolha o comando Extract Video Chapters. Esse comando agrupa o conteúdo do vídeo em capítulos e fornece um resumo de cada um deles.

Depois de executar o comando com o vídeo fornecido, você vai receber uma saída semelhante a esta:

[

{

"timecode": "00:00",

"chapterSummary": "The video opens with scenic views of Rio de Janeiro, introducing the \"Marvelous City\" and its famous beaches like Ipanema and Copacabana, before pivoting to the existence of the favelas."

},

{

"timecode": "00:20",

"chapterSummary": "The narrator describes the favelas, home to one in five Rio residents, highlighting that while often associated with crime and poverty, this is only a small part of their story."

},

{

"timecode": "00:36",

"chapterSummary": "Google introduces its project to map the favelas, emphasizing that providing addresses to these uncharted areas is a crucial step in giving residents an identity."

},

{

"timecode": "00:43",

"chapterSummary": "The video concludes by focusing on the people of the favelas, inviting viewers to go beyond the map and explore their world through a 360-degree experience."

}

]

Isso só é possível graças à longa janela de contexto do Gemini.

8. Modo de pensamento 🧠

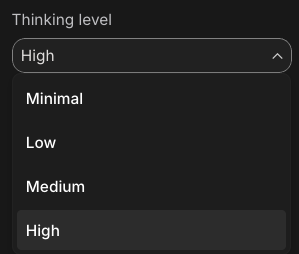

Os modelos do Gemini usam um processo de raciocínio interno que melhora significativamente a capacidade de raciocínio para tarefas complexas. Os níveis de pensamento (Gemini 3) e os orçamentos (Gemini 2.5) controlam o comportamento de pensamento. Você também pode ativar a flag include_thoughts para ver as ideias brutas do modelo.

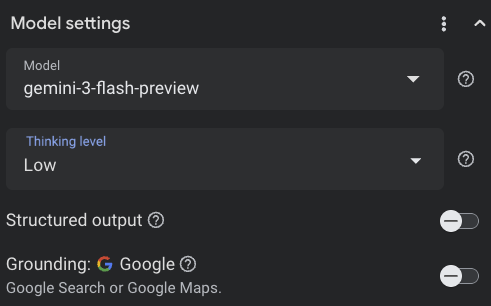

Para ver o modo de pensamento em ação, abra o Google AI Studio ( ai.dev) e inicie um novo chat. No painel à direita, você pode definir o nível de pensamento:

Se você clicar no botão Get code no canto superior direito, também poderá ver como definir o nível de pensamento no código, algo semelhante a isto:

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="How does AI work?",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(

thinking_level="low",

include_thoughts=True

)

),

)

Teste diferentes comandos e níveis de pensamento para entender o comportamento do modelo.

9. Ferramentas 🧰

O Gemini vem com várias ferramentas integradas, como Pesquisa Google, Google Maps, execução de código, uso do computador, pesquisa de arquivos e muito mais. Também é possível definir suas ferramentas personalizadas com a chamada de função. Vamos ver como usá-los brevemente.

Pesquisa Google 🔎

Você pode embasar as respostas do modelo nos resultados da Pesquisa Google para ter respostas mais precisas, atualizadas e relevantes.

No Vertex AI Studio ( console.cloud.google.com/vertex-ai/studio) ou no Google AI Studio ( ai.dev), inicie uma nova conversa e verifique se o embasamento da Pesquisa Google está desativado:

Em seguida, faça uma pergunta sobre a previsão do tempo para hoje na sua localização. Exemplo:

How's the weather in London today?

Geralmente, você recebe uma resposta para um dia no passado porque o modelo não tem acesso às informações mais recentes. Exemplo:

In London today (Friday, May 24, 2025), the weather is a bit of a mixed bag, typical for late May.

Agora, ative o embasamento da Pesquisa Google e faça a mesma pergunta. Você vai receber informações atualizadas sobre o clima com links para as fontes de embasamento:

In London today (Wednesday, February 11, 2026), the weather is cool and mostly cloudy with a chance of light rain.

É assim que você teria o embasamento da Pesquisa Google no seu código. Você também pode clicar no botão "Código" no Vertex AI Studio para receber um exemplo de embasamento:

google_search_tool = Tool(google_search=GoogleSearch())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="How's the weather like today in London?",

config=GenerateContentConfig(tools=[google_search_tool])

)

Google Maps 🗺️

Você também pode embasar as respostas do modelo com o Google Maps, que tem acesso a informações sobre mais de 250 milhões de lugares.

Para ver como funciona, escolha o Google Maps em vez da Pesquisa Google na seção de embasamento das configurações do modelo no Vertex AI Studio e faça uma pergunta que exija dados do Maps, por exemplo:

Can you show me some Greek restaurants and their map coordinates near me?

O código fica assim:

google_maps_tool = Tool(google_maps=GoogleMaps())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents=""What are the best restaurants near here?",

config=GenerateContentConfig(tools=[google_maps_tool]),

# Optional: Provide location context (this is in Los Angeles)

tool_config=ToolConfig(

retrieval_config=types.RetrievalConfig(

lat_lng=types.LatLng(

latitude=34.050481, longitude=-118.248526))),

)

Execução de código 🧑💻

O Gemini pode gerar e executar código Python com uma lista de bibliotecas compatíveis (pandas, numpy, PyPDF2 etc.). Isso é útil para aplicativos que usam o raciocínio baseado em código (por exemplo, resolver equações).

Para testar, mude para o Google AI Studio, inicie uma nova conversa e verifique se a chave Code execution está ativada. Em seguida, faça uma pergunta em que a ferramenta de execução de código possa ser útil. Exemplo:

What is the sum of the first 50 prime numbers?

O Gemini vai gerar e executar um código Python. No final, a resposta certa é 5117.

É possível executar a ferramenta de execução de código no código da seguinte maneira:

code_execution_tool = Tool(code_execution=ToolCodeExecution())

response = client.models.generate_content(

model="gemini-3-flash-preview",

contents="What is the sum of the first 50 prime numbers?",

config=GenerateContentConfig(

tools=[code_execution_tool],

temperature=0))

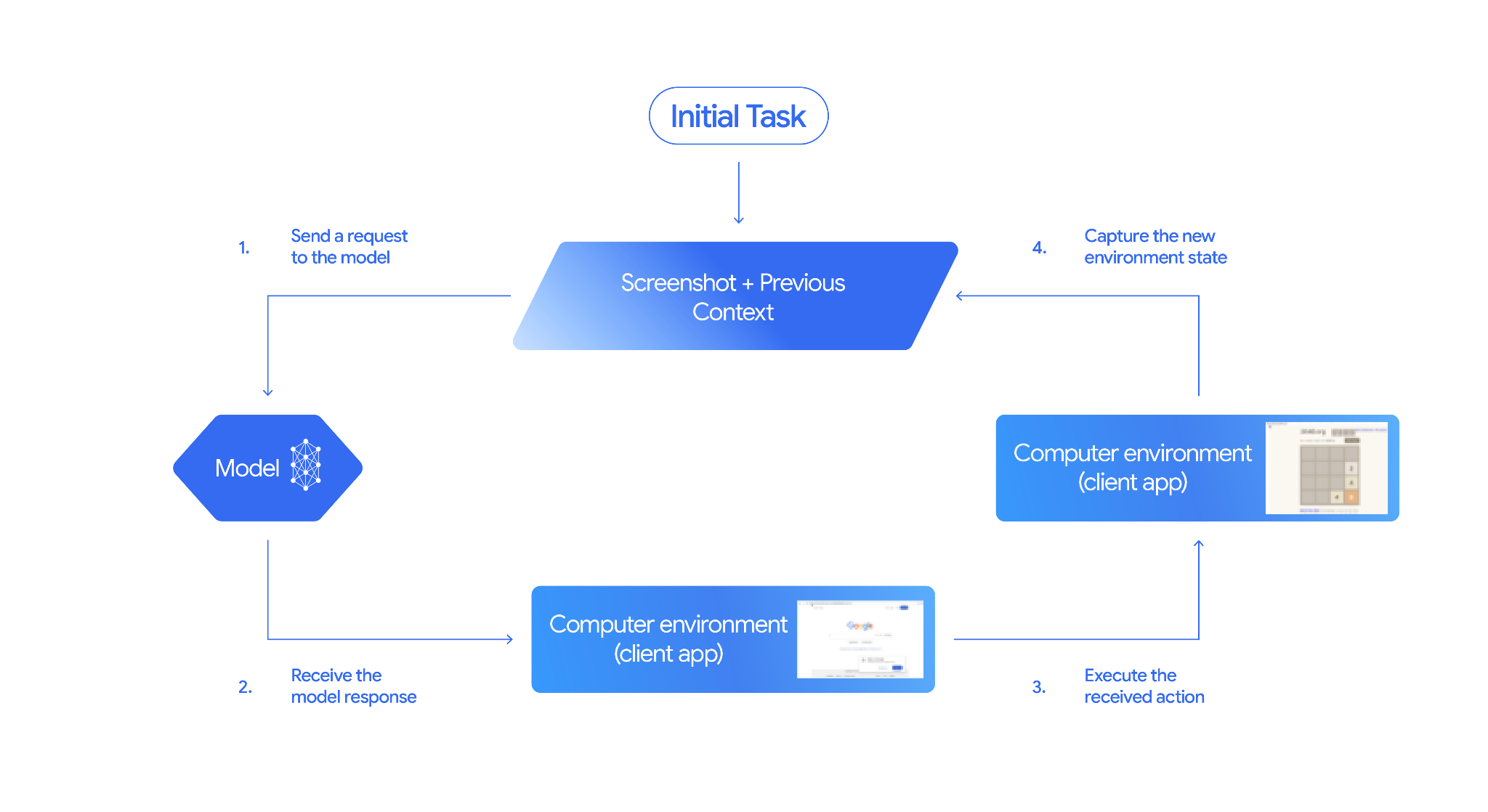

Uso de computador 🖥️

O modelo de uso de computador do Gemini (prévia) permite criar agentes de controle do navegador para automatizar tarefas. Ele funciona neste loop:

Para ver em ação, execute main.py em github.com/google-gemini/computer-use-preview.

Por exemplo, você pode acessar sua chave de API no Google AI Studio e pedir para o Gemini pesquisar voos para você:

export GEMINI_API_KEY=your-api-key

python main.py --query "Find me top 5 fights sorted by price with the following constraints:

Flight site to use: www.google.com/travel/flights

From: London

To: Larnaca

One-way or roundtrip: One way

Date to leave: Sometime next week

Date to return: N/A

Travel preferences:

-Direct flights

-No flights before 10am

-Carry-on luggage"

O Gemini vai abrir um navegador anônimo e começar a pesquisar voos para você.

Pesquisa de arquivos 📁

A ferramenta de pesquisa de arquivos permite a geração aumentada de recuperação (RAG) sem esforço. Basta fazer upload dos seus arquivos, e ele faz todos os detalhes de RAG de fragmentação, incorporação e recuperação para você.

Para ver isso em ação, execute main.py em github.com/meteatamel/genai-beyond-basics/blob/main/samples/grounding/file-search-tool.

Receba sua chave de API do Google AI Studio e crie um repositório de pesquisa de arquivos:

export GEMINI_API_KEY=your-gemini-api-key

python main.py create_store my-file-search-store

Faça upload de um PDF para a loja:

python main.py upload_to_store fileSearchStores/myfilesearchstore-5a9x71ifjge9 cymbal-starlight-2024.pdf

Faça uma pergunta sobre o PDF apontando para a loja:

python main.py generate_content "What's the cargo capacity of Cymbal Starlight?" fileSearchStores/myfilesearchstore-5a9x71ifjge9

Você vai receber uma resposta baseada no PDF:

Generating content with file search store: fileSearchStores/myfilesearchstore-5a9x71ifjge9

Response: The Cymbal Starlight 2024 has a cargo capacity of 13.5 cubic feet, which is located in the trunk of the vehicle. It is important to distribute the weight evenly and not overload the trunk, as this could impact the vehicle's handling and stability. The vehicle can also accommodate up to two suitcases in the trunk, and it is recommended to use soft-sided luggage to maximize space and cargo straps to secure it while driving.

Grounding sources: cymbal-starlight-2024.pdf

Chamada de função 📲

Se as ferramentas integradas não forem suficientes, você também poderá definir suas próprias ferramentas (funções) no Gemini. Basta enviar uma função Python como uma ferramenta, em vez de enviar uma especificação detalhada da OpenAPI. Ele é usado automaticamente como uma ferramenta pelo modelo e pelo SDK.

Por exemplo, você pode ter uma função para retornar a latitude e a longitude de um local:

def location_to_lat_long(location: str):

"""Given a location, returns the latitude and longitude

Args:

location: The location for which to get the weather.

Returns:

The latitude and longitude information in JSON.

"""

logger.info(f"Calling location_to_lat_long({location})")

url = f"https://geocoding-api.open-meteo.com/v1/search?name={location}&count=1"

return api_request(url)

Você também pode ter uma função para retornar as informações meteorológicas de uma latitude e longitude:

def lat_long_to_weather(latitude: str, longitude: str):

"""Given a latitude and longitude, returns the weather information

Args:

latitude: The latitude of a location

longitude: The longitude of a location

Returns:

The weather information for the location in JSON.

"""

logger.info(f"Calling lat_long_to_weather({latitude}, {longitude})")

url = (f"https://api.open-meteo.com/v1/forecast?latitude={latitude}&longitude={longitude}¤t=temperature_2m,"

f"relative_humidity_2m,surface_pressure,wind_speed_10m,wind_direction_10m&forecast_days=1")

return api_request(url)

Agora, você pode transmitir essas duas funções como ferramentas para o Gemini e permitir que ele as use para buscar informações meteorológicas de um local:

def generate_content_with_function_calls():

client = genai.Client(

vertexai=True,

project=PROJECT_ID,

location=LOCATION)

response = client.models.generate_content(

model=MODEL_ID,

contents=PROMPT,

config=GenerateContentConfig(

system_instruction=[

"You are a helpful weather assistant.",

"Your mission is to provide weather information for different cities."

"Make sure your responses are in plain text format (no markdown) and include all the cities asked.",

],

tools=[location_to_lat_long, lat_long_to_weather],

temperature=0),

)

print(response.text)

#print(response.automatic_function_calling_history)

Para ver isso em ação, execute main_genaisdk.py em github.com/meteatamel/genai-beyond-basics/blob/main/samples/function-calling/weather.

10. Agentes 🤖

A API Interactions do Gemini foi projetada para criar e interagir com agentes. Você pode usar agentes especializados, como o Deep Research do Gemini. O agente Deep Research do Gemini planeja, executa e sintetiza de forma autônoma tarefas de pesquisa em várias etapas. Ele navega por paisagens complexas de informações usando a pesquisa na Web e seus próprios dados para produzir relatórios detalhados e citados.

Veja como usar o agente do Deep Research com a API Interaction:

interaction = client.interactions.create(

input="Research the history of the Google TPUs.",

agent="deep-research-pro-preview-12-2025",

background=True

)

while True:

if interaction.status == "completed":

print("\nFinal Report:\n",

interaction.outputs[-1].text)

break

Para executar essa amostra, execute main.py em github.com/meteatamel/genai-samples/blob/main/vertexai/interactions-api.

export GOOGLE_API_KEY=your-api-key

python main.py agent

Depois de um tempo, a pesquisa vai aparecer:

User: Research the history of the Google TPUs with a focus on 2025 and 2026

Status: in_progress

Status: in_progress

Status: in_progress

...

Model Final Report:

# Architectural Convergence and Commercial Expansion: The History of Google TPUs (2015–2026)

## Key Findings

* **Strategic Pivot (2025):** Google transitioned the Tensor Processing Unit (TPU) from a primarily internal differentiator to a commercial merchant-silicon competitor, epitomized by the massive "Ironwood" (TPU v7) deployment and external sales strategy.

* **Technological Leap:** The introduction of TPU v7 "Ironwood" in 2025 marked a paradigm shift, utilizing 3nm process technology to deliver 42.5 exaFLOPS per pod, directly challenging NVIDIA's Blackwell architecture in the high-performance computing (HPC) sector.

...

11. Geração de imagens 📷

Nano Banana 🍌 é o nome dos recursos nativos de geração de imagens do Gemini. O Gemini pode gerar e processar imagens de forma conversacional com texto, imagens ou uma combinação dos dois. Isso permite criar, editar e repetir recursos visuais com um controle sem precedentes.

O Nano Banana se refere a dois modelos distintos disponíveis na API Gemini:

- Nano Banana: o modelo Gemini 2.5 Flash Image (

gemini-2.5-flash-image). Ele foi projetado para velocidade e eficiência, otimizado para tarefas de alto volume e baixa latência. - Nano Banana Pro: o modelo de prévia de imagem do Gemini 3 Pro (

gemini-3-pro-image-preview). Ele foi projetado para produção profissional de recursos, usando raciocínio avançado para seguir instruções complexas e renderizar texto de alta fidelidade.

Confira um snippet de código em que você pode transmitir uma imagem e pedir ao Nano Banana para editá-la:

from google import genai

from google.genai import types

from PIL import Image

client = genai.Client()

prompt = (

"Create a picture of my cat eating a nano-banana in a "

"fancy restaurant under the Gemini constellation",

)

image = Image.open("/path/to/cat_image.png")

response = client.models.generate_content(

model="gemini-2.5-flash-image",

contents=[prompt, image],

)

for part in response.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = part.as_image()

image.save("generated_image.png")

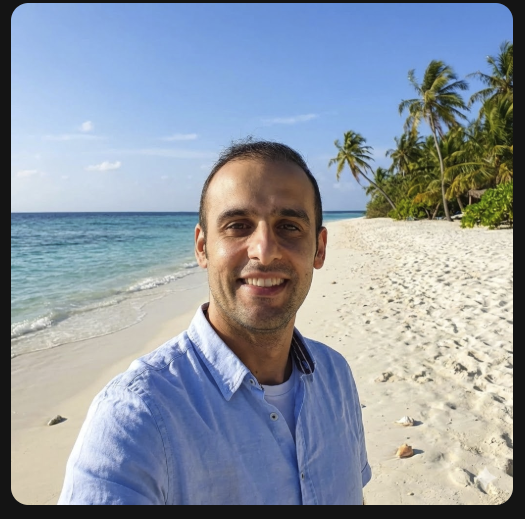

O Nano Banana está disponível no app Gemini, no AI Studio ou no Vertex AI Studio. A maneira mais simples de testar é no app Gemini. No app Gemini ( gemini.google.com), selecione 🍌 Create images em Tools. Depois, faça upload de uma imagem e tente algo divertido. Por exemplo, você pode dizer:

Can you transform this picture of mine to a nice beach on a tropical island?

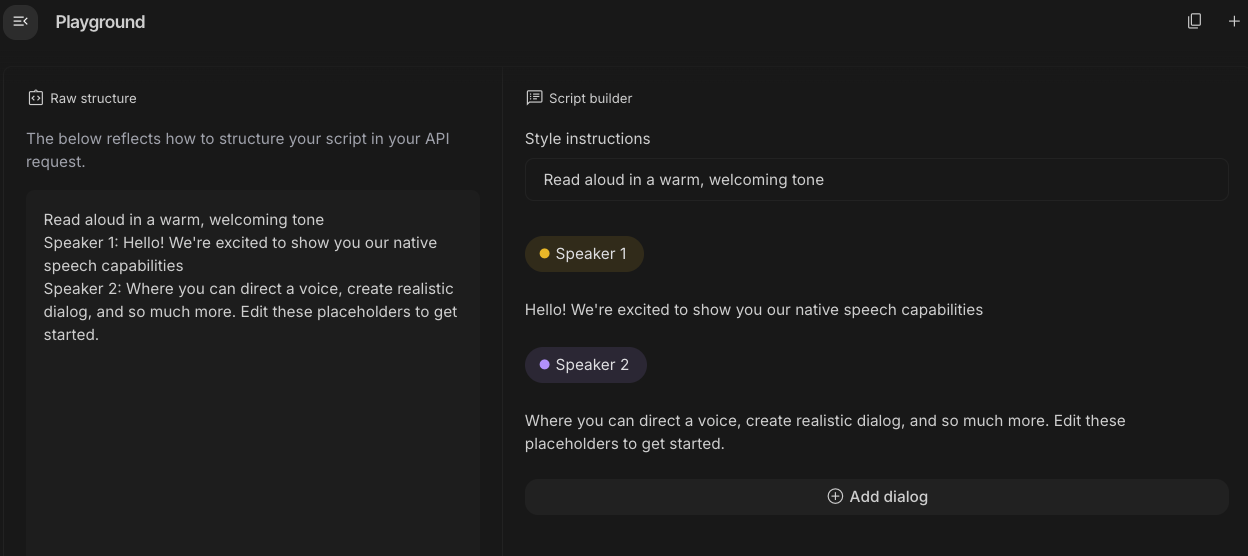

12. Geração de Text-to-Speech 🎶

O Gemini pode transformar entradas de texto em áudio de um ou vários locutores usando os recursos de geração de texto em voz (TTS) do Gemini. A geração de TTS é controlável. Isso significa que você pode usar a linguagem natural para estruturar interações e orientar o estilo, o sotaque, o ritmo e o tom do áudio.

Há dois modelos que oferecem suporte à TTS:

O recurso de TTS é diferente da geração de fala fornecida pela API Live, que foi projetada para áudio interativo e não estruturado, além de entradas e saídas multimodais. Embora a API Live se destaque em contextos de conversa dinâmica, a TTS pela API Gemini é feita para cenários que exigem recitação exata de texto com controle refinado sobre estilo e som, como geração de podcasts ou audiolivros.

Confira um snippet de código para TTS de um único falante:

from google import genai

from google.genai import types

import wave

# Set up the wave file to save the output:

def wave_file(filename, pcm, channels=1, rate=24000, sample_width=2):

with wave.open(filename, "wb") as wf:

wf.setnchannels(channels)

wf.setsampwidth(sample_width)

wf.setframerate(rate)

wf.writeframes(pcm)

client = genai.Client()

response = client.models.generate_content(

model="gemini-2.5-flash-preview-tts",

contents="Say cheerfully: Have a wonderful day!",

config=types.GenerateContentConfig(

response_modalities=["AUDIO"],

speech_config=types.SpeechConfig(

voice_config=types.VoiceConfig(

prebuilt_voice_config=types.PrebuiltVoiceConfig(

voice_name='Kore',

)

)

),

)

)

data = response.candidates[0].content.parts[0].inline_data.data

file_name='out.wav'

wave_file(file_name, data) # Saves the file to current directory

Confira mais exemplos na documentação de geração de texto em voz (TTS).

Você também pode testar a geração de voz no playground do Google AI Studio. Teste diferentes comandos no app generate-speech:

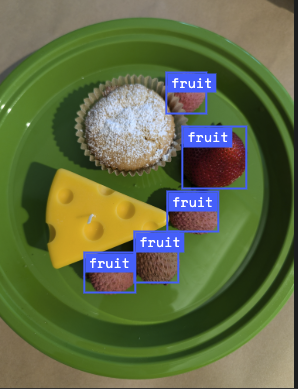

13. Entendimento espacial 🌐

O Gemini tem detecção de objetos e compreensão espacial avançadas.

A maneira mais fácil de entender isso é ver na prática. Acesse o app inicial de compreensão espacial no AI Studio. Escolha algumas imagens e tente detectar itens nelas com o Gemini.

Por exemplo, você pode detectar "sombras" ou "frutas" em diferentes imagens:

Teste com imagens diferentes e veja como o Gemini detecta e rotula objetos diferentes.

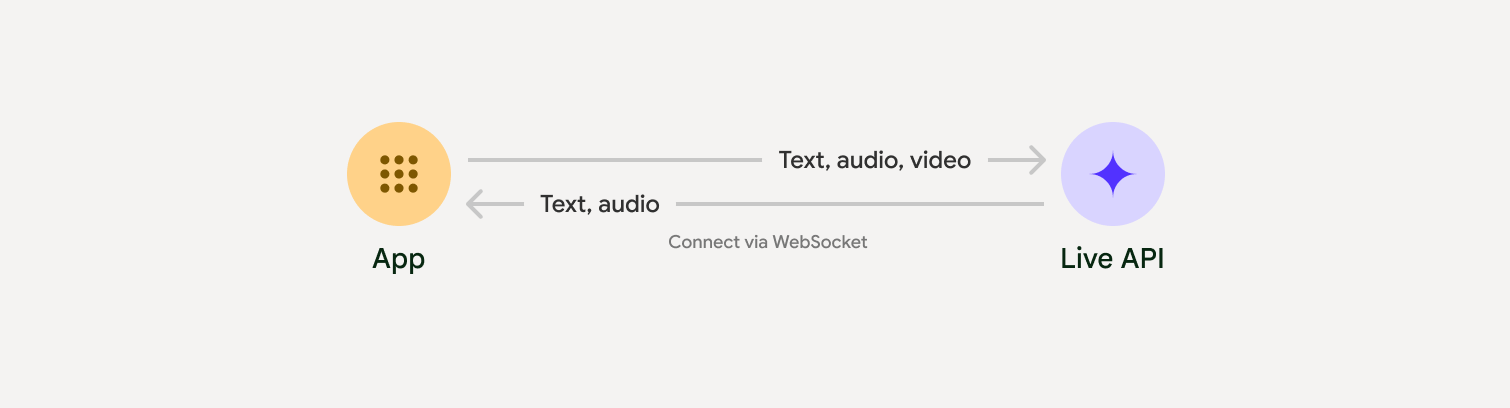

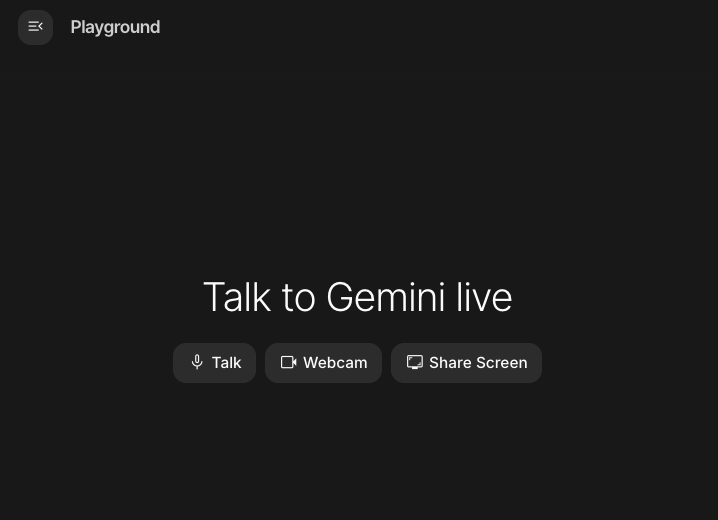

14. API Live 🎤

A API Live permite interações de voz e vídeo em tempo real e de baixa latência com o Gemini. Ele processa fluxos contínuos de áudio, vídeo ou texto para oferecer respostas faladas imediatas e semelhantes às humanas, criando uma experiência de conversa natural para seus usuários.

Teste a API Live no Google AI Studio ou a API Live no Vertex AI Studio. Nos dois apps, você pode compartilhar sua voz, vídeo e tela e ter uma conversa em tempo real com o Gemini.

Comece a compartilhar seu vídeo ou tela e faça perguntas gerais ao Gemini por voz. Exemplo:

Can you describe what you see on the screen?

Você vai se surpreender com a naturalidade das respostas do Gemini.

15. Conclusão

Neste codelab, abordamos o ecossistema do Gemini, começando com a família de produtos e aprendendo a integrar os modelos aos nossos aplicativos usando o SDK unificado da IA generativa do Google. Conhecemos os recursos de ponta do Gemini, incluindo a janela de contexto longo, o modo de pensar, as ferramentas de embasamento integradas, a API Live e a compreensão espacial. Recomendamos que você se aprofunde nos documentos de referência e continue testando todo o potencial do Gemini.

References

- App Gemini

- NotebookLM

- Google AI Studio

- Vertex AI Studio

- CLI do Gemini

- Google Antigravity

- Modelos do Gemini

- SDK de IA generativa do Google

- SDK do Python

- Go SDK

- SDK do Node

- SDK do Java

- SDK C#

- API Interactions

- Agente Deep Research do Gemini

- Geração de imagens do Nano Banana

- Geração de conversão de texto em voz (TTS)

- API Live