1. Introducción

Última actualización: 15/09/2021

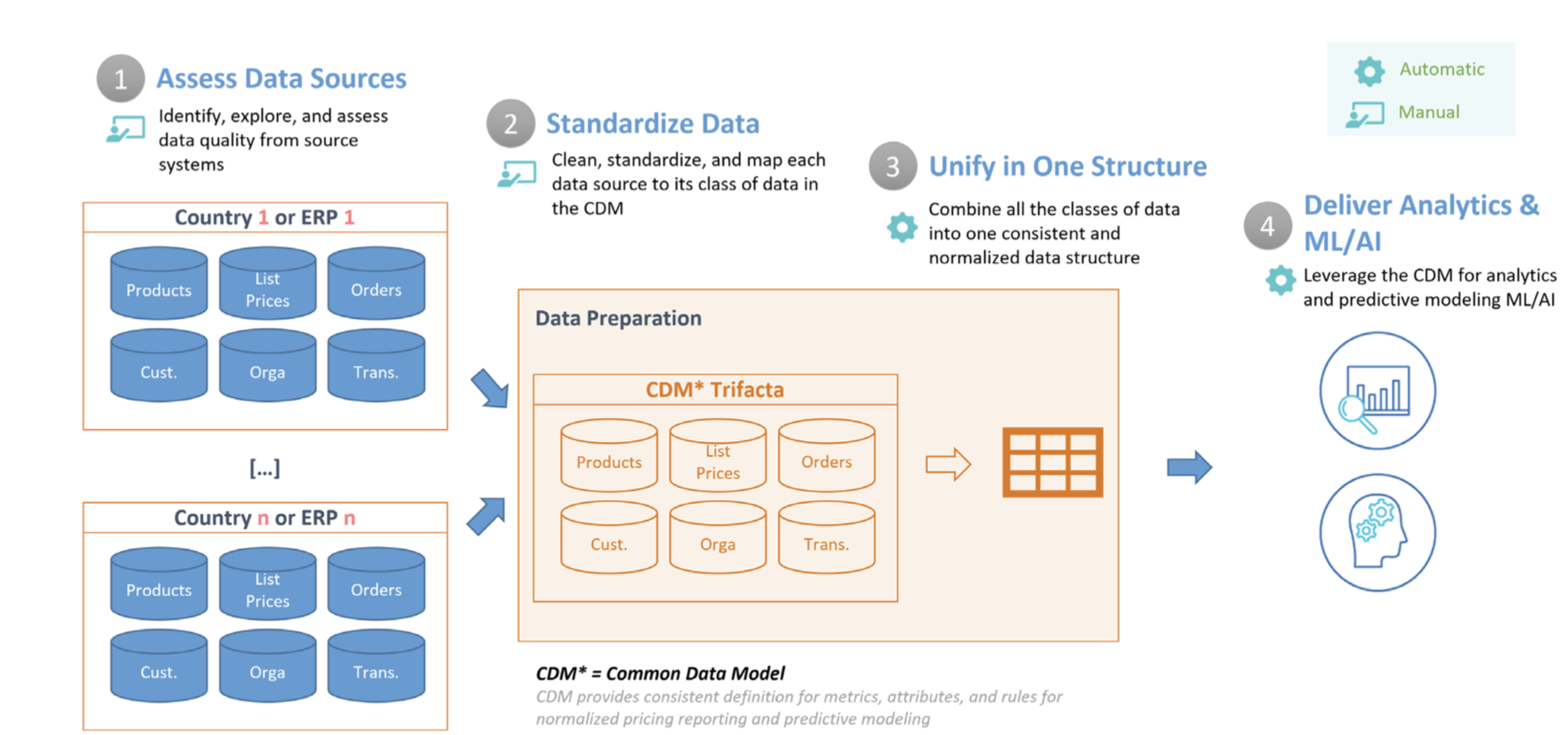

Los datos necesarios para mejorar las estadísticas y la optimización de precios son dispares por naturaleza (diferentes sistemas, diferentes realidades locales, etc.), por lo que es crucial desarrollar una tabla de CDM bien estructurada, estandarizada y limpia. Esto incluye atributos clave para la optimización de precios, como las transacciones, los productos, los precios y los clientes. En este documento, te indicamos los pasos que se describen a continuación y te ofrecemos una guía de inicio rápido para las estadísticas de precios que puedes ampliar y personalizar según tus necesidades. En el siguiente diagrama, se describen los pasos que se abordan en este documento.

- Evaluar las fuentes de datos: En primer lugar, debes obtener un inventario de las fuentes de datos que se usarán para crear el CDM. En este paso, Dataprep también se usa para identificar y explorar problemas con los datos de entrada. Por ejemplo, valores faltantes y no coincidentes, convenciones de nomenclatura inconsistentes, duplicados, problemas de integridad de datos, valores atípicos, etcétera.

- Estandariza los datos: A continuación, se corrigen los problemas identificados anteriormente para garantizar la exactitud, integridad, integridad y coherencia de los datos. Este proceso puede implicar varias transformaciones en Dataprep, como el formato de fecha, la estandarización de valores, la conversión de unidades, el filtrado de campos y valores innecesarios, y la división, la unión o la anulación de duplicación de los datos de origen.

- Unificar en una estructura: La siguiente etapa de la canalización une cada fuente de datos en una sola tabla ancha en BigQuery que contiene todos los atributos al más detallado nivel. Esta estructura desnormalizada permite realizar consultas analíticas eficientes que no requieren uniones.

- Proporciona estadísticas y AA/IA: Una vez que los datos están limpios y formateados para su análisis, los analistas pueden explorar los datos históricos para comprender el impacto de los cambios de precios anteriores. Además, BigQuery ML se puede usar para crear modelos predictivos que estiman ventas futuras. El resultado de estos modelos se puede incorporar en paneles en Looker para crear situaciones hipotéticas. donde los usuarios empresariales pueden analizar cómo podrían verse las ventas con ciertos cambios de precio.

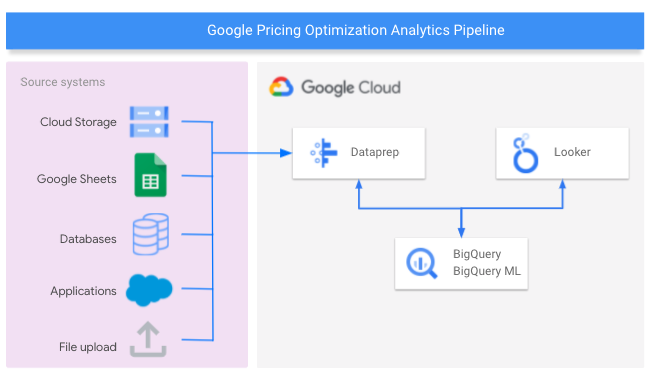

En el siguiente diagrama, se muestran los componentes de Google Cloud usados para crear la canalización de estadísticas de optimización de precios.

Qué compilarás

Aquí, te mostraremos cómo diseñar un almacén de datos de optimización de precios, automatizar la preparación de los datos con el tiempo, usar el aprendizaje automático para predecir el impacto de los cambios en los precios de los productos y desarrollar informes para proporcionar estadísticas prácticas a tu equipo.

Qué aprenderás

- Cómo conectar Dataprep a fuentes de datos para analizar los precios, que se pueden almacenar en bases de datos relacionales, archivos sin formato, Hojas de cálculo de Google y otras aplicaciones compatibles

- Cómo compilar un flujo de Dataprep para crear una tabla de CDM en tu almacén de datos de BigQuery

- Cómo usar BigQuery ML para predecir ingresos futuros.

- Cómo generar informes en Looker para analizar las tendencias históricas de precios y ventas y comprender el impacto de los cambios futuros de precios

Requisitos

- Un proyecto de Google Cloud con facturación habilitada. Descubre cómo confirmar que tienes habilitada la facturación en un proyecto.

- BigQuery debe estar habilitado en tu proyecto. Se habilita automáticamente en proyectos nuevos. De lo contrario, habilítala en un proyecto existente. También puedes obtener más información para comenzar a usar BigQuery desde la consola de Cloud aquí.

- Dataprep también debe estar habilitado en tu proyecto. Dataprep está habilitado en la consola de Google en el menú de navegación de la izquierda en la sección Macrodatos. Sigue los pasos de registro para activarla.

- Para configurar tus propios paneles de Looker, debes tener acceso de desarrollador a una instancia de Looker. Si quieres solicitar una prueba, comunícate con nuestro equipo aquí o usa nuestro panel público para explorar los resultados de la canalización de datos en nuestros datos de muestra.

- Es útil tener experiencia con el lenguaje de consulta estructurado (SQL) y conocimientos básicos de los siguientes temas: Dataprep de Trifacta, BigQuery y Looker.

2. Crea el CDM en BigQuery

En esta sección, crearás el modelo de datos comunes (CDM), que proporciona una vista consolidada de la información que necesitas analizar y sugerir cambios en los precios.

- Abre la consola de BigQuery.

- Selecciona el proyecto que quieres usar para probar este patrón de referencia.

- Usa un conjunto de datos existente o crea un conjunto de datos de BigQuery. Asigna el nombre

Pricing_CDMal conjunto de datos. - Crea la tabla:

create table `CDM_Pricing`

(

Fiscal_Date DATETIME,

Product_ID STRING,

Client_ID INT64,

Customer_Hierarchy STRING,

Division STRING,

Market STRING,

Channel STRING,

Customer_code INT64,

Customer_Long_Description STRING,

Key_Account_Manager INT64,

Key_Account_Manager_Description STRING,

Structure STRING,

Invoiced_quantity_in_Pieces FLOAT64,

Gross_Sales FLOAT64,

Trade_Budget_Costs FLOAT64,

Cash_Discounts_and_other_Sales_Deductions INT64,

Net_Sales FLOAT64,

Variable_Production_Costs_STD FLOAT64,

Fixed_Production_Costs_STD FLOAT64,

Other_Cost_of_Sales INT64,

Standard_Gross_Margin FLOAT64,

Transportation_STD FLOAT64,

Warehouse_STD FLOAT64,

Gross_Margin_After_Logistics FLOAT64,

List_Price_Converged FLOAT64

);

3. Evaluar las fuentes de datos

En este instructivo, usarás fuentes de datos de muestra almacenadas en Hojas de cálculo de Google y BigQuery.

- La hoja de cálculo de Google transactions, que contiene una fila para cada transacción. Contiene detalles como la cantidad de cada producto vendido, las ventas brutas totales y los costos asociados.

- La hoja de cálculo de Google Precios de productos que contiene el precio de cada producto para un cliente determinado en cada mes.

- La tabla de BigQuery company_descriptions contiene información de clientes individuales.

Esta tabla de BigQuery company_descriptions se puede crear usando la siguiente instrucción:

create table `Company_Descriptions`

(

Customer_ID INT64,

Customer_Long_Description STRING

);

insert into `Company_Descriptions` values (15458, 'ENELTEN');

insert into `Company_Descriptions` values (16080, 'NEW DEVICES CORP.');

insert into `Company_Descriptions` values (19913, 'ENELTENGAS');

insert into `Company_Descriptions` values (30108, 'CARTOON NT');

insert into `Company_Descriptions` values (32492, 'Thomas Ed Automobiles');

4. Compila el flujo

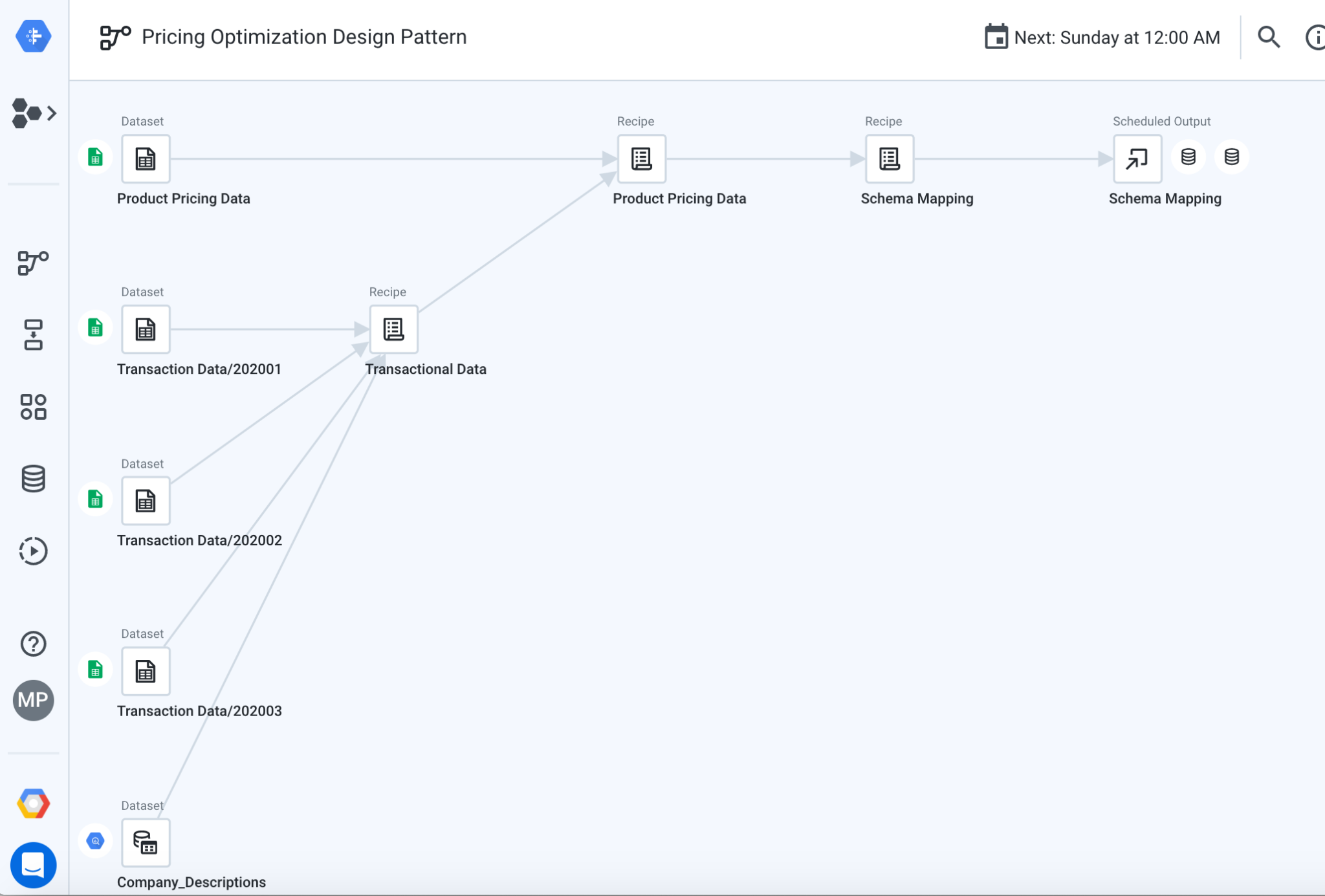

En este paso, importarás un flujo de Dataprep de muestra, que usarás para transformar y unificar los conjuntos de datos de ejemplo enumerados en la sección anterior. Un flujo representa una canalización o un objeto que reúne conjuntos de datos y recetas, que se usan para transformarlos y unirlos.

- Descarga el paquete de flujo Pricing Optimization Pattern de GitHup, pero no lo descomprimas. Este archivo contiene el flujo de patrón de diseño de optimización de precios que se utiliza para transformar los datos de muestra.

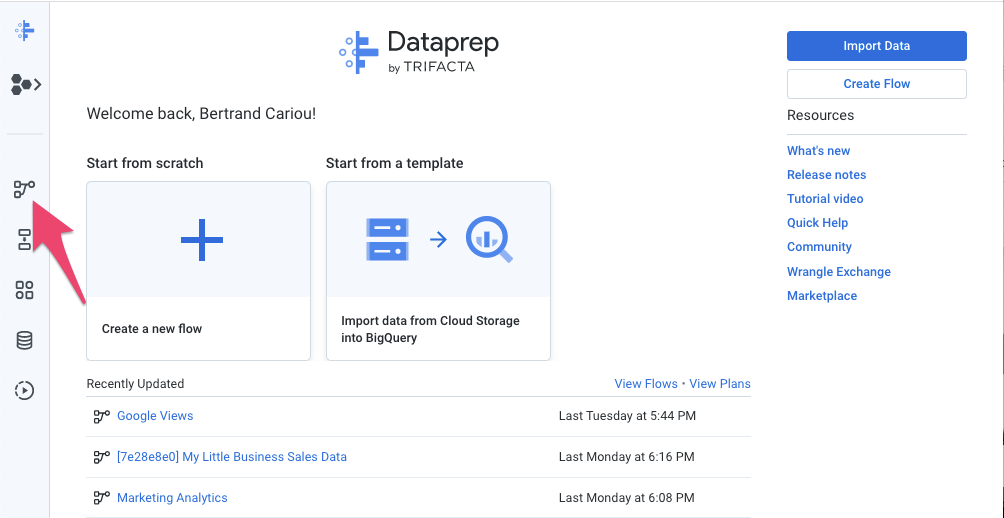

- En Dataprep, haz clic en el ícono Flows (Flujos) en la barra de navegación izquierda. Luego, en la vista Flows, selecciona Import en el menú contextual. Después de importar el flujo, puedes seleccionarlo para verlo y editarlo.

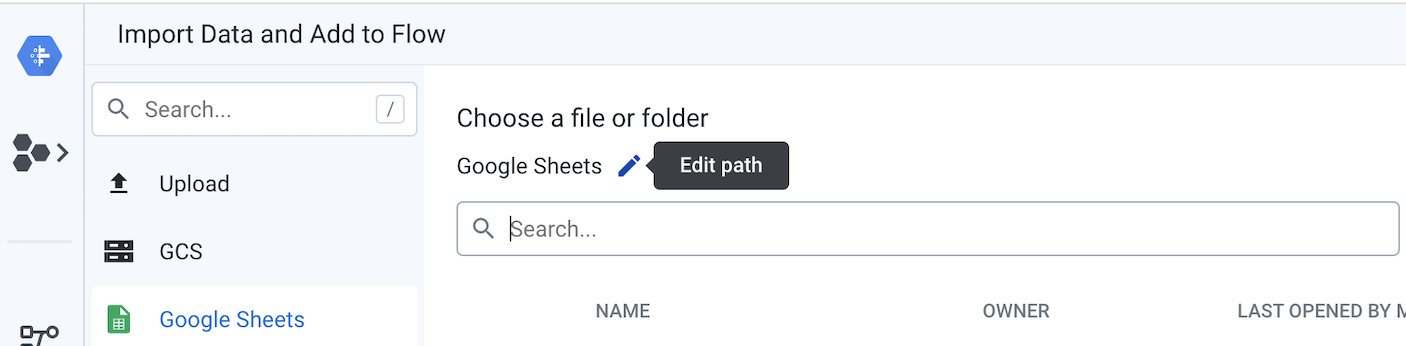

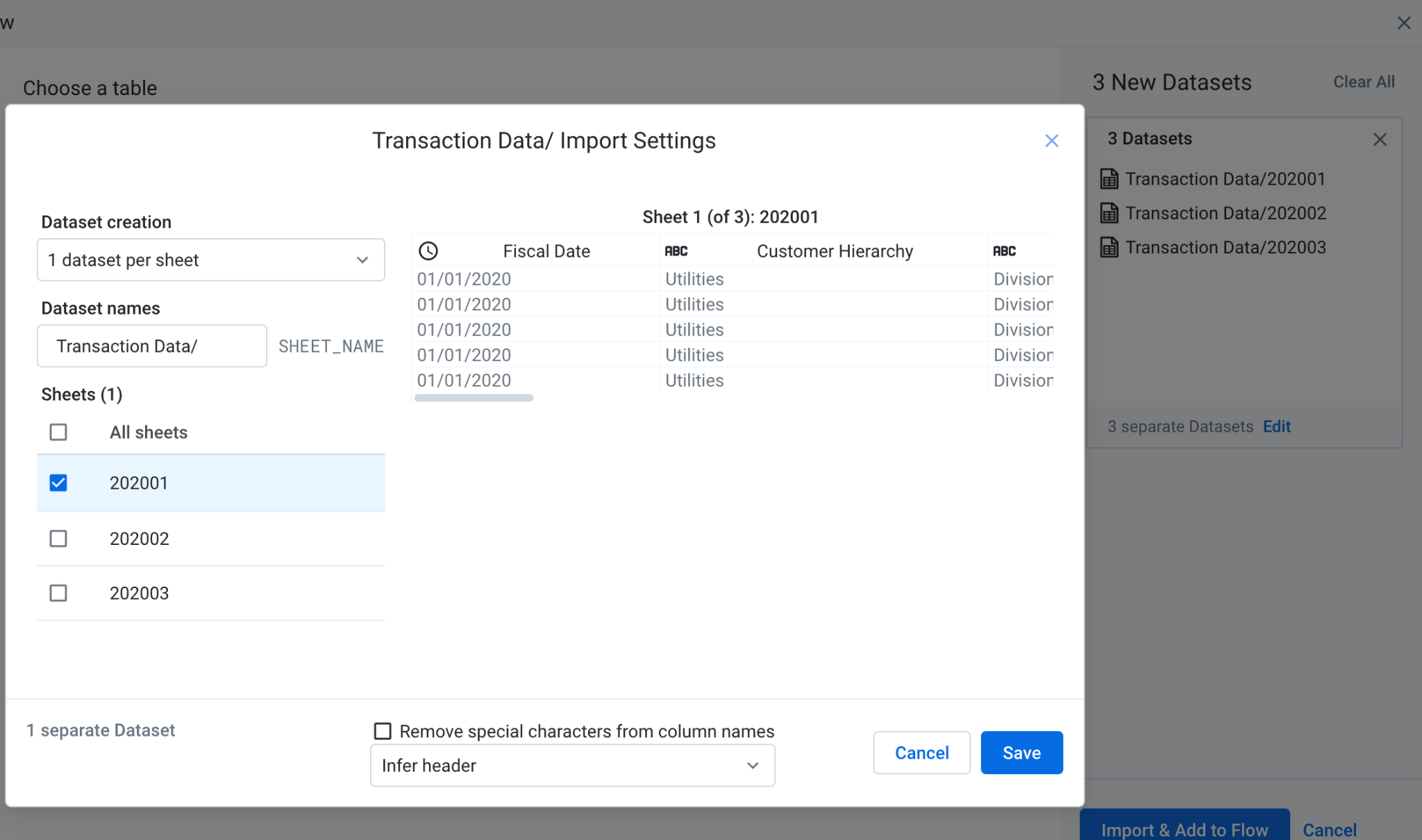

- En el lado izquierdo del flujo, el precio del producto y cada una de las tres hojas de cálculo de Google Transactions deben estar conectadas como conjuntos de datos. Para ello, haz clic con el botón derecho en los objetos del conjunto de datos de Hojas de cálculo de Google y selecciona Reemplazar. Luego, haz clic en el vínculo Import Datasets (Importar conjuntos de datos). Haz clic en el botón "Editar ruta" lápiz, como se muestra en el siguiente diagrama.

Reemplaza el valor actual por el vínculo que apunta a las transacciones y a los precios de los productos de Hojas de cálculo de Google.

Si las Hojas de cálculo de Google contienen varias pestañas, puedes seleccionar la que deseas usar en el menú. Haz clic en Editar y selecciona las pestañas que deseas usar como fuente de datos. Luego, haz clic en Guardar y, luego, en Importar y Add to Flow. Cuando vuelvas a la ventana modal, haz clic en Reemplazar. En este flujo, cada hoja se representa como su propio conjunto de datos para demostrar la unión de fuentes dispares más adelante en una receta posterior.

- Define las tablas de salida de BigQuery:

En este paso, asociarás la ubicación para que se cargue la tabla de salida CDM_Pricing de BigQuery cada vez que ejecutes el trabajo de Dataoprep.

En la Vista de flujo, haz clic en el ícono Salida de asignación de esquema (Schema Mapping Output) y, en el panel Detalles, haz clic en la pestaña Destinos. Desde allí, edita los resultados de los destinos manuales usados para las pruebas y los de los destinos programados que se usan cuando quieres automatizar todo el flujo. Para ello, sigue estas instrucciones:

- Edita "Destinos manuales": En el panel de detalles, en la sección Destinos manuales, haz clic en el botón Editar. En la página Publishing Settings, debajo de Publishing Actions, si ya existe una acción de publicación, edítala. De lo contrario, haz clic en el botón Add Action. Desde allí, navega por los conjuntos de datos de BigQuery al conjunto de datos

Pricing_CDMque creaste en un paso anterior y selecciona la tablaCDM_Pricing. Confirma que la opción Append to this table every run esté marcada y, luego, haz clic en Add y, luego, en Save Settings. - Edita los "Destinos programados"

En el panel Detalles, en la sección Destinos programados, haz clic en Editar.

La configuración se hereda de los destinos manuales y no es necesario que realices ningún cambio. Haz clic en Guardar configuración.

5. Estandarizar datos

La unión de flujo proporcionada, formatea y limpia los datos de transacciones y, luego, une el resultado con las descripciones de la empresa y los datos de precios agregados para la generación de informes. Aquí, se explican los componentes del flujo, que se pueden ver en la siguiente imagen.

6. Explora la receta de datos transaccionales

Primero, explorarás lo que sucede dentro de la receta de datos transaccionales, que se usa para preparar los datos de las transacciones. Haz clic en el objeto de datos de transacción en la vista de flujo. En el panel de detalles, haz clic en el botón Editar receta.

Se abrirá la página de Transformer con la receta presentada en el panel Details. La receta contiene todos los pasos de transformación que se aplican a los datos. Puedes navegar dentro de la Receta si haces clic en cada uno de los pasos para ver el estado de los datos en esta posición particular en la Receta.

También puedes hacer clic en el menú Más para cada paso de la receta y seleccionar Ir a los seleccionados o Editarlo para explorar cómo funciona la transformación.

- Transacciones de unión: Es el primer paso de las transacciones de uniones de la receta de datos transaccionales almacenadas en hojas diferentes que representan cada mes.

- Estandariza las descripciones de los clientes: El siguiente paso de la receta estandariza las descripciones de los clientes. Significa que los nombres de los clientes pueden ser similares con pequeños cambios, y queremos normalizarlos como en el nombre. En la receta, se muestran dos enfoques posibles. Primero, aprovecha el algoritmo de estandarización, que se puede configurar con diferentes opciones de estandarización, como "Cadenas similares". donde los valores con caracteres en común se agrupan o en “Pronunciación” donde los valores que suenan similares se agrupan en clústeres. Como alternativa, puedes buscar la descripción de la empresa en la tabla de BigQuery a la que se hace referencia anteriormente con el ID de la empresa.

Puedes seguir navegando por la receta para descubrir las diversas técnicas que se aplican para limpiar y dar formato a los datos: borrar filas, dar formato basado en patrones, enriquecer datos con búsquedas, tratar con valores faltantes o reemplazar caracteres no deseados.

7. Explora la receta de datos de precios de productos

A continuación, puedes explorar lo que sucede en la receta de datos de precios de productos, que une los datos de transacciones preparados con los datos de precios agregados.

Haz clic en el PARÁMETRO DE DISEÑO DE OPTIMIZACIÓN DE PRECIOS en la parte superior de la página para cerrar la página de Transformación y volver a la Vista de flujo. Desde allí, haz clic en el objeto de datos de precios del producto y edita la receta.

- Anular la dinamización de las columnas de precios mensuales: Haz clic en la receta entre los 2 y 3 pasos para ver cómo se ven los datos antes del paso Anular la dinamización. Notarás que los datos contienen el valor de la transacción en una columna distinta para cada mes: enero, febrero. Este formato no es conveniente para aplicar el cálculo de agregación (es decir, suma, transacción promedio) en SQL. Es necesario anular la dinamización de los datos para que cada columna se convierta en una fila de la tabla de BigQuery. La receta aprovecha la función unpivot para transformar las 3 columnas en una fila para cada mes, de modo que sea más fácil aplicar cálculos grupales.

- Calcular el valor promedio de las transacciones por cliente, producto y fecha: Queremos calcular el valor promedio de las transacciones para cada cliente, producto y datos. Podemos usar la función Agregar y generar una tabla nueva (opción "Agrupar por como tabla nueva"). En ese caso, los datos se agregan a nivel del grupo y perdemos los detalles de cada transacción individual. También podemos optar por mantener los detalles y los valores agregados en el mismo conjunto de datos (opción “Agrupar por como columnas nuevas”), lo que resulta muy conveniente para aplicar una proporción (es decir, el porcentaje de contribución de la categoría de producto a los ingresos totales). Puedes probar este comportamiento editando el paso 7 de la receta y seleccionando la opción “Agrupar por como tabla nueva” (Group by as a new table) o “Agrupar por como columnas nuevas” para ver las diferencias.

- Fecha de fijación de precios de la unión: Por último, se usa una unión para combinar varios conjuntos de datos en uno más grande y agregar columnas al conjunto de datos inicial. En este paso, los datos de precios se unen con el resultado de la receta de datos transaccionales según “Pricing Data.Product Code” = Data.SKU de transacción y “Pricing Data.Price Date” = 'Datos de transacción.Fecha fiscal'

Para obtener más información sobre las transformaciones que puedes aplicar con Dataprep, consulta la hoja de referencia para la transformación de datos de Trifacta.

8. Explora la receta de asignación de esquemas

La última receta, la asignación de esquemas, garantiza que la tabla de CDM resultante coincida con el esquema existente de la tabla de salida de BigQuery. Aquí, la funcionalidad de Destino rápido se usa para cambiar el formato de la estructura de datos a fin de que coincida con la tabla de BigQuery por medio de la coincidencia parcial para comparar ambos esquemas y aplicar cambios automáticos.

9. Unificar en una sola estructura

Ahora que se configuraron las fuentes y los destinos, y se exploraron los pasos de los flujos, puedes ejecutar el flujo para transformar y cargar la tabla de CDM en BigQuery.

- Run Schema Mapping output: En la vista de flujo, selecciona el objeto de salida de Schema Mapping y haz clic en “Run”. en el panel Detalles. Seleccione "Trifacta Photon". Entorno de ejecución y desmarca Ignorar errores de receta. Luego, haz clic en el botón Ejecutar. Si la tabla de BigQuery especificada existe, Dataprep agregará filas nuevas; de lo contrario, creará una tabla nueva.

- Visualiza el estado del trabajo: Dataprep abre automáticamente la página Run Job para que puedas supervisar la ejecución del trabajo. El proceso y la carga de la tabla de BigQuery debería tardar unos minutos. Cuando se complete el trabajo, el resultado del CDM de precios se cargará en BigQuery en un formato limpio, estructurado y normalizado, listo para el análisis.

10. Ofrece estadísticas y AA/IA

Requisitos previos de Analytics

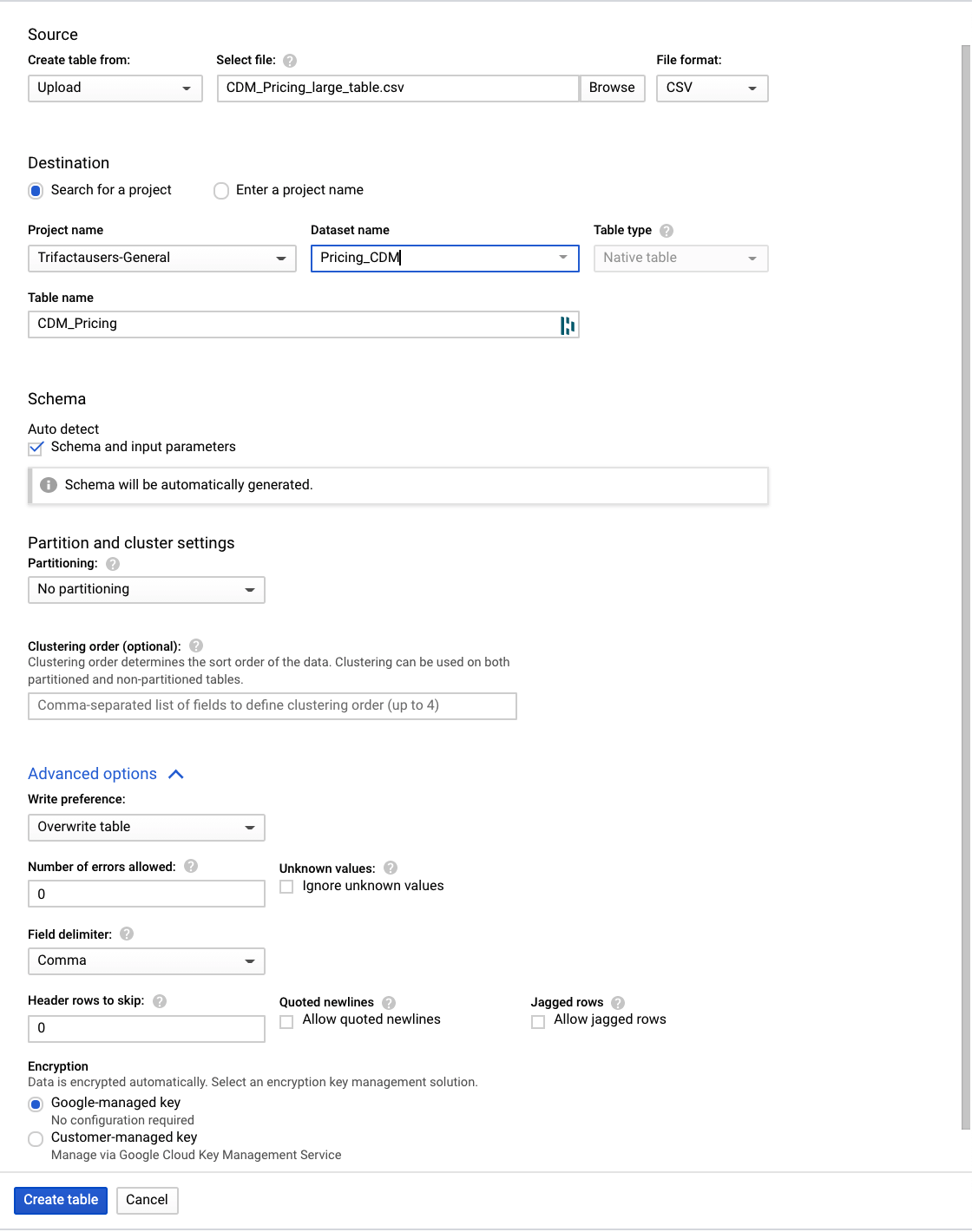

Para ejecutar algunos análisis y un modelo predictivo con resultados interesantes, creamos un conjunto de datos que es más grande y relevante para descubrir estadísticas específicas. Debes subir estos datos a tu conjunto de datos de BigQuery antes de continuar con esta guía.

- Descarga el gran conjunto de datos de este repositorio de GitHub

- En la consola de Google para BigQuery, navega a tu proyecto y al conjunto de datos CDM_Pricing.

- Haz clic en el menú y abre el conjunto de datos. Para crear la tabla, cargaremos los datos de un archivo local.

Haz clic en el botón + Crear tabla y define estos parámetros:

- Crear una tabla desde la carga y seleccionar el archivo CDM_Pricing_Large_Table.csv

- Detecta automáticamente el esquema y verifica el esquema y los parámetros de entrada

- Opciones avanzadas, Preferencia de escritura, Reemplazar tabla

- Haz clic en Crear tabla.

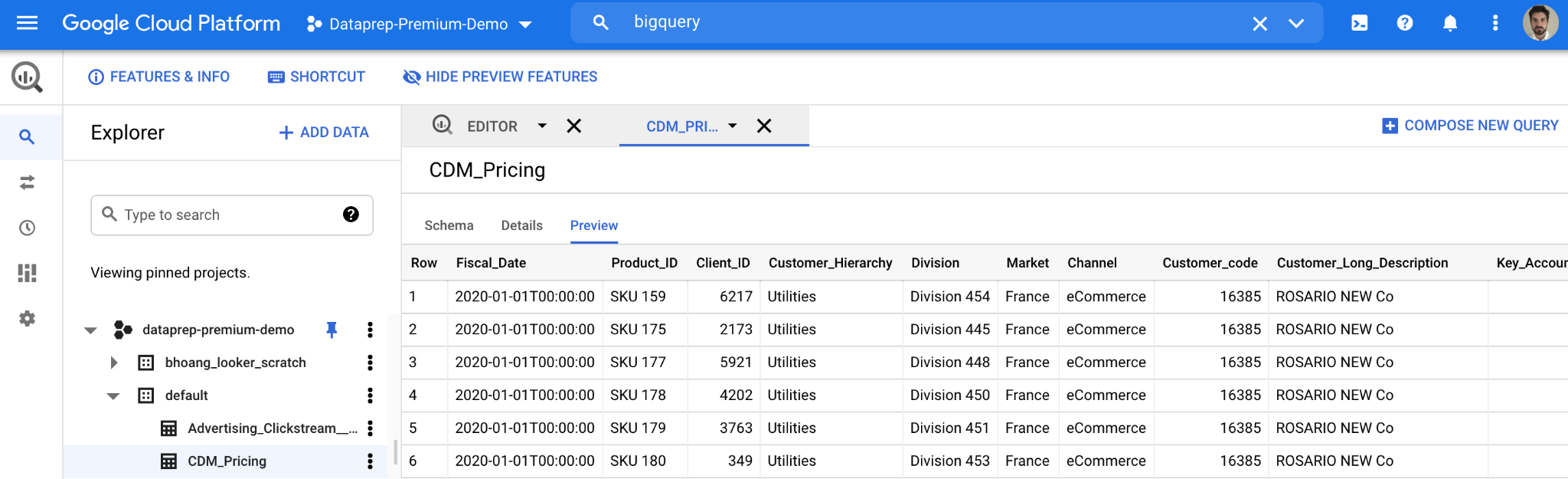

Después de crear la tabla y subir los datos en la consola de Google para BigQuery, deberías ver los detalles de la tabla nueva, como se muestra a continuación. Con los datos de precios en BigQuery, podemos hacer preguntas más integrales con facilidad para analizar tus datos de precios en un nivel más profundo.

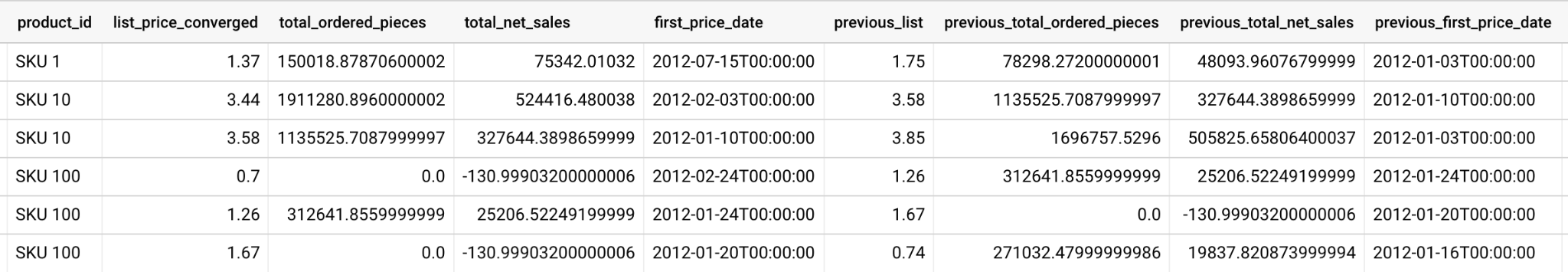

11. Cómo ver el efecto de los cambios de precios

Un ejemplo de algo que puedes analizar es un cambio en el comportamiento de orden cuando cambiaste previamente el precio de un artículo.

- Primero, creas una tabla temporal que tiene una línea cada vez que cambia el precio de un producto, con información sobre el precio de ese producto en particular, como la cantidad de artículos que se pidieron con cada precio y las ventas netas totales asociadas con ese precio.

create temp table price_changes as (

select

product_id,

list_price_converged,

total_ordered_pieces,

total_net_sales,

first_price_date,

lag(list_price_converged) over(partition by product_id order by first_price_date asc) as previous_list,

lag(total_ordered_pieces) over(partition by product_id order by first_price_date asc) as previous_total_ordered_pieces,

lag(total_net_sales) over(partition by product_id order by first_price_date asc) as previous_total_net_sales,

lag(first_price_date) over(partition by product_id order by first_price_date asc) as previous_first_price_date

from (

select

product_id,list_price_converged,sum(invoiced_quantity_in_pieces) as total_ordered_pieces, sum(net_sales) as total_net_sales, min(fiscal_date) as first_price_date

from `{{my_project}}.{{my_dataset}}.CDM_Pricing` AS cdm_pricing

group by 1,2

order by 1, 2 asc

)

);

select * from price_changes where previous_list is not null order by product_id, first_price_date desc

- A continuación, con la tabla temporal en su lugar, puedes calcular el cambio de precio promedio entre los SKU:

select avg((previous_list-list_price_converged)/nullif(previous_list,0))*100 as average_price_change from price_changes;

- Por último, puedes analizar lo que sucede después de que se modifica un precio observando la relación entre cada cambio de precio y la cantidad total de artículos que se pidieron:

select

(total_ordered_pieces-previous_total_ordered_pieces)/nullif(previous_total_ordered_pieces,0)

as

price_changes_percent_ordered_change,

(list_price_converged-previous_list)/nullif(previous_list,0)

as

price_changes_percent_price_change

from price_changes

12. Crea un modelo de previsión de series temporales

A continuación, con las funciones de aprendizaje automático integradas de BigQuery, puedes compilar un modelo de previsión de series temporales ARIMA para predecir la cantidad de cada artículo que se venderá.

- Primero, creas un modelo ARIMA_PLUS.

create or replace `{{my_project}}.{{my_dataset}}.bqml_arima`

options

(model_type = 'ARIMA_PLUS',

time_series_timestamp_col = 'fiscal_date',

time_series_data_col = 'total_quantity',

time_series_id_col = 'product_id',

auto_arima = TRUE,

data_frequency = 'AUTO_FREQUENCY',

decompose_time_series = TRUE

) as

select

fiscal_date,

product_id,

sum(invoiced_quantity_in_pieces) as total_quantity

from

`{{my_project}}.{{my_dataset}}.CDM_Pricing`

group by 1,2;

- Luego, usarás la función ML.FORECAST para predecir ventas futuras en cada producto:

select

*

from

ML.FORECAST(model testing.bqml_arima,

struct(30 as horizon, 0.8 as confidence_level));

- Con estas predicciones disponibles, puedes tratar de entender lo que podría suceder si aumentas los precios. Por ejemplo, si aumentas el precio de cada producto en un 15%, podrías calcular los ingresos totales estimados para el próximo mes con una consulta como la siguiente:

select

sum(forecast_value * list_price) as total_revenue

from ml.forecast(mode testing.bqml_arima,

struct(30 as horizon, 0.8 as confidence_level)) forecasts

left join (select product_id,

array_agg(list_price_converged

order by fiscal_date desc limit 1)[offset(0)] as list_price

from `leigha-bq-dev.retail.cdm_pricing` group by 1) recent_prices

using (product_id);

13. Crea un informe

Ahora que tus datos de precios desnormalizados están centralizados en BigQuery y comprendes cómo ejecutar consultas significativas en estos datos, es momento de crear un informe que les permita a los usuarios empresariales explorar esta información y tomar medidas al respecto.

Si ya tienes una instancia de Looker, puedes usar LookML en este repositorio de GitHub para comenzar a analizar los datos de precios de este patrón. Simplemente crea un nuevo proyecto de Looker, agrega LookML y reemplaza la conexión y los nombres de las tablas en cada archivo de vista para que coincidan con tu configuración de BigQuery.

En este modelo, encontrarás la tabla derivada ( en este archivo de vista) que mostramos antes para examinar los cambios de precio:

view: price_changes {

derived_table: {

sql: select

product_id,

list_price_converged,

total_ordered_pieces,

total_net_sales,

first_price_date,

lag(list_price_converged) over(partition by product_id order by first_price_date asc) as previous_list,

lag(total_ordered_pieces) over(partition by product_id order by first_price_date asc) as previous_total_ordered_pieces,

lag(total_net_sales) over(partition by product_id order by first_price_date asc) as previous_total_net_sales,

lag(first_price_date) over(partition by product_id order by first_price_date asc) as previous_first_price_date

from (

select

product_id,list_price_converged,sum(invoiced_quantity_in_pieces) as total_ordered_pieces, sum(net_sales) as total_net_sales, min(fiscal_date) as first_price_date

from ${cdm_pricing.SQL_TABLE_NAME} AS cdm_pricing

group by 1,2

order by 1, 2 asc

)

;;

}

...

}

Así como con el modelo ARIMA de BigQuery ML que mostramos antes, para predecir ventas futuras ( en este archivo de vista)

view: arima_model {

derived_table: {

persist_for: "24 hours"

sql_create:

create or replace model ${sql_table_name}

options

(model_type = 'arima_plus',

time_series_timestamp_col = 'fiscal_date',

time_series_data_col = 'total_quantity',

time_series_id_col = 'product_id',

auto_arima = true,

data_frequency = 'auto_frequency',

decompose_time_series = true

) as

select

fiscal_date,

product_id,

sum(invoiced_quantity_in_pieces) as total_quantity

from

${cdm_pricing.sql_table_name}

group by 1,2 ;;

}

}

...

}

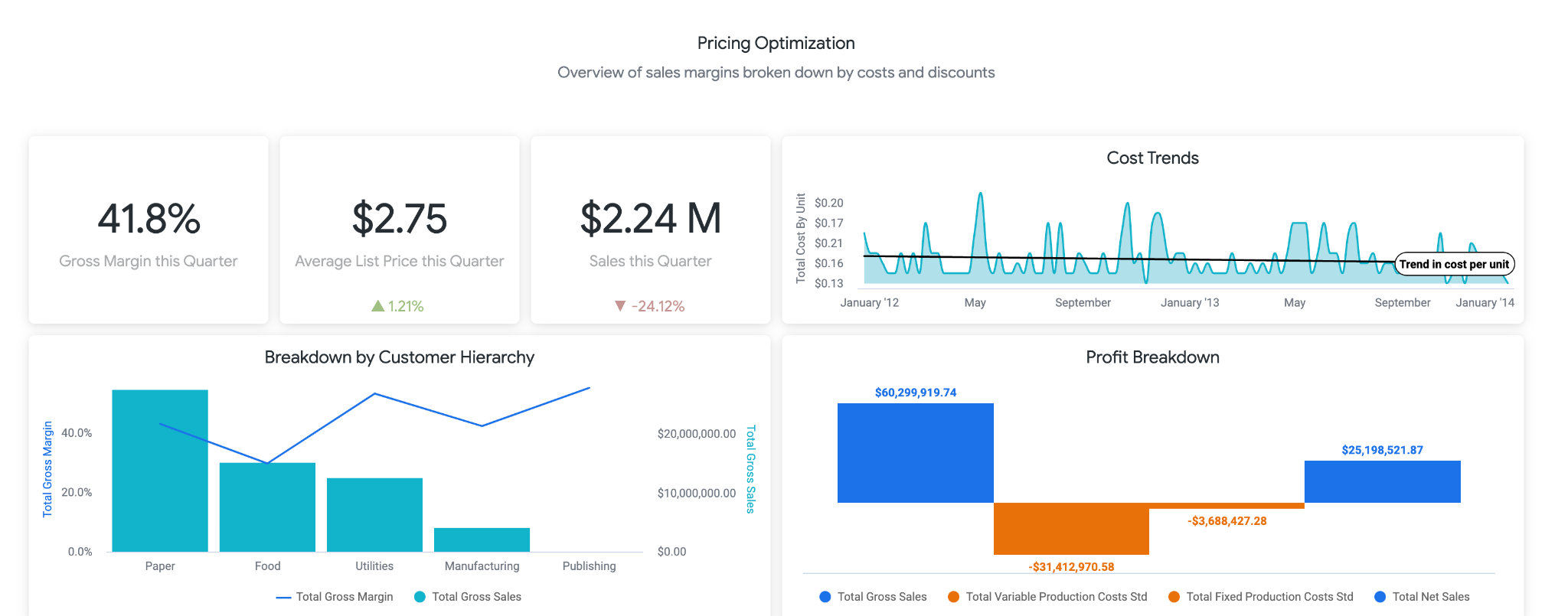

LookML también contiene un panel de muestra. Puedes acceder a una versión de demostración del panel aquí. La primera parte del panel brinda a los usuarios información de alto nivel sobre los cambios en las ventas, los costos, los precios y los márgenes. Como usuario empresarial, te recomendamos que crees una alerta para saber si las ventas han caído por debajo del X%, ya que esto puede significar que deberías bajar los precios.

En la siguiente sección, que se muestra a continuación, los usuarios pueden profundizar en las tendencias relacionadas con los cambios de precios. Aquí puedes desglosar productos específicos para ver el precio de lista exacto y a qué precios se cambiaron, lo que puede ser útil para identificar productos específicos y realizar más investigaciones.

Por último, en la parte inferior del informe están los resultados de nuestro modelo de BigQueryML. Con los filtros en la parte superior del panel de Looker, puedes ingresar parámetros fácilmente para simular diferentes situaciones similares a las descritas anteriormente. Por ejemplo, ver lo que sucedería si el volumen de pedidos bajara al 75% del valor previsto y el precio de todos los productos se aumentara en un 25%, como se muestra a continuación

Esto funciona con la tecnología de los parámetros de LookML, que luego se incorporan directamente en los cálculos de mediciones que se encuentran aquí. Con este tipo de informes, puedes encontrar los precios óptimos para todos los productos o desglosar productos específicos para determinar dónde deberías aumentar o reducir los precios, y cuál sería el resultado con respecto a los ingresos brutos y netos.

14. Adáptate a tus sistemas de precios

Si bien en este instructivo se transforman las fuentes de datos de muestra, te enfrentarás a desafíos de datos muy similares para los recursos de precios que se encuentran en tus diversas plataformas. Los recursos de precios tienen diferentes formatos de exportación (a menudo, xls, sheets, csv, txt, bases de datos relacionales y aplicaciones empresariales) para obtener resultados resumidos y detallados, cada uno de los cuales se puede conectar a Dataprep. Te recomendamos que comiences por describir los requisitos de transformación de manera similar a los ejemplos anteriores. Después de aclarar tus especificaciones y de haber identificado los tipos de transformaciones necesarios, puedes diseñarlas con Dataprep.

- Haz una copia del flujo de Dataprep (haz clic en el botón **... "**more" a la derecha del flujo y selecciona la opción Duplicar) que personalizarás, o bien comienza desde cero con un flujo de Dataprep nuevo.

- Conéctate a tu propio conjunto de datos de precios. Dataprep es compatible de forma nativa con los formatos de archivo como Excel, CSV, Hojas de cálculo de Google y JSON. También puedes conectarte a otros sistemas con los conectores de Dataprep.

- Envía tus recursos de datos en las distintas categorías de transformación que identificaste. Para cada categoría, crea una receta. Inspírate en el flujo proporcionado en este patrón de diseño para transformar los datos y escribir tus propias recetas. Si no puedes avanzar, no te preocupes, pide ayuda en el diálogo de chat en la parte inferior izquierda de la pantalla de Dataprep.

- Conectar la receta a la instancia de BigQuery No tienes que preocuparte por crear las tablas de forma manual en BigQuery, Dataprep se encargará de ello automáticamente. Cuando agregues el resultado a tu flujo, te sugerimos que selecciones un destino manual y elimines la tabla en cada ejecución. Prueba cada receta de forma individual hasta el momento en que entregues los resultados esperados. Una vez finalizada la prueba, convertirás el resultado en Agregar a la tabla en cada ejecución para evitar borrar los datos anteriores.

- De manera opcional, puedes asociar el flujo para que se ejecute según la programación. Esto es útil si el proceso debe ejecutarse continuamente. Podrías definir un programa para cargar la respuesta todos los días o cada hora en función de la actualización que necesites. Si decides ejecutar el flujo según un programa, deberás agregar una salida de destino de programación en el flujo para cada receta.

Modifica el modelo de aprendizaje automático de BigQuery

En este instructivo, se proporciona un modelo ARIMA de muestra. Sin embargo, existen parámetros adicionales que puedes controlar cuando desarrollas el modelo para asegurarte de que se ajuste mejor a tus datos. Puedes ver más detalles en el ejemplo de , dentro de nuestra documentación aquí. Además, puedes usar las funciones ML.ARIMA_EVALUATE, ML.ARIMA_COEFFICIENTS y ML.EXPLAIN_FORECAST de BigQuery para obtener más detalles sobre tu modelo y tomar decisiones de optimización.

Editar informes de Looker

Después de importar el LookML a tu propio proyecto como se describió anteriormente, puedes realizar ediciones directas para agregar campos adicionales, modificar cálculos o parámetros ingresados por el usuario, y cambiar las visualizaciones en los paneles para satisfacer las necesidades de tu empresa. Puedes encontrar detalles sobre el desarrollo en LookML aquí y sobre cómo visualizar datos en Looker aquí.

15. Felicitaciones

Ahora conoces los pasos clave necesarios para optimizar el rendimiento de tus productos de venta minorista los precios.

¿Qué sigue?

Explora otros patrones de referencia de analítica inteligente

Lecturas adicionales

- Lee el blog aquí

- Más información sobre Dataprep aquí

- Obtén más información sobre el aprendizaje automático de BigQuery aquí.

- Obtén más información sobre Looker aquí.