1. Обзор

Представьте себе модное приложение, которое не только поможет вам подобрать идеальный наряд, но и даст советы по стилю в режиме реального времени, и все это благодаря возможностям передовой интеграции genAI! В этом докладе мы рассмотрим, как мы создали такое приложение, используя возможности векторного поиска AlloyDB в сочетании с индексом Google ScaNN, что позволяет молниеносно искать подходящие наряды и мгновенно предоставлять рекомендации по моде.

Мы также углубимся в то, как индекс ScaNN AlloyDB оптимизирует сложные запросы для создания персонализированных предложений по стилю. Мы также будем использовать Gemini и Imagen, мощные генеративные модели искусственного интеллекта, чтобы вдохновлять вас на творческий стиль и даже визуализировать ваш индивидуальный образ. Все это приложение построено на бессерверной архитектуре, обеспечивая пользователям бесперебойную и масштабируемую работу.

Задача: предлагая персонализированные предложения по одежде, приложение призвано помочь людям, которые борются с нерешительностью в моде. Это также помогает избежать усталости от принятия решений при планировании экипировки.

Решение: Приложение рекомендации одежды решает проблему предоставления пользователям интеллектуального, персонализированного и увлекательного опыта моды, одновременно демонстрируя возможности AlloyDB, генеративного искусственного интеллекта и бессерверных технологий.

Что ты построишь

В рамках этой лабораторной работы вы:

- Создайте экземпляр AlloyDB и загрузите набор данных электронной торговли.

- Включите расширения pgvector и генеративной модели искусственного интеллекта в AlloyDB.

- Генерация вложений из описания продукта

- Разверните решение в бессерверных функциях Cloud Run.

- Загрузите изображение в Gemini и создайте запрос описания изображения.

- Генерируйте результаты поиска на основе подсказок в сочетании с внедренными наборами данных электронной торговли.

- Добавьте дополнительные подсказки, чтобы настроить подсказку и создать рекомендации по стилю.

- Разверните решение в бессерверных функциях Cloud Run.

Требования

2. Архитектура

Высокоуровневая архитектура приложения выглядит следующим образом:

В следующих разделах описывается контекстуальная последовательность урока:

Проглатывание :

Наш первый шаг — загрузить данные о розничной торговле (инвентарь, описания продуктов, взаимодействие с клиентами) в AlloyDB.

Аналитический механизм:

Мы будем использовать AlloyDB в качестве аналитической системы для выполнения следующих задач:

- Извлечение контекста: механизм анализирует данные, хранящиеся в AlloyDB, чтобы понять взаимосвязи между продуктами, категориями, поведением клиентов и т. д., если это применимо.

- Создание встраивания: встраивания (математические представления текста) создаются как для запроса пользователя, так и для информации, хранящейся в AlloyDB.

- Векторный поиск: механизм выполняет поиск по сходству, сравнивая встраивание запроса с встраиванием описаний продуктов, обзоров и других соответствующих данных. Это определяет 25 наиболее важных «ближайших соседей».

Рекомендации Близнецам:

Массив байтов изображения передается в модель Gemini через API Vertex AI вместе с запросом текстового описания верхнего износа и рекомендаций по нижнему износу.

AlloyDB RAG и векторный поиск:

Описание верхней одежды используется для запроса в базу данных. Запрос преобразует текст поиска (рекомендацию модели Gemini для сопоставления износа нижней части) во вложения и выполняет векторный поиск по вложениям, хранящимся в базе данных, чтобы найти ближайших соседей (совпадающие результаты). Векторные вложения в базе данных AlloyDB индексируются с использованием индекса ScaNN для лучшего поиска.

Генерация ответного изображения:

Проверенные ответы структурируются в массив JSON, а весь механизм упаковывается в бессерверную функцию запуска облака, которая вызывается из Agent Builder.

Генерация изображения изображения:

Подсказка пользователя о стиле, выбранная пользователем рекомендация и любые запросы на персонализацию объединяются, чтобы предложить Imagen 3 существующее изображение. Изображение стиля создается на основе этого запроса с использованием API Vertex AI.

3. Прежде чем начать

Создать проект

- В Google Cloud Console на странице выбора проекта выберите или создайте проект Google Cloud.

- Убедитесь, что для вашего облачного проекта включена оплата. Узнайте, как проверить, включена ли оплата в проекте .

- Вы будете использовать Cloud Shell , среду командной строки, работающую в Google Cloud, в которую предварительно загружен bq. Нажмите «Активировать Cloud Shell» (

) в верхней части консоли Google Cloud.

) в верхней части консоли Google Cloud. - После подключения к Cloud Shell убедитесь, что вы уже прошли аутентификацию и что для проекта установлен идентификатор вашего проекта, используя следующую команду:

gcloud auth list

- Выполните следующую команду, чтобы убедиться, что будущие команды gcloud правильно идентифицируют ваш проект.

gcloud config list project

- Если ваш проект не установлен, используйте следующую команду, чтобы установить его явно:

gcloud config set project <YOUR_PROJECT_ID>

- Включите необходимые API.

Перейдите по ссылке , чтобы включить API.

Если вы пропустили включение какого-либо API, вы всегда можете включить его в ходе реализации.

Дополнительную информацию о командах и использовании gcloud можно найти в документации .

4. Настройка базы данных

В этой лабораторной работе мы будем использовать AlloyDB в качестве базы данных для хранения набора данных розничной электронной торговли. Он использует кластеры для хранения всех ресурсов, таких как базы данных и журналы. Каждый кластер имеет основной экземпляр , который предоставляет точку доступа к данным. Таблицы — это реальный ресурс, в котором хранятся данные.

Давайте создадим кластер, экземпляр и таблицу AlloyDB, куда будет загружен набор данных электронной коммерции.

Создайте кластер и экземпляр

- В Google Cloud Console найдите AlloyDB . Самый простой способ найти большинство страниц в Cloud Console — это выполнить их поиск с помощью панели поиска консоли.

- Нажмите СОЗДАТЬ КЛАСТЕР .

- Создайте кластер и экземпляр со следующими значениями:

- идентификатор кластера: "

shopping-cluster" - пароль: "

alloydb" - Совместимость с PostgreSQL 15

- Регион: "

us-central1" - Сеть: «

default»

- В разделе «Сеть» при выборе сети по умолчанию появляется следующая опция. Нажмите НАСТРОЙКА СОЕДИНЕНИЯ , чтобы настроить сеть по умолчанию.

- Выберите « Использовать автоматически выделенный диапазон IP-адресов» и нажмите «Продолжить» . Ознакомившись с информацией, нажмите СОЗДАТЬ СОЕДИНЕНИЕ .

Дождитесь завершения создания сети по умолчанию.

- В разделе «Настройка основного экземпляра» установите для идентификатора экземпляра «

shopping-instance".

- Нажмите CREATE CLUSTER , чтобы завершить настройку кластера следующим образом:

5. Прием данных

Теперь пришло время добавить таблицу с данными о магазине. Подождите, пока ваш экземпляр завершится. После его создания вы можете войти в AlloyDB, используя учетные данные, которые вы указали при создании кластера.

Аутентификация в базе данных AlloyDB

- В Google Cloud Console перейдите в AlloyDB . Выберите основной кластер и нажмите AlloyDB Studio на панели навигации слева:

- Введите следующие данные для аутентификации в базе данных AlloyDB:

- Имя пользователя: «

postgres» - База данных: «

postgres». - Пароль: «

alloydb»

После успешной аутентификации в AlloyDB Studio команды SQL будут введены на вкладках редактора . Вы можете добавить несколько окон редактора, используя плюс справа от первой вкладки редактора.

Вы будете вводить команды для AlloyDB в окнах редактора, используя при необходимости параметры «Выполнить», «Форматировать» и «Очистить».

Включить расширения

Для создания этого приложения мы будем использовать расширения « pgvector" и « google_ml_integration" .

- Расширение pgvector позволяет хранить и искать вложения векторов.

- Расширение google_ml_integration предоставляет функции, которые вы используете для доступа к конечным точкам прогнозирования Vertex AI для получения прогнозов в SQL.

- Включите эти расширения, запустив следующие DDL:

CREATE EXTENSION IF NOT EXISTS google_ml_integration CASCADE;

CREATE EXTENSION IF NOT EXISTS vector;

- Проверьте, установлены ли расширения, выполнив эту команду SQL:

select extname, extversion from pg_extension;

Создать таблицу

- Создайте таблицу, используя следующий оператор DDL:

CREATE TABLE

apparels ( id BIGINT,

category VARCHAR(100),

sub_category VARCHAR(50),

uri VARCHAR(200),

image VARCHAR(100),

content VARCHAR(2000),

pdt_desc VARCHAR(5000),

embedding vector(768) );

При успешном выполнении приведенной выше команды вы сможете просмотреть таблицу в

база данных. На следующем изображении показан пример:

Прием данных

Для этой лабораторной работы у нас есть тестовые данные примерно из 200 записей в этом файле SQL . Он содержит id, category, sub_category, uri, image и content . Остальные поля будут заполнены позже в лабораторной работе.

- Скопируйте 20 строк/операторов вставки из файла SQL на новую вкладку «Редактор» в AlloyDB Studio и нажмите «Выполнить» .

- Разверните раздел «Проводник», пока не увидите таблицу с именем

apparels. - Щелкните значок меню [ ⋮ ] и выберите «Запрос» . Оператор SELECT откроется на новой вкладке редактора.

- Нажмите «Выполнить» , чтобы убедиться, что строки вставлены.

Предоставить разрешение пользователю

Мы предоставим пользователю postgres разрешение на создание вложений из AlloyDB . В AlloyDB Studio выполните следующий оператор, чтобы предоставить пользователю postgres права на выполнение функции embedding :

GRANT EXECUTE ON FUNCTION embedding TO postgres;

Предоставьте РОЛЬ пользователя Vertex AI сервисной учетной записи AlloyDB.

Мы будем использовать модели внедрения текста из Vertex AI для создания внедрений, для которых РОЛЬ пользователя Vertex AI привязана к учетной записи службы AlloyDB.

В Google Cloud Console щелкните терминал Cloud Shell [  ] и выполните следующую команду:

] и выполните следующую команду:

PROJECT_ID=$(gcloud config get-value project)

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:service-$(gcloud projects describe $PROJECT_ID --format="value(projectNumber)")@gcp-sa-alloydb.iam.gserviceaccount.com" \

--role="roles/aiplatform.user"

6. Создайте контекст

Чтобы создать встраивание, нам понадобится context , то есть вся информация, которую мы хотим включить в одно поле. Мы сделаем это, создав описание продукта, которое будем хранить в столбце pdt_desc таблицы apparels .

В нашем случае мы будем использовать всю информацию о каждом продукте, но когда вы делаете это со своими собственными данными, вы можете создавать данные любым способом, который вы считаете значимым для вашего бизнеса.

На вкладке редактора AlloyDB Studio выполните следующую команду, которая обновит поле pdt_desc контекстными данными:

UPDATE

apparels

SET

pdt_desc = CONCAT('This product category is: ', category, ' and sub_category is: ', sub_category, '. The description of the product is as follows: ', content, '. The product image is stored at: ', uri)

WHERE

id IS NOT NULL;

Этот DML создает простую контекстную сводку, используя информацию из всех полей, доступных в таблице, и других зависимостей (если таковые имеются в вашем случае). Для более точного набора информации и создания контекста вы можете формировать данные любым способом, который вы считаете значимым для вашего бизнеса.

7. Создайте вложения для контекста

Компьютерам гораздо проще обрабатывать числа, чем текст. Система внедрения преобразует текст в ряд чисел с плавающей запятой, которые должны представлять текст, независимо от того, как он сформулирован, на каком языке он используется и т. д.

Рассмотрим описание прибрежного места. Его можно назвать "on the water », « beachfront », « walk from your room to the ocean », « sur la mer », « на берегу океана » и т. д. Все эти термины выглядят по-разному, но их семантическое значение или, в терминологии машинного обучения, их вложения должны быть очень близки друг к другу.

Теперь, когда данные и контекст готовы, мы запустим SQL, чтобы добавить внедрения столбца описания продукта (pdt_desc ) в таблицу в поле embedding . Вы можете использовать различные модели внедрения. Мы используем text-embedding-005 от Vertex AI.

- В AlloyDB Studio выполните следующую команду, чтобы сгенерировать внедрения, и обновите столбец

pdt_desc, добавив внедрения для хранящихся в нем данных:

UPDATE

apparels

SET

embedding = embedding( 'text-embedding-005',

pdt_desc)

WHERE

TRUE;

- Убедитесь, что внедрения создаются, выполнив следующую команду:

SELECT

id,

category,

sub_category,

content,

embedding

FROM

Apparels

LIMIT 5;

Ниже приведен пример вектора внедрения, который выглядит как массив чисел с плавающей запятой для примера текста в запросе следующим образом:

8. Выполните векторный поиск.

Теперь, когда таблица, данные и внедрения готовы, давайте выполним векторный поиск в реальном времени для текста поиска пользователя.

Предположим, что поисковый текст пользователя: « pink color, casual, pure cotton tops for women ».

Чтобы найти совпадения для этого запроса, выполните следующий SQL-запрос:

SELECT

id,

category,

sub_category,

content,

pdt_desc AS description

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-005',

'pink color, casual, pure cotton tops for women')::vector

LIMIT

5;

Давайте рассмотрим этот запрос подробно:

В этом запросе

- Текст поиска пользователя: «

I want womens tops, pink casual only pure cotton. - Мы преобразуем этот искомый текст во встраивания, используя метод

embedding()вместе с моделью:text-embedding-005. Этот шаг должен выглядеть знакомо после предыдущего шага, где мы применили функцию внедрения ко всем элементам таблицы. - "

<=>" представляет собой использование метода расстояния COSINE SIMILARITY . Вы можете найти все доступные меры сходства в документации pgvector . - Мы преобразуем результат метода внедрения в векторный тип данных, чтобы сделать его совместимым с векторами, хранящимися в базе данных.

- LIMIT 5 означает, что мы хотим извлечь 5 ближайших соседей для искомого текста.

Ниже показан пример ответа на этот SQL-запрос:

Как вы можете видеть по результатам, совпадения довольно близки к искомому тексту. Попробуйте изменить цвет, чтобы увидеть, как изменятся результаты.

Индекс AlloyDB ScaNN для оценки производительности запросов

Теперь предположим, что мы хотим повысить производительность (время запроса), эффективность и запоминаемость результатов векторного поиска с помощью индекса ScaNN .

Если вы хотите использовать индекс ScanNN, попробуйте выполнить следующие действия:

- Поскольку у нас уже созданы кластер, экземпляр, контекст и внедрения, нам просто нужно установить расширение ScaNN, используя следующий оператор:

CREATE EXTENSION IF NOT EXISTS alloydb_scann;

- Создайте индекс ScanNN:

CREATE INDEX apparel_index ON apparels

USING scann (embedding cosine)

WITH (num_leaves=54);

В приведенном выше DDL:

-

apparel_index— это имя индекса. -

apparels— это название таблицы. -

scann— это индексный метод. -

embedding— это столбец таблицы, который вы хотите проиндексировать. -

cosine— это метод расстояния, который вы хотите использовать с индексом. -

54— это количество разделов, которые можно применить к этому индексу. Установите любое значение от 1 до 1048576. Дополнительные сведения о том, как определить это значение, см . в разделе Настройка индекса ScanNN .

Согласно рекомендации репозитория ScanN , мы использовали КВАДРАТНЫЙ КОРЕНЬ из количества точек данных. При секционировании num_leaves должно примерно равняться квадратному корню из количества точек данных.

- Проверьте, создан ли индекс с помощью запроса:

SELECT * FROM pg_stat_ann_indexes;

- Выполните векторный поиск, используя тот же запрос, который мы использовали без индекса:

select * from apparels

ORDER BY embedding <=> CAST(embedding('textembedding-gecko', 'white tops for girls without any print') as vector(768))

LIMIT 20

Приведенный выше запрос аналогичен тому, который мы использовали в лабораторной работе на шаге 8. Однако теперь у нас есть поле, проиндексированное с использованием индекса ScaNN.

- Протестируйте с помощью простого поискового запроса с индексом и без него. Для тестирования без индекса необходимо удалить индекс:

white tops for girls without any print

Приведенный выше текст поиска в запросе векторного поиска по ИНДЕКСИРОВАННЫМ данным внедрения приводит к качественным результатам поиска и эффективности. Эффективность значительно повышается (с точки зрения времени выполнения: 10,37 мс без ScaNN и 0,87 мс с ScaNN) с помощью индекса. Для получения дополнительной информации по этой теме, пожалуйста, обратитесь к этому блогу .

9. Проверка соответствия с LLM

Прежде чем двигаться дальше и создавать сервис для возврата лучших совпадений в приложение, давайте воспользуемся генеративной моделью ИИ, чтобы проверить, действительно ли эти потенциальные ответы актуальны и безопасны ли для обмена ими с пользователем.

Обеспечение настройки экземпляра для Gemini

- Убедитесь, что

google_ml_integrationуже включена для вашего кластера и экземпляра. В AlloyDB Studio выполните следующую команду:

show google_ml_integration.enable_model_support;

Если значение отображается как «включено» , вы можете пропустить следующие 2 шага и сразу перейти к настройке.

интеграция AlloyDB и модели Vertex AI.

- Перейдите к основному экземпляру вашего кластера AlloyDB и нажмите «РЕДАКТИРОВАТЬ ОСНОВНОЙ ЭКЗЕМПЛЯР» .

- В разделе «Параметры расширенной конфигурации» разверните раздел «Новый флаг базы данных» и убедитесь, что

google_ml_integration.enable_model_support flagустановлено значение «on» следующим образом:

3. Если для него не установлено значение «

3. Если для него не установлено значение « on », установите для него значение « on », а затем нажмите «ОБНОВИТЬ ЭКЗЕМПЛЯР» .

Этот шаг займет несколько минут.

Интеграция моделей AlloyDB и Vertex AI

Теперь вы можете подключиться к AlloyDB Studio и запустить следующую инструкцию DML, чтобы настроить доступ к модели Gemini из AlloyDB, используя идентификатор вашего проекта, где указано. Перед запуском команды вас могут предупредить о синтаксической ошибке, но она должна работать нормально.

- В Google Cloud Console перейдите в AlloyDB . Выберите основной кластер и нажмите AlloyDB Studio на панели навигации слева.

- Мы будем использовать

gemini-1.5-pro:generateContent, который доступен по умолчанию с расширениемgoogle_ml_integration.

- Вы можете проверить модели, настроенные для доступа, с помощью следующей команды в AlloyDB Studio:

select model_id,model_type from google_ml.model_info_view;

- Предоставьте пользователям базы данных разрешение на выполнение функции ml_predict_row для выполнения прогнозов с использованием моделей Google Vertex AI, выполнив следующую команду:

GRANT EXECUTE ON FUNCTION ml_predict_row to postgres;

Оценка ответов

Хотя в следующем разделе, где мы фактически перенесем приложение в Cloud Run, нам придется использовать один большой запрос, чтобы гарантировать, что ответы на запрос являются разумными, запрос может быть трудным для понимания.

Мы рассмотрим отдельные разделы, которые помогут построить более крупный запрос, который мы в конечном итоге используем.

- Сначала мы отправим запрос в базу данных, чтобы получить 5 наиболее близких совпадений с пользовательским запросом. Мы жестко запрограммировали запрос, чтобы сделать его простым, но не волнуйтесь, мы интерполируем его в запрос позже.

Мы включаем описание продукта из таблицы apparels и добавляем два новых поля: одно объединяет описание с индексом, а другое — с исходным запросом. Эти данные сохраняются в таблице с именем xyz , которая является временным именем таблицы.

CREATE TABLE

xyz AS

SELECT

id || ' - ' || pdt_desc AS literature,

pdt_desc AS content,

'I want womens tops, pink casual only pure cotton.' AS user_text

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-005',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5;

Результатом этого запроса будут 5 наиболее похожих строк, относящихся к запросу пользователя.

новая таблица xyz будет содержать 5 строк, каждая из которых будет иметь следующие столбцы:

-

literature -

content -

user_text

- Чтобы определить, насколько действительны ответы, мы воспользуемся сложным запросом, в котором объясним, как оценивать ответы. Он использует

user_textиcontentтаблицыxyzкак часть запроса.

"Read this user search text: ', user_text,

' Compare it against the product inventory data set: ', content,

' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

- Используя этот запрос, мы затем проверим «качественность» ответов в таблице

xyz. Когда мы говорим «хорошо», мы имеем в виду, насколько точно генерируемые реакции соответствуют нашим ожиданиям.

CREATE TABLE

x AS

SELECT

json_array_elements( google_ml.predict_row( model_id => 'gemini-1.5',

request_body => CONCAT('{

"contents": [

{ "role": "user",

"parts":

[ { "text": "Read this user search text: ', user_text, ' Compare it against the product inventory data set: ', content, ' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

} ]

}

] }'

)::json))-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'

AS LLM_RESPONSE

FROM

xyz;

-

predict_rowвозвращает результат в формате JSON. Код «-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'"используется для извлечения фактического текста из этого JSON. Чтобы увидеть фактический возвращаемый JSON, вы можете удалить этот код. - Наконец, чтобы получить поле LLM, вам просто нужно извлечь его из таблицы x:

SELECT

LLM_RESPONSE

FROM

x;

- Это можно объединить в один запрос следующим образом:

Предупреждение . Если вы выполнили приведенные выше запросы для проверки промежуточных результатов,

убедитесь, что вы удалили таблицы xyz и x из базы данных AlloyDB перед выполнением этого запроса,

SELECT

LLM_RESPONSE

FROM (

SELECT

json_array_elements( google_ml.predict_row( model_id => 'gemini-1.5',

request_body => CONCAT('{

"contents": [

{ "role": "user",

"parts":

[ { "text": "Read this user search text: ', user_text, ' Compare it against the product inventory data set: ', content, ' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

} ]

}

] }'

)::json))-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'

AS LLM_RESPONSE

FROM (

SELECT

id || ' - ' || pdt_desc AS literature,

pdt_desc AS content,

'I want womens tops, pink casual only pure cotton.' user_text

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-005',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5 ) AS xyz ) AS X;

Более крупный запрос представляет собой комбинацию всех запросов, которые мы выполняли на предыдущих шагах. Результаты показывают, есть ли совпадение, какой процент совпадения, а также некоторые пояснения к рейтингу.

Обратите внимание, что в модели Gemini потоковая передача включена по умолчанию, поэтому фактический ответ распределяется по нескольким строкам:

10. Разместите приложение в Интернете.

Теперь мы разместим это приложение, чтобы к нему можно было получить доступ из Интернета.

Создайте функцию Cloud Run

- В Google Cloud Console перейдите в раздел «Функции запуска облака», используя следующую ссылку:

https://console.cloud.google.com/run/create?deploymentType=function

- В Configuration установите имя функции « retail-engine » и выберите регион « us-central1 ».

- В URL-адресе конечной точки выберите среду выполнения Java 17 .

- В разделе «Аутентификация» выберите «Разрешить неаутентифицированные вызовы» .

- Разверните Контейнер(ы), Тома, Сеть, Безопасность и перейдите на вкладку Сеть .

- Выберите «Подключиться к VPC для исходящего трафика» , а затем нажмите « Использовать соединители бессерверного доступа к VPC» .

- В разделе «Сеть» нажмите «Добавить новый соединитель VPC» . Включите API-интерфейс бессерверного доступа к VPC , если он еще не включен.

- В соединителе «Создать» задайте имя

alloydb-test-conn. - Установите регион

us-central. - Оставьте значение «Сеть» по умолчанию и установите «Подсеть» в качестве «Пользовательский диапазон IP-адресов» с доступным диапазоном IP-адресов 10.8.0.0 или чем-то подобным.

- Разверните «Показать настройки масштабирования» и установите для параметра «Минимум экземпляров» значение 2, а для параметра «Максимум экземпляров» — 3.

- Выберите тип экземпляра f1-micro . Ниже показаны параметры создания соединителя:

- Нажмите «Создать», чтобы создать соединитель.

- В разделе «Маршрутизация трафика» выберите «Направить весь трафик в VPC» .

- Нажмите «Создать» , чтобы создать функцию.

Развертывание приложения

После создания функции обновите исходный код и повторно разверните приложение.

- В Cloud Run перейдите на вкладку «Сервисы» и выберите функцию «Retail-Engine» .

- Откройте вкладку «Источник». Оставьте для точки входа функции по умолчанию значение «

gcfv2.HelloHttpFunction». - Замените содержимое файла HelloHttpFunction.java содержимым из этого файла Java .

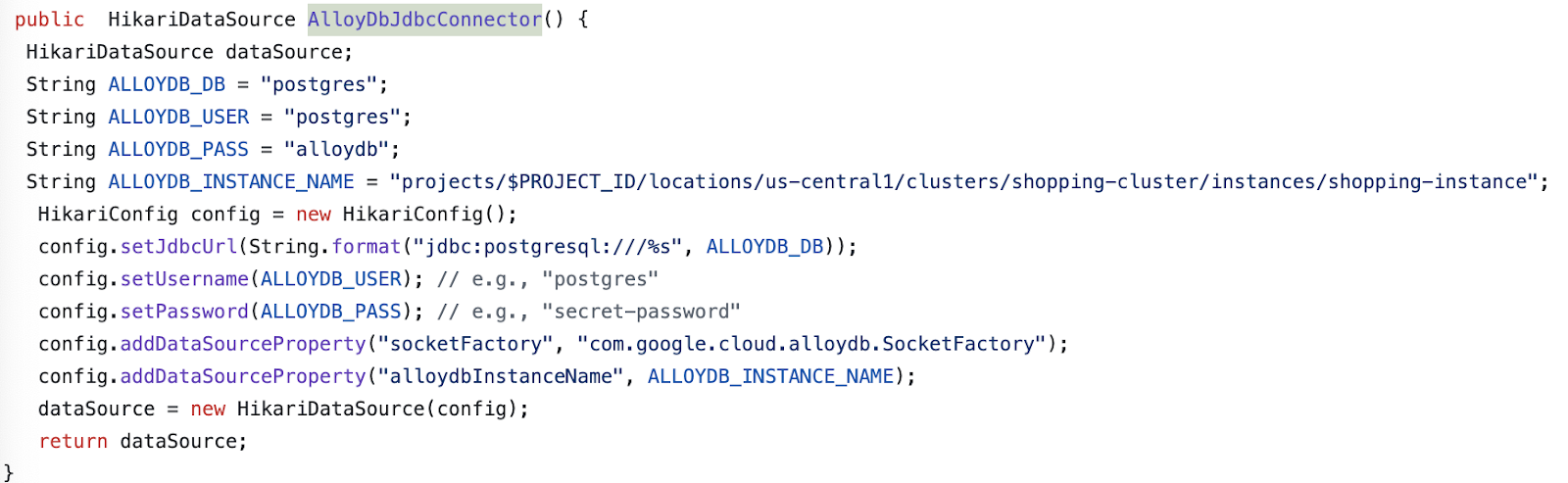

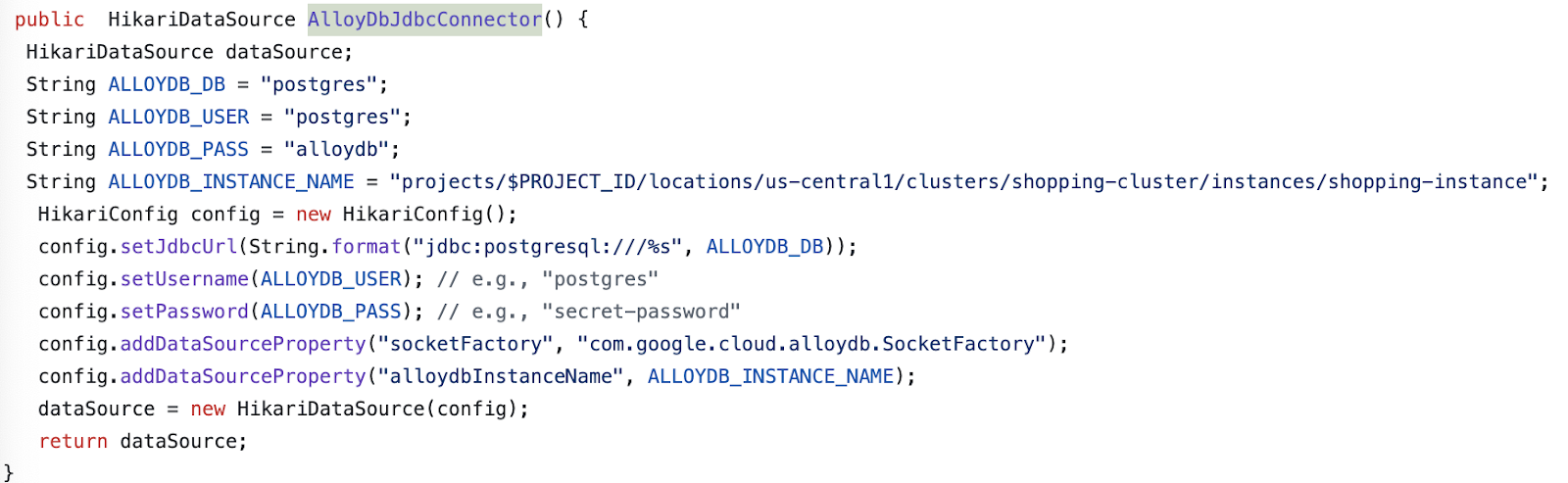

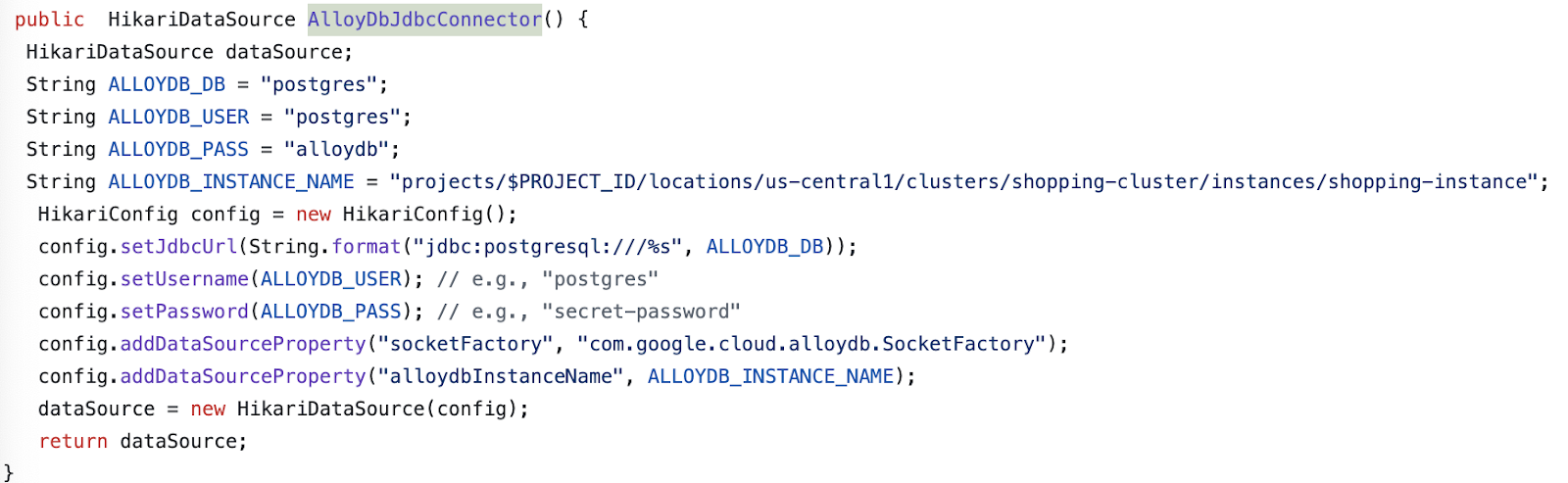

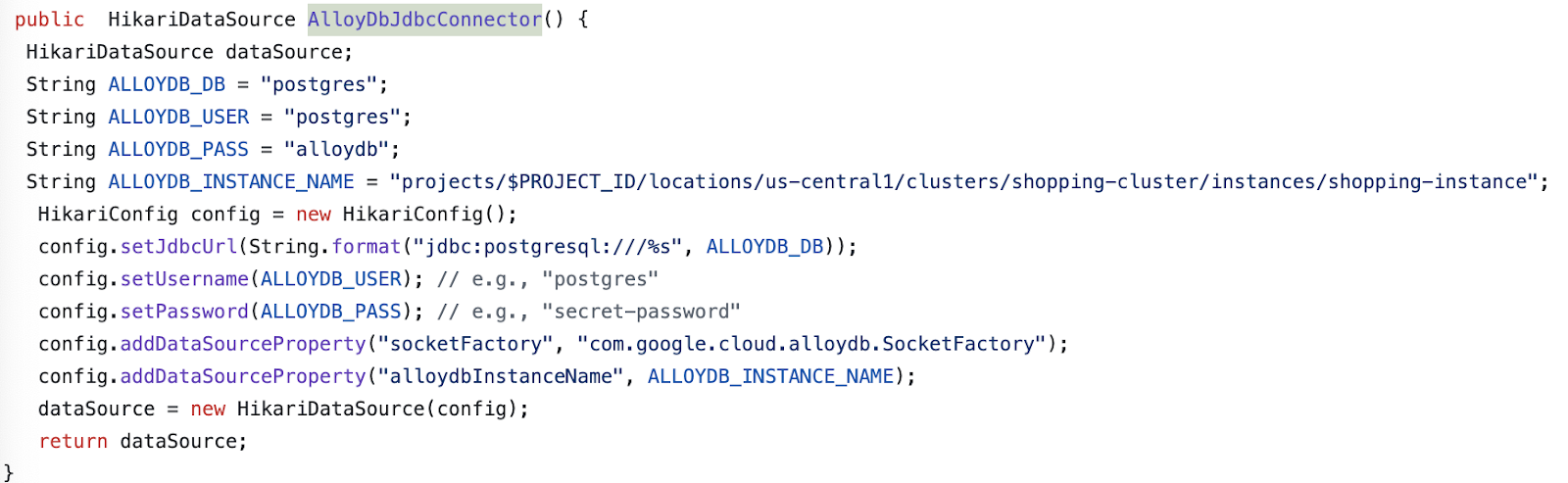

- Обновите данные AlloyDbJdbcConnector в файле в соответствии с данными вашего экземпляра и кластера AlloyDB. Замените

$PROJECT_IDидентификатором проекта вашего кластера и экземпляра AlloyDB.

- Замените содержимое файла pom.xml содержимым этого XML- файла.

- Нажмите «Сохранить и повторно развернуть» , чтобы развернуть функцию.

11. Протестируйте приложение для розничной торговли

После развертывания обновленной облачной функции вы должны увидеть конечную точку в следующем формате:

https://retail-engine-PROJECT_NUMBER.us-central1.run.app

Вы можете протестировать его из терминала Cloud Shell, выполнив следующую команду:

gcloud functions call retail-engine --region=us-central1 --gen2 --data '{"search": "I want some kids clothes themed on Disney"}'

Альтернативно вы можете протестировать функцию Cloud Run следующим образом:

PROJECT_ID=$(gcloud config get-value project)

curl -X POST https://retail-engine-$PROJECT_NUMBER.us-central1.run.app \

-H 'Content-Type: application/json' \

-d '{"search":"I want some kids clothes themed on Disney"}' \

| jq .

И результат:

Теперь, когда мы запустили поиск вектора сходства с использованием модели встраивания для данных AlloyDB, мы можем перейти к созданию приложения, которое использует эти встраивания вместе с вашим изображением и предлагает генерировать предложения по стилю.

12. Поймите порядок рекомендаций по одежде

Приложение рекомендаций по экипировке — это приложение для загрузки спринта, которое настроено для работы с встраиваниями, которые мы создали в приложении розничной торговли AlloyDB вместе с Gemini и Imagen, для создания вариантов визуального стиля экипировки. Он также позволяет добавлять собственные подсказки и импровизировать рекомендации.

Подумайте об этом так: вы загружаете в это приложение изображение ярко-розового топа из вашего гардероба. Когда вы нажимаете «Показать», на основе подсказки, заданной в коде приложения, и встроенных данных в базе данных AlloyDB, приложение генерирует несколько параметров, соответствующих исходному изображению. Теперь вам интересно, как предложенные варианты могут выглядеть с синим ожерельем, поэтому вы добавляете подсказку в эти строки и нажимаете «Стиль». Создается окончательное изображение, сочетающее в себе мощное сочетание исходного изображения и рекомендаций по созданию подходящего наряда.

Чтобы начать создавать приложение с рекомендациями по одежде, выполните следующие действия:

- В Cloud Run откройте приложение розничной торговли и запишите URL-адрес вашего приложения. Это репозиторий вложений, который мы будем использовать для генерации подобных предложений.

- В своей IDE клонируйте репозиторий https://github.com/AbiramiSukumaran/outfit-recommender/ . В этом упражнении показанные шаги выполняются в Visual Studio Code IDE.

git clone https://github.com/AbiramiSukumaran/outfit-recommender/

Ниже приведены некоторые важные файлы в каталоге приложения:

-

src/main: Исходный каталог, в котором находятся файлы приложения и HTML: -

HelloWorldApplication.java: основная точка входа для приложения весенней загрузки. -

HelloWorldController.java: контроллер REST Spring Boot, который обрабатывает HTTP-запросы, связанные с приложением рекомендации одежды. Этот файл обрабатывает запросы GET и POST, обрабатывает запросы пользователя, анализирует изображения, взаимодействует с встраиваниями AlloyDB и возвращает окончательный ответ пользовательскому интерфейсу. Этот контроллер вызывает класс GenerateImageSample. -

GenerateImageSample.java: содержит класс генерации изображений, который подключается к Vertex AI, форматирует пользовательское приглашение, выполняет вызовы API к модели Imagen, возвращает прогнозируемое изображение в класс контроллера. -

Resources: этот каталог содержит изображения и файлы HTML, необходимые для создания пользовательского интерфейса приложения. -

Pom.xml: определяет зависимости и конфигурации проекта.

- В коде Visual Studio откройте

HelloWorldController.javaи обновите экземпляры идентификатора проекта и местоположения в соответствии с местом создания вашего экземпляра AlloyDB.

- Обновите

endpoint, указав URL-адрес приложения для розничной торговли, который вы разместили ранее.

- Откройте

GenerateImageSample.javaи обновите идентификатор проекта и местоположение в соответствии с местом создания вашего экземпляра AlloyDB.

- Сохраните все файлы.

Теперь мы развернем это приложение в бессерверной среде выполнения Cloud Run.

13. Разместите приложение в Интернете.

Теперь, когда мы добавили соответствующий проект, местоположение и сведения о приложении для розничной торговли в приложение весенней загрузки рекомендации по оборудованию, мы можем развернуть приложение в Cloud Run.

Мы будем использовать команду gcloud run deploy в терминале Visual Code Studio для развертывания приложения. Для Visual Studio Code вы можете установить расширение Google Cloud Code, чтобы начать использовать интерфейс командной строки gcloud.

Чтобы развернуть приложение, выполните следующие действия:

- В вашей IDE откройте клонированный каталог и запустите терминал. В Visual Code Studio нажмите «Терминал» > «Новый терминал» .

- Следуйте инструкциям в этом документе , чтобы установить интерфейс командной строки gcloud.

- Если вы используете Visual Code Studio, нажмите «Расширения» , найдите Google Cloud Code и установите расширение.

- В терминале IDE подтвердите свою учетную запись Google, выполнив следующую команду:

gcloud auth application-default login

- Установите идентификатор проекта в тот же проект, в котором находится ваш экземпляр AlloyDB.

gcloud config set project PROJECT_ID

- Запустите процесс развертывания.

gcloud run deploy

- В

Source code locationнажмите Enter, чтобы выбрать клонированный каталог GitHub. - В

Service name» введите имя службы, например Outfit-Recommender, и нажмите Enter. - В

Please specify a regionвведите местоположение, где размещен ваш экземпляр AlloyDB и приложение для розничной торговли, например 32 для us-central1, и нажмите Enter.

- В поле

Allow unauthenticated invocations to [..]введите Y и нажмите Enter.

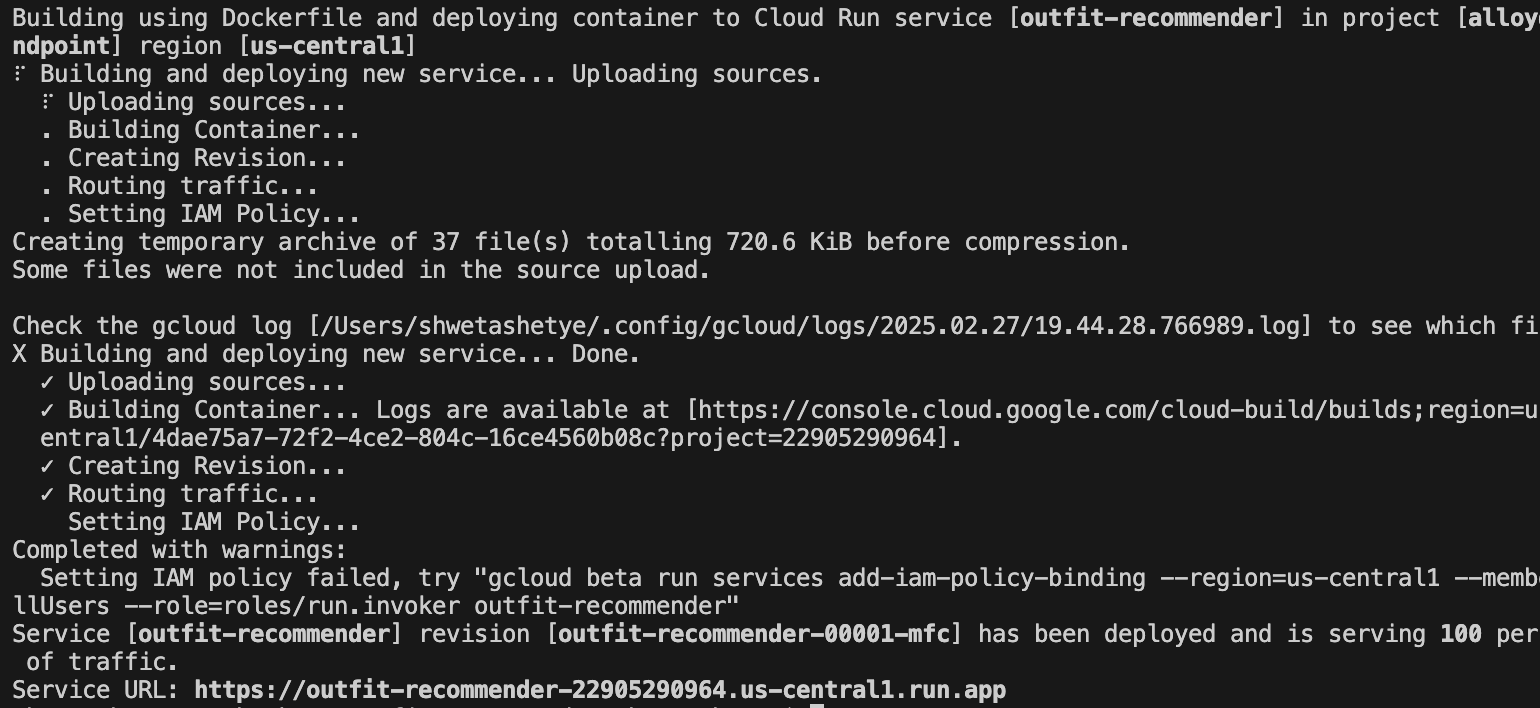

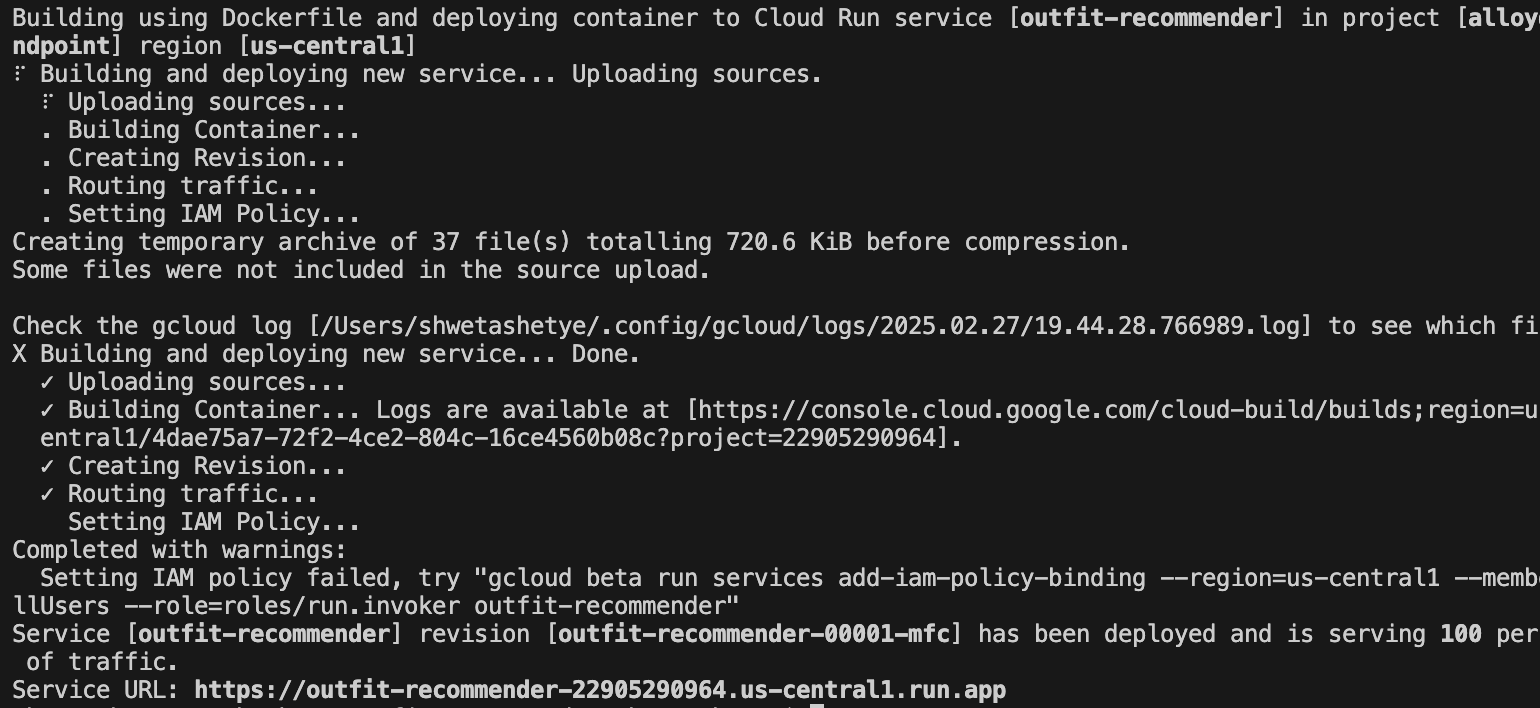

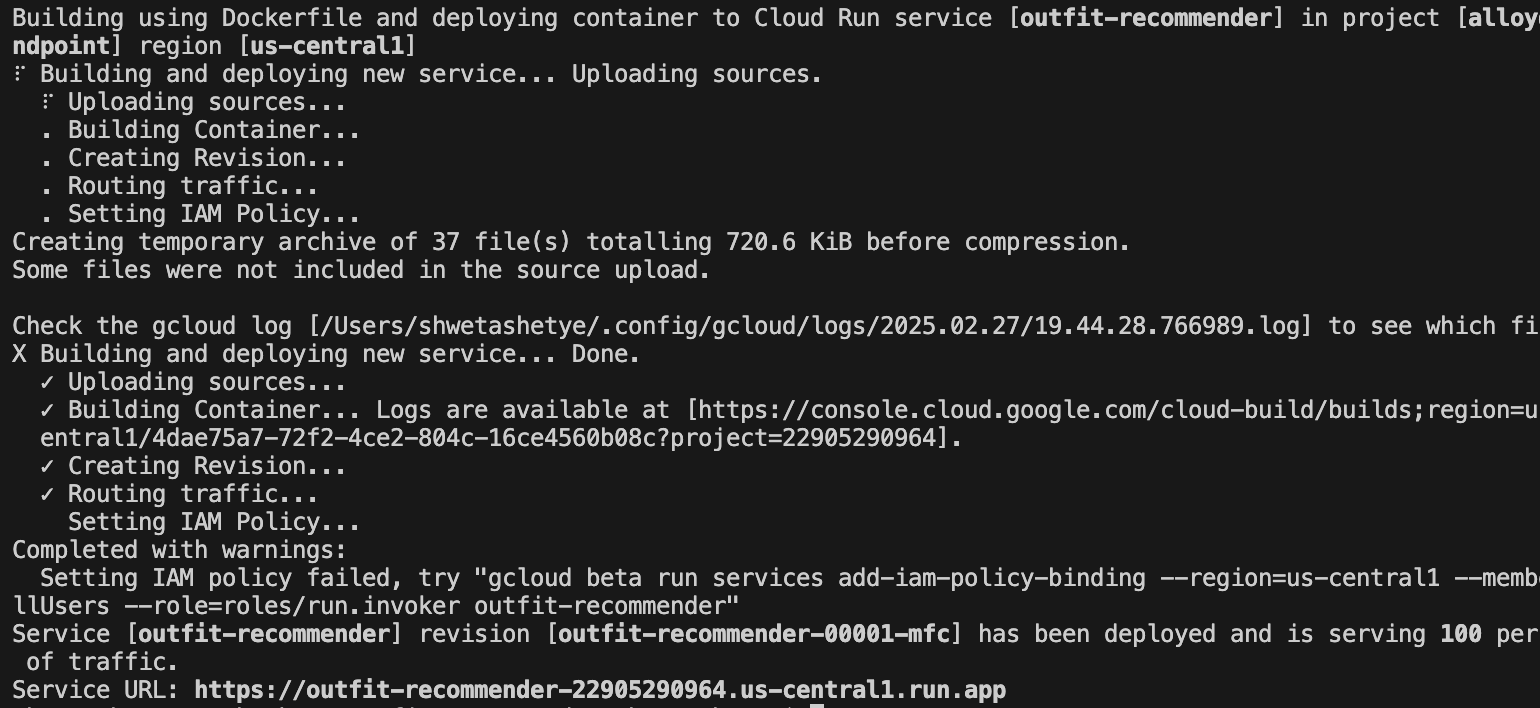

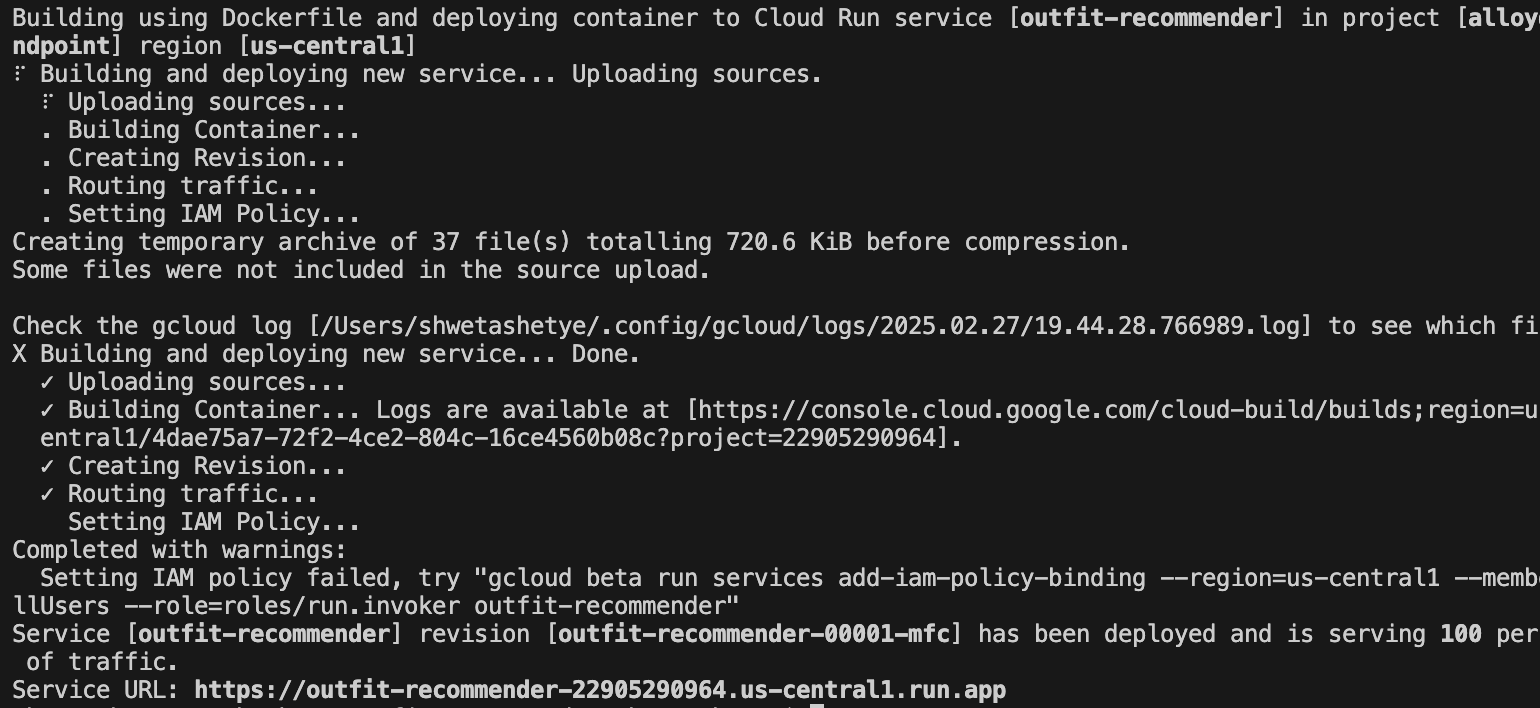

На следующем изображении показан ход развертывания вашего приложения:

14. Проверьте приложение рекомендации экипировки.

После успешного развертывания приложения в Cloud Run вы сможете увидеть сервис в Google Cloud Console следующим образом:

- В Google Cloud Console перейдите в Cloud Run .

- В разделе «Службы» щелкните развернутую службу рекомендации по оборудованию . Вы должны увидеть как розничный движок , так и службу рекомендации одежды следующим образом:

- Щелкните URL-адрес приложения, чтобы открыть пользовательский интерфейс приложения-рекомендатора.

The following is a sample URL that you will use:

https://outfit-recommender-22905290964.us-central1.run.app/style

Развернутое приложение можно увидеть следующим образом:

Использование приложения

Чтобы начать использовать приложение, выполните следующие действия:

- Нажмите «Загрузить» и загрузите изображение предмета одежды.

- После загрузки изображения нажмите «Стиль» . Приложение использует изображение в качестве подсказки и генерирует нижние параметры на основе подсказки приложения для розничной торговли, которая включает в себя встраивания для набора розничных данных.

Приложение генерирует предложения изображений, а также подсказку на основе изображения с рекомендациями по стилю. Например, A white semi-sheer button up blouse with pink floral patterns on it, with balloon sleeves.

- Вы можете передать дополнительные запросы в эту автоматически созданную рекомендацию по стилю. Например,

STYLE RECOMMENDATION: Cute brown skirt on a curly updo. Make it photo realistic. Accessorize with cherry earrings and burgundy plastic case sling bag. - Нажмите «Показать» , чтобы увидеть окончательный стиль.

15. Очистка

Чтобы избежать списания средств с вашей учетной записи Google Cloud за ресурсы, используемые в этом посте, выполните следующие действия:

- В консоли Google Cloud перейдите на страницу «Управление ресурсами» .

- В списке проектов выберите проект, который хотите удалить, и нажмите «Удалить» .

- В диалоговом окне введите идентификатор проекта, а затем нажмите «Завершить работу» , чтобы удалить проект.

16. Поздравления

Поздравляем! Вы успешно выполнили поиск по сходству с помощью поиска AlloyDB, pgvector и Vector, а также использовали результаты поиска с мощной моделью Imagen для генерации рекомендаций по стилю.

1. Обзор

Представьте себе модное приложение, которое не только поможет вам подобрать идеальный наряд, но и даст советы по стилю в режиме реального времени, и все это благодаря возможностям передовой интеграции genAI! В этом докладе мы рассмотрим, как мы создали такое приложение, используя возможности векторного поиска AlloyDB в сочетании с индексом Google ScaNN, что позволяет молниеносно искать подходящие наряды и мгновенно предоставлять рекомендации по моде.

Мы также углубимся в то, как индекс ScaNN AlloyDB оптимизирует сложные запросы для создания персонализированных предложений по стилю. Мы также будем использовать Gemini и Imagen, мощные генеративные модели искусственного интеллекта, чтобы вдохновлять вас на творческий стиль и даже визуализировать ваш индивидуальный образ. Все это приложение построено на бессерверной архитектуре, обеспечивая пользователям бесперебойную и масштабируемую работу.

Задача: предлагая персонализированные предложения по одежде, приложение призвано помочь людям, которые борются с нерешительностью в моде. Это также помогает избежать усталости от принятия решений при планировании экипировки.

Решение: Приложение рекомендации одежды решает проблему предоставления пользователям интеллектуального, персонализированного и увлекательного опыта моды, одновременно демонстрируя возможности AlloyDB, генеративного искусственного интеллекта и бессерверных технологий.

Что ты построишь

В рамках этой лабораторной работы вы:

- Создайте экземпляр AlloyDB и загрузите набор данных электронной торговли.

- Включите расширения pgvector и генеративной модели искусственного интеллекта в AlloyDB.

- Генерация вложений из описания продукта

- Разверните решение в бессерверных функциях Cloud Run.

- Загрузите изображение в Gemini и создайте запрос описания изображения.

- Генерируйте результаты поиска на основе подсказок в сочетании с внедренными наборами данных электронной торговли.

- Добавьте дополнительные подсказки, чтобы настроить подсказку и создать рекомендации по стилю.

- Развернуть решение в функциях без сервера Cloud Run

Требования

2. Архитектура

Архитектура приложения высокого уровня заключается в следующем:

В следующих разделах подчеркивается контекстуальный поток учебника:

Приглашение :

Наш первый шаг - прогласить данные розничной торговли (инвентаризацию, описания продуктов, взаимодействие с клиентами) в AlloyDB.

Аналитический двигатель:

Мы будем использовать AlloyDB в качестве механизма Analytics для выполнения ниже:

- Извлечение контекста: двигатель анализирует данные, хранящиеся в AlloyDB, чтобы понять отношения между продуктами, категориями, поведением клиентов и т. Д.

- Создание встраивания: встраивание (математические представления текста) генерируются как для запроса пользователя, так и для информации, хранящейся в AlloyDB.

- Векторный поиск: двигатель выполняет поиск сходства, сравнивая запрос, внедряющий встроенные встроенные продукты, обзоры и другие соответствующие данные. Это идентифицирует 25 наиболее актуальных «ближайших соседей».

Рекомендация Близнецов:

Массив байтов изображения передается в модель Близнецов через API вершины AI, а также подсказку с просьбой о текстовом описании верхнего износа вместе с рекомендациями нижней одежды.

AlloyDB Rag и Vector Search:

Описание верхней одежды используется для запроса базы данных. Запрос преобразует текст поиска (рекомендация из модели Gemini для сопоставления нижнего износа) в встраивание и выполняет векторный поиск по вставкам, хранящимся в базе данных, чтобы найти ближайших соседей (соответствующие результаты). Вторжения векторов в базе данных AlloyDB индексируются с использованием индекса скана для лучшего отзыва.

Генерация изображений ответа:

Проверенные ответы структурированы в массив JSON, а весь двигатель упакован в функцию без сервера облачного запуска, которая вызывает у Agent Builder.

Генерация изображений Imagen:

Пользовательская приглашение пользователя, выбранная пользователем рекомендация и любые запросы персонализации объединены, чтобы предпринять Imagen 3 с существующим изображением. Изображение стиля генерируется на основе этой подсказки, используя API Vertex AI.

3. Прежде чем начать

Создать проект

- На консоли Google Cloud , на странице выбора проектов выберите или создайте Google Cloud Project .

- Убедитесь, что выставление счета включено для вашего облачного проекта. Узнайте, как проверить, включен ли выставление счетов на проекте .

- Вы используете Cloud Shell , среду командной строки, работающая в Google Cloud, которая поставляется с предварительно загруженной BQ. Нажмите «Активировать облачную оболочку» (

) в верхней части облачной консоли Google.

) в верхней части облачной консоли Google. - После подключения к облачной оболочке убедитесь, что вы уже аутентифицировали и что проект устанавливается на идентификатор вашего проекта, используя следующую команду:

gcloud auth list

- Запустите следующую команду, чтобы подтвердить, что будущие команды GCLOUD правильно определили ваш проект.

gcloud config list project

- Если ваш проект не установлен, используйте следующую команду, чтобы явно установить ее:

gcloud config set project <YOUR_PROJECT_ID>

- Включить требуемые API.

Перейдите по ссылке , чтобы включить API.

Если вы скучаете по включению любого API, вы всегда можете включить его в ходе реализации.

Для получения дополнительной информации о командах GCLOUD и использовании, обратитесь к документации .

4. Настройка базы данных

В этой лаборатории мы будем использовать AlloyDB в качестве базы данных для хранения набора данных в розничной торговле. Он использует кластеры для хранения всех ресурсов, таких как базы данных и журналы. Каждый кластер имеет основной экземпляр , который обеспечивает точку доступа к данным. Таблицы - это фактический ресурс, который хранит данные.

Давайте создадим кластер AlloyDB, экземпляр и таблицу, где будет загружен набор данных электронной коммерции.

Создать кластер и экземпляр

- В Cloud Console Google найдите AlloyDB . Простой способ найти большинство страниц в облачной консоли - искать их, используя строку поиска консоли.

- Нажмите «Создать кластер» .

- Создайте кластер и экземпляр со следующими значениями:

- идентификатор кластера: «

shopping-cluster» - пароль: "

alloydb" - Postgresql 15 совместимо

- Регион: "

us-central1" - Сеть: "

default"

- В сети, когда вы выбираете сеть по умолчанию, появляется следующая опция. Нажмите «Настройка соединения» , чтобы настроить сеть по умолчанию.

- Выберите Используйте автоматически выделенный диапазон IP и нажмите «Продолжить» . После просмотра информации нажмите «Создать соединение» .

Подождите, пока создание сети по умолчанию завершит.

- В настройке своего основного экземпляра установите идентификатор экземпляра как «

shopping-instance".

- Нажмите «Создать кластер» , чтобы завершить настройку кластера следующим образом:

5. Перепуск данных

Теперь пришло время добавить таблицу с данными о магазине. Подождите, пока ваш экземпляр закончит создание. После того, как он будет создан, вы можете войти в AlloyDB, используя учетные данные, которые вы устанавливаете при создании кластера.

Аутентификация в базу данных AlloyDB

- В Google Cloud Console перейдите в AlloyDB . Выберите первичный кластер, а затем нажмите Alloydb Studio в левой навигации:

- Введите следующие данные для аутентификации в базу данных AlloyDB:

- Имя пользователя: "

postgres" - База данных: "

postgres" - Пароль: "

alloydb"

После того, как вы успешно пройдете подлинность в Studio AlloyDB, команды SQL введены в вкладки редактора . Вы можете добавить несколько Windows редактора, используя плюс справа от первой вкладки редактора.

Вы введете команды для AlloyDB в Windows Editor, используя параметры Run, Format и Clean Acsome.

Включить расширения

Для создания этого приложения мы будем использовать расширения « pgvector" и « google_ml_integration" .

- Расширение PGVector позволяет хранить и искать векторы.

- Расширение Google_ml_integration предоставляет функции, которые вы используете для доступа к конечным точкам прогнозирования вершины AI, чтобы получить прогнозы в SQL.

- Включите эти расширения, выполнив следующие DDL:

CREATE EXTENSION IF NOT EXISTS google_ml_integration CASCADE;

CREATE EXTENSION IF NOT EXISTS vector;

- Убедитесь, установлены ли расширения с помощью этой команды SQL:

select extname, extversion from pg_extension;

Создать таблицу

- Создайте таблицу с помощью следующего оператора DDL:

CREATE TABLE

apparels ( id BIGINT,

category VARCHAR(100),

sub_category VARCHAR(50),

uri VARCHAR(200),

image VARCHAR(100),

content VARCHAR(2000),

pdt_desc VARCHAR(5000),

embedding vector(768) );

При успешном выполнении вышеуказанной команды вы сможете просмотреть таблицу в

база данных. На следующем изображении показан пример:

Проглатывание данных

Для этой лаборатории у нас есть тестовые данные о 200 записях в этом файле SQL . Он содержит id, category, sub_category, uri, image и content . Другие поля будут заполнены позже в лаборатории.

- Скопируйте операторы 20 строк/вставки из файла SQL на новой вкладке редактора в AlloyDB Studio и нажмите «Запуск» .

- Разверните раздел Explorer, пока не увидите таблицу с именем

apparels. - Нажмите значок меню [ ⋮ ] и нажмите «Запрос» . Оператор SELECT откроется на новой вкладке редактора.

- Нажмите запустить , чтобы убедиться, что строки вставлены.

Предоставить разрешение пользователю

Мы предоставим разрешение пользователю postgres на генерацию внедрения из AlloyDB . В Studio Alloydb запустите следующее оператор для предоставления прав выполнять функцию embedding пользователю postgres :

GRANT EXECUTE ON FUNCTION embedding TO postgres;

Предоставьте роли пользователя AI Vertex AI в учетную запись Service AlloyDB

Мы будем использовать модели встроенного текста из AI Vertex для генерации встроений, для которых пользовательская роль Vertex AI в учетную запись службы AlloyDB.

В консоли Cloud Google нажмите на терминал Cloud Shell [  ] значок и запустите следующую команду:

] значок и запустите следующую команду:

PROJECT_ID=$(gcloud config get-value project)

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:service-$(gcloud projects describe $PROJECT_ID --format="value(projectNumber)")@gcp-sa-alloydb.iam.gserviceaccount.com" \

--role="roles/aiplatform.user"

6. Постройте контекст

Чтобы создать внедрение, нам нужно иметь context , то есть вся информация, которую мы хотим включить в одну область. Мы сделаем это, создав описание продукта, которое мы храним в столбце pdt_desc в таблице apparels .

В нашем случае мы будем использовать всю информацию о каждом продукте, но когда вы делаете это со своими собственными данными, не стесняйтесь разработать данные любым способом, которым вы находите значимыми для своего бизнеса.

На вкладке AlloyDB Studio Editor запустите следующую команду, которая обновляет поле pdt_desc с данными контекста:

UPDATE

apparels

SET

pdt_desc = CONCAT('This product category is: ', category, ' and sub_category is: ', sub_category, '. The description of the product is as follows: ', content, '. The product image is stored at: ', uri)

WHERE

id IS NOT NULL;

Этот DML создает простой резюме контекста, используя информацию из всех полей, доступных в таблице, и других зависимостей (если таковые имеются в вашем варианте использования). Для более точного ассортимента информации и создания контекста не стесняйтесь разработать данные любым способом, которым вы считаете значимыми для своего бизнеса.

7. Создайте встраивания для контекста

Для компьютеров гораздо проще обрабатывать числа, чем обрабатывать текст. Система встраивания преобразует текст в серию номеров с плавающими темпами, которые должны представлять текст, независимо от того, как он сформулирован, какой язык он использует и т. Д.

Подумайте о том, чтобы описать приморское местоположение. Это можно назвать "on the water », « beachfront », « walk from your room to the ocean », « sur la mer », « на берегу океана Бьюре -окране» и т. Д. Все эти термины выглядят по -разному, но их семантическое значение или в терминологии машинного обучения, их вступители должны быть очень близки друг к другу.

Теперь, когда данные и контекст готовы, мы запустим SQL, чтобы добавить встроенные вставки столбца описания продукта (pdt_desc ) в таблицу во embedding поля. Есть множество моделей встраивания, которые вы можете использовать. Мы используем text-embedding-005 из вершины AI.

- В Studio AlloyDB запустите следующую команду для генерации встроений и обновите столбец

pdt_descс помощью вставки для данных, которые он хранит:

UPDATE

apparels

SET

embedding = embedding( 'text-embedding-005',

pdt_desc)

WHERE

TRUE;

- Убедитесь, что встраивания генерируются путем выполнения следующей команды:

SELECT

id,

category,

sub_category,

content,

embedding

FROM

Apparels

LIMIT 5;

Ниже приведен пример вектора Entrydings, который выглядит как массив поплавков, для образца текста в запросе следующим образом:

8. Выполнить векторный поиск

Теперь, когда таблица, данные и внедрения готовы, давайте выполним поиск вектора в реальном времени для текста поиска пользователя.

Предположим, что текст поиска пользователя - « pink color, casual, pure cotton tops for women »

Чтобы найти совпадения для этого запроса, запустите следующий SQL -запрос:

SELECT

id,

category,

sub_category,

content,

pdt_desc AS description

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-005',

'pink color, casual, pure cotton tops for women')::vector

LIMIT

5;

Давайте подробно рассмотрим этот запрос:

В этом запросе,

- Текст поиска пользователя: «

I want womens tops, pink casual only pure cotton. - Мы преобразуем этот текст поиска в встраивание с использованием метода

embedding()вместе с моделью:text-embedding-005. Этот шаг должен выглядеть знакомо после последнего шага, где мы применили функцию встраивания ко всем элементам в таблице. - «

<=>» представляет использование метода расстояния сходства косинуса . Вы можете найти все меры сходства, доступные в документации PGVector . - Мы преобразуем результат метода встраивания в тип векторных данных, чтобы сделать его совместимым с векторами, хранящимися в базе данных.

- Предел 5 представляет, что мы хотим извлечь 5 ближайших соседей для текста поиска.

Следующее показывает пример ответа этого запроса SQL:

Как вы можете наблюдать в своих результатах, матчи довольно близки к тексту поиска. Попробуйте изменить цвет, чтобы увидеть, как меняются результаты.

Индекс Scann Scann AlloyDB для производительности запроса

Теперь допустим, мы хотим повысить производительность (время запроса), эффективность и вспомнить этот результат поиска вектора с использованием индекса скана .

Если вы хотите использовать индекс скана, попробуйте следующие шаги:

- Поскольку у нас уже созданы кластер, экземпляр, контекст и встраивание, нам просто нужно установить расширение Scann, используя следующее оператор:

CREATE EXTENSION IF NOT EXISTS alloydb_scann;

- Создайте индекс скана:

CREATE INDEX apparel_index ON apparels

USING scann (embedding cosine)

WITH (num_leaves=54);

В вышеупомянутом DDL:

-

apparel_index- это имя индекса. -

apparels- это название таблицы. -

scann- это метод индекса. -

embeddingстолбец в таблице, которую вы хотите индексировать. -

cosine- это метод расстояния, который вы хотите использовать с индексом. -

54- это количество разделов для применения к этому индексу. Установите любое значение от 1 до 1048576. Для получения дополнительной информации о том, как решить это значение, см . Tune A Scann Index .

Согласно рекомендации в Scann Repo , мы использовали квадратный корень из количества точек данных. При распределении num_leaves должен быть примерно квадратным корнем количества данных.

- Проверьте, создается ли индекс с помощью запроса:

SELECT * FROM pg_stat_ann_indexes;

- Выполните векторный поиск, используя тот же запрос, который мы использовали без индекса:

select * from apparels

ORDER BY embedding <=> CAST(embedding('textembedding-gecko', 'white tops for girls without any print') as vector(768))

LIMIT 20

Приведенный выше запрос - тот же, который мы использовали в лаборатории на шаге 8. Однако теперь у нас есть поле, с использованием индекса скана.

- Проверьте с помощью простого поискового запроса с индексом и без него. Для тестирования без индекса вы должны отказаться от индекса:

white tops for girls without any print

Приведенный выше текст поиска в запросе поиска вектора на индексированных данных встроенных встроенных данных приводит к результатам качества поиска и эффективности. Эффективность значительно улучшается (с точки зрения времени для выполнения: 10,37 мс без скачкования и 0,87 мс со сканом) с индексом. Для получения дополнительной информации по этой теме, пожалуйста, обратитесь к этому блогу .

9. Совместите проверку с LLM

Прежде чем двигаться дальше и создать услугу, чтобы вернуть лучшие совпадения с приложением, давайте использовать генеративную модель ИИ для проверки, действительно ли эти потенциальные ответы являются действительно актуальными и безопасными для поделиться пользователем.

Обеспечение установки экземпляра для Близнецов

- Убедитесь, что

google_ml_integrationуже включена для вашего кластера и экземпляра. В студии Alloydb запустите следующую команду:

show google_ml_integration.enable_model_support;

Если значение показано как «включение» , вы можете пропустить следующие 2 шага и перейти непосредственно к настройке

Интеграция модели AlyDB и Vertex AI.

- Перейдите в основной экземпляр кластера AlloyDB и нажмите «Редактировать первичный экземпляр» .

- В расширенных параметрах конфигурации разверните новый раздел флага базы данных и убедитесь, что

google_ml_integration.enable_model_support flagустанавливается на «on» следующим образом:

3. Если он не установлен на «

3. Если он не установлен на « on », установите его на « on », а затем нажмите Endute Encement .

Этот шаг займет несколько минут.

Интеграция модели ALOYDB и Vertex AI

Теперь вы можете подключиться к AlloyDB Studio и запустить следующее оператор DML, чтобы настроить доступ к модели Gemini из AlloyDB, используя свой идентификатор проекта, где указано. Вы можете быть предупреждены о синтаксической ошибке перед запуском команды, но она должна работать нормально.

- В Google Cloud Console перейдите в AlloyDB . Выберите первичный кластер, а затем нажмите Alloydb Studio в левой навигации.

- Мы будем использовать

gemini-1.5-pro:generateContent, который доступен по умолчанию с расширениемgoogle_ml_integration.

- Вы можете проверить модели, настроенные для доступа через следующую команду в Alloydb Studio:

select model_id,model_type from google_ml.model_info_view;

- Дайте разрешение для пользователей базы данных выполнить функцию ML_PREDICT_ROW , чтобы запустить прогнозы, используя модели Google Vertex AI, выполнив следующую команду:

GRANT EXECUTE ON FUNCTION ml_predict_row to postgres;

Оценка ответов

В то время как мы в конечном итоге используем один большой запрос для следующего раздела, где мы фактически возьмем приложение для Cloud Run, чтобы гарантировать, что ответы из запроса являются разумными, запрос может быть трудно понять.

Мы посмотрим на отдельные разделы, которые продолжаются, чтобы построить больший запрос, который мы наконец используем.

- Сначала мы отправим запрос в базу данных, чтобы получить 5 самых близких совпадений с пользовательским запросом. Мы жестко кодируем запрос, чтобы сохранить этот простой, но не волнуйтесь, мы позже интерполируем его в запрос.

Мы включаем описание продукта из таблицы apparels и добавляем два новых поля - один, который объединяет описание с индексом, а другой с исходным запросом. Эти данные сохраняются в таблице под названием xyz , которая является временным названием таблицы.

CREATE TABLE

xyz AS

SELECT

id || ' - ' || pdt_desc AS literature,

pdt_desc AS content,

'I want womens tops, pink casual only pure cotton.' AS user_text

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-005',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5;

Вывод этого запроса будет 5 самых похожих строк, относящихся к запросу пользователей.

Новая таблица xyz будет содержать 5 строк, где каждая строка будет иметь следующие столбцы:

-

literature -

content -

user_text

- Чтобы определить, насколько действительны ответы, мы будем использовать сложный запрос, в котором объясняем, как оценить ответы. Он использует

user_textиcontentв таблицеxyzкак часть запроса.

"Read this user search text: ', user_text,

' Compare it against the product inventory data set: ', content,

' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

- Используя этот запрос, мы рассмотрим «доброта» ответов в таблице

xyz. Когда мы говорим доброту, мы подразумеваем, насколько близко точны ответы на то, что мы ожидаем.

CREATE TABLE

x AS

SELECT

json_array_elements( google_ml.predict_row( model_id => 'gemini-1.5',

request_body => CONCAT('{

"contents": [

{ "role": "user",

"parts":

[ { "text": "Read this user search text: ', user_text, ' Compare it against the product inventory data set: ', content, ' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

} ]

}

] }'

)::json))-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'

AS LLM_RESPONSE

FROM

xyz;

-

predict_rowвозвращает свой результат в формате JSON. Код "-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'"используется для извлечения фактического текста из этого JSON. Чтобы увидеть фактический JSON, который возвращается, вы можете удалить этот код. - Наконец, чтобы получить поле LLM, вам просто нужно извлечь его из таблицы X:

SELECT

LLM_RESPONSE

FROM

x;

- Это можно объединить в один запрос следующим образом:

Предупреждение : если вы запустили приведенные выше запросы, чтобы проверить промежуточные результаты,

Убедитесь, что вы удаляете/удалили таблицы xyz и x из базы данных AlloyDB перед запуска этим запроса,

SELECT

LLM_RESPONSE

FROM (

SELECT

json_array_elements( google_ml.predict_row( model_id => 'gemini-1.5',

request_body => CONCAT('{

"contents": [

{ "role": "user",

"parts":

[ { "text": "Read this user search text: ', user_text, ' Compare it against the product inventory data set: ', content, ' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

} ]

}

] }'

)::json))-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'

AS LLM_RESPONSE

FROM (

SELECT

id || ' - ' || pdt_desc AS literature,

pdt_desc AS content,

'I want womens tops, pink casual only pure cotton.' user_text

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-005',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5 ) AS xyz ) AS X;

Большой запрос - это комбинация всех запросов, которые мы запускаем на предыдущих шагах. Результаты сообщают, есть ли совпадение или нет, какой процент матча, и некоторые объяснения рейтинга.

Обратите внимание, что модель Близнецов имеет потоковую передачу по умолчанию, поэтому фактический ответ распространяется по нескольким линиям:

10. Переведите приложение в Интернет

Теперь мы будем размещать это приложение, чтобы его можно было получить из Интернета.

Создать функцию Cloud Run

- В консоли Cloud Google перейдите на функции Cloud Run, используя следующую ссылку:

https://console.cloud.google.com/run/create?deploymenttype=function

- В Configure установите имя функции как « розничный двигатель » и выберите регион как « US-Central1 ».

- В URL -адресе конечной точки выберите время выполнения как Java 17 .

- В аутентификации выберите «Разрешить неаутентированные призывы» .

- Разверните контейнер (ы), объемы, сеть, безопасность и нажмите на вкладку «Сеть» .

- Выберите «Подключиться к VPC» для исходящего трафика , а затем нажмите «Использовать бессерновые разъемы VPC Access» .

- В сети нажмите «Добавить новый контакт VPC» . Включите API VPC без сервера , если он еще не включен.

- В разъеме Create, установите имя в

alloydb-test-conn. - Установите регион в

us-central. - Оставьте значение сети в качестве по умолчанию и установите подсеть как пользовательский диапазон IP с диапазоном IP 10.8.0.0 или что -то подобное, что доступно.

- Расширить настройки масштабирования показывать и установить минимальные экземпляры на 2 и максимальные экземпляры до 3.

- Выберите тип экземпляра как f1-micro . Следующее показывает параметры Create Connector:

- Нажмите «Создать», чтобы создать разъем.

- В маршрутизации трафика выберите маршрут весь трафик в VPC .

- Нажмите «Создать» , чтобы создать функцию.

Развернуть приложение

После того, как функция создана, обновите источник и повторно разверните приложение.

- В Cloud Run нажмите на вкладку «Сервис» и нажмите функцию розничной торговли двигателя .

- Нажмите на вкладку «Источник». Оставьте точку записи функции по умолчанию, установленную на «

gcfv2.HelloHttpFunction». - Замените содержимое файла hellohttpfunction.java содержимым из этого файла Java .

- Обновите подробную информацию о AlloyDBJDBCConnector в файле в соответствии с подробностями вашего экземпляра AlloyDB и кластера. Замените

$PROJECT_IDна идентификатор проекта вашего кластера и экземпляра AlloyDB.

- Замените содержимое файла pom.xml на содержимое этого XML -файла.

- Нажмите «Сохранить» и перераспределение, чтобы развернуть функцию.

11. Проверьте приложение для розничной торговли двигателя

После развертывания обновленной облачной функции вы должны увидеть конечную точку в следующем формате:

https://retail-engine-PROJECT_NUMBER.us-central1.run.app

Вы можете проверить его из терминала облачной оболочки, выполнив следующую команду:

gcloud functions call retail-engine --region=us-central1 --gen2 --data '{"search": "I want some kids clothes themed on Disney"}'

В качестве альтернативы, вы можете проверить функцию Cloud Run следующим образом:

PROJECT_ID=$(gcloud config get-value project)

curl -X POST https://retail-engine-$PROJECT_NUMBER.us-central1.run.app \

-H 'Content-Type: application/json' \

-d '{"search":"I want some kids clothes themed on Disney"}' \

| jq .

И результат:

Теперь, когда мы выполняем поиск вектора сходства, используя модель Enterdings на данных AlloyDB, мы можем перейти к созданию приложения, которое использует эти вставки вместе с вашим изображением, и побуждает генерировать предложения по стилю

12. Понять поток рекомендаций наряда

Приложение для рекомендаций наряда представляет собой приложение Sprint Boot, которое настроено для работы с вставками, которые мы создали в приложении AlloyDB в сфере розничной торговли, вместе с Gemini и Imagen для генерации параметров стиля визуального наряда. Это также позволяет добавлять пользовательские подсказки и импровизировать рекомендацию.

Подумайте об этом таким образом, вы загружаете изображение ярко -розового топа в своем гардеробе в это приложение. Когда вы нажимаете Show, на основе подсказки, установленной в коде приложения и встроения в базе данных AlloyDB, приложение генерирует несколько параметров, которые соответствуют исходному изображению. Теперь вы задаетесь вопросом, как предлагаемые варианты могут выглядеть с синим ожерельем, поэтому вы добавляете подсказку на эти линии и нажимаете стиль. Создается конечное изображение, которое объединяет мощную комбинацию исходного изображения и рекомендаций для создания соответствующей одежды.

Чтобы начать создание приложения для рекомендаций одежды, выполните следующие действия:

- В Cloud Run откройте приложение для розничной торговли и обратите внимание на URL вашего приложения. Это репозиторий построений, который мы будем использовать для получения аналогичных предложений.

- В вашей IDE Clone the https://github.com/abiramisukumaran/outfit-recommender/ Repository. Для этого упражнения показанные шаги выполняются в IDE Visual Studio Code.

git clone https://github.com/AbiramiSukumaran/outfit-recommender/

Ниже приведены некоторые из важных файлов в каталоге приложения:

-

src/main: Source Directory, где проживают файлы приложений и HTML: -

HelloWorldApplication.java: основная точка входа для приложения Spring Boot. -

HelloWorldController.java: Spring Boot Rest Controller, который обрабатывает HTTP -запросы, связанные с приложением для рекомендации для одежды. Этот файл обрабатывает и публикует запросы, обрабатывает подсказки пользователей, анализирует изображения, взаимодействует с Enterdings AlloyDB и возвращает окончательный ответ на пользовательский интерфейс. Этот контроллер вызывает класс GenerateImagesample. -

GenerateImageSample.java: содержит класс генерации изображений, который подключается к AI Vertex AI, форматирует пользовательскую подсказку, делает вызовы API в модель Imagen, возвращает прогнозируемое изображение в класс контроллера. -

Resources: этот каталог содержит изображения и HTML -файлы, необходимые для генерации пользовательского интерфейса приложения. -

Pom.xml: определяет зависимости и конфигурации проекта.

- В коде Visual Studio откройте

HelloWorldController.javaи обновите экземпляры идентификатора и местоположения проекта в соответствии с тем, где создается ваш экземпляр AlloyDB.

- Обновите

endpointдо URL-адреса приложения для розничной торговли, который вы размещали ранее.

- Откройте

GenerateImageSample.javaи обновите идентификатор проекта и местоположение в соответствии с тем, где создается ваш экземпляр AlloyDB.

- Сохраните все файлы.

Теперь мы будем развернуть это приложение для выполнения Cloud Run без сервера.

13. Принесите приложение в Интернет

Теперь, когда мы добавили соответствующий проект, местоположение и данные приложения для розничной торговли двигателями в приложение для Spring Boot Recument, мы можем развернуть приложение для Cloud Run.

Мы будем использовать команду gcloud run deploy в терминале Visual Code Studio для развертывания приложения. Для кода Visual Studio вы можете установить расширение Cloud Code Google, чтобы начать использовать GCLOUD CLI.

Чтобы развернуть приложение, выполните следующие действия:

- В своей IDE откройте клонированный каталог и запустите терминал. Для Visual Code Studio щелкните терминал > Новый терминал .

- Следуйте инструкциям в этом документе , чтобы установить Gcloud CLI.

- Если вы используете Visual Code Studio, нажмите «Расширения» , поиск облачного кода Google и установите расширение.

- В вашем терминале IDE аутентифицируйте свою учетную запись Google, выполнив следующую команду:

gcloud auth application-default login

- Установите свой идентификатор проекта в тот же проект, где находится ваш экземпляр AlloyDB.

gcloud config set project PROJECT_ID

- Начните процесс развертывания.

gcloud run deploy

- В

Source code locationнажмите Enter, чтобы выбрать клонированный каталог GitHub. - В

Service nameвведите имя для Сервиса, например, наряд-рекогмер, и нажмите Enter. - В,

Please specify a region, введите место, где размещается ваш экземпляр AlloyDB и приложение для розничной торговли двигателя, например, 32 для US-Central1, и нажмите Enter.

- В

Allow unauthenticated invocations to [..], введите Y и нажмите Enter.

Следующее изображение показывает прогресс развертывания вашего приложения:

14. Проверьте приложение для рекомендации одежды

После того, как приложение будет успешно развернуто в Cloud Run, вы можете увидеть службу в облачной консоли Google следующим образом:

- В Google Cloud Console перейдите в Cloud Run .

- В услугах нажмите на развернутую услугу Erderender . Вы должны увидеть и услугу розничной торговли , и сервис- наряд-рекогментеров следующим образом:

- Нажмите на URL -адрес приложения, чтобы открыть пользовательский интерфейс приложения Recurederder.

The following is a sample URL that you will use:

https://outfit-recommender-22905290964.us-central1.run.app/style

Развернутое приложение можно увидеть следующим образом:

Использование приложения

Чтобы начать использовать приложение, выполните следующие действия:

- Нажмите «Загрузить» и загрузите изображение предмета одежды.

- После того, как изображение загружено, щелкните стиль . Приложение использует изображение в качестве подсказки и генерирует нижние параметры на основе приложения при приложении для розничной торговли, которое включает в себя встроенные наборы данных для розничной торговли.

Приложение генерирует предложения изображения, а также подсказку, основанную на изображении с рекомендациями по стилю. Например, A white semi-sheer button up blouse with pink floral patterns on it, with balloon sleeves.

- Вы можете передать дополнительные подсказки этой рекомендации с автоматическим стилем. Например,

STYLE RECOMMENDATION: Cute brown skirt on a curly updo. Make it photo realistic. Accessorize with cherry earrings and burgundy plastic case sling bag. - Нажмите «Показать» , чтобы увидеть окончательный стиль.

15. Очистите

Чтобы избежать внесения сборов в вашей учетной записи Google Cloud за ресурсы, используемые в этом посте, выполните следующие действия:

- В консоли Cloud Google перейдите на страницу управления ресурсами .

- В списке проектов выберите проект, который вы хотите удалить, а затем нажмите «Удалить» .

- В диалоговом окне введите идентификатор проекта, а затем нажмите «Выключить» , чтобы удалить проект.

16. Поздравляю

Поздравляем! Вы успешно выполнили поиск сходства, используя AlloyDB, PGVector и Vector Search в сочетании с использованием результата поиска с мощной моделью Imagen для генерации рекомендаций по стилю.

1. Обзор

Представьте себе приложение для моды, которое не только помогает вам найти идеальный наряд, но и дает советы по стилю в реальном времени, все благодаря силе передовой интеграции Genai! В этом выступлении мы рассмотрим, как мы создали такое приложение, используя возможности поиска AlloyDB в сочетании с индексом скана Google, обеспечивая молниеносные поиски для сопоставления нарядов и предоставления мгновенных рекомендаций моды.

Мы также углубимся в то, как индекс Scann AlloyDB оптимизирует сложные запросы для создания персонализированных предложений в стиле. Мы также будем использовать Gemini & Imagen, мощные генеративные модели искусственного интеллекта, чтобы обеспечить творческое вдохновение стиль и даже визуализировать ваш персонализированный внешний вид. Все это приложение построено на без серверов архитектуры, обеспечивая бесшовный и масштабируемый опыт для пользователей.

Задача: предлагая персонализированные предложения по одежде, приложение намерено помогать людям, которые борются с нерешительной модой. Это также помогает избежать усталости от принятия решений от планирования одежды.

Решение: приложение Erderender наряда решает проблему предоставления пользователям интеллектуального, персонализированного и привлекательного модного опыта, демонстрируя возможности технологий AlloyDB, Generative AI и без серверов.

Что вы построите

Как часть этой лаборатории, вы будете:

- Создайте экземпляр AlloyDB и загрузите набор данных электронной коммерции

- Включить PGVector и генеративные расширения модели ИИ в AlloyDB

- Генерировать встроения из описания продукта

- Развернуть решение в функциях без сервера Cloud Run

- Загрузите изображение в Близнецы и генерируйте приглашение описания изображения.

- Сгенерировать результаты поиска на основе подсказок в сочетании с вставками набора данных электронной коммерции.

- Добавьте дополнительные подсказки для настройки приглашения и генерации рекомендаций стиля.

- Развернуть решение в функциях без сервера Cloud Run

Требования

2. Архитектура

Архитектура приложения высокого уровня заключается в следующем:

В следующих разделах подчеркивается контекстуальный поток учебника:

Приглашение :

Наш первый шаг - прогласить данные розничной торговли (инвентаризацию, описания продуктов, взаимодействие с клиентами) в AlloyDB.

Аналитический двигатель:

Мы будем использовать AlloyDB в качестве механизма Analytics для выполнения ниже:

- Извлечение контекста: двигатель анализирует данные, хранящиеся в AlloyDB, чтобы понять отношения между продуктами, категориями, поведением клиентов и т. Д.

- Создание встраивания: встраивание (математические представления текста) генерируются как для запроса пользователя, так и для информации, хранящейся в AlloyDB.

- Векторный поиск: двигатель выполняет поиск сходства, сравнивая запрос, внедряющий встроенные встроенные продукты, обзоры и другие соответствующие данные. Это идентифицирует 25 наиболее актуальных «ближайших соседей».

Рекомендация Близнецов:

Массив байтов изображения передается в модель Близнецов через API вершины AI, а также подсказку с просьбой о текстовом описании верхнего износа вместе с рекомендациями нижней одежды.

AlloyDB Rag и Vector Search:

Описание верхней одежды используется для запроса базы данных. Запрос преобразует текст поиска (рекомендация из модели Gemini для сопоставления нижнего износа) в встраивание и выполняет векторный поиск по вставкам, хранящимся в базе данных, чтобы найти ближайших соседей (соответствующие результаты). Вторжения векторов в базе данных AlloyDB индексируются с использованием индекса скана для лучшего отзыва.

Генерация изображений ответа:

Проверенные ответы структурированы в массив JSON, а весь двигатель упакован в функцию без сервера облачного запуска, которая вызывает у Agent Builder.

Генерация изображений Imagen:

The user's styling prompt, a user-selected recommendation and any personalization requests are combined to prompt Imagen 3 with an existing image. The styling image is generated based on this prompt, using the Vertex AI API.

3. Before you begin

Create a project

- In the Google Cloud Console , on the project selector page, select or create a Google Cloud project .

- Make sure that billing is enabled for your Cloud project. Learn how to check if billing is enabled on a project .

- You'll use Cloud Shell , a command-line environment running in Google Cloud that comes preloaded with bq. Click Activate Cloud Shell (

) at the top of the Google Cloud console.

) at the top of the Google Cloud console. - Once connected to Cloud Shell, verify that you're already authenticated and that the project is set to your project ID using the following command:

gcloud auth list

- Run the following command to confirm that the future gcloud commands will identify your project correctly.

gcloud config list project

- If your project is not set, use the following command to set it explicitly:

gcloud config set project <YOUR_PROJECT_ID>

- Enable the required APIs.

Follow the link to enable APIs.

If you miss enabling any API, you can always enable it during the course of the implementation.

For more information about gcloud commands and usage, refer to the documentation .

4. Database setup

In this lab we'll use AlloyDB as the database to store the retail ecommerce dataset. It uses clusters to store all of the resources, such as databases and logs. Each cluster has a primary instance that provides an access point to the data. Tables are the actual resource that stores data.

Let's create an AlloyDB cluster, instance, and table where the ecommerce dataset will be loaded.

Create a cluster and instance

- In the Google Cloud Console, search for AlloyDB . An easy way to find most pages in Cloud Console is to search for them using the search bar of the console.

- Click CREATE CLUSTER .

- Create a cluster and instance with the following values:

- cluster id: "

shopping-cluster" - password: "

alloydb" - PostgreSQL 15 compatible

- Region: "

us-central1" - Networking: "

default"

- In Network, when you select the default network, the following option appears. Click SET UP CONNECTION to set up a default network.

- Select Use an automatically allocated IP range and click Continue . After reviewing the information, click CREATE CONNECTION .

Wait for the default network creation to complete.

- In Configure your primary instance, set the Instance ID as "

shopping-instance".

- Click CREATE CLUSTER to complete setting up of the cluster as follows:

5. Data ingestion