1. Overview

Spanner is a fully managed, horizontally scalable, globally distributed database service that is great for both relational and non-relational operational workloads. Beyond its core capabilities, Spanner offers powerful advanced features that enable building intelligent and data-driven applications.

This codelab builds upon the foundational understanding of Spanner and dives into leveraging its advanced integrations to enhance your data processing and analytical capabilities, using an online banking application as a basis.

We will focus on three key advanced features:

- Vertex AI integration: Discover how to seamlessly integrate Spanner with Google Cloud's AI platform, Vertex AI. You will learn how to invoke Vertex AI models directly from within Spanner SQL queries, enabling powerful in-database transformations and predictions, allowing our banking application to automatically categorize transactions for use cases like budget tracking and anomaly detection.

- Full-text search: Learn how to implement full-text search functionality within Spanner. You will explore indexing text data and writing efficient queries to perform keyword-based searches across your operational data, enabling powerful data discovery, such as efficiently finding customers by email address within our banking system.

- BigQuery federated queries: Explore how to leverage Spanner's federated query capabilities to directly query data residing in BigQuery. This allows you to combine Spanner's real-time operational data with BigQuery's analytical datasets for comprehensive insights and reporting without data duplication or complex ETL processes, powering various use cases in our banking application like targeted marketing campaigns by combining real-time customer data with broader historical trends from BigQuery.

What you'll learn

- How to setup a Spanner instance.

- How to create a database and tables.

- How to load data into your Spanner database tables.

- How to call Vertex AI models from Spanner.

- How to query your Spanner database using fuzzy search and full-text search.

- How to perform federated queries against Spanner from BigQuery.

- How to delete your Spanner instance.

What you'll need

2. Setup and requirements

Create a project

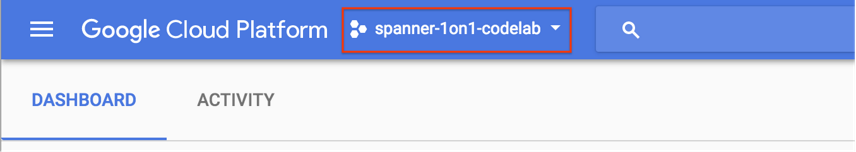

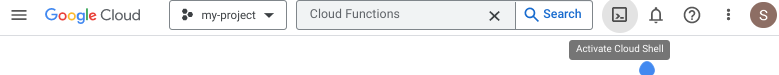

If you already have a Google Cloud project with billing enabled, click on the project selection pull down menu in the upper left of the console:

With a selected project, skip to Enable the required APIs.

If you don't already have a Google Account (Gmail or Google Apps), you must create one. Sign-in to Google Cloud Platform console (console.cloud.google.com) and create a new project.

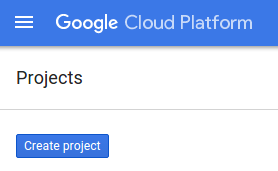

Click the "NEW PROJECT" button in the resulting dialog to create a new project:

If you don't already have a project, you should see a dialog like this to create your first one:

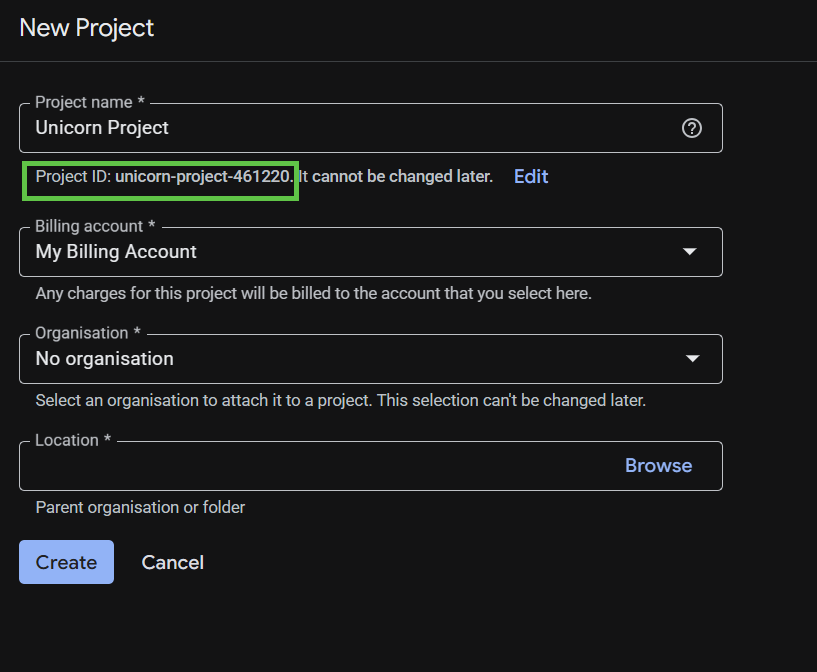

The subsequent project creation dialog lets you enter the details of your new project.

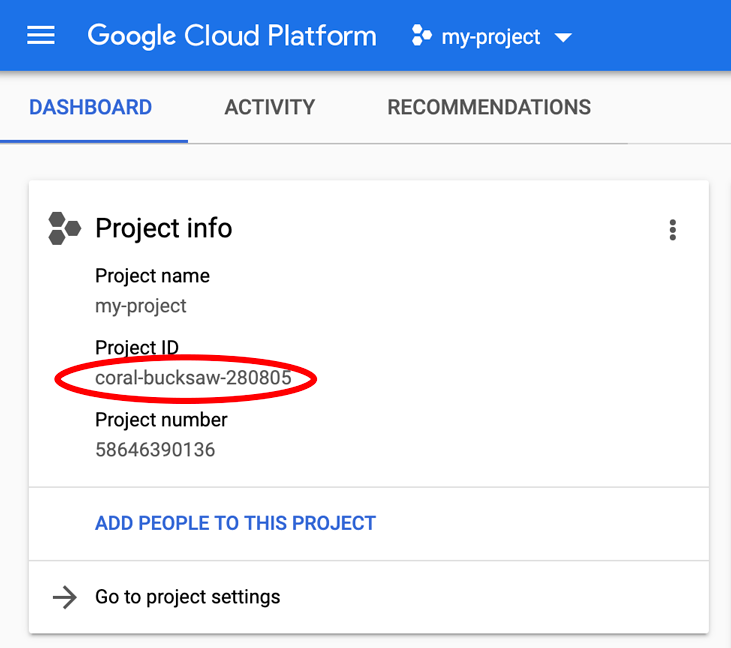

Remember the project ID, which is a unique name across all Google Cloud projects. It will be referred to later in this codelab as PROJECT_ID.

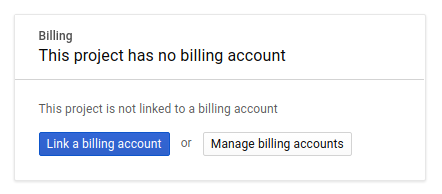

Next, if you haven't already done so, you'll need to enable billing in the Developers Console in order to use Google Cloud resources and enable the Spanner API, Vertex AI API, BigQuery API, and BigQuery Connection API.

Spanner pricing is documented here. Other costs associated with other resources will be documented in their specific pricing pages.

New users of Google Cloud Platform are eligible for a $300 free trial.

Google Cloud Shell Setup

In this codelab we will be using Google Cloud Shell, a command line environment running in the Cloud.

This Debian-based virtual machine is loaded with all the development tools you'll need. It offers a persistent 5 GB home directory and runs in Google Cloud, greatly enhancing network performance and authentication. This means that all you will need for this codelab is a browser.

To activate Cloud Shell from the Cloud Console, simply click Activate Cloud Shell ![]() (it should only take a few moments to provision and connect to the environment).

(it should only take a few moments to provision and connect to the environment).

Once connected to Cloud Shell, you should see that you are already authenticated and that the project is already set to your PROJECT_ID.

gcloud auth list

Expected output:

Credentialed Accounts ACTIVE: * ACCOUNT: <myaccount>@<mydomain>.com

gcloud config list project

Expected output:

[core] project = <PROJECT_ID>

If, for some reason, the project is not set, issue the following command:

gcloud config set project <PROJECT_ID>

Looking for your PROJECT_ID? Check out what ID you used in the setup steps or look it up in the Cloud Console dashboard:

Cloud Shell also sets some environment variables by default, which may be useful as you run future commands.

echo $GOOGLE_CLOUD_PROJECT

Expected output:

<PROJECT_ID>

Enable the required APIs

Enable the Spanner, Vertex AI, and BigQuery APIs for your project:

gcloud services enable spanner.googleapis.com

gcloud services enable aiplatform.googleapis.com

gcloud services enable bigquery.googleapis.com

gcloud services enable bigqueryconnection.googleapis.com

Summary

In this step, you have set up your project if you didn't already have one, activated Cloud Shell, and enabled the required APIs.

Next up

Next, you will set up the Spanner instance.

3. Setup a Spanner instance

Create the Spanner instance

In this step, you will set up a Spanner Instance for the codelab. To do this, open up Cloud Shell and run this command:

export SPANNER_INSTANCE=cloudspanner-onlinebanking

gcloud spanner instances create $SPANNER_INSTANCE \

--config=regional-us-central1 \

--description="Spanner Online Banking" \

--nodes=1 \

--edition=ENTERPRISE \

--default-backup-schedule-type=NONE

Expected output:

Creating instance...done.

Summary

In this step, you have created the Spanner instance.

Next up

Next, you will prepare the initial application and create the database and schema.

4. Create a database and schema

Prepare the initial application

In this step, you will create the database and schema through the code.

First, create a Java application named onlinebanking using Maven:

mvn -B archetype:generate \

-DarchetypeGroupId=org.apache.maven.archetypes \

-DgroupId=com.google.codelabs \

-DartifactId=onlinebanking \

-DjavaCompilerVersion=1.8 \

-DjunitVersion=4.13.2 \

-DarchetypeVersion=1.5

Checkout and copy the data files we will add to the database (see here for the code repository):

git clone https://github.com/GoogleCloudPlatform/cloud-spanner-samples.git

cp -r ./cloud-spanner-samples/banking/data ./onlinebanking

Navigate to the application folder:

cd onlinebanking

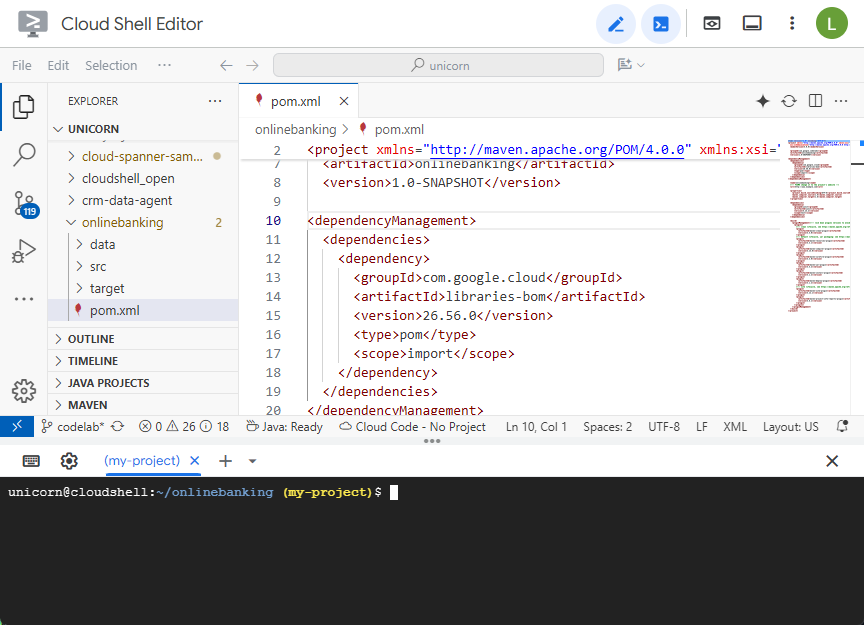

Open the Maven pom.xml file. Add the dependency management section to use Maven BOM to manage the version of Google Cloud libraries:

<dependencyManagement>

<dependencies>

<dependency>

<groupId>com.google.cloud</groupId>

<artifactId>libraries-bom</artifactId>

<version>26.56.0</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

This is what the editor and file will look like:

Make sure the dependencies section includes the libraries the application will use:

<dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-nop</artifactId>

<version>2.0.9</version>

</dependency>

<dependency>

<groupId>com.opencsv</groupId>

<artifactId>opencsv</artifactId>

<version>5.10</version>

</dependency>

<dependency>

<groupId>com.google.cloud</groupId>

<artifactId>google-cloud-spanner</artifactId>

</dependency>

<dependency>

<groupId>com.google.cloud</groupId>

<artifactId>google-cloud-bigquery</artifactId>

</dependency>

<dependency>

<groupId>com.google.cloud</groupId>

<artifactId>google-cloud-bigqueryconnection</artifactId>

</dependency>

</dependencies>

Finally, replace the build plugins so that the application will be packaged into a runnable JAR:

<build>

<plugins>

<plugin>

<artifactId>maven-resources-plugin</artifactId>

<version>3.3.1</version>

<executions>

<execution>

<id>copy-resources</id>

<phase>process-resources</phase>

<goals>

<goal>copy-resources</goal>

</goals>

<configuration>

<outputDirectory>${project.build.directory}/${project.artifactId}-resources</outputDirectory>

<resources>

<resource>

<directory>resources</directory>

<filtering>true</filtering>

</resource>

</resources>

</configuration>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-dependency-plugin</artifactId>

<version>3.8.1</version>

<executions>

<execution>

<id>copy-dependencies</id>

<phase>prepare-package</phase>

<goals>

<goal>copy-dependencies</goal>

</goals>

<configuration>

<outputDirectory>${project.build.directory}/${project.artifactId}-resources/lib</outputDirectory>

<overWriteReleases>false</overWriteReleases>

<overWriteSnapshots>false</overWriteSnapshots>

<overWriteIfNewer>true</overWriteIfNewer>

</configuration>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-jar-plugin</artifactId>

<version>3.4.2</version>

<configuration>

<finalName>${project.artifactId}</finalName>

<outputDirectory>${project.build.directory}</outputDirectory>

<archive>

<index>false</index>

<manifest>

<mainClass>com.google.codelabs.App</mainClass>

<addClasspath>true</addClasspath>

<classpathPrefix>${project.artifactId}-resources/lib/</classpathPrefix>

</manifest>

</archive>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-failsafe-plugin</artifactId>

<version>3.2.5</version>

<executions>

<execution>

<goals>

<goal>integration-test</goal>

</goals>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-surefire-plugin</artifactId>

<version>3.2.5</version>

<configuration>

<useSystemClassLoader>false</useSystemClassLoader>

</configuration>

</plugin>

</plugins>

</build>

Save the changes you made to the pom.xml file by selecting "Save" under the Cloud Shell Editor's "File" menu or by pressing Ctrl+S.

Now that the dependencies are ready, you will add code to the App to create a schema, some indexes (including search) and an AI model connected to a remote endpoint. You will build on these artifacts and add more methods to this class along this codelab.

Open App.java under onlinebanking/src/main/java/com/google/codelabs and replace the contents with the following code:

package com.google.codelabs;

import java.util.Arrays;

import java.util.List;

import java.util.concurrent.ExecutionException;

import com.google.api.gax.longrunning.OperationFuture;

import com.google.cloud.bigquery.BigQuery;

import com.google.cloud.bigquery.BigQueryOptions;

import com.google.cloud.spanner.Database;

import com.google.cloud.spanner.DatabaseAdminClient;

import com.google.cloud.spanner.DatabaseClient;

import com.google.cloud.spanner.DatabaseId;

import com.google.cloud.spanner.Spanner;

import com.google.cloud.spanner.SpannerException;

import com.google.cloud.spanner.SpannerExceptionFactory;

import com.google.cloud.spanner.SpannerOptions;

import com.google.spanner.admin.database.v1.CreateDatabaseMetadata;

public class App {

// Create the Spanner database and schema

public static void create(DatabaseAdminClient dbAdminClient, DatabaseId db,

String location, String model) {

System.out.println("Creating Spanner database...");

List<String> statements = Arrays.asList(

"CREATE TABLE Customers (\n"

+ " CustomerId INT64 NOT NULL,\n"

+ " FirstName STRING(256) NOT NULL,\n"

+ " LastName STRING(256) NOT NULL,\n"

+ " FullName STRING(512) AS (FirstName || ' ' || LastName) STORED,\n"

+ " Email STRING(512) NOT NULL,\n"

+ " EmailTokens TOKENLIST AS\n"

+ " (TOKENIZE_SUBSTRING(Email, ngram_size_min=>2, ngram_size_max=>3,\n"

+ " relative_search_types=>[\"all\"])) HIDDEN,\n"

+ " Address STRING(MAX)\n"

+ ") PRIMARY KEY (CustomerId)",

"CREATE INDEX CustomersByEmail\n"

+ "ON Customers(Email)",

"CREATE SEARCH INDEX CustomersFuzzyEmail\n"

+ "ON Customers(EmailTokens)",

"CREATE TABLE Accounts (\n"

+ " AccountId INT64 NOT NULL,\n"

+ " CustomerId INT64 NOT NULL,\n"

+ " AccountType STRING(256) NOT NULL,\n"

+ " Balance NUMERIC NOT NULL,\n"

+ " OpenDate TIMESTAMP NOT NULL\n"

+ ") PRIMARY KEY (AccountId)",

"CREATE INDEX AccountsByCustomer\n"

+ "ON Accounts (CustomerId)",

"CREATE TABLE TransactionLedger (\n"

+ " TransactionId INT64 NOT NULL,\n"

+ " AccountId INT64 NOT NULL,\n"

+ " TransactionType STRING(256) NOT NULL,\n"

+ " Amount NUMERIC NOT NULL,\n"

+ " Timestamp TIMESTAMP NOT NULL"

+ " OPTIONS(allow_commit_timestamp=true),\n"

+ " Category STRING(256),\n"

+ " Description STRING(MAX),\n"

+ " CategoryTokens TOKENLIST AS (TOKENIZE_FULLTEXT(Category)) HIDDEN,\n"

+ " DescriptionTokens TOKENLIST AS (TOKENIZE_FULLTEXT(Description)) HIDDEN\n"

+ ") PRIMARY KEY (AccountId, TransactionId),\n"

+ "INTERLEAVE IN PARENT Accounts ON DELETE CASCADE",

"CREATE INDEX TransactionLedgerByAccountType\n"

+ "ON TransactionLedger(AccountId, TransactionType)",

"CREATE INDEX TransactionLedgerByCategory\n"

+ "ON TransactionLedger(AccountId, Category)",

"CREATE SEARCH INDEX TransactionLedgerTextSearch\n"

+ "ON TransactionLedger(CategoryTokens, DescriptionTokens)",

"CREATE MODEL TransactionCategoryModel\n"

+ "INPUT (prompt STRING(MAX))\n"

+ "OUTPUT (content STRING(MAX))\n"

+ "REMOTE OPTIONS (\n"

+ " endpoint = '//aiplatform.googleapis.com/projects/" + db.getInstanceId().getProject()

+ "/locations/" + location + "/publishers/google/models/" + model + "',\n"

+ " default_batch_size = 1\n"

+ ")");

OperationFuture<Database, CreateDatabaseMetadata> op = dbAdminClient.createDatabase(

db.getInstanceId().getInstance(),

db.getDatabase(),

statements);

try {

Database dbOperation = op.get();

System.out.println("Created Spanner database [" + dbOperation.getId() + "]");

} catch (ExecutionException e) {

throw (SpannerException) e.getCause();

} catch (InterruptedException e) {

throw SpannerExceptionFactory.propagateInterrupt(e);

}

}

static void printUsageAndExit() {

System.out.println("Online Online Banking Application 1.0.0");

System.out.println("Usage:");

System.out.println(" java -jar target/onlinebanking.jar <command> [command_option(s)]");

System.out.println("");

System.out.println("Examples:");

System.out.println(" java -jar target/onlinebanking.jar create");

System.out.println(" - Create a sample Spanner database and schema in your "

+ "project.\n");

System.exit(1);

}

public static void main(String[] args) {

if (args.length < 1) {

printUsageAndExit();

}

String instanceId = System.getProperty("SPANNER_INSTANCE", System.getenv("SPANNER_INSTANCE"));

String databaseId = System.getProperty("SPANNER_DATABASE", System.getenv("SPANNER_DATABASE"));

String location = System.getenv().getOrDefault("SPANNER_LOCATION", "us-central1");

String model = System.getenv().getOrDefault("SPANNER_MODEL", "gemini-2.0-flash-lite");

if (instanceId == null || databaseId == null) {

System.err.println("Missing one or more required environment variables: SPANNER_INSTANCE or "

+ "SPANNER_DATABASE");

System.exit(1);

}

BigQueryOptions bigqueryOptions = BigQueryOptions.newBuilder().build();

BigQuery bigquery = bigqueryOptions.getService();

SpannerOptions spannerOptions = SpannerOptions.newBuilder().build();

try (Spanner spanner = spannerOptions.getService()) {

String command = args[0];

DatabaseId db = DatabaseId.of(spannerOptions.getProjectId(), instanceId, databaseId);

DatabaseClient dbClient = spanner.getDatabaseClient(db);

DatabaseAdminClient dbAdminClient = spanner.getDatabaseAdminClient();

switch (command) {

case "create":

create(dbAdminClient, db, location, model);

break;

default:

printUsageAndExit();

}

}

}

}

Save the changes to App.java.

Take a look at the different entities that your code is creating and build the application JAR:

mvn package

Expected output:

[INFO] Building jar: /home/your_user/onlinebanking/target/onlinebanking.jar [INFO] ------------------------------------------------------------------------ [INFO] BUILD SUCCESS

Run the application to see the usage information:

java -jar target/onlinebanking.jar

Expected output:

Online Banking Application 1.0.0

Usage:

java -jar target/onlinebanking.jar <command> [command_option(s)]

Examples:

java -jar target/onlinebanking.jar create

- Create a sample Spanner database and schema in your project.

Create the database and schema

Set the required application environment variables:

export SPANNER_INSTANCE=cloudspanner-onlinebanking

export SPANNER_DATABASE=onlinebanking

Create the database and schema by running the create command:

java -jar target/onlinebanking.jar create

Expected output:

Creating Spanner database... Created Spanner database [<DATABASE_RESOURCE_NAME>]

Check the schema in Spanner

In the Spanner console, navigate to your instance and database that was just created.

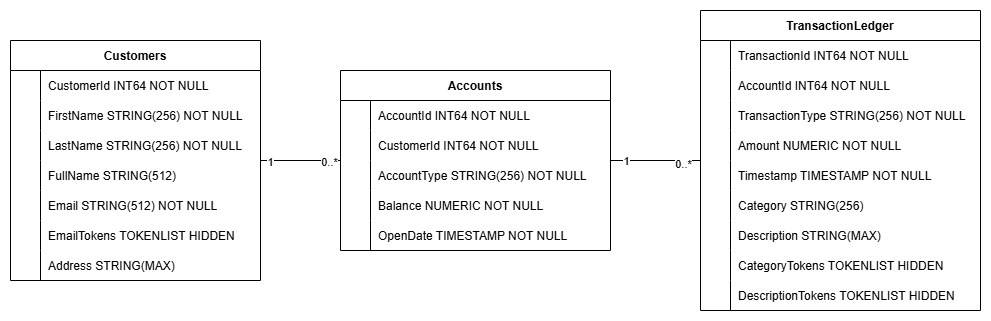

You should see all 3 tables - Accounts, Customers, and TransactionLedger.

This action creates the database schema, including the Accounts, Customers, and TransactionLedger tables, along with secondary indexes for optimized data retrieval, and a Vertex AI model reference.

The TransactionLedger table is interleaved within Accounts to enhance query performance for account-specific transactions through improved data locality.

Secondary indexes (CustomersByEmail, CustomersFuzzyEmail, AccountsByCustomer, TransactionLedgerByAccountType, TransactionLedgerByCategory, TransactionLedgerTextSearch) were implemented to optimize common data access patterns used in this codelab, such as customer lookups by exact and fuzzy email, retrieving accounts by customer, and efficiently querying and searching transaction data.

The TransactionCategoryModel leverages Vertex AI to enable direct SQL calls to an LLM, which is used for dynamic transaction categorization in this codelab.

Summary

In this step, you have created the Spanner database and schema.

Next up

Next, you will load the sample application data.

5. Load data

Now, you will add functionality to load sample data from CSV files into the database.

Open App.java and start by replacing the imports:

package com.google.codelabs;

import java.io.FileReader;

import java.math.BigDecimal;

import java.time.Duration;

import java.time.Instant;

import java.time.temporal.ChronoUnit;

import java.util.ArrayList;

import java.util.Arrays;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.Random;

import java.util.concurrent.ExecutionException;

import com.google.api.gax.longrunning.OperationFuture;

import com.google.cloud.Timestamp;

import com.google.cloud.bigquery.BigQuery;

import com.google.cloud.bigquery.BigQueryOptions;

import com.google.cloud.spanner.Database;

import com.google.cloud.spanner.DatabaseAdminClient;

import com.google.cloud.spanner.DatabaseClient;

import com.google.cloud.spanner.DatabaseId;

import com.google.cloud.spanner.Key;

import com.google.cloud.spanner.Spanner;

import com.google.cloud.spanner.SpannerException;

import com.google.cloud.spanner.SpannerExceptionFactory;

import com.google.cloud.spanner.SpannerOptions;

import com.google.cloud.spanner.Statement;

import com.google.cloud.spanner.Struct;

import com.google.spanner.admin.database.v1.CreateDatabaseMetadata;

import com.opencsv.CSVReader;

Then add the insert methods to the class App:

// Insert customers from CSV

public static void insertCustomers(DatabaseClient dbClient) {

System.out.println("Inserting customers...");

dbClient

.readWriteTransaction()

.run(transaction -> {

int count = 0;

List<Statement> statements = new ArrayList<>();

try (CSVReader reader = new CSVReader(new FileReader("data/customers.csv"))) {

reader.skip(1);

String[] line;

while ((line = reader.readNext()) != null) {

Statement statement = Statement.newBuilder(

"INSERT INTO Customers (CustomerId, FirstName, LastName, Email, Address) "

+ "VALUES (@customerId, @firstName, @lastName, @email, @address)")

.bind("customerId").to(Long.parseLong(line[0]))

.bind("firstName").to(line[1])

.bind("lastName").to(line[2])

.bind("email").to(line[3])

.bind("address").to(line[4])

.build();

statements.add(statement);

count++;

}

transaction.batchUpdate(statements);

System.out.println("Inserted " + count + " customers");

return null;

}

});

}

// Insert accounts from CSV

public static void insertAccounts(DatabaseClient dbClient) {

System.out.println("Inserting accounts...");

dbClient

.readWriteTransaction()

.run(transaction -> {

int count = 0;

List<Statement> statements = new ArrayList<>();

try (CSVReader reader = new CSVReader(new FileReader("data/accounts.csv"))) {

reader.skip(1);

String[] line;

while ((line = reader.readNext()) != null) {

Statement statement = Statement.newBuilder(

"INSERT INTO Accounts (AccountId, CustomerId, AccountType, Balance, OpenDate) "

+ "VALUES (@accountId, @customerId, @accountType, @balance, @openDate)")

.bind("accountId").to(Long.parseLong(line[0]))

.bind("customerId").to(Long.parseLong(line[1]))

.bind("accountType").to(line[2])

.bind("balance").to(new BigDecimal(line[3]))

.bind("openDate").to(line[4])

.build();

statements.add(statement);

count++;

}

transaction.batchUpdate(statements);

System.out.println("Inserted " + count + " accounts");

return null;

}

});

}

// Insert transactions from CSV

public static void insertTransactions(DatabaseClient dbClient) {

System.out.println("Inserting transactions...");

dbClient

.readWriteTransaction()

.run(transaction -> {

int count = 0;

List<Statement> statements = new ArrayList<>();

try (CSVReader reader = new CSVReader(new FileReader("data/transactions.csv"))) {

reader.skip(1);

String[] line;

// Specify timestamps that are within last 30 days

Random random = new Random();

Instant startTime = Instant.now().minus(15, ChronoUnit.DAYS);

Instant currentTimestamp = startTime;

Map<Long, BigDecimal> balanceChanges = new HashMap<>();

while ((line = reader.readNext()) != null) {

long accountId = Long.parseLong(line[1]);

String transactionType = line[2];

BigDecimal amount = new BigDecimal(line[3]);

int randomMinutes = random.nextInt(60) + 1;

currentTimestamp = currentTimestamp.plus(Duration.ofMinutes(randomMinutes));

Timestamp timestamp = Timestamp.ofTimeSecondsAndNanos(

currentTimestamp.getEpochSecond(), currentTimestamp.getNano());

Statement statement = Statement.newBuilder(

"INSERT INTO TransactionLedger (TransactionId, AccountId, TransactionType, Amount,"

+ "Timestamp, Category, Description) "

+ "VALUES (@transactionId, @accountId, @transactionType, @amount, @timestamp,"

+ "@category, @description)")

.bind("transactionId").to(Long.parseLong(line[0]))

.bind("accountId").to(accountId)

.bind("transactionType").to(transactionType)

.bind("amount").to(amount)

.bind("timestamp").to(timestamp)

.bind("category").to(line[5])

.bind("description").to(line[6])

.build();

statements.add(statement);

// Track balance changes per account

BigDecimal balanceChange = balanceChanges.getOrDefault(accountId,

BigDecimal.ZERO);

if ("Credit".equalsIgnoreCase(transactionType)) {

balanceChanges.put(accountId, balanceChange.add(amount));

} else if ("Debit".equalsIgnoreCase(transactionType)) {

balanceChanges.put(accountId, balanceChange.subtract(amount));

} else {

System.err.println("Unsupported transaction type: " + transactionType);

continue;

}

count++;

}

// Apply final balance updates

for (Map.Entry<Long, BigDecimal> entry : balanceChanges.entrySet()) {

long accountId = entry.getKey();

BigDecimal balanceChange = entry.getValue();

Struct row = transaction.readRow(

"Accounts",

Key.of(accountId),

List.of("Balance"));

if (row != null) {

BigDecimal currentBalance = row.getBigDecimal("Balance");

BigDecimal updatedBalance = currentBalance.add(balanceChange);

Statement statement = Statement.newBuilder(

"UPDATE Accounts SET Balance = @balance WHERE AccountId = @accountId")

.bind("accountId").to(accountId)

.bind("balance").to(updatedBalance)

.build();

statements.add(statement);

}

}

transaction.batchUpdate(statements);

System.out.println("Inserted " + count + " transactions");

}

return null;

});

}

Add another case statement in the main method for insert within switch (command):

case "insert":

String insertType = (args.length >= 2) ? args[1] : "";

if (insertType.equals("customers")) {

insertCustomers(dbClient);

} else if (insertType.equals("accounts")) {

insertAccounts(dbClient);

} else if (insertType.equals("transactions")) {

insertTransactions(dbClient);

} else {

insertCustomers(dbClient);

insertAccounts(dbClient);

insertTransactions(dbClient);

}

break;

Finally, affix how to use insert to the printUsageAndExit method:

System.out.println(" java -jar target/onlinebanking.jar insert");

System.out.println(" - Insert sample Customers, Accounts, and Transactions into the "

+ "database.\n");

Save the changes you made to App.java.

Rebuild the application:

mvn package

Insert the sample data by running the insert command:

java -jar target/onlinebanking.jar insert

Expected output:

Inserting customers... Inserted 100 customers Inserting accounts... Inserted 125 accounts Inserting transactions... Inserted 200 transactions

In the Spanner Console, navigate back to Spanner Studio for your instance and database. Then select the TransactionLedger table, and click "Data" in the sidebar to verify the data was loaded. There should be 200 rows in the table.

Summary

In this step, you inserted the sample data in the database.

Next up

Next, you will leverage Vertex AI integration to automatically categorize banking transactions directly within Spanner SQL.

6. Categorize data with Vertex AI

In this step, you will leverage the power of Vertex AI to automatically categorize your financial transactions directly within Spanner SQL. With Vertex AI you can choose an existing pre-trained model or train and deploy your own. See the available models in the Vertex AI Model Garden.

For this codelab we will use one of the Gemini models, Gemini Flash Lite. This version of Gemini is cost-effective yet can still handle most daily workloads.

Currently, we have a number of financial transactions that we would like to categorize (groceries, transportation, etc) depending on the description. We can do this by registering a model in Spanner then using ML.PREDICT to call the AI model.

In our banking application we may want to categorize transactions to gain deeper insights into customer behavior so we can personalize services, detect anomalies more effectively, or provide the customer with the ability to track their budget month-to-month.

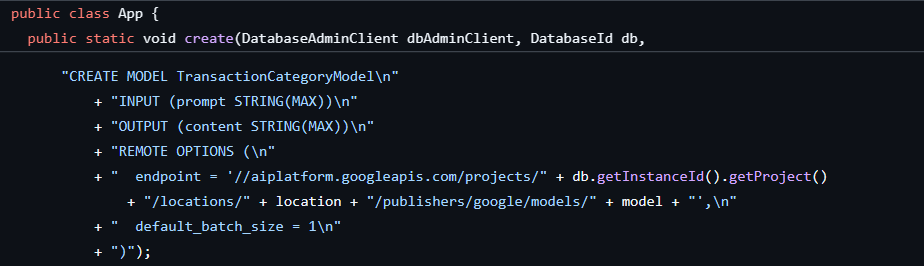

The first step was already done when we created the database and schema, which created a model like this:

Next, we will add a method to the application to call ML.PREDICT.

Open App.java and add the categorize method:

// Use Vertex AI to set the category of transactions

public static void categorize(DatabaseClient dbClient) {

System.out.println("Categorizing transactions...");

try {

// Create a prompt to instruct the LLM how to categorize the transactions

String categories = String.join(", ", Arrays.asList("Entertainment", "Gifts", "Groceries",

"Investment", "Medical", "Movies", "Online Shopping", "Other", "Purchases", "Refund",

"Restaurants", "Salary", "Transfer", "Transportation", "Utilities"));

String prompt = "Categorize the following financial activity into one of these "

+ "categories: " + categories + ". Return Other if the description cannot be mapped to "

+ "one of these categories. Only return the exact category string, no other text or "

+ "punctuation or reasoning. Description: ";

String sql = "UPDATE TransactionLedger SET Category = (\n"

+ " SELECT content FROM ML.PREDICT(MODEL `TransactionCategoryModel`, (\n"

+ " SELECT CONCAT('" + prompt + "', CASE WHEN TRIM(Description) = ''\n"

+ " THEN 'Other' ELSE Description END) AS prompt\n"

+ " ))\n"

+ ") WHERE TRUE";

// Use partitioned update to batch update a large number of rows

dbClient.executePartitionedUpdate(Statement.of(sql));

System.out.println("Completed categorizing transactions");

} catch (SpannerException e) {

throw e;

}

}

Add another case statement in the main method for categorize:

case "categorize":

categorize(dbClient);

break;

Finally, affix how to use categorize to the printUsageAndExit method:

System.out.println(" java -jar target/onlinebanking.jar categorize");

System.out.println(" - Use AI to categorize transactions in the database.\n");

Save the changes you made to App.java.

Rebuild the application:

mvn package

Categorize the transactions in the database by running the categorize command:

java -jar target/onlinebanking.jar categorize

Expected output:

Categorizing transactions... Completed categorizing transactions

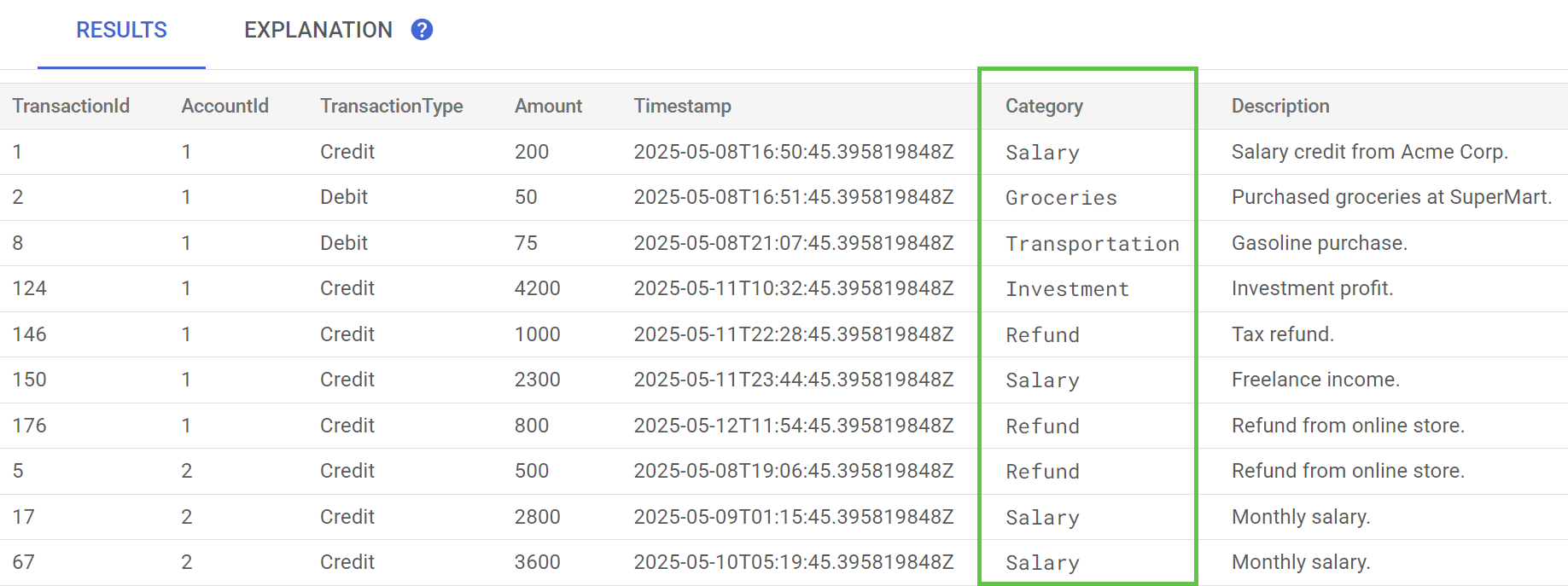

In Spanner Studio, run the Preview Data statement for the TransactionLedger table. The Category column should now be populated for all the rows.

Now that we have categorized the transactions we can use this information for internal or customer-facing queries, in a following step we will look at how to find how much a given customer is spending in a category over the month.

Summary

In this step, you utilized a pre-trained model to perform AI-powered categorization of your data.

Next up

Next, you will make use of tokenization to perform fuzzy and full-text searches.

7. Query using full-text search

Add the query code

Spanner provides many full-text search queries. In this step you will perform an exact-match search, then perform a fuzzy search and a full-text search.

Open App.java and start by replacing the imports:

package com.google.codelabs;

import java.io.FileReader;

import java.math.BigDecimal;

import java.time.Duration;

import java.time.Instant;

import java.time.temporal.ChronoUnit;

import java.util.ArrayList;

import java.util.Arrays;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.Random;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.TimeUnit;

import com.google.api.gax.longrunning.OperationFuture;

import com.google.cloud.Timestamp;

import com.google.cloud.bigquery.BigQuery;

import com.google.cloud.bigquery.BigQueryOptions;

import com.google.cloud.spanner.Database;

import com.google.cloud.spanner.DatabaseAdminClient;

import com.google.cloud.spanner.DatabaseClient;

import com.google.cloud.spanner.DatabaseId;

import com.google.cloud.spanner.Key;

import com.google.cloud.spanner.ReadOnlyTransaction;

import com.google.cloud.spanner.ResultSet;

import com.google.cloud.spanner.Spanner;

import com.google.cloud.spanner.SpannerException;

import com.google.cloud.spanner.SpannerExceptionFactory;

import com.google.cloud.spanner.SpannerOptions;

import com.google.cloud.spanner.Statement;

import com.google.cloud.spanner.Struct;

import com.google.cloud.spanner.TimestampBound;

import com.google.spanner.admin.database.v1.CreateDatabaseMetadata;

import com.opencsv.CSVReader;

Then add the query methods:

// Get current account balance(s) by customer

public static void getBalance(DatabaseClient dbClient, long customerId) {

String query = "SELECT AccountId, Balance\n"

+ "FROM Accounts\n"

+ "WHERE CustomerId = @customerId";

Statement statement = Statement.newBuilder(query)

.bind("customerId").to(customerId)

.build();

// Ignore ongoing transactions, use stale reads as seconds-old data is sufficient

TimestampBound stalenessBound = TimestampBound.ofMaxStaleness(5, TimeUnit.SECONDS);

try (ReadOnlyTransaction transaction = dbClient.singleUseReadOnlyTransaction(stalenessBound);

ResultSet resultSet = transaction.executeQuery(statement);) {

System.out.println("Account balances for customer " + customerId + ":");

while (resultSet.next()) {

System.out.println(" Account " + resultSet.getLong("AccountId") + ": "

+ resultSet.getBigDecimal("Balance"));

}

}

}

// Find customers by email

public static void findCustomers(DatabaseClient dbClient, String email) {

// Query using fuzzy search (ngrams) to allow for spelling mistakes

String query = "SELECT CustomerId, Email\n"

+ "FROM Customers\n"

+ "WHERE SEARCH_NGRAMS(EmailTokens, @email)\n"

+ "ORDER BY SCORE_NGRAMS(EmailTokens, @email) DESC\n"

+ "LIMIT 10";

Statement statement = Statement.newBuilder(query)

.bind("email").to(email)

.build();

try (ReadOnlyTransaction transaction = dbClient.singleUseReadOnlyTransaction();

ResultSet resultSet = transaction.executeQuery(statement)) {

System.out.println("Customer emails matching " + email + " (top 10 matches):");

while (resultSet.next()) {

System.out.println(" Customer " + resultSet.getLong("CustomerId") + ": "

+ resultSet.getString("Email"));

}

}

}

// Get total monthly spending for a customer by category

public static void getSpending(DatabaseClient dbClient, long customerId, String category) {

// Query category using full-text search

String query = "SELECT SUM(Amount) as TotalSpending\n"

+ "FROM TransactionLedger t\n"

+ "JOIN Accounts a\n"

+ " ON t.AccountId = a.AccountId\n"

+ "WHERE t.TransactionType = 'Debit'\n"

+ " AND a.CustomerId = @customerId\n"

+ " AND t.Timestamp >= TIMESTAMP_ADD(CURRENT_TIMESTAMP(), INTERVAL -30 DAY)\n"

+ " AND (SEARCH(t.CategoryTokens, @category) OR SEARCH(t.DescriptionTokens, @category))";

Statement statement = Statement.newBuilder(query)

.bind("customerId").to(customerId)

.bind("category").to(category)

.build();

try (ReadOnlyTransaction transaction = dbClient.singleUseReadOnlyTransaction();

ResultSet resultSet = transaction.executeQuery(statement);) {

System.out.println("Total spending for customer " + customerId + " under category "

+ category + ":");

while (resultSet.next()) {

BigDecimal totalSpending = BigDecimal.ZERO;

if (!resultSet.isNull("TotalSpending")) {

totalSpending = resultSet.getBigDecimal("TotalSpending");

}

System.out.println(" " + totalSpending);

}

}

}

Add another case statement in the main method for query:

case "query":

String queryType = (args.length >= 2) ? args[1] : "";

if (queryType.equals("balance")) {

long customerId = (args.length >= 3) ? Long.parseLong(args[2]) : 1L;

getBalance(dbClient, customerId);

} else if (queryType.equals("email")) {

String email = (args.length >= 3) ? args[2] : "";

findCustomers(dbClient, email);

} else if (queryType.equals("spending")) {

long customerId = (args.length >= 3) ? Long.parseLong(args[2]) : 1L;

String category = (args.length >= 4) ? args[3] : "";

getSpending(dbClient, customerId, category);

} else {

printUsageAndExit();

}

break;

Finally, affix how to use the query commands to the printUsageAndExit method:

System.out.println(" java -jar target/onlinebanking.jar query balance 1");

System.out.println(" - Query customer account balance(s) by customer id.\n");

System.out.println(" java -jar target/onlinebanking.jar query email madi");

System.out.println(" - Find customers by email using fuzzy search.\n");

System.out.println(" java -jar target/onlinebanking.jar query spending 1 groceries");

System.out.println(" - Query customer spending by customer id and category using "

+ "full-text search.\n");

Save the changes you made to App.java.

Rebuild the application:

mvn package

Perform an exact-match search for customer account balances

An exact-match query looks for matching rows that exactly match a term.

To improve performance an index was already added when you created the database and schema:

"CREATE INDEX AccountsByCustomer\n"

+ "ON Accounts (CustomerId)",

The getBalance method implicitly uses this index to find customers that match the provided customerId, and also joins on accounts belonging to that customer.

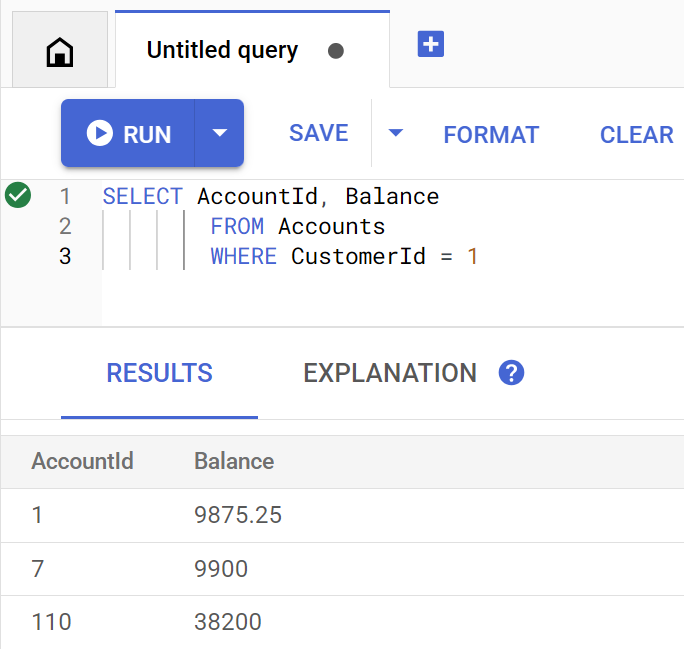

This is what the query looks like when executed directly in Spanner Studio:

List customer 1's account balance(s) by running the command:

java -jar target/onlinebanking.jar query balance 1

Expected output:

Account balances for customer 1: Account 1: 9875.25 Account 7: 9900 Account 110: 38200

There are 100 customers, so you can also query any of the other customer account balances by specifying a different customer ID:

java -jar target/onlinebanking.jar query balance 5

java -jar target/onlinebanking.jar query balance 10

java -jar target/onlinebanking.jar query balance 99

Perform a fuzzy search against customer emails

Fuzzy searches allow for finding approximate matches for search terms, including spelling variations and typos.

An n-gram index was already added when you created the database and schema:

CREATE TABLE Customers (

...

EmailTokens TOKENLIST AS (TOKENIZE_SUBSTRING(Email,

ngram_size_min=>2,

ngram_size_max=>3,

relative_search_types=>["all"])) HIDDEN,

) PRIMARY KEY(CustomerId);

CREATE SEARCH INDEX CustomersFuzzyEmail ON Customers(EmailTokens);

The findCustomers method uses SEARCH_NGRAMS and SCORE_NGRAMS to query against this index to find customers by email. Because the email column has been n-gram tokenized this query can contain spelling mistakes and still return a correct answer. The results are ordered based on the best match.

Find matching customer email addresses that contain madi by running the command:

java -jar target/onlinebanking.jar query email madi

Expected output:

Customer emails matching madi (top 10 matches): Customer 39: madison.perez@example.com Customer 64: mason.gray@example.com Customer 91: mabel.alexander@example.com

This response shows the closest matches that include madi, or a similar string, in ranked order.

This is what the query looks like if executed directly in Spanner Studio:

Fuzzy search can also help with spelling mistakes such as misspellings of emily:

java -jar target/onlinebanking.jar query email emily

java -jar target/onlinebanking.jar query email emliy

java -jar target/onlinebanking.jar query email emilee

Expected output:

Customer emails matching emliy (top 10 matches): Customer 31: emily.lopez@example.com

In each case the expected customer email is returned as the top hit.

Search transactions with full-text search

Spanner's full-text search feature is used to retrieve records based on keywords or phrases. It has the ability to correct for spelling mistakes or search synonyms.

A full-text search index was already added when you created the database and schema:

CREATE TABLE TransactionLedger ( ... CategoryTokens TOKENLIST AS (TOKENIZE_FULLTEXT(Category)) HIDDEN, DescriptionTokens TOKENLIST AS (TOKENIZE_FULLTEXT(Description)) HIDDEN, ) PRIMARY KEY(AccountId, TransactionId), INTERLEAVE IN PARENT Accounts ON DELETE CASCADE; CREATE SEARCH INDEX TransactionLedgerTextSearch ON TransactionLedger(CategoryTokens, DescriptionTokens);

The getSpending method uses the SEARCH full-text search function to match against that index. It looks for all spending (debits) over the last 30 days for the given customer ID.

Get the total spending over the last month for customer 1 in the groceries category by running the command:

java -jar target/onlinebanking.jar query spending 1 groceries

Expected output:

Total spending for customer 1 under category groceries: 50

You can also find spending across other categories (that we categorized in a previous step), or use a different customer ID:

java -jar target/onlinebanking.jar query spending 1 transportation

java -jar target/onlinebanking.jar query spending 1 restaurants

java -jar target/onlinebanking.jar query spending 12 entertainment

Summary

In this step, you performed exact-match queries as well as fuzzy and full-text searches.

Next up

Next, you will integrate Spanner with Google BigQuery to perform federated queries, allowing you to combine your real-time Spanner data with BigQuery data.

8. Run federated queries with BigQuery

Create the BigQuery dataset

In this step, you will bring together BigQuery and Spanner data through the use of federated queries.

To do this, in the Cloud Shell command line, first create a MarketingCampaigns dataset:

bq mk --location=us-central1 MarketingCampaigns

Expected output:

Dataset '<PROJECT_ID>:MarketingCampaigns' successfully created.

And a CustomerSegments table in the dataset:

bq mk --table MarketingCampaigns.CustomerSegments CampaignId:STRING,CampaignName:STRING,CustomerId:INT64

Expected output:

Table '<PROJECT_ID>:MarketingCampaigns.CustomerSegments' successfully created.

Next, make a connection from BigQuery to Spanner:

bq mk --connection \

--connection_type=CLOUD_SPANNER \

--properties="{\"database\": \"projects/$GOOGLE_CLOUD_PROJECT/instances/cloudspanner-onlinebanking/databases/onlinebanking\", \"useParallelism\": true, \"useDataBoost\": true}" \

--location=us-central1 \

spanner-connection

Expected output:

Connection <PROJECT_NUMBER>.us-central1.spanner-connection successfully created

Finally, add some customers to the BigQuery table that can be joined with our Spanner data:

bq query --use_legacy_sql=false '

INSERT INTO MarketingCampaigns.CustomerSegments (CampaignId, CampaignName, CustomerId)

VALUES

("campaign1", "Spring Promotion", 1),

("campaign1", "Spring Promotion", 3),

("campaign1", "Spring Promotion", 5),

("campaign1", "Spring Promotion", 7),

("campaign1", "Spring Promotion", 9),

("campaign1", "Spring Promotion", 11)'

Expected output:

Waiting on bqjob_r76a7ce76c5ec948f_0000019644bda052_1 ... (0s) Current status: DONE Number of affected rows: 6

You can verify the data is available by querying BigQuery:

bq query --use_legacy_sql=false "SELECT * FROM MarketingCampaigns.CustomerSegments"

Expected output:

+------------+------------------+------------+ | CampaignId | CampaignName | CustomerId | +------------+------------------+------------+ | campaign1 | Spring Promotion | 1 | | campaign1 | Spring Promotion | 5 | | campaign1 | Spring Promotion | 7 | | campaign1 | Spring Promotion | 9 | | campaign1 | Spring Promotion | 11 | | campaign1 | Spring Promotion | 3 | +------------+------------------+------------+

This data in BigQuery represents data that has been added through various bank workflows. For example, this may be the list of customers that have recently opened accounts or signed up for a marketing promotion. To determine the list of customers we want to target in our marketing campaign we need to query both this data in BigQuery and also the real-time data in Spanner, and a federated query allows us to do this in a single query.

Run a federated query with BigQuery

Next, we will add a method to the application to call EXTERNAL_QUERY to perform the federated query. This will allow joining and analyzing customer data across BigQuery and Spanner, such as identifying which customers meet the criteria for our marketing campaign based on their recent spending.

Open App.java and start by replacing the imports:

package com.google.codelabs;

import java.io.FileReader;

import java.math.BigDecimal;

import java.time.Duration;

import java.time.Instant;

import java.time.temporal.ChronoUnit;

import java.util.ArrayList;

import java.util.Arrays;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.Random;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.TimeUnit;

import com.google.api.gax.longrunning.OperationFuture;

import com.google.cloud.Timestamp;

import com.google.cloud.bigquery.BigQuery;

import com.google.cloud.bigquery.BigQueryException;

import com.google.cloud.bigquery.BigQueryOptions;

import com.google.cloud.bigquery.connection.v1.ConnectionName;

import com.google.cloud.bigquery.JobException;

import com.google.cloud.bigquery.QueryJobConfiguration;

import com.google.cloud.bigquery.TableResult;

import com.google.cloud.spanner.Database;

import com.google.cloud.spanner.DatabaseAdminClient;

import com.google.cloud.spanner.DatabaseClient;

import com.google.cloud.spanner.DatabaseId;

import com.google.cloud.spanner.Key;

import com.google.cloud.spanner.ReadOnlyTransaction;

import com.google.cloud.spanner.ResultSet;

import com.google.cloud.spanner.Spanner;

import com.google.cloud.spanner.SpannerException;

import com.google.cloud.spanner.SpannerExceptionFactory;

import com.google.cloud.spanner.SpannerOptions;

import com.google.cloud.spanner.Statement;

import com.google.cloud.spanner.Struct;

import com.google.cloud.spanner.TimestampBound;

import com.google.spanner.admin.database.v1.CreateDatabaseMetadata;

import com.opencsv.CSVReader;

Then add the campaign method:

// Get customers for quarterly marketing campaign in BigQuery using Spanner data

public static void campaign(BigQuery bq, DatabaseId db, String location, String campaignId,

int threshold) {

// The BigQuery dataset, table, and Spanner connection must already exist for this to succeed

ConnectionName connection = ConnectionName.of(db.getInstanceId().getProject(), location,

"spanner-connection");

// Use a federated query to bring Spanner data into BigQuery

String bqQuery = "SELECT cs.CampaignName, c.CustomerId, c.FullName, t.TotalSpending\n"

+ "FROM MarketingCampaigns.CustomerSegments cs\n"

+ "JOIN EXTERNAL_QUERY('" + connection.toString() + "',\n"

+ " \"SELECT t.AccountId, SUM(t.Amount) AS TotalSpending"

+ " FROM TransactionLedger t"

+ " WHERE t.Timestamp >= TIMESTAMP_ADD(CURRENT_TIMESTAMP(), INTERVAL -90 DAY)"

+ " GROUP BY t.AccountId"

+ " HAVING SUM(t.Amount) > " + threshold + "\"\n"

+ ") t ON cs.CustomerId = t.AccountId\n"

+ "JOIN EXTERNAL_QUERY('" + connection.toString() + "',\n"

+ " \"SELECT CustomerId, FullName"

+ " FROM Customers\"\n"

+ ") c ON c.CustomerId = cs.CustomerId\n"

+ "WHERE cs.CampaignId = '" + campaignId + "'";

try {

QueryJobConfiguration queryConfig = QueryJobConfiguration.newBuilder(bqQuery).build();

TableResult results = bq.query(queryConfig);

System.out.println("Customers for campaign (" + campaignId + "):");

results.iterateAll().forEach(row -> {

System.out.println(" " + row.get("FullName").getStringValue()

+ " (" + row.get("CustomerId").getStringValue() + ")");

});

} catch (JobException e) {

throw (BigQueryException) e.getCause();

} catch (InterruptedException e) {

throw SpannerExceptionFactory.propagateInterrupt(e);

}

}

Add another case statement in the main method for campaign:

case "campaign":

String campaignId = (args.length >= 2) ? args[1] : "";

int threshold = (args.length >= 3) ? Integer.parseInt(args[2]) : 5000;

campaign(bigquery, db, location, campaignId, threshold);

break;

Finally, affix how to use campaign to the printUsageAndExit method:

System.out.println(" java -jar target/onlinebanking.jar campaign campaign1 5000");

System.out.println(" - Use Federated Queries (BigQuery) to find customers that match a "

+ "marketing campaign by name based on a recent spending threshold.\n");

Save the changes you made to App.java.

Rebuild the application:

mvn package

Run a federated query to determine customers who should be included in the marketing campaign (campaign1) if they have spent at least $5000 over the past 3 months by running the campaign command:

java -jar target/onlinebanking.jar campaign campaign1 5000

Expected output:

Customers for campaign (campaign1): Alice Smith (1) Eve Davis (5) Kelly Thomas (11)

We can now target these customers with exclusive offers or rewards.

Or we can look for a broader number of customers that have achieved a smaller spending threshold over the past 3 months:

java -jar target/onlinebanking.jar campaign campaign1 2500

Expected output:

Customers for campaign (campaign1): Alice Smith (1) Charlie Williams (3) Eve Davis (5) Ivy Taylor (9) Kelly Thomas (11)

Summary

In this step, you successfully executed federated queries from BigQuery that brought in real-time Spanner data.

Next up

Next, you can clean up the resources created for this codelab to avoid charges.

9. Cleanup (optional)

This step is optional. If you want to continue to experiment with your Spanner instance, you do not need to clean it up at this time. However, the project you are using will continue to be charged for the instance. If you have no further need for this instance, then you should delete it at this time to avoid these charges. In addition to the Spanner instance, this codelab also created a BigQuery dataset and connection which should be cleaned up when they are no longer needed.

Delete the Spanner instance:

gcloud spanner instances delete cloudspanner-onlinebanking

Confirm you want to continue (type Y):

Delete instance [cloudspanner-onlinebanking]. Are you sure? Do you want to continue (Y/n)?

Delete the BigQuery connection and dataset:

bq rm --connection --location=us-central1 spanner-connection

bq rm -r MarketingCampaigns

Confirm deletion of the BigQuery dataset (type Y):

rm: remove dataset '<PROJECT_ID>:MarketingCampaigns'? (y/N)

10. Congratulations

🚀 You have created a new Cloud Spanner instance, created an empty database, loaded sample data, performed advanced operations and queries, and (optionally) deleted the Cloud Spanner instance.

What we've covered

- How to setup a Spanner instance.

- How to create a database and tables.

- How to load data into your Spanner database tables.

- How to call Vertex AI models from Spanner.

- How to query your Spanner database using fuzzy search and full-text search.

- How to perform federated queries against Spanner from BigQuery.

- How to delete your Spanner instance.

What's next?

- Learn more about advanced Spanner features, including:

- See the available Spanner client libraries.