1. Omówienie/Wprowadzenie

Chociaż wielowarstwowe aplikacje obejmujące sieć, serwer aplikacji i bazę danych są fundamentem tworzenia stron internetowych i stanowią punkt wyjścia dla wielu witryn, sukces często wiąże się z wyzwaniami dotyczącymi skalowalności, integracji i elastyczności. Jak można przetwarzać dane w czasie rzeczywistym i udostępniać je w wielu kluczowych systemach biznesowych? Te problemy w połączeniu z wymaganiami aplikacji działających na skalę internetową skłoniły nas do powstania rozproszonego systemu komunikacyjnego i wywołały architektoniczny wzorzec używania potoków danych w celu stworzenia odpornych systemów działających w czasie rzeczywistym. W związku z tym zrozumienie tego, jak publikować dane w czasie rzeczywistym w rozproszonym systemie komunikacyjnym oraz jak stworzyć potok danych, to kluczowe umiejętności zarówno dla programistów, jak i architektów.

Co utworzysz

W ramach tego ćwiczenia w programie utworzysz potok danych pogodowych, który zaczyna się od urządzenia z internetem rzeczy (IoT), wykorzystuje kolejkę wiadomości do odbierania i dostarczania danych, wykorzystuje funkcję bezserwerową do przeniesienia danych do hurtowni danych, a następnie utworzysz panel wyświetlający te informacje. W przypadku urządzenia IoT zostanie wykorzystane Raspberry Pi z czujnikiem pogody, a kilka komponentów Google Cloud Platform będzie stanowić potok danych. Opracowanie Raspberry Pi jest korzystne, ale jest opcjonalną częścią tego ćwiczenia z programowania, a strumieniowe przesyłanie danych pogodowych można zastąpić skryptem.

Po ukończeniu tego ćwiczenia z programowania otrzymasz strumień danych zasilający panel, który wyświetla temperaturę, wilgotność, punkt rosy i ciśnienie powietrza.

Czego się nauczysz

- Jak korzystać z Google Pub/Sub

- Jak wdrożyć funkcję w Google Cloud Functions

- Jak korzystać z Google BigQuery

- Jak utworzyć panel w Studiu danych Google

- Jeśli utworzysz czujnik IoT, dowiesz się też, jak korzystać z pakietu Google Cloud SDK i jak zabezpieczać wywołania dostępu zdalnego do Google Cloud Platform.

Czego potrzebujesz

- konto Google Cloud Platform. Nowi użytkownicy Google Cloud Platform mogą skorzystać z bezpłatnego okresu próbnego o wartości 300 USD.

Jeśli zamiast korzystać z przykładowych danych i skryptu chcesz utworzyć część dotyczącą czujnika IoT w ramach tego ćwiczenia w programie, potrzebujesz także poniższego skryptu ( można go zamówić jako kompletny zestaw lub jako pojedyncze części)...

- Raspberry Pi Zero W z zasilaczem, kartą pamięci SD i etui

- Czytnik kart USB

- Koncentrator USB (umożliwiający podłączenie klawiatury i myszy do jedynego portu USB w Raspberry Pi)

- Przewody do płytki prototypowej żeńskie i żeńskie

- Nagłówki GPIO Hammer

- Czujnik BME280

- Lutownica z lutem

Zakładamy też, że użytkownik musi mieć dostęp do monitora komputera lub telewizora z wejściem HDMI, kabla HDMI, klawiatury i myszy.

2. Przygotowanie

Samodzielne konfigurowanie środowiska

Jeśli nie masz jeszcze konta Google (Gmaila lub G Suite), musisz je utworzyć. Niezależnie od tego, czy już masz konto Google, zachęcamy do skorzystania z bezpłatnego okresu próbnego o wartości 300 USD.

Zaloguj się w konsoli Google Cloud Platform ( console.cloud.google.com). Możesz użyć w tym module domyślnego projektu („Mój pierwszy projekt”) lub utworzyć nowy projekt. Jeśli chcesz utworzyć nowy projekt, możesz użyć strony zarządzania zasobami. Identyfikator projektu musi być unikalną nazwą we wszystkich projektach Google Cloud (poniższa nazwa jest już zajęta i nie będzie działać). Zanotuj identyfikator swojego projektu (np. identyfikator projektu _____), ponieważ będzie potrzebny później.

Wykonanie tych ćwiczeń w programie nie powinno kosztować więcej niż kilka złotych, ale może być wyższe, jeśli zdecydujesz się użyć więcej zasobów lub w ogóle je pozostawić. Zapoznaj się z sekcją Czyszczenie na końcu tego ćwiczenia z programowania.

3. Tworzenie tabeli BigQuery

BigQuery to bezserwerowa, wysoce skalowalna i tania hurtownia danych dla firm. Będzie idealną opcją przechowywania danych przesyłanych strumieniowo z urządzeń IoT, a jednocześnie umożliwi panelowi analitycznemu zapytania o informacje.

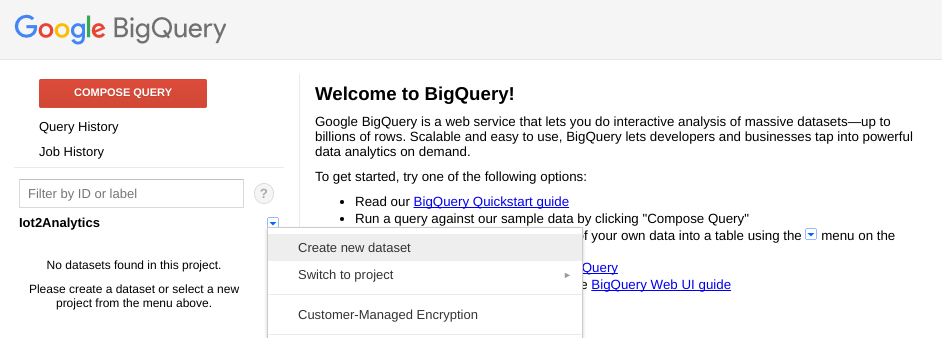

Utwórzmy tabelę, w której będą przechowywane wszystkie dane pogodowe IoT. Wybierz BigQuery z konsoli Cloud. Spowoduje to otwarcie usługi BigQuery w nowym oknie (nie zamykaj oryginalnego okna, ponieważ będzie trzeba otworzyć je ponownie).

Kliknij ikonę strzałki w dół obok nazwy projektu i wybierz „Utwórz nowy zbiór danych”.

Wpisz „WeatherData” W przypadku zbioru danych wybierz lokalizację, w której zostaną zapisane, i kliknij „OK”.

Kliknij przycisk „+”, obok zbioru danych, aby utworzyć nową tabelę

W polu Dane źródłowe wybierz Utwórz pustą tabelę. W polu Nazwa tabeli docelowej wpisz pogodęDataTable. W sekcji Schemat kliknij przycisk Dodaj pole, aż pojawi się łącznie 9 pól. Wypełnij pola w sposób pokazany poniżej i pamiętaj, by dla każdego pola wybrać odpowiedni Typ. Gdy skończysz, kliknij przycisk Utwórz tabelę.

Powinien wyświetlić się taki wynik...

Masz teraz skonfigurowaną hurtownię danych, która będzie otrzymywać dane o pogodzie.

4. Tworzenie tematu Pub/Sub

Cloud Pub/Sub to prosta, niezawodna i skalowalna podstawa do analizy strumieni i systemów obliczeniowych opartych na zdarzeniach. W związku z tym doskonale nadaje się do obsługi przychodzących wiadomości IoT, a następnie umożliwienia ich przetworzenia przez kolejne systemy.

Jeśli nadal jesteś w oknie BigQuery, przełącz się z powrotem na konsolę Cloud. Jeśli konsola Cloud została przez Ciebie zamknięta, otwórz stronę https://console.cloud.google.com

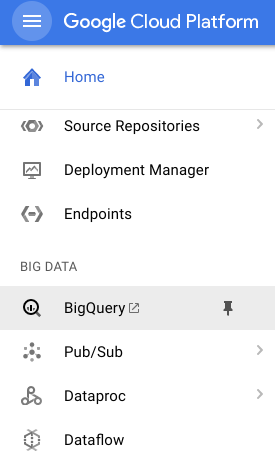

W konsoli Google Cloud wybierz Pub/Sub, a następnie Topics (Tematy).

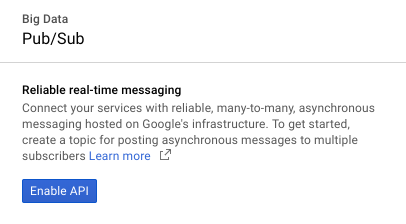

Jeśli pojawi się prośba o włączenie interfejsu API, kliknij przycisk Włącz API.

Kliknij przycisk Utwórz temat .

Wpisz „dane pogodowe” jako nazwę tematu, a następnie kliknij Utwórz.

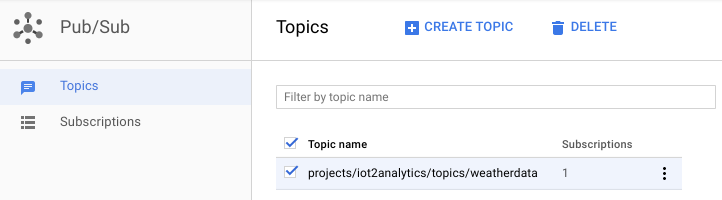

Powinien wyświetlić się nowo utworzony temat.

Masz teraz temat Pub/Sub, w którym możesz publikować wiadomości IoT i umożliwiać innym procesom dostęp do nich.

Bezpieczne publikowanie w temacie

Jeśli planujesz publikować wiadomości w temacie Pub/Sub z zasobów spoza konsoli Google Cloud (np. z czujnika IoT), konieczne będzie ściślejsze kontrolowanie dostępu za pomocą konta usługi i zapewnienie bezpieczeństwa połączenia przez utworzenie certyfikatu zaufania.

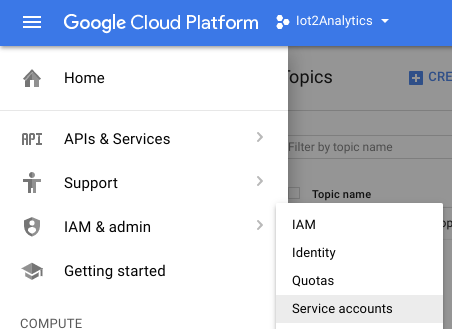

W konsoli Cloud wybierz Administracja Administracja, a następnie Konta usługi

Kliknij przycisk Utwórz konto usługi

Z menu Rola wybierz rolę publikującego Pub/Sub.

Wpisz nazwę konta usługi (iotWeatherPublisher), zaznacz pole wyboru Udostępnij nowy klucz prywatny, upewnij się, że typ klucza jest ustawiony na JSON i kliknij „Utwórz”

Klucz bezpieczeństwa zostanie pobrany automatycznie. Do klucza jest tylko 1 klucz, więc trzeba go nie stracić. Kliknij „Zamknij”.

Powinno być widać, że konto usługi zostało utworzone i powiązany jest z nim identyfikator klucza.

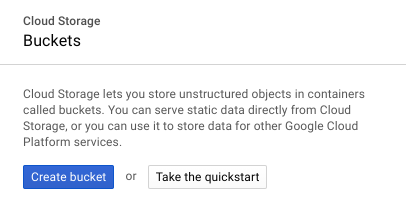

Aby później łatwo uzyskać do niego dostęp, zapiszemy go w Google Cloud Storage. W konsoli Cloud wybierz miejsce na dane, a następnie Przeglądarka.

Kliknij przycisk Utwórz zasobnik

Wybierz nazwę zasobnika na dane (musi być globalnie unikalna we wszystkich usługach Google Cloud) i kliknij przycisk Utwórz

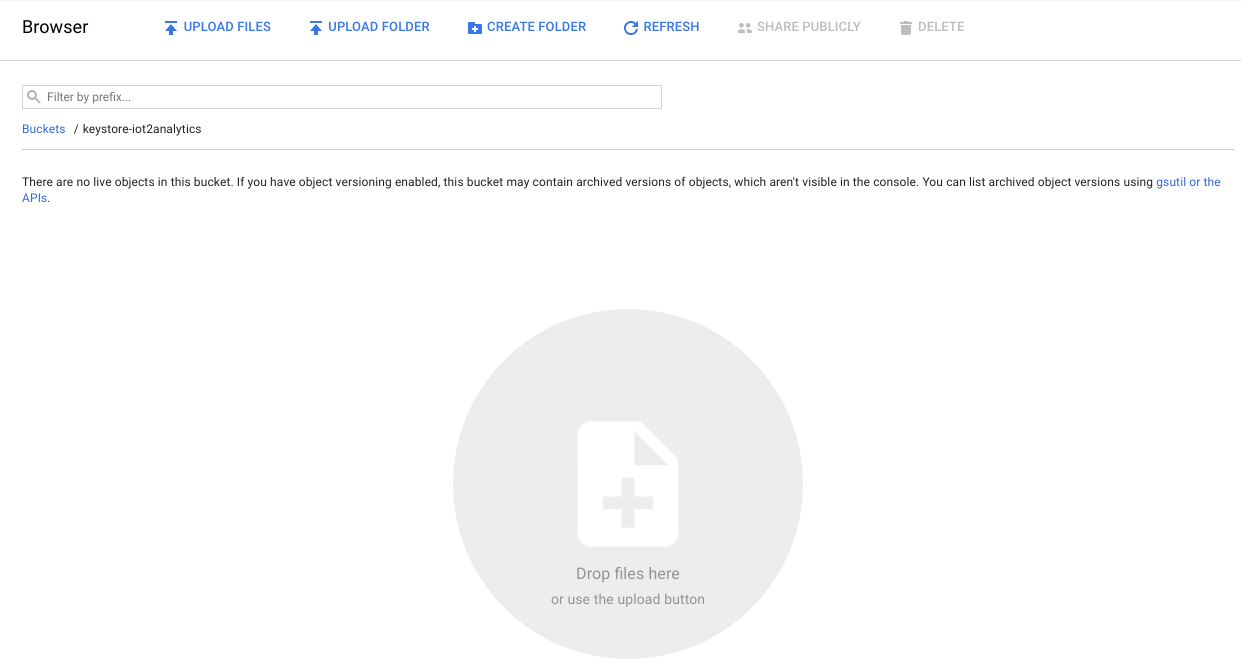

Znajdź klucz bezpieczeństwa, który został automatycznie pobrany, a następnie przeciągnij go i upuść lub prześlij do zasobnika na dane.

Gdy klucz zostanie przesłany, powinien pojawić się w przeglądarce Cloud Storage

Zapisz nazwę zasobnika na dane i nazwę pliku klucza bezpieczeństwa – będzie to potrzebne później.

5. Utwórz funkcję w Cloud Functions

Dzięki usługom w chmurze możliwe jest w pełni bezserwerowe modele przetwarzania danych, w których logika może być uruchamiana na żądanie w odpowiedzi na zdarzenia pochodzące z dowolnego miejsca. Na potrzeby tego modułu funkcja w Cloud Functions będzie uruchamiać się za każdym razem, gdy wiadomość zostanie opublikowana w temacie pogody, odczyta ją i zapisze w BigQuery.

W konsoli Cloud wybierz Cloud Functions

Jeśli wyświetli się komunikat interfejsu API, kliknij przycisk Włącz API

Kliknij przycisk Utwórz funkcję

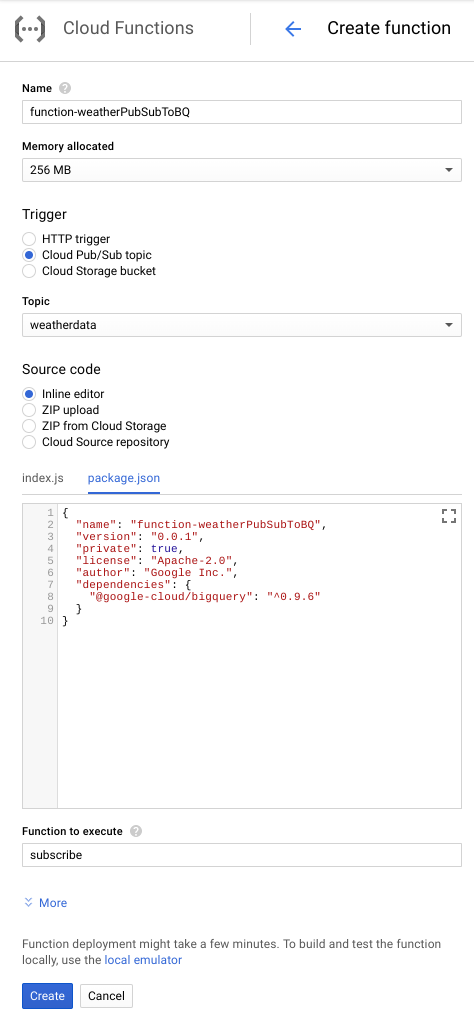

W polu Nazwa wpisz function-WeatherPubSubToBQ. W sekcji Wyzwalaj wybierz temat Cloud Pub/Sub, a w menu Temat wybierz dane pogody. W przypadku kodu źródłowego wybierz edytor wbudowany. Na karcie index.js wklej ten kod w miejscu, od którego należy zacząć. Pamiętaj, aby zmienić stałe wartości projectId, datasetId i tableId, aby pasowały do Twojego środowiska.

/**

* Background Cloud Function to be triggered by PubSub.

*

* @param {object} event The Cloud Functions event.

* @param {function} callback The callback function.

*/

exports.subscribe = function (event, callback) {

const BigQuery = require('@google-cloud/bigquery');

const projectId = "myProject"; //Enter your project ID here

const datasetId = "myDataset"; //Enter your BigQuery dataset name here

const tableId = "myTable"; //Enter your BigQuery table name here -- make sure it is setup correctly

const PubSubMessage = event.data;

// Incoming data is in JSON format

const incomingData = PubSubMessage.data ? Buffer.from(PubSubMessage.data, 'base64').toString() : "{'sensorID':'na','timecollected':'1/1/1970 00:00:00','zipcode':'00000','latitude':'0.0','longitude':'0.0','temperature':'-273','humidity':'-1','dewpoint':'-273','pressure':'0'}";

const jsonData = JSON.parse(incomingData);

var rows = [jsonData];

console.log(`Uploading data: ${JSON.stringify(rows)}`);

// Instantiates a client

const bigquery = BigQuery({

projectId: projectId

});

// Inserts data into a table

bigquery

.dataset(datasetId)

.table(tableId)

.insert(rows)

.then((foundErrors) => {

rows.forEach((row) => console.log('Inserted: ', row));

if (foundErrors && foundErrors.insertErrors != undefined) {

foundErrors.forEach((err) => {

console.log('Error: ', err);

})

}

})

.catch((err) => {

console.error('ERROR:', err);

});

// [END bigquery_insert_stream]

callback();

};

Na karcie package.json wklej ten kod, zastępując umieszczony w nim kod zastępczy.

{

"name": "function-weatherPubSubToBQ",

"version": "0.0.1",

"private": true,

"license": "Apache-2.0",

"author": "Google Inc.",

"dependencies": {

"@google-cloud/bigquery": "^0.9.6"

}

}

Jeśli funkcja do wykonania jest ustawiona na „HelloWorld”, zmień ją na „subscribe”. Z użyciem przycisku Utwórz

Funkcja pokaże, że została wdrożona, po około 2 minutach

Gratulacje! Właśnie udało Ci się połączyć Pub/Sub z BigQuery za pomocą funkcji.

6. Skonfiguruj sprzęt IoT (opcjonalnie)

Składanie Raspberry Pi i czujnika

Jeśli jest więcej niż 7 pin, przytnij nagłówek do mniej niż 7 pinów. Przylutuj styki nagłówka do płytki czujnika.

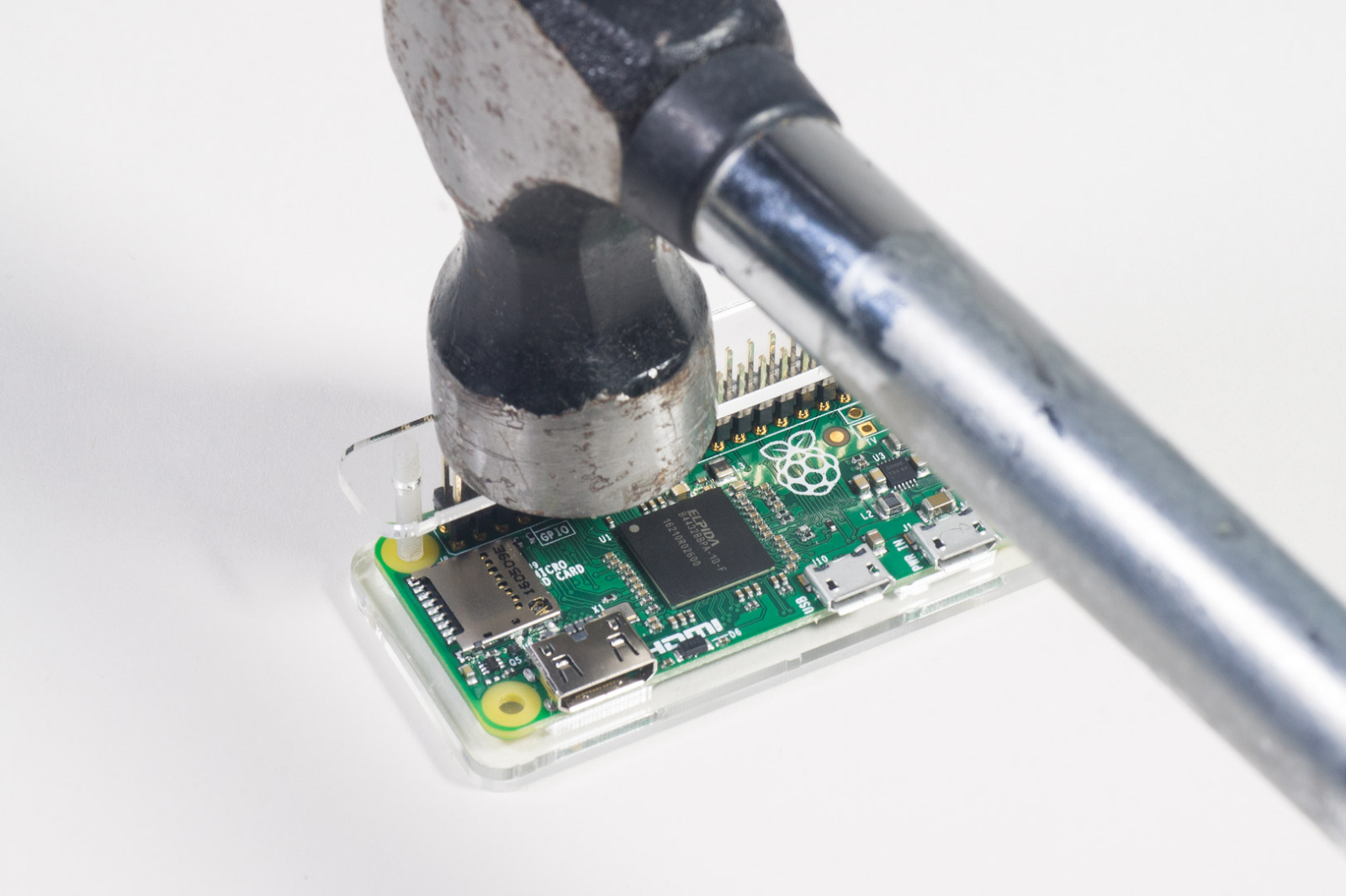

Ostrożnie włóż styki młotka do Raspberry Pi.

Sformatuj kartę SD i zainstaluj instalator NOOBS (New Of Box Software), wykonując czynności opisane tutaj. Włóż kartę SD do Raspberry Pi i włóż ją do etui.

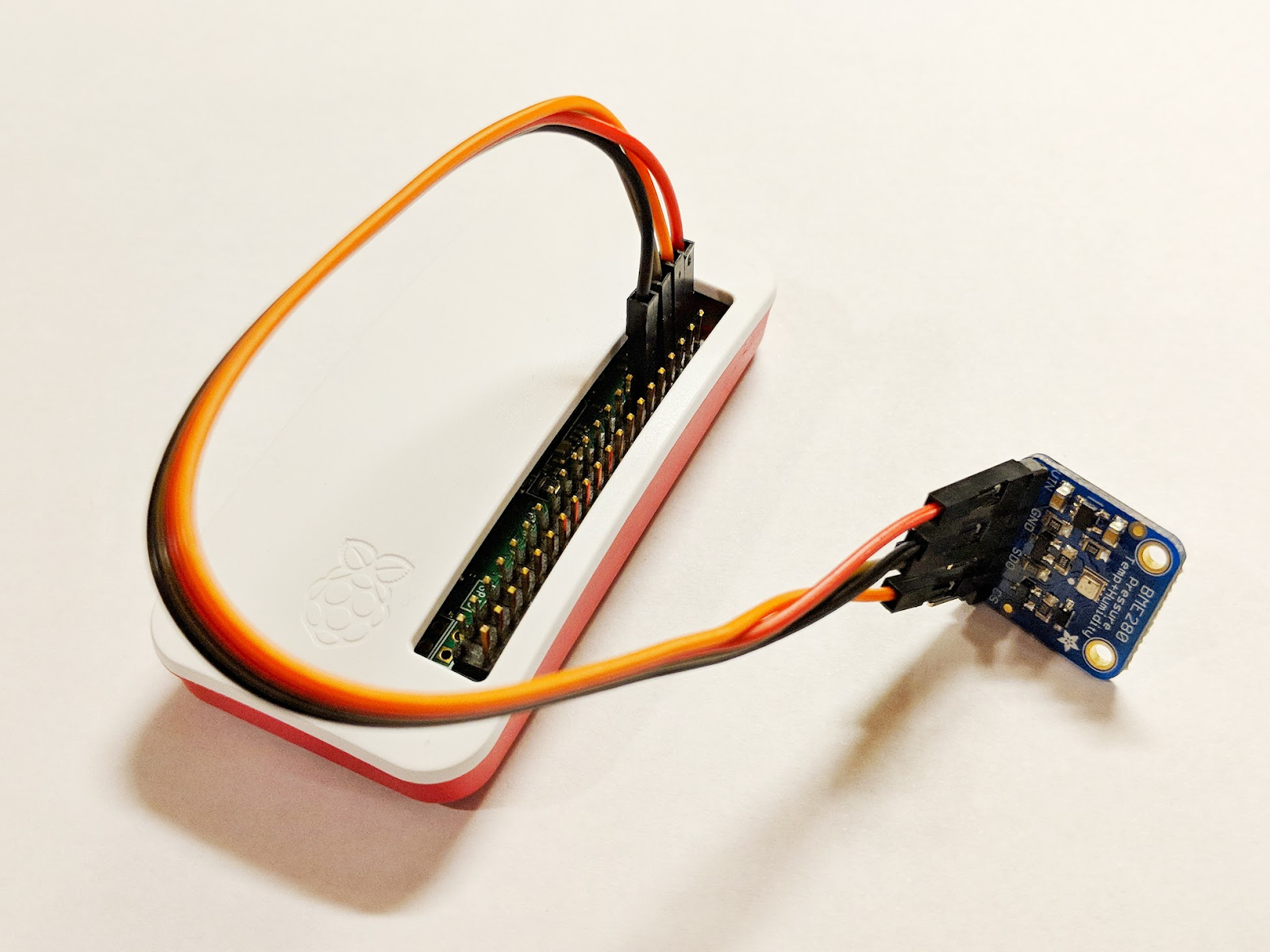

Użyj przewodów płytki prototypowej, aby podłączyć czujnik do Raspberry Pi, zgodnie z poniższym schematem.

Przypnij Raspberry Pi | Połączenie czujnika |

Pin 1 (3,3 V) | Numer VIN |

Kod PIN 3 (CPIO2) | protokół SDI |

Kod PIN 5 (GPIO3) | SCK |

Pin 9 (transport lądowy) | GND |

Podłącz monitor (złącze mini-HDMI), klawiaturę/mysz (z koncentratorem USB), a na koniec podłącz zasilacz.

Konfigurowanie Raspberry Pi i czujnika

Po zakończeniu uruchamiania Raspberry Pi wybierz Raspbian jako odpowiedni system operacyjny, upewnij się, że wybrany język jest poprawny, a następnie kliknij Zainstaluj (ikona dysku twardego w lewej górnej części okna).

Kliknij ikonę Wi-Fi (w prawym górnym rogu ekranu) i wybierz sieć. Jeśli korzystasz z sieci zabezpieczonej, wpisz hasło (klucz wstępnie udostępniony).

Kliknij ikonę maliny (w lewym górnym rogu ekranu), wybierz Preferences (Preferencje), a następnie wybierz Raspberry Pi Configuration (Konfiguracja Raspberry Pi). Na karcie Interfejsy włącz I2C. Na karcie Lokalizacja ustaw język i strefę czasową. Po ustawieniu strefy czasowej zezwól Raspberry Pi na zrestartowanie.

Po ponownym uruchomieniu kliknij ikonę terminala, by otworzyć okno terminala.

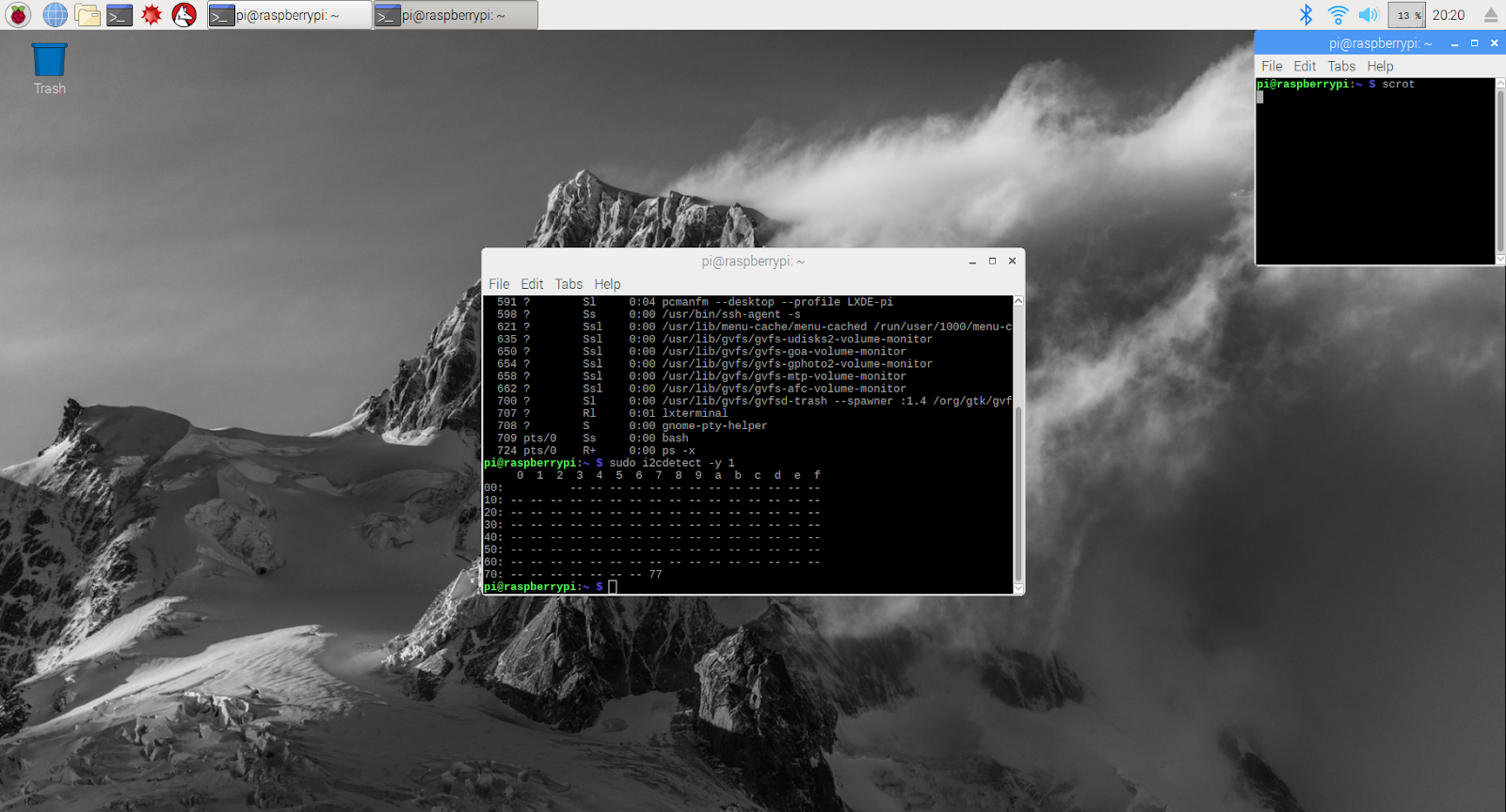

Wpisz następujące polecenie, aby sprawdzić, czy czujnik jest prawidłowo podłączony.

sudo i2cdetect -y 1

Wynik powinien wyglądać tak – upewnij się, że wyświetla się 77.

Instalowanie pakietu SDK Google Cloud

Aby korzystać z narzędzi na platformie Google Cloud, na Raspberry Pi trzeba zainstalować pakiet Google Cloud SDK. Pakiet SDK zawiera narzędzia potrzebne do korzystania z Google Cloud Platform i zarządzania nim. Jest dostępny dla kilku języków programowania.

Otwórz okno terminala na Raspberry Pi, jeśli jeszcze nie zostało otwarte, i ustaw zmienną środowiskową, która będzie dopasowywać wersję pakietu SDK do systemu operacyjnego Raspberry Pi.

export CLOUD_SDK_REPO="cloud-sdk-$(lsb_release -c -s)"

Teraz dodaj lokalizację, w której są przechowywane pakiety Google Cloud SDK, aby narzędzia instalacyjne wiedziały, gdzie szukać pakietu SDK.

echo "deb http://packages.cloud.google.com/apt $CLOUD_SDK_REPO main" | sudo tee -a /etc/apt/sources.list.d/google-cloud-sdk.list

Dodaj klucz publiczny z repozytorium pakietów Google, aby umożliwić Raspberry Pi weryfikację zabezpieczeń i ufność treści podczas instalacji

curl https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add -

Sprawdź, czy oprogramowanie na urządzeniu Raspberry Pi jest aktualne, i zainstaluj podstawowy pakiet SDK Google Cloud

sudo apt-get update && sudo apt-get install google-cloud-sdk

Gdy pojawi się pytanie „Czy chcesz kontynuować?”, naciśnij Enter.

Zainstaluj pakiet tendo za pomocą menedżera pakietów Pythona. Ten pakiet służy do sprawdzania, czy skrypt jest uruchomiony więcej niż raz i jest instalowany dla jego aplikacji w skrypcie pogody.

pip install tendo

Użyj menedżera pakietów Pythona, aby upewnić się, że pakiety Google Cloud PubSub i OAuth2 dla Pythona są zainstalowane i aktualne

sudo pip install --upgrade google-cloud-pubsub

sudo pip install --upgrade oauth2client

Inicjowanie pakietu SDK Google Cloud

Pakiet SDK umożliwia zdalny, uwierzytelniony dostęp do Google Cloud. W tym ćwiczeniu w Codelabs zostanie wykorzystany do uzyskania dostępu do zasobnika na dane, co pozwoli łatwo pobrać klucz bezpieczeństwa na Raspberry Pi.

W wierszu poleceń na Raspberry Pi wpisz

gcloud init --console-only

Gdy pojawi się pytanie „Czy chcesz się zalogować (T/n)?”, naciśnij Enter.

Gdy zobaczysz komunikat „Otwórz w przeglądarce poniższy link:” z długim adresem URL zaczynającym się od https://accounts.google.com/o/oauth?..., najedź kursorem myszy na adres URL, kliknij go prawym przyciskiem myszy i wybierz „Kopiuj URL”. Następnie otwórz przeglądarkę (ikona niebieskiej kuli ziemskiej w lewym górnym rogu ekranu), kliknij pasek adresu prawym przyciskiem myszy i wybierz „Wklej”.

Gdy zobaczysz ekran logowania, wpisz adres e-mail powiązany z Twoim kontem Google Cloud i naciśnij Enter. Następnie wpisz hasło i kliknij przycisk Dalej.

Zobaczysz prośbę, że pakiet SDK Google Cloud chce uzyskać dostęp do Twojego konta Google. Kliknij przycisk Zezwalaj.

Zobaczysz kod weryfikacyjny. Zaznacz go myszą, kliknij prawym przyciskiem myszy i wybierz Kopiuj. Wróć do okna terminala, sprawdź, czy kursor znajduje się po prawej stronie pola „Wpisz kod weryfikacyjny:”, kliknij prawym przyciskiem myszy i wybierz Wklej. Naciśnij Enter.

Jeśli pojawi się prośba o wybranie projektu w chmurze, którego chcesz użyć, wpisz liczbę odpowiadającą nazwie projektu i naciśnij Enter.

Jeśli pojawi się prośba o włączenie interfejsu Compute API, naciśnij przycisk Enter, aby go włączyć. Następnie poprosimy Cię o skonfigurowanie ustawień Google Compute Engine. Naciśnij Enter. Wyświetli się lista potencjalnych regionów/stref. Wybierz jeden w pobliżu, wpisz odpowiednią liczbę i naciśnij Enter.

Za chwilę zobaczysz dodatkowe informacje. Pakiet Google Cloud SDK jest teraz skonfigurowany. Możesz zamknąć okno przeglądarki, ponieważ nie będzie już potrzebny.

Instalowanie oprogramowania czujnika i skrypt pogodowy

Za pomocą wiersza poleceń w Raspberry Pi skopiuj pakiety potrzebne do odczytu informacji z pinów wejściowych/wyjściowych.

git clone https://github.com/adafruit/Adafruit_Python_GPIO

Instalowanie pobranych pakietów

cd Adafruit_Python_GPIO

sudo python setup.py install

cd ..

Skopiuj kod projektu, który włącza czujnik pogody

git clone https://github.com/googlecodelabs/iot-data-pipeline

Skopiuj sterownik czujnika do tego samego katalogu, w którym znajduje się pozostała część pobranego oprogramowania.

cd iot-data-pipeline/third_party/Adafruit_BME280

mv Adafruit_BME280.py ../..

cd ../..

Edytuj skrypt, wpisując...

nano checkWeather.py

Zmień projekt na identyfikator projektu, a temat na nazwę tematu Pub/Sub (zostały one podane w sekcjach „Pierwsze kroki przy konfiguracji” i „Tworzenie tematu Pub/Sub” tego ćwiczenia z programowania).

Zmień wartości sensorID, sensorZipCode, sensorLat i sensorLong na dowolną wartość. Wartości szerokości i długości geograficznej dla konkretnej lokalizacji lub adresu znajdziesz tutaj.

Po wprowadzeniu niezbędnych zmian naciśnij Ctrl+X, aby rozpocząć zamykanie edytora nano. Aby potwierdzić, naciśnij Y.

# constants - change to fit your project and location

SEND_INTERVAL = 10 #seconds

sensor = BME280(t_mode=BME280_OSAMPLE_8, p_mode=BME280_OSAMPLE_8, h_mode=BME280_OSAMPLE_8)

credentials = GoogleCredentials.get_application_default()

project="myProject" #change this to your Google Cloud project id

topic = "myTopic" #change this to your Google Cloud PubSub topic name

sensorID = "s-Googleplex"

sensorZipCode = "94043"

sensorLat = "37.421655"

sensorLong = "-122.085637"

Instalowanie klucza bezpieczeństwa

Skopiuj klucz bezpieczeństwa (z sekcji „Bezpieczne publikowanie w temacie”) do Raspberry Pi.

Jeśli do skopiowania klucza bezpieczeństwa z komputera lokalnego do Raspberry Pi (do katalogu /home/pi) użyto SFTP lub SCP, możesz pominąć następny krok i przejść do eksportu ścieżki.

Jeśli klucz bezpieczeństwa został umieszczony w zasobniku na dane, musisz zapamiętać nazwę zasobnika i nazwę pliku. Skopiuj klucz bezpieczeństwa za pomocą polecenia gsutil. To polecenie może uzyskać dostęp do Google Storage (dlaczego nosi nazwę gsutil i dlaczego ścieżka do pliku zaczyna się od gs://). Pamiętaj, aby w poniższym poleceniu podać nazwę Twojego zasobnika i nazwy pliku.

gsutil cp gs://nameOfYourBucket/yourSecurityKeyFilename.json .

Powinien pojawić się komunikat z informacją, że plik jest kopiowany, a operacja została zakończona.

Z wiersza poleceń w Raspberry Pi wyeksportuj ścieżkę do klucza bezpieczeństwa (zmień nazwę pliku, aby była zgodna z tym, co masz).

export GOOGLE_APPLICATION_CREDENTIALS=/home/pi/iot-data-pipeline/yourSecurityKeyFilename.json

Masz teraz gotowy czujnik pogodowy IoT, który jest gotowy do przesyłania danych do Google Cloud.

7. Uruchamianie potoku danych

Konieczne może być włączenie interfejsu Compute API

Strumieniowanie danych z Raspberry Pi

Jeśli masz skonstruowany czujnik pogodowy Raspberry Pi IoT, uruchom skrypt, który odczytuje dane pogodowe i przesyła je do Google Cloud Pub/Sub. Jeśli nie jesteś w katalogu /home/pi/iot-data-pipeline, przejdź najpierw do tego katalogu

cd /home/pi/iot-data-pipeline

Uruchom skrypt pogodowy

python checkWeather.py

Okno terminala powinno co minutę powtarzać dane pogodowe. Gdy dane są ustawione w trybie ciągłym, możesz przejść do następnej sekcji (Sprawdź, czy dane są w trybie ciągłym).

Symulowany strumień danych

Jeśli czujnik pogody IoT nie został utworzony przez Ciebie, możesz zasymulować strumieniowanie danych, korzystając z publicznego zbioru danych zapisanego w Google Cloud Storage i przesyłając go do istniejącego tematu Pub/Sub. Użyta zostanie usługa Google Dataflow wraz z udostępnionym przez Google szablonem do odczytu z Cloud Storage i publikowania w Pub/Sub.

W ramach tego procesu Dataflow będzie potrzebować tymczasowej lokalizacji pamięci, więc utwórzmy do tego zasobnik na dane.

W konsoli Cloud wybierz miejsce na dane, a następnie Przeglądarka.

Kliknij przycisk Utwórz zasobnik

Wybierz nazwę zasobnika na dane (musi być globalnie unikalna we wszystkich usługach Google Cloud) i kliknij przycisk Utwórz. Zapamiętaj nazwę tego zasobnika na dane, ponieważ wkrótce będzie on potrzebny.

W konsoli Cloud wybierz Dataflow.

Kliknij Utwórz zadanie z szablonu (w górnej części ekranu).

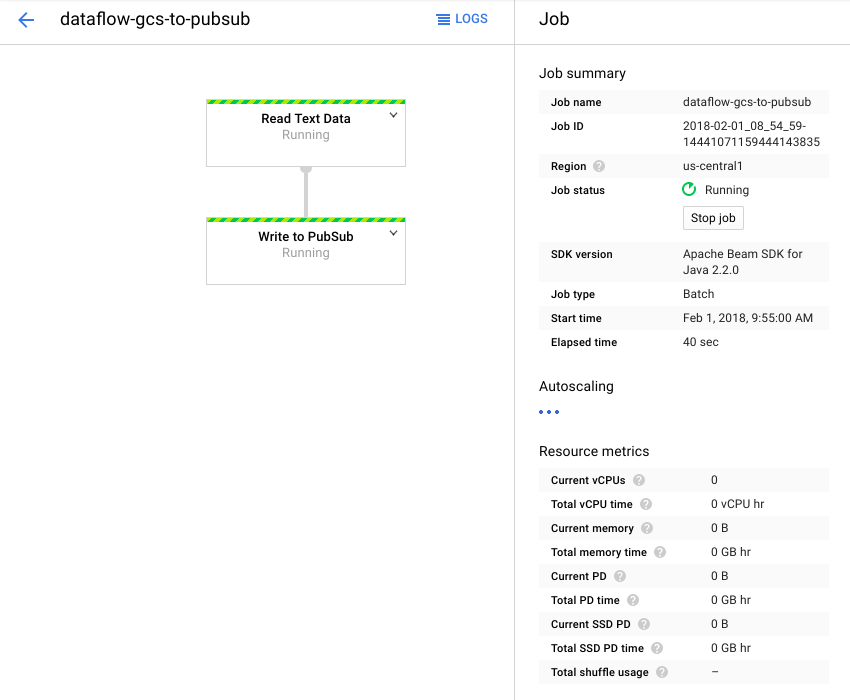

Uzupełnij szczegóły stanowiska w podany niżej sposób, zwracając uwagę na te kwestie:

- Wpisz nazwę zadania dataflow-gcs-to-pubsub

- Region powinien być wybierany automatycznie zgodnie z miejscem hostowania projektu i nie należy go zmieniać.

- Wybierz szablon Cloud Dataflow z tekstem GCS do Cloud Pub/Sub

- W polu Pliki wejściowe w Cloud Storage wpisz gs://codelab-iot-data-pipeline-sampleWeatherdata/*.json (to jest publiczny zbiór danych)

- Dokładna ścieżka w wyjściowym temacie Pub/Sub będzie zależała od nazwy projektu i będzie wyglądać mniej więcej tak: „projekty/nazwaProjektu/tematy/danepogodowe”.

- Jako lokalizację tymczasową ustaw nazwę właśnie utworzonego zasobnika Google Cloud Storage i prefiks nazwy pliku „tmp”. Powinien wyglądać tak: „gs://myStorageBucketName/tmp”.

Po wpisaniu wszystkich informacji (patrz poniżej) kliknij przycisk Uruchom zadanie

Zadanie Dataflow powinno się uruchomić.

Wykonanie zadania Dataflow powinno zająć około minuty.

8. Sprawdź przepływ danych

Logi funkcji w Cloud Functions

Sprawdź, czy funkcja w Cloud Functions jest aktywowana przez Pub/Sub

gcloud beta functions logs read function-weatherPubSubToBQ

Logi powinny wskazywać, że funkcja jest wykonywana, odbiera dane i jest wstawiana do BigQuery

Dane BigQuery

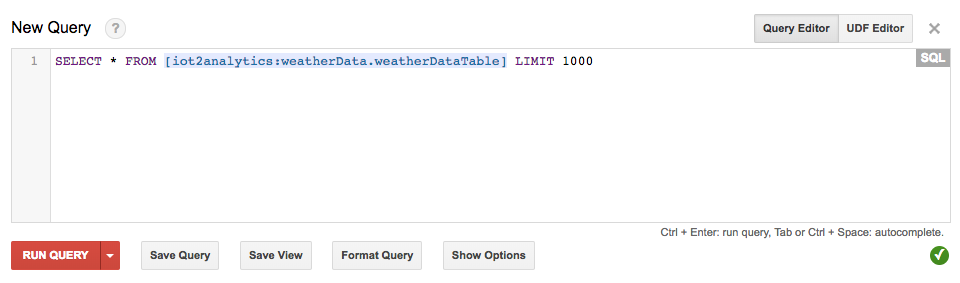

Sprawdź, czy dane są przekazywane do tabeli BigQuery. W konsoli Google Cloud otwórz BigQuery (bigquery.cloud.google.com).

Pod nazwą projektu (po lewej stronie okna) kliknij Zbiór danych (WeatherData), a następnie tabelę (WeatherDataTable), a następnie przycisk Zapytanie do tabeli.

Dodaj do instrukcji SQL gwiazdkę, aby odczytać SELECT * FROM... jak pokazano poniżej, a następnie kliknij przycisk URUCHOM ZAPYTANIE

W razie potrzeby kliknij przycisk Uruchom zapytanie

Jeśli pojawią się wyniki, oznacza to, że przepływ danych jest prawidłowy.

W przypadku przepływu danych możesz teraz utworzyć panel analityczny.

9. Tworzenie panelu Studia danych

Studio danych Google pozwala Ci tworzyć przyjazne raporty i panele informacyjne na podstawie Twoich danych – do tego możesz je dopasować do swoich potrzeb i łatwo udostępniać.

W przeglądarce otwórz stronę https://datastudio.google.com

W sekcji „Tworzenie nowego raportu” kliknij Pusty, a następnie przycisk Rozpocznij

Zaznacz pole wyboru, aby zaakceptować warunki, kliknij przycisk Dalej, wybierz e-maile, które chcesz otrzymywać, i kliknij przycisk Gotowe. W sekcji „Tworzenie nowego raportu” ponownie kliknij Pusty

Kliknij przycisk Utwórz nowe źródło danych

Kliknij BigQuery, potem przycisk Autoryzuj, a potem wybierz konto Google, którego chcesz używać w Studiu danych (powinno to być to samo konto, które było używane podczas ćwiczeń z programowania).

Kliknij przycisk Zezwalaj

Wybierz nazwę projektu, zbiór danych i tabelę. Następnie kliknij przycisk Połącz.

Zmień pola typu w podany niżej sposób (wszystko powinno być liczbą, oprócz wartości timecollected i sensorID). Pamiętaj, że czas zbierania danych jest ustawiony na Data Godzina (a nie tylko Data). Zmień wartości w polach Agregacja zgodnie z poniższym opisem (punkt rosy, temperatura, wilgotność i ciśnienie powinny być wartościami średnimi, a w pozostałych przypadkach mieć wartość „Brak”). Kliknij przycisk Utwórz raport.

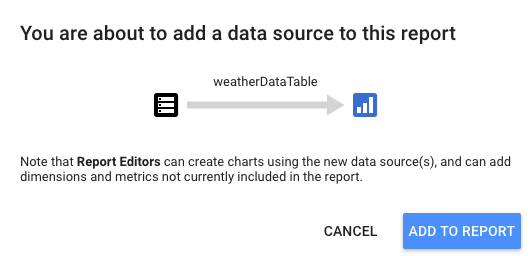

Potwierdź, klikając przycisk Dodaj do raportu

Jeśli pojawi się prośba o wybranie konta Google, zrób to, a następnie kliknij przycisk Zezwól, by Studio danych mogło przechowywać raporty na Dysku Google.

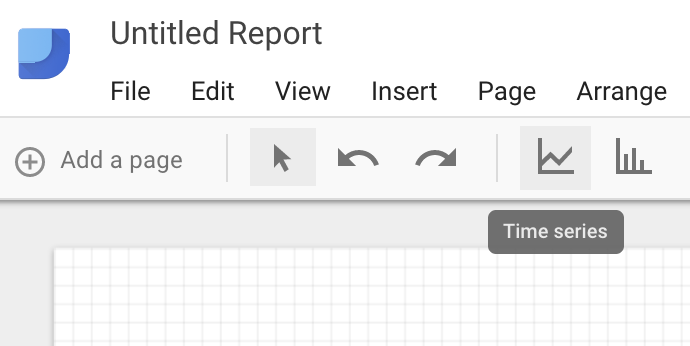

Pojawi się puste pole, w którym możesz utworzyć panel. Z górnego rzędu ikon wybierz Seria czasowa.

Narysuj prostokąt w lewym górnym rogu pustego arkusza. Powinien zajmować około 1⁄4 pustej arkusza.

Po prawej stronie okna wybierz kartę Styl. Zmiana brakujących danych z wartości „wiersz na zero” do opcji „Podziały wiersza”. W sekcji Lewa oś Y usuń wartość 0 z wartości Minimalna wartość na osi Y, aby ją zmienić na (Automatyczna).

Kliknij wykres w arkuszu i skopiuj go i wklej (Ctrl+C/Ctrl+V) trzy razy. Dopasuj wykresy tak, aby każdy z nich miał 1⁄4 jego układu.

Kliknij każdy wykres, a następnie w sekcji Właściwości i dane ciągu czasowego kliknij istniejący wskaźnik (punkt rosy), wybierz inne dane, które będą wyświetlane, dopóki wszystkie cztery odczyty pogody (punkt rosy, temperatura, wilgotność i ciśnienie) nie będą miały własnego wykresu.

Masz teraz podstawowy pulpit nawigacyjny.

10. Gratulacje!

Udało Ci się utworzyć cały potok danych. Dzięki temu wiesz już, jak korzystać z Google Pub/Sub, jak wdrożyć funkcję bezserwerową, jak wykorzystać BigQuery i jak utworzyć panel do statystyk w Studiu danych. Wiesz też, jak bezpiecznie przesyłać dane do Google Cloud Platform przy użyciu pakietu Google Cloud SDK. W końcu zdobywasz praktyczne doświadczenie w zakresie ważnego wzorca architektury, które pozwala obsłużyć duże ilości danych przy zachowaniu dostępności.

Porządkowanie roszczeń

Gdy zakończysz eksperymentowanie z danymi pogodowymi i potokiem analitycznym, możesz usunąć uruchomione zasoby.

Jeśli czujnik IoT został skonstruowany, wyłącz go. Naciśnij Ctrl+C w oknie terminala, aby zatrzymać skrypt, a następnie wpisz następujące polecenie, aby wyłączyć Raspberry Pi

shutdown -h now

Otwórz Cloud Functions, kliknij pole wyboru obok funkcji-WeatherPubSubToBQ, a następnie kliknij Usuń.

Otwórz Pub/Sub, kliknij Temat, zaznacz pole wyboru obok tematu danych o pogodzie, a następnie kliknij Usuń.

Przejdź do obszaru Pamięć, zaznacz pola wyboru obok zasobników na dane, a następnie kliknij Usuń.

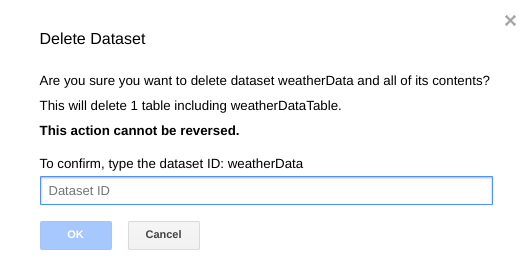

Wejdź na bigquery.cloud.google.com, kliknij strzałkę w dół obok nazwy projektu, strzałkę w dół po prawej stronie zbioru danych pogodowych i kliknij Usuń zbiór danych.

Gdy pojawi się prośba, wpisz identyfikator zbioru danych (WeatherData), aby dokończyć usuwanie danych.