1. מבוא

עדכון אחרון: 28.02.2020

ה-Codelab הזה מדגים דפוס הטמעת נתונים כדי להטמיע ב-BigQuery כמות גדולה של נתוני בריאות בפורמט CSV. בשיעור ה-Lab הזה נשתמש בצינור עיבוד הנתונים ב-Cloud Data fusion באצווה. נתונים מציאותיים של בדיקות רפואיות נוצרו עבורך והופיעו בשבילך בקטגוריה של Google Cloud Storage (gs://hcls_testing_data_fhir_10_patients/csv/).

בשיעור ה-Lab הזה של הקוד, תלמדו:

- איך מטמיעים נתוני CSV (טעינה מתוזמנת באצווה) מ-GCS ל-BigQuery באמצעות Cloud Data Fusion.

- פיתוח ויזואלי של צינור עיבוד נתונים לשילוב נתונים ב-Cloud Data Fusion לצורך טעינה, טרנספורמציה והתאמה למסכה של נתוני בריאות בכמות גדולה.

מה צריך כדי להריץ את ה-Codelab הזה?

- צריכה להיות לך גישה לפרויקט GCP.

- צריך להיות לך תפקיד 'בעלים' בפרויקט GCP.

- נתוני שירותי בריאות בפורמט CSV, כולל הכותרת.

אם אין לך פרויקט GCP, עליך לפעול לפי השלבים האלה כדי ליצור פרויקט GCP חדש.

נתוני הבריאות בפורמט CSV נטענו מראש לקטגוריה של GCS בכתובת gs://hcls_testing_data_fhir_10_patients/csv/. לכל קובץ CSV של משאב יש מבנה סכימה ייחודי. לדוגמה, הסכימה של Patients.csv שונה מזו של Providers.csv. ניתן למצוא קובצי סכימה שנטענו מראש בכתובת gs://hcls_testing_data_fhir_10_patients/csv_schemas.

אם אתם צריכים מערך נתונים חדש, תמיד אפשר ליצור אותו באמצעות SyntheaTM. לאחר מכן, מעלים אותו ל-GCS במקום להעתיק אותו מהקטגוריה בשלב 'העתקת נתוני קלט'.

2. הגדרת פרויקט ב-GCP

לאתחל את משתני המעטפת בסביבה שלכם

כדי למצוא את PROJECT_ID, ניתן לעיין במאמר זיהוי פרויקטים.

<!-- CODELAB: Initialize shell variables -> <!-- Your current GCP Project ID -> export PROJECT_ID=<PROJECT_ID> <!-- A new GCS Bucket in your current Project - INPUT -> export BUCKET_NAME=<BUCKET_NAME> <!-- A new BQ Dataset ID - OUTPUT -> export DATASET_ID=<DATASET_ID>

יצירת קטגוריה של GCS כדי לאחסן נתוני קלט ויומני שגיאות באמצעות הכלי gsutil.

gsutil mb -l us gs://$BUCKET_NAME

מקבלים גישה למערך הנתונים הסינתטי.

- מכתובת האימייל שמשמשת להתחברות אל Cloud Console, שולחים אימייל לכתובת hcls-solutions-external+subscribe@google.com עם בקשת הצטרפות.

- תקבלו אימייל עם הוראות לאישור הפעולה.

- משתמשים באפשרות של שליחת תשובה לאימייל והצטרפות לקבוצה. אין ללחוץ על הלחצן.

- אחרי שתקבלו את הודעת האישור באימייל, תוכלו להמשיך לשלב הבא ב-Codelab.

מעתיקים את נתוני הקלט.

gsutil -m cp -r gs://hcls_testing_data_fhir_10_patients/csv gs://$BUCKET_NAME

יצירת מערך נתונים ב-BigQuery.

bq mk --location=us --dataset $PROJECT_ID:$DATASET_ID

3. הגדרת סביבת Cloud Data Fusion

כדי להפעיל את Cloud Data Fusion API ולהעניק את ההרשאות הנדרשות, יש לבצע את השלבים הבאים:

מפעילים ממשקי API.

- עוברים אל GCP Console API Library.

- בוחרים את הפרויקט מרשימת הפרויקטים.

- בספריית ה-API, בוחרים את ה-API שרוצים להפעיל. אם אתם צריכים עזרה במציאת ה-API, אפשר להשתמש בשדה החיפוש או במסננים.

- בדף ה-API, לוחצים על ENABLE.

יצירת מכונת Cloud Data Fusion.

- בוחרים את ProjectID במסוף GCP.

- בוחרים באפשרות Data Fusion מהתפריט השמאלי, ולאחר מכן לוחצים על הלחצן CREATE AN INSTANCE במרכז הדף (יצירה ראשונה), או לוחצים על הלחצן CREATE INSTANCE בתפריט העליון (יצירה נוספת).

- מציינים את שם המכונה. בוחרים באפשרות Enterprise.

- לוחצים על הלחצן CREATE (יצירה).

הגדרת הרשאות למכונות.

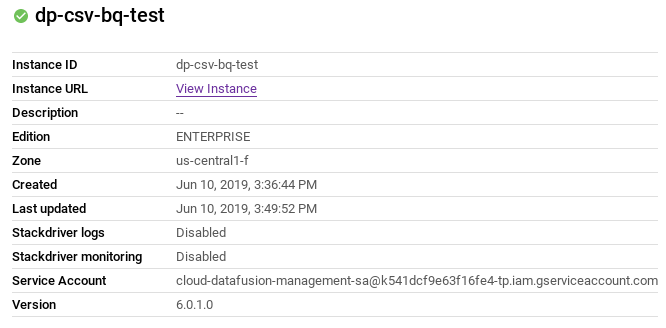

אחרי שיוצרים מכונה, פועלים לפי השלבים הבאים כדי להעניק לחשבון השירות שמשויך להרשאות המכונה בפרויקט:

- כדי לעבור לדף הפרטים של המכונה, לוחצים על השם שלה.

- מעתיקים את חשבון השירות.

- עוברים לדף IAM של הפרויקט.

- בדף ההרשאות של IAM, אנחנו נוסיף עכשיו את חשבון השירות כחבר חדש ונעניק לו את התפקיד סוכן שירות של Cloud Data Fusion API. לוחצים על הלחצן Add (הוספה) ומדביקים את 'חשבון שירות' (service account) בשדה 'חברים חדשים' ובוחרים באפשרות Service Management -> תפקיד 'סוכן שרת' של Cloud Data Fusion API.

- לוחצים על שמירה.

לאחר ביצוע השלבים האלה, אפשר להתחיל להשתמש ב-Cloud Data Fusion על ידי לחיצה על הקישור View Instance בדף המכונות של Cloud Data Fusion או בדף הפרטים של מכונה.

מגדירים את כלל חומת האש.

- מעבר אל קונסולת GCP -> רשת VPC -> כללי חומת אש כדי לבדוק אם כלל ברירת המחדל של allow-ssh קיים או לא.

- אם לא, מוסיפים כלל של חומת אש שמאפשר לכל תעבורת הנתונים הנכנסת (ingress) מסוג SSH לרשת ברירת המחדל.

באמצעות שורת הפקודה:

gcloud beta compute --project={PROJECT_ID} firewall-rules create default-allow-ssh --direction=INGRESS --priority=1000 --network=default --action=ALLOW --rules=tcp:22 --source-ranges=0.0.0.0/0 --enable-logging

שימוש בממשק המשתמש: לוחצים על 'יצירת כלל חומת אש' וממלאים את הפרטים:

4. בניית סכימה לטרנספורמציה

עכשיו, אחרי שהגדרנו את סביבת Cloud Fusion ב-GCP, נבנה סכימה. אנחנו צריכים את הסכימה הזו כדי לשנות את נתוני ה-CSV.

- בחלון Cloud Data Fusion, לוחצים על הקישור View Instance בעמודה Action. המערכת תפנה אתכם לדף אחר. לוחצים על ה-url שסופק כדי לפתוח את מכונת Cloud Data Fusion. הבחירה ללחוץ על 'התחלת הסיור' או 'לא, תודה' בחלון הקופץ 'ברוכים הבאים'.

- הרחבה של 'המבורגר' בתפריט, בוחרים באפשרות Pipeline -> סטודיו

- בקטע Transform (טרנספורמציה) בלוח יישומי הפלאגין שבצד ימין, לוחצים לחיצה כפולה על הצומת של Wrangler, שיופיע בממשק המשתמש של Data Pipelines.

- מצביעים על הצומת של Wrangler ולוחצים על Properties (מאפיינים). לוחצים על הלחצן Wrangle ולאחר מכן בוחרים קובץ מקור בפורמט .csv (לדוגמה, patients.csv), שצריך לכלול את כל שדות הנתונים כדי ליצור את הסכימה הרצויה.

- לוחצים על החץ למטה (טרנספורמציות בעמודה) לצד השם של כל עמודה (לדוגמה, גוף).

- כברירת מחדל, הייבוא הראשוני מניח שיש רק עמודה אחת בקובץ הנתונים. כדי לנתח אותה כקובץ CSV, בוחרים באפשרות ניתוח ← CSV, ואז בוחרים את התו המפריד ובודקים את האפשרות 'הגדרת השורה הראשונה ככותרת' בהתאם לצורך. לוחצים על הלחצן 'אישור'.

- לוחצים על החץ למטה לצד השדה 'גוף' ובוחרים באפשרות 'מחיקת עמודה' כדי להסיר את השדה 'גוף'. בנוסף, אפשר לנסות טרנספורמציות אחרות, כמו הסרת עמודות, שינוי סוג הנתונים בעמודות מסוימות (ברירת המחדל היא 'מחרוזת'), פיצול עמודות, הגדרת שמות של עמודות וכו'.

- העמודות ו"שלבי הטרנספורמציה" הכרטיסיות מציגות את סכימת הפלט ואת המתכון של ה-Wrangler. לוחצים על אישור בפינה השמאלית העליונה. לוחצים על הלחצן 'אימות'. ההודעה הירוקה 'לא נמצאו שגיאות' שמצביע על הצלחה.

- ב-Wrangler Properties, לוחצים על התפריט הנפתח Actions (פעולות) כדי לייצא את הסכימה הרצויה לאחסון המקומי לצורך ייבוא עתידי במקרה הצורך.

- שומרים את מתכון ה-Wrangler לשימוש עתידי.

parse-as-csv :body ',' true drop body

- כדי לסגור את החלון Wrangler Properties, לוחצים על הלחצן X.

5. פיתוח צמתים לצינור עיבוד הנתונים

בקטע הזה ניצור את רכיבי צינור עיבוד הנתונים.

- בפינה השמאלית העליונה בממשק המשתמש של Data Pipelines אתם אמורים לראות שסוג צינור עיבוד הנתונים Data Pipeline – Batch נבחר.

- בחלונית השמאלית יש קטעים שונים בתור 'מסנן', 'מקור', 'טרנספורמציה', 'Analytics', Sink, 'תנאים ופעולות', 'רכיבי Handler של שגיאות' ו'התראות'. בקטעים האלה אפשר לבחור צומת או צמתים לצינור עיבוד הנתונים.

צומת מקור

- בוחרים את הצומת 'מקור'.

- בקטע Source (מקור) בלוח יישומי הפלאגין שבצד ימין, לוחצים לחיצה כפולה על הצומת של Google Cloud Storage, שמופיע בממשק המשתמש של Data Pipelines.

- מעבירים את העכבר מעל צומת המקור של GCS ולוחצים על מאפיינים.

- מזינים את הפרטים בשדות הדרושים. מגדירים את השדות הבאים:

- Label = {any text}

- שם ההפניה = {any text}

- Project ID = זיהוי אוטומטי

- Path = כתובת ה-URL של GCS לקטגוריה בפרויקט הנוכחי. לדוגמה, gs://$BUCKET_NAME/csv/

- עיצוב = טקסט

- שדה נתיב = שם הקובץ

- Path Filename Only (שם הקובץ של הנתיב בלבד) = true

- קריאת קבצים באופן רקורסיבי = true

- הוספת השדה 'filename' לסכימת הפלט של GCS, לוחצים על הלחצן +.

- לקבלת הסבר מפורט, לוחצים על תיעוד. לוחצים על הלחצן 'אימות'. ההודעה הירוקה 'לא נמצאו שגיאות' שמצביע על הצלחה.

- כדי לסגור את מאפייני GCS, לוחצים על הלחצן X.

שינוי הצומת

- בוחרים את הצומת Transform (טרנספורמציה).

- בקטע Transform (טרנספורמציה) בלוח הפלאגין שבצד ימין, לוחצים לחיצה כפולה על הצומת Wrangler, שמופיע בממשק המשתמש של Data Pipelines. מחברים את צומת המקור של GCS לצומת טרנספורמציה של Wrangler.

- מצביעים על הצומת של Wrangler ולוחצים על Properties (מאפיינים).

- לוחצים על התפריט הנפתח פעולות ובוחרים באפשרות ייבוא כדי לייבא סכימה שמורה (לדוגמה: gs://hcls_testing_data_fhir_10_patients/csv_schemas/ schema (Patients).json), ולהדביק את המתכון השמור מהקטע הקודם.

- לחלופין, אפשר להשתמש שוב בצומת Wrangler מהקטע: יצירת סכימה לטרנספורמציה.

- מזינים את הפרטים בשדות הדרושים. מגדירים את השדות הבאים:

- תווית = {any text}

- שם שדה להזנת קלט = {*}

- Precondition = {filename != "patients.csv"} כדי ליצור הבחנה בין כל קובץ קלט (לדוגמה, patients.csv, providers.csv, allergies.csv וכו') מצומת המקור.

- כדי להפעיל את קוד ה-JavaScript שסופק על ידי המשתמש, צריך להוסיף צומת JavaScript, ולבצע טרנספורמציה נוספת ברשומות. ב-Codelab הזה, אנחנו משתמשים בצומת JavaScript כדי לקבל חותמת זמן לכל עדכון רשומה. חיבור צומת הטרנספורמציה של Wrangler לצומת טרנספורמציה של JavaScript. פותחים את Properties (מאפיינים) של JavaScript ומוסיפים את הפונקציה הבאה:

function transform(input, emitter, context) {

input.TIMESTAMP = (new Date()).getTime()*1000;

emitter.emit(input);

}

- מוסיפים את השדה TIMESTAMP לסכימת הפלט (אם הוא לא קיים) על ידי לחיצה על הסימן +. בוחרים את חותמת הזמן בתור סוג הנתונים.

- לקבלת הסבר מפורט, לוחצים על תיעוד. צריך ללחוץ על הלחצן 'אימות' כדי לאמת את כל פרטי הקלט. ירוק "לא נמצאו שגיאות" שמצביע על הצלחה.

- כדי לסגור את החלון של Transform Properties, לוחצים על הלחצן X.

אנונימיזציה והסרת פרטי זיהוי של נתונים

- כדי לבחור עמודות נתונים ספציפיות, לוחצים על החץ למטה בעמודה ומחילים כללי אנונימיזציה בקטע 'אנונימיזציה של הנתונים' לפי הדרישות שלכם (לדוגמה, העמודה 'ת"ז').

- אפשר להוסיף עוד הוראות בחלון מתכון בצומת Wrangler. לדוגמה, שימוש בהוראת הגיבוב (hash) עם אלגוריתם הגיבוב (hashing) לפי התחביר הבא לצורך הסרת פרטי הזיהוי:

hash <column> <algorithm> <encode> <column>: name of the column <algorithm>: Hashing algorithm (i.e. MD5, SHA-1, etc.) <encode>: default is true (hashed digest is encoded as hex with left-padding zeros). To disable hex encoding, set <encode> to false.

צומת של sink

- בוחרים את הצומת של ה-sink.

- בקטע Sink בלוח יישומי הפלאגין שבצד ימין, לוחצים לחיצה כפולה על הצומת של BigQuery, שיופיע בממשק המשתמש של צינור הנתונים.

- מצביעים על צומת ה-sink ב-BigQuery ולוחצים על 'מאפיינים'.

- ממלאים את שדות החובה. מגדירים את השדות הבאים:

- Label = {any text}

- שם ההפניה = {any text}

- Project ID = זיהוי אוטומטי

- מערך הנתונים = מערך הנתונים ב-BigQuery שנמצא בשימוש בפרויקט הנוכחי (למשל, DATASET_ID)

- טבלה = {table name}

- לקבלת הסבר מפורט, לוחצים על תיעוד. צריך ללחוץ על הלחצן 'אימות' כדי לאמת את כל פרטי הקלט. ירוק "לא נמצאו שגיאות" שמצביע על הצלחה.

- כדי לסגור את מאפייני BigQuery, לוחצים על הלחצן X.

6. פיתוח צינור נתונים באצווה

חיבור כל הצמתים בצינור עיבוד נתונים

- יש לגרור חץ של חיבור > בקצה הימני של צומת המקור ולשחרר אותו בקצה השמאלי של צומת היעד.

- לצינור עיבוד נתונים יכולים להיות כמה הסתעפויות שמקבלים קובצי קלט מאותו צומת מקור של GCS.

- נותנים שם לצינור עיבוד הנתונים.

זה הכול. יצרתם עכשיו את צינור עיבוד הנתונים הראשון ב-Batch ואתם יכולים לפרוס ולהפעיל את צינור עיבוד הנתונים.

שליחת התראות של צינורות עיבוד נתונים באימייל (אופציונלי)

כדי להשתמש בתכונה 'שליחת אימייל של התראה בצינור עיבוד נתונים', ההגדרה מחייבת הגדרה של שרת אימייל לשליחת אימייל ממכונה וירטואלית. מידע נוסף זמין בקישור העזר הבא:

שליחת אימייל ממופע מסוים | משאבי עזרה ל-Compute Engine

ב-Codelab הזה, אנחנו מגדירים שירות ממסר דואר באמצעות Mailgun לפי השלבים הבאים:

- פועלים לפי ההוראות בקטע שליחת אימייל באמצעות Mailgun | מסמכי התיעוד של Compute Engine כדי להגדיר חשבון עם Mailgun ולהגדיר את שירות ממסר האימייל. בהמשך מפורטים שינויים נוספים.

- הוספת כל הנמענים כתובות אימייל לרשימת ההיתרים של Mailgun. ניתן למצוא את הרשימה הזו בקטע Mailgun >Sending>Overview (סקירה) בחלונית השמאלית.

לאחר שהנמענים ילחצו על 'אני מסכים/ה' באימייל שנשלח מהכתובת support@mailgun.net, כתובות האימייל שלהם נשמרות ברשימה המורשית לקבל התראות באימייל לגבי צינור עיבוד הנתונים.

- שלב 3 מתוך "לפני שמתחילים" סעיף - צור כלל חומת אש באופן הבא:

- שלב 3 של "הגדרת Mailgun כשרת ממסר דואר עם Postfix" בוחרים באפשרות אתר אינטרנט או אינטרנט עם smarthost, במקום מקומי בלבד לפי ההוראות.

- שלב 4 של "הגדרת Mailgun כשרת ממסר דואר עם Postfix" עורכים את vi /etc/postfix/main.cf כדי להוסיף את הערך 10.128.0.0/9 בסוף mynetworks.

- עורכים את vi /etc/postfix/master.cf כדי לשנות את ברירת המחדל של smtp (25) ליציאה 587.

- בפינה השמאלית העליונה של Data Fusion studio, לוחצים על Configure. לוחצים על התראה על צינור עיבוד נתונים ואז לוחצים על הלחצן + כדי לפתוח את החלון התראות. בוחרים באפשרות SendEmail.

- ממלאים את טופס ההגדרה של אימייל. בוחרים באפשרות השלמה, הצלחה או כשל בתפריט הנפתח Run Condition לכל סוג התראה. אם Include Workflow Token = false, רק המידע משדה ההודעה יישלח. אם הערך של Include Workflow Token = true, יישלח המידע המפורט משדה ההודעה ומ-Workflow Token. צריך להשתמש באותיות קטנות בפרוטוקול. אפשר להשתמש בכל סוג של "זיוף" פרט לכתובת האימייל של החברה שלכם עבור השולח.

7. הגדרה, פריסה, הרצה/תזמון של צינור עיבוד נתונים

- בפינה השמאלית העליונה ב-Data Fusion studio, לוחצים על Configure. בוחרים את Spark for Engine Config. לוחצים על 'שמירה' בחלון 'הגדרה'.

- לוחצים על תצוגה מקדימה כדי לראות תצוגה מקדימה של הנתונים**,** ולוחצים שוב על **תצוגה מקדימה** כדי לחזור לחלון הקודם. אפשר גם **להפעיל** את צינור עיבוד הנתונים במצב Preview (תצוגה מקדימה).

- לוחצים על יומנים כדי לצפות ביומנים.

- לוחצים על Save כדי לשמור את כל השינויים.

- לוחצים על ייבוא כדי לייבא הגדרות שמורות של צינור עיבוד נתונים כשיוצרים צינור עיבוד נתונים חדש.

- לוחצים על Export (ייצוא) כדי לייצא תצורה של צינור עיבוד נתונים.

- לוחצים על Deploy כדי לפרוס את צינור עיבוד הנתונים.

- לאחר הפריסה, לוחצים על Run ומחכים עד שצינור עיבוד הנתונים יסתיים.

- אפשר לשכפל את צינור עיבוד הנתונים על ידי בחירה באפשרות 'שכפול' בלחצן פעולות.

- כדי לייצא את הגדרות צינור עיבוד הנתונים, בוחרים באפשרות 'ייצוא' מתחת ללחצן פעולות.

- כדי להגדיר טריגרים לצינור עיבוד נתונים לפי הצורך, לוחצים על טריגרים נכנסים או על טריגרים יוצאים בקצה השמאלי או הימני של חלון Studio.

- לוחצים על Schedule (תזמון) כדי לתזמן את צינור עיבוד הנתונים כך שיפעל ויטען נתונים מדי פעם.

- בסיכום מוצגים תרשימים של היסטוריית ההרצה, רשומות, יומני שגיאות ואזהרות.

8. אימות

- צינור עיבוד הנתונים Verify הופעל בהצלחה.

- לבדוק אם מערך הנתונים ב-BigQuery כולל את כל הטבלאות.

bq ls $PROJECT_ID:$DATASET_ID

tableId Type Labels Time Partitioning

----------------- ------- -------- -------------------

Allergies TABLE

Careplans TABLE

Conditions TABLE

Encounters TABLE

Imaging_Studies TABLE

Immunizations TABLE

Medications TABLE

Observations TABLE

Organizations TABLE

Patients TABLE

Procedures TABLE

Providers TABLE

- לקבל התראות באימייל (אם הוגדרו).

הצגת התוצאות

כדי לצפות בתוצאות אחרי שצינור עיבוד הנתונים פועל:

- הרצת שאילתות על הטבלה בממשק המשתמש של BigQuery. לממשק המשתמש של BIGQUERY

- מעדכנים את השאילתה שלמטה לשם הפרויקט, למערך הנתונים ולטבלה שלכם.

9. מנקה

כדי להימנע מצבירת חיובים בחשבון Google Cloud Platform על המשאבים שבהם השתמשתם במדריך הזה:

בסיום המדריך, אפשר למחוק את המשאבים שיצרתם ב-GCP כדי שהם לא ינצלו את המכסה שלכם, ולא תחויבו עליהם בעתיד. בסעיפים הבאים מוסבר איך למחוק או להשבית את המשאבים האלו.

מחיקת מערך הנתונים ב-BigQuery

יש לפעול לפי ההוראות הבאות כדי למחוק את מערך הנתונים ב-BigQuery שנוצר במסגרת המדריך הזה.

מחיקת הקטגוריה של GCS

כדי למחוק את הקטגוריה של GCS שיצרתם במסגרת המדריך הזה, פועלים לפי ההוראות הבאות.

מחיקת מכונת Cloud Data Fusion

פועלים לפי ההוראות למחיקת מכונת Cloud Data Fusion.

מחיקת הפרויקט

הדרך הקלה ביותר לבטל את החיוב היא למחוק את הפרויקט שיצרתם בשביל המדריך הזה.

כדי למחוק את הפרויקט:

- נכנסים לדף Projects במסוף GCP. לדף 'פרויקטים'

- ברשימת הפרויקטים, בוחרים את הפרויקט שרוצים למחוק ולוחצים על מחיקה.

- כדי למחוק את הפרויקט, כותבים את מזהה הפרויקט בתיבת הדו-שיח ולוחצים על Shut down.

10. מזל טוב

כל הכבוד! סיימתם בהצלחה את מעבדת הקוד כדי להטמיע נתונים מתחום הטיפול הרפואי ב-BigQuery באמצעות Cloud Data Fusion.

ייבאתם נתוני CSV מ-Google Cloud Storage אל BigQuery.

יצרתם תצוגה חזותית של צינור עיבוד הנתונים לשילוב נתונים לצורך טעינה, טרנספורמציה והתאמה למסכה של נתוני בריאות בכמות גדולה.

עכשיו אתם יודעים מהם השלבים העיקריים שצריך לבצע כדי להתחיל את השימוש בניתוח נתוני בריאות עם BigQuery ב-Google Cloud Platform.