1. 개요

오늘날의 빠르게 변화하는 소매 환경에서 탁월한 고객 서비스를 제공하는 동시에 맞춤형 쇼핑 경험을 제공하는 것이 가장 중요합니다. 고객 질문에 답변하고, 제품 검색을 안내하며, 검색 결과를 조정하도록 설계된 지식 기반 채팅 애플리케이션을 만드는 기술적 여정을 살펴보겠습니다. 이 혁신적인 솔루션은 데이터 저장을 위한 AlloyDB, 문맥 이해를 위한 자체 분석 엔진, 관련성 검증을 위한 Gemini (대규모 언어 모델), 지능형 대화형 어시스턴트를 빠르게 부트스트랩하는 Google의 Agent Builder를 결합합니다.

과제: 오늘날의 소매업체 고객은 즉각적인 답변과 자신만의 선호사항에 맞는 제품 추천을 기대합니다. 기존 검색 방법은 이러한 수준의 맞춤설정을 제공하지 못하는 경우가 많습니다.

해결 방법: Google의 지식 기반 채팅 애플리케이션은 이 문제를 직접적으로 해결합니다. 소매 데이터에서 파생된 풍부한 지식 기반을 활용하여 고객 의도를 파악하고, 지능적으로 응답하며, 매우 관련성 높은 결과를 제공합니다.

빌드할 항목

이 실습 (1부)에서는 다음을 수행합니다.

- AlloyDB 인스턴스 만들기 및 전자상거래 데이터 세트 로드

- AlloyDB에서 pgvector 및 생성형 AI 모델 확장 프로그램 사용 설정

- 제품 설명에서 임베딩 생성

- 사용자 검색 텍스트에 대한 실시간 코사인 유사성 검색 수행

- 서버리스 Cloud Run 함수에서 솔루션 배포

실습의 두 번째 부분에서는 Agent Builder 단계를 다룹니다.

요구사항

2. 아키텍처

데이터 흐름: 데이터가 시스템을 통해 이동하는 방식을 자세히 살펴보겠습니다.

처리:

첫 번째 단계는 소매 데이터 (인벤토리, 제품 설명, 고객 상호작용)를 AlloyDB로 처리하는 것입니다.

애널리틱스 엔진:

AlloyDB를 분석 엔진으로 사용하여 다음을 실행합니다.

- 컨텍스트 추출: 엔진은 AlloyDB에 저장된 데이터를 분석하여 제품, 카테고리, 고객 행동 등의 관계를 파악합니다(해당하는 경우).

- 임베딩 생성: 사용자의 쿼리와 AlloyDB에 저장된 정보에 대해 임베딩 (텍스트의 수학적 표현)이 생성됩니다.

- 벡터 검색: 엔진이 유사성 검색을 실행하여 쿼리 임베딩을 제품 설명, 리뷰, 기타 관련 데이터의 임베딩과 비교합니다. 이렇게 하면 가장 관련성 높은 '가장 가까운 이웃' 25개가 식별됩니다.

Gemini 유효성 검사:

이러한 잠재적 대답은 평가를 위해 Gemini로 전송됩니다. Gemini는 이러한 정보가 사용자와 공유하기에 적합하고 안전한지 판단합니다.

응답 생성:

유효성 검사된 응답은 JSON 배열로 구성되며 전체 엔진은 에이전트 빌더에서 호출되는 서버리스 Cloud Run 함수로 패키징됩니다.

대화형 상호작용:

Agent Builder는 사용자에게 자연어 형식으로 응답을 표시하여 대화의 양방향 진행을 돕습니다. 이 부분은 후속 실습에서 다룹니다.

3. 시작하기 전에

프로젝트 만들기

- Google Cloud 콘솔의 프로젝트 선택기 페이지에서 Google Cloud 프로젝트를 선택하거나 만듭니다.

- Cloud 프로젝트에 결제가 사용 설정되어 있어야 하므로 프로젝트에 결제가 사용 설정되어 있는지 확인하는 방법을 알아보세요 .

- bq가 미리 로드되어 제공되는 Google Cloud에서 실행되는 명령줄 환경인 Cloud Shell을 사용합니다. Google Cloud 콘솔 상단에서 Cloud Shell 활성화를 클릭합니다.

- Cloud Shell에 연결되면 다음 명령어를 사용하여 이미 인증되었는지, 프로젝트가 프로젝트 ID로 설정되어 있는지 확인합니다.

gcloud auth list

- Cloud Shell에서 다음 명령어를 실행하여 gcloud 명령어가 프로젝트를 알고 있는지 확인합니다.

gcloud config list project

- 프로젝트가 설정되지 않은 경우 다음 명령어를 사용하여 설정합니다.

gcloud config set project <YOUR_PROJECT_ID>

- 필요한 API를 사용 설정합니다.

gcloud services enable alloydb.googleapis.com \

compute.googleapis.com \

cloudresourcemanager.googleapis.com \

servicenetworking.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

cloudfunctions.googleapis.com \

aiplatform.googleapis.com

gcloud 명령어의 대안은 콘솔을 통해 각 제품을 검색하거나 이 링크를 사용하는 것입니다.

누락된 API가 있으면 구현 과정에서 언제든지 사용 설정할 수 있습니다.

gcloud 명령어 및 사용법은 문서를 참조하세요.

4. 데이터베이스 설정

이 실습에서는 소매 데이터를 보관할 데이터베이스로 AlloyDB를 사용합니다. clusters를 사용하여 데이터베이스 및 로그와 같은 모든 리소스를 보관합니다. 각 클러스터에는 데이터에 대한 액세스 포인트를 제공하는 기본 인스턴스가 있습니다. 테이블에는 실제 데이터가 포함됩니다.

전자상거래 데이터 세트가 로드될 AlloyDB 클러스터, 인스턴스, 테이블을 만들어 보겠습니다.

클러스터 및 인스턴스 만들기

- Cloud 콘솔에서 AlloyDB 페이지로 이동합니다. Cloud Console에서 대부분의 페이지를 찾는 가장 쉬운 방법은 콘솔의 검색창을 사용하는 것입니다.

- 이 페이지에서 '클러스터 만들기'를 선택합니다.

- 아래와 같은 화면이 표시됩니다. 다음 값을 사용하여 클러스터 및 인스턴스를 만듭니다.

- 클러스터 ID: '

shopping-cluster' - 비밀번호: "

alloydb" - PostgreSQL 15 호환

- 지역: '

us-central1' - 네트워킹: '

default'

- 기본 네트워크를 선택하면 아래와 같은 화면이 표시됩니다. '연결 설정'을 선택합니다.

- 여기에서 '자동으로 할당된 IP 범위 사용'을 선택하고 계속합니다. 정보를 검토한 후 '연결 만들기'를 선택합니다.

- 네트워크가 설정되면 클러스터를 계속 만들 수 있습니다. 아래와 같이 클러스터 설정을 완료하려면 클러스터 만들기를 클릭합니다.

인스턴스 ID를 'shopping-instance"'로 변경해야 합니다.

클러스터를 만드는 데 약 10분이 소요됩니다. 완료되면 다음과 유사한 화면이 표시됩니다.

5. 데이터 수집

이제 매장 데이터가 포함된 표를 추가하겠습니다. AlloyDB로 이동하여 기본 클러스터를 선택한 다음 AlloyDB Studio를 선택합니다.

인스턴스 생성이 완료될 때까지 기다려야 할 수 있습니다. 클러스터가 생성되면 클러스터를 만들 때 만든 사용자 인증 정보로 AlloyDB에 로그인합니다. PostgreSQL에 인증할 때 다음 데이터를 사용하세요.

- 사용자 이름 : '

postgres' - 데이터베이스 : '

postgres' - 비밀번호 : '

alloydb'

AlloyDB 스튜디오에 성공적으로 인증하면 편집기에 SQL 명령어가 입력됩니다. 마지막 창 오른쪽에 있는 더하기 기호를 사용하여 여러 편집기 창을 추가할 수 있습니다.

필요에 따라 실행, 형식 지정, 지우기 옵션을 사용하여 편집기 창에 AlloyDB 명령어를 입력합니다.

확장 프로그램 사용 설정

이 앱을 빌드하는 데 pgvector 및 google_ml_integration 확장 프로그램을 사용합니다. pgvector 확장 프로그램을 사용하면 벡터 임베딩을 저장하고 검색할 수 있습니다. google_ml_integration 확장 프로그램은 Vertex AI 예측 엔드포인트에 액세스하여 SQL로 예측을 가져오는 데 사용하는 함수를 제공합니다. 다음 DDL을 실행하여 이러한 확장 프로그램을 사용 설정합니다.

CREATE EXTENSION IF NOT EXISTS google_ml_integration CASCADE;

CREATE EXTENSION IF NOT EXISTS vector;

데이터베이스에서 사용 설정된 확장 프로그램을 확인하려면 다음 SQL 명령어를 실행합니다.

select extname, extversion from pg_extension;

테이블 만들기

아래 DDL 문을 사용하여 테이블을 만듭니다.

CREATE TABLE

apparels ( id BIGINT,

category VARCHAR(100),

sub_category VARCHAR(50),

uri VARCHAR(200),

image VARCHAR(100),

content VARCHAR(2000),

pdt_desc VARCHAR(5000),

embedding vector(768) );

위 명령어를 실행하면 데이터베이스에서 테이블을 볼 수 있습니다. 샘플 스크린샷은 아래와 같습니다.

데이터 수집

이 실습에서는 이 SQL 파일에 약 200개의 레코드로 구성된 테스트 데이터가 있습니다. id, category, sub_category, uri, image 및 content를 포함합니다. 나머지 필드는 실습 후반부에서 입력합니다.

여기에서 20줄/삽입 문을 복사한 다음 빈 편집기 탭에 해당 줄을 붙여넣고 실행을 선택합니다.

테이블 콘텐츠를 보려면 탐색기 섹션을 펼쳐 apparels라는 테이블이 표시될 때까지 펼칩니다. 테이블을 쿼리하는 옵션을 보려면 삼중 콜론 (⋮)을 선택합니다. 새 편집기 탭에 SELECT 문장이 열립니다.

권한 부여

아래 문을 실행하여 embedding 함수에 대한 실행 권한을 사용자 postgres에게 부여합니다.

GRANT EXECUTE ON FUNCTION embedding TO postgres;

AlloyDB 서비스 계정에 Vertex AI 사용자 역할을 부여합니다.

Cloud Shell 터미널로 이동하여 다음 명령어를 실행합니다.

PROJECT_ID=$(gcloud config get-value project)

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:service-$(gcloud projects describe $PROJECT_ID --format="value(projectNumber)")@gcp-sa-alloydb.iam.gserviceaccount.com" \

--role="roles/aiplatform.user"

6. 컨텍스트

AlloyDB 인스턴스 페이지로 돌아갑니다.

임베딩을 만들려면 context, 즉 단일 필드에 포함할 모든 정보가 필요합니다. 제품 설명 (pdt_desc라고 함)을 만들어 이를 수행합니다. 이 경우 각 제품에 관한 모든 정보를 사용하지만 자체 데이터로 이를 수행할 때는 비즈니스에 의미 있는 방식으로 데이터를 엔지니어링해도 됩니다.

새로 만든 인스턴스의 AlloyDB 스튜디오에서 다음 문을 실행합니다. 이렇게 하면 pdt_desc 필드가 컨텍스트 데이터로 업데이트됩니다.

UPDATE

apparels

SET

pdt_desc = CONCAT('This product category is: ', category, ' and sub_category is: ', sub_category, '. The description of the product is as follows: ', content, '. The product image is stored at: ', uri)

WHERE

id IS NOT NULL;

이 DML은 테이블에 있는 모든 필드의 정보와 기타 종속 항목 (사용 사례에 있는 경우)의 정보를 사용하여 간단한 컨텍스트 요약을 만듭니다. 더 정확한 정보 분류와 맥락 생성을 위해 비즈니스에 의미 있는 방식으로 데이터를 엔지니어링하세요.

7. 컨텍스트의 임베딩 만들기

컴퓨터는 텍스트를 처리하는 것보다 숫자를 처리하는 것이 훨씬 쉽습니다. 임베딩 시스템은 텍스트의 표현 방식, 사용하는 언어 등에 관계없이 텍스트를 텍스트를 나타내는 일련의 부동 소수점 수로 변환합니다.

해변가 위치를 설명해 보세요. 'on the water', 'beachfront', 'walk from your room to the ocean', 'sur la mer', 'на берегу океана' 등 다양한 표현이 있을 수 있습니다. 이러한 용어는 모두 다르게 보이지만 의미론적 의미 또는 머신러닝 용어로 보면 임베딩이 서로 매우 근접합니다.

이제 데이터와 컨텍스트가 준비되었으므로 SQL을 실행하여 제품 설명의 임베딩을 embedding 필드의 테이블에 추가합니다. 사용할 수 있는 다양한 임베딩 모델이 있습니다. Vertex AI의 text-embedding-004를 사용합니다. 프로젝트 전체에서 동일한 임베딩 모델을 사용해야 합니다.

참고: 얼마 전에 만든 기존 Google Cloud 프로젝트를 사용하는 경우 textembedding-gecko와 같은 이전 버전의 텍스트 삽입 모델을 계속 사용해야 할 수 있습니다.

UPDATE

apparels

SET

embedding = embedding( 'text-embedding-004',

pdt_desc)

WHERE

TRUE;

apparels 표를 다시 살펴보고 임베딩을 확인합니다. 변경사항을 확인하려면 SELECT 문을 다시 실행해야 합니다.

SELECT

id,

category,

sub_category,

content,

embedding

FROM

apparels;

그러면 아래와 같이 쿼리의 샘플 텍스트에 대한 부동 소수점 배열처럼 보이는 임베딩 벡터가 반환됩니다.

참고: 무료 등급으로 새로 만든 Google Cloud 프로젝트는 삽입 모델에 허용되는 초당 삽입 요청 수와 관련하여 할당량 문제가 발생할 수 있습니다. 임베딩을 생성하는 동안 ID에 필터 쿼리를 사용한 후 1~5개의 레코드 등을 선택적으로 선택하는 것이 좋습니다.

8. 벡터 검색 실행

이제 테이블, 데이터, 임베딩이 모두 준비되었으므로 사용자 검색 텍스트에 대한 실시간 벡터 검색을 실행해 보겠습니다.

사용자가 다음과 같이 묻는다고 가정해 보겠습니다.

"핑크색 캐주얼한 순면 여성용 상의가 필요합니다."

다음 쿼리를 실행하여 일치하는 항목을 찾을 수 있습니다.

SELECT

id,

category,

sub_category,

content,

pdt_desc AS description

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-004',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5;

이 쿼리를 자세히 살펴보겠습니다.

이 쿼리에서

- 사용자의 검색어는 '핑크색 캐주얼 여성용 상의, 순면만 원함'입니다.

text-embedding-004모델을 사용하여embedding()메서드에서 임베딩으로 변환합니다. 이 단계는 테이블의 모든 항목에 임베딩 함수를 적용한 마지막 단계와 유사합니다.- '

<=>'는 COSINE SIMILARITY 거리 메서드의 사용을 나타냅니다. 사용 가능한 모든 유사성 측정값은 pgvector 문서에서 확인할 수 있습니다. - 데이터베이스에 저장된 벡터와 호환되도록 임베딩 메서드의 결과를 벡터 유형으로 변환합니다.

- LIMIT 5는 검색 텍스트의 최근접 이웃 5개를 추출하겠다는 의미입니다.

결과는 다음과 같습니다.

검색 결과에서 볼 수 있듯이 검색어와 상당히 유사한 검색 결과가 표시됩니다. 색상을 변경하여 결과가 어떻게 달라지는지 확인해 보세요.

중요사항:

이제 ScaNN 색인을 사용하여 이 벡터 검색 결과의 성능 (쿼리 시간), 효율성, 재현율을 높이고자 한다고 가정해 보겠습니다. 이 블로그의 단계에 따라 색인이 있는 경우와 없는 경우의 결과 차이를 비교하세요. 편의를 위해 색인 생성 단계를 나열합니다.

- 이미 클러스터, 인스턴스, 컨텍스트, 임베딩이 생성되었으므로 다음 문을 사용하여 ScaNN 확장 프로그램을 설치하기만 하면 됩니다.

CREATE EXTENSION IF NOT EXISTS alloydb_scann;

- 다음으로 색인 (ScaNN)을 만듭니다.

CREATE INDEX apparel_index ON apparels

USING scann (embedding cosine)

WITH (num_leaves=54);

위의 DDL에서 apparel_index는 색인의 이름입니다.

'apparels'가 내 테이블입니다.

'scann'은 색인 메서드입니다.

'embedding'은 색인을 생성하려는 테이블의 열입니다.

'cosine'은 색인과 함께 사용할 거리 메서드입니다.

'54'는 이 색인에 적용할 파티션 수입니다. 1~1048576 사이의 값으로 설정합니다. 이 값을 결정하는 방법에 관한 자세한 내용은 ScaNN 색인 조정을 참고하세요.

ScaNN 저장소에서 권장하는 대로 데이터 포인트 수의 제곱근을 사용했습니다. 파티션을 만들 때는 num_leaves가 대략 데이터 포인트 수의 제곱근이어야 합니다.

- 다음 쿼리를 사용하여 색인이 생성되었는지 확인합니다.

SELECT * FROM pg_stat_ann_indexes;

- 색인 없이 사용한 것과 동일한 쿼리를 사용하여 벡터 검색을 실행합니다.

select * from apparels

ORDER BY embedding <=> CAST(embedding('textembedding-gecko', 'white tops for girls without any print') as vector(768))

LIMIT 20

위 쿼리는 실습의 8단계에서 사용한 쿼리와 동일합니다. 하지만 이제 필드의 색인이 생성되었습니다.

- 색인 유무와 관계없이 간단한 검색 쿼리로 테스트합니다 (색인 삭제).

white tops for girls without any print

색인이 생성된 임베딩 데이터의 벡터 검색 쿼리에 위의 검색 텍스트를 사용하면 검색 결과의 품질과 효율성이 향상됩니다. 색인을 사용하면 효율성이 크게 향상됩니다 (실행 시간: ScaNN 사용 안 함 시 10.37ms, ScaNN 사용 시 0.87ms). 이 주제에 관한 자세한 내용은 이 블로그를 참고하세요.

9. LLM을 사용한 일치 유효성 검사

계속해서 애플리케이션에 가장 적합한 검색 결과를 반환하는 서비스를 만들기 전에 생성형 AI 모델을 사용하여 이러한 잠재적 응답이 실제로 관련성이 높고 사용자와 공유하기에 안전한지 확인해 보겠습니다.

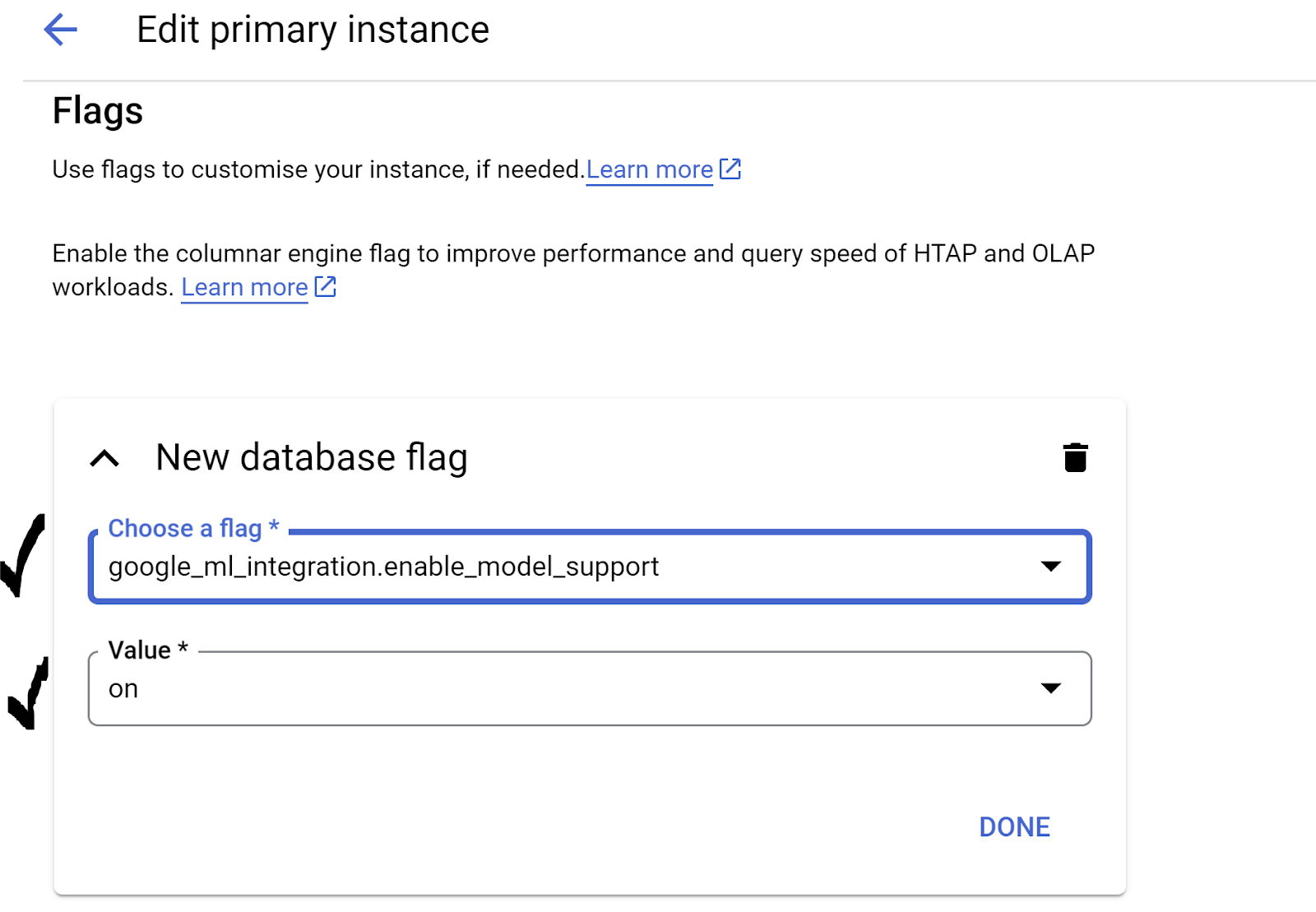

인스턴스가 Gemini용으로 설정되어 있는지 확인

먼저 클러스터와 인스턴스에 Google ML 통합이 이미 사용 설정되어 있는지 확인합니다. AlloyDB Studio에서 다음 명령어를 실행합니다.

show google_ml_integration.enable_model_support;

값이 'on'으로 표시되면 다음 2단계를 건너뛰고 AlloyDB 및 Vertex AI 모델 통합 설정으로 바로 이동할 수 있습니다.

- AlloyDB 클러스터의 기본 인스턴스로 이동하여 '기본 인스턴스 수정'을 클릭합니다.

- 고급 구성 옵션의 플래그 섹션으로 이동합니다.

google_ml_integration.enable_model_support flag가 아래와 같이 'on'로 설정되어 있는지 확인합니다.

'사용'으로 설정되어 있지 않으면 '사용'으로 설정한 다음 인스턴스 업데이트 버튼을 클릭합니다. 이 단계는 몇 분 정도 걸립니다.

AlloyDB 및 Vertex AI 모델 통합

이제 AlloyDB 스튜디오에 연결하고 다음 DML 문을 실행하여 표시된 위치에서 프로젝트 ID를 사용하여 AlloyDB에서 Gemini 모델 액세스를 설정할 수 있습니다. 명령어를 실행하기 전에 구문 오류에 대한 경고가 표시될 수 있지만 명령어는 정상적으로 실행됩니다.

먼저 아래와 같이 Gemini 1.5 모델 연결을 만듭니다. 아래 명령어에서 $PROJECT_ID를 Google Cloud 프로젝트 ID로 바꾸어야 합니다.

CALL

google_ml.create_model( model_id => 'gemini-1.5',

model_request_url => 'https://us-central1-aiplatform.googleapis.com/v1/projects/$PROJECT_ID/locations/us-central1/publishers/google/models/gemini-1.5-pro:streamGenerateContent',

model_provider => 'google',

model_auth_type => 'alloydb_service_agent_iam');

AlloyDB Studio에서 다음 명령어를 통해 액세스에 구성된 모델을 확인할 수 있습니다.

select model_id,model_type from google_ml.model_info_view;

마지막으로 데이터베이스 사용자가 ml_predict_row 함수를 실행하여 Google Vertex AI 모델을 통해 예측을 실행할 수 있는 권한을 부여해야 합니다. 다음 명령어를 실행합니다.

GRANT EXECUTE ON FUNCTION ml_predict_row to postgres;

참고: 기존 Google Cloud 프로젝트와 얼마 전에 만든 AlloyDB의 기존 클러스터/인스턴스를 사용하는 경우, 향후 gemini-1.5 호출 시 문제가 발생할 수 있으므로 gemini-1.5 모델에 대한 이전 참조를 삭제하고 위의 CALL 문을 사용하여 다시 만들고 ml_predict_row 함수에 대한 grant execute를 다시 실행해야 할 수 있습니다.

응답 평가

다음 섹션에서는 쿼리의 응답이 합리적인지 확인하기 위해 하나의 대규모 쿼리를 사용하게 되지만 쿼리를 이해하기 어려울 수 있습니다. 이제 몇 분 후에 각 부분을 살펴보고 어떻게 조합되는지 확인해 보겠습니다.

- 먼저 데이터베이스에 요청을 보내 사용자 검색어와 가장 일치하는 5개 항목을 가져옵니다. 단순성을 유지하기 위해 쿼리를 하드코딩하고 있지만 나중에 쿼리에 보간할 예정이니 걱정하지 마세요.

apparels테이블의 제품 설명을 포함하고 설명을 색인과 결합하는 필드와 원래 요청과 결합하는 필드라는 두 가지 새 필드를 추가합니다. 이 모든 내용은xyz(임시 테이블 이름)이라는 테이블에 저장됩니다.

CREATE TABLE

xyz AS

SELECT

id || ' - ' || pdt_desc AS literature,

pdt_desc AS content,

'I want womens tops, pink casual only pure cotton.' AS user_text

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-004',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5;

이 쿼리의 출력은 사용자 쿼리와 가장 유사한 5개의 행입니다. 새 테이블 xyz에는 5개의 행이 포함되며 각 행에는 다음 열이 있습니다.

literaturecontentuser_text

- 응답의 유효성을 판단하기 위해 응답을 평가하는 방법을 설명하는 복잡한 쿼리를 사용합니다.

xyz테이블의user_text및content를 쿼리의 일부로 사용합니다.

"Read this user search text: ', user_text,

' Compare it against the product inventory data set: ', content,

' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

- 이 쿼리를 사용하여

xyz테이블에서 응답의 '좋음'을 검토합니다.

CREATE TABLE

x AS

SELECT

json_array_elements( google_ml.predict_row( model_id => 'gemini-1.5',

request_body => CONCAT('{

"contents": [

{ "role": "user",

"parts":

[ { "text": "Read this user search text: ', user_text, ' Compare it against the product inventory data set: ', content, ' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

} ]

}

] }'

)::json))-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'

AS LLM_RESPONSE

FROM

xyz;

predict_row는 결과를 JSON 형식으로 반환합니다. 코드-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'"는 해당 JSON에서 실제 텍스트를 추출하는 데 사용됩니다. 반환된 실제 JSON을 보려면 이 코드를 삭제하면 됩니다.- 마지막으로 LLM 필드를 가져오려면 x 테이블에서 추출하면 됩니다.

SELECT

LLM_RESPONSE

FROM

x;

- 다음과 같이 단일 다음 쿼리로 결합할 수 있습니다.

위 쿼리를 실행하여 중간 결과를 확인한 경우, 이를 실행하기 전에 AlloyDB 데이터베이스에서 xyz 및 x 테이블을 삭제해야 합니다.

SELECT

LLM_RESPONSE

FROM (

SELECT

json_array_elements( google_ml.predict_row( model_id => 'gemini-1.5',

request_body => CONCAT('{

"contents": [

{ "role": "user",

"parts":

[ { "text": "Read this user search text: ', user_text, ' Compare it against the product inventory data set: ', content, ' Return a response with 3 values: 1) MATCH: if the 2 contexts are at least 85% matching or not: YES or NO 2) PERCENTAGE: percentage of match, make sure that this percentage is accurate 3) DIFFERENCE: A clear short easy description of the difference between the 2 products. Remember if the user search text says that some attribute should not be there, and the record has it, it should be a NO match."

} ]

}

] }'

)::json))-> 'candidates' -> 0 -> 'content' -> 'parts' -> 0 -> 'text'

AS LLM_RESPONSE

FROM (

SELECT

id || ' - ' || pdt_desc AS literature,

pdt_desc AS content,

'I want womens tops, pink casual only pure cotton.' user_text

FROM

apparels

ORDER BY

embedding <=> embedding('text-embedding-004',

'I want womens tops, pink casual only pure cotton.')::vector

LIMIT

5 ) AS xyz ) AS X;

여전히 부담스러울 수 있지만 조금 더 이해하기 쉬워졌기를 바랍니다. 결과에는 일치 여부, 일치 비율, 등급에 대한 설명이 표시됩니다.

Gemini 모델은 기본적으로 스트리밍이 사용 설정되어 있으므로 실제 응답이 여러 줄에 걸쳐 표시됩니다.

10. 애플리케이션을 웹으로 가져가기

앱을 웹으로 가져갈 준비가 되셨나요? Cloud Run 함수를 사용하여 이 지식 엔진을 서버리스로 만들려면 다음 단계를 따르세요.

- Google Cloud 콘솔의 Cloud Run 함수로 이동하여 새 Cloud Run 함수를 만들거나 https://console.cloud.google.com/functions/add 링크를 사용하세요.

- 환경을 'Cloud Run 함수'로 선택합니다. 함수 이름 'retail-engine'을 제공하고 리전을 'us-central1'로 선택합니다. 인증을 '인증되지 않은 호출 허용'으로 설정하고 다음을 클릭합니다. 런타임으로 Java 17을, 소스 코드로 인라인 편집기를 선택합니다.

- 기본적으로 진입점이 '

gcfv2.HelloHttpFunction'로 설정됩니다. Cloud Run 함수의HelloHttpFunction.java및pom.xml에 있는 자리표시자 코드를 각각 Java 파일 및 XML의 코드로 바꿉니다. - Java 파일에서 $PROJECT_ID 자리표시자와 AlloyDB 연결 사용자 인증 정보를 값으로 변경해야 합니다. AlloyDB 사용자 인증 정보는 이 Codelab을 시작할 때 사용한 사용자 인증 정보입니다. 다른 값을 사용한 경우 Java 파일에서 동일하게 수정하세요.

- 배포를 클릭합니다.

배포가 완료되면 Cloud 함수가 AlloyDB 데이터베이스 인스턴스에 액세스할 수 있도록 VPC 커넥터를 만듭니다.

중요 단계:

배포를 설정하면 Google Cloud Run Functions 콘솔에 함수가 표시됩니다. 새로 만든 함수 (retail-engine)를 검색하여 클릭한 다음 수정을 클릭하고 다음을 변경합니다.

- 런타임, 빌드, 연결, 보안 설정으로 이동

- 시간 제한을 180초로 늘립니다.

- '연결' 탭으로 이동합니다.

- 인그레스 설정에서 '모든 트래픽 허용'이 선택되어 있는지 확인합니다.

- 이그레스 설정에서 네트워크 드롭다운을 클릭하고 '새 VPC 커넥터 추가' 옵션을 선택한 다음 표시되는 대화상자의 안내를 따릅니다.

- VPC 커넥터의 이름을 지정하고 리전이 인스턴스와 동일한지 확인합니다. 네트워크 값은 기본값으로 두고 서브넷을 맞춤 IP 범위로 설정하여 IP 범위를 10.8.0.0으로 설정하거나 사용 가능한 유사한 값을 설정합니다.

- '확장 설정 표시'를 펼치고 구성이 다음과 정확히 일치하는지 확인합니다.

- '만들기'를 클릭하면 이 커넥터가 이그레스 설정에 표시됩니다.

- 새로 만든 커넥터를 선택합니다.

- 모든 트래픽이 이 VPC 커넥터를 통해 라우팅되도록 선택합니다.

- 다음을 클릭한 후 배포를 클릭합니다.

11. 애플리케이션 테스트

업데이트된 Cloud 함수가 배포되면 다음 형식의 엔드포인트가 표시됩니다.

https://us-central1-YOUR_PROJECT_ID.cloudfunctions.net/retail-engine

다음 명령어를 실행하여 Cloud Shell 터미널에서 테스트할 수 있습니다.

gcloud functions call retail-engine --region=us-central1 --gen2 --data '{"search": "I want some kids clothes themed on Disney"}'

또는 다음과 같이 Cloud Run 함수를 테스트할 수 있습니다.

PROJECT_ID=$(gcloud config get-value project)

curl -X POST https://us-central1-$PROJECT_ID.cloudfunctions.net/retail-engine \

-H 'Content-Type: application/json' \

-d '{"search":"I want some kids clothes themed on Disney"}' \

| jq .

결과는 다음과 같습니다.

작업이 끝났습니다. AlloyDB 데이터에서 임베딩 모델을 사용하여 유사성 벡터 검색을 실행하는 방법은 간단합니다.

대화형 에이전트 빌드

에이전트는 이 실습의 2단계에서 빌드됩니다.

12. 삭제

이 실습의 2부를 완료할 계획이라면 이 단계를 건너뜁니다. 이 단계를 실행하면 현재 프로젝트가 삭제됩니다.

이 게시물에서 사용한 리소스의 비용이 Google Cloud 계정에 청구되지 않도록 하려면 다음 단계를 따르세요.

- Google Cloud 콘솔에서 리소스 관리 페이지로 이동합니다.

- 프로젝트 목록에서 삭제할 프로젝트를 선택하고 삭제를 클릭합니다.

- 대화상자에서 프로젝트 ID를 입력하고 종료를 클릭하여 프로젝트를 삭제합니다.

13. 축하합니다

축하합니다. AlloyDB, pgvector, 벡터 검색을 사용하여 유사성 검색을 실행했습니다. Google은 AlloyDB, Vertex AI, 벡터 검색의 기능을 결합하여 문맥 및 벡터 검색을 접근성, 효율성, 의미 중심적으로 개선하는 데 큰 진전을 이루었습니다. 이 실습의 다음 부분에서는 상담사 빌드 단계를 다룹니다.