1. بررسی اجمالی

این آزمایشگاه اطلاعات دقیقی را در مورد استقرار یک سرور برنامه کاربردی LIT در Google Cloud Platform (GCP) برای تعامل با مدلهای بنیاد Vertex AI Gemini و مدلهای زبان بزرگ شخص ثالث (LLM) ارائه میکند. همچنین شامل راهنمایی در مورد نحوه استفاده از رابط کاربری LIT برای اشکال زدایی سریع و تفسیر مدل است.

با دنبال کردن این آزمایشگاه، کاربران یاد خواهند گرفت که چگونه:

- یک سرور LIT را در GCP پیکربندی کنید.

- سرور LIT را به مدل های Vertex AI Gemini یا سایر LLM های خود میزبان متصل کنید.

- از رابط کاربری LIT برای تجزیه و تحلیل، اشکالزدایی و تفسیر اعلانها برای عملکرد و بینش بهتر مدل استفاده کنید.

LIT چیست؟

LIT یک ابزار بصری و تعاملی برای درک مدل است که از متن، تصویر و داده های جدولی پشتیبانی می کند. می توان آن را به عنوان یک سرور مستقل یا در محیط های نوت بوک مانند Google Colab، Jupyter و Google Cloud Vertex AI اجرا کرد. LIT از PyPI و GitHub در دسترس است.

بهروزرسانیهای اخیر که در اصل برای درک مدلهای طبقهبندی و رگرسیون ساخته شدهاند، ابزارهایی را برای اشکالزدایی اعلانهای LLM اضافه کردهاند که به شما این امکان را میدهد تا چگونگی تأثیر کاربر، مدل و محتوای سیستم بر رفتار تولید را بررسی کنید.

Vertex AI و Model Garden چیست؟

Vertex AI یک پلتفرم یادگیری ماشینی (ML) است که به شما امکان میدهد مدلهای ML و برنامههای هوش مصنوعی را آموزش و استقرار دهید و LLMها را برای استفاده در برنامههای مبتنی بر هوش مصنوعی خود سفارشی کنید. Vertex AI مهندسی داده، علم داده و جریانهای کاری مهندسی ML را ترکیب میکند و به تیمهای شما امکان میدهد با استفاده از یک مجموعه ابزار مشترک با یکدیگر همکاری کنند و برنامههای شما را با استفاده از مزایای Google Cloud مقیاسبندی کنند.

Vertex Model Garden یک کتابخانه مدل ML است که به شما کمک میکند مدلها و داراییهای شخصی ثالث را کشف، آزمایش، سفارشیسازی و استقرار کنید.

کاری که خواهی کرد

شما از Google Cloud Shell و Cloud Run برای استقرار یک ظرف Docker از تصویر از پیش ساخته شده LIT استفاده خواهید کرد.

Cloud Run یک پلت فرم محاسباتی مدیریت شده است که به شما امکان می دهد کانتینرها را مستقیماً در بالای زیرساخت مقیاس پذیر Google از جمله بر روی GPU ها اجرا کنید.

مجموعه داده

نسخه ی نمایشی به طور پیش فرض از مجموعه داده های نمونه اشکال زدایی سریع LIT استفاده می کند، یا می توانید مجموعه خود را از طریق UI بارگیری کنید.

قبل از شروع

برای این راهنمای مرجع، به یک پروژه Google Cloud نیاز دارید. می توانید یک پروژه جدید ایجاد کنید یا پروژه ای را که قبلا ایجاد کرده اید انتخاب کنید.

2. Google Cloud Console و Cloud Shell را راه اندازی کنید

شما یک Google Cloud Console راه اندازی می کنید و در این مرحله از Google Cloud Shell استفاده می کنید.

2-الف: یک Google Cloud Console راه اندازی کنید

یک مرورگر راه اندازی کنید و به Google Cloud Console بروید.

Google Cloud Console یک رابط مدیریت وب قدرتمند و ایمن است که به شما امکان می دهد منابع Google Cloud خود را به سرعت مدیریت کنید. این یک ابزار DevOps در حال حرکت است.

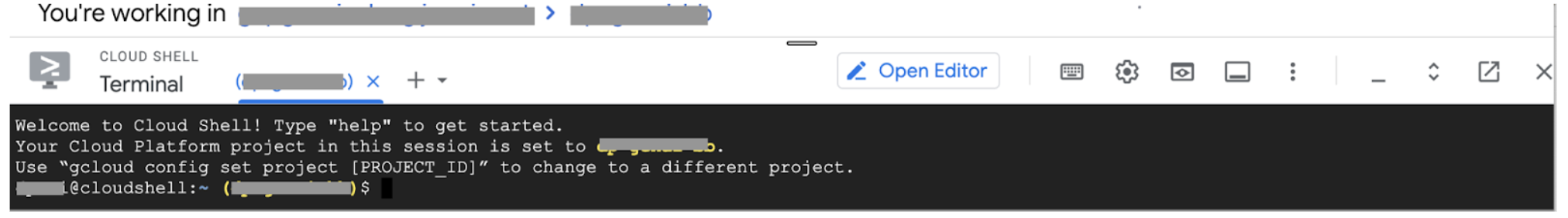

2-b: Google Cloud Shell را راه اندازی کنید

Cloud Shell یک محیط توسعه و عملیات آنلاین است که در هر جایی با مرورگر شما قابل دسترسی است. می توانید منابع خود را با ترمینال آنلاین آن که با ابزارهایی مانند ابزار خط فرمان gcloud، kubectl و غیره از قبل بارگذاری شده است، مدیریت کنید. همچنین میتوانید برنامههای مبتنی بر ابر خود را با استفاده از ویرایشگر پوسته ابری آنلاین توسعه دهید، بسازید، اشکالزدایی کنید، و آنها را استقرار دهید. Cloud Shell یک محیط آنلاین و آماده برای توسعه دهندگان با مجموعه ابزار مورد علاقه از پیش نصب شده و 5 گیگابایت فضای ذخیره سازی دائمی فراهم می کند. در مراحل بعدی از خط فرمان استفاده خواهید کرد.

یک Google Cloud Shell را با استفاده از نماد در سمت راست بالای نوار منو، که در تصویر زیر به رنگ آبی دایره شده است، راه اندازی کنید.

شما باید یک ترمینال با پوسته Bash در پایین صفحه ببینید.

2-c: پروژه Google Cloud را تنظیم کنید

شما باید شناسه پروژه و منطقه پروژه را با استفاده از دستور gcloud تنظیم کنید.

# Set your GCP Project ID.

gcloud config set project your-project-id

# Set your GCP Project Region.

gcloud config set run/region your-project-region

3. LIT App Server Docker Image را با Cloud Run اجرا کنید

3-a: برنامه LIT را در Cloud Run اجرا کنید

ابتدا باید آخرین نسخه LIT-App را به عنوان نسخه ای که قرار است راه اندازی شود، تنظیم کنید.

# Set latest version as your LIT_SERVICE_TAG.

export LIT_SERVICE_TAG=latest

# List all the public LIT GCP App server docker images.

gcloud container images list-tags us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-lit-app

پس از تنظیم تگ نسخه، باید سرویس را نامگذاری کنید.

# Set your lit service name. While 'lit-app-service' is provided as a placeholder, you can customize the service name based on your preferences.

export LIT_SERVICE_NAME=lit-app-service

پس از آن، می توانید دستور زیر را برای استقرار کانتینر در Cloud Run اجرا کنید.

# Use below cmd to deploy the LIT App to Cloud Run.

gcloud run deploy $LIT_SERVICE_NAME \

--image us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-lit-app:$LIT_SERVICE_TAG \

--port 5432 \

--cpu 8 \

--memory 32Gi \

--no-cpu-throttling \

--no-allow-unauthenticated

LIT همچنین به شما این امکان را می دهد که هنگام راه اندازی سرور، مجموعه داده را اضافه کنید. برای انجام این کار، متغیر DATASETS را طوری تنظیم کنید که شامل دادههایی باشد که میخواهید بارگیری کنید، با استفاده از قالب name:path ، به عنوان مثال data_foo:/bar/data_2024.jsonl . قالب مجموعه داده باید jsonl. باشد، که در آن هر رکورد حاوی فیلدهای target و source prompt و اختیاری است. برای بارگیری چندین مجموعه داده، آنها را با کاما جدا کنید. اگر تنظیم نشود، مجموعه داده نمونه اشکال زدایی سریع LIT بارگیری می شود.

# Set the dataset.

export DATASETS=[DATASETS]

با تنظیم MAX_EXAMPLES، می توانید حداکثر تعداد نمونه را برای بارگیری از هر مجموعه ارزیابی تنظیم کنید.

# Set the max examples.

export MAX_EXAMPLES=[MAX_EXAMPLES]

سپس در دستور deploy می توانید اضافه کنید

--set-env-vars "DATASETS=$DATASETS" \

--set-env-vars "MAX_EXAMPLES=$MAX_EXAMPLES" \

3-b: سرویس برنامه LIT را مشاهده کنید

پس از ایجاد سرور LIT App، می توانید این سرویس را در بخش Cloud Run در Cloud Console پیدا کنید.

سرویس LIT App را که به تازگی ایجاد کرده اید انتخاب کنید. مطمئن شوید که نام سرویس با LIT_SERVICE_NAME یکسان است.

میتوانید URL سرویس را با کلیک کردن روی سرویسی که به تازگی راهاندازی کردهاید پیدا کنید.

سپس باید بتوانید رابط کاربری LIT را مشاهده کنید. اگر با خطا مواجه شدید، قسمت Troubleshooting را بررسی کنید.

می توانید برای نظارت بر فعالیت، مشاهده پیام های خطا و پیگیری پیشرفت استقرار، بخش LOGS را بررسی کنید.

برای مشاهده معیارهای سرویس می توانید قسمت METRICS را بررسی کنید.

3-c: بارگذاری مجموعه داده ها

روی گزینه Configure در LIT UI کلیک کنید، Dataset را انتخاب کنید. با تعیین یک نام و ارائه URL مجموعه داده، مجموعه داده را بارگیری کنید. قالب مجموعه داده باید jsonl. باشد، که در آن هر رکورد حاوی فیلدهای target و source prompt و اختیاری است.

4. مدل های Gemini را در Vertex AI Model Garden آماده کنید

مدل های پایه Gemini گوگل از Vertex AI API در دسترس هستند. LIT پوشش مدل VertexAIModelGarden را برای استفاده از این مدل ها برای تولید فراهم می کند. به سادگی نسخه مورد نظر (به عنوان مثال، "gemini-1.5-pro-001") را از طریق پارامتر نام مدل مشخص کنید. مزیت کلیدی استفاده از این مدل ها این است که نیازی به تلاش اضافی برای استقرار ندارند. بهطور پیشفرض، دسترسی فوری به مدلهایی مانند Gemini 1.0 Pro و Gemini 1.5 Pro در GCP دارید که نیاز به مراحل پیکربندی اضافی را از بین میبرد.

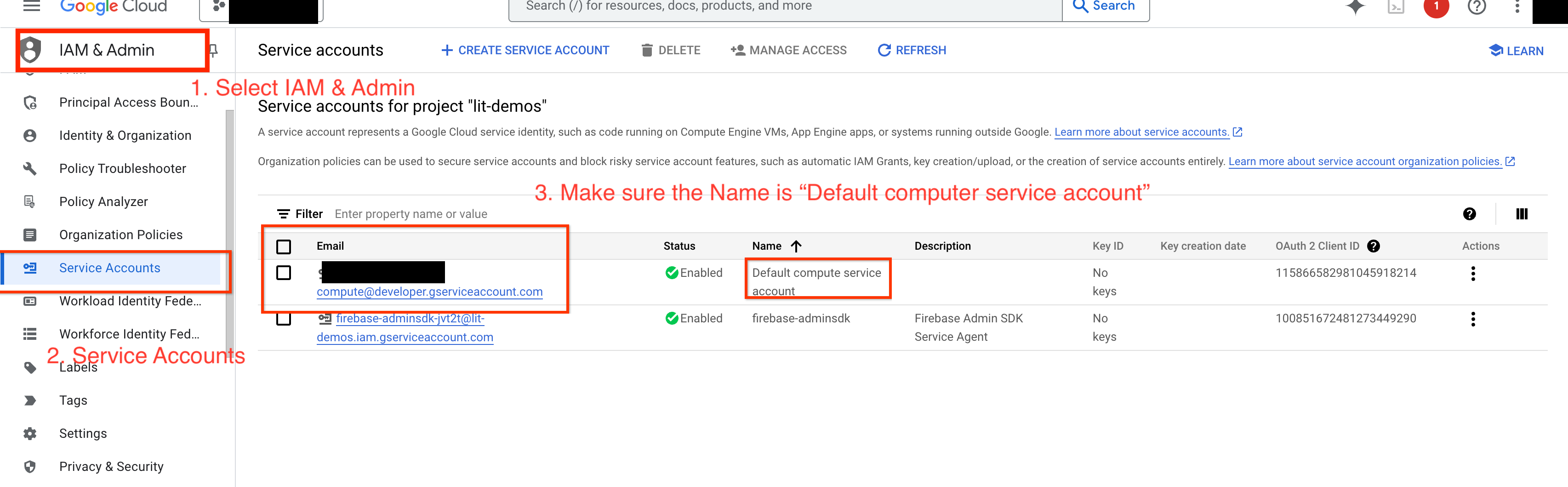

4-a: مجوزهای Vertex AI را اعطا کنید

برای پرس و جوی Gemini در GCP، باید مجوزهای Vertex AI را به حساب سرویس اعطا کنید. مطمئن شوید که نام حساب سرویس Default compute service account باشد. ایمیل حساب سرویس حساب کاربری را کپی کنید.

ایمیل حساب سرویس را به عنوان اصلی با نقش Vertex AI User در لیست مجاز IAM خود اضافه کنید.

4-b: بارگذاری مدل های جمینی

در مراحل زیر مدلهای Gemini را بارگیری میکنید و پارامترهای آن را تنظیم میکنید.

- روی گزینه

Configureدر رابط کاربری LIT کلیک کنید.

- روی گزینه

- در زیر گزینه

Select a base modelگزینهgeminiرا انتخاب کنید.

- در زیر گزینه

- شما باید مدل را در

new_nameنامگذاری کنید.

- شما باید مدل را در

- مدل های جمینی انتخابی خود را به عنوان

model_nameوارد کنید.

- مدل های جمینی انتخابی خود را به عنوان

- روی

Load Modelکلیک کنید.

- روی

- روی

Submitکلیک کنید.

- روی

5. سرور مدل LLM های خود میزبانی شده را در GCP مستقر کنید

LLMهای خود میزبان با تصویر داکر سرور مدل LIT به شما این امکان را می دهد که از ویژگی های برجسته LIT و توکنیزه کردن توابع برای به دست آوردن بینش عمیق تر در مورد رفتار مدل استفاده کنید. تصویر سرور مدل با مدلهای KerasNLP یا Hugging Face Transformers ، از جمله وزنهای ارائهشده توسط کتابخانه و میزبانیشده توسط خود، به عنوان مثال، در Google Cloud Storage کار میکند.

5-a: پیکربندی مدل ها

هر ظرف یک مدل را بارگیری می کند که با استفاده از متغیرهای محیطی پیکربندی شده است.

شما باید با تنظیم MODEL_CONFIG مدل هایی را برای بارگذاری مشخص کنید. قالب باید name:path باشد، برای مثال model_foo:model_foo_path . مسیر می تواند یک URL، یک مسیر فایل محلی، یا نام یک پیش تنظیم برای چارچوب Deep Learning پیکربندی شده باشد (برای اطلاعات بیشتر به جدول زیر مراجعه کنید). این سرور با Gemma، GPT2، Llama، و Mistral روی همه مقادیر DL_FRAMEWORK پشتیبانی شده تست شده است. مدل های دیگر باید کار کنند، اما ممکن است تنظیمات لازم باشد.

# Set models you want to load. While 'gemma2b is given as a placeholder, you can load your preferred model by following the instructions above.

export MODEL_CONFIG=gemma2b:gemma_2b_en

علاوه بر این، سرور مدل LIT امکان پیکربندی متغیرهای محیطی مختلف را با استفاده از دستور زیر فراهم میکند. لطفا برای جزئیات به جدول مراجعه کنید. توجه داشته باشید که هر متغیر باید جداگانه تنظیم شود.

# Customize the variable value as needed.

export [VARIABLE]=[VALUE]

متغیر | ارزش ها | توضیحات |

DL_FRAMEWORK | | کتابخانه مدل سازی برای بارگذاری وزن های مدل در زمان اجرا مشخص شده استفاده می شود. به طور پیش فرض |

DL_RUNTIME | | چارچوب باطن یادگیری عمیق که مدل بر روی آن اجرا می شود. تمام مدل های بارگذاری شده توسط این سرور از یک Backend استفاده می کنند، ناسازگاری ها منجر به خطا می شود. به طور پیش فرض |

PRECISION | | دقت نقطه شناور برای مدل های LLM. پیش فرض |

BATCH_SIZE | اعداد صحیح مثبت | تعداد نمونه هایی برای پردازش در هر دسته. پیش فرض |

SEQUENCE_LENGTH | اعداد صحیح مثبت | حداکثر طول توالی اعلان ورودی به اضافه متن تولید شده. پیش فرض |

5-b: سرور مدل را در Cloud Run مستقر کنید

ابتدا باید آخرین نسخه مدل سرور را به عنوان نسخه ای که قرار است اجرا شود تنظیم کنید.

# Set latest as MODEL_VERSION_TAG.

export MODEL_VERSION_TAG=latest

# List all the public LIT GCP model server docker images.

gcloud container images list-tags us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-model-server

پس از تنظیم تگ نسخه، باید مدل-سرور خود را نامگذاری کنید.

# Set your Service name.

export MODEL_SERVICE_NAME='gemma2b-model-server'

پس از آن، می توانید دستور زیر را برای استقرار کانتینر در Cloud Run اجرا کنید. اگر متغیرهای محیط را تنظیم نکنید، مقادیر پیش فرض اعمال می شود. از آنجایی که اکثر LLM ها به منابع محاسباتی گران قیمت نیاز دارند، استفاده از GPU به شدت توصیه می شود. اگر ترجیح می دهید فقط روی CPU اجرا شود (که برای مدل های کوچکی مانند GPT2 خوب کار می کند)، می توانید آرگومان های مرتبط --gpu 1 --gpu-type nvidia-l4 --max-instances 7 حذف کنید.

# Deploy the model service container.

gcloud beta run deploy $MODEL_SERVICE_NAME \

--image us-east4-docker.pkg.dev/lit-demos/lit-app/gcp-model-server:$MODEL_VERSION_TAG \

--port 5432 \

--cpu 8 \

--memory 32Gi \

--no-cpu-throttling \

--gpu 1 \

--gpu-type nvidia-l4 \

--max-instances 7 \

--set-env-vars "MODEL_CONFIG=$MODEL_CONFIG" \

--no-allow-unauthenticated

علاوه بر این، می توانید متغیرهای محیط را با افزودن دستورات زیر سفارشی کنید. فقط متغیرهای محیطی را که برای نیازهای خاص شما ضروری هستند، بگنجانید.

--set-env-vars "DL_FRAMEWORK=$DL_FRAMEWORK" \

--set-env-vars "DL_RUNTIME=$DL_RUNTIME" \

--set-env-vars "PRECISION=$PRECISION" \

--set-env-vars "BATCH_SIZE=$BATCH_SIZE" \

--set-env-vars "SEQUENCE_LENGTH=$SEQUENCE_LENGTH" \

متغیرهای محیطی اضافی ممکن است برای دسترسی به مدلهای خاص لازم باشد. دستورالعملهای Kaggle Hub (که برای مدلهای KerasNLP استفاده میشود) و Hugging Face Hub را در صورت لزوم ببینید.

5-c: دسترسی به سرور مدل

پس از ایجاد سرور مدل، سرویس شروع شده را می توان در بخش Cloud Run پروژه GCP شما یافت.

سرور مدلی را که به تازگی ایجاد کرده اید انتخاب کنید. مطمئن شوید که نام سرویس با MODEL_SERVICE_NAME یکی باشد.

میتوانید URL سرویس را با کلیک کردن روی مدل سرویسی که اخیراً راهاندازی کردهاید، پیدا کنید.

می توانید برای نظارت بر فعالیت، مشاهده پیام های خطا و پیگیری پیشرفت استقرار، بخش LOGS را بررسی کنید.

برای مشاهده معیارهای سرویس می توانید قسمت METRICS را بررسی کنید.

5-d: بارگذاری مدل های خود میزبان

اگر در مرحله 3 سرور LIT خود را پراکسی کنید (بخش عیب یابی را بررسی کنید)، باید با اجرای دستور زیر کد هویت GCP خود را دریافت کنید.

# Find your GCP identity token.

gcloud auth print-identity-token

در مراحل زیر، مدلهای خود میزبان را بارگیری میکنید و پارامترهای آن را تنظیم میکنید.

- روی گزینه

Configureدر رابط کاربری LIT کلیک کنید. - در زیر گزینه

Select a base modelگزینهLLM (self hosted)را انتخاب کنید. - شما باید مدل را در

new_nameنامگذاری کنید. - آدرس سرور مدل خود را به عنوان

base_urlوارد کنید. - اگر سرور LIT App را پراکسی میکنید، رمز شناسایی بهدستآمده را در

identity_tokenوارد کنید (مرحله 3 و مرحله 7 را ببینید). در غیر این صورت، آن را خالی بگذارید. - روی

Load Modelکلیک کنید. - روی

Submitکلیک کنید.

6. تعامل با LIT در GCP

LIT مجموعه ای غنی از ویژگی ها را برای کمک به اشکال زدایی و درک رفتارهای مدل ارائه می دهد. میتوانید با تایپ متن در یک کادر و مشاهده پیشبینیهای مدل، کاری به سادگی جستجو در مدل انجام دهید، یا مدلها را با مجموعه ویژگیهای قدرتمند LIT بررسی کنید، از جمله:

6-الف: مدل را از طریق LIT جستجو کنید

LIT پس از بارگیری مدل و مجموعه داده به طور خودکار مجموعه داده را پرس و جو می کند. با انتخاب پاسخ در ستون ها می توانید پاسخ هر مدل را مشاهده کنید.

6-ب: از تکنیک Sequence Salience استفاده کنید

در حال حاضر تکنیک Sequence Salience در LIT فقط از مدل های خود میزبان پشتیبانی می کند.

Sequence Salience یک ابزار بصری است که با برجسته کردن قسمتهایی از یک فرمان برای خروجی مشخص، به اشکالزدایی دستورات LLM کمک میکند. برای اطلاعات بیشتر در مورد Sequence Salience، برای اطلاعات بیشتر در مورد نحوه استفاده از این ویژگی، آموزش کامل را بررسی کنید.

برای دسترسی به نتایج برجسته، روی هر ورودی یا خروجی در اعلان یا پاسخ کلیک کنید و نتایج برجسته نمایش داده می شود.

6-c: Manullay Edit Prompt and Target

LIT به شما این امکان را می دهد که به صورت دستی هر prompt و target برای نقطه داده موجود ویرایش کنید. با کلیک بر روی Add ، ورودی جدید به مجموعه داده اضافه می شود.

6-d: Prompt را کنار هم مقایسه کنید

LIT به شما این امکان را می دهد که دستورات را در کنار هم در نمونه های اصلی و ویرایش شده مقایسه کنید. می توانید به صورت دستی یک مثال را ویرایش کنید و نتیجه پیش بینی و تجزیه و تحلیل Sequence Salience را برای هر دو نسخه اصلی و ویرایش شده به طور همزمان مشاهده کنید. شما می توانید اعلان را برای هر نقطه داده تغییر دهید و LIT با پرس و جو از مدل، پاسخ مربوطه را ایجاد می کند.

6-e: مقایسه چند مدل در کنار هم

LIT امکان مقایسه کنار هم مدلها را بر روی نمونههای تولید متن و امتیازدهی جداگانه، و همچنین در نمونههای جمعآوری شده برای معیارهای خاص فراهم میکند. با پرس و جو از مدل های بارگذاری شده مختلف، می توانید به راحتی تفاوت در پاسخ های آنها را مقایسه کنید.

6-f: ژنراتورهای خودکار ضد فاکتور

میتوانید از ژنراتورهای خودکار خلاف واقع برای ایجاد ورودیهای جایگزین استفاده کنید و فوراً ببینید که مدل شما با آنها چگونه رفتار میکند.

6-g: عملکرد مدل را ارزیابی کنید

میتوانید عملکرد مدل را با استفاده از معیارها (در حال حاضر از امتیازات BLEU و ROUGE برای تولید متن پشتیبانی میکند) در کل مجموعه داده یا هر زیر مجموعهای از نمونههای فیلتر شده یا انتخابشده ارزیابی کنید.

7. عیب یابی

7-الف: مسائل و راه حل های دسترسی بالقوه

از آنجایی که --no-allow-unauthenticated هنگام استقرار در Cloud Run اعمال می شود، ممکن است مطابق شکل زیر با خطاهای ممنوعه مواجه شوید.

دو روش برای دسترسی به سرویس LIT App وجود دارد.

1. پروکسی به سرویس محلی

با استفاده از دستور زیر می توانید سرویس را به هاست محلی پراکسی کنید.

# Proxy the service to local host.

gcloud run services proxy $LIT_SERVICE_NAME

سپس باید بتوانید با کلیک روی پیوند سرویس پروکسی به سرور LIT دسترسی پیدا کنید.

2. به طور مستقیم کاربران را احراز هویت کنید

برای احراز هویت کاربران میتوانید این پیوند را دنبال کنید و اجازه دسترسی مستقیم به سرویس LIT App را بدهید. این رویکرد همچنین می تواند گروهی از کاربران را قادر به دسترسی به این سرویس کند. برای توسعه شامل همکاری با افراد متعدد، این گزینه موثرتری است.

7-b: بررسی می کند تا اطمینان حاصل شود که سرور مدل با موفقیت راه اندازی شده است

برای اطمینان از راهاندازی موفقیتآمیز سرور مدل، میتوانید مستقیماً با ارسال یک درخواست، سرور مدل را پرس و جو کنید. سرور مدل سه نقطه پایانی، predict ، tokenize و salience را ارائه میکند. اطمینان حاصل کنید که هر دو فیلد prompt و target را در درخواست خود ارائه کرده اید.

# Query the model server predict endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/predict -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

# Query the model server tokenize endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/tokenize -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

# Query the model server salience endpoint.

curl -X POST http://YOUR_MODEL_SERVER_URL/salience -H "Content-Type: application/json" -d '{"inputs":[{"prompt":"[YOUR PROMPT]", "target":[YOUR TARGET]}]}'

اگر با مشکل دسترسی مواجه شدید، بخش 7-a بالا را بررسی کنید.

8. تبریک می گویم

آفرین برای تکمیل کد لبه! زمان برای خنک شدن!

پاک کن

برای پاکسازی آزمایشگاه، همه سرویسهای ابری Google ایجاد شده برای آزمایشگاه را حذف کنید. برای اجرای دستورات زیر از Google Cloud Shell استفاده کنید.

اگر اتصال Google Cloud به دلیل عدم فعالیت قطع شد، متغیرها را طبق مراحل قبلی بازنشانی کنید.

# Delete the LIT App Service.

gcloud run services delete $LIT_SERVICE_NAME

اگر سرور مدل را راه اندازی کرده اید، باید سرور مدل را نیز حذف کنید.

# Delete the Model Service.

gcloud run services delete $MODEL_SERVICE_NAME

در ادامه مطلب

با مواد زیر به یادگیری ویژگی های ابزار LIT ادامه دهید:

- جما: پیوند

- پایه کد منبع باز LIT: Git repo

- کاغذ LIT: ArXiv

- کاغذ اشکال زدایی سریع LIT: ArXiv

- نمایش ویدئویی ویژگی LIT: یوتیوب

- نسخه ی نمایشی اشکال زدایی سریع LIT: Youtube

- جعبه ابزار مسئول GenAI: پیوند

تماس بگیرید

برای هر گونه سوال یا مشکل در مورد این کد لبه، لطفاً با ما در GitHub تماس بگیرید.

مجوز

این اثر تحت مجوز Creative Commons Attribution 4.0 Generic مجوز دارد.