1. Tổng quan

Trong lớp học lập trình này, bạn sẽ sử dụng Vertex AI để chạy một công việc huấn luyện nhiều worker cho mô hình TensorFlow.

Kiến thức bạn sẽ học được

Bạn sẽ tìm hiểu cách:

- Sửa đổi mã xử lý ứng dụng huấn luyện để đào tạo nhiều nhân viên

- Định cấu hình và triển khai công việc đào tạo nhiều nhân viên từ giao diện người dùng Vertex AI

- Định cấu hình và triển khai công việc đào tạo nhiều nhân viên bằng Vertex SDK

Tổng chi phí để chạy phòng thí nghiệm này trên Google Cloud là khoảng 5 USD.

2. Giới thiệu về Vertex AI

Phòng thí nghiệm này sử dụng sản phẩm AI mới nhất có trên Google Cloud. Vertex AI tích hợp các giải pháp học máy trên Google Cloud vào một trải nghiệm phát triển liền mạch. Trước đây, các mô hình được huấn luyện bằng AutoML và mô hình tuỳ chỉnh có thể truy cập được thông qua các dịch vụ riêng biệt. Dịch vụ mới kết hợp cả hai thành một API duy nhất, cùng với các sản phẩm mới khác. Bạn cũng có thể di chuyển các dự án hiện có sang Vertex AI. Nếu bạn có ý kiến phản hồi, vui lòng xem trang hỗ trợ.

Vertex AI có nhiều sản phẩm nhằm hỗ trợ quy trình học máy toàn diện. Phòng thí nghiệm này sẽ tập trung vào các sản phẩm được làm nổi bật dưới đây: Đào tạo và Bàn làm việc

3. Tổng quan về trường hợp sử dụng

Trong phòng thí nghiệm này, bạn sẽ sử dụng công nghệ học chuyển đổi để huấn luyện một mô hình phân loại hình ảnh trên tập dữ liệu sắn từ Tập dữ liệu TensorFlow. Cấu trúc mà bạn sẽ sử dụng là mô hình ResNet50 từ thư viện tf.keras.applications được huấn luyện trước trên tập dữ liệu Imagenet.

Tại sao nên chọn hình thức đào tạo phân tán?

Nếu bạn có một GPU, TensorFlow sẽ sử dụng trình tăng tốc này để tăng tốc quá trình huấn luyện mô hình mà bạn không cần làm gì thêm. Tuy nhiên, nếu muốn được tăng thêm hiệu quả nhờ việc sử dụng nhiều GPU trên một hoặc nhiều máy (mỗi máy có thể có nhiều GPU), bạn cần sử dụng tf.distribute. Đây là thư viện của TensorFlow để chạy một phép tính trên nhiều thiết bị. Thiết bị là một CPU hoặc bộ tăng tốc, chẳng hạn như GPU hoặc TPU, trên một số máy mà TensorFlow có thể chạy các hoạt động.

Cách đơn giản nhất để bắt đầu với quy trình huấn luyện phân tán là một máy duy nhất có nhiều thiết bị GPU. Chiến lược phân phối TensorFlow trong mô-đun tf.distribute sẽ quản lý việc phối hợp phân phối dữ liệu và cập nhật độ dốc trên tất cả GPU. Nếu bạn đã thành thạo quy trình huấn luyện một máy chủ lưu trữ và đang tìm cách mở rộng hơn nữa, thì việc thêm nhiều máy vào cụm của bạn có thể giúp bạn tăng hiệu suất hơn nữa. Bạn có thể sử dụng một cụm máy chỉ có CPU hoặc mỗi máy có một hoặc nhiều GPU. Phòng thí nghiệm này đề cập đến trường hợp thứ hai và minh hoạ cách sử dụng MultiWorkerMirroredStrategy để phân phối hoạt động huấn luyện một mô hình TensorFlow cho nhiều máy trên Vertex AI.

MultiWorkerMirroredStrategy là chiến lược song song dữ liệu đồng bộ mà bạn có thể sử dụng chỉ với một vài lần thay đổi mã. Hệ thống sẽ tạo một bản sao của mô hình này trên mỗi thiết bị trong cụm của bạn. Các lần cập nhật độ dốc tiếp theo sẽ diễn ra một cách đồng bộ. Tức là mỗi thiết bị worker tính toán việc truyền tiến và lùi thông qua mô hình trên một lát cắt khác của dữ liệu đầu vào. Sau đó, các độ dốc được tính toán từ mỗi lát cắt này được tổng hợp trên tất cả các thiết bị trên một máy và tất cả các máy trong cụm và giảm (thường là trung bình) trong một quy trình được gọi là tất cả-giảm. Sau đó, trình tối ưu hoá sẽ thực hiện các bản cập nhật thông số bằng các độ dốc giảm này, nhờ đó giúp đồng bộ hoá các thiết bị. Để tìm hiểu thêm về chương trình đào tạo phân tán bằng TensorFlow, hãy xem video dưới đây:

4. Thiết lập môi trường

Bạn cần có một dự án Google Cloud Platform đã bật tính năng thanh toán để chạy lớp học lập trình này. Để tạo một dự án, hãy làm theo hướng dẫn tại đây.

Bước 1: Bật Compute Engine API

Chuyển đến Compute Engine rồi chọn Enable (Bật) nếu bạn chưa bật tính năng này. Bạn sẽ cần có gói này để tạo thực thể sổ tay.

Bước 2: Bật Container Registry API

Chuyển đến Sổ đăng ký vùng chứa và chọn Bật nếu bạn chưa chọn. Bạn sẽ dùng mã này để tạo một vùng chứa cho công việc huấn luyện tuỳ chỉnh.

Bước 3: Bật API Vertex AI

Chuyển đến phần Vertex AI trong Cloud Console rồi nhấp vào Bật Vertex AI API.

Bước 4: Tạo một thực thể Vertex AI Workbench

Trong phần Vertex AI của Cloud Console, hãy nhấp vào Workbench (Bảng điều khiển):

Bật API Notebooks nếu chưa bật.

Sau khi bật, hãy nhấp vào SÁCH GHI CHÚ CỦA QUẢN LÝ:

Sau đó, chọn SÁCH LƯU Ý MỚI.

Đặt tên cho sổ tay của bạn, sau đó nhấp vào Cài đặt nâng cao.

Trong phần Cài đặt nâng cao, hãy bật tính năng tắt khi không hoạt động và đặt số phút thành 60. Điều này có nghĩa là sổ tay của bạn sẽ tự động tắt khi không được sử dụng, do đó bạn không phải chịu các chi phí không cần thiết.

Trong phần Bảo mật, chọn "Bật thiết bị đầu cuối" nếu chưa được bật.

Bạn có thể giữ nguyên mọi chế độ cài đặt nâng cao khác.

Tiếp theo, hãy nhấp vào Tạo. Quá trình cung cấp thực thể này sẽ mất vài phút.

Sau khi tạo phiên bản, hãy chọn Open JupyterLab.

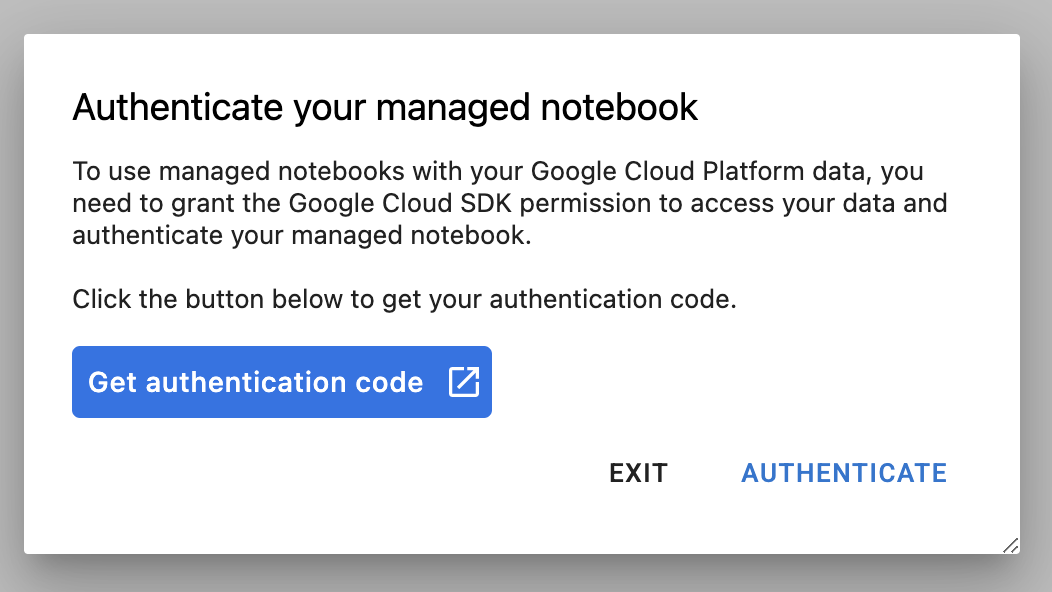

Vào lần đầu tiên sử dụng một phiên bản mới, bạn sẽ được yêu cầu xác thực. Hãy làm theo các bước trong giao diện người dùng để thực hiện việc này.

5. Vùng chứa mã xử lý ứng dụng huấn luyện

Bạn sẽ gửi công việc đào tạo này cho Vertex bằng cách đặt mã đăng ký huấn luyện của bạn vào Vùng chứa Docker và đẩy vùng chứa này vào Google Container Registry. Khi sử dụng phương pháp này, bạn có thể huấn luyện một mô hình được tạo bằng bất kỳ khung nào.

Để bắt đầu, trên trình đơn Trình chạy, hãy mở cửa sổ dòng lệnh trong thực thể sổ tay của bạn:

Tạo một thư mục mới có tên là cassava và cd vào thư mục đó:

mkdir cassava

cd cassava

Bước 1: Tạo Dockerfile

Bước đầu tiên trong việc đóng gói mã là tạo một Dockerfile. Trong Dockerfile, bạn sẽ thêm tất cả các lệnh cần thiết để chạy hình ảnh. Công cụ này sẽ cài đặt tất cả thư viện cần thiết và thiết lập điểm truy cập cho mã huấn luyện.

Trên Terminal, hãy tạo một Dockerfile trống:

touch Dockerfile

Mở Dockerfile và sao chép nội dung sau đây vào đó:

FROM gcr.io/deeplearning-platform-release/tf2-gpu.2-7

WORKDIR /

# Copies the trainer code to the docker image.

COPY trainer /trainer

# Sets up the entry point to invoke the trainer.

ENTRYPOINT ["python", "-m", "trainer.task"]

Dockerfile này sử dụng hình ảnh Docker GPU cho TensorFlow Enterprise 2.7 của Deep Learning Container. Các vùng chứa học sâu trên Google Cloud được cài đặt sẵn nhiều khung phổ biến của công nghệ học máy và khoa học dữ liệu. Sau khi tải hình ảnh đó xuống, Dockerfile này sẽ thiết lập điểm truy cập cho mã huấn luyện. Bạn chưa tạo các tệp này – ở bước tiếp theo, bạn sẽ thêm mã để huấn luyện và điều chỉnh mô hình.

Bước 2: Tạo một bộ chứa Cloud Storage

Trong công việc đào tạo này, bạn sẽ xuất mô hình TensorFlow đã qua huấn luyện sang một Bộ chứa trên đám mây. Trên cửa sổ dòng lệnh, hãy chạy lệnh sau để xác định một biến env cho dự án của bạn, nhớ thay thế your-cloud-project bằng mã dự án của bạn:

PROJECT_ID='your-cloud-project'

Tiếp theo, hãy chạy dòng sau trong dòng lệnh để tạo một bộ chứa mới trong dự án của bạn.

BUCKET="gs://${PROJECT_ID}-bucket"

gsutil mb -l us-central1 $BUCKET

Bước 3: Thêm mã huấn luyện mô hình

Trên cửa sổ dòng lệnh, hãy chạy lệnh sau để tạo thư mục cho mã huấn luyện và một tệp Python nơi bạn sẽ thêm mã:

mkdir trainer

touch trainer/task.py

Bây giờ, bạn sẽ có những nội dung sau trong thư mục cassava/:

+ Dockerfile

+ trainer/

+ task.py

Tiếp theo, hãy mở tệp task.py bạn vừa tạo rồi sao chép đoạn mã bên dưới. Bạn cần thay thế {your-gcs-bucket} bằng tên của bộ chứa Cloud Storage mà bạn vừa tạo.

import tensorflow as tf

import tensorflow_datasets as tfds

import os

PER_REPLICA_BATCH_SIZE = 64

EPOCHS = 2

# TODO: replace {your-gcs-bucket} with the name of the Storage bucket you created earlier

BUCKET = 'gs://{your-gcs-bucket}/mwms'

def preprocess_data(image, label):

'''Resizes and scales images.'''

image = tf.image.resize(image, (300,300))

return tf.cast(image, tf.float32) / 255., label

def create_dataset(batch_size):

'''Loads Cassava dataset and preprocesses data.'''

data, info = tfds.load(name='cassava', as_supervised=True, with_info=True)

number_of_classes = info.features['label'].num_classes

train_data = data['train'].map(preprocess_data,

num_parallel_calls=tf.data.experimental.AUTOTUNE)

train_data = train_data.shuffle(1000)

train_data = train_data.batch(batch_size)

train_data = train_data.prefetch(tf.data.experimental.AUTOTUNE)

# Set AutoShardPolicy

options = tf.data.Options()

options.experimental_distribute.auto_shard_policy = tf.data.experimental.AutoShardPolicy.DATA

train_data = train_data.with_options(options)

return train_data, number_of_classes

def create_model(number_of_classes):

'''Creates and compiles pretrained ResNet50 model.'''

base_model = tf.keras.applications.ResNet50(weights='imagenet', include_top=False)

x = base_model.output

x = tf.keras.layers.GlobalAveragePooling2D()(x)

x = tf.keras.layers.Dense(1016, activation='relu')(x)

predictions = tf.keras.layers.Dense(number_of_classes, activation='softmax')(x)

model = tf.keras.Model(inputs=base_model.input, outputs=predictions)

model.compile(

loss='sparse_categorical_crossentropy',

optimizer=tf.keras.optimizers.Adam(0.0001),

metrics=['accuracy'])

return model

def _is_chief(task_type, task_id):

'''Helper function. Determines if machine is chief.'''

return task_type == 'chief'

def _get_temp_dir(dirpath, task_id):

'''Helper function. Gets temporary directory for saving model.'''

base_dirpath = 'workertemp_' + str(task_id)

temp_dir = os.path.join(dirpath, base_dirpath)

tf.io.gfile.makedirs(temp_dir)

return temp_dir

def write_filepath(filepath, task_type, task_id):

'''Helper function. Gets filepath to save model.'''

dirpath = os.path.dirname(filepath)

base = os.path.basename(filepath)

if not _is_chief(task_type, task_id):

dirpath = _get_temp_dir(dirpath, task_id)

return os.path.join(dirpath, base)

def main():

# Create strategy

strategy = tf.distribute.MultiWorkerMirroredStrategy()

# Get data

global_batch_size = PER_REPLICA_BATCH_SIZE * strategy.num_replicas_in_sync

train_data, number_of_classes = create_dataset(global_batch_size)

# Wrap variable creation within strategy scope

with strategy.scope():

model = create_model(number_of_classes)

model.fit(train_data, epochs=EPOCHS)

# Determine type and task of the machine from

# the strategy cluster resolver

task_type, task_id = (strategy.cluster_resolver.task_type,

strategy.cluster_resolver.task_id)

# Based on the type and task, write to the desired model path

write_model_path = write_filepath(BUCKET, task_type, task_id)

model.save(write_model_path)

if __name__ == "__main__":

main()

Trước khi tạo vùng chứa, hãy tìm hiểu kỹ hơn về mã sử dụng MultiWorkerMirroredStrategy qua API tf.distribute.Strategy.

Có một số thành phần trong mã cần thiết để mã của bạn hoạt động với MultiWorkerMirroredStrategy.

- Dữ liệu cần được phân đoạn, nghĩa là mỗi worker được chỉ định một tập hợp con của toàn bộ tập dữ liệu. Do đó, ở mỗi bước, mỗi worker sẽ xử lý kích thước lô chung của các phần tử tập dữ liệu không chồng chéo. Quá trình phân đoạn này sẽ tự động diễn ra với

tf.data.experimental.AutoShardPolicy(bạn có thể đặt thànhFILEhoặcDATA). Trong ví dụ này, hàmcreate_dataset()đặtAutoShardPolicythànhDATAvì tập dữ liệu sắn không được tải xuống dưới dạng nhiều tệp. Tuy nhiên, nếu bạn không đặt chính sách này thànhDATA, thì chính sáchAUTOmặc định sẽ có hiệu lực và kết quả cuối cùng vẫn như vậy. Bạn có thể tìm hiểu thêm về tính năng phân đoạn tập dữ liệu bằngMultiWorkerMirroredStrategytại đây. - Trong hàm

main(), đối tượngMultiWorkerMirroredStrategyđược tạo. Tiếp theo, bạn kết hợp việc tạo các biến mô hình trong phạm vi của chiến lược. Bước quan trọng này cho TensorFlow biết những biến nào cần được phản ánh trên các bản sao. - Kích thước lô được

num_replicas_in_synctăng tỷ lệ. Điều này đảm bảo rằng mỗi bản sao sẽ xử lý cùng một số lượng ví dụ trên mỗi bước. Việc điều chỉnh quy mô kích thước lô là một phương pháp hay nhất khi sử dụng chiến lược tính song song dữ liệu đồng bộ trong TensorFlow. - Việc lưu mô hình sẽ phức tạp hơn một chút trong trường hợp nhiều worker, vì đích đến cần phải khác nhau đối với mỗi worker. Worker chính sẽ lưu vào thư mục mô hình mong muốn, trong khi các worker khác sẽ lưu mô hình vào thư mục tạm thời. Điều quan trọng là các thư mục tạm thời này phải là duy nhất để ngăn nhiều worker ghi vào cùng một vị trí. Việc lưu có thể chứa các hoạt động tập thể, nghĩa là mọi nhân viên phải tiết kiệm chứ không chỉ người trưởng nhóm. Các hàm

_is_chief(),_get_temp_dir(),write_filepath()cũng như hàmmain()đều chứa mã nguyên mẫu giúp lưu mô hình.

Xin lưu ý rằng nếu đã sử dụng MultiWorkerMirroredStrategy trong một môi trường khác, thì bạn có thể đã thiết lập biến môi trường TF_CONFIG. Vertex AI tự động đặt TF_CONFIG cho bạn nên bạn không cần xác định biến này trên mỗi máy trong cụm.

Bước 4: Tạo vùng chứa

Trên Terminal, hãy chạy đoạn mã sau để xác định biến env cho dự án, nhớ thay thế your-cloud-project bằng mã nhận dạng của dự án:

PROJECT_ID='your-cloud-project'

Xác định một biến bằng URI của hình ảnh vùng chứa của bạn trong Google Container Registry:

IMAGE_URI="gcr.io/$PROJECT_ID/multiworker:cassava"

Định cấu hình Docker

gcloud auth configure-docker

Sau đó, hãy tạo vùng chứa bằng cách chạy lệnh sau từ gốc của thư mục cassava:

docker build ./ -t $IMAGE_URI

Cuối cùng, hãy đẩy địa chỉ email này đến Google Container Registry:

docker push $IMAGE_URI

Khi đã đẩy vùng chứa vào Container Registry, bạn đã sẵn sàng bắt đầu công việc huấn luyện.

6. Chạy chương trình đào tạo cho nhiều nhân viên trên Vertex AI

Phòng thí nghiệm này sử dụng chương trình huấn luyện tuỳ chỉnh thông qua một vùng chứa tuỳ chỉnh trên Google Container Registry, nhưng bạn cũng có thể chạy công việc huấn luyện với các vùng chứa dựng sẵn.

Để bắt đầu, hãy chuyển đến phần Đào tạo trong phần Vertex của Cloud Console:

Bước 1: Thiết lập công việc huấn luyện

Nhấp vào Tạo để nhập các thông số cho công việc đào tạo của bạn.

- Trong mục Tập dữ liệu, hãy chọn Không có tập dữ liệu được quản lý

- Sau đó, hãy chọn Đào tạo tuỳ chỉnh (nâng cao) làm phương pháp đào tạo của bạn rồi nhấp vào Tiếp tục.

- Nhập

multiworker-cassava(hoặc bất kỳ tên nào bạn muốn đặt cho mô hình) cho Tên mô hình - Nhấp vào Tiếp tục

Trong bước Cài đặt vùng chứa, hãy chọn Vùng chứa tuỳ chỉnh:

Trong hộp đầu tiên (Hình ảnh vùng chứa), hãy nhập giá trị của biến IMAGE_URI từ phần trước. Giá trị này phải là: gcr.io/your-cloud-project/multiworker:cassava, có mã dự án riêng của bạn. Để trống các trường còn lại rồi nhấp vào Tiếp tục.

Bỏ qua bước Hhyperparameters bằng cách nhấp lại vào Tiếp tục.

Bước 2: Định cấu hình cụm điện toán

Vertex AI cung cấp 4 nhóm worker để xử lý nhiều loại tác vụ trong máy.

Nhóm worker 0 định cấu hình Primary (Chính), chief (trình lập lịch biểu) hoặc "master" (chính). Trong MultiWorkerMirroredStrategy, tất cả máy đều được chỉ định là worker, tức là các máy thực tế thực thi phép tính được sao chép. Ngoài mỗi máy là một worker, bạn cần có một worker đảm nhận thêm một số công việc như lưu điểm kiểm tra và ghi tệp tóm tắt vào TensorBoard. Máy này được gọi là máy chính. Chỉ có một worker chính, vì vậy, số lượng worker của bạn cho nhóm worker 0 sẽ luôn là 1.

Trong phần Điện toán và định giá, hãy giữ nguyên khu vực đã chọn và định cấu hình Nhóm nhân viên 0 như sau:

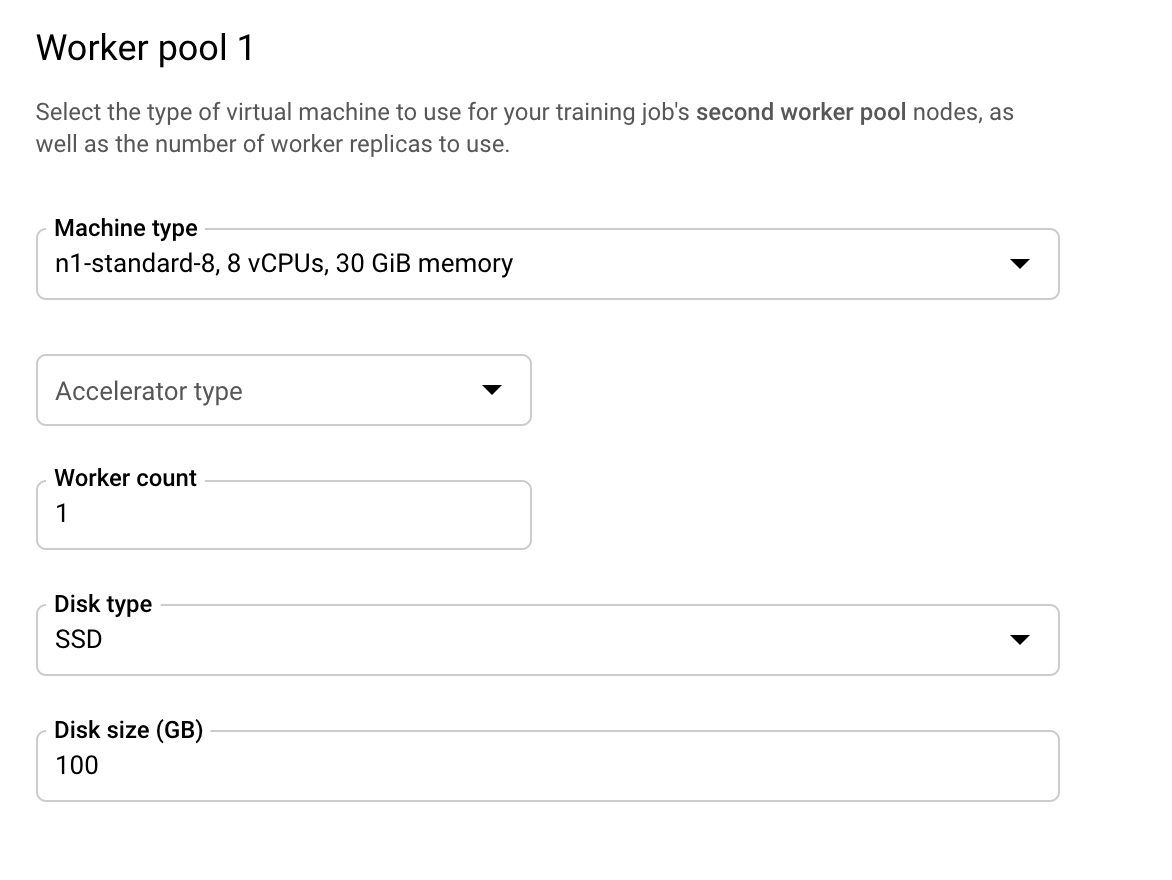

Nhóm Worker 1 là nơi bạn định cấu hình worker cho cụm của mình.

Định cấu hình Nhóm nhân viên 1 như sau:

Cụm hiện được định cấu hình để có hai máy chỉ có CPU. Khi chạy mã xử lý ứng dụng huấn luyện, MultiWorkerMirroredStrategy sẽ phân phối nội dung huấn luyện trên cả hai máy.

MultiWorkerMirroredStrategy chỉ có loại tác vụ chính và worker, vì vậy, bạn không cần định cấu hình Nhóm nhân viên khác. Tuy nhiên, nếu sử dụng ParameterServerStrategy của TensorFlow, bạn sẽ định cấu hình các máy chủ thông số trong nhóm nhân viên 2. Và nếu muốn thêm một trình đánh giá vào cụm, bạn sẽ định cấu hình máy đó trong nhóm worker 3.

Nhấp vào Start training (Bắt đầu huấn luyện) để bắt đầu công việc điều chỉnh tham số siêu dữ liệu. Trong phần Đào tạo của bảng điều khiển, trên thẻ QUY TRÌNH ĐÀO TẠO, bạn sẽ thấy công việc mới khởi chạy:

🎉 Xin chúc mừng! 🎉

Bạn đã tìm hiểu cách sử dụng Vertex AI để:

- Triển khai công việc đào tạo nhiều nhân viên cho đoạn mã đào tạo được cung cấp trong một vùng chứa tuỳ chỉnh. Bạn đã sử dụng mô hình TensorFlow trong ví dụ này, nhưng bạn có thể huấn luyện mô hình được tạo bằng bất kỳ khung nào bằng cách sử dụng vùng chứa tuỳ chỉnh hoặc tích hợp sẵn.

Để tìm hiểu thêm về các phần khác nhau của Vertex, hãy xem tài liệu này.

7. [Không bắt buộc] Sử dụng Vertex SDK

Phần trước đã trình bày cách bắt đầu công việc đào tạo thông qua giao diện người dùng. Trong phần này, bạn sẽ tìm hiểu một cách khác để gửi công việc huấn luyện là sử dụng Vertex Python API.

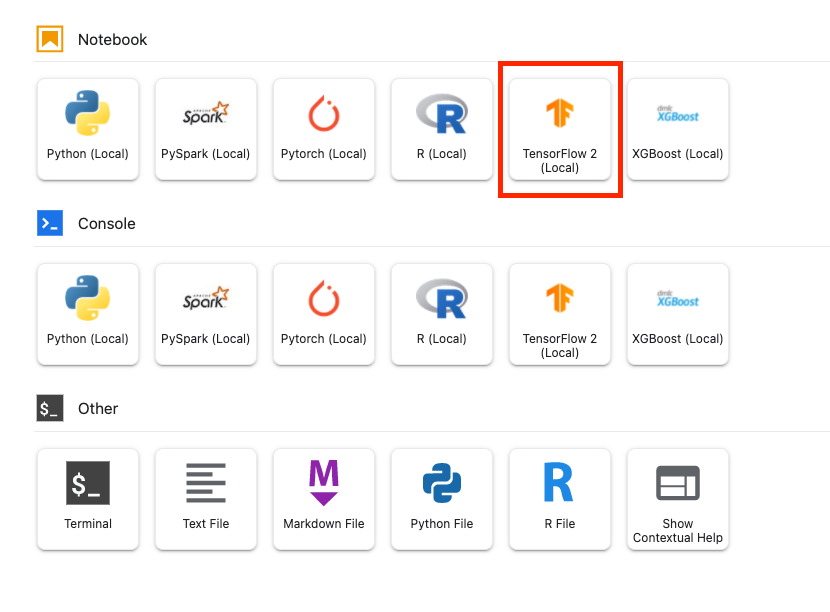

Quay lại thực thể sổ tay của bạn rồi tạo một sổ tay TensorFlow 2 trong Trình chạy:

Nhập Vertex AI SDK.

from google.cloud import aiplatform

Để bắt đầu công việc đào tạo nhiều nhân viên, trước tiên, bạn cần xác định thông số của nhóm nhân viên. Lưu ý rằng việc sử dụng GPU trong thông số kỹ thuật là hoàn toàn không bắt buộc và bạn có thể xoá accelerator_type và accelerator_count nếu muốn sử dụng cụm chỉ CPU như đã trình bày trong phần trước.

# The spec of the worker pools including machine type and Docker image

# Be sure to replace {YOUR-PROJECT-ID} with your project ID.

worker_pool_specs=[

{

"replica_count": 1,

"machine_spec": {

"machine_type": "n1-standard-8", "accelerator_type": "NVIDIA_TESLA_V100", "accelerator_count": 1

},

"container_spec": {"image_uri": "gcr.io/{YOUR-PROJECT-ID}/multiworker:cassava"}

},

{

"replica_count": 1,

"machine_spec": {

"machine_type": "n1-standard-8", "accelerator_type": "NVIDIA_TESLA_V100", "accelerator_count": 1

},

"container_spec": {"image_uri": "gcr.io/{YOUR-PROJECT-ID}/multiworker:cassava"}

}

]

Tiếp theo, hãy tạo và chạy CustomJob. Bạn cần thay thế {YOUR_BUCKET} bằng một bộ chứa trong dự án để chạy thử. Bạn có thể sử dụng cùng một bộ chứa mà bạn đã tạo trước đó.

# Replace YOUR_BUCKET

my_multiworker_job = aiplatform.CustomJob(display_name='multiworker-cassava-sdk',

worker_pool_specs=worker_pool_specs,

staging_bucket='gs://{YOUR_BUCKET}')

my_multiworker_job.run()

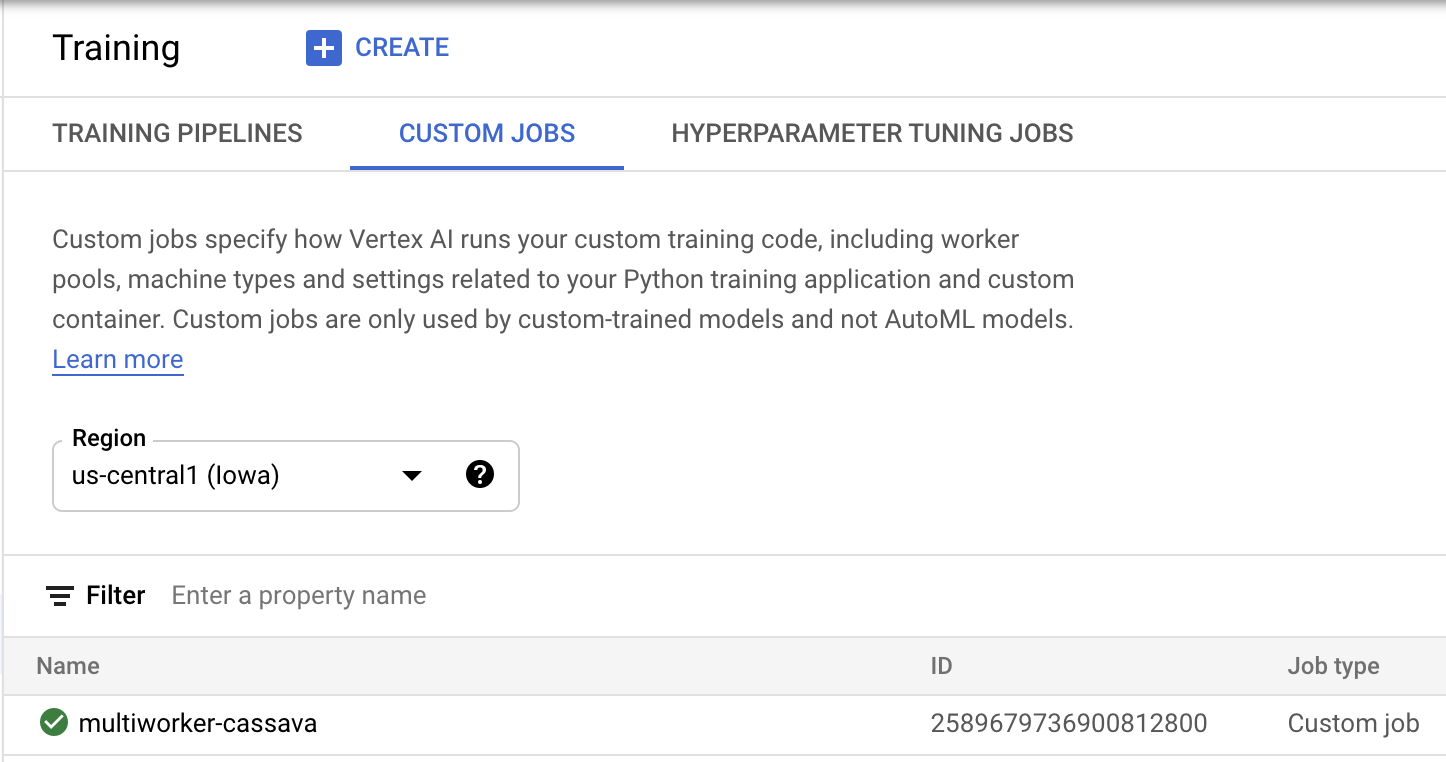

Trong phần Đào tạo trên bảng điều khiển, bên dưới thẻ CÔNG VIỆC TUỲ CHỈNH, bạn sẽ thấy công việc đào tạo của mình:

8. Dọn dẹp

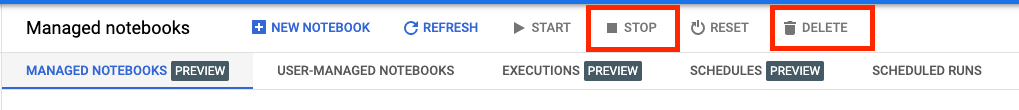

Vì đã định cấu hình sổ tay hết thời gian chờ sau 60 phút ở trạng thái rảnh, nên chúng ta không cần phải lo lắng về việc tắt thực thể. Nếu bạn muốn tắt thực thể theo cách thủ công, hãy nhấp vào nút Dừng trong phần Vertex AI Workbench (Bảng điều khiển Vertex AI) của bảng điều khiển. Nếu bạn muốn xoá hoàn toàn sổ tay, hãy nhấp vào nút Xoá.

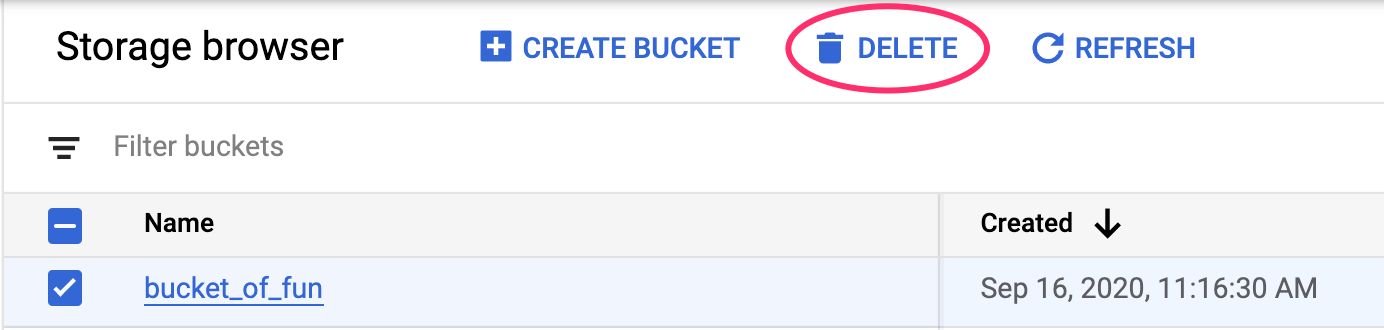

Để xoá Bộ chứa Storage, hãy sử dụng trình đơn Điều hướng trong Cloud Console, duyệt đến Bộ nhớ, chọn bộ chứa rồi nhấp vào Xoá: