1. Visão geral

A API Video Intelligence permite usar a tecnologia de análise de vídeo do Google como parte dos aplicativos.

Neste laboratório, você vai usar a API Video Intelligence com Python.

O que você vai aprender

- Como configurar o ambiente

- Como configurar o Python

- Como detectar mudanças na imagem

- Como detectar rótulos

- Como detectar conteúdo explícito

- Como transcrever falas

- Como detectar e rastrear textos

- Como detectar e rastrear objetos

- Como detectar e rastrear logotipos

O que é necessário

Pesquisa

Como você vai usar este tutorial?

Como você classificaria sua experiência com Python?

Como você classificaria sua experiência com os serviços do Google Cloud?

2. Configuração e requisitos

Configuração de ambiente autoguiada

- Faça login no Console do Google Cloud e crie um novo projeto ou reutilize um existente. Crie uma conta do Gmail ou do Google Workspace, se ainda não tiver uma.

- O Nome do projeto é o nome de exibição para os participantes do projeto. É uma string de caracteres não usada pelas APIs do Google e pode ser atualizada quando você quiser.

- O ID do projeto precisa ser exclusivo em todos os projetos do Google Cloud e não pode ser mudado após a definição. O console do Cloud gera automaticamente uma string exclusiva. Em geral, não importa o que seja. Na maioria dos codelabs, é necessário fazer referência ao ID do projeto, normalmente identificado como

PROJECT_ID. Se você não gostar do ID gerado, crie outro aleatório. Se preferir, teste o seu e confira se ele está disponível. Ele não pode ser mudado após essa etapa e permanece durante o projeto. - Para sua informação, há um terceiro valor, um Número do projeto, que algumas APIs usam. Saiba mais sobre esses três valores na documentação.

- Em seguida, ative o faturamento no console do Cloud para usar os recursos/APIs do Cloud. A execução deste codelab não vai ser muito cara, se tiver algum custo. Para encerrar os recursos e evitar cobranças além deste tutorial, exclua os recursos criados ou exclua o projeto. Novos usuários do Google Cloud estão qualificados para o programa de US$ 300 de avaliação sem custos.

Inicie o Cloud Shell

Embora o Google Cloud possa ser operado remotamente em um laptop, neste codelab você vai usar o Cloud Shell, um ambiente de linha de comando executado no Cloud.

Ativar o Cloud Shell

- No Console do Cloud, clique em Ativar o Cloud Shell

.

.

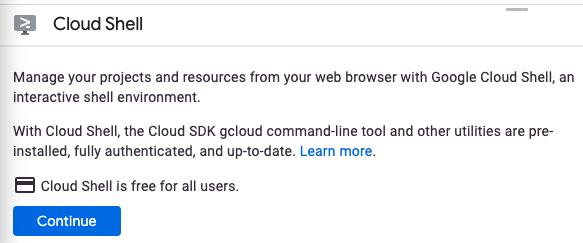

Se você estiver iniciando o Cloud Shell pela primeira vez, verá uma tela intermediária com a descrição dele. Se aparecer uma tela intermediária, clique em Continuar.

Leva apenas alguns instantes para provisionar e se conectar ao Cloud Shell.

Essa máquina virtual tem todas as ferramentas de desenvolvimento necessárias. Ela oferece um diretório principal persistente de 5 GB, além de ser executada no Google Cloud. Isso aprimora o desempenho e a autenticação da rede. Grande parte do trabalho neste codelab, se não todo, pode ser feito em um navegador.

Depois de se conectar ao Cloud Shell, você verá sua autenticação e o projeto estará configurado com o ID do seu projeto.

- Execute o seguinte comando no Cloud Shell para confirmar se a conta está autenticada:

gcloud auth list

Resposta ao comando

Credentialed Accounts

ACTIVE ACCOUNT

* <my_account>@<my_domain.com>

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- Execute o seguinte comando no Cloud Shell para confirmar que o comando gcloud sabe sobre seu projeto:

gcloud config list project

Resposta ao comando

[core] project = <PROJECT_ID>

Se o projeto não estiver configurado, configure-o usando este comando:

gcloud config set project <PROJECT_ID>

Resposta ao comando

Updated property [core/project].

3. Configuração do ambiente

Antes de usar a API Video Intelligence, execute o seguinte comando no Cloud Shell para ativá-la:

gcloud services enable videointelligence.googleapis.com

Você verá algo como:

Operation "operations/..." finished successfully.

Agora você pode usar a API Video Intelligence.

Navegue até seu diretório principal:

cd ~

Crie um ambiente virtual de Python para isolar as dependências:

virtualenv venv-videointel

Ative o ambiente virtual:

source venv-videointel/bin/activate

Instale o IPython e a biblioteca de cliente da API Video Intelligence:

pip install ipython google-cloud-videointelligence

Você verá algo como:

... Installing collected packages: ..., ipython, google-cloud-videointelligence Successfully installed ... google-cloud-videointelligence-2.11.0 ...

Agora você está pronto para usar a biblioteca de cliente da API Video Intelligence.

Nas próximas etapas, você vai usar um interpretador de Python interativo chamado IPython, que foi instalado na etapa anterior. Inicie uma sessão executando ipython no Cloud Shell:

ipython

Você verá algo como:

Python 3.9.2 (default, Feb 28 2021, 17:03:44) Type 'copyright', 'credits' or 'license' for more information IPython 8.12.0 -- An enhanced Interactive Python. Type '?' for help. In [1]:

4. Vídeo de amostra

É possível usar a API Video Intelligence para anotar vídeos armazenados no Cloud Storage ou fornecidos como bytes de dados.

Nas próximas etapas, você vai usar um vídeo de amostra armazenado no Cloud Storage. Você pode visualizar o vídeo no seu navegador.

Preparar, apontar, fogo!

5. Detecta mudanças no quadro

A API Video Intelligence pode ser usada para detectar mudanças na imagem de um vídeo. Uma tomada é um trecho do vídeo, uma série de frames com continuidade visual.

Copie o código a seguir na sessão do IPython:

from typing import cast

from google.cloud import videointelligence_v1 as vi

def detect_shot_changes(video_uri: str) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.SHOT_CHANGE_DETECTION]

request = vi.AnnotateVideoRequest(input_uri=video_uri, features=features)

print(f'Processing video: "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Reserve um momento para estudar o código e ver como ele usa o método da biblioteca de cliente annotate_video com o parâmetro SHOT_CHANGE_DETECTION para analisar um vídeo e detectar mudanças na imagem.

Chame a função para analisar o vídeo:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

results = detect_shot_changes(video_uri)

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para imprimir as imagens do vídeo:

def print_video_shots(results: vi.VideoAnnotationResults):

shots = results.shot_annotations

print(f" Video shots: {len(shots)} ".center(40, "-"))

for i, shot in enumerate(shots):

t1 = shot.start_time_offset.total_seconds()

t2 = shot.end_time_offset.total_seconds()

print(f"{i+1:>3} | {t1:7.3f} | {t2:7.3f}")

Como chamar a função:

print_video_shots(results)

Você verá algo como:

----------- Video shots: 34 ------------ 1 | 0.000 | 12.880 2 | 12.920 | 21.680 3 | 21.720 | 27.880 ... 32 | 135.160 | 138.320 33 | 138.360 | 146.200 34 | 146.240 | 162.520

Se você extrair o quadro do meio de cada tomada e organizá-los em um quadro, é possível gerar um resumo visual do vídeo:

Resumo

Nesta etapa, você conseguiu realizar a detecção de alteração de imagem em um vídeo usando a API Video Intelligence. Saiba mais sobre como detectar mudanças na imagem.

6. Detectar rótulos

É possível usar a API Video Intelligence para detectar rótulos em um vídeo. Os rótulos descrevem o vídeo com base no conteúdo visual dele.

Copie o código a seguir na sessão do IPython:

from datetime import timedelta

from typing import Optional, Sequence, cast

from google.cloud import videointelligence_v1 as vi

def detect_labels(

video_uri: str,

mode: vi.LabelDetectionMode,

segments: Optional[Sequence[vi.VideoSegment]] = None,

) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.LABEL_DETECTION]

config = vi.LabelDetectionConfig(label_detection_mode=mode)

context = vi.VideoContext(segments=segments, label_detection_config=config)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

print(f'Processing video "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Reserve um momento para estudar o código e ver como ele usa o método da biblioteca de cliente annotate_video com o parâmetro LABEL_DETECTION para analisar um vídeo e detectar rótulos.

Chame a função para analisar os primeiros 37 segundos do vídeo:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

mode = vi.LabelDetectionMode.SHOT_MODE

segment = vi.VideoSegment(

start_time_offset=timedelta(seconds=0),

end_time_offset=timedelta(seconds=37),

)

results = detect_labels(video_uri, mode, [segment])

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para exibir os rótulos no nível do vídeo:

def print_video_labels(results: vi.VideoAnnotationResults):

labels = sorted_by_first_segment_confidence(results.segment_label_annotations)

print(f" Video labels: {len(labels)} ".center(80, "-"))

for label in labels:

categories = category_entities_to_str(label.category_entities)

for segment in label.segments:

confidence = segment.confidence

t1 = segment.segment.start_time_offset.total_seconds()

t2 = segment.segment.end_time_offset.total_seconds()

print(

f"{confidence:4.0%}",

f"{t1:7.3f}",

f"{t2:7.3f}",

f"{label.entity.description}{categories}",

sep=" | ",

)

def sorted_by_first_segment_confidence(

labels: Sequence[vi.LabelAnnotation],

) -> Sequence[vi.LabelAnnotation]:

def first_segment_confidence(label: vi.LabelAnnotation) -> float:

return label.segments[0].confidence

return sorted(labels, key=first_segment_confidence, reverse=True)

def category_entities_to_str(category_entities: Sequence[vi.Entity]) -> str:

if not category_entities:

return ""

entities = ", ".join([e.description for e in category_entities])

return f" ({entities})"

Como chamar a função:

print_video_labels(results)

Você verá algo como:

------------------------------- Video labels: 10 ------------------------------- 96% | 0.000 | 36.960 | nature 74% | 0.000 | 36.960 | vegetation 59% | 0.000 | 36.960 | tree (plant) 56% | 0.000 | 36.960 | forest (geographical feature) 49% | 0.000 | 36.960 | leaf (plant) 43% | 0.000 | 36.960 | flora (plant) 38% | 0.000 | 36.960 | nature reserve (geographical feature) 38% | 0.000 | 36.960 | woodland (forest) 35% | 0.000 | 36.960 | water resources (water) 32% | 0.000 | 36.960 | sunlight (light)

Graças a esses rótulos no nível do vídeo, é possível entender que o início do vídeo é principalmente sobre natureza e vegetação.

Adicione esta função para imprimir os rótulos no nível da tomada:

def print_shot_labels(results: vi.VideoAnnotationResults):

labels = sorted_by_first_segment_start_and_confidence(

results.shot_label_annotations

)

print(f" Shot labels: {len(labels)} ".center(80, "-"))

for label in labels:

categories = category_entities_to_str(label.category_entities)

print(f"{label.entity.description}{categories}")

for segment in label.segments:

confidence = segment.confidence

t1 = segment.segment.start_time_offset.total_seconds()

t2 = segment.segment.end_time_offset.total_seconds()

print(f"{confidence:4.0%} | {t1:7.3f} | {t2:7.3f}")

def sorted_by_first_segment_start_and_confidence(

labels: Sequence[vi.LabelAnnotation],

) -> Sequence[vi.LabelAnnotation]:

def first_segment_start_and_confidence(label: vi.LabelAnnotation):

first_segment = label.segments[0]

ms = first_segment.segment.start_time_offset.total_seconds()

return (ms, -first_segment.confidence)

return sorted(labels, key=first_segment_start_and_confidence)

Como chamar a função:

print_shot_labels(results)

Você verá algo como:

------------------------------- Shot labels: 29 -------------------------------- planet (astronomical object) 83% | 0.000 | 12.880 earth (planet) 53% | 0.000 | 12.880 water resources (water) 43% | 0.000 | 12.880 aerial photography (photography) 43% | 0.000 | 12.880 vegetation 32% | 0.000 | 12.880 92% | 12.920 | 21.680 83% | 21.720 | 27.880 77% | 27.920 | 31.800 76% | 31.840 | 34.720 ... butterfly (insect, animal) 84% | 34.760 | 36.960 ...

Graças a esses rótulos no nível da tomada, é possível entender que o vídeo começa com uma imagem de um planeta (provavelmente a Terra), que há uma borboleta na cena 34.760-36.960s...

Resumo

Nesta etapa, você conseguiu realizar a detecção de rótulos em um vídeo usando a API Video Intelligence. Leia mais sobre como detectar rótulos.

7. Detecte conteúdo explícito

A API Video Intelligence pode ser usada para detectar conteúdo explícito em um vídeo. Conteúdo explícito é um conteúdo adulto geralmente impróprio para menores de 18 anos e inclui, entre outros, nudez, atividades sexuais e pornografia. A detecção é realizada com base apenas em sinais visuais por frame (o áudio não é usado). A resposta inclui valores de probabilidade que variam de VERY_UNLIKELY a VERY_LIKELY.

Copie o código a seguir na sessão do IPython:

from datetime import timedelta

from typing import Optional, Sequence, cast

from google.cloud import videointelligence_v1 as vi

def detect_explicit_content(

video_uri: str,

segments: Optional[Sequence[vi.VideoSegment]] = None,

) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.EXPLICIT_CONTENT_DETECTION]

context = vi.VideoContext(segments=segments)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

print(f'Processing video "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Estude o código e veja como ele usa o método da biblioteca de cliente annotate_video com o parâmetro EXPLICIT_CONTENT_DETECTION para analisar um vídeo e detectar conteúdo explícito.

Chame a função para analisar os primeiros 10 segundos do vídeo:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

segment = vi.VideoSegment(

start_time_offset=timedelta(seconds=0),

end_time_offset=timedelta(seconds=10),

)

results = detect_explicit_content(video_uri, [segment])

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para exibir as diferentes contagens de probabilidade:

def print_explicit_content(results: vi.VideoAnnotationResults):

from collections import Counter

frames = results.explicit_annotation.frames

likelihood_counts = Counter([f.pornography_likelihood for f in frames])

print(f" Explicit content frames: {len(frames)} ".center(40, "-"))

for likelihood in vi.Likelihood:

print(f"{likelihood.name:<22}: {likelihood_counts[likelihood]:>3}")

Como chamar a função:

print_explicit_content(results)

Você verá algo como:

----- Explicit content frames: 10 ------ LIKELIHOOD_UNSPECIFIED: 0 VERY_UNLIKELY : 10 UNLIKELY : 0 POSSIBLE : 0 LIKELY : 0 VERY_LIKELY : 0

Adicione esta função para mostrar os detalhes do frame:

def print_frames(results: vi.VideoAnnotationResults, likelihood: vi.Likelihood):

frames = results.explicit_annotation.frames

frames = [f for f in frames if f.pornography_likelihood == likelihood]

print(f" {likelihood.name} frames: {len(frames)} ".center(40, "-"))

for frame in frames:

print(frame.time_offset)

Como chamar a função:

print_frames(results, vi.Likelihood.VERY_UNLIKELY)

Você verá algo como:

------- VERY_UNLIKELY frames: 10 ------- 0:00:00.365992 0:00:01.279206 0:00:02.268336 0:00:03.289253 0:00:04.400163 0:00:05.291547 0:00:06.449558 0:00:07.452751 0:00:08.577405 0:00:09.554514

Resumo

Nesta etapa, você conseguiu realizar a detecção de conteúdo explícito em um vídeo usando a API Video Intelligence. Saiba mais sobre como detectar conteúdo explícito.

8. Transcrever fala

É possível usar a API Video Intelligence para transcrever falas em vídeo em texto.

Copie o código a seguir na sessão do IPython:

from datetime import timedelta

from typing import Optional, Sequence, cast

from google.cloud import videointelligence_v1 as vi

def transcribe_speech(

video_uri: str,

language_code: str,

segments: Optional[Sequence[vi.VideoSegment]] = None,

) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.SPEECH_TRANSCRIPTION]

config = vi.SpeechTranscriptionConfig(

language_code=language_code,

enable_automatic_punctuation=True,

)

context = vi.VideoContext(

segments=segments,

speech_transcription_config=config,

)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

print(f'Processing video "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Estude o código e veja como ele usa o método da biblioteca de cliente annotate_video com o parâmetro SPEECH_TRANSCRIPTION para analisar um vídeo e transcrever fala.

Chame a função para analisar o vídeo dos segundos 55 a 80:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

language_code = "en-GB"

segment = vi.VideoSegment(

start_time_offset=timedelta(seconds=55),

end_time_offset=timedelta(seconds=80),

)

results = transcribe_speech(video_uri, language_code, [segment])

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para imprimir a fala transcrita:

def print_video_speech(results: vi.VideoAnnotationResults, min_confidence: float = 0.8):

def keep_transcription(transcription: vi.SpeechTranscription) -> bool:

return min_confidence <= transcription.alternatives[0].confidence

transcriptions = results.speech_transcriptions

transcriptions = [t for t in transcriptions if keep_transcription(t)]

print(f" Speech transcriptions: {len(transcriptions)} ".center(80, "-"))

for transcription in transcriptions:

first_alternative = transcription.alternatives[0]

confidence = first_alternative.confidence

transcript = first_alternative.transcript

print(f" {confidence:4.0%} | {transcript.strip()}")

Como chamar a função:

print_video_speech(results)

Você verá algo como:

--------------------------- Speech transcriptions: 2 --------------------------- 91% | I was keenly aware of secret movements in the trees. 92% | I looked into his large and lustrous eyes. They seem somehow to express his entire personality.

Adicione esta função para exibir a lista de palavras detectadas e os carimbos de data/hora delas:

def print_word_timestamps(

results: vi.VideoAnnotationResults,

min_confidence: float = 0.8,

):

def keep_transcription(transcription: vi.SpeechTranscription) -> bool:

return min_confidence <= transcription.alternatives[0].confidence

transcriptions = results.speech_transcriptions

transcriptions = [t for t in transcriptions if keep_transcription(t)]

print(" Word timestamps ".center(80, "-"))

for transcription in transcriptions:

first_alternative = transcription.alternatives[0]

confidence = first_alternative.confidence

for word in first_alternative.words:

t1 = word.start_time.total_seconds()

t2 = word.end_time.total_seconds()

word = word.word

print(f"{confidence:4.0%} | {t1:7.3f} | {t2:7.3f} | {word}")

Como chamar a função:

print_word_timestamps(results)

Você verá algo como:

------------------------------- Word timestamps -------------------------------- 93% | 55.000 | 55.700 | I 93% | 55.700 | 55.900 | was 93% | 55.900 | 56.300 | keenly 93% | 56.300 | 56.700 | aware 93% | 56.700 | 56.900 | of ... 94% | 76.900 | 77.400 | express 94% | 77.400 | 77.600 | his 94% | 77.600 | 78.200 | entire 94% | 78.200 | 78.500 | personality.

Resumo

Nesta etapa, você realizou a transcrição de fala em um vídeo usando a API Video Intelligence. Saiba mais sobre a transcrição de áudio.

9. Detectar e rastrear texto

É possível usar a API Video Intelligence para detectar e rastrear texto em um vídeo.

Copie o código a seguir na sessão do IPython:

from datetime import timedelta

from typing import Optional, Sequence, cast

from google.cloud import videointelligence_v1 as vi

def detect_text(

video_uri: str,

language_hints: Optional[Sequence[str]] = None,

segments: Optional[Sequence[vi.VideoSegment]] = None,

) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.TEXT_DETECTION]

config = vi.TextDetectionConfig(

language_hints=language_hints,

)

context = vi.VideoContext(

segments=segments,

text_detection_config=config,

)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

print(f'Processing video "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Estude o código e confira como ele usa o método da biblioteca de cliente annotate_video com o parâmetro TEXT_DETECTION para analisar um vídeo e detectar texto.

Chame a função para analisar o vídeo dos segundos 13 a 27:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

segment = vi.VideoSegment(

start_time_offset=timedelta(seconds=13),

end_time_offset=timedelta(seconds=27),

)

results = detect_text(video_uri, segments=[segment])

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para imprimir o texto detectado:

def print_video_text(results: vi.VideoAnnotationResults, min_frames: int = 15):

annotations = sorted_by_first_segment_end(results.text_annotations)

print(" Detected text ".center(80, "-"))

for annotation in annotations:

for text_segment in annotation.segments:

frames = len(text_segment.frames)

if frames < min_frames:

continue

text = annotation.text

confidence = text_segment.confidence

start = text_segment.segment.start_time_offset

seconds = segment_seconds(text_segment.segment)

print(text)

print(f" {confidence:4.0%} | {start} + {seconds:.1f}s | {frames} fr.")

def sorted_by_first_segment_end(

annotations: Sequence[vi.TextAnnotation],

) -> Sequence[vi.TextAnnotation]:

def first_segment_end(annotation: vi.TextAnnotation) -> int:

return annotation.segments[0].segment.end_time_offset.total_seconds()

return sorted(annotations, key=first_segment_end)

def segment_seconds(segment: vi.VideoSegment) -> float:

t1 = segment.start_time_offset.total_seconds()

t2 = segment.end_time_offset.total_seconds()

return t2 - t1

Como chamar a função:

print_video_text(results)

Você verá algo como:

-------------------------------- Detected text --------------------------------- GOMBE NATIONAL PARK 99% | 0:00:15.760000 + 1.7s | 15 fr. TANZANIA 100% | 0:00:15.760000 + 4.8s | 39 fr. With words and narration by 100% | 0:00:23.200000 + 3.6s | 31 fr. Jane Goodall 99% | 0:00:23.080000 + 3.8s | 33 fr.

Adicione essa função para imprimir a lista de frames de texto e caixas delimitadoras detectados:

def print_text_frames(results: vi.VideoAnnotationResults, contained_text: str):

# Vertex order: top-left, top-right, bottom-right, bottom-left

def box_top_left(box: vi.NormalizedBoundingPoly) -> str:

tl = box.vertices[0]

return f"({tl.x:.5f}, {tl.y:.5f})"

def box_bottom_right(box: vi.NormalizedBoundingPoly) -> str:

br = box.vertices[2]

return f"({br.x:.5f}, {br.y:.5f})"

annotations = results.text_annotations

annotations = [a for a in annotations if contained_text in a.text]

for annotation in annotations:

print(f" {annotation.text} ".center(80, "-"))

for text_segment in annotation.segments:

for frame in text_segment.frames:

frame_ms = frame.time_offset.total_seconds()

box = frame.rotated_bounding_box

print(

f"{frame_ms:>7.3f}",

box_top_left(box),

box_bottom_right(box),

sep=" | ",

)

Chame a função para verificar quais frames mostram o nome do narrador:

contained_text = "Goodall"

print_text_frames(results, contained_text)

Você verá algo como:

--------------------------------- Jane Goodall --------------------------------- 23.080 | (0.39922, 0.49861) | (0.62752, 0.55888) 23.200 | (0.38750, 0.49028) | (0.62692, 0.56306) ... 26.800 | (0.36016, 0.49583) | (0.61094, 0.56048) 26.920 | (0.45859, 0.49583) | (0.60365, 0.56174)

Se você desenhar as caixas delimitadoras na parte superior dos frames correspondentes, o resultado será:

Resumo

Nesta etapa, você conseguiu realizar a detecção e o rastreamento de texto em um vídeo usando a API Video Intelligence. Saiba mais sobre como detectar e acompanhar textos.

10. Detecta e rastreia objetos

É possível usar a API Video Intelligence para detectar e rastrear objetos em um vídeo.

Copie o código a seguir na sessão do IPython:

from datetime import timedelta

from typing import Optional, Sequence, cast

from google.cloud import videointelligence_v1 as vi

def track_objects(

video_uri: str, segments: Optional[Sequence[vi.VideoSegment]] = None

) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.OBJECT_TRACKING]

context = vi.VideoContext(segments=segments)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

print(f'Processing video "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Reserve um momento para estudar o código e ver como ele usa o método da biblioteca de cliente annotate_video com o parâmetro OBJECT_TRACKING para analisar um vídeo e detectar objetos.

Chame a função para analisar o vídeo dos segundos 98 a 112:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

segment = vi.VideoSegment(

start_time_offset=timedelta(seconds=98),

end_time_offset=timedelta(seconds=112),

)

results = track_objects(video_uri, [segment])

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para exibir a lista de objetos detectados:

def print_detected_objects(

results: vi.VideoAnnotationResults,

min_confidence: float = 0.7,

):

annotations = results.object_annotations

annotations = [a for a in annotations if min_confidence <= a.confidence]

print(

f" Detected objects: {len(annotations)}"

f" ({min_confidence:.0%} <= confidence) ".center(80, "-")

)

for annotation in annotations:

entity = annotation.entity

description = entity.description

entity_id = entity.entity_id

confidence = annotation.confidence

t1 = annotation.segment.start_time_offset.total_seconds()

t2 = annotation.segment.end_time_offset.total_seconds()

frames = len(annotation.frames)

print(

f"{description:<22}",

f"{entity_id:<10}",

f"{confidence:4.0%}",

f"{t1:>7.3f}",

f"{t2:>7.3f}",

f"{frames:>2} fr.",

sep=" | ",

)

Como chamar a função:

print_detected_objects(results)

Você verá algo como:

------------------- Detected objects: 3 (70% <= confidence) -------------------- insect | /m/03vt0 | 87% | 98.840 | 101.720 | 25 fr. insect | /m/03vt0 | 71% | 108.440 | 111.080 | 23 fr. butterfly | /m/0cyf8 | 91% | 111.200 | 111.920 | 7 fr.

Adicione esta função para imprimir a lista de frames de objetos detectados e caixas delimitadoras:

def print_object_frames(

results: vi.VideoAnnotationResults,

entity_id: str,

min_confidence: float = 0.7,

):

def keep_annotation(annotation: vi.ObjectTrackingAnnotation) -> bool:

return (

annotation.entity.entity_id == entity_id

and min_confidence <= annotation.confidence

)

annotations = results.object_annotations

annotations = [a for a in annotations if keep_annotation(a)]

for annotation in annotations:

description = annotation.entity.description

confidence = annotation.confidence

print(

f" {description},"

f" confidence: {confidence:.0%},"

f" frames: {len(annotation.frames)} ".center(80, "-")

)

for frame in annotation.frames:

t = frame.time_offset.total_seconds()

box = frame.normalized_bounding_box

print(

f"{t:>7.3f}",

f"({box.left:.5f}, {box.top:.5f})",

f"({box.right:.5f}, {box.bottom:.5f})",

sep=" | ",

)

Chame a função com o ID de entidade para insetos:

insect_entity_id = "/m/03vt0"

print_object_frames(results, insect_entity_id)

Você verá algo como:

--------------------- insect, confidence: 87%, frames: 25 ---------------------- 98.840 | (0.49327, 0.19617) | (0.69905, 0.69633) 98.960 | (0.49559, 0.19308) | (0.70631, 0.69671) ... 101.600 | (0.46668, 0.19776) | (0.76619, 0.69371) 101.720 | (0.46805, 0.20053) | (0.76447, 0.68703) --------------------- insect, confidence: 71%, frames: 23 ---------------------- 108.440 | (0.47343, 0.10694) | (0.63821, 0.98332) 108.560 | (0.46960, 0.10206) | (0.63033, 0.98285) ... 110.960 | (0.49466, 0.05102) | (0.65941, 0.99357) 111.080 | (0.49572, 0.04728) | (0.65762, 0.99868)

Se você desenhar as caixas delimitadoras na parte superior dos frames correspondentes, o resultado será:

Resumo

Nesta etapa, você conseguiu detectar e rastrear objetos em um vídeo usando a API Video Intelligence. Saiba mais sobre como detectar e rastrear objetos.

11. Detectar e rastrear logotipos

É possível usar a API Video Intelligence para detectar e rastrear logotipos em um vídeo. Mais de 100.000 marcas e logotipos podem ser detectados.

Copie o código a seguir na sessão do IPython:

from datetime import timedelta

from typing import Optional, Sequence, cast

from google.cloud import videointelligence_v1 as vi

def detect_logos(

video_uri: str, segments: Optional[Sequence[vi.VideoSegment]] = None

) -> vi.VideoAnnotationResults:

video_client = vi.VideoIntelligenceServiceClient()

features = [vi.Feature.LOGO_RECOGNITION]

context = vi.VideoContext(segments=segments)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

print(f'Processing video "{video_uri}"...')

operation = video_client.annotate_video(request)

# Wait for operation to complete

response = cast(vi.AnnotateVideoResponse, operation.result())

# A single video is processed

results = response.annotation_results[0]

return results

Estude o código e veja como ele usa o método da biblioteca de cliente annotate_video com o parâmetro LOGO_RECOGNITION para analisar um vídeo e detectar logotipos.

Chame a função para analisar a penúltima sequência do vídeo:

video_uri = "gs://cloud-samples-data/video/JaneGoodall.mp4"

segment = vi.VideoSegment(

start_time_offset=timedelta(seconds=146),

end_time_offset=timedelta(seconds=156),

)

results = detect_logos(video_uri, [segment])

Aguarde o processamento do vídeo:

Processing video: "gs://cloud-samples-data/video/JaneGoodall.mp4"...

Adicione esta função para exibir a lista de logotipos detectados:

def print_detected_logos(results: vi.VideoAnnotationResults):

annotations = results.logo_recognition_annotations

print(f" Detected logos: {len(annotations)} ".center(80, "-"))

for annotation in annotations:

entity = annotation.entity

entity_id = entity.entity_id

description = entity.description

for track in annotation.tracks:

confidence = track.confidence

t1 = track.segment.start_time_offset.total_seconds()

t2 = track.segment.end_time_offset.total_seconds()

logo_frames = len(track.timestamped_objects)

print(

f"{confidence:4.0%}",

f"{t1:>7.3f}",

f"{t2:>7.3f}",

f"{logo_frames:>3} fr.",

f"{entity_id:<15}",

f"{description}",

sep=" | ",

)

Como chamar a função:

print_detected_logos(results)

Você verá algo como:

------------------------------ Detected logos: 1 ------------------------------- 92% | 150.680 | 155.720 | 43 fr. | /m/055t58 | Google Maps

Adicione essa função para imprimir a lista de frames de logotipo e caixas delimitadoras detectados:

def print_logo_frames(results: vi.VideoAnnotationResults, entity_id: str):

def keep_annotation(annotation: vi.LogoRecognitionAnnotation) -> bool:

return annotation.entity.entity_id == entity_id

annotations = results.logo_recognition_annotations

annotations = [a for a in annotations if keep_annotation(a)]

for annotation in annotations:

description = annotation.entity.description

for track in annotation.tracks:

confidence = track.confidence

print(

f" {description},"

f" confidence: {confidence:.0%},"

f" frames: {len(track.timestamped_objects)} ".center(80, "-")

)

for timestamped_object in track.timestamped_objects:

t = timestamped_object.time_offset.total_seconds()

box = timestamped_object.normalized_bounding_box

print(

f"{t:>7.3f}",

f"({box.left:.5f}, {box.top:.5f})",

f"({box.right:.5f}, {box.bottom:.5f})",

sep=" | ",

)

Chame a função com o ID de entidade do logotipo do Google Maps:

maps_entity_id = "/m/055t58"

print_logo_frames(results, maps_entity_id)

Você verá algo como:

------------------- Google Maps, confidence: 92%, frames: 43 ------------------- 150.680 | (0.42024, 0.28633) | (0.58192, 0.64220) 150.800 | (0.41713, 0.27822) | (0.58318, 0.63556) ... 155.600 | (0.41775, 0.27701) | (0.58372, 0.63986) 155.720 | (0.41688, 0.28005) | (0.58335, 0.63954)

Se você desenhar as caixas delimitadoras na parte superior dos frames correspondentes, o resultado será:

Resumo

Nesta etapa, você realizou a detecção e o rastreamento de logotipos em um vídeo usando a API Video Intelligence. Saiba mais sobre como detectar e acompanhar logotipos.

12. Detectar vários recursos

Aqui está o tipo de solicitação que você pode fazer para receber todos os insights de uma só vez:

from google.cloud import videointelligence_v1 as vi

video_client = vi.VideoIntelligenceServiceClient()

video_uri = "gs://..."

features = [

vi.Feature.SHOT_CHANGE_DETECTION,

vi.Feature.LABEL_DETECTION,

vi.Feature.EXPLICIT_CONTENT_DETECTION,

vi.Feature.SPEECH_TRANSCRIPTION,

vi.Feature.TEXT_DETECTION,

vi.Feature.OBJECT_TRACKING,

vi.Feature.LOGO_RECOGNITION,

vi.Feature.FACE_DETECTION, # NEW

vi.Feature.PERSON_DETECTION, # NEW

]

context = vi.VideoContext(

segments=...,

shot_change_detection_config=...,

label_detection_config=...,

explicit_content_detection_config=...,

speech_transcription_config=...,

text_detection_config=...,

object_tracking_config=...,

face_detection_config=..., # NEW

person_detection_config=..., # NEW

)

request = vi.AnnotateVideoRequest(

input_uri=video_uri,

features=features,

video_context=context,

)

# video_client.annotate_video(request)

13. Parabéns!

Você aprendeu a usar a API Video Intelligence com Python.

Limpar

Para limpar seu ambiente de desenvolvimento, faça o seguinte no Cloud Shell:

- Se você ainda estiver na sessão do IPython, volte para o shell:

exit - Pare de usar o ambiente virtual do Python:

deactivate - Exclua a pasta do ambiente virtual:

cd ~ ; rm -rf ./venv-videointel

Para excluir seu projeto do Google Cloud usando o Cloud Shell:

- Recupere seu ID do projeto atual:

PROJECT_ID=$(gcloud config get-value core/project) - Verifique se este é o projeto que você quer excluir:

echo $PROJECT_ID - Exclua o projeto:

gcloud projects delete $PROJECT_ID

Saiba mais

- Teste a demonstração no navegador: https://zackakil.github.io/video-intelligence-api-visualiser

- Documentação da Video Intelligence: https://cloud.google.com/video-intelligence/docs

- Recursos Beta: https://cloud.google.com/video-intelligence/docs/beta

- Python no Google Cloud: https://cloud.google.com/python

- Bibliotecas de cliente do Cloud para Python: https://github.com/googleapis/google-cloud-python

Licença

Este conteúdo está sob a licença Atribuição 2.0 Genérica da Creative Commons.